Elasticsearch - Hướng dẫn nhanh

Elasticsearch là một máy chủ tìm kiếm dựa trên Apache Lucene. Nó được phát triển bởi Shay Banon và xuất bản vào năm 2010. Hiện nó được duy trì bởi Elasticsearch BV. Phiên bản mới nhất của nó là 7.0.0.

Elasticsearch là một công cụ phân tích và tìm kiếm toàn văn mã nguồn mở và được phân phối theo thời gian thực. Nó có thể truy cập từ giao diện dịch vụ web RESTful và sử dụng lược đồ ít tài liệu JSON (JavaScript Object Notation) để lưu trữ dữ liệu. Nó được xây dựng trên ngôn ngữ lập trình Java và do đó Elasticsearch có thể chạy trên các nền tảng khác nhau. Nó cho phép người dùng khám phá một lượng lớn dữ liệu với tốc độ rất cao.

Các tính năng chung

Các tính năng chung của Elasticsearch như sau:

Elasticsearch có thể mở rộng đến petabyte dữ liệu có cấu trúc và không có cấu trúc.

Elasticsearch có thể được sử dụng để thay thế các kho tài liệu như MongoDB và RavenDB.

Elasticsearch sử dụng chức năng không chuẩn hóa để cải thiện hiệu suất tìm kiếm.

Elasticsearch là một trong những công cụ tìm kiếm doanh nghiệp phổ biến và hiện đang được sử dụng bởi nhiều tổ chức lớn như Wikipedia, The Guardian, StackOverflow, GitHub, v.v.

Elasticsearch là một mã nguồn mở và có sẵn theo giấy phép Apache phiên bản 2.0.

Ý chính

Các khái niệm chính của Elasticsearch như sau:

Nút

Nó đề cập đến một phiên bản đang chạy của Elasticsearch. Một máy chủ vật lý và ảo chứa nhiều nút tùy thuộc vào khả năng của tài nguyên vật lý của chúng như RAM, khả năng lưu trữ và xử lý.

Cụm

Nó là một tập hợp của một hoặc nhiều nút. Cluster cung cấp khả năng lập chỉ mục và tìm kiếm tập thể trên tất cả các nút cho toàn bộ dữ liệu.

Mục lục

Nó là một tập hợp các loại tài liệu khác nhau và thuộc tính của chúng. Chỉ mục cũng sử dụng khái niệm phân đoạn để cải thiện hiệu suất. Ví dụ, một tập hợp tài liệu chứa dữ liệu của một ứng dụng mạng xã hội.

Tài liệu

Nó là một tập hợp các trường theo một cách cụ thể được xác định ở định dạng JSON. Mỗi tài liệu thuộc về một loại và nằm bên trong một chỉ mục. Mọi tài liệu được liên kết với một số nhận dạng duy nhất được gọi là UID.

Mảnh vỡ

Chỉ mục được chia nhỏ theo chiều ngang thành các phân đoạn. Điều này có nghĩa là mỗi phân đoạn chứa tất cả các thuộc tính của tài liệu nhưng chứa ít đối tượng JSON hơn chỉ mục. Sự phân tách theo chiều ngang làm cho phân đoạn trở thành một nút độc lập, có thể được lưu trữ trong bất kỳ nút nào. Phân đoạn chính là phần nằm ngang ban đầu của một chỉ mục và sau đó các phân đoạn chính này được sao chép thành các phân đoạn sao chép.

Bản sao

Elasticsearch cho phép người dùng tạo bản sao các chỉ mục và phân đoạn của họ. Việc sao chép không chỉ giúp tăng tính khả dụng của dữ liệu trong trường hợp bị lỗi mà còn cải thiện hiệu suất tìm kiếm bằng cách thực hiện thao tác tìm kiếm song song trong các bản sao này.

Ưu điểm

Elasticsearch được phát triển trên Java, giúp nó tương thích trên hầu hết mọi nền tảng.

Elasticsearch là thời gian thực, nói cách khác là sau một giây, tài liệu được thêm vào có thể tìm kiếm được trong công cụ này

Elasticsearch được phân phối, giúp dễ dàng mở rộng quy mô và tích hợp trong bất kỳ tổ chức lớn nào.

Dễ dàng tạo các bản sao lưu đầy đủ bằng cách sử dụng khái niệm gateway, có trong Elasticsearch.

Việc xử lý nhiều hợp đồng thuê nhà rất dễ dàng trong Elasticsearch khi so sánh với Apache Solr.

Elasticsearch sử dụng các đối tượng JSON làm phản hồi, điều này giúp bạn có thể gọi máy chủ Elasticsearch với một số lượng lớn các ngôn ngữ lập trình khác nhau.

Elasticsearch hỗ trợ hầu hết mọi loại tài liệu ngoại trừ những tài liệu không hỗ trợ kết xuất văn bản.

Nhược điểm

Elasticsearch không có hỗ trợ đa ngôn ngữ về mặt xử lý dữ liệu yêu cầu và phản hồi (chỉ có thể trong JSON) không giống như trong Apache Solr, nơi có thể ở các định dạng CSV, XML và JSON.

Đôi khi, Elasticsearch gặp sự cố Chia rẽ tình huống não.

So sánh giữa Elasticsearch và RDBMS

Trong Elasticsearch, chỉ mục tương tự như các bảng trong RDBMS (Hệ quản trị cơ sở dữ liệu quan hệ). Mỗi bảng là một tập hợp các hàng giống như mọi chỉ mục là một tập hợp các tài liệu trong Elasticsearch.

Bảng sau đây đưa ra so sánh trực tiếp giữa các thuật ngữ này

| Elasticsearch | RDBMS |

|---|---|

| Cụm | Cơ sở dữ liệu |

| Mảnh vỡ | Mảnh vỡ |

| Mục lục | Bàn |

| Cánh đồng | Cột |

| Tài liệu | Hàng |

Trong chương này, chúng ta sẽ hiểu chi tiết quy trình cài đặt của Elasticsearch.

Để cài đặt Elasticsearch trên máy tính cục bộ của bạn, bạn sẽ phải làm theo các bước dưới đây:

Step 1- Kiểm tra phiên bản java được cài đặt trên máy tính của bạn. Nó phải là java 7 hoặc cao hơn. Bạn có thể kiểm tra bằng cách làm như sau:

Trong Hệ điều hành Windows (OS) (sử dụng dấu nhắc lệnh) -

> java -versionTrong hệ điều hành UNIX (Sử dụng thiết bị đầu cuối) -

$ echo $JAVA_HOMEStep 2 - Tùy thuộc vào hệ điều hành của bạn, tải xuống Elasticsearch từ www.elastic.co như được đề cập bên dưới -

Đối với hệ điều hành windows, tải xuống tệp ZIP.

Đối với HĐH UNIX, hãy tải xuống tệp TAR.

Đối với HĐH Debian, hãy tải xuống tệp DEB.

Đối với Red Hat và các bản phân phối Linux khác, hãy tải xuống tệp RPN.

Các tiện ích APT và Yum cũng có thể được sử dụng để cài đặt Elasticsearch trong nhiều bản phân phối Linux.

Step 3 - Quá trình cài đặt Elasticsearch rất đơn giản và được mô tả bên dưới cho các hệ điều hành khác nhau -

Windows OS- Giải nén gói zip và Elasticsearch đã được cài đặt.

UNIX OS- Giải nén tệp tar ở bất kỳ vị trí nào và Elasticsearch đã được cài đặt.

$wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch7.0.0-linux-x86_64.tar.gz $tar -xzf elasticsearch-7.0.0-linux-x86_64.tar.gzUsing APT utility for Linux OS- Tải xuống và cài đặt Khóa ký công khai

$ wget -qo - https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo

apt-key add -Lưu định nghĩa kho lưu trữ như hình dưới đây -

$ echo "deb https://artifacts.elastic.co/packages/7.x/apt stable main" |

sudo tee -a /etc/apt/sources.list.d/elastic-7.x.listChạy cập nhật bằng lệnh sau:

$ sudo apt-get updateBây giờ bạn có thể cài đặt bằng cách sử dụng lệnh sau:

$ sudo apt-get install elasticsearchDownload and install the Debian package manually using the command given here −

$wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch7.0.0-amd64.deb $sudo dpkg -i elasticsearch-7.0.0-amd64.deb0Using YUM utility for Debian Linux OS

Tải xuống và cài đặt Khóa ký công khai -

$ rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearchTHÊM văn bản sau vào tệp có hậu tố .repo trong thư mục “/etc/yum.repos.d/” của bạn. Ví dụ :asticsearch.repo

elasticsearch-7.x]

name=Elasticsearch repository for 7.x packages

baseurl=https://artifacts.elastic.co/packages/7.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-mdBây giờ bạn có thể cài đặt Elasticsearch bằng cách sử dụng lệnh sau

sudo yum install elasticsearchStep 4- Vào thư mục chính Elasticsearch và bên trong thư mục bin. Chạy tệp thunsearch.bat trong trường hợp Windows hoặc bạn có thể thực hiện tương tự bằng cách sử dụng dấu nhắc lệnh và thông qua thiết bị đầu cuối trong trường hợp tệp UNIX rum Elasticsearch.

Trong Windows

> cd elasticsearch-2.1.0/bin

> elasticsearchTrong Linux

$ cd elasticsearch-2.1.0/bin

$ ./elasticsearchNote - Trong trường hợp windows, bạn có thể gặp lỗi cho biết JAVA_HOME chưa được đặt, vui lòng đặt nó trong biến môi trường thành “C: \ Program Files \ Java \ jre1.8.0_31” hoặc vị trí bạn đã cài đặt java.

Step 5- Cổng mặc định cho giao diện web Elasticsearch là 9200 hoặc bạn có thể thay đổi nó bằng cách thay đổi http.port bên trong tệp đàn hồi.yml có trong thư mục bin. Bạn có thể kiểm tra xem máy chủ có hoạt động hay không bằng cách duyệthttp://localhost:9200. Nó sẽ trả về một đối tượng JSON, chứa thông tin về Elasticsearch đã cài đặt theo cách sau:

{

"name" : "Brain-Child",

"cluster_name" : "elasticsearch", "version" : {

"number" : "2.1.0",

"build_hash" : "72cd1f1a3eee09505e036106146dc1949dc5dc87",

"build_timestamp" : "2015-11-18T22:40:03Z",

"build_snapshot" : false,

"lucene_version" : "5.3.1"

},

"tagline" : "You Know, for Search"

}Step 6- Ở bước này, chúng ta hãy cài đặt Kibana. Làm theo mã tương ứng được cung cấp bên dưới để cài đặt trên Linux và Windows -

For Installation on Linux −

wget https://artifacts.elastic.co/downloads/kibana/kibana-7.0.0-linuxx86_64.tar.gz

tar -xzf kibana-7.0.0-linux-x86_64.tar.gz

cd kibana-7.0.0-linux-x86_64/

./bin/kibanaFor Installation on Windows −

Tải xuống Kibana cho Windows từ https://www.elastic.co/products/kibana. Khi bạn nhấp vào liên kết, bạn sẽ tìm thấy trang chủ như hình dưới đây -

Giải nén và đi đến thư mục chính của Kibana và sau đó chạy nó.

CD c:\kibana-7.0.0-windows-x86_64

.\bin\kibana.batTrong chương này, chúng ta hãy tìm hiểu cách thêm một số chỉ mục, ánh xạ và dữ liệu vào Elasticsearch. Lưu ý rằng một số dữ liệu này sẽ được sử dụng trong các ví dụ được giải thích trong hướng dẫn này.

Tạo chỉ mục

Bạn có thể sử dụng lệnh sau để tạo chỉ mục:

PUT schoolPhản ứng

Nếu chỉ mục được tạo, bạn có thể thấy kết quả sau:

{"acknowledged": true}Thêm dữ liệu

Elasticsearch sẽ lưu trữ các tài liệu mà chúng tôi thêm vào chỉ mục như được hiển thị trong đoạn mã sau. Các tài liệu được cung cấp một số ID được sử dụng để xác định tài liệu.

Nội dung yêu cầu

POST school/_doc/10

{

"name":"Saint Paul School", "description":"ICSE Afiliation",

"street":"Dawarka", "city":"Delhi", "state":"Delhi", "zip":"110075",

"location":[28.5733056, 77.0122136], "fees":5000,

"tags":["Good Faculty", "Great Sports"], "rating":"4.5"

}Phản ứng

{

"_index" : "school",

"_type" : "_doc",

"_id" : "10",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 2,

"_primary_term" : 1

}Ở đây, chúng tôi đang thêm một tài liệu tương tự khác.

POST school/_doc/16

{

"name":"Crescent School", "description":"State Board Affiliation",

"street":"Tonk Road",

"city":"Jaipur", "state":"RJ", "zip":"176114","location":[26.8535922,75.7923988],

"fees":2500, "tags":["Well equipped labs"], "rating":"4.5"

}Phản ứng

{

"_index" : "school",

"_type" : "_doc",

"_id" : "16",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 9,

"_primary_term" : 7

}Bằng cách này, chúng tôi sẽ tiếp tục bổ sung bất kỳ dữ liệu mẫu nào mà chúng tôi cần để làm việc trong các chương sắp tới.

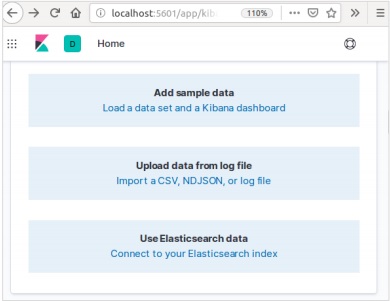

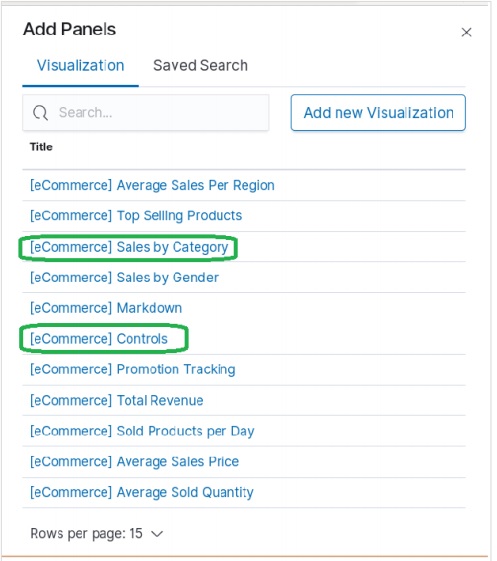

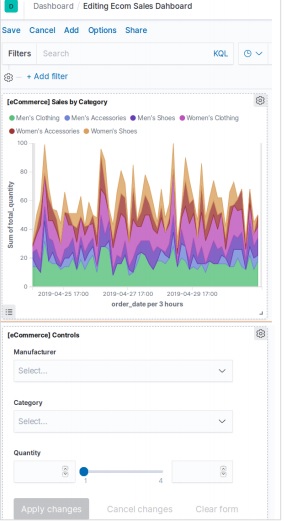

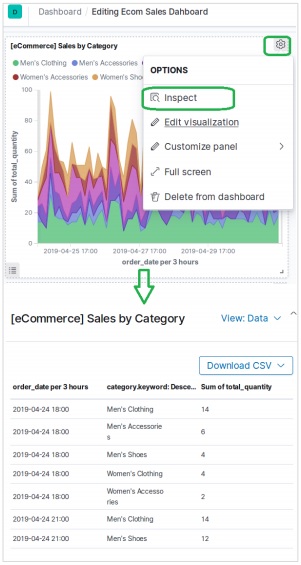

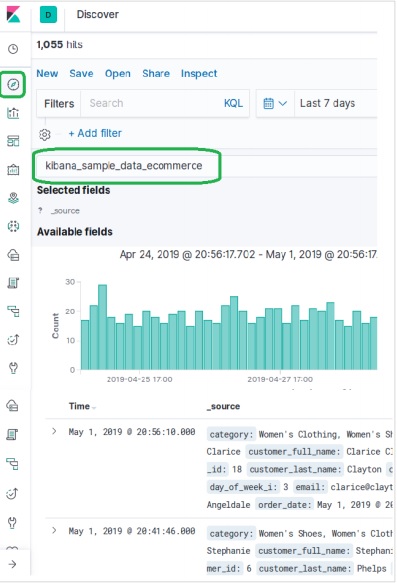

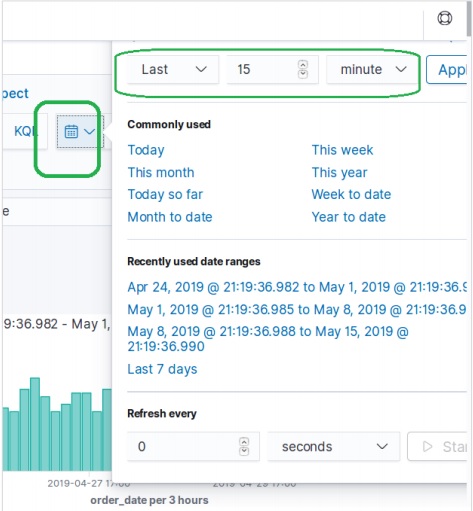

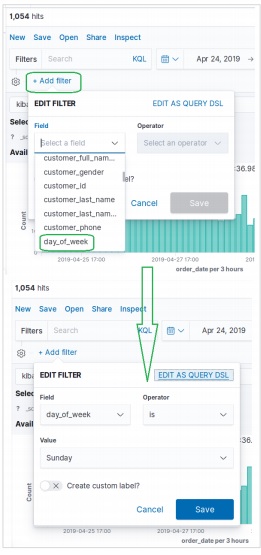

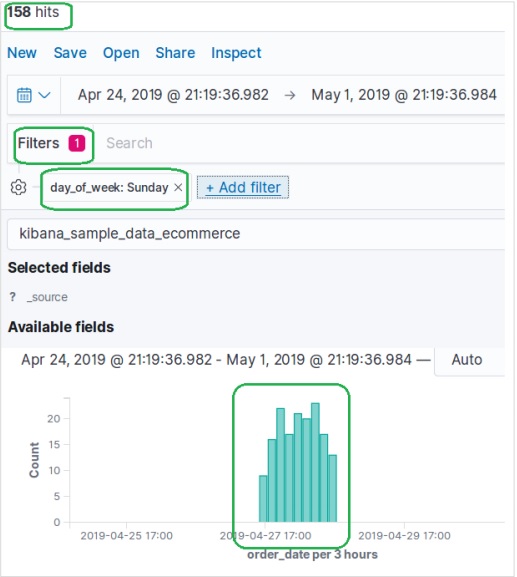

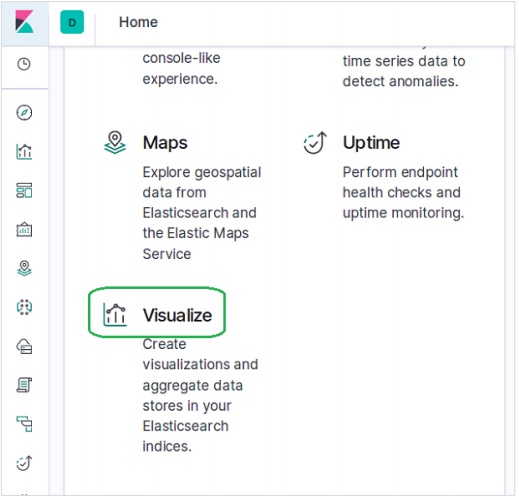

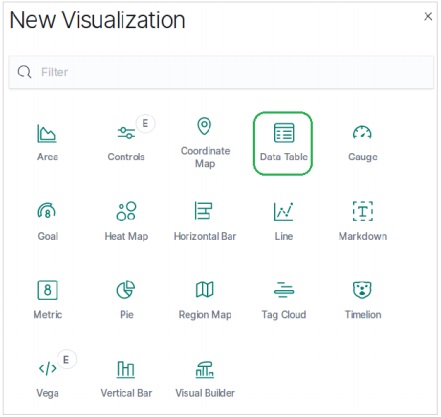

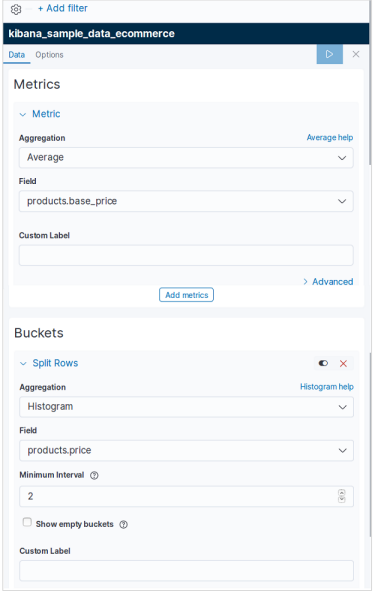

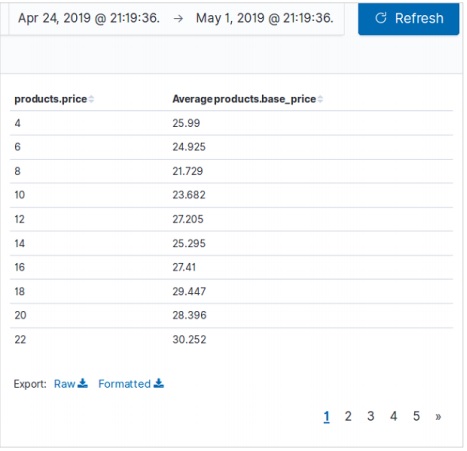

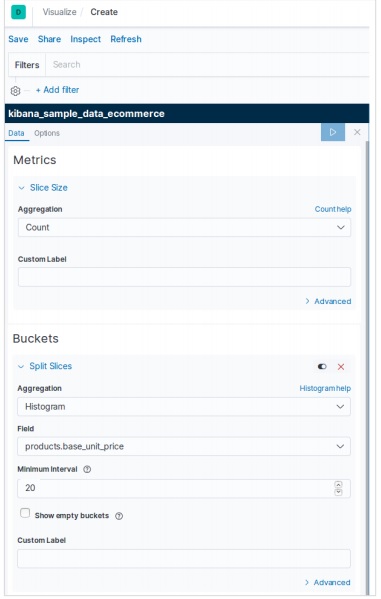

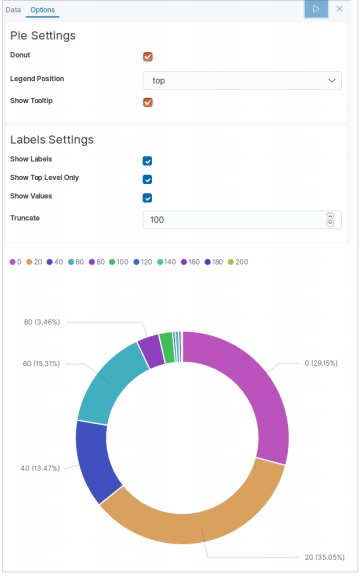

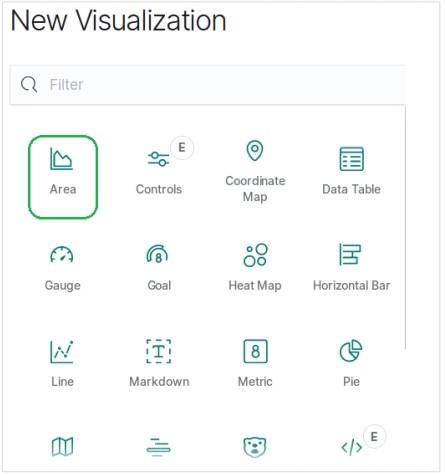

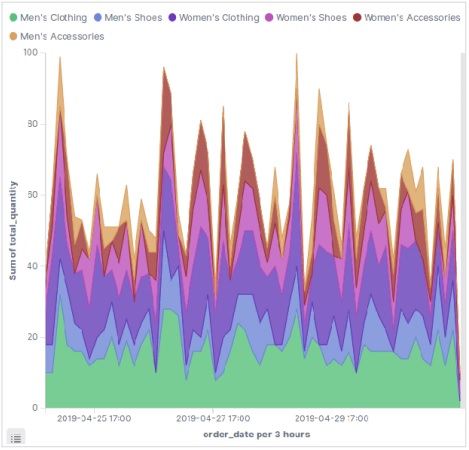

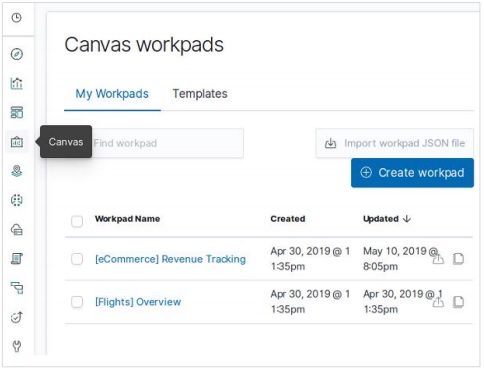

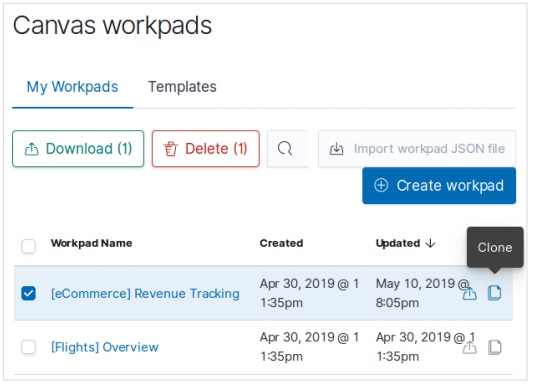

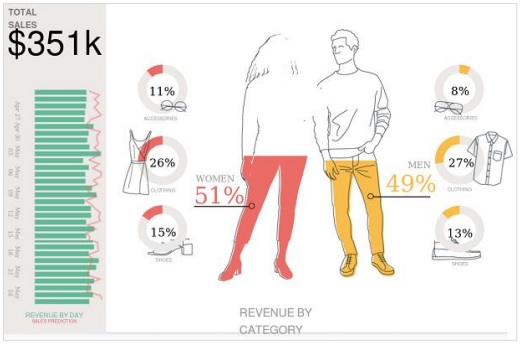

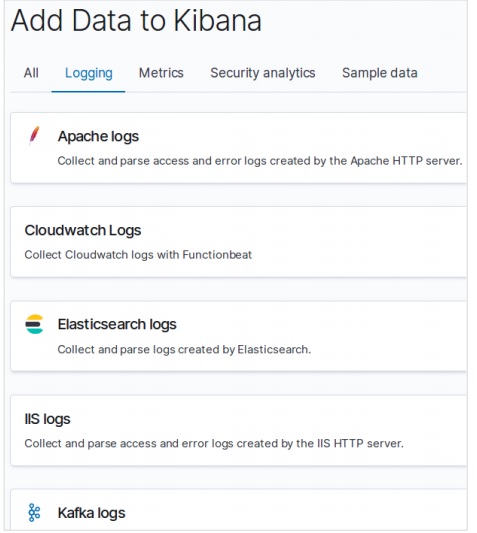

Thêm dữ liệu mẫu trong Kibana

Kibana là một công cụ điều khiển GUI để truy cập dữ liệu và tạo hình ảnh trực quan. Trong phần này, hãy cho chúng tôi hiểu cách chúng tôi có thể thêm dữ liệu mẫu vào đó.

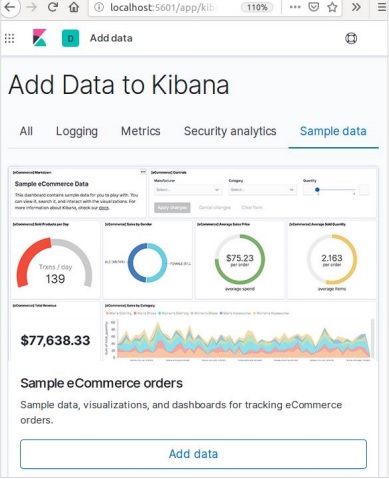

Trong trang chủ Kibana, hãy chọn tùy chọn sau để thêm dữ liệu thương mại điện tử mẫu:

Màn hình tiếp theo sẽ hiển thị một số hình ảnh trực quan và một nút để Thêm dữ liệu -

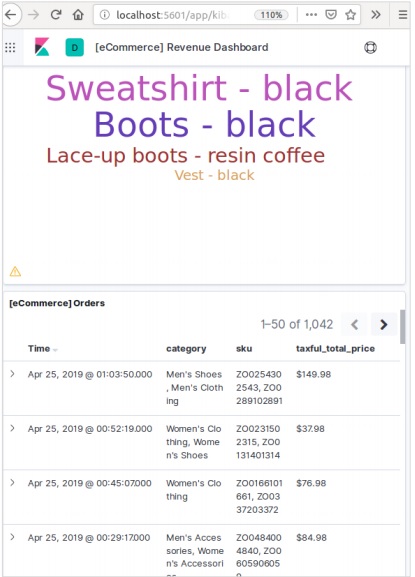

Nhấp vào Thêm dữ liệu sẽ hiển thị màn hình sau xác nhận dữ liệu đã được thêm vào chỉ mục có tên Thương mại điện tử.

Trong bất kỳ hệ thống hoặc phần mềm nào, khi chúng tôi nâng cấp lên phiên bản mới hơn, chúng tôi cần làm theo một vài bước để duy trì cài đặt ứng dụng, cấu hình, dữ liệu và những thứ khác. Các bước này được yêu cầu để làm cho ứng dụng ổn định trong hệ thống mới hoặc để duy trì tính toàn vẹn của dữ liệu (ngăn dữ liệu bị hỏng).

Bạn cần làm theo các bước sau để nâng cấp Elasticsearch -

Đọc tài liệu Nâng cấp từ https://www.elastic.co/

Kiểm tra phiên bản đã nâng cấp trong môi trường không sản xuất của bạn như trong môi trường UAT, E2E, SIT hoặc DEV.

Lưu ý rằng không thể khôi phục về phiên bản Elasticsearch trước đó nếu không có sao lưu dữ liệu. Do đó, nên sao lưu dữ liệu trước khi nâng cấp lên phiên bản cao hơn.

Chúng tôi có thể nâng cấp bằng cách khởi động lại toàn bộ cụm hoặc nâng cấp luân phiên. Nâng cấp cuộn dành cho các phiên bản mới. Lưu ý rằng không xảy ra tình trạng ngừng hoạt động dịch vụ khi bạn đang sử dụng phương pháp nâng cấp luân phiên để di chuyển.

Các bước nâng cấp

Kiểm tra nâng cấp trong môi trường nhà phát triển trước khi nâng cấp cụm sản xuất của bạn.

Sao lưu dữ liệu của bạn. Bạn không thể quay trở lại phiên bản cũ hơn trừ khi bạn có ảnh chụp nhanh dữ liệu của mình.

Cân nhắc đóng các công việc máy học trước khi bạn bắt đầu quá trình nâng cấp. Trong khi các công việc học máy có thể tiếp tục chạy trong quá trình nâng cấp luân phiên, nó sẽ làm tăng chi phí trên cụm trong quá trình nâng cấp.

Nâng cấp các thành phần của Ngăn xếp đàn hồi của bạn theo thứ tự sau:

- Elasticsearch

- Kibana

- Logstash

- Beats

- Máy chủ APM

Nâng cấp từ 6.6 trở lên

Để nâng cấp trực tiếp lên Elasticsearch 7.1.0 từ phiên bản 6.0-6.6, bạn phải lập chỉ mục lại theo cách thủ công bất kỳ chỉ số 5.x nào mà bạn cần để tiếp tục và thực hiện khởi động lại toàn bộ cụm.

Khởi động lại toàn bộ cụm

Quá trình khởi động lại toàn bộ cụm liên quan đến việc tắt từng nút trong cụm, nâng cấp từng nút lên 7x và sau đó khởi động lại cụm.

Sau đây là các bước cấp cao cần được thực hiện để khởi động lại toàn bộ cụm -

- Tắt phân bổ phân đoạn

- Ngừng lập chỉ mục và thực hiện xả đồng bộ hóa

- Tắt tất cả các nút

- Nâng cấp tất cả các nút

- Nâng cấp bất kỳ plugin nào

- Bắt đầu mỗi nút được nâng cấp

- Chờ cho tất cả các nút tham gia cụm và báo cáo trạng thái màu vàng

- Bật lại phân bổ

Khi phân bổ được bật lại, cụm bắt đầu phân bổ các phân đoạn bản sao cho các nút dữ liệu. Tại thời điểm này, có thể an toàn để tiếp tục lập chỉ mục và tìm kiếm, nhưng cụm của bạn sẽ phục hồi nhanh hơn nếu bạn có thể đợi cho đến khi tất cả các phân đoạn chính và bản sao được phân bổ thành công và trạng thái của tất cả các nút có màu xanh lục.

Giao diện lập trình ứng dụng (API) trong web là một nhóm các lệnh gọi hàm hoặc hướng dẫn lập trình khác để truy cập thành phần phần mềm trong ứng dụng web cụ thể đó. Ví dụ, Facebook API giúp nhà phát triển tạo ứng dụng bằng cách truy cập dữ liệu hoặc các chức năng khác từ Facebook; nó có thể là ngày sinh hoặc cập nhật trạng thái.

Elasticsearch cung cấp API REST, được truy cập bởi JSON qua HTTP. Elasticsearch sử dụng một số quy ước mà chúng ta sẽ thảo luận ngay bây giờ.

Nhiều chỉ số

Hầu hết các hoạt động, chủ yếu là tìm kiếm và các hoạt động khác, trong API dành cho một hoặc nhiều chỉ số. Điều này giúp người dùng tìm kiếm ở nhiều nơi hoặc tất cả dữ liệu có sẵn bằng cách thực hiện truy vấn một lần. Nhiều ký hiệu khác nhau được sử dụng để thực hiện các hoạt động trong nhiều chỉ số. Chúng ta sẽ thảo luận một vài trong số chúng ở đây trong chương này.

Ký hiệu được phân tách bằng dấu phẩy

POST /index1,index2,index3/_searchNội dung yêu cầu

{

"query":{

"query_string":{

"query":"any_string"

}

}

}Phản ứng

Các đối tượng JSON từ index1, index2, index3 có any_string trong đó.

_tất cả từ khóa cho tất cả chỉ số

POST /_all/_searchNội dung yêu cầu

{

"query":{

"query_string":{

"query":"any_string"

}

}

}Phản ứng

Các đối tượng JSON từ tất cả các chỉ số và có any_string trong đó.

Các ký tự đại diện (*, +, -)

POST /school*/_searchNội dung yêu cầu

{

"query":{

"query_string":{

"query":"CBSE"

}

}

}Phản ứng

Các đối tượng JSON từ tất cả các chỉ số bắt đầu với trường học có CBSE trong đó.

Ngoài ra, bạn cũng có thể sử dụng mã sau:

POST /school*,-schools_gov /_searchNội dung yêu cầu

{

"query":{

"query_string":{

"query":"CBSE"

}

}

}Phản ứng

Các đối tượng JSON từ tất cả các chỉ số bắt đầu bằng “school” nhưng không phải từ school_gov và có CBSE trong đó.

Ngoài ra còn có một số tham số chuỗi truy vấn URL -

- ignore_unavailable- Sẽ không có lỗi nào xảy ra hoặc không có hoạt động nào bị dừng, nếu một hoặc nhiều chỉ mục có trong URL không tồn tại. Ví dụ, chỉ mục trường học tồn tại, nhưng hiệu sách không tồn tại.

POST /school*,book_shops/_searchNội dung yêu cầu

{

"query":{

"query_string":{

"query":"CBSE"

}

}

}Nội dung yêu cầu

{

"error":{

"root_cause":[{

"type":"index_not_found_exception", "reason":"no such index",

"resource.type":"index_or_alias", "resource.id":"book_shops",

"index":"book_shops"

}],

"type":"index_not_found_exception", "reason":"no such index",

"resource.type":"index_or_alias", "resource.id":"book_shops",

"index":"book_shops"

},"status":404

}Hãy xem xét đoạn mã sau:

POST /school*,book_shops/_search?ignore_unavailable = trueNội dung yêu cầu

{

"query":{

"query_string":{

"query":"CBSE"

}

}

}Phản hồi (không có lỗi)

Các đối tượng JSON từ tất cả các chỉ số bắt đầu với trường học có CBSE trong đó.

allow_no_indices

truegiá trị của thông số này sẽ ngăn lỗi, nếu một URL có ký tự đại diện dẫn đến không có chỉ số. Ví dụ: không có chỉ mục nào bắt đầu bằng school_pri -

POST /schools_pri*/_search?allow_no_indices = trueNội dung yêu cầu

{

"query":{

"match_all":{}

}

}Phản hồi (Không có lỗi)

{

"took":1,"timed_out": false, "_shards":{"total":0, "successful":0, "failed":0},

"hits":{"total":0, "max_score":0.0, "hits":[]}

}expand_wildcards

Tham số này quyết định xem các ký tự đại diện có cần được mở rộng cho các chỉ số mở hay chỉ số đóng hay thực hiện cả hai. Giá trị của tham số này có thể mở và đóng hoặc không có và tất cả.

Ví dụ: đóng các trường chỉ mục -

POST /schools/_closePhản ứng

{"acknowledged":true}Hãy xem xét đoạn mã sau:

POST /school*/_search?expand_wildcards = closedNội dung yêu cầu

{

"query":{

"match_all":{}

}

}Phản ứng

{

"error":{

"root_cause":[{

"type":"index_closed_exception", "reason":"closed", "index":"schools"

}],

"type":"index_closed_exception", "reason":"closed", "index":"schools"

}, "status":403

}Hỗ trợ toán ngày trong tên chỉ mục

Elasticsearch cung cấp chức năng tìm kiếm các chỉ mục theo ngày và giờ. Chúng ta cần chỉ định ngày và giờ theo một định dạng cụ thể. Ví dụ: accountdetail-2015.12.30, chỉ mục sẽ lưu trữ chi tiết tài khoản ngân hàng của ngày 30 tháng 12 năm 2015. Các phép toán có thể được thực hiện để lấy thông tin chi tiết cho một ngày cụ thể hoặc một phạm vi ngày và giờ.

Định dạng cho tên chỉ mục toán học ngày -

<static_name{date_math_expr{date_format|time_zone}}>

/<accountdetail-{now-2d{YYYY.MM.dd|utc}}>/_searchstatic_name là một phần của biểu thức được giữ nguyên trong mọi chỉ mục toán ngày như chi tiết tài khoản. date_math_expr chứa biểu thức toán học xác định ngày và giờ động như now-2d. date_format chứa định dạng trong đó ngày được viết trong chỉ mục như YYYY.MM.dd. Nếu ngày hôm nay là ngày 30 tháng 12 năm 2015, thì <accountdetail- {now-2d {YYYY.MM.dd}}> sẽ trả về accountdetail-2015.12.28.

| Biểu hiện | Giải quyết cho |

|---|---|

| <accountdetail- {now-d}> | accountdetail-2015.12.29 |

| <accountdetail- {now-M}> | accountdetail-2015.11.30 |

| <accountdetail- {now {YYYY.MM}}> | accountdetail-2015.12 |

Bây giờ chúng ta sẽ thấy một số tùy chọn phổ biến có sẵn trong Elasticsearch có thể được sử dụng để nhận phản hồi ở định dạng được chỉ định.

Kết quả khá

Chúng tôi có thể nhận được phản hồi trong một đối tượng JSON được định dạng tốt bằng cách thêm một tham số truy vấn URL, tức là khá = true.

POST /schools/_search?pretty = trueNội dung yêu cầu

{

"query":{

"match_all":{}

}

}Phản ứng

……………………..

{

"_index" : "schools", "_type" : "school", "_id" : "1", "_score" : 1.0,

"_source":{

"name":"Central School", "description":"CBSE Affiliation",

"street":"Nagan", "city":"paprola", "state":"HP", "zip":"176115",

"location": [31.8955385, 76.8380405], "fees":2000,

"tags":["Senior Secondary", "beautiful campus"], "rating":"3.5"

}

}

………………….Đầu ra có thể đọc được của con người

Tùy chọn này có thể thay đổi các phản hồi thống kê thành dạng con người có thể đọc được (Nếu con người = true) hoặc dạng máy tính có thể đọc được (nếu con người = sai). Ví dụ: nếu human = true thì distance_kilometer = 20KM và nếu human = false thì distance_meter = 20000, khi phản hồi cần được sử dụng bởi một chương trình máy tính khác.

Lọc phản hồi

Chúng ta có thể lọc phản hồi cho ít trường hơn bằng cách thêm chúng vào tham số field_path. Ví dụ,

POST /schools/_search?filter_path = hits.totalNội dung yêu cầu

{

"query":{

"match_all":{}

}

}Phản ứng

{"hits":{"total":3}}Elasticsearch cung cấp các API tài liệu đơn lẻ và API đa tài liệu, nơi lệnh gọi API nhắm mục tiêu một tài liệu và nhiều tài liệu tương ứng.

API chỉ mục

Nó giúp thêm hoặc cập nhật tài liệu JSON trong một chỉ mục khi có yêu cầu đối với chỉ mục tương ứng đó với ánh xạ cụ thể. Ví dụ: yêu cầu sau sẽ thêm đối tượng JSON vào lập chỉ mục trường học và ánh xạ trường học -

PUT schools/_doc/5

{

name":"City School", "description":"ICSE", "street":"West End",

"city":"Meerut",

"state":"UP", "zip":"250002", "location":[28.9926174, 77.692485],

"fees":3500,

"tags":["fully computerized"], "rating":"4.5"

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 2,

"_primary_term" : 1

}Tạo chỉ mục tự động

Khi một yêu cầu được thực hiện để thêm đối tượng JSON vào một chỉ mục cụ thể và nếu chỉ mục đó không tồn tại, thì API này sẽ tự động tạo chỉ mục đó và cũng là ánh xạ cơ bản cho đối tượng JSON cụ thể đó. Chức năng này có thể bị vô hiệu hóa bằng cách thay đổi các giá trị của các tham số sau thành false, có trong tệp tin đàn hồi.yml.

action.auto_create_index:false

index.mapper.dynamic:falseBạn cũng có thể hạn chế việc tự động tạo chỉ mục, trong đó chỉ cho phép tên chỉ mục với các mẫu cụ thể bằng cách thay đổi giá trị của tham số sau:

action.auto_create_index:+acc*,-bank*Note - Ở đây + biểu thị được phép và - biểu thị không được phép.

Phiên bản

Elasticsearch cũng cung cấp cơ sở kiểm soát phiên bản. Chúng ta có thể sử dụng tham số truy vấn phiên bản để chỉ định phiên bản của một tài liệu cụ thể.

PUT schools/_doc/5?version=7&version_type=external

{

"name":"Central School", "description":"CBSE Affiliation", "street":"Nagan",

"city":"paprola", "state":"HP", "zip":"176115", "location":[31.8955385, 76.8380405],

"fees":2200, "tags":["Senior Secondary", "beautiful campus"], "rating":"3.3"

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 7,

"result" : "updated",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 3,

"_primary_term" : 1

}Tạo phiên bản là một quá trình thời gian thực và nó không bị ảnh hưởng bởi các hoạt động tìm kiếm thời gian thực.

Có hai kiểu lập phiên bản quan trọng nhất -

Phiên bản nội bộ

Phiên bản nội bộ là phiên bản mặc định bắt đầu bằng 1 và tăng dần với mỗi lần cập nhật, xóa bao gồm.

Phiên bản bên ngoài

Nó được sử dụng khi phiên bản của tài liệu được lưu trữ trong một hệ thống bên ngoài như hệ thống lập phiên bản của bên thứ ba. Để kích hoạt chức năng này, chúng tôi cần đặt version_type thành bên ngoài. Tại đây Elasticsearch sẽ lưu trữ số phiên bản theo chỉ định của hệ thống bên ngoài và sẽ không tự động tăng chúng.

Loại hoạt động

Loại hoạt động được sử dụng để buộc một hoạt động tạo. Điều này giúp tránh ghi đè tài liệu hiện có.

PUT chapter/_doc/1?op_type=create

{

"Text":"this is chapter one"

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"_index" : "chapter",

"_type" : "_doc",

"_id" : "1",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 0,

"_primary_term" : 1

}Tạo ID tự động

Khi ID không được chỉ định trong thao tác lập chỉ mục, thì Elasticsearch sẽ tự động tạo id cho tài liệu đó.

POST chapter/_doc/

{

"user" : "tpoint",

"post_date" : "2018-12-25T14:12:12",

"message" : "Elasticsearch Tutorial"

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"_index" : "chapter",

"_type" : "_doc",

"_id" : "PVghWGoB7LiDTeV6LSGu",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 1,

"_primary_term" : 1

}Nhận API

API giúp trích xuất đối tượng JSON kiểu bằng cách thực hiện yêu cầu nhận đối với một tài liệu cụ thể.

pre class="prettyprint notranslate" > GET schools/_doc/5Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 7,

"_seq_no" : 3,

"_primary_term" : 1,

"found" : true,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

}Hoạt động này là thời gian thực và không bị ảnh hưởng bởi tốc độ làm mới của Chỉ mục.

Bạn cũng có thể chỉ định phiên bản, sau đó Elasticsearch sẽ chỉ tìm nạp phiên bản tài liệu đó.

Bạn cũng có thể chỉ định _all trong yêu cầu, để Elasticsearch có thể tìm kiếm id tài liệu đó ở mọi loại và nó sẽ trả về tài liệu phù hợp đầu tiên.

Bạn cũng có thể chỉ định các trường bạn muốn trong kết quả của mình từ tài liệu cụ thể đó.

GET schools/_doc/5?_source_includes=name,feesKhi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 7,

"_seq_no" : 3,

"_primary_term" : 1,

"found" : true,

"_source" : {

"fees" : 2200,

"name" : "Central School"

}

}Bạn cũng có thể tìm nạp phần nguồn trong kết quả của mình bằng cách thêm phần _source vào yêu cầu nhận của bạn.

GET schools/_doc/5?_sourceKhi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 7,

"_seq_no" : 3,

"_primary_term" : 1,

"found" : true,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

}Bạn cũng có thể làm mới phân đoạn trước khi thực hiện thao tác nhận bằng cách đặt tham số làm mới thành true.

Xóa API

Bạn có thể xóa một chỉ mục, ánh xạ hoặc một tài liệu cụ thể bằng cách gửi một yêu cầu HTTP DELETE tới Elasticsearch.

DELETE schools/_doc/4Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"found":true, "_index":"schools", "_type":"school", "_id":"4", "_version":2,

"_shards":{"total":2, "successful":1, "failed":0}

}Phiên bản của tài liệu có thể được chỉ định để xóa phiên bản cụ thể đó. Tham số định tuyến có thể được chỉ định để xóa tài liệu khỏi một người dùng cụ thể và hoạt động không thành công nếu tài liệu không thuộc về người dùng cụ thể đó. Trong thao tác này, bạn có thể chỉ định tùy chọn làm mới và thời gian chờ giống như API GET.

Cập nhật API

Tập lệnh được sử dụng để thực hiện thao tác này và việc lập phiên bản được sử dụng để đảm bảo rằng không có cập nhật nào xảy ra trong quá trình lấy và lập chỉ mục lại. Ví dụ: bạn có thể cập nhật học phí của trường học bằng cách sử dụng script -

POST schools/_update/4

{

"script" : {

"source": "ctx._source.name = params.sname",

"lang": "painless",

"params" : {

"sname" : "City Wise School"

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "4",

"_version" : 3,

"result" : "updated",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 4,

"_primary_term" : 2

}Bạn có thể kiểm tra bản cập nhật bằng cách gửi yêu cầu đến tài liệu được cập nhật.

API này được sử dụng để tìm kiếm nội dung trong Elasticsearch. Người dùng có thể tìm kiếm bằng cách gửi yêu cầu nhận với chuỗi truy vấn dưới dạng tham số hoặc họ có thể đăng truy vấn trong nội dung thư của yêu cầu đăng. Chủ yếu tất cả các APIS tìm kiếm là đa chỉ mục, đa loại.

Đa chỉ mục

Elasticsearch cho phép chúng tôi tìm kiếm các tài liệu có trong tất cả các chỉ số hoặc trong một số chỉ số cụ thể. Ví dụ: nếu chúng tôi cần tìm kiếm tất cả các tài liệu có tên chứa trung tâm, chúng tôi có thể làm như được hiển thị ở đây -

GET /_all/_search?q=city:paprolaKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi sau:

{

"took" : 33,

"timed_out" : false,

"_shards" : {

"total" : 7,

"successful" : 7,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 0.9808292,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 0.9808292,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

}

]

}

}Tìm kiếm URI

Nhiều tham số có thể được chuyển trong một thao tác tìm kiếm sử dụng Mã định danh tài nguyên đồng nhất -

| S.Không | Mô tả về Thông Số |

|---|---|

| 1 | Q Tham số này được sử dụng để chỉ định chuỗi truy vấn. |

| 2 | lenient Tham số này được sử dụng để chỉ định chuỗi truy vấn. Các lỗi dựa trên định dạng có thể được bỏ qua bằng cách đặt tham số này thành true. Nó là sai theo mặc định. |

| 3 | fields Tham số này được sử dụng để chỉ định chuỗi truy vấn. |

| 4 | sort Chúng ta có thể nhận được kết quả được sắp xếp bằng cách sử dụng tham số này, các giá trị có thể có cho tham số này là fieldName, fieldName: asc / fieldname: desc |

| 5 | timeout Chúng tôi có thể giới hạn thời gian tìm kiếm bằng cách sử dụng thông số này và phản hồi chỉ chứa các lần truy cập trong thời gian được chỉ định đó. Theo mặc định, không có thời gian chờ. |

| 6 | terminate_after Chúng tôi có thể hạn chế phản hồi đối với một số tài liệu cụ thể cho mỗi phân đoạn, khi đạt đến đó truy vấn sẽ kết thúc sớm. Theo mặc định, không có cuối cùng |

| 7 | from Bắt đầu từ chỉ mục của các lần truy cập để trả về. Mặc định là 0. |

| số 8 | size Nó biểu thị số lần truy cập cần trả lại. Mặc định là 10. |

Yêu cầu tìm kiếm cơ thể

Chúng tôi cũng có thể chỉ định truy vấn bằng cách sử dụng truy vấn DSL trong phần thân yêu cầu và có nhiều ví dụ đã được đưa ra trong các chương trước. Một ví dụ như vậy được đưa ra ở đây -

POST /schools/_search

{

"query":{

"query_string":{

"query":"up"

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi sau:

{

"took" : 11,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 0.47000363,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 0.47000363,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

}

}Khung tổng hợp thu thập tất cả dữ liệu được chọn bởi truy vấn tìm kiếm và bao gồm nhiều khối xây dựng, giúp xây dựng các bản tóm tắt phức tạp của dữ liệu. Cấu trúc cơ bản của một tập hợp được hiển thị ở đây:

"aggregations" : {

"" : {

"" : {

}

[,"meta" : { [] } ]?

[,"aggregations" : { []+ } ]?

}

[,"" : { ... } ]*

}Có nhiều loại tổng hợp khác nhau, mỗi loại có mục đích riêng. Chúng được thảo luận chi tiết trong chương này.

Tổng hợp số liệu

Các tổng hợp này giúp tính toán ma trận từ các giá trị của trường của các tài liệu tổng hợp và đôi khi một số giá trị có thể được tạo từ các tập lệnh.

Ma trận số có giá trị đơn như tổng hợp trung bình hoặc đa giá trị như thống kê.

Tổng hợp Trung bình

Tổng hợp này được sử dụng để lấy giá trị trung bình của bất kỳ trường số nào có trong các tài liệu tổng hợp. Ví dụ,

POST /schools/_search

{

"aggs":{

"avg_fees":{"avg":{"field":"fees"}}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"took" : 41,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : 1.0,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 1.0,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

},

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 1.0,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

},

"aggregations" : {

"avg_fees" : {

"value" : 2850.0

}

}

}Cardinality Aggregation

Tổng hợp này cung cấp số lượng các giá trị riêng biệt của một trường cụ thể.

POST /schools/_search?size=0

{

"aggs":{

"distinct_name_count":{"cardinality":{"field":"fees"}}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"took" : 2,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"distinct_name_count" : {

"value" : 2

}

}

}Note - Giá trị của cardinality là 2 vì có hai giá trị khác biệt trong phí.

Tổng hợp số liệu thống kê mở rộng

Tổng hợp này tạo ra tất cả các thống kê về một trường số cụ thể trong các tài liệu tổng hợp.

POST /schools/_search?size=0

{

"aggs" : {

"fees_stats" : { "extended_stats" : { "field" : "fees" } }

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"took" : 8,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"fees_stats" : {

"count" : 2,

"min" : 2200.0,

"max" : 3500.0,

"avg" : 2850.0,

"sum" : 5700.0,

"sum_of_squares" : 1.709E7,

"variance" : 422500.0,

"std_deviation" : 650.0,

"std_deviation_bounds" : {

"upper" : 4150.0,

"lower" : 1550.0

}

}

}

}Tổng hợp tối đa

Tổng hợp này tìm giá trị tối đa của một trường số cụ thể trong các tài liệu được tổng hợp.

POST /schools/_search?size=0

{

"aggs" : {

"max_fees" : { "max" : { "field" : "fees" } }

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"took" : 16,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"max_fees" : {

"value" : 3500.0

}

}

}Tổng hợp tối thiểu

Tổng hợp này tìm giá trị nhỏ nhất của một trường số cụ thể trong các tài liệu tổng hợp.

POST /schools/_search?size=0

{

"aggs" : {

"min_fees" : { "min" : { "field" : "fees" } }

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"took" : 2,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"min_fees" : {

"value" : 2200.0

}

}

}Tổng hợp

Tập hợp này tính tổng của một trường số cụ thể trong các tài liệu được tổng hợp.

POST /schools/_search?size=0

{

"aggs" : {

"total_fees" : { "sum" : { "field" : "fees" } }

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"took" : 8,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"total_fees" : {

"value" : 5700.0

}

}

}Có một số tổng hợp số liệu khác được sử dụng trong các trường hợp đặc biệt như tổng hợp giới hạn địa lý và tổng hợp trung tâm địa lý cho mục đích xác định vị trí địa lý.

Tổng hợp số liệu thống kê

Tổng hợp chỉ số nhiều giá trị tính toán thống kê trên các giá trị số được trích xuất từ các tài liệu tổng hợp.

POST /schools/_search?size=0

{

"aggs" : {

"grades_stats" : { "stats" : { "field" : "fees" } }

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"took" : 2,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"grades_stats" : {

"count" : 2,

"min" : 2200.0,

"max" : 3500.0,

"avg" : 2850.0,

"sum" : 5700.0

}

}

}Siêu dữ liệu tổng hợp

Bạn có thể thêm một số dữ liệu về tập hợp tại thời điểm được yêu cầu bằng cách sử dụng thẻ meta và có thể lấy dữ liệu đó để phản hồi.

POST /schools/_search?size=0

{

"aggs" : {

"min_fees" : { "avg" : { "field" : "fees" } ,

"meta" :{

"dsc" :"Lowest Fees This Year"

}

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"took" : 0,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"min_fees" : {

"meta" : {

"dsc" : "Lowest Fees This Year"

},

"value" : 2850.0

}

}

}Các API này chịu trách nhiệm quản lý tất cả các khía cạnh của chỉ mục như cài đặt, bí danh, ánh xạ, mẫu chỉ mục.

Tạo chỉ mục

API này giúp bạn tạo chỉ mục. Chỉ mục có thể được tạo tự động khi người dùng chuyển các đối tượng JSON đến bất kỳ chỉ mục nào hoặc nó có thể được tạo trước đó. Để tạo chỉ mục, bạn chỉ cần gửi một yêu cầu PUT với cài đặt, ánh xạ và bí danh hoặc chỉ một yêu cầu đơn giản không có nội dung.

PUT collegesKhi chạy đoạn mã trên, chúng tôi nhận được kết quả như hình dưới đây:

{

"acknowledged" : true,

"shards_acknowledged" : true,

"index" : "colleges"

}Chúng ta cũng có thể thêm một số cài đặt vào lệnh trên -

PUT colleges

{

"settings" : {

"index" : {

"number_of_shards" : 3,

"number_of_replicas" : 2

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả như hình dưới đây:

{

"acknowledged" : true,

"shards_acknowledged" : true,

"index" : "colleges"

}Xóa chỉ mục

API này giúp bạn xóa bất kỳ chỉ mục nào. Bạn chỉ cần chuyển một yêu cầu xóa với tên của Chỉ mục cụ thể đó.

DELETE /collegesBạn có thể xóa tất cả các chỉ số bằng cách sử dụng _all hoặc *.

Nhận chỉ mục

API này có thể được gọi bằng cách chỉ gửi yêu cầu nhận đến một hoặc nhiều chỉ số. Điều này trả về thông tin về chỉ mục.

GET collegesKhi chạy đoạn mã trên, chúng tôi nhận được kết quả như hình dưới đây:

{

"colleges" : {

"aliases" : {

"alias_1" : { },

"alias_2" : {

"filter" : {

"term" : {

"user" : "pkay"

}

},

"index_routing" : "pkay",

"search_routing" : "pkay"

}

},

"mappings" : { },

"settings" : {

"index" : {

"creation_date" : "1556245406616",

"number_of_shards" : "1",

"number_of_replicas" : "1",

"uuid" : "3ExJbdl2R1qDLssIkwDAug",

"version" : {

"created" : "7000099"

},

"provided_name" : "colleges"

}

}

}

}Bạn có thể lấy thông tin của tất cả các chỉ số bằng cách sử dụng _all hoặc *.

Chỉ mục tồn tại

Sự tồn tại của một chỉ mục có thể được xác định bằng cách chỉ gửi một yêu cầu nhận đến chỉ mục đó. Nếu phản hồi HTTP là 200, nó tồn tại; nếu nó là 404, nó không tồn tại.

HEAD collegesKhi chạy đoạn mã trên, chúng tôi nhận được kết quả như hình dưới đây:

200-OKCài đặt chỉ mục

Bạn có thể nhận cài đặt chỉ mục bằng cách thêm từ khóa _settings vào cuối URL.

GET /colleges/_settingsKhi chạy đoạn mã trên, chúng tôi nhận được kết quả như hình dưới đây:

{

"colleges" : {

"settings" : {

"index" : {

"creation_date" : "1556245406616",

"number_of_shards" : "1",

"number_of_replicas" : "1",

"uuid" : "3ExJbdl2R1qDLssIkwDAug",

"version" : {

"created" : "7000099"

},

"provided_name" : "colleges"

}

}

}

}Số liệu thống kê

API này giúp bạn trích xuất số liệu thống kê về một chỉ mục cụ thể. Bạn chỉ cần gửi yêu cầu nhận với URL chỉ mục và từ khóa _stats ở cuối.

GET /_statsKhi chạy đoạn mã trên, chúng tôi nhận được kết quả như hình dưới đây:

………………………………………………

},

"request_cache" : {

"memory_size_in_bytes" : 849,

"evictions" : 0,

"hit_count" : 1171,

"miss_count" : 4

},

"recovery" : {

"current_as_source" : 0,

"current_as_target" : 0,

"throttle_time_in_millis" : 0

}

} ………………………………………………Tuôn ra

Quá trình xóa chỉ mục đảm bảo rằng bất kỳ dữ liệu nào hiện chỉ tồn tại trong nhật ký giao dịch cũng được lưu giữ vĩnh viễn trong Lucene. Điều này làm giảm thời gian khôi phục vì dữ liệu đó không cần được lập chỉ mục lại từ nhật ký giao dịch sau khi Lucene được lập chỉ mục được mở.

POST colleges/_flushKhi chạy đoạn mã trên, chúng tôi nhận được kết quả như hình dưới đây:

{

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

}

}Thông thường, kết quả từ các API Elasticsearch khác nhau được hiển thị ở định dạng JSON. Nhưng JSON không phải lúc nào cũng dễ đọc. Vì vậy, tính năng API mèo có sẵn trong Elasticsearch giúp quản lý việc đưa ra định dạng in kết quả dễ đọc và dễ hiểu hơn. Có nhiều tham số khác nhau được sử dụng trong API cat mà máy chủ có mục đích khác nhau, chẳng hạn - thuật ngữ V làm cho đầu ra dài dòng.

Hãy để chúng tôi tìm hiểu về API mèo chi tiết hơn trong chương này.

Dài dòng

Đầu ra dài dòng cung cấp một màn hình hiển thị đẹp mắt về kết quả của lệnh mèo. Trong ví dụ được đưa ra bên dưới, chúng tôi nhận được chi tiết của các chỉ số khác nhau có trong cụm.

GET /_cat/indices?vKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

yellow open schools RkMyEn2SQ4yUgzT6EQYuAA 1 1 2 1 21.6kb 21.6kb

yellow open index_4_analysis zVmZdM1sTV61YJYrNXf1gg 1 1 0 0 283b 283b

yellow open sensor-2018-01-01 KIrrHwABRB-ilGqTu3OaVQ 1 1 1 0 4.2kb 4.2kb

yellow open colleges 3ExJbdl2R1qDLssIkwDAug 1 1 0 0 283b 283bTiêu đề

Tham số h, còn được gọi là tiêu đề, được sử dụng để chỉ hiển thị các cột được đề cập trong lệnh.

GET /_cat/nodes?h=ip,portKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

127.0.0.1 9300Sắp xếp

Lệnh sắp xếp chấp nhận chuỗi truy vấn có thể sắp xếp bảng theo cột được chỉ định trong truy vấn. Sắp xếp mặc định là tăng dần nhưng điều này có thể được thay đổi bằng cách thêm: desc vào một cột.

Ví dụ dưới đây, đưa ra kết quả của các mẫu được sắp xếp theo thứ tự giảm dần của các mẫu chỉ mục đã phân loại.

GET _cat/templates?v&s=order:desc,index_patternsKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

name index_patterns order version

.triggered_watches [.triggered_watches*] 2147483647

.watch-history-9 [.watcher-history-9*] 2147483647

.watches [.watches*] 2147483647

.kibana_task_manager [.kibana_task_manager] 0 7000099Đếm

Tham số đếm cung cấp số lượng tổng số tài liệu trong toàn bộ cụm.

GET /_cat/count?vKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

epoch timestamp count

1557633536 03:58:56 17809API cụm được sử dụng để lấy thông tin về cụm và các nút của nó và thực hiện các thay đổi trong chúng. Để gọi API này, chúng ta cần chỉ định tên nút, địa chỉ hoặc _local.

GET /_nodes/_localKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

………………………………………………

cluster_name" : "elasticsearch",

"nodes" : {

"FKH-5blYTJmff2rJ_lQOCg" : {

"name" : "ubuntu",

"transport_address" : "127.0.0.1:9300",

"host" : "127.0.0.1",

"ip" : "127.0.0.1",

"version" : "7.0.0",

"build_flavor" : "default",

"build_type" : "tar",

"build_hash" : "b7e28a7",

"total_indexing_buffer" : 106502553,

"roles" : [

"master",

"data",

"ingest"

],

"attributes" : {

………………………………………………Tình trạng cụm

API này được sử dụng để nhận trạng thái về tình trạng của cụm bằng cách thêm từ khóa 'sức khỏe'.

GET /_cluster/healthKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"cluster_name" : "elasticsearch",

"status" : "yellow",

"timed_out" : false,

"number_of_nodes" : 1,

"number_of_data_nodes" : 1,

"active_primary_shards" : 7,

"active_shards" : 7,

"relocating_shards" : 0,

"initializing_shards" : 0,

"unassigned_shards" : 4,

"delayed_unassigned_shards" : 0,

"number_of_pending_tasks" : 0,

"number_of_in_flight_fetch" : 0,

"task_max_waiting_in_queue_millis" : 0,

"active_shards_percent_as_number" : 63.63636363636363

}Trạng thái cụm

API này được sử dụng để nhận thông tin trạng thái về một cụm bằng cách thêm URL từ khóa 'trạng thái'. Thông tin trạng thái chứa phiên bản, nút chính, các nút khác, bảng định tuyến, siêu dữ liệu và các khối.

GET /_cluster/stateKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

………………………………………………

{

"cluster_name" : "elasticsearch",

"cluster_uuid" : "IzKu0OoVTQ6LxqONJnN2eQ",

"version" : 89,

"state_uuid" : "y3BlwvspR1eUQBTo0aBjig",

"master_node" : "FKH-5blYTJmff2rJ_lQOCg",

"blocks" : { },

"nodes" : {

"FKH-5blYTJmff2rJ_lQOCg" : {

"name" : "ubuntu",

"ephemeral_id" : "426kTGpITGixhEzaM-5Qyg",

"transport

}

………………………………………………Thống kê cụm

API này giúp lấy thống kê về cụm bằng cách sử dụng từ khóa 'thống kê'. API này trả về số phân đoạn, kích thước lưu trữ, mức sử dụng bộ nhớ, số lượng nút, vai trò, hệ điều hành và hệ thống tệp.

GET /_cluster/statsKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

………………………………………….

"cluster_name" : "elasticsearch",

"cluster_uuid" : "IzKu0OoVTQ6LxqONJnN2eQ",

"timestamp" : 1556435464704,

"status" : "yellow",

"indices" : {

"count" : 7,

"shards" : {

"total" : 7,

"primaries" : 7,

"replication" : 0.0,

"index" : {

"shards" : {

"min" : 1,

"max" : 1,

"avg" : 1.0

},

"primaries" : {

"min" : 1,

"max" : 1,

"avg" : 1.0

},

"replication" : {

"min" : 0.0,

"max" : 0.0,

"avg" : 0.0

}

………………………………………….Cài đặt cập nhật cụm

API này cho phép bạn cập nhật cài đặt của một cụm bằng cách sử dụng từ khóa 'cài đặt'. Có hai loại cài đặt - liên tục (áp dụng khi khởi động lại) và tạm thời (không tồn tại khi khởi động lại toàn bộ cụm).

Số liệu thống kê về nút

API này được sử dụng để truy xuất số liệu thống kê của một nút khác của cụm. Số liệu thống kê của nút gần giống như cụm.

GET /_nodes/statsKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"_nodes" : {

"total" : 1,

"successful" : 1,

"failed" : 0

},

"cluster_name" : "elasticsearch",

"nodes" : {

"FKH-5blYTJmff2rJ_lQOCg" : {

"timestamp" : 1556437348653,

"name" : "ubuntu",

"transport_address" : "127.0.0.1:9300",

"host" : "127.0.0.1",

"ip" : "127.0.0.1:9300",

"roles" : [

"master",

"data",

"ingest"

],

"attributes" : {

"ml.machine_memory" : "4112797696",

"xpack.installed" : "true",

"ml.max_open_jobs" : "20"

},

………………………………………………………….Nút hot_threads

API này giúp bạn truy xuất thông tin về các luồng nóng hiện tại trên mỗi nút trong cụm.

GET /_nodes/hot_threadsKhi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

:::{ubuntu}{FKH-5blYTJmff2rJ_lQOCg}{426kTGpITGixhEzaM5Qyg}{127.0.0.1}{127.0.0.1:9300}{ml.machine_memory=4112797696,

xpack.installed=true, ml.max_open_jobs=20}

Hot threads at 2019-04-28T07:43:58.265Z, interval=500ms, busiestThreads=3,

ignoreIdleThreads=true:Trong Elasticsearch, tìm kiếm được thực hiện bằng cách sử dụng truy vấn dựa trên JSON. Một truy vấn được tạo thành từ hai mệnh đề -

Leaf Query Clauses - Các mệnh đề này là đối sánh, thuật ngữ hoặc phạm vi, tìm kiếm một giá trị cụ thể trong trường cụ thể.

Compound Query Clauses - Các truy vấn này là sự kết hợp của các mệnh đề truy vấn lá và các truy vấn ghép khác để trích xuất thông tin mong muốn.

Elasticsearch hỗ trợ một số lượng lớn các truy vấn. Một truy vấn bắt đầu bằng một từ khóa truy vấn và sau đó có các điều kiện và bộ lọc bên trong dưới dạng đối tượng JSON. Các loại truy vấn khác nhau đã được mô tả bên dưới.

Khớp tất cả truy vấn

Đây là truy vấn cơ bản nhất; nó trả về tất cả nội dung và với điểm 1,0 cho mọi đối tượng.

POST /schools/_search

{

"query":{

"match_all":{}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được kết quả sau:

{

"took" : 7,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : 1.0,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 1.0,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

},

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 1.0,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

}

}Truy vấn văn bản đầy đủ

Các truy vấn này được sử dụng để tìm kiếm toàn bộ nội dung như một chương hoặc một bài báo. Truy vấn này hoạt động theo trình phân tích được liên kết với chỉ mục hoặc tài liệu cụ thể đó. Trong phần này, chúng ta sẽ thảo luận về các loại truy vấn toàn văn khác nhau.

Khớp truy vấn

Truy vấn này khớp một văn bản hoặc cụm từ với các giá trị của một hoặc nhiều trường.

POST /schools*/_search

{

"query":{

"match" : {

"rating":"4.5"

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"took" : 44,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 0.47000363,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 0.47000363,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

}

}Truy vấn nhiều đối sánh

Truy vấn này khớp với một văn bản hoặc cụm từ với nhiều trường.

POST /schools*/_search

{

"query":{

"multi_match" : {

"query": "paprola",

"fields": [ "city", "state" ]

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"took" : 12,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 0.9808292,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 0.9808292,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

}

]

}

}Truy vấn Chuỗi truy vấn

Truy vấn này sử dụng trình phân tích cú pháp truy vấn và từ khóa query_string.

POST /schools*/_search

{

"query":{

"query_string":{

"query":"beautiful"

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"took" : 60,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

………………………………….Truy vấn cấp độ kỳ hạn

Các truy vấn này chủ yếu xử lý dữ liệu có cấu trúc như số, ngày tháng và enums.

POST /schools*/_search

{

"query":{

"term":{"zip":"176115"}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

……………………………..

hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 0.9808292,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

}

}

]

…………………………………………..Truy vấn phạm vi

Truy vấn này được sử dụng để tìm các đối tượng có giá trị giữa các phạm vi giá trị đã cho. Để làm được điều này, chúng ta cần sử dụng các toán tử như -

- gte - lớn hơn bằng

- gt - lớn hơn

- lte - nhỏ hơn bằng

- lt - nhỏ hơn

Ví dụ, hãy quan sát đoạn mã dưới đây:

POST /schools*/_search

{

"query":{

"range":{

"rating":{

"gte":3.5

}

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"took" : 24,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 1.0,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 1.0,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

}

}Tồn tại các loại truy vấn cấp thuật ngữ khác, chẳng hạn như -

Exists query - Nếu một trường nào đó có giá trị khác rỗng.

Missing query - Điều này hoàn toàn ngược lại với truy vấn tồn tại, truy vấn này tìm kiếm các đối tượng không có trường cụ thể hoặc trường có giá trị null.

Wildcard or regexp query - Truy vấn này sử dụng biểu thức chính quy để tìm các mẫu trong các đối tượng.

Truy vấn phức hợp

Các truy vấn này là tập hợp các truy vấn khác nhau được hợp nhất với nhau bằng cách sử dụng các toán tử Boolean như và, hoặc, không hoặc cho các chỉ số khác nhau hoặc có các lệnh gọi hàm, v.v.

POST /schools/_search

{

"query": {

"bool" : {

"must" : {

"term" : { "state" : "UP" }

},

"filter": {

"term" : { "fees" : "2200" }

},

"minimum_should_match" : 1,

"boost" : 1.0

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"took" : 6,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 0,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

}

}Truy vấn địa lý

Các truy vấn này liên quan đến vị trí địa lý và điểm địa lý. Những truy vấn này giúp tìm ra trường học hoặc bất kỳ đối tượng địa lý nào khác gần bất kỳ vị trí nào. Bạn cần sử dụng kiểu dữ liệu điểm địa lý.

PUT /geo_example

{

"mappings": {

"properties": {

"location": {

"type": "geo_shape"

}

}

}

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{ "acknowledged" : true,

"shards_acknowledged" : true,

"index" : "geo_example"

}Bây giờ chúng ta đăng dữ liệu trong chỉ mục đã tạo ở trên.

POST /geo_example/_doc?refresh

{

"name": "Chapter One, London, UK",

"location": {

"type": "point",

"coordinates": [11.660544, 57.800286]

}

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"took" : 1,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : 1.0,

"hits" : [

"_index" : "geo_example",

"_type" : "_doc",

"_id" : "hASWZ2oBbkdGzVfiXHKD",

"_score" : 1.0,

"_source" : {

"name" : "Chapter One, London, UK",

"location" : {

"type" : "point",

"coordinates" : [

11.660544,

57.800286

]

}

}

}

}Ánh xạ là phác thảo của các tài liệu được lưu trữ trong một chỉ mục. Nó xác định kiểu dữ liệu như geo_point hoặc chuỗi và định dạng của các trường có trong tài liệu và quy tắc để kiểm soát ánh xạ các trường được thêm động.

PUT bankaccountdetails

{

"mappings":{

"properties":{

"name": { "type":"text"}, "date":{ "type":"date"},

"balance":{ "type":"double"}, "liability":{ "type":"double"}

}

}

}Khi chúng tôi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"acknowledged" : true,

"shards_acknowledged" : true,

"index" : "bankaccountdetails"

}Các loại dữ liệu trường

Elasticsearch hỗ trợ một số kiểu dữ liệu khác nhau cho các trường trong tài liệu. Các kiểu dữ liệu được sử dụng để lưu trữ các trường trong Elasticsearch được thảo luận chi tiết tại đây.

Các loại dữ liệu cốt lõi

Đây là các kiểu dữ liệu cơ bản như văn bản, từ khóa, ngày, dài, kép, boolean hoặc ip, được hầu hết các hệ thống hỗ trợ.

Các kiểu dữ liệu phức tạp

Các kiểu dữ liệu này là sự kết hợp của các kiểu dữ liệu cốt lõi. Chúng bao gồm mảng, đối tượng JSON và kiểu dữ liệu lồng nhau. Ví dụ về kiểu dữ liệu lồng nhau được hiển thị bên dưới & dấu trừ

POST /tabletennis/_doc/1

{

"group" : "players",

"user" : [

{

"first" : "dave", "last" : "jones"

},

{

"first" : "kevin", "last" : "morris"

}

]

}Khi chúng tôi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"_index" : "tabletennis",

"_type" : "_doc",

"_id" : "1",

_version" : 2,

"result" : "updated",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 1,

"_primary_term" : 1

}Một mã mẫu khác được hiển thị bên dưới -

POST /accountdetails/_doc/1

{

"from_acc":"7056443341", "to_acc":"7032460534",

"date":"11/1/2016", "amount":10000

}Khi chúng tôi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{ "_index" : "accountdetails",

"_type" : "_doc",

"_id" : "1",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 1,

"_primary_term" : 1

}Chúng ta có thể kiểm tra tài liệu trên bằng cách sử dụng lệnh sau:

GET /accountdetails/_mappings?include_type_name=falseLoại bỏ các loại ánh xạ

Các chỉ số được tạo trong Elasticsearch 7.0.0 trở lên không còn chấp nhận ánh xạ _default_. Các chỉ số được tạo trong 6.x sẽ tiếp tục hoạt động như trước trong Elasticsearch 6.x. Các loại không được chấp nhận trong API phiên bản 7.0.

Khi một truy vấn được xử lý trong một hoạt động tìm kiếm, nội dung trong bất kỳ chỉ mục nào sẽ được phân tích bởi mô-đun phân tích. Mô-đun này bao gồm bộ phân tích, bộ tách sóng, bộ lọc mã thông báo và bộ lọc bộ lọc. Nếu không có bộ phân tích nào được xác định, thì theo mặc định, các bộ phân tích, mã thông báo, bộ lọc và bộ phân tích tích hợp sẽ được đăng ký với mô-đun phân tích.

Trong ví dụ sau, chúng tôi sử dụng máy phân tích chuẩn được sử dụng khi không có máy phân tích nào khác được chỉ định. Nó sẽ phân tích câu dựa trên ngữ pháp và đưa ra các từ được sử dụng trong câu.

POST _analyze

{

"analyzer": "standard",

"text": "Today's weather is beautiful"

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"tokens" : [

{

"token" : "today's",

"start_offset" : 0,

"end_offset" : 7,

"type" : "",

"position" : 0

},

{

"token" : "weather",

"start_offset" : 8,

"end_offset" : 15,

"type" : "",

"position" : 1

},

{

"token" : "is",

"start_offset" : 16,

"end_offset" : 18,

"type" : "",

"position" : 2

},

{

"token" : "beautiful",

"start_offset" : 19,

"end_offset" : 28,

"type" : "",

"position" : 3

}

]

}Cấu hình máy phân tích chuẩn

Chúng tôi có thể định cấu hình bộ phân tích tiêu chuẩn với các thông số khác nhau để nhận được các yêu cầu tùy chỉnh của chúng tôi.

Trong ví dụ sau, chúng tôi định cấu hình trình phân tích tiêu chuẩn để có max_token_length là 5.

Đối với điều này, trước tiên chúng tôi tạo một chỉ mục với trình phân tích có tham số max_length_token.

PUT index_4_analysis

{

"settings": {

"analysis": {

"analyzer": {

"my_english_analyzer": {

"type": "standard",

"max_token_length": 5,

"stopwords": "_english_"

}

}

}

}

}Tiếp theo, chúng tôi áp dụng bộ phân tích với một văn bản như hình dưới đây. Xin lưu ý cách mã thông báo không xuất hiện vì nó có hai dấu cách ở đầu và hai dấu cách ở cuối. Đối với từ “là”, có một khoảng trắng ở đầu và một khoảng trắng ở cuối từ. Lấy tất cả chúng, nó trở thành 4 chữ cái có dấu cách và điều đó không biến nó thành một từ. Ít nhất phải có một ký tự nonspace ở đầu hoặc cuối, để làm cho nó trở thành một từ được đếm.

POST index_4_analysis/_analyze

{

"analyzer": "my_english_analyzer",

"text": "Today's weather is beautiful"

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"tokens" : [

{

"token" : "today",

"start_offset" : 0,

"end_offset" : 5,

"type" : "",

"position" : 0

},

{

"token" : "s",

"start_offset" : 6,

"end_offset" : 7,

"type" : "",

"position" : 1

},

{

"token" : "weath",

"start_offset" : 8,

"end_offset" : 13,

"type" : "",

"position" : 2

},

{

"token" : "er",

"start_offset" : 13,

"end_offset" : 15,

"type" : "",

"position" : 3

},

{

"token" : "beaut",

"start_offset" : 19,

"end_offset" : 24,

"type" : "",

"position" : 5

},

{

"token" : "iful",

"start_offset" : 24,

"end_offset" : 28,

"type" : "",

"position" : 6

}

]

}Danh sách các máy phân tích khác nhau và mô tả của chúng được đưa ra trong bảng dưới đây:

| S.Không | Trình phân tích & Mô tả |

|---|---|

| 1 | Standard analyzer (standard) stopwords và cài đặt max_token_length có thể được đặt cho máy phân tích này. Theo mặc định, danh sách từ dừng trống và max_token_length là 255. |

| 2 | Simple analyzer (simple) Máy phân tích này được cấu tạo bởi tokenizer chữ thường. |

| 3 | Whitespace analyzer (whitespace) Bộ phân tích này bao gồm bộ tách khoảng trắng. |

| 4 | Stop analyzer (stop) stopwords và stopwords_path có thể được định cấu hình. Theo mặc định, các từ dừng được khởi tạo thành các từ dừng tiếng Anh và stopwords_path chứa đường dẫn đến tệp văn bản có các từ dừng. |

Tokenizers

Tokenizers được sử dụng để tạo mã thông báo từ một văn bản trong Elasticsearch. Văn bản có thể được chia thành các mã thông báo bằng cách tính đến khoảng trắng hoặc các dấu câu khác. Elasticsearch có rất nhiều công cụ phân tích mã hóa tích hợp, có thể được sử dụng trong bộ phân tích tùy chỉnh.

Dưới đây là một ví dụ về tokenizer ngắt văn bản thành các thuật ngữ bất cứ khi nào nó gặp một ký tự không phải là chữ cái, nhưng nó cũng viết thường tất cả các thuật ngữ:

POST _analyze

{

"tokenizer": "lowercase",

"text": "It Was a Beautiful Weather 5 Days ago."

}Khi chạy đoạn mã trên, chúng tôi nhận được phản hồi như hình dưới đây:

{

"tokens" : [

{

"token" : "it",

"start_offset" : 0,

"end_offset" : 2,

"type" : "word",

"position" : 0

},

{

"token" : "was",

"start_offset" : 3,

"end_offset" : 6,

"type" : "word",

"position" : 1

},

{

"token" : "a",

"start_offset" : 7,

"end_offset" : 8,

"type" : "word",

"position" : 2

},

{

"token" : "beautiful",

"start_offset" : 9,

"end_offset" : 18,

"type" : "word",

"position" : 3

},

{

"token" : "weather",

"start_offset" : 19,

"end_offset" : 26,

"type" : "word",

"position" : 4

},

{

"token" : "days",

"start_offset" : 29,

"end_offset" : 33,

"type" : "word",

"position" : 5

},

{

"token" : "ago",

"start_offset" : 34,

"end_offset" : 37,

"type" : "word",

"position" : 6

}

]

}Danh sách các Tokenizers và mô tả của chúng được hiển thị ở đây trong bảng dưới đây -

| S.Không | Tokenizer & Mô tả |

|---|---|

| 1 | Standard tokenizer (standard) Điều này được xây dựng dựa trên tokenizer dựa trên ngữ pháp và max_token_length có thể được định cấu hình cho tokenizer này. |

| 2 | Edge NGram tokenizer (edgeNGram) Có thể đặt các cài đặt như min_gram, max_gram, token_chars cho tokenizer này. |

| 3 | Keyword tokenizer (keyword) Điều này tạo ra toàn bộ đầu vào dưới dạng đầu ra và có thể đặt buffer_size cho việc này. |

| 4 | Letter tokenizer (letter) Thao tác này sẽ ghi lại toàn bộ từ cho đến khi gặp một ký tự không phải chữ cái. |

Elasticsearch bao gồm một số mô-đun, chịu trách nhiệm về chức năng của nó. Các mô-đun này có hai loại cài đặt như sau:

Static Settings- Các cài đặt này cần được định cấu hình trong tệp config (asticsearch.yml) trước khi khởi động Elasticsearch. Bạn cần cập nhật tất cả các nút quan tâm trong cụm để phản ánh những thay đổi của các cài đặt này.

Dynamic Settings - Các cài đặt này có thể được đặt trên Elasticsearch trực tiếp.

Chúng ta sẽ thảo luận về các mô-đun khác nhau của Elasticsearch trong các phần sau của chương này.

Định tuyến cấp độ cụm và phân bổ mảnh

Cài đặt cấp độ cụm quyết định việc phân bổ các phân đoạn cho các nút khác nhau và phân bổ lại các phân đoạn để cân bằng lại cụm. Đây là các cài đặt sau để kiểm soát phân bổ phân đoạn.

Phân bổ mảnh cấp độ cụm

| Cài đặt | Giá trị có thể | Sự miêu tả |

|---|---|---|

| cluster.routing.allocation.enable | ||

| tất cả | Giá trị mặc định này cho phép phân bổ phân đoạn cho tất cả các loại phân đoạn. | |

| bầu cử sơ bộ | Điều này chỉ cho phép phân bổ phân đoạn cho các phân đoạn chính. | |

| new_primaries | Điều này chỉ cho phép phân bổ phân đoạn cho các phân đoạn chính cho các chỉ số mới. | |

| không ai | Điều này không cho phép bất kỳ phân bổ phân đoạn nào. | |

| cluster.routing.allocation .node_concurrent_recoveries | Giá trị số (theo mặc định là 2) | Điều này hạn chế số lượng phục hồi phân đoạn đồng thời. |

| cluster.routing.allocation .node_initial_primaries_recoveries | Giá trị số (theo mặc định là 4) | Điều này hạn chế số lần khôi phục chính ban đầu song song. |

| cluster.routing.allocation .same_shard.host | Giá trị boolean (theo mặc định là false) | Điều này hạn chế việc phân bổ nhiều hơn một bản sao của cùng một phân đoạn trong cùng một nút vật lý. |

| indices.recovery.concurrent _streams | Giá trị số (theo mặc định là 3) | Điều này kiểm soát số lượng luồng mạng mở trên mỗi nút tại thời điểm khôi phục phân đoạn từ các phân đoạn ngang hàng. |

| indices.recovery.concurrent _small_file_streams | Giá trị số (theo mặc định là 2) | Điều này kiểm soát số luồng mở trên mỗi nút đối với các tệp nhỏ có kích thước dưới 5mb tại thời điểm khôi phục phân đoạn. |

| cluster.routing.rebalance.enable | ||

| tất cả | Giá trị mặc định này cho phép cân bằng cho tất cả các loại phân đoạn. | |

| bầu cử sơ bộ | Điều này chỉ cho phép cân bằng phân đoạn cho các phân đoạn chính. | |

| bản sao | Điều này cho phép cân bằng phân đoạn chỉ cho các phân đoạn bản sao. | |

| không ai | Điều này không cho phép bất kỳ loại cân bằng phân đoạn nào. | |

| cluster.routing.allocation .allow_rebalance | ||

| luôn luôn | Giá trị mặc định này luôn cho phép cân bằng lại. | |

| indices_primaries _active | Điều này cho phép tái cân bằng khi tất cả các phân đoạn chính trong cụm được phân bổ. | |

| Indices_all_active | Điều này cho phép tái cân bằng khi tất cả các phân đoạn chính và bản sao được phân bổ. | |

| cluster.routing.allocation.cluster _concurrent_rebalance | Giá trị số (theo mặc định là 2) | Điều này hạn chế số lượng cân bằng phân đoạn đồng thời trong cụm. |

| cluster.routing.allocation .balance.shard | Giá trị nổi (theo mặc định là 0,45f) | Điều này xác định hệ số trọng số cho các phân đoạn được phân bổ trên mọi nút. |

| cluster.routing.allocation .balance.index | Giá trị nổi (theo mặc định là 0,55f) | Điều này xác định tỷ lệ số phân đoạn trên mỗi chỉ mục được phân bổ trên một nút cụ thể. |

| cluster.routing.allocation .balance.threshold | Giá trị float không âm (theo mặc định là 1.0f) | Đây là giá trị tối ưu hóa tối thiểu của các hoạt động nên được thực hiện. |

Phân bổ mảnh dựa trên đĩa

| Cài đặt | Giá trị có thể | Sự miêu tả |

|---|---|---|

| cluster.routing.allocation.disk.threshold_enabled | Giá trị Boolean (theo mặc định là true) | Điều này cho phép và vô hiệu hóa trình quyết định phân bổ đĩa. |

| cluster.routing.allocation.disk.watermark.low | Giá trị chuỗi (theo mặc định là 85%) | Điều này biểu thị mức sử dụng tối đa của đĩa; sau thời điểm này, không có phân đoạn nào khác có thể được cấp phát cho đĩa đó. |

| cluster.routing.allocation.disk.watermark.high | Giá trị chuỗi (theo mặc định là 90%) | Điều này biểu thị mức sử dụng tối đa tại thời điểm phân bổ; nếu đạt đến điểm này tại thời điểm phân bổ, thì Elasticsearch sẽ phân bổ phân đoạn đó vào một đĩa khác. |

| cluster.info.update.interval | Giá trị chuỗi (theo mặc định là 30 giây) | Đây là khoảng thời gian giữa các lần kiểm tra việc sử dụng ổ đĩa. |

| cluster.routing.allocation.disk.include_relocations | Giá trị Boolean (theo mặc định là true) | Điều này quyết định xem có nên xem xét các phân đoạn hiện đang được cấp phát hay không trong khi tính toán mức sử dụng đĩa. |

Khám phá

Mô-đun này giúp một cụm phát hiện và duy trì trạng thái của tất cả các nút trong đó. Trạng thái của cụm thay đổi khi một nút được thêm vào hoặc xóa khỏi nó. Cài đặt tên cụm được sử dụng để tạo ra sự khác biệt hợp lý giữa các cụm khác nhau. Có một số mô-đun giúp bạn sử dụng các API được cung cấp bởi các nhà cung cấp đám mây và những mô-đun đó như được cung cấp bên dưới -

- Khám phá Azure

- Khám phá EC2

- Khám phá công cụ máy tính của Google

- Khám phá Zen

Cổng vào

Mô-đun này duy trì trạng thái cụm và dữ liệu phân đoạn trên toàn bộ cụm khởi động lại. Sau đây là các cài đặt tĩnh của mô-đun này:

| Cài đặt | Giá trị có thể | Sự miêu tả |

|---|---|---|

| gateway.emplete_nodes | giá trị số (theo mặc định là 0) | Số lượng nút dự kiến sẽ có trong cụm để khôi phục các phân đoạn cục bộ. |

| gateway.eosystem_master_nodes | giá trị số (theo mặc định là 0) | Số lượng nút chính dự kiến sẽ có trong cụm trước khi bắt đầu khôi phục. |

| gateway.eosystem_data_nodes | giá trị số (theo mặc định là 0) | Số lượng nút dữ liệu dự kiến trong cụm trước khi bắt đầu khôi phục. |

| gateway.recover_ after_time | Giá trị chuỗi (theo mặc định là 5m) | Đây là khoảng thời gian giữa các lần kiểm tra việc sử dụng ổ đĩa. |

| cluster.routing.allocation. disk.include_relocations | Giá trị Boolean (theo mặc định là true) | Điều này chỉ định thời gian mà quá trình khôi phục sẽ đợi để bắt đầu bất kể số lượng nút đã tham gia trong cụm. gateway.recover_ after_nodes |

HTTP

Mô-đun này quản lý giao tiếp giữa máy khách HTTP và các API Elasticsearch. Mô-đun này có thể bị vô hiệu hóa bằng cách thay đổi giá trị của http.enabled thành false.