Parallelität in Python - Kurzanleitung

In diesem Kapitel werden wir das Konzept der Parallelität in Python verstehen und die verschiedenen Threads und Prozesse kennenlernen.

Was ist Parallelität?

Mit einfachen Worten, Parallelität ist das gleichzeitige Auftreten von zwei oder mehr Ereignissen. Parallelität ist ein natürliches Phänomen, da viele Ereignisse gleichzeitig auftreten.

Parallelität ist in Bezug auf die Programmierung, wenn sich zwei Aufgaben bei der Ausführung überschneiden. Durch die gleichzeitige Programmierung kann die Leistung unserer Anwendungen und Softwaresysteme verbessert werden, da wir die Anforderungen gleichzeitig bearbeiten können, anstatt darauf zu warten, dass eine vorherige abgeschlossen wird.

Historischer Rückblick auf die Parallelität

Die folgenden Punkte geben uns einen kurzen historischen Überblick über die Parallelität -

Aus dem Konzept der Eisenbahnen

Parallelität ist eng mit dem Konzept der Eisenbahnen verbunden. Bei den Eisenbahnen mussten mehrere Züge im selben Eisenbahnsystem so umgeschlagen werden, dass jeder Zug sicher ans Ziel kam.

Concurrent Computing im akademischen Bereich

Das Interesse an Parallelität in der Informatik begann mit dem 1965 von Edsger W. Dijkstra veröffentlichten Forschungsbericht. In diesem Artikel identifizierte und löste er das Problem des gegenseitigen Ausschlusses, die Eigenschaft der Parallelitätskontrolle.

Parallelitätsprimitive auf hoher Ebene

In jüngster Zeit erhalten Programmierer aufgrund der Einführung von Parallelitätsprimitiven auf hoher Ebene verbesserte gleichzeitige Lösungen.

Verbesserte Parallelität mit Programmiersprachen

Programmiersprachen wie Golang, Rust und Python von Google haben unglaubliche Entwicklungen in Bereichen gemacht, die uns helfen, bessere gleichzeitige Lösungen zu erhalten.

Was ist Thread & Multithreading?

Threadist die kleinste Ausführungseinheit, die in einem Betriebssystem ausgeführt werden kann. Es ist selbst kein Programm, sondern läuft innerhalb eines Programms. Mit anderen Worten, Threads sind nicht unabhängig voneinander. Jeder Thread teilt den Codeabschnitt, den Datenabschnitt usw. mit anderen Threads. Sie werden auch als Leichtbauprozesse bezeichnet.

Ein Thread besteht aus folgenden Komponenten:

Programmzähler, der aus der Adresse des nächsten ausführbaren Befehls besteht

Stack

Registersatz

Eine eindeutige ID

MultithreadingAuf der anderen Seite ist die Fähigkeit einer CPU, die Verwendung des Betriebssystems durch gleichzeitiges Ausführen mehrerer Threads zu verwalten. Die Hauptidee von Multithreading besteht darin, Parallelität zu erreichen, indem ein Prozess in mehrere Threads aufgeteilt wird. Das Konzept des Multithreading kann anhand des folgenden Beispiels verstanden werden.

Beispiel

Angenommen, wir führen einen bestimmten Prozess aus, bei dem wir MS Word öffnen, um Inhalte einzugeben. Ein Thread wird zum Öffnen von MS Word zugewiesen, und ein anderer Thread wird zum Eingeben von Inhalten benötigt. Und jetzt, wenn wir das vorhandene bearbeiten möchten, wird ein anderer Thread benötigt, um die Bearbeitungsaufgabe zu erledigen und so weiter.

Was ist Prozess & Multiprocessing?

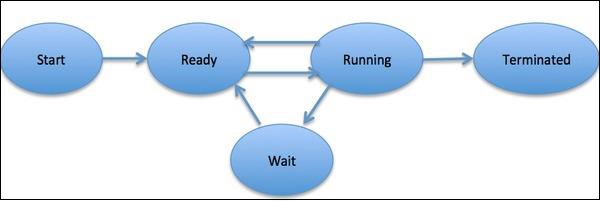

EINprocessist definiert als eine Entität, die die grundlegende Arbeitseinheit darstellt, die im System implementiert werden soll. Einfach ausgedrückt, schreiben wir unsere Computerprogramme in eine Textdatei. Wenn wir dieses Programm ausführen, wird es zu einem Prozess, der alle im Programm genannten Aufgaben ausführt. Während des Prozesslebenszyklus durchläuft es verschiedene Phasen - Start, Bereit, Ausführen, Warten und Beenden.

Das folgende Diagramm zeigt die verschiedenen Phasen eines Prozesses -

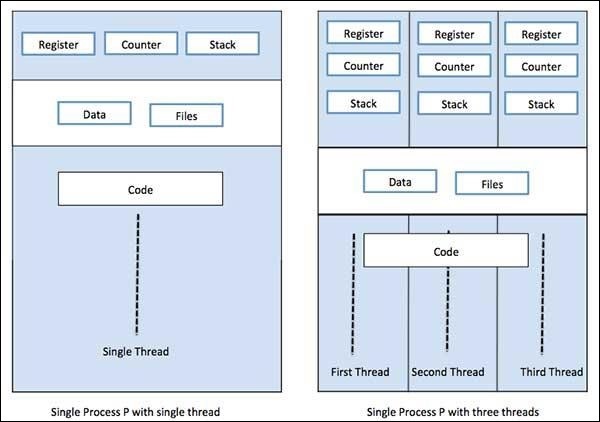

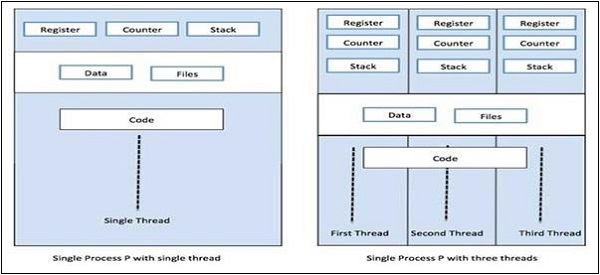

Ein Prozess kann nur einen Thread haben, der als primärer Thread bezeichnet wird, oder mehrere Threads mit einem eigenen Satz von Registern, Programmzählern und Stapeln. Das folgende Diagramm zeigt uns den Unterschied -

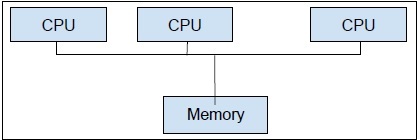

Multiprocessing,Zum anderen werden zwei oder mehr CPU-Einheiten in einem einzigen Computersystem verwendet. Unser primäres Ziel ist es, das volle Potenzial unserer Hardware auszuschöpfen. Um dies zu erreichen, müssen wir die gesamte Anzahl der in unserem Computersystem verfügbaren CPU-Kerne verwenden. Multiprocessing ist der beste Ansatz dafür.

Python ist eine der beliebtesten Programmiersprachen. Im Folgenden sind einige Gründe aufgeführt, die es für gleichzeitige Anwendungen geeignet machen:

Syntethischer Zucker

Syntaktischer Zucker ist eine Syntax innerhalb einer Programmiersprache, die das Lesen oder Ausdrücken erleichtern soll. Es macht die Sprache für den menschlichen Gebrauch „süßer“: Dinge können klarer, präziser oder in einem alternativen Stil ausgedrückt werden, der auf Präferenzen basiert. Python wird mit Magic-Methoden geliefert, die so definiert werden können, dass sie auf Objekte wirken. Diese Magic-Methoden werden als syntaktischer Zucker verwendet und sind an leichter verständliche Schlüsselwörter gebunden.

Große Gemeinschaft

Die Python-Sprache hat eine massive Akzeptanzrate bei Datenwissenschaftlern und Mathematikern erlebt, die auf den Gebieten KI, maschinelles Lernen, tiefes Lernen und quantitative Analyse tätig sind.

Nützliche APIs für die gleichzeitige Programmierung

Python 2 und 3 verfügen über eine große Anzahl von APIs, die für die parallele / gleichzeitige Programmierung vorgesehen sind. Am beliebtesten sind siethreading, concurrent.features, multiprocessing, asyncio, gevent and greenlets, usw.

Einschränkungen von Python bei der Implementierung gleichzeitiger Anwendungen

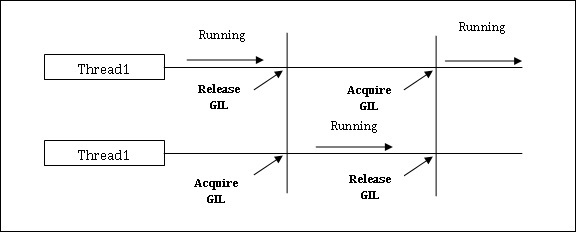

Python hat eine Einschränkung für gleichzeitige Anwendungen. Diese Einschränkung wird aufgerufenGIL (Global Interpreter Lock)ist in Python vorhanden. GIL erlaubt uns niemals, mehrere CPU-Kerne zu verwenden, und daher können wir sagen, dass es in Python keine echten Threads gibt. Wir können das Konzept von GIL wie folgt verstehen:

GIL (Global Interpreter Lock)

Es ist eines der umstrittensten Themen in der Python-Welt. In CPython ist GIL der Mutex - die gegenseitige Ausschlusssperre, die die Thread-Sicherheit erhöht. Mit anderen Worten, wir können sagen, dass GIL verhindert, dass mehrere Threads Python-Code parallel ausführen. Die Sperre kann jeweils nur von einem Thread gehalten werden. Wenn wir einen Thread ausführen möchten, muss er zuerst die Sperre erhalten. Das folgende Diagramm hilft Ihnen, die Funktionsweise von GIL zu verstehen.

Es gibt jedoch einige Bibliotheken und Implementierungen in Python, wie z Numpy, Jpython und IronPytbhon. Diese Bibliotheken funktionieren ohne Interaktion mit GIL.

Sowohl Parallelität als auch Parallelität werden in Bezug auf Multithread-Programme verwendet, aber es gibt viel Verwirrung über die Ähnlichkeit und den Unterschied zwischen ihnen. Die große Frage in dieser Hinsicht: Ist Parallelität Parallelität oder nicht? Obwohl beide Begriffe ziemlich ähnlich erscheinen, aber die Antwort auf die obige Frage NEIN lautet, sind Parallelität und Parallelität nicht gleich. Wenn sie nicht gleich sind, was ist dann der grundlegende Unterschied zwischen ihnen?

In einfachen Worten, bei der Parallelität wird der Zugriff auf den gemeinsam genutzten Status von verschiedenen Threads aus verwaltet, und bei der Parallelität werden mehrere CPUs oder deren Kerne verwendet, um die Leistung der Hardware zu verbessern.

Parallelität im Detail

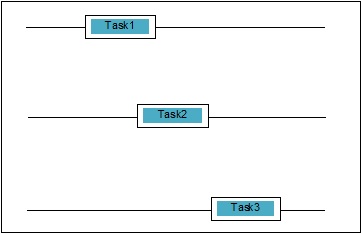

Parallelität ist, wenn sich zwei Aufgaben bei der Ausführung überschneiden. Es kann vorkommen, dass eine Anwendung mehrere Aufgaben gleichzeitig bearbeitet. Wir können es schematisch verstehen; Mehrere Aufgaben machen gleichzeitig Fortschritte:

Parallelitätsstufen

In diesem Abschnitt werden wir die drei wichtigen Ebenen der Parallelität in Bezug auf die Programmierung diskutieren -

Low-Level-Parallelität

In dieser Ebene der Parallelität werden atomare Operationen explizit verwendet. Wir können eine solche Parallelität nicht für die Anwendungserstellung verwenden, da sie sehr fehleranfällig und schwer zu debuggen ist. Selbst Python unterstützt eine solche Parallelität nicht.

Mittlere Parallelität

In dieser Parallelität werden keine expliziten atomaren Operationen verwendet. Es werden die expliziten Sperren verwendet. Python und andere Programmiersprachen unterstützen eine solche Parallelität. Meistens verwenden Anwendungsprogrammierer diese Parallelität.

Parallelität auf hoher Ebene

In dieser Parallelität werden weder explizite atomare Operationen noch explizite Sperren verwendet. Python hatconcurrent.futures Modul zur Unterstützung dieser Art von Parallelität.

Eigenschaften gleichzeitiger Systeme

Damit ein Programm oder ein gleichzeitiges System korrekt ist, müssen einige Eigenschaften erfüllt sein. Eigenschaften im Zusammenhang mit der Beendigung des Systems sind wie folgt:

Korrektheitseigenschaft

Die Korrektheitseigenschaft bedeutet, dass das Programm oder das System die gewünschte richtige Antwort liefern muss. Um es einfach zu halten, können wir sagen, dass das System den Startprogrammstatus korrekt dem Endstatus zuordnen muss.

Sicherheitseigenschaft

Die Sicherheitseigenschaft bedeutet, dass das Programm oder das System in a bleiben muss “good” oder “safe” Zustand und tut nie etwas “bad”.

Lebendigkeitseigenschaft

Diese Eigenschaft bedeutet, dass ein Programm oder System muss “make progress” und es würde einen wünschenswerten Zustand erreichen.

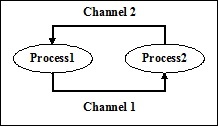

Akteure gleichzeitiger Systeme

Dies ist eine gemeinsame Eigenschaft eines gleichzeitigen Systems, in dem mehrere Prozesse und Threads gleichzeitig ausgeführt werden können, um Fortschritte bei ihren eigenen Aufgaben zu erzielen. Diese Prozesse und Threads werden als Akteure des gleichzeitigen Systems bezeichnet.

Ressourcen gleichzeitiger Systeme

Die Akteure müssen die Ressourcen wie Speicher, Festplatte, Drucker usw. nutzen, um ihre Aufgaben auszuführen.

Bestimmte Regeln

Jedes gleichzeitige System muss über eine Reihe von Regeln verfügen, um die Art der von den Akteuren auszuführenden Aufgaben und den Zeitpunkt für jede Aufgabe zu definieren. Die Aufgaben könnten das Erfassen von Sperren, die gemeinsame Nutzung von Speicher, das Ändern des Status usw. sein.

Barrieren gleichzeitiger Systeme

Weitergabe von Daten

Ein wichtiges Problem bei der Implementierung der gleichzeitigen Systeme ist die gemeinsame Nutzung von Daten zwischen mehreren Threads oder Prozessen. Tatsächlich muss der Programmierer sicherstellen, dass Sperren die gemeinsam genutzten Daten schützen, damit alle Zugriffe darauf serialisiert werden und jeweils nur ein Thread oder Prozess auf die gemeinsam genutzten Daten zugreifen kann. Wenn mehrere Threads oder Prozesse versuchen, auf dieselben gemeinsam genutzten Daten zuzugreifen, werden nicht alle bis auf mindestens einen blockiert und bleiben inaktiv. Mit anderen Worten, wir können sagen, dass wir jeweils nur einen Prozess oder Thread verwenden können, wenn die Sperre in Kraft ist. Es kann einige einfache Lösungen geben, um die oben genannten Hindernisse zu beseitigen -

Einschränkung des Datenaustauschs

Die einfachste Lösung besteht darin, keine veränderlichen Daten gemeinsam zu nutzen. In diesem Fall müssen wir keine explizite Sperrung verwenden, und die Barriere der Parallelität aufgrund gegenseitiger Daten wäre gelöst.

Unterstützung bei der Datenstruktur

Oft müssen die gleichzeitigen Prozesse gleichzeitig auf dieselben Daten zugreifen. Eine andere Lösung als die Verwendung expliziter Sperren besteht darin, eine Datenstruktur zu verwenden, die den gleichzeitigen Zugriff unterstützt. Zum Beispiel können wir die verwendenqueueModul, das thread-sichere Warteschlangen bereitstellt. Wir können auch verwendenmultiprocessing.JoinableQueue Klassen für Multiprozessor-basierte Parallelität.

Unveränderliche Datenübertragung

Manchmal ist die von uns verwendete Datenstruktur, beispielsweise die Parallelitätswarteschlange, nicht geeignet. Dann können wir die unveränderlichen Daten übergeben, ohne sie zu sperren.

Veränderliche Datenübertragung

Nehmen wir in Fortsetzung der obigen Lösung an, wenn nur veränderbare Daten anstatt unveränderlicher Daten übergeben werden müssen, können wir veränderbare Daten übergeben, die schreibgeschützt sind.

Gemeinsame Nutzung von E / A-Ressourcen

Ein weiteres wichtiges Problem bei der Implementierung gleichzeitiger Systeme ist die Verwendung von E / A-Ressourcen durch Threads oder Prozesse. Das Problem tritt auf, wenn ein Thread oder Prozess die E / A so lange verwendet und der andere im Leerlauf sitzt. Wir können eine solche Barriere sehen, wenn wir mit einer E / A-schweren Anwendung arbeiten. Es kann anhand eines Beispiels verstanden werden, wie Seiten vom Webbrowser angefordert werden. Es ist eine schwere Anwendung. Wenn die Rate, mit der die Daten angefordert werden, langsamer ist als die Rate, mit der sie verbraucht werden, haben wir hier eine E / A-Barriere in unserem gleichzeitigen System.

Das folgende Python-Skript dient zum Anfordern einer Webseite und zum Abrufen der Zeit, die unser Netzwerk benötigt hat, um die angeforderte Seite abzurufen.

import urllib.request

import time

ts = time.time()

req = urllib.request.urlopen('http://www.tutorialspoint.com')

pageHtml = req.read()

te = time.time()

print("Page Fetching Time : {} Seconds".format (te-ts))Nach dem Ausführen des obigen Skripts können wir die Zeit zum Abrufen der Seite wie unten gezeigt abrufen.

Ausgabe

Page Fetching Time: 1.0991398811340332 SecondsWir können sehen, dass die Zeit zum Abrufen der Seite mehr als eine Sekunde beträgt. Was ist nun, wenn wir Tausende verschiedener Webseiten abrufen möchten? Sie können verstehen, wie viel Zeit unser Netzwerk in Anspruch nehmen würde.

Was ist Parallelität?

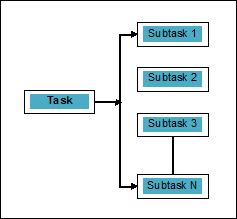

Parallelität kann als die Kunst definiert werden, die Aufgaben in Unteraufgaben aufzuteilen, die gleichzeitig verarbeitet werden können. Es ist entgegengesetzt zu der oben diskutierten Parallelität, bei der zwei oder mehr Ereignisse gleichzeitig stattfinden. Wir können es schematisch verstehen; Eine Aufgabe ist in mehrere Unteraufgaben unterteilt, die wie folgt parallel verarbeitet werden können:

Beachten Sie die folgenden Punkte, um mehr über die Unterscheidung zwischen Parallelität und Parallelität zu erfahren:

Gleichzeitig aber nicht parallel

Eine Anwendung kann gleichzeitig, aber nicht parallel sein. Dies bedeutet, dass sie mehrere Aufgaben gleichzeitig verarbeitet, die Aufgaben jedoch nicht in Unteraufgaben unterteilt sind.

Parallel aber nicht gleichzeitig

Eine Anwendung kann parallel, aber nicht gleichzeitig sein. Dies bedeutet, dass sie jeweils nur für eine Aufgabe ausgeführt wird und die in Unteraufgaben aufgeschlüsselten Aufgaben parallel verarbeitet werden können.

Weder parallel noch gleichzeitig

Eine Anwendung kann weder parallel noch gleichzeitig sein. Dies bedeutet, dass jeweils nur eine Aufgabe bearbeitet wird und die Aufgabe niemals in Unteraufgaben unterteilt wird.

Sowohl parallel als auch gleichzeitig

Eine Anwendung kann sowohl parallel als auch gleichzeitig ausgeführt werden. Dies bedeutet, dass beide Aufgaben gleichzeitig ausgeführt werden und die Aufgabe in Unteraufgaben unterteilt ist, um sie parallel auszuführen.

Notwendigkeit der Parallelität

Wir können Parallelität erreichen, indem wir die Unteraufgaben auf verschiedene Kerne einer einzelnen CPU oder auf mehrere Computer verteilen, die innerhalb eines Netzwerks verbunden sind.

Berücksichtigen Sie die folgenden wichtigen Punkte, um zu verstehen, warum Parallelität erforderlich ist:

Effiziente Codeausführung

Mit Hilfe der Parallelität können wir unseren Code effizient ausführen. Dies spart Zeit, da derselbe Code in Teilen parallel ausgeführt wird.

Schneller als sequentielles Rechnen

Sequentielles Rechnen wird durch physikalische und praktische Faktoren eingeschränkt, aufgrund derer es nicht möglich ist, schnellere Rechenergebnisse zu erzielen. Auf der anderen Seite wird dieses Problem durch paralleles Rechnen gelöst und liefert schnellere Rechenergebnisse als sequentielles Rechnen.

Weniger Ausführungszeit

Die parallele Verarbeitung reduziert die Ausführungszeit des Programmcodes.

Wenn wir über ein reales Beispiel für Parallelität sprechen, ist die Grafikkarte unseres Computers das Beispiel, das die wahre Leistungsfähigkeit der Parallelverarbeitung hervorhebt, da sie Hunderte einzelner Verarbeitungskerne aufweist, die unabhängig voneinander arbeiten und gleichzeitig die Ausführung durchführen können. Aus diesem Grund können wir auch High-End-Anwendungen und Spiele ausführen.

Verständnis der Prozessoren für die Implementierung

Wir kennen Parallelität, Parallelität und den Unterschied zwischen ihnen, aber was ist mit dem System, auf dem es implementiert werden soll? Es ist sehr wichtig, das System zu verstehen, auf dem wir implementieren werden, da es uns den Vorteil gibt, beim Entwerfen der Software fundierte Entscheidungen zu treffen. Wir haben die folgenden zwei Arten von Prozessoren -

Single-Core-Prozessoren

Single-Core-Prozessoren können jeweils einen Thread ausführen. Diese Prozessoren verwendencontext switchingum alle erforderlichen Informationen für einen Thread zu einem bestimmten Zeitpunkt zu speichern und die Informationen später wiederherzustellen. Der Kontextwechselmechanismus hilft uns, innerhalb einer bestimmten Sekunde Fortschritte bei einer Reihe von Threads zu erzielen, und es sieht so aus, als würde das System an mehreren Dingen arbeiten.

Single-Core-Prozessoren bieten viele Vorteile. Diese Prozessoren benötigen weniger Strom und es gibt kein komplexes Kommunikationsprotokoll zwischen mehreren Kernen. Andererseits ist die Geschwindigkeit von Single-Core-Prozessoren begrenzt und für größere Anwendungen nicht geeignet.

Multi-Core-Prozessoren

Mehrkernprozessoren haben mehrere unabhängige Prozessoreinheiten, die auch als solche bezeichnet werden cores.

Solche Prozessoren benötigen keinen Kontextumschaltmechanismus, da jeder Kern alles enthält, was zum Ausführen einer Folge gespeicherter Anweisungen erforderlich ist.

Fetch-Decode-Execute-Zyklus

Die Kerne von Mehrkernprozessoren folgen einem Ausführungszyklus. Dieser Zyklus wird als bezeichnetFetch-Decode-ExecuteZyklus. Es umfasst die folgenden Schritte:

Holen

Dies ist der erste Schritt des Zyklus, bei dem Anweisungen aus dem Programmspeicher abgerufen werden.

Dekodieren

Kürzlich abgerufene Anweisungen würden in eine Reihe von Signalen umgewandelt, die andere Teile der CPU auslösen.

Ausführen

Dies ist der letzte Schritt, in dem die abgerufenen und die decodierten Anweisungen ausgeführt werden. Das Ergebnis der Ausführung wird in einem CPU-Register gespeichert.

Ein Vorteil hierbei ist, dass die Ausführung in Multi-Core-Prozessoren schneller ist als die von Single-Core-Prozessoren. Es ist für größere Anwendungen geeignet. Andererseits ist ein komplexes Kommunikationsprotokoll zwischen mehreren Kernen ein Problem. Mehrere Kerne benötigen mehr Strom als Single-Core-Prozessoren.

Es gibt verschiedene System- und Speicherarchitekturstile, die beim Entwerfen des Programms oder des gleichzeitigen Systems berücksichtigt werden müssen. Dies ist sehr wichtig, da ein System- und Speicherstil für eine Aufgabe geeignet sein kann, für andere Aufgaben jedoch fehleranfällig sein kann.

Computersystemarchitekturen, die Parallelität unterstützen

Michael Flynn gab 1972 Taxonomie für die Kategorisierung verschiedener Stile der Computersystemarchitektur. Diese Taxonomie definiert vier verschiedene Stile wie folgt:

- Einzelbefehlsstrom, Einzeldatenstrom (SISD)

- Einzelbefehlsstrom, Mehrfachdatenstrom (SIMD)

- Mehrfachbefehlsstrom, Einzeldatenstrom (MISD)

- Mehrfachbefehlsstrom, Mehrfachdatenstrom (MIMD).

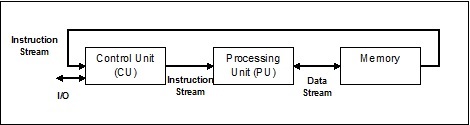

Einzelbefehlsstrom, Einzeldatenstrom (SISD)

Wie der Name schon sagt, würden solche Systeme einen sequentiellen eingehenden Datenstrom und eine einzelne Verarbeitungseinheit haben, um den Datenstrom auszuführen. Sie sind wie Einprozessorsysteme mit paralleler Computerarchitektur. Es folgt die Architektur von SISD -

Vorteile von SISD

Die Vorteile der SISD-Architektur sind folgende:

- Es benötigt weniger Strom.

- Es gibt kein Problem mit komplexen Kommunikationsprotokollen zwischen mehreren Kernen.

Nachteile von SISD

Die Nachteile der SISD-Architektur sind folgende:

- Die Geschwindigkeit der SISD-Architektur ist genau wie bei Single-Core-Prozessoren begrenzt.

- Es ist nicht für größere Anwendungen geeignet.

Einzelbefehlsstrom, Mehrfachdatenstrom (SIMD)

Wie der Name schon sagt, würden solche Systeme mehrere eingehende Datenströme und eine Anzahl von Verarbeitungseinheiten haben, die zu einem bestimmten Zeitpunkt auf einen einzelnen Befehl einwirken können. Sie sind wie Multiprozessorsysteme mit paralleler Computerarchitektur. Es folgt die Architektur von SIMD -

Das beste Beispiel für SIMD sind die Grafikkarten. Diese Karten haben Hunderte von einzelnen Verarbeitungseinheiten. Wenn wir über den Rechenunterschied zwischen SISD und SIMD sprechen, dann für das Hinzufügen von Arrays[5, 15, 20] und [15, 25, 10],Die SISD-Architektur müsste drei verschiedene Addiervorgänge ausführen. Andererseits können wir mit der SIMD-Architektur dann in einem einzigen Addiervorgang hinzufügen.

Vorteile von SIMD

Die Vorteile der SIMD-Architektur sind folgende:

Dieselbe Operation an mehreren Elementen kann nur mit einer Anweisung ausgeführt werden.

Der Durchsatz des Systems kann durch Erhöhen der Anzahl der Kerne des Prozessors erhöht werden.

Die Verarbeitungsgeschwindigkeit ist höher als bei der SISD-Architektur.

Nachteile von SIMD

Die Nachteile der SIMD-Architektur sind folgende:

- Es gibt eine komplexe Kommunikation zwischen der Anzahl der Prozessorkerne.

- Die Kosten sind höher als bei der SISD-Architektur.

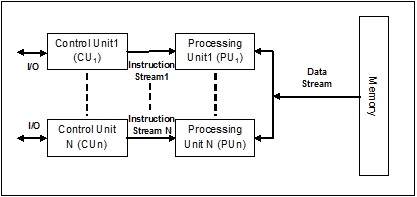

MISD-Stream (Multiple Instruction Single Data)

Systeme mit MISD-Stream haben eine Anzahl von Verarbeitungseinheiten, die unterschiedliche Operationen ausführen, indem sie unterschiedliche Anweisungen für denselben Datensatz ausführen. Es folgt die Architektur von MISD -

Die Vertreter der MISD-Architektur existieren kommerziell noch nicht.

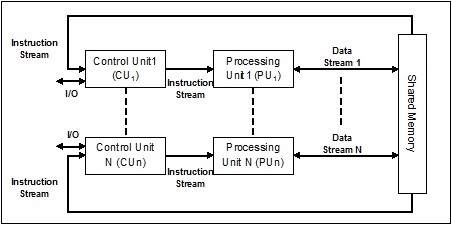

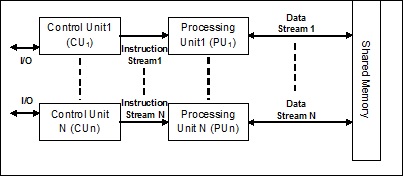

MIMD-Stream (Multiple Instruction Multiple Data)

In dem System, das eine MIMD-Architektur verwendet, kann jeder Prozessor in einem Multiprozessorsystem verschiedene Befehlssätze unabhängig voneinander auf dem unterschiedlichen Datensatz parallel ausführen. Dies steht im Gegensatz zur SIMD-Architektur, bei der eine einzelne Operation für mehrere Datensätze ausgeführt wird. Es folgt die Architektur von MIMD -

Ein normaler Multiprozessor verwendet die MIMD-Architektur. Diese Architekturen werden grundsätzlich in einer Reihe von Anwendungsbereichen verwendet, wie z. B. computergestütztes Design / computergestützte Fertigung, Simulation, Modellierung, Kommunikationsschalter usw.

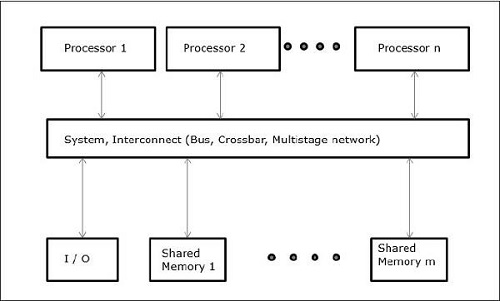

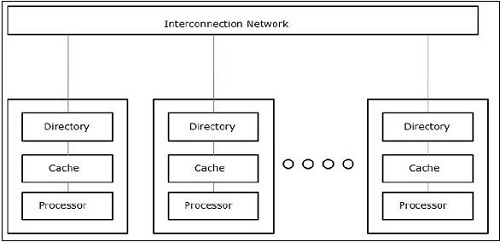

Speicherarchitekturen, die Parallelität unterstützen

Bei der Arbeit mit Konzepten wie Parallelität und Parallelität müssen die Programme immer beschleunigt werden. Eine von Computerdesignern gefundene Lösung besteht darin, Mehrfachcomputer mit gemeinsamem Speicher zu erstellen, dh Computer mit einem einzigen physischen Adressraum, auf den alle Kerne eines Prozessors zugreifen. In diesem Szenario kann es verschiedene Architekturstile geben. Im Folgenden sind die drei wichtigen Architekturstile aufgeführt:

UMA (Uniform Memory Access)

In diesem Modell teilen sich alle Prozessoren den physischen Speicher einheitlich. Alle Prozessoren haben die gleiche Zugriffszeit auf alle Speicherwörter. Jeder Prozessor kann einen privaten Cache-Speicher haben. Die Peripheriegeräte folgen einer Reihe von Regeln.

Wenn alle Prozessoren gleichen Zugriff auf alle Peripheriegeräte haben, wird das System als a bezeichnet symmetric multiprocessor. Wenn nur ein oder wenige Prozessoren auf die Peripheriegeräte zugreifen können, wird das System als bezeichnetasymmetric multiprocessor.

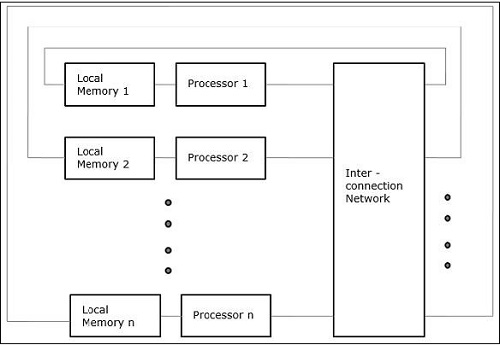

Ungleichmäßiger Speicherzugriff (NUMA)

Im NUMA-Multiprozessormodell variiert die Zugriffszeit mit dem Ort des Speicherworts. Hier wird der gemeinsam genutzte Speicher physisch auf alle Prozessoren verteilt, die als lokale Speicher bezeichnet werden. Die Sammlung aller lokalen Speicher bildet einen globalen Adressraum, auf den alle Prozessoren zugreifen können.

Nur Cache-Speicherarchitektur (COMA)

Das COMA-Modell ist eine spezielle Version des NUMA-Modells. Hier werden alle verteilten Hauptspeicher in Cache-Speicher konvertiert.

Wie wir wissen, ist der Faden im Allgemeinen eine sehr dünne, gedrehte Schnur, die normalerweise aus Baumwoll- oder Seidenstoff besteht und zum Nähen von Kleidung und dergleichen verwendet wird. Der gleiche Begriff Thread wird auch in der Welt der Computerprogrammierung verwendet. Wie hängen wir nun den zum Nähen von Kleidung verwendeten Faden und den für die Computerprogrammierung verwendeten Faden zusammen? Die Rollen der beiden Threads sind hier ähnlich. In der Kleidung halten Sie das Tuch zusammen und auf der anderen Seite halten Sie bei der Computerprogrammierung das Computerprogramm in einem Faden und lassen das Programm aufeinanderfolgende Aktionen oder viele Aktionen gleichzeitig ausführen.

Threadist die kleinste Ausführungseinheit in einem Betriebssystem. Es ist an sich kein Programm, sondern läuft innerhalb eines Programms. Mit anderen Worten, Threads sind nicht unabhängig voneinander und teilen Codeabschnitt, Datenabschnitt usw. mit anderen Threads. Diese Fäden werden auch als leichte Prozesse bezeichnet.

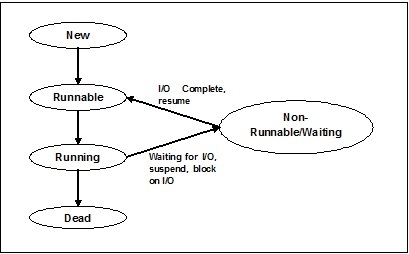

Fadenzustände

Um die Funktionalität von Threads im Detail zu verstehen, müssen wir den Lebenszyklus der Threads oder die verschiedenen Thread-Zustände kennenlernen. Normalerweise kann ein Thread in fünf verschiedenen Zuständen existieren. Die verschiedenen Zustände sind unten gezeigt -

Neues Thema

Ein neuer Thread beginnt seinen Lebenszyklus im neuen Zustand. Zu diesem Zeitpunkt wurde es jedoch noch nicht gestartet und es wurden keine Ressourcen zugewiesen. Wir können sagen, dass es nur eine Instanz eines Objekts ist.

Runnable

Wenn der neugeborene Thread gestartet wird, kann der Thread ausgeführt werden, dh er wartet darauf, ausgeführt zu werden. In diesem Status verfügt es über alle Ressourcen, aber der Taskplaner hat die Ausführung noch nicht geplant.

Laufen

In diesem Zustand macht der Thread Fortschritte und führt die Aufgabe aus, die vom Aufgabenplaner zur Ausführung ausgewählt wurde. Jetzt kann der Thread entweder in den toten Zustand oder in den nicht ausführbaren / wartenden Zustand wechseln.

Nicht laufen / warten

In diesem Zustand wird der Thread angehalten, weil er entweder auf die Antwort einer E / A-Anforderung wartet oder auf den Abschluss der Ausführung eines anderen Threads.

tot

Ein ausführbarer Thread wechselt in den Status "Beendet", wenn er seine Aufgabe abgeschlossen oder auf andere Weise beendet hat.

Das folgende Diagramm zeigt den gesamten Lebenszyklus eines Threads -

Arten von Thread

In diesem Abschnitt sehen wir die verschiedenen Arten von Threads. Die Typen werden unten beschrieben -

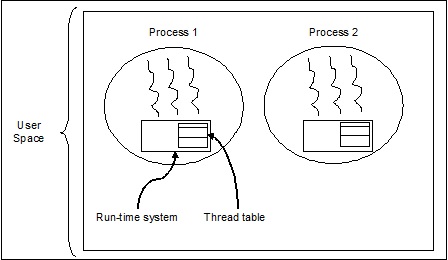

Threads auf Benutzerebene

Dies sind vom Benutzer verwaltete Threads.

In diesem Fall ist dem Thread-Verwaltungskern die Existenz von Threads nicht bekannt. Die Thread-Bibliothek enthält Code zum Erstellen und Zerstören von Threads, zum Weiterleiten von Nachrichten und Daten zwischen Threads, zum Planen der Thread-Ausführung sowie zum Speichern und Wiederherstellen von Thread-Kontexten. Die Anwendung beginnt mit einem einzelnen Thread.

Die Beispiele für Threads auf Benutzerebene sind -

- Java-Threads

- POSIX-Threads

Vorteile von Threads auf Benutzerebene

Im Folgenden sind die verschiedenen Vorteile von Threads auf Benutzerebene aufgeführt:

- Für das Thread-Switching sind keine Berechtigungen für den Kernel-Modus erforderlich.

- Thread auf Benutzerebene kann auf jedem Betriebssystem ausgeführt werden.

- Die Planung kann im Thread auf Benutzerebene anwendungsspezifisch sein.

- Threads auf Benutzerebene lassen sich schnell erstellen und verwalten.

Nachteile von Threads auf Benutzerebene

Im Folgenden sind die verschiedenen Nachteile von Threads auf Benutzerebene aufgeführt:

- In einem typischen Betriebssystem werden die meisten Systemaufrufe blockiert.

- Multithread-Anwendungen können Multiprocessing nicht nutzen.

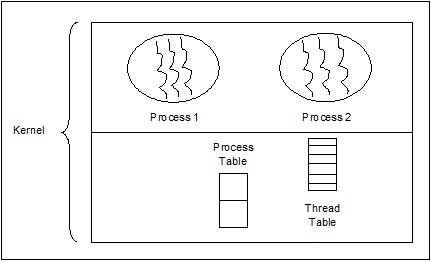

Threads auf Kernebene

Vom Betriebssystem verwaltete Threads wirken auf den Kernel, der ein Betriebssystemkern ist.

In diesem Fall führt der Kernel die Thread-Verwaltung durch. Im Anwendungsbereich befindet sich kein Thread-Verwaltungscode. Kernel-Threads werden direkt vom Betriebssystem unterstützt. Jede Anwendung kann für Multithreading programmiert werden. Alle Threads in einer Anwendung werden in einem einzigen Prozess unterstützt.

Der Kernel verwaltet Kontextinformationen für den gesamten Prozess und für einzelne Threads innerhalb des Prozesses. Die Planung durch den Kernel erfolgt auf Thread-Basis. Der Kernel führt die Thread-Erstellung, -Planung und -Verwaltung im Kernelbereich durch. Kernel-Threads sind im Allgemeinen langsamer zu erstellen und zu verwalten als die Benutzer-Threads. Beispiele für Threads auf Kernelebene sind Windows und Solaris.

Vorteile von Threads auf Kernel-Ebene

Im Folgenden sind die verschiedenen Vorteile von Threads auf Kernelebene aufgeführt:

Der Kernel kann mehrere Threads aus demselben Prozess gleichzeitig für mehrere Prozesse planen.

Wenn ein Thread in einem Prozess blockiert ist, kann der Kernel einen anderen Thread desselben Prozesses planen.

Kernel-Routinen selbst können Multithread-fähig sein.

Nachteile von Threads auf Kernel-Ebene

Kernel-Threads sind im Allgemeinen langsamer zu erstellen und zu verwalten als die Benutzer-Threads.

Die Übertragung der Kontrolle von einem Thread auf einen anderen innerhalb desselben Prozesses erfordert einen Moduswechsel zum Kernel.

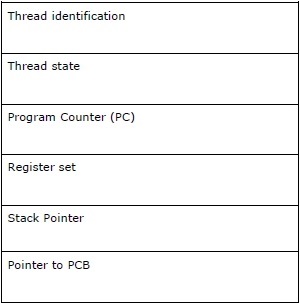

Thread Control Block - TCB

Thread Control Block (TCB) kann als Datenstruktur im Kernel des Betriebssystems definiert werden, die hauptsächlich Informationen zum Thread enthält. In TCB gespeicherte threadspezifische Informationen würden einige wichtige Informationen zu jedem Prozess hervorheben.

Beachten Sie die folgenden Punkte in Bezug auf die in TCB enthaltenen Threads:

Thread identification - Dies ist die eindeutige Thread-ID (tid), die jedem neuen Thread zugewiesen wird.

Thread state - Es enthält Informationen zum Status (Running, Runnable, Non-Running, Dead) des Threads.

Program Counter (PC) - Es zeigt auf die aktuelle Programmanweisung des Threads.

Register set - Es enthält die Registerwerte des Threads, die ihnen für Berechnungen zugewiesen wurden.

Stack Pointer- Es zeigt auf den Stapel des Threads im Prozess. Es enthält die lokalen Variablen im Bereich des Threads.

Pointer to PCB - Es enthält den Zeiger auf den Prozess, der diesen Thread erstellt hat.

Beziehung zwischen Prozess & Thread

Beim Multithreading sind Prozess und Thread zwei sehr eng verwandte Begriffe mit dem gleichen Ziel, dass der Computer mehr als eine Sache gleichzeitig ausführen kann. Ein Prozess kann einen oder mehrere Threads enthalten, im Gegenteil, Thread kann keinen Prozess enthalten. Beide bleiben jedoch die beiden grundlegenden Ausführungseinheiten. Ein Programm, das eine Reihe von Anweisungen ausführt, initiiert sowohl den Prozess als auch den Thread.

Die folgende Tabelle zeigt den Vergleich zwischen Prozess und Thread -

| Prozess | Faden |

|---|---|

| Der Prozess ist schwer oder ressourcenintensiv. | Thread ist leichtgewichtig und benötigt weniger Ressourcen als ein Prozess. |

| Prozessumschaltung erfordert Interaktion mit dem Betriebssystem. | Thread-Switching muss nicht mit dem Betriebssystem interagieren. |

| In mehreren Verarbeitungsumgebungen führt jeder Prozess denselben Code aus, verfügt jedoch über eigene Speicher- und Dateiressourcen. | Alle Threads können denselben Satz offener Dateien und untergeordneter Prozesse gemeinsam nutzen. |

| Wenn ein Prozess blockiert ist, kann kein anderer Prozess ausgeführt werden, bis der erste Prozess entsperrt ist. | Während ein Thread blockiert ist und wartet, kann ein zweiter Thread in derselben Task ausgeführt werden. |

| Mehrere Prozesse ohne Verwendung von Threads verbrauchen mehr Ressourcen. | Prozesse mit mehreren Threads verbrauchen weniger Ressourcen. |

| In mehreren Prozessen arbeitet jeder Prozess unabhängig von den anderen. | Ein Thread kann die Daten eines anderen Threads lesen, schreiben oder ändern. |

| Wenn sich der übergeordnete Prozess ändert, hat dies keine Auswirkungen auf die untergeordneten Prozesse. | Wenn sich im Hauptthread etwas ändert, kann dies das Verhalten anderer Threads dieses Prozesses beeinflussen. |

| Um mit Geschwisterprozessen zu kommunizieren, müssen Prozesse prozessübergreifende Kommunikation verwenden. | Threads können direkt mit anderen Threads dieses Prozesses kommunizieren. |

Konzept des Multithreading

Wie bereits erwähnt, ist Multithreading die Fähigkeit einer CPU, die Verwendung des Betriebssystems durch gleichzeitiges Ausführen mehrerer Threads zu verwalten. Die Hauptidee von Multithreading besteht darin, Parallelität zu erreichen, indem ein Prozess in mehrere Threads aufgeteilt wird. Einfacher ausgedrückt können wir sagen, dass Multithreading der Weg ist, um Multitasking mithilfe des Thread-Konzepts zu erreichen.

Das Konzept des Multithreading kann anhand des folgenden Beispiels verstanden werden.

Beispiel

Angenommen, wir führen einen Prozess aus. Der Prozess könnte darin bestehen, MS Word zum Schreiben von etwas zu öffnen. In einem solchen Prozess wird ein Thread zum Öffnen von MS Word zugewiesen und ein anderer Thread wird zum Schreiben benötigt. Angenommen, wir möchten etwas bearbeiten, dann ist ein anderer Thread erforderlich, um die Bearbeitungsaufgabe usw. auszuführen.

Das folgende Diagramm hilft uns zu verstehen, wie mehrere Threads im Speicher vorhanden sind -

Wir können im obigen Diagramm sehen, dass mehr als ein Thread innerhalb eines Prozesses existieren kann, wobei jeder Thread seinen eigenen Registersatz und lokale Variablen enthält. Ansonsten teilen sich alle Threads in einem Prozess globale Variablen.

Vorteile des Multithreading

Lassen Sie uns nun einige Vorteile des Multithreading sehen. Die Vorteile sind wie folgt:

Speed of communication - Multithreading verbessert die Rechengeschwindigkeit, da jeder Kern oder Prozessor gleichzeitig separate Threads verarbeitet.

Program remains responsive - Ein Programm kann so reagieren, dass ein Thread auf die Eingabe wartet und ein anderer gleichzeitig eine GUI ausführt.

Access to global variables - Beim Multithreading können alle Threads eines bestimmten Prozesses auf die globalen Variablen zugreifen. Wenn sich die globale Variable ändert, ist sie auch für andere Threads sichtbar.

Utilization of resources - Das Ausführen mehrerer Threads in jedem Programm nutzt die CPU besser aus und die Leerlaufzeit der CPU wird kürzer.

Sharing of data - Es ist kein zusätzlicher Speicherplatz für jeden Thread erforderlich, da Threads innerhalb eines Programms dieselben Daten gemeinsam nutzen können.

Nachteile von Multithreading

Lassen Sie uns nun einige Nachteile des Multithreading sehen. Die Nachteile sind wie folgt:

Not suitable for single processor system - Beim Multithreading ist es schwierig, eine Leistung in Bezug auf die Rechengeschwindigkeit auf einem Einzelprozessorsystem im Vergleich zur Leistung auf einem Multiprozessorsystem zu erzielen.

Issue of security - Da wir wissen, dass alle Threads in einem Programm dieselben Daten gemeinsam haben, besteht immer ein Sicherheitsproblem, da jeder unbekannte Thread die Daten ändern kann.

Increase in complexity - Multithreading kann die Komplexität des Programms erhöhen und das Debuggen wird schwierig.

Lead to deadlock state - Multithreading kann das Programm zu einem potenziellen Risiko führen, den Deadlock-Status zu erreichen.

Synchronization required- Eine Synchronisierung ist erforderlich, um einen gegenseitigen Ausschluss zu vermeiden. Dies führt zu mehr Speicher- und CPU-Auslastung.

In diesem Kapitel erfahren Sie, wie Sie Threads in Python implementieren.

Python-Modul für die Thread-Implementierung

Python-Threads werden manchmal als einfache Prozesse bezeichnet, da Threads viel weniger Speicher belegen als Prozesse. Mit Threads können mehrere Aufgaben gleichzeitig ausgeführt werden. In Python haben wir die folgenden zwei Module, die Threads in einem Programm implementieren:

<_thread>module

<threading>module

Der Hauptunterschied zwischen diesen beiden Modulen besteht darin, dass <_thread> Modul behandelt einen Thread als Funktion, während das <threading>Das Modul behandelt jeden Thread als Objekt und implementiert ihn objektorientiert. Darüber hinaus ist die<_thread>Modul ist effektiv in Low-Level-Threading und hat weniger Funktionen als das <threading> Modul.

Modul <_Thread>

In der früheren Version von Python hatten wir die <thread>Modul, aber es wurde für eine ziemlich lange Zeit als "veraltet" angesehen. Benutzer wurden aufgefordert, die zu verwenden<threading>Modul stattdessen. Daher ist in Python 3 das Modul "Thread" nicht mehr verfügbar. Es wurde umbenannt in "<_thread>"für Abwärtsinkompatibilitäten in Python3.

Um einen neuen Thread mit Hilfe des zu generieren <_thread> Modul müssen wir das aufrufen start_new_threadMethode davon. Die Funktionsweise dieser Methode kann mit Hilfe der folgenden Syntax verstanden werden:

_thread.start_new_thread ( function, args[, kwargs] )Hier -

args ist ein Tupel von Argumenten

kwargs ist ein optionales Wörterbuch mit Schlüsselwortargumenten

Wenn wir die Funktion aufrufen möchten, ohne ein Argument zu übergeben, müssen wir ein leeres Tupel von Argumenten in verwenden args.

Dieser Methodenaufruf wird sofort zurückgegeben, der untergeordnete Thread wird gestartet und die Funktion mit der übergebenen Liste von Argumenten (falls vorhanden) aufgerufen. Der Thread wird beendet, sobald die Funktion zurückgegeben wird.

Beispiel

Im Folgenden finden Sie ein Beispiel zum Generieren eines neuen Threads mithilfe von <_thread>Modul. Wir verwenden hier die Methode start_new_thread ().

import _thread

import time

def print_time( threadName, delay):

count = 0

while count < 5:

time.sleep(delay)

count += 1

print ("%s: %s" % ( threadName, time.ctime(time.time()) ))

try:

_thread.start_new_thread( print_time, ("Thread-1", 2, ) )

_thread.start_new_thread( print_time, ("Thread-2", 4, ) )

except:

print ("Error: unable to start thread")

while 1:

passAusgabe

Die folgende Ausgabe hilft uns, die Erzeugung neuer Threads mithilfe von zu verstehen <_thread> Modul.

Thread-1: Mon Apr 23 10:03:33 2018

Thread-2: Mon Apr 23 10:03:35 2018

Thread-1: Mon Apr 23 10:03:35 2018

Thread-1: Mon Apr 23 10:03:37 2018

Thread-2: Mon Apr 23 10:03:39 2018

Thread-1: Mon Apr 23 10:03:39 2018

Thread-1: Mon Apr 23 10:03:41 2018

Thread-2: Mon Apr 23 10:03:43 2018

Thread-2: Mon Apr 23 10:03:47 2018

Thread-2: Mon Apr 23 10:03:51 2018<Threading> -Modul

Das <threading>Das Modul wird objektorientiert implementiert und behandelt jeden Thread als Objekt. Daher bietet es eine viel leistungsfähigere Unterstützung für Threads auf hoher Ebene als das Modul <_thread>. Dieses Modul ist in Python 2.4 enthalten.

Zusätzliche Methoden im Modul <threading>

Das <threading> Modul umfasst alle Methoden der <_thread>Modul, bietet aber auch zusätzliche Methoden. Die zusätzlichen Methoden sind wie folgt:

threading.activeCount() - Diese Methode gibt die Anzahl der aktiven Thread-Objekte zurück

threading.currentThread() - Diese Methode gibt die Anzahl der Thread-Objekte im Thread-Steuerelement des Aufrufers zurück.

threading.enumerate() - Diese Methode gibt eine Liste aller aktuell aktiven Thread-Objekte zurück.

run() - Die run () -Methode ist der Einstiegspunkt für einen Thread.

start() - Die Methode start () startet einen Thread durch Aufrufen der Methode run.

join([time]) - Join () wartet auf das Beenden von Threads.

isAlive() - Die Methode isAlive () prüft, ob noch ein Thread ausgeführt wird.

getName() - Die Methode getName () gibt den Namen eines Threads zurück.

setName() - Die Methode setName () legt den Namen eines Threads fest.

Für die Implementierung von Threading wird die <threading> Modul hat die Thread Klasse, die die folgenden Methoden bereitstellt -

Wie erstelle ich Threads mit dem Modul <threading>?

In diesem Abschnitt erfahren Sie, wie Sie mithilfe von Threads erstellen <threading>Modul. Führen Sie die folgenden Schritte aus, um mit dem Modul <threading> einen neuen Thread zu erstellen.

Step 1 - In diesem Schritt müssen wir eine neue Unterklasse der definieren Thread Klasse.

Step 2 - Um zusätzliche Argumente hinzuzufügen, müssen wir das überschreiben __init__(self [,args]) Methode.

Step 3 - In diesem Schritt müssen wir die Methode run (self [, args]) überschreiben, um zu implementieren, was der Thread beim Starten tun soll.

Jetzt nach dem Erstellen der neuen Thread Unterklasse können wir eine Instanz davon erstellen und dann einen neuen Thread starten, indem wir die aufrufen start(), was wiederum die nennt run() Methode.

Beispiel

In diesem Beispiel erfahren Sie, wie Sie mithilfe von einen neuen Thread generieren <threading> Modul.

import threading

import time

exitFlag = 0

class myThread (threading.Thread):

def __init__(self, threadID, name, counter):

threading.Thread.__init__(self)

self.threadID = threadID

self.name = name

self.counter = counter

def run(self):

print ("Starting " + self.name)

print_time(self.name, self.counter, 5)

print ("Exiting " + self.name)

def print_time(threadName, delay, counter):

while counter:

if exitFlag:

threadName.exit()

time.sleep(delay)

print ("%s: %s" % (threadName, time.ctime(time.time())))

counter -= 1

thread1 = myThread(1, "Thread-1", 1)

thread2 = myThread(2, "Thread-2", 2)

thread1.start()

thread2.start()

thread1.join()

thread2.join()

print ("Exiting Main Thread")

Starting Thread-1

Starting Thread-2Ausgabe

Betrachten Sie nun die folgende Ausgabe:

Thread-1: Mon Apr 23 10:52:09 2018

Thread-1: Mon Apr 23 10:52:10 2018

Thread-2: Mon Apr 23 10:52:10 2018

Thread-1: Mon Apr 23 10:52:11 2018

Thread-1: Mon Apr 23 10:52:12 2018

Thread-2: Mon Apr 23 10:52:12 2018

Thread-1: Mon Apr 23 10:52:13 2018

Exiting Thread-1

Thread-2: Mon Apr 23 10:52:14 2018

Thread-2: Mon Apr 23 10:52:16 2018

Thread-2: Mon Apr 23 10:52:18 2018

Exiting Thread-2

Exiting Main ThreadPython-Programm für verschiedene Thread-Zustände

Es gibt fünf Thread-Zustände - neu, lauffähig, laufend, wartend und tot. Unter diesen fünf werden wir uns hauptsächlich auf drei Staaten konzentrieren - Laufen, Warten und Tot. Ein Thread erhält seine Ressourcen im laufenden Zustand und wartet auf die Ressourcen im wartenden Zustand. Die endgültige Freigabe der Ressource befindet sich, wenn sie ausgeführt und erworben wurde, im toten Zustand.

Das folgende Python-Programm zeigt mit Hilfe der Methoden start (), sleep () und join (), wie ein Thread im laufenden, wartenden und toten Zustand eingegeben wurde.

Step 1 - Importieren Sie die erforderlichen Module <Threading> und <Zeit>

import threading

import timeStep 2 - Definieren Sie eine Funktion, die beim Erstellen eines Threads aufgerufen wird.

def thread_states():

print("Thread entered in running state")Step 3 - Wir verwenden das Modul sleep () des Zeitmoduls, um unseren Thread etwa 2 Sekunden warten zu lassen.

time.sleep(2)Step 4 - Jetzt erstellen wir einen Thread mit dem Namen T1, der das Argument der oben definierten Funktion übernimmt.

T1 = threading.Thread(target=thread_states)Step 5- Jetzt können wir mit Hilfe der Funktion start () unseren Thread starten. Es wird die Nachricht erzeugt, die von uns bei der Definition der Funktion festgelegt wurde.

T1.start()

Thread entered in running stateStep 6 - Jetzt können wir den Thread endlich mit der join () -Methode beenden, nachdem er seine Ausführung abgeschlossen hat.

T1.join()Starten eines Threads in Python

In Python können wir einen neuen Thread auf verschiedene Arten starten. Am einfachsten ist es jedoch, ihn als einzelne Funktion zu definieren. Nachdem wir die Funktion definiert haben, können wir diese als Ziel für eine neue übergebenthreading.ThreadObjekt und so weiter. Führen Sie den folgenden Python-Code aus, um zu verstehen, wie die Funktion funktioniert:

import threading

import time

import random

def Thread_execution(i):

print("Execution of Thread {} started\n".format(i))

sleepTime = random.randint(1,4)

time.sleep(sleepTime)

print("Execution of Thread {} finished".format(i))

for i in range(4):

thread = threading.Thread(target=Thread_execution, args=(i,))

thread.start()

print("Active Threads:" , threading.enumerate())Ausgabe

Execution of Thread 0 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>]

Execution of Thread 1 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>,

<Thread(Thread-3577, started 3080)>]

Execution of Thread 2 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>,

<Thread(Thread-3577, started 3080)>,

<Thread(Thread-3578, started 2268)>]

Execution of Thread 3 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>,

<Thread(Thread-3577, started 3080)>,

<Thread(Thread-3578, started 2268)>,

<Thread(Thread-3579, started 4520)>]

Execution of Thread 0 finished

Execution of Thread 1 finished

Execution of Thread 2 finished

Execution of Thread 3 finishedDaemon-Threads in Python

Bevor Sie die Daemon-Threads in Python implementieren, müssen Sie sich mit Daemon-Threads und ihrer Verwendung vertraut machen. In Bezug auf die Datenverarbeitung ist Daemon ein Hintergrundprozess, der die Anforderungen für verschiedene Dienste wie Datenübertragung, Dateiübertragung usw. verarbeitet. Es wäre ruhend, wenn es nicht mehr benötigt wird. Dieselbe Aufgabe kann auch mit Hilfe von Nicht-Daemon-Threads ausgeführt werden. In diesem Fall muss der Hauptthread die Nicht-Daemon-Threads jedoch manuell verfolgen. Wenn wir dagegen Daemon-Threads verwenden, kann der Haupt-Thread dies vollständig vergessen und wird beendet, wenn der Haupt-Thread beendet wird. Ein weiterer wichtiger Punkt bei Daemon-Threads ist, dass wir sie nur für nicht wesentliche Aufgaben verwenden können, die uns nicht betreffen würden, wenn sie nicht abgeschlossen werden oder dazwischen beendet werden. Es folgt die Implementierung von Daemon-Threads in Python -

import threading

import time

def nondaemonThread():

print("starting my thread")

time.sleep(8)

print("ending my thread")

def daemonThread():

while True:

print("Hello")

time.sleep(2)

if __name__ == '__main__':

nondaemonThread = threading.Thread(target = nondaemonThread)

daemonThread = threading.Thread(target = daemonThread)

daemonThread.setDaemon(True)

daemonThread.start()

nondaemonThread.start()Im obigen Code gibt es nämlich zwei Funktionen >nondaemonThread() und >daemonThread(). Die erste Funktion druckt ihren Status und schläft nach 8 Sekunden, während die Funktion deamonThread () alle 2 Sekunden auf unbestimmte Zeit Hallo druckt. Wir können den Unterschied zwischen Nondaemon- und Daemon-Threads anhand der folgenden Ausgabe verstehen:

Hello

starting my thread

Hello

Hello

Hello

Hello

ending my thread

Hello

Hello

Hello

Hello

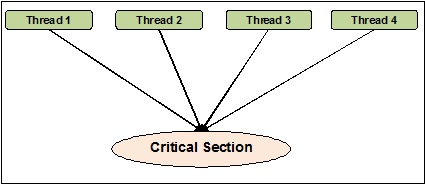

HelloDie Thread-Synchronisation kann als eine Methode definiert werden, mit deren Hilfe sichergestellt werden kann, dass zwei oder mehr gleichzeitige Threads nicht gleichzeitig auf das als kritischer Abschnitt bekannte Programmsegment zugreifen. Andererseits ist, wie wir wissen, dieser kritische Abschnitt der Teil des Programms, auf den auf die gemeinsam genutzte Ressource zugegriffen wird. Daher können wir sagen, dass bei der Synchronisierung sichergestellt wird, dass zwei oder mehr Threads nicht miteinander verbunden sind, indem gleichzeitig auf die Ressourcen zugegriffen wird. Das folgende Diagramm zeigt, dass vier Threads gleichzeitig versuchen, auf den kritischen Abschnitt eines Programms zuzugreifen.

Nehmen wir zur Verdeutlichung an, dass zwei oder mehr Threads gleichzeitig versuchen, das Objekt zur Liste hinzuzufügen. Dieser Vorgang kann nicht zu einem erfolgreichen Ende führen, da entweder ein oder alle Objekte gelöscht werden oder der Status der Liste vollständig beschädigt wird. Hier besteht die Rolle der Synchronisation darin, dass jeweils nur ein Thread auf die Liste zugreifen kann.

Probleme bei der Thread-Synchronisation

Beim Implementieren der gleichzeitigen Programmierung oder beim Anwenden synchronisierender Grundelemente können Probleme auftreten. In diesem Abschnitt werden wir zwei Hauptthemen diskutieren. Die Probleme sind -

- Deadlock

- Rennbedingung

Rennbedingung

Dies ist eines der Hauptprobleme bei der gleichzeitigen Programmierung. Der gleichzeitige Zugriff auf gemeinsam genutzte Ressourcen kann zu Rennbedingungen führen. Eine Race-Bedingung kann als das Auftreten einer Bedingung definiert werden, wenn zwei oder mehr Threads auf gemeinsam genutzte Daten zugreifen und dann versuchen können, ihren Wert gleichzeitig zu ändern. Aus diesem Grund können die Werte von Variablen unvorhersehbar sein und abhängig von den Zeitpunkten der Kontextwechsel der Prozesse variieren.

Beispiel

Betrachten Sie dieses Beispiel, um das Konzept der Rennbedingungen zu verstehen -

Step 1 - In diesem Schritt müssen wir das Threading-Modul importieren -

import threadingStep 2 - Definieren Sie nun eine globale Variable, z. B. x, zusammen mit ihrem Wert als 0 -

x = 0Step 3 - Jetzt müssen wir das definieren increment_global() Funktion, die in dieser globalen Funktion das Inkrement um 1 ausführt x -

def increment_global():

global x

x += 1Step 4 - In diesem Schritt definieren wir die taskofThread()Funktion, die die Funktion increment_global () für eine bestimmte Anzahl von Malen aufruft; für unser Beispiel ist es 50000 mal -

def taskofThread():

for _ in range(50000):

increment_global()Step 5- Definieren Sie nun die main () - Funktion, in der die Threads t1 und t2 erstellt werden. Beide werden mit Hilfe der Funktion start () gestartet und warten, bis sie ihre Arbeit mit Hilfe der Funktion join () beendet haben.

def main():

global x

x = 0

t1 = threading.Thread(target= taskofThread)

t2 = threading.Thread(target= taskofThread)

t1.start()

t2.start()

t1.join()

t2.join()Step 6- Nun müssen wir den Bereich angeben, in dem angegeben wird, wie viele Iterationen wir die main () - Funktion aufrufen möchten. Hier rufen wir es 5 mal an.

if __name__ == "__main__":

for i in range(5):

main()

print("x = {1} after Iteration {0}".format(i,x))In der unten gezeigten Ausgabe können wir den Effekt der Rennbedingung als den Wert von x sehen, nachdem jede Iteration 100000 erwartet wird. Es gibt jedoch viele Variationen im Wert. Dies ist auf den gleichzeitigen Zugriff von Threads auf die gemeinsam genutzte globale Variable x zurückzuführen.

Ausgabe

x = 100000 after Iteration 0

x = 54034 after Iteration 1

x = 80230 after Iteration 2

x = 93602 after Iteration 3

x = 93289 after Iteration 4Umgang mit Rennbedingungen mit Schlössern

Da wir die Auswirkung der Race-Bedingung im obigen Programm gesehen haben, benötigen wir ein Synchronisationstool, das die Race-Bedingung zwischen mehreren Threads verarbeiten kann. In Python ist die<threading>Das Modul bietet eine Lock-Klasse für den Umgang mit Rennbedingungen. Weiterhin ist dieLockDie Klasse bietet verschiedene Methoden, mit deren Hilfe wir die Race-Bedingungen zwischen mehreren Threads behandeln können. Die Methoden werden nachfolgend beschrieben -

erwerben () Methode

Diese Methode wird verwendet, um eine Sperre zu erfassen, dh zu blockieren. Eine Sperre kann blockierend oder nicht blockierend sein, abhängig vom folgenden wahren oder falschen Wert -

With value set to True - Wenn die Methode purchase () mit True aufgerufen wird, was das Standardargument ist, wird die Thread-Ausführung blockiert, bis die Sperre aufgehoben wird.

With value set to False - Wenn die Methode purchase () mit False aufgerufen wird, was nicht das Standardargument ist, wird die Thread-Ausführung erst blockiert, wenn sie auf true gesetzt ist, dh bis sie gesperrt ist.

release () Methode

Diese Methode wird verwendet, um eine Sperre aufzuheben. Im Folgenden sind einige wichtige Aufgaben im Zusammenhang mit dieser Methode aufgeführt:

Wenn ein Schloss gesperrt ist, wird das release()Methode würde es entsperren. Seine Aufgabe ist es, genau einem Thread zu erlauben, fortzufahren, wenn mehr als ein Thread blockiert ist und darauf wartet, dass die Sperre entsperrt wird.

Es wird ein erhöhen ThreadError wenn die Sperre bereits entsperrt ist.

Jetzt können wir das obige Programm mit der Lock-Klasse und ihren Methoden umschreiben, um die Race-Bedingung zu vermeiden. Wir müssen die taskofThread () -Methode mit dem Argument lock definieren und dann die Methoden purchase () und release () zum Blockieren und Nichtblockieren von Sperren verwenden, um Race-Bedingungen zu vermeiden.

Beispiel

Das folgende Beispiel zeigt ein Python-Programm, um das Konzept von Sperren für den Umgang mit Race-Bedingungen zu verstehen:

import threading

x = 0

def increment_global():

global x

x += 1

def taskofThread(lock):

for _ in range(50000):

lock.acquire()

increment_global()

lock.release()

def main():

global x

x = 0

lock = threading.Lock()

t1 = threading.Thread(target = taskofThread, args = (lock,))

t2 = threading.Thread(target = taskofThread, args = (lock,))

t1.start()

t2.start()

t1.join()

t2.join()

if __name__ == "__main__":

for i in range(5):

main()

print("x = {1} after Iteration {0}".format(i,x))Die folgende Ausgabe zeigt, dass der Effekt der Rennbedingung vernachlässigt wird. Der Wert von x beträgt nach jeder Iteration jetzt 100000, was den Erwartungen dieses Programms entspricht.

Ausgabe

x = 100000 after Iteration 0

x = 100000 after Iteration 1

x = 100000 after Iteration 2

x = 100000 after Iteration 3

x = 100000 after Iteration 4Deadlocks - Das Problem der Dining Philosophen

Deadlock ist ein problematisches Problem beim Entwerfen der gleichzeitigen Systeme. Wir können dieses Problem mit Hilfe des Essensphilosophenproblems wie folgt veranschaulichen:

Edsger Dijkstra führte ursprünglich das Problem des Speisephilosophen ein, eines der bekanntesten Beispiele für eines der größten Probleme des gleichzeitigen Systems namens Deadlock.

In diesem Problem sitzen fünf berühmte Philosophen an einem runden Tisch und essen etwas aus ihren Schalen. Es gibt fünf Gabeln, mit denen die fünf Philosophen ihr Essen essen können. Die Philosophen beschließen jedoch, zwei Gabeln gleichzeitig zu verwenden, um ihr Essen zu essen.

Nun gibt es zwei Hauptbedingungen für die Philosophen. Erstens kann jeder der Philosophen entweder essen oder denken, und zweitens müssen sie zuerst beide Gabeln erhalten, dh links und rechts. Das Problem tritt auf, wenn jeder der fünf Philosophen gleichzeitig die linke Gabel auswählt. Jetzt warten alle darauf, dass die richtige Gabel frei ist, aber sie werden ihre Gabel niemals abgeben, bis sie ihr Essen gegessen haben und die richtige Gabel niemals verfügbar sein würde. Daher würde es am Esstisch einen Deadlock-Zustand geben.

Deadlock im gleichzeitigen System

Wenn wir jetzt sehen, kann das gleiche Problem auch in unseren gleichzeitigen Systemen auftreten. Die Gabeln im obigen Beispiel wären die Systemressourcen, und jeder Philosoph kann den Prozess darstellen, der im Wettbewerb um die Ressourcen steht.

Lösung mit Python-Programm

Die Lösung dieses Problems kann gefunden werden, indem die Philosophen in zwei Typen aufgeteilt werden - greedy philosophers und generous philosophers. Hauptsächlich wird ein gieriger Philosoph versuchen, die linke Gabel aufzunehmen und zu warten, bis sie da ist. Er wird dann warten, bis die richtige Gabel da ist, sie aufheben, essen und dann ablegen. Auf der anderen Seite wird ein großzügiger Philosoph versuchen, die linke Gabel aufzuheben, und wenn sie nicht da ist, wird er warten und es nach einiger Zeit erneut versuchen. Wenn sie die linke Gabel bekommen, werden sie versuchen, die richtige zu bekommen. Wenn sie auch die richtige Gabel bekommen, essen sie beide Gabeln und lassen sie los. Wenn sie jedoch nicht die richtige Gabel bekommen, lassen sie die linke Gabel los.

Beispiel

Das folgende Python-Programm hilft uns, eine Lösung für das Problem des Essensphilosophen zu finden:

import threading

import random

import time

class DiningPhilosopher(threading.Thread):

running = True

def __init__(self, xname, Leftfork, Rightfork):

threading.Thread.__init__(self)

self.name = xname

self.Leftfork = Leftfork

self.Rightfork = Rightfork

def run(self):

while(self.running):

time.sleep( random.uniform(3,13))

print ('%s is hungry.' % self.name)

self.dine()

def dine(self):

fork1, fork2 = self.Leftfork, self.Rightfork

while self.running:

fork1.acquire(True)

locked = fork2.acquire(False)

if locked: break

fork1.release()

print ('%s swaps forks' % self.name)

fork1, fork2 = fork2, fork1

else:

return

self.dining()

fork2.release()

fork1.release()

def dining(self):

print ('%s starts eating '% self.name)

time.sleep(random.uniform(1,10))

print ('%s finishes eating and now thinking.' % self.name)

def Dining_Philosophers():

forks = [threading.Lock() for n in range(5)]

philosopherNames = ('1st','2nd','3rd','4th', '5th')

philosophers= [DiningPhilosopher(philosopherNames[i], forks[i%5], forks[(i+1)%5]) \

for i in range(5)]

random.seed()

DiningPhilosopher.running = True

for p in philosophers: p.start()

time.sleep(30)

DiningPhilosopher.running = False

print (" It is finishing.")

Dining_Philosophers()Das obige Programm verwendet das Konzept gieriger und großzügiger Philosophen. Das Programm hat auch die verwendetacquire() und release() Methoden der Lock Klasse der <threading>Modul. Wir können die Lösung in der folgenden Ausgabe sehen -

Ausgabe

4th is hungry.

4th starts eating

1st is hungry.

1st starts eating

2nd is hungry.

5th is hungry.

3rd is hungry.

1st finishes eating and now thinking.3rd swaps forks

2nd starts eating

4th finishes eating and now thinking.

3rd swaps forks5th starts eating

5th finishes eating and now thinking.

4th is hungry.

4th starts eating

2nd finishes eating and now thinking.

3rd swaps forks

1st is hungry.

1st starts eating

4th finishes eating and now thinking.

3rd starts eating

5th is hungry.

5th swaps forks

1st finishes eating and now thinking.

5th starts eating

2nd is hungry.

2nd swaps forks

4th is hungry.

5th finishes eating and now thinking.

3rd finishes eating and now thinking.

2nd starts eating 4th starts eating

It is finishing.Wenn im wirklichen Leben ein Team von Menschen an einer gemeinsamen Aufgabe arbeitet, sollte zwischen ihnen eine Kommunikation bestehen, um die Aufgabe ordnungsgemäß zu erledigen. Die gleiche Analogie gilt auch für Threads. Um die ideale Zeit des Prozessors zu verkürzen, erstellen wir bei der Programmierung mehrere Threads und weisen jedem Thread unterschiedliche Unteraufgaben zu. Daher muss eine Kommunikationseinrichtung vorhanden sein, und sie sollten miteinander interagieren, um den Auftrag synchron zu beenden.

Berücksichtigen Sie die folgenden wichtigen Punkte im Zusammenhang mit der Thread-Interkommunikation:

No performance gain - Wenn wir keine ordnungsgemäße Kommunikation zwischen Threads und Prozessen erreichen können, sind die Leistungsgewinne durch Parallelität und Parallelität nutzlos.

Accomplish task properly - Ohne einen ordnungsgemäßen Interkommunikationsmechanismus zwischen Threads kann die zugewiesene Aufgabe nicht ordnungsgemäß ausgeführt werden.

More efficient than inter-process communication - Die Kommunikation zwischen Threads ist effizienter und benutzerfreundlicher als die Kommunikation zwischen Prozessen, da alle Threads innerhalb eines Prozesses denselben Adressraum verwenden und keinen gemeinsamen Speicher verwenden müssen.

Python-Datenstrukturen für die thread-sichere Kommunikation

Multithread-Code hat das Problem, Informationen von einem Thread an einen anderen Thread zu übergeben. Die Standard-Kommunikationsprimitive lösen dieses Problem nicht. Daher müssen wir unser eigenes zusammengesetztes Objekt implementieren, um Objekte zwischen Threads zu teilen, um die Kommunikation threadsicher zu machen. Im Folgenden finden Sie einige Datenstrukturen, die nach einigen Änderungen eine thread-sichere Kommunikation ermöglichen.

Sets

Um die Set-Datenstruktur threadsicher zu verwenden, müssen wir die Set-Klasse erweitern, um unseren eigenen Sperrmechanismus zu implementieren.

Beispiel

Hier ist ein Python-Beispiel für die Erweiterung der Klasse -

class extend_class(set):

def __init__(self, *args, **kwargs):

self._lock = Lock()

super(extend_class, self).__init__(*args, **kwargs)

def add(self, elem):

self._lock.acquire()

try:

super(extend_class, self).add(elem)

finally:

self._lock.release()

def delete(self, elem):

self._lock.acquire()

try:

super(extend_class, self).delete(elem)

finally:

self._lock.release()Im obigen Beispiel wurde ein Klassenobjekt benannt extend_class wurde definiert, die weiter von Python geerbt wird set class. Im Konstruktor dieser Klasse wird ein Sperrobjekt erstellt. Nun gibt es zwei Funktionen -add() und delete(). Diese Funktionen sind definiert und threadsicher. Sie verlassen sich beide auf diesuper Klassenfunktionalität mit einer Schlüsselausnahme.

Dekorateur

Dies ist eine weitere wichtige Methode für die thread-sichere Kommunikation, bei der Dekoratoren verwendet werden.

Beispiel

Betrachten Sie ein Python-Beispiel, das zeigt, wie Dekorateure verwendet werden & mminus;

def lock_decorator(method):

def new_deco_method(self, *args, **kwargs):

with self._lock:

return method(self, *args, **kwargs)

return new_deco_method

class Decorator_class(set):

def __init__(self, *args, **kwargs):

self._lock = Lock()

super(Decorator_class, self).__init__(*args, **kwargs)

@lock_decorator

def add(self, *args, **kwargs):

return super(Decorator_class, self).add(elem)

@lock_decorator

def delete(self, *args, **kwargs):

return super(Decorator_class, self).delete(elem)Im obigen Beispiel wurde eine Dekorationsmethode mit dem Namen lock_decorator definiert, die weiter von der Python-Methodenklasse geerbt wird. Anschließend wird im Konstruktor dieser Klasse ein Sperrobjekt erstellt. Jetzt gibt es zwei Funktionen - add () und delete (). Diese Funktionen sind definiert und threadsicher. Beide sind mit einer Ausnahme auf erstklassige Funktionen angewiesen.

Listen

Die Listendatenstruktur ist threadsicher, schnell und einfach für die temporäre Speicherung im Speicher. In Cpython schützt die GIL vor gleichzeitigem Zugriff auf sie. Als wir erfuhren, dass Listen threadsicher sind, aber was ist mit den darin enthaltenen Daten? Tatsächlich sind die Daten der Liste nicht geschützt. Zum Beispiel,L.append(x)Es kann nicht garantiert werden, dass das erwartete Ergebnis zurückgegeben wird, wenn ein anderer Thread versucht, dasselbe zu tun. Dies liegt jedoch daranappend() ist eine atomare Operation und threadsicher, aber der andere Thread versucht, die Daten der Liste gleichzeitig zu ändern, sodass wir die Nebenwirkungen der Race-Bedingungen auf die Ausgabe sehen können.

Um diese Art von Problem zu beheben und die Daten sicher zu ändern, müssen wir einen geeigneten Sperrmechanismus implementieren, der ferner sicherstellt, dass mehrere Threads möglicherweise nicht unter Rennbedingungen laufen können. Um einen ordnungsgemäßen Sperrmechanismus zu implementieren, können wir die Klasse wie in den vorherigen Beispielen erweitern.

Einige andere atomare Operationen auf Listen sind wie folgt:

L.append(x)

L1.extend(L2)

x = L[i]

x = L.pop()

L1[i:j] = L2

L.sort()

x = y

x.field = y

D[x] = y

D1.update(D2)

D.keys()Hier -

- L, L1, L2 sind alle Listen

- D, D1, D2 sind Diktate

- x, y sind Objekte

- Ich, ich bin Ints

Warteschlangen

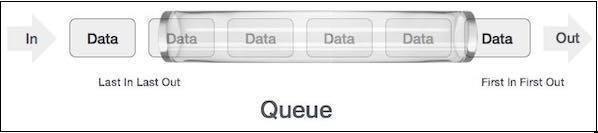

Wenn die Daten der Liste nicht geschützt sind, müssen wir uns möglicherweise den Konsequenzen stellen. Wir können falsche Daten der Rennbedingungen erhalten oder löschen. Aus diesem Grund wird empfohlen, die Warteschlangendatenstruktur zu verwenden. Ein reales Beispiel für eine Warteschlange kann eine einspurige Einbahnstraße sein, bei der das Fahrzeug zuerst ein- und zuerst ausfährt. Weitere Beispiele aus der Praxis sind die Warteschlangen an den Fahrkartenschaltern und Bushaltestellen.

Warteschlangen sind standardmäßig threadsichere Datenstrukturen, und wir müssen uns nicht um die Implementierung komplexer Sperrmechanismen kümmern. Python bietet uns die

Arten von Warteschlangen

In diesem Abschnitt werden wir uns mit den verschiedenen Arten von Warteschlangen befassen. Python bietet drei Optionen für Warteschlangen, die aus dem verwendet werden können<queue> Modul -

- Normale Warteschlangen (FIFO, First in First out)

- LIFO, Last in First Out

- Priority

In den folgenden Abschnitten erfahren Sie mehr über die verschiedenen Warteschlangen.

Normale Warteschlangen (FIFO, First in First out)

Es sind die am häufigsten verwendeten Warteschlangenimplementierungen, die von Python angeboten werden. In diesem Warteschlangenmechanismus erhält jeder, der zuerst kommt, zuerst den Dienst. FIFO wird auch als normale Warteschlange bezeichnet. FIFO-Warteschlangen können wie folgt dargestellt werden:

Python-Implementierung der FIFO-Warteschlange

In Python kann die FIFO-Warteschlange sowohl mit einem Thread als auch mit Multithreads implementiert werden.

FIFO-Warteschlange mit einem Thread

Für die Implementierung der FIFO-Warteschlange mit einem einzelnen Thread wird die QueueDie Klasse implementiert einen einfachen First-In- und First-Out-Container. Elemente werden an einem „Ende“ der Sequenz mit hinzugefügtput()und vom anderen Ende mit entfernt get().

Beispiel

Es folgt ein Python-Programm zur Implementierung der FIFO-Warteschlange mit einem einzelnen Thread -

import queue

q = queue.Queue()

for i in range(8):

q.put("item-" + str(i))

while not q.empty():

print (q.get(), end = " ")Ausgabe

item-0 item-1 item-2 item-3 item-4 item-5 item-6 item-7Die Ausgabe zeigt, dass das obige Programm einen einzelnen Thread verwendet, um zu veranschaulichen, dass die Elemente in derselben Reihenfolge aus der Warteschlange entfernt werden, in der sie eingefügt wurden.

FIFO-Warteschlange mit mehreren Threads

Um FIFO mit mehreren Threads zu implementieren, müssen wir die Funktion myqueue () definieren, die vom Warteschlangenmodul erweitert wird. Die Funktionsweise der Methoden get () und put () ist dieselbe wie oben beschrieben, während die FIFO-Warteschlange mit einem einzelnen Thread implementiert wird. Um es dann multithreaded zu machen, müssen wir die Threads deklarieren und instanziieren. Diese Threads belegen die Warteschlange auf FIFO-Weise.

Beispiel

Es folgt ein Python-Programm zur Implementierung einer FIFO-Warteschlange mit mehreren Threads

import threading

import queue

import random

import time

def myqueue(queue):

while not queue.empty():

item = queue.get()

if item is None:

break

print("{} removed {} from the queue".format(threading.current_thread(), item))

queue.task_done()

time.sleep(2)

q = queue.Queue()

for i in range(5):

q.put(i)

threads = []

for i in range(4):

thread = threading.Thread(target=myqueue, args=(q,))

thread.start()

threads.append(thread)

for thread in threads:

thread.join()Ausgabe

<Thread(Thread-3654, started 5044)> removed 0 from the queue

<Thread(Thread-3655, started 3144)> removed 1 from the queue

<Thread(Thread-3656, started 6996)> removed 2 from the queue

<Thread(Thread-3657, started 2672)> removed 3 from the queue

<Thread(Thread-3654, started 5044)> removed 4 from the queueLIFO, Last in First Out-Warteschlange

Diese Warteschlange verwendet eine völlig entgegengesetzte Analogie zu FIFO-Warteschlangen (First in First Out). In diesem Warteschlangenmechanismus erhält derjenige, der zuletzt kommt, zuerst den Dienst. Dies ähnelt der Implementierung einer Stapeldatenstruktur. LIFO-Warteschlangen erweisen sich als nützlich bei der Implementierung der Tiefensuche wie Algorithmen der künstlichen Intelligenz.

Python-Implementierung der LIFO-Warteschlange

In Python kann die LIFO-Warteschlange sowohl mit einem Thread als auch mit Multithreads implementiert werden.

LIFO-Warteschlange mit einem Thread

Für die Implementierung der LIFO-Warteschlange mit einem einzelnen Thread wird die Queue Die Klasse implementiert mithilfe der Struktur einen grundlegenden Last-In- und First-Out-Container Queue.LifoQueue. Nun zum Anrufput()werden die Elemente im Kopf des Behälters hinzugefügt und auch bei Verwendung aus dem Kopf entfernt get().

Beispiel

Es folgt ein Python-Programm zur Implementierung der LIFO-Warteschlange mit einem einzelnen Thread -

import queue

q = queue.LifoQueue()

for i in range(8):

q.put("item-" + str(i))

while not q.empty():

print (q.get(), end=" ")

Output:

item-7 item-6 item-5 item-4 item-3 item-2 item-1 item-0Die Ausgabe zeigt, dass das obige Programm einen einzelnen Thread verwendet, um zu veranschaulichen, dass Elemente in der entgegengesetzten Reihenfolge aus der Warteschlange entfernt werden, in der sie eingefügt werden.

LIFO-Warteschlange mit mehreren Threads

Die Implementierung ist ähnlich wie bei der Implementierung von FIFO-Warteschlangen mit mehreren Threads. Der einzige Unterschied ist, dass wir die verwenden müssenQueue Klasse, die mithilfe der Struktur einen grundlegenden Last-In- und First-Out-Container implementiert Queue.LifoQueue.

Beispiel

Es folgt ein Python-Programm zur Implementierung einer LIFO-Warteschlange mit mehreren Threads -

import threading

import queue

import random

import time

def myqueue(queue):

while not queue.empty():

item = queue.get()

if item is None:

break

print("{} removed {} from the queue".format(threading.current_thread(), item))

queue.task_done()

time.sleep(2)

q = queue.LifoQueue()

for i in range(5):

q.put(i)

threads = []

for i in range(4):

thread = threading.Thread(target=myqueue, args=(q,))

thread.start()

threads.append(thread)

for thread in threads:

thread.join()Ausgabe

<Thread(Thread-3882, started 4928)> removed 4 from the queue

<Thread(Thread-3883, started 4364)> removed 3 from the queue

<Thread(Thread-3884, started 6908)> removed 2 from the queue

<Thread(Thread-3885, started 3584)> removed 1 from the queue

<Thread(Thread-3882, started 4928)> removed 0 from the queuePrioritätswarteschlange

In FIFO- und LIFO-Warteschlangen hängt die Reihenfolge der Elemente mit der Reihenfolge des Einfügens zusammen. Es gibt jedoch viele Fälle, in denen die Priorität wichtiger ist als die Reihenfolge des Einfügens. Betrachten wir ein Beispiel aus der Praxis. Angenommen, die Sicherheit am Flughafen überprüft Personen verschiedener Kategorien. Personen der VVIP, Mitarbeiter der Fluggesellschaft, Zollbeamte und Kategorien können vorrangig überprüft werden, anstatt wie bei den Bürgern auf der Grundlage der Ankunft überprüft zu werden.

Ein weiterer wichtiger Aspekt, der für die Prioritätswarteschlange berücksichtigt werden muss, ist die Entwicklung eines Taskplaners. Ein gängiges Design besteht darin, die meisten Agentenaufgaben vorrangig in der Warteschlange zu erledigen. Diese Datenstruktur kann verwendet werden, um die Elemente basierend auf ihrem Prioritätswert aus der Warteschlange aufzunehmen.

Python-Implementierung der Prioritätswarteschlange

In Python kann die Prioritätswarteschlange sowohl mit einem Thread als auch mit Multithreads implementiert werden.

Prioritätswarteschlange mit einem Thread

Für die Implementierung der Prioritätswarteschlange mit einem einzelnen Thread wird die Queue Die Klasse implementiert eine Aufgabe für den Prioritätscontainer mithilfe der Struktur Queue.Prioritätswarteschlange. Nun zum Anrufput()werden die Elemente mit einem Wert hinzugefügt, bei dem der niedrigste Wert die höchste Priorität hat, und daher zuerst mithilfe von abgerufen werden get().

Beispiel

Betrachten Sie das folgende Python-Programm zur Implementierung der Prioritätswarteschlange mit einem einzelnen Thread:

import queue as Q

p_queue = Q.PriorityQueue()

p_queue.put((2, 'Urgent'))

p_queue.put((1, 'Most Urgent'))

p_queue.put((10, 'Nothing important'))

prio_queue.put((5, 'Important'))

while not p_queue.empty():

item = p_queue.get()

print('%s - %s' % item)Ausgabe

1 – Most Urgent

2 - Urgent

5 - Important

10 – Nothing importantIn der obigen Ausgabe können wir sehen, dass die Warteschlange die Elemente basierend auf der Priorität gespeichert hat - weniger Wert hat hohe Priorität.

Prioritätswarteschlange mit mehreren Threads

Die Implementierung ähnelt der Implementierung von FIFO- und LIFO-Warteschlangen mit mehreren Threads. Der einzige Unterschied ist, dass wir die verwenden müssenQueue Klasse zum Initialisieren der Priorität mithilfe der Struktur Queue.PriorityQueue. Ein weiterer Unterschied besteht in der Art und Weise, wie die Warteschlange generiert wird. Im folgenden Beispiel wird es mit zwei identischen Datensätzen generiert.

Beispiel

Das folgende Python-Programm hilft bei der Implementierung der Prioritätswarteschlange mit mehreren Threads:

import threading

import queue

import random

import time

def myqueue(queue):

while not queue.empty():

item = queue.get()

if item is None:

break

print("{} removed {} from the queue".format(threading.current_thread(), item))

queue.task_done()

time.sleep(1)

q = queue.PriorityQueue()

for i in range(5):

q.put(i,1)

for i in range(5):

q.put(i,1)

threads = []

for i in range(2):

thread = threading.Thread(target=myqueue, args=(q,))

thread.start()

threads.append(thread)

for thread in threads:

thread.join()Ausgabe

<Thread(Thread-4939, started 2420)> removed 0 from the queue

<Thread(Thread-4940, started 3284)> removed 0 from the queue

<Thread(Thread-4939, started 2420)> removed 1 from the queue

<Thread(Thread-4940, started 3284)> removed 1 from the queue

<Thread(Thread-4939, started 2420)> removed 2 from the queue

<Thread(Thread-4940, started 3284)> removed 2 from the queue

<Thread(Thread-4939, started 2420)> removed 3 from the queue

<Thread(Thread-4940, started 3284)> removed 3 from the queue

<Thread(Thread-4939, started 2420)> removed 4 from the queue

<Thread(Thread-4940, started 3284)> removed 4 from the queueIn diesem Kapitel erfahren Sie, wie Sie Thread-Anwendungen testen. Wir werden auch lernen, wie wichtig das Testen ist.

Warum testen?

Bevor wir uns mit der Bedeutung des Testens befassen, müssen wir wissen, was Testen ist. Im Allgemeinen ist das Testen eine Technik, um herauszufinden, wie gut etwas funktioniert. Wenn wir jedoch speziell über Computerprogramme oder Software sprechen, ist Testen die Technik, um auf die Funktionalität eines Softwareprogramms zuzugreifen.

In diesem Abschnitt werden wir die Bedeutung von Softwaretests diskutieren. Bei der Softwareentwicklung muss vor der Freigabe der Software an den Client eine doppelte Überprüfung durchgeführt werden. Aus diesem Grund ist es sehr wichtig, die Software von einem erfahrenen Testteam zu testen. Berücksichtigen Sie die folgenden Punkte, um die Bedeutung von Softwaretests zu verstehen:

Verbesserung der Softwarequalität

Sicherlich möchte kein Unternehmen Software von geringer Qualität liefern und kein Kunde möchte Software von geringer Qualität kaufen. Das Testen verbessert die Qualität der Software, indem die darin enthaltenen Fehler gefunden und behoben werden.

Kundenzufriedenheit