Talend - Bienenstock

Lassen Sie uns in diesem Kapitel verstehen, wie man mit Hive Job bei Talend arbeitet.

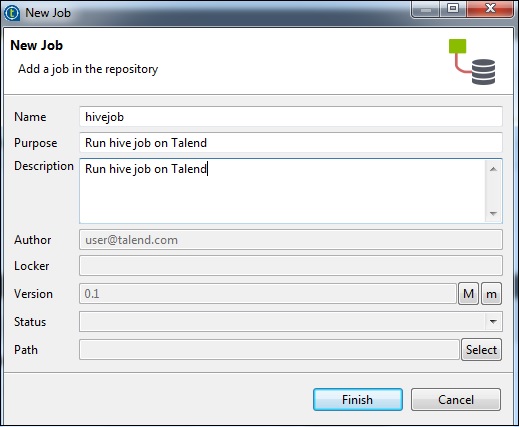

Erstellen eines Talend Hive Jobs

Als Beispiel laden wir NYSE-Daten in eine Hive-Tabelle und führen eine grundlegende Hive-Abfrage aus. Klicken Sie mit der rechten Maustaste auf Job Design und erstellen Sie einen neuen Job - Hivejob. Erwähnen Sie die Details des Jobs und klicken Sie auf Fertig stellen.

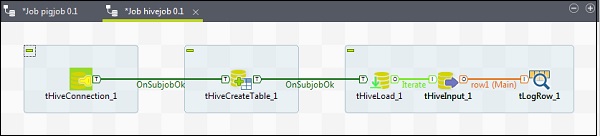

Hinzufügen von Komponenten zum Hive Job

Um Komponenten einem Hive-Job zuzuordnen, ziehen Sie fünf Talend-Komponenten per Drag & Drop - tHiveConnection, tHiveCreateTable, tHiveLoad, tHiveInput und tLogRow - von der Palette zum Designerfenster. Klicken Sie dann mit der rechten Maustaste auf tHiveConnection und erstellen Sie den OnSubjobOk-Trigger für tHiveCreateTable. Klicken Sie nun mit der rechten Maustaste auf tHiveCreateTable und erstellen Sie den OnSubjobOk-Trigger für tHiveLoad. Klicken Sie mit der rechten Maustaste auf tHiveLoad und erstellen Sie einen iterativen Trigger für tHiveInput. Klicken Sie abschließend mit der rechten Maustaste auf tHiveInput und erstellen Sie eine Hauptzeile für tLogRow.

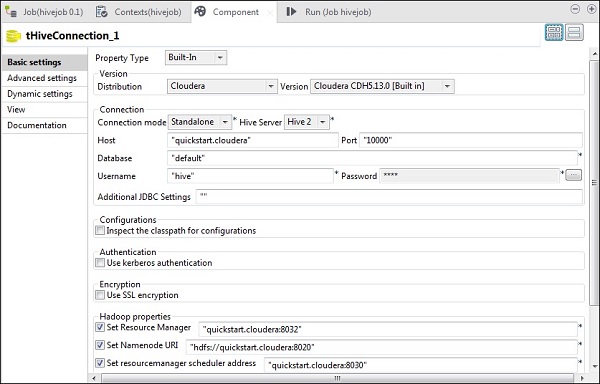

Komponenten und Transformationen konfigurieren

Wählen Sie in tHiveConnection die Distribution als Cloudera und die von Ihnen verwendete Version aus. Beachten Sie, dass der Verbindungsmodus eigenständig und der Hive-Dienst Hive 2 ist. Überprüfen Sie auch, ob die folgenden Parameter entsprechend eingestellt sind:

- Host: "quickstart.cloudera"

- Port: "10000"

- Datenbank: "Standard"

- Benutzername: "Bienenstock"

Beachten Sie, dass das Passwort automatisch ausgefüllt wird. Sie müssen es nicht bearbeiten. Auch andere Hadoop-Eigenschaften werden voreingestellt und standardmäßig festgelegt.

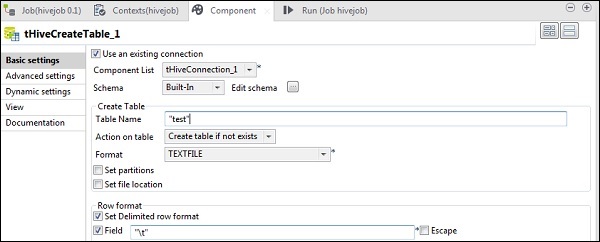

Wählen Sie in tHiveCreateTable die Option Vorhandene Verbindung verwenden aus und fügen Sie tHiveConnection in die Komponentenliste ein. Geben Sie den Tabellennamen an, den Sie in der Standarddatenbank erstellen möchten. Behalten Sie die anderen Parameter wie unten gezeigt bei.

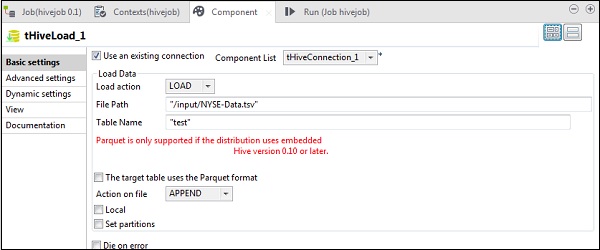

Wählen Sie in tHiveLoad "Vorhandene Verbindung verwenden" aus und fügen Sie tHiveConnection in die Komponentenliste ein. Wählen Sie in der Aktion Laden die Option LADEN. Geben Sie unter Dateipfad den HDFS-Pfad Ihrer NYSE-Eingabedatei an. Erwähnen Sie die Tabelle in Tabellenname, in die Sie die Eingabe laden möchten. Behalten Sie die anderen Parameter wie unten gezeigt bei.

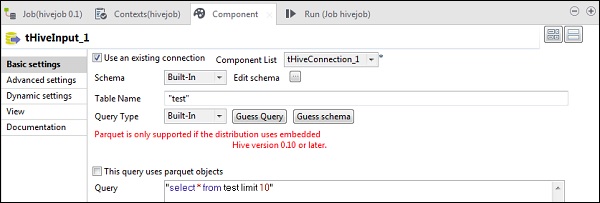

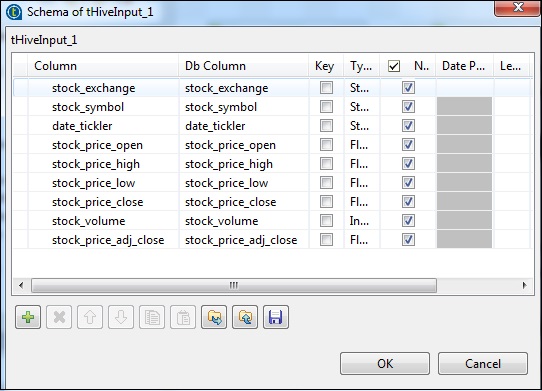

Wählen Sie in tHiveInput die Option Vorhandene Verbindung verwenden aus und fügen Sie tHiveConnection in die Komponentenliste ein. Klicken Sie auf Schema bearbeiten, fügen Sie die Spalten und ihren Typ hinzu, wie im folgenden Schema-Snapshot gezeigt. Geben Sie nun den Tabellennamen an, den Sie in tHiveCreateTable erstellt haben.

Fügen Sie Ihre Abfrage in die Abfrageoption ein, die Sie in der Hive-Tabelle ausführen möchten. Hier drucken wir alle Spalten der ersten 10 Zeilen in der Test-Hive-Tabelle.

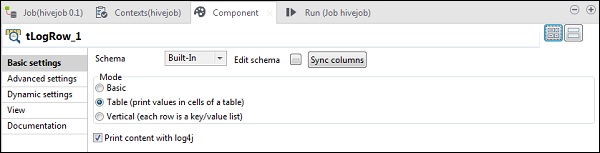

Klicken Sie in tLogRow auf Spalten synchronisieren und wählen Sie Tabellenmodus, um die Ausgabe anzuzeigen.

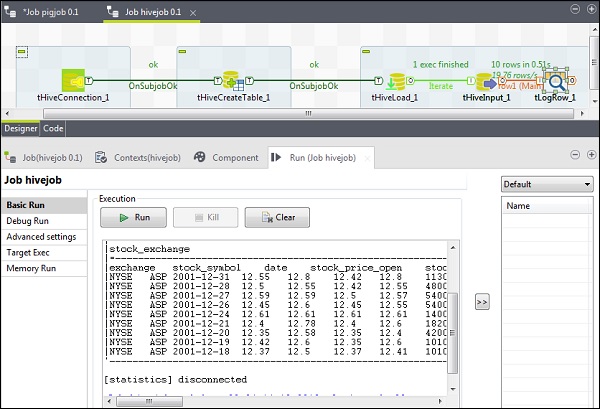

Hive Job ausführen

Klicken Sie auf Ausführen, um die Ausführung zu starten. Wenn alle Verbindungen und Parameter korrekt eingestellt wurden, wird die Ausgabe Ihrer Abfrage wie unten gezeigt angezeigt.