DynamoDB - Guide rapide

DynamoDB permet aux utilisateurs de créer des bases de données capables de stocker et de récupérer n'importe quelle quantité de données, et de desservir n'importe quelle quantité de trafic. Il distribue automatiquement les données et le trafic sur les serveurs pour gérer dynamiquement les demandes de chaque client et maintient également des performances rapides.

DynamoDB contre SGBDR

DynamoDB utilise un modèle NoSQL, ce qui signifie qu'il utilise un système non relationnel. Le tableau suivant met en évidence les différences entre DynamoDB et RDBMS -

| Tâches communes | SGBDR | DynamoDB |

|---|---|---|

| Connect to the Source | Il utilise une connexion persistante et des commandes SQL. | Il utilise des requêtes HTTP et des opérations API |

| Create a Table | Ses structures fondamentales sont des tables et doivent être définies. | Il n'utilise que des clés primaires et aucun schéma lors de la création. Il utilise diverses sources de données. |

| Get Table Info | Toutes les informations de la table restent accessibles | Seules les clés primaires sont révélées. |

| Load Table Data | Il utilise des lignes constituées de colonnes. | Dans les tableaux, il utilise des éléments composés d'attributs |

| Read Table Data | Il utilise des instructions SELECT et des instructions de filtrage. | Il utilise GetItem, Query et Scan. |

| Manage Indexes | Il utilise des index standard créés via des instructions SQL. Les modifications y sont apportées automatiquement lors des changements de table. | Il utilise un index secondaire pour réaliser la même fonction. Il nécessite des spécifications (clé de partition et clé de tri). |

| Modify Table Data | Il utilise une instruction UPDATE. | Il utilise une opération UpdateItem. |

| Delete Table Data | Il utilise une instruction DELETE. | Il utilise une opération DeleteItem. |

| Delete a Table | Il utilise une instruction DROP TABLE. | Il utilise une opération DeleteTable. |

Avantages

Les deux principaux avantages de DynamoDB sont l'évolutivité et la flexibilité. Il ne force pas l'utilisation d'une source de données et d'une structure particulières, permettant aux utilisateurs de travailler avec pratiquement n'importe quoi, mais de manière uniforme.

Sa conception prend également en charge un large éventail d'utilisations, des tâches et opérations plus légères aux fonctionnalités d'entreprise exigeantes. Il permet également une utilisation simple de plusieurs langages: Ruby, Java, Python, C #, Erlang, PHP et Perl.

Limites

DynamoDB souffre de certaines limitations, cependant, ces limitations ne créent pas nécessairement d'énormes problèmes ou n'entravent pas un développement solide.

Vous pouvez les revoir à partir des points suivants -

Capacity Unit Sizes- Une unité de capacité de lecture est une seule lecture cohérente par seconde pour les éléments ne dépassant pas 4 Ko. Une unité de capacité d'écriture est une seule écriture par seconde pour les éléments ne dépassant pas 1 Ko.

Provisioned Throughput Min/Max- Toutes les tables et tous les index secondaires globaux ont au minimum une unité de capacité de lecture et une unité de capacité d'écriture. Les maximums dépendent de la région. Aux États-Unis, 40K en lecture et en écriture restent le plafond par table (80K par compte), et d'autres régions ont un plafond de 10K par table avec un plafond de 20K de compte.

Provisioned Throughput Increase and Decrease - Vous pouvez l'augmenter aussi souvent que nécessaire, mais les diminutions restent limitées à pas plus de quatre fois par jour par table.

Table Size and Quantity Per Account - Les tailles de table n'ont pas de limites, mais les comptes ont une limite de 256 tables, sauf si vous demandez un plafond plus élevé.

Secondary Indexes Per Table - Cinq locaux et cinq mondiaux sont autorisés.

Projected Secondary Index Attributes Per Table - DynamoDB autorise 20 attributs.

Partition Key Length and Values - Leur longueur minimale est de 1 octet et maximale de 2048 octets, cependant, DynamoDB ne place aucune limite sur les valeurs.

Sort Key Length and Values - Sa longueur minimale est de 1 octet, et maximale de 1024 octets, sans limite de valeurs sauf si sa table utilise un index secondaire local.

Table and Secondary Index Names - Les noms doivent comporter au minimum 3 caractères et au maximum 255. Ils utilisent les caractères suivants: AZ, az, 0-9, «_», «-» et «.».

Attribute Names - Un caractère reste le minimum et 64 Ko le maximum, avec des exceptions pour les clés et certains attributs.

Reserved Words - DynamoDB n'empêche pas l'utilisation de mots réservés comme noms.

Expression Length- Les chaînes d'expression ont une limite de 4 Ko. Les expressions d'attributs ont une limite de 255 octets. Les variables de substitution d'une expression ont une limite de 2 Mo.

Avant d'utiliser DynamoDB, vous devez vous familiariser avec ses composants de base et son écosystème. Dans l'écosystème DynamoDB, vous travaillez avec des tables, des attributs et des éléments. Une table contient des ensembles d'éléments et les éléments contiennent des ensembles d'attributs. Un attribut est un élément fondamental de données ne nécessitant aucune décomposition supplémentaire, c'est-à-dire un champ.

Clé primaire

Les clés primaires servent de moyen d'identification unique pour les éléments de table et les index secondaires offrent une flexibilité de requête. Les flux DynamoDB enregistrent les événements en modifiant les données de la table.

La création de table nécessite non seulement de définir un nom, mais également la clé primaire; qui identifie les éléments du tableau. Aucun élément ne partage une clé. DynamoDB utilise deux types de clés primaires -

Partition Key- Cette clé primaire simple consiste en un seul attribut appelé «clé de partition». En interne, DynamoDB utilise la valeur de clé comme entrée pour une fonction de hachage pour déterminer le stockage.

Partition Key and Sort Key - Cette clé, connue sous le nom de «Clé primaire composite», se compose de deux attributs.

La clé de partition et

La clé de tri.

DynamoDB applique le premier attribut à une fonction de hachage et stocke les éléments avec la même clé de partition ensemble; avec leur ordre déterminé par la clé de tri. Les éléments peuvent partager des clés de partition, mais pas les clés de tri.

Les attributs de clé primaire n'autorisent que des valeurs scalaires (uniques); et les types de données chaîne, nombre ou binaire. Les attributs non clés n'ont pas ces contraintes.

Index secondaires

Ces index vous permettent d'interroger les données de la table avec une clé alternative. Bien que DynamoDB ne force pas leur utilisation, ils optimisent les requêtes.

DynamoDB utilise deux types d'index secondaires -

Global Secondary Index - Cet index possède des clés de partition et de tri, qui peuvent différer des clés de table.

Local Secondary Index - Cet index possède une clé de partition identique à la table, cependant, sa clé de tri diffère.

API

Les opérations d'API proposées par DynamoDB incluent celles du plan de contrôle, du plan de données (par exemple, création, lecture, mise à jour et suppression) et des flux. Dans les opérations du plan de contrôle, vous créez et gérez des tables avec les outils suivants:

- CreateTable

- DescribeTable

- ListTables

- UpdateTable

- DeleteTable

Dans le plan de données, vous effectuez des opérations CRUD avec les outils suivants:

| Créer | Lis | Mettre à jour | Effacer |

|---|---|---|---|

PutItem BatchWriteItem |

Obtenir l'article BatchGetItem Requete Analyse |

UpdateItem | Effacer l'article BatchWriteItem |

Les flux de la table de contrôle des opérations de flux. Vous pouvez consulter les outils de flux suivants -

- ListStreams

- DescribeStream

- GetShardIterator

- GetRecords

Débit provisionné

Lors de la création de table, vous spécifiez le débit provisionné, qui réserve des ressources pour les lectures et les écritures. Vous utilisez des unités de capacité pour mesurer et définir le débit.

Lorsque les applications dépassent le débit défini, les demandes échouent. La console GUI DynamoDB permet de surveiller le débit défini et utilisé pour un provisionnement amélioré et dynamique.

Lire la cohérence

Utilise DynamoDB eventually consistent et strongly consistentlit pour prendre en charge les besoins des applications dynamiques. Les lectures finalement cohérentes ne fournissent pas toujours les données actuelles.

Les lectures fortement cohérentes fournissent toujours des données actuelles (à l'exception des pannes d'équipement ou des problèmes de réseau). Les lectures finalement cohérentes servent de paramètre par défaut, nécessitant un paramètre true dans leConsistentRead paramètre pour le changer.

Partitions

DynamoDB utilise des partitions pour le stockage des données. Ces allocations de stockage pour les tables ont un support SSD et se répliquent automatiquement entre les zones. DynamoDB gère toutes les tâches de partition, ne nécessitant aucune intervention de l'utilisateur.

Lors de la création de table, la table entre dans l'état CREATING, qui alloue des partitions. Lorsqu'il atteint l'état ACTIF, vous pouvez effectuer des opérations. Le système modifie les partitions lorsque sa capacité atteint son maximum ou lorsque vous modifiez le débit.

L'environnement DynamoDB consiste uniquement à utiliser votre compte Amazon Web Services pour accéder à la console d'interface graphique DynamoDB, mais vous pouvez également effectuer une installation locale.

Accédez au site Web suivant - https://aws.amazon.com/dynamodb/

Cliquez sur le bouton «Premiers pas avec Amazon DynamoDB» ou sur le bouton «Créer un compte AWS» si vous ne possédez pas de compte Amazon Web Services. Le processus simple et guidé vous informera de tous les frais et exigences associés.

Après avoir effectué toutes les étapes nécessaires du processus, vous aurez accès. Connectez-vous simplement à la console AWS, puis accédez à la console DynamoDB.

Assurez-vous de supprimer le matériel inutilisé ou inutile pour éviter les frais associés.

Installation locale

AWS (Amazon Web Service) fournit une version de DynamoDB pour les installations locales. Il prend en charge la création d'applications sans service Web ni connexion. Il réduit également le débit provisionné, le stockage des données et les frais de transfert en autorisant une base de données locale. Ce guide suppose une installation locale.

Lorsque vous êtes prêt pour le déploiement, vous pouvez apporter quelques petits ajustements à votre application pour la convertir en utilisation AWS.

Le fichier d'installation est un .jar executable. Il fonctionne sous Linux, Unix, Windows et tout autre système d'exploitation prenant en charge Java. Téléchargez le fichier en utilisant l'un des liens suivants -

Tarball - http://dynamodb-local.s3-website-us-west2.amazonaws.com/dynamodb_local_latest.tar.gz

Zip archive - http://dynamodb-local.s3-website-us-west2.amazonaws.com/dynamodb_local_latest.zip

Note- D'autres référentiels proposent le fichier, mais pas nécessairement la dernière version. Utilisez les liens ci-dessus pour les fichiers d'installation à jour. Assurez-vous également que vous disposez de la version 6.x de Java Runtime Engine (JRE) ou d'une version plus récente. DynamoDB ne peut pas fonctionner avec des versions plus anciennes.

Après avoir téléchargé l'archive appropriée, extrayez son répertoire (DynamoDBLocal.jar) et placez-le à l'emplacement souhaité.

Vous pouvez ensuite démarrer DynamoDB en ouvrant une invite de commande, en accédant au répertoire contenant DynamoDBLocal.jar et en entrant la commande suivante -

java -Djava.library.path=./DynamoDBLocal_lib -jar DynamoDBLocal.jar -sharedDbVous pouvez également arrêter le DynamoDB en fermant l'invite de commande utilisée pour le démarrer.

Environnement de travail

Vous pouvez utiliser un shell JavaScript, une console GUI et plusieurs langues pour travailler avec DynamoDB. Les langages disponibles incluent Ruby, Java, Python, C #, Erlang, PHP et Perl.

Dans ce didacticiel, nous utilisons des exemples de console Java et GUI pour la clarté conceptuelle et du code. Installez un IDE Java, le SDK AWS pour Java et configurez les informations d'identification de sécurité AWS pour le SDK Java afin d'utiliser Java.

Conversion du code de service local en code de service Web

Lorsque vous êtes prêt pour le déploiement, vous devrez modifier votre code. Les ajustements dépendent du langage du code et d'autres facteurs. Le principal changement consiste simplement à changer leendpointd'un point local à une région AWS. D'autres changements nécessitent une analyse plus approfondie de votre application.

Une installation locale diffère du service Web à bien des égards, y compris, mais sans s'y limiter, les principales différences suivantes:

L'installation locale crée des tables immédiatement, mais le service prend beaucoup plus de temps.

L'installation locale ignore le débit.

La suppression se produit immédiatement dans une installation locale.

Les lectures / écritures se produisent rapidement dans les installations locales en raison de l'absence de surcharge du réseau.

DynamoDB fournit trois options pour effectuer des opérations: une console GUI Web, un shell JavaScript et un langage de programmation de votre choix.

Dans ce didacticiel, nous nous concentrerons sur l'utilisation de la console GUI et du langage Java pour plus de clarté et de compréhension conceptuelle.

Console GUI

La console GUI ou AWS Management Console pour Amazon DynamoDB se trouvent à l'adresse suivante - https://console.aws.amazon.com/dynamodb/home

Il vous permet d'effectuer les tâches suivantes -

- CRUD

- Afficher les éléments de table

- Effectuer des requêtes de table

- Définir des alarmes pour la surveillance de la capacité de la table

- Afficher les métriques de table en temps réel

- Afficher les alarmes du tableau

Si votre compte DynamoDB n'a pas de tables, lors de l'accès, il vous guide tout au long de la création d'une table. Son écran principal propose trois raccourcis pour effectuer des opérations courantes -

- Créer des tableaux

- Ajouter et interroger des tables

- Surveiller et gérer les tables

Le shell JavaScript

DynamoDB comprend un shell JavaScript interactif. Le shell s'exécute dans un navigateur Web et les navigateurs recommandés incluent Firefox et Chrome.

Note - L'utilisation d'autres navigateurs peut entraîner des erreurs.

Accédez au shell en ouvrant un navigateur Web et en saisissant l'adresse suivante -http://localhost:8000/shell

Utilisez le shell en saisissant JavaScript dans le volet gauche, puis en cliquant sur le bouton icône «Lecture» dans le coin supérieur droit du volet gauche, qui exécute le code. Les résultats du code s'affichent dans le volet droit.

DynamoDB et Java

Utilisez Java avec DynamoDB en utilisant votre environnement de développement Java. Les opérations confirment la syntaxe et la structure Java normales.

Les types de données pris en charge par DynamoDB incluent ceux spécifiques aux attributs, aux actions et au langage de codage de votre choix.

Types de données d'attribut

DynamoDB prend en charge un grand ensemble de types de données pour les attributs de table. Chaque type de données appartient à l'une des trois catégories suivantes -

Scalar - Ces types représentent une valeur unique et incluent un nombre, une chaîne, un binaire, un booléen et une valeur nulle.

Document - Ces types représentent une structure complexe possédant des attributs imbriqués et incluent des listes et des cartes.

Set - Ces types représentent plusieurs scalaires et incluent des ensembles de chaînes, des ensembles de nombres et des ensembles binaires.

N'oubliez pas DynamoDB comme une base de données NoSQL sans schéma qui n'a pas besoin de définitions d'attribut ou de type de données lors de la création d'une table. Il ne nécessite que des types de données d'attribut de clé primaire contrairement au SGBDR, qui nécessite des types de données de colonne lors de la création de table.

Scalaires

Numbers - Ils sont limités à 38 chiffres et sont soit positifs, négatifs ou nuls.

String - Ils sont Unicode utilisant UTF-8, avec une longueur minimum de> 0 et maximum de 400 Ko.

Binary- Ils stockent toutes les données binaires, par exemple, des données cryptées, des images et du texte compressé. DynamoDB considère ses octets comme non signés.

Boolean - Ils stockent vrai ou faux.

Null - Ils représentent un état inconnu ou non défini.

Document

List - Il stocke les collections de valeurs ordonnées et utilise des crochets [...] carrés.

Map - Il stocke des collections de paires nom-valeur non ordonnées et utilise des accolades ({...}).

Ensemble

Les ensembles doivent contenir des éléments du même type, qu'il soit numérique, chaîne ou binaire. Les seules limites placées sur les ensembles consistent en la limite de taille d'élément de 400 Ko, et chaque élément étant unique.

Types de données d'action

L'API DynamoDB contient divers types de données utilisés par les actions. Vous pouvez consulter une sélection des types de clés suivants -

AttributeDefinition - Il représente la table de clés et le schéma d'index.

Capacity - Il représente la quantité de débit consommée par une table ou un index.

CreateGlobalSecondaryIndexAction - Il représente un nouvel index secondaire global ajouté à une table.

LocalSecondaryIndex - Il représente les propriétés d'index secondaire local.

ProvisionedThroughput - Il représente le débit provisionné pour un index ou une table.

PutRequest - Il représente les requêtes PutItem.

TableDescription - Il représente les propriétés de la table.

Types de données Java pris en charge

DynamoDB prend en charge les types de données primitifs, les collections Set et les types arbitraires pour Java.

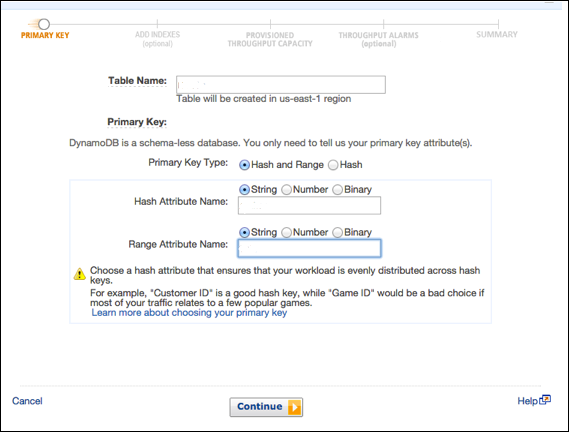

La création d'une table consiste généralement à générer la table, à la nommer, à établir ses attributs de clé primaire et à définir les types de données d'attribut.

Utilisez la console GUI, Java ou une autre option pour effectuer ces tâches.

Créer une table à l'aide de la console GUI

Créez une table en accédant à la console à l'adresse https://console.aws.amazon.com/dynamodb. Choisissez ensuite l'option «Créer une table».

Notre exemple génère un tableau rempli d'informations sur les produits, avec des produits d'attributs uniques identifiés par un numéro d'identification (attribut numérique). dans leCreate Tableécran, entrez le nom de la table dans le champ du nom de la table; entrez la clé primaire (ID) dans le champ de clé de partition; et entrez «Numéro» pour le type de données.

Après avoir entré toutes les informations, sélectionnez Create.

Créer une table à l'aide de Java

Utilisez Java pour créer la même table. Sa clé primaire se compose des deux attributs suivants -

ID - Utilisez une clé de partition et le ScalarAttributeType N, ce qui signifie nombre.

Nomenclature - Utilisez une clé de tri et le ScalarAttributeType S, ce qui signifie chaîne.

Java utilise le createTable methodpour générer une table; et dans l'appel, le nom de la table, les attributs de clé primaire et les types de données d'attribut sont spécifiés.

Vous pouvez consulter l'exemple suivant -

import java.util.Arrays;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Table;

import com.amazonaws.services.dynamodbv2.model.AttributeDefinition;

import com.amazonaws.services.dynamodbv2.model.KeySchemaElement;

import com.amazonaws.services.dynamodbv2.model.KeyType;

import com.amazonaws.services.dynamodbv2.model.ProvisionedThroughput;

import com.amazonaws.services.dynamodbv2.model.ScalarAttributeType;

public class ProductsCreateTable {

public static void main(String[] args) throws Exception {

AmazonDynamoDBClient client = new AmazonDynamoDBClient()

.withEndpoint("http://localhost:8000");

DynamoDB dynamoDB = new DynamoDB(client);

String tableName = "Products";

try {

System.out.println("Creating the table, wait...");

Table table = dynamoDB.createTable (tableName,

Arrays.asList (

new KeySchemaElement("ID", KeyType.HASH), // the partition key

// the sort key

new KeySchemaElement("Nomenclature", KeyType.RANGE)

),

Arrays.asList (

new AttributeDefinition("ID", ScalarAttributeType.N),

new AttributeDefinition("Nomenclature", ScalarAttributeType.S)

),

new ProvisionedThroughput(10L, 10L)

);

table.waitForActive();

System.out.println("Table created successfully. Status: " +

table.getDescription().getTableStatus());

} catch (Exception e) {

System.err.println("Cannot create the table: ");

System.err.println(e.getMessage());

}

}

}Dans l'exemple ci-dessus, notez le point de terminaison: .withEndpoint.

Il indique l'utilisation d'une installation locale à l'aide de l'hôte local. Notez également lesProvisionedThroughput parameter, que l'installation locale ignore.

Le chargement d'une table consiste généralement à créer un fichier source, à s'assurer que le fichier source est conforme à une syntaxe compatible avec DynamoDB, à envoyer le fichier source à la destination, puis à confirmer un remplissage réussi.

Utilisez la console GUI, Java ou une autre option pour effectuer la tâche.

Charger la table à l'aide de la console GUI

Chargez les données à l'aide d'une combinaison de la ligne de commande et de la console. Vous pouvez charger des données de plusieurs manières, dont certaines sont les suivantes -

- La console

- La ligne de commande

- Code et aussi

- Pipeline de données (une fonctionnalité abordée plus loin dans le didacticiel)

Cependant, pour la vitesse, cet exemple utilise à la fois le shell et la console. Tout d'abord, chargez les données source dans la destination avec la syntaxe suivante -

aws dynamodb batch-write-item -–request-items file://[filename]Par exemple -

aws dynamodb batch-write-item -–request-items file://MyProductData.jsonVérifiez le succès de l'opération en accédant à la console à -

https://console.aws.amazon.com/dynamodb

Choisir Tables dans le volet de navigation et sélectionnez la table de destination dans la liste des tables.

Sélectionnez le Itemsonglet pour examiner les données que vous avez utilisées pour remplir le tableau. SélectionnerCancel pour revenir à la liste des tableaux.

Charger la table à l'aide de Java

Utilisez Java en créant d'abord un fichier source. Notre fichier source utilise le format JSON. Chaque produit a deux attributs de clé primaire (ID et Nomenclature) et une carte JSON (Stat) -

[

{

"ID" : ... ,

"Nomenclature" : ... ,

"Stat" : { ... }

},

{

"ID" : ... ,

"Nomenclature" : ... ,

"Stat" : { ... }

},

...

]Vous pouvez consulter l'exemple suivant -

{

"ID" : 122,

"Nomenclature" : "Particle Blaster 5000",

"Stat" : {

"Manufacturer" : "XYZ Inc.",

"sales" : "1M+",

"quantity" : 500,

"img_src" : "http://www.xyz.com/manuals/particleblaster5000.jpg",

"description" : "A laser cutter used in plastic manufacturing."

}

}L'étape suivante consiste à placer le fichier dans le répertoire utilisé par votre application.

Java utilise principalement le putItem et path methods pour effectuer le chargement.

Vous pouvez consulter l'exemple de code suivant pour traiter un fichier et le charger -

import java.io.File;

import java.util.Iterator;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Item;

import com.amazonaws.services.dynamodbv2.document.Table;

import com.fasterxml.jackson.core.JsonFactory;

import com.fasterxml.jackson.core.JsonParser;

import com.fasterxml.jackson.databind.JsonNode;

import com.fasterxml.jackson.databind.ObjectMapper

import com.fasterxml.jackson.databind.node.ObjectNode;

public class ProductsLoadData {

public static void main(String[] args) throws Exception {

AmazonDynamoDBClient client = new AmazonDynamoDBClient()

.withEndpoint("http://localhost:8000");

DynamoDB dynamoDB = new DynamoDB(client);

Table table = dynamoDB.getTable("Products");

JsonParser parser = new JsonFactory()

.createParser(new File("productinfo.json"));

JsonNode rootNode = new ObjectMapper().readTree(parser);

Iterator<JsonNode> iter = rootNode.iterator();

ObjectNode currentNode;

while (iter.hasNext()) {

currentNode = (ObjectNode) iter.next();

int ID = currentNode.path("ID").asInt();

String Nomenclature = currentNode.path("Nomenclature").asText();

try {

table.putItem(new Item()

.withPrimaryKey("ID", ID, "Nomenclature", Nomenclature)

.withJSON("Stat", currentNode.path("Stat").toString()));

System.out.println("Successful load: " + ID + " " + Nomenclature);

} catch (Exception e) {

System.err.println("Cannot add product: " + ID + " " + Nomenclature);

System.err.println(e.getMessage());

break;

}

}

parser.close();

}

}L'interrogation d'une table nécessite principalement la sélection d'une table, la spécification d'une clé de partition et l'exécution de la requête; avec la possibilité d'utiliser des index secondaires et d'effectuer un filtrage plus approfondi via des opérations d'analyse.

Utilisez la console GUI, Java ou une autre option pour effectuer la tâche.

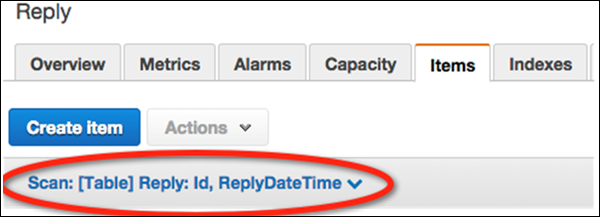

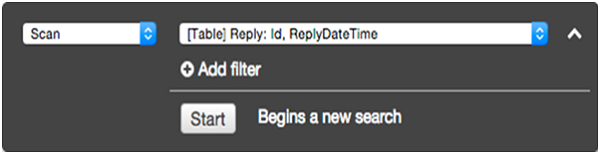

Table de requête à l'aide de la console GUI

Effectuez quelques requêtes simples en utilisant les tables précédemment créées. Tout d'abord, ouvrez la console àhttps://console.aws.amazon.com/dynamodb

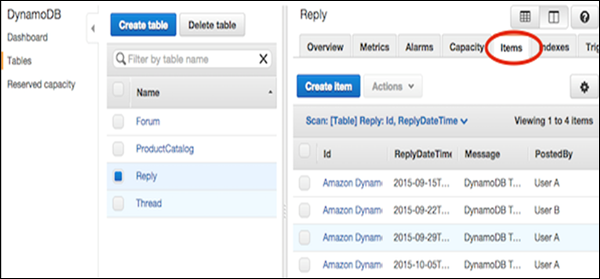

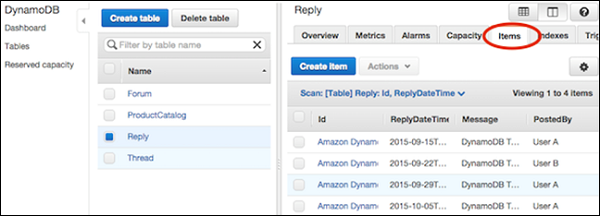

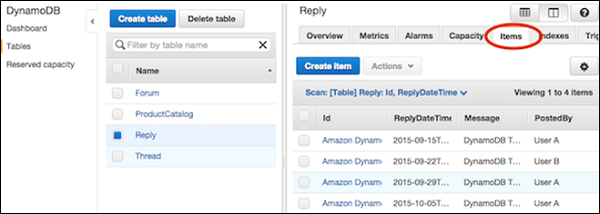

Choisir Tables dans le volet de navigation et sélectionnez Replydans la liste des tableaux. Sélectionnez ensuite leItems onglet pour voir les données chargées.

Sélectionnez le lien de filtrage des données ("Scan: [Table] Reply") sous le Create Item bouton.

Dans l'écran de filtrage, sélectionnez Requête pour l'opération. Entrez la valeur de clé de partition appropriée et cliquez surStart.

le Reply table renvoie ensuite les éléments correspondants.

Table de requête à l'aide de Java

Utilisez la méthode de requête en Java pour effectuer des opérations de récupération de données. Il faut spécifier la valeur de la clé de partition, la clé de tri étant facultative.

Codez une requête Java en créant d'abord un querySpec objectdécrivant les paramètres. Passez ensuite l'objet à la méthode de requête. Nous utilisons la clé de partition des exemples précédents.

Vous pouvez consulter l'exemple suivant -

import java.util.HashMap;

import java.util.Iterator;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Item;

import com.amazonaws.services.dynamodbv2.document.ItemCollection;

import com.amazonaws.services.dynamodbv2.document.QueryOutcome;

import com.amazonaws.services.dynamodbv2.document.Table;

import com.amazonaws.services.dynamodbv2.document.spec.QuerySpec;

import com.amazonaws.services.dynamodbv2.document.utils.NameMap;

public class ProductsQuery {

public static void main(String[] args) throws Exception {

AmazonDynamoDBClient client = new AmazonDynamoDBClient()

.withEndpoint("http://localhost:8000");

DynamoDB dynamoDB = new DynamoDB(client);

Table table = dynamoDB.getTable("Products");

HashMap<String, String> nameMap = new HashMap<String, String>();

nameMap.put("#ID", "ID");

HashMap<String, Object> valueMap = new HashMap<String, Object>();

valueMap.put(":xxx", 122);

QuerySpec querySpec = new QuerySpec()

.withKeyConditionExpression("#ID = :xxx")

.withNameMap(new NameMap().with("#ID", "ID"))

.withValueMap(valueMap);

ItemCollection<QueryOutcome> items = null;

Iterator<Item> iterator = null;

Item item = null;

try {

System.out.println("Product with the ID 122");

items = table.query(querySpec);

iterator = items.iterator();

while (iterator.hasNext()) {

item = iterator.next();

System.out.println(item.getNumber("ID") + ": "

+ item.getString("Nomenclature"));

}

} catch (Exception e) {

System.err.println("Cannot find products with the ID number 122");

System.err.println(e.getMessage());

}

}

}Notez que la requête utilise la clé de partition, cependant, les index secondaires fournissent une autre option pour les requêtes. Leur flexibilité permet d'interroger des attributs non clés, un sujet qui sera abordé plus loin dans ce tutoriel.

La méthode d'analyse prend également en charge les opérations de récupération en rassemblant toutes les données de la table. leoptional .withFilterExpression empêche les éléments en dehors des critères spécifiés d'apparaître dans les résultats.

Plus tard dans ce tutoriel, nous discuterons scanningen détail. Maintenant, jetez un œil à l'exemple suivant -

import java.util.Iterator;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Item;

import com.amazonaws.services.dynamodbv2.document.ItemCollection;

import com.amazonaws.services.dynamodbv2.document.ScanOutcome;

import com.amazonaws.services.dynamodbv2.document.Table;

import com.amazonaws.services.dynamodbv2.document.spec.ScanSpec;

import com.amazonaws.services.dynamodbv2.document.utils.NameMap;

import com.amazonaws.services.dynamodbv2.document.utils.ValueMap;

public class ProductsScan {

public static void main(String[] args) throws Exception {

AmazonDynamoDBClient client = new AmazonDynamoDBClient()

.withEndpoint("http://localhost:8000");

DynamoDB dynamoDB = new DynamoDB(client);

Table table = dynamoDB.getTable("Products");

ScanSpec scanSpec = new ScanSpec()

.withProjectionExpression("#ID, Nomenclature , stat.sales")

.withFilterExpression("#ID between :start_id and :end_id")

.withNameMap(new NameMap().with("#ID", "ID"))

.withValueMap(new ValueMap().withNumber(":start_id", 120)

.withNumber(":end_id", 129));

try {

ItemCollection<ScanOutcome> items = table.scan(scanSpec);

Iterator<Item> iter = items.iterator();

while (iter.hasNext()) {

Item item = iter.next();

System.out.println(item.toString());

}

} catch (Exception e) {

System.err.println("Cannot perform a table scan:");

System.err.println(e.getMessage());

}

}

}Dans ce chapitre, nous discuterons de la manière dont nous pouvons supprimer une table ainsi que des différentes manières de supprimer une table.

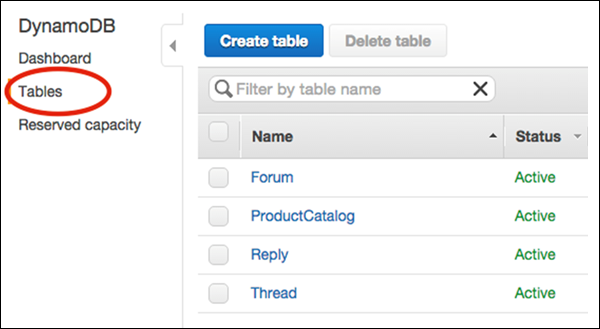

La suppression de table est une opération simple nécessitant un peu plus que le nom de la table. Utilisez la console GUI, Java ou toute autre option pour effectuer cette tâche.

Supprimer la table à l'aide de la console GUI

Effectuez une opération de suppression en accédant d'abord à la console à -

https://console.aws.amazon.com/dynamodb.

Choisir Tables dans le volet de navigation, et choisissez la table que vous souhaitez supprimer dans la liste des tables, comme indiqué dans la capture d'écran suivante.

Enfin, sélectionnez Delete Table. Après avoir choisi Supprimer la table, une confirmation apparaît. Votre table est alors supprimée.

Supprimer la table à l'aide de Java

Utilisez le deleteméthode pour supprimer une table. Un exemple est donné ci-dessous pour mieux expliquer le concept.

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Table;

public class ProductsDeleteTable {

public static void main(String[] args) throws Exception {

AmazonDynamoDBClient client = new AmazonDynamoDBClient()

.withEndpoint("http://localhost:8000");

DynamoDB dynamoDB = new DynamoDB(client);

Table table = dynamoDB.getTable("Products");

try {

System.out.println("Performing table delete, wait...");

table.delete();

table.waitForDelete();

System.out.print("Table successfully deleted.");

} catch (Exception e) {

System.err.println("Cannot perform table delete: ");

System.err.println(e.getMessage());

}

}

}DynamoDB propose un large éventail d'outils API puissants pour la manipulation de tables, la lecture de données et la modification de données.

Amazon recommande d'utiliser AWS SDKs(par exemple, le SDK Java) plutôt que d'appeler des API de bas niveau. Les bibliothèques rendent l'interaction avec les API de bas niveau directement inutile. Les bibliothèques simplifient les tâches courantes telles que l'authentification, la sérialisation et les connexions.

Manipuler les tableaux

DynamoDB propose cinq actions de bas niveau pour la gestion des tables -

CreateTable- Cela génère une table et inclut le débit défini par l'utilisateur. Il vous oblige à définir une clé primaire, qu'elle soit composite ou simple. Il autorise également un ou plusieurs index secondaires.

ListTables - Cela fournit une liste de toutes les tables du compte de l'utilisateur AWS actuel et liées à leur point de terminaison.

UpdateTable - Cela modifie le débit et le débit de l'index secondaire global.

DescribeTable- Cela fournit des métadonnées de table; par exemple, l'état, la taille et les indices.

DeleteTable - Cela efface simplement la table et ses index.

Lire les données

DynamoDB propose quatre actions de bas niveau pour la lecture des données -

GetItem- Il accepte une clé primaire et renvoie les attributs de l'élément associé. Il permet de modifier son paramètre de lecture cohérent par défaut.

BatchGetItem- Il exécute plusieurs requêtes GetItem sur plusieurs éléments via des clés primaires, avec l'option d'une ou plusieurs tables. Ses retours ne dépassent pas 100 articles et doivent rester inférieurs à 16 Mo. Il permet finalement des lectures cohérentes et fortement cohérentes.

Scan- Il lit tous les éléments du tableau et produit un ensemble de résultats finalement cohérent. Vous pouvez filtrer les résultats par conditions. Il évite l'utilisation d'un index et scanne toute la table, ne l'utilisez donc pas pour les requêtes nécessitant une prévisibilité.

Query- Il renvoie un ou plusieurs éléments de table ou des éléments d'index secondaire. Il utilise une valeur spécifiée pour la clé de partition et permet l'utilisation d'opérateurs de comparaison pour restreindre la portée. Il prend en charge les deux types de cohérence, et chaque réponse obéit à une limite de 1 Mo en taille.

Modifier les données

DynamoDB propose quatre actions de bas niveau pour la modification des données -

PutItem- Cela génère un nouvel élément ou remplace les éléments existants. Lors de la découverte de clés primaires identiques, par défaut, il remplace l'élément. Les opérateurs conditionnels vous permettent de contourner la valeur par défaut et de ne remplacer les éléments que sous certaines conditions.

BatchWriteItem- Cela exécute à la fois plusieurs requêtes PutItem et DeleteItem, et sur plusieurs tables. Si une demande échoue, cela n'affecte pas toute l'opération. Son plafond est de 25 éléments et 16 Mo de taille.

UpdateItem - Il modifie les attributs d'élément existants et permet l'utilisation d'opérateurs conditionnels pour exécuter des mises à jour uniquement sous certaines conditions.

DeleteItem - Il utilise la clé primaire pour effacer un élément, et permet également l'utilisation d'opérateurs conditionnels pour spécifier les conditions de suppression.

La création d'un élément dans DynamoDB consiste principalement en une spécification d'élément et d'attribut, ainsi que la possibilité de spécifier des conditions. Chaque élément existe sous la forme d'un ensemble d'attributs, chaque attribut étant nommé et attribué à une valeur d'un certain type.

Les types de valeur incluent scalaire, document ou ensemble. Les articles ont une taille limite de 400 Ko, avec la possibilité de n'importe quel nombre d'attributs capables de s'adapter dans cette limite. Les tailles de nom et de valeur (longueurs binaires et UTF-8) déterminent la taille de l'élément. L'utilisation de noms d'attributs courts aide à réduire la taille des éléments.

Note- Vous devez spécifier tous les attributs de clé primaire, les clés primaires ne nécessitant que la clé de partition; et les clés composites nécessitant à la fois la clé de partition et de tri.

Souvenez-vous également que les tables ne possèdent pas de schéma prédéfini. Vous pouvez stocker des ensembles de données radicalement différents dans une seule table.

Utilisez la console GUI, Java ou un autre outil pour effectuer cette tâche.

Comment créer un élément à l'aide de la console GUI?

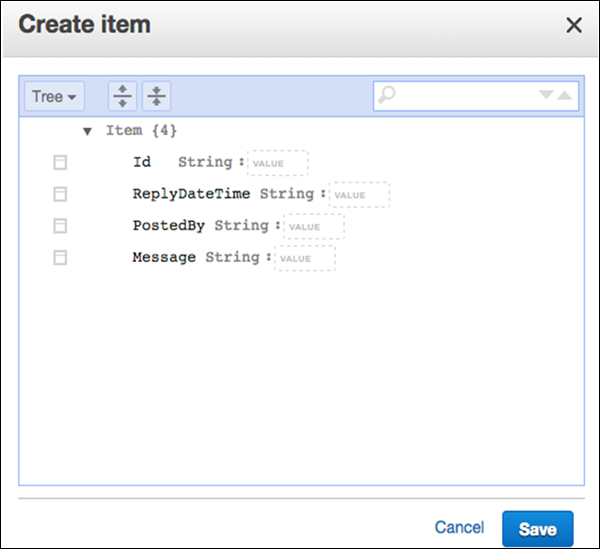

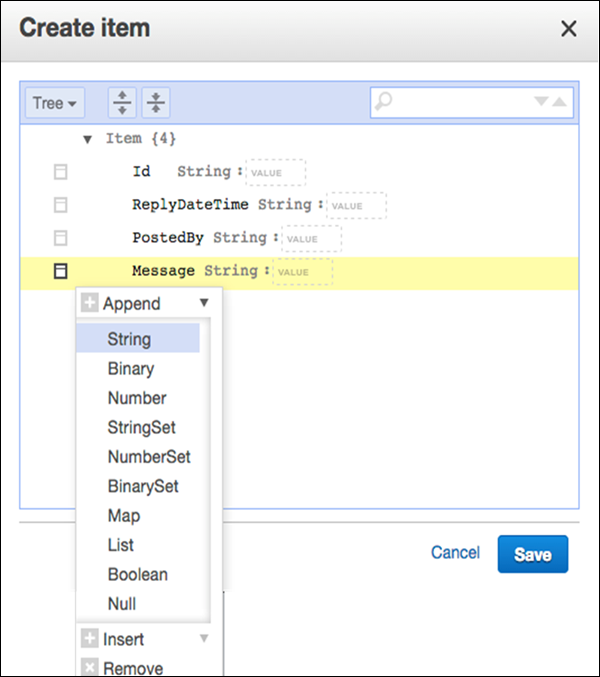

Accédez à la console. Dans le volet de navigation sur le côté gauche, sélectionnezTables. Choisissez le nom de la table à utiliser comme destination, puis sélectionnez leItems onglet comme indiqué dans la capture d'écran suivante.

Sélectionner Create Item. L'écran Créer un article fournit une interface pour saisir les valeurs d'attribut requises. Tous les indices secondaires doivent également être saisis.

Si vous avez besoin de plus d'attributs, sélectionnez le menu d'action à gauche du Message. Puis sélectionnezAppendet le type de données souhaité.

Après avoir saisi toutes les informations essentielles, sélectionnez Save pour ajouter l'élément.

Comment utiliser Java dans la création d'articles?

L'utilisation de Java dans les opérations de création d'élément consiste à créer une instance de classe DynamoDB, une instance de classe Table, une instance de classe Item et à spécifier la clé primaire et les attributs de l'élément que vous allez créer. Ajoutez ensuite votre nouvel élément avec la méthode putItem.

Exemple

DynamoDB dynamoDB = new DynamoDB (new AmazonDynamoDBClient(

new ProfileCredentialsProvider()));

Table table = dynamoDB.getTable("ProductList");

// Spawn a related items list

List<Number> RELItems = new ArrayList<Number>();

RELItems.add(123);

RELItems.add(456);

RELItems.add(789);

//Spawn a product picture map

Map<String, String> photos = new HashMap<String, String>();

photos.put("Anterior", "http://xyz.com/products/101_front.jpg");

photos.put("Posterior", "http://xyz.com/products/101_back.jpg");

photos.put("Lateral", "http://xyz.com/products/101_LFTside.jpg");

//Spawn a product review map

Map<String, List<String>> prodReviews = new HashMap<String, List<String>>();

List<String> fiveStarRVW = new ArrayList<String>();

fiveStarRVW.add("Shocking high performance.");

fiveStarRVW.add("Unparalleled in its market.");

prodReviews.put("5 Star", fiveStarRVW);

List<String> oneStarRVW = new ArrayList<String>();

oneStarRVW.add("The worst offering in its market.");

prodReviews.put("1 Star", oneStarRVW);

// Generate the item

Item item = new Item()

.withPrimaryKey("Id", 101)

.withString("Nomenclature", "PolyBlaster 101")

.withString("Description", "101 description")

.withString("Category", "Hybrid Power Polymer Cutter")

.withString("Make", "Brand – XYZ")

.withNumber("Price", 50000)

.withString("ProductCategory", "Laser Cutter")

.withBoolean("Availability", true)

.withNull("Qty")

.withList("ItemsRelated", RELItems)

.withMap("Images", photos)

.withMap("Reviews", prodReviews);

// Add item to the table

PutItemOutcome outcome = table.putItem(item);Vous pouvez également consulter l'exemple plus large suivant.

Note- L'exemple suivant peut supposer une source de données précédemment créée. Avant de tenter de l'exécuter, acquérez les bibliothèques de prise en charge et créez les sources de données nécessaires (tables avec les caractéristiques requises ou autres sources référencées).

L'exemple suivant utilise également Eclipse IDE, un fichier d'informations d'identification AWS et AWS Toolkit dans un projet Eclipse AWS Java.

package com.amazonaws.codesamples.document;

import java.io.IOException;

import java.util.Arrays;

import java.util.HashMap;

import java.util.HashSet;

import java.util.Map;

import com.amazonaws.auth.profile.ProfileCredentialsProvider;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.DeleteItemOutcome;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Item;

import com.amazonaws.services.dynamodbv2.document.Table;

import com.amazonaws.services.dynamodbv2.document.UpdateItemOutcome;

import com.amazonaws.services.dynamodbv2.document.spec.DeleteItemSpec;

import com.amazonaws.services.dynamodbv2.document.spec.UpdateItemSpec;

import com.amazonaws.services.dynamodbv2.document.utils.NameMap;

import com.amazonaws.services.dynamodbv2.document.utils.ValueMap;

import com.amazonaws.services.dynamodbv2.model.ReturnValue;

public class CreateItemOpSample {

static DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient (

new ProfileCredentialsProvider()));

static String tblName = "ProductList";

public static void main(String[] args) throws IOException {

createItems();

retrieveItem();

// Execute updates

updateMultipleAttributes();

updateAddNewAttribute();

updateExistingAttributeConditionally();

// Item deletion

deleteItem();

}

private static void createItems() {

Table table = dynamoDB.getTable(tblName);

try {

Item item = new Item()

.withPrimaryKey("ID", 303)

.withString("Nomenclature", "Polymer Blaster 4000")

.withStringSet( "Manufacturers",

new HashSet<String>(Arrays.asList("XYZ Inc.", "LMNOP Inc.")))

.withNumber("Price", 50000)

.withBoolean("InProduction", true)

.withString("Category", "Laser Cutter");

table.putItem(item);

item = new Item()

.withPrimaryKey("ID", 313)

.withString("Nomenclature", "Agitatatron 2000")

.withStringSet( "Manufacturers",

new HashSet<String>(Arrays.asList("XYZ Inc,", "CDE Inc.")))

.withNumber("Price", 40000)

.withBoolean("InProduction", true)

.withString("Category", "Agitator");

table.putItem(item);

} catch (Exception e) {

System.err.println("Cannot create items.");

System.err.println(e.getMessage());

}

}

}La récupération d'un élément dans DynamoDB nécessite l'utilisation de GetItem et la spécification du nom de la table et de la clé primaire de l'élément. Assurez-vous d'inclure une clé primaire complète plutôt que d'omettre une partie.

Par exemple, omettre la clé de tri d'une clé composite.

Le comportement de GetItem est conforme à trois valeurs par défaut -

- Il s'exécute comme une lecture finalement cohérente.

- Il fournit tous les attributs.

- Il ne détaille pas sa consommation unitaire de capacité.

Ces paramètres vous permettent de remplacer le comportement par défaut de GetItem.

Récupérer un élément

DynamoDB garantit la fiabilité en conservant plusieurs copies des éléments sur plusieurs serveurs. Chaque écriture réussie crée ces copies, mais prend un temps considérable à exécuter; signifiant finalement cohérent. Cela signifie que vous ne pouvez pas tenter une lecture immédiatement après avoir écrit un élément.

Vous pouvez modifier la lecture cohérente par défaut de GetItem, cependant, le coût des données plus actuelles reste la consommation d'unités de capacité plus; plus précisément, deux fois plus. Remarque DynamoDB atteint généralement la cohérence entre chaque copie en une seconde.

Vous pouvez utiliser la console GUI, Java ou un autre outil pour effectuer cette tâche.

Récupération d'éléments à l'aide de Java

L'utilisation de Java dans les opérations de récupération d'éléments nécessite la création d'une instance de classe DynamoDB, une instance de classe de table et l'appel de la méthode getItem de l'instance de table. Spécifiez ensuite la clé primaire de l'élément.

Vous pouvez consulter l'exemple suivant -

DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient(

new ProfileCredentialsProvider()));

Table table = dynamoDB.getTable("ProductList");

Item item = table.getItem("IDnum", 109);Dans certains cas, vous devez spécifier les paramètres de cette opération.

L'exemple suivant utilise .withProjectionExpression et GetItemSpec pour les spécifications de récupération -

GetItemSpec spec = new GetItemSpec()

.withPrimaryKey("IDnum", 122)

.withProjectionExpression("IDnum, EmployeeName, Department")

.withConsistentRead(true);

Item item = table.getItem(spec);

System.out.println(item.toJSONPretty());Vous pouvez également consulter un exemple plus détaillé suivant pour une meilleure compréhension.

Note- L'exemple suivant peut supposer une source de données précédemment créée. Avant de tenter de l'exécuter, acquérez les bibliothèques de prise en charge et créez les sources de données nécessaires (tables avec les caractéristiques requises ou autres sources référencées).

Cet exemple utilise également Eclipse IDE, un fichier d'informations d'identification AWS et AWS Toolkit dans un projet Eclipse AWS Java.

package com.amazonaws.codesamples.document;

import java.io.IOException

import java.util.Arrays;

import java.util.HashMap;

import java.util.HashSet;

import java.util.Map;

import com.amazonaws.auth.profile.ProfileCredentialsProvider;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.DeleteItemOutcome;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Item;

import com.amazonaws.services.dynamodbv2.document.Table;

import com.amazonaws.services.dynamodbv2.document.UpdateItemOutcome;

import com.amazonaws.services.dynamodbv2.document.spec.DeleteItemSpec;

import com.amazonaws.services.dynamodbv2.document.spec.UpdateItemSpec;

import com.amazonaws.services.dynamodbv2.document.utils.NameMap;

import com.amazonaws.services.dynamodbv2.document.utils.ValueMap;

import com.amazonaws.services.dynamodbv2.model.ReturnValue;

public class GetItemOpSample {

static DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient(

new ProfileCredentialsProvider()));

static String tblName = "ProductList";

public static void main(String[] args) throws IOException {

createItems();

retrieveItem();

// Execute updates

updateMultipleAttributes();

updateAddNewAttribute();

updateExistingAttributeConditionally();

// Item deletion

deleteItem();

}

private static void createItems() {

Table table = dynamoDB.getTable(tblName);

try {

Item item = new Item()

.withPrimaryKey("ID", 303)

.withString("Nomenclature", "Polymer Blaster 4000")

.withStringSet( "Manufacturers",

new HashSet<String>(Arrays.asList("XYZ Inc.", "LMNOP Inc.")))

.withNumber("Price", 50000)

.withBoolean("InProduction", true)

.withString("Category", "Laser Cutter");

table.putItem(item);

item = new Item()

.withPrimaryKey("ID", 313)

.withString("Nomenclature", "Agitatatron 2000")

.withStringSet( "Manufacturers",

new HashSet<String>(Arrays.asList("XYZ Inc,", "CDE Inc.")))

.withNumber("Price", 40000)

.withBoolean("InProduction", true)

.withString("Category", "Agitator");

table.putItem(item);

} catch (Exception e) {

System.err.println("Cannot create items.");

System.err.println(e.getMessage());

}

}

private static void retrieveItem() {

Table table = dynamoDB.getTable(tableName);

try {

Item item = table.getItem("ID", 303, "ID, Nomenclature, Manufacturers", null);

System.out.println("Displaying retrieved items...");

System.out.println(item.toJSONPretty());

} catch (Exception e) {

System.err.println("Cannot retrieve items.");

System.err.println(e.getMessage());

}

}

}La mise à jour d'un élément dans DynamoDB consiste principalement à spécifier la clé primaire complète et le nom de table de l'élément. Il nécessite une nouvelle valeur pour chaque attribut que vous modifiez. L'opération utiliseUpdateItem, qui modifie les éléments existants ou les crée lors de la découverte d'un élément manquant.

Dans les mises à jour, vous souhaiterez peut-être suivre les modifications en affichant les valeurs d'origine et les nouvelles valeurs, avant et après les opérations. UpdateItem utilise leReturnValues paramètre pour y parvenir.

Note - L'opération ne rapporte pas la consommation d'unité de capacité, mais vous pouvez utiliser ReturnConsumedCapacity paramètre.

Utilisez la console GUI, Java ou tout autre outil pour effectuer cette tâche.

Comment mettre à jour des éléments à l'aide des outils GUI?

Accédez à la console. Dans le volet de navigation sur le côté gauche, sélectionnezTables. Choisissez la table nécessaire, puis sélectionnez leItems languette.

Choisissez l'élément souhaité pour une mise à jour et sélectionnez Actions | Edit.

Modifiez les attributs ou valeurs nécessaires dans le Edit Item la fenêtre.

Mettre à jour les éléments à l'aide de Java

L'utilisation de Java dans les opérations de mise à jour des éléments nécessite la création d'une instance de classe Table et l'appel de son updateItemméthode. Ensuite, vous spécifiez la clé primaire de l'élément et fournissez unUpdateExpression détaillant les modifications d'attributs.

Ce qui suit est un exemple de la même chose -

DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient(

new ProfileCredentialsProvider()));

Table table = dynamoDB.getTable("ProductList");

Map<String, String> expressionAttributeNames = new HashMap<String, String>();

expressionAttributeNames.put("#M", "Make");

expressionAttributeNames.put("#P", "Price

expressionAttributeNames.put("#N", "ID");

Map<String, Object> expressionAttributeValues = new HashMap<String, Object>();

expressionAttributeValues.put(":val1",

new HashSet<String>(Arrays.asList("Make1","Make2")));

expressionAttributeValues.put(":val2", 1); //Price

UpdateItemOutcome outcome = table.updateItem(

"internalID", // key attribute name

111, // key attribute value

"add #M :val1 set #P = #P - :val2 remove #N", // UpdateExpression

expressionAttributeNames,

expressionAttributeValues);le updateItem La méthode permet également de spécifier des conditions, qui peuvent être vues dans l'exemple suivant -

Table table = dynamoDB.getTable("ProductList");

Map<String, String> expressionAttributeNames = new HashMap<String, String>();

expressionAttributeNames.put("#P", "Price");

Map<String, Object> expressionAttributeValues = new HashMap<String, Object>();

expressionAttributeValues.put(":val1", 44); // change Price to 44

expressionAttributeValues.put(":val2", 15); // only if currently 15

UpdateItemOutcome outcome = table.updateItem (new PrimaryKey("internalID",111),

"set #P = :val1", // Update

"#P = :val2", // Condition

expressionAttributeNames,

expressionAttributeValues);Mettre à jour les éléments à l'aide de compteurs

DynamoDB autorise les compteurs atomiques, ce qui signifie utiliser UpdateItem pour incrémenter / décrémenter les valeurs d'attribut sans affecter les autres demandes; de plus, les compteurs sont toujours mis à jour.

Voici un exemple qui explique comment cela peut être fait.

Note- L'exemple suivant peut supposer une source de données précédemment créée. Avant de tenter de l'exécuter, acquérez les bibliothèques de prise en charge et créez les sources de données nécessaires (tables avec les caractéristiques requises ou autres sources référencées).

Cet exemple utilise également Eclipse IDE, un fichier d'informations d'identification AWS et AWS Toolkit dans un projet Eclipse AWS Java.

package com.amazonaws.codesamples.document;

import java.io.IOException;

import java.util.Arrays;

import java.util.HashMap;

import java.util.HashSet;

import java.util.Map;

import com.amazonaws.auth.profile.ProfileCredentialsProvider;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.DeleteItemOutcome;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Item;

import com.amazonaws.services.dynamodbv2.document.Table;

import com.amazonaws.services.dynamodbv2.document.UpdateItemOutcome;

import com.amazonaws.services.dynamodbv2.document.spec.DeleteItemSpec;

import com.amazonaws.services.dynamodbv2.document.spec.UpdateItemSpec;

import com.amazonaws.services.dynamodbv2.document.utils.NameMap;

import com.amazonaws.services.dynamodbv2.document.utils.ValueMap;

import com.amazonaws.services.dynamodbv2.model.ReturnValue;

public class UpdateItemOpSample {

static DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient(

new ProfileCredentialsProvider()));

static String tblName = "ProductList";

public static void main(String[] args) throws IOException {

createItems();

retrieveItem();

// Execute updates

updateMultipleAttributes();

updateAddNewAttribute();

updateExistingAttributeConditionally();

// Item deletion

deleteItem();

}

private static void createItems() {

Table table = dynamoDB.getTable(tblName);

try {

Item item = new Item()

.withPrimaryKey("ID", 303)

.withString("Nomenclature", "Polymer Blaster 4000")

.withStringSet( "Manufacturers",

new HashSet<String>(Arrays.asList("XYZ Inc.", "LMNOP Inc.")))

.withNumber("Price", 50000)

.withBoolean("InProduction", true)

.withString("Category", "Laser Cutter");

table.putItem(item);

item = new Item()

.withPrimaryKey("ID", 313)

.withString("Nomenclature", "Agitatatron 2000")

.withStringSet( "Manufacturers",

new HashSet<String>(Arrays.asList("XYZ Inc,", "CDE Inc.")))

.withNumber("Price", 40000)

.withBoolean("InProduction", true)

.withString("Category", "Agitator");

table.putItem(item);

} catch (Exception e) {

System.err.println("Cannot create items.");

System.err.println(e.getMessage());

}

}

private static void updateAddNewAttribute() {

Table table = dynamoDB.getTable(tableName);

try {

Map<String, String> expressionAttributeNames = new HashMap<String, String>();

expressionAttributeNames.put("#na", "NewAttribute");

UpdateItemSpec updateItemSpec = new UpdateItemSpec()

.withPrimaryKey("ID", 303)

.withUpdateExpression("set #na = :val1")

.withNameMap(new NameMap()

.with("#na", "NewAttribute"))

.withValueMap(new ValueMap()

.withString(":val1", "A value"))

.withReturnValues(ReturnValue.ALL_NEW);

UpdateItemOutcome outcome = table.updateItem(updateItemSpec);

// Confirm

System.out.println("Displaying updated item...");

System.out.println(outcome.getItem().toJSONPretty());

} catch (Exception e) {

System.err.println("Cannot add an attribute in " + tableName);

System.err.println(e.getMessage());

}

}

}La suppression d'un élément dans DynamoDB nécessite uniquement de fournir le nom de la table et la clé d'élément. Il est également fortement recommandé d'utiliser une expression conditionnelle qui sera nécessaire pour éviter de supprimer les mauvais éléments.

Comme d'habitude, vous pouvez utiliser la console GUI, Java ou tout autre outil nécessaire pour effectuer cette tâche.

Supprimer des éléments à l'aide de la console GUI

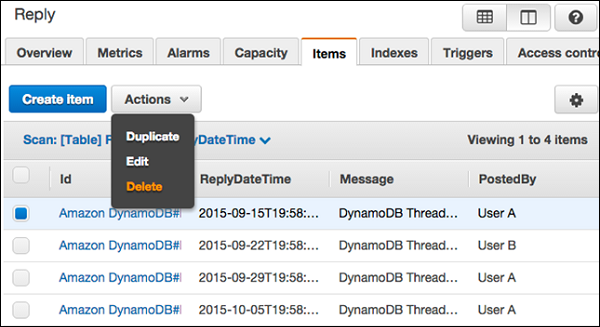

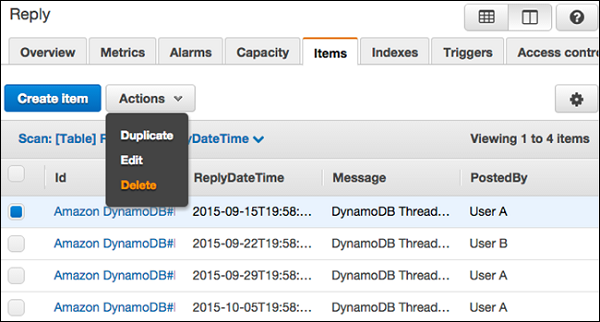

Accédez à la console. Dans le volet de navigation sur le côté gauche, sélectionnezTables. Sélectionnez ensuite le nom de la table et leItems languette.

Choisissez les éléments que vous souhaitez supprimer et sélectionnez Actions | Delete.

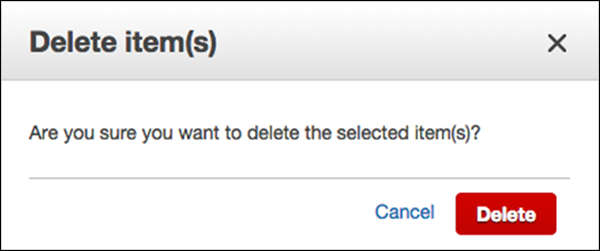

UNE Delete Item(s)La boîte de dialogue apparaît alors comme indiqué dans la capture d'écran suivante. Choisissez «Supprimer» pour confirmer.

Comment supprimer des éléments à l'aide de Java?

L'utilisation de Java dans les opérations de suppression d'éléments implique simplement la création d'une instance client DynamoDB et l'appel de deleteItem méthode en utilisant la clé de l'élément.

Vous pouvez voir l'exemple suivant, où il a été expliqué en détail.

DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient(

new ProfileCredentialsProvider()));

Table table = dynamoDB.getTable("ProductList");

DeleteItemOutcome outcome = table.deleteItem("IDnum", 151);Vous pouvez également spécifier les paramètres à protéger contre une suppression incorrecte. Utilisez simplement unConditionExpression.

Par exemple -

Map<String,Object> expressionAttributeValues = new HashMap<String,Object>();

expressionAttributeValues.put(":val", false);

DeleteItemOutcome outcome = table.deleteItem("IDnum",151,

"Ship = :val",

null, // doesn't use ExpressionAttributeNames

expressionAttributeValues);Voici un exemple plus large pour une meilleure compréhension.

Note- L'exemple suivant peut supposer une source de données précédemment créée. Avant de tenter de l'exécuter, acquérez les bibliothèques de prise en charge et créez les sources de données nécessaires (tables avec les caractéristiques requises ou autres sources référencées).

Cet exemple utilise également Eclipse IDE, un fichier d'informations d'identification AWS et AWS Toolkit dans un projet Eclipse AWS Java.

package com.amazonaws.codesamples.document;

import java.io.IOException;

import java.util.Arrays;

import java.util.HashMap;

import java.util.HashSet;

import java.util.Map;

import com.amazonaws.auth.profile.ProfileCredentialsProvider;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.DeleteItemOutcome;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Item;

import com.amazonaws.services.dynamodbv2.document.Table;

import com.amazonaws.services.dynamodbv2.document.UpdateItemOutcome;

import com.amazonaws.services.dynamodbv2.document.spec.DeleteItemSpec;

import com.amazonaws.services.dynamodbv2.document.spec.UpdateItemSpec;

import com.amazonaws.services.dynamodbv2.document.utils.NameMap;

import com.amazonaws.services.dynamodbv2.document.utils.ValueMap;

import com.amazonaws.services.dynamodbv2.model.ReturnValue;

public class DeleteItemOpSample {

static DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient(

new ProfileCredentialsProvider()));

static String tblName = "ProductList";

public static void main(String[] args) throws IOException {

createItems();

retrieveItem();

// Execute updates

updateMultipleAttributes();

updateAddNewAttribute();

updateExistingAttributeConditionally();

// Item deletion

deleteItem();

}

private static void createItems() {

Table table = dynamoDB.getTable(tblName);

try {

Item item = new Item()

.withPrimaryKey("ID", 303)

.withString("Nomenclature", "Polymer Blaster 4000")

.withStringSet( "Manufacturers",

new HashSet<String>(Arrays.asList("XYZ Inc.", "LMNOP Inc.")))

.withNumber("Price", 50000)

.withBoolean("InProduction", true)

.withString("Category", "Laser Cutter");

table.putItem(item);

item = new Item()

.withPrimaryKey("ID", 313)

.withString("Nomenclature", "Agitatatron 2000")

.withStringSet( "Manufacturers",

new HashSet<String>(Arrays.asList("XYZ Inc,", "CDE Inc.")))

.withNumber("Price", 40000)

.withBoolean("InProduction", true)

.withString("Category", "Agitator");

table.putItem(item);

} catch (Exception e) {

System.err.println("Cannot create items.");

System.err.println(e.getMessage());

}

}

private static void deleteItem() {

Table table = dynamoDB.getTable(tableName);

try {

DeleteItemSpec deleteItemSpec = new DeleteItemSpec()

.withPrimaryKey("ID", 303)

.withConditionExpression("#ip = :val")

.withNameMap(new NameMap()

.with("#ip", "InProduction"))

.withValueMap(new ValueMap()

.withBoolean(":val", false))

.withReturnValues(ReturnValue.ALL_OLD);

DeleteItemOutcome outcome = table.deleteItem(deleteItemSpec);

// Confirm

System.out.println("Displaying deleted item...");

System.out.println(outcome.getItem().toJSONPretty());

} catch (Exception e) {

System.err.println("Cannot delete item in " + tableName);

System.err.println(e.getMessage());

}

}

}L'écriture par lots opère sur plusieurs éléments en créant ou en supprimant plusieurs éléments. Ces opérations utilisentBatchWriteItem, qui comporte les limites de pas plus de 16 Mo d'écritures et de 25 requêtes. Chaque élément obéit à une limite de taille de 400 Ko. Les écritures par lots ne peuvent pas non plus effectuer de mises à jour d'éléments.

Qu'est-ce que l'écriture par lots?

Les écritures par lots peuvent manipuler des éléments sur plusieurs tables. L'appel d'opération se produit pour chaque demande individuelle, ce qui signifie que les opérations n'ont pas d'impact les unes sur les autres et que les mélanges hétérogènes sont autorisés; par exemple, unPutItem et trois DeleteItemrequêtes dans un lot, l'échec de la requête PutItem n'affectant pas les autres. Les demandes ayant échoué entraînent le retour des informations (clés et données) relatives à chaque demande échouée.

Note- Si DynamoDB renvoie des éléments sans les traiter, réessayez-les; cependant, utilisez une méthode d'interruption pour éviter un autre échec de demande basé sur une surcharge.

DynamoDB rejette une opération d'écriture par lots lorsqu'une ou plusieurs des instructions suivantes s'avèrent vraies -

La demande dépasse le débit alloué.

La demande tente d'utiliser BatchWriteItems pour mettre à jour un élément.

La demande effectue plusieurs opérations sur un seul élément.

Les tables de requêtes n'existent pas.

Les attributs d'élément dans la demande ne correspondent pas à la cible.

Les demandes dépassent les limites de taille.

Les écritures par lots nécessitent certaines RequestItem paramètres -

Les opérations de suppression nécessitent DeleteRequest clé subelements signifiant un nom et une valeur d'attribut.

le PutRequest les articles nécessitent un Item subelement signifiant une carte d'attribut et de valeur d'attribut.

Response - Une opération réussie entraîne une réponse HTTP 200, qui indique des caractéristiques telles que les unités de capacité consommées, les métriques de traitement de table et tout élément non traité.

Écrit par lots avec Java

Effectuez une écriture par lots en créant une instance de classe DynamoDB, un TableWriteItems instance de classe décrivant toutes les opérations et appelant le batchWriteItem méthode pour utiliser l'objet TableWriteItems.

Note- Vous devez créer une instance TableWriteItems pour chaque table dans une écriture par lots dans plusieurs tables. Vérifiez également votre réponse à la demande pour toute demande non traitée.

Vous pouvez consulter l'exemple suivant d'écriture par lots -

DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient(

new ProfileCredentialsProvider()));

TableWriteItems forumTableWriteItems = new TableWriteItems("Forum")

.withItemsToPut(

new Item()

.withPrimaryKey("Title", "XYZ CRM")

.withNumber("Threads", 0));

TableWriteItems threadTableWriteItems = new TableWriteItems(Thread)

.withItemsToPut(

new Item()

.withPrimaryKey("ForumTitle","XYZ CRM","Topic","Updates")

.withHashAndRangeKeysToDelete("ForumTitle","A partition key value",

"Product Line 1", "A sort key value"));

BatchWriteItemOutcome outcome = dynamoDB.batchWriteItem (

forumTableWriteItems, threadTableWriteItems);Le programme suivant est un autre exemple plus complet permettant de mieux comprendre comment un lot écrit avec Java.

Note- L'exemple suivant peut supposer une source de données précédemment créée. Avant de tenter de l'exécuter, acquérez les bibliothèques de prise en charge et créez les sources de données nécessaires (tables avec les caractéristiques requises ou autres sources référencées).

Cet exemple utilise également Eclipse IDE, un fichier d'informations d'identification AWS et AWS Toolkit dans un projet Eclipse AWS Java.

package com.amazonaws.codesamples.document;

import java.io.IOException;

import java.util.Arrays;

import java.util.HashSet;

import java.util.List;

import java.util.Map;

import com.amazonaws.auth.profile.ProfileCredentialsProvider;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.BatchWriteItemOutcome;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Item;

import com.amazonaws.services.dynamodbv2.document.TableWriteItems;

import com.amazonaws.services.dynamodbv2.model.WriteRequest;

public class BatchWriteOpSample {

static DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient(

new ProfileCredentialsProvider()));

static String forumTableName = "Forum";

static String threadTableName = "Thread";

public static void main(String[] args) throws IOException {

batchWriteMultiItems();

}

private static void batchWriteMultiItems() {

try {

// Place new item in Forum

TableWriteItems forumTableWriteItems = new TableWriteItems(forumTableName)

//Forum

.withItemsToPut(new Item()

.withPrimaryKey("Name", "Amazon RDS")

.withNumber("Threads", 0));

// Place one item, delete another in Thread

// Specify partition key and range key

TableWriteItems threadTableWriteItems = new TableWriteItems(threadTableName)

.withItemsToPut(new Item()

.withPrimaryKey("ForumName","Product

Support","Subject","Support Thread 1")

.withString("Message", "New OS Thread 1 message")

.withHashAndRangeKeysToDelete("ForumName","Subject", "Polymer Blaster",

"Support Thread 100"));

System.out.println("Processing request...");

BatchWriteItemOutcome outcome = dynamoDB.batchWriteItem (

forumTableWriteItems, threadTableWriteItems);

do {

// Confirm no unprocessed items

Map<String, List<WriteRequest>> unprocessedItems

= outcome.getUnprocessedItems();

if (outcome.getUnprocessedItems().size() == 0) {

System.out.println("All items processed.");

} else {

System.out.println("Gathering unprocessed items...");

outcome = dynamoDB.batchWriteItemUnprocessed(unprocessedItems);

}

} while (outcome.getUnprocessedItems().size() > 0);

} catch (Exception e) {

System.err.println("Could not get items: ");

e.printStackTrace(System.err);

}

}

}Les opérations de récupération par lots renvoient les attributs d'un ou de plusieurs éléments. Ces opérations consistent généralement à utiliser la clé primaire pour identifier le ou les éléments souhaités. leBatchGetItem les opérations sont soumises aux limites des opérations individuelles ainsi qu'à leurs propres contraintes uniques.

Les requêtes suivantes dans les opérations de récupération par lots entraînent un rejet -

- Faites une demande pour plus de 100 articles.

- Faites une demande dépassant le débit.

Les opérations de récupération par lots effectuent un traitement partiel des demandes susceptibles de dépasser les limites.

For example- une demande de récupération de plusieurs éléments de taille suffisante pour dépasser les limites entraîne une partie du traitement de la demande et un message d'erreur indiquant la partie non traitée. Au retour des éléments non traités, créez une solution d'algorithme de back-off pour gérer cela plutôt que de limiter les tables.

le BatchGetles opérations s'effectuent finalement avec des lectures cohérentes, nécessitant des modifications pour celles qui sont fortement cohérentes. Ils effectuent également des récupérations en parallèle.

Note- L'ordre des articles retournés. DynamoDB ne trie pas les éléments. Il n'indique pas non plus l'absence des articles demandés. De plus, ces demandes consomment des unités de capacité.

Toutes les opérations BatchGet nécessitent RequestItems des paramètres tels que la cohérence de lecture, les noms d'attributs et les clés primaires.

Response - Une opération réussie entraîne une réponse HTTP 200, qui indique des caractéristiques telles que les unités de capacité consommées, les métriques de traitement de table et tout élément non traité.

Récupérations par lots avec Java

L'utilisation de Java dans les opérations BatchGet nécessite la création d'une instance de classe DynamoDB, TableKeysAndAttributes instance de classe décrivant une liste de valeurs de clé primaire pour les éléments et passant l'objet TableKeysAndAttributes à BatchGetItem méthode.

Voici un exemple d'opération BatchGet -

DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient (

new ProfileCredentialsProvider()));

TableKeysAndAttributes forumTableKeysAndAttributes = new TableKeysAndAttributes

(forumTableName);

forumTableKeysAndAttributes.addHashOnlyPrimaryKeys (

"Title",

"Updates",

"Product Line 1"

);

TableKeysAndAttributes threadTableKeysAndAttributes = new TableKeysAndAttributes (

threadTableName);

threadTableKeysAndAttributes.addHashAndRangePrimaryKeys (

"ForumTitle",

"Topic",

"Product Line 1",

"P1 Thread 1",

"Product Line 1",

"P1 Thread 2",

"Product Line 2",

"P2 Thread 1"

);

BatchGetItemOutcome outcome = dynamoDB.batchGetItem (

forumTableKeysAndAttributes, threadTableKeysAndAttributes);

for (String tableName : outcome.getTableItems().keySet()) {

System.out.println("Table items " + tableName);

List<Item> items = outcome.getTableItems().get(tableName);

for (Item item : items) {

System.out.println(item);

}

}Vous pouvez consulter l'exemple plus large suivant.

Note- Le programme suivant peut supposer une source de données précédemment créée. Avant de tenter de l'exécuter, acquérez les bibliothèques de prise en charge et créez les sources de données nécessaires (tables avec les caractéristiques requises ou autres sources référencées).

Ce programme utilise également Eclipse IDE, un fichier d'informations d'identification AWS et AWS Toolkit dans un projet Eclipse AWS Java.

package com.amazonaws.codesamples.document;

import java.io.IOException;

import java.util.List;

import java.util.Map;

import com.amazonaws.auth.profile.ProfileCredentialsProvider;

import com.amazonaws.services.dynamodbv2.AmazonDynamoDBClient;

import com.amazonaws.services.dynamodbv2.document.BatchGetItemOutcome;

import com.amazonaws.services.dynamodbv2.document.DynamoDB;

import com.amazonaws.services.dynamodbv2.document.Item;

import com.amazonaws.services.dynamodbv2.document.TableKeysAndAttributes;

import com.amazonaws.services.dynamodbv2.model.KeysAndAttributes;

public class BatchGetOpSample {

static DynamoDB dynamoDB = new DynamoDB(new AmazonDynamoDBClient (

new ProfileCredentialsProvider()));

static String forumTableName = "Forum";

static String threadTableName = "Thread";

public static void main(String[] args) throws IOException {

retrieveMultipleItemsBatchGet();

}

private static void retrieveMultipleItemsBatchGet() {

try {

TableKeysAndAttributes forumTableKeysAndAttributes =

new TableKeysAndAttributes(forumTableName);

//Create partition key

forumTableKeysAndAttributes.addHashOnlyPrimaryKeys (

"Name",

"XYZ Melt-O-tron",

"High-Performance Processing"

);

TableKeysAndAttributes threadTableKeysAndAttributes =

new TableKeysAndAttributes(threadTableName);

//Create partition key and sort key

threadTableKeysAndAttributes.addHashAndRangePrimaryKeys (

"ForumName",

"Subject",

"High-Performance Processing",

"HP Processing Thread One",

"High-Performance Processing",

"HP Processing Thread Two",

"Melt-O-Tron",

"MeltO Thread One"

);

System.out.println("Processing...");

BatchGetItemOutcome outcome = dynamoDB.batchGetItem(forumTableKeysAndAttributes,

threadTableKeysAndAttributes);

Map<String, KeysAndAttributes> unprocessed = null;

do {

for (String tableName : outcome.getTableItems().keySet()) {

System.out.println("Table items for " + tableName);

List<Item> items = outcome.getTableItems().get(tableName);

for (Item item : items) {

System.out.println(item.toJSONPretty());

}

}

// Confirm no unprocessed items

unprocessed = outcome.getUnprocessedKeys();

if (unprocessed.isEmpty()) {

System.out.println("All items processed.");

} else {

System.out.println("Gathering unprocessed items...");

outcome = dynamoDB.batchGetItemUnprocessed(unprocessed);

}

} while (!unprocessed.isEmpty());

} catch (Exception e) {

System.err.println("Could not get items.");

System.err.println(e.getMessage());

}

}

}Les requêtes localisent des éléments ou des index secondaires via des clés primaires. L'exécution d'une requête nécessite une clé de partition et une valeur spécifique, ou une clé de tri et une valeur; avec la possibilité de filtrer avec des comparaisons. Le comportement par défaut d'une requête consiste à renvoyer tous les attributs des éléments associés à la clé primaire fournie. Cependant, vous pouvez spécifier les attributs souhaités avec leProjectionExpression paramètre.

Une requête utilise le KeyConditionExpressionparamètres pour sélectionner des éléments, ce qui nécessite de fournir le nom et la valeur de la clé de partition sous la forme d'une condition d'égalité. Vous avez également la possibilité de fournir une condition supplémentaire pour les clés de tri présentes.

Quelques exemples de conditions de clé de tri sont:

| Sr.Non | Description de la condition |

|---|---|

| 1 | x = y Il prend la valeur true si l'attribut x est égal à y. |

| 2 | x < y Il prend la valeur true si x est inférieur à y. |

| 3 | x <= y Il prend la valeur true si x est inférieur ou égal à y. |

| 4 | x > y Il prend la valeur true si x est supérieur à y. |

| 5 | x >= y Il prend la valeur true si x est supérieur ou égal à y. |

| 6 | x BETWEEN y AND z Il prend la valeur true si x est à la fois> = y et <= z. |

DynamoDB prend également en charge les fonctions suivantes: begins_with (x, substr)

Il prend la valeur true si l'attribut x commence par la chaîne spécifiée.

Les conditions suivantes doivent être conformes à certaines exigences -

Les noms d'attribut doivent commencer par un caractère dans le jeu az ou AZ.

Le deuxième caractère d'un nom d'attribut doit appartenir à l'ensemble az, AZ ou 0-9.

Les noms d'attribut ne peuvent pas utiliser de mots réservés.

Les noms d'attributs non conformes aux contraintes ci-dessus peuvent définir un espace réservé.

La requête est traitée en effectuant des extractions dans l'ordre des clés de tri et en utilisant toutes les expressions de condition et de filtre présentes. Les requêtes renvoient toujours un jeu de résultats et, en l'absence de correspondances, elles renvoient un jeu vide.

Les résultats retournent toujours dans l'ordre des clés de tri et dans l'ordre basé sur le type de données avec la valeur par défaut modifiable comme ordre croissant.

Interroger avec Java

Les requêtes en Java vous permettent d'interroger des tables et des index secondaires. Ils nécessitent la spécification des clés de partition et des conditions d'égalité, avec la possibilité de spécifier des clés de tri et des conditions.

Les étapes générales requises pour une requête en Java incluent la création d'une instance de classe DynamoDB, une instance de classe Table pour la table cible et l'appel de la méthode de requête de l'instance Table pour recevoir l'objet de requête.

La réponse à la requête contient un ItemCollection objet fournissant tous les articles retournés.

L'exemple suivant illustre une requête détaillée -

DynamoDB dynamoDB = new DynamoDB (

new AmazonDynamoDBClient(new ProfileCredentialsProvider()));

Table table = dynamoDB.getTable("Response");

QuerySpec spec = new QuerySpec()

.withKeyConditionExpression("ID = :nn")

.withValueMap(new ValueMap()

.withString(":nn", "Product Line 1#P1 Thread 1"));

ItemCollection<QueryOutcome> items = table.query(spec);

Iterator<Item> iterator = items.iterator();

Item item = null;

while (iterator.hasNext()) {

item = iterator.next();

System.out.println(item.toJSONPretty());