Sécurité réseau - Guide rapide

Dans cette ère moderne, les organisations comptent beaucoup sur les réseaux informatiques pour partager des informations dans toute l'organisation de manière efficace et productive. Les réseaux informatiques organisationnels deviennent maintenant vastes et omniprésents. En supposant que chaque membre du personnel dispose d'un poste de travail dédié, une grande entreprise disposerait de quelques milliers de postes de travail et de nombreux serveurs sur le réseau.

Il est probable que ces postes de travail ne soient pas gérés de manière centralisée et qu'ils ne disposeraient pas non plus d'une protection périmétrique. Ils peuvent avoir une variété de systèmes d'exploitation, de matériel, de logiciels et de protocoles, avec différents niveaux de cyber-sensibilisation parmi les utilisateurs. Imaginez maintenant, ces milliers de postes de travail sur le réseau de l'entreprise sont directement connectés à Internet. Ce type de réseau non sécurisé devient la cible d'une attaque qui contient des informations précieuses et affiche des vulnérabilités.

Dans ce chapitre, nous décrivons les principales vulnérabilités du réseau et l'importance de la sécurité du réseau. Dans les chapitres suivants, nous discuterons des méthodes pour y parvenir.

Réseau physique

Un réseau est défini comme deux appareils informatiques ou plus connectés ensemble pour partager efficacement les ressources. En outre, la connexion de deux ou plusieurs réseaux ensemble est appeléeinternetworking. Ainsi, Internet n'est qu'un interréseau - un ensemble de réseaux interconnectés.

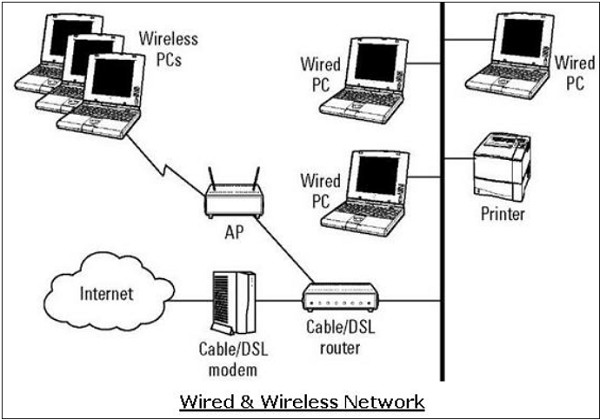

Pour mettre en place son réseau interne, une organisation dispose de plusieurs options. Il peut utiliser un réseau filaire ou un réseau sans fil pour connecter toutes les stations de travail. De nos jours, les organisations utilisent principalement une combinaison de réseaux filaires et sans fil.

Réseaux filaires et sans fil

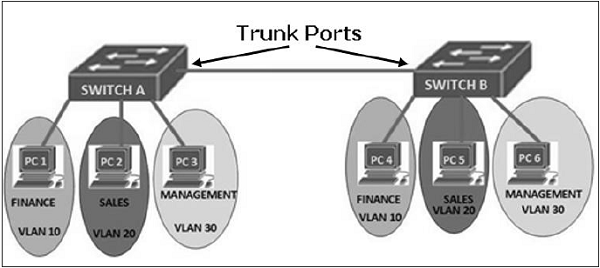

Dans un réseau filaire, les appareils sont connectés les uns aux autres à l'aide de câbles. En règle générale, les réseaux câblés sont basés sur le protocole Ethernet où les appareils sont connectés à l'aide de câbles UTP (Unshielded Twisted Pair) aux différents commutateurs. Ces commutateurs sont en outre connectés au routeur réseau pour accéder à Internet.

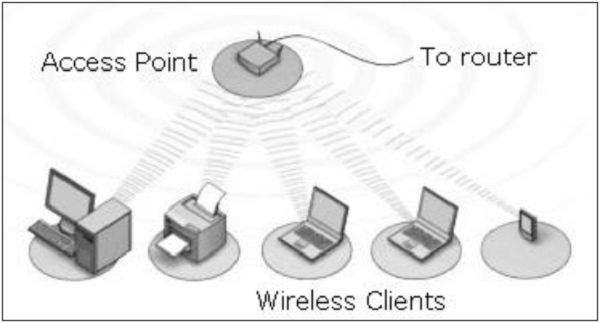

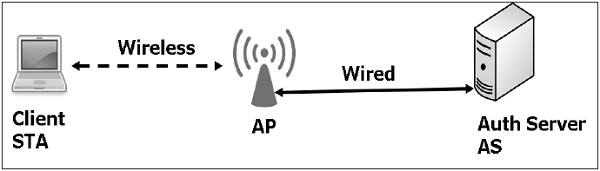

Dans un réseau sans fil, l'appareil est connecté à un point d'accès via des transmissions radio. Les points d'accès sont en outre connectés via des câbles au commutateur / routeur pour l'accès au réseau externe.

Les réseaux sans fil ont gagné en popularité en raison de la mobilité qu'ils offrent. Les appareils mobiles n'ont pas besoin d'être attachés à un câble et peuvent se déplacer librement dans la portée du réseau sans fil. Cela garantit un partage d'informations efficace et augmente la productivité.

Vulnérabilités et attaques

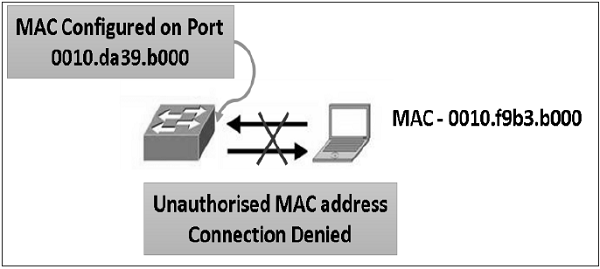

La vulnérabilité commune qui existe à la fois dans les réseaux filaires et sans fil est un «accès non autorisé» à un réseau. Un attaquant peut connecter son appareil à un réseau via un port hub / switch non sécurisé. À cet égard, le réseau sans fil est considéré comme moins sécurisé que le réseau filaire, car le réseau sans fil est facilement accessible sans aucune connexion physique.

Après avoir accédé, un attaquant peut exploiter cette vulnérabilité pour lancer des attaques telles que -

Renifler les données du paquet pour voler des informations précieuses.

Déni de service aux utilisateurs légitimes sur un réseau en inondant le support réseau de paquets parasites.

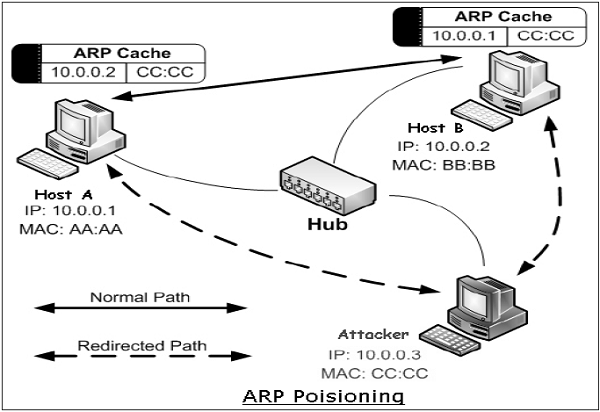

Usurpation d'identité physique (MAC) d'hôtes légitimes, puis vol de données ou lancement d'une attaque de type `` man-in-the-middle ''.

Protocole réseau

Le protocole réseau est un ensemble de règles qui régissent les communications entre les appareils connectés sur un réseau. Ils comprennent des mécanismes pour établir des connexions, ainsi que des règles de formatage pour le conditionnement des données pour les messages envoyés et reçus.

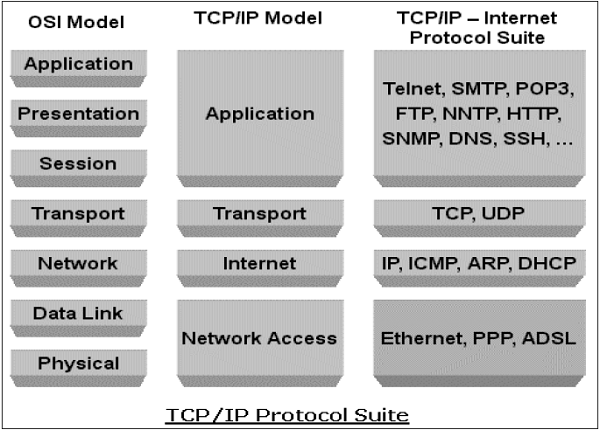

Plusieurs protocoles de réseau informatique ont été développés chacun à des fins spécifiques. Les protocoles populaires et largement utilisés sont TCP / IP avec des protocoles associés de niveau supérieur et inférieur.

Protocole TCP / IP

Transmission Control Protocol (TCP) et Internet Protocol(IP) sont deux protocoles de réseau informatique distincts principalement utilisés ensemble. En raison de leur popularité et de leur large adoption, ils sont intégrés à tous les systèmes d'exploitation des appareils en réseau.

IP correspond à la couche réseau (couche 3) tandis que TCP correspond à la couche transport (couche 4) en OSI. TCP / IP s'applique aux communications réseau où le transport TCP est utilisé pour fournir des données sur les réseaux IP.

Les protocoles TCP / IP sont couramment utilisés avec d'autres protocoles tels que HTTP, FTP, SSH au niveau de la couche application et Ethernet au niveau de la liaison de données / couche physique.

La suite de protocoles TCP / IP a été créée en 1980 en tant que solution d'interréseau avec très peu de souci pour les aspects de sécurité.

Il a été développé pour une communication dans le réseau de confiance limité. Cependant, sur une période, ce protocole est devenu la norme de facto pour la communication Internet non sécurisée.

Certaines des vulnérabilités de sécurité courantes des combinaisons de protocole TCP / IP sont:

HTTP est un protocole de couche application dans la suite TCP / IP utilisé pour transférer des fichiers qui composent les pages Web à partir des serveurs Web. Ces transferts se font en texte brut et un intrus peut facilement lire les paquets de données échangés entre le serveur et un client.

Une autre vulnérabilité HTTP est une authentification faible entre le client et le serveur Web lors de l'initialisation de la session. Cette vulnérabilité peut conduire à une attaque de piratage de session où l'attaquant vole une session HTTP de l'utilisateur légitime.

La vulnérabilité du protocole TCP est la négociation à trois pour l'établissement de la connexion. Un attaquant peut lancer une attaque par déni de service «SYN-flooding» pour exploiter cette vulnérabilité. Il établit beaucoup de sessions semi-ouvertes en ne terminant pas la poignée de main. Cela conduit à une surcharge du serveur et éventuellement à un crash.

La couche IP est sensible à de nombreuses vulnérabilités. Grâce à une modification d'en-tête de protocole IP, un attaquant peut lancer une attaque d'usurpation d'adresse IP.

Outre ce qui précède, de nombreuses autres vulnérabilités de sécurité existent dans la famille de protocoles TCP / IP dans la conception ainsi que dans sa mise en œuvre.

Incidemment, dans la communication réseau basée sur TCP / IP, si une couche est piratée, les autres couches ne prennent pas conscience du piratage et toute la communication est compromise. Par conséquent, il est nécessaire d'employer des contrôles de sécurité à chaque couche pour assurer une sécurité à toute épreuve.

Protocole DNS

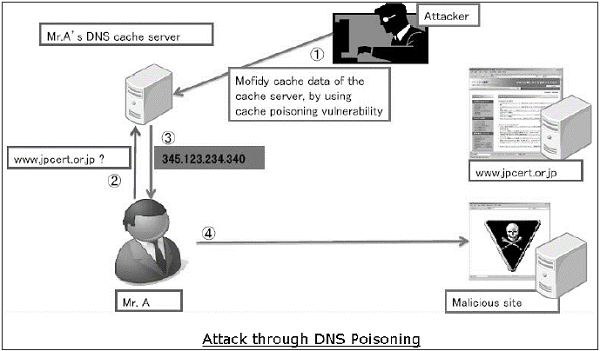

Domain Name System(DNS) est utilisé pour résoudre les noms de domaine hôte en adresses IP. Les utilisateurs du réseau dépendent de la fonctionnalité DNS principalement lors de la navigation sur Internet en tapant une URL dans le navigateur Web.

Lors d'une attaque sur DNS, le but d'un attaquant est de modifier un enregistrement DNS légitime afin qu'il soit résolu en une adresse IP incorrecte. Il peut diriger tout le trafic pour cette adresse IP vers le mauvais ordinateur. Un attaquant peut soit exploiter la vulnérabilité du protocole DNS, soit compromettre le serveur DNS pour matérialiser une attaque.

DNS cache poisoningest une attaque exploitant une vulnérabilité trouvée dans le protocole DNS. Un attaquant peut empoisonner le cache en forgeant une réponse à une requête DNS récursive envoyée par un résolveur à un serveur faisant autorité. Une fois que le cache du résolveur DNS est empoisonné, l'hôte sera dirigé vers un site Web malveillant et peut compromettre les informations d'identification en communiquant avec ce site.

Protocole ICMP

Internet Control Management Protocol(ICMP) est un protocole de gestion de réseau de base des réseaux TCP / IP. Il est utilisé pour envoyer des messages d'erreur et de contrôle concernant l'état des appareils en réseau.

ICMP fait partie intégrante de la mise en œuvre du réseau IP et est donc présent dans la configuration très réseau. ICMP a ses propres vulnérabilités et peut être utilisé abusivement pour lancer une attaque sur un réseau.

Les attaques courantes qui peuvent se produire sur un réseau en raison de vulnérabilités ICMP sont:

ICMP permet à un attaquant d'effectuer une reconnaissance du réseau pour déterminer la topologie du réseau et les chemins d'accès au réseau. Le balayage ICMP implique la découverte de toutes les adresses IP de l'hôte qui sont actives dans tout le réseau de la cible.

Trace route est un utilitaire ICMP populaire utilisé pour mapper le réseau cible en décrivant le chemin en temps réel entre le client et l'hôte distant.

Un attaquant peut lancer une attaque par déni de service en utilisant la vulnérabilité ICMP. Cette attaque implique l'envoi de paquets ping IPMP de plus de 65 535 octets au périphérique cible. L'ordinateur cible ne parvient pas à gérer correctement ce paquet et peut provoquer l'écrasement du système d'exploitation.

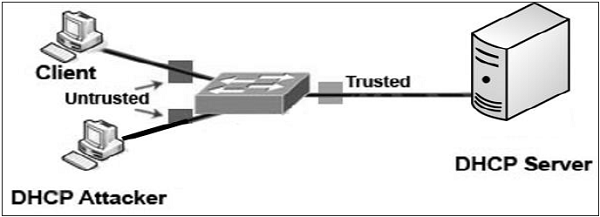

D'autres protocoles tels que ARP, DHCP, SMTP, etc. ont également leurs vulnérabilités qui peuvent être exploitées par l'attaquant pour compromettre la sécurité du réseau. Nous discuterons de certaines de ces vulnérabilités dans les chapitres suivants.

La moindre préoccupation pour l'aspect sécurité lors de la conception et de la mise en œuvre des protocoles est devenue une cause principale de menaces pour la sécurité du réseau.

Objectifs de la sécurité réseau

Comme indiqué dans les sections précédentes, il existe un grand nombre de vulnérabilités dans le réseau. Ainsi, lors de la transmission, les données sont très vulnérables aux attaques. Un attaquant peut cibler le canal de communication, obtenir les données et les lire ou réinsérer un faux message pour atteindre ses objectifs néfastes.

La sécurité du réseau ne concerne pas seulement la sécurité des ordinateurs à chaque extrémité de la chaîne de communication; cependant, il vise à garantir que l'ensemble du réseau est sécurisé.

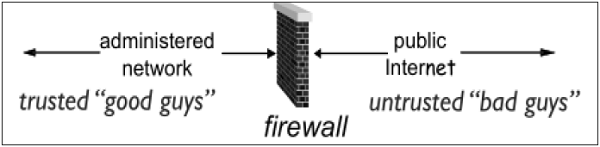

La sécurité du réseau implique la protection de la convivialité, de la fiabilité, de l'intégrité et de la sécurité du réseau et des données. Une sécurité réseau efficace empêche une variété de menaces d'entrer ou de se propager sur un réseau.

Le principal objectif de la sécurité du réseau est la confidentialité, l'intégrité et la disponibilité. Ces trois piliers de la sécurité réseau sont souvent représentés commeCIA triangle.

Confidentiality- La fonction de la confidentialité est de protéger les précieuses données commerciales des personnes non autorisées. La partie confidentialité de la sécurité du réseau garantit que les données ne sont disponibles que pour les personnes prévues et autorisées.

Integrity- Cet objectif signifie maintenir et garantir l'exactitude et la cohérence des données. La fonction de l'intégrité est de s'assurer que les données sont fiables et ne sont pas modifiées par des personnes non autorisées.

Availability - La fonction de disponibilité dans Network Security est de s'assurer que les données, les ressources / services réseau sont en permanence disponibles pour les utilisateurs légitimes, chaque fois qu'ils en ont besoin.

Atteindre la sécurité du réseau

Assurer la sécurité du réseau peut sembler très simple. Les objectifs à atteindre semblent simples. Mais en réalité, les mécanismes utilisés pour atteindre ces objectifs sont très complexes et leur compréhension implique un raisonnement solide.

International Telecommunication Union(UIT), dans sa recommandation sur l'architecture de sécurité X.800, a défini certains mécanismes pour amener la normalisation des méthodes pour assurer la sécurité du réseau. Certains de ces mécanismes sont -

En-cipherment- Ce mécanisme fournit des services de confidentialité des données en transformant les données en formes non lisibles pour les personnes non autorisées. Ce mécanisme utilise un algorithme de cryptage-décryptage avec des clés secrètes.

Digital signatures- Ce mécanisme est l'équivalent électronique des signatures ordinaires dans les données électroniques. Il fournit l'authenticité des données.

Access control- Ce mécanisme est utilisé pour fournir des services de contrôle d'accès. Ces mécanismes peuvent utiliser l'identification et l'authentification d'une entité pour déterminer et appliquer les droits d'accès de l'entité.

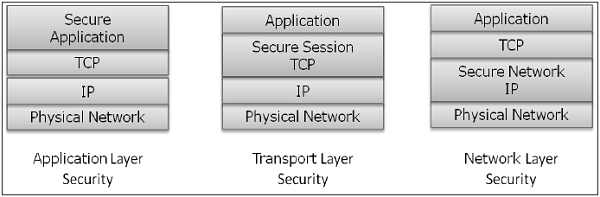

Après avoir développé et identifié divers mécanismes de sécurité pour assurer la sécurité du réseau, il est essentiel de décider où les appliquer; à la fois physiquement (à quel endroit) et logiquement (à quelle couche d'une architecture telle que TCP / IP).

Mécanismes de sécurité au niveau des couches réseau

Plusieurs mécanismes de sécurité ont été développés de manière à pouvoir être développés à une couche spécifique du modèle de couche réseau OSI.

Security at Application Layer- Les mesures de sécurité utilisées à cette couche sont spécifiques à l'application. Différents types d'applications nécessiteraient des mesures de sécurité distinctes. Afin d'assurer la sécurité de la couche application, les applications doivent être modifiées.

On considère que la conception d'un protocole d'application cryptographique sain est très difficile et sa mise en œuvre correcte est encore plus difficile. Par conséquent, il est préférable que les mécanismes de sécurité de la couche application destinés à protéger les communications réseau soient uniquement des solutions basées sur des normes qui sont utilisées depuis un certain temps.

Les extensions S / MIME (Secure Multipurpose Internet Mail Extensions), qui sont couramment utilisées pour crypter les messages électroniques, sont un exemple de protocole de sécurité de la couche application. DNSSEC est un autre protocole de cette couche utilisé pour l'échange sécurisé de messages de requête DNS.

Security at Transport Layer- Les mesures de sécurité à cette couche peuvent être utilisées pour protéger les données dans une seule session de communication entre deux hôtes. L'utilisation la plus courante des protocoles de sécurité de la couche de transport est la protection du trafic des sessions HTTP et FTP. Le Transport Layer Security (TLS) et le Secure Socket Layer (SSL) sont les protocoles les plus couramment utilisés à cette fin.

Network Layer- Les mesures de sécurité à cette couche peuvent être appliquées à toutes les applications; ainsi, ils ne sont pas spécifiques à l'application. Toutes les communications réseau entre deux hôtes ou réseaux peuvent être protégées au niveau de cette couche sans modifier aucune application. Dans certains environnements, le protocole de sécurité de la couche réseau tel que IPsec (Internet Protocol Security) offre une bien meilleure solution que les contrôles de couche de transport ou d'application en raison des difficultés d'ajout de contrôles à des applications individuelles. Cependant, les protocoles de sécurité à cette couche offrent moins de flexibilité de communication qui peut être requise par certaines applications.

Incidemment, un mécanisme de sécurité conçu pour fonctionner à une couche supérieure ne peut pas assurer la protection des données aux couches inférieures, car les couches inférieures exécutent des fonctions dont les couches supérieures ne sont pas conscientes. Par conséquent, il peut être nécessaire de déployer plusieurs mécanismes de sécurité pour améliorer la sécurité du réseau.

Dans les chapitres suivants du didacticiel, nous discuterons des mécanismes de sécurité utilisés aux différentes couches de l'architecture de réseau OSI pour assurer la sécurité du réseau.

Divers services commerciaux sont désormais proposés en ligne via des applications client-serveur. Les formulaires les plus courants sont les applications Web et les e-mails. Dans les deux applications, le client communique avec le serveur désigné et obtient des services.

Lors de l'utilisation d'un service depuis n'importe quelle application serveur, le client et le serveur échangent de nombreuses informations sur l'intranet ou Internet sous-jacent. Nous sommes conscients du fait que ces transactions d'informations sont vulnérables à diverses attaques.

La sécurité du réseau consiste à sécuriser les données contre les attaques lorsqu'elles sont en transit sur un réseau. Pour atteindre cet objectif, de nombreux protocoles de sécurité en temps réel ont été conçus. Un tel protocole doit fournir au moins les objectifs principaux suivants -

- Les parties peuvent négocier de manière interactive pour s'authentifier mutuellement.

- Établissez une clé de session secrète avant d'échanger des informations sur le réseau.

- Échangez les informations sous forme cryptée.

Fait intéressant, ces protocoles fonctionnent sur différentes couches du modèle de réseau. Par exemple, le protocole S / MIME fonctionne au niveau de la couche Application, le protocole SSL est développé pour fonctionner au niveau de la couche de transport et le protocole IPsec fonctionne au niveau de la couche réseau.

Dans ce chapitre, nous aborderons différents processus permettant d'assurer la sécurité des communications par courrier électronique et des protocoles de sécurité associés. La méthode de sécurisation du DNS est abordée ultérieurement. Dans les chapitres suivants, les protocoles pour atteindre la sécurité Web seront décrits.

Sécurité des e-mails

De nos jours, l'e-mail est devenu une application réseau très largement utilisée. Parlons brièvement de l'infrastructure de messagerie avant de commencer à connaître les protocoles de sécurité de messagerie.

Infrastructure de messagerie

Le moyen le plus simple d'envoyer un e-mail serait d'envoyer un message directement de la machine de l'expéditeur à la machine du destinataire. Dans ce cas, il est essentiel que les deux machines fonctionnent simultanément sur le réseau. Cependant, cette configuration n'est pas pratique car les utilisateurs peuvent occasionnellement connecter leurs machines au réseau.

Par conséquent, le concept de mise en place de serveurs de messagerie est arrivé. Dans cette configuration, le courrier est envoyé à un serveur de messagerie disponible en permanence sur le réseau. Lorsque la machine du destinataire se connecte au réseau, elle lit le courrier sur le serveur de messagerie.

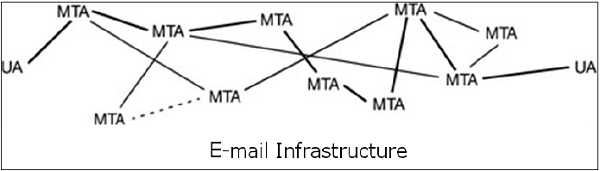

En général, l'infrastructure de messagerie se compose d'un maillage de serveurs de messagerie, également appelé Message Transfer Agents (MTA) et ordinateurs clients exécutant un programme de messagerie électronique comprenant un agent utilisateur (UA) et un MTA local.

En règle générale, un message électronique est transféré à partir de son UA, passe par le maillage des MTA et atteint finalement l'UA sur la machine du destinataire.

Les protocoles utilisés pour le courrier électronique sont les suivants -

Le protocole SMTP (Simple mail Transfer Protocol) utilisé pour le transfert des messages électroniques.

Post Office Protocol (POP) et Internet Message Access Protocol (IMAP) sont utilisés pour récupérer les messages par destinataire à partir du serveur.

MIME

La norme de base du courrier électronique Internet a été rédigée en 1982 et décrit le format des messages électroniques échangés sur Internet. Il prend principalement en charge les messages électroniques écrits sous forme de texte en alphabet romain de base.

En 1992, le besoin s'est fait sentir d'améliorer la même chose. Par conséquent, une extension de messagerie Internet polyvalente (MIME) standard supplémentaire a été définie. Il s'agit d'un ensemble d'extensions à la norme de base de messagerie Internet. MIME offre la possibilité d'envoyer des e-mails en utilisant des caractères autres que ceux de l'alphabet romain de base tels que l'alphabet cyrillique (utilisé en russe), l'alphabet grec ou même les caractères idéographiques du chinois.

Un autre besoin satisfait par MIME est d'envoyer des contenus non textuels, tels que des images ou des clips vidéo. En raison de ces fonctionnalités, la norme MIME a été largement adoptée avec SMTP pour la communication par e-mail.

Services de sécurité du courrier électronique

L'utilisation croissante de la communication par courrier électronique pour des transactions importantes et cruciales nécessite la fourniture de certains services de sécurité fondamentaux comme suit:

Confidentiality - Le message électronique ne doit être lu par personne d'autre que le destinataire prévu.

Authentication - Le destinataire de l'e-mail peut être sûr de l'identité de l'expéditeur.

Integrity - Assurance au destinataire que le message électronique n'a pas été modifié depuis sa transmission par l'expéditeur.

Non-repudiation - Le destinataire de l'e-mail peut prouver à un tiers que l'expéditeur a bien envoyé le message.

Proof of submission - L'expéditeur de l'e-mail reçoit la confirmation que le message est remis au système de distribution du courrier.

Proof of delivery - L'expéditeur reçoit une confirmation que le destinataire a reçu le message.

Les services de sécurité tels que la confidentialité, l'authentification, l'intégrité des messages et la non-répudiation sont généralement fournis à l'aide de la cryptographie à clé publique.

En règle générale, il existe trois scénarios différents de communication par courrier électronique. Nous discuterons des méthodes pour obtenir les services de sécurité ci-dessus dans ces scénarios.

E-mail individuel

Dans ce scénario, l'expéditeur envoie un message électronique à un seul destinataire. Habituellement, pas plus de deux MTA sont impliqués dans la communication.

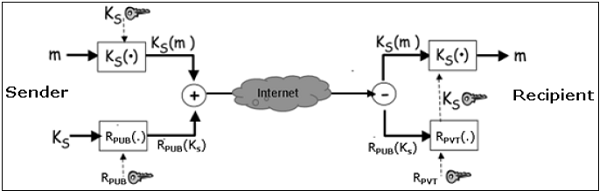

Supposons qu'un expéditeur souhaite envoyer un e-mail confidentiel à un destinataire. La protection de la vie privée dans ce cas est réalisée comme suit -

L'expéditeur et le destinataire ont respectivement leurs clés privées-publiques (S PVT , S PUB ) et (R PVT , R PUB ).

L'expéditeur génère une clé symétrique secrète, K S pour le chiffrement. Bien que l'expéditeur ait pu utiliser R PUB pour le chiffrement, une clé symétrique est utilisée pour accélérer le chiffrement et le déchiffrement.

L'expéditeur crypte le message avec la clé K S et crypte également K S avec la clé publique du destinataire, R PUB .

L'expéditeur envoie un message crypté et un K S crypté au destinataire.

Le destinataire obtient d'abord K S en déchiffrant K S codé à l' aide de sa clé privée, R PVT .

Le destinataire décrypte un message en utilisant la clé symétrique, K S .

Si des services d'intégrité des messages, d'authentification et de non-répudiation sont également nécessaires dans ce scénario, les étapes suivantes sont ajoutées au processus ci-dessus.

L'expéditeur produit le hachage du message et signe numériquement ce hachage avec sa clé privée, S PVT .

L'expéditeur envoie ce hachage signé au destinataire avec d'autres composants.

Le destinataire utilise la clé publique S PUB et extrait le hachage reçu sous la signature de l'expéditeur.

Le destinataire hache ensuite le message déchiffré et compare maintenant les deux valeurs de hachage. S'ils correspondent, l'intégrité du message est considérée comme atteinte.

De plus, le destinataire est sûr que le message est envoyé par l'expéditeur (authentification). Et enfin, l'expéditeur ne peut nier qu'il n'a pas envoyé le message (non-répudiation).

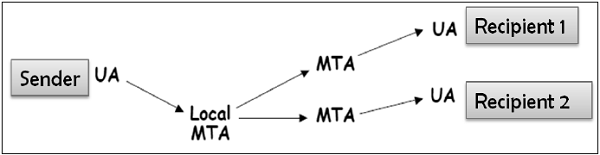

E-mail de destinataires un à plusieurs

Dans ce scénario, l'expéditeur envoie un message électronique à deux ou plusieurs destinataires. La liste est gérée par le programme de messagerie de l'expéditeur (UA + MTA local). Tous les destinataires reçoivent le même message.

Supposons que l'expéditeur souhaite envoyer un courrier électronique confidentiel à de nombreux destinataires (par exemple, R1, R2 et R3). La protection de la vie privée dans ce cas est réalisée comme suit -

L'expéditeur et tous les destinataires ont leur propre paire de clés privées-publiques.

L'expéditeur génère une clé symétrique secrète, K s et crypte le message avec cette clé.

L'expéditeur crypte ensuite K S plusieurs fois avec les clés publiques de R1, R2 et R3, obtenant R1 PUB (K S ), R2 PUB (K S ) et R3 PUB (K S ).

L'expéditeur envoie un message crypté et K S crypté correspondant au destinataire. Par exemple, le destinataire 1 (R1) reçoit un message crypté et R1 PUB (K S ).

Chaque destinataire extrait d'abord la clé K S en déchiffrant K S codé à l' aide de sa clé privée.

Chaque destinataire décrypte le message en utilisant la clé symétrique, K S .

Pour assurer l'intégrité du message, l'authentification et la non-répudiation, les étapes à suivre sont similaires aux étapes mentionnées ci-dessus dans un scénario de courrier électronique individuel.

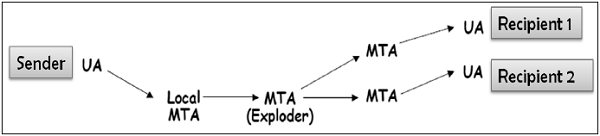

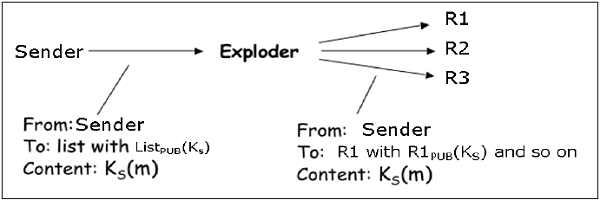

E-mail de la liste de distribution unique

Dans ce scénario, l'expéditeur envoie un message électronique à deux ou plusieurs destinataires, mais la liste des destinataires n'est pas gérée localement par l'expéditeur. En règle générale, le serveur de messagerie (MTA) gère la liste de diffusion.

L'expéditeur envoie un courrier au MTA qui gère la liste de diffusion, puis le courrier est éclaté par le MTA à tous les destinataires de la liste.

Dans ce cas, lorsque l'expéditeur souhaite envoyer un e-mail confidentiel aux destinataires de la liste de diffusion (disons R1, R2 et R3); la confidentialité est assurée comme suit -

L'expéditeur et tous les destinataires ont leur propre paire de clés privées-publiques. Le serveur Exploder a une paire de clés privées-publiques pour chaque liste de diffusion (Liste PUB , Liste PVT ) qu'il gère.

L'expéditeur génère une clé symétrique secrète K s puis crypte le message avec cette clé.

L'expéditeur crypte alors K S avec la clé publique associée à la liste, obtient la Liste PUB (K S ).

L'expéditeur envoie un message crypté et une liste PUB (K S ). Le MTA exploseur déchiffre Liste PUB (K S ) à l' aide Liste PVT et obtient K S .

L'exploseur crypte K S avec autant de clés publiques qu'il y a de membres dans la liste.

L'explodeur transmet le message crypté reçu et le K S crypté correspondant à tous les destinataires de la liste. Par exemple, l'Exploder transmet le message crypté et R1 PUB (K S ) au destinataire 1 et ainsi de suite.

Pour assurer l'intégrité du message, l'authentification et la non-répudiation, les étapes à suivre sont similaires à celles données dans le cas d'un scénario d'e-mail un-à-un.

Il est intéressant de noter que le programme de messagerie utilisant la méthode de sécurité ci-dessus pour sécuriser le courrier électronique devrait fonctionner pour tous les scénarios possibles décrits ci-dessus. La plupart des mécanismes de sécurité ci-dessus pour le courrier électronique sont fournis par deux systèmes populaires, Pretty Good Privacy (PGP) et S / MIME. Nous discutons des deux dans les sections suivantes.

PGP

Pretty Good Privacy(PGP) est un schéma de cryptage des e-mails. Il est devenu la norme de facto pour la fourniture de services de sécurité pour la communication par courrier électronique.

Comme indiqué ci-dessus, il utilise la cryptographie à clé publique, la cryptographie à clé symétrique, la fonction de hachage et la signature numérique. Il fournit -

- Privacy

- Authentification de l'expéditeur

- Intégrité des messages

- Non-repudiation

Parallèlement à ces services de sécurité, il fournit également une prise en charge de la compression des données et de la gestion des clés. PGP utilise des algorithmes cryptographiques existants tels que RSA, IDEA, MD5, etc., plutôt que d'en inventer de nouveaux.

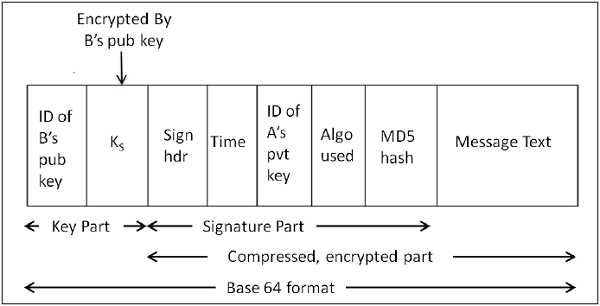

Fonctionnement de PGP

Le hachage du message est calculé. (Algorithme MD5)

Le hachage 128 bits résultant est signé à l'aide de la clé privée de l'expéditeur (algorithme RSA).

La signature numérique est concaténée au message et le résultat est compressé.

Une clé symétrique de 128 bits, K S, est générée et utilisée pour crypter le message compressé avec IDEA.

K S est chiffré à l'aide de la clé publique du destinataire à l'aide de l'algorithme RSA et le résultat est ajouté au message chiffré.

Le format du message PGP est indiqué dans le diagramme suivant. Les ID indiquent quelle clé est utilisée pour crypter KS et quelle clé doit être utilisée pour vérifier la signature sur le hachage.

Dans le schéma PGP, un message est signé et chiffré, puis MIME est codé avant la transmission.

Certificat PGP

Le certificat de clé PGP est normalement établi via une chaîne de confiance. Par exemple, la clé publique de A est signée par B en utilisant sa clé publique et la clé publique de B est signée par C en utilisant sa clé publique. Au fur et à mesure que ce processus se poursuit, il établit un réseau de confiance.

Dans un environnement PGP, tout utilisateur peut agir en tant qu'autorité de certification. Tout utilisateur PGP peut certifier la clé publique d'un autre utilisateur PGP. Cependant, un tel certificat n'est valable pour un autre utilisateur que si l'utilisateur reconnaît le certificateur comme un introducteur de confiance.

Plusieurs problèmes existent avec une telle méthode de certification. Il peut être difficile de trouver une chaîne menant d'une clé publique connue et fiable à la clé souhaitée. En outre, il peut y avoir plusieurs chaînes qui peuvent conduire à des clés différentes pour l'utilisateur souhaité.

PGP peut également utiliser l'infrastructure PKI avec l'autorité de certification et les clés publiques peuvent être certifiées par CA (certificat X.509).

S / MIME

S / MIME signifie Secure Multipurpose Internet Mail Extension. S / MIME est une norme de messagerie électronique sécurisée. Il est basé sur une norme de messagerie électronique non sécurisée antérieure appelée MIME.

Fonctionnement de S / MIME

L'approche S / MIME est similaire à PGP. Il utilise également la cryptographie à clé publique, la cryptographie à clé symétrique, les fonctions de hachage et les signatures numériques. Il fournit des services de sécurité similaires à PGP pour la communication par e-mail.

Les chiffrements symétriques les plus couramment utilisés dans S / MIME sont RC2 et TripleDES. La méthode de clé publique habituelle est RSA et l'algorithme de hachage est SHA-1 ou MD5.

S / MIME spécifie le type MIME supplémentaire, tel que «application / pkcs7-mime», pour l'enveloppement des données après le chiffrement. L'ensemble de l'entité MIME est chiffrée et intégrée dans un objet. S / MIME a des formats de message cryptographiques normalisés (différents de PGP). En fait, MIME est étendu avec certains mots clés pour identifier les parties cryptées et / ou signées du message.

S / MIME repose sur des certificats X.509 pour la distribution des clés publiques. Il a besoin d'une PKI hiérarchique descendante pour la prise en charge de la certification.

Employabilité de S / MIME

En raison de l'exigence d'un certificat de l'autorité de certification pour la mise en œuvre, tous les utilisateurs ne peuvent pas profiter de S / MIME, car certains peuvent souhaiter crypter un message, avec une paire de clés publique / privée. Par exemple, sans l'implication ou la surcharge administrative des certificats.

En pratique, bien que la plupart des applications de messagerie implémentent S / MIME, le processus d'inscription de certificat est complexe. Au lieu de cela, la prise en charge de PGP nécessite généralement l'ajout d'un plug-in et ce plug-in est livré avec tout ce qui est nécessaire pour gérer les clés. Le Web of Trust n'est pas vraiment utilisé. Les gens échangent leurs clés publiques sur un autre support. Une fois obtenus, ils conservent une copie des clés publiques de ceux avec qui les e-mails sont généralement échangés.

La couche d'implémentation dans l'architecture réseau pour les schémas PGP et S / MIME est illustrée dans l'image suivante. Ces deux schémas fournissent une sécurité au niveau de l'application pour la communication par courrier électronique.

L'un des schémas, soit PGP ou S / MIME, est utilisé en fonction de l'environnement. Une communication par e-mail sécurisée dans un réseau captif peut être fournie en s'adaptant à PGP. Pour la sécurité des e-mails sur Internet, où les e-mails sont très souvent échangés avec de nouveaux utilisateurs inconnus, S / MIME est considéré comme une bonne option.

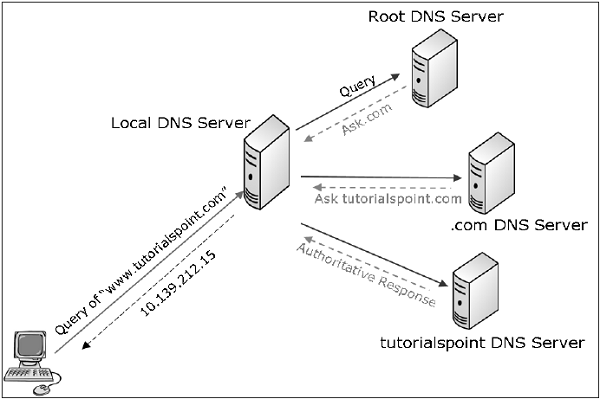

Sécurité DNS

Dans le premier chapitre, nous avons mentionné qu'un attaquant peut utiliser l'empoisonnement du cache DNS pour mener une attaque sur l'utilisateur cible. Domain Name System Security Extensions (DNSSEC) est une norme Internet qui peut déjouer de telles attaques.

Vulnérabilité du DNS standard

Dans un schéma DNS standard, chaque fois que l'utilisateur souhaite se connecter à un nom de domaine, son ordinateur contacte le serveur DNS et recherche l'adresse IP associée pour ce nom de domaine. Une fois l'adresse IP obtenue, l'ordinateur se connecte ensuite à cette adresse IP.

Dans ce schéma, aucun processus de vérification n'est impliqué. Un ordinateur demande à son serveur DNS l'adresse associée à un site Web, le serveur DNS répond avec une adresse IP et votre ordinateur l'accepte sans aucun doute comme une réponse légitime et se connecte à ce site Web.

Une recherche DNS se déroule en fait en plusieurs étapes. Par exemple, lorsqu'un ordinateur demande «www.tutorialspoint.com», une recherche DNS est effectuée en plusieurs étapes -

L'ordinateur demande d'abord au serveur DNS local (fourni par le FAI). Si le FAI a ce nom dans son cache, il répond sinon transmet la requête au «répertoire de la zone racine» où il peut trouver «.com». et les réponses de la zone racine.

Sur la base de la réponse, l'ordinateur demande ensuite au répertoire «.com» où il peut trouver «tutorialspoint.com».

Sur la base des informations reçues, l'ordinateur interroge «tutorialspoint.com» où il peut trouver www. tutorialspoint.com.

DNSSEC défini

La recherche DNS, lorsqu'elle est effectuée à l'aide de DNSSEC, implique la signature des réponses par l'entité répondante. DNSSEC est basé sur la cryptographie à clé publique.

Dans la norme DNSSEC, chaque zone DNS a une paire de clés publique / privée. Toutes les informations envoyées par un serveur DNS sont signées avec la clé privée de la zone d'origine pour garantir l'authenticité. Les clients DNS doivent connaître les clés publiques de la zone pour vérifier les signatures. Les clients peuvent être préconfigurés avec les clés publiques de tous les domaines de premier niveau ou DNS racine.

Avec DNSSEC, le processus de recherche se déroule comme suit -

Lorsque votre ordinateur va demander à la zone racine où il peut trouver .com, la réponse est signée par le serveur de la zone racine.

L'ordinateur vérifie la clé de signature de la zone racine et confirme qu'il s'agit de la zone racine légitime avec de vraies informations.

Dans la réponse, la zone racine fournit les informations sur la clé de signature du serveur de zone .com et son emplacement, permettant à l'ordinateur de contacter le répertoire .com et de s'assurer qu'il est légitime.

L'annuaire .com fournit ensuite la clé de signature et les informations pour tutorialspoint.com, lui permettant de contacter google.com et de vérifier que vous êtes connecté au vrai tutorialspoint.com, comme confirmé par les zones situées au-dessus.

Les informations envoyées se présentent sous la forme d'un ensemble d'enregistrements de ressources (RRSets). L'exemple de RRSet pour le domaine «tutorialspoint.com» dans le serveur «.com» de niveau supérieur est illustré dans le tableau suivant.

| Nom de domaine | Temps de vivre | Type | Valeur |

|---|---|---|---|

| tutorialspoint.com | 86400 | NS | dns.tutorialspoint.com |

| dns.tutorialspoint.com | 86400 | UNE | 36..1.2.3 |

| tutorialspoint.com | 86400 | CLÉ | 3682793A7B73F731029CE2737D ... |

| tutorialspoint.com | 86400 | SIG | 86947503A8B848F5272E53930C ... |

L'enregistrement KEY est une clé publique de «tutorialspoint.com».

L'enregistrement SIG est le hachage signé du serveur .com de niveau supérieur des champs NS, A et KEY enregistrements pour vérifier leur authenticité. Sa valeur est Kcom pvt (H (NS, A, KEY)).

Ainsi, on considère que lorsque DNSSEC est entièrement déployé, l'ordinateur de l'utilisateur est en mesure de confirmer que les réponses DNS sont légitimes et vraies, et d'éviter les attaques DNS lancées par empoisonnement du cache DNS.

Sommaire

Le processus de sécurisation des e-mails assure la sécurité de bout en bout de la communication. Il fournit des services de sécurité de confidentialité, d'authentification de l'expéditeur, d'intégrité des messages et de non-répudiation.

Deux schémas ont été développés pour la sécurité des e-mails: PGP et S / MIME. Ces deux schémas utilisent la cryptographie à clé secrète et à clé publique.

La recherche DNS standard est vulnérable aux attaques telles que l'usurpation DNS / l'empoisonnement du cache. La sécurisation de la recherche DNS est possible grâce à l'utilisation de DNSSEC qui utilise la cryptographie à clé publique.

Dans ce chapitre, nous avons discuté des mécanismes utilisés au niveau de la couche application pour assurer la sécurité du réseau pour la communication de bout en bout.

La sécurité du réseau consiste à sécuriser les données contre les attaques lorsqu'elles sont en transit sur un réseau. Pour atteindre cet objectif, de nombreux protocoles de sécurité en temps réel ont été conçus. Il existe des normes courantes pour les protocoles de sécurité réseau en temps réel tels que S / MIME, SSL / TLS, SSH et IPsec. Comme mentionné précédemment, ces protocoles fonctionnent à différentes couches du modèle de réseau.

Dans le dernier chapitre, nous avons discuté de certains protocoles populaires conçus pour assurer la sécurité de la couche application. Dans ce chapitre, nous discuterons du processus de sécurisation du réseau au niveau de la couche de transport et des protocoles de sécurité associés.

Pour le réseau basé sur le protocole TCP / IP, les couches physiques et de liaison de données sont généralement implémentées dans le terminal utilisateur et le matériel de la carte réseau. Les couches TCP et IP sont implémentées dans le système d'exploitation. Tout ce qui est supérieur à TCP / IP est implémenté en tant que processus utilisateur.

Besoin de sécurité de la couche de transport

Parlons d'une transaction commerciale Internet typique.

Bob visite le site Web d'Alice pour vendre des produits. Dans un formulaire sur le site, Bob saisit le type de bien et la quantité souhaitée, son adresse et les coordonnées de sa carte de paiement. Bob clique sur Soumettre et attend la livraison des marchandises avec débit du montant du prix de son compte. Tout cela semble bien, mais en l'absence de sécurité du réseau, Bob pourrait avoir quelques surprises.

Si les transactions n'utilisaient pas la confidentialité (cryptage), un attaquant pourrait obtenir les informations de sa carte de paiement. L'attaquant peut alors faire des achats aux frais de Bob.

Si aucune mesure d'intégrité des données n'est utilisée, un attaquant pourrait modifier la commande de Bob en termes de type ou de quantité de marchandises.

Enfin, si aucune authentification de serveur n'est utilisée, un serveur pourrait afficher le célèbre logo d'Alice mais le site pourrait être un site malveillant maintenu par un attaquant, qui se fait passer pour Alice. Après avoir reçu la commande de Bob, il pourrait prendre l'argent de Bob et s'enfuir. Ou il pourrait commettre un vol d'identité en recueillant le nom de Bob et les détails de sa carte de crédit.

Les schémas de sécurité de la couche de transport peuvent résoudre ces problèmes en améliorant la communication réseau basée sur TCP / IP avec la confidentialité, l'intégrité des données, l'authentification du serveur et l'authentification du client.

La sécurité à cette couche est principalement utilisée pour sécuriser les transactions Web basées sur HTTP sur un réseau. Cependant, il peut être utilisé par n'importe quelle application fonctionnant sur TCP.

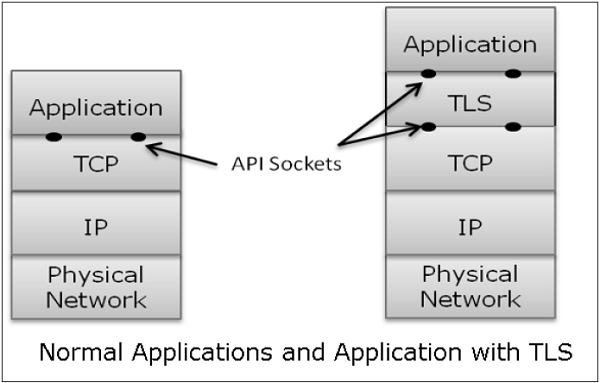

Philosophie de la conception TLS

Les protocoles TLS (Transport Layer Security) fonctionnent au-dessus de la couche TCP. La conception de ces protocoles utilise des interfaces de programme d'application (API) vers TCP, appelées «sockets» pour l'interfaçage avec la couche TCP.

Les applications sont désormais interfacées avec Transport Security Layer au lieu de TCP directement. Transport Security Layer fournit une API simple avec des sockets, qui est similaire et analogue à l'API de TCP.

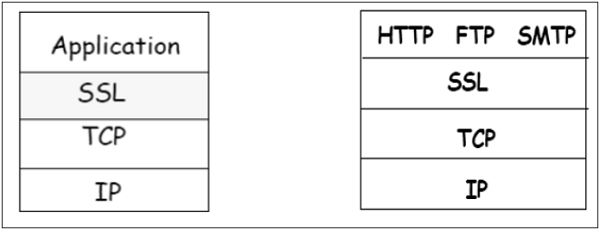

Dans le diagramme ci-dessus, bien que TLS réside techniquement entre la couche application et la couche de transport, du point de vue commun, il s'agit d'un protocole de transport qui agit comme une couche TCP améliorée avec des services de sécurité.

TLS est conçu pour fonctionner sur TCP, le protocole fiable de couche 4 (et non sur le protocole UDP), pour simplifier la conception de TLS, car il n'a pas à se soucier du «délai d'expiration» et de la «retransmission des données perdues». La couche TCP continue de faire cela comme d'habitude, ce qui répond aux besoins de TLS.

Pourquoi TLS est populaire?

La raison de la popularité de l'utilisation d'une sécurité chez Transport Layer est la simplicité. La conception et le déploiement de la sécurité à cette couche ne nécessitent aucune modification des protocoles TCP / IP implémentés dans un système d'exploitation. Seuls les processus utilisateur et les applications doivent être conçus / modifiés, ce qui est moins complexe.

Secure Socket Layer (SSL)

Dans cette section, nous abordons la famille de protocoles conçus pour TLS. La famille comprend les versions SSL 2 et 3 et le protocole TLS. SSLv2 a été remplacé par SSLv3, nous allons donc nous concentrer sur SSL v3 et TLS.

Bref historique de SSL

En 1995, Netscape a développé SSLv2 et utilisé dans Netscape Navigator 1.1. La version SSL1 n'a jamais été publiée et utilisée. Plus tard, Microsoft a amélioré SSLv2 et a introduit un autre protocole similaire appelé Private Communications Technology (PCT).

Netscape a considérablement amélioré SSLv2 sur divers problèmes de sécurité et a déployé SSLv3 en 1999. L'Internet Engineering Task Force (IETF) a ensuite introduit un protocole TLS (Transport Layer Security) similaire en tant que norme ouverte. Le protocole TLS n'est pas interopérable avec SSLv3.

TLS a modifié les algorithmes cryptographiques pour l'expansion et l'authentification des clés. En outre, TLS a suggéré l'utilisation du crypto ouvert Diffie-Hellman (DH) et de la norme de signature numérique (DSS) à la place du crypto RSA breveté utilisé dans SSL. Mais en raison de l'expiration du brevet RSA en 2000, il n'existait aucune raison forte pour que les utilisateurs abandonnent le SSLv3 largement déployé vers TLS.

Principales caractéristiques de SSL

Les principales caractéristiques du protocole SSL sont les suivantes -

SSL assure la sécurité de la connexion réseau via -

Confidentiality - Les informations sont échangées sous une forme cryptée.

Authentication- Les entités de communication s'identifient mutuellement grâce à l'utilisation de certificats numériques. L'authentification du serveur Web est obligatoire alors que l'authentification du client reste facultative.

Reliability - Maintient les contrôles d'intégrité des messages.

SSL est disponible pour toutes les applications TCP.

Pris en charge par presque tous les navigateurs Web.

Facilite les affaires avec de nouvelles entités en ligne.

Développé principalement pour le e-commerce Web.

Architecture de SSL

SSL est spécifique à TCP et ne fonctionne pas avec UDP. SSL fournit une interface de programmation d'application (API) aux applications. Les bibliothèques / classes SSL C et Java sont facilement disponibles.

Le protocole SSL est conçu pour interfonctionner entre l'application et la couche de transport, comme illustré dans l'image suivante -

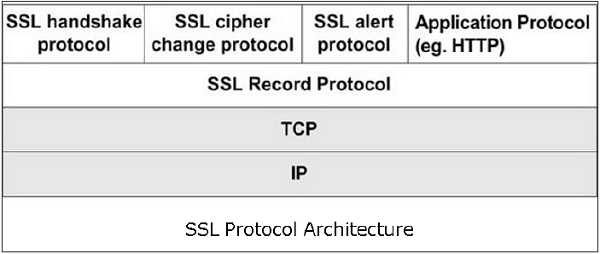

SSL lui-même n'est pas un protocole à une seule couche comme le montre l'image; en fait, il est composé de deux sous-couches.

La sous-couche inférieure comprend l'un des composants du protocole SSL appelé protocole d'enregistrement SSL. Ce composant fournit des services d'intégrité et de confidentialité.

La sous-couche supérieure comprend trois composants de protocole liés à SSL et un protocole d'application. Le composant d'application fournit le service de transfert d'informations entre les interactions client / serveur. Techniquement, il peut également fonctionner au-dessus de la couche SSL. Trois composants de protocole liés à SSL sont -

- Protocole de prise de contact SSL

- Modifier le protocole de spécification de chiffrement

- Protocole d'alerte.

Ces trois protocoles gèrent tous les échanges de messages SSL et sont abordés plus loin dans cette section.

Fonctions des composants du protocole SSL

Les quatre sous-composants du protocole SSL gèrent diverses tâches pour une communication sécurisée entre la machine cliente et le serveur.

Protocole d'enregistrement

La couche d'enregistrement formate les messages de protocole de couche supérieure.

Il fragmente les données en blocs gérables (longueur maximale 16 Ko). Il compresse éventuellement les données.

Crypte les données.

Fournit un en-tête pour chaque message et un hachage (Message Authentication Code (MAC)) à la fin.

Remet les blocs formatés à la couche TCP pour transmission.

Protocole de prise de contact SSL

C'est la partie la plus complexe de SSL. Il est appelé avant la transmission de toute donnée d'application. Il crée des sessions SSL entre le client et le serveur.

L'établissement de session implique l'authentification du serveur, la négociation des clés et des algorithmes, l'établissement des clés et l'authentification du client (facultatif).

Une session est identifiée par un ensemble unique de paramètres de sécurité cryptographiques.

Plusieurs connexions TCP sécurisées entre un client et un serveur peuvent partager la même session.

Actions de protocole de prise de contact en quatre phases. Ceux-ci sont discutés dans la section suivante.

Protocole ChangeCipherSpec

Partie la plus simple du protocole SSL. Il se compose d'un seul message échangé entre deux entités communicantes, le client et le serveur.

Lorsque chaque entité envoie le message ChangeCipherSpec, elle change son côté de la connexion en état sécurisé comme convenu.

L'état en attente des paramètres de chiffrement est copié dans l'état actuel.

L'échange de ce message indique que tous les futurs échanges de données sont cryptés et que l'intégrité est protégée.

Protocole d'alerte SSL

Ce protocole est utilisé pour signaler des erreurs - telles qu'un message inattendu, un mauvais enregistrement MAC, la négociation des paramètres de sécurité a échoué, etc.

Il est également utilisé à d'autres fins - comme notifier la fermeture de la connexion TCP, notifier la réception d'un certificat incorrect ou inconnu, etc.

Mise en place d'une session SSL

Comme indiqué ci-dessus, il existe quatre phases d'établissement de session SSL. Ceux-ci sont principalement gérés par le protocole SSL Handshake.

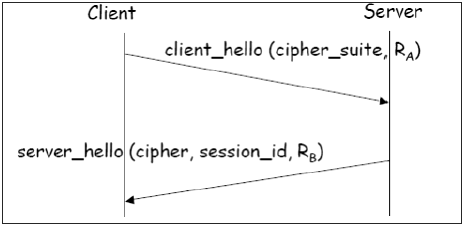

Phase 1 - Établir des capacités de sécurité.

Cette phase comprend l'échange de deux messages - Client_hello et Server_hello .

Client_hello contient la liste des algorithmes cryptographiques pris en charge par le client, par ordre décroissant de préférence.

Server_hello contient la spécification de chiffrement sélectionnée (CipherSpec) et un nouveau session_id .

Le CipherSpec contient des champs comme -

Algorithme de chiffrement (DES, 3DES, RC2 et RC4)

Algorithme MAC (basé sur MD5, SHA-1)

Algorithme à clé publique (RSA)

Les deux messages ont «nonce» pour empêcher les attaques de relecture.

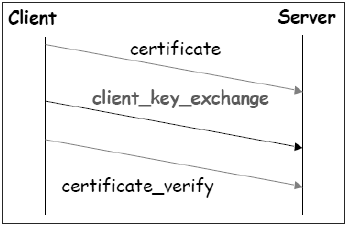

Phase 2 - Authentification du serveur et échange de clés.

Le serveur envoie un certificat. Le logiciel client est configuré avec les clés publiques de diverses organisations «de confiance» (CA) pour vérifier le certificat.

Le serveur envoie la suite de chiffrement choisie.

Le serveur peut demander un certificat client. Habituellement, ce n'est pas fait.

Le serveur indique la fin de Server_hello .

Phase 3 - Authentification du client et échange de clés.

Le client envoie un certificat, uniquement sur demande du serveur.

Il envoie également le secret pré-maître (PMS) chiffré avec la clé publique du serveur.

Le client envoie également un message Certificate_verify si le certificat est envoyé par lui pour prouver qu'il a la clé privée associée à ce certificat. Fondamentalement, le client signe un hachage des messages précédents.

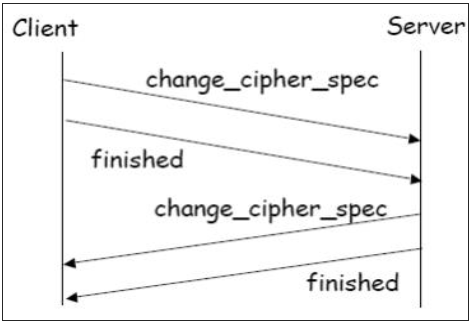

Phase 4 - Terminez.

Le client et le serveur s'envoient des messages Change_cipher_spec pour que l'état de chiffrement en attente soit copié dans l'état actuel.

Désormais, toutes les données sont cryptées et leur intégrité est protégée.

Le message «Terminé» de chaque extrémité vérifie que les processus d'échange de clés et d'authentification ont réussi.

Les quatre phases, décrites ci-dessus, se produisent lors de l'établissement de la session TCP. L'établissement de session SSL commence après TCP SYN / SYNACK et se termine avant TCP Fin.

Reprise d'une session déconnectée

Il est possible de reprendre une session déconnectée (via un message d' alerte ), si le client envoie un hello_request au serveur avec les informations cryptées session_id .

Le serveur détermine ensuite si session_id est valide. S'il est validé, il échange ChangeCipherSpec et les messages terminés avec le client et les communications sécurisées reprennent.

Cela évite de recalculer les paramètres de chiffrement de session et économise le calcul au niveau du serveur et du client.

Clés de session SSL

Nous avons vu que lors de la phase 3 de l'établissement de la session SSL, un secret pré-maître est envoyé par le client au serveur chiffré à l'aide de la clé publique du serveur. Le secret principal et diverses clés de session sont générés comme suit -

Le secret principal est généré (via un générateur de nombres pseudo aléatoires) en utilisant -

Le secret pré-maître.

Deux nonces (RA et RB) échangés dans les messages client_hello et server_hello.

Six valeurs secrètes sont ensuite dérivées de ce secret principal comme -

Clé secrète utilisée avec MAC (pour les données envoyées par le serveur)

Clé secrète utilisée avec MAC (pour les données envoyées par le client)

Clé secrète et IV utilisées pour le cryptage (par serveur)

Clé secrète et IV utilisées pour le chiffrement (par le client)

Protocole TLS

Afin de fournir une norme Internet ouverte de SSL, l'IETF a publié le protocole TLS (Transport Layer Security) en janvier 1999. TLS est défini comme une norme Internet proposée dans la RFC 5246.

Principales caractéristiques

Le protocole TLS a les mêmes objectifs que SSL.

Il permet aux applications client / serveur de communiquer de manière sécurisée en s'authentifiant, en évitant les écoutes clandestines et en résistant à la modification des messages.

Le protocole TLS se trouve au-dessus de la couche TCP de transport orientée connexion fiable dans la pile de couches réseau.

L'architecture du protocole TLS est similaire au protocole SSLv3. Il a deux sous-protocoles: le protocole TLS Record et le protocole TLS Handshake.

Bien que les protocoles SSLv3 et TLS aient une architecture similaire, plusieurs modifications ont été apportées à l'architecture et au fonctionnement, en particulier pour le protocole de prise de contact.

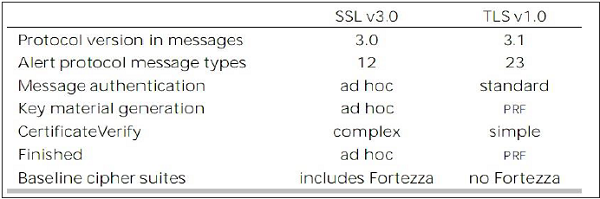

Comparaison des protocoles TLS et SSL

Il existe huit principales différences entre les protocoles TLS et SSLv3. Ce sont les suivants -

Protocol Version - L'en-tête du segment de protocole TLS porte le numéro de version 3.1 pour différencier le numéro 3 porté par l'en-tête de segment de protocole SSL.

Message Authentication- TLS utilise un code d'authentification de message à hachage par clé (H-MAC). L'avantage est que H-MAC fonctionne avec n'importe quelle fonction de hachage, pas seulement MD5 ou SHA, comme indiqué explicitement par le protocole SSL.

Session Key Generation - Il existe deux différences entre les protocoles TLS et SSL pour la génération du matériel clé.

La méthode de calcul des secrets pré-maître et maître est similaire. Mais dans le protocole TLS, le calcul du secret principal utilise la norme HMAC et la sortie de la fonction pseudo-aléatoire (PRF) au lieu du MAC ad hoc.

L'algorithme de calcul des clés de session et des valeurs d'initiation (IV) est différent dans TLS du protocole SSL.

Message de protocole d'alerte -

Le protocole TLS prend en charge tous les messages utilisés par le protocole d'alerte de SSL, sauf Aucun message d'alerte de certificat n'est rendu redondant. Le client envoie un certificat vide au cas où l'authentification du client n'est pas requise.

De nombreux messages d'alerte supplémentaires sont inclus dans le protocole TLS pour d'autres conditions d'erreur telles que record_overflow, decode_error, etc.

Supported Cipher Suites- SSL prend en charge les suites de chiffrement RSA, Diffie-Hellman et Fortezza. Le protocole TLS prend en charge toutes les combinaisons sauf Fortezza.

Client Certificate Types- TLS définit les types de certificats à demander dans un message certificate_request . SSLv3 prend en charge tous ces éléments. De plus, SSL prend en charge certains autres types de certificats tels que Fortezza.

CertificatVérification et messages terminés -

Dans SSL, une procédure de message complexe est utilisée pour le message certificate_verify . Avec TLS, les informations vérifiées sont contenues dans les messages de prise de contact eux-mêmes, évitant ainsi cette procédure complexe.

Le message terminé est calculé de différentes manières en TLS et SSLv3.

Padding of Data- Dans le protocole SSL, le remplissage ajouté aux données utilisateur avant le chiffrement est la quantité minimale requise pour rendre la taille totale des données égale à un multiple de la longueur de bloc du chiffrement. Dans TLS, le remplissage peut être n'importe quelle quantité qui entraîne une taille de données qui est un multiple de la longueur de bloc du chiffrement, jusqu'à un maximum de 255 octets.

Les différences ci-dessus entre les protocoles TLS et SSLv3 sont résumées dans le tableau suivant.

Navigation sécurisée - HTTPS

Dans cette section, nous discuterons de l'utilisation du protocole SSL / TLS pour effectuer une navigation Web sécurisée.

HTTPS défini

Le protocole HTTP (Hyper Text Transfer Protocol) est utilisé pour la navigation Web. La fonction de HTTPS est similaire à HTTP. La seule différence est que HTTPS offre une navigation Web «sécurisée». HTTPS signifie HTTP sur SSL. Ce protocole est utilisé pour fournir la connexion cryptée et authentifiée entre le navigateur Web client et le serveur du site Web.

La navigation sécurisée via HTTPS garantit que le contenu suivant est crypté -

- URL de la page Web demandée.

- Contenu de la page Web fourni par le serveur au client utilisateur.

- Contenu des formulaires remplis par l'utilisateur.

- Cookies établis dans les deux sens.

Fonctionnement de HTTPS

Le protocole d'application HTTPS utilise généralement l'un des deux protocoles de sécurité de couche de transport les plus courants: SSL ou TLS. Le processus de navigation sécurisée est décrit dans les points suivants.

Vous demandez une connexion HTTPS à une page Web en saisissant https: // suivi de l'URL dans la barre d'adresse du navigateur.

Le navigateur Web établit une connexion au serveur Web. L'utilisation de https appelle l'utilisation du protocole SSL.

Une application, navigateur dans ce cas, utilise le port système 443 au lieu du port 80 (utilisé dans le cas de http).

Le protocole SSL passe par un protocole d'établissement de liaison pour établir une session sécurisée comme indiqué dans les sections précédentes.

Le site Web envoie initialement son certificat numérique SSL à votre navigateur. Lors de la vérification du certificat, la négociation SSL progresse pour échanger les secrets partagés pour la session.

Lorsqu'un certificat numérique SSL de confiance est utilisé par le serveur, les utilisateurs voient une icône de cadenas dans la barre d'adresse du navigateur. Lorsqu'un certificat de validation étendue est installé sur un site Web, la barre d'adresse devient verte.

Une fois établie, cette session consiste en de nombreuses connexions sécurisées entre le serveur Web et le navigateur.

Utilisation de HTTPS

L'utilisation de HTTPS assure la confidentialité, l'authentification du serveur et l'intégrité des messages à l'utilisateur. Il permet une conduite sûre du commerce électronique sur Internet.

Empêche les données d'être écoutées et refuse le vol d'identité qui sont des attaques courantes sur HTTP.

Les navigateurs Web et les serveurs Web actuels sont équipés du support HTTPS. Cependant, l'utilisation de HTTPS sur HTTP nécessite plus de puissance de calcul au niveau du client et du serveur pour effectuer le cryptage et la négociation SSL.

Protocole Secure Shell (SSH)

Les principales caractéristiques de SSH sont les suivantes:

SSH est un protocole réseau qui s'exécute au-dessus de la couche TCP / IP. Il est conçu pour remplacer le TELNET qui fournissait des moyens non sécurisés de connexion à distance.

SSH fournit une communication client / serveur sécurisée et peut être utilisé pour des tâches telles que le transfert de fichiers et le courrier électronique.

SSH2 est un protocole répandu qui offre une sécurité de communication réseau améliorée par rapport à la version antérieure SSH1.

Défini par SSH

SSH est organisé en trois sous-protocoles.

Transport Layer Protocol- Cette partie du protocole SSH assure la confidentialité des données, l'authentification du serveur (hôte) et l'intégrité des données. Il peut également fournir une compression de données.

Server Authentication- Les clés d'hôte sont asymétriques comme les clés publiques / privées. Un serveur utilise une clé publique pour prouver son identité à un client. Le client vérifie que le serveur contacté est un hôte «connu» de la base de données qu'il gère. Une fois le serveur authentifié, les clés de session sont générées.

Session Key Establishment- Après authentification, le serveur et le client conviennent du chiffrement à utiliser. Les clés de session sont générées à la fois par le client et le serveur. Les clés de session sont générées avant l'authentification de l'utilisateur afin que les noms d'utilisateur et les mots de passe puissent être envoyés cryptés. Ces clés sont généralement remplacées à intervalles réguliers (par exemple, toutes les heures) pendant la session et sont détruites immédiatement après utilisation.

Data Integrity- SSH utilise des algorithmes MAC (Message Authentication Code) pour vérifier l'intégrité des données. C'est une amélioration par rapport au CRC 32 bits utilisé par SSH1.

User Authentication Protocol- Cette partie de SSH authentifie l'utilisateur auprès du serveur. Le serveur vérifie que l'accès est accordé uniquement aux utilisateurs prévus. De nombreuses méthodes d'authentification sont actuellement utilisées telles que les mots de passe saisis, Kerberos, l'authentification par clé publique, etc.

Connection Protocol - Cela fournit plusieurs canaux logiques sur une seule connexion SSH sous-jacente.

Services SSH

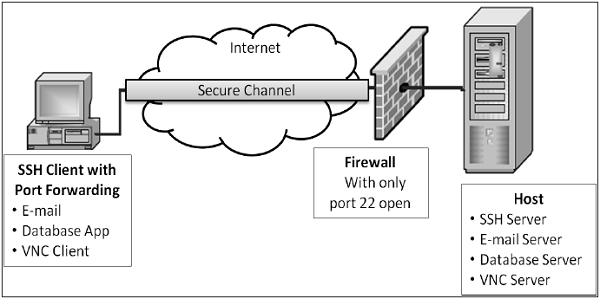

SSH fournit trois services principaux qui permettent de fournir de nombreuses solutions sécurisées. Ces services sont brièvement décrits comme suit -

Secure Command-Shell (Remote Logon)- Il permet à l'utilisateur de modifier des fichiers, d'afficher le contenu des répertoires et d'accéder aux applications sur le périphérique connecté. Les administrateurs système peuvent démarrer / afficher / arrêter à distance des services et des processus, créer des comptes utilisateur et modifier les autorisations de fichiers / répertoires, etc. Toutes les tâches réalisables à l'invite de commande d'une machine peuvent désormais être effectuées en toute sécurité à partir de la machine distante à l'aide d'une connexion à distance sécurisée.

Secure File Transfer- Le protocole de transfert de fichiers SSH (SFTP) est conçu comme une extension de SSH-2 pour un transfert de fichiers sécurisé. En substance, il s'agit d'un protocole distinct superposé au protocole Secure Shell pour gérer les transferts de fichiers. SFTP crypte à la fois le nom d'utilisateur / mot de passe et les données du fichier en cours de transfert. Il utilise le même port que le serveur Secure Shell, c'est-à-dire le port système n ° 22.

Port Forwarding (Tunneling)- Il permet de sécuriser les données des applications basées sur TCP / IP non sécurisées. Une fois la redirection de port configurée, Secure Shell redirige le trafic d'un programme (généralement un client) et l'envoie à travers le tunnel crypté vers le programme de l'autre côté (généralement un serveur). Plusieurs applications peuvent transmettre des données sur un seul canal sécurisé multiplexé, éliminant ainsi le besoin d'ouvrir de nombreux ports sur un pare-feu ou un routeur.

Avantages et limitations

Les avantages et les limites de l'utilisation de la sécurité des communications au niveau de la couche transport sont les suivants:

Avantages

Transport Layer Security est transparent pour les applications.

Le serveur est authentifié.

Les en-têtes de couche d'application sont masqués.

Il est plus fin que les mécanismes de sécurité de la couche 3 (IPsec) car il fonctionne au niveau de la connexion de transport.

Limites

Applicable uniquement aux applications basées sur TCP (pas UDP).

Les en-têtes TCP / IP sont en clair.

Convient pour une communication directe entre le client et le serveur. Ne prend pas en charge les applications sécurisées utilisant une chaîne de serveurs (par exemple, e-mail)

SSL ne fournit pas de non-répudiation car l'authentification client est facultative.

Si nécessaire, l'authentification client doit être implémentée au-dessus de SSL.

Sommaire

Un grand nombre d'applications Web ont vu le jour sur Internet au cours de la dernière décennie. De nombreux portails de gouvernance électronique et de commerce électronique ont été mis en ligne. Ces applications exigent que la session entre le serveur et le client soit sécurisée, garantissant la confidentialité, l'authentification et l'intégrité des sessions.

Une façon d'atténuer une attaque potentielle pendant la session d'un utilisateur consiste à utiliser un protocole de communication sécurisé. Deux de ces protocoles de communication, Secure Sockets Layer (SSL) et Transport Layer Security (TLS), sont traités dans ce chapitre. Ces deux protocoles fonctionnent au niveau de la couche Transport.

Un autre protocole de couche de transport, Secure Shell (SSH), conçu pour remplacer TELNET, fournit des moyens sécurisés de connexion à distance. Il est capable de fournir divers services tels que Secure Command Shell et SFTP.

L'emploi de la sécurité de la couche de transport présente de nombreux avantages. Cependant, le protocole de sécurité conçu à ces niveaux ne peut être utilisé qu'avec TCP. Ils n'assurent pas la sécurité des communications implémentées à l'aide d'UDP.

Les contrôles de sécurité de la couche réseau ont été fréquemment utilisés pour sécuriser les communications, en particulier sur des réseaux partagés tels qu'Internet, car ils peuvent assurer la protection de nombreuses applications à la fois sans les modifier.

Dans les chapitres précédents, nous avons discuté du fait que de nombreux protocoles de sécurité en temps réel ont évolué pour la sécurité du réseau, garantissant les principes de base de la sécurité tels que la confidentialité, l'authentification de l'origine, l'intégrité des messages et la non-répudiation.

La plupart de ces protocoles sont restés concentrés sur les couches supérieures de la pile de protocoles OSI, pour compenser le manque de sécurité inhérent au protocole Internet standard. Bien que utiles, ces méthodes ne peuvent pas être généralisées facilement pour une utilisation avec n'importe quelle application. Par exemple, SSL est développé spécifiquement pour sécuriser des applications comme HTTP ou FTP. Mais il existe plusieurs autres applications qui nécessitent également des communications sécurisées.

Ce besoin a conduit à développer une solution de sécurité au niveau de la couche IP afin que tous les protocoles de couche supérieure puissent en profiter. En 1992, l'IETF (Internet Engineering Task Force) a commencé à définir un standard «IPsec».

Dans ce chapitre, nous discuterons de la manière dont la sécurité est obtenue au niveau de la couche réseau en utilisant cet ensemble très populaire de protocoles IPsec.

Sécurité dans la couche réseau

Tout schéma développé pour assurer la sécurité du réseau doit être implémenté à une couche de la pile de protocoles, comme illustré dans le diagramme ci-dessous -

| Couche | Protocoles de communication | Protocoles de sécurité |

|---|---|---|

| Couche d'application | HTTP FTP SMTP | PGP. S / MIME, HTTPS |

| Couche de transport | TCP / UDP | SSL, TLS, SSH |

| Couche réseau | IP | IPsec |

Le cadre populaire développé pour assurer la sécurité au niveau de la couche réseau est IPsec (Internet Protocol Security).

Caractéristiques d'IPsec

IPsec n'est pas conçu pour fonctionner uniquement avec TCP comme protocole de transport. Il fonctionne avec UDP ainsi qu'avec tout autre protocole supérieur à IP tel que ICMP, OSPF, etc.

IPsec protège l'ensemble du paquet présenté à la couche IP, y compris les en-têtes de couche supérieure.

Étant donné que les en-têtes de couche supérieure portant le numéro de port sont masqués, l'analyse du trafic est plus difficile.

IPsec fonctionne d'une entité réseau à une autre entité réseau, et non d'un processus d'application à un processus d'application. Par conséquent, la sécurité peut être adoptée sans nécessiter de modifications des ordinateurs / applications des utilisateurs individuels.

Très utilisé pour assurer une communication sécurisée entre les entités du réseau, IPsec peut également fournir une sécurité d'hôte à hôte.

L'utilisation la plus courante d'IPsec consiste à fournir un réseau privé virtuel (VPN), soit entre deux emplacements (passerelle à passerelle), soit entre un utilisateur distant et un réseau d'entreprise (hôte à passerelle).

Fonctions de sécurité

Les fonctions de sécurité importantes fournies par IPsec sont les suivantes -

Confidentialité

Permet aux nœuds communicants de crypter les messages.

Empêche les écoutes par des tiers.

Authentification d'origine et intégrité des données.

Fournit l'assurance qu'un paquet reçu a été effectivement transmis par la partie identifiée comme la source dans l'en-tête de paquet.

Confirme que le paquet n'a pas été modifié ou autrement.

Gestion des clés.

Permet un échange sécurisé des clés.

Protection contre certains types d'attaques de sécurité, telles que les attaques de relecture.

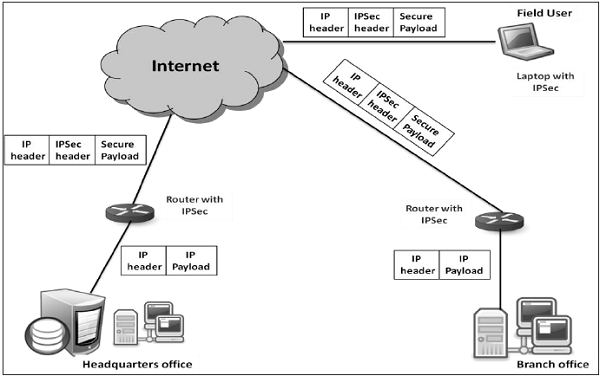

Réseau privé virtuel

Idéalement, toute institution souhaiterait disposer de son propre réseau privé de communication pour assurer la sécurité. Cependant, il peut être très coûteux d'établir et de maintenir un tel réseau privé sur une zone géographiquement dispersée. Cela nécessiterait de gérer une infrastructure complexe de liaisons de communication, de routeurs, de DNS, etc.

IPsec fournit un mécanisme simple pour implémenter un réseau privé virtuel (VPN) pour ces institutions. La technologie VPN permet au trafic inter-bureaux de l'institution d'être envoyé sur l'Internet public en chiffrant le trafic avant d'entrer sur l'Internet public et en le séparant logiquement des autres trafics. Le fonctionnement simplifié du VPN est illustré dans le diagramme suivant -

Présentation d'IPsec

IPsec est un cadre / une suite de protocoles pour assurer la sécurité au niveau de la couche IP.

Origine

Au début des années 90, Internet était utilisé par quelques établissements, principalement à des fins académiques. Mais au cours des décennies suivantes, la croissance d'Internet est devenue exponentielle en raison de l'expansion du réseau et de plusieurs organisations l'utilisant pour la communication et à d'autres fins.

Avec la croissance massive d'Internet, combinée aux faiblesses de sécurité inhérentes au protocole TCP / IP, le besoin s'est fait sentir d'une technologie capable d'assurer la sécurité du réseau sur Internet. Un rapport intitulé «La sécurité dans l'architecture Internet» a été publié par le Conseil d'architecture Internet (IAB) en 1994. Il a identifié les domaines clés pour les mécanismes de sécurité.

L'IAB a inclus l'authentification et le cryptage comme fonctionnalités de sécurité essentielles dans l'IPv6, l'IP de nouvelle génération. Heureusement, ces capacités de sécurité ont été définies de manière à pouvoir être implémentées à la fois avec l'IPv4 actuel et l'IPv6 futuriste.

Cadre de sécurité, IPsec a été défini dans plusieurs «demandes de commentaires» (RFC). Certaines RFC spécifient certaines parties du protocole, tandis que d'autres abordent la solution dans son ensemble.

Opérations dans IPsec

La suite IPsec peut être considérée comme ayant deux opérations distinctes, lorsqu'elles sont exécutées à l'unisson, fournissant un ensemble complet de services de sécurité. Ces deux opérations sont la communication IPsec et l'échange de clés Internet.

Communication IPsec

Il est généralement associé à la fonctionnalité IPsec standard. Cela implique l'encapsulation, le chiffrement et le hachage des datagrammes IP et la gestion de tous les processus de paquets.

Il est responsable de la gestion de la communication en fonction des associations de sécurité (SA) disponibles établies entre les parties communicantes.

Il utilise des protocoles de sécurité tels que l'en-tête d'authentification (AH) et le SP encapsulé (ESP).

La communication IPsec n'est pas impliquée dans la création des clés ou leur gestion.

L'opération de communication IPsec elle-même est communément appelée IPsec.

Échange de clés Internet (IKE)

IKE est le protocole de gestion automatique des clés utilisé pour IPsec.

Techniquement, la gestion des clés n'est pas essentielle pour la communication IPsec et les clés peuvent être gérées manuellement. Cependant, la gestion manuelle des clés n'est pas souhaitable pour les grands réseaux.

IKE est responsable de la création des clés pour IPsec et de l'authentification pendant le processus d'établissement des clés. Bien qu'IPsec puisse être utilisé pour tout autre protocole de gestion de clé, IKE est utilisé par défaut.

IKE définit deux protocoles (Oakley et SKEME) à utiliser avec le cadre de gestion de clés déjà défini Internet Security Association Key Management Protocol (ISAKMP).

ISAKMP n'est pas spécifique à IPsec, mais fournit le cadre pour créer des SA pour n'importe quel protocole.

Ce chapitre traite principalement de la communication IPsec et du protocole associé utilisé pour assurer la sécurité.

Modes de communication IPsec

La communication IPsec a deux modes de fonctionnement; transports et modes tunnel. Ces modes peuvent être utilisés en combinaison ou utilisés individuellement selon le type de communication souhaité.

Mode de transport

IPsec n'encapsule pas un paquet reçu de la couche supérieure.

L'en-tête IP d'origine est conservé et les données sont transmises sur la base des attributs d'origine définis par le protocole de couche supérieure.

Le diagramme suivant montre le flux de données dans la pile de protocoles.

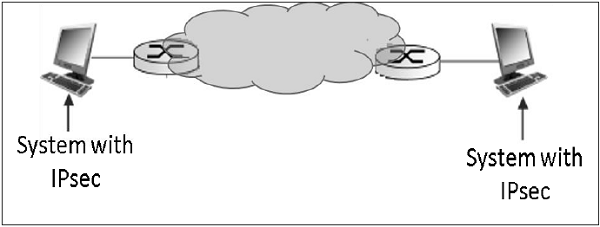

La limitation du mode de transport est qu'aucun service de passerelle ne peut être fourni. Il est réservé aux communications point à point comme illustré dans l'image suivante.

Mode tunnel

Ce mode d'IPsec fournit des services d'encapsulation avec d'autres services de sécurité.

Dans les opérations en mode tunnel, le paquet entier de la couche supérieure est encapsulé avant d'appliquer le protocole de sécurité. Un nouvel en-tête IP est ajouté.

Le diagramme suivant montre le flux de données dans la pile de protocoles.

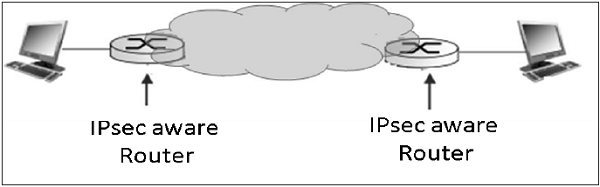

Le mode tunnel est généralement associé aux activités de la passerelle. L'encapsulation offre la possibilité d'envoyer plusieurs sessions via une seule passerelle.

La communication en mode tunnel typique est illustrée dans le diagramme suivant.

En ce qui concerne les points d'extrémité, ils ont une connexion directe de couche de transport. Le datagramme d'un système transmis à la passerelle est encapsulé puis transmis à la passerelle distante. La passerelle associée distante désencapsule les données et les transmet au point de terminaison de destination sur le réseau interne.

En utilisant IPsec, le mode de tunneling peut également être établi entre la passerelle et le système d'extrémité individuel.

Protocoles IPsec

IPsec utilise les protocoles de sécurité pour fournir les services de sécurité souhaités. Ces protocoles sont au cœur des opérations IPsec et tout le reste est conçu pour prendre en charge ces protocoles dans IPsec.

Les associations de sécurité entre les entités communicantes sont établies et maintenues par le protocole de sécurité utilisé.

Il existe deux protocoles de sécurité définis par IPsec: l'en-tête d'authentification (AH) et l'encapsulation de la charge utile de sécurité (ESP).

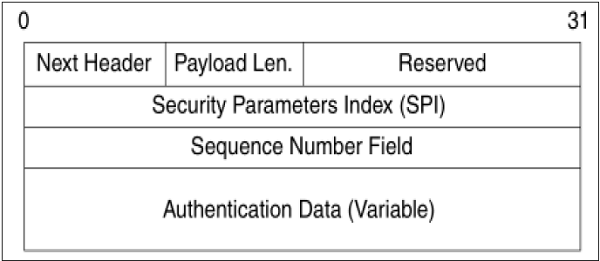

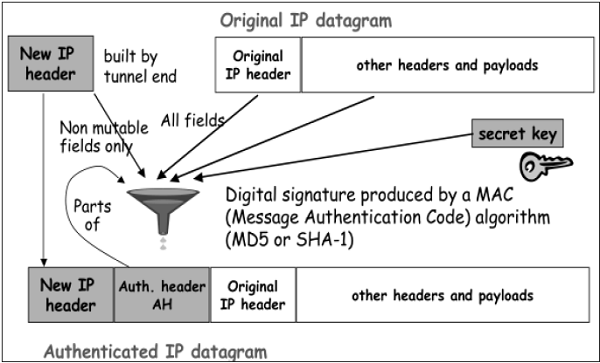

En-tête d'authentification

Le protocole AH fournit un service d'intégrité des données et d'authentification d'origine. Il répond en option à la résistance à la relecture des messages. Cependant, il n'offre aucune forme de confidentialité.

AH est un protocole qui fournit l'authentification de tout ou partie du contenu d'un datagramme par l'ajout d'un en-tête. L'en-tête est calculé en fonction des valeurs du datagramme. Quelles parties du datagramme sont utilisées pour le calcul, et où placer l'en-tête, dépend de la coopération de mode (tunnel ou transport).

Le fonctionnement du protocole AH est étonnamment simple. Il peut être considéré comme similaire aux algorithmes utilisés pour calculer les sommes de contrôle ou effectuer des contrôles CRC pour la détection d'erreur.

Le concept derrière AH est le même, sauf qu'au lieu d'utiliser un algorithme simple, AH utilise un algorithme de hachage spécial et une clé secrète connue uniquement des parties communicantes. Une association de sécurité entre deux appareils est mise en place qui spécifie ces détails.

Le processus d'AH passe par les phases suivantes.

Lorsque le paquet IP est reçu de la pile de protocoles supérieure, IPsec détermine l'association de sécurité (SA) associée à partir des informations disponibles dans le paquet; par exemple, adresse IP (source et destination).

A partir de SA, une fois qu'il est identifié que le protocole de sécurité est AH, les paramètres de l'en-tête AH sont calculés. L'en-tête AH comprend les paramètres suivants -

Le champ d'en-tête spécifie le protocole du paquet suivant l'en-tête AH. L'index des paramètres de séquence (SPI) est obtenu à partir de SA existant entre les parties communicantes.

Le numéro de séquence est calculé et inséré. Ces nombres fournissent à AH la capacité facultative de résister à l'attaque de relecture.

Les données d'authentification sont calculées différemment selon le mode de communication.

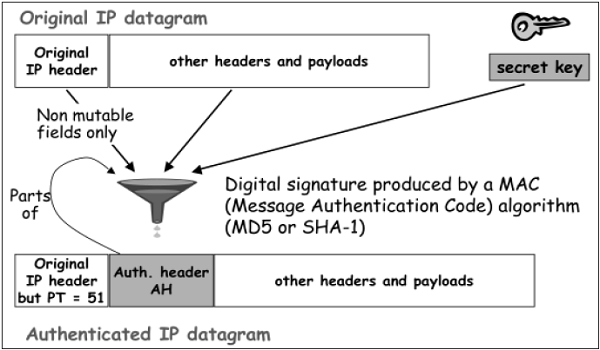

En mode transport, le calcul des données d'authentification et l'assemblage du paquet IP final pour la transmission sont représentés dans le diagramme suivant. Dans l'en-tête IP d'origine, le changement est effectué uniquement dans le numéro de protocole 51 à l'application indiquée de AH.

En mode Tunnel, le processus ci-dessus se déroule comme illustré dans le diagramme suivant.

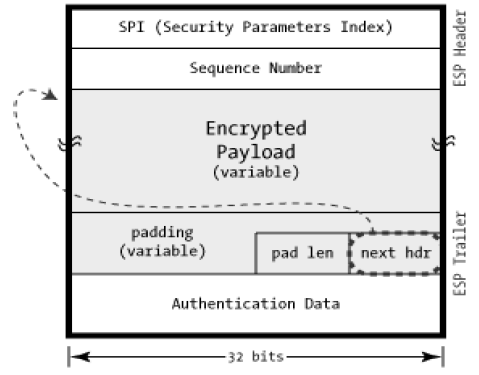

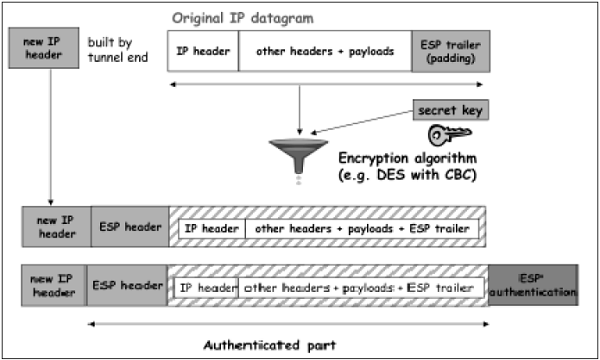

Protocole de sécurité d'encapsulation (ESP)

ESP fournit des services de sécurité tels que la confidentialité, l'intégrité, l'authentification d'origine et la résistance à la relecture en option. L'ensemble des services fournis dépend des options sélectionnées au moment de l'établissement de l'association de sécurité (SA).

Dans ESP, les algorithmes utilisés pour le chiffrement et la génération de l'authentificateur sont déterminés par les attributs utilisés pour créer la SA.

Le processus d'ESP est le suivant. Les deux premières étapes sont similaires au processus de AH comme indiqué ci-dessus.

Une fois qu'il est déterminé que ESP est impliqué, les champs du paquet ESP sont calculés. La disposition du champ ESP est illustrée dans le diagramme suivant.

Le processus de chiffrement et d'authentification en mode transport est illustré dans le diagramme suivant.

Dans le cas du mode Tunnel, le processus de cryptage et d'authentification est comme illustré dans le diagramme suivant.

Bien que l'authentification et la confidentialité soient les principaux services fournis par ESP, les deux sont facultatifs. Techniquement, nous pouvons utiliser le cryptage NULL sans authentification. Cependant, dans la pratique, l'un des deux doit être mis en œuvre pour utiliser l'ESP de manière efficace.

Le concept de base est d'utiliser ESP quand on veut authentification et cryptage, et d'utiliser AH quand on veut une authentification étendue sans cryptage.

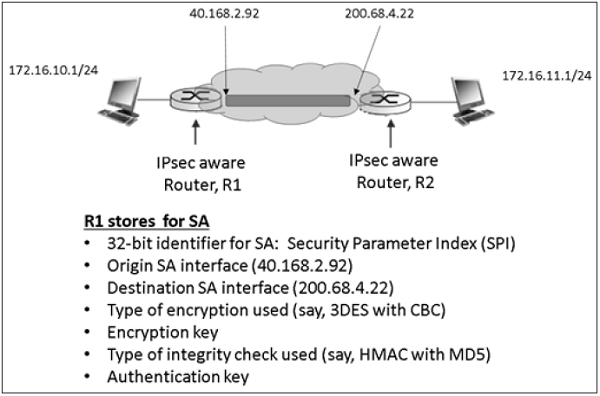

Associations de sécurité dans IPsec

L'association de sécurité (SA) est la base d'une communication IPsec. Les caractéristiques de SA sont -

Avant l'envoi des données, une connexion virtuelle est établie entre l'entité émettrice et l'entité réceptrice, appelée «Association de sécurité (SA)».