HBase - Instalasi

Bab ini menjelaskan bagaimana HBase diinstal dan dikonfigurasi pada awalnya. Java dan Hadoop diperlukan untuk melanjutkan dengan HBase, jadi Anda harus mengunduh dan menginstal java dan Hadoop di sistem Anda.

Pengaturan Pra-Instalasi

Sebelum menginstal Hadoop ke lingkungan Linux, kita perlu mengatur Linux menggunakan ssh(Secure Shell). Ikuti langkah-langkah yang diberikan di bawah ini untuk menyiapkan lingkungan Linux.

Membuat Pengguna

Pertama-tama, disarankan untuk membuat pengguna terpisah untuk Hadoop untuk mengisolasi sistem file Hadoop dari sistem file Unix. Ikuti langkah-langkah yang diberikan di bawah ini untuk membuat pengguna.

- Buka root menggunakan perintah "su".

- Buat pengguna dari akun root menggunakan perintah "useradd username".

- Sekarang Anda dapat membuka akun pengguna yang sudah ada menggunakan perintah "su username".

Buka terminal Linux dan ketik perintah berikut untuk membuat pengguna.

$ su

password:

# useradd hadoop

# passwd hadoop

New passwd:

Retype new passwdPenyiapan SSH dan Pembuatan Kunci

Penyiapan SSH diperlukan untuk melakukan operasi yang berbeda pada cluster seperti operasi shell daemon start, stop, dan terdistribusi. Untuk mengautentikasi pengguna Hadoop yang berbeda, diperlukan pasangan kunci publik / pribadi untuk pengguna Hadoop dan membagikannya dengan pengguna yang berbeda.

Perintah berikut digunakan untuk menghasilkan pasangan nilai kunci menggunakan SSH. Salin formulir kunci publik id_rsa.pub ke authorized_keys, dan berikan izin kepada pemilik, baca dan tulis masing-masing ke file authorized_keys.

$ ssh-keygen -t rsa

$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

$ chmod 0600 ~/.ssh/authorized_keysVerifikasi ssh

ssh localhostMenginstal Java

Jawa adalah prasyarat utama Hadoop dan HBase. Pertama-tama, Anda harus memverifikasi keberadaan java di sistem Anda menggunakan "java -version". Sintaks perintah versi java diberikan di bawah ini.

$ java -versionJika semuanya berfungsi dengan baik, itu akan memberi Anda output berikut.

java version "1.7.0_71"

Java(TM) SE Runtime Environment (build 1.7.0_71-b13)

Java HotSpot(TM) Client VM (build 25.0-b02, mixed mode)Jika java tidak diinstal di sistem Anda, ikuti langkah-langkah yang diberikan di bawah ini untuk menginstal java.

Langkah 1

Unduh java (JDK <latest version> - X64.tar.gz) dengan mengunjungi tautan berikut Oracle Java .

Kemudian jdk-7u71-linux-x64.tar.gz akan diunduh ke sistem Anda.

Langkah 2

Umumnya Anda akan menemukan file java yang diunduh di folder Unduhan. Verifikasi dan ekstrak filejdk-7u71-linux-x64.gz file menggunakan perintah berikut.

$ cd Downloads/

$ ls

jdk-7u71-linux-x64.gz

$ tar zxf jdk-7u71-linux-x64.gz

$ ls

jdk1.7.0_71 jdk-7u71-linux-x64.gzLANGKAH 3

Untuk membuat java tersedia untuk semua pengguna, Anda harus memindahkannya ke lokasi "/ usr / local /". Buka root dan ketik perintah berikut.

$ su

password:

# mv jdk1.7.0_71 /usr/local/

# exitLANGKAH 4

Untuk menyiapkan PATH dan JAVA_HOME variabel, tambahkan perintah berikut ke ~/.bashrc mengajukan.

export JAVA_HOME=/usr/local/jdk1.7.0_71

export PATH= $PATH:$JAVA_HOME/binSekarang terapkan semua perubahan ke dalam sistem yang sedang berjalan.

$ source ~/.bashrcLANGKAH 5

Gunakan perintah berikut untuk mengkonfigurasi alternatif java:

# alternatives --install /usr/bin/java java usr/local/java/bin/java 2

# alternatives --install /usr/bin/javac javac usr/local/java/bin/javac 2

# alternatives --install /usr/bin/jar jar usr/local/java/bin/jar 2

# alternatives --set java usr/local/java/bin/java

# alternatives --set javac usr/local/java/bin/javac

# alternatives --set jar usr/local/java/bin/jarSekarang verifikasi java -version perintah dari terminal seperti dijelaskan di atas.

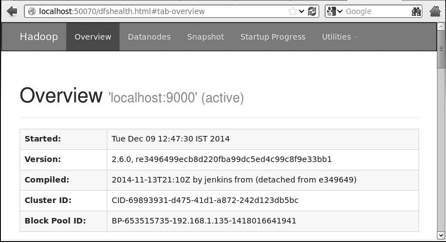

Mendownload Hadoop

Setelah menginstal java, Anda harus menginstal Hadoop. Pertama-tama, verifikasi keberadaan Hadoop menggunakan perintah “Versi Hadoop” seperti yang ditunjukkan di bawah ini.

hadoop versionJika semuanya berfungsi dengan baik, itu akan memberi Anda output berikut.

Hadoop 2.6.0

Compiled by jenkins on 2014-11-13T21:10Z

Compiled with protoc 2.5.0

From source with checksum 18e43357c8f927c0695f1e9522859d6a

This command was run using

/home/hadoop/hadoop/share/hadoop/common/hadoop-common-2.6.0.jarJika sistem Anda tidak dapat menemukan Hadoop, unduh Hadoop di sistem Anda. Ikuti perintah yang diberikan di bawah ini untuk melakukannya.

Unduh dan ekstrak hadoop-2.6.0 dari Apache Software Foundation menggunakan perintah berikut.

$ su

password:

# cd /usr/local

# wget http://mirrors.advancedhosters.com/apache/hadoop/common/hadoop-

2.6.0/hadoop-2.6.0-src.tar.gz

# tar xzf hadoop-2.6.0-src.tar.gz

# mv hadoop-2.6.0/* hadoop/

# exitMemasang Hadoop

Instal Hadoop dalam salah satu mode yang diperlukan. Di sini, kami mendemonstrasikan fungsi HBase dalam mode terdistribusi semu, oleh karena itu instal Hadoop dalam mode terdistribusi semu.

Langkah-langkah berikut digunakan untuk menginstal Hadoop 2.4.1.

Langkah 1 - Menyiapkan Hadoop

Anda dapat menyetel variabel lingkungan Hadoop dengan menambahkan perintah berikut ke ~/.bashrc mengajukan.

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

export HADOOP_INSTALL=$HADOOP_HOMESekarang terapkan semua perubahan ke dalam sistem yang sedang berjalan.

$ source ~/.bashrcLangkah 2 - Konfigurasi Hadoop

Anda dapat menemukan semua file konfigurasi Hadoop di lokasi "$ HADOOP_HOME / etc / hadoop". Anda perlu membuat perubahan pada file konfigurasi tersebut sesuai dengan infrastruktur Hadoop Anda.

$ cd $HADOOP_HOME/etc/hadoopUntuk mengembangkan program Hadoop di java, Anda harus mengatur ulang variabel lingkungan java di hadoop-env.sh mengajukan dengan mengganti JAVA_HOME nilai dengan lokasi java di sistem Anda.

export JAVA_HOME=/usr/local/jdk1.7.0_71Anda harus mengedit file berikut untuk mengkonfigurasi Hadoop.

core-site.xml

Itu core-site.xml file berisi informasi seperti nomor port yang digunakan untuk instance Hadoop, memori yang dialokasikan untuk sistem file, batas memori untuk menyimpan data, dan ukuran buffer Baca / Tulis.

Buka core-site.xml dan tambahkan properti berikut di antara tag <configuration> dan </configuration>.

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>hdfs-site.xml

Itu hdfs-site.xml file berisi informasi seperti nilai data replikasi, jalur kode nama, dan jalur datanode sistem file lokal Anda, tempat Anda ingin menyimpan infrastruktur Hadoop.

Mari kita asumsikan data berikut.

dfs.replication (data replication value) = 1

(In the below given path /hadoop/ is the user name.

hadoopinfra/hdfs/namenode is the directory created by hdfs file system.)

namenode path = //home/hadoop/hadoopinfra/hdfs/namenode

(hadoopinfra/hdfs/datanode is the directory created by hdfs file system.)

datanode path = //home/hadoop/hadoopinfra/hdfs/datanodeBuka file ini dan tambahkan properti berikut di antara tag <configuration>, </configuration>.

<configuration>

<property>

<name>dfs.replication</name >

<value>1</value>

</property>

<property>

<name>dfs.name.dir</name>

<value>file:///home/hadoop/hadoopinfra/hdfs/namenode</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>file:///home/hadoop/hadoopinfra/hdfs/datanode</value>

</property>

</configuration>Note: Dalam file di atas, semua nilai properti ditentukan pengguna dan Anda dapat membuat perubahan sesuai dengan infrastruktur Hadoop Anda.

yarn-site.xml

File ini digunakan untuk mengkonfigurasi benang menjadi Hadoop. Buka file yarn-site.xml dan tambahkan properti berikut di antara <configuration $ gt ;, </ configuration $ gt; tag di file ini.

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>mapred-site.xml

File ini digunakan untuk menentukan kerangka MapReduce mana yang kita gunakan. Secara default, Hadoop berisi template benang-situs.xml. Pertama-tama, Anda harus menyalin file darimapred-site.xml.template untuk mapred-site.xml file menggunakan perintah berikut.

$ cp mapred-site.xml.template mapred-site.xmlBuka mapred-site.xml file dan tambahkan properti berikut di antara tag <configuration> dan </configuration>.

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>Memverifikasi Instalasi Hadoop

Langkah-langkah berikut digunakan untuk memverifikasi penginstalan Hadoop.

Langkah 1 - Penyiapan Node Nama

Siapkan namenode menggunakan perintah “hdfs namenode -format” sebagai berikut.

$ cd ~

$ hdfs namenode -formatHasil yang diharapkan adalah sebagai berikut.

10/24/14 21:30:55 INFO namenode.NameNode: STARTUP_MSG:

/************************************************************

STARTUP_MSG: Starting NameNode

STARTUP_MSG: host = localhost/192.168.1.11

STARTUP_MSG: args = [-format]

STARTUP_MSG: version = 2.4.1

...

...

10/24/14 21:30:56 INFO common.Storage: Storage directory

/home/hadoop/hadoopinfra/hdfs/namenode has been successfully formatted.

10/24/14 21:30:56 INFO namenode.NNStorageRetentionManager: Going to

retain 1 images with txid >= 0

10/24/14 21:30:56 INFO util.ExitUtil: Exiting with status 0

10/24/14 21:30:56 INFO namenode.NameNode: SHUTDOWN_MSG:

/************************************************************

SHUTDOWN_MSG: Shutting down NameNode at localhost/192.168.1.11

************************************************************/Langkah 2 - Memverifikasi Hadoop dfs

Perintah berikut digunakan untuk memulai dfs. Menjalankan perintah ini akan memulai sistem file Hadoop Anda.

$ start-dfs.shOutput yang diharapkan adalah sebagai berikut.

10/24/14 21:37:56

Starting namenodes on [localhost]

localhost: starting namenode, logging to /home/hadoop/hadoop-

2.4.1/logs/hadoop-hadoop-namenode-localhost.out

localhost: starting datanode, logging to /home/hadoop/hadoop-

2.4.1/logs/hadoop-hadoop-datanode-localhost.out

Starting secondary namenodes [0.0.0.0]Langkah 3 - Memverifikasi Skrip Benang

Perintah berikut digunakan untuk memulai skrip benang. Menjalankan perintah ini akan memulai benang daemon Anda.

$ start-yarn.shOutput yang diharapkan adalah sebagai berikut.

starting yarn daemons

starting resourcemanager, logging to /home/hadoop/hadoop-

2.4.1/logs/yarn-hadoop-resourcemanager-localhost.out

localhost: starting nodemanager, logging to /home/hadoop/hadoop-

2.4.1/logs/yarn-hadoop-nodemanager-localhost.outLangkah 4 - Mengakses Hadoop di Browser

Nomor port default untuk mengakses Hadoop adalah 50070. Gunakan url berikut untuk mendapatkan layanan Hadoop di browser Anda.

http://localhost:50070

Langkah 5 - Verifikasi semua Aplikasi Cluster

Nomor port default untuk mengakses semua aplikasi cluster adalah 8088. Gunakan url berikut untuk mengunjungi layanan ini.

http://localhost:8088/

Memasang HBase

Kita dapat menginstal HBase di salah satu dari tiga mode: mode Standalone, mode Pseudo Distributed, dan mode Fully Distributed.

Menginstal HBase dalam Mode Standalone

Unduh versi stabil terbaru dari bentuk HBase http://www.interior-dsgn.com/apache/hbase/stable/menggunakan perintah "wget", dan ekstrak menggunakan perintah "zxvf" tar. Lihat perintah berikut.

$cd usr/local/

$wget http://www.interior-dsgn.com/apache/hbase/stable/hbase-0.98.8-

hadoop2-bin.tar.gz

$tar -zxvf hbase-0.98.8-hadoop2-bin.tar.gzBeralih ke mode pengguna super dan pindahkan folder HBase ke / usr / local seperti yang ditunjukkan di bawah ini.

$su

$password: enter your password here

mv hbase-0.99.1/* Hbase/Mengonfigurasi HBase dalam Mode Standalone

Sebelum melanjutkan dengan HBase, Anda harus mengedit file berikut dan mengkonfigurasi HBase.

hbase-env.sh

Atur java Home untuk HBase dan buka hbase-env.shfile dari folder conf. Edit variabel lingkungan JAVA_HOME dan ubah jalur yang ada ke variabel JAVA_HOME Anda saat ini seperti yang ditunjukkan di bawah ini.

cd /usr/local/Hbase/conf

gedit hbase-env.shIni akan membuka file env.sh dari HBase. Sekarang ganti fileJAVA_HOME nilai dengan nilai Anda saat ini seperti yang ditunjukkan di bawah ini.

export JAVA_HOME=/usr/lib/jvm/java-1.7.0hbase-site.xml

Ini adalah file konfigurasi utama HBase. Setel direktori data ke lokasi yang sesuai dengan membuka folder beranda HBase di / usr / local / HBase. Di dalam folder conf, Anda akan menemukan beberapa file, buka filehbase-site.xml file seperti yang ditunjukkan di bawah ini.

#cd /usr/local/HBase/

#cd conf

# gedit hbase-site.xmlDi dalam hbase-site.xmlfile, Anda akan menemukan tag <configuration> dan </configuration>. Di dalamnya, setel direktori HBase di bawah kunci properti dengan nama "hbase.rootdir" seperti yang ditunjukkan di bawah ini.

<configuration>

//Here you have to set the path where you want HBase to store its files.

<property>

<name>hbase.rootdir</name>

<value>file:/home/hadoop/HBase/HFiles</value>

</property>

//Here you have to set the path where you want HBase to store its built in zookeeper files.

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/home/hadoop/zookeeper</value>

</property>

</configuration>Dengan ini, instalasi HBase dan bagian konfigurasi berhasil diselesaikan. Kita bisa memulai HBase dengan menggunakanstart-hbase.shskrip yang disediakan di folder bin HBase. Untuk itu, buka Home Folder HBase dan jalankan script start HBase seperti yang ditunjukkan di bawah ini.

$cd /usr/local/HBase/bin

$./start-hbase.shJika semuanya berjalan dengan baik, ketika Anda mencoba menjalankan skrip start HBase, Anda akan mendapat pesan yang mengatakan bahwa HBase telah dimulai.

starting master, logging to /usr/local/HBase/bin/../logs/hbase-tpmaster-localhost.localdomain.outMenginstal HBase dalam Pseudo-Distributed Mode

Sekarang mari kita periksa bagaimana HBase diinstal dalam mode pseudo-didistribusikan.

Konfigurasi HBase

Sebelum melanjutkan dengan HBase, konfigurasikan Hadoop dan HDFS pada sistem lokal Anda atau pada sistem jarak jauh dan pastikan keduanya berjalan. Hentikan HBase jika sedang berjalan.

hbase-site.xml

Edit file hbase-site.xml untuk menambahkan properti berikut.

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>Ini akan menyebutkan di mode mana HBase harus dijalankan. Di file yang sama dari sistem file lokal, ubah hbase.rootdir, alamat instance HDFS Anda, menggunakan sintaks hdfs: //// URI. Kami menjalankan HDFS di localhost di port 8030.

<property>

<name>hbase.rootdir</name>

<value>hdfs://localhost:8030/hbase</value>

</property>Memulai HBase

Setelah konfigurasi selesai, telusuri folder home HBase dan mulai HBase menggunakan perintah berikut.

$cd /usr/local/HBase

$bin/start-hbase.shNote: Sebelum memulai HBase, pastikan Hadoop sedang berjalan.

Memeriksa Direktori HBase di HDFS

HBase membuat direktorinya di HDFS. Untuk melihat direktori yang dibuat, telusuri Hadoop bin dan ketik perintah berikut.

$ ./bin/hadoop fs -ls /hbaseJika semuanya berjalan dengan baik, itu akan memberi Anda hasil sebagai berikut.

Found 7 items

drwxr-xr-x - hbase users 0 2014-06-25 18:58 /hbase/.tmp

drwxr-xr-x - hbase users 0 2014-06-25 21:49 /hbase/WALs

drwxr-xr-x - hbase users 0 2014-06-25 18:48 /hbase/corrupt

drwxr-xr-x - hbase users 0 2014-06-25 18:58 /hbase/data

-rw-r--r-- 3 hbase users 42 2014-06-25 18:41 /hbase/hbase.id

-rw-r--r-- 3 hbase users 7 2014-06-25 18:41 /hbase/hbase.version

drwxr-xr-x - hbase users 0 2014-06-25 21:49 /hbase/oldWALsMemulai dan Menghentikan Master

Menggunakan "local-master-backup.sh" Anda dapat memulai hingga 10 server. Buka folder home HBase, master dan jalankan perintah berikut untuk memulainya.

$ ./bin/local-master-backup.sh 2 4Untuk mematikan master cadangan, Anda memerlukan id prosesnya, yang akan disimpan dalam file bernama “/tmp/hbase-USER-X-master.pid.” Anda dapat mematikan master cadangan menggunakan perintah berikut.

$ cat /tmp/hbase-user-1-master.pid |xargs kill -9Memulai dan Menghentikan RegionServers

Anda dapat menjalankan beberapa server wilayah dari satu sistem menggunakan perintah berikut.

$ .bin/local-regionservers.sh start 2 3Untuk menghentikan server wilayah, gunakan perintah berikut.

$ .bin/local-regionservers.sh stop 3

Memulai HBaseShell

Setelah Menginstal HBase berhasil, Anda dapat memulai HBase Shell. Di bawah ini diberikan urutan langkah-langkah yang harus diikuti untuk memulai shell HBase. Buka terminal, dan login sebagai pengguna super.

Mulai Sistem File Hadoop

Jelajahi folder sbin home Hadoop dan mulai sistem file Hadoop seperti yang ditunjukkan di bawah ini.

$cd $HADOOP_HOME/sbin

$start-all.shMulai HBase

Jelajahi folder bin direktori root HBase dan mulai HBase.

$cd /usr/local/HBase

$./bin/start-hbase.shMulai Server Master HBase

Ini akan menjadi direktori yang sama. Mulailah seperti yang ditunjukkan di bawah ini.

$./bin/local-master-backup.sh start 2 (number signifies specific

server.)Mulai Wilayah

Mulai server wilayah seperti yang ditunjukkan di bawah ini.

$./bin/./local-regionservers.sh start 3Mulai HBase Shell

Anda dapat memulai shell HBase menggunakan perintah berikut.

$cd bin

$./hbase shellIni akan memberi Anda HBase Shell Prompt seperti yang ditunjukkan di bawah ini.

2014-12-09 14:24:27,526 INFO [main] Configuration.deprecation:

hadoop.native.lib is deprecated. Instead, use io.native.lib.available

HBase Shell; enter 'help<RETURN>' for list of supported commands.

Type "exit<RETURN>" to leave the HBase Shell

Version 0.98.8-hadoop2, r6cfc8d064754251365e070a10a82eb169956d5fe, Fri

Nov 14 18:26:29 PST 2014

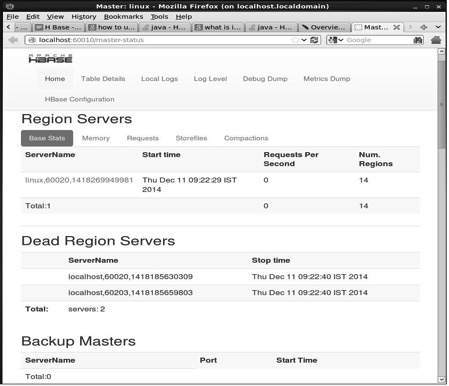

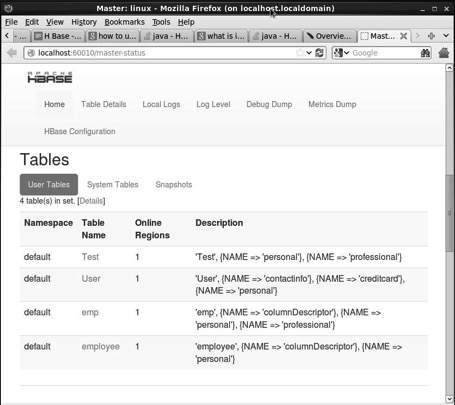

hbase(main):001:0>Antarmuka Web HBase

Untuk mengakses antarmuka web HBase, ketik url berikut di browser.

http://localhost:60010Antarmuka ini mencantumkan server Wilayah, master cadangan, dan tabel HBase Anda yang sedang berjalan.

Server Wilayah HBase dan Master Cadangan

Tabel HBase

Mengatur Lingkungan Java

Kami juga dapat berkomunikasi dengan HBase menggunakan pustaka Java, tetapi sebelum mengakses HBase menggunakan Java API Anda perlu menyetel jalur kelas untuk pustaka tersebut.

Mengatur Classpath

Sebelum melanjutkan dengan pemrograman, setel jalur kelas ke perpustakaan HBase di .bashrcmengajukan. Buka.bashrc di salah satu editor seperti yang ditunjukkan di bawah ini.

$ gedit ~/.bashrcSetel jalur kelas untuk perpustakaan HBase (folder lib di HBase) di dalamnya seperti yang ditunjukkan di bawah ini.

export CLASSPATH = $CLASSPATH://home/hadoop/hbase/lib/*Ini untuk mencegah pengecualian "class not found" saat mengakses HBase menggunakan java API.