Scikit Learn - Guida rapida

In questo capitolo capiremo cos'è Scikit-Learn o Sklearn, l'origine di Scikit-Learn e alcuni altri argomenti correlati come comunità e collaboratori responsabili dello sviluppo e della manutenzione di Scikit-Learn, i suoi prerequisiti, l'installazione e le sue caratteristiche.

Cos'è Scikit-Learn (Sklearn)

Scikit-learn (Sklearn) è la libreria più utile e robusta per l'apprendimento automatico in Python. Fornisce una selezione di strumenti efficienti per l'apprendimento automatico e la modellazione statistica tra cui classificazione, regressione, clustering e riduzione della dimensionalità tramite un'interfaccia di coerenza in Python. Questa libreria, che è in gran parte scritta in Python, è costruita suNumPy, SciPy e Matplotlib.

Origine di Scikit-Learn

In origine si chiamava scikits.learn ed è stato inizialmente sviluppato da David Cournapeau come progetto Google Summer of Code nel 2007. Successivamente, nel 2010, Fabian Pedregosa, Gael Varoquaux, Alexandre Gramfort e Vincent Michel, del FIRCA (Istituto francese di ricerca in informatica e automazione), hanno questo progetto a un altro livello e ha reso la prima versione pubblica (v0.1 beta) il 1 ° febbraio 2010.

Diamo un'occhiata alla sua cronologia delle versioni:

Maggio 2019: scikit-learn 0.21.0

Marzo 2019: scikit-learn 0.20.3

Dicembre 2018: scikit-learn 0.20.2

Novembre 2018: scikit-learn 0.20.1

Settembre 2018: scikit-learn 0.20.0

Luglio 2018: scikit-learn 0.19.2

Luglio 2017: scikit-learn 0.19.0

Settembre 2016. scikit-learn 0.18.0

Novembre 2015. scikit-learn 0.17.0

Marzo 2015. scikit-learn 0.16.0

Luglio 2014. scikit-learn 0.15.0

Agosto 2013. scikit-learn 0.14

Comunità e collaboratori

Scikit-learn è uno sforzo della comunità e chiunque può contribuirvi. Questo progetto è ospitato suhttps://github.com/scikit-learn/scikit-learn. Le persone che seguono sono attualmente i principali contributori allo sviluppo e alla manutenzione di Sklearn -

Joris Van den Bossche (Data Scientist)

Thomas J Fan (Sviluppatore software)

Alexandre Gramfort (ricercatore in machine learning)

Olivier Grisel (esperto di machine learning)

Nicolas Hug (ricercatore associato)

Andreas Mueller (scienziato dell'apprendimento automatico)

Hanmin Qin (ingegnere del software)

Adrin Jalali (Sviluppatore Open Source)

Nelle Varoquaux (Data Science Researcher)

Roman Yurchak (Data Scientist)

Diverse organizzazioni come Booking.com, JP Morgan, Evernote, Inria, AWeber, Spotify e molte altre stanno utilizzando Sklearn.

Prerequisiti

Prima di iniziare a utilizzare l'ultima versione di scikit-learn, è necessario quanto segue:

Python (> = 3.5)

NumPy (> = 1.11.0)

Scipy (> = 0,17,0) li

Joblib (> = 0,11)

Matplotlib (> = 1.5.1) è richiesto per le funzionalità di plottaggio di Sklearn.

Pandas (> = 0.18.0) è richiesto per alcuni degli esempi di scikit-learn utilizzando la struttura e l'analisi dei dati.

Installazione

Se hai già installato NumPy e Scipy, di seguito sono riportati i due modi più semplici per installare scikit-learn:

Utilizzando pip

Il seguente comando può essere utilizzato per installare scikit-learn tramite pip -

pip install -U scikit-learnUtilizzando conda

Il seguente comando può essere utilizzato per installare scikit-learn tramite conda -

conda install scikit-learnD'altra parte, se NumPy e Scipy non sono ancora installati sulla tua workstation Python, puoi installarli utilizzando uno dei due pip o conda.

Un'altra opzione per usare scikit-learn è usare distribuzioni Python come Canopy e Anaconda perché entrambi forniscono l'ultima versione di scikit-learn.

Caratteristiche

Piuttosto che concentrarsi sul caricamento, la manipolazione e il riepilogo dei dati, la libreria Scikit-learn si concentra sulla modellazione dei dati. Alcuni dei gruppi di modelli più popolari forniti da Sklearn sono i seguenti:

Supervised Learning algorithms - Quasi tutti i più diffusi algoritmi di apprendimento supervisionato, come la regressione lineare, la Support Vector Machine (SVM), l'albero decisionale ecc., Fanno parte di scikit-learn.

Unsupervised Learning algorithms - D'altra parte, ha anche tutti i più diffusi algoritmi di apprendimento non supervisionato dal clustering, analisi fattoriale, PCA (Principal Component Analysis) alle reti neurali non supervisionate.

Clustering - Questo modello viene utilizzato per raggruppare i dati senza etichetta.

Cross Validation - Viene utilizzato per verificare l'accuratezza dei modelli supervisionati su dati invisibili.

Dimensionality Reduction - Viene utilizzato per ridurre il numero di attributi nei dati che possono essere ulteriormente utilizzati per il riepilogo, la visualizzazione e la selezione delle caratteristiche.

Ensemble methods - Come suggerisce il nome, viene utilizzato per combinare le previsioni di più modelli supervisionati.

Feature extraction - Viene utilizzato per estrarre le caratteristiche dai dati per definire gli attributi nei dati di immagine e testo.

Feature selection - Viene utilizzato per identificare attributi utili per creare modelli supervisionati.

Open Source - È una libreria open source e utilizzabile anche commercialmente con licenza BSD.

Questo capitolo tratta il processo di modellazione coinvolto in Sklearn. Cerchiamo di capire lo stesso in dettaglio e iniziare con il caricamento del set di dati.

Caricamento del set di dati

Una raccolta di dati è denominata set di dati. Ha i seguenti due componenti:

Features- Le variabili dei dati sono chiamate le sue caratteristiche. Sono anche noti come predittori, input o attributi.

Feature matrix - È la raccolta di funzionalità, nel caso ce ne siano più di una.

Feature Names - È l'elenco di tutti i nomi delle funzionalità.

Response- È la variabile di output che dipende fondamentalmente dalle variabili delle caratteristiche. Sono anche conosciuti come destinazione, etichetta o output.

Response Vector- Viene utilizzato per rappresentare la colonna di risposta. In genere, abbiamo solo una colonna di risposta.

Target Names - Rappresenta i possibili valori assunti da un vettore di risposta.

Scikit-learn ha pochi set di dati di esempio come iris e digits per la classificazione e il Boston house prices per la regressione.

Esempio

Di seguito è riportato un esempio da caricare iris set di dati -

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

feature_names = iris.feature_names

target_names = iris.target_names

print("Feature names:", feature_names)

print("Target names:", target_names)

print("\nFirst 10 rows of X:\n", X[:10])Produzione

Feature names: ['sepal length (cm)', 'sepal width (cm)', 'petal length (cm)', 'petal width (cm)']

Target names: ['setosa' 'versicolor' 'virginica']

First 10 rows of X:

[

[5.1 3.5 1.4 0.2]

[4.9 3. 1.4 0.2]

[4.7 3.2 1.3 0.2]

[4.6 3.1 1.5 0.2]

[5. 3.6 1.4 0.2]

[5.4 3.9 1.7 0.4]

[4.6 3.4 1.4 0.3]

[5. 3.4 1.5 0.2]

[4.4 2.9 1.4 0.2]

[4.9 3.1 1.5 0.1]

]Divisione del set di dati

Per verificare l'accuratezza del nostro modello, possiamo dividere il set di dati in due parti:a training set e a testing set. Utilizzare il set di addestramento per addestrare il modello e il set di test per testare il modello. Dopodiché, possiamo valutare il rendimento del nostro modello.

Esempio

Il seguente esempio suddividerà i dati in un rapporto 70:30, ovvero il 70% dei dati verrà utilizzato come dati di addestramento e il 30% verrà utilizzato come dati di test. Il set di dati è il set di dati dell'iride come nell'esempio precedente.

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size = 0.3, random_state = 1

)

print(X_train.shape)

print(X_test.shape)

print(y_train.shape)

print(y_test.shape)Produzione

(105, 4)

(45, 4)

(105,)

(45,)Come visto nell'esempio sopra, utilizza train_test_split()funzione di scikit-learn per dividere il set di dati. Questa funzione ha i seguenti argomenti:

X, y - Qui, X è il feature matrix e y è il response vector, che devono essere divisi.

test_size- Questo rappresenta il rapporto tra i dati del test e il totale dei dati forniti. Come nell'esempio precedente, stiamo impostandotest_data = 0.3 per 150 righe di X. Produrrà dati di test di 150 * 0,3 = 45 righe.

random_size- Viene utilizzato per garantire che la divisione sarà sempre la stessa. Ciò è utile nelle situazioni in cui si desidera ottenere risultati riproducibili.

Addestra il modello

Successivamente, possiamo utilizzare il nostro set di dati per addestrare alcuni modelli di previsione. Come discusso, scikit-learn ha un'ampia gamma di fileMachine Learning (ML) algorithms che hanno un'interfaccia coerente per l'adattamento, la previsione dell'accuratezza, il richiamo, ecc.

Esempio

Nell'esempio seguente, utilizzeremo il classificatore KNN (K vicini più vicini). Non entrare nei dettagli degli algoritmi KNN, poiché ci sarà un capitolo separato per questo. Questo esempio viene utilizzato per farti capire solo la parte di implementazione.

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size = 0.4, random_state=1

)

from sklearn.neighbors import KNeighborsClassifier

from sklearn import metrics

classifier_knn = KNeighborsClassifier(n_neighbors = 3)

classifier_knn.fit(X_train, y_train)

y_pred = classifier_knn.predict(X_test)

# Finding accuracy by comparing actual response values(y_test)with predicted response value(y_pred)

print("Accuracy:", metrics.accuracy_score(y_test, y_pred))

# Providing sample data and the model will make prediction out of that data

sample = [[5, 5, 3, 2], [2, 4, 3, 5]]

preds = classifier_knn.predict(sample)

pred_species = [iris.target_names[p] for p in preds] print("Predictions:", pred_species)Produzione

Accuracy: 0.9833333333333333

Predictions: ['versicolor', 'virginica']Persistenza del modello

Una volta addestrato il modello, è auspicabile che il modello sia persistente per un utilizzo futuro in modo da non doverlo riaddestrare più e più volte. Può essere fatto con l'aiuto didump e load caratteristiche di joblib pacchetto.

Considera l'esempio seguente in cui salveremo il modello addestrato sopra (classifier_knn) per un uso futuro -

from sklearn.externals import joblib

joblib.dump(classifier_knn, 'iris_classifier_knn.joblib')Il codice precedente salverà il modello nel file denominato iris_classifier_knn.joblib. Ora l'oggetto può essere ricaricato dal file con l'aiuto del seguente codice:

joblib.load('iris_classifier_knn.joblib')Pre-elaborazione dei dati

Poiché abbiamo a che fare con molti dati e quei dati sono in forma grezza, prima di inserire tali dati in algoritmi di apprendimento automatico, dobbiamo convertirli in dati significativi. Questo processo è chiamato pre-elaborazione dei dati. Scikit-learn ha il pacchetto denominatopreprocessingper questo scopo. Ilpreprocessing pacchetto ha le seguenti tecniche:

Binarizzazione

Questa tecnica di pre-elaborazione viene utilizzata quando è necessario convertire i nostri valori numerici in valori booleani.

Esempio

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]]

)

data_binarized = preprocessing.Binarizer(threshold=0.5).transform(input_data)

print("\nBinarized data:\n", data_binarized)Nell'esempio sopra, abbiamo usato threshold value = 0,5 ed è per questo che tutti i valori superiori a 0,5 verrebbero convertiti in 1 e tutti i valori inferiori a 0,5 sarebbero convertiti in 0.

Produzione

Binarized data:

[

[ 1. 0. 1.]

[ 0. 1. 1.]

[ 0. 0. 1.]

[ 1. 1. 0.]

]Rimozione media

Questa tecnica viene utilizzata per eliminare la media dal vettore delle caratteristiche in modo che ogni caratteristica sia centrata sullo zero.

Esempio

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]]

)

#displaying the mean and the standard deviation of the input data

print("Mean =", input_data.mean(axis=0))

print("Stddeviation = ", input_data.std(axis=0))

#Removing the mean and the standard deviation of the input data

data_scaled = preprocessing.scale(input_data)

print("Mean_removed =", data_scaled.mean(axis=0))

print("Stddeviation_removed =", data_scaled.std(axis=0))Produzione

Mean = [ 1.75 -1.275 2.2 ]

Stddeviation = [ 2.71431391 4.20022321 4.69414529]

Mean_removed = [ 1.11022302e-16 0.00000000e+00 0.00000000e+00]

Stddeviation_removed = [ 1. 1. 1.]Ridimensionamento

Usiamo questa tecnica di pre-elaborazione per ridimensionare i vettori delle caratteristiche. Il ridimensionamento dei vettori delle caratteristiche è importante, perché le caratteristiche non dovrebbero essere sinteticamente grandi o piccole.

Esempio

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_scaler_minmax = preprocessing.MinMaxScaler(feature_range=(0,1))

data_scaled_minmax = data_scaler_minmax.fit_transform(input_data)

print ("\nMin max scaled data:\n", data_scaled_minmax)Produzione

Min max scaled data:

[

[ 0.48648649 0.58252427 0.99122807]

[ 0. 1. 0.81578947]

[ 0.27027027 0. 1. ]

[ 1. 0.99029126 0. ]

]Normalizzazione

Usiamo questa tecnica di pre-elaborazione per modificare i vettori delle caratteristiche. La normalizzazione dei vettori di caratteristiche è necessaria in modo che i vettori di caratteristiche possano essere misurati su scala comune. Esistono due tipi di normalizzazione come segue:

Normalizzazione L1

È anche chiamato Deviazioni Minime Assolute. Modifica il valore in modo tale che la somma dei valori assoluti rimanga sempre fino a 1 in ogni riga. L'esempio seguente mostra l'implementazione della normalizzazione L1 sui dati di input.

Esempio

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_normalized_l1 = preprocessing.normalize(input_data, norm='l1')

print("\nL1 normalized data:\n", data_normalized_l1)Produzione

L1 normalized data:

[

[ 0.22105263 -0.2 0.57894737]

[-0.2027027 0.32432432 0.47297297]

[ 0.03571429 -0.56428571 0.4 ]

[ 0.42142857 0.16428571 -0.41428571]

]Normalizzazione L2

Chiamato anche minimi quadrati. Modifica il valore in modo tale che la somma dei quadrati rimanga sempre fino a 1 in ogni riga. L'esempio seguente mostra l'implementazione della normalizzazione L2 sui dati di input.

Esempio

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_normalized_l2 = preprocessing.normalize(input_data, norm='l2')

print("\nL1 normalized data:\n", data_normalized_l2)Produzione

L2 normalized data:

[

[ 0.33946114 -0.30713151 0.88906489]

[-0.33325106 0.53320169 0.7775858 ]

[ 0.05156558 -0.81473612 0.57753446]

[ 0.68706914 0.26784051 -0.6754239 ]

]Come sappiamo, l'apprendimento automatico sta per creare un modello dai dati. A tal fine, il computer deve prima comprendere i dati. Successivamente, discuteremo vari modi per rappresentare i dati in modo da essere compresi dal computer:

Dati come tabella

Il modo migliore per rappresentare i dati in Scikit-learn è sotto forma di tabelle. Una tabella rappresenta una griglia 2-D di dati in cui le righe rappresentano i singoli elementi del set di dati e le colonne rappresentano le quantità relative a quei singoli elementi.

Esempio

Con l'esempio fornito di seguito, possiamo scaricare iris dataset sotto forma di Pandas DataFrame con l'aiuto di python seaborn biblioteca.

import seaborn as sns

iris = sns.load_dataset('iris')

iris.head()Produzione

sepal_length sepal_width petal_length petal_width species

0 5.1 3.5 1.4 0.2 setosa

1 4.9 3.0 1.4 0.2 setosa

2 4.7 3.2 1.3 0.2 setosa

3 4.6 3.1 1.5 0.2 setosa

4 5.0 3.6 1.4 0.2 setosaDall'output sopra, possiamo vedere che ogni riga di dati rappresenta un singolo fiore osservato e il numero di righe rappresenta il numero totale di fiori nel set di dati. Generalmente, ci riferiamo alle righe della matrice come campioni.

D'altra parte, ogni colonna di dati rappresenta un'informazione quantitativa che descrive ogni campione. Generalmente, ci riferiamo alle colonne della matrice come caratteristiche.

Dati come matrice delle caratteristiche

La matrice delle caratteristiche può essere definita come il layout della tabella in cui le informazioni possono essere pensate come una matrice 2-D. È memorizzato in una variabile denominataXe si presume essere bidimensionale con forma [n_samples, n_features]. Per lo più, è contenuto in un array NumPy o in un Pandas DataFrame. Come detto in precedenza, i campioni rappresentano sempre i singoli oggetti descritti dal dataset e le caratteristiche rappresentano le distinte osservazioni che descrivono ogni campione in maniera quantitativa.

Dati come matrice di destinazione

Insieme alla matrice delle caratteristiche, indicata con X, abbiamo anche l'array di destinazione. Si chiama anche etichetta. È indicato con y. L'etichetta o l'array di destinazione è solitamente unidimensionale con lunghezza n_samples. È generalmente contenuto in NumPyarray o Panda Series. La matrice di destinazione può avere sia i valori, i valori numerici continui che i valori discreti.

In che modo l'array di destinazione differisce dalle colonne delle caratteristiche?

Possiamo distinguere sia per un punto che l'array di destinazione è solitamente la quantità che vogliamo prevedere dai dati, cioè in termini statistici è la variabile dipendente.

Esempio

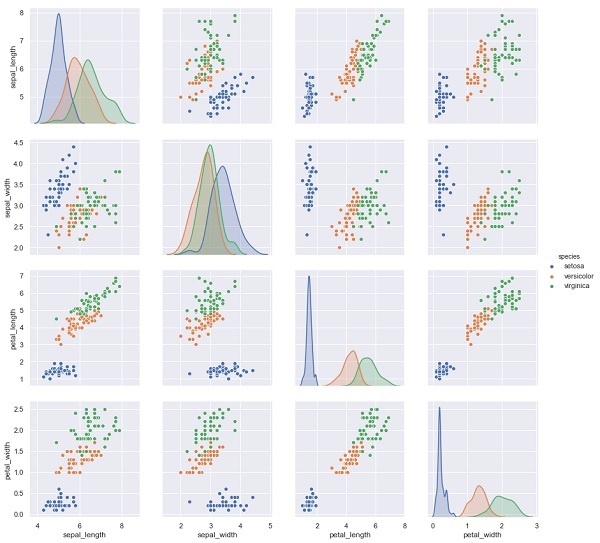

Nell'esempio seguente, dal set di dati dell'iride prevediamo le specie di fiore in base alle altre misurazioni. In questo caso, la colonna Specie verrebbe considerata come l'elemento.

import seaborn as sns

iris = sns.load_dataset('iris')

%matplotlib inline

import seaborn as sns; sns.set()

sns.pairplot(iris, hue='species', height=3);Produzione

X_iris = iris.drop('species', axis=1)

X_iris.shape

y_iris = iris['species']

y_iris.shapeProduzione

(150,4)

(150,)In questo capitolo impareremo Estimator API(Interfaccia di programmazione applicazioni). Cominciamo con la comprensione di cos'è un'API di stima.

Cos'è Estimator API

È una delle principali API implementate da Scikit-learn. Fornisce un'interfaccia coerente per un'ampia gamma di applicazioni ML, ecco perché tutti gli algoritmi di apprendimento automatico in Scikit-Learn vengono implementati tramite l'API Estimator. L'oggetto che apprende dai dati (adattando i dati) è uno stimatore. Può essere utilizzato con qualsiasi algoritmo come classificazione, regressione, clustering o anche con un trasformatore, che estrae funzionalità utili dai dati grezzi.

Per l'adattamento dei dati, tutti gli oggetti dello stimatore espongono un metodo di adattamento che accetta un set di dati mostrato come segue:

estimator.fit(data)Successivamente, tutti i parametri di uno stimatore possono essere impostati, come segue, quando viene istanziato dall'attributo corrispondente.

estimator = Estimator (param1=1, param2=2)

estimator.param1L'output di quanto sopra sarebbe 1.

Una volta che i dati sono dotati di uno stimatore, i parametri vengono stimati dai dati a portata di mano. Ora, tutti i parametri stimati saranno gli attributi dell'oggetto stimatore che terminano con un trattino basso come segue:

estimator.estimated_param_Utilizzo di Estimator API

Gli usi principali degli stimatori sono i seguenti:

Stima e decodifica di un modello

L'oggetto Estimator viene utilizzato per la stima e la decodifica di un modello. Inoltre, il modello è stimato come una funzione deterministica dei seguenti:

I parametri forniti nella costruzione dell'oggetto.

Lo stato casuale globale (numpy.random) se il parametro random_state dello stimatore è impostato su nessuno.

Tutti i dati passati alla chiamata più recente a fit, fit_transform, or fit_predict.

Tutti i dati passati in una sequenza di chiamate a partial_fit.

Mappatura della rappresentazione dei dati non rettangolari in dati rettangolari

Mappa una rappresentazione di dati non rettangolari in dati rettangolari. In parole semplici, prende l'input in cui ogni campione non è rappresentato come un oggetto simile a una matrice di lunghezza fissa e produce un oggetto di caratteristiche simile a una matrice per ogni campione.

Distinzione tra campioni principali e periferici

Modella la distinzione tra campioni principali e periferici utilizzando i seguenti metodi:

fit

fit_predict se trasduttivo

prevedere se induttivo

Principi guida

Durante la progettazione dell'API Scikit-Learn, tenendo presenti i principi guida:

Consistenza

Questo principio afferma che tutti gli oggetti dovrebbero condividere un'interfaccia comune disegnata da un insieme limitato di metodi. Anche la documentazione dovrebbe essere coerente.

Gerarchia di oggetti limitata

Questo principio guida dice:

Gli algoritmi dovrebbero essere rappresentati da classi Python

I set di dati devono essere rappresentati in formato standard come array NumPy, Pandas DataFrames, matrice sparsa SciPy.

I nomi dei parametri dovrebbero usare stringhe Python standard.

Composizione

Come sappiamo, gli algoritmi ML possono essere espressi come la sequenza di molti algoritmi fondamentali. Scikit-learn fa uso di questi algoritmi fondamentali ogni volta che è necessario.

Valori predefiniti ragionevoli

Secondo questo principio, la libreria Scikit-learn definisce un valore predefinito appropriato ogni volta che i modelli ML richiedono parametri specificati dall'utente.

Ispezione

Secondo questo principio guida, ogni valore di parametro specificato viene esposto come attributi pubici.

Passaggi per l'utilizzo dell'API Estimator

Di seguito sono riportati i passaggi per l'utilizzo dell'API per la stima di Scikit-Learn -

Passaggio 1: scegli una classe di modello

In questo primo passaggio, dobbiamo scegliere una classe di modello. Può essere fatto importando la classe Estimator appropriata da Scikit-learn.

Passaggio 2: scegli gli iperparametri del modello

In questo passaggio, dobbiamo scegliere gli iperparametri del modello di classe. Può essere fatto istanziando la classe con i valori desiderati.

Passaggio 3: disposizione dei dati

Successivamente, dobbiamo organizzare i dati in matrice di caratteristiche (X) e vettore di destinazione (y).

Passaggio 4: adattamento del modello

Ora, dobbiamo adattare il modello ai tuoi dati. Può essere fatto chiamando il metodo fit () dell'istanza del modello.

Passaggio 5: applicazione del modello

Dopo aver adattato il modello, possiamo applicarlo a nuovi dati. Per l'apprendimento supervisionato, utilizzarepredict()metodo per prevedere le etichette per dati sconosciuti. Mentre per l'apprendimento senza supervisione, usapredict() o transform() per dedurre le proprietà dei dati.

Esempio di apprendimento supervisionato

Qui, come esempio di questo processo, stiamo prendendo un caso comune di adattamento di una linea a (x, y) dati, ad es simple linear regression.

Innanzitutto, dobbiamo caricare il set di dati, stiamo usando il set di dati iris -

Esempio

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shapeProduzione

(150, 4)Esempio

y_iris = iris['species']

y_iris.shapeProduzione

(150,)Esempio

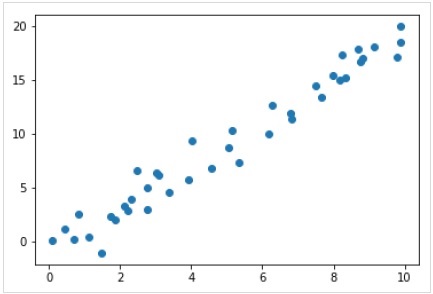

Ora, per questo esempio di regressione, utilizzeremo i seguenti dati di esempio:

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);Produzione

Quindi, abbiamo i dati sopra per il nostro esempio di regressione lineare.

Ora, con questi dati, possiamo applicare i passaggi sopra menzionati.

Scegli una classe di modello

Qui, per calcolare un semplice modello di regressione lineare, dobbiamo importare la classe di regressione lineare come segue:

from sklearn.linear_model import LinearRegressionScegli gli iperparametri del modello

Una volta scelta una classe di modello, dobbiamo fare alcune scelte importanti che sono spesso rappresentate come iperparametri, ovvero i parametri che devono essere impostati prima che il modello si adatti ai dati. Qui, per questo esempio di regressione lineare, vorremmo adattare l'intercetta utilizzando ilfit_intercept iperparametro come segue -

Example

model = LinearRegression(fit_intercept = True)

modelOutput

LinearRegression(copy_X = True, fit_intercept = True, n_jobs = None, normalize = False)Organizzazione dei dati

Ora, come sappiamo che la nostra variabile target y è nella forma corretta, cioè una lunghezza n_samplesmatrice di 1-D. Ma dobbiamo rimodellare la matrice delle caratteristicheX per renderlo una matrice di dimensioni [n_samples, n_features]. Può essere fatto come segue:

Example

X = x[:, np.newaxis]

X.shapeOutput

(40, 1)Modello di montaggio

Una volta sistemati i dati, è il momento di adattare il modello, ovvero di applicare il nostro modello ai dati. Questo può essere fatto con l'aiuto difit() metodo come segue -

Example

model.fit(X, y)Output

LinearRegression(copy_X = True, fit_intercept = True, n_jobs = None,normalize = False)In Scikit-learn, il fit() il processo ha alcuni trattini bassi finali.

Per questo esempio, il parametro seguente mostra la pendenza dell'adattamento lineare semplice dei dati -

Example

model.coef_Output

array([1.99839352])Il parametro seguente rappresenta l'intercetta dell'adattamento lineare semplice ai dati -

Example

model.intercept_Output

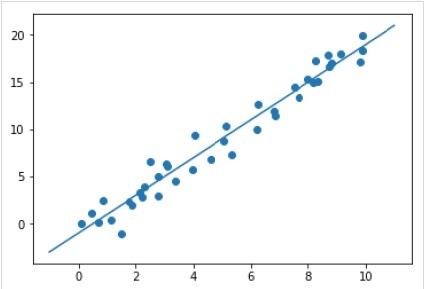

-0.9895459457775022Applicazione del modello a nuovi dati

Dopo aver addestrato il modello, possiamo applicarlo a nuovi dati. Poiché il compito principale dell'apprendimento automatico supervisionato è valutare il modello sulla base di nuovi dati che non fanno parte del set di addestramento. Può essere fatto con l'aiuto dipredict() metodo come segue -

Example

xfit = np.linspace(-1, 11)

Xfit = xfit[:, np.newaxis]

yfit = model.predict(Xfit)

plt.scatter(x, y)

plt.plot(xfit, yfit);Output

Esempio completo di lavoro / eseguibile

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shape

y_iris = iris['species']

y_iris.shape

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);

from sklearn.linear_model import LinearRegression

model = LinearRegression(fit_intercept=True)

model

X = x[:, np.newaxis]

X.shape

model.fit(X, y)

model.coef_

model.intercept_

xfit = np.linspace(-1, 11)

Xfit = xfit[:, np.newaxis]

yfit = model.predict(Xfit)

plt.scatter(x, y)

plt.plot(xfit, yfit);Esempio di apprendimento senza supervisione

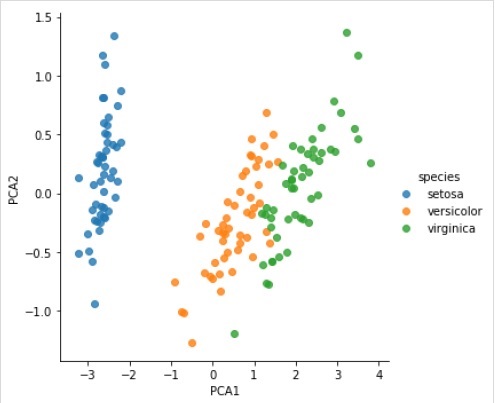

Qui, come esempio di questo processo, stiamo prendendo un caso comune di riduzione della dimensionalità del set di dati Iris in modo da poterlo visualizzare più facilmente. Per questo esempio, utilizzeremo l'analisi delle componenti principali (PCA), una tecnica di riduzione della dimensionalità lineare veloce.

Come nell'esempio sopra riportato, possiamo caricare e tracciare i dati casuali dal set di dati iris. Dopodiché possiamo seguire i passaggi come di seguito:

Scegli una classe di modello

from sklearn.decomposition import PCAScegli gli iperparametri del modello

Example

model = PCA(n_components=2)

modelOutput

PCA(copy = True, iterated_power = 'auto', n_components = 2, random_state = None,

svd_solver = 'auto', tol = 0.0, whiten = False)Modello di montaggio

Example

model.fit(X_iris)Output

PCA(copy = True, iterated_power = 'auto', n_components = 2, random_state = None,

svd_solver = 'auto', tol = 0.0, whiten = False)Trasforma i dati in bidimensionali

Example

X_2D = model.transform(X_iris)Ora possiamo tracciare il risultato come segue:

Output

iris['PCA1'] = X_2D[:, 0]

iris['PCA2'] = X_2D[:, 1]

sns.lmplot("PCA1", "PCA2", hue = 'species', data = iris, fit_reg = False);Output

Esempio completo di lavoro / eseguibile

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shape

y_iris = iris['species']

y_iris.shape

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);

from sklearn.decomposition import PCA

model = PCA(n_components=2)

model

model.fit(X_iris)

X_2D = model.transform(X_iris)

iris['PCA1'] = X_2D[:, 0]

iris['PCA2'] = X_2D[:, 1]

sns.lmplot("PCA1", "PCA2", hue='species', data=iris, fit_reg=False);Gli oggetti di Scikit-learn condividono un'API di base uniforme che consiste nelle seguenti tre interfacce complementari:

Estimator interface - Serve per costruire e adattare i modelli.

Predictor interface - Serve per fare previsioni.

Transformer interface - Serve per convertire i dati.

Le API adottano convenzioni semplici e le scelte progettuali sono state guidate in modo da evitare la proliferazione del codice del framework.

Scopo delle convenzioni

Lo scopo delle convenzioni è assicurarsi che l'API si attenga ai seguenti principi generali:

Consistency - Tutti gli oggetti, siano essi di base o compositi, devono condividere un'interfaccia coerente composta ulteriormente da un insieme limitato di metodi.

Inspection - I parametri del costruttore ei valori dei parametri determinati dall'algoritmo di apprendimento devono essere archiviati ed esposti come attributi pubblici.

Non-proliferation of classes - I set di dati dovrebbero essere rappresentati come array NumPy o matrice sparsa di Scipy mentre i nomi ei valori degli iperparametri dovrebbero essere rappresentati come stringhe Python standard per evitare la proliferazione del codice del framework.

Composition - Gli algoritmi, sia che siano esprimibili come sequenze o combinazioni di trasformazioni ai dati, sia che siano naturalmente visti come meta-algoritmi parametrizzati su altri algoritmi, dovrebbero essere implementati e composti da blocchi di costruzione esistenti.

Sensible defaults- In scikit-learn ogni volta che un'operazione richiede un parametro definito dall'utente, viene definito un valore predefinito appropriato. Questo valore predefinito dovrebbe far sì che l'operazione venga eseguita in modo ragionevole, ad esempio, fornendo una soluzione di base per l'attività in corso.

Convenzioni varie

Le convenzioni disponibili in Sklearn sono spiegate di seguito:

Tipo casting

Dichiara che l'input deve essere convertito in float64. Nell'esempio seguente, in cuisklearn.random_projection modulo utilizzato per ridurre la dimensionalità dei dati, lo spiegherà -

Example

import numpy as np

from sklearn import random_projection

rannge = np.random.RandomState(0)

X = range.rand(10,2000)

X = np.array(X, dtype = 'float32')

X.dtype

Transformer_data = random_projection.GaussianRandomProjection()

X_new = transformer.fit_transform(X)

X_new.dtypeOutput

dtype('float32')

dtype('float64')Nell'esempio sopra, possiamo vedere che X è float32 a cui viene lanciato float64 di fit_transform(X).

Refitting e aggiornamento dei parametri

Gli iperparametri di uno stimatore possono essere aggiornati e rimontati dopo che è stato costruito tramite il set_params()metodo. Vediamo il seguente esempio per capirlo:

Example

import numpy as np

from sklearn.datasets import load_iris

from sklearn.svm import SVC

X, y = load_iris(return_X_y = True)

clf = SVC()

clf.set_params(kernel = 'linear').fit(X, y)

clf.predict(X[:5])Output

array([0, 0, 0, 0, 0])Una volta che lo stimatore è stato costruito, il codice sopra cambierà il kernel predefinito rbf a lineare via SVC.set_params().

Ora, il codice seguente cambierà nuovamente il kernel in rbf per rimontare lo stimatore e per fare una seconda previsione.

Example

clf.set_params(kernel = 'rbf', gamma = 'scale').fit(X, y)

clf.predict(X[:5])Output

array([0, 0, 0, 0, 0])Codice completo

Quello che segue è il programma eseguibile completo -

import numpy as np

from sklearn.datasets import load_iris

from sklearn.svm import SVC

X, y = load_iris(return_X_y = True)

clf = SVC()

clf.set_params(kernel = 'linear').fit(X, y)

clf.predict(X[:5])

clf.set_params(kernel = 'rbf', gamma = 'scale').fit(X, y)

clf.predict(X[:5])Adattamento Multiclasse e Multilabel

In caso di adattamento multiclasse, sia l'apprendimento che le attività di previsione dipendono dal formato dei dati di destinazione su cui si adattano. Il modulo utilizzato èsklearn.multiclass. Controlla l'esempio seguente, dove il classificatore multiclasse è adatto a un array 1d.

Example

from sklearn.svm import SVC

from sklearn.multiclass import OneVsRestClassifier

from sklearn.preprocessing import LabelBinarizer

X = [[1, 2], [3, 4], [4, 5], [5, 2], [1, 1]]

y = [0, 0, 1, 1, 2]

classif = OneVsRestClassifier(estimator = SVC(gamma = 'scale',random_state = 0))

classif.fit(X, y).predict(X)Output

array([0, 0, 1, 1, 2])Nell'esempio precedente, il classificatore si adatta a una matrice unidimensionale di etichette multiclasse e l'estensione predict()fornisce quindi una previsione multiclasse corrispondente. Ma d'altra parte, è anche possibile adattare una matrice bidimensionale di indicatori di etichette binarie come segue:

Example

from sklearn.svm import SVC

from sklearn.multiclass import OneVsRestClassifier

from sklearn.preprocessing import LabelBinarizer

X = [[1, 2], [3, 4], [4, 5], [5, 2], [1, 1]]

y = LabelBinarizer().fit_transform(y)

classif.fit(X, y).predict(X)Output

array(

[

[0, 0, 0],

[0, 0, 0],

[0, 1, 0],

[0, 1, 0],

[0, 0, 0]

]

)Allo stesso modo, in caso di adattamento di più etichette, a un'istanza possono essere assegnate più etichette come segue:

Example

from sklearn.preprocessing import MultiLabelBinarizer

y = [[0, 1], [0, 2], [1, 3], [0, 2, 3], [2, 4]]

y = MultiLabelBinarizer().fit_transform(y)

classif.fit(X, y).predict(X)Output

array(

[

[1, 0, 1, 0, 0],

[1, 0, 1, 0, 0],

[1, 0, 1, 1, 0],

[1, 0, 1, 1, 0],

[1, 0, 1, 0, 0]

]

)Nell'esempio sopra, sklearn.MultiLabelBinarizerviene utilizzato per binarizzare la matrice bidimensionale di multilabel su cui adattare. Questo è il motivo per cui la funzione Forecast () fornisce un array 2d come output con più etichette per ogni istanza.

Questo capitolo ti aiuterà a conoscere la modellazione lineare in Scikit-Learn. Cominciamo col comprendere cos'è la regressione lineare in Sklearn.

La seguente tabella elenca i vari modelli lineari forniti da Scikit-Learn -

| Suor n | Descrizione del Modello |

|---|---|

| 1 | Regressione lineare È uno dei migliori modelli statistici che studia la relazione tra una variabile dipendente (Y) con un dato insieme di variabili indipendenti (X). |

| 2 | Regressione logistica La regressione logistica, nonostante il nome, è un algoritmo di classificazione piuttosto che un algoritmo di regressione. Basato su un dato insieme di variabili indipendenti, viene utilizzato per stimare il valore discreto (0 o 1, sì / no, vero / falso). |

| 3 | Regressione della cresta La regressione della cresta o regolarizzazione di Tikhonov è la tecnica di regolarizzazione che esegue la regolarizzazione L2. Modifica la funzione di perdita aggiungendo la penalità (quantità di ritiro) equivalente al quadrato della grandezza dei coefficienti. |

| 4 | Regressione bayesiana della cresta La regressione bayesiana consente a un meccanismo naturale di sopravvivere a dati insufficienti o dati scarsamente distribuiti formulando la regressione lineare utilizzando distributori di probabilità piuttosto che stime puntuali. |

| 5 | LASSO LASSO è la tecnica di regolarizzazione che esegue la regolarizzazione L1. Modifica la funzione di perdita aggiungendo la penalità (quantità di ritiro) equivalente alla somma del valore assoluto dei coefficienti. |

| 6 | Multi-task LASSO Consente di adattare più problemi di regressione imponendo congiuntamente che le caratteristiche selezionate siano le stesse per tutti i problemi di regressione, chiamati anche task. Sklearn fornisce un modello lineare denominato MultiTaskLasso, addestrato con una norma mista L1, L2 per la regolarizzazione, che stima i coefficienti sparsi per più problemi di regressione congiuntamente. |

| 7 | Rete elastica Elastic-Net è un metodo di regressione regolarizzato che combina linearmente entrambe le penalità, ovvero L1 e L2 dei metodi di regressione Lazo e Ridge. È utile quando sono presenti più funzionalità correlate. |

| 8 | Rete elastica multi-task Si tratta di un modello Elastic-Net che permette di adattare più problemi di regressione congiuntamente imponendo che le caratteristiche selezionate siano le stesse per tutti i problemi di regressione, chiamati anche task |

Questo capitolo si concentra sulle caratteristiche polinomiali e sugli strumenti di pipelining in Sklearn.

Introduzione alle caratteristiche polinomiali

I modelli lineari addestrati su funzioni non lineari dei dati generalmente mantengono le prestazioni veloci dei metodi lineari. Inoltre, consente loro di adattare una gamma di dati molto più ampia. Questo è il motivo per cui nell'apprendimento automatico vengono utilizzati tali modelli lineari, addestrati su funzioni non lineari.

Uno di questi esempi è che una semplice regressione lineare può essere estesa costruendo caratteristiche polinomiali dai coefficienti.

Matematicamente, supponiamo di avere un modello di regressione lineare standard, quindi per i dati 2-D sarebbe simile a questo:

$$Y=W_{0}+W_{1}X_{1}+W_{2}X_{2}$$Ora possiamo combinare le caratteristiche in polinomi di secondo ordine e il nostro modello avrà il seguente aspetto:

$$Y=W_{0}+W_{1}X_{1}+W_{2}X_{2}+W_{3}X_{1}X_{2}+W_{4}X_1^2+W_{5}X_2^2$$Quanto sopra è ancora un modello lineare. Qui, abbiamo visto che la regressione polinomiale risultante è nella stessa classe di modelli lineari e può essere risolta in modo simile.

Per fare ciò, scikit-learn fornisce un modulo denominato PolynomialFeatures. Questo modulo trasforma una matrice di dati di input in una nuova matrice di dati di un determinato grado.

Parametri

La seguente tabella è costituita dai parametri utilizzati da PolynomialFeatures modulo

| Suor n | Parametro e descrizione |

|---|---|

| 1 | degree - intero, predefinito = 2 Rappresenta il grado delle caratteristiche polinomiali. |

| 2 | interaction_only - Booleano, predefinito = false Per impostazione predefinita, è falso, ma se impostato come vero, vengono prodotte le funzionalità che sono prodotti di funzionalità di input più distinte. Tali funzionalità sono chiamate funzionalità di interazione. |

| 3 | include_bias - Booleano, predefinito = vero Include una colonna di polarizzazione, ovvero la caratteristica in cui tutte le potenze dei polinomi sono zero. |

| 4 | order - str in {'C', 'F'}, default = 'C' Questo parametro rappresenta l'ordine della matrice di output nel caso denso. L'ordine 'F' significa più veloce da calcolare ma d'altra parte, può rallentare gli stimatori successivi. |

Attributi

La tabella seguente è costituita dagli attributi utilizzati da PolynomialFeatures modulo

| Suor n | Attributi e descrizione |

|---|---|

| 1 | powers_ - array, forma (n_output_features, n_input_features) Mostra potenze_ [i, j] è l'esponente del j-esimo input nell'i-esimo output. |

| 2 | n_input_features _ - int Come suggerisce il nome, fornisce il numero totale di funzioni di input. |

| 3 | n_output_features _ - int Come suggerisce il nome, fornisce il numero totale di funzioni di output polinomiali. |

Esempio di implementazione

Seguendo gli usi dello script Python PolynomialFeatures trasformatore per trasformare array di 8 in forma (4,2) -

from sklearn.preprocessing import PolynomialFeatures

import numpy as np

Y = np.arange(8).reshape(4, 2)

poly = PolynomialFeatures(degree=2)

poly.fit_transform(Y)Produzione

array(

[

[ 1., 0., 1., 0., 0., 1.],

[ 1., 2., 3., 4., 6., 9.],

[ 1., 4., 5., 16., 20., 25.],

[ 1., 6., 7., 36., 42., 49.]

]

)Razionalizzazione utilizzando gli strumenti della pipeline

Il tipo di pre-elaborazione di cui sopra, ovvero la trasformazione di una matrice di dati di input in una nuova matrice di dati di un determinato grado, può essere semplificato con il Pipeline strumenti, che sono fondamentalmente utilizzati per concatenare più stimatori in uno.

Esempio

Gli script Python seguenti che utilizzano gli strumenti Pipeline di Scikit-learn per semplificare la preelaborazione (si adatteranno a dati polinomiali di ordine 3).

#First, import the necessary packages.

from sklearn.preprocessing import PolynomialFeatures

from sklearn.linear_model import LinearRegression

from sklearn.pipeline import Pipeline

import numpy as np

#Next, create an object of Pipeline tool

Stream_model = Pipeline([('poly', PolynomialFeatures(degree=3)), ('linear', LinearRegression(fit_intercept=False))])

#Provide the size of array and order of polynomial data to fit the model.

x = np.arange(5)

y = 3 - 2 * x + x ** 2 - x ** 3

Stream_model = model.fit(x[:, np.newaxis], y)

#Calculate the input polynomial coefficients.

Stream_model.named_steps['linear'].coef_Produzione

array([ 3., -2., 1., -1.])L'output sopra mostra che il modello lineare addestrato sulle caratteristiche polinomiali è in grado di recuperare gli esatti coefficienti polinomiali di input.

Qui, impareremo a conoscere un algoritmo di ottimizzazione in Sklearn, definito come Stochastic Gradient Descent (SGD).

Stochastic Gradient Descent (SGD) è un algoritmo di ottimizzazione semplice ma efficiente utilizzato per trovare i valori dei parametri / coefficienti delle funzioni che minimizzano una funzione di costo. In altre parole, viene utilizzato per l'apprendimento discriminativo di classificatori lineari in funzioni di perdita convessa come SVM e regressione logistica. È stato applicato con successo a set di dati su larga scala perché l'aggiornamento dei coefficienti viene eseguito per ogni istanza di addestramento, piuttosto che alla fine delle istanze.

Classificatore SGD

Il classificatore Stochastic Gradient Descent (SGD) implementa fondamentalmente una semplice routine di apprendimento SGD che supporta varie funzioni di perdita e penalità per la classificazione. Scikit-learn fornisceSGDClassifier modulo per implementare la classificazione SGD.

Parametri

La seguente tabella è costituita dai parametri utilizzati da SGDClassifier modulo -

| Suor n | Parametro e descrizione |

|---|---|

| 1 | loss - str, default = 'hinge' Rappresenta la funzione di perdita da utilizzare durante l'implementazione. Il valore predefinito è "cerniera" che ci darà un SVM lineare. Le altre opzioni che possono essere utilizzate sono:

|

| 2 | penalty - str, "none", "l2", "l1", "elasticnet" È il termine di regolarizzazione utilizzato nel modello. Per impostazione predefinita, è L2. Possiamo usare L1 o 'elasticnet; ma entrambi potrebbero portare scarsità al modello, quindi non ottenibile con L2. |

| 3 | alpha - float, predefinito = 0.0001 Alpha, la costante che moltiplica il termine di regolarizzazione, è il parametro di tuning che decide quanto si vuole penalizzare il modello. Il valore predefinito è 0.0001. |

| 4 | l1_ratio - float, predefinito = 0,15 Questo è chiamato parametro di miscelazione ElasticNet. Il suo range è 0 <= l1_ratio <= 1. Se l1_ratio = 1, la penalità sarebbe L1. Se l1_ratio = 0, la penalità sarebbe una penalità L2. |

| 5 | fit_intercept - Booleano, impostazione predefinita = vero Questo parametro specifica che una costante (bias o intercetta) deve essere aggiunta alla funzione di decisione. Nessuna intercetta verrà utilizzata nel calcolo e i dati saranno considerati già centrati, se verrà impostato su falso. |

| 6 | tol - float o none, opzionale, default = 1.e-3 Questo parametro rappresenta il criterio di arresto per le iterazioni. Il suo valore predefinito è False ma se impostato su Nessuno, le iterazioni si interromperanno quandoloss > best_loss - tol for n_iter_no_changeepoche successive. |

| 7 | shuffle - Booleano, opzionale, predefinito = True Questo parametro indica se vogliamo che i nostri dati di addestramento vengano mescolati dopo ogni epoca o meno. |

| 8 | verbose - intero, predefinito = 0 Rappresenta il livello di verbosità. Il suo valore predefinito è 0. |

| 9 | epsilon - float, predefinito = 0,1 Questo parametro specifica la larghezza della regione insensibile. Se loss = "epsilon-insensitive", qualsiasi differenza tra la previsione corrente e l'etichetta corretta, inferiore alla soglia, verrà ignorata. |

| 10 | max_iter - int, opzionale, default = 1000 Come suggerisce il nome, rappresenta il numero massimo di passaggi nelle epoche, ovvero i dati di allenamento. |

| 11 | warm_start - bool, opzionale, predefinito = false Con questo parametro impostato su True, possiamo riutilizzare la soluzione della chiamata precedente per adattarla all'inizializzazione. Se scegliamo default cioè false, cancellerà la soluzione precedente. |

| 12 | random_state - int, istanza RandomState o None, opzionale, default = nessuno Questo parametro rappresenta il seme del numero pseudo casuale generato che viene utilizzato durante la mescolanza dei dati. Le seguenti sono le opzioni.

|

| 13 | n_jobs - int o none, opzionale, Default = None Rappresenta il numero di CPU da utilizzare nel calcolo OVA (One Versus All), per problemi multi-classe. Il valore predefinito è nessuno, che significa 1. |

| 14 | learning_rate - stringa, opzionale, default = 'ottimale'

|

| 15 | eta0 - doppio, predefinito = 0,0 Rappresenta il tasso di apprendimento iniziale per le opzioni di tasso di apprendimento sopra menzionate, ovvero "costante", "invscalling" o "adattivo". |

| 16 | power_t - idouble, default = 0,5 È l'esponente del tasso di apprendimento "crescente". |

| 17 | early_stopping - bool, predefinito = False Questo parametro rappresenta l'uso dell'arresto anticipato per terminare l'addestramento quando il punteggio di convalida non migliora. Il suo valore predefinito è false ma, se impostato su true, mette automaticamente da parte una frazione stratificata di dati di addestramento come convalida e interrompe l'addestramento quando il punteggio di convalida non migliora. |

| 18 | validation_fraction - float, predefinito = 0,1 Viene utilizzato solo quando early_stopping è vero. Rappresenta la proporzione di dati di addestramento da impostare come set di convalida per la conclusione anticipata dei dati di addestramento. |

| 19 | n_iter_no_change - int, predefinito = 5 Rappresenta il numero di iterazioni senza alcun miglioramento se l'algoritmo dovrebbe essere eseguito prima dell'arresto anticipato. |

| 20 | classs_weight - dict, {class_label: weight} o "balanced", o None, opzionale Questo parametro rappresenta i pesi associati alle classi. Se non fornito, le classi dovrebbero avere un peso 1. |

| 20 | warm_start - bool, opzionale, predefinito = false Con questo parametro impostato su True, possiamo riutilizzare la soluzione della chiamata precedente per adattarla all'inizializzazione. Se scegliamo default cioè false, cancellerà la soluzione precedente. |

| 21 | average - iBoolean o int, opzionale, predefinito = false Rappresenta il numero di CPU da utilizzare nel calcolo OVA (One Versus All), per problemi multi-classe. Il valore predefinito è nessuno, che significa 1. |

Attributi

La tabella seguente è costituita dagli attributi utilizzati da SGDClassifier modulo -

| Suor n | Attributi e descrizione |

|---|---|

| 1 | coef_ - array, shape (1, n_features) if n_classes == 2, else (n_classes, n_features) Questo attributo fornisce il peso assegnato alle caratteristiche. |

| 2 | intercept_ - array, shape (1,) if n_classes == 2, else (n_classes,) Rappresenta il termine indipendente nella funzione decisionale. |

| 3 | n_iter_ - int Fornisce il numero di iterazioni per raggiungere il criterio di arresto. |

Implementation Example

Come altri classificatori, Stochastic Gradient Descent (SGD) deve essere dotato dei seguenti due array:

Un array X contenente i campioni di addestramento. È di dimensione [n_samples, n_features].

Un array Y contenente i valori target, ovvero le etichette di classe per i campioni di addestramento. È di dimensione [n_samples].

Example

Il seguente script Python utilizza il modello lineare SGDClassifier -

import numpy as np

from sklearn import linear_model

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

Y = np.array([1, 1, 2, 2])

SGDClf = linear_model.SGDClassifier(max_iter = 1000, tol=1e-3,penalty = "elasticnet")

SGDClf.fit(X, Y)Output

SGDClassifier(

alpha = 0.0001, average = False, class_weight = None,

early_stopping = False, epsilon = 0.1, eta0 = 0.0, fit_intercept = True,

l1_ratio = 0.15, learning_rate = 'optimal', loss = 'hinge', max_iter = 1000,

n_iter = None, n_iter_no_change = 5, n_jobs = None, penalty = 'elasticnet',

power_t = 0.5, random_state = None, shuffle = True, tol = 0.001,

validation_fraction = 0.1, verbose = 0, warm_start = False

)Example

Ora, una volta adattato, il modello può prevedere nuovi valori come segue:

SGDClf.predict([[2.,2.]])Output

array([2])Example

Per l'esempio sopra, possiamo ottenere il vettore di peso con l'aiuto del seguente script python:

SGDClf.coef_Output

array([[19.54811198, 9.77200712]])Example

Allo stesso modo, possiamo ottenere il valore di intercettazione con l'aiuto del seguente script python -

SGDClf.intercept_Output

array([10.])Example

Possiamo ottenere la distanza segnata dall'iperpiano usando SGDClassifier.decision_function come usato nel seguente script python -

SGDClf.decision_function([[2., 2.]])Output

array([68.6402382])Regressore SGD

Il regressore Stochastic Gradient Descent (SGD) implementa fondamentalmente una semplice routine di apprendimento SGD che supporta varie funzioni di perdita e penalità per adattarsi ai modelli di regressione lineare. Scikit-learn fornisceSGDRegressor modulo per implementare la regressione SGD.

Parametri

Parametri utilizzati da SGDRegressorsono quasi uguali a quelli usati nel modulo SGDClassifier. La differenza sta nel parametro "perdita". PerSGDRegressor parametro di perdita dei moduli i valori positivi sono i seguenti:

squared_loss - Si riferisce all'adattamento dei minimi quadrati ordinari.

huber: SGDRegressor- correggere i valori anomali passando dalla perdita quadrata a quella lineare oltre una distanza di epsilon. Il lavoro di "huber" consiste nel modificare "squared_loss" in modo che l'algoritmo si concentri meno sulla correzione dei valori anomali.

epsilon_insensitive - In realtà, ignora gli errori meno di epsilon.

squared_epsilon_insensitive- È uguale a epsilon_insensitive. L'unica differenza è che diventa una perdita quadrata oltre una tolleranza di epsilon.

Un'altra differenza è che il parametro denominato "power_t" ha il valore predefinito di 0,25 anziché 0,5 come in SGDClassifier. Inoltre, non ha i parametri "class_weight" e "n_jobs".

Attributi

Anche gli attributi di SGDRegressor sono gli stessi del modulo SGDClassifier. Piuttosto ha tre attributi extra come segue:

average_coef_ - array, forma (n_features,)

Come suggerisce il nome, fornisce i pesi medi assegnati alle caratteristiche.

average_intercept_ - matrice, forma (1,)

Come suggerisce il nome, fornisce il termine di intercettazione media.

t_ - int

Fornisce il numero di aggiornamenti del peso eseguiti durante la fase di allenamento.

Note - gli attributi average_coef_ e average_intercept_ funzioneranno dopo aver abilitato il parametro 'average' a True.

Implementation Example

Seguendo gli usi dello script Python SGDRegressor modello lineare -

import numpy as np

from sklearn import linear_model

n_samples, n_features = 10, 5

rng = np.random.RandomState(0)

y = rng.randn(n_samples)

X = rng.randn(n_samples, n_features)

SGDReg =linear_model.SGDRegressor(

max_iter = 1000,penalty = "elasticnet",loss = 'huber',tol = 1e-3, average = True

)

SGDReg.fit(X, y)Output

SGDRegressor(

alpha = 0.0001, average = True, early_stopping = False, epsilon = 0.1,

eta0 = 0.01, fit_intercept = True, l1_ratio = 0.15,

learning_rate = 'invscaling', loss = 'huber', max_iter = 1000,

n_iter = None, n_iter_no_change = 5, penalty = 'elasticnet', power_t = 0.25,

random_state = None, shuffle = True, tol = 0.001, validation_fraction = 0.1,

verbose = 0, warm_start = False

)Example

Ora, una volta adattato, possiamo ottenere il vettore di peso con l'aiuto del seguente script python -

SGDReg.coef_Output

array([-0.00423314, 0.00362922, -0.00380136, 0.00585455, 0.00396787])Example

Allo stesso modo, possiamo ottenere il valore di intercettazione con l'aiuto del seguente script python -

SGReg.intercept_Output

SGReg.intercept_Example

Possiamo ottenere il numero di aggiornamenti di peso durante la fase di allenamento con l'aiuto del seguente script python:

SGDReg.t_Output

61.0Pro e contro di SGD

Seguendo i pro di SGD -

Stochastic Gradient Descent (SGD) è molto efficiente.

È molto facile da implementare poiché ci sono molte opportunità per l'ottimizzazione del codice.

A seguito degli svantaggi di SGD -

Stochastic Gradient Descent (SGD) richiede diversi iperparametri come i parametri di regolarizzazione.

È sensibile al ridimensionamento delle funzionalità.

Questo capitolo tratta un metodo di apprendimento automatico denominato SVM (Support Vector Machines).

introduzione

Le Support Vector Machine (SVM) sono metodi di machine learning supervisionati potenti ma flessibili utilizzati per la classificazione, la regressione e il rilevamento dei valori anomali. Gli SVM sono molto efficienti negli spazi ad alta dimensione e generalmente vengono utilizzati nei problemi di classificazione. Gli SVM sono diffusi ed efficienti in termini di memoria perché utilizzano un sottoinsieme di punti di addestramento nella funzione decisionale.

L'obiettivo principale degli SVM è dividere i set di dati in un numero di classi per trovare un file maximum marginal hyperplane (MMH) che può essere fatto nei seguenti due passaggi:

Support Vector Machines genererà prima gli iperpiani in modo iterativo che separa le classi nel modo migliore.

Dopodiché sceglierà l'iperpiano che segrega correttamente le classi.

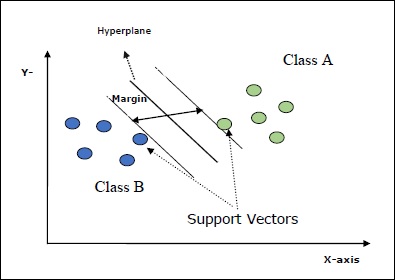

Alcuni concetti importanti in SVM sono i seguenti:

Support Vectors- Possono essere definiti come i punti dati più vicini all'iperpiano. I vettori di supporto aiutano a decidere la linea di separazione.

Hyperplane - Il piano decisionale o lo spazio che divide un insieme di oggetti aventi classi differenti.

Margin - Il divario tra due linee sui punti dati dell'armadio di classi diverse è chiamato margine.

I seguenti diagrammi ti daranno un'idea di questi concetti SVM:

SVM in Scikit-learn supporta vettori campione sia sparsi che densi come input.

Classificazione di SVM

Scikit-learn offre tre classi, vale a dire SVC, NuSVC e LinearSVC che può eseguire la classificazione di classi multiclasse.

SVC

È la classificazione del vettore di supporto C su cui si basa l'implementazione libsvm. Il modulo utilizzato da scikit-learn èsklearn.svm.SVC. Questa classe gestisce il supporto multiclasse secondo uno schema uno contro uno.

Parametri

La seguente tabella è costituita dai parametri utilizzati da sklearn.svm.SVC classe -

| Suor n | Parametro e descrizione |

|---|---|

| 1 | C - float, opzionale, default = 1.0 È il parametro di penalità del termine di errore. |

| 2 | kernel - stringa, opzionale, default = 'rbf' Questo parametro specifica il tipo di kernel da utilizzare nell'algoritmo. possiamo scegliere uno qualsiasi tra,‘linear’, ‘poly’, ‘rbf’, ‘sigmoid’, ‘precomputed’. Il valore predefinito del kernel sarebbe‘rbf’. |

| 3 | degree - int, opzionale, default = 3 Rappresenta il grado della funzione del kernel "poly" e verrà ignorato da tutti gli altri kernel. |

| 4 | gamma - {'scale', 'auto'} o float, È il coefficiente del kernel per i kernel "rbf", "poly" e "sigmoid". |

| 5 | optinal default - = 'scala' Se scegli il valore predefinito, ad esempio gamma = 'scale', il valore di gamma che deve essere utilizzato da SVC è 1 / (_ ∗. ()). D'altra parte, se gamma = 'auto', utilizza 1 / _. |

| 6 | coef0 - float, opzionale, Default = 0.0 Un termine indipendente nella funzione kernel che è significativo solo in "poly" e "sigmoid". |

| 7 | tol - float, opzionale, default = 1.e-3 Questo parametro rappresenta il criterio di arresto per le iterazioni. |

| 8 | shrinking - Booleano, opzionale, predefinito = True Questo parametro rappresenta se vogliamo utilizzare l'euristica di riduzione o meno. |

| 9 | verbose - Booleano, predefinito: false Abilita o disabilita l'output dettagliato. Il suo valore predefinito è false. |

| 10 | probability - booleano, opzionale, predefinito = vero Questo parametro abilita o disabilita le stime di probabilità. Il valore predefinito è false, ma deve essere abilitato prima di chiamare fit. |

| 11 | max_iter - int, opzionale, default = -1 Come suggerisce il nome, rappresenta il numero massimo di iterazioni all'interno del risolutore. Il valore -1 significa che non c'è limite al numero di iterazioni. |

| 12 | cache_size - galleggiante, opzionale Questo parametro specificherà la dimensione della cache del kernel. Il valore sarà in MB (MegaByte). |

| 13 | random_state - int, istanza RandomState o None, opzionale, default = nessuno Questo parametro rappresenta il seme del numero pseudo casuale generato che viene utilizzato durante la mescolanza dei dati. Le seguenti sono le opzioni:

|

| 14 | class_weight - {dict, 'balanced'}, facoltativo Questo parametro imposterà il parametro C della classe j su _ℎ [] ∗ per SVC. Se usiamo l'opzione predefinita, significa che tutte le classi dovrebbero avere un peso. D'altra parte, se scegliclass_weight:balanced, utilizzerà i valori di y per regolare automaticamente i pesi. |

| 15 | decision_function_shape - ovo ',' ovr ', default =' ovr ' Questo parametro deciderà se l'algoritmo tornerà ‘ovr’ (uno contro riposo) funzione decisionale della forma come tutti gli altri classificatori, o l'originale ovo(uno contro uno) funzione decisionale di libsvm. |

| 16 | break_ties - booleano, opzionale, predefinito = false True - La previsione interromperà i legami in base ai valori di confidenza di decision_function False - Il pronostico restituirà la prima classe tra le classi in parità. |

Attributi

La tabella seguente è costituita dagli attributi utilizzati da sklearn.svm.SVC classe -

| Suor n | Attributi e descrizione |

|---|---|

| 1 | support_ - tipo array, forma = [n_SV] Restituisce gli indici dei vettori di supporto. |

| 2 | support_vectors_ - tipo array, forma = [n_SV, n_features] Restituisce i vettori di supporto. |

| 3 | n_support_ - tipo array, dtype = int32, shape = [n_class] Rappresenta il numero di vettori di supporto per ogni classe. |

| 4 | dual_coef_ - matrice, forma = [n_class-1, n_SV] Questi sono i coefficienti dei vettori di supporto nella funzione di decisione. |

| 5 | coef_ - array, forma = [n_class * (n_class-1) / 2, n_features] Questo attributo, disponibile solo in caso di kernel lineare, fornisce il peso assegnato alle funzionalità. |

| 6 | intercept_ - matrice, forma = [n_class * (n_class-1) / 2] Rappresenta il termine indipendente (costante) nella funzione decisionale. |

| 7 | fit_status_ - int L'uscita sarebbe 0 se è montata correttamente. L'uscita sarebbe 1 se non è inserita correttamente. |

| 8 | classes_ - matrice di forma = [n_classes] Fornisce le etichette delle classi. |

Implementation Example

Come altri classificatori, anche SVC deve essere dotato dei seguenti due array:

Un array Xtenendo i campioni di addestramento. È di dimensione [n_samples, n_features].

Un array Ytenendo i valori target, ovvero le etichette di classe per i campioni di addestramento. È di dimensione [n_samples].

Seguendo gli usi dello script Python sklearn.svm.SVC classe -

import numpy as np

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

y = np.array([1, 1, 2, 2])

from sklearn.svm import SVC

SVCClf = SVC(kernel = 'linear',gamma = 'scale', shrinking = False,)

SVCClf.fit(X, y)Output

SVC(C = 1.0, cache_size = 200, class_weight = None, coef0 = 0.0,

decision_function_shape = 'ovr', degree = 3, gamma = 'scale', kernel = 'linear',

max_iter = -1, probability = False, random_state = None, shrinking = False,

tol = 0.001, verbose = False)Example

Ora, una volta adattato, possiamo ottenere il vettore di peso con l'aiuto del seguente script python -

SVCClf.coef_Output

array([[0.5, 0.5]])Example

Allo stesso modo, possiamo ottenere il valore di altri attributi come segue:

SVCClf.predict([[-0.5,-0.8]])Output

array([1])Example

SVCClf.n_support_Output

array([1, 1])Example

SVCClf.support_vectors_Output

array(

[

[-1., -1.],

[ 1., 1.]

]

)Example

SVCClf.support_Output

array([0, 2])Example

SVCClf.intercept_Output

array([-0.])Example

SVCClf.fit_status_Output

0NuSVC

NuSVC è Nu Support Vector Classification. È un'altra classe fornita da scikit-learn che può eseguire la classificazione multi-classe. È come SVC ma NuSVC accetta set di parametri leggermente diversi. Il parametro che è diverso da SVC è il seguente:

nu - float, opzionale, default = 0,5

Rappresenta un limite superiore sulla frazione di errori di addestramento e un limite inferiore della frazione di vettori di supporto. Il suo valore dovrebbe essere compreso nell'intervallo (o, 1].

Il resto dei parametri e degli attributi sono gli stessi di SVC.

Esempio di implementazione

Possiamo implementare lo stesso esempio usando sklearn.svm.NuSVC classe anche.

import numpy as np

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

y = np.array([1, 1, 2, 2])

from sklearn.svm import NuSVC

NuSVCClf = NuSVC(kernel = 'linear',gamma = 'scale', shrinking = False,)

NuSVCClf.fit(X, y)Produzione

NuSVC(cache_size = 200, class_weight = None, coef0 = 0.0,

decision_function_shape = 'ovr', degree = 3, gamma = 'scale', kernel = 'linear',

max_iter = -1, nu = 0.5, probability = False, random_state = None,

shrinking = False, tol = 0.001, verbose = False)Possiamo ottenere gli output del resto degli attributi come nel caso di SVC.

LinearSVC

È la classificazione del vettore di supporto lineare. È simile a SVC con kernel = 'linear'. La differenza tra loro è questaLinearSVC implementato in termini di liblinear mentre SVC è implementato in libsvm. Questa è la ragioneLinearSVCha una maggiore flessibilità nella scelta delle sanzioni e delle funzioni di perdita. Inoltre si adatta meglio a un numero elevato di campioni.

Se parliamo dei suoi parametri e attributi, allora non supporta ‘kernel’ perché si presume che sia lineare e manca anche di alcuni attributi come support_, support_vectors_, n_support_, fit_status_ e, dual_coef_.

Tuttavia, supporta penalty e loss parametri come segue -

penalty − string, L1 or L2(default = ‘L2’)

Questo parametro viene utilizzato per specificare la norma (L1 o L2) utilizzata nella penalizzazione (regolarizzazione).

loss − string, hinge, squared_hinge (default = squared_hinge)

Rappresenta la funzione di perdita dove "cerniera" è la perdita SVM standard e "squared_hinge" è il quadrato della perdita di cerniera.

Esempio di implementazione

Seguendo gli usi dello script Python sklearn.svm.LinearSVC classe -

from sklearn.svm import LinearSVC

from sklearn.datasets import make_classification

X, y = make_classification(n_features = 4, random_state = 0)

LSVCClf = LinearSVC(dual = False, random_state = 0, penalty = 'l1',tol = 1e-5)

LSVCClf.fit(X, y)Produzione

LinearSVC(C = 1.0, class_weight = None, dual = False, fit_intercept = True,

intercept_scaling = 1, loss = 'squared_hinge', max_iter = 1000,

multi_class = 'ovr', penalty = 'l1', random_state = 0, tol = 1e-05, verbose = 0)Esempio

Ora, una volta adattato, il modello può prevedere nuovi valori come segue:

LSVCClf.predict([[0,0,0,0]])Produzione

[1]Esempio

Per l'esempio sopra, possiamo ottenere il vettore di peso con l'aiuto del seguente script python:

LSVCClf.coef_Produzione

[[0. 0. 0.91214955 0.22630686]]Esempio

Allo stesso modo, possiamo ottenere il valore di intercettazione con l'aiuto del seguente script python -

LSVCClf.intercept_Produzione

[0.26860518]Regressione con SVM

Come discusso in precedenza, SVM viene utilizzato sia per la classificazione che per i problemi di regressione. Il metodo di Scikit-learn di Support Vector Classification (SVC) può essere esteso anche per risolvere i problemi di regressione. Questo metodo esteso è chiamato Support Vector Regression (SVR).

Somiglianza di base tra SVM e SVR

Il modello creato da SVC dipende solo da un sottoinsieme di dati di addestramento. Perché? Perché la funzione di costo per la creazione del modello non si preoccupa dell'addestramento dei punti dati che si trovano al di fuori del margine.

Mentre il modello prodotto da SVR (Support Vector Regression) dipende anche solo da un sottoinsieme dei dati di addestramento. Perché? Perché la funzione di costo per la creazione del modello ignora qualsiasi punto di dati di addestramento vicino alla previsione del modello.

Scikit-learn offre tre classi, vale a dire SVR, NuSVR and LinearSVR come tre diverse implementazioni di SVR.

SVR

È la regressione vettoriale di supporto Epsilon su cui si basa l'implementazione libsvm. Al contrario diSVC Ci sono due parametri liberi nel modello, vale a dire ‘C’ e ‘epsilon’.

epsilon - float, opzionale, default = 0.1

Rappresenta l'epsilon nel modello epsilon-SVR e specifica il tubo epsilon entro il quale nessuna penalità è associata nella funzione di perdita di allenamento con i punti previsti entro una distanza epsilon dal valore effettivo.

Il resto dei parametri e degli attributi sono simili a quelli usati in SVC.

Esempio di implementazione

Seguendo gli usi dello script Python sklearn.svm.SVR classe -

from sklearn import svm

X = [[1, 1], [2, 2]]

y = [1, 2]

SVRReg = svm.SVR(kernel = ’linear’, gamma = ’auto’)

SVRReg.fit(X, y)Produzione

SVR(C = 1.0, cache_size = 200, coef0 = 0.0, degree = 3, epsilon = 0.1, gamma = 'auto',

kernel = 'linear', max_iter = -1, shrinking = True, tol = 0.001, verbose = False)Esempio

Ora, una volta adattato, possiamo ottenere il vettore di peso con l'aiuto del seguente script python -

SVRReg.coef_Produzione

array([[0.4, 0.4]])Esempio

Allo stesso modo, possiamo ottenere il valore di altri attributi come segue:

SVRReg.predict([[1,1]])Produzione

array([1.1])Allo stesso modo, possiamo ottenere anche i valori di altri attributi.

NuSVR

NuSVR è Nu Support Vector Regression. È come NuSVC, ma NuSVR utilizza un parametronuper controllare il numero di vettori di supporto. E inoltre, a differenza di NuSVC dovenu sostituito il parametro C, qui sostituisce epsilon.

Esempio di implementazione

Seguendo gli usi dello script Python sklearn.svm.SVR classe -

from sklearn.svm import NuSVR

import numpy as np

n_samples, n_features = 20, 15

np.random.seed(0)

y = np.random.randn(n_samples)

X = np.random.randn(n_samples, n_features)

NuSVRReg = NuSVR(kernel = 'linear', gamma = 'auto',C = 1.0, nu = 0.1)^M

NuSVRReg.fit(X, y)Produzione

NuSVR(C = 1.0, cache_size = 200, coef0 = 0.0, degree = 3, gamma = 'auto',

kernel = 'linear', max_iter = -1, nu = 0.1, shrinking = True, tol = 0.001,

verbose = False)Esempio

Ora, una volta adattato, possiamo ottenere il vettore di peso con l'aiuto del seguente script python -

NuSVRReg.coef_Produzione

array(

[

[-0.14904483, 0.04596145, 0.22605216, -0.08125403, 0.06564533,

0.01104285, 0.04068767, 0.2918337 , -0.13473211, 0.36006765,

-0.2185713 , -0.31836476, -0.03048429, 0.16102126, -0.29317051]

]

)Allo stesso modo, possiamo ottenere anche il valore di altri attributi.

LinearSVR

È la regressione vettoriale di supporto lineare. È simile a SVR con kernel = 'linear'. La differenza tra loro è questaLinearSVR implementato in termini di liblinear, mentre SVC implementato in libsvm. Questa è la ragioneLinearSVRha una maggiore flessibilità nella scelta delle sanzioni e delle funzioni di perdita. Inoltre si adatta meglio a un numero elevato di campioni.

Se parliamo dei suoi parametri e attributi, allora non supporta ‘kernel’ perché si presume che sia lineare e manca anche di alcuni attributi come support_, support_vectors_, n_support_, fit_status_ e, dual_coef_.

Tuttavia, supporta i parametri di "perdita" come segue:

loss - stringa, opzionale, predefinito = 'epsilon_insensitive'

Rappresenta la funzione di perdita dove la perdita epsilon_insensitive è la perdita L1 e la perdita al quadrato epsilon-insensibile è la perdita L2.

Esempio di implementazione

Seguendo gli usi dello script Python sklearn.svm.LinearSVR classe -

from sklearn.svm import LinearSVR

from sklearn.datasets import make_regression

X, y = make_regression(n_features = 4, random_state = 0)

LSVRReg = LinearSVR(dual = False, random_state = 0,

loss = 'squared_epsilon_insensitive',tol = 1e-5)

LSVRReg.fit(X, y)Produzione

LinearSVR(

C=1.0, dual=False, epsilon=0.0, fit_intercept=True,

intercept_scaling=1.0, loss='squared_epsilon_insensitive',

max_iter=1000, random_state=0, tol=1e-05, verbose=0

)Esempio

Ora, una volta adattato, il modello può prevedere nuovi valori come segue:

LSRReg.predict([[0,0,0,0]])Produzione

array([-0.01041416])Esempio

Per l'esempio sopra, possiamo ottenere il vettore di peso con l'aiuto del seguente script python:

LSRReg.coef_Produzione

array([20.47354746, 34.08619401, 67.23189022, 87.47017787])Esempio

Allo stesso modo, possiamo ottenere il valore di intercettazione con l'aiuto del seguente script python -

LSRReg.intercept_Produzione

array([-0.01041416])Qui impareremo cos'è il rilevamento delle anomalie in Sklearn e come viene utilizzato nell'identificazione dei punti dati.

Il rilevamento delle anomalie è una tecnica utilizzata per identificare i punti dati nel set di dati che non si adattano bene al resto dei dati. Ha molte applicazioni nel business come il rilevamento delle frodi, il rilevamento delle intrusioni, il monitoraggio dell'integrità del sistema, la sorveglianza e la manutenzione predittiva. Le anomalie, chiamate anche valori anomali, possono essere suddivise nelle seguenti tre categorie:

Point anomalies - Si verifica quando una singola istanza di dati è considerata anomala rispetto al resto dei dati.

Contextual anomalies- Questo tipo di anomalia dipende dal contesto. Si verifica se un'istanza di dati è anomala in un contesto specifico.

Collective anomalies - Si verifica quando una raccolta di istanze di dati correlate è anomala rispetto all'intero set di dati anziché ai singoli valori.

Metodi

Due metodi vale a dire outlier detection e novelty detectionpuò essere utilizzato per il rilevamento di anomalie. È necessario vedere la distinzione tra loro.

Rilevamento dei valori anomali

I dati di addestramento contengono valori anomali lontani dal resto dei dati. Tali valori anomali sono definiti come osservazioni. Questo è il motivo per cui gli stimatori del rilevamento dei valori anomali cercano sempre di adattarsi alla regione con i dati di addestramento più concentrati ignorando le osservazioni devianti. È anche noto come rilevamento delle anomalie senza supervisione.

Rilevamento di novità

Si occupa di rilevare un modello non osservato nelle nuove osservazioni che non è incluso nei dati di addestramento. Qui, i dati di allenamento non sono inquinati dai valori anomali. È anche noto come rilevamento di anomalie semi-supervisionato.

Esistono una serie di strumenti ML, forniti da scikit-learn, che possono essere utilizzati sia per il rilevamento dei valori anomali che per il rilevamento delle novità. Questi strumenti implementano prima l'apprendimento degli oggetti dai dati in modo non supervisionato utilizzando il metodo fit () come segue:

estimator.fit(X_train)Ora, le nuove osservazioni verranno ordinate come inliers (labeled 1) o outliers (labeled -1) utilizzando il metodo forecast () come segue:

estimator.fit(X_test)Lo stimatore calcolerà prima la funzione di punteggio non elaborato e quindi il metodo di previsione utilizzerà la soglia su quella funzione di punteggio non elaborato. Possiamo accedere a questa funzione di punteggio grezzo con l'aiuto discore_sample metodo e può controllare la soglia di contamination parametro.

Possiamo anche definire decision_function metodo che definisce valori anomali come valore negativo e valori anomali come valore non negativo.

estimator.decision_function(X_test)Sklearn algoritmi per il rilevamento dei valori anomali

Cominciamo col capire cos'è un involucro ellittico.

Adatto a un involucro ellittico

Questo algoritmo presume che i dati regolari provengano da una distribuzione nota come la distribuzione gaussiana. Per il rilevamento dei valori anomali, Scikit-learn fornisce un oggetto denominatocovariance.EllipticEnvelop.

Questo oggetto adatta una stima robusta di covarianza ai dati e, quindi, adatta un'ellisse ai punti dati centrali. Ignora i punti al di fuori della modalità centrale.

Parametri

La tabella seguente è composta dai parametri utilizzati da sklearn. covariance.EllipticEnvelop metodo -

| Suor n | Parametro e descrizione |

|---|---|

| 1 | store_precision - Booleano, opzionale, predefinito = True Possiamo specificarlo se viene memorizzata la precisione stimata. |

| 2 | assume_centered - Booleano, opzionale, predefinito = False Se impostiamo False, calcolerà la posizione robusta e la covarianza direttamente con l'aiuto dell'algoritmo FastMCD. D'altra parte, se impostato su True, calcolerà il supporto di posizione robusta e covariante. |

| 3 | support_fraction - float in (0., 1.), opzionale, default = Nessuno Questo parametro indica al metodo quanta proporzione di punti deve essere inclusa nel supporto delle stime MCD non elaborate. |

| 4 | contamination - float in (0., 1.), opzionale, default = 0.1 Fornisce la proporzione dei valori anomali nel set di dati. |

| 5 | random_state - int, istanza RandomState o None, opzionale, default = nessuno Questo parametro rappresenta il seme del numero pseudo casuale generato che viene utilizzato durante la mescolanza dei dati. Le seguenti sono le opzioni:

|

Attributi

La tabella seguente è costituita dagli attributi utilizzati da sklearn. covariance.EllipticEnvelop metodo -

| Suor n | Attributi e descrizione |

|---|---|

| 1 | support_ - tipo array, forma (n_samples,) Rappresenta la maschera delle osservazioni utilizzate per calcolare stime robuste di posizione e forma. |

| 2 | location_ - tipo array, forma (n_features) Restituisce la posizione robusta stimata. |

| 3 | covariance_ - tipo array, forma (n_features, n_features) Restituisce la matrice di covarianza robusta stimata. |

| 4 | precision_ - tipo array, forma (n_features, n_features) Restituisce la matrice pseudo inversa stimata. |

| 5 | offset_ - galleggiante Viene utilizzato per definire la funzione decisionale dai punteggi grezzi. decision_function = score_samples -offset_ |

Implementation Example

import numpy as np^M

from sklearn.covariance import EllipticEnvelope^M

true_cov = np.array([[.5, .6],[.6, .4]])