PythonWebスクレイピング-はじめに

Webスクレイピングは、Webから情報を抽出する自動プロセスです。この章では、Webスクレイピングの詳細、Webクロールとの比較、およびWebスクレイピングを選択する理由について説明します。また、Webスクレイパーのコンポーネントと動作についても学習します。

Webスクレイピングとは何ですか?

「スクラップ」という単語の辞書の意味は、Webから何かを取得することを意味します。ここで2つの質問が発生します。Webから何を取得できるか、そしてそれを取得する方法です。

最初の質問への答えは ‘data’。データはどのプログラマーにとっても不可欠であり、すべてのプログラミングプロジェクトの基本的な要件は、大量の有用なデータです。

データを取得する方法はたくさんあるので、2番目の質問への答えは少し注意が必要です。一般に、データベースまたはデータファイルやその他のソースからデータを取得する場合があります。しかし、オンラインで利用できる大量のデータが必要な場合はどうでしょうか。このような種類のデータを取得する1つの方法は、必要なデータを手動で検索(Webブラウザーでクリックして離す)して保存(スプレッドシートまたはファイルにコピーアンドペースト)することです。この方法は非常に面倒で時間がかかります。このようなデータを取得する別の方法は、web scraping。

Web scraping、 とも呼ばれている web data mining または web harvestingは、Webから有用な情報を自動的に抽出、解析、ダウンロード、および整理できるエージェントを構築するプロセスです。言い換えれば、ウェブサイトからデータを手動で保存する代わりに、ウェブスクレイピングソフトウェアは、要件に従って複数のウェブサイトからデータを自動的にロードおよび抽出すると言うことができます。

Webスクレイピングの起源

Webスクレイピングの起源は、非WebベースのアプリケーションまたはネイティブWindowsアプリケーションを統合するために使用された画面スクレイピングです。もともとスクリーンスクレイピングは、ワールドワイドウェブ(WWW)が広く使用される前に使用されていましたが、拡張されたWWWをスケールアップすることはできませんでした。これにより、スクリーンスクレイピングのアプローチとと呼ばれる手法を自動化する必要がありました。‘Web Scraping’ 誕生しました。

Webクロールv / sWebスクレイピング

Webクロールとスクレイピングという用語は、データを抽出することを基本的な概念としているため、同じ意味で使用されることがよくあります。しかし、それらは互いに異なります。それらの定義から基本的な違いを理解することができます。

Webクロールは基本的に、ボット、別名クローラーを使用してページ上の情報にインデックスを付けるために使用されます。とも呼ばれますindexing。一方、Webスクレイピングは、ボット、別名スクレイパーを使用して情報を抽出する自動化された方法です。とも呼ばれますdata extraction。

これら2つの用語の違いを理解するために、以下に示す比較表を調べてみましょう。

| Webクロール | Webスクレイピング |

|---|---|

| 多数のウェブサイトのコンテンツをダウンロードして保存することを指します。 | サイト固有の構造を使用して、Webサイトから個々のデータ要素を抽出することを指します。 |

| 主に大規模に行われます。 | あらゆる規模で実装できます。 |

| 一般的な情報を生成します。 | 特定の情報を生成します。 |

| Google、Bing、Yahooなどの主要な検索エンジンで使用されます。 Googlebot Webクローラーの例です。 | Webスクレイピングを使用して抽出された情報は、他のWebサイトで複製したり、データ分析を実行したりするために使用できます。たとえば、データ要素には名前、住所、価格などがあります。 |

Webスクレイピングの使用

Webスクレイピングを使用する用途と理由は、ワールドワイドウェブの使用と同じくらい無限です。Webスクレイパーは、オンラインフードの注文、オンラインショッピングWebサイトのスキャン、利用可能になった瞬間の試合のチケットの購入など、人間と同じように何でもできます。ウェブスクレイピングの重要な用途のいくつかをここで説明します-

E-commerce Websites − Webスクレイパーは、特定の製品の価格に特に関連するデータをさまざまなeコマースWebサイトから収集して比較できます。

Content Aggregators − Webスクレイピングは、ニュースアグリゲーターやジョブアグリゲーターなどのコンテンツアグリゲーターによって、更新されたデータをユーザーに提供するために広く使用されています。

Marketing and Sales Campaigns − Webスクレイパーを使用して、販売およびマーケティングキャンペーンの電子メールや電話番号などのデータを取得できます。

Search Engine Optimization (SEO) − Webスクレイピングは、SEMRush、MajesticなどのSEOツールで広く使用されており、重要な検索キーワードのランク付けをビジネスに伝えます。

Data for Machine Learning Projects −機械学習プロジェクトのデータの取得は、Webスクレイピングに依存します。

Data for Research −研究者は、この自動化されたプロセスによって時間を節約することにより、研究作業の目的で有用なデータを収集できます。

Webスクレイパーのコンポーネント

ウェブスクレイパーは次のコンポーネントで構成されています-

Webクローラーモジュール

Webスクレイパーの非常に必要なコンポーネントであるWebクローラーモジュールは、URLに対してHTTPまたはHTTPS要求を行うことによってターゲットWebサイトをナビゲートするために使用されます。クローラーは非構造化データ(HTMLコンテンツ)をダウンロードし、次のモジュールであるエクストラクターに渡します。

抽出器

エクストラクタは、フェッチされたHTMLコンテンツを処理し、データを半構造化形式に抽出します。これはパーサーモジュールとも呼ばれ、正規表現、HTML解析、DOM解析、人工知能などのさまざまな解析手法を使用して機能します。

データ変換およびクリーニングモジュール

上で抽出されたデータは、すぐに使用するには適していません。使用できるように、クリーニングモジュールを通過する必要があります。この目的には、文字列操作や正規表現などのメソッドを使用できます。抽出と変換も1つのステップで実行できることに注意してください。

ストレージモジュール

データを抽出した後、要件に従ってデータを保存する必要があります。ストレージモジュールは、データベースまたはJSONまたはCSV形式で保存できる標準形式でデータを出力します。

Webスクレイパーの動作

Webスクレイパーは、複数のWebページのコンテンツをダウンロードしてそこからデータを抽出するために使用されるソフトウェアまたはスクリプトとして定義できます。

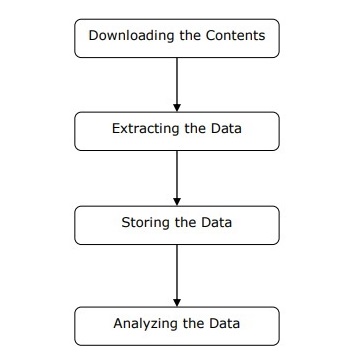

上図に示すように、簡単な手順でWebスクレイパーの動作を理解できます。

ステップ1:Webページからコンテンツをダウンロードする

このステップでは、Webスクレイパーが複数のWebページから要求されたコンテンツをダウンロードします。

ステップ2:データの抽出

WebサイトのデータはHTMLであり、ほとんどが構造化されていません。したがって、このステップでは、Webスクレイパーがダウンロードされたコンテンツから構造化データを解析して抽出します。

ステップ3:データの保存

ここで、Webスクレイパーは、抽出されたデータをCSV、JSON、またはデータベースなどの任意の形式で保存および保存します。

ステップ4:データの分析

これらのすべての手順が正常に実行された後、Webスクレイパーはこのようにして取得されたデータを分析します。