Hive-설치

Hive, Pig 및 HBase와 같은 모든 Hadoop 하위 프로젝트는 Linux 운영 체제를 지원합니다. 따라서 Linux 버전 OS를 설치해야합니다. Hive 설치를 위해 다음과 같은 간단한 단계가 실행됩니다.

1 단계 : JAVA 설치 확인

Hive를 설치하기 전에 시스템에 Java를 설치해야합니다. 다음 명령을 사용하여 Java 설치를 확인하겠습니다.

$ java –version시스템에 Java가 이미 설치되어 있으면 다음 응답이 표시됩니다.

java version "1.7.0_71"

Java(TM) SE Runtime Environment (build 1.7.0_71-b13)

Java HotSpot(TM) Client VM (build 25.0-b02, mixed mode)시스템에 java가 설치되어 있지 않으면 아래 단계에 따라 java를 설치하십시오.

자바 설치

1 단계 :

다음 링크를 방문하여 Java (JDK <최신 버전>-X64.tar.gz)를 다운로드하십시오. http://www.oracle.com/technetwork/java/javase/downloads/jdk7-downloads-1880260.html.

그런 다음 jdk-7u71-linux-x64.tar.gz가 시스템에 다운로드됩니다.

2 단계 :

일반적으로 다운로드 폴더에서 다운로드 한 Java 파일을 찾을 수 있습니다. 이를 확인하고 다음 명령을 사용하여 jdk-7u71-linux-x64.gz 파일을 추출하십시오.

$ cd Downloads/

$ ls

jdk-7u71-linux-x64.gz

$ tar zxf jdk-7u71-linux-x64.gz

$ ls

jdk1.7.0_71 jdk-7u71-linux-x64.gz3 단계 :

모든 사용자가 Java를 사용할 수 있도록하려면 "/ usr / local /"위치로 이동해야합니다. 루트를 열고 다음 명령을 입력하십시오.

$ su

password:

# mv jdk1.7.0_71 /usr/local/

# exit4 단계 :

PATH 및 JAVA_HOME 변수를 설정하려면 ~ / .bashrc 파일에 다음 명령을 추가하십시오.

export JAVA_HOME=/usr/local/jdk1.7.0_71

export PATH=$PATH:$JAVA_HOME/bin이제 모든 변경 사항을 현재 실행중인 시스템에 적용합니다.

$ source ~/.bashrc단계 V :

다음 명령을 사용하여 Java 대안을 구성하십시오.

# alternatives --install /usr/bin/java/java/usr/local/java/bin/java 2

# alternatives --install /usr/bin/javac/javac/usr/local/java/bin/javac 2

# alternatives --install /usr/bin/jar/jar/usr/local/java/bin/jar 2

# alternatives --set java/usr/local/java/bin/java

# alternatives --set javac/usr/local/java/bin/javac

# alternatives --set jar/usr/local/java/bin/jar이제 위에서 설명한대로 터미널에서 java -version 명령을 사용하여 설치를 확인합니다.

2 단계 : Hadoop 설치 확인

Hive를 설치하기 전에 시스템에 Hadoop을 설치해야합니다. 다음 명령을 사용하여 Hadoop 설치를 확인하겠습니다.

$ hadoop version시스템에 Hadoop이 이미 설치되어 있으면 다음과 같은 응답을 받게됩니다.

Hadoop 2.4.1 Subversion https://svn.apache.org/repos/asf/hadoop/common -r 1529768

Compiled by hortonmu on 2013-10-07T06:28Z

Compiled with protoc 2.5.0

From source with checksum 79e53ce7994d1628b240f09af91e1af4시스템에 Hadoop이 설치되어 있지 않은 경우 다음 단계를 진행하십시오.

Hadoop 다운로드

다음 명령을 사용하여 Apache Software Foundation에서 Hadoop 2.4.1을 다운로드하고 추출합니다.

$ su

password:

# cd /usr/local

# wget http://apache.claz.org/hadoop/common/hadoop-2.4.1/

hadoop-2.4.1.tar.gz

# tar xzf hadoop-2.4.1.tar.gz

# mv hadoop-2.4.1/* to hadoop/

# exit의사 분산 모드에서 Hadoop 설치

다음 단계는 의사 분산 모드에서 Hadoop 2.4.1을 설치하는 데 사용됩니다.

1 단계 : Hadoop 설정

다음 명령을 추가하여 Hadoop 환경 변수를 설정할 수 있습니다. ~/.bashrc 파일.

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export

PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin이제 모든 변경 사항을 현재 실행중인 시스템에 적용합니다.

$ source ~/.bashrc2 단계 : Hadoop 구성

"$ HADOOP_HOME / etc / hadoop"위치에서 모든 Hadoop 구성 파일을 찾을 수 있습니다. Hadoop 인프라에 따라 해당 구성 파일을 적절하게 변경해야합니다.

$ cd $HADOOP_HOME/etc/hadoopJava를 사용하여 Hadoop 프로그램을 개발하려면 다음에서 Java 환경 변수를 재설정해야합니다. hadoop-env.sh 대체하여 파일 JAVA_HOME 시스템의 java 위치와 함께 값.

export JAVA_HOME=/usr/local/jdk1.7.0_71다음은 Hadoop을 구성하기 위해 편집해야하는 파일 목록입니다.

core-site.xml

그만큼 core-site.xml 파일에는 Hadoop 인스턴스에 사용되는 포트 번호, 파일 시스템에 할당 된 메모리, 데이터 저장을위한 메모리 제한, 읽기 / 쓰기 버퍼 크기와 같은 정보가 포함됩니다.

core-site.xml을 열고 <configuration> 및 </ configuration> 태그 사이에 다음 속성을 추가합니다.

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>hdfs-site.xml

그만큼 hdfs-site.xml파일에는 복제 데이터 값, 이름 노드 경로 및 로컬 파일 시스템의 데이터 노드 경로와 같은 정보가 포함됩니다. Hadoop 인프라를 저장하려는 장소를 의미합니다.

다음 데이터를 가정 해 보겠습니다.

dfs.replication (data replication value) = 1

(In the following path /hadoop/ is the user name.

hadoopinfra/hdfs/namenode is the directory created by hdfs file system.)

namenode path = //home/hadoop/hadoopinfra/hdfs/namenode

(hadoopinfra/hdfs/datanode is the directory created by hdfs file system.)

datanode path = //home/hadoop/hadoopinfra/hdfs/datanode이 파일을 열고이 파일의 <configuration>, </ configuration> 태그 사이에 다음 속성을 추가합니다.

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.name.dir</name>

<value>file:///home/hadoop/hadoopinfra/hdfs/namenode </value>

</property>

<property>

<name>dfs.data.dir</name>

<value>file:///home/hadoop/hadoopinfra/hdfs/datanode </value >

</property>

</configuration>Note: 위 파일에서 모든 속성 값은 사용자 정의되며 Hadoop 인프라에 따라 변경할 수 있습니다.

yarn-site.xml

이 파일은 yarn을 Hadoop으로 구성하는 데 사용됩니다. yarn-site.xml 파일을 열고이 파일의 <configuration>, </ configuration> 태그 사이에 다음 특성을 추가하십시오.

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>mapred-site.xml

이 파일은 우리가 사용하는 MapReduce 프레임 워크를 지정하는 데 사용됩니다. 기본적으로 Hadoop에는 yarn-site.xml의 템플릿이 포함되어 있습니다. 먼저 다음 명령을 사용하여 파일을 mapred-site, xml.template에서 mapred-site.xml 파일로 복사해야합니다.

$ cp mapred-site.xml.template mapred-site.xml열다 mapred-site.xml 파일을 열고이 파일의 <configuration>, </ configuration> 태그 사이에 다음 속성을 추가합니다.

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>Hadoop 설치 확인

다음 단계는 Hadoop 설치를 확인하는 데 사용됩니다.

1 단계 : 이름 노드 설정

다음과 같이“hdfs namenode -format”명령을 사용하여 namenode를 설정합니다.

$ cd ~

$ hdfs namenode -format예상되는 결과는 다음과 같습니다.

10/24/14 21:30:55 INFO namenode.NameNode: STARTUP_MSG:

/************************************************************

STARTUP_MSG: Starting NameNode

STARTUP_MSG: host = localhost/192.168.1.11

STARTUP_MSG: args = [-format]

STARTUP_MSG: version = 2.4.1

...

...

10/24/14 21:30:56 INFO common.Storage: Storage directory

/home/hadoop/hadoopinfra/hdfs/namenode has been successfully formatted.

10/24/14 21:30:56 INFO namenode.NNStorageRetentionManager: Going to

retain 1 images with txid >= 0

10/24/14 21:30:56 INFO util.ExitUtil: Exiting with status 0

10/24/14 21:30:56 INFO namenode.NameNode: SHUTDOWN_MSG:

/************************************************************

SHUTDOWN_MSG: Shutting down NameNode at localhost/192.168.1.11

************************************************************/2 단계 : Hadoop dfs 확인

다음 명령은 dfs를 시작하는 데 사용됩니다. 이 명령을 실행하면 Hadoop 파일 시스템이 시작됩니다.

$ start-dfs.sh예상되는 출력은 다음과 같습니다.

10/24/14 21:37:56

Starting namenodes on [localhost]

localhost: starting namenode, logging to /home/hadoop/hadoop-2.4.1/logs/hadoop-hadoop-namenode-localhost.out

localhost: starting datanode, logging to /home/hadoop/hadoop-2.4.1/logs/hadoop-hadoop-datanode-localhost.out

Starting secondary namenodes [0.0.0.0]3 단계 : Yarn 스크립트 확인

다음 명령은 yarn 스크립트를 시작하는 데 사용됩니다. 이 명령을 실행하면 yarn 데몬이 시작됩니다.

$ start-yarn.sh예상되는 출력은 다음과 같습니다.

starting yarn daemons

starting resourcemanager, logging to /home/hadoop/hadoop-2.4.1/logs/yarn-hadoop-resourcemanager-localhost.out

localhost: starting nodemanager, logging to /home/hadoop/hadoop-2.4.1/logs/yarn-hadoop-nodemanager-localhost.out4 단계 : 브라우저에서 Hadoop 액세스

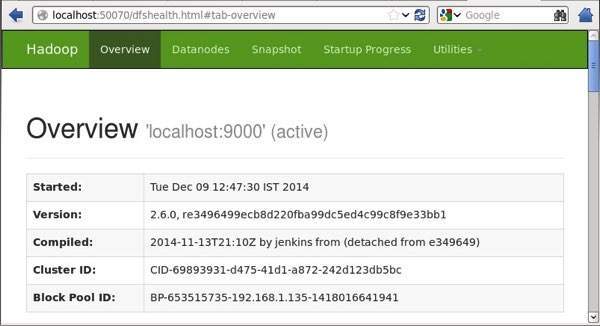

Hadoop에 액세스하기위한 기본 포트 번호는 50070입니다. 다음 URL을 사용하여 브라우저에서 Hadoop 서비스를 가져옵니다.

http://localhost:50070/

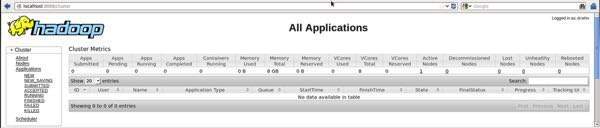

단계 V : 클러스터의 모든 애플리케이션 확인

클러스터의 모든 애플리케이션에 액세스하기위한 기본 포트 번호는 8088입니다.이 서비스를 방문하려면 다음 URL을 사용하십시오.

http://localhost:8088/

3 단계 : Hive 다운로드

이 자습서에서는 hive-0.14.0을 사용합니다. 다음 링크를 방문하여 다운로드 할 수 있습니다.http://apache.petsads.us/hive/hive-0.14.0/./ Downloads 디렉토리에 다운로드되었다고 가정하겠습니다. 여기서는이 튜토리얼을 위해“apache-hive-0.14.0-bin.tar.gz”라는 Hive 아카이브를 다운로드합니다. 다음 명령은 다운로드를 확인하는 데 사용됩니다.

$ cd Downloads

$ ls다운로드에 성공하면 다음과 같은 응답이 표시됩니다.

apache-hive-0.14.0-bin.tar.gz4 단계 : Hive 설치

시스템에 Hive를 설치하려면 다음 단계가 필요합니다. Hive 아카이브가 / Downloads 디렉토리에 다운로드되었다고 가정 해 보겠습니다.

Hive 아카이브 추출 및 확인

다음 명령은 다운로드를 확인하고 하이브 아카이브를 추출하는 데 사용됩니다.

$ tar zxvf apache-hive-0.14.0-bin.tar.gz

$ ls다운로드에 성공하면 다음과 같은 응답이 표시됩니다.

apache-hive-0.14.0-bin apache-hive-0.14.0-bin.tar.gz/ usr / local / hive 디렉토리에 파일 복사

수퍼 유저 "su-"의 파일을 복사해야합니다. 다음 명령은 추출 된 디렉토리에서 / usr / local / hive”디렉토리로 파일을 복사하는 데 사용됩니다.

$ su -

passwd:

# cd /home/user/Download

# mv apache-hive-0.14.0-bin /usr/local/hive

# exitHive를위한 환경 설정

다음 줄을 추가하여 Hive 환경을 설정할 수 있습니다. ~/.bashrc 파일:

export HIVE_HOME=/usr/local/hive

export PATH=$PATH:$HIVE_HOME/bin

export CLASSPATH=$CLASSPATH:/usr/local/Hadoop/lib/*:.

export CLASSPATH=$CLASSPATH:/usr/local/hive/lib/*:.~ / .bashrc 파일을 실행하려면 다음 명령을 사용합니다.

$ source ~/.bashrc5 단계 : Hive 구성

Hadoop으로 Hive를 구성하려면 다음을 편집해야합니다. hive-env.sh 파일은 $HIVE_HOME/conf예배 규칙서. 다음 명령은 Hive로 리디렉션됩니다.config 폴더를 열고 템플릿 파일을 복사합니다.

$ cd $HIVE_HOME/conf

$ cp hive-env.sh.template hive-env.sh편집 hive-env.sh 다음 줄을 추가하여 파일 :

export HADOOP_HOME=/usr/local/hadoopHive 설치가 성공적으로 완료되었습니다. 이제 Metastore를 구성하려면 외부 데이터베이스 서버가 필요합니다. Apache Derby 데이터베이스를 사용합니다.

6 단계 : Apache Derby 다운로드 및 설치

Apache Derby를 다운로드하고 설치하려면 아래 단계를 따르십시오.

Apache Derby 다운로드

다음 명령은 Apache Derby를 다운로드하는 데 사용됩니다. 다운로드하는 데 시간이 걸립니다.

$ cd ~

$ wget http://archive.apache.org/dist/db/derby/db-derby-10.4.2.0/db-derby-10.4.2.0-bin.tar.gz다음 명령은 다운로드를 확인하는 데 사용됩니다.

$ ls다운로드에 성공하면 다음과 같은 응답이 표시됩니다.

db-derby-10.4.2.0-bin.tar.gzDerby 아카이브 추출 및 확인

다음 명령은 Derby 아카이브를 추출하고 확인하는 데 사용됩니다.

$ tar zxvf db-derby-10.4.2.0-bin.tar.gz

$ ls다운로드에 성공하면 다음과 같은 응답이 표시됩니다.

db-derby-10.4.2.0-bin db-derby-10.4.2.0-bin.tar.gz/ usr / local / derby 디렉토리에 파일 복사

수퍼 유저 "su-"에서 복사해야합니다. 다음 명령은 추출 된 디렉토리에서 / usr / local / derby 디렉토리로 파일을 복사하는 데 사용됩니다.

$ su -

passwd:

# cd /home/user

# mv db-derby-10.4.2.0-bin /usr/local/derby

# exitDerby를위한 환경 설정

다음 행을 추가하여 Derby 환경을 설정할 수 있습니다. ~/.bashrc 파일:

export DERBY_HOME=/usr/local/derby

export PATH=$PATH:$DERBY_HOME/bin

Apache Hive

18

export CLASSPATH=$CLASSPATH:$DERBY_HOME/lib/derby.jar:$DERBY_HOME/lib/derbytools.jar다음 명령을 사용하여 ~/.bashrc 파일:

$ source ~/.bashrcMetastore를 저장할 디렉토리 생성

$ DERBY_HOME 디렉토리에 data라는 디렉토리를 작성하여 Metastore 데이터를 저장하십시오.

$ mkdir $DERBY_HOME/data이제 Derby 설치 및 환경 설정이 완료되었습니다.

7 단계 : Hive의 메타 스토어 구성

메타 스토어 구성은 데이터베이스가 저장되는 Hive를 지정하는 것을 의미합니다. $ HIVE_HOME / conf 디렉토리에있는 hive-site.xml 파일을 편집하여이를 수행 할 수 있습니다. 먼저 다음 명령을 사용하여 템플릿 파일을 복사합니다.

$ cd $HIVE_HOME/conf

$ cp hive-default.xml.template hive-site.xml편집하다 hive-site.xml <configuration> 및 </ configuration> 태그 사이에 다음 줄을 추가합니다.

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:derby://localhost:1527/metastore_db;create=true </value>

<description>JDBC connect string for a JDBC metastore </description>

</property>jpox.properties라는 파일을 만들고 여기에 다음 줄을 추가합니다.

javax.jdo.PersistenceManagerFactoryClass =

org.jpox.PersistenceManagerFactoryImpl

org.jpox.autoCreateSchema = false

org.jpox.validateTables = false

org.jpox.validateColumns = false

org.jpox.validateConstraints = false

org.jpox.storeManagerType = rdbms

org.jpox.autoCreateSchema = true

org.jpox.autoStartMechanismMode = checked

org.jpox.transactionIsolation = read_committed

javax.jdo.option.DetachAllOnCommit = true

javax.jdo.option.NontransactionalRead = true

javax.jdo.option.ConnectionDriverName = org.apache.derby.jdbc.ClientDriver

javax.jdo.option.ConnectionURL = jdbc:derby://hadoop1:1527/metastore_db;create = true

javax.jdo.option.ConnectionUserName = APP

javax.jdo.option.ConnectionPassword = mine8 단계 : Hive 설치 확인

Hive를 실행하기 전에 /tmp폴더 및 HDFS의 별도 Hive 폴더. 여기에서 우리는/user/hive/warehouse폴더. 아래와 같이 새로 생성 된 폴더에 대한 쓰기 권한을 설정해야합니다.

chmod g+w이제 Hive를 확인하기 전에 HDFS에서 설정하십시오. 다음 명령을 사용하십시오.

$ $HADOOP_HOME/bin/hadoop fs -mkdir /tmp

$ $HADOOP_HOME/bin/hadoop fs -mkdir /user/hive/warehouse

$ $HADOOP_HOME/bin/hadoop fs -chmod g+w /tmp

$ $HADOOP_HOME/bin/hadoop fs -chmod g+w /user/hive/warehouse다음 명령은 Hive 설치를 확인하는 데 사용됩니다.

$ cd $HIVE_HOME

$ bin/hiveHive를 성공적으로 설치하면 다음과 같은 응답이 표시됩니다.

Logging initialized using configuration in jar:file:/home/hadoop/hive-0.9.0/lib/hive-common-0.9.0.jar!/hive-log4j.properties

Hive history file=/tmp/hadoop/hive_job_log_hadoop_201312121621_1494929084.txt

………………….

hive>모든 테이블을 표시하기 위해 다음 샘플 명령이 실행됩니다.

hive> show tables;

OK

Time taken: 2.798 seconds

hive>