Współbieżność w Pythonie - szybki przewodnik

W tym rozdziale zrozumiemy pojęcie współbieżności w Pythonie i poznamy różne wątki i procesy.

Co to jest współbieżność?

Krótko mówiąc, współbieżność to występowanie dwóch lub więcej zdarzeń w tym samym czasie. Współbieżność jest zjawiskiem naturalnym, ponieważ w danym momencie występuje jednocześnie wiele zdarzeń.

Jeśli chodzi o programowanie, współbieżność występuje, gdy dwa zadania nakładają się na siebie podczas wykonywania. Dzięki programowaniu współbieżnemu można poprawić wydajność naszych aplikacji i systemów oprogramowania, ponieważ możemy jednocześnie obsługiwać żądania, zamiast czekać na ukończenie poprzedniego.

Historyczny przegląd współbieżności

Poniższe punkty dadzą nam krótki historyczny przegląd współbieżności -

Z koncepcji kolei

Współbieżność jest ściśle związana z koncepcją kolei. W przypadku kolei istniała potrzeba obsługi wielu pociągów w tym samym systemie kolejowym w taki sposób, aby każdy pociąg bezpiecznie dotarł do celu.

Obliczenia współbieżne w środowisku akademickim

Zainteresowanie współbieżnością w informatyce zaczęło się od artykułu badawczego opublikowanego przez Edsgera W. Dijkstry w 1965 roku. W artykule tym zidentyfikował i rozwiązał problem wzajemnego wykluczania, będącego własnością kontroli współbieżności.

Prymitywy współbieżności wysokiego poziomu

W ostatnim czasie programiści otrzymują ulepszone rozwiązania współbieżne z powodu wprowadzenia prymitywów współbieżności wysokiego poziomu.

Ulepszona współbieżność z językami programowania

Języki programowania, takie jak Golang, Rust i Python firmy Google, dokonały niesamowitych zmian w obszarach, które pomagają nam uzyskać lepsze, współbieżne rozwiązania.

Co to jest wątek i wielowątkowość?

Threadto najmniejsza jednostka wykonania, jaką można wykonać w systemie operacyjnym. Sam w sobie nie jest programem, ale działa w programie. Innymi słowy, wątki nie są od siebie niezależne. Każdy wątek dzieli sekcję kodu, sekcję danych itp. Z innymi wątkami. Znane są również jako lekkie procesy.

Wątek składa się z następujących elementów -

Licznik programu, który składa się z adresu następnej instrukcji wykonywalnej

Stack

Zestaw rejestrów

Unikalny identyfikator

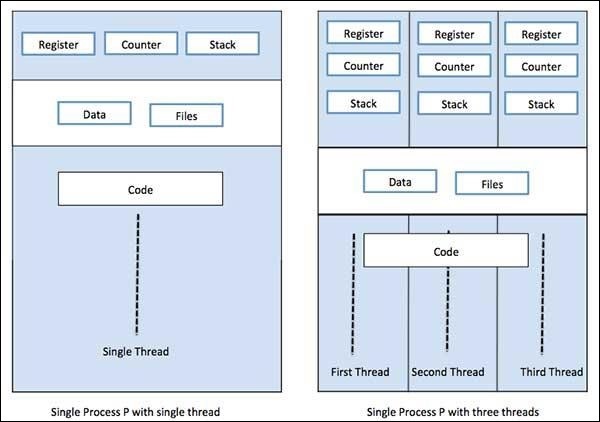

MultithreadingZ drugiej strony to zdolność procesora do zarządzania wykorzystaniem systemu operacyjnego poprzez jednoczesne wykonywanie wielu wątków. Główną ideą wielowątkowości jest osiągnięcie równoległości poprzez podzielenie procesu na wiele wątków. Pojęcie wielowątkowości można zrozumieć na poniższym przykładzie.

Przykład

Załóżmy, że uruchamiamy określony proces, w którym otwieramy MS Word, aby wpisać do niego zawartość. Jeden wątek zostanie przypisany do otwarcia MS Word, a inny wątek będzie wymagany do wpisania w nim treści. A teraz, jeśli chcemy edytować istniejący, do wykonania zadania edycji będzie potrzebny kolejny wątek i tak dalej.

Co to jest proces i wieloprocesorowość?

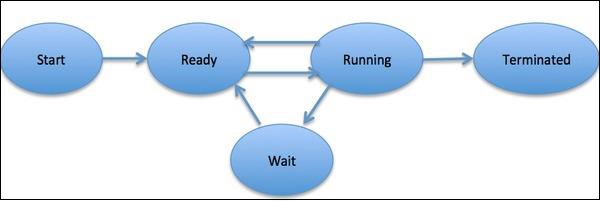

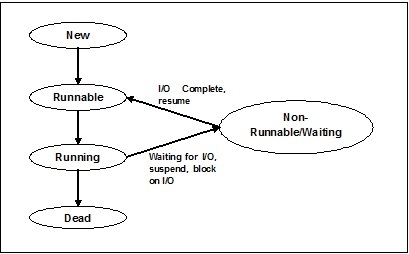

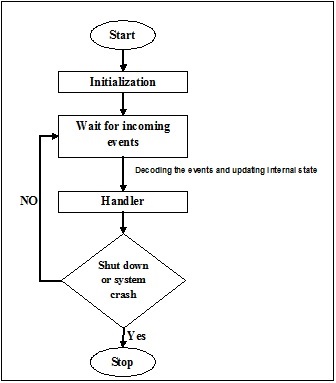

ZAprocessdefiniuje się jako jednostkę, która stanowi podstawową jednostkę pracy do zaimplementowania w systemie. Mówiąc prościej, piszemy nasze programy komputerowe w pliku tekstowym i kiedy wykonujemy ten program, staje się on procesem, który wykonuje wszystkie zadania wymienione w programie. Podczas cyklu życia procesu przechodzi przez różne etapy - Start, Gotowość, Uruchomienie, Oczekiwanie i Zakończenie.

Poniższy diagram przedstawia różne etapy procesu -

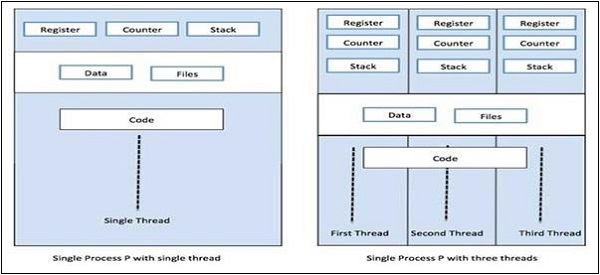

Proces może mieć tylko jeden wątek, zwany wątkiem podstawowym, lub wiele wątków posiadających własny zestaw rejestrów, licznik programu i stos. Poniższy diagram pokaże nam różnicę -

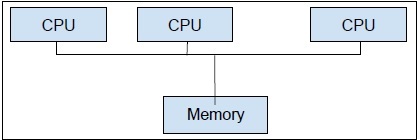

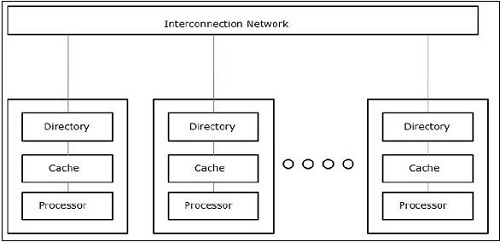

Multiprocessing,z drugiej strony jest to użycie dwóch lub więcej jednostek CPU w jednym systemie komputerowym. Naszym głównym celem jest wykorzystanie pełnego potencjału naszego sprzętu. Aby to osiągnąć, musimy wykorzystać pełną liczbę rdzeni procesora dostępnych w naszym systemie komputerowym. Najlepszym podejściem do tego jest wieloprocesowość.

Python to jeden z najpopularniejszych języków programowania. Oto kilka powodów, które sprawiają, że nadaje się do jednoczesnych aplikacji -

Cukier syntaktyczny

Cukier syntaktyczny to składnia w języku programowania, która ma na celu ułatwienie czytania lub wyrażania. Sprawia, że język jest „słodszy” do użytku przez ludzi: rzeczy można wyrazić jaśniej, bardziej zwięźle lub w alternatywnym stylu opartym na preferencjach. Python zawiera metody Magic, które można zdefiniować tak, aby działały na obiektach. Te magiczne metody są używane jako cukier syntaktyczny i są powiązane z łatwiejszymi do zrozumienia słowami kluczowymi.

Duża społeczność

Język Python był świadkiem ogromnego wskaźnika adopcji wśród analityków danych i matematyków, pracujących w dziedzinie sztucznej inteligencji, uczenia maszynowego, głębokiego uczenia się i analizy ilościowej.

Przydatne interfejsy API do programowania współbieżnego

Python 2 i 3 mają dużą liczbę interfejsów API przeznaczonych do programowania równoległego / współbieżnego. Najpopularniejsze z nich tothreading, concurrent.features, multiprocessing, asyncio, gevent and greenlets, itp.

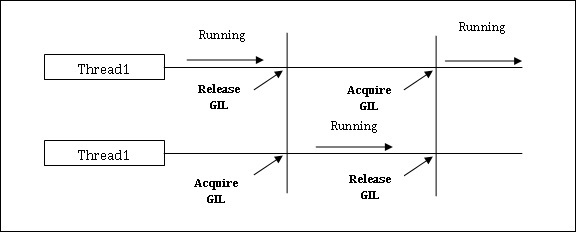

Ograniczenia Pythona we wdrażaniu współbieżnych aplikacji

Python zawiera ograniczenie dla współbieżnych aplikacji. To ograniczenie nazywa sięGIL (Global Interpreter Lock)jest obecny w Pythonie. GIL nigdy nie pozwala nam na wykorzystanie wielu rdzeni procesora, dlatego możemy powiedzieć, że w Pythonie nie ma prawdziwych wątków. Możemy zrozumieć koncepcję GIL w następujący sposób -

GIL (Global Interpreter Lock)

Jest to jeden z najbardziej kontrowersyjnych tematów w świecie Pythona. W CPythonie GIL jest muteksem - blokadą wzajemnego wykluczania, która zapewnia bezpieczeństwo wątków. Innymi słowy, możemy powiedzieć, że GIL zapobiega równoległemu wykonywaniu kodu Pythona przez wiele wątków. Blokada może być utrzymywana tylko przez jeden wątek naraz, a jeśli chcemy wykonać wątek, musi najpierw uzyskać blokadę. Poniższy diagram pomoże ci zrozumieć działanie GIL.

Jednak istnieją pewne biblioteki i implementacje w Pythonie, takie jak Numpy, Jpython i IronPytbhon. Biblioteki te działają bez interakcji z GIL.

Zarówno współbieżność, jak i równoległość są używane w odniesieniu do programów wielowątkowych, ale istnieje wiele nieporozumień dotyczących podobieństwa i różnicy między nimi. Najważniejsze pytanie w tym zakresie: czy równoległość współbieżności jest czy nie? Chociaż oba terminy wydają się dość podobne, ale odpowiedź na powyższe pytanie brzmi NIE, współbieżność i równoległość nie są tym samym. A jeśli nie są takie same, jaka jest między nimi podstawowa różnica?

Mówiąc prościej, współbieżność zajmuje się zarządzaniem dostępem do współdzielonego stanu z różnych wątków, a z drugiej strony równoległość polega na wykorzystaniu wielu procesorów lub ich rdzeni w celu poprawy wydajności sprzętu.

Szczegóły współbieżności

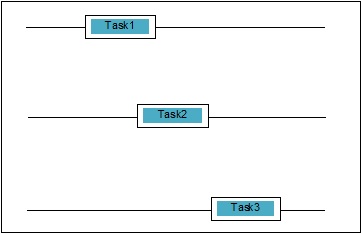

Współbieżność występuje, gdy dwa zadania nakładają się na siebie podczas wykonywania. Może to być sytuacja, w której aplikacja obsługuje więcej niż jedno zadanie w tym samym czasie. Możemy to zrozumieć schematycznie; w tym samym czasie postępuje wiele zadań, jak następuje -

Poziomy współbieżności

W tej sekcji omówimy trzy ważne poziomy współbieżności w zakresie programowania -

Współbieżność niskiego poziomu

Na tym poziomie współbieżności istnieje jawne użycie operacji atomowych. Nie możemy używać tego rodzaju współbieżności do budowania aplikacji, ponieważ jest ona bardzo podatna na błędy i trudna do debugowania. Nawet Python nie obsługuje tego rodzaju współbieżności.

Współbieżność średniego poziomu

W tej współbieżności nie ma użycia jawnych operacji atomowych. Używa jawnych blokad. Python i inne języki programowania obsługują tego rodzaju współbieżność. Przeważnie programiści aplikacji używają tej współbieżności.

Współbieżność wysokiego poziomu

W tej współbieżności nie są używane ani jawne operacje niepodzielne, ani jawne blokady. Python maconcurrent.futures moduł do obsługi tego rodzaju współbieżności.

Właściwości systemów współbieżnych

Aby program lub system współbieżny były poprawne, muszą spełniać pewne właściwości. Właściwości związane z zakończeniem systemu są następujące -

Właściwość poprawności

Właściwość poprawności oznacza, że program lub system musi podać żądaną poprawną odpowiedź. Aby to uprościć, możemy powiedzieć, że system musi poprawnie odwzorować stan programu początkowego na stan końcowy.

Majątek bezpieczeństwa

Właściwość bezpieczeństwa oznacza, że program lub system musi pozostać w pliku “good” lub “safe” stan i nigdy nic nie robi “bad”.

Majątek życia

Ta właściwość oznacza, że program lub system musi “make progress” i osiągnie jakiś pożądany stan.

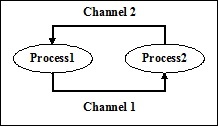

Aktorzy systemów współbieżnych

Jest to wspólna właściwość systemu współbieżnego, w którym może istnieć wiele procesów i wątków, które działają w tym samym czasie, aby wykonywać postępy w wykonywaniu własnych zadań. Te procesy i wątki nazywane są aktorami systemu współbieżnego.

Zasoby systemów współbieżnych

Aktorzy muszą wykorzystywać zasoby, takie jak pamięć, dysk, drukarka itp., Aby wykonywać swoje zadania.

Pewien zbiór zasad

Każdy współbieżny system musi posiadać zestaw reguł określających rodzaj zadań do wykonania przez aktorów i ich harmonogram. Zadania mogą obejmować pozyskiwanie blokad, udostępnianie pamięci, modyfikowanie stanu itp.

Bariery współbieżnych systemów

Udostępnianie danych

Istotną kwestią podczas wdrażania systemów współbieżnych jest współdzielenie danych pomiędzy wieloma wątkami lub procesami. W rzeczywistości programista musi zapewnić, że blokady chronią współdzielone dane, tak aby wszystkie dostępy do nich były serializowane i tylko jeden wątek lub proces miał dostęp do współdzielonych danych w danym momencie. W przypadku, gdy wiele wątków lub procesów próbuje uzyskać dostęp do tych samych udostępnionych danych, nie wszystkie, z wyjątkiem co najmniej jednego, zostaną zablokowane i pozostaną bezczynne. Innymi słowy, możemy powiedzieć, że bylibyśmy w stanie używać tylko jednego procesu lub wątku w czasie, gdy obowiązuje blokada. Istnieje kilka prostych rozwiązań w celu usunięcia wyżej wymienionych barier -

Ograniczenie udostępniania danych

Najprostszym rozwiązaniem jest nieudostępnianie żadnych zmiennych danych. W takim przypadku nie musimy używać jawnego blokowania, a bariera współbieżności spowodowana wzajemnymi danymi zostałaby rozwiązana.

Pomoc w zakresie struktury danych

Często współbieżne procesy muszą mieć dostęp do tych samych danych w tym samym czasie. Innym rozwiązaniem, niż użycie jawnych blokad, jest użycie struktury danych, która obsługuje współbieżny dostęp. Na przykład możemy użyćqueuemoduł, który zapewnia kolejki bezpieczne dla wątków. Możemy również użyćmultiprocessing.JoinableQueue klasy dla współbieżności opartej na wieloprocesowości.

Niezmienny transfer danych

Czasami struktura danych, której używamy, powiedzmy kolejka współbieżności, nie jest odpowiednia, wtedy możemy przekazać niezmienne dane bez ich blokowania.

Zmienny transfer danych

Kontynuując powyższe rozwiązanie, załóżmy, że jeśli wymagane jest przekazywanie tylko danych podlegających zmianom, a nie danych niezmiennych, to możemy przekazywać zmienne dane, które są tylko do odczytu.

Udostępnianie zasobów we / wy

Inną ważną kwestią we wdrażaniu systemów współbieżnych jest wykorzystanie zasobów we / wy przez wątki lub procesy. Problem pojawia się, gdy jeden wątek lub proces używa wejścia / wyjścia przez tak długi czas, a inny jest bezczynny. Tego rodzaju barierę widzimy pracując z aplikacją wymagającą dużej liczby wejść / wyjść. Można to zrozumieć na przykładzie żądania stron z przeglądarki internetowej. To ciężka aplikacja. Tutaj, jeśli szybkość, z jaką żądane są dane, jest wolniejsza niż szybkość, z jaką są one zużywane, to mamy barierę we / wy w naszym współbieżnym systemie.

Poniższy skrypt Pythona służy do żądania strony internetowej i uzyskania czasu, jaki zajęło naszej sieci uzyskanie żądanej strony -

import urllib.request

import time

ts = time.time()

req = urllib.request.urlopen('http://www.tutorialspoint.com')

pageHtml = req.read()

te = time.time()

print("Page Fetching Time : {} Seconds".format (te-ts))Po wykonaniu powyższego skryptu możemy uzyskać czas pobierania strony, jak pokazano poniżej.

Wynik

Page Fetching Time: 1.0991398811340332 SecondsWidzimy, że czas na pobranie strony jest dłuższy niż jedna sekunda. A co, jeśli chcemy pobrać tysiące różnych stron internetowych, możesz zrozumieć, ile czasu zajmie nasza sieć.

Co to jest równoległość?

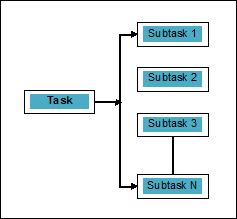

Równoległość można zdefiniować jako sztukę dzielenia zadań na podzadania, które mogą być przetwarzane jednocześnie. Jest to przeciwieństwo współbieżności, jak omówiono powyżej, w której dwa lub więcej zdarzeń zachodzi w tym samym czasie. Możemy to zrozumieć schematycznie; zadanie jest podzielone na kilka podzadań, które mogą być przetwarzane równolegle, w następujący sposób -

Aby uzyskać więcej informacji na temat różnicy między współbieżnością a równoległością, rozważ następujące punkty -

Współbieżne, ale nie równoległe

Aplikacja może być współbieżna, ale nie równoległa, co oznacza, że w tym samym czasie przetwarza więcej niż jedno zadanie, ale zadania nie są dzielone na podzadania.

Równolegle, ale nie równolegle

Aplikacja może być równoległa, ale nie współbieżna, co oznacza, że działa tylko na jednym zadaniu na raz, a zadania podzielone na podzadania mogą być przetwarzane równolegle.

Ani równoległe, ani współbieżne

Aplikacja nie może być ani równoległa, ani współbieżna. Oznacza to, że działa tylko na jednym zadaniu naraz, a zadanie nigdy nie jest dzielone na podzadania.

Zarówno równoległe, jak i współbieżne

Aplikacja może być zarówno równoległa, jak i współbieżna, co oznacza, że działa jednocześnie na wielu zadaniach, a zadanie jest podzielone na podzadania do wykonywania ich równolegle.

Konieczność równoległości

Możemy osiągnąć paralelizm, rozdzielając podzadania na różne rdzenie pojedynczego procesora lub na wiele komputerów połączonych w sieci.

Rozważ następujące ważne punkty, aby zrozumieć, dlaczego konieczne jest osiągnięcie równoległości:

Wydajne wykonanie kodu

Za pomocą równoległości możemy wydajnie uruchamiać nasz kod. Zaoszczędzi to nasz czas, ponieważ ten sam kod w częściach działa równolegle.

Szybszy niż przetwarzanie sekwencyjne

Obliczenia sekwencyjne są ograniczone czynnikami fizycznymi i praktycznymi, przez co nie jest możliwe uzyskanie szybszych wyników obliczeń. Z drugiej strony ten problem jest rozwiązany przez obliczenia równoległe i daje nam szybsze wyniki obliczeń niż obliczenia sekwencyjne.

Krótszy czas realizacji

Przetwarzanie równoległe skraca czas wykonywania kodu programu.

Jeśli mówimy o prawdziwym przykładzie równoległości, karta graficzna naszego komputera jest przykładem, który podkreśla prawdziwą moc przetwarzania równoległego, ponieważ ma setki indywidualnych rdzeni przetwarzających, które działają niezależnie i mogą wykonywać operacje w tym samym czasie. Z tego powodu jesteśmy w stanie uruchamiać również aplikacje i gry z najwyższej półki.

Zrozumienie procesorów do wdrożenia

Wiemy o współbieżności, równoległości i różnicy między nimi, ale co z systemem, w którym ma być zaimplementowana. Niezbędna jest znajomość systemu, na którym będziemy wdrażać, ponieważ daje nam to możliwość podejmowania świadomych decyzji podczas projektowania oprogramowania. Mamy dwa rodzaje procesorów -

Procesory jednordzeniowe

Procesory jednordzeniowe mogą w dowolnym momencie wykonywać jeden wątek. Te procesory używającontext switchingaby przechowywać wszystkie niezbędne informacje dotyczące wątku w określonym czasie, a następnie przywrócić je później. Mechanizm przełączania kontekstów pomaga nam robić postępy w wielu wątkach w ciągu danej sekundy i wygląda na to, że system pracuje nad wieloma rzeczami.

Procesory jednordzeniowe mają wiele zalet. Te procesory wymagają mniej energii i nie ma złożonego protokołu komunikacyjnego między wieloma rdzeniami. Z drugiej strony szybkość procesorów jednordzeniowych jest ograniczona i nie nadaje się do większych aplikacji.

Procesory wielordzeniowe

Procesory wielordzeniowe mają wiele niezależnych jednostek przetwarzających zwanych również cores.

Takie procesory nie potrzebują mechanizmu przełączania kontekstu, ponieważ każdy rdzeń zawiera wszystko, czego potrzebuje do wykonania sekwencji zapisanych instrukcji.

Cykl pobierania, dekodowania i wykonywania

Rdzenie procesorów wielordzeniowych wykonują cykl. Ten cykl nazywa sięFetch-Decode-Executecykl. Obejmuje następujące kroki -

Sprowadzać

Jest to pierwszy krok cyklu, który polega na pobieraniu instrukcji z pamięci programu.

Rozszyfrować

Niedawno pobrane instrukcje byłyby konwertowane na serię sygnałów, które będą wyzwalać inne części procesora.

Wykonać

Jest to ostatni krok, w którym zostaną wykonane pobrane i zdekodowane instrukcje. Wynik wykonania zostanie zapisany w rejestrze procesora.

Jedną z zalet jest to, że wykonanie w procesorach wielordzeniowych jest szybsze niż w procesorach jednordzeniowych. Nadaje się do większych zastosowań. Z drugiej strony problemem jest złożony protokół komunikacyjny między wieloma rdzeniami. Wiele rdzeni wymaga więcej mocy niż procesory jednordzeniowe.

Podczas projektowania programu lub systemu współbieżnego należy wziąć pod uwagę różne style systemu i architektury pamięci. Jest to bardzo konieczne, ponieważ jeden styl systemu i pamięci może być odpowiedni do jednego zadania, ale może być podatny na błędy w przypadku innego zadania.

Architektury systemów komputerowych obsługujące współbieżność

Michael Flynn w 1972 roku przedstawił taksonomię kategoryzacji różnych stylów architektury systemów komputerowych. Ta taksonomia definiuje cztery różne style w następujący sposób -

- Pojedynczy strumień instrukcji, pojedynczy strumień danych (SISD)

- Pojedynczy strumień instrukcji, wiele strumieni danych (SIMD)

- Wiele strumieni instrukcji, pojedynczy strumień danych (MISD)

- Wiele strumieni instrukcji, wiele strumieni danych (MIMD).

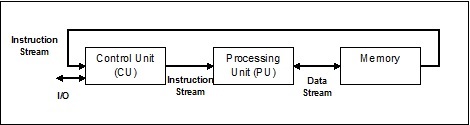

Pojedynczy strumień instrukcji, pojedynczy strumień danych (SISD)

Jak sama nazwa wskazuje, takie systemy miałyby jeden sekwencyjny przychodzący strumień danych i jedną jednostkę przetwarzającą do realizacji strumienia danych. Są jak systemy jednoprocesorowe o równoległej architekturze obliczeniowej. Oto architektura SISD -

Zalety SISD

Zalety architektury SISD są następujące -

- Wymaga mniej energii.

- Nie ma problemu ze złożonym protokołem komunikacyjnym między wieloma rdzeniami.

Wady SISD

Wady architektury SISD są następujące -

- Szybkość architektury SISD jest ograniczona, podobnie jak w przypadku procesorów jednordzeniowych.

- Nie nadaje się do większych zastosowań.

Pojedynczy strumień instrukcji, wiele strumieni danych (SIMD)

Jak sama nazwa wskazuje, tego rodzaju systemy miałyby wiele przychodzących strumieni danych i liczbę jednostek przetwarzających, które mogą działać na pojedynczą instrukcję w danym momencie. Są jak systemy wieloprocesorowe z równoległą architekturą obliczeniową. Oto architektura SIMD -

Najlepszym przykładem SIMD są karty graficzne. Te karty mają setki indywidualnych jednostek przetwarzania. Jeśli mówimy o obliczeniowej różnicy między SISD i SIMD, to o dodawanie tablic[5, 15, 20] i [15, 25, 10],Architektura SISD musiałaby wykonać trzy różne operacje dodawania. Z drugiej strony, dzięki architekturze SIMD, możemy dodać następnie w jednej operacji dodawania.

Zalety SIMD

Zalety architektury SIMD są następujące -

Ta sama operacja na wielu elementach może być wykonana przy użyciu tylko jednej instrukcji.

Wydajność systemu można zwiększyć, zwiększając liczbę rdzeni procesora.

Szybkość przetwarzania jest wyższa niż w architekturze SISD.

Wady SIMD

Wady architektury SIMD są następujące -

- Istnieje złożona komunikacja między liczbą rdzeni procesora.

- Koszt jest wyższy niż w przypadku architektury SISD.

Strumień wielu instrukcji pojedynczych danych (MISD)

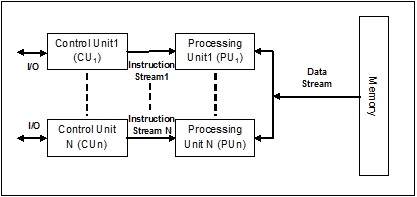

Systemy ze strumieniem MISD mają wiele jednostek przetwarzających wykonujących różne operacje, wykonując różne instrukcje na tym samym zestawie danych. Oto architektura MISD -

Przedstawiciele architektury MISD nie istnieją jeszcze komercyjnie.

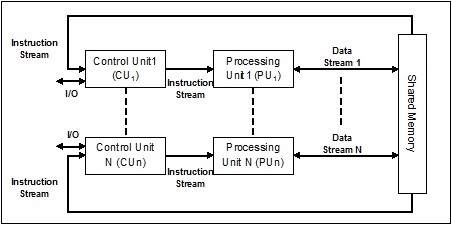

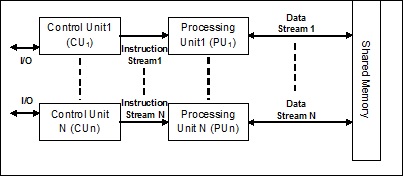

Strumień danych wielu instrukcji (MIMD)

W systemie wykorzystującym architekturę MIMD każdy procesor w systemie wieloprocesorowym może wykonywać różne zestawy instrukcji niezależnie od różnych zestawów danych równolegle. Jest to przeciwieństwo architektury SIMD, w której pojedyncza operacja jest wykonywana na wielu zestawach danych. Oto architektura MIMD -

Zwykły procesor wieloprocesorowy wykorzystuje architekturę MIMD. Architektury te są zasadniczo używane w wielu obszarach zastosowań, takich jak projektowanie wspomagane komputerowo / produkcja wspomagana komputerowo, symulacja, modelowanie, przełączniki komunikacyjne itp.

Architektury pamięci obsługujące współbieżność

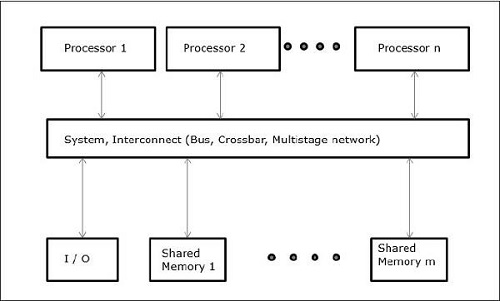

Podczas pracy z takimi pojęciami, jak współbieżność i równoległość, zawsze istnieje potrzeba przyspieszenia programów. Jednym z rozwiązań znalezionych przez projektantów komputerów jest utworzenie wielu komputerów z pamięcią współdzieloną, tj. Komputerów posiadających pojedynczą fizyczną przestrzeń adresową, do której dostęp mają wszystkie rdzenie procesora. W tym scenariuszu może istnieć wiele różnych stylów architektury, ale następujące są trzy ważne style architektoniczne -

UMA (jednolity dostęp do pamięci)

W tym modelu wszystkie procesory równomiernie współdzielą pamięć fizyczną. Wszystkie procesory mają równy czas dostępu do wszystkich słów pamięci. Każdy procesor może mieć prywatną pamięć podręczną. Urządzenia peryferyjne podlegają pewnym regułom.

Gdy wszystkie procesory mają równy dostęp do wszystkich urządzeń peryferyjnych, system nazywa się a symmetric multiprocessor. Gdy tylko jeden lub kilka procesorów ma dostęp do urządzeń peryferyjnych, system nosi nazwęasymmetric multiprocessor.

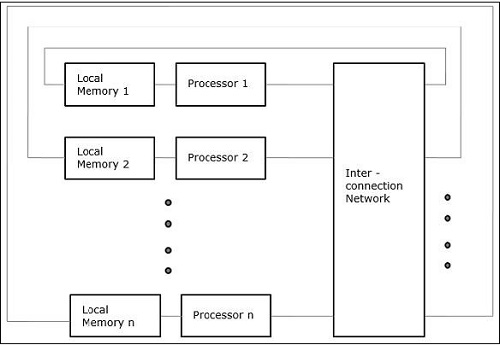

Niejednolity dostęp do pamięci (NUMA)

W modelu wieloprocesorowym NUMA czas dostępu różni się w zależności od lokalizacji słowa pamięci. Tutaj pamięć współdzielona jest fizycznie rozdzielana między wszystkie procesory, zwane pamięcią lokalną. Zbiór wszystkich lokalnych pamięci tworzy globalną przestrzeń adresową, do której mają dostęp wszystkie procesory.

Architektura pamięci podręcznej (COMA)

Model COMA to wyspecjalizowana wersja modelu NUMA. Tutaj wszystkie rozproszone pamięci główne są konwertowane na pamięci podręczne.

Ogólnie rzecz biorąc, jak wiemy, nić jest bardzo cienkim skręconym sznurkiem, zwykle z bawełny lub jedwabiu, używanym do szycia ubrań i tym podobnych. Ten sam termin wątek jest również używany w świecie programowania komputerowego. A teraz, jak odnosimy się do nici używanej do szycia ubrań i nici używanej do programowania komputerowego? Role pełnione przez oba wątki są tutaj podobne. W ubraniach nić trzyma tkaninę razem, a po drugiej stronie, w programowaniu komputerowym, nić trzyma program komputerowy i pozwala programowi na wykonanie sekwencyjnych działań lub wielu akcji naraz.

Threadto najmniejsza jednostka wykonania w systemie operacyjnym. Sam w sobie nie jest programem, ale działa w programie. Innymi słowy, wątki nie są od siebie niezależne i współdzielą sekcję kodu, sekcję danych itp. Z innymi wątkami. Te wątki są również znane jako lekkie procesy.

Stany wątku

Aby dogłębnie zrozumieć funkcjonalność wątków, musimy poznać cykl życia wątków lub różne stany wątków. Zazwyczaj wątek może istnieć w pięciu różnych stanach. Poniżej przedstawiono różne stany -

Nowy wątek

Nowy wątek rozpoczyna swój cykl życia w nowym stanie. Jednak na tym etapie jeszcze się nie rozpoczął i nie przydzielono mu żadnych środków. Można powiedzieć, że jest to tylko instancja obiektu.

Runnable

Gdy nowo narodzony wątek jest uruchamiany, wątek staje się gotowy do uruchomienia, tj. Czeka na uruchomienie. W tym stanie ma wszystkie zasoby, ale nadal harmonogram zadań nie zaplanował jego uruchomienia.

Bieganie

W tym stanie wątek wykonuje postęp i wykonuje zadanie, które zostało wybrane do uruchomienia przez harmonogram zadań. Teraz wątek może przejść do stanu martwego lub niedziałającego / oczekującego.

Nie działa / czeka

W tym stanie wątek jest wstrzymywany, ponieważ czeka na odpowiedź jakiegoś żądania we / wy lub czeka na zakończenie wykonywania innego wątku.

Nie żyje

Uruchomiony wątek przechodzi w stan zakończony po zakończeniu zadania lub w inny sposób.

Poniższy diagram przedstawia pełny cykl życia wątku -

Rodzaje wątków

W tej sekcji zobaczymy różne rodzaje nici. Rodzaje opisano poniżej -

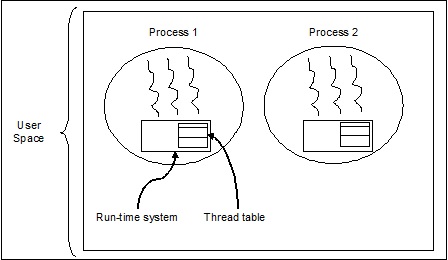

Wątki na poziomie użytkownika

To są wątki zarządzane przez użytkowników.

W tym przypadku jądro zarządzania wątkami nie jest świadome istnienia wątków. Biblioteka wątków zawiera kod do tworzenia i niszczenia wątków, przekazywania komunikatów i danych między wątkami, planowania wykonywania wątków oraz zapisywania i przywracania kontekstów wątków. Aplikacja rozpoczyna się od pojedynczego wątku.

Przykłady wątków na poziomie użytkownika to -

- Wątki Java

- Wątki POSIX

Zalety wątków na poziomie użytkownika

Poniżej przedstawiono różne zalety wątków na poziomie użytkownika -

- Przełączanie wątków nie wymaga uprawnień trybu jądra.

- Wątek na poziomie użytkownika może działać w dowolnym systemie operacyjnym.

- Planowanie może być specyficzne dla aplikacji w wątku na poziomie użytkownika.

- Wątki na poziomie użytkownika są szybkie w tworzeniu i zarządzaniu.

Wady wątków na poziomie użytkownika

Poniżej przedstawiono różne wady wątków na poziomie użytkownika -

- W typowym systemie operacyjnym większość wywołań systemowych jest blokowana.

- Aplikacja wielowątkowa nie może korzystać z wieloprocesowości.

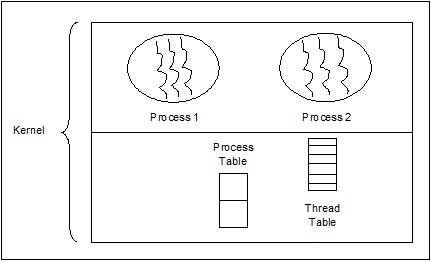

Wątki na poziomie jądra

Wątki zarządzane przez system operacyjny działają na jądro, które jest rdzeniem systemu operacyjnego.

W tym przypadku jądro zarządza wątkami. W obszarze aplikacji nie ma kodu zarządzania wątkami. Wątki jądra są obsługiwane bezpośrednio przez system operacyjny. Każda aplikacja może zostać zaprogramowana jako wielowątkowa. Wszystkie wątki w aplikacji są obsługiwane w ramach jednego procesu.

Jądro przechowuje informacje kontekstowe dla całego procesu i dla poszczególnych wątków w procesie. Planowanie przez jądro odbywa się na zasadzie wątku. Kernel wykonuje tworzenie wątków, planowanie i zarządzanie w przestrzeni jądra. Wątki jądra są generalnie wolniejsze do tworzenia i zarządzania niż wątki użytkownika. Przykładami wątków na poziomie jądra są Windows, Solaris.

Zalety wątków na poziomie jądra

Poniżej przedstawiono różne zalety wątków na poziomie jądra -

Kernel może jednocześnie zaplanować wiele wątków z tego samego procesu w wielu procesach.

Jeśli jeden wątek procesu jest zablokowany, jądro może zaplanować inny wątek tego samego procesu.

Same procedury jądra mogą być wielowątkowe.

Wady wątków na poziomie jądra

Wątki jądra są generalnie wolniejsze do tworzenia i zarządzania niż wątki użytkownika.

Przeniesienie kontroli z jednego wątku do drugiego w ramach tego samego procesu wymaga przełączenia trybu na jądro.

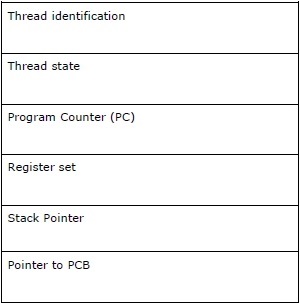

Blok kontroli wątku - TCB

Blok kontroli wątków (TCB) można zdefiniować jako strukturę danych w jądrze systemu operacyjnego, która zawiera głównie informacje o wątku. Informacje specyficzne dla wątku przechowywane w TCB mogą uwydatnić kilka ważnych informacji o każdym procesie.

Rozważ następujące punkty związane z wątkami zawartymi w TCB -

Thread identification - Jest to unikalny identyfikator wątku (tid) przypisywany do każdego nowego wątku.

Thread state - Zawiera informacje związane ze stanem (uruchomiony, działający, niedziałający, martwy) wątku.

Program Counter (PC) - Wskazuje na aktualną instrukcję programu wątku.

Register set - Zawiera wartości rejestrów wątku przypisane im do obliczeń.

Stack Pointer- Wskazuje na stos wątku w procesie. Zawiera zmienne lokalne w zakresie wątku.

Pointer to PCB - Zawiera wskaźnik do procesu, który utworzył ten wątek.

Relacja między procesem a wątkiem

W wielowątkowości proces i wątek to dwa bardzo ściśle powiązane terminy, których celem jest umożliwienie komputerowi wykonywania więcej niż jednej rzeczy naraz. Proces może zawierać jeden lub więcej wątków, ale wręcz przeciwnie, wątek nie może zawierać procesu. Jednak obie pozostają dwiema podstawowymi jednostkami egzekucyjnymi. Program wykonujący serię instrukcji inicjuje proces i wątkuje oba.

Poniższa tabela przedstawia porównanie procesu i wątku -

| Proces | Wątek |

|---|---|

| Proces jest ciężki lub wymaga dużej ilości zasobów. | Wątek jest lekki, co wymaga mniej zasobów niż proces. |

| Przełączanie procesów wymaga interakcji z systemem operacyjnym. | Przełączanie wątków nie wymaga interakcji z systemem operacyjnym. |

| W wielu środowiskach przetwarzania każdy proces wykonuje ten sam kod, ale ma własną pamięć i zasoby plikowe. | Wszystkie wątki mogą współdzielić ten sam zestaw otwartych plików, procesów potomnych. |

| Jeśli jeden proces jest zablokowany, żaden inny proces nie może zostać wykonany, dopóki pierwszy proces nie zostanie odblokowany. | Podczas gdy jeden wątek jest zablokowany i czeka, można uruchomić drugi wątek w tym samym zadaniu. |

| Wiele procesów bez użycia wątków zużywa więcej zasobów. | Wiele procesów wielowątkowych zużywa mniej zasobów. |

| W przypadku wielu procesów każdy proces działa niezależnie od innych. | Jeden wątek może czytać, zapisywać lub zmieniać dane innego wątku. |

| Jeśli nastąpiłaby jakakolwiek zmiana w procesie nadrzędnym, nie ma to wpływu na procesy potomne. | Jeśli nastąpiłaby jakakolwiek zmiana w głównym wątku, może to wpłynąć na zachowanie innych wątków tego procesu. |

| Aby komunikować się z procesami rodzeństwa, procesy muszą wykorzystywać komunikację międzyprocesową. | Wątki mogą bezpośrednio komunikować się z innymi wątkami tego procesu. |

Koncepcja wielowątkowości

Jak omówiliśmy wcześniej, wielowątkowość to zdolność procesora do zarządzania wykorzystaniem systemu operacyjnego poprzez jednoczesne wykonywanie wielu wątków. Główną ideą wielowątkowości jest osiągnięcie równoległości poprzez podzielenie procesu na wiele wątków. Mówiąc prościej, możemy powiedzieć, że wielowątkowość to sposób na osiągnięcie wielozadaniowości przy użyciu pojęcia wątków.

Pojęcie wielowątkowości można zrozumieć na poniższym przykładzie.

Przykład

Załóżmy, że uruchamiamy proces. Proces może polegać na otwarciu słowa MS na napisanie czegoś. W takim procesie jeden wątek zostanie przypisany do otwartego słowa MS, a inny wątek będzie musiał pisać. Teraz załóżmy, że jeśli chcemy coś edytować, to do wykonania zadania edycji będzie potrzebny inny wątek i tak dalej.

Poniższy diagram pomaga nam zrozumieć, jak wiele wątków istnieje w pamięci -

Na powyższym diagramie widać, że w jednym procesie może istnieć więcej niż jeden wątek, w którym każdy wątek zawiera własny zestaw rejestrów i zmienne lokalne. Poza tym wszystkie wątki w procesie mają wspólne zmienne globalne.

Zalety wielowątkowości

Przyjrzyjmy się teraz kilku zaletom wielowątkowości. Zalety są następujące -

Speed of communication - Wielowątkowość poprawia szybkość obliczeń, ponieważ każdy rdzeń lub procesor obsługuje jednocześnie oddzielne wątki.

Program remains responsive - Umożliwia programowi pozostanie responsywnym, ponieważ jeden wątek czeka na dane wejściowe, a inny jednocześnie uruchamia GUI.

Access to global variables - W przypadku wielowątkowości wszystkie wątki danego procesu mają dostęp do zmiennych globalnych, a jeśli nastąpi jakakolwiek zmiana w zmiennej globalnej, będzie ona widoczna również dla innych wątków.

Utilization of resources - Uruchomienie kilku wątków w każdym programie powoduje lepsze wykorzystanie procesora, a czas bezczynności procesora zmniejsza się.

Sharing of data - Nie jest wymagane dodatkowe miejsce na każdy wątek, ponieważ wątki w programie mogą współużytkować te same dane.

Wady wielowątkowości

Przyjrzyjmy się teraz kilku wadom wielowątkowości. Wady są następujące -

Not suitable for single processor system - Wielowątkowość sprawia, że trudno jest osiągnąć wydajność w zakresie szybkości obliczeń w systemie jednoprocesorowym w porównaniu z wydajnością w systemie wieloprocesorowym.

Issue of security - Ponieważ wiemy, że wszystkie wątki w programie współużytkują te same dane, stąd zawsze istnieje kwestia bezpieczeństwa, ponieważ każdy nieznany wątek może zmienić dane.

Increase in complexity - Wielowątkowość może zwiększyć złożoność programu, a debugowanie staje się trudne.

Lead to deadlock state - Wielowątkowość może prowadzić do potencjalnego ryzyka osiągnięcia stanu zakleszczenia przez program.

Synchronization required- Synchronizacja jest wymagana, aby uniknąć wzajemnego wykluczenia. Prowadzi to do większego wykorzystania pamięci i procesora.

W tym rozdziale dowiemy się, jak zaimplementować wątki w Pythonie.

Moduł Pythona do implementacji wątków

Wątki Pythona są czasami nazywane lekkimi procesami, ponieważ wątki zajmują znacznie mniej pamięci niż procesy. Wątki pozwalają na wykonywanie wielu zadań jednocześnie. W Pythonie mamy dwa następujące moduły, które implementują wątki w programie -

<_thread>module

<threading>module

Główna różnica między tymi dwoma modułami polega na tym <_thread> moduł traktuje wątek jako funkcję, podczas gdy <threading>moduł traktuje każdy wątek jako obiekt i implementuje go w sposób obiektowy. Ponadto<_thread>Moduł jest skuteczny w wątkach niskiego poziomu i ma mniej możliwości niż <threading> moduł.

Moduł <_thread>

We wcześniejszej wersji Pythona mieliśmy rozszerzenie <thread>moduł, ale od dłuższego czasu był uważany za „przestarzały”. Zachęcamy użytkowników do korzystania z<threading>moduł zamiast. Dlatego w Pythonie 3 moduł „wątek” nie jest już dostępny. Nazwa została zmieniona na „<_thread>"dla wstecznej niezgodności w Pythonie3.

Aby wygenerować nowy wątek za pomocą <_thread> musimy wywołać moduł start_new_threadmetoda. Działanie tej metody można zrozumieć za pomocą następującej składni -

_thread.start_new_thread ( function, args[, kwargs] )Tutaj -

args jest krotką argumentów

kwargs jest opcjonalnym słownikiem argumentów słów kluczowych

Jeśli chcemy wywołać funkcję bez przekazywania argumentu, musimy użyć pustej krotki argumentów w args.

To wywołanie metody zwraca natychmiast, uruchamia się wątek potomny i wywołuje funkcję z przekazaną listą argumentów, jeśli istnieje. Wątek kończy się jako i kiedy funkcja zwraca.

Przykład

Poniżej znajduje się przykład generowania nowego wątku przy użyciu <_thread>moduł. Używamy tutaj metody start_new_thread ().

import _thread

import time

def print_time( threadName, delay):

count = 0

while count < 5:

time.sleep(delay)

count += 1

print ("%s: %s" % ( threadName, time.ctime(time.time()) ))

try:

_thread.start_new_thread( print_time, ("Thread-1", 2, ) )

_thread.start_new_thread( print_time, ("Thread-2", 4, ) )

except:

print ("Error: unable to start thread")

while 1:

passWynik

Poniższe dane wyjściowe pomogą nam zrozumieć generowanie nowych wątków bz pomocą <_thread> moduł.

Thread-1: Mon Apr 23 10:03:33 2018

Thread-2: Mon Apr 23 10:03:35 2018

Thread-1: Mon Apr 23 10:03:35 2018

Thread-1: Mon Apr 23 10:03:37 2018

Thread-2: Mon Apr 23 10:03:39 2018

Thread-1: Mon Apr 23 10:03:39 2018

Thread-1: Mon Apr 23 10:03:41 2018

Thread-2: Mon Apr 23 10:03:43 2018

Thread-2: Mon Apr 23 10:03:47 2018

Thread-2: Mon Apr 23 10:03:51 2018moduł <threading>

Plik <threading>moduł implementuje się w sposób obiektowy i traktuje każdy wątek jako obiekt. W związku z tym zapewnia znacznie wydajniejszą obsługę wysokiego poziomu dla wątków niż moduł <_thread>. Ten moduł jest zawarty w Pythonie 2.4.

Dodatkowe metody w module <threading>

Plik <threading> moduł zawiera wszystkie metody <_thread>moduł, ale zapewnia również dodatkowe metody. Dodatkowe metody są następujące -

threading.activeCount() - Ta metoda zwraca liczbę aktywnych obiektów wątku

threading.currentThread() - Ta metoda zwraca liczbę obiektów wątku w kontrolce wątku wywołującego.

threading.enumerate() - Ta metoda zwraca listę wszystkich aktualnie aktywnych obiektów wątku.

run() - Metoda run () jest punktem wejścia dla wątku.

start() - Metoda start () uruchamia wątek przez wywołanie metody run.

join([time]) - Join () czeka na zakończenie wątków.

isAlive() - Metoda isAlive () sprawdza, czy wątek nadal jest wykonywany.

getName() - Metoda getName () zwraca nazwę wątku.

setName() - Metoda setName () ustawia nazwę wątku.

Do implementacji wątków <threading> moduł ma Thread klasa, która udostępnia następujące metody -

Jak tworzyć wątki za pomocą modułu <threading>?

W tej sekcji dowiemy się, jak tworzyć wątki za pomocą <threading>moduł. Wykonaj poniższe czynności, aby utworzyć nowy wątek za pomocą modułu <threading> -

Step 1 - W tym kroku musimy zdefiniować nową podklasę klasy Thread klasa.

Step 2 - Następnie, aby dodać dodatkowe argumenty, musimy zastąpić __init__(self [,args]) metoda.

Step 3 - W tym kroku musimy nadpisać metodę run (self [, args]), aby zaimplementować to, co wątek powinien zrobić po uruchomieniu.

Teraz, po utworzeniu nowego Thread podklasy, możemy utworzyć jej instancję, a następnie rozpocząć nowy wątek, wywołując plik start(), co z kolei wywołuje run() metoda.

Przykład

Rozważ ten przykład, aby dowiedzieć się, jak wygenerować nowy wątek przy użyciu <threading> moduł.

import threading

import time

exitFlag = 0

class myThread (threading.Thread):

def __init__(self, threadID, name, counter):

threading.Thread.__init__(self)

self.threadID = threadID

self.name = name

self.counter = counter

def run(self):

print ("Starting " + self.name)

print_time(self.name, self.counter, 5)

print ("Exiting " + self.name)

def print_time(threadName, delay, counter):

while counter:

if exitFlag:

threadName.exit()

time.sleep(delay)

print ("%s: %s" % (threadName, time.ctime(time.time())))

counter -= 1

thread1 = myThread(1, "Thread-1", 1)

thread2 = myThread(2, "Thread-2", 2)

thread1.start()

thread2.start()

thread1.join()

thread2.join()

print ("Exiting Main Thread")

Starting Thread-1

Starting Thread-2Wynik

Rozważmy teraz następujący wynik -

Thread-1: Mon Apr 23 10:52:09 2018

Thread-1: Mon Apr 23 10:52:10 2018

Thread-2: Mon Apr 23 10:52:10 2018

Thread-1: Mon Apr 23 10:52:11 2018

Thread-1: Mon Apr 23 10:52:12 2018

Thread-2: Mon Apr 23 10:52:12 2018

Thread-1: Mon Apr 23 10:52:13 2018

Exiting Thread-1

Thread-2: Mon Apr 23 10:52:14 2018

Thread-2: Mon Apr 23 10:52:16 2018

Thread-2: Mon Apr 23 10:52:18 2018

Exiting Thread-2

Exiting Main ThreadProgram w Pythonie dla różnych stanów wątków

Istnieje pięć stanów wątku - nowy, gotowy do uruchomienia, uruchomiony, oczekujący i martwy. Spośród tych pięciu Z tych pięciu skupimy się głównie na trzech stanach - biegnących, oczekujących i martwych. Wątek pobiera swoje zasoby w stanie uruchomionym, czeka na zasoby w stanie oczekiwania; ostateczne wydanie zasobu, jeżeli wykonywane i nabyte jest w stanie martwym.

Poniższy program w Pythonie za pomocą metod start (), sleep () i join () pokaże, w jaki sposób wątek wszedł odpowiednio w stan pracy, oczekiwania i stanu martwego.

Step 1 - Zaimportuj niezbędne moduły, <wątek> i <czas>

import threading

import timeStep 2 - Zdefiniuj funkcję, która zostanie wywołana podczas tworzenia wątku.

def thread_states():

print("Thread entered in running state")Step 3 - Używamy metody sleep () modułu czasu, aby nasz wątek czekał powiedzmy 2 sekundy.

time.sleep(2)Step 4 - Teraz tworzymy wątek o nazwie T1, który przyjmuje argument funkcji zdefiniowanej powyżej.

T1 = threading.Thread(target=thread_states)Step 5- Teraz za pomocą funkcji start () możemy uruchomić nasz wątek. Wyprodukuje komunikat, który został przez nas ustawiony podczas definiowania funkcji.

T1.start()

Thread entered in running stateStep 6 - Teraz w końcu możemy zabić wątek metodą join () po zakończeniu jej wykonywania.

T1.join()Uruchamianie wątku w Pythonie

W pythonie możemy rozpocząć nowy wątek na różne sposoby, ale najłatwiejszym z nich jest zdefiniowanie go jako pojedynczej funkcji. Po zdefiniowaniu funkcji możemy przekazać to jako cel dla nowegothreading.Threadobiekt i tak dalej. Wykonaj następujący kod w języku Python, aby zrozumieć, jak działa funkcja -

import threading

import time

import random

def Thread_execution(i):

print("Execution of Thread {} started\n".format(i))

sleepTime = random.randint(1,4)

time.sleep(sleepTime)

print("Execution of Thread {} finished".format(i))

for i in range(4):

thread = threading.Thread(target=Thread_execution, args=(i,))

thread.start()

print("Active Threads:" , threading.enumerate())Wynik

Execution of Thread 0 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>]

Execution of Thread 1 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>,

<Thread(Thread-3577, started 3080)>]

Execution of Thread 2 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>,

<Thread(Thread-3577, started 3080)>,

<Thread(Thread-3578, started 2268)>]

Execution of Thread 3 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>,

<Thread(Thread-3577, started 3080)>,

<Thread(Thread-3578, started 2268)>,

<Thread(Thread-3579, started 4520)>]

Execution of Thread 0 finished

Execution of Thread 1 finished

Execution of Thread 2 finished

Execution of Thread 3 finishedWątki demona w Pythonie

Przed zaimplementowaniem wątków demonów w Pythonie musimy wiedzieć o wątkach demonów i ich zastosowaniu. Jeśli chodzi o przetwarzanie danych, demon jest procesem w tle, który obsługuje żądania różnych usług, takich jak wysyłanie danych, przesyłanie plików itp. Byłby uśpiony, gdyby nie był już potrzebny. To samo zadanie można wykonać również z pomocą wątków innych niż demonowe. Jednak w tym przypadku główny wątek musi ręcznie śledzić wątki niebędące demonami. Z drugiej strony, jeśli używamy wątków demonów, główny wątek może o tym całkowicie zapomnieć i zostanie zabity, gdy główny wątek zostanie zamknięty. Inną ważną kwestią dotyczącą wątków demonów jest to, że możemy zdecydować się na użycie ich tylko do nieistotnych zadań, które nie wpłyną na nas, jeśli nie zostaną ukończone lub zostaną zabite w międzyczasie. Poniżej znajduje się implementacja wątków demona w Pythonie -

import threading

import time

def nondaemonThread():

print("starting my thread")

time.sleep(8)

print("ending my thread")

def daemonThread():

while True:

print("Hello")

time.sleep(2)

if __name__ == '__main__':

nondaemonThread = threading.Thread(target = nondaemonThread)

daemonThread = threading.Thread(target = daemonThread)

daemonThread.setDaemon(True)

daemonThread.start()

nondaemonThread.start()W powyższym kodzie są dwie funkcje, a mianowicie >nondaemonThread() i >daemonThread(). Pierwsza funkcja drukuje swój stan i usypia po 8 sekundach, podczas gdy funkcja deamonThread () drukuje Hello po każdych 2 sekundach przez czas nieokreślony. Możemy zrozumieć różnicę między wątkami nondaemon i daemon za pomocą następujących danych wyjściowych -

Hello

starting my thread

Hello

Hello

Hello

Hello

ending my thread

Hello

Hello

Hello

Hello

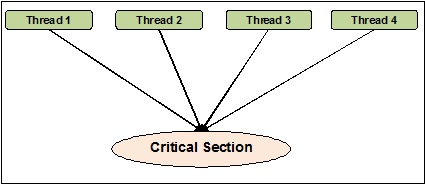

HelloSynchronizację wątków można zdefiniować jako metodę, za pomocą której możemy być pewni, że dwa lub więcej współbieżnych wątków nie uzyskuje jednocześnie dostępu do segmentu programu znanego jako sekcja krytyczna. Z drugiej strony, jak wiemy, ta sekcja krytyczna to część programu, w której uzyskuje się dostęp do współdzielonego zasobu. Dlatego możemy powiedzieć, że synchronizacja jest procesem zapewniającym, że dwa lub więcej wątków nie będzie ze sobą współpracować, uzyskując dostęp do zasobów w tym samym czasie. Poniższy diagram pokazuje, że cztery wątki próbują uzyskać dostęp do krytycznej sekcji programu w tym samym czasie.

Aby było jaśniej, załóżmy, że dwa lub więcej wątków próbuje jednocześnie dodać obiekt do listy. Ta czynność nie może doprowadzić do pomyślnego zakończenia, ponieważ spowoduje usunięcie jednego lub wszystkich obiektów lub całkowicie zepsuje stan listy. Tutaj rola synchronizacji polega na tym, że tylko jeden wątek na raz ma dostęp do listy.

Problemy z synchronizacją wątków

Możemy napotkać problemy podczas wdrażania programowania współbieżnego lub stosowania synchronizujących elementów podstawowych. W tej sekcji omówimy dwie główne kwestie. Problemy są -

- Deadlock

- Warunki wyścigu

Warunki wyścigu

Jest to jeden z głównych problemów w programowaniu współbieżnym. Jednoczesny dostęp do współdzielonych zasobów może prowadzić do wyścigu. Stan wyścigu można zdefiniować jako wystąpienie warunku, w którym dwa lub więcej wątków mogą uzyskać dostęp do udostępnionych danych, a następnie próbować jednocześnie zmienić ich wartość. Z tego powodu wartości zmiennych mogą być nieprzewidywalne i różnić się w zależności od czasów przełączania kontekstu procesów.

Przykład

Rozważ ten przykład, aby zrozumieć pojęcie warunków wyścigu -

Step 1 - W tym kroku musimy zaimportować moduł Threading -

import threadingStep 2 - Teraz zdefiniuj zmienną globalną, powiedzmy x, wraz z jej wartością jako 0 -

x = 0Step 3 - Teraz musimy zdefiniować increment_global() funkcja, która dokona przyrostu o 1 w tej globalnej funkcji x -

def increment_global():

global x

x += 1Step 4 - W tym kroku zdefiniujemy plik taskofThread()funkcja, która wywoła funkcję Increment_global () określoną liczbę razy; dla naszego przykładu jest to 50000 razy -

def taskofThread():

for _ in range(50000):

increment_global()Step 5- Teraz zdefiniuj funkcję main (), w której tworzone są wątki t1 i t2. Oba zostaną uruchomione za pomocą funkcji start () i zaczekają, aż zakończą swoje zadanie za pomocą funkcji join ().

def main():

global x

x = 0

t1 = threading.Thread(target= taskofThread)

t2 = threading.Thread(target= taskofThread)

t1.start()

t2.start()

t1.join()

t2.join()Step 6- Teraz musimy podać zakres, dla ilu iteracji chcemy wywołać funkcję main (). Tutaj dzwonimy 5 razy.

if __name__ == "__main__":

for i in range(5):

main()

print("x = {1} after Iteration {0}".format(i,x))Na poniższym wyjściu możemy zobaczyć efekt wyścigu, ponieważ wartość x po każdej iteracji jest spodziewana jako 100000. Jednak istnieje wiele odchyleń wartości. Wynika to z równoczesnego dostępu wątków do wspólnej zmiennej globalnej x.

Wynik

x = 100000 after Iteration 0

x = 54034 after Iteration 1

x = 80230 after Iteration 2

x = 93602 after Iteration 3

x = 93289 after Iteration 4Radzenie sobie z sytuacją wyścigu za pomocą blokad

Jak widzieliśmy wpływ stanu wyścigu w powyższym programie, potrzebujemy narzędzia do synchronizacji, które poradzi sobie z sytuacją wyścigu między wieloma wątkami. W Pythonie<threading>Moduł zapewnia klasę Lock do radzenia sobie z sytuacją wyścigu. PonadtoLockclass udostępnia różne metody, za pomocą których możemy obsłużyć wyścig między wieloma wątkami. Metody opisano poniżej -

metoda nabycia ()

Ta metoda służy do pozyskiwania, czyli blokowania zamka. Blokada może być blokująca lub nieblokująca w zależności od następującej wartości true lub false -

With value set to True - Jeśli metoda acquiringu () zostanie wywołana z wartością True, która jest domyślnym argumentem, wówczas wykonanie wątku jest blokowane do momentu odblokowania blokady.

With value set to False - Jeśli metoda acquiringu () zostanie wywołana z wartością False, która nie jest argumentem domyślnym, wówczas wykonanie wątku nie jest blokowane, dopóki nie zostanie ustawione na wartość true, tj. Dopóki nie zostanie zablokowane.

release (), metoda

Ta metoda służy do zwolnienia blokady. Poniżej znajduje się kilka ważnych zadań związanych z tą metodą -

Jeśli blokada jest zablokowana, plik release()metoda odblokuje go. Jego zadaniem jest zezwolenie na działanie dokładnie jednego wątku, jeśli więcej niż jeden wątek jest zablokowany i czeka na odblokowanie blokady.

Podniesie ThreadError jeśli zamek jest już odblokowany.

Teraz możemy przepisać powyższy program z klasą lock i jej metodami, aby uniknąć sytuacji wyścigu. Musimy zdefiniować metodę taskofThread () z argumentem lock, a następnie musimy użyć metod pozyskiwania () i release () do blokowania i nieblokowania blokad, aby uniknąć sytuacji wyścigu.

Przykład

Poniżej znajduje się przykład programu w języku Python do zrozumienia koncepcji blokad do radzenia sobie z sytuacją wyścigu -

import threading

x = 0

def increment_global():

global x

x += 1

def taskofThread(lock):

for _ in range(50000):

lock.acquire()

increment_global()

lock.release()

def main():

global x

x = 0

lock = threading.Lock()

t1 = threading.Thread(target = taskofThread, args = (lock,))

t2 = threading.Thread(target = taskofThread, args = (lock,))

t1.start()

t2.start()

t1.join()

t2.join()

if __name__ == "__main__":

for i in range(5):

main()

print("x = {1} after Iteration {0}".format(i,x))Poniższy wynik pokazuje, że wpływ stanu wyścigu jest pomijany; ponieważ wartość x, po każdej & każdej iteracji, wynosi teraz 100000, co jest zgodne z oczekiwaniami tego programu.

Wynik

x = 100000 after Iteration 0

x = 100000 after Iteration 1

x = 100000 after Iteration 2

x = 100000 after Iteration 3

x = 100000 after Iteration 4Deadlocks - The Dining Philosophers problem

Impas to kłopotliwa kwestia, z którą można się spotkać podczas projektowania systemów współbieżnych. Możemy zilustrować tę kwestię za pomocą problemu filozofa jadalni w następujący sposób:

Edsger Dijkstra pierwotnie przedstawił problem filozofa kulinarnego, jedną ze słynnych ilustracji jednego z największych problemów systemu współbieżnego zwanego impasem.

W tym problemie jest pięciu znanych filozofów siedzących przy okrągłym stole i jedzących ze swoich misek. Pięciu filozofów może użyć pięciu widelców do jedzenia jedzenia. Jednak filozofowie decydują się na jednoczesne użycie dwóch widelców do jedzenia.

Otóż, są dwa główne warunki dla filozofów. Po pierwsze, każdy z filozofów może być w stanie jedzenia lub myślenia, a po drugie, musi najpierw uzyskać oba rozwidlenia, tj. Lewy i prawy. Problem pojawia się, gdy każdemu z pięciu filozofów w tym samym czasie udaje się wybrać lewą widełkę. Teraz wszyscy czekają, aż właściwy widelec będzie wolny, ale nigdy nie zrezygnują ze swojego widelca, dopóki nie zjedzą jedzenia, a właściwy widelec nigdy nie będzie dostępny. W związku z tym przy stole obiadowym nastąpiłby impas.

Impas w systemie współbieżnym

Teraz, jeśli widzimy, ten sam problem może pojawić się również w naszych współbieżnych systemach. Rozwidlenia w powyższym przykładzie byłyby zasobami systemowymi, a każdy filozof może reprezentować proces, który konkuruje o zasoby.

Rozwiązanie z programem w języku Python

Rozwiązanie tego problemu można znaleźć, dzieląc filozofów na dwa typy - greedy philosophers i generous philosophers. Głównie chciwy filozof będzie próbował chwycić lewy widelec i poczekać, aż się tam znajdzie. Następnie będzie czekał, aż pojawi się właściwy widelec, podniesie go, zje, a następnie odłoży. Z drugiej strony hojny filozof spróbuje podnieść lewy widelec, a jeśli go tam nie ma, zaczeka i spróbuje ponownie za jakiś czas. Jeśli dostaną lewy widelec, spróbują zdobyć prawy. Jeśli dostaną również odpowiedni widelec, zjedzą i zwolnią oba widelce. Jeśli jednak nie dostaną prawego widelca, zwolnią lewy.

Przykład

Poniższy program w Pythonie pomoże nam znaleźć rozwiązanie problemu filozofa kulinarnego -

import threading

import random

import time

class DiningPhilosopher(threading.Thread):

running = True

def __init__(self, xname, Leftfork, Rightfork):

threading.Thread.__init__(self)

self.name = xname

self.Leftfork = Leftfork

self.Rightfork = Rightfork

def run(self):

while(self.running):

time.sleep( random.uniform(3,13))

print ('%s is hungry.' % self.name)

self.dine()

def dine(self):

fork1, fork2 = self.Leftfork, self.Rightfork

while self.running:

fork1.acquire(True)

locked = fork2.acquire(False)

if locked: break

fork1.release()

print ('%s swaps forks' % self.name)

fork1, fork2 = fork2, fork1

else:

return

self.dining()

fork2.release()

fork1.release()

def dining(self):

print ('%s starts eating '% self.name)

time.sleep(random.uniform(1,10))

print ('%s finishes eating and now thinking.' % self.name)

def Dining_Philosophers():

forks = [threading.Lock() for n in range(5)]

philosopherNames = ('1st','2nd','3rd','4th', '5th')

philosophers= [DiningPhilosopher(philosopherNames[i], forks[i%5], forks[(i+1)%5]) \

for i in range(5)]

random.seed()

DiningPhilosopher.running = True

for p in philosophers: p.start()

time.sleep(30)

DiningPhilosopher.running = False

print (" It is finishing.")

Dining_Philosophers()Powyższy program wykorzystuje koncepcję chciwych i hojnych filozofów. Program wykorzystał również rozszerzenieacquire() i release() metody Lock klasa <threading>moduł. Możemy zobaczyć rozwiązanie na następującym wyjściu -

Wynik

4th is hungry.

4th starts eating

1st is hungry.

1st starts eating

2nd is hungry.

5th is hungry.

3rd is hungry.

1st finishes eating and now thinking.3rd swaps forks

2nd starts eating

4th finishes eating and now thinking.

3rd swaps forks5th starts eating

5th finishes eating and now thinking.

4th is hungry.

4th starts eating

2nd finishes eating and now thinking.

3rd swaps forks

1st is hungry.

1st starts eating

4th finishes eating and now thinking.

3rd starts eating

5th is hungry.

5th swaps forks

1st finishes eating and now thinking.

5th starts eating

2nd is hungry.

2nd swaps forks

4th is hungry.

5th finishes eating and now thinking.

3rd finishes eating and now thinking.

2nd starts eating 4th starts eating

It is finishing.W prawdziwym życiu, jeśli zespół ludzi pracuje nad wspólnym zadaniem, powinna istnieć między nimi komunikacja w celu prawidłowego wykonania zadania. Ta sama analogia dotyczy również wątków. W programowaniu, aby skrócić idealny czas procesora, tworzymy wiele wątków i przypisujemy różne zadania podrzędne do każdego wątku. Dlatego musi istnieć możliwość komunikacji i powinni oni współdziałać ze sobą, aby zakończyć pracę w zsynchronizowany sposób.

Rozważ następujące ważne punkty związane z komunikacją między wątkami -

No performance gain - Jeśli nie możemy osiągnąć prawidłowej komunikacji między wątkami i procesami, korzyści wydajnościowe wynikające z współbieżności i równoległości są bezużyteczne.

Accomplish task properly - Bez odpowiedniego mechanizmu komunikacji między wątkami przydzielone zadanie nie może zostać poprawnie zakończone.

More efficient than inter-process communication - Komunikacja między wątkami jest wydajniejsza i łatwiejsza w użyciu niż komunikacja między procesami, ponieważ wszystkie wątki w procesie mają tę samą przestrzeń adresową i nie muszą używać pamięci współdzielonej.

Struktury danych Python do bezpiecznej wątkowo komunikacji

W przypadku kodu wielowątkowego pojawia się problem z przekazywaniem informacji z jednego wątku do drugiego. Standardowe prymitywy komunikacyjne nie rozwiązują tego problemu. Dlatego musimy zaimplementować własny obiekt złożony, aby udostępniać obiekty między wątkami, aby komunikacja była bezpieczna dla wątków. Poniżej znajduje się kilka struktur danych, które zapewniają bezpieczną komunikację wątkowo po wprowadzeniu w nich pewnych zmian -

Zestawy

Aby używać struktury danych zestawu w sposób bezpieczny dla wątków, musimy rozszerzyć klasę zestawu, aby zaimplementować własny mechanizm blokujący.

Przykład

Oto przykład rozszerzenia klasy w Pythonie -

class extend_class(set):

def __init__(self, *args, **kwargs):

self._lock = Lock()

super(extend_class, self).__init__(*args, **kwargs)

def add(self, elem):

self._lock.acquire()

try:

super(extend_class, self).add(elem)

finally:

self._lock.release()

def delete(self, elem):

self._lock.acquire()

try:

super(extend_class, self).delete(elem)

finally:

self._lock.release()W powyższym przykładzie obiekt klasy o nazwie extend_class została zdefiniowana, która jest dalej dziedziczona z Pythona set class. Obiekt lock jest tworzony w konstruktorze tej klasy. Teraz są dwie funkcje -add() i delete(). Te funkcje są zdefiniowane i są bezpieczne dla wątków. Oboje polegają nasuper funkcjonalność klasy z jednym kluczowym wyjątkiem.

Dekorator

Jest to kolejna kluczowa metoda komunikacji bezpiecznej dla wątków, polegająca na użyciu dekoratorów.

Przykład

Rozważmy przykład Pythona, który pokazuje, jak używać dekoratorów & mminus;

def lock_decorator(method):

def new_deco_method(self, *args, **kwargs):

with self._lock:

return method(self, *args, **kwargs)

return new_deco_method

class Decorator_class(set):

def __init__(self, *args, **kwargs):

self._lock = Lock()

super(Decorator_class, self).__init__(*args, **kwargs)

@lock_decorator

def add(self, *args, **kwargs):

return super(Decorator_class, self).add(elem)

@lock_decorator

def delete(self, *args, **kwargs):

return super(Decorator_class, self).delete(elem)W powyższym przykładzie zdefiniowano metodę dekoratora o nazwie lock_decorator, która jest dalej dziedziczona z klasy metod Pythona. Następnie w konstruktorze tej klasy tworzony jest obiekt blokady. Teraz mamy dwie funkcje - add () i delete (). Te funkcje są zdefiniowane i są bezpieczne dla wątków. Oba polegają na najwyższej klasy funkcjonalności z jednym kluczowym wyjątkiem.

Listy

Struktura danych listy jest bezpieczna dla wątków, szybka i łatwa do tymczasowego przechowywania w pamięci. W Cpython GIL chroni przed jednoczesnym dostępem do nich. Jak dowiedzieliśmy się, że listy są bezpieczne dla wątków, ale co z zawartymi w nich danymi. W rzeczywistości dane listy nie są chronione. Na przykład,L.append(x)nie gwarantuje zwrócenia oczekiwanego wyniku, jeśli inny wątek próbuje zrobić to samo. To dlatego, że chociażappend() jest operacją niepodzielną i bezpieczną dla wątków, ale drugi wątek próbuje jednocześnie modyfikować dane listy, dlatego na wyjściu widać skutki uboczne warunków wyścigu.

Aby rozwiązać tego rodzaju problem i bezpiecznie zmodyfikować dane, musimy zaimplementować odpowiedni mechanizm blokujący, który dodatkowo gwarantuje, że wiele wątków nie może potencjalnie znaleźć się w warunkach wyścigu. Aby zaimplementować odpowiedni mechanizm blokujący, możemy rozszerzyć klasę, tak jak to zrobiliśmy w poprzednich przykładach.

Niektóre inne niepodzielne operacje na listach są następujące -

L.append(x)

L1.extend(L2)

x = L[i]

x = L.pop()

L1[i:j] = L2

L.sort()

x = y

x.field = y

D[x] = y

D1.update(D2)

D.keys()Tutaj -

- L, L1, L2 to listy

- D, D1, D2 to dykty

- x, y to obiekty

- i, j są ints

Kolejki

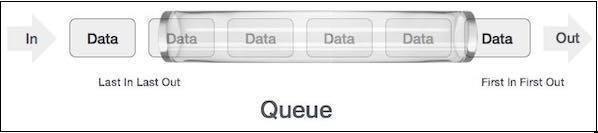

Jeśli dane listy nie są chronione, możemy ponieść konsekwencje. Możemy otrzymać lub usunąć błędne dane dotyczące warunków wyścigu. Dlatego zaleca się stosowanie struktury danych kolejki. Rzeczywistym przykładem kolejki może być jednopasmowa droga jednokierunkowa, na której pojazd wjeżdża pierwszy, zjeżdża jako pierwszy. Więcej rzeczywistych przykładów można zobaczyć w kolejkach przy kasach biletowych i na przystankach autobusowych.

Kolejki są domyślnie bezpieczną wątkowo strukturą danych i nie musimy się martwić o implementację złożonego mechanizmu blokowania. Python zapewnia nam

Rodzaje kolejek

W tej sekcji omówimy różne typy kolejek. Python udostępnia trzy opcje kolejek do użycia z<queue> moduł -

- Normalne kolejki (FIFO, pierwsze weszło, pierwsze wyszło)

- LIFO, Last in First Out

- Priority

Dowiemy się o różnych kolejkach w kolejnych sekcjach.

Normalne kolejki (FIFO, pierwsze weszło, pierwsze wyszło)

Jest to najczęściej używana implementacja kolejki oferowana przez Pythona. W tym mechanizmie kolejkowania ten, kto będzie pierwszy, otrzyma usługę jako pierwszy. FIFO jest również nazywane normalnymi kolejkami. Kolejki FIFO można przedstawić w następujący sposób -

Implementacja kolejki FIFO w języku Python

W Pythonie kolejkę FIFO można zaimplementować zarówno z pojedynczym wątkiem, jak iz wielowątkowością.

Kolejka FIFO z pojedynczym wątkiem

Aby zaimplementować kolejkę FIFO z pojedynczym wątkiem, plik Queueclass zaimplementuje podstawowy kontener „pierwszy na wejściu, pierwszy na wyjściu”. Elementy zostaną dodane do jednego „końca” sekwencji za pomocąput()i usunięte z drugiego końca za pomocą get().

Przykład

Poniżej znajduje się program w Pythonie do implementacji kolejki FIFO z pojedynczym wątkiem -

import queue

q = queue.Queue()

for i in range(8):

q.put("item-" + str(i))

while not q.empty():

print (q.get(), end = " ")Wynik

item-0 item-1 item-2 item-3 item-4 item-5 item-6 item-7Dane wyjściowe pokazują, że powyższy program używa pojedynczego wątku do zilustrowania, że elementy są usuwane z kolejki w tej samej kolejności, w jakiej są wstawiane.

Kolejka FIFO z wieloma wątkami

Aby zaimplementować FIFO z wieloma wątkami, musimy zdefiniować funkcję myqueue (), która jest rozszerzana z modułu queue. Działanie metod get () i put () jest takie samo, jak omówiono powyżej przy implementacji kolejki FIFO z pojedynczym wątkiem. Następnie, aby był wielowątkowy, musimy zadeklarować i utworzyć instancję wątków. Wątki te będą zużywać kolejkę w sposób FIFO.

Przykład

Poniżej znajduje się program w Pythonie do implementacji kolejki FIFO z wieloma wątkami

import threading

import queue

import random

import time

def myqueue(queue):

while not queue.empty():

item = queue.get()

if item is None:

break

print("{} removed {} from the queue".format(threading.current_thread(), item))

queue.task_done()

time.sleep(2)

q = queue.Queue()

for i in range(5):

q.put(i)

threads = []

for i in range(4):

thread = threading.Thread(target=myqueue, args=(q,))

thread.start()

threads.append(thread)

for thread in threads:

thread.join()Wynik

<Thread(Thread-3654, started 5044)> removed 0 from the queue

<Thread(Thread-3655, started 3144)> removed 1 from the queue

<Thread(Thread-3656, started 6996)> removed 2 from the queue

<Thread(Thread-3657, started 2672)> removed 3 from the queue

<Thread(Thread-3654, started 5044)> removed 4 from the queueLIFO, kolejka Last in First Out

Ta kolejka używa zupełnie odwrotnej analogii niż kolejki FIFO (First in First Out). W tym mechanizmie kolejkowania ten, kto jest ostatni, otrzyma usługę jako pierwszy. Jest to podobne do implementacji struktury danych stosu. Kolejki LIFO okazują się przydatne podczas implementacji wyszukiwania w głąb, takich jak algorytmy sztucznej inteligencji.

Implementacja kolejki LIFO w Pythonie

W Pythonie kolejkę LIFO można zaimplementować zarówno z pojedynczym wątkiem, jak iz wielowątkowością.

Kolejka LIFO z pojedynczym wątkiem

Aby zaimplementować kolejkę LIFO z pojedynczym wątkiem, plik Queue class zaimplementuje podstawowy kontener „ostatni na wejściu, pierwszy na wyjściu” przy użyciu struktury Queue.LifoQueue. Teraz dzwonięput(), elementy są dodawane w głowicy pojemnika i usuwane z głowicy również podczas używania get().

Przykład

Poniżej znajduje się program w Pythonie do implementacji kolejki LIFO z pojedynczym wątkiem -

import queue

q = queue.LifoQueue()

for i in range(8):

q.put("item-" + str(i))

while not q.empty():

print (q.get(), end=" ")

Output:

item-7 item-6 item-5 item-4 item-3 item-2 item-1 item-0Dane wyjściowe pokazują, że powyższy program używa pojedynczego wątku do zilustrowania, że elementy są usuwane z kolejki w odwrotnej kolejności, w jakiej są wstawiane.

Kolejka LIFO z wieloma wątkami

Implementacja jest podobna do implementacji kolejek FIFO z wieloma wątkami. Jedyna różnica polega na tym, że musimy użyć rozszerzeniaQueue klasa, która zaimplementuje podstawowy kontener „ostatni na wejściu, pierwszy na wyjściu” przy użyciu struktury Queue.LifoQueue.

Przykład

Poniżej znajduje się program w Pythonie do implementacji kolejki LIFO z wieloma wątkami -

import threading

import queue

import random

import time

def myqueue(queue):

while not queue.empty():

item = queue.get()

if item is None:

break

print("{} removed {} from the queue".format(threading.current_thread(), item))

queue.task_done()

time.sleep(2)

q = queue.LifoQueue()

for i in range(5):

q.put(i)

threads = []

for i in range(4):

thread = threading.Thread(target=myqueue, args=(q,))

thread.start()

threads.append(thread)

for thread in threads:

thread.join()Wynik

<Thread(Thread-3882, started 4928)> removed 4 from the queue

<Thread(Thread-3883, started 4364)> removed 3 from the queue

<Thread(Thread-3884, started 6908)> removed 2 from the queue

<Thread(Thread-3885, started 3584)> removed 1 from the queue

<Thread(Thread-3882, started 4928)> removed 0 from the queueKolejka priorytetowa

W kolejkach FIFO i LIFO kolejność pozycji jest powiązana z kolejnością wstawiania. Jednak w wielu przypadkach priorytet jest ważniejszy niż kolejność wstawiania. Rozważmy przykład z prawdziwego świata. Załóżmy, że ochrona na lotnisku sprawdza osoby należące do różnych kategorii. Osoby z VVIP, personel linii lotniczych, urzędnik celny, kategorie mogą być sprawdzane na zasadzie pierwszeństwa zamiast sprawdzania na podstawie przylotu, tak jak w przypadku zwykłych ludzi.

Innym ważnym aspektem, który należy wziąć pod uwagę w przypadku kolejki priorytetowej, jest sposób opracowania harmonogramu zadań. Jednym z typowych projektów jest obsługa większości zadań agenta na podstawie priorytetów w kolejce. Ta struktura danych może służyć do pobierania elementów z kolejki na podstawie ich wartości priorytetu.

Implementacja kolejki priorytetów w Pythonie

W Pythonie kolejka priorytetowa może być implementowana zarówno z pojedynczym wątkiem, jak i wielowątkowością.

Kolejka priorytetowa z jednym wątkiem

Aby zaimplementować kolejkę priorytetową z pojedynczym wątkiem, plik Queue class zaimplementuje zadanie na kontenerze priorytetowym przy użyciu struktury Queue.Kolejka priorytetowa. Teraz dzwonięput(), elementy są dodawane z wartością, przy której najniższa wartość będzie miała najwyższy priorytet, a zatem zostanie pobrana jako pierwsza przy użyciu get().

Przykład

Rozważmy następujący program w Pythonie do implementacji kolejki Priority z pojedynczym wątkiem -

import queue as Q

p_queue = Q.PriorityQueue()

p_queue.put((2, 'Urgent'))

p_queue.put((1, 'Most Urgent'))

p_queue.put((10, 'Nothing important'))

prio_queue.put((5, 'Important'))

while not p_queue.empty():

item = p_queue.get()

print('%s - %s' % item)Wynik

1 – Most Urgent

2 - Urgent

5 - Important

10 – Nothing importantNa powyższym wyjściu widzimy, że kolejka przechowała pozycje w oparciu o priorytet - wartość bez priorytetu ma wysoki priorytet.

Kolejka priorytetowa z wieloma wątkami

Implementacja jest podobna do implementacji kolejek FIFO i LIFO z wieloma wątkami. Jedyna różnica polega na tym, że musimy użyć rozszerzeniaQueue klasa do inicjowania priorytetu przy użyciu struktury Queue.PriorityQueue. Inna różnica dotyczy sposobu generowania kolejki. W poniższym przykładzie zostanie wygenerowany z dwoma identycznymi zestawami danych.

Przykład

Poniższy program w Pythonie pomaga w implementacji kolejki priorytetowej z wieloma wątkami -

import threading

import queue

import random

import time

def myqueue(queue):

while not queue.empty():

item = queue.get()

if item is None:

break

print("{} removed {} from the queue".format(threading.current_thread(), item))

queue.task_done()

time.sleep(1)

q = queue.PriorityQueue()

for i in range(5):

q.put(i,1)

for i in range(5):

q.put(i,1)

threads = []

for i in range(2):

thread = threading.Thread(target=myqueue, args=(q,))

thread.start()

threads.append(thread)

for thread in threads:

thread.join()Wynik

<Thread(Thread-4939, started 2420)> removed 0 from the queue

<Thread(Thread-4940, started 3284)> removed 0 from the queue

<Thread(Thread-4939, started 2420)> removed 1 from the queue

<Thread(Thread-4940, started 3284)> removed 1 from the queue

<Thread(Thread-4939, started 2420)> removed 2 from the queue

<Thread(Thread-4940, started 3284)> removed 2 from the queue

<Thread(Thread-4939, started 2420)> removed 3 from the queue

<Thread(Thread-4940, started 3284)> removed 3 from the queue

<Thread(Thread-4939, started 2420)> removed 4 from the queue

<Thread(Thread-4940, started 3284)> removed 4 from the queueW tym rozdziale dowiemy się o testowaniu aplikacji wątkowych. Dowiemy się również, jak ważne jest testowanie.

Dlaczego testować?

Zanim przejdziemy do dyskusji o znaczeniu testowania, musimy wiedzieć, czym jest testowanie. Ogólnie rzecz biorąc, testowanie to technika sprawdzania, jak dobrze coś działa. Z drugiej strony, szczególnie jeśli mówimy o programach komputerowych lub oprogramowaniu, testowanie jest techniką uzyskiwania dostępu do funkcjonalności programu.

W tej sekcji omówimy znaczenie testowania oprogramowania. W przypadku tworzenia oprogramowania przed wydaniem oprogramowania klientowi musi istnieć podwójna kontrola. Dlatego bardzo ważne jest testowanie oprogramowania przez doświadczony zespół testowy. Rozważ następujące punkty, aby zrozumieć znaczenie testowania oprogramowania -

Poprawa jakości oprogramowania

Z pewnością żadna firma nie chce dostarczać oprogramowania niskiej jakości i żaden klient nie chce kupować oprogramowania niskiej jakości. Testowanie poprawia jakość oprogramowania poprzez znajdowanie i naprawianie błędów.

Zadowolenie klientów

Najważniejszą częścią każdej firmy jest zadowolenie klientów. Dostarczając wolne od błędów i dobrej jakości oprogramowanie, firmy mogą osiągnąć satysfakcję klientów.

Zmniejsz wpływ nowych funkcji

Załóżmy, że stworzyliśmy system oprogramowania składający się z 10000 linii i musimy dodać nową funkcję, wtedy zespół programistów miałby obawy o wpływ tej nowej funkcji na całe oprogramowanie. Tutaj również testowanie odgrywa istotną rolę, ponieważ jeśli zespół testowy wykonał dobry zestaw testów, może to uchronić nas przed potencjalnymi katastrofalnymi przerwami.

Doświadczenie użytkownika

Kolejną najważniejszą częścią każdej firmy jest doświadczenie użytkowników tego produktu. Tylko testy mogą zapewnić, że użytkownik końcowy uzna produkt za prosty i łatwy w użyciu.

Zmniejszenie wydatków

Testowanie może obniżyć całkowity koszt oprogramowania poprzez znajdowanie i naprawianie błędów w fazie testowania jego rozwoju, zamiast naprawiania go po dostarczeniu. Jeśli po dostarczeniu oprogramowania wystąpi poważny błąd, zwiększy to jego wymierne koszty, powiedzmy w postaci wydatków i kosztów niematerialnych, np. Niezadowolenie klienta, negatywną reputację firmy itp.

Co przetestować?

Zawsze zaleca się posiadanie odpowiedniej wiedzy na temat tego, co ma być testowane. W tej sekcji najpierw zrozumiemy, jaki jest główny motyw testera podczas testowania dowolnego oprogramowania. Pokrycie kodu, tj. Ile wierszy kodu trafia w nasz zestaw testów podczas testowania, należy unikać. Dzieje się tak dlatego, że podczas testowania skupianie się tylko na liczbie wierszy kodu nie dodaje żadnej wartości do naszego systemu. Mogą pozostać pewne błędy, które będą widoczne później na późniejszym etapie, nawet po wdrożeniu.

Rozważ następujące ważne punkty związane z tym, co przetestować -

Musimy skupić się na testowaniu funkcjonalności kodu, a nie pokryciu kodu.

Najpierw musimy przetestować najważniejsze części kodu, a następnie przejść do mniej ważnych części kodu. Na pewno zaoszczędzi to czas.

Tester musi mieć wiele różnych testów, które mogą doprowadzić oprogramowanie do granic możliwości.

Podejścia do testowania współbieżnych programów

Ze względu na możliwość wykorzystania prawdziwych możliwości architektury wielordzeniowej, współbieżne systemy oprogramowania zastępują systemy sekwencyjne. W ostatnim czasie współbieżne programy systemowe są używane we wszystkim, od telefonów komórkowych po pralki, od samochodów po samoloty itp. Musimy być bardziej ostrożni podczas testowania współbieżnych programów, ponieważ jeśli dodaliśmy wiele wątków do aplikacji jednowątkowej, już błąd, wtedy mielibyśmy wiele błędów.

Techniki testowania współbieżnych programów w dużym stopniu koncentrują się na wyborze przeplotu, który ujawnia potencjalnie szkodliwe wzorce, takie jak warunki wyścigu, zakleszczenia i naruszenie atomowości. Poniżej przedstawiono dwa podejścia do testowania współbieżnych programów -

Systematyczne badanie

Podejście to ma na celu jak najszersze zbadanie przestrzeni przeplotów. Takie podejścia mogą przyjąć technikę brutalnej siły, a inne przyjmują technikę redukcji częściowego rzędu lub technikę heurystyczną do badania przestrzeni przeplotów.

Oparte na własności

Podejścia oparte na właściwościach opierają się na obserwacji, że błędy współbieżności są bardziej prawdopodobne w przypadku przeplotów, które ujawniają określone właściwości, takie jak podejrzany wzorzec dostępu do pamięci. Różne podejścia oparte na właściwościach dotyczą różnych usterek, takich jak warunki wyścigu, zakleszczenia i naruszenie atomowości, co dodatkowo zależy od jednej lub innych określonych właściwości.

Strategie testowania

Strategia testowania jest również znana jako podejście testowe. Strategia definiuje sposób przeprowadzania testów. Podejście testowe obejmuje dwie techniki -

Proaktywne

Podejście, w którym proces projektowania testów jest inicjowany tak wcześnie, jak to możliwe, aby znaleźć i naprawić usterki przed utworzeniem kompilacji.

Reaktywny

Podejście, w którym testowanie rozpoczyna się dopiero po zakończeniu procesu programowania.

Przed zastosowaniem jakiejkolwiek strategii testowej lub podejścia do programu w języku Python, musimy mieć podstawowe pojęcie o rodzaju błędów, jakie może mieć program. Błędy są następujące -

Błędy składniowe

Podczas tworzenia programu może wystąpić wiele drobnych błędów. Błędy są głównie spowodowane błędami pisarskimi. Na przykład brak dwukropka lub nieprawidłowa pisownia słowa kluczowego itp. Takie błędy wynikają z błędu w składni programu, a nie z logiki. Stąd te błędy nazywane są błędami składniowymi.

Błędy semantyczne

Błędy semantyczne nazywane są również błędami logicznymi. Jeśli w programie wystąpi błąd logiczny lub semantyczny, instrukcja skompiluje się i uruchomi poprawnie, ale nie da pożądanego wyniku, ponieważ logika nie jest poprawna.

Testów jednostkowych

Jest to jedna z najczęściej używanych strategii testowania programów w Pythonie. Ta strategia jest używana do testowania jednostek lub komponentów kodu. Przez jednostki lub komponenty rozumiemy klasy lub funkcje kodu. Testowanie jednostkowe upraszcza testowanie dużych systemów programowania poprzez testowanie „małych” jednostek. Przy pomocy powyższej koncepcji testowanie jednostkowe można zdefiniować jako metodę, w której poszczególne jednostki kodu źródłowego są testowane w celu określenia, czy zwracają pożądane wyniki.

W kolejnych sekcjach dowiemy się o różnych modułach Pythona do testowania jednostkowego.

unittest module

Pierwszym modułem do testów jednostkowych jest moduł unittest. Jest inspirowany JUnitem i domyślnie zawarty w Pythonie3.6. Obsługuje automatyzację testów, udostępnianie kodu konfiguracji i zamykania testów, agregację testów w kolekcje oraz niezależność testów od struktury raportowania.

Poniżej znajduje się kilka ważnych koncepcji obsługiwanych przez moduł unittest

Uchwyt tekstowy

Służy do skonfigurowania testu, aby można go było uruchomić przed rozpoczęciem testu i rozebrać po zakończeniu testu. Może wiązać się z utworzeniem tymczasowej bazy danych, katalogów itp. Potrzebnych przed rozpoczęciem testu.

Przypadek testowy