SAP BODS - Szybki przewodnik

Hurtownia danych jest znana jako centralne repozytorium do przechowywania danych z jednego lub wielu heterogenicznych źródeł danych. Hurtownia danych służy do raportowania i analizowania informacji i przechowuje zarówno dane historyczne, jak i bieżące. Dane w systemie DW są wykorzystywane do raportowania analitycznego, które jest później wykorzystywane przez analityków biznesowych, kierowników sprzedaży lub pracowników wiedzy do podejmowania decyzji.

Dane w systemie DW są ładowane z operacyjnego systemu transakcyjnego, takiego jak Sprzedaż, Marketing, HR, SCM itp. Mogą przejść przez operacyjny magazyn danych lub inne transformacje, zanim zostaną załadowane do systemu DW w celu przetworzenia informacji.

Hurtownia danych - kluczowe funkcje

Kluczowe cechy systemu DW to -

Jest to centralne repozytorium danych, w którym dane są przechowywane z jednego lub większej liczby heterogenicznych źródeł danych.

System DW przechowuje zarówno dane bieżące, jak i historyczne. Zwykle system DW przechowuje dane historyczne z 5-10 lat.

System DW jest zawsze oddzielony od operacyjnego systemu transakcyjnego.

Dane w systemie DW są wykorzystywane do różnych rodzajów raportów analitycznych w zakresie od kwartalnych do rocznych porównań.

Potrzeba systemu DW

Załóżmy, że masz agencję zajmującą się pożyczkami mieszkaniowymi, w której dane pochodzą z wielu aplikacji, takich jak marketing, sprzedaż, ERP, HRM, MM itp. Te dane są wyodrębniane, przekształcane i ładowane do hurtowni danych.

Na przykład, jeśli musisz porównać kwartalną / roczną sprzedaż produktu, nie możesz użyć operacyjnej transakcyjnej bazy danych, ponieważ spowoduje to zawieszenie systemu transakcyjnego. Dlatego do tego celu używana jest hurtownia danych.

Różnica między DW i ODB

Różnice między hurtownią danych a operacyjną bazą danych (transakcyjną bazą danych) są następujące:

System transakcyjny jest przeznaczony do znanych obciążeń i transakcji, takich jak aktualizowanie rekordu użytkownika, wyszukiwanie rekordu itp. Jednak transakcje hurtowni danych są bardziej złożone i mają ogólną postać danych.

System transakcyjny zawiera bieżące dane organizacji, a hurtownia danych zwykle zawiera dane historyczne.

System transakcyjny obsługuje równoległe przetwarzanie wielu transakcji. Aby zachować spójność bazy danych, wymagane są mechanizmy kontroli współbieżności i odtwarzania.

Zapytanie do operacyjnej bazy danych umożliwia odczytywanie i modyfikowanie operacji (usuwanie i aktualizowanie), podczas gdy zapytanie OLAP wymaga dostępu tylko do odczytu przechowywanych danych (instrukcja Select).

Architektura DW

Hurtownia danych obejmuje czyszczenie danych, integrację danych i konsolidację danych.

Hurtownia danych ma architekturę trójwarstwową - Data Source Layer, Integration Layer, i Presentation Layer. Powyższa ilustracja przedstawia wspólną architekturę systemu hurtowni danych.

Istnieją cztery typy systemów hurtowni danych.

- Data Mart

- Przetwarzanie analityczne online (OLAP)

- Przetwarzanie transakcyjne online (OLTP)

- Analiza predykcyjna (PA)

Data Mart

Data Mart jest znana jako najprostsza forma hurtowni danych i zwykle składa się z pojedynczego obszaru funkcjonalnego w organizacji, takiego jak sprzedaż, finanse lub marketing itp.

Data Mart w organizacji jest tworzony i zarządzany przez jeden dział. Ponieważ należy do jednego działu, zwykle pobiera dane tylko z kilku lub jednego typu źródeł / aplikacji. Źródłem tym może być wewnętrzny system operacyjny, hurtownia danych lub system zewnętrzny.

Przetwarzanie analityczne online

W systemie OLAP liczba transakcji jest mniejsza niż w systemie transakcyjnym. Wykonywane zapytania mają złożony charakter i obejmują agregacje danych.

Co to jest agregacja?

Zapisujemy tabele z zagregowanymi danymi, takimi jak roczne (1 wiersz), kwartalne (4 wiersze), miesięczne (12 wierszy) lub tak dalej, jeśli ktoś musi robić porównanie rok do roku, przetworzony zostanie tylko jeden wiersz. Jednak w niezagregowanej tabeli będzie porównywać wszystkie wiersze.

SELECT SUM(salary)

FROM employee

WHERE title = 'Programmer';Skuteczne środki w systemie OLAP

Czas odpowiedzi jest uważany za jeden z najbardziej skutecznych i kluczowych mierników w OLAPsystem. Zagregowane przechowywane dane są utrzymywane w wielowymiarowych schematach, takich jak schematy gwiaździste (gdy dane są uporządkowane w hierarchiczne grupy, często nazywane wymiarami, oraz w fakty i zagregowane fakty, nazywa się to Schematami).

Opóźnienie systemu OLAP wynosi kilka godzin w porównaniu z bazami danych, w przypadku których oczekuje się, że opóźnienie jest zbliżone do jednego dnia.

Przetwarzanie transakcji online

W systemie OLTP istnieje wiele krótkich transakcji online, takich jak INSERT, UPDATE i DELETE.

W systemie OLTP skuteczną miarą jest czas przetwarzania krótkich transakcji i jest on znacznie krótszy. Kontroluje integralność danych w środowiskach z wieloma dostępami. W przypadku systemu OLTP liczba transakcji na sekundę mierzyeffectiveness. System hurtowni danych OLTP zawiera aktualne i szczegółowe dane i jest utrzymywany w schematach w modelu encji (3NF).

Przykład

Codzienny system transakcyjny w sklepie detalicznym, w którym zapisy klientów są codziennie wprowadzane, aktualizowane i usuwane. Zapewnia bardzo szybkie przetwarzanie zapytań. Bazy danych OLTP zawierają szczegółowe i aktualne dane. Schemat używany do przechowywania bazy danych OLTP to model jednostki.

Różnice między OLTP i OLAP

Na poniższych ilustracjach przedstawiono kluczowe różnice między OLTP i OLAP system.

Indexes - System OLTP ma tylko kilka indeksów, podczas gdy w systemie OLAP istnieje wiele indeksów do optymalizacji wydajności.

Joins- W systemie OLTP duża liczba sprzężeń i danych jest znormalizowana. Jednak w systemie OLAP jest mniej połączeń i są one zdenormalizowane.

Aggregation - W systemie OLTP dane nie są agregowane, podczas gdy w bazie danych OLAP używanych jest więcej agregacji.

Analiza predykcyjna

Analiza predykcyjna jest znana jako znajdowanie ukrytych wzorców w danych przechowywanych w systemie DW przy użyciu różnych funkcji matematycznych do przewidywania przyszłych wyników.

System analizy predykcyjnej różni się od systemu OLAP sposobem jego wykorzystania. Służy do skupienia się na przyszłych wynikach. System OALP koncentruje się na przetwarzaniu danych bieżących i historycznych na potrzeby raportowania analitycznego.

Na rynku dostępne są różne systemy hurtowni danych / baz danych, które spełniają możliwości systemu DW. Najpopularniejszymi dostawcami systemów hurtowni danych są -

- Microsoft SQL Server

- Oracle Exadata

- IBM Netezza

- Teradata

- Sybase IQ

- SAP Business Warehouse (SAP BW)

SAP Business Warehouse

SAP Business Warehousejest częścią platformy wydań SAP NetWeaver. Przed wersją NetWeaver 7.4 była nazywana SAP NetWeaver Business Warehouse.

Hurtownia danych w SAP BW to integracja, transformacja, czyszczenie, przechowywanie i przemieszczanie danych. Proces DW obejmuje modelowanie danych w systemie BW, etapowanie i administrację. Głównym narzędziem służącym do zarządzania zadaniami DW w systemie BW jest pulpit administracyjny.

Kluczowe cechy

SAP BW udostępnia funkcje takie jak Business Intelligence, które obejmują usługi analityczne i planowanie biznesowe, raportowanie analityczne, przetwarzanie zapytań i informacje oraz hurtownię danych przedsiębiorstwa.

Zapewnia połączenie baz danych i narzędzi do zarządzania bazami danych, które pomagają w podejmowaniu decyzji.

Inne kluczowe cechy systemu BW obejmują Business Application Programming Interface (BAPI), który obsługuje połączenie z aplikacjami innymi niż SAP R / 3, automatyczne wyodrębnianie i ładowanie danych, zintegrowany procesor OLAP, repozytorium metadanych, narzędzia administracyjne, obsługę wielu języków i interfejs sieciowy.

SAP BW został po raz pierwszy wprowadzony w 1998 roku przez niemiecką firmę SAP. System SAP BW został oparty na podejściu opartym na modelach, aby uczynić Enterprise Data Warehouse łatwym, prostym i wydajniejszym dla danych SAP R3.

W ciągu ostatnich 16 lat SAP BW stał się jednym z kluczowych systemów dla wielu firm do zarządzania ich potrzebami w zakresie hurtowni danych.

Business Explorer (BEx) zapewnia możliwość elastycznego raportowania, analizy strategicznej i raportowania operacyjnego w firmie.

Służy do wykonywania funkcji raportowania, wykonywania zapytań i analizy w systemie BI. Możesz również przetwarzać dane bieżące i historyczne z różnym stopniem szczegółowości w Internecie iw formacie Excel.

Za pomocą BEx rozgłaszanie informacji, treści BI mogą być udostępniane za pośrednictwem poczty elektronicznej jako dokument lub w postaci linków jako dane na żywo lub też można je publikować za pomocą funkcji SAP EP.

Obiekty i produkty biznesowe

SAP Business Objects jest znane jako najpopularniejsze narzędzie Business Intelligence i służy do manipulowania danymi, dostępu użytkowników, analizowania, formatowania i publikowania informacji na różnych platformach. Jest to zestaw narzędzi oparty na interfejsie użytkownika, który umożliwia użytkownikom biznesowym i decydentom wyświetlanie, sortowanie i analizowanie aktualnych i historycznych danych biznesowych.

Obejmuje następujące narzędzia -

Web Intelligence

Web Intelligence (WebI) jest nazywany najbardziej popularnym narzędziem do szczegółowego raportowania obiektów biznesowych, które obsługuje różne funkcje analizy danych, takie jak drążenie, hierarchie, wykresy, miary obliczeniowe itp. Umożliwia użytkownikom końcowym tworzenie zapytań ad hoc w panelu zapytań i do przeprowadzania analizy danych zarówno w trybie online, jak i offline.

SAP Business Objects Xcelsius / Dashboards

Pulpity nawigacyjne zapewniają użytkownikom końcowym funkcje wizualizacji danych i tablic rozdzielczych, a za pomocą tego narzędzia można tworzyć interaktywne pulpity nawigacyjne.

Możesz także dodawać różnego rodzaju wykresy i wykresy oraz tworzyć dynamiczne pulpity nawigacyjne do wizualizacji danych, które są najczęściej używane podczas spotkań finansowych w organizacji.

Crystal Reports

Raporty Crystal Reports są używane do raportowania z dokładnością do piksela. Dzięki temu użytkownicy mogą tworzyć i projektować raporty, a następnie wykorzystywać je do celów drukowania.

poszukiwacz

Eksplorator umożliwia użytkownikowi przeszukiwanie zawartości w repozytorium BI, a najlepsze dopasowania są wyświetlane w postaci wykresów. Nie ma potrzeby zapisywania zapytań, aby przeprowadzić wyszukiwanie.

Różne inne komponenty i narzędzia wprowadzone do szczegółowego raportowania, wizualizacji danych i dashboardów to Design Studio, edycja Analysis dla Microsoft Office, repozytorium BI i platforma Business Objects Mobile.

ETL to skrót od Extract, Transform and Load. Narzędzie ETL wyodrębnia dane z różnych systemów źródłowych RDBMS, przekształca dane, np. Stosując obliczenia, konkatenację itp., A następnie ładuje dane do systemu hurtowni danych. Dane są ładowane do systemu DW w postaci tabel wymiarów i tabel faktów.

Ekstrakcja

Podczas ładowania ETL wymagany jest obszar przemieszczania. Istnieje wiele powodów, dla których wymagana jest strefa przejściowa.

Systemy źródłowe są dostępne tylko przez określony czas w celu wyodrębnienia danych. Ten okres jest krótszy niż całkowity czas ładowania danych. Dlatego obszar przemieszczania umożliwia wyodrębnianie danych z systemu źródłowego i przechowywanie ich w obszarze przemieszczania przed zakończeniem przedziału czasowego.

Obszar pomostowy jest wymagany, gdy chcesz uzyskać dane z wielu źródeł danych razem lub jeśli chcesz połączyć razem dwa lub więcej systemów. Na przykład nie będzie można wykonać zapytania SQL łączącego dwie tabele z dwóch fizycznie różnych baz danych.

Ramy czasowe pobierania danych dla różnych systemów różnią się w zależności od strefy czasowej i godzin pracy.

Dane wyodrębnione z systemów źródłowych mogą być wykorzystywane w wielu systemach hurtowni danych, magazynach danych operacyjnych itp.

ETL umożliwia wykonywanie złożonych transformacji i wymaga dodatkowego miejsca do przechowywania danych.

Przekształcać

Podczas transformacji danych na wyodrębnionych danych stosuje się zestaw funkcji w celu załadowania ich do systemu docelowego. Dane, które nie wymagają żadnej transformacji, nazywane są bezpośrednim przenoszeniem lub przekazywaniem danych.

Możesz zastosować różne transformacje do danych wyodrębnionych z systemu źródłowego. Na przykład możesz wykonać niestandardowe obliczenia. Jeśli chcesz uzyskać sumę przychodów ze sprzedaży, a nie ma jej w bazie danych, możesz zastosować rozszerzenieSUM formułę podczas transformacji i załaduj dane.

Na przykład, jeśli masz imię i nazwisko w tabeli w różnych kolumnach, możesz użyć konkatenacji przed załadowaniem.

Załaduj

Podczas fazy ładowania dane są ładowane do systemu docelowego i może to być plik płaski lub system hurtowni danych.

SAP BO Data Services to narzędzie ETL używane do integracji danych, jakości danych, profilowania danych i przetwarzania danych. Pozwala na integrację, transformację zaufanego systemu hurtowni danych na potrzeby raportowania analitycznego.

BO Data Services składa się z interfejsu programistycznego UI, repozytorium metadanych, łączności danych z systemem źródłowym i docelowym oraz konsoli zarządzania do planowania zadań.

Integracja danych i zarządzanie danymi

SAP BO Data Services to narzędzie do integracji i zarządzania danymi, które składa się z serwera zadań Data Integrator oraz narzędzia Data Integrator Designer.

Kluczowe cechy

Możesz zastosować różne transformacje danych za pomocą języka Data Integrator, aby zastosować złożone transformacje danych i budować niestandardowe funkcje.

Data Integrator Designer służy do przechowywania zadań w czasie rzeczywistym i zadań wsadowych oraz nowych projektów w repozytorium.

DI Designer zapewnia również opcję zespołowego programowania ETL, udostępniając centralne repozytorium ze wszystkimi podstawowymi funkcjami.

Serwer zadań Data Integrator jest odpowiedzialny za przetwarzanie zadań utworzonych za pomocą DI Designer.

Administrator sieci

Administrator sieciowy Data Integrator jest używany przez administratorów systemu i administratora baz danych do utrzymywania repozytoriów w usługach danych. Usługi danych obejmują repozytorium metadanych, repozytorium centralne do projektowania zespołowego, serwer zadań i usługi internetowe.

Kluczowe funkcje DI Web Administrator

- Służy do planowania, monitorowania i wykonywania zadań wsadowych.

- Służy do konfiguracji oraz uruchamiania i zatrzymywania serwerów czasu rzeczywistego.

- Służy do konfiguracji wykorzystania serwera zadań, serwera dostępu i repozytorium.

- Służy do konfigurowania adapterów.

- Służy do konfigurowania i kontrolowania wszystkich narzędzi w BO Data Services.

Funkcja zarządzania danymi kładzie nacisk na jakość danych. Obejmuje czyszczenie danych, ulepszanie i konsolidację danych w celu uzyskania poprawnych danych w systemie DW.

W tym rozdziale poznamy architekturę SAP BODS. Ilustracja przedstawia architekturę systemu BODS ze strefą pomostową.

Warstwa źródłowa

Warstwa źródłowa obejmuje różne źródła danych, takie jak aplikacje SAP i system RDBMS inny niż SAP, a integracja danych odbywa się w obszarze przejściowym.

SAP Business Objects Data Services obejmuje różne komponenty, takie jak Data Service Designer, Data Services Management Console, Repository Manager, Data Services Server Manager, Work bench, etc. Docelowym systemem może być system DW, taki jak SAP HANA, SAP BW lub inny niż SAP System hurtowni danych.

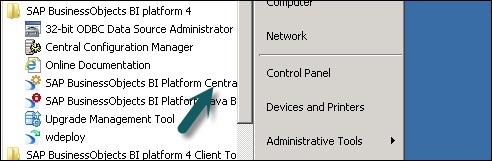

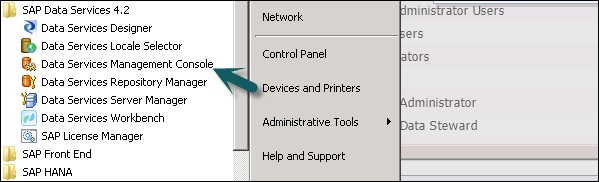

Poniższy zrzut ekranu przedstawia różne komponenty SAP BODS.

Możesz również podzielić architekturę BODS na następujące warstwy -

- Warstwa aplikacji sieci Web

- Warstwa serwera bazy danych

- Warstwa usług danych

Poniższa ilustracja przedstawia architekturę BODS.

Ewolucja produktu - ATL, DI i DQ

Acta Technology Inc. opracowała SAP Business Objects Data Services, a później firma Business Objects Company go przejęła. Acta Technology Inc. to firma z siedzibą w USA, która była odpowiedzialna za rozwój pierwszej platformy integracji danych. Dwa produkty oprogramowania ETL opracowane przez Acta Inc. toData Integration (DI) narzędzie i Data Management lub Data Quality (DQ) narzędzie.

Business Objects, francuska firma przejęła Acta Technology Inc. w 2002 roku, a później oba produkty zostały przemianowane na Business Objects Data Integration (BODI) narzędzie i Business Objects Data Quality (BODQ) narzędzie.

SAP przejął Business Objects w 2007 roku i oba produkty zostały przemianowane na SAP BODI i SAP BODQ. W 2008 r. SAP zintegrował oba produkty w jednym oprogramowaniu o nazwie SAP Business Objects Data Services (BODS).

SAP BODS zapewnia rozwiązanie do integracji danych i zarządzania danymi, a we wcześniejszej wersji BODS uwzględniono rozwiązanie do przetwarzania danych tekstowych.

BODS - Obiekty

Nazywa się wszystkie jednostki używane w BO Data Services Designer Objects. Wszystkie obiekty, takie jak projekty, zadania, metadane i funkcje systemowe są przechowywane w lokalnej bibliotece obiektów. Wszystkie obiekty mają charakter hierarchiczny.

Obiekty zawierają głównie:

Properties- Służą do opisu obiektu i nie wpływają na jego działanie. Przykład - nazwa obiektu, data jego utworzenia itp.

Options - Które kontrolują działanie obiektów.

Rodzaje obiektów

W systemie istnieją dwa typy obiektów - obiekty wielokrotnego użytku i obiekty jednorazowego użytku. Typ obiektu określa, w jaki sposób ten obiekt jest używany i pobierany.

Obiekty wielokrotnego użytku

Większość obiektów przechowywanych w repozytorium można ponownie wykorzystać. Gdy obiekt wielokrotnego użytku jest zdefiniowany i zapisany w repozytorium lokalnym, możesz ponownie użyć obiektu, tworząc wywołania do definicji. Każdy obiekt wielokrotnego użytku ma tylko jedną definicję, a wszystkie wywołania tego obiektu odwołują się do tej definicji. Teraz, jeśli definicja obiektu zostanie zmieniona w jednym miejscu, zmieniasz definicję obiektu we wszystkich miejscach, w których ten obiekt się pojawia.

Biblioteka obiektów jest używana do przechowywania definicji obiektu, a gdy obiekt jest przeciągany i upuszczany z biblioteki, tworzone jest nowe odniesienie do istniejącego obiektu.

Obiekty jednorazowego użytku

Wszystkie obiekty, które są zdefiniowane specjalnie dla zadania lub przepływu danych, nazywane są obiektami jednorazowego użytku. Na przykład określona transformacja używana w dowolnym ładowaniu danych.

BODS - Hierarchia obiektów

Wszystkie obiekty mają charakter hierarchiczny. Poniższy diagram przedstawia hierarchię obiektów w systemie SAP BODS -

BODS - narzędzia i funkcje

W oparciu o architekturę przedstawioną poniżej mamy wiele narzędzi zdefiniowanych w SAP Business Objects Data Services. Każde narzędzie ma swoją własną funkcję zgodnie z krajobrazem systemu.

U góry masz zainstalowane Usługi platformy informacyjnej dla użytkowników i zarządzania bezpieczeństwem praw. BODS zależy od konsoli centralnego zarządzania (CMC) dla dostępu użytkownika i funkcji bezpieczeństwa. Dotyczy to wersji 4.x. W poprzedniej wersji odbywało się to w konsoli zarządzania.

Projektant usług danych to narzędzie deweloperskie, które służy do tworzenia obiektów składających się z mapowania danych, transformacji i logiki. Jest oparty na graficznym interfejsie użytkownika i działa jako projektant usług danych.

Magazyn

Repozytorium służy do przechowywania metadanych obiektów używanych w BO Data Services. Każde repozytorium powinno być zarejestrowane w Centralnej Konsoli Zarządzania i połączone z jednym lub wieloma serwerami zadań, które są odpowiedzialne za wykonywanie zadań tworzonych przez Ciebie.

Rodzaje repozytoriów

Istnieją trzy typy repozytoriów.

Local Repository - Służy do przechowywania metadanych wszystkich obiektów utworzonych w Projektancie usług danych, takich jak projekty, zadania, przepływ danych, przepływ pracy itp.

Central Repository- Służy do kontroli zarządzania wersjami obiektów i służy do tworzenia wielu zastosowań. Centralne repozytorium przechowuje wszystkie wersje obiektu aplikacji. W związku z tym umożliwia przejście do poprzednich wersji.

Profiler Repository- Służy do zarządzania wszystkimi metadanymi związanymi z zadaniami profilera wykonywanymi w projektancie SAP BODS. Repozytorium CMS przechowuje metadane wszystkich zadań wykonywanych w CMC na platformie BI. Repozytorium Information Steward przechowuje wszystkie metadane zadań związanych z profilowaniem i obiektów utworzonych przez zarządcę informacji.

Serwer zadań

Serwer zadań służy do wykonywania zadań w czasie rzeczywistym i zadań wsadowych utworzonych przez Ciebie. Pobiera informacje o zadaniu z odpowiednich repozytoriów i inicjuje silnik danych w celu wykonania zadania. Serwer zadań może wykonywać zadania w czasie rzeczywistym lub zaplanowane i wykorzystuje wielowątkowość w pamięci podręcznej oraz przetwarzanie równoległe w celu optymalizacji wydajności.

Dostęp do serwera

Serwer dostępu w usługach danych jest znany jako system brokera komunikatów w czasie rzeczywistym, który przyjmuje żądania komunikatów, przechodzi do usługi czasu rzeczywistego i wyświetla komunikat w określonych ramach czasowych.

Konsola zarządzania usługami danych

Data Service Management Console służy do wykonywania czynności administracyjnych takich jak planowanie zleceń, generowanie raportów jakościowych w systemie DS, walidacja danych, dokumentacja itp.

BODS - standardy nazewnictwa

Zaleca się stosowanie standardowych konwencji nazewnictwa dla wszystkich obiektów we wszystkich systemach, ponieważ umożliwia to łatwą identyfikację obiektów w repozytoriach.

Tabela zawiera listę zalecanych konwencji nazewnictwa, których należy używać dla wszystkich zadań i innych obiektów.

| Prefiks | Przyrostek | Obiekt |

|---|---|---|

| DF_ | n / a | Przepływ danych |

| EDF_ | _Wejście | Wbudowany przepływ danych |

| EDF_ | _Wynik | Wbudowany przepływ danych |

| RTJob_ | n / a | Praca w czasie rzeczywistym |

| WF_ | n / a | Przepływ pracy |

| PRACA_ | n / a | Praca |

| n / a | _DS | Magazyn danych |

| DC_ | n / a | Konfiguracja danych |

| SC_ | n / a | Konfiguracja systemu |

| n / a | _Memory_DS | Magazyn danych pamięci |

| PROC_ | n / a | Procedura składowana |

Podstawy BO Data Service obejmują kluczowe obiekty w projektowaniu przepływu pracy, takie jak projekt, praca, przepływ pracy, przepływ danych, repozytoria.

BODS - repozytorium i typy

Repozytorium służy do przechowywania metadanych obiektów używanych w BO Data Services. Każde repozytorium powinno być zarejestrowane w Centralnej Konsoli Zarządzania, CMC i połączone z jednym lub wieloma serwerami zadań, które są odpowiedzialne za wykonywanie zadań tworzonych przez Ciebie.

Rodzaje repozytoriów

Istnieją trzy typy repozytoriów.

Local Repository - Służy do przechowywania metadanych wszystkich obiektów utworzonych w Projektancie usług danych, takich jak projekty, zadania, przepływ danych, przepływ pracy itp.

Central Repository- Służy do kontroli zarządzania wersjami obiektów i służy do tworzenia wielu zastosowań. Centralne repozytorium przechowuje wszystkie wersje obiektu aplikacji. W związku z tym umożliwia przejście do poprzednich wersji.

Profiler Repository- Służy do zarządzania wszystkimi metadanymi związanymi z zadaniami profilera wykonywanymi w projektancie SAP BODS. Repozytorium CMS przechowuje metadane wszystkich zadań wykonywanych w CMC na platformie BI. Repozytorium Information Steward przechowuje wszystkie metadane zadań związanych z profilowaniem i obiektów utworzonych przez zarządcę informacji.

Aby utworzyć repozytorium BODS, musisz mieć zainstalowaną bazę danych. Możesz użyć SQL Server, bazy danych Oracle, My SQL, SAP HANA, Sybase itp.

Tworzenie repozytorium

Musisz utworzyć następujących użytkowników w bazie danych podczas instalowania BODS i tworzenia repozytoriów. Ci użytkownicy są zobowiązani do logowania się na różnych serwerach, takich jak serwer CMS, serwer audytowy itp.

Utwórz BODS użytkownika zidentyfikowane przez Bodsserver 1

- Grant Connect to BODS;

- Przyznaj sesję tworzenia BODS;

- Udziel DBA BODS;

- Przyznaj tworzenie dowolnej tabeli dla BODS;

- Przyznaj tworzenie dowolnego widoku dla BODS;

- Grant Drop Any Table to BODS;

- Przyznaj upuść dowolny widok do BODS;

- Przyznaj Wstaw dowolną tabelę do BODS;

- Udziel aktualizacji dowolnej tabeli do BODS;

- Przyznaj Usuń dowolną tabelę do BODS;

- Zmienić NIEOGRANICZONY MIEJSCE NA UŻYTKOWNIKÓW

Utwórz system CMS użytkownika zidentyfikowany przez serwer CMS1

- Grant Connect to CMS;

- Przyznaj tworzenie sesji do CMS;

- Udziel DBA CMS;

- Przyznaj tworzenie dowolnej tabeli do CMS;

- Przyznaj tworzenie dowolnego widoku do CMS;

- Przyznaj upuszczenie dowolnej tabeli do CMS;

- Przyznaj upuść dowolny widok do CMS;

- Przyznaj Wstaw dowolną tabelę do CMS;

- Udziel aktualizacji dowolnej tabeli do CMS;

- Przyznaj Usuń dowolną tabelę do CMS;

- Zmień NIEOGRANICZONY MIEJSCE NA CMS UŻYTKOWNIKÓW;

Utwórz użytkownika CMSAUDIT zidentyfikowanego przez serwer CMSAUDIT1

- Przyznaj połączenie z CMSAUDIT;

- Przyznaj utworzenie sesji CMSAUDIT;

- Udziel DBA CMSAUDIT;

- Udziel CMSAUDIT możliwości tworzenia dowolnej tabeli;

- Udziel możliwości tworzenia dowolnego widoku CMSAUDIT;

- Przyznaj upuść dowolną tabelę do CMSAUDIT;

- Przyznaj upuść dowolny widok do CMSAUDIT;

- Przyznaj Wstaw dowolną tabelę do CMSAUDIT;

- Udziel aktualizacji dowolnej tabeli do CMSAUDIT;

- Przyznaj Usuń dowolną tabelę do CMSAUDIT;

- Zmień NIEOGRANICZONĄ KWOTĘ USER CMSAUDIT DLA UŻYTKOWNIKÓW;

Aby utworzyć nowe repozytorium po instalacji

Step 1 - Utwórz bazę danych Local_Repoi przejdź do Menedżera repozytorium usług danych. Skonfiguruj bazę danych jako repozytorium lokalne.

Otworzy się nowe okno.

Step 2 - Wprowadź szczegóły w następujących polach -

Typ repozytorium, typ bazy danych, nazwa serwera bazy danych, port, nazwa użytkownika i hasło.

Step 3 - Kliknij Createprzycisk. Otrzymasz następującą wiadomość -

Step 4 - Teraz zaloguj się do CMC Centralnej Konsoli Zarządzania w SAP BI Platform z nazwą użytkownika i hasłem.

Step 5 - Na stronie głównej CMC kliknij Data Services.

Step 6 - Z Data Services menu, Kliknij Configure a new Data Services Magazyn.

Step 7 - Wprowadź dane podane w nowym oknie.

- Nazwa repozytorium: Local_Repo

- Typ bazy danych: SAP HANA

- Nazwa serwera bazy danych: najlepiej

- Nazwa bazy danych: LOCAL_REPO

- Nazwa Użytkownika:

- Password:*****

Step 8 - Kliknij przycisk Test Connection a jeśli się powiedzie, kliknij Save. Po zapisaniu pojawi się w zakładce Repozytorium w CMC.

Step 9 - Zastosuj prawa dostępu i zabezpieczenia w lokalnym repozytorium w formacie CMC → User and Groups.

Step 10 - Po uzyskaniu dostępu przejdź do Projektanta usług danych → Wybierz repozytorium → Wprowadź nazwę użytkownika i hasło, aby się zalogować.

Aktualizacja repozytorium

Aby zaktualizować repozytorium, wykonaj podane kroki.

Step 1 - Aby zaktualizować repozytorium po instalacji, utwórz bazę danych Local_Repo i przejdź do Menedżera repozytorium usług danych.

Step 2 - Skonfiguruj bazę danych jako repozytorium lokalne.

Otworzy się nowe okno.

Step 3 - Wprowadź szczegóły w następujących polach.

Typ repozytorium, typ bazy danych, nazwa serwera bazy danych, port, nazwa użytkownika i hasło.

Zobaczysz dane wyjściowe, jak pokazano na zrzucie ekranu pokazanym poniżej.

Data Service Management Console (DSMC) służy do wykonywania czynności administracyjnych, takich jak planowanie zadań, generowanie raportów jakościowych w systemie DS, walidacja danych, dokumentacja itp.

Dostęp do konsoli zarządzania usługami danych można uzyskać w następujący sposób -

Dostęp do konsoli zarządzania usługami danych można uzyskać, przechodząc do Start → All Programs → Data Services → Data Service Management Console.

Dostęp do konsoli zarządzania usługami danych można również uzyskać za pośrednictwem Designer jeśli jesteś już zalogowany.

Aby uzyskać dostęp do konsoli zarządzania usługami danych za pośrednictwem Designer Home Page wykonaj czynności podane poniżej.

Aby uzyskać dostęp do konsoli zarządzania usługami danych za pośrednictwem narzędzi, wykonaj podane czynności -

Step 1 - Idź do Tools → Data Services Management Console jak pokazano na poniższym obrazku.

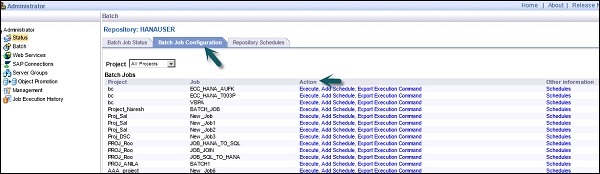

Step 2 - Po zalogowaniu się do Data Services Management Console, ekran główny otworzy się, jak pokazano na zrzucie ekranu podanym poniżej. U góry widać nazwę użytkownika, za pośrednictwem którego jesteś zalogowany.

Na stronie głównej zobaczysz następujące opcje -

- Administrator

- Dokumentacja automatyczna

- Walidacji danych

- Analiza wpływu i pochodzenia

- Pulpit operacyjny

- Raporty dotyczące jakości danych

W tym rozdziale wyjaśniono kluczowe funkcje każdego modułu konsoli zarządzania usługami danych.

Moduł administratora

Opcja Administrator służy do zarządzania -

- Użytkownicy i role

- Aby dodać połączenia, aby uzyskać dostęp do serwerów i repozytoriów

- Aby uzyskać dostęp do danych ofert pracy opublikowanych dla usług internetowych

- Do planowania i monitorowania zadań wsadowych

- Sprawdzanie statusu serwera i usług w czasie rzeczywistym.

Po kliknięciu Administratormożesz zobaczyć wiele linków w lewym okienku. Są to - status, partia, usługi internetowe, połączenia SAP, grupy serwerów, zarządzanie repozytoriami programu Profiler i historia wykonania zadań.

Węzły

Poszczególne węzły w module Administratora zostały omówione poniżej.

Status

Węzeł Status służy do sprawdzania statusu zadań wsadowych i w czasie rzeczywistym, statusu serwera dostępu, repozytoriów adaptera i profilera oraz innych statusów systemu.

Kliknij Status → Wybierz repozytorium

W prawym okienku zobaczysz zakładki z następującymi opcjami -

Batch Job Status- Służy do sprawdzania statusu zadania wsadowego. Możesz sprawdzić informacje o zadaniu, takie jak śledzenie, monitorowanie, błąd i monitor wydajności, godzina rozpoczęcia, godzina zakończenia, czas trwania itp.

Batch Job Configuration - Konfiguracja zadania wsadowego służy do sprawdzania harmonogramu poszczególnych zadań lub można dodać akcję, taką jak Wykonaj, Dodaj harmonogram, Eksportuj polecenie wykonania.

Repositories Schedules - Służy do przeglądania i konfigurowania harmonogramów dla wszystkich zadań w repozytorium.

Węzeł wsadowy

W węźle Batch Job zobaczysz te same opcje, co powyżej.

| Sr. No. | Opcja i opis |

|---|---|

| 1 | Batch Job Status Zobacz status ostatniej realizacji i szczegółowe informacje o każdym zadaniu. |

| 2 | Batch Job Configuration Skonfiguruj opcje wykonywania i planowania dla poszczególnych zadań. |

| 3 | Repository Schedules Przeglądaj i konfiguruj harmonogramy dla wszystkich zadań w repozytorium. |

Węzeł usług sieci Web

Usługi sieci Web są używane do publikowania zadań w czasie rzeczywistym i zadań wsadowych jako operacji usługi sieci Web oraz do sprawdzania stanu tych operacji. Służy to również do utrzymania bezpieczeństwa ofert pracy publikowanych jako usługa internetowa i do przeglądaniaWSDL plik.

Połączenia SAP

SAP Connections służy do sprawdzania stanu lub konfigurowania RFC server interface w konsoli zarządzania usługami danych.

Aby sprawdzić stan interfejsu serwera RFC, przejdź do zakładki RFC Server Interface Status. Aby dodać nowy interfejs serwera RFC, na karcie konfiguracji kliknijAdd.

Po otwarciu nowego okna wprowadź szczegóły konfiguracji serwera RFC kliknij Apply.

Grupy serwerów

Służy do grupowania wszystkich serwerów zadań, które są powiązane z tym samym repozytorium, w jedną grupę serwerów. Ta karta służy do równoważenia obciążenia podczas wykonywania zadań w usługach danych.

Kiedy zadanie jest wykonywane, sprawdza odpowiedni serwer zadań, a jeśli jest wyłączony, przenosi zadanie na inny serwer zadań w tej samej grupie. Jest używany głównie w produkcji do równoważenia obciążenia.

Repozytoria profili

Połączenie repozytorium profili z administratorem umożliwia rozszerzenie węzła repozytorium profili. Możesz przejść do strony statusu Zadania profilu.

Węzeł zarządzania

Aby skorzystać z funkcji zakładki Administrator, musisz dodać połączenia do usług danych za pomocą węzła zarządzania. Węzeł zarządzania zawiera różne opcje konfiguracji aplikacji administracyjnej.

Historia wykonywania zadań

Służy do sprawdzania historii wykonania zadania lub przepływu danych. Korzystając z tej opcji, możesz sprawdzić historię wykonania jednego zadania wsadowego lub wszystkich zadań wsadowych utworzonych przez Ciebie.

Po wybraniu zadania wyświetlane są informacje w postaci tabeli, na którą składają się nazwa repozytorium, nazwa zadania, czas rozpoczęcia, czas zakończenia, czas wykonania, status itp.

Data Service Designer to narzędzie programistyczne, które służy do tworzenia obiektów składających się z mapowania danych, transformacji i logiki. Jest oparty na graficznym interfejsie użytkownika i działa jako projektant usług danych.

Za pomocą narzędzia Data Services Designer można tworzyć różne obiekty, takie jak projekty, zadania, przepływy pracy, przepływy danych, mapowanie, transformacje itp.

Aby uruchomić projektanta usług danych, wykonaj kroki podane poniżej.

Step 1 - Wskaż Start → Wszystkie programy → SAP Data Services 4.2 → Data Services Designer.

Step 2 - Wybierz repozytorium i wprowadź hasło, aby się zalogować.

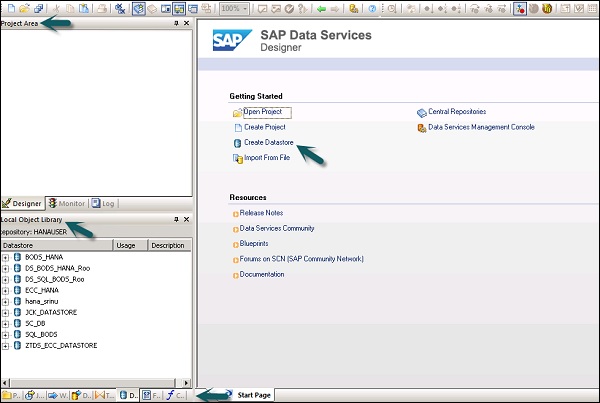

Po wybraniu repozytorium i zalogowaniu się do projektanta usług danych pojawi się ekran główny, jak pokazano na poniższym obrazku.

W lewym panelu znajduje się obszar projektu, w którym można utworzyć nowy projekt, zadanie, przepływ danych, przepływ pracy itp. W obszarze Projekt znajduje się biblioteka obiektów lokalnych, na którą składają się wszystkie obiekty utworzone w usługach danych.

W dolnym panelu możesz otworzyć istniejące obiekty, przechodząc do określonych opcji, takich jak Projekt, Praca, Przepływ danych, Przepływ pracy itp. Po wybraniu dowolnego obiektu z dolnego panelu pokaże Ci wszystkie podobne obiekty utworzony w Repozytorium w lokalnej bibliotece obiektów.

Po prawej stronie znajduje się ekran główny, na którym można -

- Utwórz projekt

- Otwarty projekt

- Utwórz magazyny danych

- Utwórz repozytoria

- Importuj z pliku płaskiego

- Konsola zarządzania usługami danych

Aby opracować przepływ ETL, musisz najpierw utworzyć składnice danych dla systemu źródłowego i docelowego. Postępuj zgodnie z podanymi krokami, aby opracować przepływ ETL -

Step 1 - Kliknij Create Data Stores.

Otworzy się nowe okno.

Step 2 - Wejdź do Datastore Nazwa, Datastoretyp i typ bazy danych, jak pokazano poniżej. Możesz wybrać inną bazę danych jako system źródłowy, jak pokazano na poniższym zrzucie ekranu.

Step 3- Aby użyć systemu ECC jako źródła danych, wybierz Aplikacje SAP jako typ Datastore. Wprowadź nazwę użytkownika i hasło, a naAdvance wprowadź numer systemu i numer klienta.

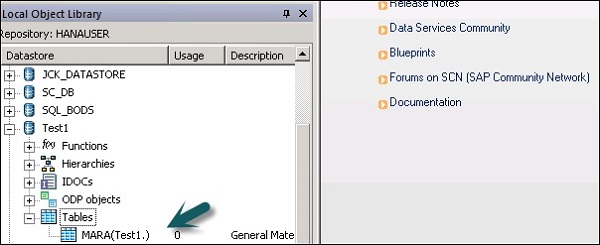

Step 4- Kliknij OK, a magazyn danych zostanie dodany do listy lokalnych bibliotek obiektów. Jeśli rozwiniesz Datastore, nie wyświetli się żadna tabela.

Step 5 - Aby wyodrębnić dowolną tabelę z systemu ECC w celu załadowania do systemu docelowego, kliknij prawym przyciskiem myszy Tabele → Importuj według nazw.

Step 6 - Wprowadź nazwę tabeli i kliknij Import. Tutaj używana jest tabela - Mara, która jest domyślną tabelą w systemie ECC.

Step 7 - W podobny sposób utwórz plik Datastoredla systemu docelowego. W tym przykładzie HANA jest używana jako system docelowy.

Po kliknięciu OK, to Datastore zostanie dodany do lokalnej biblioteki obiektów i nie będzie w nim żadnej tabeli.

Utwórz przepływ ETL

Aby utworzyć przepływ ETL, utwórz nowy projekt.

Step 1 - Kliknij opcję, Create Project. Wprowadź nazwę projektu i kliknijCreate. Zostanie dodany do obszaru projektu.

Step 2 - Kliknij prawym przyciskiem myszy nazwę projektu i utwórz nowe zadanie wsadowe / zadanie w czasie rzeczywistym.

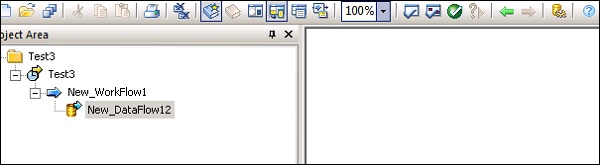

Step 3- Wprowadź nazwę pracy i naciśnij Enter. Musisz dodać do tego przepływ pracy i przepływ danych. Wybierz przepływ pracy i kliknij obszar roboczy, aby dodać go do zadania. Wprowadź nazwę przepływu pracy i kliknij go dwukrotnie, aby dodać do obszaru projektu.

Step 4- W podobny sposób wybierz przepływ danych i przenieś go do obszaru projektu. Wprowadź nazwę przepływu danych i kliknij dwukrotnie, aby dodać go do nowego projektu.

Step 5- Teraz przeciągnij tabelę źródłową z magazynu danych do obszaru roboczego. Teraz możesz przeciągnąć tabelę docelową o podobnym typie danych do obszaru roboczego lub możesz utworzyć nową tabelę szablonu.

Aby utworzyć nową tabelę szablonów, kliknij prawym przyciskiem myszy tabelę źródłową, Dodaj nowy → Tabela szablonów.

Step 6- Wprowadź nazwę tabeli i wybierz Datastore z listy jako docelowy Datastore. Nazwa właściciela reprezentuje nazwę schematu, w którym ma zostać utworzona tabela.

Tabela zostanie dodana do obszaru roboczego pod tą nazwą tabeli.

Step 7- Przeciągnij linię z tabeli źródłowej do tabeli docelowej. KliknijSave All opcja u góry.

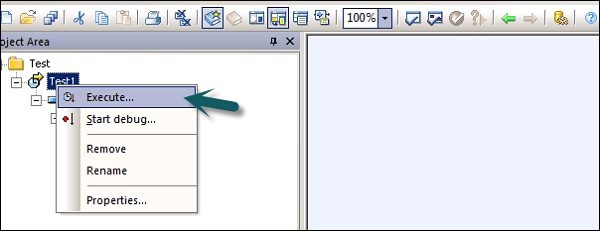

Teraz możesz zaplanować zadanie za pomocą konsoli zarządzania usługami danych lub wykonać je ręcznie, klikając prawym przyciskiem myszy nazwę zadania i opcję Wykonaj.

Magazyny danych służą do konfigurowania połączenia między aplikacją a bazą danych. Możesz bezpośrednio utworzyć Datastore lub można je utworzyć za pomocą adapterów. Datastore umożliwia aplikacji / oprogramowaniu odczytywanie lub zapisywanie metadanych z aplikacji lub bazy danych oraz zapisywanie w tej bazie danych lub aplikacji.

W usługach Business Objects Data Services można łączyć się z następującymi systemami za pomocą Datastore -

- Systemy mainframe i bazy danych

- Aplikacje i oprogramowanie z adapterami napisanymi przez użytkownika

- Aplikacje SAP, SAP BW, Oracle Apps, Siebel itp.

SAP Business Objects Data Services udostępnia opcję łączenia się z interfejsami Mainframe przy użyciu AttunityZłącze. Za pomocąAttunity, połącz Datastore z poniższą listą źródeł -

- DB2 UDB dla OS / 390

- DB2 UDB for OS / 400

- IMS/DB

- VSAM

- Adabas

- Pliki płaskie w systemach OS / 390 i OS / 400

Korzystając ze złącza Attunity, możesz połączyć się z danymi na komputerze mainframe za pomocą oprogramowania. Oprogramowanie to należy zainstalować ręcznie na serwerze mainframe i lokalnym serwerze zadań klienta przy użyciu interfejsu ODBC.

Wprowadź szczegóły, takie jak lokalizacja hosta, port, obszar roboczy Attunity itp.

Utwórz Datastore dla bazy danych

Aby utworzyć Datastore dla bazy danych, wykonaj poniższe czynności.

Step 1- Wprowadź nazwę Datastore, typ Datastore i typ bazy danych, jak pokazano na poniższym obrazku. Możesz wybrać inną bazę danych jako system źródłowy podany na liście.

Step 2- Aby użyć systemu ECC jako źródła danych, wybierz Aplikacje SAP jako typ Datastore. Wprowadź nazwę użytkownika i hasło. KliknijAdvance i wprowadź numer systemu oraz numer klienta.

Step 3- Kliknij OK, a magazyn danych zostanie dodany do listy lokalnych bibliotek obiektów. Jeśli rozwiniesz Datastore, nie ma tabeli do wyświetlenia.

W tym rozdziale dowiemy się, jak edytować lub zmieniać Datastore. Aby zmienić lub edytować Datastore, wykonaj czynności podane poniżej.

Step 1- Aby edytować Datastore, kliknij prawym przyciskiem myszy nazwę Datastore i kliknij Edytuj. Otworzy się edytor Datastore.

Możesz edytować informacje o połączeniu dla bieżącej konfiguracji Datastore.

Step 2 - Kliknij Advance i możesz edytować numer klienta, identyfikator systemu i inne właściwości.

Step 3 - Kliknij Edit możliwość dodawania, edytowania i usuwania konfiguracji.

Step 4 - Kliknij OK, a zmiany zostaną zastosowane.

Możesz utworzyć Datastore, używając pamięci jako typu bazy danych. Pamięciowe magazyny danych służą do poprawy wydajności przepływu danych w zadaniach czasu rzeczywistego, ponieważ przechowuje dane w pamięci w celu ułatwienia szybkiego dostępu i nie wymaga korzystania z oryginalnego źródła danych.

Pamięć Datastore jest używana do przechowywania schematów tablic pamięci w repozytorium. Te tabele pamięci pobierają dane z tabel w relacyjnej bazie danych lub przy użyciu hierarchicznych plików danych, takich jak komunikaty XML i obiekty IDoc. Tabele pamięci pozostają aktywne do momentu wykonania zadania, a dane w tabelach pamięci nie mogą być współdzielone między różnymi zadaniami czasu rzeczywistego.

Tworzenie pamięci Datastore

Aby utworzyć Memory Datastore, wykonaj kroki podane poniżej.

Step 1 - Kliknij opcję Utwórz Datastore i wprowadź nazwę Datastore “Memory_DS_TEST”. Tabele pamięci są przedstawiane za pomocą zwykłych tabel RDBMS i można je zidentyfikować za pomocą konwencji nazewnictwa.

Step 2 - W Datastore Type wybierz Database, aw typie bazy danych wybierz Memory. Kliknij OK.

Step 3 - Teraz przejdź do Projekt → Nowy → Projekt, jak pokazano na zrzucie ekranu podanym poniżej.

Step 4- Utwórz nowe zadanie, klikając prawym przyciskiem myszy. Dodaj przepływ pracy i przepływ danych, jak pokazano poniżej.

Step 5- Wybierz tabelę szablonów i przeciągnij i upuść do obszaru roboczego. Otworzy się okno Utwórz tabelę.

Step 6- Wprowadź nazwę tabeli i w Datastore wybierz Memory Datastore. Jeśli chcesz mieć identyfikator wiersza wygenerowany przez system, wybierz plikcreate row idpole wyboru. Kliknij OK.

Step 7 - Podłącz tę tabelę pamięci do przepływu danych i kliknij Save All na górze.

Tabela pamięci jako źródło i cel

Aby użyć tabeli pamięci jako celu -

Step 1- Przejdź do lokalnej biblioteki obiektów, kliknij kartę Datastore. Rozwiń Memory Datastore → Rozwiń tabele.

Step 2- Wybierz tabelę pamięci, której chcesz użyć jako tabelę źródłową lub docelową i przeciągnij ją do przepływu pracy. Połącz tę tabelę pamięci jako źródło lub cel w przepływie danych.

Step 3 - Kliknij save przycisk, aby zapisać pracę.

Istnieją różni dostawcy baz danych, którzy zapewniają tylko jednokierunkową ścieżkę komunikacyjną z jednej bazy danych do drugiej. Te ścieżki są nazywane linkami do baz danych. W SQL Server serwer połączony umożliwia jednokierunkową ścieżkę komunikacyjną z jednej bazy danych do drugiej.

Przykład

Rozważmy lokalny serwer bazy danych o nazwie “Product” przechowuje łącze do bazy danych, aby uzyskać dostęp do informacji na zdalnym serwerze bazy danych o nazwie Customer. Obecnie użytkownicy połączeni ze zdalnym serwerem bazy danych Klient nie mogą używać tego samego łącza w celu uzyskania dostępu do danych w produkcie serwera bazy danych. Użytkownicy, którzy są połączeni z“Customer” powinien mieć osobne łącze w słowniku danych serwera, aby uzyskać dostęp do danych na serwerze bazy danych Produktów.

Ta ścieżka komunikacyjna między dwiema bazami danych nazywana jest łączem bazy danych. Magazyny danych, które są tworzone między tymi powiązanymi relacjami baz danych, są nazywane połączonymi magazynami danych.

Istnieje możliwość połączenia jednego Datastore z innym Datastore i zaimportowania zewnętrznego łącza do bazy danych jako opcja Datastore.

Adapter Datastore umożliwia importowanie metadanych aplikacji do repozytorium. Możesz uzyskać dostęp do metadanych aplikacji i przenosić dane wsadowe i dane w czasie rzeczywistym między różnymi aplikacjami i oprogramowaniem.

Dostępny jest zestaw programistyczny adaptera - SDK dostarczony przez firmę SAP, którego można użyć do tworzenia niestandardowych adapterów. Te karty są wyświetlane w projektancie usług danych przez magazyn danych adaptera.

Aby wyodrębnić lub załadować dane za pomocą adaptera, należy w tym celu zdefiniować co najmniej jeden Datastore.

Adapter Datastore - definicja

Aby zdefiniować Adaptive Datastore, wykonaj następujące kroki -

Step 1 - Kliknij Create Datastore→ Wprowadź nazwę Datastore. Wybierz typ Datastore jako adapter. WybierzJob Server z listy oraz Nazwa instancji adaptera i kliknij OK.

Aby przeglądać metadane aplikacji

Kliknij prawym przyciskiem myszy nazwę Datastore i kliknij Open. Otworzy się nowe okno pokazujące metadane źródłowe. Kliknij znak +, aby sprawdzić obiekty, i kliknij prawym przyciskiem obiekt do zaimportowania.

Format pliku definiuje się jako zestaw właściwości przedstawiających strukturę plików płaskich. Definiuje strukturę metadanych. Format pliku służy do łączenia się ze źródłową i docelową bazą danych, gdy dane są przechowywane w plikach, a nie w bazie danych.

Format pliku jest używany do następujących funkcji -

- Utwórz szablon formatu pliku, aby zdefiniować strukturę pliku.

- Utwórz określony format pliku źródłowego i docelowego w przepływie danych.

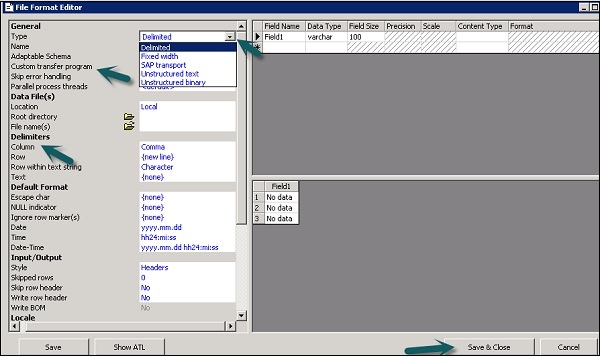

Następujące typy plików mogą być używane jako pliki źródłowe lub docelowe przy użyciu formatu pliku -

- Delimited

- Transport SAP

- Tekst nieustrukturyzowany

- Niestrukturalny plik binarny

- Stała szerokość

Edytor formatu plików

Edytor formatu plików służy do ustawiania właściwości szablonów formatu plików oraz źródłowych i docelowych formatów plików.

W edytorze formatu plików dostępne są następujące tryby -

New mode - Pozwala na utworzenie nowego szablonu formatu pliku.

Edit mode - Pozwala edytować istniejący szablon formatu pliku.

Source mode - Pozwala edytować format pliku określonego pliku źródłowego.

Target mode - Pozwala edytować format pliku określonego pliku docelowego.

Istnieją trzy obszary robocze dla edytora formatu plików -

Properties Values - Służy do edycji wartości właściwości formatu pliku.

Column Attributes - Służy do edycji i definiowania kolumn lub pól w pliku.

Data Preview - Służy do sprawdzenia, jak ustawienia wpływają na przykładowe dane.

Tworzenie formatu pliku

Aby utworzyć format pliku, wykonaj czynności podane poniżej.

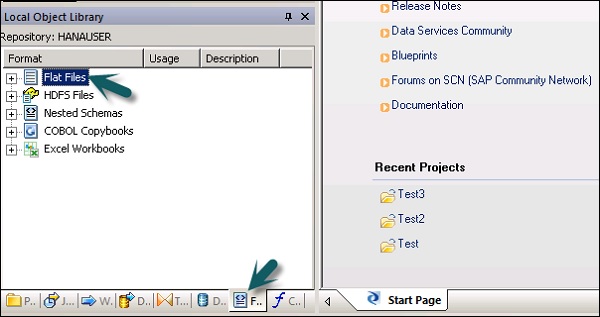

Step 1 - Idź do Local Object Library → Flat files.

Step 2 - Kliknij prawym przyciskiem opcję Flat Files → New.

Otworzy się nowe okno Edytora formatu plików.

Step 3- Wybierz typ formatu pliku. Wprowadź nazwę opisującą szablon formatu pliku. W przypadku plików rozdzielanych i o stałej szerokości można je czytać i wczytywać za pomocą niestandardowego programu do przenoszenia. Wprowadź inne właściwości, aby opisać pliki, które reprezentuje ten szablon.

Możesz także określić strukturę kolumn w obszarze roboczym atrybutów kolumn dla kilku określonych formatów plików. Po zdefiniowaniu wszystkich właściwości kliknij plikSave przycisk.

Edycja formatu pliku

Aby edytować formaty plików, wykonaj czynności podane poniżej.

Step 1 - W lokalnej bibliotece obiektów przejdź do Format patka.

Step 2- Wybierz format pliku, który chcesz edytować. Kliknij prawym przyciskiem myszyEdit opcja.

Wprowadź zmiany w edytorze formatu pliku i kliknij Save przycisk.

Możesz utworzyć format pliku copybook w języku COBOL, który spowalnia tworzenie samego formatu. Możesz skonfigurować źródło później, po dodaniu formatu do przepływu danych.

Możesz stworzyć format pliku i połączyć go z plikiem danych w tym samym czasie. Wykonaj czynności podane poniżej.

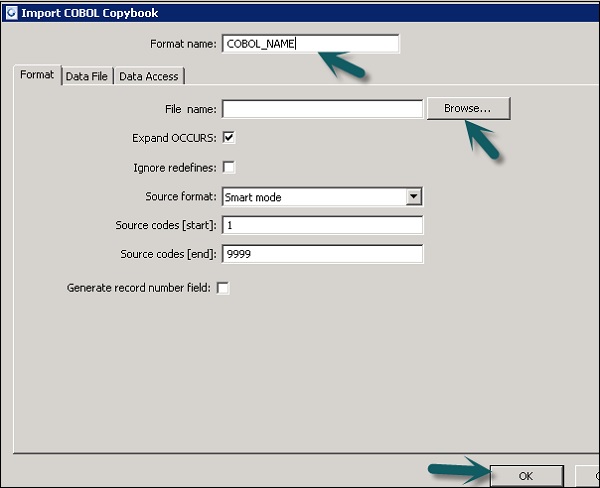

Step 1 - Przejdź do Local Object Library → File Format → COBOL Copybooks.

Step 2 - Kliknij prawym przyciskiem myszy New opcja.

Step 3- Wprowadź nazwę formatu. Przejdź do zakładki Format → Wybierz zeszyt COBOL do zaimportowania. Rozszerzenie pliku to.cpy.

Step 4 - Kliknij OK. Ten format pliku jest dodawany do lokalnej biblioteki obiektów. Otworzy się okno dialogowe Nazwa schematu kopiowania COBOL. W razie potrzeby zmień nazwę schematu i kliknijOK.

Korzystając z baz danych, można wyodrębnić dane z tabel i funkcji w bazie danych. Podczas importowania danych dla metadanychTool umożliwia edycję nazw kolumn, typów danych, opisu itp.

Możesz edytować następujące obiekty -

- Nazwa tabeli

- Nazwa kolumny

- Opis tabeli

- Opis kolumny

- Typ danych kolumny

- Typ zawartości kolumny

- Atrybuty tabeli

- Klucz podstawowy

- Imię właściciela

Importowanie metadanych

Aby zaimportować metadane, wykonaj czynności podane poniżej -

Step 1 - Idź do Local Object Library → przejdź do Datastore, którego chcesz użyć.

Step 2 - Kliknij prawym przyciskiem myszy Datastore → Otwórz.

W obszarze roboczym zostaną wyświetlone wszystkie elementy dostępne do importu. Wybierz elementy, dla których chcesz zaimportować metadane.

W bibliotece obiektów przejdź do magazynu danych, aby wyświetlić listę zaimportowanych obiektów.

Możesz użyć skoroszytu programu Microsoft Excel jako źródła danych przy użyciu formatów plików w usługach danych. Skoroszyt programu Excel powinien być dostępny w systemie plików Windows lub systemie plików Unix.

| Sr.No. | Dostęp i opis |

|---|---|

| 1 | In the object library, click the Formats tab. Formalny skoroszyt programu Excel opisuje strukturę zdefiniowaną w skoroszycie programu Excel (oznaczoną rozszerzeniem .xls). Szablony formatów dla zakresów danych programu Excel są przechowywane w bibliotece obiektów. Szablon służy do definiowania formatu określonego źródła w przepływie danych. SAP Data Services korzysta ze skoroszytów programu Excel tylko jako źródła (nie jako cele). |

Kliknij prawym przyciskiem myszy New opcję i wybierz Excel Workbook jak pokazano na poniższym zrzucie ekranu.

Ekstrakcja danych z XML FILE DTD, XSD

Możesz także zaimportować format pliku schematu XML lub DTD.

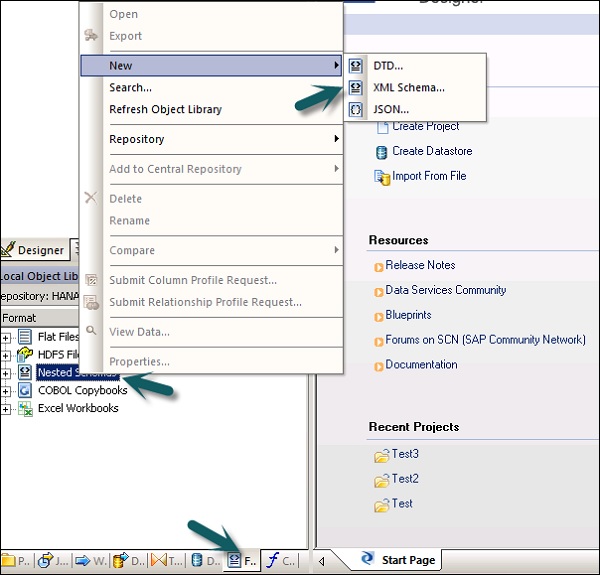

Step 1 - Idź do Lokalna biblioteka obiektów → zakładka Format → Schemat zagnieżdżony.

Step 2 - Wskaż New(Możesz wybrać plik DTD, schemat XML lub format pliku JSON). Wprowadź nazwę formatu pliku i wybierz plik, który chcesz zaimportować. Kliknij OK.

Pobieranie danych z zeszytów COBOL

Możesz także importować format plików w zeszytach COBOL. Przejdź do Lokalna biblioteka obiektów → Format → Książki w języku COBOL.

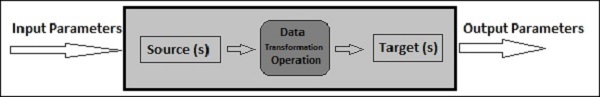

Przepływ danych służy do wyodrębniania, przekształcania i ładowania danych ze źródła do systemu docelowego. Wszystkie transformacje, ładowanie i formatowanie odbywa się w przepływie danych.

Po zdefiniowaniu przepływu danych w projekcie można go dodać do przepływu pracy lub zadania ETL. Przepływ danych może wysyłać lub odbierać obiekty / informacje za pomocą parametrów. Przepływ danych jest nazwany w formacieDF_Name.

Przykład przepływu danych

Załóżmy, że chcesz załadować tabelę faktów w systemie DW z danymi z dwóch tabel w systemie źródłowym.

Przepływ danych zawiera następujące obiekty -

- Dwie tabele źródłowe

- Łączenie między dwiema tabelami i zdefiniowane w przekształceniu zapytania

- Tabela docelowa

Istnieją trzy typy obiektów, które można dodać do przepływu danych. Oni są -

- Source

- Target

- Transforms

Step 1 - Przejdź do lokalnej biblioteki obiektów i przeciągnij obie tabele do obszaru roboczego.

Step 2 - Aby dodać transformację zapytania, przeciągnij z prawego paska narzędzi.

Step 3 - Połącz obie tabele i utwórz tabelę docelową szablonu, klikając prawym przyciskiem myszy pole Zapytanie → Dodaj nowy → Nowa tabela szablonów.

Step 4 - Wprowadź nazwę tabeli docelowej, nazwę magazynu danych i właściciela (nazwę schematu), pod którym ma zostać utworzona tabela.

Step 5 - Przeciągnij tabelę docelową na wierzch i dołącz ją do transformacji zapytania.

Przekazywanie parametrów

Możesz także przekazywać różne parametry do i z przepływu danych. Podczas przekazywania parametru do przepływu danych obiekty w przepływie danych odwołują się do tych parametrów. Używając parametrów, możesz przekazać różne operacje do przepływu danych.

Przykład - załóżmy, że wprowadziłeś parametr do tabeli o ostatniej aktualizacji. Pozwala wyodrębnić tylko wiersze zmodyfikowane od ostatniej aktualizacji.

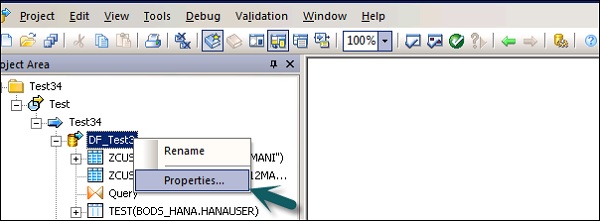

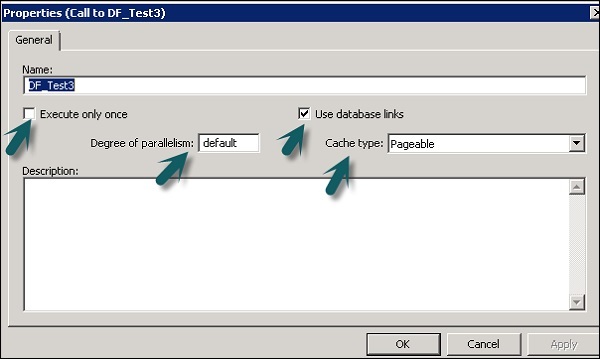

Możesz zmienić właściwości przepływu danych, takie jak Wykonaj raz, typ pamięci podręcznej, łącze do bazy danych, równoległość itp.

Step 1 - Aby zmienić właściwości przepływu danych, kliknij prawym przyciskiem myszy Przepływ danych → Właściwości

Możesz ustawić różne właściwości przepływu danych. Właściwości podano poniżej.

| Sr. No. | Właściwości i opis |

|---|---|

| 1 | Execute only once Jeśli określisz, że przepływ danych powinien być wykonywany tylko raz, zadanie wsadowe nigdy nie będzie ponownie wykonywać tego przepływu danych po pomyślnym zakończeniu przepływu danych, z wyjątkiem sytuacji, gdy przepływ danych jest zawarty w przepływie pracy, który jest jednostką odzyskiwania, która wykonuje ponownie i nie zakończyło się pomyślnie w innym miejscu poza jednostką odzysku. Zaleca się, aby nie oznaczać przepływu danych jako Wykonaj tylko raz, jeśli nadrzędny przepływ pracy jest jednostką odzyskiwania. |

| 2 | Use database links Łącza bazy danych to ścieżki komunikacyjne między jednym serwerem bazy danych a innym. Łącza do baz danych umożliwiają lokalnym użytkownikom dostęp do danych w zdalnej bazie danych, która może znajdować się na lokalnym lub zdalnym komputerze tego samego lub innego typu bazy danych. |

| 3 | Degree of parallelism Stopień równoległości (DOP) to właściwość przepływu danych, która określa, ile razy każda transformacja w przepływie danych jest replikowana w celu przetworzenia równoległego podzbioru danych. |

| 4 | Cache type Dane można buforować, aby poprawić wydajność operacji, takich jak łączenie, grupowanie, sortowanie, filtrowanie, wyszukiwanie i porównywanie tabel. Możesz wybrać jedną z następujących wartości opcji Typ pamięci podręcznej w oknie Właściwości przepływu danych -

|

Step 2 - Zmień właściwości, takie jak Wykonaj tylko raz, Stopień równoległości i typy pamięci podręcznej.

Obiekty źródłowe i docelowe

Przepływ danych może wyodrębniać lub ładować dane bezpośrednio przy użyciu następujących obiektów -

Source objects - Obiekty źródłowe określają źródło, z którego wyodrębniane są dane lub użytkownik je odczytuje.

Target objects - Obiekty docelowe definiują cel, do którego ładujesz lub zapisujesz dane.

Można użyć następującego typu obiektu źródłowego i różnych metod dostępu do obiektów źródłowych.

| Stół | Plik sformatowany za pomocą kolumn i wierszy, tak jak jest używany w relacyjnych bazach danych | Bezpośrednio lub przez adapter |

| Tabela szablonów | Tabela szablonów, która została utworzona i zapisana w innym przepływie danych (używana w rozwoju) | Bezpośredni |

| Plik | Plik płaski z ogranicznikami lub o stałej szerokości | Bezpośredni |

| Dokument | Plik w formacie specyficznym dla aplikacji (nieczytelny przez parser SQL lub XML) | Poprzez adapter |

| Plik XML | Plik sformatowany za pomocą znaczników XML | Bezpośredni |

| Wiadomość XML | Używany jako źródło w zadaniach w czasie rzeczywistym | Bezpośredni |

Można użyć następujących obiektów docelowych i zastosować inną metodę dostępu.

| Stół | Plik sformatowany za pomocą kolumn i wierszy, tak jak jest używany w relacyjnych bazach danych | Bezpośrednio lub przez adapter |

| Tabela szablonów | Tabela, której format jest oparty na danych wyjściowych poprzedniej transformacji (używany w programowaniu) | Bezpośredni |

| Plik | Plik płaski z ogranicznikami lub o stałej szerokości | Bezpośredni |

| Dokument | Plik w formacie specyficznym dla aplikacji (nieczytelny przez parser SQL lub XML) | Poprzez adapter |

| Plik XML | Plik sformatowany za pomocą znaczników XML | Bezpośredni |

| Plik szablonu XML | Plik XML, którego format jest oparty na poprzednim wyniku transformacji (używany w programowaniu, głównie do debugowania przepływów danych) | Bezpośredni |

Przepływy pracy służą do określenia procesu do wykonania. Głównym celem workflow jest przygotowanie do realizacji przepływów danych oraz ustalenie stanu systemu po zakończeniu realizacji przepływu danych.

Zadania wsadowe w projektach ETL są podobne do przepływów pracy z tą różnicą, że zadanie nie ma parametrów.

Do przepływu pracy można dodawać różne obiekty. Oni są -

- Przepływ pracy

- Przepływ danych

- Scripts

- Loops

- Conditions

- Try or Catch Blocks

Możesz również wywołać przepływ pracy z innym przepływem pracy lub przepływ pracy może wywołać sam siebie.

Note - W przepływie pracy kroki są wykonywane w kolejności od lewej do prawej.

Przykład przepływu pracy

Załóżmy, że istnieje tabela faktów, którą chcesz zaktualizować i utworzono przepływ danych z transformacją. Teraz, jeśli chcesz przenieść dane z systemu źródłowego, musisz sprawdzić ostatnią modyfikację tabeli faktów, aby wyodrębnić tylko wiersze, które zostały dodane po ostatniej aktualizacji.

Aby to osiągnąć, należy utworzyć jeden skrypt, który określa datę ostatniej aktualizacji, a następnie przekazuje go jako parametr wejściowy do przepływu danych.

Musisz także sprawdzić, czy połączenie danych z określoną tabelą faktów jest aktywne, czy nie. Jeśli nie jest aktywny, musisz ustawić blok catch, który automatycznie wysyła e-mail do administratora z powiadomieniem o tym problemie.

Przepływy pracy można tworzyć za pomocą następujących metod -

- Biblioteka obiektów

- Paleta narzędzi

Tworzenie przepływu pracy przy użyciu biblioteki obiektów

Aby utworzyć przepływ pracy przy użyciu biblioteki obiektów, wykonaj kroki podane poniżej.

Step 1 - Przejdź do biblioteki obiektów → zakładka Workflow.

Step 2 - Kliknij prawym przyciskiem myszy New opcja.

Step 3 - Wprowadź nazwę przepływu pracy.

Tworzenie przepływu pracy za pomocą palety narzędzi

Aby utworzyć przepływ pracy za pomocą palety narzędzi, kliknij ikonę po prawej stronie i przeciągnij przepływ pracy w obszarze roboczym.

Możesz również ustawić wykonywanie przepływu pracy tylko raz, przechodząc do właściwości przepływu pracy.

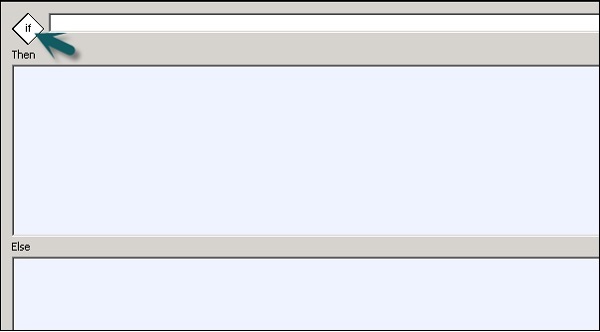

Warunki

Możesz także dodać warunki warunkowe do przepływu pracy. Pozwala to na implementację logiki Jeśli / Inaczej / To w przepływach pracy.

| Sr.No. | Warunkowe i opis |

|---|---|

| 1 | If Wyrażenie logiczne, którego wynikiem jest PRAWDA lub FAŁSZ. Do konstruowania wyrażenia można używać funkcji, zmiennych i standardowych operatorów. |

| 2 | Then Elementy przepływu pracy do wykonania, jeśli If wyrażenie przyjmuje wartość PRAWDA. |

| 3 | Else (Opcjonalnie) Elementy przepływu pracy do wykonania, jeśli If wyrażenie przyjmuje wartość FALSE. |

Aby zdefiniować warunkowy

Step 1 - Idź do Workflow → Kliknij ikonę Warunek na palecie narzędzi po prawej stronie.

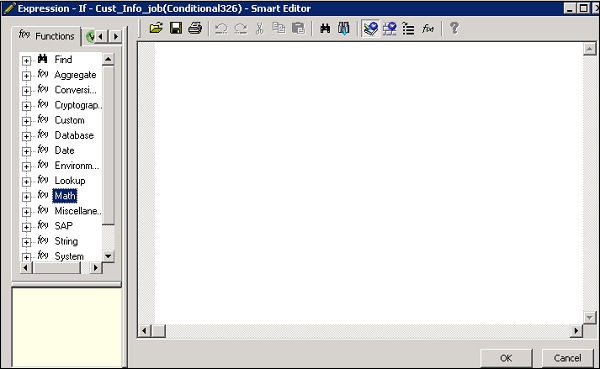

Step 2 - Kliknij dwukrotnie nazwę warunku, aby otworzyć plik If-Then–Else edytor warunkowy.

Step 3- Wprowadź wyrażenie logiczne, które kontroluje warunek. Kliknij OK.

Step 4 - Przeciągnij przepływ danych, który chcesz wykonać Then and Else okno zgodnie z wyrażeniem w warunku JEŻELI.

Po spełnieniu warunku możesz debugować i zweryfikować warunek.

Transformacje służą do manipulowania zestawami danych jako danymi wejściowymi i tworzenia jednego lub wielu wyników. Istnieją różne przekształcenia, których można używać w usługach danych. Rodzaj przekształceń zależy od wersji i zakupionego produktu.

Dostępne są następujące typy transformacji -

Integracja danych

Transformacje integracji danych są używane do ekstrakcji danych, transformacji i ładowania do systemu DW. Zapewnia integralność danych i zwiększa produktywność programistów.

- Data_Generator

- Data_Transfer

- Effective_Date

- Hierarchy_flattening

- Tabela_Porównanie itp.

Jakość danych

Transformacje jakości danych służą do poprawy jakości danych. Możesz zastosować parsowanie, poprawianie, standaryzację, wzbogacanie zestawu danych z systemu źródłowego.

- Associate

- Oczyszczanie danych

- DSF2 Walk Sequencer itp.

Platforma

Platforma służy do przenoszenia zbioru danych. Za pomocą tego można generować, mapować i scalać wiersze z co najmniej dwóch źródeł danych.

- Case

- Merge

- Zapytanie itp.

Przetwarzanie danych tekstowych

Przetwarzanie danych tekstowych umożliwia przetwarzanie dużej ilości danych tekstowych.

W tym rozdziale zobaczysz, jak dodawać Transform do przepływu danych.

Step 1 - Idź do Object Library → zakładka Transform.

Step 2- Wybierz transformację, którą chcesz dodać do przepływu danych. Jeśli dodasz transformację, która ma opcję wyboru konfiguracji, pojawi się monit.

Step 3 - Narysuj połączenie przepływu danych, aby połączyć źródło z transformacją.

Step 4 - Kliknij dwukrotnie nazwę Transformacji, aby otworzyć edytor transformacji.

Po zakończeniu definiowania kliknij OK aby zamknąć edytor.

Jest to najczęściej stosowana transformacja w usługach danych i możesz wykonywać następujące funkcje -

- Filtrowanie danych ze źródeł

- Łączenie danych z wielu źródeł

- Wykonywanie funkcji i przekształceń danych

- Mapowanie kolumn ze schematów wejściowych do wyjściowych

- Przypisywanie kluczy podstawowych

- Dodaj nowe kolumny, schematy i funkcje wynikające ze schematów wyjściowych

Ponieważ transformacja zapytania jest najczęściej używaną transformacją, dla tego zapytania dostępny jest skrót na palecie narzędzi.

Aby dodać przekształcenie zapytania, wykonaj kroki podane poniżej -

Step 1- Kliknij paletę narzędzi do przekształcania zapytań. Kliknij w dowolnym miejscu obszaru roboczego Przepływ danych. Podłącz to do wejść i wyjść.

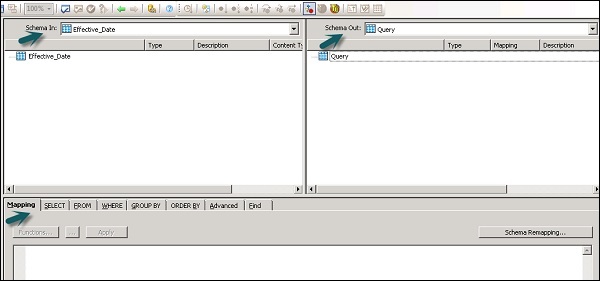

Po dwukrotnym kliknięciu ikony transformacji zapytania otwiera się edytor zapytań używany do wykonywania operacji zapytań.

Następujące obszary są obecne w przekształceniu zapytania -

- Schemat wejściowy

- Schemat wyjściowy

- Parameters

Schematy wejścia i wyjścia zawierają kolumny, zagnieżdżone schematy i funkcje. Schemat wejścia i schematu wyjścia pokazuje aktualnie wybrany schemat w transformacji.

Aby zmienić schemat wyjściowy, wybierz schemat z listy, kliknij prawym przyciskiem myszy i wybierz Ustaw jako aktualny.

Zmiana jakości danych

Transformacji jakości danych nie można bezpośrednio łączyć z transformacją poprzedzającą, która zawiera zagnieżdżone tabele. Aby połączyć te transformacje, należy dodać transformację zapytania lub transformację potoku XML między transformacją z tabeli zagnieżdżonej a transformacją jakości danych.

Jak wykorzystać transformację jakości danych?

Step 1 - Idź do Object Library → zakładka Transform

Step 2 - Rozwiń transformację jakości danych i dodaj konfigurację transformacji lub transformacji, którą chcesz dodać do przepływu danych.

Step 3- Narysuj połączenia przepływu danych. Kliknij dwukrotnie nazwę transformacji, aby otworzyć edytor transformacji. W schemacie wejściowym wybierz pola wejściowe, które chcesz zmapować.

Note - Aby użyć transformacji skojarzonej, możesz dodać pola zdefiniowane przez użytkownika do zakładki wprowadzania.

Przekształcenie przetwarzania danych tekstowych

Przetwarzanie danych tekstowych Transform umożliwia wyodrębnienie określonych informacji z dużej ilości tekstu. Możesz wyszukiwać fakty i jednostki, takie jak klienci, produkty i fakty finansowe, specyficzne dla organizacji.

Ta transformacja sprawdza również relacje między jednostkami i umożliwia wyodrębnienie. Dane wyodrębnione przy użyciu przetwarzania danych tekstowych mogą być wykorzystywane w Business Intelligence, raportowaniu, zapytaniach i analizach.

Transformacja wyodrębniania jednostek

W usługach danych przetwarzanie danych tekstowych odbywa się za pomocą funkcji Entity Extraction, która wyodrębnia encje i fakty z danych nieustrukturyzowanych.

Polega to na analizowaniu i przetwarzaniu dużej ilości danych tekstowych, wyszukiwaniu obiektów, przypisywaniu ich do odpowiedniego typu i prezentowaniu metadanych w standardowym formacie.

Transformacja wyodrębniania jednostek może wyodrębnić informacje z dowolnego tekstu, HTML, XML lub określonej zawartości w formacie binarnym (np. PDF) i wygenerować ustrukturyzowane dane wyjściowe. Dane wyjściowe można wykorzystać na kilka sposobów w zależności od przepływu pracy. Możesz użyć go jako danych wejściowych do innej transformacji lub zapisać do wielu źródeł wyjściowych, takich jak tabela bazy danych lub plik prosty. Dane wyjściowe są generowane w kodowaniu UTF-16.

Entity Extract Transform can be used in the following scenarios −

Wyszukiwanie określonych informacji z dużej ilości tekstu.

Znajdowanie ustrukturyzowanych informacji z nieustrukturyzowanego tekstu z istniejącymi informacjami w celu tworzenia nowych połączeń.

Raportowanie i analiza jakości produktu.

Różnice między TDP a czyszczeniem danych

Przetwarzanie danych tekstowych służy do wyszukiwania odpowiednich informacji z nieustrukturyzowanych danych tekstowych. Jednak czyszczenie danych służy do standaryzacji i czyszczenia ustrukturyzowanych danych.

| Parametry | Przetwarzanie danych tekstowych | Oczyszczanie danych |

|---|---|---|

| Typ danych wejściowych | Dane nieustrukturyzowane | Dane strukturalne |

| Rozmiar wejściowy | Więcej niż 5 KB | Mniej niż 5 KB |

| Zakres wejściowy | Szeroka domena z wieloma odmianami | Ograniczone warianty |

| Potencjalne użycie | Potencjalne znaczące informacje z nieustrukturyzowanych danych | Jakość danych do przechowywania w repozytorium |

| Wynik | Utwórz adnotacje w postaci encji, typu itp. Dane wejściowe nie są zmieniane | Utwórz standardowe pola, dane wejściowe zostaną zmienione |

Administracja usługami danych obejmuje tworzenie zadań w czasie rzeczywistym i zadań wsadowych, planowanie zadań, osadzony przepływ danych, zmienne i parametry, mechanizm odzyskiwania, profilowanie danych, dostrajanie wydajności itp.

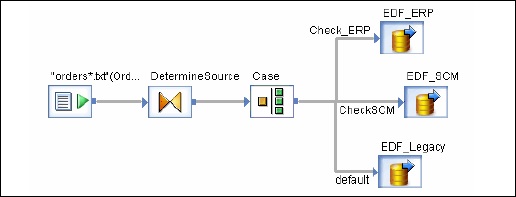

Praca w czasie rzeczywistym

Możesz tworzyć zadania czasu rzeczywistego do przetwarzania komunikatów w czasie rzeczywistym w projektancie usług danych. Podobnie jak zadanie wsadowe, zadanie w czasie rzeczywistym wyodrębnia dane, przekształca je i ładuje.

Każde zadanie w czasie rzeczywistym może wyodrębnić dane z pojedynczej wiadomości. Możesz także wyodrębniać dane z innych źródeł, takich jak tabele lub pliki.

W przeciwieństwie do zadań wsadowych, zadania w czasie rzeczywistym nie są wykonywane za pomocą wyzwalaczy. Są one wykonywane przez administratorów jako usługi czasu rzeczywistego. Usługi czasu rzeczywistego czekają na wiadomości z serwera dostępowego. Serwer dostępu odbiera tę wiadomość i przekazuje ją do usług czasu rzeczywistego, które są skonfigurowane do przetwarzania tego typu wiadomości. Usługi czasu rzeczywistego wykonują komunikat, zwracają wynik i kontynuują przetwarzanie komunikatów, dopóki nie otrzymają instrukcji zatrzymania wykonywania.

Zadania w czasie rzeczywistym a zadania wsadowe

Transformacje, takie jak gałęzie i logika sterująca, są używane częściej w zadaniach czasu rzeczywistego, co nie ma miejsca w przypadku zadań wsadowych w projektancie.

W przeciwieństwie do zadań wsadowych, zadania w czasie rzeczywistym nie są wykonywane w odpowiedzi na harmonogram lub wyzwalacz wewnętrzny.

Tworzenie prac w czasie rzeczywistym

Zadania w czasie rzeczywistym można tworzyć przy użyciu tych samych obiektów, takich jak przepływy danych, przepływy pracy, pętle, warunki, skrypty itp.

Możesz użyć następujących modeli danych do tworzenia zadań w czasie rzeczywistym -

- Pojedynczy model przepływu danych

- Model przepływu wielu danych

Pojedynczy model przepływu danych

Możesz utworzyć zadanie w czasie rzeczywistym z pojedynczym przepływem danych w jego pętli przetwarzania w czasie rzeczywistym i obejmuje jedno źródło komunikatów i pojedynczy cel komunikatu.

Creating Real Time job using single data model −

Aby utworzyć zadanie w czasie rzeczywistym przy użyciu pojedynczego modelu danych, wykonaj podane czynności.

Step 1 - Idź do Projektanta usług danych → Nowy projekt → Projekt → Wprowadź nazwę projektu

Step 2 - Kliknij prawym przyciskiem myszy białe miejsce w obszarze projektu → Nowe zadanie w czasie rzeczywistym.

Obszar roboczy pokazuje dwa składniki zadania w czasie rzeczywistym -

- RT_Process_begins

- Step_ends

Pokazuje początek i koniec pracy w czasie rzeczywistym.

Step 3 - Aby utworzyć zadanie w czasie rzeczywistym z pojedynczym przepływem danych, wybierz przepływ danych z palety narzędzi w prawym panelu i przeciągnij go do obszaru roboczego.

Kliknij wewnątrz pętli, możesz użyć jednego źródła wiadomości i jednego celu wiadomości w pętli przetwarzania w czasie rzeczywistym. Połącz znaczniki początku i końca z przepływem danych.

Step 4 - Dodaj obiekty konfiguracyjne do przepływu danych zgodnie z wymaganiami i zapisz zadanie.

Model przepływu wielu danych

Umożliwia to tworzenie zadań w czasie rzeczywistym z wieloma przepływami danych w pętli przetwarzania w czasie rzeczywistym. Musisz również upewnić się, że dane w każdym modelu danych są w pełni przetworzone, zanim przejdą do następnej wiadomości.

Testowanie zadań w czasie rzeczywistym

Możesz przetestować zadanie w czasie rzeczywistym, przekazując przykładową wiadomość jako wiadomość źródłową z pliku. Możesz sprawdzić, czy usługi danych generują oczekiwany komunikat docelowy.

Aby upewnić się, że praca przyniesie oczekiwany rezultat, możesz wykonać zadanie w trybie przeglądania danych. Korzystając z tego trybu, możesz przechwytywać dane wyjściowe, aby upewnić się, że praca w czasie rzeczywistym działa dobrze.

Wbudowane przepływy danych

Osadzony przepływ danych jest znany jako przepływy danych, które są wywoływane z innego przepływu danych w projekcie. Osadzony przepływ danych może zawierać wiele źródeł i celów, ale tylko jeden wejściowy lub wyjściowy przepływ danych do głównego przepływu danych.

Można stosować następujące typy osadzonych przepływów danych -

One Input - Osadzony przepływ danych jest dodawany na końcu przepływu danych.

One Output - Osadzony przepływ danych jest dodawany na początku przepływu danych.

No input or output - Wykonaj replikację istniejącego przepływu danych.

Osadzony przepływ danych może służyć do następujących celów -

Aby uprościć wyświetlanie przepływu danych.

Jeśli chcesz zapisać logikę przepływu i ponownie użyć jej w innych przepływach danych.

Do debugowania, w którym tworzysz sekcje przepływu danych jako osadzony przepływ danych i wykonujesz je oddzielnie.

Możesz wybrać obiekt w istniejącym przepływie danych. Istnieją dwa sposoby tworzenia osadzonego przepływu danych.

opcja 1

Kliknij prawym przyciskiem myszy obiekt i wybierz opcję Embedded Data Flow.

Opcja 2

Przeciągnij kompletny przepływ danych z biblioteki obiektów do otwartego przepływu danych w przestrzeni roboczej i sprawdź poprawność. Następnie otwórz utworzony przepływ danych. Wybierz obiekt, którego chcesz użyć jako portu wejściowego i wyjściowego, i kliknijmake port dla tego obiektu.

Usługi danych dodają ten obiekt jako punkt połączenia dla osadzonego przepływu danych.

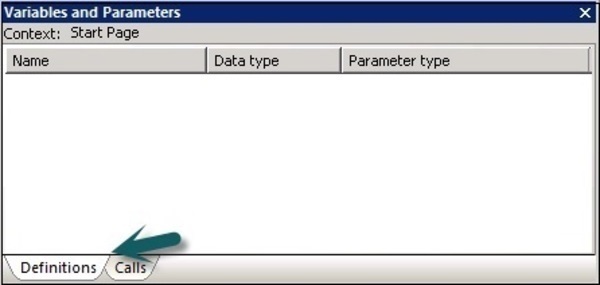

Zmienne i parametry

Możesz używać zmiennych lokalnych i globalnych z przepływem danych i przepływem pracy, co zapewnia większą elastyczność w projektowaniu zadań.

Kluczowe cechy to -

Typ danych zmiennej może być liczbą, liczbą całkowitą, dziesiętną, datą lub ciągiem tekstowym, takim jak znak.

Zmienne mogą być używane w przepływach danych i przepływach pracy jako funkcje w Where klauzula.

Zmienne lokalne w usługach danych są ograniczone do obiektu, w którym zostały utworzone.

Zmienne globalne są ograniczone do miejsc pracy, w których zostały utworzone. Używając zmiennych globalnych, możesz zmieniać wartości domyślnych zmiennych globalnych w czasie wykonywania.

Wyrażenia używane w przepływie pracy i przepływie danych są znane jako parameters.

Wszystkie zmienne i parametry w przepływie pracy i przepływach danych są wyświetlane w oknie zmiennych i parametrów.

Aby wyświetlić zmienne i parametry, wykonaj kroki podane poniżej -

Idź do Narzędzia → Zmienne.

Nowe okno Variables and parametersjest wyświetlany. Zawiera dwie zakładki - Definicje i Połączenia.

Plik Definitionszakładka umożliwia tworzenie i przeglądanie zmiennych i parametrów. Możesz używać lokalnych zmiennych i parametrów na poziomie przepływu pracy i przepływu danych. Zmienne globalne mogą być używane na poziomie zawodów.

Praca |

Zmienne lokalne Zmienne globalne |

Skrypt lub warunek w zadaniu Każdy przedmiot w pracy |

Przepływ pracy |

Zmienne lokalne Parametry |

Ten przepływ pracy lub przekazywany do innych przepływów pracy lub przepływów danych przy użyciu parametru. Obiekty nadrzędne do przekazywania zmiennych lokalnych. Przepływy pracy mogą również zwracać zmienne lub parametry do obiektów nadrzędnych. |

Przepływ danych |

Parametry |

Klauzula WHERE, mapowanie kolumn lub funkcja w przepływie danych. Przepływ danych. Przepływy danych nie mogą zwracać wartości wyjściowych. |

Na karcie wywołania możesz zobaczyć nazwę parametru zdefiniowanego dla wszystkich obiektów w definicji obiektu nadrzędnego.

Definiowanie zmiennej lokalnej

Aby zdefiniować zmienną lokalną, otwórz zadanie w czasie rzeczywistym.

Step 1- Idź do Narzędzia → Zmienne. NowyVariables and Parameters okno się otworzy.

Step 2 - Idź do Zmienna → Kliknij prawym przyciskiem myszy → Wstaw

Stworzy nowy parametr $NewVariable0.

Step 3- Wprowadź nazwę nowej zmiennej. Wybierz typ danych z listy.

Po zdefiniowaniu zamknij okno. W podobny sposób można zdefiniować parametry przepływu danych i przepływu pracy.

Jeśli zadanie nie zostanie wykonane pomyślnie, należy naprawić błąd i ponownie uruchomić zadanie. W przypadku nieudanych prac istnieje możliwość, że niektóre tabele zostały załadowane, zmienione lub częściowo załadowane. Musisz ponownie uruchomić zadanie, aby pobrać wszystkie dane i usunąć zduplikowane lub brakujące dane.

Dwie techniki, które można zastosować do odzyskiwania, są następujące:

Automatic Recovery - Pozwala to na uruchamianie nieudanych zadań w trybie odzyskiwania.

Manually Recovery - Pozwala to na ponowne uruchomienie zadań bez rozważania częściowego ponownego wykonania poprzedniego czasu.

To run a job with Recovery option enabled in Designer

Step 1 - Kliknij prawym przyciskiem myszy nazwę zadania → Wykonaj.

Step 2 - Zapisz wszystkie zmiany i Wykonaj → Tak.

Step 3- Przejdź do zakładki Wykonanie → pole wyboru Włącz odzyskiwanie. Jeśli to pole nie jest zaznaczone, usługi danych nie odzyskają zadania, jeśli się nie powiedzie.

To run a job in Recovery mode from Designer

Step 1- Kliknij prawym przyciskiem myszy i wykonaj zadanie jak powyżej. Zapisz zmiany.

Step 2- Przejdź do opcji wykonania. Musisz upewnić się, że opcjaRecover from last failed execution pole jest zaznaczone.

Note- Ta opcja nie jest włączona, jeśli zadanie nie zostało jeszcze wykonane. Jest to znane jako Automatyczne odzyskiwanie nieudanej pracy.

Projektant usług danych udostępnia funkcję profilowania danych, która zapewnia i poprawia jakość i strukturę danych źródłowych.

Data Profiler umożliwia:

Znajdź anomalie w danych źródłowych, walidację i działania naprawcze oraz jakość danych źródłowych.

Zdefiniuj strukturę i relacje danych źródłowych, aby lepiej wykonywać zadania, przepływy pracy i przepływy danych.

Znajdź zawartość systemu źródłowego i docelowego, aby określić, czy Twoje zadanie zwraca oczekiwany wynik.

Data Profiler udostępnia następujące informacje o wykonaniu serwera Profiler -

Analiza kolumnowa

Basic Profiling - Zawiera informacje, takie jak min, maks, średnia itp.

Detailed Profiling - Obejmuje informacje, takie jak odrębna liczba, odrębny procent, mediana itp.

Analiza relacji

Anomalie danych między dwiema kolumnami, dla których definiujesz relację.

Funkcji profilowania danych można używać na danych z następujących źródeł danych -

- SQL Server

- Oracle

- DB2

- Złącze Attunity

- Sybase IQ

- Teradata

Łączenie się z serwerem Profiler

Aby połączyć się z serwerem profili -

Step 1 - Idź do Narzędzia → Logowanie do serwera Profiler

Step 2 - Wprowadź szczegóły, takie jak system, nazwa użytkownika, hasło i uwierzytelnianie.

Step 3 - Kliknij Log on przycisk.

Po nawiązaniu połączenia zostanie wyświetlona lista repozytoriów profilerów. WybierzRepository i kliknij Connect.

Wydajność zadania ETL zależy od systemu, w którym używasz oprogramowania Data Services, liczby ruchów itp.

Istnieje wiele innych czynników wpływających na wydajność zadania ETL. Oni są -

Source Data Base - Źródłowa baza danych powinna być ustawiona na wykonywanie Selectoświadczenia szybko. Można to zrobić, zwiększając rozmiar operacji we / wy bazy danych, zwiększając rozmiar współużytkowanego bufora w celu buforowania większej ilości danych i uniemożliwiając równoległe tworzenie małych tabel itp.

Source Operating System- Źródłowy system operacyjny powinien być skonfigurowany do szybkiego odczytu danych z dysków. Ustaw protokół odczytu z wyprzedzeniem na 64 KB.

Target Database - Docelowa baza danych musi być skonfigurowana do działania INSERT i UPDATEszybko. Można to zrobić poprzez -

- Wyłączanie rejestrowania archiwum.

- Wyłączanie rejestrowania Ponów dla wszystkich tabel.

- Maksymalizacja rozmiaru współużytkowanego bufora.

Target Operating System- Docelowy system operacyjny musi zostać skonfigurowany, aby szybko zapisywać dane na dyskach. Możesz włączyć asynchroniczne operacje we / wy, aby operacje wejścia / wyjścia były tak szybkie, jak to tylko możliwe.

Network - Przepustowość sieci powinna być wystarczająca do przesłania danych ze źródła do systemu docelowego.

BODS Repository Database - Aby poprawić wydajność zadań BODS, można wykonać następujące czynności -