Hadoop - ภาพรวมข้อมูลขนาดใหญ่

“ ข้อมูล 90% ของโลกถูกสร้างขึ้นในช่วงไม่กี่ปีที่ผ่านมา”

เนื่องจากการถือกำเนิดของเทคโนโลยีอุปกรณ์และวิธีการสื่อสารใหม่ ๆ เช่นเว็บไซต์เครือข่ายสังคมปริมาณข้อมูลที่มนุษย์ผลิตขึ้นจึงเติบโตอย่างรวดเร็วทุกปี จำนวนข้อมูลที่ผลิตโดยเราตั้งแต่เริ่มต้นจนถึงปี 2546 คือ 5 พันล้านกิกะไบต์ หากคุณรวบรวมข้อมูลในรูปแบบของดิสก์ข้อมูลอาจเต็มสนามฟุตบอลทั้งหมด จำนวนเท่ากันถูกสร้างขึ้นในทุกๆสองวันใน2011และทุกๆสิบนาทีใน 2013. อัตรานี้ยังคงเติบโตอย่างมาก แม้ว่าข้อมูลทั้งหมดที่จัดทำขึ้นจะมีความหมายและมีประโยชน์เมื่อได้รับการประมวลผล แต่ก็ถูกละเลย

Big Data คืออะไร?

Big dataคือชุดข้อมูลขนาดใหญ่ที่ไม่สามารถประมวลผลได้โดยใช้เทคนิคการคำนวณแบบดั้งเดิม ไม่ใช่เทคนิคหรือเครื่องมือเดียว แต่กลายเป็นเรื่องที่สมบูรณ์ซึ่งเกี่ยวข้องกับเครื่องมือเทคนิคและกรอบงานต่างๆ

อะไรมาภายใต้ Big Data?

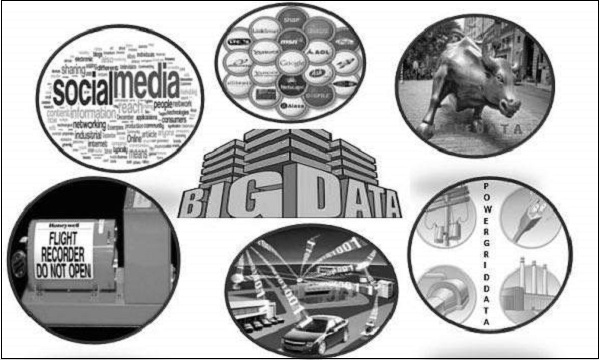

ข้อมูลขนาดใหญ่เกี่ยวข้องกับข้อมูลที่ผลิตโดยอุปกรณ์และแอปพลิเคชันต่างๆ ด้านล่างนี้คือฟิลด์บางส่วนที่อยู่ภายใต้ร่มของ Big Data

Black Box Data - เป็นส่วนประกอบของเฮลิคอปเตอร์เครื่องบินและเครื่องบินไอพ่น ฯลฯ โดยจะบันทึกเสียงของลูกเรือการบินการบันทึกไมโครโฟนและหูฟังและข้อมูลประสิทธิภาพของเครื่องบิน

Social Media Data - โซเชียลมีเดียเช่น Facebook และ Twitter เก็บข้อมูลและมุมมองที่โพสต์โดยผู้คนนับล้านทั่วโลก

Stock Exchange Data - ข้อมูลตลาดหลักทรัพย์มีข้อมูลเกี่ยวกับการตัดสินใจ 'ซื้อ' และ 'ขาย' ที่เกิดจากการแบ่งปันของ บริษัท ต่างๆที่ทำโดยลูกค้า

Power Grid Data - ข้อมูลกริดพลังงานเก็บข้อมูลที่ใช้โดยโหนดเฉพาะที่เกี่ยวกับสถานีฐาน

Transport Data - ข้อมูลการขนส่งรวมถึงรุ่นความจุระยะทางและความพร้อมของยานพาหนะ

Search Engine Data - เครื่องมือค้นหาดึงข้อมูลจำนวนมากจากฐานข้อมูลต่างๆ

ดังนั้นข้อมูลขนาดใหญ่จึงมีข้อมูลจำนวนมากความเร็วสูงและข้อมูลที่หลากหลายที่ขยายได้ ข้อมูลในนั้นจะเป็นสามประเภท

Structured data - ข้อมูลเชิงสัมพันธ์

Semi Structured data - ข้อมูล XML

Unstructured data - Word, PDF, ข้อความ, บันทึกสื่อ

ประโยชน์ของข้อมูลขนาดใหญ่

การใช้ข้อมูลที่เก็บไว้ในเครือข่ายโซเชียลเช่น Facebook หน่วยงานการตลาดกำลังเรียนรู้เกี่ยวกับการตอบสนองสำหรับแคมเปญโปรโมชั่นและสื่อโฆษณาอื่น ๆ

การใช้ข้อมูลในโซเชียลมีเดียเช่นความชอบและการรับรู้ผลิตภัณฑ์ของผู้บริโภค บริษัท ผลิตภัณฑ์และองค์กรค้าปลีกกำลังวางแผนการผลิต

การใช้ข้อมูลเกี่ยวกับประวัติทางการแพทย์ของผู้ป่วยก่อนหน้านี้โรงพยาบาลจะให้บริการที่ดีขึ้นและรวดเร็ว

เทคโนโลยีข้อมูลขนาดใหญ่

เทคโนโลยีข้อมูลขนาดใหญ่มีความสำคัญในการให้การวิเคราะห์ที่แม่นยำยิ่งขึ้นซึ่งอาจนำไปสู่การตัดสินใจที่เป็นรูปธรรมมากขึ้นซึ่งส่งผลให้ประสิทธิภาพในการดำเนินงานดีขึ้นลดต้นทุนและลดความเสี่ยงสำหรับธุรกิจ

ในการควบคุมพลังของข้อมูลขนาดใหญ่คุณจะต้องมีโครงสร้างพื้นฐานที่สามารถจัดการและประมวลผลข้อมูลที่มีโครงสร้างและไม่มีโครงสร้างจำนวนมหาศาลได้แบบเรียลไทม์และสามารถปกป้องความเป็นส่วนตัวและความปลอดภัยของข้อมูลได้

มีเทคโนโลยีต่างๆในตลาดจากผู้ขายที่แตกต่างกันเช่น Amazon, IBM, Microsoft และอื่น ๆ เพื่อจัดการกับข้อมูลขนาดใหญ่ ในขณะที่พิจารณาเทคโนโลยีที่จัดการข้อมูลขนาดใหญ่เราจะตรวจสอบเทคโนโลยีสองประเภทต่อไปนี้ -

ข้อมูลขนาดใหญ่เชิงปฏิบัติการ

ซึ่งรวมถึงระบบต่างๆเช่น MongoDB ที่ให้ความสามารถในการดำเนินงานสำหรับปริมาณงานแบบโต้ตอบแบบเรียลไทม์ซึ่งข้อมูลจะถูกบันทึกและจัดเก็บเป็นหลัก

ระบบ NoSQL Big Data ได้รับการออกแบบมาเพื่อใช้ประโยชน์จากสถาปัตยกรรมการประมวลผลแบบคลาวด์ใหม่ที่เกิดขึ้นในช่วงทศวรรษที่ผ่านมาเพื่อให้การประมวลผลจำนวนมากทำงานได้ในราคาประหยัดและมีประสิทธิภาพ ทำให้ปริมาณงานข้อมูลขนาดใหญ่ในการดำเนินงานง่ายต่อการจัดการมากขึ้นถูกลงและดำเนินการได้เร็วขึ้น

ระบบ NoSQL บางระบบสามารถให้ข้อมูลเชิงลึกเกี่ยวกับรูปแบบและแนวโน้มตามข้อมูลแบบเรียลไทม์โดยมีการเข้ารหัสน้อยที่สุดและไม่จำเป็นต้องใช้นักวิทยาศาสตร์ข้อมูลและโครงสร้างพื้นฐานเพิ่มเติม

ข้อมูลขนาดใหญ่เชิงวิเคราะห์

ซึ่งรวมถึงระบบต่างๆเช่นระบบฐานข้อมูล Massively Parallel Processing (MPP) และ MapReduce ที่ให้ความสามารถในการวิเคราะห์สำหรับการวิเคราะห์ย้อนหลังและการวิเคราะห์ที่ซับซ้อนซึ่งอาจสัมผัสข้อมูลส่วนใหญ่หรือทั้งหมด

MapReduce นำเสนอวิธีการใหม่ในการวิเคราะห์ข้อมูลที่เสริมกับความสามารถที่จัดเตรียมโดย SQL และระบบที่ใช้ MapReduce ซึ่งสามารถปรับขนาดได้จากเซิร์ฟเวอร์เครื่องเดียวไปจนถึงเครื่องระดับสูงและระดับต่ำหลายพันเครื่อง

เทคโนโลยีทั้งสองประเภทนี้เสริมและนำมาใช้งานร่วมกันบ่อยครั้ง

ระบบปฏิบัติการเทียบกับระบบวิเคราะห์

| ปฏิบัติการ | เชิงวิเคราะห์ | |

|---|---|---|

| เวลาแฝง | 1 มิลลิวินาที - 100 มิลลิวินาที | 1 นาที - 100 นาที |

| ภาวะพร้อมกัน | 1,000 - 100,000 | 1 - 10 |

| รูปแบบการเข้าถึง | การเขียนและการอ่าน | อ่าน |

| แบบสอบถาม | เลือก | ไม่เลือก |

| ขอบเขตข้อมูล | ปฏิบัติการ | ย้อนหลัง |

| ผู้ใช้ | ลูกค้า | นักวิทยาศาสตร์ข้อมูล |

| เทคโนโลยี | NoSQL | MapReduce ฐานข้อมูล MPP |

ความท้าทายของข้อมูลขนาดใหญ่

ความท้าทายที่สำคัญที่เกี่ยวข้องกับข้อมูลขนาดใหญ่มีดังนี้ -

- การจับข้อมูล

- Curation

- Storage

- Searching

- Sharing

- Transfer

- Analysis

- Presentation

เพื่อตอบสนองความท้าทายข้างต้นโดยปกติองค์กรต่างๆจะต้องใช้ความช่วยเหลือจากเซิร์ฟเวอร์ขององค์กร