SAP BODS - คู่มือฉบับย่อ

คลังข้อมูลเรียกว่าที่เก็บกลางเพื่อจัดเก็บข้อมูลจากแหล่งข้อมูลที่แตกต่างกันหนึ่งหรือหลายแหล่ง คลังข้อมูลใช้สำหรับการรายงานและวิเคราะห์ข้อมูลและจัดเก็บข้อมูลทั้งในอดีตและปัจจุบัน ข้อมูลในระบบ DW ใช้สำหรับการรายงานเชิงวิเคราะห์ซึ่งต่อมานักวิเคราะห์ธุรกิจผู้จัดการฝ่ายขายหรือผู้มีความรู้จะใช้ในการตัดสินใจ

ข้อมูลในระบบ DW ถูกโหลดจากระบบธุรกรรมเชิงปฏิบัติการเช่นการขายการตลาด HR SCM เป็นต้นซึ่งอาจผ่านการจัดเก็บข้อมูลการปฏิบัติงานหรือการเปลี่ยนแปลงอื่น ๆ ก่อนที่จะโหลดไปยังระบบ DW เพื่อประมวลผลข้อมูล

คลังข้อมูล - คุณสมบัติหลัก

คุณสมบัติที่สำคัญของ DW System คือ -

เป็นที่เก็บข้อมูลส่วนกลางที่จัดเก็บข้อมูลจากแหล่งข้อมูลที่แตกต่างกันอย่างน้อยหนึ่งแหล่ง

ระบบ DW เก็บข้อมูลทั้งในปัจจุบันและในอดีต โดยปกติระบบ DW จะเก็บข้อมูลย้อนหลัง 5-10 ปี

ระบบ DW จะแยกออกจากระบบธุรกรรมด้านปฏิบัติการเสมอ

ข้อมูลในระบบ DW ใช้สำหรับการรายงานเชิงวิเคราะห์ประเภทต่างๆตั้งแต่การเปรียบเทียบรายไตรมาสไปจนถึงการเปรียบเทียบรายปี

ต้องการระบบ DW

สมมติว่าคุณมีหน่วยงานสินเชื่อบ้านที่ข้อมูลมาจากแอปพลิเคชั่นต่างๆเช่นการตลาดการขาย ERP HRM MM เป็นต้นข้อมูลนี้จะถูกแยกแปลงและโหลดในคลังข้อมูล

ตัวอย่างเช่นหากคุณต้องเปรียบเทียบยอดขายรายไตรมาส / รายปีของผลิตภัณฑ์คุณไม่สามารถใช้ฐานข้อมูลธุรกรรมเชิงปฏิบัติการได้เนื่องจากจะทำให้ระบบธุรกรรมค้าง ดังนั้นคลังข้อมูลจึงถูกใช้เพื่อจุดประสงค์นี้

ความแตกต่างระหว่าง DW และ ODB

ความแตกต่างระหว่างคลังข้อมูลและฐานข้อมูลเชิงปฏิบัติการ (ฐานข้อมูลธุรกรรม) มีดังนี้ -

ระบบธุรกรรมได้รับการออกแบบมาสำหรับปริมาณงานและธุรกรรมที่เป็นที่รู้จักเช่นการอัปเดตเรกคอร์ดผู้ใช้การค้นหาเรกคอร์ดเป็นต้นอย่างไรก็ตามธุรกรรมคลังข้อมูลมีความซับซ้อนมากขึ้นและนำเสนอรูปแบบข้อมูลทั่วไป

ระบบธุรกรรมมีข้อมูลปัจจุบันขององค์กรและคลังข้อมูลโดยปกติจะมีข้อมูลประวัติ

ระบบธุรกรรมรองรับการประมวลผลแบบขนานของธุรกรรมหลายรายการ จำเป็นต้องมีกลไกการควบคุมและการกู้คืนพร้อมกันเพื่อรักษาความสอดคล้องของฐานข้อมูล

แบบสอบถามฐานข้อมูลการดำเนินงานอนุญาตให้อ่านและแก้ไขการดำเนินการ (ลบและอัปเดต) ในขณะที่แบบสอบถาม OLAP ต้องการการเข้าถึงข้อมูลที่จัดเก็บแบบอ่านอย่างเดียว (เลือกคำสั่ง)

สถาปัตยกรรม DW

Data Warehousing เกี่ยวข้องกับการล้างข้อมูลการรวมข้อมูลและการรวมข้อมูล

คลังข้อมูลมีสถาปัตยกรรม 3 ชั้น - Data Source Layer, Integration Layer, และ Presentation Layer. ภาพประกอบด้านบนแสดงสถาปัตยกรรมทั่วไปของระบบคลังข้อมูล

ระบบคลังข้อมูลมีสี่ประเภท

- ข้อมูลมาร์ท

- การประมวลผลเชิงวิเคราะห์ออนไลน์ (OLAP)

- การประมวลผลธุรกรรมออนไลน์ (OLTP)

- การวิเคราะห์เชิงคาดการณ์ (PA)

ข้อมูลมาร์ท

Data Mart เรียกได้ว่าเป็นรูปแบบที่ง่ายที่สุดของระบบคลังข้อมูลและโดยปกติจะประกอบด้วยพื้นที่การทำงานเดียวในองค์กรเช่นการขายการเงินหรือการตลาดเป็นต้น

Data Mart ในองค์กรและสร้างและจัดการโดยแผนกเดียว เนื่องจากเป็นของแผนกเดียวแผนกมักจะได้รับข้อมูลจากแหล่งที่มา / แอปพลิเคชันเพียงไม่กี่ประเภทหรือหนึ่งประเภท แหล่งข้อมูลนี้อาจเป็นระบบปฏิบัติการภายในคลังข้อมูลหรือระบบภายนอก

การประมวลผลวิเคราะห์ออนไลน์

ในระบบ OLAP มีจำนวนธุรกรรมน้อยกว่าเมื่อเทียบกับระบบธุรกรรม คำค้นหาที่ดำเนินการมีลักษณะซับซ้อนและเกี่ยวข้องกับการรวมข้อมูล

Aggregation คืออะไร?

เราบันทึกตารางที่มีข้อมูลรวมเช่นรายปี (1 แถว) รายไตรมาส (4 แถว) รายเดือน (12 แถว) หรือมากกว่านั้นหากมีคนต้องทำการเปรียบเทียบแบบปีต่อปีจะมีการประมวลผลเพียงแถวเดียว อย่างไรก็ตามในตารางที่ไม่ได้รวมจะเปรียบเทียบแถวทั้งหมด

SELECT SUM(salary)

FROM employee

WHERE title = 'Programmer';มาตรการที่มีประสิทธิภาพในระบบ OLAP

เวลาตอบสนองเป็นหนึ่งในมาตรการที่มีประสิทธิภาพและสำคัญที่สุดใน OLAPระบบ. ข้อมูลที่จัดเก็บโดยรวมจะถูกเก็บรักษาไว้ในสคีมาหลายมิติเช่นสคีมาสตาร์ (เมื่อข้อมูลถูกจัดเรียงเป็นกลุ่มตามลำดับชั้นมักเรียกว่ามิติข้อมูลและเป็นข้อเท็จจริงและข้อเท็จจริงรวมเรียกว่า Schemas

เวลาในการตอบสนองของระบบ OLAP อยู่ที่ไม่กี่ชั่วโมงเมื่อเทียบกับมาร์ทข้อมูลที่คาดว่าเวลาแฝงจะใกล้เคียงกับหนึ่งวัน

การประมวลผลธุรกรรมออนไลน์

ในระบบ OLTP มีธุรกรรมออนไลน์สั้น ๆ จำนวนมากเช่น INSERT, UPDATE และ DELETE

ในระบบ OLTP มาตรการที่มีประสิทธิภาพคือเวลาในการประมวลผลของธุรกรรมสั้น ๆ และน้อยกว่ามาก ควบคุมความสมบูรณ์ของข้อมูลในสภาพแวดล้อมแบบหลายการเข้าถึง สำหรับระบบ OLTP จำนวนธุรกรรมต่อวินาทีจะวัดค่าeffectiveness. ระบบคลังข้อมูล OLTP ประกอบด้วยข้อมูลปัจจุบันและรายละเอียดและได้รับการดูแลใน schemas ในรูปแบบเอนทิตี (3NF)

ตัวอย่าง

ระบบการทำธุรกรรมแบบวันต่อวันในร้านค้าปลีกที่มีการแทรกบันทึกของลูกค้าอัปเดตและลบในแต่ละวัน ให้การประมวลผลแบบสอบถามที่รวดเร็วมาก ฐานข้อมูล OLTP ประกอบด้วยข้อมูลรายละเอียดและข้อมูลปัจจุบัน สคีมาที่ใช้ในการจัดเก็บฐานข้อมูล OLTP คือโมเดลเอนทิตี

ความแตกต่างระหว่าง OLTP และ OLAP

ภาพประกอบต่อไปนี้แสดงความแตกต่างที่สำคัญระหว่างไฟล์ OLTP และ OLAP ระบบ.

Indexes - ระบบ OLTP มีดัชนีเพียงไม่กี่รายการในขณะที่ในระบบ OLAP มีดัชนีมากมายสำหรับการเพิ่มประสิทธิภาพ

Joins- ในระบบ OLTP การรวมและข้อมูลจำนวนมากจะถูกทำให้เป็นมาตรฐาน อย่างไรก็ตามในระบบ OLAP มีการรวมน้อยและถูกยกเลิกการทำให้เป็นมาตรฐาน

Aggregation - ในระบบ OLTP ข้อมูลจะไม่ถูกรวมในขณะที่อยู่ในฐานข้อมูล OLAP จะใช้การรวมมากกว่า

การวิเคราะห์เชิงคาดการณ์

การวิเคราะห์เชิงทำนายเรียกว่าการค้นหารูปแบบที่ซ่อนอยู่ในข้อมูลที่จัดเก็บในระบบ DW โดยใช้ฟังก์ชันทางคณิตศาสตร์ที่แตกต่างกันเพื่อทำนายผลลัพธ์ในอนาคต

ระบบ Predictive Analysis แตกต่างจากระบบ OLAP ในแง่ของการใช้งาน ใช้เพื่อมุ่งเน้นไปที่ผลลัพธ์ในอนาคต ระบบ OALP มุ่งเน้นไปที่การประมวลผลข้อมูลในปัจจุบันและในอดีตสำหรับการรายงานเชิงวิเคราะห์

มีคลังข้อมูล / ระบบฐานข้อมูลมากมายในตลาดที่ตรงตามความสามารถของระบบ DW ผู้ขายที่พบมากที่สุดสำหรับระบบคลังข้อมูล ได้แก่ -

- Microsoft SQL Server

- Oracle Exadata

- IBM Netezza

- Teradata

- Sybase IQ

- SAP Business Warehouse (SAP BW)

SAP Business Warehouse

SAP Business Warehouseเป็นส่วนหนึ่งของแพลตฟอร์มการเผยแพร่ SAP NetWeaver ก่อนหน้า NetWeaver 7.4 จะเรียกว่า SAP NetWeaver Business Warehouse

คลังข้อมูลใน SAP BW หมายถึงการรวมข้อมูลการแปลงการล้างข้อมูลการจัดเก็บและการจัดเตรียมข้อมูล กระบวนการ DW รวมถึงการสร้างแบบจำลองข้อมูลในระบบ BW การจัดเตรียมและการดูแลระบบ เครื่องมือหลักซึ่งใช้ในการจัดการงาน DW ในระบบ BW คือ workbench การดูแลระบบ

คุณสมบัติหลัก

SAP BW มีความสามารถเช่น Business Intelligence ซึ่งรวมถึงบริการเชิงวิเคราะห์และการวางแผนธุรกิจการรายงานเชิงวิเคราะห์การประมวลผลแบบสอบถามและข้อมูลและคลังข้อมูลขององค์กร

ประกอบด้วยฐานข้อมูลและเครื่องมือการจัดการฐานข้อมูลที่ช่วยในการตัดสินใจ

คุณสมบัติหลักอื่น ๆ ของระบบ BW ได้แก่ Business Application Programming Interface (BAPI) ที่รองรับการเชื่อมต่อกับแอปพลิเคชันที่ไม่ใช่ SAP R / 3, การแยกและโหลดข้อมูลอัตโนมัติ, ตัวประมวลผล OLAP ในตัว, ที่เก็บข้อมูลเมตา, เครื่องมือการดูแลระบบ, การสนับสนุนหลายภาษาและ a อินเตอร์เฟซที่เปิดใช้งานเว็บ

SAP BW เปิดตัวครั้งแรกในปี 2541 โดย SAP บริษัท สัญชาติเยอรมัน ระบบ SAP BW เป็นไปตามแนวทางที่ขับเคลื่อนด้วยโมเดลเพื่อทำให้ Enterprise Data Warehouse เป็นเรื่องง่ายเรียบง่ายและมีประสิทธิภาพมากขึ้นสำหรับข้อมูล SAP R3

จาก 16 ปีที่ผ่านมา SAP BW ได้พัฒนาเป็นหนึ่งในระบบสำคัญสำหรับหลาย ๆ บริษัท ในการจัดการความต้องการคลังข้อมูลขององค์กร

Business Explorer (BEx) ให้ตัวเลือกสำหรับการรายงานที่ยืดหยุ่นการวิเคราะห์เชิงกลยุทธ์และการรายงานเชิงปฏิบัติการใน บริษัท

ใช้ในการทำรายงานการดำเนินการสืบค้นและการวิเคราะห์ในระบบ BI คุณยังสามารถประมวลผลข้อมูลปัจจุบันและข้อมูลในอดีตได้ถึงระดับต่างๆของรายละเอียดบนเว็บและในรูปแบบ Excel

การใช้ BEx การกระจายข้อมูลเนื้อหา BI สามารถแชร์ผ่านอีเมลเป็นเอกสารหรือในรูปแบบของลิงก์เป็นข้อมูลสดหรือคุณสามารถเผยแพร่โดยใช้ฟังก์ชัน SAP EP

วัตถุและผลิตภัณฑ์ทางธุรกิจ

SAP Business Objects หรือที่เรียกว่าเครื่องมือ Business Intelligence ที่ใช้กันทั่วไปและใช้สำหรับจัดการข้อมูลการเข้าถึงของผู้ใช้การวิเคราะห์การจัดรูปแบบและการเผยแพร่ข้อมูลบนแพลตฟอร์มต่างๆ เป็นชุดเครื่องมือแบบฟรอนต์เอนด์ซึ่งช่วยให้ผู้ใช้ทางธุรกิจและผู้มีอำนาจตัดสินใจสามารถแสดงจัดเรียงและวิเคราะห์ข้อมูลทางธุรกิจในปัจจุบันและในอดีตได้

ประกอบด้วยเครื่องมือดังต่อไปนี้ -

Web Intelligence

Web Intelligence (WebI) เรียกว่าเป็นเครื่องมือการรายงานโดยละเอียดของ Business Objects ที่ใช้กันทั่วไปซึ่งสนับสนุนคุณสมบัติต่างๆของการวิเคราะห์ข้อมูลเช่นการเจาะลึกลำดับชั้นแผนภูมิการวัดจากการคำนวณเป็นต้นช่วยให้ผู้ใช้ปลายทางสามารถสร้างแบบสอบถามเฉพาะกิจในแผงแบบสอบถามและ เพื่อทำการวิเคราะห์ข้อมูลทั้งออนไลน์และออฟไลน์

SAP Business Objects Xcelsius / Dashboards

แดชบอร์ดให้การแสดงข้อมูลและความสามารถในการแดชบอร์ดแก่ผู้ใช้ปลายทางและคุณสามารถสร้างแดชบอร์ดแบบโต้ตอบได้โดยใช้เครื่องมือนี้

คุณยังสามารถเพิ่มแผนภูมิและกราฟประเภทต่างๆและสร้างแดชบอร์ดแบบไดนามิกสำหรับการแสดงข้อมูลได้และส่วนใหญ่จะใช้ในการประชุมทางการเงินในองค์กร

รายงานคริสตัล

Crystal Reports ใช้สำหรับการรายงานแบบพิกเซล สิ่งนี้ช่วยให้ผู้ใช้สามารถสร้างและออกแบบรายงานและใช้ในภายหลังเพื่อวัตถุประสงค์ในการพิมพ์

สำรวจ

Explorer อนุญาตให้ผู้ใช้ค้นหาเนื้อหาในที่เก็บ BI และการจับคู่ที่ดีที่สุดจะแสดงในรูปแบบของแผนภูมิ ไม่จำเป็นต้องจดข้อความค้นหาเพื่อทำการค้นหา

ส่วนประกอบและเครื่องมืออื่น ๆ อีกมากมายที่นำมาใช้สำหรับการรายงานโดยละเอียดการแสดงข้อมูลและจุดประสงค์ในการแดชบอร์ด ได้แก่ Design Studio, Analysis edition for Microsoft Office, BI Repository และ Business Objects Mobile platform

ETL ย่อมาจาก Extract, Transform and Load เครื่องมือ ETL จะดึงข้อมูลจากระบบต้นทาง RDBMS ที่แตกต่างกันแปลงข้อมูลเช่นใช้การคำนวณเชื่อมต่อ ฯลฯ แล้วโหลดข้อมูลไปยังระบบคลังข้อมูล ข้อมูลถูกโหลดในระบบ DW ในรูปแบบของตารางมิติข้อมูลและข้อเท็จจริง

การสกัด

ต้องมีพื้นที่จัดเตรียมระหว่างการโหลด ETL มีสาเหตุหลายประการที่ต้องใช้พื้นที่การจัดเตรียม

ระบบต้นทางจะพร้อมใช้งานในช่วงเวลาหนึ่งเท่านั้นในการดึงข้อมูล ช่วงเวลานี้น้อยกว่าเวลาโหลดข้อมูลทั้งหมด ดังนั้นพื้นที่จัดเตรียมช่วยให้คุณสามารถดึงข้อมูลจากระบบต้นทางและเก็บไว้ในพื้นที่การจัดเตรียมก่อนที่ช่วงเวลาจะสิ้นสุดลง

พื้นที่การจัดเตรียมเป็นสิ่งจำเป็นเมื่อคุณต้องการรับข้อมูลจากแหล่งข้อมูลหลายแหล่งเข้าด้วยกันหรือหากคุณต้องการรวมระบบสองระบบขึ้นไปเข้าด้วยกัน ตัวอย่างเช่นคุณจะไม่สามารถดำเนินการสืบค้น SQL ร่วมสองตารางจากฐานข้อมูลที่แตกต่างกันทางกายภาพสองฐานข้อมูล

ช่วงเวลาการสกัดข้อมูลสำหรับระบบต่างๆจะแตกต่างกันไปตามเขตเวลาและเวลาทำการ

ข้อมูลที่ดึงมาจากระบบต้นทางสามารถใช้ในระบบคลังข้อมูลหลายที่เก็บข้อมูลการดำเนินงาน ฯลฯ

ETL ช่วยให้คุณทำการแปลงที่ซับซ้อนและต้องการพื้นที่พิเศษในการจัดเก็บข้อมูล

แปลง

ในการแปลงข้อมูลคุณใช้ชุดของฟังก์ชันกับข้อมูลที่แยกแล้วเพื่อโหลดลงในระบบเป้าหมาย ข้อมูลซึ่งไม่ต้องการการเปลี่ยนแปลงใด ๆ เรียกว่าการเคลื่อนย้ายโดยตรงหรือส่งผ่านข้อมูล

คุณสามารถใช้การแปลงต่างๆกับข้อมูลที่แยกจากระบบต้นทางได้ ตัวอย่างเช่นคุณสามารถทำการคำนวณแบบกำหนดเองได้ หากคุณต้องการรายได้รวมจากการขายและไม่ได้อยู่ในฐานข้อมูลคุณสามารถใช้ไฟล์SUM สูตรระหว่างการแปลงและโหลดข้อมูล

ตัวอย่างเช่นหากคุณมีชื่อจริงและนามสกุลในตารางในคอลัมน์อื่นคุณสามารถใช้การเรียงต่อกันก่อนที่จะโหลด

โหลด

ในระหว่างโหลดเฟสข้อมูลจะถูกโหลดลงในระบบปลายทางและอาจเป็นไฟล์แบบแบนหรือระบบคลังข้อมูล

SAP BO Data Services เป็นเครื่องมือ ETL ที่ใช้สำหรับการรวมข้อมูลคุณภาพข้อมูลการทำโปรไฟล์ข้อมูลและการประมวลผลข้อมูล ช่วยให้คุณสามารถรวมเปลี่ยนระบบคลังข้อมูลเป็นข้อมูลที่เชื่อถือได้สำหรับการรายงานเชิงวิเคราะห์

BO Data Services ประกอบด้วยอินเทอร์เฟซการพัฒนา UI ที่เก็บข้อมูลเมตาการเชื่อมต่อข้อมูลกับระบบต้นทางและเป้าหมายและคอนโซลการจัดการสำหรับการจัดกำหนดการงาน

การรวมข้อมูลและการจัดการข้อมูล

SAP BO Data Services เป็นเครื่องมือการรวมและการจัดการข้อมูลและประกอบด้วย Data Integrator Job Server และ Data Integrator Designer

คุณสมบัติหลัก

คุณสามารถใช้การแปลงข้อมูลต่างๆโดยใช้ภาษา Data Integrator เพื่อใช้การแปลงข้อมูลที่ซับซ้อนและสร้างฟังก์ชันที่กำหนดเองได้

Data Integrator Designer ใช้เพื่อจัดเก็บงานแบบเรียลไทม์และชุดงานและโครงการใหม่ในที่เก็บ

DI Designer ยังมีตัวเลือกสำหรับการพัฒนา ETL แบบทีมโดยการจัดเตรียมที่เก็บส่วนกลางพร้อมฟังก์ชันพื้นฐานทั้งหมด

เซิร์ฟเวอร์งาน Data Integrator รับผิดชอบในการประมวลผลงานที่สร้างโดยใช้ DI Designer

ผู้ดูแลเว็บ

ผู้ดูแลระบบเว็บ Data Integrator ถูกใช้โดยผู้ดูแลระบบและผู้ดูแลระบบฐานข้อมูลเพื่อดูแลที่เก็บข้อมูลในบริการข้อมูล Data Services ประกอบด้วย Metadata Repository, Central Repository สำหรับการพัฒนาโดยใช้ทีมงาน Job Server และ Web Services

หน้าที่หลักของ DI Web Administrator

- ใช้เพื่อกำหนดเวลาตรวจสอบและดำเนินการงานชุดงาน

- ใช้สำหรับการกำหนดค่าและเริ่มและหยุดเซิร์ฟเวอร์แบบเรียลไทม์

- ใช้สำหรับกำหนดค่า Job Server, Access Server และการใช้งานที่เก็บ

- ใช้สำหรับกำหนดค่าอะแด็ปเตอร์

- ใช้สำหรับกำหนดค่าและควบคุมเครื่องมือทั้งหมดใน BO Data Services

ฟังก์ชันการจัดการข้อมูลเน้นคุณภาพของข้อมูล มันเกี่ยวข้องกับการล้างข้อมูลปรับปรุงและรวบรวมข้อมูลเพื่อให้ได้ข้อมูลที่ถูกต้องในระบบ DW

ในบทนี้เราจะเรียนรู้เกี่ยวกับสถาปัตยกรรม SAP BODS ภาพประกอบแสดงสถาปัตยกรรมของระบบ BODS พร้อมพื้นที่ Staging

ซอร์สเลเยอร์

ซอร์สเลเยอร์ประกอบด้วยแหล่งข้อมูลที่แตกต่างกันเช่นแอปพลิเคชัน SAP และระบบที่ไม่ใช่ SAP RDBMS และการรวมข้อมูลจะเกิดขึ้นในพื้นที่จัดเตรียม

SAP Business Objects Data Services มีส่วนประกอบที่แตกต่างกันเช่น Data Service Designer, Data Services Management Console, Repository Manager, Data Services Server Manager, Work bench ฯลฯ ระบบเป้าหมายสามารถเป็นระบบ DW เช่น SAP HANA, SAP BW หรือไม่ใช่ SAP ระบบคลังข้อมูล.

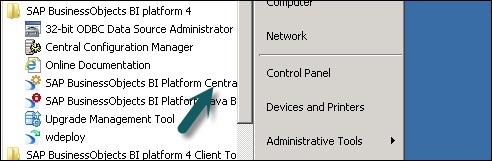

ภาพหน้าจอต่อไปนี้แสดงส่วนประกอบต่างๆของ SAP BODS

คุณยังสามารถแบ่งสถาปัตยกรรม BODS ในเลเยอร์ต่อไปนี้ -

- Web Application Layer

- ชั้นเซิร์ฟเวอร์ฐานข้อมูล

- ชั้นบริการข้อมูล

ภาพประกอบต่อไปนี้แสดงสถาปัตยกรรม BODS

วิวัฒนาการของผลิตภัณฑ์ - ATL, DI & DQ

Acta Technology Inc. พัฒนา SAP Business Objects Data Services และต่อมา บริษัท Business Objects ได้เข้าซื้อกิจการ Acta Technology Inc. เป็น บริษัท ในสหรัฐอเมริกาและรับผิดชอบในการพัฒนาแพลตฟอร์มการรวมข้อมูลครั้งแรก ผลิตภัณฑ์ซอฟต์แวร์ ETL สองตัวที่พัฒนาโดย Acta Inc. คือData Integration (DI) เครื่องมือและ Data Management หรือ Data Quality (DQ) เครื่องมือ.

Business Objects บริษัท ฝรั่งเศสเข้าซื้อกิจการ Acta Technology Inc. ในปี 2545 และต่อมาผลิตภัณฑ์ทั้งสองเปลี่ยนชื่อเป็น Business Objects Data Integration (BODI) เครื่องมือและ Business Objects Data Quality (BODQ) เครื่องมือ.

SAP ซื้อ Business Objects ในปี 2550 และทั้งสองผลิตภัณฑ์ถูกเปลี่ยนชื่อเป็น SAP BODI และ SAP BODQ ในปี 2008 SAP ได้รวมผลิตภัณฑ์ทั้งสองไว้ในผลิตภัณฑ์ซอฟต์แวร์เดียวที่ชื่อว่า SAP Business Objects Data Services (BODS)

SAP BODS มีโซลูชันการรวมข้อมูลและการจัดการข้อมูลและใน BODS เวอร์ชันก่อนหน้านี้ได้รวมโซลูชันการประมวลผลข้อมูลแบบข้อความ

BODS - วัตถุ

เรียกเอนทิตีทั้งหมดที่ใช้ใน BO Data Services Designer Objects. อ็อบเจ็กต์ทั้งหมดเช่นโปรเจ็กต์งานข้อมูลเมตาและฟังก์ชันระบบจะถูกเก็บไว้ในไลบรารีอ็อบเจ็กต์โลคัล วัตถุทั้งหมดมีลำดับชั้นตามธรรมชาติ

วัตถุส่วนใหญ่ประกอบด้วยสิ่งต่อไปนี้ -

Properties- ใช้เพื่ออธิบายวัตถุและไม่มีผลต่อการทำงานของวัตถุ ตัวอย่าง - ชื่อวัตถุวันที่สร้าง ฯลฯ

Options - ซึ่งควบคุมการทำงานของวัตถุ

ประเภทของวัตถุ

อ็อบเจ็กต์ในระบบมีสองประเภท ได้แก่ อ็อบเจ็กต์ที่ใช้ซ้ำได้และอ็อบเจ็กต์แบบใช้ครั้งเดียว ประเภทของอ็อบเจ็กต์จะกำหนดวิธีการใช้และการดึงอ็อบเจ็กต์นั้น

วัตถุที่ใช้ซ้ำได้

อ็อบเจ็กต์ส่วนใหญ่ที่เก็บไว้ในที่เก็บสามารถใช้ซ้ำได้ เมื่ออ็อบเจ็กต์ที่ใช้ซ้ำได้ถูกกำหนดและบันทึกไว้ในที่เก็บโลคัลคุณสามารถใช้อ็อบเจ็กต์ซ้ำได้โดยการสร้าง Calls to the definition แต่ละออบเจ็กต์ที่ใช้ซ้ำได้มีเพียงหนึ่งนิยามและการเรียกใช้อ็อบเจ็กต์นั้นอ้างถึงนิยามนั้น ตอนนี้ถ้าคำจำกัดความของวัตถุมีการเปลี่ยนแปลงในที่เดียวคุณกำลังเปลี่ยนนิยามของวัตถุในทุกตำแหน่งที่วัตถุนั้นปรากฏขึ้น

ไลบรารีอ็อบเจ็กต์ใช้เพื่อบรรจุนิยามอ็อบเจ็กต์และเมื่ออ็อบเจ็กต์ถูกลากและหลุดจากไลบรารีการอ้างอิงใหม่ไปยังอ็อบเจ็กต์ที่มีอยู่จะถูกสร้างขึ้น

วัตถุแบบใช้ครั้งเดียว

อ็อบเจ็กต์ทั้งหมดที่กำหนดโดยเฉพาะสำหรับงานหรือโฟลว์ข้อมูลเรียกว่าอ็อบเจ็กต์แบบใช้ครั้งเดียว ตัวอย่างเช่นการแปลงเฉพาะที่ใช้ในการโหลดข้อมูลใด ๆ

BODS - ลำดับชั้นของวัตถุ

วัตถุทั้งหมดมีลำดับชั้นตามธรรมชาติ แผนภาพต่อไปนี้แสดงลำดับชั้นของวัตถุในระบบ SAP BODS -

BODS - เครื่องมือและฟังก์ชั่น

จากสถาปัตยกรรมที่แสดงด้านล่างนี้เรามีเครื่องมือมากมายที่กำหนดไว้ใน SAP Business Objects Data Services เครื่องมือแต่ละตัวมีหน้าที่ของตัวเองตามแนวนอนของระบบ

ที่ด้านบนคุณมีบริการแพลตฟอร์มข้อมูลติดตั้งสำหรับผู้ใช้และการจัดการความปลอดภัยสิทธิ์ BODS ขึ้นอยู่กับคอนโซลการจัดการกลาง (CMC) สำหรับการเข้าถึงของผู้ใช้และคุณสมบัติความปลอดภัย สิ่งนี้ใช้ได้กับเวอร์ชัน 4.x ในเวอร์ชันก่อนหน้านี้ทำในคอนโซลการจัดการ

Data Services Designer เป็นเครื่องมือสำหรับนักพัฒนาซึ่งใช้ในการสร้างอ็อบเจ็กต์ที่ประกอบด้วยการแม็ปข้อมูลการแปลงและตรรกะ เป็น GUI และทำงานเป็นนักออกแบบสำหรับ Data Services

ที่เก็บ

Repository ใช้เพื่อจัดเก็บข้อมูลเมตาของอ็อบเจ็กต์ที่ใช้ใน BO Data Services แต่ละ Repository ควรลงทะเบียนใน Central Management Console และเชื่อมโยงกับเซิร์ฟเวอร์งานเดียวหรือหลายงานซึ่งรับผิดชอบในการเรียกใช้งานที่คุณสร้างขึ้น

ประเภทของที่เก็บ

ที่เก็บมีสามประเภท

Local Repository - ใช้เพื่อจัดเก็บข้อมูลเมตาของออบเจ็กต์ทั้งหมดที่สร้างขึ้นใน Data Services Designer เช่นโปรเจ็กต์งานโฟลว์ข้อมูลเวิร์กโฟลว์ ฯลฯ

Central Repository- ใช้เพื่อควบคุมการจัดการเวอร์ชันของอ็อบเจ็กต์และใช้สำหรับการพัฒนาแบบ multiuse Central Repository เก็บเวอร์ชันทั้งหมดของแอ็พพลิเคชันอ็อบเจ็กต์ ดังนั้นจึงช่วยให้คุณสามารถย้ายไปยังเวอร์ชันก่อนหน้าได้

Profiler Repository- ใช้เพื่อจัดการข้อมูลเมตาทั้งหมดที่เกี่ยวข้องกับงาน profiler ที่ดำเนินการใน SAP BODS designer CMS Repository เก็บข้อมูลเมตาของงานทั้งหมดที่ดำเนินการใน CMC บนแพลตฟอร์ม BI Information Steward Repository เก็บข้อมูลเมตาทั้งหมดของงานการทำโปรไฟล์และวัตถุที่สร้างขึ้นในผู้ดูแลข้อมูล

เซิร์ฟเวอร์งาน

เซิร์ฟเวอร์งานใช้เพื่อดำเนินการตามเวลาจริงและงานชุดงานที่คุณสร้างขึ้น รับข้อมูลงานจากที่เก็บตามลำดับและเริ่มต้นเครื่องมือข้อมูลเพื่อดำเนินการงาน เซิร์ฟเวอร์งานสามารถดำเนินการตามเวลาจริงหรืองานตามกำหนดเวลาและใช้มัลติเธรดในการแคชหน่วยความจำและการประมวลผลแบบขนานเพื่อเพิ่มประสิทธิภาพการทำงาน

เข้าถึงเซิร์ฟเวอร์

Access Server ใน Data Services เรียกว่าระบบนายหน้าข้อความเรียลไทม์ซึ่งรับคำขอข้อความย้ายไปยังบริการเรียลไทม์และแสดงข้อความในกรอบเวลาที่กำหนด

คอนโซลการจัดการบริการข้อมูล

Data Service Management Console ใช้เพื่อดำเนินกิจกรรมการดูแลระบบเช่นการจัดตารางงานการสร้างรายงานคุณภาพในระบบ DS การตรวจสอบข้อมูลเอกสารประกอบเป็นต้น

BODS - มาตรฐานการตั้งชื่อ

ขอแนะนำให้ใช้รูปแบบการตั้งชื่อมาตรฐานสำหรับอ็อบเจ็กต์ทั้งหมดในระบบทั้งหมดเนื่องจากจะช่วยให้คุณระบุอ็อบเจ็กต์ใน Repositories ได้อย่างง่ายดาย

ตารางแสดงรายการหลักการตั้งชื่อที่แนะนำซึ่งควรใช้สำหรับงานทั้งหมดและวัตถุอื่น ๆ

| คำนำหน้า | คำต่อท้าย | วัตถุ |

|---|---|---|

| DF_ | n / a | กระแสข้อมูล |

| EDF_ | _Input | การไหลของข้อมูลในตัว |

| EDF_ | _Output | การไหลของข้อมูลในตัว |

| RTJob_ | n / a | งานเรียลไทม์ |

| WF_ | n / a | ขั้นตอนการทำงาน |

| งาน_ | n / a | งาน |

| n / a | _DS | Datastore |

| กระแสตรง_ | n / a | การกำหนดค่าข้อมูล |

| SC_ | n / a | การกำหนดค่าระบบ |

| n / a | _Memory_DS | ที่เก็บข้อมูลหน่วยความจำ |

| PROC_ | n / a | ขั้นตอนการเก็บ |

ข้อมูลพื้นฐานของ BO Data Service ประกอบด้วยออบเจ็กต์หลักในการออกแบบ Work flow เช่น Project, Job, Work flow, data flow, Repositories

BODS - ที่เก็บและประเภท

Repository ใช้เพื่อจัดเก็บข้อมูลเมตาของอ็อบเจ็กต์ที่ใช้ใน BO Data Services แต่ละ Repository ควรลงทะเบียนใน Central Management Console, CMC และเชื่อมโยงกับเซิร์ฟเวอร์งานเดียวหรือหลายงานซึ่งมีหน้าที่ดำเนินการงานที่คุณสร้างขึ้น

ประเภทของที่เก็บ

ที่เก็บมีสามประเภท

Local Repository - ใช้เพื่อจัดเก็บข้อมูลเมตาของออบเจ็กต์ทั้งหมดที่สร้างขึ้นใน Data Services Designer เช่นโปรเจ็กต์งานโฟลว์ข้อมูลเวิร์กโฟลว์ ฯลฯ

Central Repository- ใช้เพื่อควบคุมการจัดการเวอร์ชันของอ็อบเจ็กต์และใช้สำหรับการพัฒนาแบบ multiuse Central Repository เก็บเวอร์ชันทั้งหมดของแอ็พพลิเคชันอ็อบเจ็กต์ ดังนั้นจึงช่วยให้คุณสามารถย้ายไปยังเวอร์ชันก่อนหน้าได้

Profiler Repository- ใช้เพื่อจัดการข้อมูลเมตาทั้งหมดที่เกี่ยวข้องกับงาน profiler ที่ดำเนินการใน SAP BODS designer CMS Repository เก็บข้อมูลเมตาของงานทั้งหมดที่ดำเนินการใน CMC บนแพลตฟอร์ม BI Information Steward Repository เก็บข้อมูลเมตาทั้งหมดของงานการทำโปรไฟล์และวัตถุที่สร้างขึ้นในผู้ดูแลข้อมูล

ในการสร้าง BODS Repository คุณต้องติดตั้งฐานข้อมูล คุณสามารถใช้ SQL Server, ฐานข้อมูล Oracle, My SQL, SAP HANA, Sybase และอื่น ๆ

การสร้างที่เก็บ

คุณต้องสร้างผู้ใช้ต่อไปนี้ในฐานข้อมูลขณะติดตั้ง BODS และเพื่อสร้างที่เก็บ ผู้ใช้เหล่านี้จำเป็นต้องล็อกอินเข้าสู่เซิร์ฟเวอร์ต่างๆเช่น CMS Server, Audit Server เป็นต้น

สร้าง BODS ของผู้ใช้ที่ระบุโดย Bodsserver1

- ให้การเชื่อมต่อกับ BODS;

- ให้สิทธิ์การสร้างเซสชันแก่ BODS;

- ให้ DBA เป็น BODS;

- ให้สิทธิ์สร้างตารางใด ๆ กับ BODS

- ให้สิทธิ์สร้างมุมมองใด ๆ กับ BODS

- ให้วางตารางใด ๆ ให้กับ BODS;

- ให้สิทธิ์ในการดู BODS;

- ให้แทรกตารางใด ๆ กับ BODS;

- ให้การอัปเดตตารางใด ๆ กับ BODS

- ให้สิทธิ์ลบตารางใด ๆ เป็น BODS;

- แก้ไขผู้ใช้ BODS QUOTA ไม่ จำกัด เฉพาะผู้ใช้

สร้าง CMS ของผู้ใช้ที่ระบุโดย CMSserver1

- ให้สิทธิ์เชื่อมต่อกับ CMS;

- ให้สิทธิ์สร้างเซสชันเป็น CMS

- ให้ DBA เป็น CMS;

- ให้สิทธิ์สร้างตารางใด ๆ เป็น CMS

- ให้สิทธิ์สร้างมุมมองใด ๆ กับ CMS

- อนุญาตให้วางตารางใด ๆ เป็น CMS;

- ให้สิทธิ์การดู CMS ใด ๆ

- อนุญาตให้แทรกตารางใด ๆ กับ CMS;

- ให้การอัปเดตตารางใด ๆ เป็น CMS

- ให้สิทธิ์ลบตารางใด ๆ เป็น CMS;

- แก้ไข CMS ของผู้ใช้ไม่ จำกัด โควต้าสำหรับผู้ใช้

สร้าง CMSAUDIT ของผู้ใช้ที่ระบุโดย CMSAUDITserver1

- ให้การเชื่อมต่อกับ CMSAUDIT;

- ให้สิทธิ์ Create Session เป็น CMSAUDIT

- ให้ DBA เป็น CMSAUDIT;

- ให้สิทธิ์สร้างตารางใด ๆ กับ CMSAUDIT;

- ให้สิทธิ์สร้างมุมมองใด ๆ กับ CMSAUDIT;

- อนุญาตให้วางตารางใด ๆ เพื่อ CMSAUDIT;

- ให้สิทธิ์ในการดู CMSAUDIT;

- ให้สิทธิ์แทรกตารางใด ๆ กับ CMSAUDIT;

- ให้อัปเดตตารางใด ๆ เป็น CMSAUDIT;

- ให้สิทธิ์ลบตารางใด ๆ เป็น CMSAUDIT;

- แก้ไข CMSAUDIT ผู้ใช้โควต้าไม่ จำกัด เฉพาะผู้ใช้

เพื่อสร้าง Repository ใหม่หลังการติดตั้ง

Step 1 - สร้างฐานข้อมูล Local_Repoและไปที่ Data Services Repository Manager กำหนดค่าฐานข้อมูลเป็นที่เก็บในเครื่อง

หน้าต่างใหม่จะเปิดขึ้น

Step 2 - กรอกรายละเอียดในช่องต่อไปนี้ -

ประเภทที่เก็บ, ประเภทฐานข้อมูล, ชื่อเซิร์ฟเวอร์ฐานข้อมูล, พอร์ต, ชื่อผู้ใช้และรหัสผ่าน

Step 3 - คลิกไฟล์ Createปุ่ม. คุณจะได้รับข้อความต่อไปนี้ -

Step 4 - ตอนนี้เข้าสู่ระบบ Central Management Console CMC ใน SAP BI Platform ด้วยชื่อผู้ใช้และรหัสผ่าน

Step 5 - ในหน้าแรกของ CMC คลิก Data Services.

Step 6 - จากไฟล์ Data Services คลิกเมนู Configure a new Data Services ที่เก็บ

Step 7 - กรอกรายละเอียดตามที่ระบุในหน้าต่างใหม่

- ชื่อที่เก็บ: Local_Repo

- ประเภทฐานข้อมูล: SAP HANA

- ชื่อเซิร์ฟเวอร์ฐานข้อมูล: ดีที่สุด

- ชื่อฐานข้อมูล: LOCAL_REPO

- ชื่อผู้ใช้:

- Password:*****

Step 8 - คลิกปุ่ม Test Connection และหากประสบความสำเร็จให้คลิก Save. เมื่อคุณบันทึกแล้วจะอยู่ใต้แท็บ Repository ใน CMC

Step 9 - ใช้สิทธิ์การเข้าถึงและความปลอดภัยบนที่เก็บในเครื่องใน CMC → User and Groups.

Step 10 - เมื่อได้รับการเข้าถึงแล้วให้ไปที่ Data Services Designer →เลือก Repository →ป้อนชื่อผู้ใช้และรหัสผ่านเพื่อเข้าสู่ระบบ

การอัพเดต Repository

ในการอัปเดตที่เก็บให้ทำตามขั้นตอนที่กำหนด

Step 1 - หากต้องการอัปเดต Repository หลังการติดตั้งให้สร้างฐานข้อมูล Local_Repo และไปที่ Data Services Repository Manager

Step 2 - กำหนดค่าฐานข้อมูลเป็นที่เก็บในเครื่อง

หน้าต่างใหม่จะเปิดขึ้น

Step 3 - ป้อนรายละเอียดสำหรับฟิลด์ต่อไปนี้

ประเภทที่เก็บ, ประเภทฐานข้อมูล, ชื่อเซิร์ฟเวอร์ฐานข้อมูล, พอร์ต, ชื่อผู้ใช้และรหัสผ่าน

คุณจะเห็นผลลัพธ์ตามที่แสดงในภาพหน้าจอที่แสดงด้านล่าง

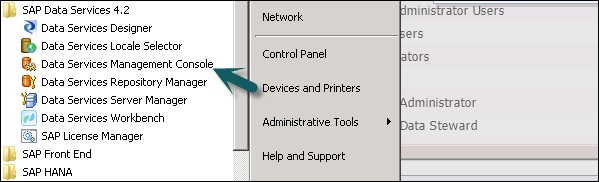

Data Service Management Console (DSMC) ใช้เพื่อดำเนินกิจกรรมการดูแลระบบเช่นการจัดตารางงานการสร้างรายงานคุณภาพในระบบ DS การตรวจสอบข้อมูลเอกสารประกอบเป็นต้น

คุณสามารถเข้าถึง Data Services Management Console ได้ด้วยวิธีต่อไปนี้ -

คุณสามารถเข้าถึง Data Services Management Console ได้โดยไปที่ Start → All Programs → Data Services → Data Service Management Console.

คุณยังสามารถเข้าถึงคอนโซลการจัดการบริการข้อมูลผ่านทาง Designer หากคุณเข้าสู่ระบบแล้ว

ในการเข้าถึงคอนโซลการจัดการบริการข้อมูลผ่าน Designer Home Page ทำตามขั้นตอนที่ระบุด้านล่าง

ในการเข้าถึงคอนโซลการจัดการบริการข้อมูลผ่านเครื่องมือให้ทำตามขั้นตอนที่กำหนด -

Step 1 - ไปที่ Tools → Data Services Management Console ดังแสดงในภาพต่อไปนี้

Step 2 - เมื่อคุณเข้าสู่ระบบ Data Services Management Consoleหน้าจอหลักจะเปิดขึ้นตามที่แสดงในภาพหน้าจอด้านล่าง ที่ด้านบนคุณจะเห็นชื่อผู้ใช้ที่คุณเข้าสู่ระบบ

ในโฮมเพจคุณจะเห็นตัวเลือกต่อไปนี้ -

- Administrator

- เอกสารอัตโนมัติ

- การตรวจสอบข้อมูล

- การวิเคราะห์ผลกระทบและเชื้อสาย

- แดชบอร์ดการดำเนินงาน

- รายงานคุณภาพข้อมูล

ฟังก์ชั่นหลักของแต่ละโมดูลของ Data Services Management Console มีอธิบายไว้ในบทนี้

โมดูลผู้ดูแลระบบ

ตัวเลือกผู้ดูแลระบบใช้ในการจัดการ -

- ผู้ใช้และบทบาท

- เพื่อเพิ่มการเชื่อมต่อเพื่อเข้าถึงเซิร์ฟเวอร์และที่เก็บ

- เพื่อเข้าถึงข้อมูลงานที่เผยแพร่สำหรับบริการบนเว็บ

- สำหรับการจัดตารางเวลาและการตรวจสอบงานแบทช์

- เพื่อตรวจสอบสถานะการเข้าถึงเซิร์ฟเวอร์และบริการเรียลไทม์

เมื่อคุณคลิกไฟล์ Administratorคุณจะเห็นลิงค์มากมายในบานหน้าต่างด้านซ้าย ได้แก่ สถานะแบทช์บริการเว็บการเชื่อมต่อ SAP กลุ่มเซิร์ฟเวอร์การจัดการที่เก็บ Profiler และประวัติการดำเนินการงาน

โหนด

โหนดต่างๆอยู่ภายใต้โมดูลผู้ดูแลระบบจะกล่าวถึงด้านล่าง

สถานะ

โหนดสถานะใช้เพื่อตรวจสอบสถานะของงานแบตช์และงานแบบเรียลไทม์สถานะการเข้าถึงเซิร์ฟเวอร์ที่เก็บอะแด็ปเตอร์และโพรไฟล์และสถานะระบบอื่น ๆ

คลิกสถานะ→เลือกที่เก็บ

ในบานหน้าต่างด้านขวาคุณจะเห็นแท็บของตัวเลือกต่อไปนี้ -

Batch Job Status- ใช้เพื่อตรวจสอบสถานะของชุดงาน คุณสามารถตรวจสอบข้อมูลงานเช่น Trace, Monitor, Error และ Performance Monitor, Start Time, End Time, Duration เป็นต้น

Batch Job Configuration - Batch job Configuration ใช้เพื่อตรวจสอบกำหนดการของแต่ละงานหรือคุณสามารถเพิ่มการดำเนินการเช่น Execute, Add Schedule, Export Execution Command

Repositories Schedules - ใช้เพื่อดูและกำหนดตารางเวลาสำหรับงานทั้งหมดในที่เก็บ

แบทช์โหนด

ภายใต้โหนด Batch Job คุณจะเห็นตัวเลือกเดียวกันกับด้านบน

| เลขที่ | ตัวเลือกและคำอธิบาย |

|---|---|

| 1 | Batch Job Status ดูสถานะของการดำเนินการล่าสุดและข้อมูลเชิงลึกเกี่ยวกับแต่ละงาน |

| 2 | Batch Job Configuration กำหนดค่าตัวเลือกการดำเนินการและการจัดกำหนดการสำหรับงานแต่ละงาน |

| 3 | Repository Schedules ดูและกำหนดค่ากำหนดการสำหรับงานทั้งหมดในที่เก็บ |

โหนดบริการบนเว็บ

Web Services ใช้เพื่อเผยแพร่งานแบบเรียลไทม์และงานแบทช์เป็นการดำเนินการบริการเว็บและเพื่อตรวจสอบสถานะของการดำเนินการเหล่านี้ นอกจากนี้ยังใช้เพื่อรักษาความปลอดภัยสำหรับงานที่เผยแพร่เป็นบริการบนเว็บและเพื่อดูWSDL ไฟล์.

การเชื่อมต่อ SAP

SAP Connections ใช้เพื่อตรวจสอบสถานะหรือกำหนดค่า RFC server interface ในคอนโซลการจัดการบริการข้อมูล

หากต้องการตรวจสอบสถานะของอินเตอร์เฟสเซิร์ฟเวอร์ RFC ให้ไปที่แท็บสถานะอินเตอร์เฟสเซิร์ฟเวอร์ RFC ในการเพิ่มอินเตอร์เฟสเซิร์ฟเวอร์ RFC ใหม่บนแท็บคอนฟิกูเรชันคลิกAdd.

เมื่อหน้าต่างใหม่เปิดขึ้นให้ป้อนรายละเอียดการกำหนดค่าเซิร์ฟเวอร์ RFC คลิก Apply.

กลุ่มเซิร์ฟเวอร์

สิ่งนี้ใช้เพื่อจัดกลุ่มเซิร์ฟเวอร์งานทั้งหมดที่เชื่อมโยงกับที่เก็บเดียวกันเป็นกลุ่มเซิร์ฟเวอร์เดียว แท็บนี้ใช้สำหรับการทำโหลดบาลานซ์ในขณะดำเนินการงานในบริการข้อมูล

เมื่อดำเนินการงานจะตรวจสอบเซิร์ฟเวอร์งานที่เกี่ยวข้องและหากหยุดทำงานจะย้ายงานไปยังเซิร์ฟเวอร์งานอื่นในกลุ่มเดียวกัน ส่วนใหญ่จะใช้ในการผลิตสำหรับการทำโหลดบาลานซ์

ที่เก็บโปรไฟล์

เมื่อคุณเชื่อมต่อที่เก็บโปรไฟล์กับผู้ดูแลระบบจะอนุญาตให้คุณขยายโหนดที่เก็บโปรไฟล์ คุณสามารถไปที่หน้าสถานะงานโปรไฟล์

โหนดการจัดการ

ในการใช้คุณลักษณะของแท็บผู้ดูแลระบบคุณต้องเพิ่มการเชื่อมต่อกับบริการข้อมูลโดยใช้โหนดการจัดการ โหนดการจัดการประกอบด้วยตัวเลือกการกำหนดค่าต่างๆสำหรับแอ็พพลิเคชันการดูแลระบบ

ประวัติการดำเนินงาน

ใช้เพื่อตรวจสอบประวัติการดำเนินการของงานหรือโฟลว์ข้อมูล เมื่อใช้ตัวเลือกนี้คุณสามารถตรวจสอบประวัติการดำเนินการของงานแบทช์หนึ่งงานหรืองานแบตช์ทั้งหมดที่คุณสร้างขึ้น

เมื่อคุณเลือกงานข้อมูลจะแสดงในรูปแบบของตารางซึ่งประกอบด้วยชื่อที่เก็บชื่องานเวลาเริ่มต้นเวลาสิ้นสุดเวลาดำเนินการสถานะ ฯลฯ

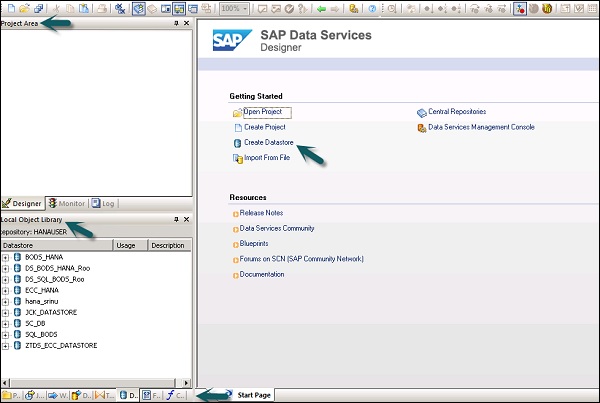

Data Service Designer เป็นเครื่องมือสำหรับนักพัฒนาซึ่งใช้ในการสร้างออบเจ็กต์ที่ประกอบด้วยการแมปข้อมูลการแปลงและตรรกะ เป็น GUI และทำงานเป็นนักออกแบบสำหรับ Data Services

คุณสามารถสร้างอ็อบเจ็กต์ต่างๆโดยใช้ Data Services Designer เช่น Projects, Jobs, Work Flows, Data Flows, mapping, transformations เป็นต้น

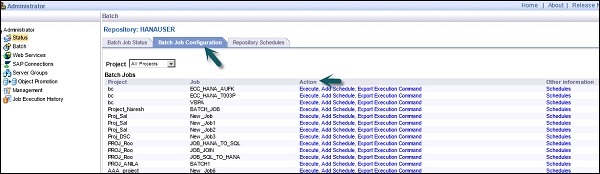

ในการเริ่มต้น Data Services Designer ให้ทำตามขั้นตอนด้านล่าง

Step 1 - ชี้ไปที่เริ่ม→โปรแกรมทั้งหมด→ SAP Data Services 4.2 → Data Services Designer

Step 2 - เลือก Repository และป้อนรหัสผ่านเพื่อเข้าสู่ระบบ

เมื่อคุณเลือก Repository และล็อกอินเข้าสู่ Data Services Designer หน้าจอหลักจะปรากฏดังที่แสดงในภาพด้านล่าง

ในบานหน้าต่างด้านซ้ายคุณมีพื้นที่โปรเจ็กต์ซึ่งคุณสามารถสร้างโปรเจ็กต์ใหม่งานโฟลว์ข้อมูลโฟลว์งานเป็นต้นในพื้นที่โปรเจ็กต์คุณมีไลบรารี Local Object ซึ่งประกอบด้วยอ็อบเจ็กต์ทั้งหมดที่สร้างใน Data Services

ในบานหน้าต่างด้านล่างคุณสามารถเปิดออบเจ็กต์ที่มีอยู่ได้โดยไปที่ตัวเลือกเฉพาะเช่นโปรเจ็กต์งานโฟลว์ข้อมูลเวิร์กโฟลว์ ฯลฯ เมื่อคุณเลือกอ็อบเจ็กต์ใด ๆ จากบานหน้าต่างด้านล่างมันจะแสดงอ็อบเจ็กต์ที่คล้ายกันทั้งหมด สร้างขึ้นใน Repository ภายใต้ไลบรารีอ็อบเจ็กต์โลคัล

ทางด้านขวาคุณจะมีหน้าจอหลักซึ่งสามารถใช้เพื่อ -

- สร้างโครงการ

- เปิดโครงการ

- สร้างที่เก็บข้อมูล

- สร้างที่เก็บ

- นำเข้าจากไฟล์แบบแบน

- คอนโซลการจัดการบริการข้อมูล

ในการพัฒนาโฟลว์ ETL อันดับแรกคุณต้องสร้างที่เก็บข้อมูลสำหรับต้นทางและระบบเป้าหมาย ทำตามขั้นตอนที่กำหนดเพื่อพัฒนาโฟลว์ ETL -

Step 1 - คลิก Create Data Stores.

หน้าต่างใหม่จะเปิดขึ้น

Step 2 - ป้อนไฟล์ Datastore ชื่อ, Datastoreประเภทและประเภทฐานข้อมูลดังแสดงด้านล่าง คุณสามารถเลือกฐานข้อมูลอื่นเป็นระบบต้นทางได้ดังแสดงในภาพหน้าจอด้านล่าง

Step 3- ในการใช้ระบบ ECC เป็นแหล่งข้อมูลให้เลือก SAP Applications เป็นประเภท Datastore ป้อนชื่อผู้ใช้และรหัสผ่านและบนไฟล์Advance ป้อนหมายเลขระบบและหมายเลขไคลเอนต์

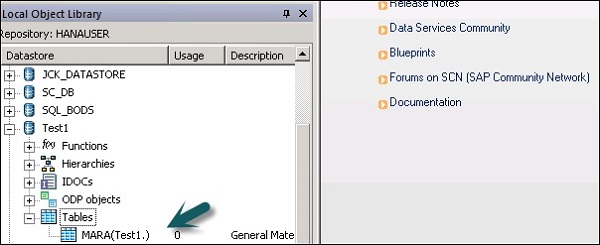

Step 4- คลิกตกลงและ Datastore จะถูกเพิ่มไปยังรายการไลบรารีวัตถุภายใน หากคุณขยาย Datastore จะไม่แสดงตารางใด ๆ

Step 5 - ในการดึงตารางใด ๆ จากระบบ ECC ไปโหลดบนระบบเป้าหมายให้คลิกขวาที่ Tables → Import by Names

Step 6 - ใส่ชื่อตารางแล้วคลิก Import. ในที่นี้จะใช้ Table – Mara ซึ่งเป็นตารางเริ่มต้นในระบบ ECC

Step 7 - ในทำนองเดียวกันให้สร้างไฟล์ Datastoreสำหรับระบบเป้าหมาย ในตัวอย่างนี้ HANA ใช้เป็นระบบเป้าหมาย

เมื่อคุณคลิกตกลงสิ่งนี้ Datastore จะถูกเพิ่มลงในไลบรารีวัตถุภายในเครื่องและจะไม่มีตารางอยู่ภายใน

สร้าง ETL Flow

หากต้องการสร้างโฟลว์ ETL ให้สร้างโครงการใหม่

Step 1 - คลิกตัวเลือก Create Project. ป้อนชื่อโครงการแล้วคลิกCreate. จะถูกเพิ่มเข้าไปในพื้นที่โครงการ

Step 2 - คลิกขวาที่ชื่อโครงการและสร้างงานชุดใหม่ / งานตามเวลาจริง

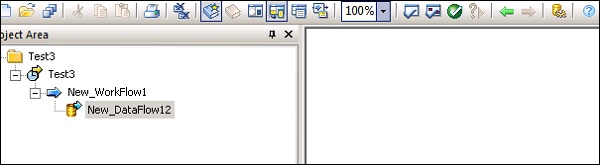

Step 3- ป้อนชื่องานแล้วกด Enter คุณต้องเพิ่ม Work flow และ Data flow เข้าไป เลือกเวิร์กโฟลว์และคลิกพื้นที่งานเพื่อเพิ่มลงในงาน ป้อนชื่อของเวิร์กโฟลว์และดับเบิลคลิกเพื่อเพิ่มลงในพื้นที่โครงการ

Step 4- ในทำนองเดียวกันให้เลือกโฟลว์ข้อมูลและนำไปยังพื้นที่โครงการ ป้อนชื่อโฟลว์ข้อมูลและดับเบิลคลิกเพื่อเพิ่มภายใต้โปรเจ็กต์ใหม่

Step 5- ตอนนี้ลากตารางต้นทางภายใต้ที่เก็บข้อมูลไปยังพื้นที่ทำงาน ตอนนี้คุณสามารถลากตารางเป้าหมายที่มีประเภทข้อมูลคล้ายกันไปยังพื้นที่ทำงานหรือคุณสามารถสร้างตารางเทมเพลตใหม่ได้

หากต้องการสร้างตารางเทมเพลตใหม่ให้คลิกขวาที่ตารางต้นทางเพิ่มใหม่→เทมเพลตตาราง

Step 6- ป้อนชื่อตารางและเลือก Datastore จากรายการเป็น Datastore เป้าหมาย ชื่อเจ้าของแสดงถึงชื่อสคีมาที่ต้องสร้างตาราง

ตารางจะถูกเพิ่มลงในพื้นที่ทำงานด้วยชื่อตารางนี้

Step 7- ลากเส้นจากตารางต้นทางไปยังตารางเป้าหมาย คลิกSave All ตัวเลือกที่ด้านบน

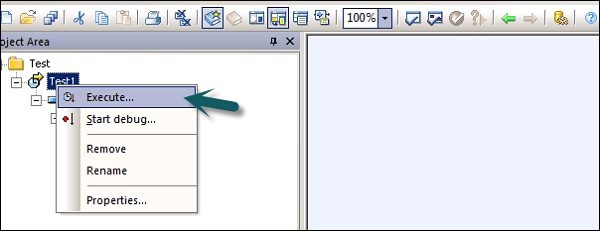

ตอนนี้คุณสามารถกำหนดเวลางานโดยใช้ Data Service Management Console หรือคุณสามารถดำเนินการได้ด้วยตนเองโดยคลิกขวาที่ชื่องานและดำเนินการ

Datastores ใช้เพื่อตั้งค่าการเชื่อมต่อระหว่างแอปพลิเคชันและฐานข้อมูล คุณสามารถสร้าง Datastore ได้โดยตรงหรือสร้างด้วยความช่วยเหลือของอะแดปเตอร์ Datastore อนุญาตให้แอปพลิเคชัน / ซอฟต์แวร์อ่านหรือเขียนข้อมูลเมตาจากแอปพลิเคชันหรือฐานข้อมูลและเขียนไปยังฐานข้อมูลหรือแอปพลิเคชันนั้น

ใน Business Objects Data Services คุณสามารถเชื่อมต่อกับระบบต่อไปนี้โดยใช้ Datastore -

- ระบบเมนเฟรมและฐานข้อมูล

- แอพพลิเคชั่นและซอฟต์แวร์ที่มีอะแดปเตอร์เขียนโดยผู้ใช้

- แอปพลิเคชัน SAP, SAP BW, Oracle Apps, Siebel ฯลฯ

SAP Business Objects Data Services มีตัวเลือกในการเชื่อมต่อกับอินเตอร์เฟสเมนเฟรมโดยใช้ Attunityตัวเชื่อมต่อ การใช้Attunityเชื่อมต่อ Datastore กับรายการแหล่งที่มาที่ระบุด้านล่าง -

- DB2 UDB สำหรับ OS / 390

- DB2 UDB สำหรับ OS / 400

- IMS/DB

- VSAM

- Adabas

- ไฟล์ Flat บน OS / 390 และ OS / 400

การใช้ตัวเชื่อมต่อ Attunity คุณสามารถเชื่อมต่อกับข้อมูลเมนเฟรมด้วยความช่วยเหลือของซอฟต์แวร์ ซอฟต์แวร์นี้จำเป็นต้องติดตั้งด้วยตนเองบนเซิร์ฟเวอร์เมนเฟรมและเซิร์ฟเวอร์งานไคลเอ็นต์ภายในโดยใช้อินเตอร์เฟส ODBC

ป้อนรายละเอียดเช่นตำแหน่งโฮสต์พอร์ตพื้นที่ทำงาน Attunity ฯลฯ

สร้าง Datastore สำหรับฐานข้อมูล

ในการสร้าง Datastore สำหรับฐานข้อมูลให้ทำตามขั้นตอนด้านล่าง

Step 1- ป้อนชื่อ Datastore ประเภท Datastore และประเภทฐานข้อมูลตามที่แสดงในภาพด้านล่าง คุณสามารถเลือกฐานข้อมูลอื่นเป็นระบบต้นทางที่ระบุไว้ในรายการ

Step 2- ในการใช้ระบบ ECC เป็นแหล่งข้อมูลให้เลือก SAP Applications เป็นประเภท Datastore ป้อนชื่อผู้ใช้และรหัสผ่าน คลิกAdvance แล้วป้อนหมายเลขระบบและหมายเลขไคลเอนต์

Step 3- คลิกตกลงและ Datastore จะถูกเพิ่มไปยังรายการไลบรารีวัตถุภายใน หากคุณขยาย Datastore จะไม่มีตารางที่จะแสดง

ในบทนี้เราจะเรียนรู้วิธีแก้ไขหรือเปลี่ยน Datastore หากต้องการเปลี่ยนหรือแก้ไข Datastore ให้ทำตามขั้นตอนด้านล่าง

Step 1- หากต้องการแก้ไข Datastore ให้คลิกขวาที่ชื่อ Datastore แล้วคลิกแก้ไข มันจะเปิดตัวแก้ไข Datastore

คุณสามารถแก้ไขข้อมูลการเชื่อมต่อสำหรับการกำหนดค่า Datastore ปัจจุบัน

Step 2 - คลิกไฟล์ Advance และคุณสามารถแก้ไขหมายเลขไคลเอ็นต์รหัสระบบและคุณสมบัติอื่น ๆ

Step 3 - คลิกไฟล์ Edit ตัวเลือกในการเพิ่มแก้ไขและลบการกำหนดค่า

Step 4 - คลิกตกลงและการเปลี่ยนแปลงจะถูกนำไปใช้

คุณสามารถสร้าง Datastore โดยใช้หน่วยความจำเป็นประเภทฐานข้อมูล หน่วยความจำ Datastores ใช้เพื่อปรับปรุงประสิทธิภาพของการไหลของข้อมูลในงานเรียลไทม์เนื่องจากเก็บข้อมูลไว้ในหน่วยความจำเพื่ออำนวยความสะดวกในการเข้าถึงอย่างรวดเร็วและไม่จำเป็นต้องไปที่แหล่งข้อมูลดั้งเดิม

หน่วยความจำ Datastore ใช้เพื่อจัดเก็บสกีมาตารางหน่วยความจำในที่เก็บ ตารางหน่วยความจำเหล่านี้รับข้อมูลจากตารางในฐานข้อมูลเชิงสัมพันธ์หรือใช้ไฟล์ข้อมูลแบบลำดับชั้นเช่นข้อความ XML และ IDocs ตารางหน่วยความจำยังคงมีชีวิตอยู่จนกว่างานจะถูกดำเนินการและไม่สามารถแชร์ข้อมูลในตารางหน่วยความจำระหว่างงานตามเวลาจริงที่แตกต่างกันได้

การสร้างที่เก็บข้อมูลหน่วยความจำ

ในการสร้าง Memory Datastore ให้ทำตามขั้นตอนด้านล่าง

Step 1 - คลิก Create Datastore และป้อนชื่อ Datastore “Memory_DS_TEST”. ตารางหน่วยความจำแสดงด้วยตาราง RDBMS ปกติและสามารถระบุได้ด้วยหลักการตั้งชื่อ

Step 2 - ในประเภท Datastore เลือกฐานข้อมูลและเลือกประเภทฐานข้อมูล Memory. คลิกตกลง

Step 3 - ไปที่ Project → New → Project ตามที่แสดงในภาพหน้าจอด้านล่าง

Step 4- สร้างงานใหม่โดยคลิกขวา เพิ่ม Work flow และ Data Flow ตามที่แสดงด้านล่าง

Step 5- เลือกตารางเทมเพลตแล้วลากและวางไปที่พื้นที่ทำงาน หน้าต่างสร้างตารางจะเปิดขึ้น

Step 6- ใส่ชื่อตารางและใน Datastore เลือก Memory Datastore หากคุณต้องการให้ระบบสร้างรหัสแถวให้เลือกไฟล์create row idกล่องกาเครื่องหมาย คลิกตกลง

Step 7 - เชื่อมต่อตารางหน่วยความจำนี้กับกระแสข้อมูลแล้วคลิก Save All ที่ด้านบน.

ตารางหน่วยความจำเป็นแหล่งที่มาและเป้าหมาย

การใช้ตารางความจำเป็นเป้าหมาย -

Step 1- ไปที่ไลบรารีวัตถุในเครื่องคลิกแท็บ Datastore ขยาย Memory Datastore →ขยายตาราง

Step 2- เลือกตารางหน่วยความจำที่คุณต้องการใช้เป็นแหล่งที่มาหรือตารางเป้าหมายแล้วลากไปที่เวิร์กโฟลว์ เชื่อมต่อตารางหน่วยความจำนี้เพื่อเป็นแหล่งที่มาหรือเป้าหมายในโฟลว์ข้อมูล

Step 3 - คลิกไฟล์ save ปุ่มบันทึกงาน

มีผู้จำหน่ายฐานข้อมูลหลายรายซึ่งให้เส้นทางการสื่อสารทางเดียวจากฐานข้อมูลหนึ่งไปยังฐานข้อมูลอื่นเท่านั้น เส้นทางเหล่านี้เรียกว่าลิงก์ฐานข้อมูล ใน SQL Server เซิร์ฟเวอร์ที่เชื่อมโยงจะอนุญาตเส้นทางการสื่อสารทางเดียวจากฐานข้อมูลหนึ่งไปยังอีกฐานข้อมูล

ตัวอย่าง

พิจารณาเซิร์ฟเวอร์ฐานข้อมูลท้องถิ่นที่ชื่อ “Product” เก็บลิงค์ฐานข้อมูลเพื่อเข้าถึงข้อมูลบนเซิร์ฟเวอร์ฐานข้อมูลระยะไกลที่เรียกว่า Customer. ขณะนี้ผู้ใช้ที่เชื่อมต่อกับเซิร์ฟเวอร์ฐานข้อมูลระยะไกลลูกค้าไม่สามารถใช้ลิงก์เดียวกันเพื่อเข้าถึงข้อมูลในผลิตภัณฑ์เซิร์ฟเวอร์ฐานข้อมูล ผู้ใช้ที่เชื่อมต่อกับ“Customer” ควรมีลิงค์แยกต่างหากในพจนานุกรมข้อมูลของเซิร์ฟเวอร์เพื่อเข้าถึงข้อมูลในเซิร์ฟเวอร์ฐานข้อมูลผลิตภัณฑ์

เส้นทางการสื่อสารระหว่างฐานข้อมูลทั้งสองนี้เรียกว่าการเชื่อมโยงฐานข้อมูล Datastores ซึ่งสร้างขึ้นระหว่างความสัมพันธ์ฐานข้อมูลที่เชื่อมโยงเหล่านี้เรียกว่า Datastores ที่เชื่อมโยง

มีความเป็นไปได้ในการเชื่อมต่อ Datastore หนึ่งกับ Datastore อื่นและนำเข้าลิงก์ฐานข้อมูลภายนอกเป็นตัวเลือกของ Datastore

Adapter Datastore อนุญาตให้คุณนำเข้าข้อมูลเมตาของแอปพลิเคชันไปยังที่เก็บ คุณสามารถเข้าถึงข้อมูลเมตาของแอปพลิเคชันและย้ายชุดข้อมูลและข้อมูลเรียลไทม์ระหว่างแอปพลิเคชันและซอฟต์แวร์ต่างๆ

มีชุดพัฒนาซอฟต์แวร์อะแดปเตอร์ - SDK ที่ SAP จัดหาให้ซึ่งสามารถใช้เพื่อพัฒนาอะแดปเตอร์แบบกำหนดเองได้ อะแด็ปเตอร์เหล่านี้แสดงในตัวออกแบบ Data Services โดย Adapter Datastores

ในการแยกหรือโหลดข้อมูลโดยใช้อะแด็ปเตอร์คุณควรกำหนด Datastore อย่างน้อยหนึ่งรายการเพื่อจุดประสงค์นี้

Adapter Datastore - คำจำกัดความ

ในการกำหนด Adaptive Datastore ให้ทำตามขั้นตอนที่กำหนด -

Step 1 - คลิก Create Datastore→ป้อนชื่อสำหรับ Datastore เลือก Datastore Type เป็น Adapter เลือกไฟล์Job Server จากรายการและชื่ออินสแตนซ์อะแด็ปเตอร์แล้วคลิก OK.

เพื่อเรียกดูข้อมูลเมตาของแอปพลิเคชัน

คลิกขวาที่ชื่อ Datastore แล้วคลิก Open. จะเปิดหน้าต่างใหม่ที่แสดงข้อมูลเมตาของแหล่งที่มา คลิกที่เครื่องหมาย + เพื่อตรวจสอบวัตถุและคลิกขวาที่วัตถุที่จะนำเข้า

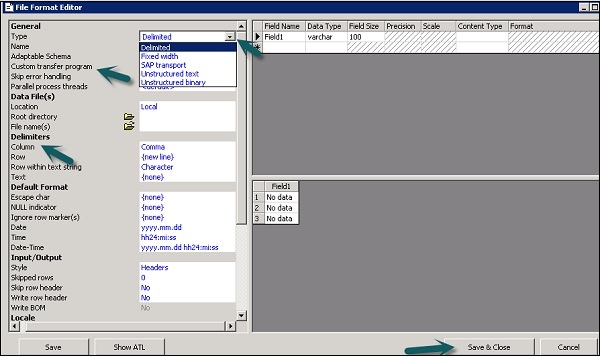

รูปแบบไฟล์ถูกกำหนดเป็นชุดของคุณสมบัติเพื่อนำเสนอโครงสร้างของไฟล์แบบแบน เป็นการกำหนดโครงสร้างข้อมูลเมตา รูปแบบไฟล์ใช้เพื่อเชื่อมต่อกับฐานข้อมูลต้นทางและปลายทางเมื่อข้อมูลถูกเก็บไว้ในไฟล์และไม่ได้อยู่ในฐานข้อมูล

รูปแบบไฟล์ใช้สำหรับฟังก์ชันต่อไปนี้ -

- สร้างเทมเพลตรูปแบบไฟล์เพื่อกำหนดโครงสร้างของไฟล์

- สร้างแหล่งที่มาเฉพาะและรูปแบบไฟล์เป้าหมายในกระแสข้อมูล

ไฟล์ประเภทต่อไปนี้สามารถใช้เป็นไฟล์ต้นฉบับหรือไฟล์เป้าหมายโดยใช้รูปแบบไฟล์ -

- Delimited

- SAP ขนส่ง

- ข้อความที่ไม่มีโครงสร้าง

- ไบนารีที่ไม่มีโครงสร้าง

- ความกว้างคงที่

ตัวแก้ไขรูปแบบไฟล์

File Format Editor ใช้เพื่อตั้งค่าคุณสมบัติสำหรับเทมเพลตรูปแบบไฟล์และรูปแบบไฟล์ต้นทางและปลายทาง

โหมดต่อไปนี้มีอยู่ในตัวแก้ไขรูปแบบไฟล์ -

New mode - ช่วยให้คุณสร้างเทมเพลตรูปแบบไฟล์ใหม่

Edit mode - ช่วยให้คุณสามารถแก้ไขเทมเพลตรูปแบบไฟล์ที่มีอยู่

Source mode - ช่วยให้คุณแก้ไขรูปแบบไฟล์ของไฟล์ต้นฉบับเฉพาะ

Target mode - ช่วยให้คุณแก้ไขรูปแบบไฟล์ของไฟล์เป้าหมายเฉพาะ

มีพื้นที่ทำงานสามส่วนสำหรับตัวแก้ไขรูปแบบไฟล์ -

Properties Values - ใช้เพื่อแก้ไขค่าสำหรับคุณสมบัติรูปแบบไฟล์

Column Attributes - ใช้เพื่อแก้ไขและกำหนดคอลัมน์หรือฟิลด์ในไฟล์

Data Preview - ใช้เพื่อดูว่าการตั้งค่ามีผลต่อข้อมูลตัวอย่างอย่างไร

การสร้างรูปแบบไฟล์

ในการสร้างรูปแบบไฟล์ให้ทำตามขั้นตอนด้านล่าง

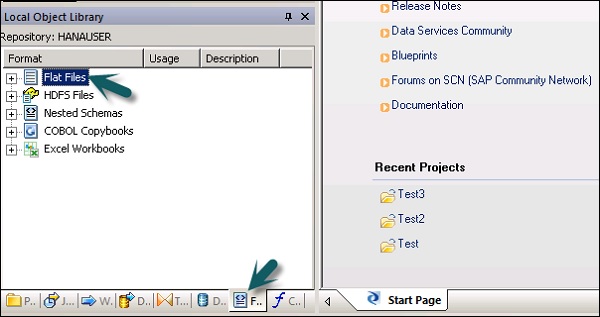

Step 1 - ไปที่ Local Object Library → Flat files

Step 2 - คลิกขวาที่ตัวเลือก Flat Files → New

หน้าต่างใหม่ของ File Format Editor จะเปิดขึ้น

Step 3- เลือกประเภทของรูปแบบไฟล์ ป้อนชื่อที่อธิบายเทมเพลตรูปแบบไฟล์ สำหรับไฟล์ที่มีความกว้างแบบ จำกัด และคงที่คุณสามารถอ่านและโหลดได้โดยใช้ Custom Transfer Program ป้อนคุณสมบัติอื่น ๆ เพื่ออธิบายไฟล์ที่เทมเพลตนี้เป็นตัวแทน

คุณยังสามารถระบุโครงสร้างของคอลัมน์ในพื้นที่ทำงานของคอลัมน์แอตทริบิวต์สำหรับรูปแบบไฟล์เฉพาะบางรูปแบบ เมื่อกำหนดคุณสมบัติทั้งหมดแล้วให้คลิกไฟล์Save ปุ่ม.

การแก้ไขรูปแบบไฟล์

ในการแก้ไขรูปแบบไฟล์ให้ทำตามขั้นตอนด้านล่าง

Step 1 - ใน Local Object Library ไปที่ไฟล์ Format แท็บ

Step 2- เลือกรูปแบบไฟล์ที่คุณต้องการแก้ไข คลิกขวาที่ไฟล์Edit ตัวเลือก

ทำการเปลี่ยนแปลงในตัวแก้ไขรูปแบบไฟล์แล้วคลิกไฟล์ Save ปุ่ม.

คุณสามารถสร้างรูปแบบไฟล์สมุดลอก COBOL ที่ทำให้คุณสร้างรูปแบบได้ช้าลง คุณสามารถกำหนดค่าซอร์สได้ในภายหลังเมื่อคุณเพิ่มรูปแบบลงในกระแสข้อมูล

คุณสามารถสร้างรูปแบบไฟล์และเชื่อมต่อกับไฟล์ข้อมูลได้ในเวลาเดียวกัน ทำตามขั้นตอนที่ระบุด้านล่าง

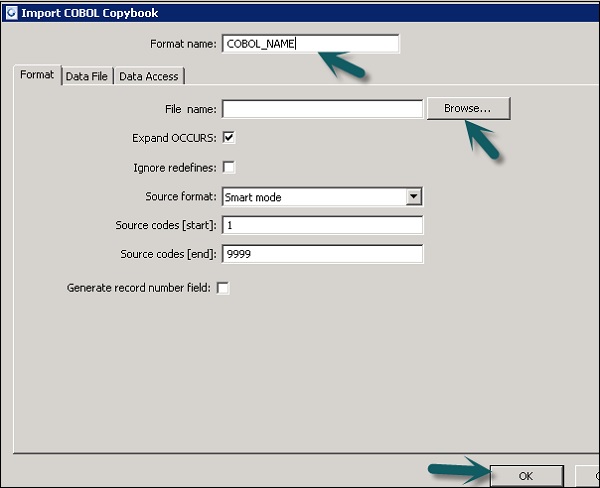

Step 1 - ไปที่ Local Object Library →รูปแบบไฟล์→ COBOL Copybooks

Step 2 - คลิกขวาที่ไฟล์ New ตัวเลือก

Step 3- ป้อนชื่อรูปแบบ ไปที่แท็บรูปแบบ→เลือกสมุดลอก COBOL เพื่อนำเข้า นามสกุลของไฟล์คือ.cpy.

Step 4 - คลิก OK. รูปแบบไฟล์นี้ถูกเพิ่มลงในไลบรารี Local Object กล่องโต้ตอบชื่อสคีมา COBOL Copybook จะเปิดขึ้น หากจำเป็นให้เปลี่ยนชื่อสคีมาแล้วคลิกOK.

โดยใช้ฐานข้อมูลที่เก็บข้อมูลคุณสามารถดึงข้อมูลจากตารางและฟังก์ชันในฐานข้อมูล เมื่อคุณดำเนินการนำเข้าข้อมูลสำหรับข้อมูลเมตาTool ช่วยให้คุณสามารถแก้ไขชื่อคอลัมน์ชนิดข้อมูลคำอธิบาย ฯลฯ

คุณสามารถแก้ไขวัตถุต่อไปนี้ -

- ชื่อตาราง

- ชื่อคอลัมน์

- คำอธิบายตาราง

- คำอธิบายคอลัมน์

- ประเภทข้อมูลคอลัมน์

- ประเภทเนื้อหาคอลัมน์

- คุณสมบัติของตาราง

- คีย์หลัก

- ชื่อเจ้าของ

การนำเข้าข้อมูลเมตา

ในการนำเข้าข้อมูลเมตาให้ทำตามขั้นตอนด้านล่าง -

Step 1 - ไปที่ Local Object Library →ไปที่ Datastore ที่คุณต้องการใช้

Step 2 - คลิกขวาที่ Datastore →เปิด

ในพื้นที่ทำงานรายการทั้งหมดที่พร้อมใช้งานสำหรับการนำเข้าจะแสดงขึ้น เลือกรายการที่คุณต้องการนำเข้าข้อมูลเมตา

ในไลบรารีวัตถุไปที่พื้นที่เก็บข้อมูลเพื่อดูรายการวัตถุที่นำเข้า

คุณสามารถใช้สมุดงาน Microsoft Excel เป็นแหล่งข้อมูลโดยใช้รูปแบบไฟล์ใน Data Services เวิร์กบุ๊ก Excel ควรมีอยู่ในระบบไฟล์ Windows หรือระบบไฟล์ Unix

| ซีเนียร์ | การเข้าถึงและคำอธิบาย |

|---|---|

| 1 | In the object library, click the Formats tab. สมุดงาน Excel อย่างเป็นทางการอธิบายโครงสร้างที่กำหนดไว้ในสมุดงาน Excel (แสดงด้วยนามสกุล. xls) คุณจัดเก็บเทมเพลตรูปแบบสำหรับช่วงข้อมูล Excel ในไลบรารีวัตถุ คุณใช้เทมเพลตเพื่อกำหนดรูปแบบของแหล่งที่มาเฉพาะในโฟลว์ข้อมูล SAP Data Services ใช้สมุดงาน Excel เป็นแหล่งที่มาเท่านั้น (ไม่ใช่เป้าหมาย) |

คลิกขวาที่ไฟล์ New ตัวเลือกและเลือก Excel Workbook ดังแสดงในภาพหน้าจอด้านล่าง

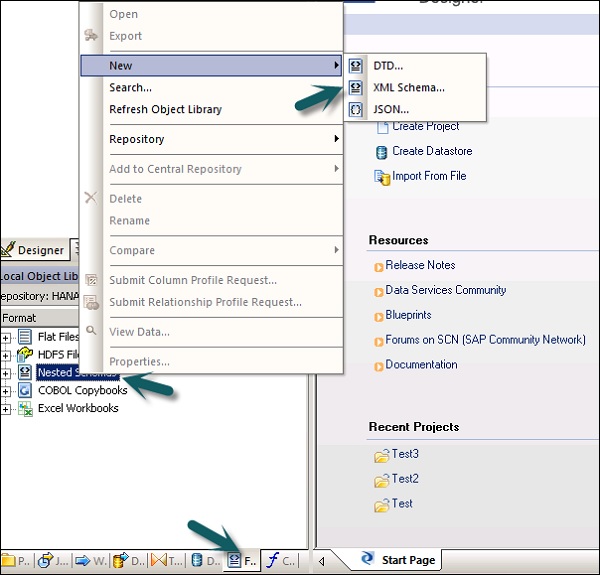

การดึงข้อมูลจาก XML FILE DTD, XSD

คุณยังสามารถนำเข้ารูปแบบไฟล์ XML หรือ DTD schema

Step 1 - ไปที่ Local object Library →แท็บ Format → Nested Schema

Step 2 - ชี้ไปที่ New(คุณสามารถเลือกไฟล์ DTD หรือ XML Schema หรือรูปแบบไฟล์ JSON) ป้อนชื่อของรูปแบบไฟล์และเลือกไฟล์ที่คุณต้องการนำเข้า คลิกตกลง

การดึงข้อมูลจาก COBOL Copybooks

คุณยังสามารถนำเข้ารูปแบบไฟล์ใน COBOL copybooks ไปที่ Local Object Library → Format → COBOL Copybooks

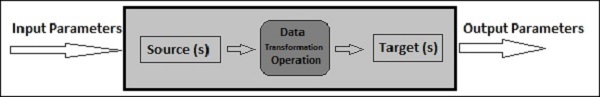

โฟลว์ข้อมูลใช้ในการแยกแปลงและโหลดข้อมูลจากต้นทางไปยังระบบเป้าหมาย การแปลงการโหลดและการจัดรูปแบบทั้งหมดเกิดขึ้นในกระแสข้อมูล

เมื่อคุณกำหนดโฟลว์ข้อมูลในโปรเจ็กต์แล้วสามารถเพิ่มลงในเวิร์กโฟลว์หรืองาน ETL ได้ กระแสข้อมูลสามารถส่งหรือรับวัตถุ / ข้อมูลโดยใช้พารามิเตอร์ กระแสข้อมูลถูกตั้งชื่อในรูปแบบDF_Name.

ตัวอย่างการไหลของข้อมูล

สมมติว่าคุณต้องการโหลดตารางข้อเท็จจริงในระบบ DW พร้อมข้อมูลจากสองตารางในระบบต้นทาง

กระแสข้อมูลประกอบด้วยวัตถุต่อไปนี้ -

- สองตารางแหล่งที่มา

- เข้าร่วมระหว่างสองตารางและกำหนดไว้ในการแปลงแบบสอบถาม

- ตารางเป้าหมาย

มีออบเจ็กต์สามประเภทที่สามารถเพิ่มลงในโฟลว์ข้อมูลได้ พวกเขาคือ -

- Source

- Target

- Transforms

Step 1 - ไปที่ Local Object Library แล้วลากทั้งสองตารางไปยังพื้นที่ทำงาน

Step 2 - หากต้องการเพิ่ม Query Transformation ให้ลากจากแถบเครื่องมือด้านขวา

Step 3 - เข้าร่วมทั้งสองตารางและสร้างตารางเป้าหมายเทมเพลตโดยคลิกขวาที่กล่องแบบสอบถาม→เพิ่มใหม่→ตารางเทมเพลตใหม่

Step 4 - ป้อนชื่อของตารางเป้าหมายชื่อที่เก็บข้อมูลและเจ้าของ (ชื่อสคีมา) ที่จะสร้างตาราง

Step 5 - ลากตารางเป้าหมายไปข้างหน้าและเข้าร่วมกับการแปลงแบบสอบถาม

ผ่านพารามิเตอร์

คุณยังสามารถส่งผ่านพารามิเตอร์ต่างๆเข้าและออกจากโฟลว์ข้อมูล ในขณะที่ส่งพารามิเตอร์ไปยังโฟลว์ข้อมูลออบเจ็กต์ในโฟลว์ข้อมูลจะอ้างอิงพารามิเตอร์เหล่านั้น การใช้พารามิเตอร์คุณสามารถส่งผ่านการดำเนินการต่างๆไปยังโฟลว์ข้อมูลได้

ตัวอย่าง - สมมติว่าคุณได้ป้อนพารามิเตอร์ลงในตารางเกี่ยวกับการอัปเดตล่าสุด ช่วยให้คุณสามารถแยกเฉพาะแถวที่แก้ไขตั้งแต่การอัปเดตครั้งล่าสุด

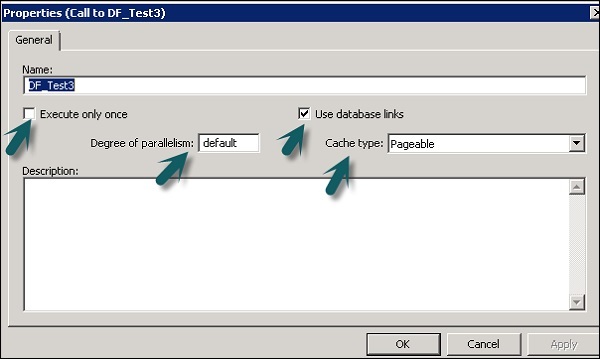

คุณสามารถเปลี่ยนคุณสมบัติของกระแสข้อมูลเช่นดำเนินการครั้งเดียวประเภทแคชลิงก์ฐานข้อมูลความขนาน ฯลฯ

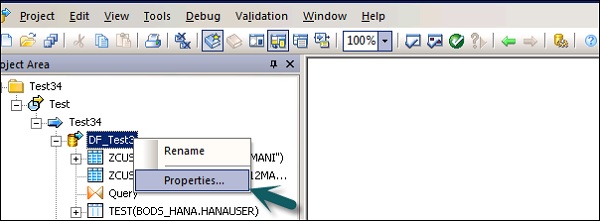

Step 1 - หากต้องการเปลี่ยนคุณสมบัติของการไหลของข้อมูลให้คลิกขวาที่การไหลของข้อมูล→คุณสมบัติ

คุณสามารถตั้งค่าคุณสมบัติต่างๆสำหรับกระแสข้อมูล คุณสมบัติได้รับด้านล่าง

| เลขที่ | คุณสมบัติและคำอธิบาย |

|---|---|

| 1 | Execute only once เมื่อคุณระบุว่ากระแสข้อมูลควรดำเนินการเพียงครั้งเดียวงานแบตช์จะไม่ดำเนินการโฟลว์ข้อมูลนั้นซ้ำหลังจากโฟลว์ข้อมูลเสร็จสมบูรณ์ยกเว้นว่าโฟลว์ข้อมูลจะอยู่ในเวิร์กโฟลว์ที่เป็นหน่วยการกู้คืนที่ดำเนินการซ้ำและ ทำไม่สำเร็จที่อื่นนอกหน่วยกู้คืน ขอแนะนำว่าอย่าทำเครื่องหมายกระแสข้อมูลเป็นดำเนินการเพียงครั้งเดียวถ้าโฟลว์งานพาเรนต์เป็นหน่วยการกู้คืน |

| 2 | Use database links ลิงก์ฐานข้อมูลคือเส้นทางการสื่อสารระหว่างเซิร์ฟเวอร์ฐานข้อมูลหนึ่งกับอีกเซิร์ฟเวอร์หนึ่ง ลิงก์ฐานข้อมูลช่วยให้ผู้ใช้ในพื้นที่สามารถเข้าถึงข้อมูลบนฐานข้อมูลระยะไกลซึ่งอาจอยู่บนเครื่องโลคัลหรือคอมพิวเตอร์ระยะไกลที่มีฐานข้อมูลประเภทเดียวกันหรือต่างกัน |

| 3 | Degree of parallelism Degree Of Parallelism (DOP) เป็นคุณสมบัติของกระแสข้อมูลที่กำหนดจำนวนครั้งที่การแปลงแต่ละครั้งภายในโฟลว์ข้อมูลจำลองแบบเพื่อประมวลผลชุดย่อยแบบขนาน |

| 4 | Cache type คุณสามารถแคชข้อมูลเพื่อปรับปรุงประสิทธิภาพของการดำเนินการเช่นการรวมกลุ่มการเรียงลำดับการกรองการค้นหาและการเปรียบเทียบตาราง คุณสามารถเลือกค่าใดค่าหนึ่งต่อไปนี้สำหรับตัวเลือกประเภทแคชบนหน้าต่างคุณสมบัติโฟลว์ข้อมูลของคุณ -

|

Step 2 - เปลี่ยนคุณสมบัติเช่นดำเนินการเพียงครั้งเดียวระดับความขนานและประเภทแคช

แหล่งที่มาและวัตถุเป้าหมาย

กระแสข้อมูลสามารถดึงหรือโหลดข้อมูลได้โดยตรงโดยใช้วัตถุต่อไปนี้ -

Source objects - ออบเจ็กต์ต้นทางกำหนดแหล่งที่มาที่จะดึงข้อมูลหรือคุณอ่านข้อมูล

Target objects - Target Objects กำหนดเป้าหมายที่คุณโหลดหรือเขียนข้อมูล

สามารถใช้อ็อบเจ็กต์ต้นทางประเภทต่อไปนี้และใช้วิธีการเข้าถึงที่แตกต่างกันสำหรับอ็อบเจ็กต์ต้นทาง

| ตาราง | ไฟล์ที่จัดรูปแบบด้วยคอลัมน์และแถวตามที่ใช้ในฐานข้อมูลเชิงสัมพันธ์ | โดยตรงหรือผ่านอะแดปเตอร์ |

| ตารางเทมเพลต | ตารางเทมเพลตที่สร้างและบันทึกไว้ในโฟลว์ข้อมูลอื่น (ใช้ในการพัฒนา) | โดยตรง |

| ไฟล์ | ไฟล์แบนที่มีตัวคั่นหรือความกว้างคงที่ | โดยตรง |

| เอกสาร | ไฟล์ที่มีรูปแบบเฉพาะแอปพลิเคชัน (ไม่สามารถอ่านได้โดยตัวแยกวิเคราะห์ SQL หรือ XML) | ผ่านอะแดปเตอร์ |

| ไฟล์ XML | ไฟล์ที่จัดรูปแบบด้วยแท็ก XML | โดยตรง |

| ข้อความ XML | ใช้เป็นแหล่งข้อมูลในงานแบบเรียลไทม์ | โดยตรง |

สามารถใช้อ็อบเจ็กต์ Target ต่อไปนี้และสามารถใช้วิธีการเข้าถึงที่แตกต่างกันได้

| ตาราง | ไฟล์ที่จัดรูปแบบด้วยคอลัมน์และแถวตามที่ใช้ในฐานข้อมูลเชิงสัมพันธ์ | โดยตรงหรือผ่านอะแดปเตอร์ |

| ตารางเทมเพลต | ตารางที่มีรูปแบบขึ้นอยู่กับผลลัพธ์ของการแปลงก่อนหน้า (ใช้ในการพัฒนา) | โดยตรง |

| ไฟล์ | ไฟล์แบนที่มีตัวคั่นหรือความกว้างคงที่ | โดยตรง |

| เอกสาร | ไฟล์ที่มีรูปแบบเฉพาะแอปพลิเคชัน (ไม่สามารถอ่านได้โดยตัวแยกวิเคราะห์ SQL หรือ XML) | ผ่านอะแดปเตอร์ |

| ไฟล์ XML | ไฟล์ที่จัดรูปแบบด้วยแท็ก XML | โดยตรง |

| ไฟล์เทมเพลต XML | ไฟล์ XML ที่มีรูปแบบขึ้นอยู่กับเอาต์พุตการแปลงก่อนหน้า (ใช้ในการพัฒนาโดยเฉพาะสำหรับการดีบักกระแสข้อมูล) | โดยตรง |

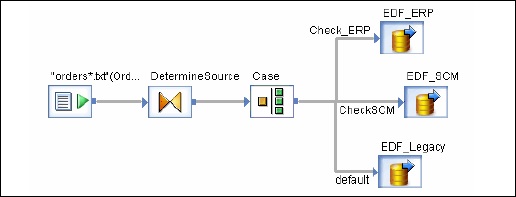

เวิร์กโฟลว์ใช้เพื่อกำหนดกระบวนการสำหรับการดำเนินการ จุดประสงค์หลักของเวิร์กโฟลว์คือการเตรียมการดำเนินการโฟลว์ข้อมูลและกำหนดสถานะของระบบเมื่อการดำเนินการโฟลว์ข้อมูลเสร็จสิ้น

งานชุดงานในโครงการ ETL จะคล้ายกับเวิร์กโฟลว์โดยมีข้อแตกต่างเพียงประการเดียวที่งานไม่มีพารามิเตอร์

สามารถเพิ่มอ็อบเจ็กต์ต่างๆลงในเวิร์กโฟลว์ พวกเขาคือ -

- ขั้นตอนการทำงาน

- การไหลของข้อมูล

- Scripts

- Loops

- Conditions

- ลองหรือจับบล็อก

นอกจากนี้คุณยังสามารถโทรลำดับงานโฟลว์งานอื่น ๆ หรือเวิร์กโฟลว์สามารถเรียกตัวเองได้

Note - ในขั้นตอนการทำงานจะดำเนินการตามลำดับจากซ้ายไปขวา

ตัวอย่างผังงาน

สมมติว่ามีตารางข้อเท็จจริงที่คุณต้องการอัปเดตและคุณได้สร้างโฟลว์ข้อมูลพร้อมกับการแปลง ตอนนี้หากคุณต้องการย้ายข้อมูลจากระบบต้นทางคุณต้องตรวจสอบการแก้ไขล่าสุดสำหรับตารางแฟคเพื่อให้คุณแยกเฉพาะแถวที่เพิ่มหลังจากอัพเดตครั้งล่าสุด

เพื่อให้บรรลุสิ่งนี้คุณต้องสร้างหนึ่งสคริปต์ซึ่งกำหนดวันที่อัพเดตล่าสุดจากนั้นส่งผ่านสิ่งนี้เป็นพารามิเตอร์อินพุตไปยังโฟลว์ข้อมูล

คุณต้องตรวจสอบด้วยว่าการเชื่อมต่อข้อมูลกับตารางข้อเท็จจริงเฉพาะนั้นใช้งานได้หรือไม่ หากไม่ได้ใช้งานคุณจะต้องตั้งค่า catch block ซึ่งจะส่งอีเมลไปยังผู้ดูแลระบบโดยอัตโนมัติเพื่อแจ้งเกี่ยวกับปัญหานี้

สามารถสร้างเวิร์กโฟลว์ได้โดยใช้วิธีการต่อไปนี้ -

- ไลบรารีวัตถุ

- จานเครื่องมือ

การสร้างเวิร์กโฟลว์โดยใช้ Object Library

ในการสร้างเวิร์กโฟลว์โดยใช้ Object Library ให้ทำตามขั้นตอนด้านล่าง

Step 1 - ไปที่แท็บ Object Library → Workflow

Step 2 - คลิกขวาที่ไฟล์ New ตัวเลือก

Step 3 - ป้อนชื่อของเวิร์กโฟลว์

การสร้างเวิร์กโฟลว์โดยใช้จานเครื่องมือ

หากต้องการสร้างเวิร์กโฟลว์โดยใช้จานเครื่องมือให้คลิกไอคอนทางด้านขวาแล้วลากผังงานในพื้นที่ทำงาน

คุณยังสามารถตั้งค่าให้เรียกใช้เวิร์กโฟลว์เพียงครั้งเดียวโดยไปที่คุณสมบัติของเวิร์กโฟลว์

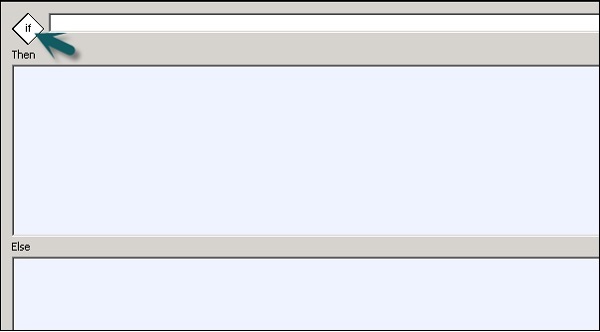

เงื่อนไข

คุณยังสามารถเพิ่มเงื่อนไขในเวิร์กโฟลว์ สิ่งนี้ช่วยให้คุณสามารถใช้ตรรกะ If / Else / Then บนเวิร์กโฟลว์ได้

| ซีเนียร์ | เงื่อนไขและคำอธิบาย |

|---|---|

| 1 | If นิพจน์บูลีนที่ประเมินค่าเป็น TRUE หรือ FALSE คุณสามารถใช้ฟังก์ชันตัวแปรและตัวดำเนินการมาตรฐานเพื่อสร้างนิพจน์ |

| 2 | Then องค์ประกอบลำดับงานที่จะดำเนินการหากไฟล์ If นิพจน์ประเมินเป็น TRUE |

| 3 | Else (ไม่บังคับ) องค์ประกอบลำดับงานที่จะดำเนินการหากไฟล์ If นิพจน์ประเมินเป็น FALSE |

เพื่อกำหนดเงื่อนไข

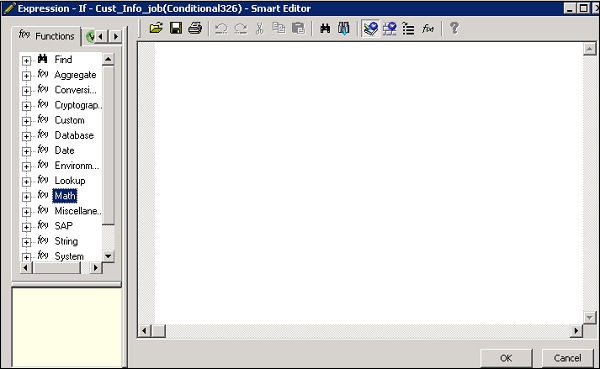

Step 1 - ไปที่เวิร์กโฟลว์→คลิกไอคอนเงื่อนไขบนจานเครื่องมือทางด้านขวา

Step 2 - ดับเบิลคลิกที่ชื่อ Conditional เพื่อเปิดไฟล์ If-Then–Else ตัวแก้ไขเงื่อนไข

Step 3- ป้อนนิพจน์บูลีนที่ควบคุมเงื่อนไข คลิกตกลง

Step 4 - ลากโฟลว์ข้อมูลที่คุณต้องการดำเนินการ Then and Else หน้าต่างตามนิพจน์ในเงื่อนไข IF

เมื่อคุณทำเงื่อนไขเสร็จแล้วคุณสามารถดีบักและตรวจสอบเงื่อนไขได้

การแปลงใช้เพื่อจัดการกับชุดข้อมูลเป็นอินพุตและสร้างเอาต์พุตหนึ่งหรือหลายเอาต์พุต มีการแปลงต่างๆซึ่งสามารถใช้ใน Data Services ประเภทของการเปลี่ยนแปลงขึ้นอยู่กับรุ่นและผลิตภัณฑ์ที่ซื้อ

มีการเปลี่ยนแปลงประเภทต่อไปนี้ -

การรวมข้อมูล

การแปลงการรวมข้อมูลใช้สำหรับการแยกข้อมูลแปลงและโหลดไปยังระบบ DW ช่วยให้มั่นใจได้ถึงความสมบูรณ์ของข้อมูลและเพิ่มประสิทธิภาพการทำงานของนักพัฒนา

- Data_Generator

- Data_Transfer

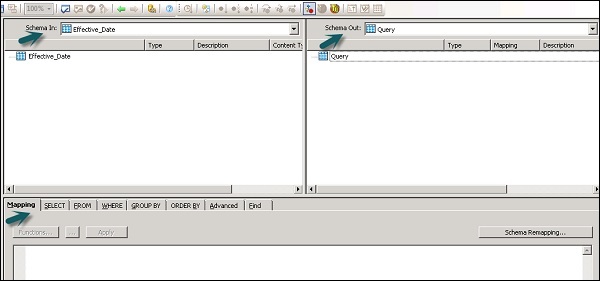

- Effective_Date

- Hierarchy_flattening

- Table_Comparision ฯลฯ

คุณภาพข้อมูล

การแปลงคุณภาพข้อมูลใช้เพื่อปรับปรุงคุณภาพข้อมูล คุณสามารถใช้ชุดข้อมูลแยกวิเคราะห์ที่ถูกต้องเป็นมาตรฐานและเพิ่มคุณค่าจากระบบต้นทาง

- Associate

- ล้างข้อมูล

- DSF2 Walk Sequencer ฯลฯ

แพลตฟอร์ม

แพลตฟอร์มใช้สำหรับการเคลื่อนไหวของชุดข้อมูล ด้วยการใช้สิ่งนี้คุณสามารถสร้างแมปและรวมแถวจากแหล่งข้อมูลสองแหล่งขึ้นไป

- Case

- Merge

- แบบสอบถาม ฯลฯ

การประมวลผลข้อมูลข้อความ

การประมวลผลข้อมูลข้อความช่วยให้คุณประมวลผลข้อมูลข้อความจำนวนมาก

ในบทนี้คุณจะเห็นวิธีการเพิ่ม Transform ไปยังกระแสข้อมูล

Step 1 - ไปที่ Object Library →แท็บ Transform

Step 2- เลือกการแปลงที่คุณต้องการเพิ่มในโฟลว์ข้อมูล หากคุณเพิ่มการเปลี่ยนแปลงที่มีตัวเลือกให้เลือกการกำหนดค่าพรอมต์จะเปิดขึ้น

Step 3 - วาดการเชื่อมต่อกระแสข้อมูลเพื่อเชื่อมต่อแหล่งที่มากับการแปลง

Step 4 - ดับเบิลคลิกที่ชื่อการเปลี่ยนแปลงเพื่อเปิดโปรแกรมแก้ไขการเปลี่ยนแปลง

เมื่อกำหนดคำจำกัดความเสร็จแล้วให้คลิก OK เพื่อปิดตัวแก้ไข

นี่คือการเปลี่ยนแปลงทั่วไปที่ใช้ใน Data Services และคุณสามารถทำหน้าที่ต่อไปนี้ -

- การกรองข้อมูลจากแหล่งที่มา

- การเข้าร่วมข้อมูลจากหลายแหล่ง

- ทำหน้าที่และการแปลงข้อมูล

- การแม็พคอลัมน์จากสกีมาอินพุตไปยังเอาต์พุต

- การกำหนดคีย์หลัก

- เพิ่มคอลัมน์สคีมาและฟังก์ชันใหม่ที่ส่งผลให้สคีมาเอาต์พุต

เนื่องจากการแปลงแบบสอบถามเป็นการแปลงที่ใช้บ่อยที่สุดจึงมีทางลัดสำหรับแบบสอบถามนี้ในจานเครื่องมือ

ในการเพิ่มการแปลงข้อความค้นหาให้ทำตามขั้นตอนด้านล่าง -

Step 1- คลิกที่จานเครื่องมือการแปลงแบบสอบถาม คลิกที่ใดก็ได้บนพื้นที่ทำงานการไหลของข้อมูล เชื่อมต่อสิ่งนี้กับอินพุตและเอาต์พุต

เมื่อคุณคลิกสองครั้งที่ไอคอนการแปลงแบบสอบถามจะเปิดตัวแก้ไขแบบสอบถามที่ใช้ในการดำเนินการแบบสอบถาม

พื้นที่ต่อไปนี้มีอยู่ในการแปลงแบบสอบถาม -

- อินพุต Schema

- สคีมาเอาต์พุต

- Parameters

สกีมาอินพุตและเอาต์พุตประกอบด้วยคอลัมน์สคีมาที่ซ้อนกันและฟังก์ชัน Schema In และ Schema Out แสดงสคีมาที่เลือกในปัจจุบันในการแปลง

ในการเปลี่ยนสคีมาเอาต์พุตให้เลือกสคีมาในรายการคลิกขวาและเลือกสร้างปัจจุบัน

การแปลงคุณภาพข้อมูล

การแปลงคุณภาพข้อมูลไม่สามารถเชื่อมต่อโดยตรงกับการแปลงต้นน้ำซึ่งมีตารางซ้อนกัน ในการเชื่อมต่อการแปลงเหล่านี้คุณควรเพิ่มการแปลงแบบสอบถามหรือการแปลงไปป์ไลน์ XML ระหว่างการแปลงจากตารางที่ซ้อนกันและการแปลงคุณภาพข้อมูล

จะใช้ Data Quality Transformation ได้อย่างไร?

Step 1 - ไปที่ Object Library →แท็บ Transform

Step 2 - ขยายการแปลงคุณภาพข้อมูลและเพิ่มการกำหนดค่าการแปลงหรือการแปลงที่คุณต้องการเพิ่มลงในโฟลว์ข้อมูล

Step 3- วาดการเชื่อมต่อการไหลของข้อมูล ดับเบิลคลิกที่ชื่อการแปลงจะเปิดตัวแก้ไขการแปลง ในสคีมาอินพุตให้เลือกช่องป้อนข้อมูลที่คุณต้องการแมป

Note - ในการใช้ Associate Transform คุณสามารถเพิ่มฟิลด์ที่ผู้ใช้กำหนดลงในแท็บอินพุต

การแปลงการประมวลผลข้อมูลข้อความ

การแปลงการประมวลผลข้อมูลข้อความช่วยให้คุณสามารถดึงข้อมูลเฉพาะจากข้อความจำนวนมากได้ คุณสามารถค้นหาข้อเท็จจริงและเอนทิตีเช่นลูกค้าผลิตภัณฑ์และข้อมูลทางการเงินเฉพาะสำหรับองค์กร

การแปลงนี้ยังตรวจสอบความสัมพันธ์ระหว่างเอนทิตีและอนุญาตการแยก ข้อมูลที่แยกออกมาโดยใช้การประมวลผลข้อมูลข้อความสามารถใช้ใน Business Intelligence, Reporting, query และ analytics

การแปลงการแยกเอนทิตี

ในบริการข้อมูลการประมวลผลข้อมูลข้อความจะกระทำด้วยความช่วยเหลือของ Entity Extraction ซึ่งแยกเอนทิตีและข้อเท็จจริงจากข้อมูลที่ไม่มีโครงสร้าง

สิ่งนี้เกี่ยวข้องกับการวิเคราะห์และประมวลผลข้อมูลข้อความจำนวนมากการค้นหาเอนทิตีกำหนดให้เป็นประเภทที่เหมาะสมและนำเสนอข้อมูลเมตาในรูปแบบมาตรฐาน

การแปลง Entity Extraction สามารถดึงข้อมูลจากเนื้อหาข้อความ HTML XML หรือรูปแบบไบนารีบางอย่าง (เช่น PDF) และสร้างเอาต์พุตที่มีโครงสร้าง คุณสามารถใช้ผลลัพธ์ได้หลายวิธีตามขั้นตอนการทำงานของคุณ คุณสามารถใช้เป็นอินพุตสำหรับการแปลงอื่นหรือเขียนไปยังแหล่งเอาต์พุตหลายรายการเช่นตารางฐานข้อมูลหรือไฟล์แบบแบน เอาต์พุตถูกสร้างขึ้นในการเข้ารหัส UTF-16

Entity Extract Transform can be used in the following scenarios −

การค้นหาข้อมูลเฉพาะจากปริมาณข้อความจำนวนมาก

การค้นหาข้อมูลที่มีโครงสร้างจากข้อความที่ไม่มีโครงสร้างด้วยข้อมูลที่มีอยู่เพื่อทำการเชื่อมต่อใหม่

การรายงานและการวิเคราะห์คุณภาพของผลิตภัณฑ์

ความแตกต่างระหว่าง TDP และ Data Cleansing

การประมวลผลข้อมูลข้อความใช้สำหรับการค้นหาข้อมูลที่เกี่ยวข้องจากข้อมูลข้อความที่ไม่มีโครงสร้าง อย่างไรก็ตามการล้างข้อมูลจะใช้สำหรับการกำหนดมาตรฐานและการล้างข้อมูลที่มีโครงสร้าง

| พารามิเตอร์ | การประมวลผลข้อมูลข้อความ | การล้างข้อมูล |

|---|---|---|

| ประเภทอินพุต | ข้อมูลที่ไม่มีโครงสร้าง | ข้อมูลที่มีโครงสร้าง |

| ขนาดอินพุต | มากกว่า 5KB | น้อยกว่า 5KB |

| ขอบเขตการป้อนข้อมูล | โดเมนกว้างที่มีรูปแบบต่างๆมากมาย | รูปแบบที่ จำกัด |

| การใช้งานที่เป็นไปได้ | ข้อมูลที่มีความหมายที่เป็นไปได้จากข้อมูลที่ไม่มีโครงสร้าง | คุณภาพของข้อมูลสำหรับการจัดเก็บใน Repository |

| เอาต์พุต | สร้างคำอธิบายประกอบในรูปแบบของเอนทิตีประเภท ฯลฯ ข้อมูลที่ป้อนจะไม่มีการเปลี่ยนแปลง | สร้างฟิลด์มาตรฐานอินพุตมีการเปลี่ยนแปลง |

การดูแลระบบบริการข้อมูลรวมถึงการสร้างงานแบบเรียลไทม์และชุดงานการจัดตารางเวลางานโฟลว์ข้อมูลแบบฝังตัวแปรและพารามิเตอร์กลไกการกู้คืนการทำโปรไฟล์ข้อมูลการปรับแต่งประสิทธิภาพ ฯลฯ

งานตามเวลาจริง

คุณสามารถสร้างงานแบบเรียลไทม์เพื่อประมวลผลข้อความแบบเรียลไทม์ในตัวออกแบบบริการข้อมูล เช่นเดียวกับงานแบทช์งานแบบเรียลไทม์จะดึงข้อมูลแปลงและโหลดข้อมูล

งานแบบเรียลไทม์แต่ละงานสามารถดึงข้อมูลจากข้อความเดียวได้ คุณยังสามารถดึงข้อมูลจากแหล่งอื่น ๆ เช่นตารางหรือไฟล์

งานแบบเรียลไทม์จะไม่ถูกดำเนินการโดยใช้ทริกเกอร์ซึ่งแตกต่างจากงานแบทช์ พวกเขาดำเนินการเป็นบริการเรียลไทม์โดยผู้ดูแลระบบ บริการแบบเรียลไทม์รอข้อความจากเซิร์ฟเวอร์การเข้าถึง เซิร์ฟเวอร์ Access ได้รับข้อความนี้และส่งต่อไปยังบริการแบบเรียลไทม์ซึ่งกำหนดค่าให้ประมวลผลประเภทข้อความ บริการแบบเรียลไทม์จะดำเนินการข้อความและส่งคืนผลลัพธ์และดำเนินการกับข้อความต่อไปจนกว่าจะได้รับคำสั่งให้หยุดดำเนินการ

เรียลไทม์เทียบกับงานแบทช์

การแปลงเช่นเดียวกับสาขาและตรรกะการควบคุมจะใช้บ่อยกว่าในงานเรียลไทม์ซึ่งไม่ใช่กรณีของงานแบทช์ในนักออกแบบ

งานแบบเรียลไทม์จะไม่ดำเนินการตามกำหนดเวลาหรือทริกเกอร์ภายในซึ่งแตกต่างจากงานแบตช์

การสร้างงานตามเวลาจริง

สามารถสร้างงานแบบเรียลไทม์โดยใช้ออบเจ็กต์เดียวกันเช่นโฟลว์ข้อมูลกระแสงานลูปเงื่อนไขสคริปต์ ฯลฯ

คุณสามารถใช้โมเดลข้อมูลต่อไปนี้เพื่อสร้างงานแบบเรียลไทม์ -

- แบบจำลองการไหลของข้อมูลเดียว

- แบบจำลองการไหลของข้อมูลหลายแบบ

แบบจำลองการไหลของข้อมูลเดียว

คุณสามารถสร้างงานแบบเรียลไทม์ด้วยโฟลว์ข้อมูลเดียวในลูปการประมวลผลแบบเรียลไทม์และรวมแหล่งข้อความเดียวและเป้าหมายข้อความเดียว

Creating Real Time job using single data model −

ในการสร้างงานตามเวลาจริงโดยใช้แบบจำลองข้อมูลเดียวให้ทำตามขั้นตอนที่กำหนด

Step 1 - ไปที่ Data Services Designer → Project New → Project →ใส่ชื่อโปรเจ็กต์

Step 2 - คลิกขวาที่ช่องว่างในพื้นที่โครงการ→งานใหม่ตามเวลาจริง

พื้นที่ทำงานแสดงสององค์ประกอบของงานตามเวลาจริง -

- RT_Process_begins

- Step_ends

แสดงจุดเริ่มต้นและจุดสิ้นสุดของงานตามเวลาจริง

Step 3 - ในการสร้างงานแบบเรียลไทม์ด้วยโฟลว์ข้อมูลเดียวให้เลือกโฟลว์ข้อมูลจากพาเล็ตเครื่องมือในบานหน้าต่างด้านขวาแล้วลากไปยังพื้นที่ทำงาน

คลิกภายในลูปคุณสามารถใช้แหล่งข้อความเดียวและเป้าหมายข้อความเดียวในลูปการประมวลผลแบบเรียลไทม์ เชื่อมต่อจุดเริ่มต้นและจุดสิ้นสุดกับโฟลว์ข้อมูล

Step 4 - เพิ่มกำหนดค่าวัตถุในโฟลว์ข้อมูลตามต้องการและบันทึกงาน

แบบจำลองการไหลของข้อมูลหลายแบบ

สิ่งนี้ช่วยให้คุณสร้างงานแบบเรียลไทม์ที่มีการไหลของข้อมูลหลายรายการในลูปการประมวลผลแบบเรียลไทม์ คุณต้องตรวจสอบให้แน่ใจว่าข้อมูลในแต่ละแบบจำลองข้อมูลได้รับการประมวลผลอย่างสมบูรณ์ก่อนที่จะย้ายไปยังข้อความถัดไป

การทดสอบงานตามเวลาจริง

คุณสามารถทดสอบงานแบบเรียลไทม์ได้โดยส่งข้อความตัวอย่างเป็นข้อความต้นทางจากไฟล์ คุณสามารถตรวจสอบว่าบริการข้อมูลสร้างข้อความเป้าหมายที่คาดไว้หรือไม่

เพื่อให้แน่ใจว่างานของคุณให้ผลลัพธ์ที่คาดหวังคุณสามารถดำเนินการงานในโหมดดูข้อมูล เมื่อใช้โหมดนี้คุณสามารถจับข้อมูลเอาต์พุตเพื่อให้แน่ใจว่างานเรียลไทม์ของคุณทำงานได้ดี

การไหลของข้อมูลในตัว

การไหลของข้อมูลในตัวเรียกว่ากระแสข้อมูลซึ่งเรียกจากกระแสข้อมูลอื่นในการออกแบบ โฟลว์ข้อมูลที่ฝังไว้สามารถมีแหล่งที่มาและเป้าหมายได้หลายแหล่ง แต่มีเพียงอินพุตหรือเอาต์พุตเดียวเท่านั้นที่ส่งผ่านข้อมูลไปยังโฟลว์ข้อมูลหลัก

สามารถใช้โฟลว์ข้อมูลฝังตัวประเภทต่อไปนี้ -

One Input - เพิ่มโฟลว์ข้อมูลที่ฝังไว้ที่ส่วนท้ายของกระแสข้อมูล

One Output - มีการเพิ่มโฟลว์ข้อมูลแบบฝังที่จุดเริ่มต้นของโฟลว์ข้อมูล

No input or output - จำลองกระแสข้อมูลที่มีอยู่

สามารถใช้โฟลว์ข้อมูลในตัวเพื่อวัตถุประสงค์ต่อไปนี้ -

เพื่อลดความซับซ้อนของการแสดงกระแสข้อมูล

หากคุณต้องการบันทึกลอจิกโฟลว์และใช้ซ้ำในโฟลว์ข้อมูลอื่น

สำหรับการดีบักโดยคุณจะสร้างส่วนของกระแสข้อมูลเป็นโฟลว์ข้อมูลแบบฝังและดำเนินการแยกกัน

คุณสามารถเลือกวัตถุในโฟลว์ข้อมูลที่มีอยู่ มีสองวิธีในการสร้างโฟลว์ข้อมูลแบบฝัง

ตัวเลือกที่ 1

คลิกขวาที่ออบเจ็กต์แล้วเลือกเพื่อทำให้ Embedded Data flow

ทางเลือกที่ 2

ลากกระแสข้อมูลที่สมบูรณ์และตรวจสอบความถูกต้องจากไลบรารีออบเจ็กต์ไปยังโฟลว์ข้อมูลแบบเปิดในพื้นที่ทำงาน จากนั้นเปิดโฟลว์ข้อมูลที่สร้างขึ้น เลือกวัตถุที่คุณต้องการใช้เป็นพอร์ตอินพุตและเอาต์พุตแล้วคลิกmake port สำหรับวัตถุนั้น

บริการข้อมูลเพิ่มวัตถุนั้นเป็นจุดเชื่อมต่อสำหรับการไหลของข้อมูลแบบฝัง

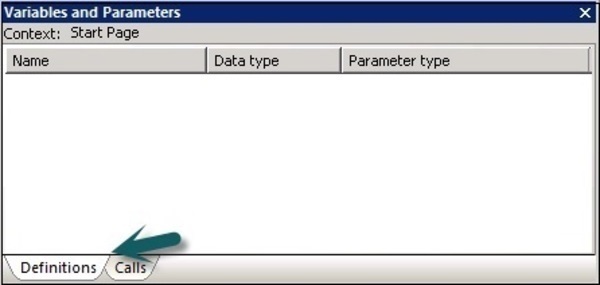

ตัวแปรและพารามิเตอร์

คุณสามารถใช้ตัวแปรภายในและทั่วโลกกับโฟลว์ข้อมูลและเวิร์กโฟลว์ซึ่งให้ความยืดหยุ่นมากขึ้นในการออกแบบงาน

คุณสมบัติที่สำคัญคือ -

ชนิดข้อมูลของตัวแปรอาจเป็นตัวเลขจำนวนเต็มทศนิยมวันที่หรือสตริงข้อความเช่นอักขระ

ตัวแปรสามารถใช้ในโฟลว์ข้อมูลและโฟลว์งานเป็นฟังก์ชันในไฟล์ Where อนุประโยค

ตัวแปรภายในในบริการข้อมูลถูก จำกัด เฉพาะออบเจ็กต์ที่สร้างขึ้น

ตัวแปรส่วนกลางถูก จำกัด เฉพาะงานที่สร้างขึ้น เมื่อใช้ตัวแปรส่วนกลางคุณสามารถเปลี่ยนค่าสำหรับตัวแปรส่วนกลางเริ่มต้นได้ในขณะทำงาน

นิพจน์ที่ใช้ในเวิร์กโฟลว์และโฟลว์ข้อมูลเรียกว่า parameters.

ตัวแปรและพารามิเตอร์ทั้งหมดในผังงานและกระแสข้อมูลจะแสดงในหน้าต่างตัวแปรและพารามิเตอร์

หากต้องการดูตัวแปรและพารามิเตอร์ให้ทำตามขั้นตอนด้านล่าง -

ไปที่เครื่องมือ→ตัวแปร

หน้าต่างใหม่ Variables and parametersจะปรากฏขึ้น มีสองแท็บ - คำจำกัดความและการโทร

Definitionsแท็บช่วยให้คุณสร้างและดูตัวแปรและพารามิเตอร์ คุณสามารถใช้ตัวแปรท้องถิ่นและพารามิเตอร์ที่เวิร์กโฟลว์และระดับกระแสข้อมูล สามารถใช้ตัวแปรส่วนกลางได้ที่ระดับงาน

งาน |

ตัวแปรท้องถิ่น ตัวแปรส่วนกลาง |

สคริปต์หรือเงื่อนไขในงาน วัตถุใด ๆ ในงาน |

ขั้นตอนการทำงาน |

ตัวแปรท้องถิ่น พารามิเตอร์ |

ขั้นตอนการทำงานนี้หรือส่งต่อไปยังโฟลว์งานหรือโฟลว์ข้อมูลอื่นโดยใช้พารามิเตอร์ อ็อบเจ็กต์พาเรนต์เพื่อส่งผ่านตัวแปรโลคัล โฟลว์งานอาจส่งคืนตัวแปรหรือพารามิเตอร์ไปยังอ็อบเจ็กต์พาเรนต์ |

การไหลของข้อมูล |

พารามิเตอร์ |

คำสั่ง WHERE การแมปคอลัมน์หรือฟังก์ชันในกระแสข้อมูล การไหลของข้อมูล กระแสข้อมูลไม่สามารถส่งคืนค่าเอาต์พุต |

ในแท็บการโทรคุณสามารถดูชื่อของพารามิเตอร์ที่กำหนดไว้สำหรับอ็อบเจ็กต์ทั้งหมดในนิยามของอ็อบเจ็กต์พาเรนต์

การกำหนดตัวแปรท้องถิ่น

หากต้องการกำหนด Local Variable ให้เปิดงานตามเวลาจริง

Step 1- ไปที่เครื่องมือ→ตัวแปร ใหม่Variables and Parameters หน้าต่างจะเปิดขึ้น

Step 2 - ไปที่ตัวแปร→คลิกขวา→แทรก

มันจะสร้างพารามิเตอร์ใหม่ $NewVariable0.

Step 3- ป้อนชื่อของตัวแปรใหม่ เลือกประเภทข้อมูลจากรายการ

เมื่อกำหนดแล้วให้ปิดหน้าต่าง ในทำนองเดียวกันคุณสามารถกำหนดพารามิเตอร์สำหรับกระแสข้อมูลและขั้นตอนการทำงานได้

ในกรณีที่งานของคุณทำงานไม่สำเร็จคุณควรแก้ไขข้อผิดพลาดและเรียกใช้งานใหม่ ในกรณีที่งานล้มเหลวมีความเป็นไปได้ที่บางตารางจะถูกโหลดเปลี่ยนแปลงหรือโหลดบางส่วน คุณต้องรันงานอีกครั้งเพื่อรับข้อมูลทั้งหมดและเพื่อลบข้อมูลที่ซ้ำกันหรือขาดหายไป

สองเทคนิคที่สามารถใช้ในการกู้คืนมีดังนี้ -

Automatic Recovery - สิ่งนี้ช่วยให้คุณเรียกใช้งานที่ไม่ประสบความสำเร็จในโหมดการกู้คืน

Manually Recovery - สิ่งนี้ช่วยให้คุณสามารถเรียกใช้งานใหม่ได้โดยไม่ต้องคำนึงถึงการรันซ้ำบางส่วนในครั้งก่อน

To run a job with Recovery option enabled in Designer

Step 1 - คลิกขวาที่ชื่องาน→ดำเนินการ

Step 2 - บันทึกการเปลี่ยนแปลงทั้งหมดและดำเนินการ→ใช่

Step 3- ไปที่แท็บการดำเนินการ→กล่องกาเครื่องหมายเปิดใช้งานการกู้คืน หากไม่ได้เลือกช่องนี้บริการข้อมูลจะไม่กู้คืนงานหากล้มเหลว

To run a job in Recovery mode from Designer

Step 1- คลิกขวาและสั่งงานตามด้านบน บันทึกการเปลี่ยนแปลง.

Step 2- ไปที่ตัวเลือกการดำเนินการ คุณต้องมั่นใจว่าตัวเลือกRecover from last failed execution เลือกช่องแล้ว

Note- ไม่ได้เปิดใช้งานตัวเลือกนี้หากงานยังไม่ถูกดำเนินการ สิ่งนี้เรียกว่าการกู้คืนงานที่ล้มเหลวโดยอัตโนมัติ

Data Services Designer มีคุณลักษณะของ Data Profiling เพื่อให้แน่ใจและปรับปรุงคุณภาพและโครงสร้างของข้อมูลต้นทาง

Data Profiler ช่วยให้คุณ -

ค้นหาความผิดปกติในแหล่งข้อมูลการตรวจสอบความถูกต้องและการดำเนินการแก้ไขและคุณภาพของแหล่งข้อมูล

กำหนดโครงสร้างและความสัมพันธ์ของแหล่งข้อมูลเพื่อการดำเนินการงานกระแสงานและกระแสข้อมูลที่ดีขึ้น

ค้นหาเนื้อหาของแหล่งที่มาและระบบเป้าหมายเพื่อพิจารณาว่างานของคุณส่งคืนผลลัพธ์ที่คาดหวัง

Data Profiler ให้ข้อมูลต่อไปนี้ของการเรียกใช้เซิร์ฟเวอร์ Profiler -

การวิเคราะห์คอลัมน์

Basic Profiling - รวมข้อมูลเช่น min, max, avg ฯลฯ

Detailed Profiling - รวมข้อมูลเช่นจำนวนที่แตกต่างกันเปอร์เซ็นต์ที่แตกต่างกันค่ามัธยฐาน ฯลฯ

การวิเคราะห์ความสัมพันธ์

ความผิดปกติของข้อมูลระหว่างสองคอลัมน์ที่คุณกำหนดความสัมพันธ์

คุณสมบัติการสร้างโปรไฟล์ข้อมูลสามารถใช้กับข้อมูลจากแหล่งข้อมูลต่อไปนี้ -

- เซิร์ฟเวอร์ SQL

- Oracle

- DB2

- ตัวเชื่อมต่อ Attunity

- Sybase IQ

- Teradata

กำลังเชื่อมต่อกับเซิร์ฟเวอร์ Profiler

ในการเชื่อมต่อกับเซิร์ฟเวอร์โปรไฟล์ -

Step 1 - ไปที่ Tools → Profiler Server Login

Step 2 - กรอกรายละเอียดเช่นระบบชื่อผู้ใช้รหัสผ่านและการรับรองความถูกต้อง

Step 3 - คลิกไฟล์ Log on ปุ่ม.

เมื่อคุณเชื่อมต่อรายการที่เก็บ profiler จะแสดงขึ้น เลือกRepository แล้วคลิก Connect.

ประสิทธิภาพของงาน ETL ขึ้นอยู่กับระบบที่คุณใช้ซอฟต์แวร์ Data Services จำนวนการเคลื่อนไหว ฯลฯ

มีปัจจัยอื่น ๆ อีกมากมายที่นำไปสู่ประสิทธิภาพในงาน ETL พวกเขาคือ -

Source Data Base - ควรตั้งค่าฐานข้อมูลต้นทางเพื่อดำเนินการ Selectงบอย่างรวดเร็ว สามารถทำได้โดยการเพิ่มขนาดของฐานข้อมูล I / O เพิ่มขนาดของบัฟเฟอร์ที่ใช้ร่วมกันเพื่อแคชข้อมูลมากขึ้นและไม่อนุญาตให้ขนานกันสำหรับตารางขนาดเล็กเป็นต้น

Source Operating System- ควรกำหนดค่าระบบปฏิบัติการต้นทางให้อ่านข้อมูลจากดิสก์ได้อย่างรวดเร็ว ตั้งค่าโปรโตคอลอ่านล่วงหน้าเป็น 64KB

Target Database - ต้องกำหนดค่าฐานข้อมูลเป้าหมายเพื่อดำเนินการ INSERT และ UPDATEอย่างรวดเร็ว. สามารถทำได้โดย -

- การปิดใช้งานการบันทึกการเก็บถาวร

- ปิดใช้งานการบันทึกซ้ำสำหรับตารางทั้งหมด

- การเพิ่มขนาดของบัฟเฟอร์ที่ใช้ร่วมกัน

Target Operating System- ระบบปฏิบัติการเป้าหมายต้องได้รับการกำหนดค่าเพื่อที่จะเขียนข้อมูลลงในดิสก์ได้อย่างรวดเร็ว คุณสามารถเปิด I / O แบบอะซิงโครนัสเพื่อให้การดำเนินการอินพุต / เอาต์พุตเร็วที่สุด

Network - แบนด์วิดท์เครือข่ายควรเพียงพอสำหรับการถ่ายโอนข้อมูลจากต้นทางไปยังระบบเป้าหมาย

BODS Repository Database - เพื่อปรับปรุงประสิทธิภาพของงาน BODS สามารถทำได้ดังต่อไปนี้ -

Monitor Sample Rate - ในกรณีที่คุณกำลังประมวลผลชุดข้อมูลจำนวนมากในงาน ETL ให้ตรวจสอบอัตราตัวอย่างเป็นค่าที่สูงขึ้นเพื่อลดจำนวนการเรียก I / O ไปยังไฟล์บันทึกซึ่งจะช่วยปรับปรุงประสิทธิภาพ

คุณยังสามารถแยกบันทึกบริการข้อมูลออกจากการสแกนไวรัสได้หากกำหนดค่าการสแกนไวรัสบนเซิร์ฟเวอร์งานเนื่องจากอาจทำให้ประสิทธิภาพลดลง

Job Server OS - ในบริการข้อมูลหนึ่งกระแสข้อมูลในงานจะเริ่มต้น ‘al_engine’กระบวนการซึ่งเริ่มต้นสี่เธรด เพื่อประสิทธิภาพสูงสุดให้พิจารณาการออกแบบที่ทำงานอย่างใดอย่างหนึ่ง‘al_engine’กระบวนการต่อ CPU ในแต่ละครั้ง ระบบปฏิบัติการเซิร์ฟเวอร์งานควรได้รับการปรับแต่งเพื่อให้เธรดทั้งหมดกระจายไปยังซีพียูทั้งหมดที่มี

SAP BO Data Services สนับสนุนการพัฒนาผู้ใช้หลายคนซึ่งผู้ใช้แต่ละคนสามารถทำงานกับแอปพลิเคชันในที่เก็บในเครื่องของตนเองได้ แต่ละทีมใช้ที่เก็บส่วนกลางเพื่อบันทึกสำเนาหลักของแอปพลิเคชันและเวอร์ชันทั้งหมดของอ็อบเจ็กต์ในแอปพลิเคชัน

คุณสมบัติที่สำคัญคือ -

ใน SAP Data Services คุณสามารถสร้างที่เก็บกลางสำหรับจัดเก็บสำเนาทีมของแอปพลิเคชัน ประกอบด้วยข้อมูลทั้งหมดที่มีอยู่ในที่เก็บในเครื่อง อย่างไรก็ตามเพียงแค่ให้ที่เก็บข้อมูลวัตถุ ในการเปลี่ยนแปลงใด ๆ คุณควรต้องทำงานในที่เก็บในเครื่อง

คุณสามารถคัดลอกอ็อบเจ็กต์จากที่เก็บส่วนกลางไปยังที่เก็บโลคัล อย่างไรก็ตามหากคุณต้องทำการเปลี่ยนแปลงใด ๆ คุณต้องตรวจสอบวัตถุนั้นในที่เก็บส่วนกลาง ด้วยเหตุนี้ผู้ใช้รายอื่นจึงไม่สามารถตรวจสอบวัตถุนั้นในที่เก็บส่วนกลางได้ดังนั้นจึงไม่สามารถทำการเปลี่ยนแปลงกับวัตถุเดียวกันได้

เมื่อคุณทำการเปลี่ยนแปลงกับออบเจ็กต์คุณจะต้องเช็คอินสำหรับวัตถุนั้น อนุญาตให้บริการข้อมูลบันทึกอ็อบเจ็กต์ที่แก้ไขใหม่ในที่เก็บส่วนกลาง

บริการข้อมูลอนุญาตให้ผู้ใช้หลายคนที่มีที่เก็บในเครื่องเชื่อมต่อกับที่เก็บส่วนกลางในเวลาเดียวกัน แต่มีผู้ใช้เพียงคนเดียวเท่านั้นที่สามารถตรวจสอบและทำการเปลี่ยนแปลงกับออบเจ็กต์เฉพาะได้

ที่เก็บกลางยังเก็บรักษาประวัติของแต่ละออบเจ็กต์ ช่วยให้คุณสามารถเปลี่ยนกลับไปเป็นอ็อบเจ็กต์เวอร์ชันก่อนหน้าได้หากการเปลี่ยนแปลงไม่ได้ผลลัพธ์ตามที่ต้องการ

ผู้ใช้หลายคน

SAP BO Data Services ช่วยให้ผู้ใช้หลายคนสามารถทำงานบนแอปพลิเคชันเดียวกันได้ในเวลาเดียวกัน คำศัพท์ต่อไปนี้ควรได้รับการพิจารณาในสภาพแวดล้อมที่มีผู้ใช้หลายคน -

| ซีเนียร์ | ผู้ใช้หลายคนและคำอธิบาย |

|---|---|

| 1 | Highest level object วัตถุระดับสูงสุดคือวัตถุที่ไม่ได้ขึ้นอยู่กับวัตถุใด ๆ ในลำดับชั้นของวัตถุ ตัวอย่างเช่นถ้า Job 1 ประกอบด้วย Work Flow 1 และ Data Flow 1 ดังนั้น Job 1 จะเป็นออบเจ็กต์ระดับสูงสุด |

| 2 | Object dependents วัตถุขึ้นอยู่กับวัตถุคือวัตถุที่เกี่ยวข้องภายใต้วัตถุระดับสูงสุดในลำดับชั้น ตัวอย่างเช่นถ้า Job 1 ประกอบด้วย Work Flow 1 ซึ่งมี Data Flow 1 ดังนั้น Work Flow 1 และ Data Flow 1 จะขึ้นอยู่กับ Job 1 นอกจากนี้ Data Flow 1 จะขึ้นอยู่กับ Work Flow 1 |

| 3 | Object version เวอร์ชันอ็อบเจ็กต์คืออินสแตนซ์ของอ็อบเจ็กต์ ทุกครั้งที่คุณเพิ่มหรือตรวจสอบอ็อบเจ็กต์ในที่เก็บส่วนกลางซอฟต์แวร์จะสร้างอ็อบเจ็กต์เวอร์ชันใหม่ เวอร์ชันล่าสุดของอ็อบเจ็กต์คือเวอร์ชันล่าสุดหรือเวอร์ชันล่าสุดที่สร้างขึ้น |

หากต้องการอัพเดตที่เก็บโลคัลในสภาพแวดล้อมที่มีผู้ใช้หลายคนคุณสามารถรับสำเนาล่าสุดของแต่ละอ็อบเจ็กต์จากที่เก็บส่วนกลาง ในการแก้ไขวัตถุคุณสามารถใช้ตัวเลือกเช็คเอาต์และเช็คอิน

มีพารามิเตอร์ความปลอดภัยต่างๆที่สามารถนำไปใช้กับที่เก็บส่วนกลางเพื่อให้ปลอดภัย

พารามิเตอร์ความปลอดภัยต่างๆ ได้แก่ -

Authentication - อนุญาตให้เฉพาะผู้ใช้ที่แท้จริงเท่านั้นที่จะเข้าสู่ระบบที่เก็บส่วนกลาง

Authorization - สิ่งนี้ช่วยให้ผู้ใช้สามารถกำหนดระดับการอนุญาตที่แตกต่างกันสำหรับแต่ละวัตถุ

Auditing- ใช้เพื่อรักษาประวัติของการเปลี่ยนแปลงทั้งหมดที่เกิดขึ้นกับวัตถุ คุณสามารถตรวจสอบเวอร์ชันก่อนหน้าทั้งหมดและเปลี่ยนกลับไปใช้เวอร์ชันเก่าได้

การสร้างที่เก็บกลางที่ไม่ปลอดภัย

ในสภาพแวดล้อมการพัฒนาผู้ใช้หลายคนขอแนะนำให้ทำงานในวิธีการจัดเก็บส่วนกลางเสมอ

ในการสร้างที่เก็บส่วนกลางที่ไม่ปลอดภัยให้ทำตามขั้นตอนที่กำหนด -

Step 1 - สร้างฐานข้อมูลโดยใช้ระบบจัดการฐานข้อมูลซึ่งจะทำหน้าที่เป็นที่เก็บส่วนกลาง

Step 2 - ไปที่ Repository Manager

Step 3- เลือกประเภท Repository เป็น Central ป้อนรายละเอียดฐานข้อมูลเช่นชื่อผู้ใช้และรหัสผ่านแล้วคลิกCreate.

Step 4 - เพื่อกำหนดการเชื่อมต่อกับ Central Repository Tools → Central Repository.

Step 5 - เลือก Repository ในการเชื่อมต่อ Central Repository แล้วคลิกไฟล์ Add ไอคอน.

Step 6 - ป้อนรหัสผ่านสำหรับที่เก็บส่วนกลางแล้วคลิกไฟล์ Activate ปุ่ม.

การสร้าง Secure Central Repository

ในการสร้าง Central Repository ที่ปลอดภัยให้ไปที่ Repository Manager เลือก Repository Type เป็น Central คลิกEnable Security กล่องกาเครื่องหมาย

สำหรับการพัฒนาที่ประสบความสำเร็จในสภาพแวดล้อมที่มีผู้ใช้หลายคนขอแนะนำให้ใช้กระบวนการบางอย่างเช่นเช็คอินและเช็คเอาต์

คุณสามารถใช้กระบวนการต่อไปนี้ในสภาพแวดล้อมที่มีผู้ใช้หลายคน -

- Filtering

- ตรวจสอบวัตถุ

- กำลังยกเลิกการชำระเงิน

- การตรวจสอบในวัตถุ

- การติดฉลากวัตถุ

การกรองสามารถใช้ได้เมื่อคุณเพิ่มวัตถุใด ๆ เช็คอินเช็คเอาต์และติดป้ายกำกับวัตถุไปยังที่เก็บส่วนกลาง

การย้ายงานผู้ใช้หลายคน

ใน SAP Data Services การโอนย้ายงานสามารถใช้ได้ในระดับต่างๆเช่นระดับแอปพลิเคชันระดับพื้นที่เก็บข้อมูลระดับการอัปเกรด

คุณไม่สามารถคัดลอกเนื้อหาของที่เก็บส่วนกลางหนึ่งไปยังที่เก็บส่วนกลางอื่นได้โดยตรง คุณต้องใช้ประโยชน์จากที่เก็บในเครื่อง

ขั้นตอนแรกคือการรับเวอร์ชันล่าสุดของอ็อบเจ็กต์ทั้งหมดจากที่เก็บส่วนกลางไปยังที่เก็บโลคัล เปิดใช้งานที่เก็บส่วนกลางที่คุณต้องการคัดลอกเนื้อหา เพิ่มวัตถุทั้งหมดที่คุณต้องการคัดลอกจากที่เก็บในเครื่องไปยังที่เก็บกลาง

การย้ายที่เก็บส่วนกลาง

หากคุณอัปเดตเวอร์ชันของ SAP Data Services คุณต้องอัปเดตเวอร์ชันของ Repository ด้วย

ควรพิจารณาประเด็นต่อไปนี้เมื่อโอนย้ายที่เก็บส่วนกลางเพื่ออัปเกรดเวอร์ชัน -

สำรองข้อมูลที่เก็บกลางของตารางและวัตถุทั้งหมด

ในการรักษาเวอร์ชันของอ็อบเจ็กต์ใน data services ให้ดูแลที่เก็บส่วนกลางสำหรับแต่ละเวอร์ชัน สร้างประวัติส่วนกลางใหม่ด้วยซอฟต์แวร์ Data Services เวอร์ชันใหม่และคัดลอกออบเจ็กต์ทั้งหมดไปยังที่เก็บนี้

หากคุณติดตั้ง Data Services เวอร์ชันใหม่ขอแนะนำเสมอคุณควรอัปเกรดที่เก็บกลางของคุณเป็นอ็อบเจ็กต์เวอร์ชันใหม่

อัปเกรดที่เก็บในเครื่องของคุณเป็นเวอร์ชันเดียวกันเนื่องจากเวอร์ชันที่แตกต่างกันของที่เก็บส่วนกลางและที่เก็บในเครื่องอาจไม่ทำงานในเวลาเดียวกัน

ก่อนที่จะโอนย้ายที่เก็บกลางให้ตรวจสอบวัตถุทั้งหมด เนื่องจากคุณไม่ได้อัปเกรดที่เก็บส่วนกลางและที่เก็บในเครื่องพร้อมกันดังนั้นจึงจำเป็นต้องตรวจสอบวัตถุทั้งหมด เมื่อคุณอัปเกรดที่เก็บส่วนกลางเป็นเวอร์ชันที่ใหม่กว่าแล้วคุณจะไม่สามารถตรวจสอบออบเจ็กต์จากที่เก็บในเครื่องซึ่งมีบริการข้อมูลเวอร์ชันเก่ากว่า