Python'da Eş Zamanlılık - Hızlı Kılavuz

Bu bölümde, Python'da eşzamanlılık kavramını anlayacak ve farklı iş parçacıkları ve süreçler hakkında bilgi edineceğiz.

Eşzamanlılık nedir?

Basit bir deyişle, eşzamanlılık, aynı anda iki veya daha fazla olayın meydana gelmesidir. Eşzamanlılık doğal bir fenomendir çünkü birçok olay herhangi bir zamanda aynı anda meydana gelir.

Programlama açısından, eşzamanlılık, iki görevin yürütülürken örtüştüğü zamandır. Eşzamanlı programlama ile uygulamalarımızın ve yazılım sistemlerimizin performansı iyileştirilebilir, çünkü bir öncekinin tamamlanmasını beklemek yerine isteklerle eşzamanlı olarak ilgilenebiliriz.

Eş Zamanlılığın Tarihsel İncelemesi

Aşağıdaki noktalar bize eşzamanlılığın kısa tarihsel incelemesini verecektir -

Demiryolları konseptinden

Eşzamanlılık, demiryolları kavramı ile yakından ilgilidir. Demiryolları ile, aynı demiryolu sistemi üzerinde birden çok trenin, her trenin hedefine güvenli bir şekilde varacağı şekilde idare edilmesi gerekiyordu.

Akademide eşzamanlı bilgi işlem

Bilgisayar bilimi eşzamanlılığına ilgi 1965 yılında Edsger W. Dijkstra tarafından yayınlanan araştırma makalesi ile başladı. Bu makalede, eşzamanlılık kontrolünün özelliği olan karşılıklı dışlama sorununu belirledi ve çözdü.

Üst düzey eşzamanlılık ilkelleri

Son zamanlarda, programcılar üst düzey eşzamanlılık ilkelerinin ortaya çıkması nedeniyle gelişmiş eşzamanlı çözümler alıyorlar.

Programlama dilleriyle geliştirilmiş eşzamanlılık

Google'ın Golang, Rust ve Python gibi programlama dilleri, daha iyi eşzamanlı çözümler elde etmemize yardımcı olan alanlarda inanılmaz gelişmeler kaydetti.

İş parçacığı ve çoklu okuma nedir?

Threadbir işletim sisteminde gerçekleştirilebilecek en küçük yürütme birimidir. Kendi başına bir program değildir, ancak bir program içinde çalışır. Başka bir deyişle, ipler birbirinden bağımsız değildir. Her iş parçacığı, kod bölümünü, veri bölümünü vb. Diğer iş parçacıklarıyla paylaşır. Hafif işlemler olarak da bilinirler.

Bir iş parçacığı aşağıdaki bileşenlerden oluşur -

Bir sonraki çalıştırılabilir talimatın adresinden oluşan program sayacı

Stack

Kayıt seti

Benzersiz bir kimlik

MultithreadingÖte yandan, bir CPU'nun aynı anda birden fazla iş parçacığı çalıştırarak işletim sistemi kullanımını yönetme yeteneğidir. Çoklu okumanın ana fikri, bir süreci birden çok iş parçacığına bölerek paralellik sağlamaktır. Çoklu okuma kavramı aşağıdaki örnek yardımıyla anlaşılabilir.

Misal

İçeriği yazmak için MS Word'ü açtığımız belirli bir işlemi yürüttüğümüzü varsayalım. MS Word'ü açmak için bir iş parçacığı atanacak ve içeriğin yazılması için başka bir iş parçacığı gerekli olacaktır. Ve şimdi, mevcut olanı düzenlemek istersek, düzenleme görevini yapmak için başka bir iş parçacığı gerekecektir.

Süreç ve çoklu işlem nedir?

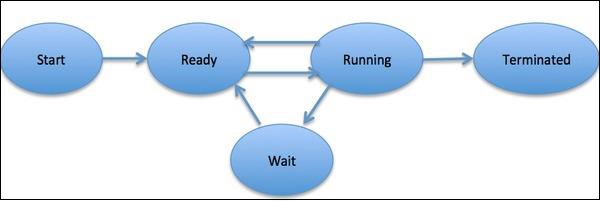

Birprocesssistemde uygulanacak temel iş birimini temsil eden bir varlık olarak tanımlanır. Basit bir ifadeyle bilgisayar programlarımızı bir metin dosyasına yazıyoruz ve bu programı çalıştırdığımızda programda bahsedilen tüm görevleri yerine getiren bir işlem haline geliyor. Süreç yaşam döngüsü boyunca farklı aşamalardan geçer - Başlatma, Hazırlık, Çalıştırma, Bekleme ve Sonlandırma.

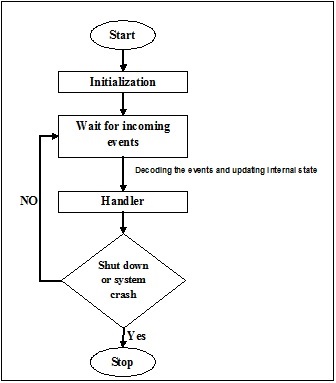

Aşağıdaki şema, bir sürecin farklı aşamalarını göstermektedir -

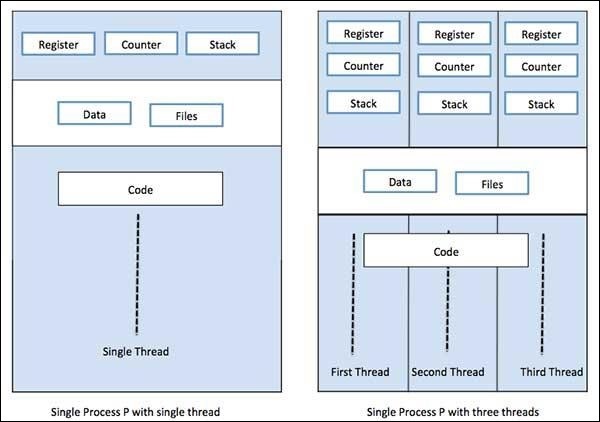

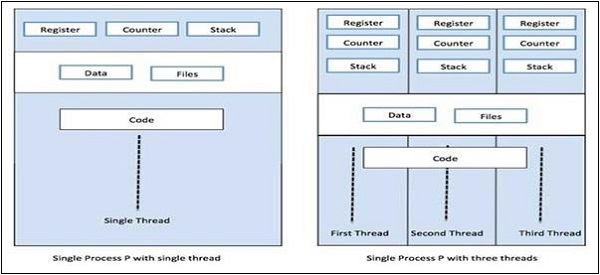

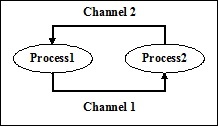

Bir işlem, birincil evre olarak adlandırılan tek bir iş parçacığına veya kendi kayıt kümelerine, program sayacına ve yığınına sahip birden çok evreye sahip olabilir. Aşağıdaki şema bize farkı gösterecektir -

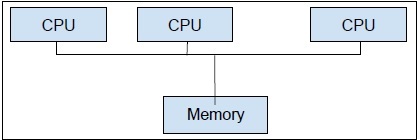

Multiprocessing,Öte yandan, tek bir bilgisayar sistemi içinde iki veya daha fazla CPU biriminin kullanılmasıdır. Birincil hedefimiz, donanımımızdan tam potansiyeli elde etmektir. Bunu başarmak için bilgisayar sistemimizde bulunan tam sayıda CPU çekirdeğini kullanmamız gerekir. Çoklu işlem, bunu yapmak için en iyi yaklaşımdır.

Python, en popüler programlama dillerinden biridir. Eşzamanlı uygulamalar için uygun kılan nedenlerden bazıları şunlardır -

Sözdizimsel şeker

Sözdizimsel şeker, şeyleri okumayı veya ifade etmeyi kolaylaştırmak için tasarlanmış bir programlama dili içindeki sözdizimidir. Dili insan kullanımı için daha "tatlı" kılar: şeyler daha net, daha özlü veya tercihe göre alternatif bir tarzda ifade edilebilir. Python, nesneler üzerinde hareket etmek için tanımlanabilen Magic yöntemleriyle birlikte gelir. Bu Magic yöntemleri, sözdizimsel şeker olarak kullanılır ve daha kolay anlaşılır anahtar kelimelere bağlıdır.

Geniş Topluluk

Python dili, yapay zeka, makine öğrenimi, derin öğrenme ve nicel analiz alanında çalışan veri bilimcileri ve matematikçiler arasında büyük bir benimsenme oranına tanık oldu.

Eşzamanlı programlama için faydalı API'ler

Python 2 ve 3, paralel / eşzamanlı programlama için ayrılmış çok sayıda API'ye sahiptir. Bunların en popülerlerithreading, concurrent.features, multiprocessing, asyncio, gevent and greenlets, vb.

Eşzamanlı uygulamaların uygulanmasında Python'un sınırlamaları

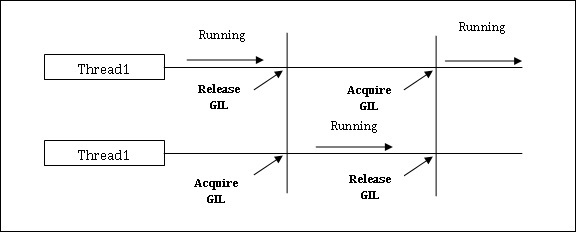

Python, eşzamanlı uygulamalar için bir sınırlama ile birlikte gelir. Bu sınırlama denirGIL (Global Interpreter Lock)Python'da mevcuttur. GIL hiçbir zaman birden fazla CPU çekirdeği kullanmamıza izin vermez ve bu nedenle Python'da gerçek iş parçacığı olmadığını söyleyebiliriz. GIL kavramını şu şekilde anlayabiliriz -

GIL (Global Tercüman Kilidi)

Python dünyasındaki en tartışmalı konulardan biridir. CPython'da GIL mutekstir - işleri iş parçacığını güvenli kılan karşılıklı dışlama kilidi. Başka bir deyişle, GIL'in birden çok iş parçacığının Python kodunu paralel olarak çalıştırmasını engellediğini söyleyebiliriz. Kilit bir seferde yalnızca bir iş parçacığı tarafından tutulabilir ve bir iş parçacığı yürütmek istiyorsak önce kilidi almalıdır. Aşağıda gösterilen şema, GIL'in çalışmasını anlamanıza yardımcı olacaktır.

Ancak, Python'da aşağıdaki gibi bazı kitaplıklar ve uygulamalar vardır: Numpy, Jpython ve IronPytbhon. Bu kitaplıklar GIL ile herhangi bir etkileşim olmadan çalışır.

Çok iş parçacıklı programlarla ilişkili olarak hem eşzamanlılık hem de paralellik kullanılır, ancak aralarındaki benzerlik ve farklılık konusunda çok fazla kafa karışıklığı vardır. Bu konudaki büyük soru: eşzamanlılık paralelliği mi değil mi? Her iki terim de oldukça benzer görünse de, yukarıdaki sorunun cevabı HAYIR olsa da, eşzamanlılık ve paralellik aynı değildir. Şimdi, eğer aynı değillerse, aralarındaki temel fark nedir?

Basit bir ifadeyle, eşzamanlılık, farklı iş parçacıklarından paylaşılan duruma erişimin yönetilmesiyle ilgilenir ve diğer tarafta, paralellik, donanımın performansını artırmak için birden çok CPU'yu veya çekirdeğini kullanma ile ilgilidir.

Ayrıntılı Olarak Eş Zamanlılık

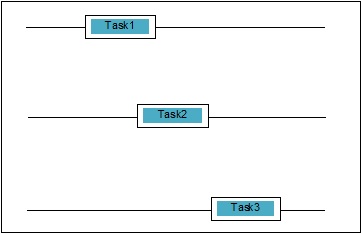

Eşzamanlılık, iki görevin yürütülürken çakışmasıdır. Bir uygulamanın aynı anda birden fazla göreve ilerlediği bir durum olabilir. Şematik olarak anlayabiliriz; aşağıdaki gibi birden çok görev aynı anda ilerliyor -

Eş Zamanlılık Seviyeleri

Bu bölümde, programlama açısından üç önemli eşzamanlılık düzeyini tartışacağız -

Düşük Seviye Eş Zamanlılık

Bu eşzamanlılık düzeyinde, atomik işlemlerin açık kullanımı vardır. Hataya çok açık olduğu ve hata ayıklaması zor olduğu için uygulama oluşturmak için bu tür bir eşzamanlılık kullanamayız. Python bile bu tür eşzamanlılığı desteklemez.

Orta Seviye Eş Zamanlılık

Bu eşzamanlılıkta, açık atomik işlemlerin kullanımı yoktur. Açık kilitleri kullanır. Python ve diğer programlama dilleri bu tür eşzamanlılığı destekler. Çoğunlukla uygulama programcıları bu eşzamanlılığı kullanır.

Üst Düzey Eş Zamanlılık

Bu eşzamanlılıkta, ne açık atomik işlemler ne de açık kilitler kullanılır. Python'daconcurrent.futures Bu tür eşzamanlılığı desteklemek için modül.

Eşzamanlı Sistemlerin Özellikleri

Bir programın veya eşzamanlı sistemin doğru olması için bazı özelliklerin onun tarafından karşılanması gerekir. Sistemin sonlandırılmasına ilişkin özellikler aşağıdaki gibidir -

Doğruluk özelliği

Doğruluk özelliği, programın veya sistemin istenen doğru yanıtı vermesi gerektiği anlamına gelir. Basit tutmak için, sistemin başlangıç program durumunu son duruma doğru bir şekilde eşlemesi gerektiğini söyleyebiliriz.

Güvenlik özelliği

Güvenlik özelliği, programın veya sistemin bir “good” veya “safe” devlet ve asla hiçbir şey yapmaz “bad”.

Canlılık özelliği

Bu özellik, bir programın veya sistemin “make progress” ve arzu edilen bir duruma ulaşacaktır.

Eşzamanlı sistemlerin aktörleri

Bu, kendi görevlerinde ilerleme kaydetmek için aynı anda çalışan birden çok işlem ve iş parçacığının olabileceği eşzamanlı sistemin ortak bir özelliğidir. Bu süreçlere ve iş parçacıklarına eşzamanlı sistemin aktörleri denir.

Eşzamanlı Sistemlerin Kaynakları

Oyuncular görevlerini yerine getirebilmek için bellek, disk, yazıcı vb. Kaynakları kullanmalıdır.

Belirli kurallar seti

Her eşzamanlı sistem, aktörler tarafından gerçekleştirilecek görev türlerini ve her birinin zamanlamasını tanımlayan bir dizi kurala sahip olmalıdır. Görevler kilit alma, bellek paylaşımı, durumu değiştirme vb. Olabilir.

Eşzamanlı Sistemlerin Engelleri

Verilerin paylaşılması

Eşzamanlı sistemleri uygularken önemli bir konu, verilerin birden çok iş parçacığı veya süreç arasında paylaşılmasıdır. Gerçekte, programcı kilitlerin paylaşılan verileri koruduğundan emin olmalıdır, böylece ona tüm erişimler serileştirilir ve bir seferde yalnızca bir iş parçacığı veya işlem paylaşılan verilere erişebilir. Birden fazla iş parçacığı veya işlemin tümü aynı paylaşılan verilere erişmeye çalıştığında, hepsi değil, en az biri engellenecek ve boşta kalacaktır. Başka bir deyişle, kilit yürürlükte iken bir seferde sadece bir süreç veya iş parçacığı kullanabileceğimizi söyleyebiliriz. Yukarıda belirtilen engelleri kaldırmak için bazı basit çözümler olabilir -

Veri Paylaşımı Kısıtlaması

En basit çözüm, değiştirilebilir herhangi bir veriyi paylaşmamaktır. Bu durumda, açık kilitleme kullanmamıza gerek kalmaz ve karşılıklı verilerden kaynaklanan eşzamanlılık engeli çözülür.

Veri Yapısı Yardımı

Çoğu zaman eşzamanlı işlemlerin aynı verilere aynı anda erişmesi gerekir. Açık kilit kullanmaktan başka bir çözüm, eşzamanlı erişimi destekleyen bir veri yapısı kullanmaktır. Örneğin, kullanabilirizqueuemodül, iş parçacığı açısından güvenli kuyruklar sağlar. Ayrıca kullanabilirizmultiprocessing.JoinableQueue çoklu işlem tabanlı eşzamanlılık sınıfları.

Değişmez Veri Transferi

Bazen kullandığımız veri yapısı, mesela eşzamanlılık kuyruğu uygun değildir, o zaman değişmez verileri kilitlemeden geçirebiliriz.

Değişken Veri Aktarımı

Yukarıdaki çözümün devamında, eğer değişmez verilerden ziyade sadece değişken veriyi geçirmemiz gerekiyorsa, o zaman sadece okunabilen değişken veriyi geçirebileceğimizi varsayalım.

G / Ç Kaynaklarının Paylaşımı

Eşzamanlı sistemlerin uygulanmasında bir diğer önemli konu, iş parçacıkları veya süreçler tarafından G / Ç kaynaklarının kullanılmasıdır. Sorun, bir iş parçacığı veya işlem G / Ç'yi bu kadar uzun süre kullandığında ve diğeri boşta kaldığında ortaya çıkar. I / O ağır bir uygulama ile çalışırken bu tür bir engel görebiliriz. Web tarayıcısından sayfaların istenmesi bir örnek yardımı ile anlaşılabilir. Ağır bir uygulamadır. Burada, verinin talep edildiği hız, tüketildiği hızdan daha yavaşsa, eşzamanlı sistemimizde I / O bariyerimiz vardır.

Aşağıdaki Python betiği, bir web sayfası istemek ve ağımızın istenen sayfayı almak için harcadığı zamanı almak içindir -

import urllib.request

import time

ts = time.time()

req = urllib.request.urlopen('http://www.tutorialspoint.com')

pageHtml = req.read()

te = time.time()

print("Page Fetching Time : {} Seconds".format (te-ts))Yukarıdaki komut dosyasını çalıştırdıktan sonra, sayfa getirme zamanını aşağıda gösterildiği gibi alabiliriz.

Çıktı

Page Fetching Time: 1.0991398811340332 SecondsSayfayı getirme süresinin bir saniyeden fazla olduğunu görebiliriz. Şimdi ya binlerce farklı web sayfasını getirmek istersek, ağımızın ne kadar zaman alacağını anlayabilirsiniz.

Paralellik nedir?

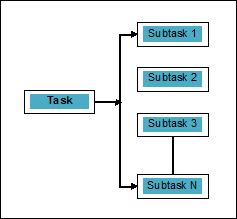

Paralellik, görevleri eşzamanlı olarak işlenebilen alt görevlere bölme sanatı olarak tanımlanabilir. Yukarıda tartışıldığı gibi, aynı anda iki veya daha fazla olayın meydana geldiği eşzamanlılığın tersidir. Şematik olarak anlayabiliriz; bir görev, aşağıdaki gibi paralel olarak işlenebilen birkaç alt göreve bölünür -

Eşzamanlılık ve paralellik arasındaki ayrım hakkında daha fazla fikir edinmek için aşağıdaki noktaları göz önünde bulundurun:

Eşzamanlı ama paralel değil

Bir uygulama eşzamanlı olabilir ancak paralel olmayabilir, aynı anda birden fazla görevi işlediği, ancak görevlerin alt görevlere ayrılmadığı anlamına gelir.

Paralel ama eşzamanlı değil

Bir uygulama paralel olabilir ancak eşzamanlı olmayabilir, bir seferde yalnızca bir görev üzerinde çalıştığı ve alt görevlere bölünmüş görevlerin paralel olarak işlenebileceği anlamına gelir.

Ne paralel ne de eşzamanlı

Bir uygulama ne paralel ne de eşzamanlı olabilir. Bu, aynı anda yalnızca bir görev üzerinde çalıştığı ve görevin asla alt görevlere ayrılmadığı anlamına gelir.

Hem paralel hem de eşzamanlı

Bir uygulama hem paralel hem de eşzamanlı olabilir, yani aynı anda birden çok görevde çalışır ve görev, bunları paralel olarak yürütmek için alt görevlere bölünür.

Paralelliğin Gerekliliği

Alt görevleri tek CPU'nun farklı çekirdekleri arasında veya bir ağa bağlı birden fazla bilgisayar arasında dağıtarak paralellik sağlayabiliriz.

Paralelliğe ulaşmak için neden gerekli olduğunu anlamak için aşağıdaki önemli noktaları göz önünde bulundurun -

Verimli kod yürütme

Paralellik yardımıyla kodumuzu verimli bir şekilde çalıştırabiliriz. Aynı kod parçalar halinde paralel olarak çalıştığı için zamandan tasarruf edecek.

Sıralı hesaplamadan daha hızlı

Sıralı hesaplama, daha hızlı hesaplama sonuçları elde etmenin mümkün olmadığı fiziksel ve pratik faktörlerle sınırlıdır. Öte yandan, bu sorun paralel hesaplamayla çözülür ve bize sıralı hesaplamadan daha hızlı hesaplama sonuçları verir.

Daha az uygulama süresi

Paralel işleme, program kodunun yürütme süresini azaltır.

Gerçek hayattaki paralellik örneğinden bahsedecek olursak, bilgisayarımızın grafik kartı paralel işlemenin gerçek gücünü vurgulayan örnektir çünkü bağımsız olarak çalışan ve aynı anda yürütmeyi yapabilen yüzlerce ayrı işlemci çekirdeğine sahiptir. Bu nedenle, üst düzey uygulamaları ve oyunları da çalıştırabiliyoruz.

Uygulama için işlemcilerin anlaşılması

Eşzamanlılık, paralellik ve aralarındaki farkı biliyoruz ama uygulanacağı sistem ne olacak? Uygulayacağımız sistem anlayışına sahip olmak çok gerekli çünkü yazılımı tasarlarken bilinçli kararlar almamız bize fayda sağlıyor. Aşağıdaki iki tür işlemciye sahibiz -

Tek çekirdekli işlemciler

Tek çekirdekli işlemciler, herhangi bir zamanda bir iş parçacığını yürütebilir. Bu işlemciler kullanırcontext switchingbir iş parçacığı için gerekli tüm bilgileri belirli bir zamanda depolamak ve ardından bilgileri daha sonra geri yüklemek için. Bağlam değiştirme mekanizması, belirli bir saniye içinde bir dizi iş parçacığı üzerinde ilerleme kaydetmemize yardımcı olur ve sistem birden çok şey üzerinde çalışıyormuş gibi görünür.

Tek çekirdekli işlemcilerin birçok avantajı vardır. Bu işlemciler daha az güç gerektirir ve birden çok çekirdek arasında karmaşık bir iletişim protokolü yoktur. Öte yandan, tek çekirdekli işlemcilerin hızı sınırlıdır ve daha büyük uygulamalar için uygun değildir.

Çok çekirdekli işlemciler

Çok çekirdekli işlemcilerin birden çok bağımsız işlem birimi vardır. cores.

Bu tür işlemciler bağlam değiştirme mekanizmasına ihtiyaç duymaz, çünkü her çekirdek bir dizi depolanan talimatı yürütmek için ihtiyaç duyduğu her şeyi içerir.

Getirme-Kod Çözme-Yürütme Döngüsü

Çok çekirdekli işlemcilerin çekirdekleri, yürütme için bir döngü izler. Bu döngü denirFetch-Decode-Executedöngü. Aşağıdaki adımları içerir -

Getir

Bu, program belleğinden talimatların alınmasını içeren çevrimin ilk adımıdır.

Kod çözme

Yakın zamanda alınan talimatlar, CPU'nun diğer bölümlerini tetikleyecek bir dizi sinyale dönüştürülecektir.

Yürüt

Alınan ve kodu çözülen talimatların yürütüleceği son adımdır. Yürütmenin sonucu bir CPU kaydında saklanacaktır.

Buradaki avantajlardan biri, çok çekirdekli işlemcilerdeki yürütmenin tek çekirdekli işlemcilerden daha hızlı olmasıdır. Daha büyük uygulamalar için uygundur. Öte yandan, birden çok çekirdek arasındaki karmaşık iletişim protokolü bir sorundur. Birden çok çekirdek, tek çekirdekli işlemcilerden daha fazla güç gerektirir.

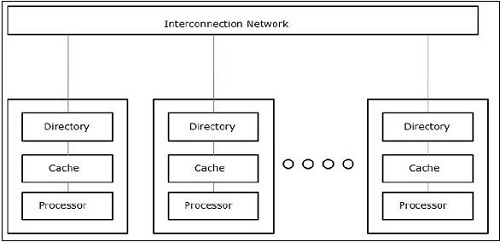

Programı veya eşzamanlı sistemi tasarlarken dikkate alınması gereken farklı sistem ve bellek mimarisi stilleri vardır. Bu çok gereklidir, çünkü bir sistem ve bellek stili bir görev için uygun olabilir, ancak diğer göreve hataya açık olabilir.

Eşzamanlılığı destekleyen bilgisayar sistemi mimarileri

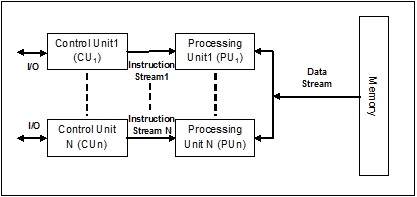

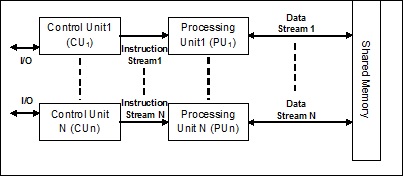

Michael Flynn, 1972'de bilgisayar sistemi mimarisinin farklı stillerini kategorize etmek için taksonomi verdi. Bu sınıflandırma, dört farklı stili şu şekilde tanımlar:

- Tek talimat akışı, tek veri akışı (SISD)

- Tek talimat akışı, çoklu veri akışı (SIMD)

- Çoklu talimat akışı, tek veri akışı (MISD)

- Çoklu talimat akışı, çoklu veri akışı (MIMD).

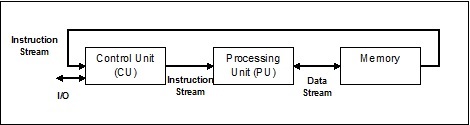

Tek talimat akışı, tek veri akışı (SISD)

Adından da anlaşılacağı gibi, bu tür sistemler, bir sıralı gelen veri akışına ve veri akışını yürütmek için tek bir işlem birimine sahip olacaktır. Paralel bilgi işlem mimarisine sahip tek işlemcili sistemler gibidirler. SISD'nin mimarisi aşağıdadır -

SISD'nin Avantajları

SISD mimarisinin avantajları aşağıdaki gibidir -

- Daha az güç gerektirir.

- Birden çok çekirdek arasında karmaşık iletişim protokolü sorunu yoktur.

SISD'nin dezavantajları

SISD mimarisinin dezavantajları aşağıdaki gibidir -

- SISD mimarisinin hızı, tıpkı tek çekirdekli işlemciler gibi sınırlıdır.

- Daha büyük uygulamalar için uygun değildir.

Tek talimat akışı, çoklu veri akışı (SIMD)

Adından da anlaşılacağı gibi, bu tür sistemler birden çok gelen veri akışına ve herhangi bir zamanda tek bir talimat üzerinde hareket edebilen işlem birimlerinin sayısına sahip olacaktır. Paralel bilgi işlem mimarisine sahip çok işlemcili sistemler gibidirler. SIMD'nin mimarisi aşağıdadır -

SIMD için en iyi örnek grafik kartlarıdır. Bu kartların yüzlerce ayrı işlem birimi vardır. SISD ve SIMD arasındaki hesaplama farkından bahsedersek, dizileri eklemek için[5, 15, 20] ve [15, 25, 10],SISD mimarisinin üç farklı ekleme işlemi gerçekleştirmesi gerekir. Öte yandan, SIMD mimarisi ile tek bir ekleme işlemi ekleyebiliriz.

SIMD'nin Avantajları

SIMD mimarisinin avantajları aşağıdaki gibidir -

Birden fazla eleman üzerinde aynı işlem yalnızca bir komut kullanılarak gerçekleştirilebilir.

İşlemcinin çekirdek sayısı artırılarak sistemin verimi artırılabilir.

İşlem hızı SISD mimarisinden daha yüksektir.

SIMD'nin dezavantajları

SIMD mimarisinin dezavantajları aşağıdaki gibidir -

- İşlemci çekirdeği sayısı arasında karmaşık bir iletişim vardır.

- Maliyet SISD mimarisinden daha yüksektir.

Çoklu Talimat Tek Veri (MISD) akışı

MISD akışına sahip sistemler, aynı veri seti üzerinde farklı talimatlar uygulayarak farklı işlemler gerçekleştiren çok sayıda işleme birimine sahiptir. MISD'nin mimarisi aşağıdadır -

MISD mimarisinin temsilcileri henüz ticari olarak mevcut değil.

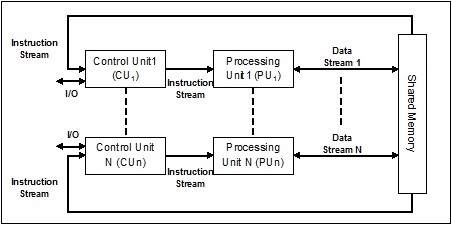

Çoklu Talimat Çoklu Veri (MIMD) akışı

MIMD mimarisini kullanan sistemde, çok işlemcili bir sistemdeki her işlemci, paralel olarak farklı veri kümeleri üzerinde bağımsız olarak farklı talimat kümelerini yürütebilir. Tek işlemin birden çok veri seti üzerinde yürütüldüğü SIMD mimarisinin tam tersidir. MIMD'nin mimarisi aşağıdadır -

Normal bir çoklu işlemci MIMD mimarisini kullanır. Bu mimariler temel olarak bilgisayar destekli tasarım / bilgisayar destekli üretim, simülasyon, modelleme, iletişim anahtarları vb. Gibi bir dizi uygulama alanında kullanılmaktadır.

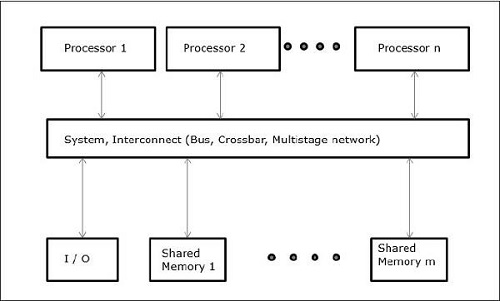

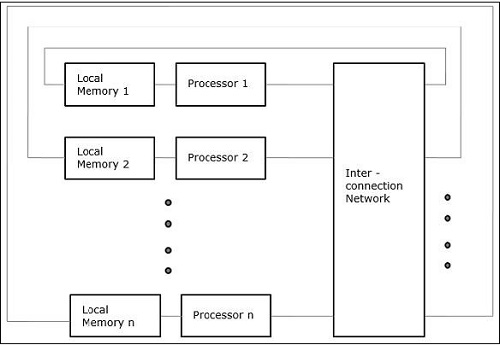

Eşzamanlılığı destekleyen bellek mimarileri

Eşzamanlılık ve paralellik gibi kavramlarla çalışırken her zaman programları hızlandırmaya ihtiyaç vardır. Bilgisayar tasarımcıları tarafından bulunan bir çözüm, paylaşımlı bellekli çoklu bilgisayarlar, yani bir işlemcinin sahip olduğu tüm çekirdekler tarafından erişilen tek fiziksel adres alanına sahip bilgisayarlar yaratmaktır. Bu senaryoda, birkaç farklı mimari tarzı olabilir, ancak aşağıdakiler üç önemli mimari tarzıdır:

UMA (Tekdüzen Bellek Erişimi)

Bu modelde, tüm işlemciler fiziksel belleği aynı şekilde paylaşır. Tüm işlemcilerin tüm bellek sözcüklerine eşit erişim süresi vardır. Her işlemcinin özel bir önbelleği olabilir. Çevresel cihazlar bir dizi kurala uyar.

Tüm işlemciler tüm çevresel aygıtlara eşit erişime sahip olduğunda, sisteme symmetric multiprocessor. Çevre aygıtlarına yalnızca bir veya birkaç işlemci erişebildiğinde, sistemeasymmetric multiprocessor.

Tekdüzen Olmayan Bellek Erişimi (NUMA)

NUMA çok işlemcili modelde, erişim süresi bellek sözcüğünün konumuna göre değişir. Burada paylaşılan hafıza, yerel hafıza adı verilen tüm işlemciler arasında fiziksel olarak dağıtılır. Tüm yerel belleklerin toplanması, tüm işlemciler tarafından erişilebilen küresel bir adres alanı oluşturur.

Yalnızca Önbellek Bellek Mimarisi (COMA)

COMA modeli, NUMA modelinin özel bir versiyonudur. Burada, dağıtılan tüm ana bellekler önbellek belleğine dönüştürülür.

Genel olarak, bildiğimiz gibi, iplik genellikle pamuklu veya ipek kumaştan çok ince bükümlü bir iptir ve giysi dikmek için kullanılır. Aynı terim, bilgisayar programlama dünyasında da kullanılmaktadır. Şimdi, giysi dikmek için kullanılan ipliği bilgisayar programlaması için kullanılan iplikle nasıl ilişkilendireceğiz? İki iş parçacığı tarafından gerçekleştirilen roller burada benzerdir. Giysilerde iplik, bezi bir arada tutar ve diğer tarafta, bilgisayar programlamasında, iplik bilgisayar programını tutar ve programın aynı anda sıralı eylemleri veya birçok eylemi gerçekleştirmesine izin verir.

Threadbir işletim sistemindeki en küçük yürütme birimidir. Kendi başına bir program değildir, ancak bir program içinde çalışır. Başka bir deyişle, evreler birbirinden bağımsız değildir ve kod bölümünü, veri bölümünü vb. Diğer evreler ile paylaşır. Bu iplikler aynı zamanda hafif işlemler olarak da bilinir.

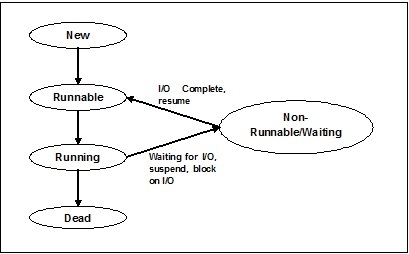

İplik Durumları

İş parçacığının işlevselliğini derinlemesine anlamak için, iş parçacığının yaşam döngüsü veya farklı iş parçacığı durumları hakkında bilgi edinmemiz gerekir. Tipik olarak, bir iş parçacığı beş farklı durumda bulunabilir. Farklı durumlar aşağıda gösterilmiştir -

Yeni Konu

Yeni bir iş parçacığı, yeni durumda yaşam döngüsüne başlar. Ancak bu aşamada henüz başlamamış ve herhangi bir kaynak tahsis edilmemiştir. Bunun sadece bir nesnenin örneği olduğunu söyleyebiliriz.

Runnable

Yeni doğan iplik başlatıldığında, iplik çalıştırılabilir hale gelir, yani çalışmayı bekler. Bu durumda, tüm kaynaklara sahiptir, ancak yine de görev zamanlayıcı çalışacak şekilde zamanlamamıştır.

Koşu

Bu durumda, iş parçacığı ilerleme kaydeder ve çalıştırmak için görev zamanlayıcı tarafından seçilen görevi yürütür. Şimdi, iş parçacığı ya ölü duruma ya da çalıştırılamaz / bekleme durumuna gidebilir.

Çalışmıyor / beklemede

Bu durumda, iş parçacığı duraklatılır çünkü ya bazı G / Ç isteğinin yanıtını beklemektedir ya da diğer iş parçacığının yürütülmesinin tamamlanmasını beklemektedir.

Ölü

Çalıştırılabilir bir evre, görevini tamamladığında veya başka şekilde sona erdiğinde sonlandırılmış duruma girer.

Aşağıdaki şema, bir iş parçacığının tüm yaşam döngüsünü göstermektedir -

İplik Türleri

Bu bölümde, farklı iplik türlerini göreceğiz. Türler aşağıda açıklanmıştır -

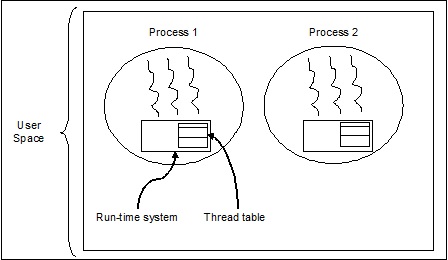

Kullanıcı Seviyesi Konuları

Bunlar kullanıcı tarafından yönetilen konulardır.

Bu durumda, iş parçacığı yönetimi çekirdeği evrelerin varlığından haberdar değildir. İş parçacığı kitaplığı evrelerin yaratılması ve yok edilmesi, ileti ve verilerin evreler arasında iletilmesi, iş parçacığı yürütmesinin programlanması ve iş parçacığı bağlamlarının kaydedilmesi ve geri yüklenmesi için kod içerir. Uygulama tek bir iş parçacığı ile başlar.

Kullanıcı düzeyindeki iş parçacığı örnekleri şunlardır:

- Java konuları

- POSIX konuları

Kullanıcı seviyesindeki Konuların Avantajları

Aşağıdakiler, kullanıcı seviyesi konularının farklı avantajlarıdır -

- İş parçacığı değiştirme, Kernel modu ayrıcalıkları gerektirmez.

- Kullanıcı seviyesi iş parçacığı herhangi bir işletim sisteminde çalışabilir.

- Çizelgeleme, kullanıcı seviyesi iş parçacığında uygulamaya özel olabilir.

- Kullanıcı düzeyinde iş parçacıkları oluşturmak ve yönetmek hızlıdır.

Kullanıcı seviyesindeki Konuların dezavantajları

Aşağıdakiler, kullanıcı seviyesi konularının farklı dezavantajlarıdır -

- Tipik bir işletim sisteminde, çoğu sistem çağrısı engelliyor.

- Çok iş parçacıklı uygulama, çoklu işlemden yararlanamaz.

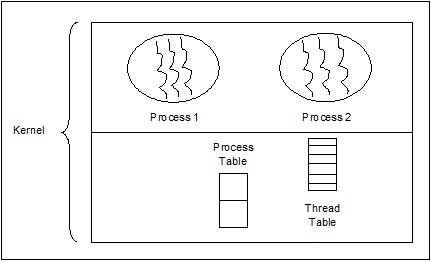

Çekirdek Seviyesi Konuları

İşletim Sistemi tarafından yönetilen iş parçacıkları, bir işletim sistemi çekirdeği olan çekirdek üzerinde hareket eder.

Bu durumda Kernel, iş parçacığı yönetimi yapar. Uygulama alanında iş parçacığı yönetimi kodu yoktur. Çekirdek iş parçacıkları doğrudan işletim sistemi tarafından desteklenir. Herhangi bir uygulama, çok iş parçacıklı olacak şekilde programlanabilir. Bir uygulama içindeki tüm iş parçacıkları tek bir süreç içinde desteklenir.

Çekirdek, bir bütün olarak sürecin bağlam bilgisini ve süreç içindeki tek tek iş parçacıklarını saklar. Çekirdek tarafından zamanlama iş parçacığı temelinde yapılır. Kernel, Kernel alanında iş parçacığı oluşturma, planlama ve yönetim gerçekleştirir. Çekirdek iş parçacıklarının oluşturulması ve yönetilmesi genellikle kullanıcı iş parçacıklarından daha yavaştır. Çekirdek seviyesi iş parçacığı örnekleri Windows, Solaris'tir.

Çekirdek Seviyesi Konularının Avantajları

Aşağıda, çekirdek düzeyinde iş parçacıklarının farklı avantajları verilmiştir -

Çekirdek aynı anda birden çok işlemde aynı işlemden birden çok iş parçacığı planlayabilir.

İşlemdeki bir iş parçacığı engellenirse, Çekirdek aynı işlemin başka bir iş parçacığını zamanlayabilir.

Çekirdek rutinleri çok iş parçacıklı olabilir.

Çekirdek Seviyesi Konularının Dezavantajları

Çekirdek iş parçacıklarının oluşturulması ve yönetilmesi genellikle kullanıcı iş parçacıklarından daha yavaştır.

Aynı süreç içinde bir iş parçacığından diğerine kontrol aktarımı, Çekirdeğe bir mod anahtarı gerektirir.

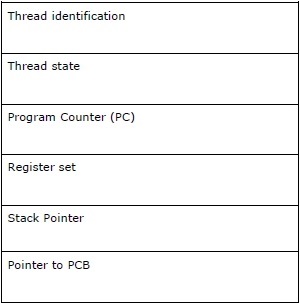

İplik Kontrol Bloğu - TCB

İş Parçacığı Kontrol Bloğu (TCB), temel olarak iş parçacığı hakkında bilgi içeren işletim sistemi çekirdeğindeki veri yapısı olarak tanımlanabilir. TCB'de depolanan iş parçacığına özgü bilgiler, her işlemle ilgili bazı önemli bilgileri vurgulayacaktır.

TCB'de bulunan konularla ilgili aşağıdaki noktaları göz önünde bulundurun -

Thread identification - Her yeni iş parçacığına atanan benzersiz iş parçacığı kimliğidir (tid).

Thread state - İş parçacığının durumu (Çalışıyor, Çalıştırılabilir, Çalışmıyor, Ölü) ile ilgili bilgileri içerir.

Program Counter (PC) - İş parçacığının mevcut program talimatını gösterir.

Register set - İş parçacığının hesaplamalar için kendilerine atanan yazmaç değerlerini içerir.

Stack Pointer- İşlemdeki iş parçacığının yığınına işaret eder. İş parçacığının kapsamı altındaki yerel değişkenleri içerir.

Pointer to PCB - Bu iş parçacığını oluşturan işlemin işaretçisini içerir.

Süreç ve iş parçacığı arasındaki ilişki

Çoklu kullanımda, süreç ve iş parçacığı, bilgisayarın aynı anda birden fazla şeyi yapabilmesini sağlamak için aynı amaca sahip, birbiriyle çok yakından ilişkili iki terimdir. Bir süreç bir veya daha fazla iş parçacığı içerebilir, ancak tersine iş parçacığı bir işlem içeremez. Ancak, ikisi de iki temel yürütme birimi olmaya devam ediyor. Bir dizi talimatı yürüten bir program, hem süreci hem de iş parçacığını başlatır.

Aşağıdaki tablo süreç ve iş parçacığı arasındaki karşılaştırmayı gösterir -

| İşlem | Konu |

|---|---|

| Süreç ağırdır veya kaynak yoğundur. | İş parçacığı hafiftir ve bir işlemden daha az kaynak gerektirir. |

| Süreç değiştirme, işletim sistemiyle etkileşim gerektirir. | İş parçacığı değiştirmenin işletim sistemiyle etkileşime girmesine gerek yoktur. |

| Birden çok işlem ortamında, her işlem aynı kodu yürütür ancak kendi belleğine ve dosya kaynaklarına sahiptir. | Tüm iş parçacıkları aynı açık dosya kümesini, alt işlemleri paylaşabilir. |

| Bir işlem engellenirse, ilk işlem engeli kaldırılıncaya kadar başka hiçbir işlem yürütülemez. | Bir iş parçacığı engellenip beklerken, aynı görevdeki ikinci bir iş parçacığı çalıştırılabilir. |

| İş parçacığı kullanmadan birden çok işlem daha fazla kaynak kullanır. | Çoklu iş parçacıklı süreçler daha az kaynak kullanır. |

| Çoklu süreçlerde her süreç diğerlerinden bağımsız olarak çalışır. | Bir iş parçacığı başka bir iş parçacığının verilerini okuyabilir, yazabilir veya değiştirebilir. |

| Üst süreçte herhangi bir değişiklik olursa, alt süreçleri etkilemez. | Ana iş parçacığında herhangi bir değişiklik olursa, bu işlemin diğer iş parçacıklarının davranışını etkileyebilir. |

| Kardeş süreçlerle iletişim kurmak için süreçler süreçler arası iletişimi kullanmalıdır. | Konular, bu sürecin diğer konuları ile doğrudan iletişim kurabilir. |

Multithreading Kavramı

Daha önce tartıştığımız gibi, Multithreading, bir CPU'nun aynı anda birden fazla iş parçacığı çalıştırarak işletim sistemi kullanımını yönetme becerisidir. Çoklu okumanın ana fikri, bir süreci birden çok iş parçacığına bölerek paralellik sağlamaktır. Daha basit bir şekilde, çoklu iş parçacığının, iş parçacığı kavramını kullanarak çoklu görevi başarmanın yolu olduğunu söyleyebiliriz.

Çoklu okuma kavramı aşağıdaki örnek yardımıyla anlaşılabilir.

Misal

Bir işlem yürüttüğümüzü varsayalım. Süreç, bir şeyler yazmak için MS kelimesini açmak olabilir. Bu tür bir işlemde, bir iş parçacığı MS sözcüğünü açmak için atanacak ve yazmak için başka bir iş parçacığı gerekecektir. Şimdi, bir şeyi düzenlemek istiyorsak, düzenleme görevini yapmak için başka bir iş parçacığı gerekeceğini varsayalım.

Aşağıdaki şema, bellekte nasıl birden fazla iş parçacığı bulunduğunu anlamamıza yardımcı olur -

Yukarıdaki diyagramda, her iş parçacığının kendi kayıt kümesini ve yerel değişkenleri içerdiği bir süreç içinde birden fazla evrenin var olabileceğini görebiliriz. Bunun dışında, bir süreçteki tüm iş parçacıkları genel değişkenleri paylaşır.

Multithreading Artıları

Şimdi çoklu kullanımın birkaç avantajını görelim. Avantajlar aşağıdaki gibidir -

Speed of communication - Çok iş parçacıklı okuma, hesaplama hızını artırır, çünkü her bir çekirdek veya işlemci aynı anda ayrı iş parçacıkları işler.

Program remains responsive - Bir iş parçacığı girdiyi beklerken diğeri aynı anda bir GUI çalıştırdığı için bir programın yanıt vermesini sağlar.

Access to global variables - Çoklu kullanımda, belirli bir sürecin tüm iş parçacıkları genel değişkenlere erişebilir ve genel değişkende herhangi bir değişiklik varsa, o zaman diğer iş parçacıkları tarafından da görülebilir.

Utilization of resources - Her programda birkaç iş parçacığının çalıştırılması, CPU'nun daha iyi kullanılmasını sağlar ve CPU'nun boşta kalma süresi azalır.

Sharing of data - Her iş parçacığı için fazladan alana gerek yoktur, çünkü bir programdaki evreler aynı verileri paylaşabilir.

Multithreading Eksileri

Şimdi çoklu kullanımın birkaç dezavantajını görelim. Dezavantajlar aşağıdaki gibidir -

Not suitable for single processor system - Multithreading, çok işlemcili sistemdeki performansa kıyasla tek işlemcili sistemde hesaplama hızı açısından performans elde etmeyi zor buluyor.

Issue of security - Bir programdaki tüm iş parçacığının aynı verileri paylaştığını bildiğimiz için, bu nedenle her zaman bir güvenlik sorunu vardır, çünkü bilinmeyen herhangi bir iş parçacığı verileri değiştirebilir.

Increase in complexity - Çoklu okuma, programın karmaşıklığını artırabilir ve hata ayıklama zorlaşır.

Lead to deadlock state - Çoklu okuma, programı kilitlenme durumuna ulaşma olasılığına yol açabilir.

Synchronization required- Karşılıklı dışlamayı önlemek için senkronizasyon gereklidir. Bu, daha fazla bellek ve CPU kullanımına yol açar.

Bu bölümde, iş parçacıklarının Python'da nasıl uygulanacağını öğreneceğiz.

Thread Uygulaması için Python Modülü

Python iş parçacıkları bazen hafif işlemler olarak adlandırılır çünkü iş parçacıkları işlemlerden çok daha az bellek kullanır. İş parçacığı, aynı anda birden fazla görevi gerçekleştirmeye izin verir. Python'da, bir programda iş parçacıkları uygulayan aşağıdaki iki modüle sahibiz:

<_thread>module

<threading>module

Bu iki modül arasındaki temel fark şudur: <_thread> modül bir iş parçacığını bir işlev olarak ele alırken, <threading>modül her evreyi bir nesne olarak ele alır ve nesneye yönelik bir şekilde uygular. Dahası,<_thread>modülü, düşük seviyeli diş açmada etkilidir ve <threading> modül.

<_thread> modülü

Python'un önceki sürümünde, <thread>modül, ancak oldukça uzun bir süredir "kullanımdan kaldırıldı" olarak kabul edildi. Kullanıcılar şunları kullanmaya teşvik edilmiştir:<threading>modül yerine. Bu nedenle, Python 3'te "thread" modülü artık mevcut değildir. "Olarak yeniden adlandırıldı<_thread>"Python3'teki geriye dönük uyumsuzluklar için.

Yardımıyla yeni iş parçacığı oluşturmak <_thread> modülü aramalıyız start_new_threadyöntemi. Bu yöntemin çalışması, aşağıdaki sözdizimi yardımıyla anlaşılabilir -

_thread.start_new_thread ( function, args[, kwargs] )Burada -

args bir grup argümandır

kwargs isteğe bağlı bir anahtar kelime argümanları sözlüğüdür

Bir argüman iletmeden işlevi çağırmak istiyorsak, o zaman içinde boş bir argüman demeti kullanmamız gerekir. args.

Bu yöntem çağrısı hemen döner, çocuk evre başlar ve işlevi, varsa, args'ın geçirilen listesiyle çağırır. İş parçacığı, işlev döndüğünde sona erer.

Misal

Aşağıda, kullanarak yeni iş parçacığı oluşturmaya bir örnek verilmiştir. <_thread>modül. Burada start_new_thread () yöntemini kullanıyoruz.

import _thread

import time

def print_time( threadName, delay):

count = 0

while count < 5:

time.sleep(delay)

count += 1

print ("%s: %s" % ( threadName, time.ctime(time.time()) ))

try:

_thread.start_new_thread( print_time, ("Thread-1", 2, ) )

_thread.start_new_thread( print_time, ("Thread-2", 4, ) )

except:

print ("Error: unable to start thread")

while 1:

passÇıktı

Aşağıdaki çıktı, yeni iş parçacıklarının neslini anlamamıza yardımcı olacaktır. <_thread> modül.

Thread-1: Mon Apr 23 10:03:33 2018

Thread-2: Mon Apr 23 10:03:35 2018

Thread-1: Mon Apr 23 10:03:35 2018

Thread-1: Mon Apr 23 10:03:37 2018

Thread-2: Mon Apr 23 10:03:39 2018

Thread-1: Mon Apr 23 10:03:39 2018

Thread-1: Mon Apr 23 10:03:41 2018

Thread-2: Mon Apr 23 10:03:43 2018

Thread-2: Mon Apr 23 10:03:47 2018

Thread-2: Mon Apr 23 10:03:51 2018<iş parçacığı> modülü

<threading>modülü nesneye yönelik bir şekilde uygular ve her evreyi bir nesne olarak ele alır. Bu nedenle, iş parçacıkları için <_thread> modülünden çok daha güçlü, üst düzey destek sağlar. Bu modül Python 2.4'e dahildir.

<threading> modülündeki ek yöntemler

<threading> modülün tüm yöntemlerini içerir <_thread>modül ancak ek yöntemler de sağlar. Ek yöntemler aşağıdaki gibidir -

threading.activeCount() - Bu yöntem, aktif olan iş parçacığı nesnelerinin sayısını döndürür

threading.currentThread() - Bu yöntem, çağıranın iş parçacığı kontrolündeki iş parçacığı nesnelerinin sayısını döndürür.

threading.enumerate() - Bu yöntem, şu anda aktif olan tüm iş parçacığı nesnelerinin bir listesini döndürür.

run() - run () yöntemi, bir iş parçacığının giriş noktasıdır.

start() - start () yöntemi, çalıştırma yöntemini çağırarak bir iş parçacığı başlatır.

join([time]) - join (), iş parçacıklarının sona ermesini bekler.

isAlive() - isAlive () yöntemi, bir iş parçacığının hala yürütülmekte olup olmadığını kontrol eder.

getName() - getName () yöntemi bir iş parçacığının adını döndürür.

setName() - setName () yöntemi bir iş parçacığının adını belirler.

Diş çekme uygulamak için, <threading> modülde Thread Aşağıdaki yöntemleri sağlayan sınıf -

<Threading> modülünü kullanarak iş parçacığı nasıl oluşturulur?

Bu bölümde, kullanarak iş parçacığı oluşturmayı öğreneceğiz. <threading>modül. <Threading> modülünü kullanarak yeni bir iş parçacığı oluşturmak için şu adımları izleyin -

Step 1 - Bu adımda, yeni bir alt sınıf tanımlamamız gerekiyor. Thread sınıf.

Step 2 - Daha sonra ek argümanlar eklemek için, __init__(self [,args]) yöntem.

Step 3 - Bu adımda, başlatıldığında iş parçacığının ne yapması gerektiğini uygulamak için run (self [, args]) yöntemini geçersiz kılmamız gerekir.

Şimdi, yenisini oluşturduktan sonra Thread alt sınıf, bunun bir örneğini oluşturabilir ve ardından yeni bir iş parçacığı başlatabiliriz. start()bu da sırayla run() yöntem.

Misal

Nasıl yeni bir iş parçacığı oluşturacağınızı öğrenmek için bu örneği düşünün. <threading> modül.

import threading

import time

exitFlag = 0

class myThread (threading.Thread):

def __init__(self, threadID, name, counter):

threading.Thread.__init__(self)

self.threadID = threadID

self.name = name

self.counter = counter

def run(self):

print ("Starting " + self.name)

print_time(self.name, self.counter, 5)

print ("Exiting " + self.name)

def print_time(threadName, delay, counter):

while counter:

if exitFlag:

threadName.exit()

time.sleep(delay)

print ("%s: %s" % (threadName, time.ctime(time.time())))

counter -= 1

thread1 = myThread(1, "Thread-1", 1)

thread2 = myThread(2, "Thread-2", 2)

thread1.start()

thread2.start()

thread1.join()

thread2.join()

print ("Exiting Main Thread")

Starting Thread-1

Starting Thread-2Çıktı

Şimdi, aşağıdaki çıktıyı düşünün -

Thread-1: Mon Apr 23 10:52:09 2018

Thread-1: Mon Apr 23 10:52:10 2018

Thread-2: Mon Apr 23 10:52:10 2018

Thread-1: Mon Apr 23 10:52:11 2018

Thread-1: Mon Apr 23 10:52:12 2018

Thread-2: Mon Apr 23 10:52:12 2018

Thread-1: Mon Apr 23 10:52:13 2018

Exiting Thread-1

Thread-2: Mon Apr 23 10:52:14 2018

Thread-2: Mon Apr 23 10:52:16 2018

Thread-2: Mon Apr 23 10:52:18 2018

Exiting Thread-2

Exiting Main ThreadÇeşitli Diş Durumları için Python Programı

Beş iş parçacığı durumu vardır - yeni, çalıştırılabilir, koşuyor, bekliyor ve ölü. Bu beşinden, esas olarak üç eyalete odaklanacağız - koşmak, beklemek ve ölmek. Bir iş parçacığı kaynaklarını çalışma durumunda alır, bekleme durumunda kaynakları bekler; Yürütülüyorsa ve ediniliyorsa kaynağın son serbest bırakılması ölü durumdaysa.

Start (), sleep () ve join () yöntemlerinin yardımıyla aşağıdaki Python programı, bir iş parçacığının sırasıyla çalışan, bekleme ve ölü duruma nasıl girildiğini gösterecektir.

Step 1 - Gerekli modülleri, <iş parçacığı> ve <zaman> içe aktarın

import threading

import timeStep 2 - Bir iş parçacığı oluştururken çağrılacak bir işlev tanımlayın.

def thread_states():

print("Thread entered in running state")Step 3 - İş parçacığımızı 2 saniye bekletmek için zaman modülünün sleep () yöntemini kullanıyoruz.

time.sleep(2)Step 4 - Şimdi, yukarıda tanımlanan fonksiyonun argümanını alan T1 adında bir evre oluşturuyoruz.

T1 = threading.Thread(target=thread_states)Step 5- Şimdi, start () işlevi yardımıyla iş parçacığımızı başlatabiliriz. Fonksiyonu tanımlarken tarafımızdan belirlenen mesajı üretecektir.

T1.start()

Thread entered in running stateStep 6 - Artık, iş parçacığını çalıştırmayı bitirdikten sonra join () yöntemi ile öldürebiliriz.

T1.join()Python'da iş parçacığı başlatmak

Python'da farklı yollarla yeni bir iş parçacığı başlatabiliriz ancak bunların en kolayı onu tek bir işlev olarak tanımlamaktır. Fonksiyonu tanımladıktan sonra, bunu yeni bir hedef olarak geçebiliriz.threading.Threadnesne vb. İşlevin nasıl çalıştığını anlamak için aşağıdaki Python kodunu yürütün -

import threading

import time

import random

def Thread_execution(i):

print("Execution of Thread {} started\n".format(i))

sleepTime = random.randint(1,4)

time.sleep(sleepTime)

print("Execution of Thread {} finished".format(i))

for i in range(4):

thread = threading.Thread(target=Thread_execution, args=(i,))

thread.start()

print("Active Threads:" , threading.enumerate())Çıktı

Execution of Thread 0 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>]

Execution of Thread 1 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>,

<Thread(Thread-3577, started 3080)>]

Execution of Thread 2 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>,

<Thread(Thread-3577, started 3080)>,

<Thread(Thread-3578, started 2268)>]

Execution of Thread 3 started

Active Threads:

[<_MainThread(MainThread, started 6040)>,

<HistorySavingThread(IPythonHistorySavingThread, started 5968)>,

<Thread(Thread-3576, started 3932)>,

<Thread(Thread-3577, started 3080)>,

<Thread(Thread-3578, started 2268)>,

<Thread(Thread-3579, started 4520)>]

Execution of Thread 0 finished

Execution of Thread 1 finished

Execution of Thread 2 finished

Execution of Thread 3 finishedPython'da Daemon konuları

Python'da daemon evrelerini uygulamadan önce, artalan süreçleri ve bunların kullanımı hakkında bilgi sahibi olmamız gerekir. Hesaplama açısından daemon, veri gönderme, dosya transferleri vb. Gibi çeşitli hizmetlere yönelik istekleri işleyen bir arka plan işlemidir. Artık gerekli değilse, uykuda olacaktır. Aynı görev, arka plan programı olmayan iş parçacıkları yardımıyla da yapılabilir. Ancak, bu durumda, ana iş parçacığı, arka plan programı olmayan evreleri manuel olarak takip etmelidir. Öte yandan, eğer arka plan iş parçacığı kullanıyorsak, ana iş parçacığı bunu tamamen unutabilir ve ana iş parçacığı çıktığında ortadan kalkar. Daemon iş parçacıklarıyla ilgili bir diğer önemli nokta da, onları yalnızca, tamamlanmazsa veya arada öldürülürse bizi etkilemeyecek gerekli olmayan görevler için kullanmayı seçebileceğimizdir. Aşağıda daemon iş parçacıklarının python'da uygulanması verilmiştir -

import threading

import time

def nondaemonThread():

print("starting my thread")

time.sleep(8)

print("ending my thread")

def daemonThread():

while True:

print("Hello")

time.sleep(2)

if __name__ == '__main__':

nondaemonThread = threading.Thread(target = nondaemonThread)

daemonThread = threading.Thread(target = daemonThread)

daemonThread.setDaemon(True)

daemonThread.start()

nondaemonThread.start()Yukarıdaki kodda iki işlev vardır: >nondaemonThread() ve >daemonThread(). İlk işlev durumunu yazdırır ve 8 saniye sonra uyur, deamonThread () işlevi ise her 2 saniyede bir süresiz olarak Hello yazdırır. Aşağıdaki çıktı yardımıyla nondaemon ve daemon iş parçacıkları arasındaki farkı anlayabiliriz -

Hello

starting my thread

Hello

Hello

Hello

Hello

ending my thread

Hello

Hello

Hello

Hello

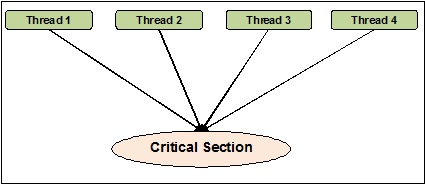

Helloİş parçacığı senkronizasyonu, iki veya daha fazla eşzamanlı iş parçacığının aynı anda kritik bölüm olarak bilinen program bölümüne erişmediğinden emin olabileceğimiz bir yöntem olarak tanımlanabilir. Öte yandan, kritik bölümün programın paylaşılan kaynağa erişilen bölümü olduğunu biliyoruz. Dolayısıyla senkronizasyonun, kaynaklara aynı anda erişerek iki veya daha fazla iş parçacığının birbiriyle arayüz oluşturmamasını sağlama işlemi olduğunu söyleyebiliriz. Aşağıdaki şema, bir programın kritik bölümüne aynı anda erişmeye çalışan dört iş parçacığını göstermektedir.

Daha net hale getirmek için, iki veya daha fazla iş parçacığının aynı anda listeye nesneyi eklemeye çalıştığını varsayalım. Bu hareket, nesnelerden birini veya tümünü bırakacağı veya listenin durumunu tamamen bozacağı için başarılı bir sona götürmez. Burada senkronizasyonun rolü, bir seferde yalnızca bir iş parçacığının listeye erişebilmesidir.

İş parçacığı senkronizasyonunda sorunlar

Eşzamanlı programlama uygularken veya senkronizasyon ilkelleri uygularken sorunlarla karşılaşabiliriz. Bu bölümde iki ana konuyu tartışacağız. Sorunlar -

- Deadlock

- Yarış kondisyonu

Yarış kondisyonu

Bu, eşzamanlı programlamadaki en önemli sorunlardan biridir. Paylaşılan kaynaklara eşzamanlı erişim, yarış durumuna neden olabilir. Bir yarış koşulu, iki veya daha fazla iş parçacığının paylaşılan verilere erişebildiği ve ardından aynı anda değerini değiştirmeye çalıştığı bir koşulun meydana gelmesi olarak tanımlanabilir. Bu nedenle, değişkenlerin değerleri tahmin edilemez olabilir ve süreçlerin bağlam anahtarlarının zamanlamalarına bağlı olarak değişebilir.

Misal

Yarış durumu kavramını anlamak için bu örneği düşünün -

Step 1 - Bu adımda, iş parçacığı modülünü içe aktarmamız gerekiyor -

import threadingStep 2 - Şimdi, 0 değeriyle birlikte x gibi bir global değişken tanımlayın -

x = 0Step 3 - Şimdi, tanımlamamız gerekiyor increment_global() fonksiyon, bu global fonksiyonda 1 artış yapacak olan x -

def increment_global():

global x

x += 1Step 4 - Bu adımda, taskofThread()işlev, belirtilen sayıda artış için increment_global () işlevini çağırır; örneğimiz için 50000 kere -

def taskofThread():

for _ in range(50000):

increment_global()Step 5- Şimdi, t1 ve t2 evrelerinin oluşturulduğu main () işlevini tanımlayın. Her ikisi de start () işlevi yardımıyla başlatılacak ve join () işlevi yardımıyla işlerini bitirene kadar bekleyecekler.

def main():

global x

x = 0

t1 = threading.Thread(target= taskofThread)

t2 = threading.Thread(target= taskofThread)

t1.start()

t2.start()

t1.join()

t2.join()Step 6- Şimdi, main () işlevini çağırmak istediğimiz kaç yineleme için aralığı vermemiz gerekiyor. Burada 5 defa arıyoruz.

if __name__ == "__main__":

for i in range(5):

main()

print("x = {1} after Iteration {0}".format(i,x))Aşağıda gösterilen çıktıda, her yinelemeden sonra 100000 beklendiği için x'in değeri olarak yarış koşulunun etkisini görebiliriz. Ancak, değerde çok fazla varyasyon vardır. Bunun nedeni, iş parçacıklarının paylaşılan global değişken x'e eşzamanlı erişimidir.

Çıktı

x = 100000 after Iteration 0

x = 54034 after Iteration 1

x = 80230 after Iteration 2

x = 93602 after Iteration 3

x = 93289 after Iteration 4Kilitleri kullanarak yarış durumu ile başa çıkmak

Yukarıdaki programda yarış koşulunun etkisini gördüğümüz gibi, birden çok iş parçacığı arasındaki yarış koşulunu ele alabilen bir senkronizasyon aracına ihtiyacımız var. Python'da<threading>modül, yarış koşullarıyla başa çıkmak için Kilit sınıfını sağlar. Dahası,Locksınıfı, birden çok iş parçacığı arasındaki yarış durumunu ele alabileceğimiz farklı yöntemler sağlar. Yöntemler aşağıda açıklanmıştır -

acquire () yöntemi

Bu yöntem, bir kilidi elde etmek, yani bloke etmek için kullanılır. Bir kilit, aşağıdaki doğru veya yanlış değere bağlı olarak bloke edici olabilir veya olmayabilir -

With value set to True - accire () yöntemi, varsayılan bağımsız değişken olan True ile çağrılırsa, kilit açılıncaya kadar iş parçacığı yürütmesi engellenir.

With value set to False - accire () yöntemi, varsayılan bağımsız değişken olmayan False ile çağrılırsa, iş parçacığı yürütmesi true olarak ayarlanıncaya, yani kilitlenene kadar engellenmez.

release () yöntemi

Bu yöntem bir kilidi serbest bırakmak için kullanılır. Aşağıda, bu yöntemle ilgili birkaç önemli görev verilmiştir -

Bir kilit kilitliyse, release()yöntem onun kilidini açar. İşi, birden fazla iş parçacığı engellenirse ve kilidin kilidinin açılmasını beklerse, tam olarak bir iş parçacığının ilerlemesine izin vermektir.

Bir ThreadError kilit zaten açıksa.

Şimdi, yarış durumundan kaçınmak için yukarıdaki programı kilit sınıfı ve yöntemleri ile yeniden yazabiliriz. TaskofThread () yöntemini kilit bağımsız değişkeniyle tanımlamamız ve ardından yarış durumundan kaçınmak için kilitlerin engellenmesi ve engellenmemesi için acquire () ve release () yöntemlerini kullanmamız gerekir.

Misal

Aşağıda, yarış durumu ile başa çıkmak için kilit kavramını anlamak için bir python programı örneği verilmiştir -

import threading

x = 0

def increment_global():

global x

x += 1

def taskofThread(lock):

for _ in range(50000):

lock.acquire()

increment_global()

lock.release()

def main():

global x

x = 0

lock = threading.Lock()

t1 = threading.Thread(target = taskofThread, args = (lock,))

t2 = threading.Thread(target = taskofThread, args = (lock,))

t1.start()

t2.start()

t1.join()

t2.join()

if __name__ == "__main__":

for i in range(5):

main()

print("x = {1} after Iteration {0}".format(i,x))Aşağıdaki çıktı yarış durumunun etkisinin ihmal edildiğini göstermektedir; x'in değeri, her & her yinelemeden sonra, şimdi 100000'dir, bu da bu programın beklentisine göre.

Çıktı

x = 100000 after Iteration 0

x = 100000 after Iteration 1

x = 100000 after Iteration 2

x = 100000 after Iteration 3

x = 100000 after Iteration 4Çıkmazlar - Yemek Filozofları sorunu

Kilitlenme, eşzamanlı sistemleri tasarlarken karşılaşılabilecek zahmetli bir sorundur. Bu konuyu yemek filozofu probleminin yardımıyla şu şekilde açıklayabiliriz:

Edsger Dijkstra başlangıçta, eşzamanlı sistemin en büyük sorunlarından biri olan kilitlenme denilen ünlü örneklerden biri olan yemek filozofu problemini tanıttı.

Bu problemde yuvarlak bir masada oturup kaselerinden yemek yiyen beş ünlü filozof var. Beş filozofun yemeklerini yemek için kullanabileceği beş çatal vardır. Ancak filozoflar yemeklerini yemek için aynı anda iki çatal kullanmaya karar verirler.

Şimdi filozoflar için iki temel koşul var. Birincisi, filozofların her biri ya yemek yiyor ya da düşünme durumunda olabilir ve ikincisi, önce her iki çatalları, yani sol ve sağ almaları gerekir. Sorun, beş filozofun her biri aynı anda sol çatalı seçmeyi başardığında ortaya çıkar. Şimdi hepsi doğru çatalın bedava olmasını bekliyor, ancak yiyeceklerini yiyene ve doğru çatal asla bulunmayana kadar çatallarını asla bırakmayacaklar. Bu nedenle, yemek masasında bir kilitlenme durumu olacaktır.

Eşzamanlı sistemde kilitlenme

Şimdi görürsek, aynı sorun eşzamanlı sistemlerimizde de ortaya çıkabilir. Yukarıdaki örnekteki çatallar, sistem kaynakları olabilir ve her filozof, kaynakları elde etmek için yarışan süreci temsil edebilir.

Python programı ile çözüm

Bu sorunun çözümü, filozofları iki türe ayırarak bulunabilir: greedy philosophers ve generous philosophers. Esas olarak açgözlü bir filozof, sol çatalı kaldırmaya çalışacak ve orada olana kadar bekleyecektir. Daha sonra sağ çatalın orada olmasını bekleyecek, alacak, yiyecek ve sonra yere koyacaktır. Öte yandan, cömert bir filozof sol çatalı kaldırmaya çalışacak ve eğer orada değilse, bekleyip bir süre sonra tekrar deneyecektir. Sol çatalı alırlarsa, doğru olanı almaya çalışacaklardır. Doğru çatalı da alacaklarsa, her iki çatalı da yiyip bırakacaklar. Ancak, sağ çatalı alamazlarsa, sol çatalı serbest bırakırlar.

Misal

Aşağıdaki Python programı, yemek filozofu sorununa bir çözüm bulmamıza yardımcı olacak -

import threading

import random

import time

class DiningPhilosopher(threading.Thread):

running = True

def __init__(self, xname, Leftfork, Rightfork):

threading.Thread.__init__(self)

self.name = xname

self.Leftfork = Leftfork

self.Rightfork = Rightfork

def run(self):

while(self.running):

time.sleep( random.uniform(3,13))

print ('%s is hungry.' % self.name)

self.dine()

def dine(self):

fork1, fork2 = self.Leftfork, self.Rightfork

while self.running:

fork1.acquire(True)

locked = fork2.acquire(False)

if locked: break

fork1.release()

print ('%s swaps forks' % self.name)

fork1, fork2 = fork2, fork1

else:

return

self.dining()

fork2.release()

fork1.release()

def dining(self):

print ('%s starts eating '% self.name)

time.sleep(random.uniform(1,10))

print ('%s finishes eating and now thinking.' % self.name)

def Dining_Philosophers():

forks = [threading.Lock() for n in range(5)]

philosopherNames = ('1st','2nd','3rd','4th', '5th')

philosophers= [DiningPhilosopher(philosopherNames[i], forks[i%5], forks[(i+1)%5]) \

for i in range(5)]

random.seed()

DiningPhilosopher.running = True

for p in philosophers: p.start()

time.sleep(30)

DiningPhilosopher.running = False

print (" It is finishing.")

Dining_Philosophers()Yukarıdaki program, açgözlü ve cömert filozoflar kavramını kullanır. Program ayrıcaacquire() ve release() yöntemleri Lock sınıfı <threading>modül. Çözümü aşağıdaki çıktıda görebiliriz -

Çıktı

4th is hungry.

4th starts eating

1st is hungry.

1st starts eating

2nd is hungry.

5th is hungry.

3rd is hungry.

1st finishes eating and now thinking.3rd swaps forks

2nd starts eating

4th finishes eating and now thinking.

3rd swaps forks5th starts eating

5th finishes eating and now thinking.

4th is hungry.

4th starts eating

2nd finishes eating and now thinking.

3rd swaps forks

1st is hungry.

1st starts eating

4th finishes eating and now thinking.

3rd starts eating

5th is hungry.

5th swaps forks

1st finishes eating and now thinking.

5th starts eating

2nd is hungry.

2nd swaps forks

4th is hungry.

5th finishes eating and now thinking.

3rd finishes eating and now thinking.

2nd starts eating 4th starts eating

It is finishing.Gerçek hayatta, eğer bir ekip ortak bir görev üzerinde çalışıyorsa, o zaman görevi düzgün bir şekilde bitirmek için aralarında iletişim olmalıdır. Aynı benzetme iplikler için de geçerlidir. Programlamada, işlemcinin ideal süresini azaltmak için birden çok iş parçacığı oluştururuz ve her iş parçacığına farklı alt görevler atarız. Bu nedenle, bir iletişim aracı olmalı ve işi senkronize bir şekilde bitirmek için birbirleriyle etkileşime girmelidirler.

İş parçacığı iç iletişimiyle ilgili aşağıdaki önemli noktaları göz önünde bulundurun -

No performance gain - İş parçacıkları ve süreçler arasında doğru iletişimi sağlayamazsak, eşzamanlılık ve paralellikten elde edilen performans kazanımlarının faydası olmaz.

Accomplish task properly - İş parçacıkları arasında uygun bir iletişim mekanizması olmadan, atanan görev düzgün bir şekilde tamamlanamaz.

More efficient than inter-process communication - İş parçacıkları arası iletişim, süreçler arası iletişimden daha verimli ve kullanımı kolaydır, çünkü bir süreç içindeki tüm iş parçacıkları aynı adres alanını paylaşır ve paylaşılan belleği kullanmaları gerekmez.

İş parçacığı güvenli iletişim için Python veri yapıları

Çok iş parçacıklı kod, bir iş parçacığından başka bir iş parçacığına bilgi geçirme sorunuyla ortaya çıkar. Standart iletişim ilkeleri bu sorunu çözmez. Bu nedenle, iletişimi güvenli hale getirmek için nesneler arasında nesneleri paylaşmak için kendi bileşik nesnemizi uygulamamız gerekir. Aşağıda, bazı değişiklikler yaptıktan sonra iş parçacığı güvenli iletişim sağlayan birkaç veri yapısı bulunmaktadır:

Setleri

Küme veri yapısını iş parçacığı açısından güvenli bir şekilde kullanmak için, kendi kilitleme mekanizmamızı uygulamak için set sınıfını genişletmemiz gerekir.

Misal

İşte sınıfı genişletmenin bir Python örneği -

class extend_class(set):

def __init__(self, *args, **kwargs):

self._lock = Lock()

super(extend_class, self).__init__(*args, **kwargs)

def add(self, elem):

self._lock.acquire()

try:

super(extend_class, self).add(elem)

finally:

self._lock.release()

def delete(self, elem):

self._lock.acquire()

try:

super(extend_class, self).delete(elem)

finally:

self._lock.release()Yukarıdaki örnekte, adında bir sınıf nesnesi extend_class Python'dan miras alınan tanımlanmıştır set class. Bu sınıfın yapıcısı içinde bir kilit nesnesi oluşturulur. Şimdi, iki işlev var -add() ve delete(). Bu işlevler tanımlanmıştır ve iş parçacığı açısından güvenlidir. İkisi de güveniyorsuper bir anahtar istisna dışında sınıf işlevselliği.

Dekoratör

Bu, iş parçacığı güvenli iletişim için başka bir anahtar yöntem, dekoratörlerin kullanılmasıdır.

Misal

Dekoratörlerin nasıl kullanılacağını gösteren bir Python örneği düşünün & mminus;

def lock_decorator(method):

def new_deco_method(self, *args, **kwargs):

with self._lock:

return method(self, *args, **kwargs)

return new_deco_method

class Decorator_class(set):

def __init__(self, *args, **kwargs):

self._lock = Lock()

super(Decorator_class, self).__init__(*args, **kwargs)

@lock_decorator

def add(self, *args, **kwargs):

return super(Decorator_class, self).add(elem)

@lock_decorator

def delete(self, *args, **kwargs):

return super(Decorator_class, self).delete(elem)Yukarıdaki örnekte, Python yöntem sınıfından daha fazla miras alınan lock_decorator adlı bir dekoratör yöntemi tanımlanmıştır. Daha sonra bu sınıfın yapıcısı içinde bir kilit nesnesi oluşturulur. Şimdi iki işlev var - ekle () ve sil (). Bu işlevler tanımlanmıştır ve iş parçacığı açısından güvenlidir. Her ikisi de bir anahtar istisna dışında süper sınıf işlevselliğe güveniyor.

Listeler

Liste veri yapısı iş parçacığı açısından güvenlidir, hızlıdır ve geçici, bellek içi depolama için kolay bir yapıdır. Cpython'da, GIL bunlara eş zamanlı erişime karşı koruma sağlar. Listelerin iş parçacığı açısından güvenli olduğunu öğrendiğimizde, peki ya içlerinde yatan veriler. Aslında listenin verileri korunmuyor. Örneğin,L.append(x)başka bir iş parçacığı aynı şeyi yapmaya çalışıyorsa beklenen sonucu döndürme garantisi verilmez. Bunun nedeni,append() atomik bir işlemdir ve iş parçacığı güvenlidir, ancak diğer iş parçacığı listenin verilerini eşzamanlı olarak değiştirmeye çalışıyor, bu nedenle yarış koşullarının çıktı üzerindeki yan etkilerini görebiliyoruz.

Bu tür bir sorunu çözmek ve verileri güvenli bir şekilde değiştirmek için, birden fazla iş parçacığının potansiyel olarak yarış koşullarında çalışmamasını sağlayan uygun bir kilitleme mekanizması uygulamalıyız. Doğru kilitleme mekanizmasını uygulamak için, önceki örneklerde yaptığımız gibi sınıfı genişletebiliriz.

Listelerdeki diğer bazı atomik işlemler aşağıdaki gibidir -

L.append(x)

L1.extend(L2)

x = L[i]

x = L.pop()

L1[i:j] = L2

L.sort()

x = y

x.field = y

D[x] = y

D1.update(D2)

D.keys()Burada -

- L, L1, L2 hepsi listedir

- D, D1, D2 diktedir

- x, y nesnelerdir

- i, j ints

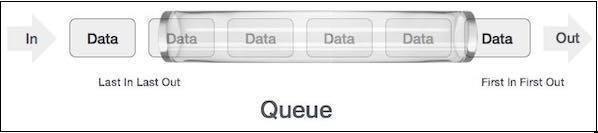

Kuyruklar

Listenin verileri korunmuyorsa, sonuçlarla yüzleşmek zorunda kalabiliriz. Yarış koşullarının yanlış veri öğesini alabilir veya silebiliriz. Bu nedenle kuyruk veri yapısının kullanılması önerilir. Gerçek dünyadaki kuyruk örneği, aracın ilk girdiği, ilk çıktığı tek şeritli tek yönlü bir yol olabilir. Bilet gişelerindeki ve otobüs duraklarındaki kuyruklardan daha fazla gerçek dünya örneği görülebilir.

Kuyruklar varsayılan olarak iş parçacığı güvenli veri yapılarıdır ve karmaşık kilitleme mekanizmasını uygulama konusunda endişelenmemize gerek yoktur. Python bize

Kuyruk Türleri

Bu bölümde, farklı kuyruk türleri hakkında kazanacağız. Python, siteden kullanmak için üç sıra seçeneği sağlar.<queue> modül -

- Normal Kuyruklar (FIFO, İlk Giren İlk Çıkar)

- LIFO, Son Giren İlk Çıkar

- Priority

Sonraki bölümlerde farklı kuyruklar hakkında bilgi edineceğiz.

Normal Kuyruklar (FIFO, İlk Giren İlk Çıkar)

Python tarafından sunulan en yaygın kullanılan kuyruk uygulamalarıdır. Bu kuyruk mekanizmasında kim önce gelirse önce hizmeti alır. FIFO, normal kuyruklar olarak da adlandırılır. FIFO kuyrukları aşağıdaki gibi gösterilebilir -

FIFO Kuyruğunun Python Uygulaması

Python'da, FIFO kuyruğu tek iş parçacığı ve çoklu iş parçacığı ile uygulanabilir.

Tek iş parçacıklı FIFO kuyruğu

FIFO kuyruğunu tek iş parçacığı ile uygulamak için, Queuesınıfı, temel bir ilk giren ilk çıkar kapsayıcı uygulayacaktır. Öğeler, dizinin bir "sonuna" eklenecekput()ve kullanılarak diğer ucundan kaldırıldı get().

Misal

Aşağıda, tek iş parçacığı ile FIFO kuyruğunun uygulanması için bir Python programı verilmiştir -

import queue

q = queue.Queue()

for i in range(8):

q.put("item-" + str(i))

while not q.empty():

print (q.get(), end = " ")Çıktı

item-0 item-1 item-2 item-3 item-4 item-5 item-6 item-7Çıktı, yukarıdaki programın, öğelerin yerleştirildikleri sırayla kuyruktan kaldırıldığını göstermek için tek bir iş parçacığı kullandığını gösterir.

Birden çok iş parçacığı içeren FIFO kuyruğu

FIFO'yu birden çok iş parçacığı ile uygulamak için, kuyruk modülünden genişletilen myqueue () işlevini tanımlamamız gerekir. Get () ve put () yöntemlerinin çalışması, FIFO kuyruğunu tek iş parçacığı ile uygularken yukarıda tartışılanla aynıdır. Daha sonra onu çok iş parçacıklı hale getirmek için, evreleri bildirmemiz ve başlatmamız gerekir. Bu iş parçacıkları kuyruğu FIFO tarzında tüketecektir.

Misal

Aşağıda, birden çok iş parçacığı içeren FIFO kuyruğunun uygulanması için bir Python programı verilmiştir

import threading

import queue

import random

import time

def myqueue(queue):

while not queue.empty():

item = queue.get()

if item is None:

break

print("{} removed {} from the queue".format(threading.current_thread(), item))

queue.task_done()

time.sleep(2)

q = queue.Queue()

for i in range(5):

q.put(i)

threads = []

for i in range(4):

thread = threading.Thread(target=myqueue, args=(q,))

thread.start()

threads.append(thread)

for thread in threads:

thread.join()Çıktı

<Thread(Thread-3654, started 5044)> removed 0 from the queue

<Thread(Thread-3655, started 3144)> removed 1 from the queue

<Thread(Thread-3656, started 6996)> removed 2 from the queue

<Thread(Thread-3657, started 2672)> removed 3 from the queue

<Thread(Thread-3654, started 5044)> removed 4 from the queueLIFO, İlk Giren Son Sırada

Bu kuyruk, FIFO (İlk Giren İlk Çıkar) kuyruklarından tamamen zıt bir analoji kullanır. Bu kuyruk mekanizmasında en son gelen, önce servisi alacaktır. Bu, yığın veri yapısını uygulamaya benzer. LIFO kuyrukları, yapay zeka algoritmaları gibi Derinlik öncelikli arama uygularken yararlı olduğunu kanıtladı.

LIFO kuyruğunun Python uygulaması

Python'da, LIFO kuyruğu tek iş parçacığı ve çoklu iş parçacığı ile uygulanabilir.

Tek iş parçacıklı LIFO kuyruğu

LIFO kuyruğunu tek iş parçacığı ile uygulamak için, Queue sınıf, yapıyı kullanarak temel bir son giren ilk çıkar kapsayıcı uygulayacak Queue.LifoQueue. Şimdi aradığımdaput(), elemanlar kabın kafasına eklenir ve kullanımda da kafadan çıkarılır. get().

Misal

Aşağıda, LIFO kuyruğunun tek iş parçacığı ile uygulanması için bir Python programı verilmiştir -

import queue

q = queue.LifoQueue()

for i in range(8):

q.put("item-" + str(i))

while not q.empty():

print (q.get(), end=" ")

Output:

item-7 item-6 item-5 item-4 item-3 item-2 item-1 item-0Çıktı, yukarıdaki programın, öğelerin eklendikleri sıranın tersi sırayla kuyruktan kaldırıldığını göstermek için tek bir iş parçacığı kullandığını gösterir.

Birden çok iş parçacığı ile LIFO kuyruğu

Uygulama, FIFO kuyruklarının çoklu iş parçacığı ile uygulanmasını yaptığımız gibi benzerdir. Tek fark, kullanmamız gerektiğidir.Queue yapıyı kullanarak temel bir son giren ilk çıkar kapsayıcı uygulayacak sınıf Queue.LifoQueue.

Misal

Aşağıda, LIFO kuyruğunun birden çok iş parçacığı ile uygulanması için bir Python programı verilmiştir -

import threading

import queue

import random

import time

def myqueue(queue):

while not queue.empty():

item = queue.get()

if item is None:

break

print("{} removed {} from the queue".format(threading.current_thread(), item))

queue.task_done()

time.sleep(2)

q = queue.LifoQueue()

for i in range(5):

q.put(i)

threads = []

for i in range(4):

thread = threading.Thread(target=myqueue, args=(q,))

thread.start()

threads.append(thread)

for thread in threads:

thread.join()Çıktı

<Thread(Thread-3882, started 4928)> removed 4 from the queue

<Thread(Thread-3883, started 4364)> removed 3 from the queue

<Thread(Thread-3884, started 6908)> removed 2 from the queue

<Thread(Thread-3885, started 3584)> removed 1 from the queue

<Thread(Thread-3882, started 4928)> removed 0 from the queueÖncelik sırası

FIFO ve LIFO kuyruklarında, öğelerin sıralaması yerleştirme sırasına bağlıdır. Ancak, önceliğin yerleştirme sırasından daha önemli olduğu birçok durum vardır. Gerçek dünya örneğini ele alalım. Havaalanındaki güvenliğin farklı kategorilerdeki insanları kontrol ettiğini varsayalım. VVIP çalışanları, havayolu personeli, gümrük memuru, kategoriler sıradan kişiler için olduğu gibi varış bazında kontrol edilmek yerine öncelikli olarak kontrol edilebilir.

Öncelik kuyruğu için dikkate alınması gereken bir diğer önemli husus, bir görev planlayıcısının nasıl geliştirileceğidir. Yaygın bir tasarım, kuyruktaki en ajan görevini öncelik temelinde sunmaktır. Bu veri yapısı, öncelik değerlerine göre öğeleri kuyruktan almak için kullanılabilir.

Öncelik Kuyruğunun Python Uygulaması

Python'da, öncelik kuyruğu tek iş parçacığı ve çoklu iş parçacığı ile uygulanabilir.

Tek iş parçacığı ile öncelik sırası

Tek iş parçacığı ile öncelik kuyruğu uygulamak için, Queue sınıf, yapıyı kullanarak öncelikli kapsayıcıda bir görev uygulayacak Queue.PriorityQueue. Şimdi aradığımdaput()öğeler, en düşük değerin en yüksek önceliğe sahip olacağı bir değerle eklenir ve bu nedenle ilk olarak kullanılarak alınır get().

Misal

Tek iş parçacığı ile Öncelik kuyruğunun uygulanması için aşağıdaki Python programını düşünün -

import queue as Q

p_queue = Q.PriorityQueue()

p_queue.put((2, 'Urgent'))

p_queue.put((1, 'Most Urgent'))

p_queue.put((10, 'Nothing important'))

prio_queue.put((5, 'Important'))

while not p_queue.empty():

item = p_queue.get()

print('%s - %s' % item)Çıktı

1 – Most Urgent

2 - Urgent

5 - Important

10 – Nothing importantYukarıdaki çıktıda, sıranın öğeleri önceliğe göre sakladığını görebiliriz - daha az değer yüksek önceliğe sahip.

Çoklu iş parçacıklı öncelik sırası

Uygulama, birden çok iş parçacığı içeren FIFO ve LIFO kuyruklarının uygulanmasına benzer. Tek fark, kullanmamız gerektiğidir.Queue yapıyı kullanarak önceliği başlatmak için sınıf Queue.PriorityQueue. Diğer bir fark, kuyruğun oluşturulma şeklidir. Aşağıda verilen örnekte, iki özdeş veri seti ile üretilecektir.

Misal

Aşağıdaki Python programı, birden çok iş parçacığı ile öncelik sırasının uygulanmasına yardımcı olur -

import threading

import queue

import random

import time

def myqueue(queue):

while not queue.empty():

item = queue.get()

if item is None:

break

print("{} removed {} from the queue".format(threading.current_thread(), item))

queue.task_done()

time.sleep(1)

q = queue.PriorityQueue()

for i in range(5):

q.put(i,1)

for i in range(5):

q.put(i,1)

threads = []

for i in range(2):

thread = threading.Thread(target=myqueue, args=(q,))

thread.start()

threads.append(thread)

for thread in threads:

thread.join()Çıktı

<Thread(Thread-4939, started 2420)> removed 0 from the queue

<Thread(Thread-4940, started 3284)> removed 0 from the queue

<Thread(Thread-4939, started 2420)> removed 1 from the queue

<Thread(Thread-4940, started 3284)> removed 1 from the queue

<Thread(Thread-4939, started 2420)> removed 2 from the queue

<Thread(Thread-4940, started 3284)> removed 2 from the queue

<Thread(Thread-4939, started 2420)> removed 3 from the queue

<Thread(Thread-4940, started 3284)> removed 3 from the queue

<Thread(Thread-4939, started 2420)> removed 4 from the queue

<Thread(Thread-4940, started 3284)> removed 4 from the queueBu bölümde, iş parçacığı uygulamalarının test edilmesini öğreneceğiz. Ayrıca test etmenin önemini de öğreneceğiz.

Neden Test Edilmeli?

Test etmenin önemi hakkındaki tartışmaya girmeden önce, testin ne olduğunu bilmemiz gerekir. Genel anlamda test, bir şeyin ne kadar iyi çalıştığını bulmanın bir tekniğidir. Öte yandan, özellikle bilgisayar programları veya yazılımları hakkında konuşursak, test, bir yazılım programının işlevselliğine erişme tekniğidir.

Bu bölümde, yazılım testinin önemini tartışacağız. Yazılım geliştirmede, yazılımın istemciye yayınlanmasından önce iki kez kontrol edilmelidir. Bu nedenle yazılımı deneyimli test ekibi tarafından test etmek çok önemlidir. Yazılım testinin önemini anlamak için aşağıdaki noktaları göz önünde bulundurun -

Yazılım kalitesinin iyileştirilmesi

Elbette hiçbir şirket düşük kaliteli yazılım sunmak istemez ve hiçbir müşteri düşük kaliteli yazılım satın almak istemez. Test, içindeki hataları bulup düzelterek yazılımın kalitesini artırır.

Müşteri memnuniyeti

Herhangi bir işin en önemli kısmı müşterilerinin memnuniyetidir. Firmalar hatasız ve kaliteli yazılımlar sunarak müşteri memnuniyetini sağlayabilirler.

Yeni özelliklerin etkisini azaltın

10000 satırlık bir yazılım sistemi yaptığımızı ve yeni bir özellik eklememiz gerektiğini varsayalım, o zaman geliştirme ekibi bu yeni özelliğin tüm yazılım üzerindeki etkisi hakkında endişelenecektir. Burada da testler hayati bir rol oynar çünkü eğer test ekibi iyi bir test paketi yapmışsa, bizi herhangi bir olası felaket kırılmasından kurtarabilir.

Kullanıcı deneyimi

Herhangi bir işin bir diğer en önemli kısmı, o ürünü kullananların deneyimidir. Yalnızca test, son kullanıcının ürünü kullanmayı basit ve kolay bulmasını sağlayabilir.

Giderleri azaltmak

Test, teslimattan sonra düzeltmek yerine geliştirmenin test aşamasında hataları bularak ve düzelterek yazılımın toplam maliyetini düşürebilir. Yazılımın teslim edilmesinden sonra büyük bir hata varsa, o zaman maddi maliyetini giderler ve maddi olmayan maliyetler, müşteri memnuniyetsizliği, şirketin olumsuz itibarı vb.

Ne Test Edilecek?

Her zaman neyin test edileceğine dair uygun bilgiye sahip olunması önerilir. Bu bölümde, herhangi bir yazılımı test ederken önce test cihazının ana nedeni olduğunu anlayacağız. Kod kapsamı, yani, test paketimizin test sırasında kaç satır kodla karşılaştığından kaçınılmalıdır. Bunun nedeni, test sırasında yalnızca kod satırlarının sayısına odaklanmak sistemimize gerçek bir değer katmamaktadır. Daha sonraki bir aşamada konuşlandırmadan sonra bile yansıyan bazı hatalar kalabilir.

Neyin test edileceğiyle ilgili aşağıdaki önemli noktaları göz önünde bulundurun:

Kod kapsamı yerine kodun işlevselliğini test etmeye odaklanmalıyız.

Önce kodun en önemli kısımlarını test etmemiz ve ardından kodun daha az önemli kısımlarına doğru ilerlememiz gerekir. Kesinlikle zaman kazandıracak.

Test cihazı, yazılımı sınırlarına kadar zorlayabilecek çok sayıda farklı teste sahip olmalıdır.

Eşzamanlı yazılım programlarını test etme yaklaşımları

Çok çekirdekli mimarinin gerçek yeteneğini kullanma yeteneği nedeniyle, eşzamanlı yazılım sistemleri sıralı sistemlerin yerini alıyor. Son zamanlarda cep telefonlarından çamaşır makinelerine, arabalardan uçaklara vb. Her şeyde eşzamanlı sistem programları kullanılıyor. zaten bir hata varsa, birden fazla hatayla sonuçlanırdık.

Eşzamanlı yazılım programları için test teknikleri, yarış koşulları, kilitlenmeler ve atomikliğin ihlali gibi potansiyel olarak zararlı modelleri ortaya çıkaran serpiştirmeyi seçmeye yoğun bir şekilde odaklanmaktadır. Eşzamanlı yazılım programlarını test etmek için iki yaklaşım aşağıda verilmiştir:

Sistematik keşif

Bu yaklaşım, harmanlamaların alanını olabildiğince geniş bir şekilde keşfetmeyi amaçlamaktadır. Bu tür yaklaşımlar, bir kaba kuvvet tekniğini benimseyebilir ve diğerleri, harmanlamaların uzayını keşfetmek için kısmi düzen azaltma tekniğini veya sezgisel tekniği benimser.

Mülkiyet odaklı

Mülkiyet odaklı yaklaşımlar, eşzamanlılık hatalarının şüpheli bellek erişim modeli gibi belirli özellikleri açığa çıkaran serpiştirmeler altında oluşma olasılığının daha yüksek olduğu gözlemine dayanır. Farklı mülkiyet odaklı yaklaşımlar, yarış koşulları, kilitlenmeler ve atomikliğin ihlali gibi farklı hataları hedefler ve bunlar ayrıca bir veya diğer belirli özelliklere bağlıdır.

Test Stratejileri

Test Stratejisi, test yaklaşımı olarak da bilinir. Strateji, testin nasıl yürütüleceğini tanımlar. Test yaklaşımının iki tekniği vardır -

Proaktif

Derleme oluşturulmadan önce hataları bulmak ve düzeltmek için test tasarım sürecinin olabildiğince erken başlatıldığı bir yaklaşım.

Reaktif

Geliştirme süreci tamamlanana kadar testin başlamadığı bir yaklaşım.

Python programına herhangi bir test stratejisi veya yaklaşım uygulamadan önce, bir yazılım programının sahip olabileceği hatalar hakkında temel bir fikre sahip olmamız gerekir. Hatalar aşağıdaki gibidir -

Sözdizimsel hatalar

Program geliştirme sırasında çok sayıda küçük hata olabilir. Hatalar çoğunlukla yazım hatalarından kaynaklanmaktadır. Örneğin, eksik iki nokta üst üste veya bir anahtar kelimenin yanlış yazımı, vb. Bu tür hatalar, mantıktaki değil, program sözdizimindeki hatadan kaynaklanır. Bu nedenle, bu hatalara sözdizimsel hatalar denir.

Anlamsal hatalar

Anlamsal hatalara mantıksal hatalar da denir. Yazılım programında mantıksal veya anlamsal bir hata varsa, ifade doğru bir şekilde derlenecek ve çalışacaktır ancak mantık doğru olmadığı için istenen çıktıyı vermeyecektir.

Birim Testi

Bu, python programlarını test etmek için en çok kullanılan test stratejilerinden biridir. Bu strateji, kodun birimlerini veya bileşenlerini test etmek için kullanılır. Birimler veya bileşenler derken, kodun sınıflarını veya işlevlerini kastediyoruz. Birim testi, "küçük" birimleri test ederek büyük programlama sistemlerinin testini basitleştirir. Yukarıdaki konseptin yardımıyla, birim testi, istenen çıktıyı döndürüp döndürmediklerini belirlemek için tek tek kaynak kod birimlerinin test edildiği bir yöntem olarak tanımlanabilir.

Sonraki bölümlerimizde, birim testi için farklı Python modülleri hakkında bilgi edineceğiz.

unittest modülü

Birim testi için ilk modül, birim testi modülüdür. JUnit'ten esinlenmiştir ve varsayılan olarak Python3.6'ya dahildir. Test otomasyonunu, testler için kurulum ve kapatma kodunun paylaşılmasını, testlerin koleksiyonlarda toplanmasını ve testlerin raporlama çerçevesinden bağımsızlığını destekler.

Aşağıda, unittest modülü tarafından desteklenen birkaç önemli kavram yer almaktadır.

Metin fikstürü

Teste başlamadan önce çalıştırılabilmesi ve test bittikten sonra yırtılabilmesi için bir test kurmak için kullanılır. Teste başlamadan önce ihtiyaç duyulan geçici veritabanı, dizin vb. Oluşturulmasını içerebilir.

Test durumu

Test senaryosu, gerekli bir yanıtın belirli bir girdi setinden gelip gelmediğini kontrol eder. Unittest modülü, yeni test senaryoları oluşturmak için kullanılabilecek TestCase adlı bir temel sınıf içerir. Varsayılan olarak iki yöntem içerir -

setUp()- egzersiz yapmadan önce test fikstürünü kurmak için bir kanca yöntemi. Bu, uygulanan test yöntemleri çağrılmadan önce çağrılır.

tearDown( - sınıftaki tüm testleri çalıştırdıktan sonra sınıf fikstürünü yeniden yapılandırmak için bir kanca yöntemi.

Test odası

Test paketleri, test senaryoları veya her ikisinden oluşan bir koleksiyondur.

Test koşucusu

Test senaryolarının veya giysilerinin çalışmasını kontrol eder ve sonucu kullanıcıya sağlar. Sonucu sağlamak için GUI veya basit metin arabirimi kullanabilir.

Example

Aşağıdaki Python programı, adlı bir modülü test etmek için unittest modülünü kullanır. Fibonacci. Program, bir sayının Fibonacci serisinin hesaplanmasına yardımcı olur. Bu örnekte, farklı yöntemler kullanarak test senaryolarını tanımlamak için Fibo_test adlı bir sınıf oluşturduk. Bu yöntemler, unittest.TestCase'den miras alınır. Varsayılan olarak iki yöntem kullanıyoruz - setUp () ve tearDown (). Ayrıca testfibocal yöntemi de tanımlıyoruz. Testin adı harf testi ile başlamalıdır. Son blokta, unittest.main () test betiğine bir komut satırı arayüzü sağlar.

import unittest

def fibonacci(n):

a, b = 0, 1

for i in range(n):

a, b = b, a + b

return a

class Fibo_Test(unittest.TestCase):

def setUp(self):

print("This is run before our tests would be executed")

def tearDown(self):

print("This is run after the completion of execution of our tests")

def testfibocal(self):

self.assertEqual(fib(0), 0)

self.assertEqual(fib(1), 1)

self.assertEqual(fib(5), 5)

self.assertEqual(fib(10), 55)

self.assertEqual(fib(20), 6765)

if __name__ == "__main__":