Netzwerksicherheit - Kurzanleitung

In dieser modernen Zeit verlassen sich Unternehmen in hohem Maße auf Computernetzwerke, um Informationen im gesamten Unternehmen auf effiziente und produktive Weise auszutauschen. Organisatorische Computernetzwerke werden jetzt groß und allgegenwärtig. Unter der Annahme, dass jeder Mitarbeiter über eine dedizierte Workstation verfügt, verfügt ein großes Unternehmen über einige Tausend Workstations und viele Server im Netzwerk.

Es ist wahrscheinlich, dass diese Workstations weder zentral verwaltet werden noch über einen Perimeterschutz verfügen. Sie verfügen möglicherweise über eine Vielzahl von Betriebssystemen, Hardware, Software und Protokollen mit unterschiedlichem Cyber-Bewusstsein bei den Benutzern. Stellen Sie sich nun vor, diese Tausenden von Arbeitsstationen im Unternehmensnetzwerk sind direkt mit dem Internet verbunden. Diese Art von ungesichertem Netzwerk wird zum Ziel eines Angriffs, der wertvolle Informationen enthält und Schwachstellen anzeigt.

In diesem Kapitel beschreiben wir die Hauptschwachstellen des Netzwerks und die Bedeutung der Netzwerksicherheit. In den folgenden Kapiteln werden wir die Methoden diskutieren, um dasselbe zu erreichen.

Physisches Netzwerk

Ein Netzwerk ist definiert als zwei oder mehr Computergeräte, die miteinander verbunden sind, um Ressourcen effizient zu teilen. Ferner ist das Verbinden von zwei oder mehr Netzwerken miteinander bekannt alsinternetworking. Das Internet ist also nur ein Netzwerk - eine Sammlung miteinander verbundener Netzwerke.

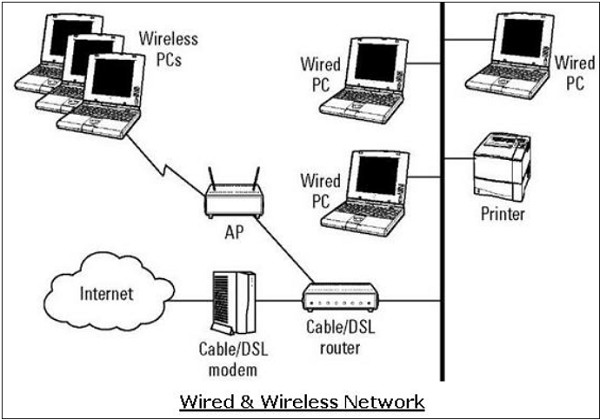

Für die Einrichtung des internen Netzwerks stehen einer Organisation verschiedene Optionen zur Verfügung. Es kann ein kabelgebundenes Netzwerk oder ein kabelloses Netzwerk verwenden, um alle Workstations zu verbinden. Heutzutage verwenden Unternehmen meist eine Kombination aus drahtgebundenen und drahtlosen Netzwerken.

Kabelgebundene und drahtlose Netzwerke

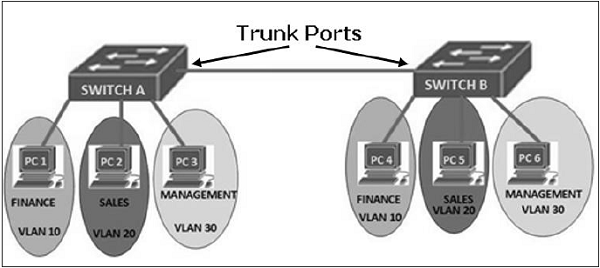

In einem kabelgebundenen Netzwerk werden Geräte über Kabel miteinander verbunden. In der Regel basieren kabelgebundene Netzwerke auf dem Ethernet-Protokoll, bei dem Geräte mithilfe der UTP-Kabel (Unshielded Twisted Pair) an die verschiedenen Switches angeschlossen werden. Diese Switches sind ferner mit dem Netzwerkrouter verbunden, um auf das Internet zuzugreifen.

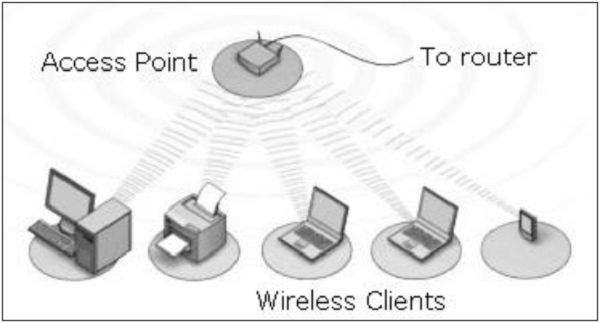

In einem drahtlosen Netzwerk ist das Gerät über Funk mit einem Zugangspunkt verbunden. Die Zugangspunkte sind ferner über Kabel mit dem Switch / Router für den externen Netzwerkzugriff verbunden.

Drahtlose Netzwerke haben aufgrund der von ihnen angebotenen Mobilität an Popularität gewonnen. Mobile Geräte müssen nicht an ein Kabel gebunden sein und können sich innerhalb der Reichweite des drahtlosen Netzwerks frei bewegen. Dies gewährleistet einen effizienten Informationsaustausch und steigert die Produktivität.

Sicherheitslücken und Angriffe

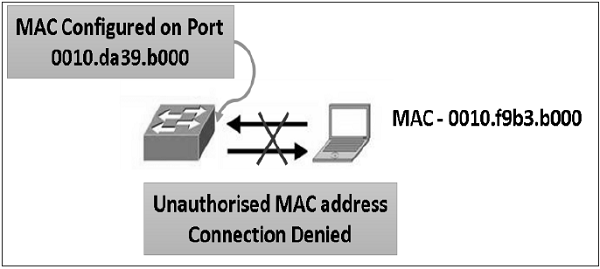

Die häufigste Sicherheitsanfälligkeit, die sowohl in drahtgebundenen als auch in drahtlosen Netzwerken besteht, ist ein „nicht autorisierter Zugriff“ auf ein Netzwerk. Ein Angreifer kann sein Gerät über einen unsicheren Hub / Switch-Port mit einem Netzwerk verbinden. In dieser Hinsicht gelten drahtlose Netzwerke als weniger sicher als kabelgebundene Netzwerke, da auf drahtlose Netzwerke ohne physische Verbindung problemlos zugegriffen werden kann.

Nach dem Zugriff kann ein Angreifer diese Sicherheitsanfälligkeit ausnutzen, um Angriffe wie -

Schnüffeln der Paketdaten, um wertvolle Informationen zu stehlen.

Denial-of-Service für legitime Benutzer in einem Netzwerk durch Überfluten des Netzwerkmediums mit falschen Paketen.

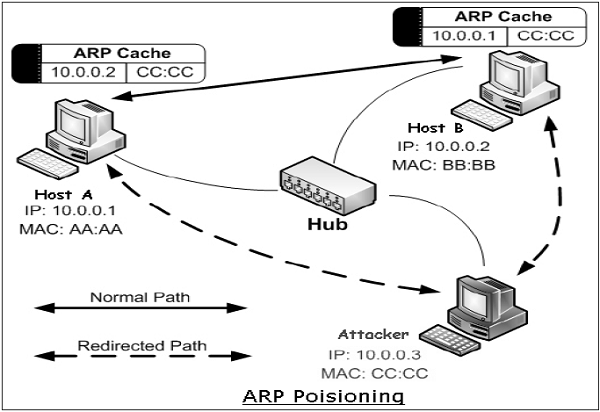

Spoofing der physischen Identität (MAC) legitimer Hosts und anschließender Diebstahl von Daten oder weiterer Start eines "Man-in-the-Middle" -Angriffs.

Netzwerkprotokoll

Das Netzwerkprotokoll besteht aus einer Reihe von Regeln, die die Kommunikation zwischen Geräten regeln, die in einem Netzwerk verbunden sind. Dazu gehören Mechanismen zum Herstellen von Verbindungen sowie Formatierungsregeln für das Datenpaketieren für gesendete und empfangene Nachrichten.

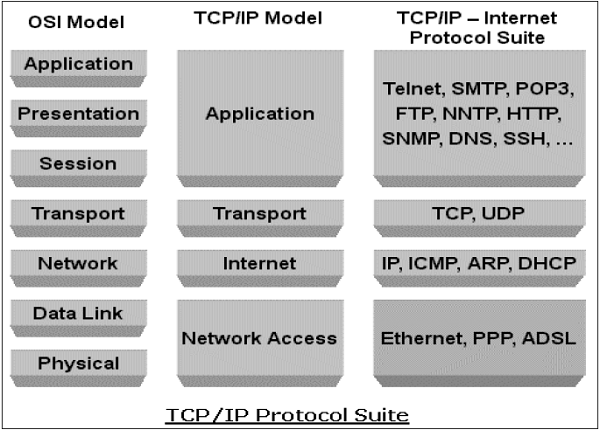

Es wurden mehrere Computernetzwerkprotokolle entwickelt, die jeweils für bestimmte Zwecke entwickelt wurden. Die populären und weit verbreiteten Protokolle sind TCP / IP mit zugehörigen Protokollen höherer und niedrigerer Ebene.

TCP / IP-Protokoll

Transmission Control Protocol (TCP) und Internet Protocol(IP) sind zwei unterschiedliche Computernetzwerkprotokolle, die meistens zusammen verwendet werden. Aufgrund ihrer Beliebtheit und breiten Akzeptanz sind sie in allen Betriebssystemen vernetzter Geräte integriert.

IP entspricht der Netzwerkschicht (Schicht 3), während TCP der Transportschicht (Schicht 4) in OSI entspricht. TCP / IP gilt für die Netzwerkkommunikation, bei der der TCP-Transport zur Bereitstellung von Daten über IP-Netzwerke verwendet wird.

TCP / IP-Protokolle werden üblicherweise mit anderen Protokollen wie HTTP, FTP, SSH auf Anwendungsebene und Ethernet auf Datenverbindungs- / physischer Ebene verwendet.

Die TCP / IP-Protokollsuite wurde 1980 als Internetworking-Lösung ohne Rücksicht auf Sicherheitsaspekte entwickelt.

Es wurde für eine Kommunikation im eingeschränkten vertrauenswürdigen Netzwerk entwickelt. Im Laufe der Zeit wurde dieses Protokoll jedoch zum De-facto-Standard für die ungesicherte Internetkommunikation.

Einige der häufigsten Sicherheitslücken von TCP / IP-Protokollanzügen sind:

HTTP ist ein Protokoll der Anwendungsschicht in der TCP / IP-Suite, das zum Übertragen von Dateien verwendet wird, aus denen die Webseiten von den Webservern bestehen. Diese Übertragungen erfolgen im Klartext und ein Eindringling kann die zwischen dem Server und einem Client ausgetauschten Datenpakete leicht lesen.

Eine weitere HTTP-Sicherheitsanfälligkeit ist eine schwache Authentifizierung zwischen dem Client und dem Webserver während der Initialisierung der Sitzung. Diese Sicherheitsanfälligkeit kann zu einem Sitzungsentführungsangriff führen, bei dem der Angreifer eine HTTP-Sitzung des legitimen Benutzers stiehlt.

Die Sicherheitsanfälligkeit bezüglich des TCP-Protokolls ist ein Drei-Wege-Handshake für den Verbindungsaufbau. Ein Angreifer kann einen Denial-of-Service-Angriff „SYN-Flooding“ starten, um diese Sicherheitsanfälligkeit auszunutzen. Er baut viele halb geöffnete Sitzungen auf, indem er den Handschlag nicht beendet. Dies führt zu einer Überlastung des Servers und schließlich zu einem Absturz.

Die IP-Schicht ist anfällig für viele Sicherheitslücken. Durch eine Änderung des IP-Protokoll-Headers kann ein Angreifer einen IP-Spoofing-Angriff starten.

Abgesehen von den oben genannten gibt es viele andere Sicherheitslücken in der TCP / IP-Protokollfamilie, sowohl im Design als auch in der Implementierung.

Übrigens werden bei der TCP / IP-basierten Netzwerkkommunikation, wenn eine Schicht gehackt wird, die anderen Schichten nicht auf den Hack aufmerksam und die gesamte Kommunikation wird beeinträchtigt. Daher müssen auf jeder Ebene Sicherheitskontrollen eingesetzt werden, um eine kinderleichte Sicherheit zu gewährleisten.

DNS-Protokoll

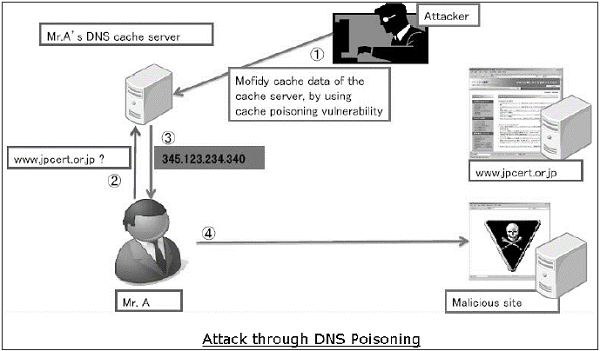

Domain Name System(DNS) wird verwendet, um Hostdomänennamen in IP-Adressen aufzulösen. Netzwerkbenutzer sind hauptsächlich beim Surfen im Internet auf DNS-Funktionen angewiesen, indem sie eine URL in den Webbrowser eingeben.

Bei einem Angriff auf DNS besteht das Ziel eines Angreifers darin, einen legitimen DNS-Eintrag so zu ändern, dass er in eine falsche IP-Adresse aufgelöst wird. Es kann den gesamten Datenverkehr für diese IP auf den falschen Computer leiten. Ein Angreifer kann entweder die Sicherheitsanfälligkeit des DNS-Protokolls ausnutzen oder den DNS-Server für die Durchführung eines Angriffs gefährden.

DNS cache poisoningist ein Angriff, der eine im DNS-Protokoll gefundene Sicherheitsanfälligkeit ausnutzt. Ein Angreifer kann den Cache vergiften, indem er eine Antwort auf eine rekursive DNS-Abfrage fälscht, die von einem Resolver an einen autorisierenden Server gesendet wird. Sobald der Cache des DNS-Resolvers vergiftet ist, wird der Host auf eine schädliche Website geleitet und kann durch die Kommunikation mit dieser Website Informationen zu Anmeldeinformationen gefährden.

ICMP-Protokoll

Internet Control Management Protocol(ICMP) ist ein grundlegendes Netzwerkverwaltungsprotokoll der TCP / IP-Netzwerke. Es wird verwendet, um Fehler- und Kontrollmeldungen zum Status von Netzwerkgeräten zu senden.

ICMP ist ein integraler Bestandteil der IP-Netzwerkimplementierung und daher in sehr Netzwerkeinstellungen vorhanden. ICMP hat seine eigenen Schwachstellen und kann missbraucht werden, um einen Angriff auf ein Netzwerk zu starten.

Die häufigsten Angriffe, die aufgrund von ICMP-Schwachstellen in einem Netzwerk auftreten können, sind:

Mit ICMP kann ein Angreifer eine Netzwerkaufklärung durchführen, um die Netzwerktopologie und die Pfade in das Netzwerk zu bestimmen. Beim ICMP-Sweep werden alle Host-IP-Adressen ermittelt, die im gesamten Netzwerk des Ziels vorhanden sind.

Trace Route ist ein beliebtes ICMP-Dienstprogramm, mit dem das Zielnetzwerk zugeordnet wird, indem der Pfad vom Client zum Remote-Host in Echtzeit beschrieben wird.

Ein Angreifer kann mithilfe der ICMP-Sicherheitsanfälligkeit einen Denial-of-Service-Angriff starten. Bei diesem Angriff werden IPMP-Ping-Pakete mit mehr als 65.535 Byte an das Zielgerät gesendet. Der Zielcomputer verarbeitet dieses Paket nicht ordnungsgemäß und kann dazu führen, dass das Betriebssystem beschädigt wird.

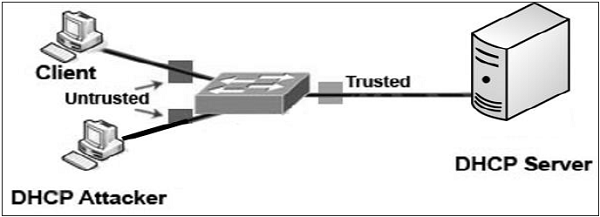

Andere Protokolle wie ARP, DHCP, SMTP usw. weisen ebenfalls Schwachstellen auf, die vom Angreifer ausgenutzt werden können, um die Netzwerksicherheit zu gefährden. Wir werden einige dieser Schwachstellen in späteren Kapiteln diskutieren.

Die geringste Sorge um den Sicherheitsaspekt beim Entwurf und der Implementierung von Protokollen hat sich zu einer Hauptursache für Bedrohungen der Netzwerksicherheit entwickelt.

Ziele der Netzwerksicherheit

Wie bereits in früheren Abschnitten erläutert, gibt es im Netzwerk eine große Anzahl von Sicherheitslücken. Daher sind Daten während der Übertragung sehr anfällig für Angriffe. Ein Angreifer kann auf den Kommunikationskanal zielen, die Daten abrufen und diese lesen oder eine falsche Nachricht erneut einfügen, um seine schändlichen Ziele zu erreichen.

Die Netzwerksicherheit betrifft nicht nur die Sicherheit der Computer an jedem Ende der Kommunikationskette. Ziel ist es jedoch sicherzustellen, dass das gesamte Netzwerk sicher ist.

Zur Netzwerksicherheit gehört der Schutz der Benutzerfreundlichkeit, Zuverlässigkeit, Integrität und Sicherheit von Netzwerken und Daten. Effektive Netzwerksicherheit verhindert, dass eine Vielzahl von Bedrohungen in ein Netzwerk eindringt oder sich dort ausbreitet.

Das Hauptziel der Netzwerksicherheit sind Vertraulichkeit, Integrität und Verfügbarkeit. Diese drei Säulen der Netzwerksicherheit werden häufig als dargestelltCIA triangle.

Confidentiality- Die Funktion der Vertraulichkeit besteht darin, wertvolle Geschäftsdaten vor unbefugten Personen zu schützen. Der Teil der Vertraulichkeit der Netzwerksicherheit stellt sicher, dass die Daten nur den beabsichtigten und autorisierten Personen zur Verfügung stehen.

Integrity- Dieses Ziel bedeutet, die Genauigkeit und Konsistenz der Daten zu gewährleisten und sicherzustellen. Die Funktion der Integrität besteht darin, sicherzustellen, dass die Daten zuverlässig sind und nicht von unbefugten Personen geändert werden.

Availability - Die Funktion der Verfügbarkeit in der Netzwerksicherheit besteht darin, sicherzustellen, dass die Daten, Netzwerkressourcen / -dienste den legitimen Benutzern jederzeit zur Verfügung stehen, wenn sie dies benötigen.

Netzwerksicherheit erreichen

Die Gewährleistung der Netzwerksicherheit scheint sehr einfach zu sein. Die zu erreichenden Ziele scheinen unkompliziert zu sein. In Wirklichkeit sind die Mechanismen zur Erreichung dieser Ziele jedoch sehr komplex, und das Verständnis dieser Mechanismen erfordert fundiertes Denken.

International Telecommunication Union(ITU) hat in seiner Empfehlung zur Sicherheitsarchitektur X.800 bestimmte Mechanismen definiert, um die Standardisierung von Methoden zur Erreichung der Netzwerksicherheit zu erreichen. Einige dieser Mechanismen sind -

En-cipherment- Dieser Mechanismus bietet Datenvertraulichkeitsdienste, indem Daten für nicht autorisierte Personen in nicht lesbare Formulare umgewandelt werden. Dieser Mechanismus verwendet einen Verschlüsselungs- / Entschlüsselungsalgorithmus mit geheimen Schlüsseln.

Digital signatures- Dieser Mechanismus ist das elektronische Äquivalent zu normalen Signaturen in elektronischen Daten. Es bietet Authentizität der Daten.

Access control- Dieser Mechanismus wird zur Bereitstellung von Zugriffskontrolldiensten verwendet. Diese Mechanismen können die Identifizierung und Authentifizierung einer Entität verwenden, um die Zugriffsrechte der Entität zu bestimmen und durchzusetzen.

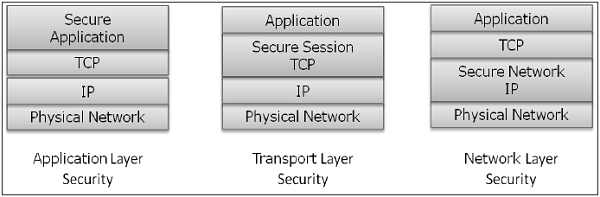

Nachdem verschiedene Sicherheitsmechanismen zur Erreichung der Netzwerksicherheit entwickelt und identifiziert wurden, ist es wichtig zu entscheiden, wo sie angewendet werden sollen. sowohl physisch (an welchem Ort) als auch logisch (auf welcher Ebene einer Architektur wie TCP / IP).

Sicherheitsmechanismen auf Netzwerkebenen

Mehrere Sicherheitsmechanismen wurden so entwickelt, dass sie auf einer bestimmten Ebene des OSI-Netzwerkschichtmodells entwickelt werden können.

Security at Application Layer- Die auf dieser Ebene verwendeten Sicherheitsmaßnahmen sind anwendungsspezifisch. Verschiedene Arten von Anwendungen würden separate Sicherheitsmaßnahmen erfordern. Um die Sicherheit der Anwendungsschicht zu gewährleisten, müssen die Anwendungen geändert werden.

Es wird davon ausgegangen, dass das Entwerfen eines kryptografisch einwandfreien Anwendungsprotokolls sehr schwierig ist und die ordnungsgemäße Implementierung noch schwieriger ist. Daher werden Sicherheitsmechanismen auf Anwendungsebene zum Schutz der Netzwerkkommunikation bevorzugt als standardbasierte Lösungen, die seit einiger Zeit verwendet werden.

Ein Beispiel für ein Sicherheitsprotokoll auf Anwendungsebene ist Secure Multipurpose Internet Mail Extensions (S / MIME), das üblicherweise zum Verschlüsseln von E-Mail-Nachrichten verwendet wird. DNSSEC ist ein weiteres Protokoll auf dieser Ebene, das für den sicheren Austausch von DNS-Abfragenachrichten verwendet wird.

Security at Transport Layer- Sicherheitsmaßnahmen auf dieser Ebene können verwendet werden, um die Daten in einer einzigen Kommunikationssitzung zwischen zwei Hosts zu schützen. Die häufigste Verwendung für Sicherheitsprotokolle der Transportschicht ist der Schutz des HTTP- und FTP-Sitzungsverkehrs. Die Transport Layer Security (TLS) und die Secure Socket Layer (SSL) sind die am häufigsten verwendeten Protokolle für diesen Zweck.

Network Layer- Sicherheitsmaßnahmen auf dieser Ebene können auf alle Anwendungen angewendet werden. Sie sind daher nicht anwendungsspezifisch. Die gesamte Netzwerkkommunikation zwischen zwei Hosts oder Netzwerken kann auf dieser Ebene geschützt werden, ohne dass eine Anwendung geändert werden muss. In einigen Umgebungen bietet das Sicherheitsprotokoll der Netzwerkschicht, wie z. B. IPsec (Internet Protocol Security), eine viel bessere Lösung als Steuerelemente der Transport- oder Anwendungsschicht, da es schwierig ist, einzelnen Anwendungen Steuerelemente hinzuzufügen. Sicherheitsprotokolle auf dieser Ebene bieten jedoch weniger Kommunikationsflexibilität, die von einigen Anwendungen möglicherweise benötigt wird.

Im Übrigen kann ein Sicherheitsmechanismus, der für den Betrieb auf einer höheren Schicht ausgelegt ist, keinen Schutz für Daten auf niedrigeren Schichten bieten, da die niedrigeren Schichten Funktionen ausführen, die den höheren Schichten nicht bekannt sind. Daher kann es erforderlich sein, mehrere Sicherheitsmechanismen bereitzustellen, um die Netzwerksicherheit zu verbessern.

In den folgenden Kapiteln des Lernprogramms werden die Sicherheitsmechanismen erläutert, die auf verschiedenen Ebenen der OSI-Netzwerkarchitektur zum Erreichen der Netzwerksicherheit eingesetzt werden.

Verschiedene Geschäftsdienste werden jetzt online über Client-Server-Anwendungen angeboten. Die beliebtesten Formulare sind Webanwendung und E-Mail. In beiden Anwendungen kommuniziert der Client mit dem angegebenen Server und erhält Dienste.

Bei der Verwendung eines Dienstes aus einer beliebigen Serveranwendung tauschen Client und Server viele Informationen im zugrunde liegenden Intranet oder Internet aus. Wir sind uns der Tatsache bewusst, dass diese Informationstransaktionen für verschiedene Angriffe anfällig sind.

Bei der Netzwerksicherheit werden Daten vor Angriffen geschützt, während sie in einem Netzwerk übertragen werden. Um dieses Ziel zu erreichen, wurden viele Echtzeit-Sicherheitsprotokolle entwickelt. Ein solches Protokoll muss mindestens die folgenden Hauptziele erfüllen:

- Die Parteien können interaktiv verhandeln, um sich gegenseitig zu authentifizieren.

- Richten Sie einen geheimen Sitzungsschlüssel ein, bevor Sie Informationen im Netzwerk austauschen.

- Tauschen Sie die Informationen in verschlüsselter Form aus.

Interessanterweise arbeiten diese Protokolle auf verschiedenen Ebenen des Netzwerkmodells. Beispielsweise funktioniert das S / MIME-Protokoll auf Anwendungsebene, das SSL-Protokoll wurde für die Transportschicht entwickelt und das IPSec-Protokoll arbeitet auf Netzwerkebene.

In diesem Kapitel werden verschiedene Prozesse zum Erreichen der Sicherheit für die E-Mail-Kommunikation und die zugehörigen Sicherheitsprotokolle erläutert. Die Methode zum Sichern von DNS wird anschließend behandelt. In den späteren Kapiteln werden die Protokolle zur Erreichung der Websicherheit beschrieben.

E-Mail-Sicherheit

Heutzutage ist E-Mail eine sehr weit verbreitete Netzwerkanwendung geworden. Lassen Sie uns kurz die E-Mail-Infrastruktur besprechen, bevor wir uns mit den E-Mail-Sicherheitsprotokollen befassen.

E-Mail-Infrastruktur

Der einfachste Weg, eine E-Mail zu senden, besteht darin, eine Nachricht direkt vom Computer des Absenders an den Computer des Empfängers zu senden. In diesem Fall ist es wichtig, dass beide Computer gleichzeitig im Netzwerk ausgeführt werden. Diese Einrichtung ist jedoch unpraktisch, da Benutzer gelegentlich ihre Computer mit dem Netzwerk verbinden können.

Daher kam das Konzept der Einrichtung von E-Mail-Servern auf. In diesem Setup wird die E-Mail an einen Mailserver gesendet, der permanent im Netzwerk verfügbar ist. Wenn der Computer des Empfängers eine Verbindung zum Netzwerk herstellt, liest er die E-Mails vom Mailserver.

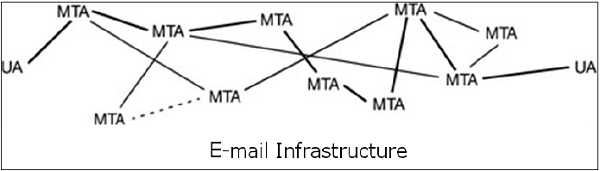

Im Allgemeinen besteht die E-Mail-Infrastruktur aus einem Netz von Mailservern, die auch als bezeichnet werden Message Transfer Agents (MTAs) und Client-Computer, auf denen ein E-Mail-Programm ausgeführt wird, das aus User Agent (UA) und lokalem MTA besteht.

In der Regel wird eine E-Mail-Nachricht von ihrer UA weitergeleitet, durchläuft das Netz von MTAs und erreicht schließlich die UA auf dem Computer des Empfängers.

Die für E-Mails verwendeten Protokolle lauten wie folgt:

SMTP (Simple Mail Transfer Protocol) zum Weiterleiten von E-Mail-Nachrichten.

Post Office Protocol (POP) und Internet Message Access Protocol (IMAP) werden verwendet, um die Nachrichten des Empfängers vom Server abzurufen.

MIME

Der grundlegende Internet-E-Mail-Standard wurde 1982 geschrieben und beschreibt das Format der im Internet ausgetauschten E-Mail-Nachrichten. Es unterstützt hauptsächlich E-Mail-Nachrichten, die als Text im grundlegenden römischen Alphabet geschrieben sind.

Bis 1992 bestand das Bedürfnis, dasselbe zu verbessern. Daher wurde ein zusätzlicher Standard für Mehrzweck-Internet-Mail-Erweiterungen (MIME) definiert. Es handelt sich um eine Reihe von Erweiterungen des grundlegenden Internet-E-Mail-Standards. MIME bietet die Möglichkeit, E-Mails mit anderen Zeichen als denen des grundlegenden römischen Alphabets zu senden, z. B. dem kyrillischen Alphabet (auf Russisch verwendet), dem griechischen Alphabet oder sogar den ideografischen Zeichen des Chinesischen.

Ein weiteres von MIME erfülltes Bedürfnis ist das Senden von Nicht-Text-Inhalten wie Bildern oder Videoclips. Aufgrund dieser Funktionen wurde der MIME-Standard mit SMTP für die E-Mail-Kommunikation weit verbreitet.

E-Mail-Sicherheitsdienste

Die zunehmende Nutzung der E-Mail-Kommunikation für wichtige und wichtige Transaktionen erfordert die Bereitstellung bestimmter grundlegender Sicherheitsdienste wie folgt:

Confidentiality - E-Mail-Nachrichten sollten nur von dem beabsichtigten Empfänger gelesen werden.

Authentication - Der E-Mail-Empfänger kann sich der Identität des Absenders sicher sein.

Integrity - Zusicherung an den Empfänger, dass die E-Mail-Nachricht seit der Übermittlung durch den Absender nicht geändert wurde.

Non-repudiation - Der E-Mail-Empfänger kann einem Dritten nachweisen, dass der Absender die Nachricht tatsächlich gesendet hat.

Proof of submission - Der E-Mail-Absender erhält die Bestätigung, dass die Nachricht an das Postzustellungssystem übergeben wird.

Proof of delivery - Der Absender erhält eine Bestätigung, dass der Empfänger die Nachricht erhalten hat.

Sicherheitsdienste wie Datenschutz, Authentifizierung, Nachrichtenintegrität und Nicht-Zurückweisung werden normalerweise mithilfe der Kryptografie mit öffentlichen Schlüsseln bereitgestellt.

In der Regel gibt es drei verschiedene Szenarien für die E-Mail-Kommunikation. In diesen Szenarien werden die Methoden zum Erreichen der oben genannten Sicherheitsdienste erörtert.

Eins-zu-eins-E-Mail

In diesem Szenario sendet der Absender eine E-Mail-Nachricht nur an einen Empfänger. Normalerweise sind nicht mehr als zwei MTA an der Kommunikation beteiligt.

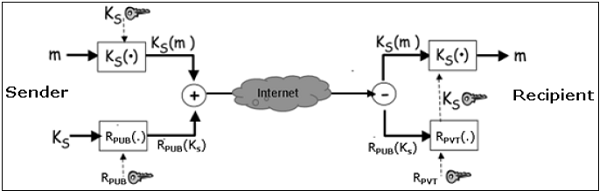

Nehmen wir an, ein Absender möchte eine vertrauliche E-Mail an einen Empfänger senden. Die Bereitstellung der Privatsphäre wird in diesem Fall wie folgt erreicht:

Der Sender und der Empfänger haben ihre privat-öffentlichen Schlüssel als (S PVT , S PUB ) bzw. (R PVT , R PUB ).

Der Absender generiert einen geheimen symmetrischen Schlüssel K S zur Verschlüsselung. Obwohl der Absender R PUB für die Verschlüsselung hätte verwenden können , wird ein symmetrischer Schlüssel verwendet, um eine schnellere Ver- und Entschlüsselung zu erreichen.

Der Absender verschlüsselt die Nachricht mit dem Schlüssel K S und verschlüsselt K S auch mit dem öffentlichen Schlüssel des Empfängers R PUB .

Der Absender sendet eine verschlüsselte Nachricht und ein verschlüsseltes K S an den Empfänger.

Der Empfänger erhält zuerst K S, indem er codiertes K S unter Verwendung seines privaten Schlüssels R PVT entschlüsselt .

Der Empfänger entschlüsselt dann Nachricht mithilfe des symmetrischen Schlüssels, K S .

Wenn in diesem Szenario auch Dienste für Nachrichtenintegrität, Authentifizierung und Nicht-Zurückweisung erforderlich sind, werden die folgenden Schritte zum obigen Prozess hinzugefügt.

Der Absender erzeugt einen Hash der Nachricht und signiert diesen Hash digital mit seinem privaten Schlüssel S PVT .

Der Absender sendet diesen signierten Hash zusammen mit anderen Komponenten an den Empfänger.

Der Empfänger verwendet den öffentlichen Schlüssel S PUB und extrahiert den unter der Unterschrift des Absenders empfangenen Hash.

Der Empfänger hasht dann die entschlüsselte Nachricht und vergleicht nun die beiden Hashwerte. Wenn sie übereinstimmen, wird die Nachrichtenintegrität als erreicht angesehen.

Der Empfänger ist sich auch sicher, dass die Nachricht vom Absender gesendet wird (Authentifizierung). Und schließlich kann der Absender nicht leugnen, dass er die Nachricht nicht gesendet hat (Nicht-Zurückweisung).

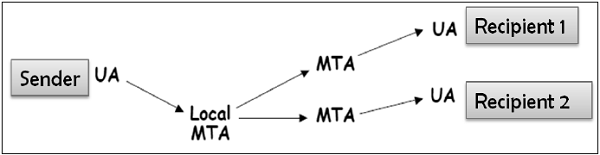

E-Mail von einem zu mehreren Empfängern

In diesem Szenario sendet der Absender eine E-Mail-Nachricht an zwei oder mehr Empfänger. Die Liste wird vom E-Mail-Programm des Absenders (UA + lokaler MTA) verwaltet. Alle Empfänger erhalten die gleiche Nachricht.

Nehmen wir an, der Absender möchte vertrauliche E-Mails an viele Empfänger senden (z. B. R1, R2 und R3). Die Bereitstellung der Privatsphäre wird in diesem Fall wie folgt erreicht:

Der Absender und alle Empfänger haben ein eigenes Paar von privat-öffentlichen Schlüsseln.

Der Absender generiert einen geheimen symmetrischen Schlüssel K s und verschlüsselt die Nachricht mit diesem Schlüssel.

Der Absender verschlüsselt dann K S mehrmals mit öffentlichen Schlüsseln von R1, R2 und R3 und erhält R1 PUB (K S ), R2 PUB (K S ) und R3 PUB (K S ).

Der Absender sendet eine verschlüsselte Nachricht und das entsprechende verschlüsselte K S an den Empfänger. Beispielsweise empfängt Empfänger 1 (R1) eine verschlüsselte Nachricht und R1 PUB (K S ).

Jeder Empfänger extrahiert zuerst den Schlüssel K S, indem er den verschlüsselten K S mit seinem privaten Schlüssel entschlüsselt .

Jeder Empfänger entschlüsselt dann die Nachricht mithilfe des symmetrischen Schlüssels, K S .

Die Schritte zum Bereitstellen der Nachrichtenintegrität, -authentifizierung und -verweigerung ähneln den oben im Eins-zu-Eins-E-Mail-Szenario genannten Schritten.

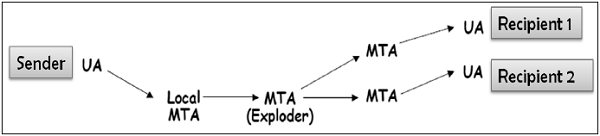

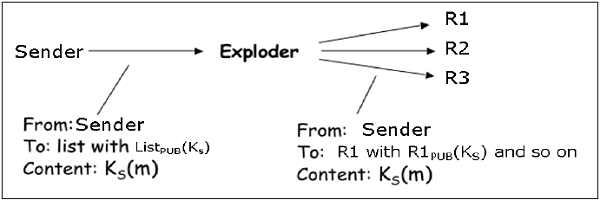

E-Mail mit einer Verteilerliste

In diesem Szenario sendet der Absender eine E-Mail-Nachricht an zwei oder mehr Empfänger, aber die Liste der Empfänger wird vom Absender nicht lokal verwaltet. Im Allgemeinen verwaltet der E-Mail-Server (MTA) die Mailingliste.

Der Absender sendet eine E-Mail an den MTA, der die Mailingliste verwaltet, und anschließend wird die E-Mail von MTA an alle Empfänger in der Liste aufgelöst.

In diesem Fall, wenn der Absender eine vertrauliche E-Mail an die Empfänger der Mailingliste senden möchte (z. B. R1, R2 und R3); Die Privatsphäre wird wie folgt gewährleistet:

Der Absender und alle Empfänger haben ein eigenes Paar von privat-öffentlichen Schlüsseln. Der Exploder-Server verfügt über ein Paar von privat-öffentlichen Schlüsseln für jede von ihm verwaltete Mailingliste (List PUB , List PVT ).

Der Absender erzeugt einen geheimen symmetrischen Schlüssel K s und verschlüsselt dann die Nachricht mit diesem Schlüssel.

Der Absender verschlüsselt dann K S mit dem der Liste zugeordneten öffentlichen Schlüssel und erhält List PUB (K S ).

Der Absender sendet eine verschlüsselte Nachricht und listet PUB (K S ) auf. Die exploder MTA dechiffriert Liste PUB (K S ) unter Verwendung Liste PVT und erhält K S .

Der Exploder verschlüsselt K S mit so vielen öffentlichen Schlüsseln, wie Mitglieder in der Liste vorhanden sind.

Der Exploder leitet die empfangene verschlüsselte Nachricht und das entsprechende verschlüsselte K S an alle Empfänger in der Liste weiter. Beispielsweise leitet der Exploder die verschlüsselte Nachricht und R1 PUB (K S ) an Empfänger 1 usw. weiter.

Für die Bereitstellung der Nachrichtenintegrität, -authentifizierung und -verweigerung sind die folgenden Schritte ähnlich wie im Fall eines Eins-zu-Eins-E-Mail-Szenarios.

Interessanterweise wird erwartet, dass das E-Mail-Programm, das die oben genannte Sicherheitsmethode zum Sichern von E-Mails verwendet, für alle oben diskutierten möglichen Szenarien funktioniert. Die meisten der oben genannten Sicherheitsmechanismen für E-Mails werden von zwei gängigen Systemen bereitgestellt: Pretty Good Privacy (PGP) und S / MIME. Wir diskutieren beide in den folgenden Abschnitten.

PGP

Pretty Good Privacy(PGP) ist ein E-Mail-Verschlüsselungsschema. Es ist zum De-facto-Standard für die Bereitstellung von Sicherheitsdiensten für die E-Mail-Kommunikation geworden.

Wie oben erläutert, werden Kryptografie mit öffentlichem Schlüssel, Kryptografie mit symmetrischem Schlüssel, Hash-Funktion und digitale Signatur verwendet. Es bietet -

- Privacy

- Absenderauthentifizierung

- Nachrichtenintegrität

- Non-repudiation

Neben diesen Sicherheitsdiensten bietet es auch Unterstützung für Datenkomprimierung und Schlüsselverwaltung. PGP verwendet vorhandene kryptografische Algorithmen wie RSA, IDEA, MD5 usw., anstatt die neuen zu erfinden.

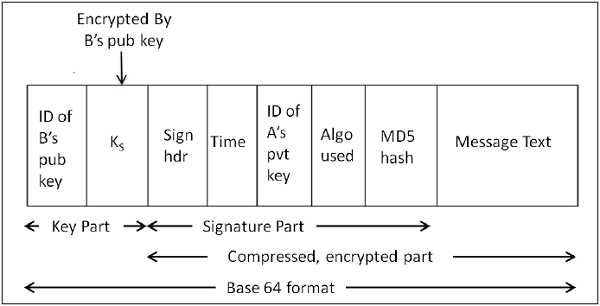

Arbeiten von PGP

Der Hash der Nachricht wird berechnet. (MD5-Algorithmus)

Der resultierende 128-Bit-Hash wird mit dem privaten Schlüssel des Absenders (RSA-Algorithmus) signiert.

Die digitale Signatur wird mit der Nachricht verknüpft und das Ergebnis wird komprimiert.

Ein 128-Bit-Symmetrieschlüssel K S wird generiert und zum Verschlüsseln der komprimierten Nachricht mit IDEA verwendet.

K S wird mit dem öffentlichen Schlüssel des Empfängers unter Verwendung des RSA-Algorithmus verschlüsselt und das Ergebnis an die verschlüsselte Nachricht angehängt.

Das Format der PGP-Nachricht ist in der folgenden Abbildung dargestellt. Die IDs geben an, welcher Schlüssel zum Verschlüsseln von KS verwendet wird und welcher Schlüssel zum Überprüfen der Signatur auf dem Hash verwendet werden soll.

Im PGP-Schema wird eine Nachricht signiert und verschlüsselt, und dann wird MIME vor der Übertragung codiert.

PGP-Zertifikat

Das PGP-Schlüsselzertifikat wird normalerweise über eine Vertrauenskette eingerichtet. Beispielsweise wird der öffentliche Schlüssel von A von B mit seinem öffentlichen Schlüssel und der öffentliche Schlüssel von B von C mit seinem öffentlichen Schlüssel signiert. Während dieses Prozesses wird ein Vertrauensnetz aufgebaut.

In einer PGP-Umgebung kann jeder Benutzer als Zertifizierungsstelle fungieren. Jeder PGP-Benutzer kann den öffentlichen Schlüssel eines anderen PGP-Benutzers zertifizieren. Ein solches Zertifikat ist jedoch nur für einen anderen Benutzer gültig, wenn der Benutzer den Zertifizierer als vertrauenswürdigen Einführer erkennt.

Bei einer solchen Zertifizierungsmethode gibt es mehrere Probleme. Es kann schwierig sein, eine Kette zu finden, die von einem bekannten und vertrauenswürdigen öffentlichen Schlüssel zum gewünschten Schlüssel führt. Es kann auch mehrere Ketten geben, die für den gewünschten Benutzer zu unterschiedlichen Schlüsseln führen können.

PGP kann auch die PKI-Infrastruktur mit Zertifizierungsstelle verwenden und öffentliche Schlüssel können von CA (X.509-Zertifikat) zertifiziert werden.

S / MIME

S / MIME steht für Secure Multipurpose Internet Mail Extension. S / MIME ist ein sicherer E-Mail-Standard. Es basiert auf einem früheren nicht sicheren E-Mail-Standard namens MIME.

Arbeiten von S / MIME

Der S / MIME-Ansatz ähnelt dem von PGP. Es werden auch Kryptografie mit öffentlichem Schlüssel, Kryptografie mit symmetrischem Schlüssel, Hash-Funktionen und digitale Signaturen verwendet. Es bietet ähnliche Sicherheitsdienste wie PGP für die E-Mail-Kommunikation.

Die in S / MIME am häufigsten verwendeten symmetrischen Chiffren sind RC2 und TripleDES. Die übliche Public-Key-Methode ist RSA, und der Hashing-Algorithmus ist SHA-1 oder MD5.

S / MIME gibt den zusätzlichen MIME-Typ an, z. B. "application / pkcs7-mime" für die Datenumhüllung nach der Verschlüsselung. Die gesamte MIME-Entität wird verschlüsselt und in ein Objekt gepackt. S / MIME verfügt über standardisierte kryptografische Nachrichtenformate (anders als PGP). Tatsächlich wird MIME um einige Schlüsselwörter erweitert, um die verschlüsselten und / oder signierten Teile in der Nachricht zu identifizieren.

S / MIME verwendet X.509-Zertifikate für die Verteilung öffentlicher Schlüssel. Für die Zertifizierungsunterstützung ist eine hierarchische PKI von oben nach unten erforderlich.

Beschäftigungsfähigkeit von S / MIME

Aufgrund der Anforderung eines Zertifikats der Zertifizierungsstelle für die Implementierung können nicht alle Benutzer S / MIME nutzen, da einige möglicherweise eine Nachricht mit einem öffentlichen / privaten Schlüsselpaar verschlüsseln möchten. Zum Beispiel ohne die Beteiligung oder den Verwaltungsaufwand von Zertifikaten.

In der Praxis ist der Prozess der Zertifikatsregistrierung komplex, obwohl die meisten E-Mail-Anwendungen S / MIME implementieren. Stattdessen erfordert die PGP-Unterstützung normalerweise das Hinzufügen eines Plug-Ins. Dieses Plug-In enthält alles, was zum Verwalten von Schlüsseln erforderlich ist. Das Web of Trust wird nicht wirklich genutzt. Menschen tauschen ihre öffentlichen Schlüssel über ein anderes Medium aus. Nach Erhalt bewahren sie eine Kopie der öffentlichen Schlüssel derjenigen auf, mit denen normalerweise E-Mails ausgetauscht werden.

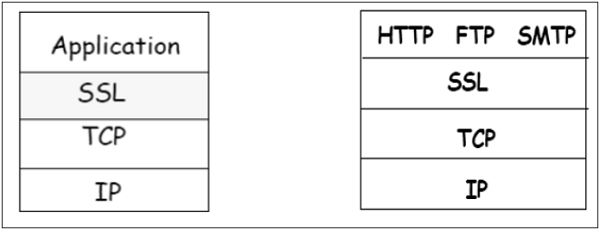

Die Implementierungsschicht in der Netzwerkarchitektur für PGP- und S / MIME-Schemata ist in der folgenden Abbildung dargestellt. Beide Schemata bieten Sicherheit auf Anwendungsebene für die E-Mail-Kommunikation.

Eines der Schemata, entweder PGP oder S / MIME, wird je nach Umgebung verwendet. Eine sichere E-Mail-Kommunikation in einem Captive-Netzwerk kann durch Anpassung an PGP bereitgestellt werden. Für die E-Mail-Sicherheit über das Internet, wo E-Mails sehr häufig mit neuen unbekannten Benutzern ausgetauscht werden, wird S / MIME als gute Option angesehen.

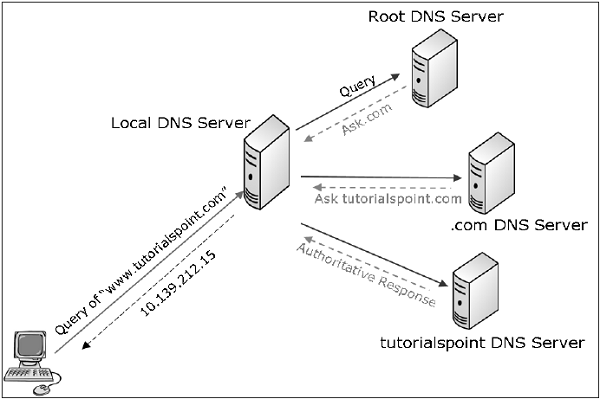

DNS-Sicherheit

Im ersten Kapitel haben wir erwähnt, dass ein Angreifer mithilfe der DNS-Cache-Vergiftung einen Angriff auf den Zielbenutzer ausführen kann. Domain Name System Security Extensions (DNSSEC) ist ein Internetstandard, der solche Angriffe abwehren kann.

Sicherheitslücke von Standard-DNS

In einem Standard-DNS-Schema kontaktiert sein Computer den DNS-Server, wenn der Benutzer eine Verbindung zu einem Domänennamen herstellen möchte, und sucht nach der zugehörigen IP-Adresse für diesen Domänennamen. Sobald die IP-Adresse erhalten wurde, stellt der Computer eine Verbindung zu dieser IP-Adresse her.

In diesem Schema ist überhaupt kein Überprüfungsprozess beteiligt. Ein Computer fragt seinen DNS-Server nach der einer Website zugeordneten Adresse, der DNS-Server antwortet mit einer IP-Adresse, und Ihr Computer akzeptiert diese zweifellos als legitime Antwort und stellt eine Verbindung zu dieser Website her.

Eine DNS-Suche erfolgt tatsächlich in mehreren Schritten. Wenn ein Computer beispielsweise nach "www.tutorialspoint.com" fragt, wird eine DNS-Suche in mehreren Schritten durchgeführt.

Der Computer fragt zuerst den lokalen DNS-Server (ISP bereitgestellt). Wenn der ISP diesen Namen im Cache hat, antwortet er andernfalls und leitet die Abfrage an das "Stammzonenverzeichnis" weiter, wo er ".com" finden kann. und Root-Zone-Antworten.

Basierend auf der Antwort fragt der Computer dann das Verzeichnis ".com", in dem er "tutorialspoint.com" finden kann.

Basierend auf den erhaltenen Informationen fragt der Computer "tutorialspoint.com" ab, wo er www finden kann. tutorialspoint.com.

DNSSEC definiert

Wenn die DNS-Suche mit DNSSEC durchgeführt wird, werden die Antworten von der antwortenden Entität signiert. DNSSEC basiert auf Kryptografie mit öffentlichem Schlüssel.

Im DNSSEC-Standard verfügt jede DNS-Zone über ein öffentliches / privates Schlüsselpaar. Alle von einem DNS-Server gesendeten Informationen werden mit dem privaten Schlüssel der Ursprungszone signiert, um die Authentizität sicherzustellen. DNS-Clients müssen die öffentlichen Schlüssel der Zone kennen, um die Signaturen zu überprüfen. Clients können mit den öffentlichen Schlüsseln aller Domänen der obersten Ebene oder dem Root-DNS vorkonfiguriert sein.

Mit DNSSEC läuft der Suchvorgang wie folgt ab:

Wenn Ihr Computer die Root-Zone fragt, wo er .com finden kann, wird die Antwort vom Root-Zone-Server signiert.

Der Computer überprüft den Signaturschlüssel der Stammzone und bestätigt, dass es sich um die legitime Stammzone mit echten Informationen handelt.

In der Antwort stellt die Stammzone die Informationen zum Signaturschlüssel des .com-Zonenservers und dessen Speicherort bereit, sodass der Computer das .com-Verzeichnis kontaktieren und sicherstellen kann, dass es legitim ist.

Das .com-Verzeichnis enthält dann den Signaturschlüssel und Informationen für tutorialspoint.com, sodass es Kontakt mit google.com aufnehmen und überprüfen kann, ob Sie mit dem echten tutorialspoint.com verbunden sind. Dies wird durch die darüber liegenden Zonen bestätigt.

Die gesendeten Informationen liegen in Form von RRSets (Resource Record Set) vor. Das Beispiel für RRSet für die Domain "tutorialspoint.com" auf dem Top-Server ".com" ist in der folgenden Tabelle dargestellt.

| Domain Name | Zeit zu leben | Art | Wert |

|---|---|---|---|

| tutorialspoint.com | 86400 | NS | dns.tutorialspoint.com |

| dns.tutorialspoint.com | 86400 | EIN | 36..1.2.3 |

| tutorialspoint.com | 86400 | SCHLÜSSEL | 3682793A7B73F731029CE2737D ... |

| tutorialspoint.com | 86400 | SIG | 86947503A8B848F5272E53930C ... |

Der KEY-Datensatz ist ein öffentlicher Schlüssel von "tutorialspoint.com".

Der SIG-Datensatz ist der signierte Hash des .com-Servers der obersten Ebene mit den Feldern NS-, A- und KEY-Datensätze, um deren Authentizität zu überprüfen. Sein Wert ist Kcom pvt (H (NS, A, KEY)).

Daher wird davon ausgegangen, dass der Computer des Benutzers bei vollständiger Einführung von DNSSEC bestätigen kann, dass DNS-Antworten legitim und wahr sind, und DNS-Angriffe vermeiden kann, die durch eine DNS-Cache-Vergiftung ausgelöst werden.

Zusammenfassung

Der Prozess der Sicherung von E-Mails gewährleistet die End-to-End-Sicherheit der Kommunikation. Es bietet Sicherheitsdienste für Vertraulichkeit, Absenderauthentifizierung, Nachrichtenintegrität und Nicht-Zurückweisung.

Für die E-Mail-Sicherheit wurden zwei Schemata entwickelt: PGP und S / MIME. Beide Schemata verwenden Kryptographie mit geheimem Schlüssel und öffentlichem Schlüssel.

Die Standard-DNS-Suche ist anfällig für Angriffe wie DNS-Spoofing / Cache-Vergiftung. Das Sichern der DNS-Suche ist durch die Verwendung von DNSSEC möglich, das die Kryptografie mit öffentlichem Schlüssel verwendet.

In diesem Kapitel haben wir die Mechanismen erörtert, die auf Anwendungsebene verwendet werden, um Netzwerksicherheit für die End-to-End-Kommunikation bereitzustellen.

Bei der Netzwerksicherheit werden Daten vor Angriffen geschützt, während sie in einem Netzwerk übertragen werden. Um dieses Ziel zu erreichen, wurden viele Echtzeit-Sicherheitsprotokolle entwickelt. Es gibt beliebte Standards für Echtzeit-Netzwerksicherheitsprotokolle wie S / MIME, SSL / TLS, SSH und IPsec. Wie bereits erwähnt, arbeiten diese Protokolle auf verschiedenen Ebenen des Netzwerkmodells.

Im letzten Kapitel haben wir einige gängige Protokolle besprochen, die Sicherheit auf Anwendungsebene bieten sollen. In diesem Kapitel werden wir den Prozess zum Erreichen der Netzwerksicherheit auf der Transportschicht und die zugehörigen Sicherheitsprotokolle erörtern.

Für ein auf dem TCP / IP-Protokoll basierendes Netzwerk werden in der Regel physische und Datenverbindungsschichten in der Hardware des Benutzerterminals und der Netzwerkkarte implementiert. TCP- und IP-Schichten sind im Betriebssystem implementiert. Alles über TCP / IP wird als Benutzerprozess implementiert.

Notwendigkeit der Sicherheit der Transportschicht

Lassen Sie uns einen typischen internetbasierten Geschäftsvorgang diskutieren.

Bob besucht Alices Website, um Waren zu verkaufen. In einem Formular auf der Website gibt Bob die Art der gewünschten Ware und Menge, seine Adresse und die Zahlungskartendaten ein. Bob klickt auf Senden und wartet auf die Lieferung von Waren mit Abbuchung des Preisbetrags von seinem Konto. Das klingt alles gut, aber ohne Netzwerksicherheit könnte Bob einige Überraschungen erleben.

Wenn bei Transaktionen keine Vertraulichkeit (Verschlüsselung) verwendet wurde, konnte ein Angreifer seine Zahlungskarteninformationen abrufen. Der Angreifer kann dann auf Kosten von Bob Einkäufe tätigen.

Wenn kein Maß für die Datenintegrität verwendet wird, kann ein Angreifer die Bestellung von Bob in Bezug auf Art oder Menge der Waren ändern.

Wenn keine Serverauthentifizierung verwendet wird, kann ein Server das berühmte Alice-Logo anzeigen, aber die Site kann eine böswillige Site sein, die von einem Angreifer verwaltet wird, der sich als Alice tarnt. Nachdem er Bobs Befehl erhalten hatte, konnte er Bobs Geld nehmen und fliehen. Oder er könnte einen Identitätsdiebstahl durchführen, indem er Bobs Namen und Kreditkartendaten sammelt.

Sicherheitsschemata der Transportschicht können diese Probleme lösen, indem sie die TCP / IP-basierte Netzwerkkommunikation mit Vertraulichkeit, Datenintegrität, Serverauthentifizierung und Clientauthentifizierung verbessern.

Die Sicherheit auf dieser Ebene wird hauptsächlich zum Sichern von HTTP-basierten Webtransaktionen in einem Netzwerk verwendet. Es kann jedoch von jeder Anwendung verwendet werden, die über TCP ausgeführt wird.

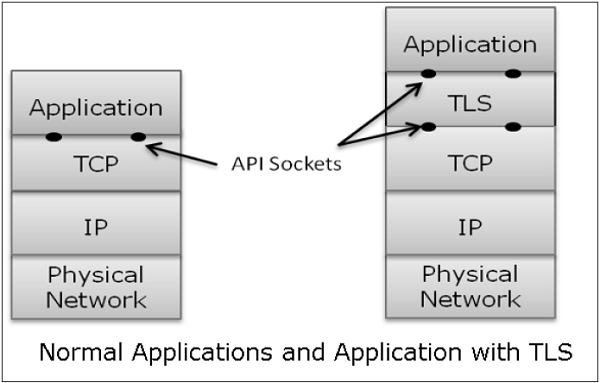

Philosophie des TLS-Designs

TLS-Protokolle (Transport Layer Security) arbeiten über der TCP-Schicht. Beim Entwurf dieser Protokolle werden beliebte APIs (Application Program Interfaces) für TCP verwendet, die als "Sockets" für die Schnittstelle mit der TCP-Schicht bezeichnet werden.

Anwendungen sind jetzt direkt mit TCP verbunden, anstatt direkt mit TCP. Transport Security Layer bietet eine einfache API mit Sockets, die der TCP-API ähnlich und analog ist.

Im obigen Diagramm befindet sich TLS zwar technisch zwischen Anwendung und Transportschicht, aus der allgemeinen Perspektive handelt es sich jedoch um ein Transportprotokoll, das als TCP-Schicht fungiert, die mit Sicherheitsdiensten erweitert wurde.

TLS wurde für den Betrieb über TCP entwickelt, das zuverlässige Layer 4-Protokoll (nicht für das UDP-Protokoll), um das Design von TLS erheblich zu vereinfachen, da es sich nicht um Zeitüberschreitung und erneute Übertragung verlorener Daten kümmern muss. Die TCP-Schicht macht das wie gewohnt weiter, was den Anforderungen von TLS entspricht.

Warum ist TLS beliebt?

Der Grund für die Beliebtheit der Verwendung einer Sicherheit bei Transport Layer ist die Einfachheit. Das Design und die Bereitstellung der Sicherheit auf dieser Ebene erfordern keine Änderung der TCP / IP-Protokolle, die in einem Betriebssystem implementiert sind. Es müssen nur Benutzerprozesse und -anwendungen entworfen / geändert werden, was weniger komplex ist.

Secure Socket Layer (SSL)

In diesem Abschnitt wird die Familie der für TLS entwickelten Protokolle erläutert. Die Familie umfasst die SSL-Versionen 2 und 3 sowie das TLS-Protokoll. SSLv2 wurde jetzt durch SSLv3 ersetzt, daher konzentrieren wir uns auf SSL v3 und TLS.

Kurze Geschichte von SSL

Im Jahr 1995 entwickelte Netscape SSLv2 und verwendete es in Netscape Navigator 1.1. Die SSL-Version1 wurde nie veröffentlicht und verwendet. Später verbesserte Microsoft SSLv2 und führte ein weiteres ähnliches Protokoll mit dem Namen Private Communications Technology (PCT) ein.

Netscape verbesserte SSLv2 in verschiedenen Sicherheitsproblemen erheblich und stellte 1999 SSLv3 bereit. Die Internet Engineering Task Force (IETF) führte anschließend ein ähnliches TLS-Protokoll (Transport Layer Security) als offenen Standard ein. Das TLS-Protokoll ist mit SSLv3 nicht interoperabel.

TLS hat die kryptografischen Algorithmen für die Schlüsselerweiterung und -authentifizierung geändert. Außerdem schlug TLS die Verwendung der offenen Krypto Diffie-Hellman (DH) und des Digital Signature Standard (DSS) anstelle der patentierten RSA-Krypto vor, die in SSL verwendet wird. Aufgrund des Ablaufs des RSA-Patents im Jahr 2000 gab es jedoch keine triftigen Gründe für Benutzer, von dem weit verbreiteten SSLv3 auf TLS umzusteigen.

Hauptmerkmale von SSL

Die wichtigsten Merkmale des SSL-Protokolls sind:

SSL bietet Netzwerkverbindungssicherheit durch -

Confidentiality - Informationen werden verschlüsselt ausgetauscht.

Authentication- Kommunikationseinheiten identifizieren sich durch die Verwendung digitaler Zertifikate. Die Webserverauthentifizierung ist obligatorisch, während die Clientauthentifizierung optional bleibt.

Reliability - Behält die Nachrichtenintegritätsprüfungen bei.

SSL ist für alle TCP-Anwendungen verfügbar.

Unterstützt von fast allen Webbrowsern.

Erleichtert die Geschäftsabwicklung mit neuen Online-Unternehmen.

Entwickelt hauptsächlich für den Web-E-Commerce.

Architektur von SSL

SSL ist TCP-spezifisch und funktioniert nicht mit UDP. SSL bietet Anwendungen eine Anwendungsprogrammierschnittstelle (Application Programming Interface, API). C- und Java-SSL-Bibliotheken / -Klassen sind leicht verfügbar.

Das SSL-Protokoll ist für die Zusammenarbeit zwischen Anwendung und Transportschicht ausgelegt, wie in der folgenden Abbildung dargestellt.

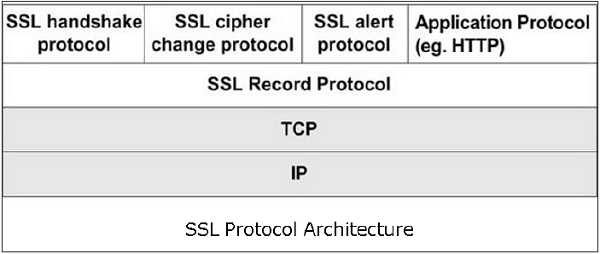

SSL selbst ist kein Single-Layer-Protokoll, wie im Bild dargestellt. Tatsächlich besteht es aus zwei Unterschichten.

Die untere Unterschicht besteht aus der einen Komponente des SSL-Protokolls, die als SSL-Aufzeichnungsprotokoll bezeichnet wird. Diese Komponente bietet Integritäts- und Vertraulichkeitsdienste.

Die obere Unterschicht besteht aus drei SSL-bezogenen Protokollkomponenten und einem Anwendungsprotokoll. Die Anwendungskomponente stellt den Informationsübertragungsdienst zwischen Client / Server-Interaktionen bereit. Technisch kann es auch auf der SSL-Schicht betrieben werden. Drei SSL-bezogene Protokollkomponenten sind -

- SSL-Handshake-Protokoll

- Ändern Sie das Cipher Spec-Protokoll

- Alarmprotokoll.

Diese drei Protokolle verwalten den gesamten SSL-Nachrichtenaustausch und werden später in diesem Abschnitt erläutert.

Funktionen von SSL-Protokollkomponenten

Die vier Unterkomponenten des SSL-Protokolls übernehmen verschiedene Aufgaben für die sichere Kommunikation zwischen dem Clientcomputer und dem Server.

Protokoll aufzeichnen

Die Datensatzschicht formatiert die Protokollnachrichten der oberen Schicht.

Es fragmentiert die Daten in verwaltbare Blöcke (maximale Länge 16 KB). Optional werden die Daten komprimiert.

Verschlüsselt die Daten.

Stellt einen Header für jede Nachricht und einen Hash (Message Authentication Code (MAC)) am Ende bereit.

Übergibt die formatierten Blöcke zur Übertragung an die TCP-Schicht.

SSL-Handshake-Protokoll

Es ist der komplexeste Teil von SSL. Es wird aufgerufen, bevor Anwendungsdaten übertragen werden. Es werden SSL-Sitzungen zwischen dem Client und dem Server erstellt.

Das Einrichten der Sitzung umfasst die Serverauthentifizierung, die Aushandlung von Schlüsseln und Algorithmen, das Einrichten von Schlüsseln und die Clientauthentifizierung (optional).

Eine Sitzung wird durch einen eindeutigen Satz kryptografischer Sicherheitsparameter identifiziert.

Mehrere sichere TCP-Verbindungen zwischen einem Client und einem Server können dieselbe Sitzung gemeinsam nutzen.

Handshake-Protokollaktionen in vier Phasen. Diese werden im nächsten Abschnitt erläutert.

ChangeCipherSpec-Protokoll

Einfachster Teil des SSL-Protokolls. Es besteht aus einer einzelnen Nachricht, die zwischen zwei kommunizierenden Einheiten, dem Client und dem Server, ausgetauscht wird.

Wenn jede Entität die ChangeCipherSpec-Nachricht sendet, wechselt sie wie vereinbart ihre Seite der Verbindung in den sicheren Zustand.

Der ausstehende Status der Verschlüsselungsparameter wird in den aktuellen Status kopiert.

Der Austausch dieser Nachricht zeigt an, dass alle zukünftigen Datenaustausche verschlüsselt und die Integrität geschützt sind.

SSL-Warnprotokoll

Dieses Protokoll wird verwendet, um Fehler zu melden, z. B. unerwartete Nachrichten, fehlerhafte MAC-Daten, fehlgeschlagene Aushandlung von Sicherheitsparametern usw.

Es wird auch für andere Zwecke verwendet - z. B. zum Benachrichtigen über das Schließen der TCP-Verbindung, zum Benachrichtigen über den Erhalt eines fehlerhaften oder unbekannten Zertifikats usw.

Einrichtung einer SSL-Sitzung

Wie oben erläutert, gibt es vier Phasen des SSL-Sitzungsaufbaus. Diese werden hauptsächlich vom SSL-Handshake-Protokoll verarbeitet.

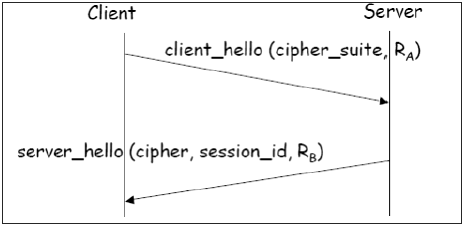

Phase 1 - Einrichtung von Sicherheitsfunktionen.

Diese Phase umfasst den Austausch von zwei Nachrichten - Client_hello und Server_hello .

Client_hello enthält eine Liste der vom Client unterstützten kryptografischen Algorithmen in absteigender Reihenfolge der Präferenzen.

Server_hello enthält die ausgewählte Cipher Specification (CipherSpec) und eine neue session_id .

Die CipherSpec enthält Felder wie -

Verschlüsselungsalgorithmus (DES, 3DES, RC2 und RC4)

MAC-Algorithmus (basierend auf MD5, SHA-1)

Public-Key-Algorithmus (RSA)

Beide Nachrichten haben "nonce", um einen Wiederholungsangriff zu verhindern.

Phase 2 - Serverauthentifizierung und Schlüsselaustausch.

Server sendet Zertifikat. Die Client-Software wird mit öffentlichen Schlüsseln verschiedener „vertrauenswürdiger“ Organisationen (CAs) konfiguriert, um das Zertifikat zu überprüfen.

Der Server sendet die ausgewählte Cipher Suite.

Der Server kann ein Client-Zertifikat anfordern. Normalerweise wird es nicht gemacht.

Server zeigt das Ende von Server_hello an .

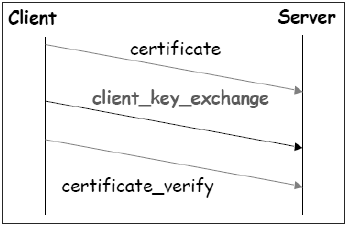

Phase 3 - Clientauthentifizierung und Schlüsselaustausch.

Der Client sendet ein Zertifikat nur auf Anforderung des Servers.

Außerdem wird das mit dem öffentlichen Schlüssel des Servers verschlüsselte Pre-Master Secret (PMS) gesendet.

Der Client sendet auch eine Certificate_verify- Nachricht, wenn er ein Zertifikat sendet , um zu beweisen, dass ihm der private Schlüssel mit diesem Zertifikat zugeordnet ist. Grundsätzlich signiert der Client einen Hash der vorherigen Nachrichten.

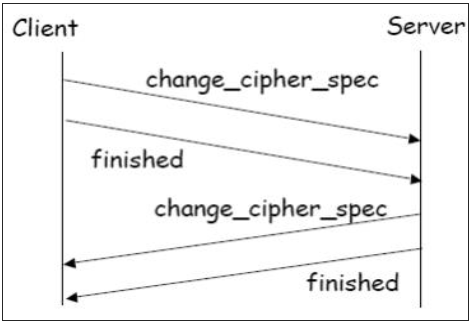

Phase 4 - Beenden.

Client und Server senden untereinander Change_cipher_spec- Nachrichten, damit der ausstehende Verschlüsselungsstatus in den aktuellen Status kopiert wird.

Von nun an sind alle Daten verschlüsselt und integer geschützt.

Die Nachricht "Fertig" von jedem Ende bestätigt, dass die Schlüsselaustausch- und Authentifizierungsprozesse erfolgreich waren.

Alle vier oben diskutierten Phasen finden im Rahmen der Einrichtung einer TCP-Sitzung statt. Der Aufbau der SSL-Sitzung beginnt nach TCP SYN / SYNACK und endet vor TCP Fin.

Fortsetzen einer getrennten Sitzung

Es ist möglich , eine getrennte Sitzung (bis zur Wiederaufnahme Alarm - Meldung), wenn der Client einen sendet hello_request an den Server mit den verschlüsselten Sitzungs_ID Informationen.

Der Server bestimmt dann, ob die Sitzungs-ID gültig ist. Nach der Validierung werden ChangeCipherSpec und fertige Nachrichten mit dem Client ausgetauscht und die sichere Kommunikation fortgesetzt .

Dies vermeidet eine Neuberechnung der Sitzungsverschlüsselungsparameter und spart Rechenleistung auf Server- und Client-Seite.

SSL-Sitzungsschlüssel

Wir haben gesehen, dass während der Phase 3 des SSL-Sitzungsaufbaus ein Pre-Master-Geheimnis vom Client an den Server gesendet wird, der mit dem öffentlichen Schlüssel des Servers verschlüsselt ist. Das Hauptgeheimnis und verschiedene Sitzungsschlüssel werden wie folgt generiert:

Das Hauptgeheimnis wird (über einen Pseudozufallszahlengenerator) mit - erzeugt

Das Pre-Master-Geheimnis.

Zwei Nonces (RA und RB) wurden in den Nachrichten client_hello und server_hello ausgetauscht.

Aus diesem Hauptgeheimnis werden dann sechs geheime Werte abgeleitet als -

Mit MAC verwendeter geheimer Schlüssel (für vom Server gesendete Daten)

Mit MAC verwendeter geheimer Schlüssel (für vom Client gesendete Daten)

Geheimschlüssel und IV für die Verschlüsselung (vom Server)

Geheimschlüssel und IV für die Verschlüsselung (vom Client)

TLS-Protokoll

Um einen offenen Internetstandard für SSL bereitzustellen, veröffentlichte die IETF im Januar 1999 das TLS-Protokoll (Transport Layer Security). TLS wird in RFC 5246 als vorgeschlagener Internetstandard definiert.

Hauptmerkmale

Das TLS-Protokoll hat dieselben Ziele wie SSL.

Es ermöglicht Client / Server-Anwendungen eine sichere Kommunikation durch Authentifizierung, verhindert das Abhören und widersteht der Änderung von Nachrichten.

Das TLS-Protokoll befindet sich über der zuverlässigen verbindungsorientierten Transport-TCP-Schicht im Netzwerkschichtstapel.

Die Architektur des TLS-Protokolls ähnelt dem SSLv3-Protokoll. Es gibt zwei Unterprotokolle: das TLS-Aufzeichnungsprotokoll und das TLS-Handshake-Protokoll.

Obwohl das SSLv3- und das TLS-Protokoll eine ähnliche Architektur aufweisen, wurden einige Änderungen an der Architektur und Funktion vorgenommen, insbesondere für das Handshake-Protokoll.

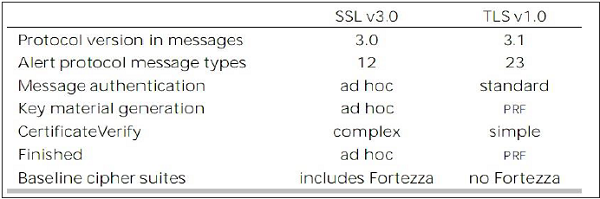

Vergleich von TLS- und SSL-Protokollen

Es gibt acht Hauptunterschiede zwischen TLS- und SSLv3-Protokollen. Diese sind wie folgt -

Protocol Version - Der Header des TLS-Protokollsegments trägt die Versionsnummer 3.1, um zwischen der Nummer 3 des SSL-Protokollsegment-Headers zu unterscheiden.

Message Authentication- TLS verwendet einen Keyed-Hash-Nachrichtenauthentifizierungscode (H-MAC). Der Vorteil ist, dass H-MAC mit jeder Hash-Funktion arbeitet, nicht nur mit MD5 oder SHA, wie im SSL-Protokoll ausdrücklich angegeben.

Session Key Generation - Es gibt zwei Unterschiede zwischen dem TLS- und dem SSL-Protokoll für die Generierung von Schlüsselmaterial.

Die Methode zur Berechnung von Pre-Master- und Master-Geheimnissen ist ähnlich. Im TLS-Protokoll verwendet die Berechnung des Hauptgeheimnisses jedoch die Ausgabe des HMAC-Standards und der Pseudozufallsfunktion (PRF) anstelle des Ad-hoc-MAC.

Der Algorithmus zum Berechnen von Sitzungsschlüsseln und Initiationswerten (IV) unterscheidet sich in TLS vom SSL-Protokoll.

Alarmprotokollnachricht -

Das TLS-Protokoll unterstützt alle vom Alert-Protokoll von SSL verwendeten Nachrichten, außer dass keine Zertifikat- Alert-Nachricht redundant gemacht wird. Der Client sendet ein leeres Zertifikat, falls keine Clientauthentifizierung erforderlich ist.

Das TLS-Protokoll enthält viele zusätzliche Warnmeldungen für andere Fehlerzustände wie record_overflow, decode_error usw.

Supported Cipher Suites- SSL unterstützt RSA-, Diffie-Hellman- und Fortezza-Chiffresuiten. Das TLS-Protokoll unterstützt alle Anzüge außer Fortezza.

Client Certificate Types- TLS definiert Zertifikatstypen, die in einer certificate_request- Nachricht angefordert werden sollen . SSLv3 unterstützt all dies. Darüber hinaus unterstützt SSL bestimmte andere Zertifikatstypen wie Fortezza.

CertificateVerify und fertige Nachrichten -

In SSL wird eine komplexe Nachrichtenprozedur für die certificate_verify- Nachricht verwendet. Bei TLS sind die verifizierten Informationen in den Handshake-Nachrichten selbst enthalten, wodurch diese komplexe Prozedur vermieden wird.

Die fertige Nachricht wird in TLS und SSLv3 auf unterschiedliche Weise berechnet.

Padding of Data- Im SSL-Protokoll ist die Auffüllung, die den Benutzerdaten vor der Verschlüsselung hinzugefügt wird, die Mindestmenge, die erforderlich ist, damit die Gesamtdatengröße einem Vielfachen der Blocklänge der Verschlüsselung entspricht. In TLS kann das Auffüllen eine beliebige Menge sein, die zu einer Datengröße führt, die ein Vielfaches der Blocklänge der Verschlüsselung beträgt, bis zu maximal 255 Byte.

Die obigen Unterschiede zwischen TLS- und SSLv3-Protokollen sind in der folgenden Tabelle zusammengefasst.

Sicheres Surfen - HTTPS

In diesem Abschnitt wird die Verwendung des SSL / TLS-Protokolls für die Durchführung eines sicheren Webbrowsings erläutert.

HTTPS definiert

Das HTTP-Protokoll (Hyper Text Transfer Protocol) wird zum Surfen im Internet verwendet. Die Funktion von HTTPS ähnelt HTTP. Der einzige Unterschied besteht darin, dass HTTPS "sicheres" Surfen im Internet bietet. HTTPS steht für HTTP over SSL. Dieses Protokoll wird verwendet, um die verschlüsselte und authentifizierte Verbindung zwischen dem Client-Webbrowser und dem Website-Server bereitzustellen.

Das sichere Durchsuchen von HTTPS stellt sicher, dass die folgenden Inhalte verschlüsselt sind:

- URL der angeforderten Webseite.

- Vom Server dem Benutzerclient bereitgestellte Webseiteninhalte.

- Inhalt der vom Benutzer ausgefüllten Formulare.

- Cookies in beide Richtungen erstellt.

Arbeiten von HTTPS

Das HTTPS-Anwendungsprotokoll verwendet normalerweise eines von zwei gängigen Sicherheitsprotokollen für die Transportschicht - SSL oder TLS. Der Prozess des sicheren Browsens wird in den folgenden Punkten beschrieben.

Sie fordern eine HTTPS-Verbindung zu einer Webseite an, indem Sie https: // gefolgt von einer URL in die Adressleiste des Browsers eingeben.

Der Webbrowser stellt eine Verbindung zum Webserver her. Die Verwendung von https ruft die Verwendung des SSL-Protokolls auf.

Eine Anwendung, in diesem Fall der Browser, verwendet den Systemport 443 anstelle von Port 80 (wird im Fall von http verwendet).

Das SSL-Protokoll durchläuft ein Handshake-Protokoll zum Einrichten einer sicheren Sitzung, wie in früheren Abschnitten erläutert.

Die Website sendet zunächst ihr SSL Digital-Zertifikat an Ihren Browser. Nach Überprüfung des Zertifikats tauscht der SSL-Handshake die gemeinsam genutzten Geheimnisse für die Sitzung aus.

Wenn der Server ein vertrauenswürdiges digitales SSL-Zertifikat verwendet, sehen Benutzer ein Vorhängeschlosssymbol in der Adressleiste des Browsers. Wenn ein erweitertes Validierungszertifikat auf einer Website installiert ist, wird die Adressleiste grün.

Einmal eingerichtet, besteht diese Sitzung aus vielen sicheren Verbindungen zwischen dem Webserver und dem Browser.

Verwendung von HTTPS

Die Verwendung von HTTPS bietet dem Benutzer Vertraulichkeit, Serverauthentifizierung und Nachrichtenintegrität. Es ermöglicht die sichere Durchführung von E-Commerce im Internet.

Verhindert das Abhören von Daten und verweigert Identitätsdiebstahl, bei dem es sich häufig um Angriffe auf HTTP handelt.

Heutige Webbrowser und Webserver sind mit HTTPS-Unterstützung ausgestattet. Die Verwendung von HTTPS über HTTP erfordert jedoch mehr Rechenleistung auf Client- und Serverseite, um die Verschlüsselung und den SSL-Handshake durchzuführen.

Secure Shell Protocol (SSH)

Die hervorstechenden Merkmale von SSH sind wie folgt:

SSH ist ein Netzwerkprotokoll, das auf der TCP / IP-Schicht ausgeführt wird. Es soll das TELNET ersetzen, das unsichere Mittel für die Remote-Anmeldung bietet.

SSH bietet eine sichere Client / Server-Kommunikation und kann für Aufgaben wie Dateiübertragung und E-Mail verwendet werden.

SSH2 ist ein weit verbreitetes Protokoll, das gegenüber der früheren Version von SSH1 eine verbesserte Sicherheit der Netzwerkkommunikation bietet.

SSH definiert

SSH ist in drei Unterprotokolle unterteilt.

Transport Layer Protocol- Dieser Teil des SSH-Protokolls bietet Datenvertraulichkeit, Server- (Host-) Authentifizierung und Datenintegrität. Optional kann auch eine Datenkomprimierung bereitgestellt werden.

Server Authentication- Hostschlüssel sind asymmetrisch wie öffentliche / private Schlüssel. Ein Server verwendet einen öffentlichen Schlüssel, um einem Client seine Identität zu beweisen. Der Client überprüft, ob der kontaktierte Server ein "bekannter" Host aus der von ihm verwalteten Datenbank ist. Sobald der Server authentifiziert ist, werden Sitzungsschlüssel generiert.

Session Key Establishment- Nach der Authentifizierung vereinbaren der Server und der Client die Verwendung der Verschlüsselung. Sitzungsschlüssel werden sowohl vom Client als auch vom Server generiert. Sitzungsschlüssel werden vor der Benutzerauthentifizierung generiert, damit Benutzernamen und Kennwörter verschlüsselt gesendet werden können. Diese Schlüssel werden in der Regel in regelmäßigen Abständen (z. B. jede Stunde) während der Sitzung ausgetauscht und sofort nach Gebrauch zerstört.

Data Integrity- SSH verwendet MAC-Algorithmen (Message Authentication Code) zur Überprüfung der Datenintegrität. Dies ist eine Verbesserung gegenüber der von SSH1 verwendeten 32-Bit-CRC.

User Authentication Protocol- Dieser Teil von SSH authentifiziert den Benutzer beim Server. Der Server überprüft, ob der Zugriff nur für beabsichtigte Benutzer gewährt wird. Derzeit werden viele Authentifizierungsmethoden verwendet, z. B. eingegebene Kennwörter, Kerberos, Authentifizierung mit öffentlichem Schlüssel usw.

Connection Protocol - Dies bietet mehrere logische Kanäle über eine einzige zugrunde liegende SSH-Verbindung.

SSH-Dienste

SSH bietet drei Hauptdienste, die die Bereitstellung vieler sicherer Lösungen ermöglichen. Diese Dienste werden kurz wie folgt beschrieben:

Secure Command-Shell (Remote Logon)- Der Benutzer kann Dateien bearbeiten, den Inhalt von Verzeichnissen anzeigen und auf Anwendungen auf dem angeschlossenen Gerät zugreifen. Systemadministratoren können Dienste und Prozesse remote starten / anzeigen / stoppen, Benutzerkonten erstellen und Datei- / Verzeichnisberechtigungen ändern usw. Alle Aufgaben, die an der Eingabeaufforderung eines Computers ausgeführt werden können, können jetzt mithilfe der sicheren Remote-Anmeldung sicher vom Remote-Computer aus ausgeführt werden.

Secure File Transfer- Das SSH File Transfer Protocol (SFTP) ist als Erweiterung für SSH-2 für die sichere Dateiübertragung konzipiert. Im Wesentlichen handelt es sich um ein separates Protokoll, das über das Secure Shell-Protokoll gelegt wird, um Dateiübertragungen durchzuführen. SFTP verschlüsselt sowohl den Benutzernamen / das Passwort als auch die übertragenen Dateidaten. Es verwendet denselben Port wie der Secure Shell-Server, dh den Systemport Nr. 22.

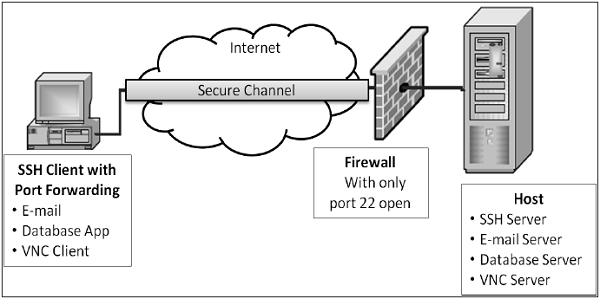

Port Forwarding (Tunneling)- Damit können Daten von ungesicherten TCP / IP-basierten Anwendungen gesichert werden. Nachdem die Portweiterleitung eingerichtet wurde, leitet Secure Shell den Datenverkehr von einem Programm (normalerweise einem Client) um und sendet ihn über den verschlüsselten Tunnel an das Programm auf der anderen Seite (normalerweise einen Server). Mehrere Anwendungen können Daten über einen einzigen gemultiplexten sicheren Kanal übertragen, sodass nicht mehr viele Ports an einer Firewall oder einem Router geöffnet werden müssen.

Vorteile und Einschränkungen

Die Vorteile und Einschränkungen des Einsatzes von Kommunikationssicherheit auf Transportebene sind folgende:

Leistungen

Die Sicherheit der Transportschicht ist für Anwendungen transparent.

Server ist authentifiziert.

Header der Anwendungsschicht sind ausgeblendet.

Es ist feinkörniger als Sicherheitsmechanismen auf Schicht 3 (IPsec), da es auf der Ebene der Transportverbindung funktioniert.

Einschränkungen

Gilt nur für TCP-basierte Anwendungen (nicht für UDP).

TCP / IP-Header sind klar.

Geeignet für die direkte Kommunikation zwischen Client und Server. Gilt nicht für sichere Anwendungen mit Serverkette (z. B. E-Mail)

SSL bietet keine Ablehnung, da die Clientauthentifizierung optional ist.

Bei Bedarf muss die Clientauthentifizierung über SSL implementiert werden.

Zusammenfassung

In den letzten zehn Jahren ist eine große Anzahl von Webanwendungen im Internet aufgetaucht. Viele E-Governance- und E-Commerce-Portale sind online gegangen. Diese Anwendungen erfordern, dass die Sitzung zwischen dem Server und dem Client sicher ist und Vertraulichkeit, Authentifizierung und Integrität der Sitzungen gewährleistet.

Eine Möglichkeit, einen potenziellen Angriff während der Sitzung eines Benutzers abzuschwächen, besteht in der Verwendung eines sicheren Kommunikationsprotokolls. Zwei dieser Kommunikationsprotokolle, Secure Sockets Layer (SSL) und Transport Layer Security (TLS), werden in diesem Kapitel behandelt. Beide Protokolle funktionieren auf der Transportschicht.

Ein weiteres Transportschichtprotokoll, Secure Shell (SSH), das TELNET ersetzen soll, bietet sichere Mittel für die Remote-Anmeldung. Es kann verschiedene Dienste wie Secure Command Shell und SFTP bereitstellen.

Der Einsatz von Sicherheit auf Transportschicht hat viele Vorteile. Das auf dieser Ebene entwickelte Sicherheitsprotokoll kann jedoch nur mit TCP verwendet werden. Sie bieten keine Sicherheit für die über UDP implementierte Kommunikation.

Sicherheitskontrollen auf Netzwerkebene wurden häufig zur Sicherung der Kommunikation verwendet, insbesondere über gemeinsam genutzte Netzwerke wie das Internet, da sie viele Anwendungen gleichzeitig schützen können, ohne sie zu ändern.

In den früheren Kapiteln haben wir erläutert, dass viele Echtzeit-Sicherheitsprotokolle für die Netzwerksicherheit entwickelt wurden, um grundlegende Sicherheitsgrundsätze wie Datenschutz, Ursprungsauthentifizierung, Nachrichtenintegrität und Nicht-Zurückweisung zu gewährleisten.

Die meisten dieser Protokolle konzentrierten sich weiterhin auf die höheren Schichten des OSI-Protokollstapels, um den inhärenten Sicherheitsmangel im Standard-Internetprotokoll auszugleichen. Obwohl diese Methoden wertvoll sind, können sie für keine Anwendung einfach verallgemeinert werden. Beispielsweise wurde SSL speziell zum Sichern von Anwendungen wie HTTP oder FTP entwickelt. Es gibt jedoch mehrere andere Anwendungen, die ebenfalls eine sichere Kommunikation benötigen.

Dieser Bedarf führte zur Entwicklung einer Sicherheitslösung auf der IP-Ebene, damit alle Protokolle der höheren Ebene davon profitieren können. 1992 begann die Internet Engineering Task Force (IETF) mit der Definition eines Standard-IPSec.

In diesem Kapitel werden wir diskutieren, wie Sicherheit auf Netzwerkebene mit diesem sehr beliebten Satz von Protokoll-IPSec erreicht wird.

Sicherheit in der Netzwerkschicht

Jedes Schema, das zur Bereitstellung von Netzwerksicherheit entwickelt wurde, muss auf einer bestimmten Ebene im Protokollstapel implementiert werden, wie in der folgenden Abbildung dargestellt.

| Schicht | Kommunikationsprotokolle | Sicherheitsprotokolle |

|---|---|---|

| Anwendungsschicht | HTTP FTP SMTP | PGP. S / MIME, HTTPS |

| Transportschicht | TCP / UDP | SSL, TLS, SSH |

| Netzwerkschicht | IP | IPsec |

Das beliebte Framework zur Gewährleistung der Sicherheit auf Netzwerkebene ist Internet Protocol Security (IPsec).

Funktionen von IPsec

IPsec funktioniert nicht nur mit TCP als Transportprotokoll. Es funktioniert mit UDP sowie jedem anderen Protokoll über IP wie ICMP, OSPF usw.

IPsec schützt das gesamte Paket, das der IP-Schicht präsentiert wird, einschließlich der Header höherer Schichten.

Da Header höherer Ebenen ausgeblendet sind, die die Portnummer tragen, ist die Verkehrsanalyse schwieriger.

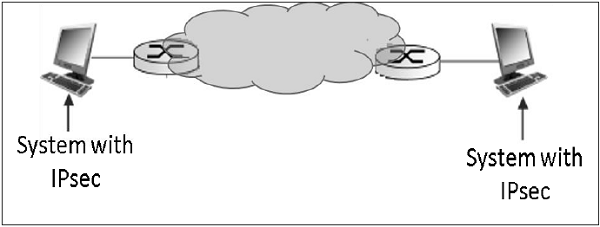

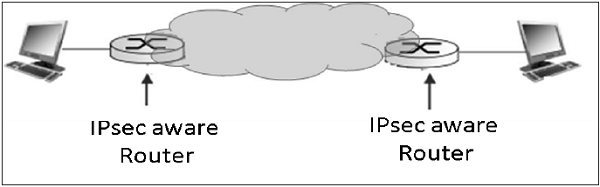

IPsec arbeitet von einer Netzwerkeinheit zu einer anderen Netzwerkeinheit, nicht von Anwendungsprozess zu Anwendungsprozess. Daher kann die Sicherheit übernommen werden, ohne dass Änderungen an einzelnen Benutzercomputern / -anwendungen erforderlich sind.

IPsec wird häufig für die sichere Kommunikation zwischen Netzwerkeinheiten verwendet und bietet auch Host-zu-Host-Sicherheit.

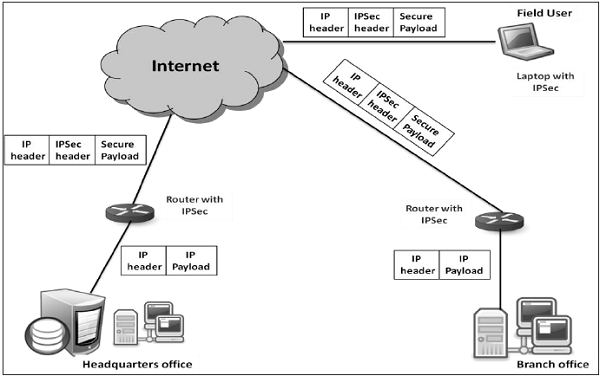

Die häufigste Verwendung von IPSec ist die Bereitstellung eines virtuellen privaten Netzwerks (VPN), entweder zwischen zwei Standorten (Gateway-zu-Gateway) oder zwischen einem Remotebenutzer und einem Unternehmensnetzwerk (Host-zu-Gateway).

Sicherheitsfunktionen

Die wichtigen Sicherheitsfunktionen des IPSec lauten wie folgt:

Vertraulichkeit

Ermöglicht kommunizierenden Knoten, Nachrichten zu verschlüsseln.

Verhindert das Abhören durch Dritte.

Ursprungsauthentifizierung und Datenintegrität.

Bietet die Gewissheit, dass ein empfangenes Paket tatsächlich von der Partei gesendet wurde, die als Quelle im Paket-Header identifiziert wurde.

Bestätigt, dass das Paket nicht geändert wurde oder auf andere Weise.

Schlüsselverwaltung.

Ermöglicht den sicheren Austausch von Schlüsseln.

Schutz vor bestimmten Arten von Sicherheitsangriffen, z. B. Wiederholungsangriffen.

Virtuelles privates Netzwerk

Im Idealfall möchte jede Institution ein eigenes privates Netzwerk für die Kommunikation, um die Sicherheit zu gewährleisten. Es kann jedoch sehr kostspielig sein, ein solches privates Netzwerk über ein geografisch verteiltes Gebiet aufzubauen und aufrechtzuerhalten. Es würde die Verwaltung einer komplexen Infrastruktur von Kommunikationsverbindungen, Routern, DNS usw. erfordern.

IPsec bietet einen einfachen Mechanismus für die Implementierung von Virtual Private Network (VPN) für solche Institutionen. Mit der VPN-Technologie kann der Inter-Office-Verkehr einer Institution über das öffentliche Internet gesendet werden, indem der Verkehr verschlüsselt wird, bevor er in das öffentliche Internet gelangt und logisch von anderem Verkehr getrennt wird. Die vereinfachte Arbeitsweise von VPN ist in der folgenden Abbildung dargestellt:

Übersicht über IPSec

IPsec ist ein Framework / eine Suite von Protokollen zur Bereitstellung von Sicherheit auf der IP-Ebene.

Ursprung

Anfang der neunziger Jahre wurde das Internet von wenigen Institutionen hauptsächlich für akademische Zwecke genutzt. In späteren Jahrzehnten wurde das Wachstum des Internets jedoch exponentiell, da das Netzwerk erweitert wurde und mehrere Organisationen es für Kommunikations- und andere Zwecke nutzten.

Angesichts des massiven Wachstums des Internets in Verbindung mit den inhärenten Sicherheitslücken des TCP / IP-Protokolls wurde die Notwendigkeit einer Technologie festgestellt, die Netzwerksicherheit im Internet bietet. Ein Bericht mit dem Titel "Sicherheit in der Internetarchitektur" wurde 1994 vom Internet Architecture Board (IAB) veröffentlicht. Er identifizierte die Schlüsselbereiche für Sicherheitsmechanismen.

Das IAB enthielt Authentifizierung und Verschlüsselung als wesentliche Sicherheitsmerkmale in IPv6, der IP der nächsten Generation. Glücklicherweise wurden diese Sicherheitsfunktionen so definiert, dass sie sowohl mit dem aktuellen IPv4 als auch mit dem futuristischen IPv6 implementiert werden können.

Das Sicherheits-Framework IPSec wurde in mehreren "Requests for Comments" (RFCs) definiert. Einige RFCs spezifizieren einige Teile des Protokolls, während andere die Lösung als Ganzes behandeln.

Operationen innerhalb von IPsec

Es kann davon ausgegangen werden, dass die IPSec-Suite zwei separate Vorgänge aufweist, wenn sie gleichzeitig ausgeführt werden und einen vollständigen Satz von Sicherheitsdiensten bereitstellen. Diese beiden Vorgänge sind IPSec-Kommunikation und Internet Key Exchange.

IPSec-Kommunikation

Es ist normalerweise mit der Standard-IPSec-Funktionalität verbunden. Es umfasst die Kapselung, Verschlüsselung und das Hashing der IP-Datagramme sowie die Verarbeitung aller Paketprozesse.

Es ist verantwortlich für die Verwaltung der Kommunikation gemäß den verfügbaren Sicherheitsassoziationen (Security Associations, SAs), die zwischen kommunizierenden Parteien eingerichtet wurden.

Es verwendet Sicherheitsprotokolle wie Authentication Header (AH) und Encapsulated SP (ESP).

Die IPSec-Kommunikation ist nicht an der Erstellung von Schlüsseln oder deren Verwaltung beteiligt.

Der IPSec-Kommunikationsvorgang selbst wird üblicherweise als IPSec bezeichnet.

Internet Key Exchange (IKE)

IKE ist das automatische Schlüsselverwaltungsprotokoll für IPSec.

Technisch gesehen ist die Schlüsselverwaltung für die IPSec-Kommunikation nicht unbedingt erforderlich, und die Schlüssel können manuell verwaltet werden. Eine manuelle Schlüsselverwaltung ist jedoch für große Netzwerke nicht wünschenswert.

IKE ist für die Erstellung von Schlüsseln für IPSec und die Bereitstellung der Authentifizierung während des Schlüsselerstellungsprozesses verantwortlich. Obwohl IPSec für alle anderen Schlüsselverwaltungsprotokolle verwendet werden kann, wird standardmäßig IKE verwendet.

IKE definiert zwei Protokolle (Oakley und SKEME), die mit dem bereits definierten Schlüsselverwaltungsframework ISAKMP (Internet Security Association Key Management Protocol) verwendet werden sollen.

ISAKMP ist nicht IPsec-spezifisch, bietet jedoch den Rahmen für die Erstellung von SAs für jedes Protokoll.

In diesem Kapitel werden hauptsächlich die IPSec-Kommunikation und das zugehörige Protokoll erläutert, mit denen die Sicherheit erreicht wird.

IPSec-Kommunikationsmodi

Die IPSec-Kommunikation verfügt über zwei Funktionsmodi. Transport- und Tunnelmodi. Diese Modi können je nach gewünschter Kommunikationsart in Kombination oder einzeln verwendet werden.

Transportmodus

IPsec kapselt kein von der oberen Schicht empfangenes Paket.

Der ursprüngliche IP-Header wird beibehalten und die Daten werden basierend auf den ursprünglichen Attributen weitergeleitet, die vom Protokoll der oberen Schicht festgelegt wurden.

Das folgende Diagramm zeigt den Datenfluss im Protokollstapel.

Die Einschränkung des Transportmodus besteht darin, dass keine Gateway-Dienste bereitgestellt werden können. Es ist für die Punkt-zu-Punkt-Kommunikation reserviert, wie in der folgenden Abbildung dargestellt.

Tunnelmodus

Dieser IPSec-Modus bietet Kapselungsdienste zusammen mit anderen Sicherheitsdiensten.

Im Tunnelmodus wird das gesamte Paket aus der oberen Schicht eingekapselt, bevor das Sicherheitsprotokoll angewendet wird. Neuer IP-Header wird hinzugefügt.

Das folgende Diagramm zeigt den Datenfluss im Protokollstapel.

Der Tunnelmodus ist normalerweise mit Gateway-Aktivitäten verbunden. Die Kapselung bietet die Möglichkeit, mehrere Sitzungen über ein einziges Gateway zu senden.

Die typische Tunnelmoduskommunikation ist in der folgenden Abbildung dargestellt.

Die Endpunkte verfügen über eine direkte Transportschichtverbindung. Das Datagramm von einem an das Gateway weitergeleiteten System wird gekapselt und dann an das Remote-Gateway weitergeleitet. Das zugeordnete Remote-Gateway entkapselt die Daten und leitet sie an den Zielendpunkt im internen Netzwerk weiter.

Mit IPsec kann der Tunnelmodus auch zwischen dem Gateway und dem einzelnen Endsystem eingerichtet werden.

IPSec-Protokolle

IPsec verwendet die Sicherheitsprotokolle, um die gewünschten Sicherheitsdienste bereitzustellen. Diese Protokolle sind das Herzstück von IPSec-Vorgängen, und alles andere unterstützt dieses Protokoll in IPSec.

Sicherheitszuordnungen zwischen den kommunizierenden Einheiten werden durch das verwendete Sicherheitsprotokoll hergestellt und verwaltet.

Es gibt zwei Sicherheitsprotokolle, die von IPsec definiert werden - Authentication Header (AH) und Encapsulating Security Payload (ESP).

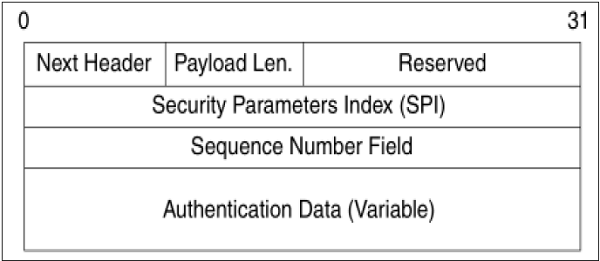

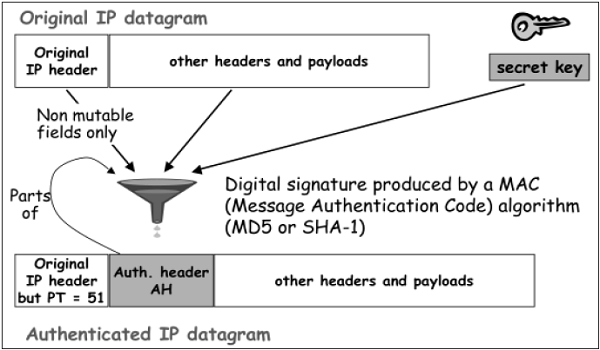

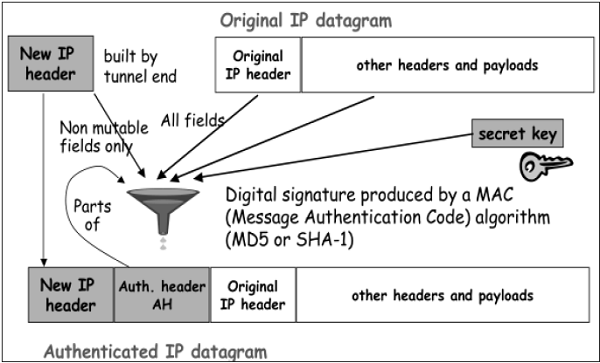

Authentifizierungsheader

Das AH-Protokoll bietet einen Dienst für Datenintegrität und Ursprungsauthentifizierung. Optional wird der Widerstand bei der Nachrichtenwiedergabe berücksichtigt. Es bietet jedoch keine Form der Vertraulichkeit.

AH ist ein Protokoll, das die Authentifizierung des gesamten oder eines Teils des Inhalts eines Datagramms durch Hinzufügen eines Headers ermöglicht. Der Header wird basierend auf den Werten im Datagramm berechnet. Welche Teile des Datagramms für die Berechnung verwendet werden und wo der Header platziert werden soll, hängt von der Moduskooperation (Tunnel oder Transport) ab.

Die Bedienung des AH-Protokolls ist überraschend einfach. Es kann als ähnlich wie die Algorithmen angesehen werden, die zur Berechnung von Prüfsummen oder zur Durchführung von CRC-Prüfungen zur Fehlererkennung verwendet werden.

Das Konzept hinter AH ist das gleiche, außer dass AH anstelle eines einfachen Algorithmus einen speziellen Hashing-Algorithmus und einen geheimen Schlüssel verwendet, der nur den kommunizierenden Parteien bekannt ist. Es wird eine Sicherheitszuordnung zwischen zwei Geräten eingerichtet, die diese Angaben angibt.

Der Prozess der AH durchläuft die folgenden Phasen.

Wenn ein IP-Paket vom oberen Protokollstapel empfangen wird, ermittelt IPsec die zugehörige Sicherheitszuordnung (SA) anhand der verfügbaren Informationen im Paket. Zum Beispiel IP-Adresse (Quelle und Ziel).

Sobald von SA festgestellt wird, dass das Sicherheitsprotokoll AH ist, werden die Parameter des AH-Headers berechnet. Der AH-Header besteht aus folgenden Parametern:

Das Header-Feld gibt das Protokoll des Pakets an, das dem AH-Header folgt. Der Sequenzparameterindex (SPI) wird von der SA erhalten, die zwischen kommunizierenden Parteien besteht.

Die Sequenznummer wird berechnet und eingefügt. Diese Nummern bieten AH die optionale Möglichkeit, einem Wiederholungsangriff zu widerstehen.

Authentifizierungsdaten werden je nach Kommunikationsmodus unterschiedlich berechnet.

Im Transportmodus ist die Berechnung der Authentifizierungsdaten und das Zusammenstellen des endgültigen IP-Pakets für die Übertragung in der folgenden Abbildung dargestellt. Im ursprünglichen IP-Header wird nur die Protokollnummer 51 für die angegebene Anwendung von AH geändert.

Im Tunnelmodus findet der obige Vorgang wie in der folgenden Abbildung dargestellt statt.

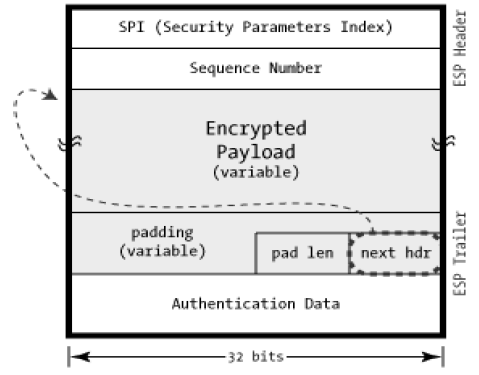

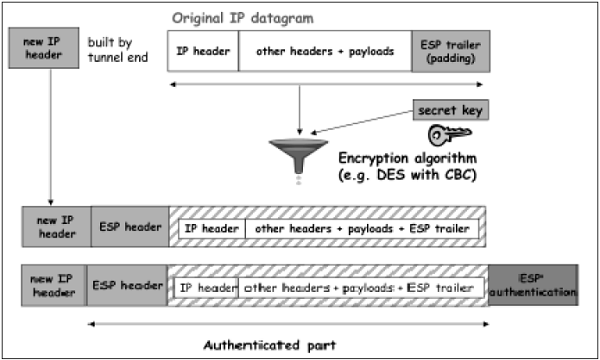

Encapsulation Security Protocol (ESP)

ESP bietet Sicherheitsdienste wie Vertraulichkeit, Integrität, Ursprungsauthentifizierung und optionalen Wiedergabewiderstand. Die Anzahl der angebotenen Dienste hängt von den Optionen ab, die zum Zeitpunkt der Gründung der Security Association (SA) ausgewählt wurden.

In ESP werden Algorithmen zum Verschlüsseln und Generieren von Authentifikatoren durch die Attribute bestimmt, die zum Erstellen der SA verwendet werden.

Der Prozess von ESP ist wie folgt. Die ersten beiden Schritte ähneln dem oben angegebenen AH-Prozess.

Sobald festgestellt wurde, dass ESP beteiligt ist, werden die Felder des ESP-Pakets berechnet. Die ESP-Feldanordnung ist in der folgenden Abbildung dargestellt.

Der Verschlüsselungs- und Authentifizierungsprozess im Transportmodus ist in der folgenden Abbildung dargestellt.

Im Tunnelmodus ist der Verschlüsselungs- und Authentifizierungsprozess wie in der folgenden Abbildung dargestellt.

Obwohl Authentifizierung und Vertraulichkeit die Hauptdienste von ESP sind, sind beide optional. Technisch können wir die NULL-Verschlüsselung ohne Authentifizierung verwenden. In der Praxis muss jedoch eine der beiden implementiert werden, um ESP effektiv nutzen zu können.

Das Grundkonzept besteht darin, ESP zu verwenden, wenn Authentifizierung und Verschlüsselung gewünscht werden, und AH zu verwenden, wenn eine erweiterte Authentifizierung ohne Verschlüsselung gewünscht wird.

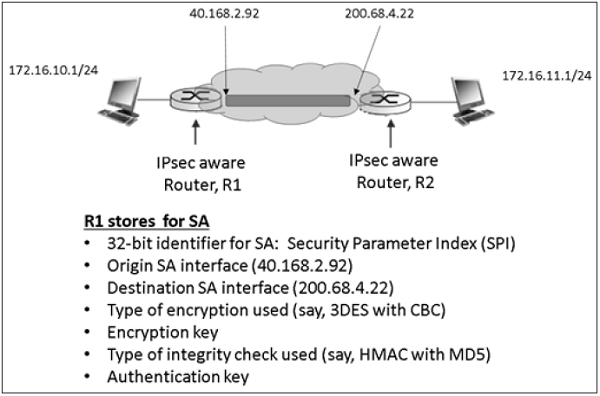

Sicherheitszuordnungen in IPSec

Die Security Association (SA) ist die Grundlage einer IPSec-Kommunikation. Die Merkmale von SA sind -

Vor dem Senden von Daten wird eine virtuelle Verbindung zwischen der sendenden Entität und der empfangenden Entität hergestellt, die als "Security Association (SA)" bezeichnet wird.