Elasticsearch - Guide rapide

Elasticsearch est un serveur de recherche basé sur Apache Lucene. Il a été développé par Shay Banon et publié en 2010. Il est maintenant maintenu par Elasticsearch BV. Sa dernière version est la 7.0.0.

Elasticsearch est un moteur de recherche et d'analyse en texte intégral distribué et open source en temps réel. Il est accessible à partir de l'interface de service Web RESTful et utilise des documents JSON (JavaScript Object Notation) sans schéma pour stocker les données. Il est construit sur le langage de programmation Java et par conséquent Elasticsearch peut fonctionner sur différentes plates-formes. Il permet aux utilisateurs d'explorer de très grandes quantités de données à très haute vitesse.

Caractéristiques générales

Les caractéristiques générales d'Elasticsearch sont les suivantes -

Elasticsearch est évolutif jusqu'à pétaoctets de données structurées et non structurées.

Elasticsearch peut être utilisé en remplacement des magasins de documents tels que MongoDB et RavenDB.

Elasticsearch utilise la dénormalisation pour améliorer les performances de recherche.

Elasticsearch est l'un des moteurs de recherche d'entreprise les plus populaires et est actuellement utilisé par de nombreuses grandes organisations telles que Wikipedia, The Guardian, StackOverflow, GitHub, etc.

Elasticsearch est une open source et disponible sous la licence Apache version 2.0.

Concepts clés

Les concepts clés d'Elasticsearch sont les suivants -

Nœud

Il fait référence à une seule instance en cours d'exécution d'Elasticsearch. Un seul serveur physique et virtuel accueille plusieurs nœuds en fonction des capacités de leurs ressources physiques telles que la RAM, le stockage et la puissance de traitement.

Grappe

C'est une collection d'un ou plusieurs nœuds. Cluster fournit des capacités d'indexation et de recherche collectives sur tous les nœuds pour des données entières.

Indice

C'est une collection de différents types de documents et de leurs propriétés. Index utilise également le concept de fragments pour améliorer les performances. Par exemple, un ensemble de documents contient des données d'une application de réseautage social.

Document

C'est une collection de champs d'une manière spécifique définie au format JSON. Chaque document appartient à un type et réside dans un index. Chaque document est associé à un identifiant unique appelé UID.

Tesson

Les index sont subdivisés horizontalement en fragments. Cela signifie que chaque partition contient toutes les propriétés du document mais contient moins d'objets JSON que l'index. La séparation horizontale fait du shard un nœud indépendant, qui peut être stocké dans n'importe quel nœud. La partition principale est la partie horizontale d'origine d'un index, puis ces partitions principales sont répliquées en fragments de réplique.

Répliques

Elasticsearch permet à un utilisateur de créer des répliques de leurs index et fragments. La réplication permet non seulement d'augmenter la disponibilité des données en cas d'échec, mais améliore également les performances de recherche en effectuant une opération de recherche parallèle dans ces répliques.

Avantages

Elasticsearch est développé sur Java, ce qui le rend compatible sur presque toutes les plates-formes.

Elasticsearch est en temps réel, c'est-à-dire qu'au bout d'une seconde, le document ajouté est consultable dans ce moteur

Elasticsearch est distribué, ce qui facilite sa mise à l'échelle et son intégration dans toute grande organisation.

La création de sauvegardes complètes est facile en utilisant le concept de passerelle, présent dans Elasticsearch.

La gestion de la multi-location est très simple dans Elasticsearch par rapport à Apache Solr.

Elasticsearch utilise des objets JSON comme réponses, ce qui permet d'appeler le serveur Elasticsearch avec un grand nombre de langages de programmation différents.

Elasticsearch prend en charge presque tous les types de documents, sauf ceux qui ne prennent pas en charge le rendu de texte.

Désavantages

Elasticsearch n'a pas de support multilingue en termes de traitement des données de demande et de réponse (uniquement possible en JSON) contrairement à Apache Solr, où cela est possible aux formats CSV, XML et JSON.

Parfois, Elasticsearch a un problème de situations de fractionnement du cerveau.

Comparaison entre Elasticsearch et RDBMS

Dans Elasticsearch, l'index est similaire aux tables du SGBDR (Relation Database Management System). Chaque table est une collection de lignes, tout comme chaque index est une collection de documents dans Elasticsearch.

Le tableau suivant donne une comparaison directe entre ces termes -

| Elasticsearch | SGBDR |

|---|---|

| Grappe | Base de données |

| Tesson | Tesson |

| Indice | Table |

| Champ | Colonne |

| Document | Rangée |

Dans ce chapitre, nous comprendrons en détail la procédure d'installation d'Elasticsearch.

Pour installer Elasticsearch sur votre ordinateur local, vous devrez suivre les étapes ci-dessous -

Step 1- Vérifiez la version de java installée sur votre ordinateur. Il doit être java 7 ou supérieur. Vous pouvez vérifier en procédant comme suit -

Dans le système d'exploitation Windows (OS) (à l'aide de l'invite de commande) -

> java -versionSous UNIX OS (à l'aide du terminal) -

$ echo $JAVA_HOMEStep 2 - En fonction de votre système d'exploitation, téléchargez Elasticsearch depuis www.elastic.co comme indiqué ci-dessous -

Pour Windows OS, téléchargez le fichier ZIP.

Pour UNIX OS, téléchargez le fichier TAR.

Pour le système d'exploitation Debian, téléchargez le fichier DEB.

Pour Red Hat et les autres distributions Linux, téléchargez le fichier RPN.

Les utilitaires APT et Yum peuvent également être utilisés pour installer Elasticsearch dans de nombreuses distributions Linux.

Step 3 - Le processus d'installation d'Elasticsearch est simple et est décrit ci-dessous pour différents systèmes d'exploitation -

Windows OS- Décompressez le package zip et Elasticsearch est installé.

UNIX OS- Extrayez le fichier tar dans n'importe quel emplacement et Elasticsearch est installé.

$wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch7.0.0-linux-x86_64.tar.gz $tar -xzf elasticsearch-7.0.0-linux-x86_64.tar.gzUsing APT utility for Linux OS- Téléchargez et installez la clé de signature publique

$ wget -qo - https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo

apt-key add -Enregistrez la définition du référentiel comme indiqué ci-dessous -

$ echo "deb https://artifacts.elastic.co/packages/7.x/apt stable main" |

sudo tee -a /etc/apt/sources.list.d/elastic-7.x.listExécutez la mise à jour à l'aide de la commande suivante -

$ sudo apt-get updateVous pouvez maintenant installer en utilisant la commande suivante -

$ sudo apt-get install elasticsearchDownload and install the Debian package manually using the command given here −

$wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch7.0.0-amd64.deb $sudo dpkg -i elasticsearch-7.0.0-amd64.deb0Using YUM utility for Debian Linux OS

Téléchargez et installez la clé de signature publique -

$ rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearchAJOUTEZ le texte suivant dans le fichier avec le suffixe .repo dans votre répertoire «/etc/yum.repos.d/». Par exemple, elasticsearch.repo

elasticsearch-7.x]

name=Elasticsearch repository for 7.x packages

baseurl=https://artifacts.elastic.co/packages/7.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-mdVous pouvez maintenant installer Elasticsearch en utilisant la commande suivante

sudo yum install elasticsearchStep 4- Allez dans le répertoire de base d'Elasticsearch et dans le dossier bin. Exécutez le fichier elasticsearch.bat dans le cas de Windows ou vous pouvez faire la même chose en utilisant l'invite de commande et via le terminal dans le cas du fichier UNIX rum Elasticsearch.

Sous Windows

> cd elasticsearch-2.1.0/bin

> elasticsearchSous Linux

$ cd elasticsearch-2.1.0/bin

$ ./elasticsearchNote - Dans le cas de Windows, vous pourriez obtenir une erreur indiquant que JAVA_HOME n'est pas défini, veuillez le définir dans les variables d'environnement sur «C: \ Program Files \ Java \ jre1.8.0_31» ou l'emplacement où vous avez installé java.

Step 5- Le port par défaut de l'interface Web d'Elasticsearch est 9200 ou vous pouvez le modifier en modifiant http.port dans le fichier elasticsearch.yml présent dans le répertoire bin. Vous pouvez vérifier si le serveur est opérationnel en parcouranthttp://localhost:9200. Il renverra un objet JSON, qui contient les informations sur Elasticsearch installé de la manière suivante -

{

"name" : "Brain-Child",

"cluster_name" : "elasticsearch", "version" : {

"number" : "2.1.0",

"build_hash" : "72cd1f1a3eee09505e036106146dc1949dc5dc87",

"build_timestamp" : "2015-11-18T22:40:03Z",

"build_snapshot" : false,

"lucene_version" : "5.3.1"

},

"tagline" : "You Know, for Search"

}Step 6- Dans cette étape, installons Kibana. Suivez le code respectif ci-dessous pour l'installation sur Linux et Windows -

For Installation on Linux −

wget https://artifacts.elastic.co/downloads/kibana/kibana-7.0.0-linuxx86_64.tar.gz

tar -xzf kibana-7.0.0-linux-x86_64.tar.gz

cd kibana-7.0.0-linux-x86_64/

./bin/kibanaFor Installation on Windows −

Téléchargez Kibana pour Windows à partir de https://www.elastic.co/products/kibana. Une fois que vous cliquez sur le lien, vous trouverez la page d'accueil comme indiqué ci-dessous -

Décompressez et accédez au répertoire de base de Kibana, puis exécutez-le.

CD c:\kibana-7.0.0-windows-x86_64

.\bin\kibana.batDans ce chapitre, apprenons comment ajouter des index, des mappages et des données à Elasticsearch. Notez que certaines de ces données seront utilisées dans les exemples expliqués dans ce didacticiel.

Créer un index

Vous pouvez utiliser la commande suivante pour créer un index -

PUT schoolRéponse

Si l'index est créé, vous pouvez voir la sortie suivante -

{"acknowledged": true}Ajouter des données

Elasticsearch stockera les documents que nous ajoutons à l'index comme indiqué dans le code suivant. Les documents reçoivent des identifiants utilisés pour identifier le document.

Demander le corps

POST school/_doc/10

{

"name":"Saint Paul School", "description":"ICSE Afiliation",

"street":"Dawarka", "city":"Delhi", "state":"Delhi", "zip":"110075",

"location":[28.5733056, 77.0122136], "fees":5000,

"tags":["Good Faculty", "Great Sports"], "rating":"4.5"

}Réponse

{

"_index" : "school",

"_type" : "_doc",

"_id" : "10",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 2,

"_primary_term" : 1

}Ici, nous ajoutons un autre document similaire.

POST school/_doc/16

{

"name":"Crescent School", "description":"State Board Affiliation",

"street":"Tonk Road",

"city":"Jaipur", "state":"RJ", "zip":"176114","location":[26.8535922,75.7923988],

"fees":2500, "tags":["Well equipped labs"], "rating":"4.5"

}Réponse

{

"_index" : "school",

"_type" : "_doc",

"_id" : "16",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 9,

"_primary_term" : 7

}De cette façon, nous continuerons à ajouter tous les exemples de données dont nous avons besoin pour notre travail dans les prochains chapitres.

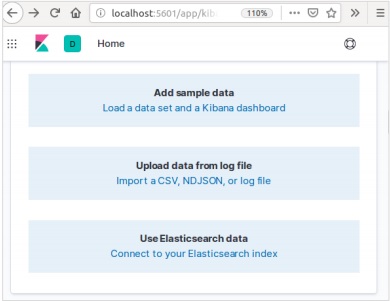

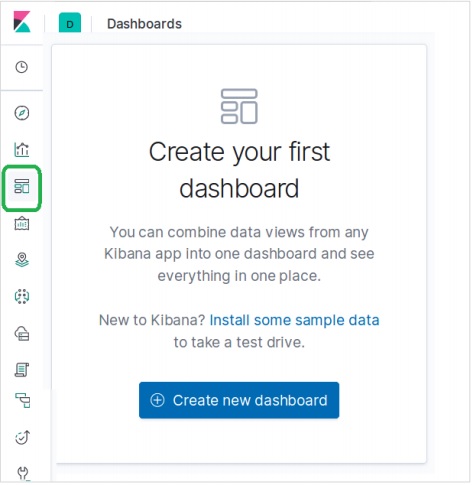

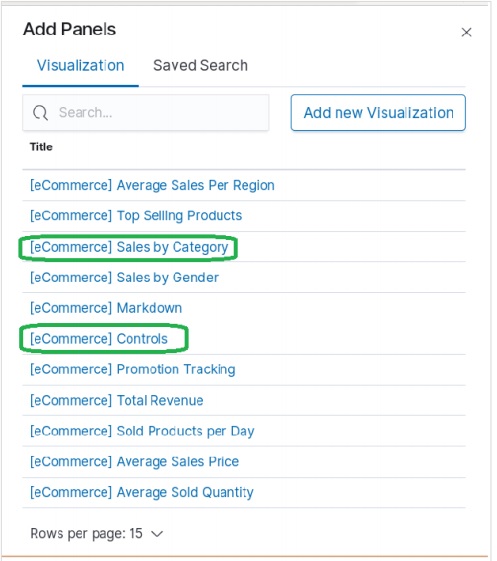

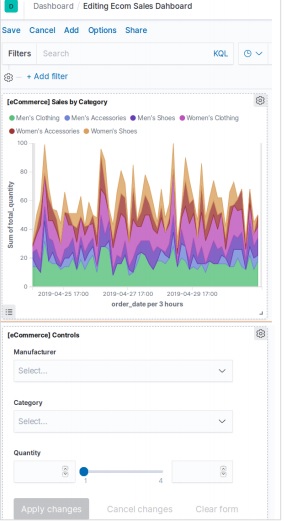

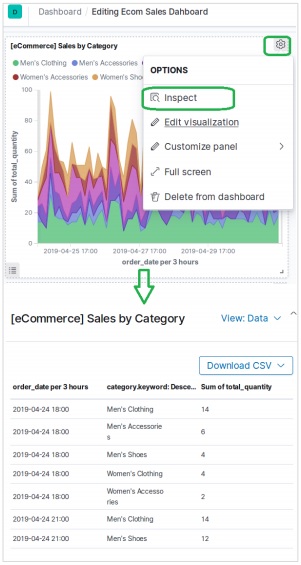

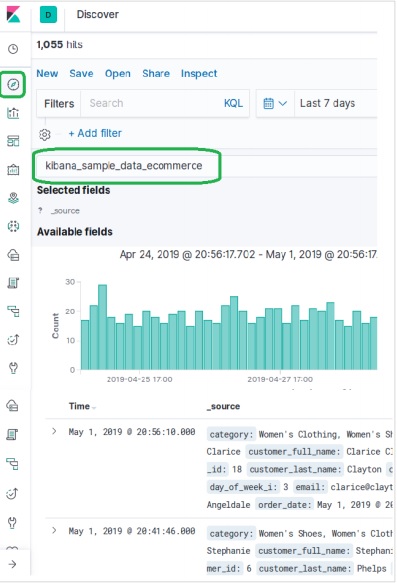

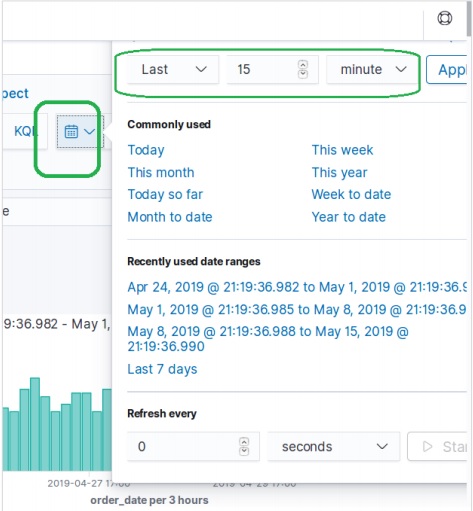

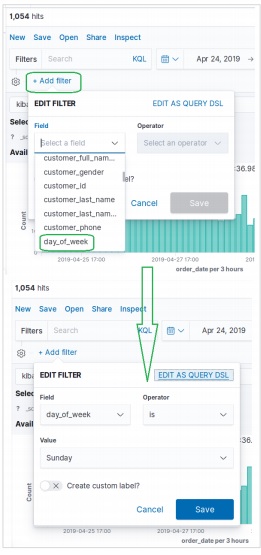

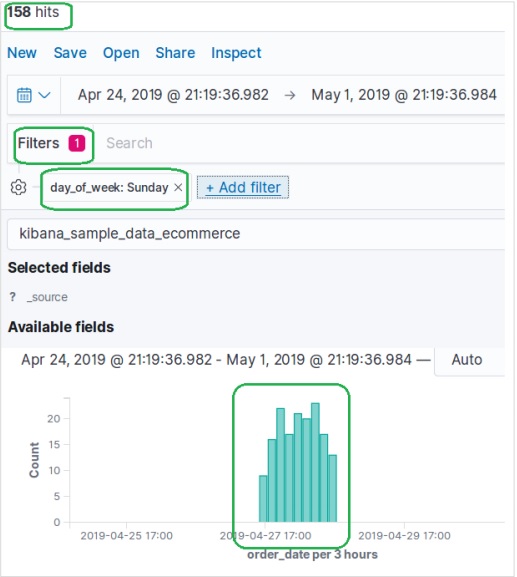

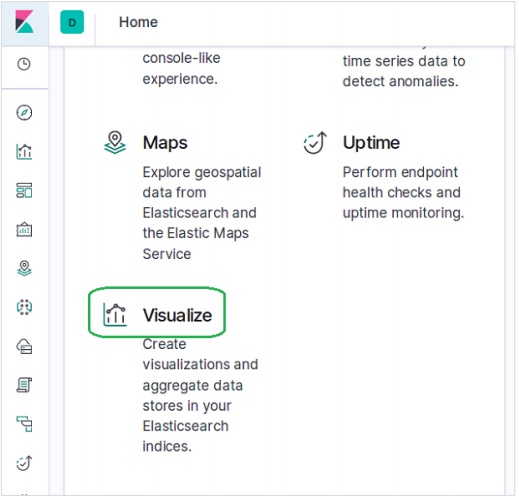

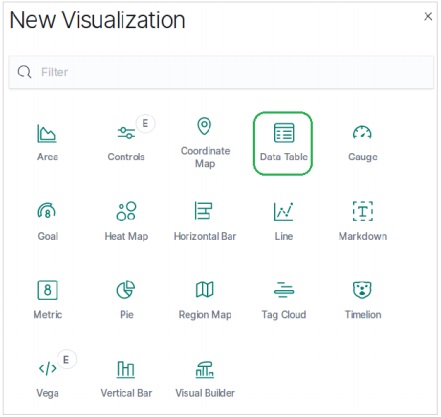

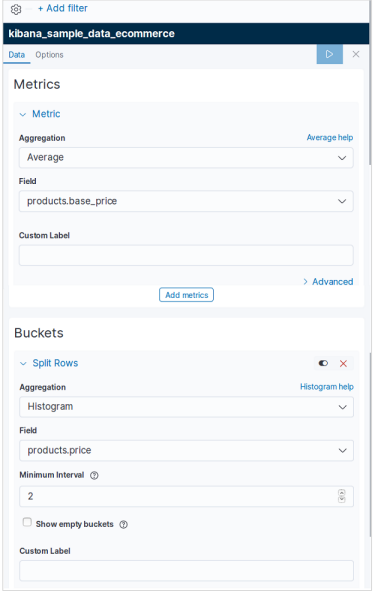

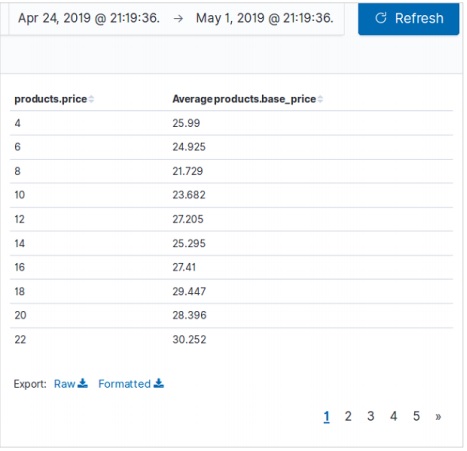

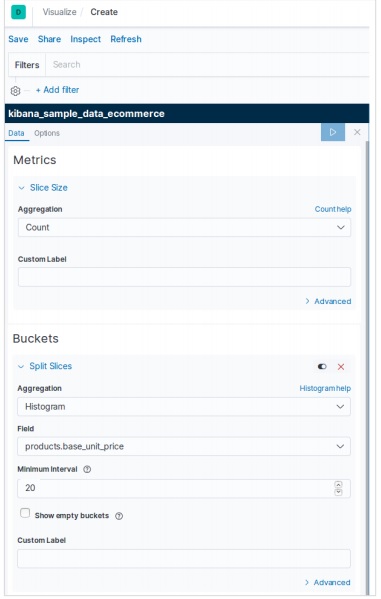

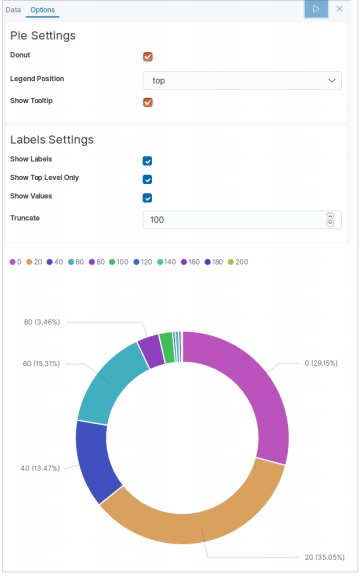

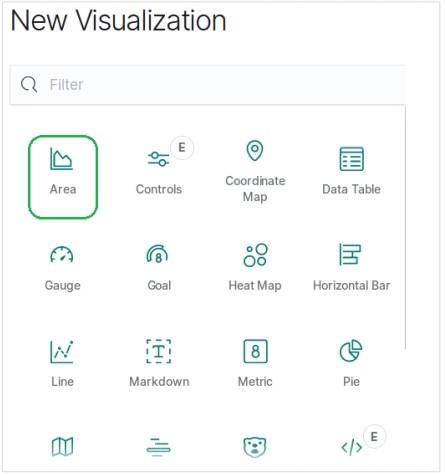

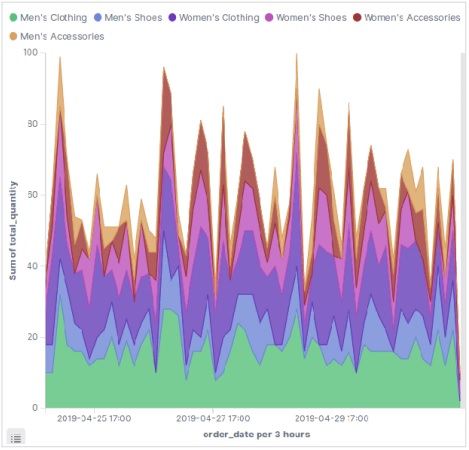

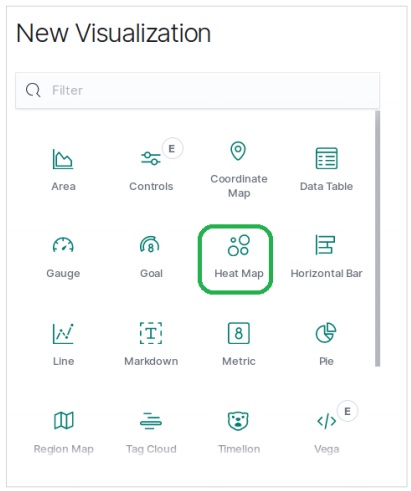

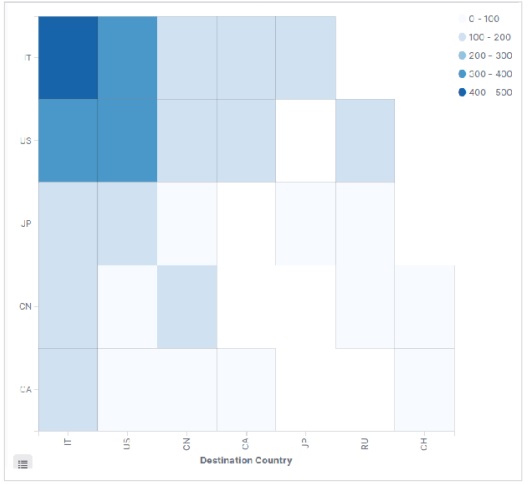

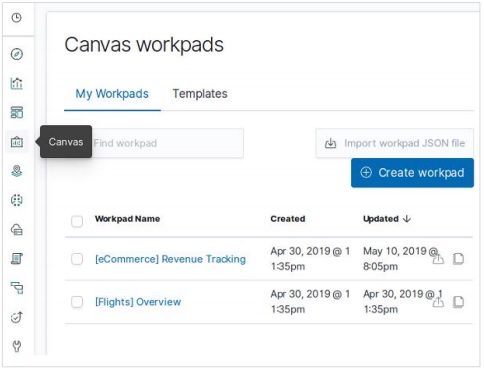

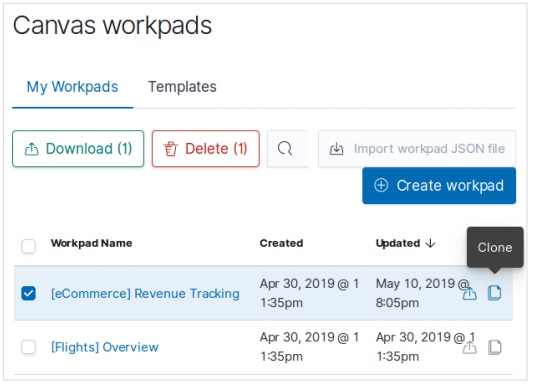

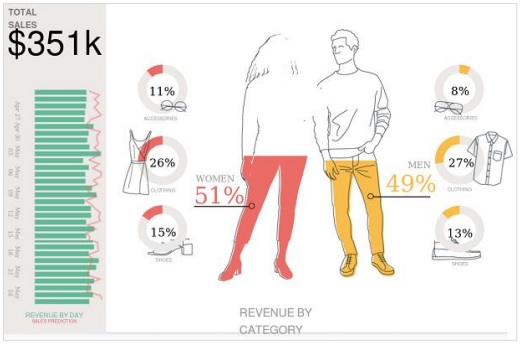

Ajout d'exemples de données dans Kibana

Kibana est un outil piloté par GUI pour accéder aux données et créer la visualisation. Dans cette section, voyons comment nous pouvons y ajouter des exemples de données.

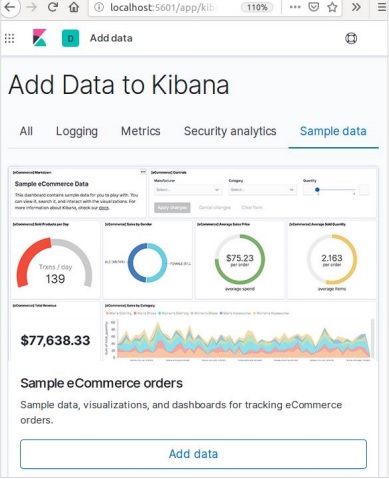

Dans la page d'accueil de Kibana, choisissez l'option suivante pour ajouter des exemples de données de commerce électronique -

L'écran suivant affichera une visualisation et un bouton pour ajouter des données -

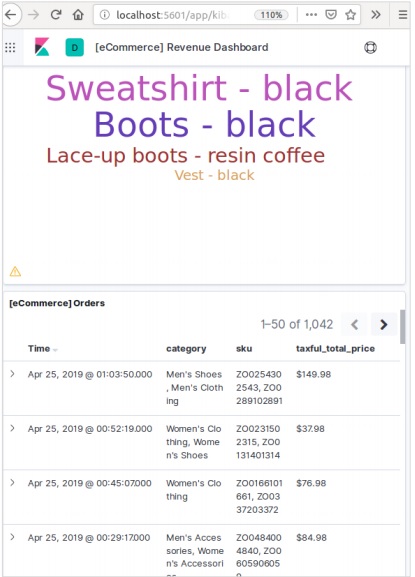

Cliquez sur Ajouter des données pour afficher l'écran suivant qui confirme que les données ont été ajoutées à un index nommé eCommerce.

Dans tout système ou logiciel, lorsque nous mettons à niveau vers une version plus récente, nous devons suivre quelques étapes pour maintenir les paramètres de l'application, les configurations, les données et autres. Ces étapes sont nécessaires pour rendre l'application stable dans un nouveau système ou pour maintenir l'intégrité des données (éviter que les données ne soient corrompues).

Vous devez suivre les étapes suivantes pour mettre à niveau Elasticsearch -

Lire les documents de mise à niveau sur https://www.elastic.co/

Testez la version mise à niveau dans vos environnements hors production comme dans l'environnement UAT, E2E, SIT ou DEV.

Notez que la restauration vers la version précédente d'Elasticsearch n'est pas possible sans sauvegarde des données. Par conséquent, une sauvegarde des données est recommandée avant la mise à niveau vers une version supérieure.

Nous pouvons mettre à niveau en utilisant un redémarrage complet du cluster ou une mise à niveau progressive. La mise à niveau progressive concerne les nouvelles versions. Notez qu'il n'y a pas de panne de service lorsque vous utilisez la méthode de mise à niveau progressive pour la migration.

Étapes de la mise à niveau

Testez la mise à niveau dans un environnement de développement avant de mettre à niveau votre cluster de production.

Sauvegardez vos données. Vous ne pouvez pas revenir à une version antérieure sauf si vous disposez d'un instantané de vos données.

Envisagez de fermer les tâches de machine learning avant de démarrer le processus de mise à niveau. Bien que les tâches d'apprentissage automatique puissent continuer à s'exécuter pendant une mise à niveau progressive, cela augmente la surcharge sur le cluster pendant le processus de mise à niveau.

Mettez à niveau les composants de votre Elastic Stack dans l'ordre suivant -

- Elasticsearch

- Kibana

- Logstash

- Beats

- Serveur APM

Mise à niveau à partir de la version 6.6 ou antérieure

Pour mettre à niveau directement vers Elasticsearch 7.1.0 à partir des versions 6.0-6.6, vous devez réindexer manuellement tous les index 5.x que vous devez reporter et effectuer un redémarrage complet du cluster.

Redémarrage complet du cluster

Le processus de redémarrage complet du cluster implique l'arrêt de chaque nœud du cluster, la mise à niveau de chaque nœud vers 7x, puis le redémarrage du cluster.

Voici les étapes de haut niveau à effectuer pour le redémarrage complet du cluster:

- Désactiver l'allocation de partition

- Arrêtez l'indexation et effectuez un vidage synchronisé

- Arrêtez tous les nœuds

- Mettre à niveau tous les nœuds

- Mettez à niveau tous les plugins

- Démarrez chaque nœud mis à niveau

- Attendez que tous les nœuds rejoignent le cluster et signalez un état jaune

- Réactiver l'allocation

Une fois l'allocation réactivée, le cluster commence à allouer les fragments de réplique aux nœuds de données. À ce stade, vous pouvez reprendre l'indexation et la recherche en toute sécurité, mais votre cluster récupérera plus rapidement si vous pouvez attendre que toutes les partitions principales et de réplique aient été allouées avec succès et que l'état de tous les nœuds soit vert.

L'interface de programmation d'application (API) dans le Web est un groupe d'appels de fonction ou d'autres instructions de programmation pour accéder au composant logiciel dans cette application Web particulière. Par exemple, l'API Facebook aide un développeur à créer des applications en accédant aux données ou à d'autres fonctionnalités de Facebook; il peut s'agir de la date de naissance ou de la mise à jour du statut.

Elasticsearch fournit une API REST, accessible par JSON via HTTP. Elasticsearch utilise certaines conventions dont nous allons discuter maintenant.

Indices multiples

La plupart des opérations, principalement les opérations de recherche et autres, dans les API concernent un ou plusieurs index. Cela aide l'utilisateur à rechercher dans plusieurs endroits ou dans toutes les données disponibles en exécutant simplement une requête une fois. De nombreuses notations différentes sont utilisées pour effectuer des opérations dans plusieurs index. Nous en discuterons quelques-uns ici dans ce chapitre.

Notation séparée par des virgules

POST /index1,index2,index3/_searchDemander le corps

{

"query":{

"query_string":{

"query":"any_string"

}

}

}Réponse

Objets JSON de index1, index2, index3 contenant any_string.

_all mot-clé pour tous les indices

POST /_all/_searchDemander le corps

{

"query":{

"query_string":{

"query":"any_string"

}

}

}Réponse

Objets JSON de tous les index et contenant any_string.

Caractères génériques (*, +, -)

POST /school*/_searchDemander le corps

{

"query":{

"query_string":{

"query":"CBSE"

}

}

}Réponse

Objets JSON de tous les index qui commencent par l'école contenant CBSE.

Vous pouvez également utiliser le code suivant -

POST /school*,-schools_gov /_searchDemander le corps

{

"query":{

"query_string":{

"query":"CBSE"

}

}

}Réponse

Objets JSON de tous les index qui commencent par «school» mais pas de schools_gov et qui contiennent CBSE.

Il existe également des paramètres de chaîne de requête URL -

- ignore_unavailable- Aucune erreur ne se produira ou aucune opération ne sera arrêtée, si le ou les index (s) présents dans l'URL n'existent pas. Par exemple, l'index des écoles existe, mais book_shops n'existe pas.

POST /school*,book_shops/_searchDemander le corps

{

"query":{

"query_string":{

"query":"CBSE"

}

}

}Demander le corps

{

"error":{

"root_cause":[{

"type":"index_not_found_exception", "reason":"no such index",

"resource.type":"index_or_alias", "resource.id":"book_shops",

"index":"book_shops"

}],

"type":"index_not_found_exception", "reason":"no such index",

"resource.type":"index_or_alias", "resource.id":"book_shops",

"index":"book_shops"

},"status":404

}Considérez le code suivant -

POST /school*,book_shops/_search?ignore_unavailable = trueDemander le corps

{

"query":{

"query_string":{

"query":"CBSE"

}

}

}Réponse (pas d'erreur)

Objets JSON de tous les index qui commencent par l'école contenant CBSE.

allow_no_indices

trueLa valeur de ce paramètre empêchera les erreurs, si une URL avec un caractère générique ne produit aucun index. Par exemple, il n'y a pas d'index commençant par schools_pri -

POST /schools_pri*/_search?allow_no_indices = trueDemander le corps

{

"query":{

"match_all":{}

}

}Réponse (aucune erreur)

{

"took":1,"timed_out": false, "_shards":{"total":0, "successful":0, "failed":0},

"hits":{"total":0, "max_score":0.0, "hits":[]}

}expand_wildcards

Ce paramètre décide si les caractères génériques doivent être développés pour ouvrir des index ou des index fermés ou effectuer les deux. La valeur de ce paramètre peut être ouverte et fermée ou aucune et toutes.

Par exemple, fermer les écoles index -

POST /schools/_closeRéponse

{"acknowledged":true}Considérez le code suivant -

POST /school*/_search?expand_wildcards = closedDemander le corps

{

"query":{

"match_all":{}

}

}Réponse

{

"error":{

"root_cause":[{

"type":"index_closed_exception", "reason":"closed", "index":"schools"

}],

"type":"index_closed_exception", "reason":"closed", "index":"schools"

}, "status":403

}Prise en charge mathématique des dates dans les noms d'index

Elasticsearch propose une fonctionnalité de recherche d'index en fonction de la date et de l'heure. Nous devons spécifier la date et l'heure dans un format spécifique. Par exemple, accountdetail-2015.12.30, index stockera les détails du compte bancaire du 30 décembre 2015. Des opérations mathématiques peuvent être effectuées pour obtenir des détails pour une date particulière ou une plage de dates et d'heures.

Format du nom de l'index mathématique de date -

<static_name{date_math_expr{date_format|time_zone}}>

/<accountdetail-{now-2d{YYYY.MM.dd|utc}}>/_searchstatic_name est une partie de l'expression qui reste la même dans chaque index mathématique de date comme le détail du compte. date_math_expr contient l'expression mathématique qui détermine la date et l'heure de manière dynamique comme now-2d. date_format contient le format dans lequel la date est écrite dans un index comme AAAA.MM.dd. Si la date d'aujourd'hui est le 30 décembre 2015, <accountdetail- {now-2d {YYYY.MM.dd}}> renverra accountdetail-2015.12.28.

| Expression | Décide de |

|---|---|

| <accountdetail- {now-d}> | accountdetail-2015.12.29 |

| <accountdetail- {now-M}> | accountdetail-2015.11.30 |

| <accountdetail- {now {YYYY.MM}}> | accountdetail-2015.12 |

Nous allons maintenant voir certaines des options courantes disponibles dans Elasticsearch qui peuvent être utilisées pour obtenir la réponse dans un format spécifié.

Jolis résultats

Nous pouvons obtenir une réponse dans un objet JSON bien formaté en ajoutant simplement un paramètre de requête URL, c'est-à-dire pretty = true.

POST /schools/_search?pretty = trueDemander le corps

{

"query":{

"match_all":{}

}

}Réponse

……………………..

{

"_index" : "schools", "_type" : "school", "_id" : "1", "_score" : 1.0,

"_source":{

"name":"Central School", "description":"CBSE Affiliation",

"street":"Nagan", "city":"paprola", "state":"HP", "zip":"176115",

"location": [31.8955385, 76.8380405], "fees":2000,

"tags":["Senior Secondary", "beautiful campus"], "rating":"3.5"

}

}

………………….Sortie lisible par l'homme

Cette option peut changer les réponses statistiques sous une forme lisible par l'homme (si humain = vrai) ou sous une forme lisible par ordinateur (si humain = faux). Par exemple, si human = true alors distance_kilometer = 20KM et si human = false alors distance_meter = 20000, lorsque la réponse doit être utilisée par un autre programme informatique.

Filtrage des réponses

Nous pouvons filtrer la réponse à moins de champs en les ajoutant dans le paramètre field_path. Par exemple,

POST /schools/_search?filter_path = hits.totalDemander le corps

{

"query":{

"match_all":{}

}

}Réponse

{"hits":{"total":3}}Elasticsearch fournit des API de document unique et des API multi-documents, dans lesquelles l'appel d'API cible un seul document et plusieurs documents respectivement.

API d'index

Il est utile d'ajouter ou de mettre à jour le document JSON dans un index lorsqu'une demande est faite à cet index respectif avec un mappage spécifique. Par exemple, la demande suivante ajoutera l'objet JSON aux écoles d'index et sous le mappage scolaire -

PUT schools/_doc/5

{

name":"City School", "description":"ICSE", "street":"West End",

"city":"Meerut",

"state":"UP", "zip":"250002", "location":[28.9926174, 77.692485],

"fees":3500,

"tags":["fully computerized"], "rating":"4.5"

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 2,

"_primary_term" : 1

}Création d'index automatique

Lorsqu'une demande est faite pour ajouter un objet JSON à un index particulier et si cet index n'existe pas, cette API crée automatiquement cet index ainsi que le mappage sous-jacent pour cet objet JSON particulier. Cette fonctionnalité peut être désactivée en modifiant les valeurs des paramètres suivants sur false, qui sont présents dans le fichier elasticsearch.yml.

action.auto_create_index:false

index.mapper.dynamic:falseVous pouvez également restreindre la création automatique d'index, où seul le nom d'index avec des modèles spécifiques est autorisé en modifiant la valeur du paramètre suivant -

action.auto_create_index:+acc*,-bank*Note - Ici + indique autorisé et - indique non autorisé.

Gestion des versions

Elasticsearch fournit également une fonction de contrôle de version. Nous pouvons utiliser un paramètre de requête de version pour spécifier la version d'un document particulier.

PUT schools/_doc/5?version=7&version_type=external

{

"name":"Central School", "description":"CBSE Affiliation", "street":"Nagan",

"city":"paprola", "state":"HP", "zip":"176115", "location":[31.8955385, 76.8380405],

"fees":2200, "tags":["Senior Secondary", "beautiful campus"], "rating":"3.3"

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 7,

"result" : "updated",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 3,

"_primary_term" : 1

}Le contrôle de version est un processus en temps réel et il n'est pas affecté par les opérations de recherche en temps réel.

Il existe deux types de contrôle de version les plus importants:

Versionnage interne

Le contrôle de version interne est la version par défaut qui commence par 1 et s'incrémente à chaque mise à jour, suppressions incluses.

Versionnage externe

Il est utilisé lorsque la gestion des versions des documents est stockée dans un système externe comme les systèmes de gestion des versions tiers. Pour activer cette fonctionnalité, nous devons définir version_type sur external. Ici, Elasticsearch stockera le numéro de version comme indiqué par le système externe et ne les incrémentera pas automatiquement.

Type d'opération

Le type d'opération est utilisé pour forcer une opération de création. Cela permet d'éviter l'écrasement du document existant.

PUT chapter/_doc/1?op_type=create

{

"Text":"this is chapter one"

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"_index" : "chapter",

"_type" : "_doc",

"_id" : "1",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 0,

"_primary_term" : 1

}Génération automatique d'ID

Lorsque l'ID n'est pas spécifié dans l'opération d'index, Elasticsearch génère automatiquement l'ID de ce document.

POST chapter/_doc/

{

"user" : "tpoint",

"post_date" : "2018-12-25T14:12:12",

"message" : "Elasticsearch Tutorial"

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"_index" : "chapter",

"_type" : "_doc",

"_id" : "PVghWGoB7LiDTeV6LSGu",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 1,

"_primary_term" : 1

}Obtenir l'API

L'API aide à extraire un objet JSON de type en effectuant une demande d'obtention pour un document particulier.

pre class="prettyprint notranslate" > GET schools/_doc/5En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 7,

"_seq_no" : 3,

"_primary_term" : 1,

"found" : true,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

}Cette opération est en temps réel et n'est pas affectée par le taux de rafraîchissement de l'Index.

Vous pouvez également spécifier la version, puis Elasticsearch ne récupérera que cette version du document.

Vous pouvez également spécifier le _all dans la requête, afin qu'Elasticsearch puisse rechercher cet identifiant de document dans chaque type et il renverra le premier document correspondant.

Vous pouvez également spécifier les champs souhaités dans votre résultat à partir de ce document particulier.

GET schools/_doc/5?_source_includes=name,feesEn exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 7,

"_seq_no" : 3,

"_primary_term" : 1,

"found" : true,

"_source" : {

"fees" : 2200,

"name" : "Central School"

}

}Vous pouvez également récupérer la partie source dans votre résultat en ajoutant simplement la partie _source dans votre demande d'obtention.

GET schools/_doc/5?_sourceEn exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "5",

"_version" : 7,

"_seq_no" : 3,

"_primary_term" : 1,

"found" : true,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

}Vous pouvez également actualiser la partition avant d'effectuer l'opération get en définissant le paramètre d'actualisation sur true.

Supprimer l'API

Vous pouvez supprimer un index, un mappage ou un document particulier en envoyant une requête HTTP DELETE à Elasticsearch.

DELETE schools/_doc/4En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"found":true, "_index":"schools", "_type":"school", "_id":"4", "_version":2,

"_shards":{"total":2, "successful":1, "failed":0}

}La version du document peut être spécifiée pour supprimer cette version particulière. Le paramètre de routage peut être spécifié pour supprimer le document d'un utilisateur particulier et l'opération échoue si le document n'appartient pas à cet utilisateur particulier. Dans cette opération, vous pouvez spécifier les options d'actualisation et d'expiration de la même manière que l'API GET.

Mettre à jour l'API

Le script est utilisé pour effectuer cette opération et le contrôle de version est utilisé pour s'assurer qu'aucune mise à jour ne s'est produite pendant l'obtention et la réindexation. Par exemple, vous pouvez mettre à jour les frais de scolarité en utilisant le script -

POST schools/_update/4

{

"script" : {

"source": "ctx._source.name = params.sname",

"lang": "painless",

"params" : {

"sname" : "City Wise School"

}

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"_index" : "schools",

"_type" : "_doc",

"_id" : "4",

"_version" : 3,

"result" : "updated",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 4,

"_primary_term" : 2

}Vous pouvez vérifier la mise à jour en envoyant une demande d'obtention au document mis à jour.

Cette API est utilisée pour rechercher du contenu dans Elasticsearch. Un utilisateur peut effectuer une recherche en envoyant une demande d'obtention avec une chaîne de requête comme paramètre ou il peut publier une requête dans le corps du message de la demande de publication. Principalement tous les APIS de recherche sont multi-index, multi-types.

Multi-index

Elasticsearch nous permet de rechercher les documents présents dans tous les index ou dans certains index spécifiques. Par exemple, si nous devons rechercher tous les documents avec un nom qui contient central, nous pouvons faire comme indiqué ici -

GET /_all/_search?q=city:paprolaEn exécutant le code ci-dessus, nous obtenons la réponse suivante -

{

"took" : 33,

"timed_out" : false,

"_shards" : {

"total" : 7,

"successful" : 7,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 0.9808292,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 0.9808292,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

}

]

}

}Recherche URI

De nombreux paramètres peuvent être passés dans une opération de recherche à l'aide de l'identificateur de ressource uniforme -

| S. Non | Paramètre et description |

|---|---|

| 1 | Q Ce paramètre est utilisé pour spécifier la chaîne de requête. |

| 2 | lenient Ce paramètre est utilisé pour spécifier la chaîne de requête. Les erreurs basées sur le format peuvent être ignorées en définissant simplement ce paramètre sur true. C'est faux par défaut. |

| 3 | fields Ce paramètre est utilisé pour spécifier la chaîne de requête. |

| 4 | sort Nous pouvons obtenir un résultat trié en utilisant ce paramètre, les valeurs possibles pour ce paramètre sont fieldName, fieldName: asc / fieldname: desc |

| 5 | timeout Nous pouvons restreindre le temps de recherche en utilisant ce paramètre et la réponse ne contient que les résultats dans ce temps spécifié. Par défaut, il n'y a pas de délai. |

| 6 | terminate_after Nous pouvons limiter la réponse à un nombre spécifié de documents pour chaque partition, lorsque la requête se terminera prématurément. Par défaut, il n'y a pas de terminate_after. |

| sept | from L'index de départ des hits à renvoyer. La valeur par défaut est 0. |

| 8 | size Il indique le nombre de hits à renvoyer. La valeur par défaut est 10. |

Demander une recherche corporelle

Nous pouvons également spécifier une requête en utilisant la requête DSL dans le corps de la requête et de nombreux exemples sont déjà donnés dans les chapitres précédents. Un tel exemple est donné ici -

POST /schools/_search

{

"query":{

"query_string":{

"query":"up"

}

}

}En exécutant le code ci-dessus, nous obtenons la réponse suivante -

{

"took" : 11,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 0.47000363,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 0.47000363,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

}

}Le cadre d'agrégation collecte toutes les données sélectionnées par la requête de recherche et se compose de nombreux blocs de construction, qui aident à créer des résumés complexes des données. La structure de base d'une agrégation est présentée ici -

"aggregations" : {

"" : {

"" : {

}

[,"meta" : { [] } ]?

[,"aggregations" : { []+ } ]?

}

[,"" : { ... } ]*

}Il existe différents types d'agrégations, chacun ayant son propre objectif. Ils sont discutés en détail dans ce chapitre.

Agrégations de métriques

Ces agrégations aident à calculer des matrices à partir des valeurs de champ des documents agrégés et parfois certaines valeurs peuvent être générées à partir de scripts.

Les matrices numériques sont soit à valeur unique comme l'agrégation moyenne, soit à valeurs multiples comme les statistiques.

Agrégation moyenne

Cette agrégation est utilisée pour obtenir la moyenne de tout champ numérique présent dans les documents agrégés. Par exemple,

POST /schools/_search

{

"aggs":{

"avg_fees":{"avg":{"field":"fees"}}

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"took" : 41,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : 1.0,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 1.0,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

},

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 1.0,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

},

"aggregations" : {

"avg_fees" : {

"value" : 2850.0

}

}

}Agrégation de cardinalité

Cette agrégation donne le nombre de valeurs distinctes d'un champ particulier.

POST /schools/_search?size=0

{

"aggs":{

"distinct_name_count":{"cardinality":{"field":"fees"}}

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"took" : 2,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"distinct_name_count" : {

"value" : 2

}

}

}Note - La valeur de la cardinalité est de 2 car il existe deux valeurs distinctes dans les frais.

Agrégation étendue des statistiques

Cette agrégation génère toutes les statistiques sur un champ numérique spécifique dans les documents agrégés.

POST /schools/_search?size=0

{

"aggs" : {

"fees_stats" : { "extended_stats" : { "field" : "fees" } }

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"took" : 8,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"fees_stats" : {

"count" : 2,

"min" : 2200.0,

"max" : 3500.0,

"avg" : 2850.0,

"sum" : 5700.0,

"sum_of_squares" : 1.709E7,

"variance" : 422500.0,

"std_deviation" : 650.0,

"std_deviation_bounds" : {

"upper" : 4150.0,

"lower" : 1550.0

}

}

}

}Agrégation maximale

Cette agrégation trouve la valeur maximale d'un champ numérique spécifique dans les documents agrégés.

POST /schools/_search?size=0

{

"aggs" : {

"max_fees" : { "max" : { "field" : "fees" } }

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"took" : 16,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"max_fees" : {

"value" : 3500.0

}

}

}Agrégation minimale

Cette agrégation trouve la valeur minimale d'un champ numérique spécifique dans les documents agrégés.

POST /schools/_search?size=0

{

"aggs" : {

"min_fees" : { "min" : { "field" : "fees" } }

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"took" : 2,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"min_fees" : {

"value" : 2200.0

}

}

}Agrégation de somme

Cette agrégation calcule la somme d'un champ numérique spécifique dans les documents agrégés.

POST /schools/_search?size=0

{

"aggs" : {

"total_fees" : { "sum" : { "field" : "fees" } }

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"took" : 8,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"total_fees" : {

"value" : 5700.0

}

}

}Il existe d'autres agrégations de métriques qui sont utilisées dans des cas particuliers, tels que l'agrégation de limites géographiques et l'agrégation de géocentres à des fins de géolocalisation.

Agrégations de statistiques

Agrégation de métriques à valeurs multiples qui calcule des statistiques sur des valeurs numériques extraites des documents agrégés.

POST /schools/_search?size=0

{

"aggs" : {

"grades_stats" : { "stats" : { "field" : "fees" } }

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"took" : 2,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"grades_stats" : {

"count" : 2,

"min" : 2200.0,

"max" : 3500.0,

"avg" : 2850.0,

"sum" : 5700.0

}

}

}Métadonnées d'agrégation

Vous pouvez ajouter des données sur l'agrégation au moment de la demande à l'aide de la balise Meta et obtenir cela en réponse.

POST /schools/_search?size=0

{

"aggs" : {

"min_fees" : { "avg" : { "field" : "fees" } ,

"meta" :{

"dsc" :"Lowest Fees This Year"

}

}

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"took" : 0,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"min_fees" : {

"meta" : {

"dsc" : "Lowest Fees This Year"

},

"value" : 2850.0

}

}

}Ces API sont chargées de gérer tous les aspects de l'index comme les paramètres, les alias, les mappages, les modèles d'index.

Créer un index

Cette API vous aide à créer un index. Un index peut être créé automatiquement lorsqu'un utilisateur transmet des objets JSON à n'importe quel index ou il peut être créé avant cela. Pour créer un index, il vous suffit d'envoyer une requête PUT avec paramètres, mappages et alias ou simplement une simple requête sans corps.

PUT collegesEn exécutant le code ci-dessus, nous obtenons la sortie comme indiqué ci-dessous -

{

"acknowledged" : true,

"shards_acknowledged" : true,

"index" : "colleges"

}Nous pouvons également ajouter quelques paramètres à la commande ci-dessus -

PUT colleges

{

"settings" : {

"index" : {

"number_of_shards" : 3,

"number_of_replicas" : 2

}

}

}En exécutant le code ci-dessus, nous obtenons la sortie comme indiqué ci-dessous -

{

"acknowledged" : true,

"shards_acknowledged" : true,

"index" : "colleges"

}Supprimer l'index

Cette API vous aide à supprimer n'importe quel index. Il vous suffit de transmettre une demande de suppression avec le nom de cet index particulier.

DELETE /collegesVous pouvez supprimer tous les index en utilisant simplement _all ou *.

Obtenir l'index

Cette API peut être appelée en envoyant simplement une requête get à un ou plusieurs index. Cela renvoie les informations sur l'index.

GET collegesEn exécutant le code ci-dessus, nous obtenons la sortie comme indiqué ci-dessous -

{

"colleges" : {

"aliases" : {

"alias_1" : { },

"alias_2" : {

"filter" : {

"term" : {

"user" : "pkay"

}

},

"index_routing" : "pkay",

"search_routing" : "pkay"

}

},

"mappings" : { },

"settings" : {

"index" : {

"creation_date" : "1556245406616",

"number_of_shards" : "1",

"number_of_replicas" : "1",

"uuid" : "3ExJbdl2R1qDLssIkwDAug",

"version" : {

"created" : "7000099"

},

"provided_name" : "colleges"

}

}

}

}Vous pouvez obtenir les informations de tous les indices en utilisant _all ou *.

L'index existe

L'existence d'un index peut être déterminée en envoyant simplement une requête get à cet index. Si la réponse HTTP est 200, elle existe; s'il est 404, il n'existe pas.

HEAD collegesEn exécutant le code ci-dessus, nous obtenons la sortie comme indiqué ci-dessous -

200-OKParamètres d'index

Vous pouvez obtenir les paramètres d'index en ajoutant simplement le mot-clé _settings à la fin de l'URL.

GET /colleges/_settingsEn exécutant le code ci-dessus, nous obtenons la sortie comme indiqué ci-dessous -

{

"colleges" : {

"settings" : {

"index" : {

"creation_date" : "1556245406616",

"number_of_shards" : "1",

"number_of_replicas" : "1",

"uuid" : "3ExJbdl2R1qDLssIkwDAug",

"version" : {

"created" : "7000099"

},

"provided_name" : "colleges"

}

}

}

}Statistiques d'index

Cette API vous aide à extraire des statistiques sur un index particulier. Il vous suffit d'envoyer une demande d'obtention avec l'URL d'index et le mot-clé _stats à la fin.

GET /_statsEn exécutant le code ci-dessus, nous obtenons la sortie comme indiqué ci-dessous -

………………………………………………

},

"request_cache" : {

"memory_size_in_bytes" : 849,

"evictions" : 0,

"hit_count" : 1171,

"miss_count" : 4

},

"recovery" : {

"current_as_source" : 0,

"current_as_target" : 0,

"throttle_time_in_millis" : 0

}

} ………………………………………………Affleurer

Le processus de vidage d'un index garantit que toutes les données qui ne sont actuellement conservées que dans le journal des transactions sont également persistantes de manière permanente dans Lucene. Cela réduit les temps de récupération car ces données n'ont pas besoin d'être réindexées à partir des journaux de transactions après l'ouverture de Lucene indexé.

POST colleges/_flushEn exécutant le code ci-dessus, nous obtenons la sortie comme indiqué ci-dessous -

{

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

}

}Habituellement, les résultats de diverses API Elasticsearch sont affichés au format JSON. Mais JSON n'est pas toujours facile à lire. Ainsi, la fonctionnalité d'API de chat est disponible dans Elasticsearch pour aider à donner un format d'impression plus facile à lire et à comprendre des résultats. Il existe divers paramètres utilisés dans l'API cat qui ont des objectifs différents du serveur, par exemple - le terme V rend la sortie verbeuse.

Apprenons plus en détail les API cat dans ce chapitre.

Verbeux

La sortie détaillée donne un bel affichage des résultats d'une commande cat. Dans l'exemple ci-dessous, nous obtenons les détails des différents indices présents dans le cluster.

GET /_cat/indices?vEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

yellow open schools RkMyEn2SQ4yUgzT6EQYuAA 1 1 2 1 21.6kb 21.6kb

yellow open index_4_analysis zVmZdM1sTV61YJYrNXf1gg 1 1 0 0 283b 283b

yellow open sensor-2018-01-01 KIrrHwABRB-ilGqTu3OaVQ 1 1 1 0 4.2kb 4.2kb

yellow open colleges 3ExJbdl2R1qDLssIkwDAug 1 1 0 0 283b 283bEn-têtes

Le paramètre h, également appelé en-tête, est utilisé pour afficher uniquement les colonnes mentionnées dans la commande.

GET /_cat/nodes?h=ip,portEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

127.0.0.1 9300Trier

La commande sort accepte la chaîne de requête qui peut trier la table par colonne spécifiée dans la requête. Le tri par défaut est ascendant mais cela peut être modifié en ajoutant: desc à une colonne.

L'exemple ci-dessous donne un résultat de modèles organisés dans l'ordre décroissant des modèles d'index classés.

GET _cat/templates?v&s=order:desc,index_patternsEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

name index_patterns order version

.triggered_watches [.triggered_watches*] 2147483647

.watch-history-9 [.watcher-history-9*] 2147483647

.watches [.watches*] 2147483647

.kibana_task_manager [.kibana_task_manager] 0 7000099Compter

Le paramètre count fournit le nombre total de documents dans l'ensemble du cluster.

GET /_cat/count?vEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

epoch timestamp count

1557633536 03:58:56 17809L'API de cluster est utilisée pour obtenir des informations sur le cluster et ses nœuds et pour y apporter des modifications. Pour appeler cette API, nous devons spécifier le nom du nœud, l'adresse ou _local.

GET /_nodes/_localEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

………………………………………………

cluster_name" : "elasticsearch",

"nodes" : {

"FKH-5blYTJmff2rJ_lQOCg" : {

"name" : "ubuntu",

"transport_address" : "127.0.0.1:9300",

"host" : "127.0.0.1",

"ip" : "127.0.0.1",

"version" : "7.0.0",

"build_flavor" : "default",

"build_type" : "tar",

"build_hash" : "b7e28a7",

"total_indexing_buffer" : 106502553,

"roles" : [

"master",

"data",

"ingest"

],

"attributes" : {

………………………………………………Santé du cluster

Cette API est utilisée pour obtenir l'état de la santé du cluster en ajoutant le mot clé 'health'.

GET /_cluster/healthEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"cluster_name" : "elasticsearch",

"status" : "yellow",

"timed_out" : false,

"number_of_nodes" : 1,

"number_of_data_nodes" : 1,

"active_primary_shards" : 7,

"active_shards" : 7,

"relocating_shards" : 0,

"initializing_shards" : 0,

"unassigned_shards" : 4,

"delayed_unassigned_shards" : 0,

"number_of_pending_tasks" : 0,

"number_of_in_flight_fetch" : 0,

"task_max_waiting_in_queue_millis" : 0,

"active_shards_percent_as_number" : 63.63636363636363

}État du cluster

Cette API est utilisée pour obtenir des informations d'état sur un cluster en ajoutant l'URL du mot clé "state". Les informations d'état contiennent la version, le nœud maître, d'autres nœuds, la table de routage, les métadonnées et les blocs.

GET /_cluster/stateEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

………………………………………………

{

"cluster_name" : "elasticsearch",

"cluster_uuid" : "IzKu0OoVTQ6LxqONJnN2eQ",

"version" : 89,

"state_uuid" : "y3BlwvspR1eUQBTo0aBjig",

"master_node" : "FKH-5blYTJmff2rJ_lQOCg",

"blocks" : { },

"nodes" : {

"FKH-5blYTJmff2rJ_lQOCg" : {

"name" : "ubuntu",

"ephemeral_id" : "426kTGpITGixhEzaM-5Qyg",

"transport

}

………………………………………………Statistiques du cluster

Cette API permet de récupérer des statistiques sur le cluster à l'aide du mot clé «stats». Cette API renvoie le numéro de partition, la taille du magasin, l'utilisation de la mémoire, le nombre de nœuds, les rôles, le système d'exploitation et le système de fichiers.

GET /_cluster/statsEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

………………………………………….

"cluster_name" : "elasticsearch",

"cluster_uuid" : "IzKu0OoVTQ6LxqONJnN2eQ",

"timestamp" : 1556435464704,

"status" : "yellow",

"indices" : {

"count" : 7,

"shards" : {

"total" : 7,

"primaries" : 7,

"replication" : 0.0,

"index" : {

"shards" : {

"min" : 1,

"max" : 1,

"avg" : 1.0

},

"primaries" : {

"min" : 1,

"max" : 1,

"avg" : 1.0

},

"replication" : {

"min" : 0.0,

"max" : 0.0,

"avg" : 0.0

}

………………………………………….Paramètres de mise à jour du cluster

Cette API vous permet de mettre à jour les paramètres d'un cluster à l'aide du mot-clé "settings". Il existe deux types de paramètres: persistants (appliqués lors des redémarrages) et transitoires (ne survivent pas à un redémarrage complet du cluster).

Statistiques des nœuds

Cette API est utilisée pour récupérer les statistiques d'un ou plusieurs nœuds du cluster. Les statistiques des nœuds sont presque les mêmes que celles du cluster.

GET /_nodes/statsEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"_nodes" : {

"total" : 1,

"successful" : 1,

"failed" : 0

},

"cluster_name" : "elasticsearch",

"nodes" : {

"FKH-5blYTJmff2rJ_lQOCg" : {

"timestamp" : 1556437348653,

"name" : "ubuntu",

"transport_address" : "127.0.0.1:9300",

"host" : "127.0.0.1",

"ip" : "127.0.0.1:9300",

"roles" : [

"master",

"data",

"ingest"

],

"attributes" : {

"ml.machine_memory" : "4112797696",

"xpack.installed" : "true",

"ml.max_open_jobs" : "20"

},

………………………………………………………….Nœuds hot_threads

Cette API vous aide à récupérer des informations sur les threads actifs actuels sur chaque nœud du cluster.

GET /_nodes/hot_threadsEn exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

:::{ubuntu}{FKH-5blYTJmff2rJ_lQOCg}{426kTGpITGixhEzaM5Qyg}{127.0.0.1}{127.0.0.1:9300}{ml.machine_memory=4112797696,

xpack.installed=true, ml.max_open_jobs=20}

Hot threads at 2019-04-28T07:43:58.265Z, interval=500ms, busiestThreads=3,

ignoreIdleThreads=true:Dans Elasticsearch, la recherche est effectuée à l'aide d'une requête basée sur JSON. Une requête est composée de deux clauses -

Leaf Query Clauses - Ces clauses sont des correspondances, des termes ou des plages, qui recherchent une valeur spécifique dans un champ spécifique.

Compound Query Clauses - Ces requêtes sont une combinaison de clauses de requête feuille et d'autres requêtes composées pour extraire les informations souhaitées.

Elasticsearch prend en charge un grand nombre de requêtes. Une requête commence par un mot clé de requête, puis contient des conditions et des filtres sous la forme d'un objet JSON. Les différents types de requêtes ont été décrits ci-dessous.

Faire correspondre toutes les requêtes

C'est la requête la plus basique; il renvoie tout le contenu et avec le score de 1,0 pour chaque objet.

POST /schools/_search

{

"query":{

"match_all":{}

}

}En exécutant le code ci-dessus, nous obtenons le résultat suivant -

{

"took" : 7,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : 1.0,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 1.0,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

},

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 1.0,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

}

}Requêtes en texte intégral

Ces requêtes sont utilisées pour rechercher un corps de texte complet comme un chapitre ou un article de presse. Cette requête fonctionne en fonction de l'analyseur associé à cet index ou document particulier. Dans cette section, nous aborderons les différents types de requêtes de texte intégral.

Requête de correspondance

Cette requête met en correspondance un texte ou une expression avec les valeurs d'un ou plusieurs champs.

POST /schools*/_search

{

"query":{

"match" : {

"rating":"4.5"

}

}

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"took" : 44,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 0.47000363,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 0.47000363,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

}

}Requête multi-correspondance

Cette requête correspond à un texte ou à une expression avec plusieurs champs.

POST /schools*/_search

{

"query":{

"multi_match" : {

"query": "paprola",

"fields": [ "city", "state" ]

}

}

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"took" : 12,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 0.9808292,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 0.9808292,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

"fees" : 2200,

"tags" : [

"Senior Secondary",

"beautiful campus"

],

"rating" : "3.3"

}

}

]

}

}Requête Requête de chaîne

Cette requête utilise un analyseur de requête et un mot clé query_string.

POST /schools*/_search

{

"query":{

"query_string":{

"query":"beautiful"

}

}

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"took" : 60,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

………………………………….Requêtes au niveau du terme

Ces requêtes traitent principalement de données structurées telles que des nombres, des dates et des énumérations.

POST /schools*/_search

{

"query":{

"term":{"zip":"176115"}

}

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

……………………………..

hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "5",

"_score" : 0.9808292,

"_source" : {

"name" : "Central School",

"description" : "CBSE Affiliation",

"street" : "Nagan",

"city" : "paprola",

"state" : "HP",

"zip" : "176115",

"location" : [

31.8955385,

76.8380405

],

}

}

]

…………………………………………..Requête de plage

Cette requête est utilisée pour trouver les objets ayant des valeurs entre les plages de valeurs données. Pour cela, nous devons utiliser des opérateurs tels que -

- gte - supérieur à égal à

- gt - supérieur à

- lte - inférieur à égal à

- lt - moins de

Par exemple, observez le code ci-dessous -

POST /schools*/_search

{

"query":{

"range":{

"rating":{

"gte":3.5

}

}

}

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"took" : 24,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 1.0,

"hits" : [

{

"_index" : "schools",

"_type" : "school",

"_id" : "4",

"_score" : 1.0,

"_source" : {

"name" : "City Best School",

"description" : "ICSE",

"street" : "West End",

"city" : "Meerut",

"state" : "UP",

"zip" : "250002",

"location" : [

28.9926174,

77.692485

],

"fees" : 3500,

"tags" : [

"fully computerized"

],

"rating" : "4.5"

}

}

]

}

}Il existe d'autres types de requêtes au niveau du terme, telles que -

Exists query - Si un certain champ a une valeur non nulle.

Missing query - Ceci est complètement opposé à la requête existe, cette requête recherche des objets sans champs spécifiques ou des champs ayant une valeur nulle.

Wildcard or regexp query - Cette requête utilise des expressions régulières pour rechercher des modèles dans les objets.

Requêtes composées

Ces requêtes sont une collection de différentes requêtes fusionnées les unes avec les autres à l'aide d'opérateurs booléens tels que et, ou, pas ou pour différents index ou ayant des appels de fonction, etc.

POST /schools/_search

{

"query": {

"bool" : {

"must" : {

"term" : { "state" : "UP" }

},

"filter": {

"term" : { "fees" : "2200" }

},

"minimum_should_match" : 1,

"boost" : 1.0

}

}

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"took" : 6,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 0,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

}

}Requêtes géographiques

Ces requêtes concernent les emplacements géographiques et les points géographiques. Ces requêtes aident à trouver des écoles ou tout autre objet géographique à proximité de n'importe quel endroit. Vous devez utiliser le type de données de point géographique.

PUT /geo_example

{

"mappings": {

"properties": {

"location": {

"type": "geo_shape"

}

}

}

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{ "acknowledged" : true,

"shards_acknowledged" : true,

"index" : "geo_example"

}Maintenant, nous publions les données dans l'index créé ci-dessus.

POST /geo_example/_doc?refresh

{

"name": "Chapter One, London, UK",

"location": {

"type": "point",

"coordinates": [11.660544, 57.800286]

}

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"took" : 1,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : 1.0,

"hits" : [

"_index" : "geo_example",

"_type" : "_doc",

"_id" : "hASWZ2oBbkdGzVfiXHKD",

"_score" : 1.0,

"_source" : {

"name" : "Chapter One, London, UK",

"location" : {

"type" : "point",

"coordinates" : [

11.660544,

57.800286

]

}

}

}

}Le mappage est le contour des documents stockés dans un index. Il définit le type de données comme geo_point ou string et le format des champs présents dans les documents et les règles pour contrôler le mappage des champs ajoutés dynamiquement.

PUT bankaccountdetails

{

"mappings":{

"properties":{

"name": { "type":"text"}, "date":{ "type":"date"},

"balance":{ "type":"double"}, "liability":{ "type":"double"}

}

}

}Lorsque nous exécutons le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"acknowledged" : true,

"shards_acknowledged" : true,

"index" : "bankaccountdetails"

}Types de données de champ

Elasticsearch prend en charge un certain nombre de types de données différents pour les champs d'un document. Les types de données utilisés pour stocker les champs dans Elasticsearch sont décrits en détail ici.

Types de données de base

Ce sont les types de données de base tels que texte, mot-clé, date, long, double, booléen ou ip, qui sont pris en charge par presque tous les systèmes.

Types de données complexes

Ces types de données sont une combinaison de types de données de base. Ceux-ci incluent un tableau, un objet JSON et un type de données imbriqué. Un exemple de type de données imbriqué est présenté ci-dessous & moins

POST /tabletennis/_doc/1

{

"group" : "players",

"user" : [

{

"first" : "dave", "last" : "jones"

},

{

"first" : "kevin", "last" : "morris"

}

]

}Lorsque nous exécutons le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"_index" : "tabletennis",

"_type" : "_doc",

"_id" : "1",

_version" : 2,

"result" : "updated",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 1,

"_primary_term" : 1

}Un autre exemple de code est présenté ci-dessous -

POST /accountdetails/_doc/1

{

"from_acc":"7056443341", "to_acc":"7032460534",

"date":"11/1/2016", "amount":10000

}Lorsque nous exécutons le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{ "_index" : "accountdetails",

"_type" : "_doc",

"_id" : "1",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 1,

"_primary_term" : 1

}Nous pouvons vérifier le document ci-dessus en utilisant la commande suivante -

GET /accountdetails/_mappings?include_type_name=falseSuppression des types de mappage

Les indices créés dans Elasticsearch 7.0.0 ou version ultérieure n'acceptent plus un mappage _default_. Les indices créés dans 6.x continueront de fonctionner comme auparavant dans Elasticsearch 6.x. Les types sont obsolètes dans les API de la version 7.0.

Lorsqu'une requête est traitée lors d'une opération de recherche, le contenu de n'importe quel index est analysé par le module d'analyse. Ce module comprend un analyseur, un tokenizer, des tokenfilters et des charfilters. Si aucun analyseur n'est défini, les analyseurs, jetons, filtres et tokenizers intégrés sont par défaut enregistrés avec le module d'analyse.

Dans l'exemple suivant, nous utilisons un analyseur standard qui est utilisé lorsqu'aucun autre analyseur n'est spécifié. Il analysera la phrase en fonction de la grammaire et produira les mots utilisés dans la phrase.

POST _analyze

{

"analyzer": "standard",

"text": "Today's weather is beautiful"

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"tokens" : [

{

"token" : "today's",

"start_offset" : 0,

"end_offset" : 7,

"type" : "",

"position" : 0

},

{

"token" : "weather",

"start_offset" : 8,

"end_offset" : 15,

"type" : "",

"position" : 1

},

{

"token" : "is",

"start_offset" : 16,

"end_offset" : 18,

"type" : "",

"position" : 2

},

{

"token" : "beautiful",

"start_offset" : 19,

"end_offset" : 28,

"type" : "",

"position" : 3

}

]

}Configuration de l'analyseur standard

Nous pouvons configurer l'analyseur standard avec divers paramètres pour obtenir nos exigences personnalisées.

Dans l'exemple suivant, nous configurons l'analyseur standard pour avoir un max_token_length de 5.

Pour cela, nous créons d'abord un index avec l'analyseur ayant le paramètre max_length_token.

PUT index_4_analysis

{

"settings": {

"analysis": {

"analyzer": {

"my_english_analyzer": {

"type": "standard",

"max_token_length": 5,

"stopwords": "_english_"

}

}

}

}

}Ensuite, nous appliquons l'analyseur avec un texte comme indiqué ci-dessous. Veuillez noter que le jeton n'apparaît pas car il comporte deux espaces au début et deux espaces à la fin. Pour le mot «est», il y a un espace au début et un espace à la fin de celui-ci. En les prenant toutes, cela devient 4 lettres avec des espaces et cela n'en fait pas un mot. Il devrait y avoir un caractère non espace au moins au début ou à la fin, pour en faire un mot à compter.

POST index_4_analysis/_analyze

{

"analyzer": "my_english_analyzer",

"text": "Today's weather is beautiful"

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"tokens" : [

{

"token" : "today",

"start_offset" : 0,

"end_offset" : 5,

"type" : "",

"position" : 0

},

{

"token" : "s",

"start_offset" : 6,

"end_offset" : 7,

"type" : "",

"position" : 1

},

{

"token" : "weath",

"start_offset" : 8,

"end_offset" : 13,

"type" : "",

"position" : 2

},

{

"token" : "er",

"start_offset" : 13,

"end_offset" : 15,

"type" : "",

"position" : 3

},

{

"token" : "beaut",

"start_offset" : 19,

"end_offset" : 24,

"type" : "",

"position" : 5

},

{

"token" : "iful",

"start_offset" : 24,

"end_offset" : 28,

"type" : "",

"position" : 6

}

]

}La liste des différents analyseurs et leur description sont données dans le tableau ci-dessous -

| S. Non | Analyseur et description |

|---|---|

| 1 | Standard analyzer (standard) Les paramètres stopwords et max_token_length peuvent être définis pour cet analyseur. Par défaut, la liste des mots vides est vide et max_token_length vaut 255. |

| 2 | Simple analyzer (simple) Cet analyseur est composé de jetons minuscules. |

| 3 | Whitespace analyzer (whitespace) Cet analyseur est composé d'un tokenizer d'espace blanc. |

| 4 | Stop analyzer (stop) stopwords et stopwords_path peuvent être configurés. Par défaut, les mots vides initialisés aux mots vides anglais et stopwords_path contient le chemin vers un fichier texte avec des mots vides. |

Tokenizers

Les jetons sont utilisés pour générer des jetons à partir d'un texte dans Elasticsearch. Le texte peut être décomposé en jetons en tenant compte des espaces ou d'autres ponctuations. Elasticsearch dispose de nombreux jetons intégrés, qui peuvent être utilisés dans un analyseur personnalisé.

Un exemple de tokenizer qui décompose le texte en termes chaque fois qu'il rencontre un caractère qui n'est pas une lettre, mais qui minuscule également tous les termes, est illustré ci-dessous

POST _analyze

{

"tokenizer": "lowercase",

"text": "It Was a Beautiful Weather 5 Days ago."

}En exécutant le code ci-dessus, nous obtenons la réponse comme indiqué ci-dessous -

{

"tokens" : [

{

"token" : "it",

"start_offset" : 0,

"end_offset" : 2,

"type" : "word",

"position" : 0

},

{

"token" : "was",

"start_offset" : 3,

"end_offset" : 6,

"type" : "word",

"position" : 1

},

{

"token" : "a",

"start_offset" : 7,

"end_offset" : 8,

"type" : "word",

"position" : 2

},

{

"token" : "beautiful",

"start_offset" : 9,

"end_offset" : 18,

"type" : "word",

"position" : 3

},

{

"token" : "weather",

"start_offset" : 19,

"end_offset" : 26,

"type" : "word",

"position" : 4

},

{

"token" : "days",

"start_offset" : 29,

"end_offset" : 33,

"type" : "word",

"position" : 5

},

{

"token" : "ago",

"start_offset" : 34,

"end_offset" : 37,

"type" : "word",

"position" : 6

}

]

}Une liste des Tokenizers et leurs descriptions sont présentées ici dans le tableau ci-dessous -

| S. Non | Tokenizer et description |

|---|---|

| 1 | Standard tokenizer (standard) Ceci est construit sur un tokenizer basé sur la grammaire et max_token_length peut être configuré pour ce tokenizer. |

| 2 | Edge NGram tokenizer (edgeNGram) Des paramètres tels que min_gram, max_gram, token_chars peuvent être définis pour ce tokenizer. |

| 3 | Keyword tokenizer (keyword) Cela génère une entrée entière en tant que sortie et buffer_size peut être défini pour cela. |

| 4 | Letter tokenizer (letter) Cela capture le mot entier jusqu'à ce qu'une non-lettre soit rencontrée. |

Elasticsearch est composé d'un certain nombre de modules, qui sont responsables de sa fonctionnalité. Ces modules ont deux types de paramètres comme suit -

Static Settings- Ces paramètres doivent être configurés dans le fichier config (elasticsearch.yml) avant de démarrer Elasticsearch. Vous devez mettre à jour tous les nœuds de préoccupation du cluster pour refléter les modifications apportées par ces paramètres.

Dynamic Settings - Ces paramètres peuvent être définis sur Elasticsearch en direct.

Nous aborderons les différents modules d'Elasticsearch dans les sections suivantes de ce chapitre.

Routage au niveau du cluster et allocation de fragments

Les paramètres au niveau du cluster décident de l'allocation des fragments à différents nœuds et de la réallocation des fragments pour rééquilibrer le cluster. Voici les paramètres suivants pour contrôler l'allocation des partitions.

Allocation de fragments au niveau du cluster

| Réglage | Valeur possible | La description |

|---|---|---|

| cluster.routing.allocation.enable | ||

| tout | Cette valeur par défaut autorise l'allocation de partitions pour tous les types de partitions. | |

| primaires | Cela autorise l'allocation de partitions uniquement pour les partitions principales. | |

| new_primaries | Cela permet l'allocation de fragments uniquement pour les fragments primaires pour les nouveaux indices. | |

| aucun | Cela n'autorise aucune allocation de partition. | |