Microsoft संज्ञानात्मक टूलकिट - त्वरित गाइड

इस अध्याय में, हम सीखेंगे कि CNTK क्या है, इसकी विशेषताएं, इसके संस्करण 1.0 और 2.0 के बीच अंतर और संस्करण 2.7 के महत्वपूर्ण हाइलाइट्स।

Microsoft संज्ञानात्मक टूलकिट (CNTK) क्या है?

Microsoft संज्ञानात्मक टूलकिट (CNTK), जिसे पहले कम्प्यूटेशनल नेटवर्क टूलकिट के रूप में जाना जाता है, एक स्वतंत्र, आसान-उपयोग, ओपन-सोर्स, वाणिज्यिक-ग्रेड टूलकिट है जो हमें मानव मस्तिष्क की तरह सीखने के लिए गहन शिक्षण एल्गोरिदम को प्रशिक्षित करने में सक्षम बनाता है। यह हमें कुछ लोकप्रिय गहरी सीखने की प्रणाली बनाने में सक्षम बनाता हैfeed-forward neural network time series prediction systems and Convolutional neural network (CNN) image classifiers।

इष्टतम प्रदर्शन के लिए, इसकी रूपरेखा कार्य C ++ में लिखे गए हैं। हालाँकि हम इसके फ़ंक्शन को C ++ का उपयोग करके कॉल कर सकते हैं, लेकिन उसी के लिए सबसे अधिक उपयोग किया जाने वाला दृष्टिकोण पायथन प्रोग्राम का उपयोग करना है।

CNTK की विशेषताएं

Microsoft CNTK के नवीनतम संस्करण में दी गई कुछ विशेषताएं और क्षमताएं निम्नलिखित हैं:

निर्मित घटकों

CNTK में अत्यधिक अनुकूलित अंतर्निर्मित घटक हैं जो पायथन, C ++ या ब्रेनस्क्रिप्ट से बहुआयामी घने या विरल डेटा को संभाल सकते हैं।

हम CNN, FNN, RNN, बैच सामान्यीकरण और अनुक्रम-से-अनुक्रम को ध्यान से लागू कर सकते हैं।

यह पायथन से GPU पर नए उपयोगकर्ता-परिभाषित कोर-घटकों को जोड़ने के लिए हमें कार्यक्षमता प्रदान करता है।

यह स्वचालित हाइपरपैरेट ट्यूनिंग भी प्रदान करता है।

हम रेनफोर्समेंट लर्निंग, जनरेटिव एडवरसरील नेटवर्क्स (GANs), सुपरवाइज्ड और साथ ही अनसुपरविंड लर्निंग को लागू कर सकते हैं।

बड़े डेटासेट के लिए, CNTK में बिल्ट-इन ऑप्टिमाइज़्ड रीडर्स हैं।

संसाधनों का कुशलता से उपयोग

CNTK हमें 1-बिट SGD के माध्यम से कई GPU / मशीनों पर उच्च सटीकता के साथ समानता प्रदान करता है।

GPU मेमोरी में सबसे बड़े मॉडल को फिट करने के लिए, यह मेमोरी शेयरिंग और अन्य अंतर्निहित तरीके प्रदान करता है।

हमारे अपने नेटवर्क को आसानी से व्यक्त करें

CNTK के पास आपके अपने नेटवर्क, शिक्षार्थियों, पाठकों, प्रशिक्षण और पायथन, C ++ और ब्रेनस्क्रिप्ट से मूल्यांकन को परिभाषित करने के लिए पूर्ण API हैं।

CNTK का उपयोग करके, हम आसानी से पायथन, C ++, C # या ब्रेनस्क्रिप्ट वाले मॉडल का मूल्यांकन कर सकते हैं।

यह उच्च-स्तर के साथ-साथ निम्न-स्तर के एपीआई प्रदान करता है।

हमारे डेटा के आधार पर, यह स्वतः ही अनुमान को आकार दे सकता है।

इसने प्रतीकात्मक रूप से प्रतीकात्मक आवर्तक तंत्रिका नेटवर्क (RNN) छोरों को अनुकूलित किया है।

मापने मॉडल प्रदर्शन

CNTK आपके द्वारा बनाए गए तंत्रिका नेटवर्क के प्रदर्शन को मापने के लिए विभिन्न घटक प्रदान करता है।

आपके मॉडल और संबद्ध ऑप्टिमाइज़र से लॉग डेटा उत्पन्न करता है, जिसका उपयोग हम प्रशिक्षण प्रक्रिया की निगरानी के लिए कर सकते हैं।

संस्करण 1.0 बनाम संस्करण 2.0

निम्न तालिका CNTK संस्करण 1.0 और 2.0 की तुलना करती है:

| संस्करण 1.0 | संस्करण 2.0 |

|---|---|

| यह 2016 में रिलीज़ हुई थी। | यह 1.0 संस्करण का एक महत्वपूर्ण पुनर्लेखन है और जून 2017 में जारी किया गया था। |

| इसने ब्रेनस्क्रिप्ट नामक एक स्वामित्व स्क्रिप्टिंग भाषा का उपयोग किया। | इसकी रूपरेखा कार्यों को C ++, पायथन का उपयोग करके बुलाया जा सकता है। हम अपने मॉड्यूल को C # या Java में आसानी से लोड कर सकते हैं। ब्रेनस्क्रिप्ट भी संस्करण 2.0 द्वारा समर्थित है। |

| यह विंडोज और लिनक्स सिस्टम दोनों पर चलता है लेकिन सीधे मैक ओएस पर नहीं। | यह विंडोज (विन 8.1, विन 10, सर्वर 2012 आर 2 और बाद में) और लिनक्स सिस्टम दोनों पर चलता है लेकिन सीधे मैक ओएस पर नहीं। |

संस्करण 2.7 के महत्वपूर्ण हाइलाइट्स

Version 2.7Microsoft संज्ञानात्मक टूलकिट का अंतिम मुख्य रिलीज़ किया गया संस्करण है। इसमें ONNX 1.4.1 का पूरा सपोर्ट है। CNTK के इस अंतिम रिलीज़ किए गए संस्करण के कुछ महत्वपूर्ण आकर्षण निम्नलिखित हैं।

ONNX 1.4.1 के लिए पूर्ण समर्थन।

विंडोज और लिनक्स सिस्टम दोनों के लिए CUDA 10 के लिए समर्थन।

यह ONNX निर्यात में अग्रिम आवर्तक तंत्रिका नेटवर्क (RNN) लूप का समर्थन करता है।

यह ONNX प्रारूप में 2GB से अधिक मॉडल निर्यात कर सकता है।

यह ब्रेनस्क्रिप्ट स्क्रिप्टिंग भाषा की प्रशिक्षण कार्रवाई में FP16 का समर्थन करता है।

यहां, हम विंडोज और लिनक्स पर CNTK की स्थापना के बारे में समझेंगे। इसके अलावा, अध्याय CNTK पैकेज, एनाकोंडा, CNTK फ़ाइलें, निर्देशिका संरचना और CNTK लाइब्रेरी संगठन स्थापित करने के लिए चरण स्थापित करने के बारे में बताता है।

आवश्यक शर्तें

CNTK को स्थापित करने के लिए, हमें अपने कंप्यूटर पर पायथन स्थापित करना चाहिए। आप लिंक पर जा सकते हैंhttps://www.python.org/downloads/और अपने OS, यानी विंडोज और लिनक्स / यूनिक्स के लिए नवीनतम संस्करण का चयन करें। पायथन पर बुनियादी ट्यूटोरियल के लिए, आप लिंक का उल्लेख कर सकते हैंhttps://www.tutorialspoint.com/python3/index.htm।

CNTK को विंडोज के साथ-साथ लिनक्स के लिए भी सपोर्ट किया जाता है ताकि हम उन दोनों से चलें।

विंडोज पर इंस्टॉल करना

विंडोज पर CNTK चलाने के लिए, हम इसका उपयोग करेंगे Anaconda versionअजगर का। हम जानते हैं कि, एनाकोंडा पायथन का पुनर्वितरण है। इसमें अतिरिक्त पैकेज जैसे शामिल हैंScipy तथाScikit-learn जिसका उपयोग CNTK द्वारा विभिन्न उपयोगी गणना करने के लिए किया जाता है।

तो, पहले अपनी मशीन पर एनाकोंडा स्थापित करने के चरण देखें -

Step 1.फर्स्ट सेटअप को पब्लिक वेबसाइट से डाउनलोड करें https://www.anaconda.com/distribution/।

Step 2 - सेटअप फ़ाइलें डाउनलोड करने के बाद, इंस्टॉलेशन शुरू करें और लिंक से निर्देशों का पालन करें https://docs.anaconda.com/anaconda/install/।

Step 3- एक बार स्थापित होने के बाद, एनाकोंडा कुछ अन्य उपयोगिताओं को भी स्थापित करेगा, जो स्वचालित रूप से आपके कंप्यूटर पैटियन चर में सभी एनाकोंडा निष्पादन योग्य शामिल करेगा। हम इस संकेत से अपने पायथन पर्यावरण को प्रबंधित कर सकते हैं, पैकेज स्थापित कर सकते हैं और पायथन स्क्रिप्ट चला सकते हैं।

CNTK पैकेज स्थापित करना

एक बार एनाकोंडा इंस्टालेशन हो जाने के बाद, आप निम्नलिखित कार्य का उपयोग करके पाइप निष्पादन योग्य के माध्यम से CNTK पैकेज को स्थापित करने के लिए सबसे सामान्य तरीके का उपयोग कर सकते हैं।

pip install cntkआपकी मशीन पर कॉग्निटिव टूलकिट स्थापित करने के लिए कई अन्य तरीके हैं। Microsoft के पास दस्तावेज़ का एक साफ सेट है जो अन्य स्थापना विधियों के बारे में विस्तार से बताता है। कृपया लिंक का अनुसरण करेंhttps://docs.microsoft.com/en-us/cognitive-toolkit/Setup-CNTK-on-your-machine।

लिनक्स पर स्थापित करना

लिनक्स पर CNTK की स्थापना विंडोज पर इसकी स्थापना से थोड़ी अलग है। यहां, लिनक्स के लिए हम CNTK को स्थापित करने के लिए एनाकोंडा का उपयोग करने जा रहे हैं, लेकिन एनाकोंडा के लिए ग्राफिकल इंस्टॉलर के बजाय, हम लिनक्स पर टर्मिनल-आधारित इंस्टॉलर का उपयोग करेंगे। यद्यपि, इंस्टॉलर लगभग सभी लिनक्स वितरणों के साथ काम करेगा, हमने विवरण को उबंटू तक सीमित कर दिया।

तो, पहले अपनी मशीन पर एनाकोंडा स्थापित करने के चरण देखें -

एनाकोंडा स्थापित करने के लिए कदम

Step 1- एनाकोंडा स्थापित करने से पहले, सुनिश्चित करें कि सिस्टम पूरी तरह से अद्यतित है। जाँच करने के लिए, पहले एक टर्मिनल के अंदर निम्नलिखित दो कमांड निष्पादित करें -

sudo apt update

sudo apt upgradeStep 2 - कंप्यूटर अपडेट होने के बाद, सार्वजनिक वेबसाइट से URL प्राप्त करें https://www.anaconda.com/distribution/ नवीनतम एनाकोंडा स्थापना फ़ाइलों के लिए।

Step 3 - URL की कॉपी हो जाने के बाद, एक टर्मिनल विंडो खोलें और निम्नलिखित कमांड निष्पादित करें -

wget -0 anaconda-installer.sh url SHAPE \* MERGEFORMAT

y

f

x

| }बदलो url एनाकोंडा वेबसाइट से कॉपी किए गए यूआरएल के साथ प्लेसहोल्डर।

Step 4 - अगला, निम्नलिखित कमांड की सहायता से, हम एनाकोंडा स्थापित कर सकते हैं -

sh ./anaconda-installer.shउपरोक्त आदेश डिफ़ॉल्ट रूप से स्थापित होगा Anaconda3 हमारे घर निर्देशिका के अंदर।

CNTK पैकेज स्थापित करना

एक बार एनाकोंडा इंस्टालेशन हो जाने के बाद, आप निम्नलिखित कार्य का उपयोग करके पाइप निष्पादन योग्य के माध्यम से CNTK पैकेज को स्थापित करने के लिए सबसे सामान्य तरीके का उपयोग कर सकते हैं।

pip install cntkCNTK फ़ाइलों और निर्देशिका संरचना की जाँच करना

एक बार जब CNTK पायथन पैकेज के रूप में स्थापित हो जाता है, तो हम इसकी फ़ाइल और निर्देशिका संरचना की जांच कर सकते हैं। यह पर हैC:\Users\

CNTK स्थापना का सत्यापन

एक बार CNTK पायथन पैकेज के रूप में स्थापित हो जाने के बाद, आपको यह सत्यापित करना चाहिए कि CNTK को सही तरीके से स्थापित किया गया है। एनाकोंडा कमांड शेल से, प्रवेश करके पायथन इंटरप्रेटर शुरू करेंipython. फिर, आयात करें CNTK निम्नलिखित कमांड दर्ज करके।

import cntk as cआयात करने के बाद, निम्न कमांड की मदद से इसके संस्करण की जाँच करें -

print(c.__version__)दुभाषिया स्थापित CNTK संस्करण के साथ प्रतिक्रिया करेगा। यदि यह प्रतिक्रिया नहीं करता है, तो स्थापना के साथ एक समस्या होगी।

CNTK पुस्तकालय संगठन

तकनीकी रूप से एक अजगर पैकेज CNTK, 13 उच्च-स्तरीय उप-संकुल और 8 छोटे उप-संकुल में आयोजित किया जाता है। निम्न तालिका में 10 सबसे अधिक उपयोग किए जाने वाले पैकेज शामिल हैं:

| अनु क्रमांक | पैकेज का नाम और विवरण |

|---|---|

| 1 | cntk.io डेटा पढ़ने के लिए कार्य करता है। उदाहरण के लिए: next_minibatch () |

| 2 | cntk.layers तंत्रिका नेटवर्क बनाने के लिए उच्च-स्तरीय फ़ंक्शन शामिल हैं। उदाहरण के लिए: घना () |

| 3 | cntk.learners प्रशिक्षण के लिए कार्य शामिल हैं। उदाहरण के लिए: sgd () |

| 4 | cntk.losses प्रशिक्षण त्रुटि को मापने के लिए कार्य करता है। उदाहरण के लिए: squared_error () |

| 5 | cntk.metrics मॉडल त्रुटि को मापने के लिए कार्य करता है। उदाहरण के लिए: classificatoin_error |

| 6 | cntk.ops तंत्रिका नेटवर्क बनाने के लिए निम्न-स्तरीय फ़ंक्शन शामिल हैं। उदाहरण के लिए: तनह () |

| 7 | cntk.random यादृच्छिक संख्या उत्पन्न करने के लिए कार्य करता है। उदाहरण के लिए: सामान्य () |

| 8 | cntk.train प्रशिक्षण कार्य शामिल हैं। उदाहरण के लिए: train_minibatch () |

| 9 | cntk.initializer मॉडल पैरामीटर इनिशियलाइज़र शामिल हैं। उदाहरण के लिए: सामान्य () और वर्दी () |

| 10 | cntk.variables निम्न-स्तरीय निर्माण शामिल हैं। उदाहरण के लिए: पैरामीटर () और चर () |

माइक्रोसॉफ्ट कॉग्निटिव टूलकिट दो अलग-अलग बिल्ड वर्जन अर्थात् CPU-only और GPU-only प्रदान करता है।

सीपीयू केवल संस्करण का निर्माण करता है

CNTK का CPU-केवल बिल्ड संस्करण अनुकूलित Intel MKLML का उपयोग करता है, जहाँ MKLML MKL (मैथ कर्नेल लाइब्रेरी) का सबसेट है और Intel MKL-DNN के साथ MKL-DNN के लिए Intel MKL के समाप्त संस्करण के रूप में जारी किया गया है।

GPU केवल संस्करण का निर्माण करता है

दूसरी ओर, CNTK का GPU-only बिल्ड संस्करण अत्यधिक अनुकूलित NVIDIA पुस्तकालयों का उपयोग करता है CUB तथा cuDNN। यह कई GPU और कई मशीनों में वितरित प्रशिक्षण का समर्थन करता है। CNTK में तेजी से वितरित प्रशिक्षण के लिए, GPU- बिल्ड संस्करण भी शामिल है -

MSR-विकसित 1bit-quantized SGD।

ब्लॉक-गति डब्ल्यूडीएम समानांतर प्रशिक्षण एल्गोरिदम।

Windows पर CNTK के साथ GPU सक्षम करना

पिछले अनुभाग में, हमने देखा कि सीपीयू के साथ उपयोग करने के लिए CNTK के मूल संस्करण को कैसे स्थापित किया जाए। अब चर्चा करते हैं कि हम GPU के साथ उपयोग करने के लिए CNTK कैसे स्थापित कर सकते हैं। लेकिन, इसमें गहरी डुबकी लगाने से पहले, आपके पास एक समर्थित ग्राफिक्स कार्ड होना चाहिए।

वर्तमान में, CNTK कम से कम CUDA 3.0 समर्थन के साथ NVIDIA ग्राफिक्स कार्ड का समर्थन करता है। यह सुनिश्चित करने के लिए, आप देख सकते हैंhttps://developer.nvidia.com/cuda-gpus क्या आपका GPU CUDA का समर्थन करता है।

तो, हमें विंडोज ओएस पर CNTK के साथ GPU को सक्षम करने के लिए चरण देखें -

Step 1 - आपके द्वारा उपयोग किए जा रहे ग्राफिक्स कार्ड के आधार पर, सबसे पहले आपको अपने ग्राफिक्स कार्ड के लिए नवीनतम GeForce या Quadro ड्राइवरों की आवश्यकता होगी।

Step 2 - जब आप ड्राइवरों को डाउनलोड करते हैं, तो आपको NVIDIA वेबसाइट से विंडोज के लिए CUDA टूलकिट संस्करण 9.0 स्थापित करने की आवश्यकता होती है https://developer.nvidia.com/cuda-90-download-archive?target_os=Windows&target_arch=x86_64। इंस्टॉल करने के बाद, इंस्टॉलर चलाएं और निर्देशों का पालन करें।

Step 3 - इसके बाद, आपको NVIDIA वेबसाइट से cuDNN बायनेरी स्थापित करने की आवश्यकता है https://developer.nvidia.com/rdp/form/cudnn-download-survey। CUDA 9.0 संस्करण के साथ, cuDNN 7.4.1 अच्छी तरह से काम करता है। मूलतः, cuDNN CUDA के शीर्ष पर एक परत है, जिसका उपयोग CNTK द्वारा किया जाता है।

Step 4 - cuDNN बायनेरिज़ को डाउनलोड करने के बाद, आपको ज़िप फ़ाइल को अपने CUDA टूलकिट इंस्टॉलेशन के रूट फ़ोल्डर में निकालने की आवश्यकता है।

Step 5- यह अंतिम चरण है जो CNTK के अंदर GPU उपयोग को सक्षम करेगा। विंडोज ओएस पर एनाकोंडा प्रॉम्प्ट के अंदर निम्नलिखित कमांड निष्पादित करें -

pip install cntk-gpuलिनक्स पर CNTK के साथ GPU सक्षम करना

आइए देखें कि हम लिनक्स ओएस पर CNTK के साथ GPU कैसे सक्षम कर सकते हैं -

CUDA टूलकिट डाउनलोड करना

सबसे पहले, आपको CUDA टूलकिट को NVIDIA की वेबसाइट https://developer.nvidia.com/cuda-90-download-archive?target_os=Linux&target_arch=x86_64&tar_distro=Ubuntu&target_version=1604&target_type = runfel = से इंस्टॉल करना होगा ।

इंस्टॉलर चलाना

अब, जब आप डिस्क पर बायनेरिज़ रखते हैं, तो टर्मिनल खोलकर इंस्टॉलर चलाएं और निम्न कमांड और स्क्रीन पर दिए गए निर्देश को निष्पादित करें -

sh cuda_9.0.176_384.81_linux-runबैश प्रोफाइल स्क्रिप्ट को संशोधित करें

अपने लिनक्स मशीन पर CUDA टूलकिट स्थापित करने के बाद, आपको BASH प्रोफ़ाइल स्क्रिप्ट को संशोधित करना होगा। इसके लिए, पहले टेक्स्ट एडिटर में $ HOME / .bashrc फ़ाइल खोलें। अब, स्क्रिप्ट के अंत में, निम्नलिखित पंक्तियाँ शामिल करें -

export PATH=/usr/local/cuda-9.0/bin${PATH:+:${PATH}} export LD_LIBRARY_PATH=/usr/local/cuda-9.0/lib64\ ${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}

InstallingCuDNN लाइब्रेरी स्थापित करना

अंत में हमें cuDNN बायनेरिज़ को स्थापित करने की आवश्यकता है। इसे NVIDIA की वेबसाइट से डाउनलोड किया जा सकता हैhttps://developer.nvidia.com/rdp/form/cudnn-download-survey। CUDA 9.0 संस्करण के साथ, cuDNN 7.4.1 अच्छी तरह से काम करता है। मूलतः, cuDNN CUDA के शीर्ष पर एक परत है, जिसका उपयोग CNTK द्वारा किया जाता है।

एक बार लिनक्स के लिए संस्करण को डाउनलोड करने के बाद, इसे निकालें /usr/local/cuda-9.0 निम्नलिखित कमांड का उपयोग करके फ़ोल्डर -

tar xvzf -C /usr/local/cuda-9.0/ cudnn-9.0-linux-x64-v7.4.1.5.tgzआवश्यकतानुसार फ़ाइल नाम का पथ बदलें।

इस अध्याय में, हम CNTK और उसके वर्गीकरण के क्रमों के बारे में विस्तार से जानेंगे।

tensors

जिस अवधारणा पर CNTK काम करता है tensor। मूल रूप से, CNTK निविष्टियाँ, आउटपुट और साथ ही मापदंडों को व्यवस्थित किया जाता हैtensors, जिसे अक्सर सामान्यीकृत मैट्रिक्स के रूप में सोचा जाता है। हर टेनर एक हैrank -

रैंक 0 का टेंसर एक अदिश राशि है।

रैंक 1 का टेंसर एक वेक्टर है।

रैंक 2 का टेंसर अमेट्रिक्स है।

यहाँ, इन विभिन्न आयामों को संदर्भित किया गया है axes.

स्थैतिक कुल्हाड़ियों और गतिशील कुल्हाड़ियों

जैसा कि नाम से पता चलता है, पूरे नेटवर्क में स्थिर अक्षों की लंबाई समान होती है। दूसरी ओर, गतिशील कुल्हाड़ियों की लंबाई उदाहरण के लिए अलग-अलग हो सकती है। वास्तव में, उनकी लंबाई आमतौर पर प्रत्येक मिनीबैच प्रस्तुत किए जाने से पहले ज्ञात नहीं होती है।

डायनेमिक ऐक्सिस स्टैटिक ऐक्स की तरह होते हैं क्योंकि वे टेंसर में निहित संख्याओं के सार्थक समूहन को भी परिभाषित करते हैं।

उदाहरण

इसे स्पष्ट करने के लिए, आइए देखें कि CNTK में लघु वीडियो क्लिप का एक छोटा भाग कैसे दिखाया जाता है। मान लीजिए कि वीडियो क्लिप का रिज़ॉल्यूशन सभी 640 * 480 है। और, क्लिप को रंग में भी शूट किया जाता है, जो आमतौर पर तीन चैनलों के साथ एन्कोडेड होता है। यह आगे का मतलब है कि हमारे मिनीबैच में निम्नलिखित हैं -

लंबाई 640, 480 और 3 की 3 स्थिर कुल्हाड़ियों क्रमशः।

दो गतिशील कुल्हाड़ियों; वीडियो की लंबाई और मिनीबैच कुल्हाड़ियों।

इसका मतलब है कि अगर एक मिनीबैच में 16 वीडियो हैं, जिनमें से प्रत्येक 240 फ्रेम लंबा है, तो इसका प्रतिनिधित्व किया जाएगा 16*240*3*640*480 tensors।

CNTK में दृश्यों के साथ काम करना

हमें लोंग-शॉर्ट टर्म मेमोरी नेटवर्क के बारे में पहले सीखकर CNTK में अनुक्रम को समझें।

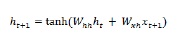

लॉन्ग-शॉर्ट टर्म मेमोरी नेटवर्क (LSTM)

Hochreiter & Schmidhuber द्वारा दीर्घकालिक-अल्पकालिक मेमोरी (LSTM) नेटवर्क पेश किए गए थे। इसने चीजों को लंबे समय तक याद रखने के लिए एक मूल आवर्तक परत प्राप्त करने की समस्या को हल किया। LSTM की वास्तुकला चित्र में ऊपर दी गई है। जैसा कि हम देख सकते हैं कि इसमें इनपुट न्यूरॉन्स, मेमोरी सेल्स और आउटपुट न्यूरॉन्स हैं। लुप्त होती क्रमिक समस्या से निपटने के लिए, दीर्घकालिक अल्पकालिक मेमोरी नेटवर्क एक स्पष्ट मेमोरी सेल (पिछले मूल्यों को संग्रहीत करता है) और निम्न गेट्स का उपयोग करता है -

Forget gate- जैसा कि नाम से ही स्पष्ट है कि यह मेमोरी सेल को पिछले मूल्यों को भूल जाने के लिए कहता है। मेमोरी सेल मानों को तब तक स्टोर करता है जब तक कि गेट 'गेट गेट' उन्हें भूल जाने के लिए नहीं कहता है।

Input gate - जैसा कि नाम से ही स्पष्ट है, यह सेल में नया सामान जोड़ता है।

Output gate - जैसा कि नाम से पता चलता है, आउटपुट गेट तय करता है कि सेल से वैक्टर के साथ अगले छिपे हुए राज्य में कब जाया जाए।

CNTK में दृश्यों के साथ काम करना बहुत आसान है। आइए इसे निम्न उदाहरण की मदद से देखते हैं -

import sys

import os

from cntk import Trainer, Axis

from cntk.io import MinibatchSource, CTFDeserializer, StreamDef, StreamDefs,\

INFINITELY_REPEAT

from cntk.learners import sgd, learning_parameter_schedule_per_sample

from cntk import input_variable, cross_entropy_with_softmax, \

classification_error, sequence

from cntk.logging import ProgressPrinter

from cntk.layers import Sequential, Embedding, Recurrence, LSTM, Dense

def create_reader(path, is_training, input_dim, label_dim):

return MinibatchSource(CTFDeserializer(path, StreamDefs(

features=StreamDef(field='x', shape=input_dim, is_sparse=True),

labels=StreamDef(field='y', shape=label_dim, is_sparse=False)

)), randomize=is_training,

max_sweeps=INFINITELY_REPEAT if is_training else 1)

def LSTM_sequence_classifier_net(input, num_output_classes, embedding_dim,

LSTM_dim, cell_dim):

lstm_classifier = Sequential([Embedding(embedding_dim),

Recurrence(LSTM(LSTM_dim, cell_dim)),

sequence.last,

Dense(num_output_classes)])

return lstm_classifier(input)

def train_sequence_classifier():

input_dim = 2000

cell_dim = 25

hidden_dim = 25

embedding_dim = 50

num_output_classes = 5

features = sequence.input_variable(shape=input_dim, is_sparse=True)

label = input_variable(num_output_classes)

classifier_output = LSTM_sequence_classifier_net(

features, num_output_classes, embedding_dim, hidden_dim, cell_dim)

ce = cross_entropy_with_softmax(classifier_output, label)

pe = classification_error(classifier_output, label)

rel_path = ("../../../Tests/EndToEndTests/Text/" +

"SequenceClassification/Data/Train.ctf")

path = os.path.join(os.path.dirname(os.path.abspath(__file__)), rel_path)

reader = create_reader(path, True, input_dim, num_output_classes)

input_map = {

features: reader.streams.features,

label: reader.streams.labels

}

lr_per_sample = learning_parameter_schedule_per_sample(0.0005)

progress_printer = ProgressPrinter(0)

trainer = Trainer(classifier_output, (ce, pe),

sgd(classifier_output.parameters, lr=lr_per_sample),progress_printer)

minibatch_size = 200

for i in range(255):

mb = reader.next_minibatch(minibatch_size, input_map=input_map)

trainer.train_minibatch(mb)

evaluation_average = float(trainer.previous_minibatch_evaluation_average)

loss_average = float(trainer.previous_minibatch_loss_average)

return evaluation_average, loss_average

if __name__ == '__main__':

error, _ = train_sequence_classifier()

print(" error: %f" % error)average since average since examples

loss last metric last

------------------------------------------------------

1.61 1.61 0.886 0.886 44

1.61 1.6 0.714 0.629 133

1.6 1.59 0.56 0.448 316

1.57 1.55 0.479 0.41 682

1.53 1.5 0.464 0.449 1379

1.46 1.4 0.453 0.441 2813

1.37 1.28 0.45 0.447 5679

1.3 1.23 0.448 0.447 11365

error: 0.333333उपरोक्त कार्यक्रम का विस्तृत विवरण अगले खंडों में कवर किया जाएगा, खासकर जब हम रिकरंट न्यूरल नेटवर्क का निर्माण करेंगे।

यह अध्याय CNTK में एक लॉजिस्टिक रिग्रेशन मॉडल के निर्माण से संबंधित है।

लॉजिस्टिक रिग्रेशन मॉडल की मूल बातें

लॉजिस्टिक रिग्रेशन, सबसे सरल एमएल तकनीकों में से एक, विशेष रूप से बाइनरी वर्गीकरण के लिए एक तकनीक है। दूसरे शब्दों में, ऐसी परिस्थितियों में एक भविष्यवाणी मॉडल बनाना जहां भविष्यवाणी करने के लिए चर का मूल्य सिर्फ दो स्पष्ट मूल्यों में से एक हो सकता है। लॉजिस्टिक रिग्रेशन का सबसे सरल उदाहरण यह अनुमान लगाना है कि क्या व्यक्ति पुरुष या महिला है, जो व्यक्ति की उम्र, आवाज, बाल और इसी तरह पर आधारित है।

उदाहरण

आइए एक और उदाहरण की मदद से गणितीय रूप से लॉजिस्टिक रिग्रेशन की अवधारणा को समझते हैं -

मान लीजिए, हम एक ऋण आवेदन की क्रेडिट योग्यता की भविष्यवाणी करना चाहते हैं; आवेदक के आधार पर 0 का अर्थ है अस्वीकार, और 1 का अर्थ है अनुमोदनdebt , income तथा credit rating। हम एक्स 1 के साथ ऋण, एक्स 2 के साथ आय और एक्स 3 के साथ क्रेडिट रेटिंग का प्रतिनिधित्व करते हैं।

लॉजिस्टिक रिग्रेशन में, हम एक वेट वैल्यू निर्धारित करते हैं, जिसका प्रतिनिधित्व करते हैं wप्रत्येक सुविधा के लिए और एक एकल पूर्वाग्रह मान के लिए, द्वारा प्रतिनिधित्व किया b।

अब मान लीजिए,

X1 = 3.0

X2 = -2.0

X3 = 1.0और मान लें कि हम वजन और पूर्वाग्रह निर्धारित करते हैं -

W1 = 0.65, W2 = 1.75, W3 = 2.05 and b = 0.33अब, कक्षा की भविष्यवाणी करने के लिए, हमें निम्नलिखित सूत्र को लागू करना होगा -

Z = (X1*W1)+(X2*W2)+(X3+W3)+b

i.e. Z = (3.0)*(0.65) + (-2.0)*(1.75) + (1.0)*(2.05) + 0.33

= 0.83अगला, हमें गणना करने की आवश्यकता है P = 1.0/(1.0 + exp(-Z))। यहां, एक्सप () फ़ंक्शन यूलर का नंबर है।

P = 1.0/(1.0 + exp(-0.83)

= 0.6963P मान की व्याख्या इस संभावना के रूप में की जा सकती है कि वर्ग १ है। यदि P <०.५ है, तो वर्ग कक्षा है = ० या फिर भविष्यवाणी (P> = ०.५) वर्ग = १ है।

वजन और पूर्वाग्रह के मूल्यों को निर्धारित करने के लिए, हमें ज्ञात इनपुट भविष्यवक्ता मूल्यों और ज्ञात सही वर्ग लेबल मूल्यों वाले प्रशिक्षण डेटा का एक सेट प्राप्त करना होगा। उसके बाद, हम वज़न और पूर्वाग्रह के मूल्यों को खोजने के लिए एक एल्गोरिथ्म, आमतौर पर ग्रेडिएंट डिसेंट का उपयोग कर सकते हैं।

LR मॉडल कार्यान्वयन उदाहरण

इस LR मॉडल के लिए, हम निम्नलिखित डेटा सेट का उपयोग करने जा रहे हैं -

1.0, 2.0, 0

3.0, 4.0, 0

5.0, 2.0, 0

6.0, 3.0, 0

8.0, 1.0, 0

9.0, 2.0, 0

1.0, 4.0, 1

2.0, 5.0, 1

4.0, 6.0, 1

6.0, 5.0, 1

7.0, 3.0, 1

8.0, 5.0, 1CNTK में इस LR मॉडल कार्यान्वयन को शुरू करने के लिए, हमें पहले निम्नलिखित पैकेजों को आयात करना होगा -

import numpy as np

import cntk as Cकार्यक्रम मुख्य () फ़ंक्शन के साथ संरचित है -

def main():

print("Using CNTK version = " + str(C.__version__) + "\n")अब, हमें प्रशिक्षण डेटा को मेमोरी में लोड करने की आवश्यकता है -

data_file = ".\\dataLRmodel.txt"

print("Loading data from " + data_file + "\n")

features_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",", skiprows=0, usecols=[0,1])

labels_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",", skiprows=0, usecols=[2], ndmin=2)अब, हम एक प्रशिक्षण कार्यक्रम बनाएंगे जो एक लॉजिस्टिक रिग्रेशन मॉडल तैयार करेगा जो प्रशिक्षण डेटा के साथ संगत है -

features_dim = 2

labels_dim = 1

X = C.ops.input_variable(features_dim, np.float32)

y = C.input_variable(labels_dim, np.float32)

W = C.parameter(shape=(features_dim, 1)) # trainable cntk.Parameter

b = C.parameter(shape=(labels_dim))

z = C.times(X, W) + b

p = 1.0 / (1.0 + C.exp(-z))

model = pअब, हमें Lerner और ट्रेनर बनाने की आवश्यकता इस प्रकार है -

ce_error = C.binary_cross_entropy(model, y) # CE a bit more principled for LR

fixed_lr = 0.010

learner = C.sgd(model.parameters, fixed_lr)

trainer = C.Trainer(model, (ce_error), [learner])

max_iterations = 4000LR मॉडल प्रशिक्षण

एक बार, हमने LR मॉडल बनाया है, अगला, प्रशिक्षण प्रक्रिया शुरू करने का समय है -

np.random.seed(4)

N = len(features_mat)

for i in range(0, max_iterations):

row = np.random.choice(N,1) # pick a random row from training items

trainer.train_minibatch({ X: features_mat[row], y: labels_mat[row] })

if i % 1000 == 0 and i > 0:

mcee = trainer.previous_minibatch_loss_average

print(str(i) + " Cross-entropy error on curr item = %0.4f " % mcee)अब, निम्नलिखित कोड की मदद से, हम मॉडल वज़न और पूर्वाग्रह प्रिंट कर सकते हैं -

np.set_printoptions(precision=4, suppress=True)

print("Model weights: ")

print(W.value)

print("Model bias:")

print(b.value)

print("")

if __name__ == "__main__":

main()लॉजिस्टिक रिग्रेशन मॉडल का प्रशिक्षण - पूरा उदाहरण

import numpy as np

import cntk as C

def main():

print("Using CNTK version = " + str(C.__version__) + "\n")

data_file = ".\\dataLRmodel.txt" # provide the name and the location of data file

print("Loading data from " + data_file + "\n")

features_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",", skiprows=0, usecols=[0,1])

labels_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",", skiprows=0, usecols=[2], ndmin=2)

features_dim = 2

labels_dim = 1

X = C.ops.input_variable(features_dim, np.float32)

y = C.input_variable(labels_dim, np.float32)

W = C.parameter(shape=(features_dim, 1)) # trainable cntk.Parameter

b = C.parameter(shape=(labels_dim))

z = C.times(X, W) + b

p = 1.0 / (1.0 + C.exp(-z))

model = p

ce_error = C.binary_cross_entropy(model, y) # CE a bit more principled for LR

fixed_lr = 0.010

learner = C.sgd(model.parameters, fixed_lr)

trainer = C.Trainer(model, (ce_error), [learner])

max_iterations = 4000

np.random.seed(4)

N = len(features_mat)

for i in range(0, max_iterations):

row = np.random.choice(N,1) # pick a random row from training items

trainer.train_minibatch({ X: features_mat[row], y: labels_mat[row] })

if i % 1000 == 0 and i > 0:

mcee = trainer.previous_minibatch_loss_average

print(str(i) + " Cross-entropy error on curr item = %0.4f " % mcee)

np.set_printoptions(precision=4, suppress=True)

print("Model weights: ")

print(W.value)

print("Model bias:")

print(b.value)

if __name__ == "__main__":

main()उत्पादन

Using CNTK version = 2.7

1000 cross entropy error on curr item = 0.1941

2000 cross entropy error on curr item = 0.1746

3000 cross entropy error on curr item = 0.0563

Model weights:

[-0.2049]

[0.9666]]

Model bias:

[-2.2846]प्रशिक्षित एलआर मॉडल का उपयोग कर भविष्यवाणी

एक बार जब LR मॉडल को प्रशिक्षित किया गया है, तो हम इसे निम्नानुसार भविष्यवाणी के लिए उपयोग कर सकते हैं -

सबसे पहले, हमारा मूल्यांकन कार्यक्रम खस्ता पैकेज को आयात करता है और प्रशिक्षण डेटा को एक फीचर मैट्रिक्स और एक क्लास लेबल मैट्रिक्स में उसी तरह लोड करता है जिस तरह से प्रशिक्षण कार्यक्रम हम ऊपर लागू करते हैं -

import numpy as np

def main():

data_file = ".\\dataLRmodel.txt" # provide the name and the location of data file

features_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",",

skiprows=0, usecols=(0,1))

labels_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",",

skiprows=0, usecols=[2], ndmin=2)अगला, यह वज़न और पूर्वाग्रह के मूल्यों को निर्धारित करने का समय है जो हमारे प्रशिक्षण कार्यक्रम द्वारा निर्धारित किए गए थे -

print("Setting weights and bias values \n")

weights = np.array([0.0925, 1.1722], dtype=np.float32)

bias = np.array([-4.5400], dtype=np.float32)

N = len(features_mat)

features_dim = 2अगला हमारा मूल्यांकन कार्यक्रम प्रत्येक प्रशिक्षण मदों के माध्यम से चलने से लॉजिस्टिक रिग्रेशन संभावना की गणना करेगा -

print("item pred_prob pred_label act_label result")

for i in range(0, N): # each item

x = features_mat[i]

z = 0.0

for j in range(0, features_dim):

z += x[j] * weights[j]

z += bias[0]

pred_prob = 1.0 / (1.0 + np.exp(-z))

pred_label = 0 if pred_prob < 0.5 else 1

act_label = labels_mat[i]

pred_str = ‘correct’ if np.absolute(pred_label - act_label) < 1.0e-5 \

else ‘WRONG’

print("%2d %0.4f %0.0f %0.0f %s" % \ (i, pred_prob, pred_label, act_label, pred_str))अब हम यह दर्शाते हैं कि भविष्यवाणी कैसे करें -

x = np.array([9.5, 4.5], dtype=np.float32)

print("\nPredicting class for age, education = ")

print(x)

z = 0.0

for j in range(0, features_dim):

z += x[j] * weights[j]

z += bias[0]

p = 1.0 / (1.0 + np.exp(-z))

print("Predicted p = " + str(p))

if p < 0.5: print("Predicted class = 0")

else: print("Predicted class = 1")पूर्ण भविष्यवाणी मूल्यांकन कार्यक्रम

import numpy as np

def main():

data_file = ".\\dataLRmodel.txt" # provide the name and the location of data file

features_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",",

skiprows=0, usecols=(0,1))

labels_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",",

skiprows=0, usecols=[2], ndmin=2)

print("Setting weights and bias values \n")

weights = np.array([0.0925, 1.1722], dtype=np.float32)

bias = np.array([-4.5400], dtype=np.float32)

N = len(features_mat)

features_dim = 2

print("item pred_prob pred_label act_label result")

for i in range(0, N): # each item

x = features_mat[i]

z = 0.0

for j in range(0, features_dim):

z += x[j] * weights[j]

z += bias[0]

pred_prob = 1.0 / (1.0 + np.exp(-z))

pred_label = 0 if pred_prob < 0.5 else 1

act_label = labels_mat[i]

pred_str = ‘correct’ if np.absolute(pred_label - act_label) < 1.0e-5 \

else ‘WRONG’

print("%2d %0.4f %0.0f %0.0f %s" % \ (i, pred_prob, pred_label, act_label, pred_str))

x = np.array([9.5, 4.5], dtype=np.float32)

print("\nPredicting class for age, education = ")

print(x)

z = 0.0

for j in range(0, features_dim):

z += x[j] * weights[j]

z += bias[0]

p = 1.0 / (1.0 + np.exp(-z))

print("Predicted p = " + str(p))

if p < 0.5: print("Predicted class = 0")

else: print("Predicted class = 1")

if __name__ == "__main__":

main()उत्पादन

वजन और पूर्वाग्रह मान सेट करना।

Item pred_prob pred_label act_label result

0 0.3640 0 0 correct

1 0.7254 1 0 WRONG

2 0.2019 0 0 correct

3 0.3562 0 0 correct

4 0.0493 0 0 correct

5 0.1005 0 0 correct

6 0.7892 1 1 correct

7 0.8564 1 1 correct

8 0.9654 1 1 correct

9 0.7587 1 1 correct

10 0.3040 0 1 WRONG

11 0.7129 1 1 correct

Predicting class for age, education =

[9.5 4.5]

Predicting p = 0.526487952

Predicting class = 1यह अध्याय CNTK के संबंध में तंत्रिका नेटवर्क की अवधारणाओं से संबंधित है।

जैसा कि हम जानते हैं कि, न्यूरॉन्स की कई परतों का उपयोग तंत्रिका नेटवर्क बनाने के लिए किया जाता है। लेकिन, सवाल यह उठता है कि CNTK में हम एक NN की परतों को कैसे मॉडल कर सकते हैं? यह परत मॉड्यूल में परिभाषित परत कार्यों की सहायता से किया जा सकता है।

परत समारोह

दरअसल, CNTK में, परतों के साथ काम करने से एक अलग कार्यात्मक प्रोग्रामिंग महसूस होता है। परत समारोह एक नियमित कार्य की तरह दिखता है और यह पूर्वनिर्धारित मापदंडों के एक सेट के साथ एक गणितीय कार्य करता है। आइए देखें कि हम लेयर फंक्शन की मदद से सबसे बेसिक लेयर टाइप Dense कैसे बना सकते हैं।

उदाहरण

निम्नलिखित मूल चरणों की सहायता से, हम सबसे बुनियादी परत प्रकार बना सकते हैं -

Step 1 - सबसे पहले, हमें CNTK के लेयर्स पैकेज से डेंस लेयर फंक्शन को इंपोर्ट करना होगा।

from cntk.layers import DenseStep 2 - CNTK रूट पैकेज से आगे, हमें input_variable फ़ंक्शन को आयात करना होगा।

from cntk import input_variableStep 3- अब, हमें input_variable फ़ंक्शन का उपयोग करके एक नया इनपुट चर बनाने की आवश्यकता है। हमें इसका आकार भी प्रदान करना होगा।

feature = input_variable(100)Step 4 - आख़िर में, हम जो न्यूरॉन्स चाहते हैं, उनकी संख्या प्रदान करने के साथ घने फ़ंक्शन का उपयोग करके एक नई परत बनाएंगे।

layer = Dense(40)(feature)अब, हम घने परत को इनपुट से जोड़ने के लिए कॉन्फ़िगर किए गए डेंस लेयर फ़ंक्शन को इनवॉइस कर सकते हैं।

पूरा कार्यान्वयन उदाहरण

from cntk.layers import Dense

from cntk import input_variable

feature= input_variable(100)

layer = Dense(40)(feature)परतों को अनुकूलित करना

जैसा कि हमने देखा है कि सीएनटीके हमें एनएन के निर्माण के लिए चूक का एक बहुत अच्छा सेट प्रदान करता है। पर आधारितactivationफ़ंक्शन और अन्य सेटिंग्स जो हम चुनते हैं, व्यवहार और साथ ही एनएन का प्रदर्शन अलग है। यह एक और बहुत उपयोगी उपजी एल्गोरिथ्म है। यही कारण है, यह समझना अच्छा है कि हम क्या कॉन्फ़िगर कर सकते हैं।

एक घने परत को कॉन्फ़िगर करने के लिए कदम

एनएन में प्रत्येक परत के पास अपने अद्वितीय कॉन्फ़िगरेशन विकल्प हैं और जब हम घने परत के बारे में बात करते हैं, तो हमारे पास परिभाषित करने के लिए महत्वपूर्ण सेटिंग्स हैं -

shape - जैसा कि नाम से पता चलता है, यह परत के आउटपुट आकार को परिभाषित करता है जो उस परत में न्यूरॉन्स की संख्या को निर्धारित करता है।

activation - यह उस लेयर के एक्टिवेशन फंक्शन को परिभाषित करता है, इसलिए यह इनपुट डेटा को ट्रांसफॉर्म कर सकता है।

init- यह उस परत के आरंभीकरण समारोह को परिभाषित करता है। जब हम एनएन का प्रशिक्षण शुरू करते हैं तो यह परत के मापदंडों को इनिशियलाइज़ करेगा।

आइए उन चरणों को देखें जिनकी सहायता से हम a को कॉन्फ़िगर कर सकते हैं Dense परत -

Step1 - सबसे पहले, हमें आयात करने की आवश्यकता है Dense CNTK के लेयर्स पैकेज से लेयर फंक्शन।

from cntk.layers import DenseStep2 - CNTK ऑप्स पैकेज से आगे, हमें आयात करने की आवश्यकता है sigmoid operator। इसका उपयोग सक्रियण फ़ंक्शन के रूप में कॉन्फ़िगर करने के लिए किया जाएगा।

from cntk.ops import sigmoidStep3 - अब, इनिलाइज़र पैकेज से, हमें आयात करने की आवश्यकता है glorot_uniform प्रारंभकर्ता।

from cntk.initializer import glorot_uniformStep4 - अंत में, हम पहले तर्क के रूप में न्यूरॉन्स की संख्या प्रदान करने के साथ घने फ़ंक्शन का उपयोग करके एक नई परत बनाएंगे। इसके अलावा, प्रदान करेंsigmoid ऑपरेटर के रूप में activation समारोह और glorot_uniform के रूप में init परत के लिए कार्य करते हैं।

layer = Dense(50, activation = sigmoid, init = glorot_uniform)पूरा कार्यान्वयन उदाहरण -

from cntk.layers import Dense

from cntk.ops import sigmoid

from cntk.initializer import glorot_uniform

layer = Dense(50, activation = sigmoid, init = glorot_uniform)मापदंडों का अनुकूलन

अब तक, हमने देखा है कि एनएन की संरचना कैसे बनाई जाए और विभिन्न सेटिंग्स को कैसे कॉन्फ़िगर किया जाए। यहां, हम देखेंगे, हम एक एनएन के मापदंडों को कैसे अनुकूलित कर सकते हैं। दो घटकों के संयोजन की मदद से अर्थात्learners तथा trainers, हम एक एनएन के मापदंडों को अनुकूलित कर सकते हैं।

ट्रेनर घटक

पहला घटक जो एक एनएन के मापदंडों को अनुकूलित करने के लिए उपयोग किया जाता है trainerघटक। यह मूल रूप से backpropagation प्रक्रिया को लागू करता है। अगर हम इसके काम करने के बारे में बात करते हैं, तो यह भविष्यवाणी प्राप्त करने के लिए एनएन के माध्यम से डेटा पास करता है।

उसके बाद, यह एनएन में मापदंडों के लिए नए मूल्यों को प्राप्त करने के लिए सीखने वाले नामक एक अन्य घटक का उपयोग करता है। एक बार जब यह नया मान प्राप्त करता है, तो यह इन नए मूल्यों को लागू करता है और प्रक्रिया को दोहराता है जब तक कि एक निकास मानदंड पूरा नहीं होता है।

सीखने वाला घटक

दूसरा घटक जो एक एनएन के मापदंडों को अनुकूलित करने के लिए उपयोग किया जाता है learner घटक, जो मूल रूप से ढाल वंश एल्गोरिथ्म के प्रदर्शन के लिए जिम्मेदार है।

CNTK पुस्तकालय में शामिल शिक्षार्थी

CNTK लाइब्रेरी में शामिल कुछ दिलचस्प शिक्षार्थियों की सूची निम्नलिखित है -

Stochastic Gradient Descent (SGD) - यह शिक्षार्थी बिना किसी अतिरिक्त के मूल स्टोचैस्टिक ग्रेडिएंट वंश का प्रतिनिधित्व करता है।

Momentum Stochastic Gradient Descent (MomentumSGD) - SGD के साथ, यह शिक्षार्थी स्थानीय मैक्सिमा की समस्या को दूर करने के लिए गति को लागू करता है।

RMSProp - यह सीखने वाला, वंश की दर को नियंत्रित करने के लिए, सीखने की दर में गिरावट का उपयोग करता है।

Adam - यह सीखने वाला, समय के साथ वंश की दर को कम करने के लिए, क्षयकारी गति का उपयोग करता है।

Adagrad - यह शिक्षार्थी, साथ ही साथ अक्सर होने वाली विशेषताओं के लिए, विभिन्न शिक्षण दर का उपयोग करता है।

CNTK - पहला न्यूरल नेटवर्क बनाना

यह अध्याय CNTK में एक तंत्रिका नेटवर्क बनाने पर विस्तार से बताएगा।

नेटवर्क संरचना बनाएँ

हमारे पहले एनएन के निर्माण के लिए CNTK अवधारणाओं को लागू करने के लिए, हम सीएनपी चौड़ाई और लंबाई के भौतिक गुणों और पंखुड़ी की चौड़ाई और लंबाई के आधार पर आईरिस फूलों की प्रजातियों को वर्गीकृत करने के लिए एनएन का उपयोग करने जा रहे हैं। डेटासेट जो हम आईरिस डेटासेट का उपयोग करेंगे, जिसमें आइरिस फूलों की विभिन्न किस्मों के भौतिक गुणों का वर्णन किया गया है -

- सिपाही की लंबाई

- सिपाही की चौड़ाई

- पंखुड़ी की लंबाई

- पेटल की चौड़ाई

- कक्षा यानी आईरिस सेटोसा या आईरिस वर्सिकोलर या आईरिस वर्जिनिका

यहां, हम एक नियमित एनएन का निर्माण करेंगे, जिसे फीडफोर्वर्ड एनएन कहा जाएगा। आइए, एनएन की संरचना बनाने के लिए कार्यान्वयन कदम देखें -

Step 1 - सबसे पहले, हम आवश्यक घटक जैसे कि हमारे परत प्रकार, सक्रियण फ़ंक्शन और एक फ़ंक्शन आयात करेंगे जो हमें CNTK लाइब्रेरी से हमारे एनएन के लिए एक इनपुट चर को परिभाषित करने की अनुमति देता है।

from cntk import default_options, input_variable

from cntk.layers import Dense, Sequential

from cntk.ops import log_softmax, reluStep 2- उसके बाद, हम अनुक्रमिक फ़ंक्शन का उपयोग करके अपना मॉडल बनाएंगे। एक बार बनाने के बाद, हम इसे अपनी इच्छित परतों के साथ खिलाएंगे। यहां, हम अपने एनएन में दो अलग-अलग परतें बनाने जा रहे हैं; एक चार न्यूरॉन्स के साथ और दूसरा तीन न्यूरॉन्स के साथ।

model = Sequential([Dense(4, activation=relu), Dense(3, activation=log_sogtmax)])Step 3- अंत में, एनएन संकलित करने के लिए, हम नेटवर्क को इनपुट चर से बांध देंगे। इसमें चार न्यूरॉन्स के साथ एक इनपुट परत और तीन न्यूरॉन्स के साथ एक आउटपुट परत है।

feature= input_variable(4)

z = model(feature)सक्रियण फ़ंक्शन लागू करना

चुनने के लिए बहुत सारे सक्रियण कार्य हैं और सही सक्रियण फ़ंक्शन चुनने से निश्चित रूप से एक बड़ा अंतर होगा कि हमारे गहन शिक्षण मॉडल कितना अच्छा प्रदर्शन करेंगे।

आउटपुट लेयर पर

चुनना activation आउटपुट लेयर पर फ़ंक्शन हमारे मॉडल के साथ जिस तरह की समस्या को हल करने जा रहा है, उस पर निर्भर करेगा।

एक प्रतिगमन समस्या के लिए, हमें एक का उपयोग करना चाहिए linear activation function आउटपुट लेयर पर।

एक द्विआधारी वर्गीकरण समस्या के लिए, हमें एक का उपयोग करना चाहिए sigmoid activation function आउटपुट लेयर पर।

बहु-श्रेणी वर्गीकरण समस्या के लिए, हमें एक का उपयोग करना चाहिए softmax activation function आउटपुट लेयर पर।

यहां, हम तीन वर्गों में से एक की भविष्यवाणी के लिए एक मॉडल बनाने जा रहे हैं। इसका मतलब है कि हमें उपयोग करने की आवश्यकता हैsoftmax activation function उत्पादन परत पर।

छिपी हुई परत पर

चुनना activation छिपी हुई परत पर कार्य करने के लिए प्रदर्शन की निगरानी के लिए कुछ प्रयोग की आवश्यकता होती है, यह देखने के लिए कि कौन सा सक्रियण फ़ंक्शन अच्छा काम करता है।

एक वर्गीकरण समस्या में, हमें संभावना का अनुमान लगाने की आवश्यकता है कि एक नमूना एक विशिष्ट वर्ग का है। इसलिए हमें ए की जरूरत हैactivation functionयह हमें संभाव्य मूल्य देता है। इस लक्ष्य तक पहुँचने के लिए,sigmoid activation function हमारी मदद कर सकते हैं।

सिग्मॉइड फ़ंक्शन से जुड़ी प्रमुख समस्याओं में से एक गायब होने वाली ढाल समस्या है। ऐसी समस्या को दूर करने के लिए, हम उपयोग कर सकते हैंReLU activation function जो सभी नकारात्मक मूल्यों को शून्य तक कवर करता है और सकारात्मक मूल्यों के लिए एक पास-थ्रू फिल्टर के रूप में काम करता है।

एक हानि समारोह उठा रहा है

एक बार, हमारे पास हमारे एनएन मॉडल के लिए संरचना है, हमें इसे अनुकूलित करना होगा। अनुकूलन के लिए हमें एक की आवश्यकता हैloss function। भिन्नactivation functions, हमारे पास चुनने के लिए बहुत कम नुकसान कार्य हैं। हालांकि, एक हानि फ़ंक्शन चुनना हमारे मॉडल के साथ जिस तरह की समस्या का समाधान करने जा रहा है, उस पर निर्भर करेगा।

उदाहरण के लिए, एक वर्गीकरण समस्या में, हमें एक हानि फ़ंक्शन का उपयोग करना चाहिए जो एक अनुमानित वर्ग और एक वास्तविक वर्ग के बीच अंतर को माप सकता है।

लॉस फंकशन

वर्गीकरण की समस्या के लिए, हम अपने एनएन मॉडल के साथ हल करने जा रहे हैं, categorical cross entropyनुकसान समारोह सबसे अच्छा उम्मीदवार है। CNTK में, इसे लागू किया जाता हैcross_entropy_with_softmax जिससे आयात किया जा सकता है cntk.losses पैकेज, निम्नानुसार है

label= input_variable(3)

loss = cross_entropy_with_softmax(z, label)मैट्रिक्स

हमारे एनएन मॉडल के लिए संरचना और लागू करने के लिए एक हानि फ़ंक्शन होने के साथ, हमारे पास हमारे सभी नए मॉडल को अनुकूलित करने के लिए नुस्खा बनाने की शुरुआत करने के लिए सभी सामग्रियां हैं। लेकिन, इसमें गहरी डुबकी लगाने से पहले, हमें मैट्रिक्स के बारे में सीखना चाहिए।

cntk.metricsCNTK नाम का पैकेज है cntk.metricsजिससे हम उन मेट्रिक्स को आयात कर सकते हैं जिनका हम उपयोग करने जा रहे हैं। जैसा कि हम एक वर्गीकरण मॉडल का निर्माण कर रहे हैं, हम उपयोग करेंगेclassification_error मैट्रिक जो 0 और 1 के बीच एक संख्या का उत्पादन करेगा। 0 और 1 के बीच की संख्या सही रूप से अनुमानित नमूनों का प्रतिशत इंगित करती है -

सबसे पहले, हमें मीट्रिक को आयात करना होगा cntk.metrics पैकेज -

from cntk.metrics import classification_error

error_rate = classification_error(z, label)उपरोक्त फ़ंक्शन को वास्तव में इनपुट के रूप में एनएन और अपेक्षित लेबल के आउटपुट की आवश्यकता होती है।

CNTK - प्रशिक्षण द न्यूरल नेटवर्क

यहां, हम CNTK में न्यूरल नेटवर्क के प्रशिक्षण के बारे में समझेंगे।

CNTK में एक मॉडल का प्रशिक्षण

पिछले अनुभाग में, हमने गहन शिक्षण मॉडल के सभी घटकों को परिभाषित किया है। अब इसे प्रशिक्षित करने का समय आ गया है। जैसा कि हमने पहले चर्चा की, हम CNTK में NN मॉडल को प्रशिक्षित कर सकते हैंlearner तथा trainer।

एक शिक्षार्थी चुनना और प्रशिक्षण स्थापित करना

इस खंड में, हम परिभाषित करेंगे learner। CNTK कई प्रदान करता हैlearnersमें से चुनना। हमारे मॉडल के लिए, पिछले अनुभागों में परिभाषित किया गया है, हम उपयोग करेंगेStochastic Gradient Descent (SGD) learner।

तंत्रिका नेटवर्क को प्रशिक्षित करने के लिए, हमें कॉन्फ़िगर करें learner तथा trainer निम्नलिखित चरणों की मदद से -

Step 1 - सबसे पहले, हमें आयात करने की आवश्यकता है sgd से कार्य करते हैं cntk.lerners पैकेज।

from cntk.learners import sgdStep 2 - इसके बाद, हमें आयात करने की आवश्यकता है Trainer से कार्य करते हैं cntk.train.trainer पैकेज

from cntk.train.trainer import TrainerStep 3 - अब, हम एक बनाने की जरूरत है learner। इसे बनाकर बनाया जा सकता हैsgd मॉडल के मापदंडों और सीखने की दर के लिए एक मूल्य प्रदान करने के साथ कार्य करते हैं।

learner = sgd(z.parametrs, 0.01)Step 4 - आख़िर में, हमें इनिशियलाइज़ करने की ज़रूरत है trainer। यह नेटवर्क, के संयोजन प्रदान किया जाना चाहिएloss तथा metric इसके साथ learner।

trainer = Trainer(z, (loss, error_rate), [learner])अनुकूलन की गति को नियंत्रित करने वाली सीखने की दर 0.1 से 0.001 के बीच छोटी संख्या होनी चाहिए।

एक शिक्षार्थी चुनना और प्रशिक्षण स्थापित करना - पूरा उदाहरण

from cntk.learners import sgd

from cntk.train.trainer import Trainer

learner = sgd(z.parametrs, 0.01)

trainer = Trainer(z, (loss, error_rate), [learner])ट्रेनर में डाटा फीड करना

एक बार जब हमने ट्रेनर को चुना और कॉन्फ़िगर किया, तो यह डेटासेट लोड करने का समय है। हमने बचा लिया हैiris डाटासेट के रूप में।CSV फ़ाइल और हम डेटा नामकरण पैकेज का उपयोग करेंगे pandas डेटासेट लोड करने के लिए।

.CSV फ़ाइल से डेटासेट लोड करने के लिए चरण

Step 1 - सबसे पहले, हमें आयात करने की आवश्यकता है pandas पैकेज।

from import pandas as pdStep 2 - अब, हमें नामांकित फ़ंक्शन को लागू करने की आवश्यकता है read_csv डिस्क से .csv फ़ाइल लोड करने के लिए फ़ंक्शन।

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’,

‘petal_length’, ‘petal_width’, index_col=False)एक बार जब हम डेटासेट लोड कर लेते हैं, तो हमें इसे एक फीचर और एक लेबल में विभाजित करने की आवश्यकता होती है।

डेटासेट को फीचर्स और लेबल में विभाजित करने के चरण

Step 1- सबसे पहले, हमें डेटासेट से सभी पंक्तियों और पहले चार कॉलमों का चयन करना होगा। इसका उपयोग करके किया जा सकता हैiloc समारोह।

x = df_source.iloc[:, :4].valuesStep 2- इसके बाद हमें आईरिस डेटासेट से प्रजाति कॉलम का चयन करना होगा। हम अंतर्निहित का उपयोग करने के लिए मूल्यों की संपत्ति का उपयोग करेंगेnumpy सरणी।

x = df_source[‘species’].valuesसांख्यिक वेक्टर प्रतिनिधित्व के लिए प्रजाति कॉलम को एनकोड करने के चरण

जैसा कि हमने पहले चर्चा की थी, हमारा मॉडल वर्गीकरण पर आधारित है, इसके लिए संख्यात्मक इनपुट मूल्यों की आवश्यकता होती है। इसलिए, यहाँ हमें सांख्यिक सदिश निरूपण के लिए प्रजाति कॉलम को एनकोड करना होगा। आइए देखें इसे करने के चरण -

Step 1- पहले, हमें सरणी में सभी तत्वों पर पुनरावृति करने के लिए एक सूची अभिव्यक्ति बनाने की आवश्यकता है। फिर प्रत्येक मान के लिए लेबल_ मैपिंग शब्दकोश में एक प्रदर्शन करें।

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}Step 2- अगला, इस परिवर्तित संख्यात्मक मान को एक-हॉट एन्कोडेड वेक्टर में कनवर्ट करें। हम उपयोग करेंगेone_hot कार्य निम्नानुसार है -

def one_hot(index, length):

result = np.zeros(length)

result[index] = 1

return resultStep 3 - अंत में, हमें इस परिवर्तित सूची को एक में बदलना होगा numpy सरणी।

y = np.array([one_hot(label_mapping[v], 3) for v in y])ओवरफिटिंग का पता लगाने के लिए कदम

स्थिति, जब आपका मॉडल नमूनों को याद करता है, लेकिन प्रशिक्षण के नमूनों से नियमों को कम नहीं कर सकता है, ओवरफिटिंग है। निम्नलिखित चरणों की मदद से, हम अपने मॉडल पर ओवरफिटिंग का पता लगा सकते हैं -

Step 1 - पहला, से sklearn पैकेज, आयात train_test_split से कार्य करते हैं model_selection मापांक।

from sklearn.model_selection import train_test_splitStep 2 - इसके बाद, हमें train_test_split फ़ंक्शन को x और लेबल y के साथ निम्न प्रकार से लागू करना होगा -

x_train, x_test, y_train, y_test = train_test_split(X, y, test_size=0-2,

stratify=y)हमने कुल डेटा का 20% अलग सेट करने के लिए 0.2 का एक test_size निर्दिष्ट किया।

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}हमारे मॉडल को प्रशिक्षण सेट और सत्यापन सेट खिलाने के लिए कदम

Step 1 - हमारे मॉडल को प्रशिक्षित करने के लिए, सबसे पहले, हम इनवॉइस करेंगे train_minibatchतरीका। फिर इसे एक शब्दकोश दें जो इनपुट डेटा को इनपुट वैरिएबल में मैप करता है जिसका उपयोग हमने एनएन और उसके संबंधित नुकसान फ़ंक्शन को परिभाषित करने के लिए किया है।

trainer.train_minibatch({ features: X_train, label: y_train})Step 2 - अगला, कॉल करें train_minibatch लूप के लिए निम्नलिखित का उपयोग करके -

for _epoch in range(10):

trainer.train_minbatch ({ feature: X_train, label: y_train})

print(‘Loss: {}, Acc: {}’.format(

trainer.previous_minibatch_loss_average,

trainer.previous_minibatch_evaluation_average))ट्रेनर में डेटा फीड करना - पूरा उदाहरण

from import pandas as pd

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’, ‘petal_length’, ‘petal_width’, index_col=False)

x = df_source.iloc[:, :4].values

x = df_source[‘species’].values

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}

def one_hot(index, length):

result = np.zeros(length)

result[index] = 1

return result

y = np.array([one_hot(label_mapping[v], 3) for v in y])

from sklearn.model_selection import train_test_split

x_train, x_test, y_train, y_test = train_test_split(X, y, test_size=0-2, stratify=y)

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}

trainer.train_minibatch({ features: X_train, label: y_train})

for _epoch in range(10):

trainer.train_minbatch ({ feature: X_train, label: y_train})

print(‘Loss: {}, Acc: {}’.format(

trainer.previous_minibatch_loss_average,

trainer.previous_minibatch_evaluation_average))एनएन के प्रदर्शन को मापने

हमारे एनएन मॉडल को अनुकूलित करने के लिए, जब भी हम ट्रेनर के माध्यम से डेटा पास करते हैं, तो यह उस मीट्रिक के माध्यम से मॉडल के प्रदर्शन को मापता है जिसे हमने ट्रेनर के लिए कॉन्फ़िगर किया था। प्रशिक्षण के दौरान एनएन मॉडल के प्रदर्शन का ऐसा माप प्रशिक्षण डेटा पर है। लेकिन दूसरी ओर, मॉडल प्रदर्शन के पूर्ण विश्लेषण के लिए हमें परीक्षण डेटा का भी उपयोग करना होगा।

इसलिए, परीक्षण डेटा का उपयोग करके मॉडल के प्रदर्शन को मापने के लिए, हम इसे लागू कर सकते हैं test_minibatch पर विधि trainer निम्नानुसार है -

trainer.test_minibatch({ features: X_test, label: y_test})एनएन के साथ भविष्यवाणी करना

एक बार जब आप एक गहन शिक्षण मॉडल को प्रशिक्षित करते हैं, तो सबसे महत्वपूर्ण बात यह है कि इसका उपयोग करके भविष्यवाणियां करें। उपरोक्त प्रशिक्षित एनएन से भविष्यवाणी करने के लिए, हम दिए गए चरणों का पालन कर सकते हैं

Step 1 - पहले, हमें निम्नलिखित फ़ंक्शन का उपयोग करके परीक्षण सेट से एक यादृच्छिक आइटम लेने की आवश्यकता है -

np.random.choiceStep 2 - अगला, हमें परीक्षण सेट से नमूना डेटा का उपयोग करके चयन करने की आवश्यकता है sample_index।

Step 3 - अब, संख्यात्मक आउटपुट को एनएन में वास्तविक लेबल में बदलने के लिए, एक उलटा मैपिंग बनाएं।

Step 4 - अब, चयनित का उपयोग करें sampleडेटा। एक समारोह के रूप में एनएन जेड को आमंत्रित करके एक भविष्यवाणी करें।

Step 5- अब, एक बार जब आप अनुमानित आउटपुट प्राप्त कर लेते हैं, तो उस न्यूरॉन के सूचकांक को लें, जिसमें अनुमानित मूल्य के रूप में उच्चतम मूल्य है। यह का उपयोग करके किया जा सकता हैnp.argmax से कार्य करते हैं numpy पैकेज।

Step 6 - आख़िर में, इंडेक्स वैल्यू को असली लेबल में बदलकर उपयोग करें inverted_mapping।

एनएन के साथ भविष्यवाणी करना - पूरा उदाहरण

sample_index = np.random.choice(X_test.shape[0])

sample = X_test[sample_index]

inverted_mapping = {

1:’Iris-setosa’,

2:’Iris-versicolor’,

3:’Iris-virginica’

}

prediction = z(sample)

predicted_label = inverted_mapping[np.argmax(prediction)]

print(predicted_label)उत्पादन

उपरोक्त डीप लर्निंग मॉडल को प्रशिक्षित करने और इसे चलाने के बाद, आपको निम्न आउटपुट मिलेगा -

Iris-versicolorCNTK - इन-मेमोरी और बड़े डेटासेट

इस अध्याय में, हम सीएनटीके में इन-मेमोरी और बड़े डेटासेट के साथ काम करने के तरीके के बारे में जानेंगे।

मेमोरी डेटासेट में छोटे से प्रशिक्षण

जब हम CNTK ट्रेनर में डेटा फीड करने की बात करते हैं, तो कई तरीके हो सकते हैं, लेकिन यह डेटा के डेटासेट और प्रारूप के आकार पर निर्भर करेगा। डेटा सेट छोटे इन-मेमोरी या बड़े डेटासेट हो सकते हैं।

इस खंड में, हम इन-मेमोरी डेटासेट के साथ काम करने जा रहे हैं। इसके लिए, हम निम्नलिखित दो रूपरेखाओं का उपयोग करेंगे -

- Numpy

- Pandas

Numpy सरणियों का उपयोग करना

यहां, हम CNTK में एक सुव्यवस्थित रूप से उत्पन्न डेटासेट के साथ काम करेंगे। इस उदाहरण में, हम एक द्विआधारी वर्गीकरण समस्या के लिए डेटा का अनुकरण करने जा रहे हैं। मान लीजिए, हमारे पास 4 विशेषताओं के साथ टिप्पणियों का एक सेट है और हमारे गहन शिक्षण मॉडल के साथ दो संभावित लेबल की भविष्यवाणी करना चाहते हैं।

कार्यान्वयन उदाहरण

इसके लिए, पहले हमें लेबल का एक सेट उत्पन्न करना चाहिए जिसमें लेबल के एक-गर्म वेक्टर प्रतिनिधित्व होता है, हम भविष्यवाणी करना चाहते हैं। इसे निम्नलिखित चरणों की सहायता से किया जा सकता है -

Step 1 - आयात करें numpy पैकेज निम्नानुसार है -

import numpy as np

num_samples = 20000Step 2 - इसके बाद, उपयोग करके एक लेबल मैपिंग जनरेट करें np.eye कार्य निम्नानुसार है -

label_mapping = np.eye(2)Step 3 - अब उपयोग करके np.random.choice फ़ंक्शन, 20000 यादृच्छिक नमूने निम्नानुसार एकत्रित करें -

y = label_mapping[np.random.choice(2,num_samples)].astype(np.float32)Step 4 - अब np.random.random फ़ंक्शन का उपयोग करके अंत में, यादृच्छिक फ्लोटिंग पॉइंट मानों की एक सरणी उत्पन्न करें -

x = np.random.random(size=(num_samples, 4)).astype(np.float32)एक बार, हम यादृच्छिक फ़्लोटिंग-पॉइंट मानों की एक सरणी उत्पन्न करते हैं, हमें उन्हें 32-बिट फ़्लोटिंग पॉइंट नंबरों में बदलने की आवश्यकता है ताकि इसे CNTK द्वारा अपेक्षित प्रारूप से मिलान किया जा सके। ऐसा करने के लिए नीचे दिए गए चरणों का पालन करें -

Step 5 इस प्रकार cntk.layers मॉड्यूल से घने और अनुक्रमिक परत कार्यों को आयात करें -

from cntk.layers import Dense, SequentialStep 6- अब, हमें नेटवर्क में परतों के लिए सक्रियण फ़ंक्शन को आयात करने की आवश्यकता है। आयात करते हैंsigmoid सक्रियण समारोह के रूप में -

from cntk import input_variable, default_options

from cntk.ops import sigmoidStep 7- अब, हमें नेटवर्क को प्रशिक्षित करने के लिए नुकसान फ़ंक्शन को आयात करने की आवश्यकता है। आयात करते हैंbinary_cross_entropy हानि समारोह के रूप में -

from cntk.losses import binary_cross_entropyStep 8- अगला, हमें नेटवर्क के लिए डिफ़ॉल्ट विकल्पों को परिभाषित करने की आवश्यकता है। यहां, हम प्रदान करेंगेsigmoidडिफ़ॉल्ट सेटिंग के रूप में सक्रियण फ़ंक्शन। इसके अलावा, अनुक्रमिक परत फ़ंक्शन का उपयोग करके मॉडल बनाएं:

with default_options(activation=sigmoid):

model = Sequential([Dense(6),Dense(2)])Step 9 - अगला, इनिशियलाइज़ a input_variable नेटवर्क के लिए इनपुट के रूप में सेवारत 4 इनपुट सुविधाओं के साथ।

features = input_variable(4)Step 10 - अब, इसे पूरा करने के लिए, हमें NN में वैरिएबल कनेक्ट करने की आवश्यकता है।

z = model(features)तो, अब हमारे पास एनएन है, निम्नलिखित चरणों की मदद से, हमें इन-मेमोरी डेटासेट का उपयोग करके प्रशिक्षित करें -

Step 11 - इस एनएन को प्रशिक्षित करने के लिए, सबसे पहले हमें सीखने वाले को आयात करना होगा cntk.learnersमापांक। हम आयात करेंगेsgd शिक्षार्थी इस प्रकार है -

from cntk.learners import sgdStep 12 - इसके साथ ही आयात करें ProgressPrinter से cntk.logging मॉड्यूल के रूप में अच्छी तरह से।

from cntk.logging import ProgressPrinter

progress_writer = ProgressPrinter(0)Step 13 - अगला, लेबल के लिए एक नया इनपुट चर परिभाषित करें -

labels = input_variable(2)Step 14 - एनएन मॉडल को प्रशिक्षित करने के लिए, अगले, हमें एक नुकसान का उपयोग करने की आवश्यकता है binary_cross_entropyसमारोह। इसके अलावा, मॉडल जेड और लेबल चर प्रदान करें।

loss = binary_cross_entropy(z, labels)Step 15 - अगला, इनिशियलाइज़ करें sgd शिक्षार्थी इस प्रकार है -

learner = sgd(z.parameters, lr=0.1)Step 16- अंत में, नुकसान फ़ंक्शन पर ट्रेन विधि को कॉल करें। इसके अलावा, इसे इनपुट डेटा के साथ प्रदान करें,sgd सीखने वाला और progress_printer.-

training_summary=loss.train((x,y),parameter_learners=[learner],callbacks=[progress_writer])पूरा कार्यान्वयन उदाहरण

import numpy as np

num_samples = 20000

label_mapping = np.eye(2)

y = label_mapping[np.random.choice(2,num_samples)].astype(np.float32)

x = np.random.random(size=(num_samples, 4)).astype(np.float32)

from cntk.layers import Dense, Sequential

from cntk import input_variable, default_options

from cntk.ops import sigmoid

from cntk.losses import binary_cross_entropy

with default_options(activation=sigmoid):

model = Sequential([Dense(6),Dense(2)])

features = input_variable(4)

z = model(features)

from cntk.learners import sgd

from cntk.logging import ProgressPrinter

progress_writer = ProgressPrinter(0)

labels = input_variable(2)

loss = binary_cross_entropy(z, labels)

learner = sgd(z.parameters, lr=0.1)

training_summary=loss.train((x,y),parameter_learners=[learner],callbacks=[progress_writer])उत्पादन

Build info:

Built time: *** ** **** 21:40:10

Last modified date: *** *** ** 21:08:46 2019

Build type: Release

Build target: CPU-only

With ASGD: yes

Math lib: mkl

Build Branch: HEAD

Build SHA1:ae9c9c7c5f9e6072cc9c94c254f816dbdc1c5be6 (modified)

MPI distribution: Microsoft MPI

MPI version: 7.0.12437.6

-------------------------------------------------------------------

average since average since examples

loss last metric last

------------------------------------------------------

Learning rate per minibatch: 0.1

1.52 1.52 0 0 32

1.51 1.51 0 0 96

1.48 1.46 0 0 224

1.45 1.42 0 0 480

1.42 1.4 0 0 992

1.41 1.39 0 0 2016

1.4 1.39 0 0 4064

1.39 1.39 0 0 8160

1.39 1.39 0 0 16352पंडों डेटाफ्रैम का उपयोग करना

Numpy सरणियाँ वे क्या शामिल कर सकते हैं और डेटा भंडारण के सबसे बुनियादी तरीकों में से एक में बहुत सीमित हैं। उदाहरण के लिए, एक एकल n- आयामी सरणी में एकल डेटा प्रकार का डेटा हो सकता है। लेकिन दूसरी ओर, कई वास्तविक दुनिया के मामलों में हमें एक पुस्तकालय की आवश्यकता होती है जो एक डेटासेट में एक से अधिक डेटा प्रकारों को संभाल सकता है।

पंडों नामक पायथन पुस्तकालयों में से एक इस तरह के डेटासेट के साथ काम करना आसान बनाता है। यह एक DataFrame (DF) की अवधारणा का परिचय देता है और हमें DF प्रारूप के रूप में विभिन्न स्वरूपों में संग्रहीत डिस्क से डेटासेट लोड करने की अनुमति देता है। उदाहरण के लिए, हम CSV को CSV, JSON, Excel आदि के रूप में संग्रहीत पढ़ सकते हैं।

आप पायथन पंडों पुस्तकालय को और अधिक विस्तार से जान सकते हैं https://www.tutorialspoint.com/python_pandas/index.htm.

कार्यान्वयन उदाहरण

इस उदाहरण में, हम चार गुणों के आधार पर आईरिस फूलों की तीन संभावित प्रजातियों को वर्गीकृत करने के उदाहरण का उपयोग करने जा रहे हैं। हमने पिछले खंडों में भी इस गहन शिक्षण मॉडल को बनाया है। मॉडल इस प्रकार है -

from cntk.layers import Dense, Sequential

from cntk import input_variable, default_options

from cntk.ops import sigmoid, log_softmax

from cntk.losses import binary_cross_entropy

model = Sequential([

Dense(4, activation=sigmoid),

Dense(3, activation=log_softmax)

])

features = input_variable(4)

z = model(features)उपरोक्त मॉडल में एक छिपी हुई परत और तीन न्यूरॉन्स के साथ एक आउटपुट परत होती है, जिससे हम अनुमान लगा सकते हैं कि कक्षाओं की संख्या कितनी है।

अगला, हम उपयोग करेंगे train विधि और lossनेटवर्क को प्रशिक्षित करने के लिए कार्य करते हैं। इसके लिए, पहले हमें आइरिस डेटा को लोड और प्रीप्रोसेस करना होगा, ताकि यह एनएन के लिए अपेक्षित लेआउट और डेटा प्रारूप से मेल खाए। इसे निम्नलिखित चरणों की सहायता से किया जा सकता है -

Step 1 - आयात करें numpy तथा Pandas पैकेज निम्नानुसार है -

import numpy as np

import pandas as pdStep 2 - अगला, उपयोग करें read_csv डेटासेट को मेमोरी में लोड करने का कार्य -

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’,

‘petal_length’, ‘petal_width’, ‘species’], index_col=False)Step 3 - अब, हमें एक ऐसा शब्दकोष बनाने की जरूरत है, जो डेटासेट में लेबल को उनके संबंधित संख्यात्मक प्रतिनिधित्व के साथ मैप कर रहा हो।

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}Step 4 - अब, का उपयोग करके iloc सूचकांक पर DataFrame, पहले चार कॉलम निम्नानुसार चुनें -

x = df_source.iloc[:, :4].valuesStep 5AsNext, हमें डेटा कॉलम को डेटासेट के लिए लेबल के रूप में चुनना होगा। इसे निम्नानुसार किया जा सकता है -

y = df_source[‘species’].valuesStep 6 - अब, हमें डेटासेट में उन लेबलों को मैप करना होगा, जिनका उपयोग करके किया जा सकता है label_mapping। इसका भी प्रयोग करेंone_hot एन्कोडिंग उन्हें एक-हॉट एन्कोडिंग सरणियों में बदलने के लिए।

y = np.array([one_hot(label_mapping[v], 3) for v in y])Step 7 - अगला, CNTK के साथ सुविधाओं और मैप किए गए लेबल का उपयोग करने के लिए, हमें उन दोनों को फ़्लोट में बदलने की आवश्यकता है -

x= x.astype(np.float32)

y= y.astype(np.float32)जैसा कि हम जानते हैं कि, लेबल को तार के रूप में डेटासेट में संग्रहीत किया जाता है और CNTK इन स्ट्रिंग्स के साथ काम नहीं कर सकता है। यही कारण है, यह लेबल का प्रतिनिधित्व करने वाले एक-गर्म एन्कोडेड वैक्टर की आवश्यकता है। इसके लिए, हम एक फ़ंक्शन को परिभाषित कर सकते हैंone_hot निम्नानुसार है -

def one_hot(index, length):

result = np.zeros(length)

result[index] = index

return resultअब, हमारे पास सही प्रारूप में सुन्न सरणी है, निम्नलिखित चरणों की मदद से हम अपने मॉडल को प्रशिक्षित करने के लिए उनका उपयोग कर सकते हैं -

Step 8- सबसे पहले, हमें नेटवर्क को प्रशिक्षित करने के लिए नुकसान फ़ंक्शन को आयात करना होगा। आयात करते हैंbinary_cross_entropy_with_softmax हानि समारोह के रूप में -

from cntk.losses import binary_cross_entropy_with_softmaxStep 9 - इस एनएन को प्रशिक्षित करने के लिए, हमें सीखने वाले को आयात करने की भी आवश्यकता है cntk.learnersमापांक। हम आयात करेंगेsgd शिक्षार्थी इस प्रकार है -

from cntk.learners import sgdStep 10 - इसके साथ ही आयात करें ProgressPrinter से cntk.logging मॉड्यूल के रूप में अच्छी तरह से।

from cntk.logging import ProgressPrinter

progress_writer = ProgressPrinter(0)Step 11 - अगला, लेबल के लिए एक नया इनपुट चर परिभाषित करें -

labels = input_variable(3)Step 12 - एनएन मॉडल को प्रशिक्षित करने के लिए, अगले, हमें एक नुकसान का उपयोग करने की आवश्यकता है binary_cross_entropy_with_softmaxसमारोह। मॉडल z और लेबल चर भी प्रदान करें।

loss = binary_cross_entropy_with_softmax (z, labels)Step 13 - अगला, इनिशियलाइज़ करें sgd शिक्षार्थी इस प्रकार है -

learner = sgd(z.parameters, 0.1)Step 14- अंत में, नुकसान फ़ंक्शन पर ट्रेन विधि को कॉल करें। इसके अलावा, इसे इनपुट डेटा के साथ प्रदान करें,sgd सीखने वाला और progress_printer।

training_summary=loss.train((x,y),parameter_learners=[learner],callbacks=

[progress_writer],minibatch_size=16,max_epochs=5)पूरा कार्यान्वयन उदाहरण

from cntk.layers import Dense, Sequential

from cntk import input_variable, default_options

from cntk.ops import sigmoid, log_softmax

from cntk.losses import binary_cross_entropy

model = Sequential([

Dense(4, activation=sigmoid),

Dense(3, activation=log_softmax)

])

features = input_variable(4)

z = model(features)

import numpy as np

import pandas as pd

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’, ‘petal_length’, ‘petal_width’, ‘species’], index_col=False)

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}

x = df_source.iloc[:, :4].values

y = df_source[‘species’].values

y = np.array([one_hot(label_mapping[v], 3) for v in y])

x= x.astype(np.float32)

y= y.astype(np.float32)

def one_hot(index, length):

result = np.zeros(length)

result[index] = index

return result

from cntk.losses import binary_cross_entropy_with_softmax

from cntk.learners import sgd

from cntk.logging import ProgressPrinter

progress_writer = ProgressPrinter(0)

labels = input_variable(3)

loss = binary_cross_entropy_with_softmax (z, labels)

learner = sgd(z.parameters, 0.1)

training_summary=loss.train((x,y),parameter_learners=[learner],callbacks=[progress_writer],minibatch_size=16,max_epochs=5)उत्पादन

Build info:

Built time: *** ** **** 21:40:10

Last modified date: *** *** ** 21:08:46 2019

Build type: Release

Build target: CPU-only

With ASGD: yes

Math lib: mkl

Build Branch: HEAD

Build SHA1:ae9c9c7c5f9e6072cc9c94c254f816dbdc1c5be6 (modified)

MPI distribution: Microsoft MPI

MPI version: 7.0.12437.6

-------------------------------------------------------------------

average since average since examples

loss last metric last

------------------------------------------------------

Learning rate per minibatch: 0.1

1.1 1.1 0 0 16

0.835 0.704 0 0 32

1.993 1.11 0 0 48

1.14 1.14 0 0 112

[………]बड़े डेटासेट के साथ प्रशिक्षण

पिछले अनुभाग में, हमने Numpy और पांडा का उपयोग करते हुए छोटे इन-मेमोरी डेटासेट के साथ काम किया, लेकिन सभी डेटासेट इतने छोटे नहीं हैं। विशेष रूप से छवियां, वीडियो, ध्वनि नमूने वाले डेटासेट बड़े हैं।MinibatchSourceएक घटक है, जो इतने बड़े डेटासेट के साथ काम करने के लिए CNTK द्वारा प्रदान किए गए डेटा को चंक्स में लोड कर सकता है। की कुछ विशेषताएंMinibatchSource घटक इस प्रकार हैं -

MinibatchSource डेटा स्रोत से पढ़े गए नमूनों को स्वचालित रूप से यादृच्छिक करके एनएन को ओवरफिटिंग से रोक सकते हैं।

इसमें अंतर्निर्मित परिवर्तन पाइपलाइन है जिसका उपयोग डेटा को बढ़ाने के लिए किया जा सकता है।

यह प्रशिक्षण प्रक्रिया से अलग पृष्ठभूमि थ्रेड पर डेटा लोड करता है।

निम्नलिखित अनुभागों में, हम यह पता लगाने जा रहे हैं कि बड़े डेटासेट के साथ काम करने के लिए आउट-ऑफ-मेमोरी डेटा के साथ मिनीबच स्रोत का उपयोग कैसे किया जाए। हम यह भी पता लगाएंगे, कि हम किसी एनएन को प्रशिक्षण देने के लिए इसका उपयोग कैसे कर सकते हैं।

MinibatchSource उदाहरण बनाना

पिछले भाग में, हमने आईरिस फूल उदाहरण का उपयोग किया है और पंडों डेटाफ्रैम का उपयोग करते हुए छोटे इन-मेमोरी डेटासेट के साथ काम किया है। यहां, हम उस कोड की जगह लेंगे जो एक पांडा डीएफ से डेटा का उपयोग करता हैMinibatchSource। सबसे पहले, हमें एक उदाहरण बनाने की आवश्यकता हैMinibatchSource निम्नलिखित चरणों की मदद से -

कार्यान्वयन उदाहरण

Step 1 - पहला, से cntk.io मॉड्यूल इस प्रकार के लिए मिनीबैचसोर्स के घटकों को आयात करता है -

from cntk.io import StreamDef, StreamDefs, MinibatchSource, CTFDeserializer,

INFINITY_REPEATStep 2 - अब, का उपयोग करके StreamDef वर्ग, लेबल के लिए एक स्ट्रीम परिभाषा क्रेट करें।

labels_stream = StreamDef(field=’labels’, shape=3, is_sparse=False)Step 3 - इसके बाद, इनपुट फ़ाइल से दर्ज की गई विशेषताओं को पढ़ने के लिए बनाएं, का एक और उदाहरण बनाएं StreamDef निम्नलिखित नुसार।

feature_stream = StreamDef(field=’features’, shape=4, is_sparse=False)Step 4 - अब, हमें प्रदान करने की आवश्यकता है iris.ctf इनपुट के रूप में फ़ाइल करें और आरंभ करें deserializer निम्नानुसार है -

deserializer = CTFDeserializer(‘iris.ctf’, StreamDefs(labels=

label_stream, features=features_stream)Step 5 - अंत में, हमें उदाहरण प्रस्तुत करने की आवश्यकता है minisourceBatch का उपयोग करके deserializer निम्नानुसार है -

Minibatch_source = MinibatchSource(deserializer, randomize=True)एक MinibatchSource उदाहरण बनाना - पूर्ण कार्यान्वयन उदाहरण

from cntk.io import StreamDef, StreamDefs, MinibatchSource, CTFDeserializer, INFINITY_REPEAT

labels_stream = StreamDef(field=’labels’, shape=3, is_sparse=False)

feature_stream = StreamDef(field=’features’, shape=4, is_sparse=False)

deserializer = CTFDeserializer(‘iris.ctf’, StreamDefs(labels=label_stream, features=features_stream)

Minibatch_source = MinibatchSource(deserializer, randomize=True)MCTF फ़ाइल बनाना

जैसा कि आपने ऊपर देखा है, हम 'iris.ctf' फ़ाइल से डेटा ले रहे हैं। इसमें CNTK टेक्स्ट फॉर्मेट (CTF) नामक फाइल फॉर्मेट है। डेटा प्राप्त करने के लिए CTF फ़ाइल बनाना अनिवार्य हैMinibatchSourceउदाहरण हमने ऊपर बनाया है। आइए देखें कि हम सीटीएफ फाइल कैसे बना सकते हैं।

कार्यान्वयन उदाहरण

Step 1 - सबसे पहले, हमें निम्नानुसार पंडों और खस्ता पैकेजों को आयात करना होगा -

import pandas as pd

import numpy as npStep 2- इसके बाद, हमें अपनी डेटा फ़ाइल, अर्थात iris.csv को मेमोरी में लोड करना होगा। फिर, इसे स्टोर करेंdf_source चर।

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’, ‘petal_length’, ‘petal_width’, ‘species’], index_col=False)Step 3 - अब, का उपयोग करके ilocसुविधाओं के रूप में अनुक्रमणिका, पहले चार कॉलम की सामग्री लें। इसके अलावा, प्रजाति कॉलम के डेटा का उपयोग इस प्रकार करें -

features = df_source.iloc[: , :4].values

labels = df_source[‘species’].valuesStep 4- अगला, हमें लेबल नाम और इसके संख्यात्मक प्रतिनिधित्व के बीच एक मानचित्रण बनाने की आवश्यकता है। इसे बनाकर किया जा सकता हैlabel_mapping निम्नानुसार है -

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}Step 5 - अब, लेबल को एक गर्म एन्कोडेड वैक्टर के एक सेट में इस प्रकार परिवर्तित करें -

labels = [one_hot(label_mapping[v], 3) for v in labels]अब, जैसा कि हमने पहले किया था, एक उपयोगिता फ़ंक्शन कहा जाता है one_hotलेबल को एनकोड करने के लिए। इसे निम्नानुसार किया जा सकता है -

def one_hot(index, length):

result = np.zeros(length)

result[index] = 1

return resultजैसा कि, हमने डेटा लोड और प्रीप्रोसेस किया है, इसे CTF फ़ाइल स्वरूप में डिस्क पर संग्रहीत करने का समय है। हम इसे पायथन कोड की मदद से कर सकते हैं -

With open(‘iris.ctf’, ‘w’) as output_file:

for index in range(0, feature.shape[0]):

feature_values = ‘ ‘.join([str(x) for x in np.nditer(features[index])])

label_values = ‘ ‘.join([str(x) for x in np.nditer(labels[index])])

output_file.write(‘features {} | labels {} \n’.format(feature_values, label_values))MCTF फ़ाइल बनाना - पूर्ण कार्यान्वयन उदाहरण

import pandas as pd

import numpy as np

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’, ‘petal_length’, ‘petal_width’, ‘species’], index_col=False)

features = df_source.iloc[: , :4].values

labels = df_source[‘species’].values

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}

labels = [one_hot(label_mapping[v], 3) for v in labels]

def one_hot(index, length):

result = np.zeros(length)

result[index] = 1

return result

With open(‘iris.ctf’, ‘w’) as output_file:

for index in range(0, feature.shape[0]):

feature_values = ‘ ‘.join([str(x) for x in np.nditer(features[index])])

label_values = ‘ ‘.join([str(x) for x in np.nditer(labels[index])])

output_file.write(‘features {} | labels {} \n’.format(feature_values, label_values))डाटा फीड करना

एक बार जब आप बनाएँ MinibatchSource,उदाहरण के लिए, हमें इसे प्रशिक्षित करने की आवश्यकता है। जब हम छोटे इन-मेमोरी डेटासेट के साथ काम करते हैं तो हम उसी तरह के प्रशिक्षण तर्क का उपयोग कर सकते हैं। यहां, हम उपयोग करेंगेMinibatchSource उदाहरण के तौर पर ट्रेन फंक्शन के लिए इनपुट फंक्शन ऑन लॉस फंक्शन इस प्रकार है -

कार्यान्वयन उदाहरण

Step 1 - प्रशिक्षण सत्र के आउटपुट को लॉग करने के लिए, पहले ProgressPrinter से आयात करें cntk.logging मॉड्यूल निम्नानुसार है -

from cntk.logging import ProgressPrinterStep 2 - अगला, प्रशिक्षण सत्र स्थापित करने के लिए, आयात करें trainer तथा training_session से cntk.train मॉड्यूल निम्नानुसार है -

from cntk.train import Trainer,Step 3 - अब, हमें स्थिरांक के कुछ सेट को परिभाषित करने की आवश्यकता है minibatch_size, samples_per_epoch तथा num_epochs निम्नानुसार है -

minbatch_size = 16

samples_per_epoch = 150

num_epochs = 30Step 4 - अगला, प्रशिक्षण के दौरान डेटा को पढ़ने के लिए CNTK को जानने के लिए, हमें नेटवर्क के लिए इनपुट चर और मिनीबैच स्रोत में धाराओं के बीच मानचित्रण को परिभाषित करने की आवश्यकता है।

input_map = {

features: minibatch.source.streams.features,

labels: minibatch.source.streams.features

}Step 5 - अगला, प्रशिक्षण प्रक्रिया के आउटपुट को लॉग करने के लिए, इनिशियलाइज़ करें progress_printer एक नया के साथ चर ProgressPrinter उदाहरण इस प्रकार है -

progress_writer = ProgressPrinter(0)Step 6 - अंत में, हमें ट्रेन की विधि को नुकसान पर लागू करने की आवश्यकता है -

train_history = loss.train(minibatch_source,

parameter_learners=[learner],

model_inputs_to_streams=input_map,

callbacks=[progress_writer],

epoch_size=samples_per_epoch,

max_epochs=num_epochs)डेटा खिलाना - पूर्ण कार्यान्वयन उदाहरण

from cntk.logging import ProgressPrinter

from cntk.train import Trainer, training_session

minbatch_size = 16

samples_per_epoch = 150

num_epochs = 30

input_map = {

features: minibatch.source.streams.features,

labels: minibatch.source.streams.features

}

progress_writer = ProgressPrinter(0)

train_history = loss.train(minibatch_source,

parameter_learners=[learner],

model_inputs_to_streams=input_map,

callbacks=[progress_writer],

epoch_size=samples_per_epoch,

max_epochs=num_epochs)उत्पादन

-------------------------------------------------------------------

average since average since examples

loss last metric last

------------------------------------------------------

Learning rate per minibatch: 0.1

1.21 1.21 0 0 32

1.15 0.12 0 0 96

[………]CNTK - प्रदर्शन को मापने

यह अध्याय बताएगा कि CNKT में मॉडल प्रदर्शन को कैसे मापें।

मॉडल के प्रदर्शन को मान्य करने की रणनीति

एमएल मॉडल बनाने के बाद, हम डेटा नमूनों के एक सेट का उपयोग करके इसे प्रशिक्षित करते थे। इस प्रशिक्षण के कारण हमारा एमएल मॉडल कुछ सामान्य नियमों को सीखता है और प्राप्त करता है। एमएल मॉडल का प्रदर्शन तब मायने रखता है जब हम मॉडल के लिए, नए नमूने, यानी प्रशिक्षण के समय प्रदान किए गए विभिन्न नमूनों को खिलाते हैं। मॉडल उस मामले में अलग तरह से व्यवहार करता है। यह उन नए नमूनों पर एक अच्छी भविष्यवाणी करने से भी बदतर हो सकता है।

लेकिन मॉडल को नए नमूनों के लिए अच्छी तरह से काम करना चाहिए क्योंकि उत्पादन के माहौल में हमें प्रशिक्षण उद्देश्य के लिए नमूना डेटा का उपयोग करने की तुलना में अलग इनपुट मिलेगा। यही कारण है कि, हमें प्रशिक्षण उद्देश्य के लिए उपयोग किए गए नमूनों से अलग नमूनों का एक सेट का उपयोग करके एमएल मॉडल को मान्य करना चाहिए। यहां, हम एनएन को मान्य करने के लिए डेटासेट बनाने के लिए दो अलग-अलग तकनीकों पर चर्चा करने जा रहे हैं।

होल्ड-आउट डेटासेट

एनएन को मान्य करने के लिए डेटासेट बनाने के लिए यह सबसे आसान तरीकों में से एक है। जैसा कि नाम का अर्थ है, इस पद्धति में हम प्रशिक्षण से नमूने का एक सेट (20% कहते हैं) वापस लेंगे और इसका उपयोग हमारे एमएल मॉडल के प्रदर्शन का परीक्षण करने के लिए करेंगे। निम्नलिखित आरेख प्रशिक्षण और सत्यापन नमूनों के बीच का अनुपात दर्शाता है -

होल्ड-आउट डेटासेट मॉडल सुनिश्चित करता है कि हमारे एमएल मॉडल को प्रशिक्षित करने के लिए हमारे पास पर्याप्त डेटा है और साथ ही हमारे पास मॉडल के प्रदर्शन का अच्छा माप प्राप्त करने के लिए उचित संख्या में नमूने होंगे।

प्रशिक्षण सेट और परीक्षण सेट में शामिल करने के लिए, मुख्य डेटासेट से यादृच्छिक नमूने चुनने के लिए यह एक अच्छा अभ्यास है। यह प्रशिक्षण और परीक्षण सेट के बीच एक समान वितरण सुनिश्चित करता है।

निम्नलिखित एक उदाहरण है जिसमें हम उपयोग करके स्वयं होल्ड-आउट डेटासेट का उत्पादन कर रहे हैं train_test_split से कार्य करते हैं scikit-learn पुस्तकालय।

उदाहरण

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=1)

# Here above test_size = 0.2 represents that we provided 20% of the data as test data.

from sklearn.neighbors import KNeighborsClassifier

from sklearn import metrics

classifier_knn = KNeighborsClassifier(n_neighbors=3)

classifier_knn.fit(X_train, y_train)

y_pred = classifier_knn.predict(X_test)

# Providing sample data and the model will make prediction out of that data

sample = [[5, 5, 3, 2], [2, 4, 3, 5]]

preds = classifier_knn.predict(sample)

pred_species = [iris.target_names[p] for p in preds] print("Predictions:", pred_species)उत्पादन

Predictions: ['versicolor', 'virginica']CNTK का उपयोग करते समय, हमें हर बार जब हम अपने मॉडल को प्रशिक्षित करते हैं, तो हमारे डेटासेट के क्रम को यादृच्छिक बनाने की आवश्यकता होती है क्योंकि -

डीप लर्निंग एल्गोरिदम यादृच्छिक-संख्या जनरेटर से अत्यधिक प्रभावित होते हैं।

जिस क्रम में हम प्रशिक्षण के दौरान एनएन को नमूने प्रदान करते हैं, उसके प्रदर्शन को बहुत प्रभावित करता है।

होल्ड-आउट डेटासेट तकनीक का उपयोग करने का मुख्य पहलू यह है कि यह अविश्वसनीय है क्योंकि कभी-कभी हमें बहुत अच्छे परिणाम मिलते हैं लेकिन कभी-कभी, हम खराब परिणाम देते हैं।

K- गुना क्रॉस सत्यापन

हमारे एमएल मॉडल को अधिक विश्वसनीय बनाने के लिए, के-फोल्ड क्रॉस सत्यापन नामक एक तकनीक है। प्रकृति में K- गुना क्रॉस सत्यापन तकनीक पिछली तकनीक के समान है, लेकिन यह इसे कई बार दोहराता है-आमतौर पर लगभग 5 से 10 बार। निम्नलिखित आरेख इसकी अवधारणा का प्रतिनिधित्व करता है -

K- गुना क्रॉस सत्यापन का कार्य करना

K- गुना क्रॉस सत्यापन के कार्य को निम्नलिखित चरणों की सहायता से समझा जा सकता है -

Step 1- जैसे कि हैंड-आउट डेटासेट तकनीक, के-फोल्ड क्रॉस सत्यापन तकनीक में, पहले हमें डेटासेट को एक प्रशिक्षण और परीक्षण सेट में विभाजित करना होगा। आदर्श रूप से, अनुपात 80-20 है, अर्थात प्रशिक्षण सेट का 80% और परीक्षण सेट का 20%।

Step 2 - अगला, हमें प्रशिक्षण सेट का उपयोग करके अपने मॉडल को प्रशिक्षित करने की आवश्यकता है।

Step 3अंतिम बार, हम अपने मॉडल के प्रदर्शन को मापने के लिए परीक्षण सेट का उपयोग करेंगे। होल्ड-आउट डेटासेट तकनीक और के-क्रॉस सत्यापन तकनीक के बीच एकमात्र अंतर यह है कि उपरोक्त प्रक्रिया आमतौर पर 5 से 10 बार दोहराई जाती है और अंत में सभी प्रदर्शन मैट्रिक्स पर गणना की जाती है। यह औसत अंतिम प्रदर्शन मेट्रिक्स होगा।

आइए एक छोटे डेटासेट के साथ एक उदाहरण देखें -

उदाहरण

from numpy import array

from sklearn.model_selection import KFold

data = array([0.1, 0.2, 0.3, 0.4, 0.5, 0.6, 0.7, 0.8, 0.9, 1.0])

kfold = KFold(5, True, 1)

for train, test in kfold.split(data):

print('train: %s, test: %s' % (data[train],(data[test]))उत्पादन

train: [0.1 0.2 0.4 0.5 0.6 0.7 0.8 0.9], test: [0.3 1. ]

train: [0.1 0.2 0.3 0.4 0.6 0.8 0.9 1. ], test: [0.5 0.7]

train: [0.2 0.3 0.5 0.6 0.7 0.8 0.9 1. ], test: [0.1 0.4]

train: [0.1 0.3 0.4 0.5 0.6 0.7 0.9 1. ], test: [0.2 0.8]

train: [0.1 0.2 0.3 0.4 0.5 0.7 0.8 1. ], test: [0.6 0.9]जैसा कि हम देखते हैं, अधिक यथार्थवादी प्रशिक्षण और परीक्षण परिदृश्य का उपयोग करने के कारण, k- गुना क्रॉस सत्यापन तकनीक हमें अधिक स्थिर प्रदर्शन माप प्रदान करती है लेकिन, नकारात्मक पक्ष पर, गहन शिक्षण मॉडल को मान्य करते समय बहुत समय लगता है।

CNTK k- क्रॉस सत्यापन के लिए समर्थन नहीं करता है, इसलिए हमें ऐसा करने के लिए अपनी स्क्रिप्ट लिखने की आवश्यकता है।

अंडरफुटिंग और ओवरफिटिंग का पता लगाना

क्या, हम हैंड-आउट डेटासेट या के-फोल्ड क्रॉस-वैलिडेशन तकनीक का उपयोग करते हैं, हम पाएंगे कि मैट्रिक्स का आउटपुट प्रशिक्षण के लिए उपयोग किए गए डेटासेट और सत्यापन के लिए उपयोग किए जाने वाले डेटासेट के लिए अलग होगा।

ओवरफिटिंग का पता लगाना

ओवरफिटिंग नामक घटना एक ऐसी स्थिति है जहां हमारे एमएल मॉडल, प्रशिक्षण डेटा को असाधारण रूप से अच्छी तरह से मॉडल करते हैं, लेकिन परीक्षण डेटा पर अच्छा प्रदर्शन करने में विफल रहता है, अर्थात परीक्षण डेटा की भविष्यवाणी करने में सक्षम नहीं था।

यह तब होता है जब एक एमएल मॉडल प्रशिक्षण डेटा से एक विशिष्ट पैटर्न और शोर को इस हद तक सीखता है, कि यह उस मॉडल को प्रशिक्षण डेटा से नए यानी अनदेखे डेटा को सामान्य बनाने की क्षमता को नकारात्मक रूप से प्रभावित करता है। यहाँ, शोर एक अप्रासंगिक सूचना या डेटासेट में यादृच्छिकता है।

निम्नलिखित दो तरीके हैं जिनकी मदद से हम मौसम का पता लगा सकते हैं कि हमारा मॉडल ओवरफिट है या नहीं -

ओवरफिट मॉडल उन्हीं नमूनों पर अच्छा प्रदर्शन करेगा जो हमने प्रशिक्षण के लिए उपयोग किए थे, लेकिन यह नए नमूनों पर बहुत खराब प्रदर्शन करेगा, यानी प्रशिक्षण के लिए अलग-अलग नमूने।

सत्यापन के दौरान मॉडल ओवरफिट है यदि परीक्षण सेट पर मीट्रिक उसी मीट्रिक से कम है, तो हम अपने प्रशिक्षण सेट पर उपयोग करते हैं।

अंडरफुटिंग का पता लगाना

हमारे एमएल में एक और स्थिति पैदा हो सकती है। यह एक ऐसी स्थिति है, जहां हमारे एमएल मॉडल ने प्रशिक्षण डेटा को अच्छी तरह से मॉडल नहीं किया है और उपयोगी आउटपुट की भविष्यवाणी करने में विफल रहता है। जब हम पहले युग का प्रशिक्षण शुरू करते हैं, तो हमारा मॉडल कमज़ोर हो जाएगा, लेकिन प्रशिक्षण प्रगति के रूप में कम कमतर हो जाएगा।

पता लगाने के तरीकों में से एक, कि क्या हमारा मॉडल अंडरफिट है या नहीं, प्रशिक्षण सेट और परीक्षण सेट के लिए मैट्रिक्स को देखना है या नहीं। यदि परीक्षण सेट पर मीट्रिक प्रशिक्षण सेट पर मीट्रिक से अधिक है तो हमारा मॉडल कमतर होगा।

CNTK - तंत्रिका नेटवर्क वर्गीकरण

इस अध्याय में, हम अध्ययन करेंगे कि CNTK का उपयोग करके तंत्रिका नेटवर्क को कैसे वर्गीकृत किया जाए।

परिचय

वर्गीकरण को दिए गए इनपुट डेटा के लिए श्रेणीबद्ध आउटपुट लेबल या प्रतिक्रियाओं की भविष्यवाणी करने की प्रक्रिया के रूप में परिभाषित किया जा सकता है। वर्गीकृत उत्पादन, जो कि मॉडल ने प्रशिक्षण चरण में सीखा है, के आधार पर "ब्लैक" या "व्हाइट" या "स्पैम" या "नो स्पैम" जैसे रूप हो सकते हैं।

दूसरी ओर, गणितीय रूप से, यह मानचित्रण फ़ंक्शन को कहने का कार्य है f इनपुट चर से एक्स कहते हैं कि आउटपुट चर से Y कहते हैं।

वर्गीकरण समस्या का एक उत्कृष्ट उदाहरण ई-मेल में स्पैम का पता लगाना हो सकता है। यह स्पष्ट है कि आउटपुट की केवल दो श्रेणियां हो सकती हैं, "स्पैम" और "नो स्पैम"।

इस तरह के वर्गीकरण को लागू करने के लिए, हमें सबसे पहले उस क्लासिफायर का प्रशिक्षण करना होगा, जहां "स्पैम" और "नो स्पैम" ईमेल का उपयोग प्रशिक्षण डेटा के रूप में किया जाएगा। एक बार, क्लासिफायरवार सफलतापूर्वक प्रशिक्षित, इसका उपयोग किसी अज्ञात ईमेल का पता लगाने के लिए किया जा सकता है।

यहाँ, हम एक 4-5-3 NN बनाने जा रहे हैं जिसमें आईरिस फूल डेटासेट का उपयोग किया गया है -

4-इनपुट नोड्स (प्रत्येक पूर्वसूचक मूल्य के लिए एक)।

5-छिपे हुए प्रसंस्करण नोड्स।

3-आउटपुट नोड्स (क्योंकि आईरिस डाटासेट में तीन संभावित प्रजातियां हैं)।

डेटासेट लोड हो रहा है

हम आईरिस फूल डेटासेट का उपयोग करेंगे, जिससे हम आइरिस फूलों की प्रजातियों को सेपाल चौड़ाई और लंबाई के भौतिक गुणों और पंखुड़ी की चौड़ाई और लंबाई के आधार पर वर्गीकृत करना चाहते हैं। डेटासेट में आईरिस फूलों की विभिन्न किस्मों के भौतिक गुणों का वर्णन है -

सिपाही की लंबाई

सिपाही की चौड़ाई

पंखुड़ी की लंबाई

पेटल की चौड़ाई

कक्षा यानी आईरिस सेटोसा या आईरिस वर्सिकोलर या आईरिस वर्जिनिका