Hadoop - Solusi Big Data

Pendekatan tradisional

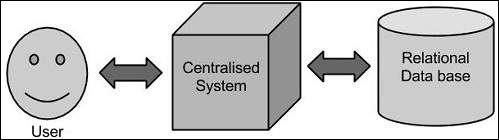

Dalam pendekatan ini, suatu perusahaan akan memiliki komputer untuk menyimpan dan memproses data besar. Untuk tujuan penyimpanan, pemrogram akan mengambil bantuan vendor database pilihan mereka seperti Oracle, IBM, dll. Dalam pendekatan ini, pengguna berinteraksi dengan aplikasi, yang pada gilirannya menangani bagian penyimpanan dan analisis data.

Keterbatasan

Pendekatan ini berfungsi dengan baik dengan aplikasi yang memproses data yang lebih sedikit yang dapat diakomodasi oleh server database standar, atau hingga batas prosesor yang memproses data. Tetapi ketika berurusan dengan data dalam jumlah besar yang dapat diskalakan, itu adalah tugas yang sangat sibuk untuk memproses data tersebut melalui satu hambatan database.

Solusi Google

Google memecahkan masalah ini menggunakan algoritma yang disebut MapReduce. Algoritma ini membagi tugas menjadi bagian-bagian kecil dan menugaskannya ke banyak komputer, dan mengumpulkan hasil dari mereka yang ketika diintegrasikan, membentuk dataset hasil.

Hadoop

Menggunakan solusi yang disediakan oleh Google, Doug Cutting dan timnya mengembangkan Proyek Sumber Terbuka bernama HADOOP.

Hadoop menjalankan aplikasi menggunakan algoritma MapReduce, di mana datanya diproses secara paralel dengan yang lain. Singkatnya, Hadoop digunakan untuk mengembangkan aplikasi yang dapat melakukan analisis statistik lengkap pada sejumlah besar data.