Apprendimento automatico con Python - Guida rapida

Viviamo nell'era dei dati che si arricchisce di una migliore potenza di calcolo e di più risorse di archiviazione. Questi dati o informazioni aumentano di giorno in giorno, ma la vera sfida è dare un senso a tutti i dati. Le aziende e le organizzazioni stanno cercando di affrontarlo costruendo sistemi intelligenti utilizzando i concetti e le metodologie di Data science, Data mining e Machine learning. Tra questi, l'apprendimento automatico è il campo più interessante dell'informatica. Non sarebbe sbagliato se chiamassimo apprendimento automatico l'applicazione e la scienza degli algoritmi che forniscono un senso ai dati.

Cos'è l'apprendimento automatico?

L'apprendimento automatico (ML) è quel campo dell'informatica con l'aiuto del quale i sistemi informatici possono fornire un senso ai dati più o meno allo stesso modo degli esseri umani.

In parole semplici, ML è un tipo di intelligenza artificiale che estrae modelli da dati grezzi utilizzando un algoritmo o un metodo. L'obiettivo principale del ML è consentire ai sistemi informatici di apprendere dall'esperienza senza essere programmati esplicitamente o l'intervento umano.

Necessità di machine learning

Gli esseri umani, in questo momento, sono le specie più intelligenti e avanzate della terra perché sanno pensare, valutare e risolvere problemi complessi. D'altra parte, l'IA è ancora nella sua fase iniziale e non ha superato l'intelligenza umana in molti aspetti. Allora la domanda è: qual è la necessità di far apprendere alla macchina? La ragione più adatta per farlo è "prendere decisioni, basate sui dati, con efficienza e scalabilità".

Ultimamente, le organizzazioni stanno investendo molto in tecnologie più recenti come Intelligenza Artificiale, Machine Learning e Deep Learning per ottenere le informazioni chiave dai dati per eseguire diverse attività del mondo reale e risolvere i problemi. Possiamo chiamarle decisioni guidate dai dati prese dalle macchine, in particolare per automatizzare il processo. Queste decisioni basate sui dati possono essere utilizzate, invece di utilizzare la logica di programmazione, nei problemi che non possono essere programmati intrinsecamente. Il fatto è che non possiamo fare a meno dell'intelligenza umana, ma un altro aspetto è che tutti dobbiamo risolvere i problemi del mondo reale con efficienza su vasta scala. Ecco perché nasce la necessità dell'apprendimento automatico.

Perché e quando far imparare le macchine?

Abbiamo già discusso della necessità del machine learning, ma sorge un'altra domanda: in quali scenari dobbiamo far apprendere alla macchina? Possono esserci diverse circostanze in cui abbiamo bisogno che le macchine prendano decisioni basate sui dati con efficienza e su vasta scala. Le seguenti sono alcune delle circostanze in cui fare in modo che le macchine apprendano sarebbe più efficace:

Mancanza di esperienza umana

Il primo scenario in cui vogliamo che una macchina apprenda e prenda decisioni basate sui dati può essere il dominio in cui manca la competenza umana. Gli esempi possono essere navigazioni in territori sconosciuti o pianeti spaziali.

Scenari dinamici

Ci sono alcuni scenari di natura dinamica, cioè continuano a cambiare nel tempo. In caso di questi scenari e comportamenti, vogliamo che una macchina apprenda e prenda decisioni basate sui dati. Alcuni degli esempi possono essere la connettività di rete e la disponibilità dell'infrastruttura in un'organizzazione.

Difficoltà nel tradurre le competenze in compiti computazionali

Ci possono essere vari domini in cui gli esseri umani hanno la loro esperienza; tuttavia, non sono in grado di tradurre questa esperienza in compiti computazionali. In tali circostanze, vogliamo l'apprendimento automatico. Gli esempi possono essere i domini del riconoscimento vocale, compiti cognitivi ecc.

Modello di machine learning

Prima di discutere il modello di apprendimento automatico, dobbiamo comprendere la seguente definizione formale di ML fornita dal professor Mitchell:

"Si dice che un programma per computer impari dall'esperienza E rispetto ad alcune classi di compiti T e misura delle prestazioni P, se le sue prestazioni nei compiti in T, misurate da P, migliorano con l'esperienza E."

La definizione di cui sopra si concentra fondamentalmente su tre parametri, anche i componenti principali di qualsiasi algoritmo di apprendimento, vale a dire Task (T), Performance (P) ed esperienza (E). In questo contesto, possiamo semplificare questa definizione come:

ML è un campo dell'IA costituito da algoritmi di apprendimento che:

Migliora le loro prestazioni (P)

Durante l'esecuzione di un compito (T)

Nel tempo con l'esperienza (E)

Sulla base di quanto sopra, il diagramma seguente rappresenta un modello di machine learning:

Parliamone più in dettaglio ora -

Compito (T)

Dal punto di vista del problema, possiamo definire il compito T come il problema del mondo reale da risolvere. Il problema può essere qualsiasi cosa come trovare il miglior prezzo della casa in una posizione specifica o trovare la migliore strategia di marketing ecc. D'altra parte, se parliamo di apprendimento automatico, la definizione di attività è diversa perché è difficile risolvere attività basate su ML approccio di programmazione convenzionale.

Si dice che un'attività T sia un'attività basata su ML quando è basata sul processo e il sistema deve seguire per operare sui punti dati. Gli esempi di attività basate su ML sono Classificazione, Regressione, Annotazione strutturata, Clustering, Trascrizione ecc.

Esperienza (E)

Come suggerisce il nome, è la conoscenza acquisita dai punti dati forniti all'algoritmo o al modello. Una volta fornito il set di dati, il modello verrà eseguito in modo iterativo e apprenderà alcuni pattern intrinseci. L'apprendimento così acquisito si chiama esperienza (E). Facendo un'analogia con l'apprendimento umano, possiamo pensare a questa situazione come in cui un essere umano sta imparando o acquisendo esperienza da vari attributi come situazione, relazioni, ecc. L'apprendimento supervisionato, non supervisionato e di rinforzo sono alcuni modi per apprendere o acquisire esperienza. L'esperienza acquisita dal nostro modello o algoritmo ML verrà utilizzata per risolvere il compito T.

Prestazioni (P)

Si suppone che un algoritmo ML svolga un'attività e acquisisca esperienza con il passare del tempo. La misura che dice se l'algoritmo ML sta funzionando come previsto o meno è la sua performance (P). P è fondamentalmente una metrica quantitativa che racconta come un modello sta eseguendo l'attività, T, usando la sua esperienza, E. Ci sono molte metriche che aiutano a comprendere le prestazioni di ML, come il punteggio di precisione, il punteggio F1, la matrice di confusione, la precisione, il richiamo , sensibilità ecc.

Sfide nell'apprendimento delle macchine

Mentre l'apprendimento automatico è in rapida evoluzione, facendo passi da gigante con la sicurezza informatica e le auto autonome, questo segmento dell'IA nel suo complesso ha ancora molta strada da fare. Il motivo è che il ML non è stato in grado di superare una serie di sfide. Le sfide che il ML sta affrontando attualmente sono:

Quality of data- Disporre di dati di buona qualità per gli algoritmi ML è una delle maggiori sfide. L'utilizzo di dati di bassa qualità porta ai problemi relativi alla preelaborazione dei dati e all'estrazione delle caratteristiche.

Time-Consuming task - Un'altra sfida affrontata dai modelli ML è il consumo di tempo soprattutto per l'acquisizione dei dati, l'estrazione e il recupero delle caratteristiche.

Lack of specialist persons - Poiché la tecnologia ML è ancora nella sua fase iniziale, la disponibilità di risorse esperte è un lavoro arduo.

No clear objective for formulating business problems - Non avere un obiettivo chiaro e ben definito per i problemi aziendali è un'altra sfida chiave per il ML perché questa tecnologia non è ancora così matura.

Issue of overfitting & underfitting - Se il modello è overfitting o underfitting, non può essere rappresentato bene per il problema.

Curse of dimensionality- Un'altra sfida che il modello ML deve affrontare sono le troppe funzionalità dei punti dati. Questo può essere un vero ostacolo.

Difficulty in deployment - La complessità del modello ML ne rende abbastanza difficile l'implementazione nella vita reale.

Applicazioni di Machine Learning

Il machine learning è la tecnologia in più rapida crescita e secondo i ricercatori siamo nell'anno d'oro dell'intelligenza artificiale e del machine learning. Viene utilizzato per risolvere molti problemi complessi del mondo reale che non possono essere risolti con l'approccio tradizionale. Di seguito sono riportate alcune applicazioni del mondo reale di ML:

Analisi delle emozioni

Analisi del sentiment

Rilevamento e prevenzione degli errori

Previsioni e previsioni meteorologiche

Analisi e previsioni del mercato azionario

Sintesi vocale

Riconoscimento vocale

Segmentazione della clientela

Riconoscimento di oggetti

Intercettazione di una frode

Prevenzione frodi

Raccomandazione dei prodotti al cliente nello shopping online.

Un'introduzione a Python

Python è un popolare linguaggio di programmazione orientato agli oggetti con le capacità del linguaggio di programmazione di alto livello. La sua sintassi facile da imparare e la capacità di portabilità lo rendono popolare in questi giorni. I fatti seguenti ci danno l'introduzione a Python:

Python è stato sviluppato da Guido van Rossum allo Stichting Mathematisch Centrum nei Paesi Bassi.

È stato scritto come il successore del linguaggio di programmazione denominato "ABC".

La sua prima versione è stata rilasciata nel 1991.

Il nome Python è stato scelto da Guido van Rossum da uno show televisivo chiamato Monty Python's Flying Circus.

È un linguaggio di programmazione open source, il che significa che possiamo scaricarlo gratuitamente e utilizzarlo per sviluppare programmi. Può essere scaricato da www.python.org .

Il linguaggio di programmazione Python ha le caratteristiche di Java e C sia. Ha l'elegante codice "C" e d'altra parte, ha classi e oggetti come Java per la programmazione orientata agli oggetti.

È un linguaggio interpretato, il che significa che il codice sorgente del programma Python verrà prima convertito in bytecode e quindi eseguito dalla macchina virtuale Python.

Punti di forza e di debolezza di Python

Ogni linguaggio di programmazione ha alcuni punti di forza oltre che di debolezza, così come Python.

Punti di forza

Secondo studi e sondaggi, Python è il quinto linguaggio più importante nonché il linguaggio più popolare per l'apprendimento automatico e la scienza dei dati. È a causa dei seguenti punti di forza che Python ha:

Easy to learn and understand- La sintassi di Python è più semplice; quindi è relativamente facile, anche per i principianti, imparare e capire la lingua.

Multi-purpose language - Python è un linguaggio di programmazione multiuso perché supporta la programmazione strutturata, la programmazione orientata agli oggetti e la programmazione funzionale.

Huge number of modules- Python ha un numero enorme di moduli per coprire ogni aspetto della programmazione. Questi moduli sono facilmente disponibili per l'uso, quindi rendono Python un linguaggio estensibile.

Support of open source community- Essendo un linguaggio di programmazione open source, Python è supportato da una comunità di sviluppatori molto ampia. Per questo motivo, i bug vengono facilmente risolti dalla comunità Python. Questa caratteristica rende Python molto robusto e adattabile.

Scalability - Python è un linguaggio di programmazione scalabile perché fornisce una struttura migliorata per supportare programmi di grandi dimensioni rispetto agli script di shell.

Debolezza

Sebbene Python sia un linguaggio di programmazione popolare e potente, ha il suo punto debole nella velocità di esecuzione lenta.

La velocità di esecuzione di Python è lenta rispetto ai linguaggi compilati perché Python è un linguaggio interpretato. Questa può essere la principale area di miglioramento per la comunità Python.

Installazione di Python

Per lavorare in Python, dobbiamo prima installarlo. Puoi eseguire l'installazione di Python in uno dei seguenti due modi:

Installazione di Python individualmente

Utilizzo della distribuzione Python preconfezionata - Anaconda

Discutiamoli ciascuno in dettaglio.

Installazione di Python individualmente

Se vuoi installare Python sul tuo computer, allora devi scaricare solo il codice binario applicabile per la tua piattaforma. La distribuzione Python è disponibile per piattaforme Windows, Linux e Mac.

Quella che segue è una rapida panoramica dell'installazione di Python sulle piattaforme sopra menzionate:

On Unix and Linux platform

Con l'aiuto dei seguenti passaggi, possiamo installare Python su piattaforma Unix e Linux -

Per prima cosa, vai a https://www.python.org/downloads/.

Quindi, fare clic sul collegamento per scaricare il codice sorgente zippato disponibile per Unix / Linux.

Ora, scarica ed estrai i file.

Successivamente, possiamo modificare il file Modules / Setup se vogliamo personalizzare alcune opzioni.

Quindi, scrivi il comando run ./configure script

make

fare installazione

On Windows platform

Con l'aiuto dei seguenti passaggi, possiamo installare Python sulla piattaforma Windows -

Per prima cosa, vai a https://www.python.org/downloads/.

Quindi, fare clic sul collegamento per il file python-XYZ.msi del programma di installazione di Windows. Qui XYZ è la versione che desideriamo installare.

Ora dobbiamo eseguire il file scaricato. Ci porterà alla procedura guidata di installazione di Python, che è facile da usare. Ora, accetta le impostazioni predefinite e attendi fino al termine dell'installazione.

On Macintosh platform

Per Mac OS X, Homebrew, si consiglia un programma di installazione di pacchetti fantastico e facile da usare per installare Python 3. Nel caso in cui non si disponga di Homebrew, è possibile installarlo con l'aiuto del seguente comando:

$ ruby -e "$(curl -fsSL

https://raw.githubusercontent.com/Homebrew/install/master/install)"Può essere aggiornato con il comando sottostante -

$ brew updateOra, per installare Python3 sul tuo sistema, dobbiamo eseguire il seguente comando:

$ brew install python3Utilizzo della distribuzione Python preconfezionata: Anaconda

Anaconda è una raccolta pacchettizzata di Python che include tutte le librerie ampiamente utilizzate nella scienza dei dati. Possiamo seguire i seguenti passaggi per configurare l'ambiente Python usando Anaconda -

Step1- Per prima cosa, dobbiamo scaricare il pacchetto di installazione richiesto dalla distribuzione di Anaconda. Il collegamento per lo stesso èhttps://www.anaconda.com/distribution/. Puoi scegliere tra Windows, Mac e Linux OS secondo le tue esigenze.

Step2- Quindi, seleziona la versione di Python che desideri installare sulla tua macchina. L'ultima versione di Python è la 3.7. Lì otterrai le opzioni per il programma di installazione grafico a 64 bit e 32 bit entrambi.

Step3- Dopo aver selezionato il sistema operativo e la versione di Python, scaricherà il programma di installazione di Anaconda sul tuo computer. Ora, fai doppio clic sul file e il programma di installazione installerà il pacchetto Anaconda.

Step4 - Per verificare se è installato o meno, apri un prompt dei comandi e digita Python come segue -

Puoi anche verificarlo in una conferenza video dettagliata suhttps://www.tutorialspoint.com/python_essentials_online_training/getting_started_with_anaconda.asp.

Perché Python per la scienza dei dati?

Python è il quinto linguaggio più importante e il linguaggio più popolare per l'apprendimento automatico e la scienza dei dati. Le seguenti sono le caratteristiche di Python che lo rendono la scelta di linguaggio preferita per la scienza dei dati:

Ampio set di pacchetti

Python ha un ampio e potente set di pacchetti pronti per essere utilizzati in vari domini. Ha anche pacchetti come numpy, scipy, pandas, scikit-learn ecc. Che sono necessari per l'apprendimento automatico e la scienza dei dati.

Facile prototipazione

Un'altra caratteristica importante di Python che lo rende la scelta del linguaggio per la scienza dei dati è la prototipazione facile e veloce. Questa funzione è utile per sviluppare un nuovo algoritmo.

Funzionalità di collaborazione

Il campo della scienza dei dati ha fondamentalmente bisogno di una buona collaborazione e Python fornisce molti strumenti utili che lo rendono estremamente.

Una lingua per molti domini

Un tipico progetto di data science include vari domini come l'estrazione dei dati, la manipolazione dei dati, l'analisi dei dati, l'estrazione delle funzionalità, la modellazione, la valutazione, la distribuzione e l'aggiornamento della soluzione. Poiché Python è un linguaggio multiuso, consente al data scientist di affrontare tutti questi domini da una piattaforma comune.

Componenti dell'ecosistema Python ML

In questa sezione, discutiamo di alcune librerie di Data Science di base che formano i componenti dell'ecosistema di apprendimento automatico di Python. Questi componenti utili rendono Python un linguaggio importante per la scienza dei dati. Sebbene ci siano molti di questi componenti, discutiamo qui alcuni dei componenti importanti dell'ecosistema Python:

Jupyter Notebook

I notebook Jupyter forniscono fondamentalmente un ambiente computazionale interattivo per lo sviluppo di applicazioni di Data Science basate su Python. In precedenza sono noti come notebook ipython. Le seguenti sono alcune delle caratteristiche dei notebook Jupyter che lo rendono uno dei migliori componenti dell'ecosistema Python ML:

I taccuini Jupyter possono illustrare il processo di analisi passo dopo passo organizzando le cose come codice, immagini, testo, output ecc. In modo graduale.

Aiuta un data scientist a documentare il processo di pensiero mentre sviluppa il processo di analisi.

Si può anche catturare il risultato come parte del notebook.

Con l'aiuto dei taccuini jupyter, possiamo condividere il nostro lavoro anche con un collega.

Installazione ed esecuzione

Se stai usando la distribuzione Anaconda, non è necessario installare il notebook jupyter separatamente poiché è già installato con esso. Devi solo andare su Anaconda Prompt e digitare il seguente comando:

C:\>jupyter notebookDopo aver premuto Invio, avvierà un server notebook su localhost: 8888 del tuo computer. È mostrato nella seguente schermata:

Ora, dopo aver fatto clic sulla scheda Nuovo, otterrai un elenco di opzioni. Seleziona Python 3 e ti porterà al nuovo notebook per iniziare a lavorarci. Lo vedrai nelle seguenti schermate:

D'altra parte, se si utilizza la distribuzione Python standard, il notebook jupyter può essere installato utilizzando il popolare programma di installazione di pacchetti Python, pip.

pip install jupyterTipi di celle in Jupyter Notebook

I seguenti sono i tre tipi di celle in un quaderno jupyter:

Code cells- Come suggerisce il nome, possiamo usare queste celle per scrivere codice. Dopo aver scritto il codice / contenuto, lo invierà al kernel associato al notebook.

Markdown cells- Possiamo usare queste celle per annotare il processo di calcolo. Possono contenere elementi come testo, immagini, equazioni Latex, tag HTML ecc.

Raw cells- Il testo scritto in essi viene visualizzato così com'è. Queste celle servono fondamentalmente per aggiungere il testo che non desideriamo venga convertito dal meccanismo di conversione automatica di jupyter notebook.

Per uno studio più dettagliato del taccuino jupyter, puoi andare al linkhttps://www.tutorialspoint.com/jupyter/index.htm.

NumPy

È un altro componente utile che rende Python uno dei linguaggi preferiti per Data Science. Fondamentalmente sta per Numerical Python e consiste di oggetti array multidimensionali. Utilizzando NumPy, possiamo eseguire le seguenti importanti operazioni:

Operazioni matematiche e logiche su array.

Trasformazione di Fourier

Operazioni associate all'algebra lineare.

Possiamo anche vedere NumPy come la sostituzione di MatLab perché NumPy viene utilizzato principalmente insieme a Scipy (Scientific Python) e Mat-plotlib (libreria di plottaggio).

Installation and Execution

Se stai utilizzando la distribuzione Anaconda, non è necessario installare NumPy separatamente poiché è già installato con esso. Devi solo importare il pacchetto nel tuo script Python con l'aiuto di quanto segue:

import numpy as npD'altra parte, se si utilizza la distribuzione standard di Python, NumPy può essere installato utilizzando il popolare programma di installazione di pacchetti Python, pip.

pip install NumPyPer uno studio più dettagliato di NumPy, puoi andare al linkhttps://www.tutorialspoint.com/numpy/index.htm.

Panda

È un'altra utile libreria Python che rende Python uno dei linguaggi preferiti per Data Science. Pandas è fondamentalmente utilizzato per la manipolazione dei dati, le discussioni e l'analisi. È stato sviluppato da Wes McKinney nel 2008. Con l'aiuto di Pandas, nell'elaborazione dei dati possiamo eseguire i seguenti cinque passaggi:

Load

Prepare

Manipulate

Model

Analyze

Rappresentazione dei dati in Panda

L'intera rappresentazione dei dati in Panda viene eseguita con l'aiuto delle seguenti tre strutture di dati:

Series- È fondamentalmente un ndarray unidimensionale con un'etichetta dell'asse, il che significa che è come un semplice array con dati omogenei. Ad esempio, la serie seguente è una raccolta di numeri interi 1,5,10,15,24,25 ...

| 1 | 5 | 10 | 15 | 24 | 25 | 28 | 36 | 40 | 89 |

Data frame- È la struttura dati più utile e viene utilizzata per quasi tutti i tipi di rappresentazione e manipolazione dei dati nei panda. È fondamentalmente una struttura dati bidimensionale che può contenere dati eterogenei. In genere, i dati tabulari sono rappresentati utilizzando frame di dati. Ad esempio, la tabella seguente mostra i dati degli studenti con i loro nomi e numeri di ruolo, età e sesso -

Nome |

Numero del rullino |

Età |

Genere |

|---|---|---|---|

Aarav |

1 |

15 |

Maschio |

Harshit |

2 |

14 |

Maschio |

Kanika |

3 |

16 |

Femmina |

Mayank |

4 |

15 |

Maschio |

Panel- È una struttura dati tridimensionale contenente dati eterogenei. È molto difficile rappresentare il pannello in rappresentazione grafica, ma può essere illustrato come un contenitore di DataFrame.

La tabella seguente ci fornisce la dimensione e la descrizione delle strutture di dati sopra menzionate utilizzate in Panda -

Struttura dati |

Dimensione |

Descrizione |

|---|---|---|

Serie |

1-D |

Dimensioni immutabili, dati 1-D omogenei |

DataFrames |

2-D |

Dimensione Mutabile, dati eterogenei in forma tabulare |

Pannello |

3-D |

Matrice modificabile in base alle dimensioni, contenitore di DataFrame. |

Possiamo capire queste strutture di dati poiché la struttura di dati di dimensione superiore è il contenitore della struttura di dati di dimensione inferiore.

Installazione ed esecuzione

Se stai utilizzando la distribuzione Anaconda, non è necessario installare Pandas separatamente poiché è già installato con esso. Devi solo importare il pacchetto nel tuo script Python con l'aiuto di quanto segue:

import pandas as pdD'altra parte, se si utilizza la distribuzione Python standard, è possibile installare Pandas utilizzando il popolare programma di installazione di pacchetti Python, pip.

pip install PandasDopo aver installato Pandas, puoi importarlo nel tuo script Python come fatto sopra.

Esempio

Quello che segue è un esempio di creazione di una serie da ndarray utilizzando Pandas -

In [1]: import pandas as pd

In [2]: import numpy as np

In [3]: data = np.array(['g','a','u','r','a','v'])

In [4]: s = pd.Series(data)

In [5]: print (s)

0 g

1 a

2 u

3 r

4 a

5 v

dtype: objectPer uno studio più dettagliato dei Panda puoi andare al link https://www.tutorialspoint.com/python_pandas/index.htm.

Scikit-impara

Un'altra libreria python utile e più importante per la scienza dei dati e l'apprendimento automatico in Python è Scikit-learn. Le seguenti sono alcune caratteristiche di Scikit-learn che lo rendono così utile:

È costruito su NumPy, SciPy e Matplotlib.

È un open source e può essere riutilizzato con licenza BSD.

È accessibile a tutti e può essere riutilizzato in vari contesti.

Con l'aiuto di esso è possibile implementare un'ampia gamma di algoritmi di apprendimento automatico che coprono le principali aree del ML come la classificazione, il clustering, la regressione, la riduzione della dimensionalità, la selezione del modello ecc.

Installazione ed esecuzione

Se stai utilizzando la distribuzione Anaconda, non è necessario installare Scikit-learn separatamente poiché è già installato con essa. Devi solo usare il pacchetto nel tuo script Python. Ad esempio, con la seguente riga di script importiamo set di dati di pazienti con cancro al seno daScikit-learn -

from sklearn.datasets import load_breast_cancerD'altra parte, se stai usando la distribuzione standard di Python e hai NumPy e SciPy, Scikit-learn può essere installato usando il popolare programma di installazione del pacchetto Python, pip.

pip install -U scikit-learnDopo aver installato Scikit-learn, puoi usarlo nel tuo script Python come hai fatto sopra.

Esistono vari algoritmi, tecniche e metodi di ML che possono essere utilizzati per creare modelli per la risoluzione di problemi della vita reale utilizzando i dati. In questo capitolo discuteremo di questi diversi tipi di metodi.

Diversi tipi di metodi

Di seguito sono riportati vari metodi ML basati su alcune ampie categorie:

Basato sulla supervisione umana

Nel processo di apprendimento, alcuni dei metodi basati sulla supervisione umana sono i seguenti:

Supervised Learning

Gli algoritmi oi metodi di apprendimento supervisionato sono gli algoritmi ML più comunemente utilizzati. Questo metodo o algoritmo di apprendimento prende il campione di dati, ovvero i dati di addestramento e il relativo output associato, ovvero etichette o risposte con ciascun campione di dati durante il processo di addestramento.

L'obiettivo principale degli algoritmi di apprendimento supervisionato è apprendere un'associazione tra campioni di dati di input e output corrispondenti dopo aver eseguito più istanze di dati di addestramento.

Ad esempio, abbiamo

x: variabili di input e

Y: variabile di output

Ora, applica un algoritmo per apprendere la funzione di mappatura dall'input all'output come segue:

Y = f (x)

Ora, l'obiettivo principale sarebbe approssimare la funzione di mappatura così bene che anche quando abbiamo nuovi dati di input (x), possiamo facilmente prevedere la variabile di output (Y) per quei nuovi dati di input.

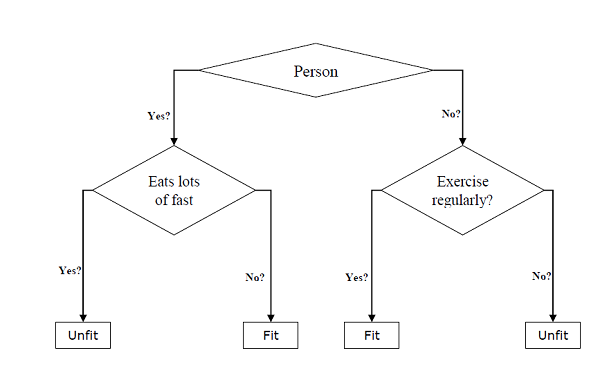

Si chiama supervisionato perché l'intero processo di apprendimento può essere pensato mentre è supervisionato da un insegnante o supervisore. Esempi di algoritmi di apprendimento automatico supervisionato includonoDecision tree, Random Forest, KNN, Logistic Regression eccetera.

In base alle attività di ML, gli algoritmi di apprendimento supervisionato possono essere suddivisi in due grandi classi:

Classification

Regression

Classification

L'obiettivo principale delle attività basate sulla classificazione è prevedere le etichette di output categoriali o le risposte per i dati di input forniti. L'output sarà basato su quanto il modello ha appreso in fase di formazione. Come sappiamo, le risposte di output categoriali indicano valori non ordinati e discreti, quindi ogni risposta di output apparterrà a una classe o categoria specifica. Discuteremo anche la classificazione e gli algoritmi associati in dettaglio nei prossimi capitoli.

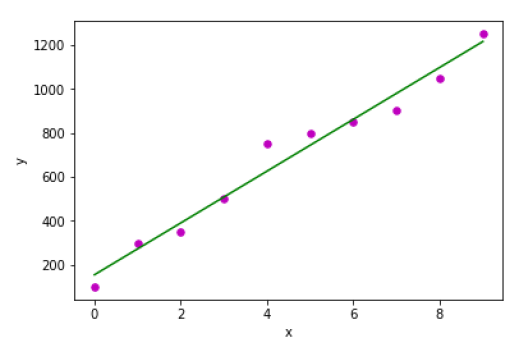

Regression

L'obiettivo principale delle attività basate sulla regressione è prevedere le etichette di output o le risposte che sono valori numerici continui, per i dati di input forniti. L'output sarà basato su ciò che il modello ha appreso nella sua fase di formazione. Fondamentalmente, i modelli di regressione utilizzano le caratteristiche dei dati di input (variabili indipendenti) ei loro corrispondenti valori numerici di output continui (variabili dipendenti o di risultato) per apprendere l'associazione specifica tra input e output corrispondenti. Discuteremo anche la regressione e gli algoritmi associati in dettaglio nei capitoli successivi.

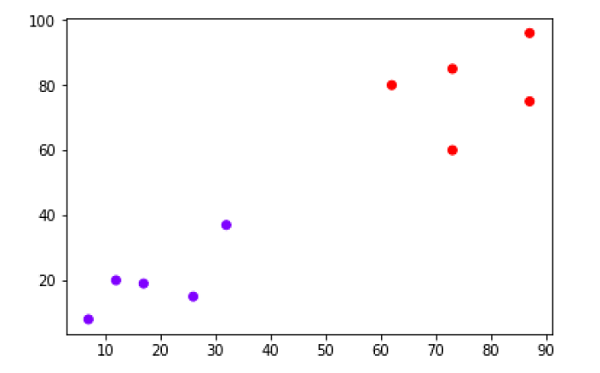

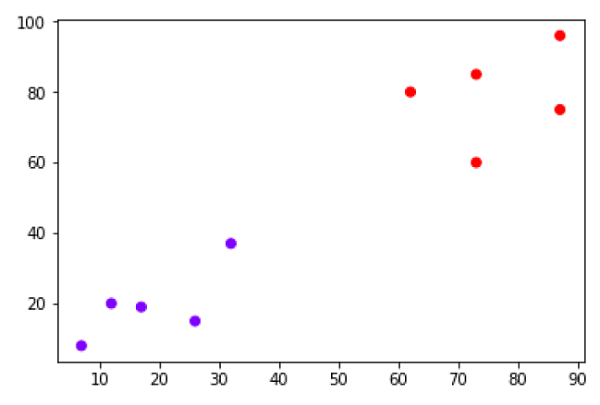

Apprendimento senza supervisione

Come suggerisce il nome, è l'opposto dei metodi o degli algoritmi di ML supervisionati, il che significa che negli algoritmi di machine learning non supervisionati non abbiamo alcun supervisore che fornisca alcun tipo di guida. Gli algoritmi di apprendimento senza supervisione sono utili nello scenario in cui non abbiamo la libertà, come negli algoritmi di apprendimento supervisionato, di avere dati di addestramento pre-etichettati e vogliamo estrarre pattern utili dai dati di input.

Ad esempio, può essere inteso come segue:

Supponiamo di avere -

x: Input variables, quindi non ci sarebbe alcuna variabile di output corrispondente e gli algoritmi devono scoprire il modello interessante nei dati per l'apprendimento.

Esempi di algoritmi di apprendimento automatico non supervisionati includono il clustering K-means, K-nearest neighbors eccetera.

In base alle attività di ML, gli algoritmi di apprendimento senza supervisione possono essere suddivisi nelle seguenti ampie classi:

Clustering

Association

Riduzione della dimensionalità

Clustering

I metodi di clustering sono uno dei metodi ML non supervisionati più utili. Questi algoritmi venivano utilizzati per trovare somiglianze e modelli di relazione tra campioni di dati e quindi raggruppare quei campioni in gruppi aventi somiglianza basata su caratteristiche. L'esempio reale di clustering è raggruppare i clienti in base al loro comportamento di acquisto.

Association

Un altro utile metodo ML senza supervisione è Associationche viene utilizzato per analizzare set di dati di grandi dimensioni per trovare modelli che rappresentano ulteriormente le relazioni interessanti tra i vari elementi. È anche definito comeAssociation Rule Mining o Market basket analysis che viene utilizzato principalmente per analizzare i modelli di acquisto dei clienti.

Dimensionality Reduction

Questo metodo ML senza supervisione viene utilizzato per ridurre il numero di variabili delle caratteristiche per ogni campione di dati selezionando un insieme di caratteristiche principali o rappresentative. Una domanda che sorge qui è: perché dobbiamo ridurre la dimensionalità? La ragione alla base è il problema della complessità dello spazio delle caratteristiche che sorge quando iniziamo ad analizzare ed estrarre milioni di caratteristiche da campioni di dati. Questo problema si riferisce generalmente alla "maledizione della dimensionalità". PCA (Principal Component Analysis), vicini K-più vicini e analisi discriminante sono alcuni degli algoritmi popolari per questo scopo.

Anomaly Detection

Questo metodo ML senza supervisione viene utilizzato per scoprire il verificarsi di eventi rari o osservazioni che generalmente non si verificano. Utilizzando le conoscenze acquisite, i metodi di rilevamento delle anomalie sarebbero in grado di distinguere tra punti dati anomali o normali. Alcuni degli algoritmi non supervisionati come il clustering, KNN può rilevare anomalie in base ai dati e alle loro caratteristiche.

Apprendimento semi-supervisionato

Questo tipo di algoritmi o metodi non sono né completamente supervisionati né completamente non supervisionati. Fondamentalmente rientrano tra i due metodi di apprendimento supervisionati e non supervisionati. Questi tipi di algoritmi utilizzano generalmente una piccola componente di apprendimento supervisionato, cioè una piccola quantità di dati annotati pre-etichettati e una grande componente di apprendimento non supervisionato, ovvero molti dati senza etichetta per l'addestramento. Possiamo seguire uno dei seguenti approcci per implementare metodi di apprendimento semi-supervisionati:

Il primo e semplice approccio consiste nel costruire il modello supervisionato sulla base di una piccola quantità di dati etichettati e annotati e quindi costruire il modello non supervisionato applicando lo stesso a grandi quantità di dati non etichettati per ottenere più campioni etichettati. Ora, allena il modello su di loro e ripeti il processo.

- , p> Il secondo approccio richiede alcuni sforzi extra. In questo approccio, possiamo prima utilizzare i metodi non supervisionati per raggruppare campioni di dati simili, annotare questi gruppi e quindi utilizzare una combinazione di queste informazioni per addestrare il modello.

Insegnamento rafforzativo

Questi metodi sono diversi dai metodi studiati in precedenza e anche usati molto raramente. In questo tipo di algoritmi di apprendimento, ci sarebbe un agente che vogliamo addestrare per un periodo di tempo in modo che possa interagire con un ambiente specifico. L'agente seguirà una serie di strategie per interagire con l'ambiente e poi, dopo aver osservato l'ambiente, intraprenderà azioni riguardanti lo stato attuale dell'ambiente. I seguenti sono i passaggi principali dei metodi di apprendimento per rinforzo:

Step1 - Innanzitutto, dobbiamo preparare un agente con una serie iniziale di strategie.

Step2 - Quindi osservare l'ambiente e il suo stato attuale.

Step3 - Successivamente, selezionare la politica ottimale relativa allo stato attuale dell'ambiente ed eseguire un'azione importante.

Step4 - Ora, l'agente può ottenere la corrispondente ricompensa o penalità in base all'azione intrapresa nel passaggio precedente.

Step5 - Ora possiamo aggiornare le strategie se necessario.

Step6 - Infine, ripetere i passaggi 2-5 finché l'agente non ha imparato e adotta le politiche ottimali.

Attività adatte al machine learning

Il diagramma seguente mostra il tipo di attività appropriato per vari problemi di ML:

Basato sulla capacità di apprendimento

Nel processo di apprendimento, i seguenti sono alcuni metodi basati sulla capacità di apprendimento:

Batch Learning

In molti casi, disponiamo di sistemi di machine learning end-to-end in cui dobbiamo addestrare il modello in una volta sola utilizzando tutti i dati di training disponibili. Questo tipo di metodo di apprendimento o algoritmo è chiamatoBatch or Offline learning. Si chiama apprendimento batch o offline perché è una procedura una tantum e il modello verrà addestrato con i dati in un unico batch. Di seguito sono riportati i passaggi principali dei metodi di apprendimento in batch:

Step1 - Innanzitutto, dobbiamo raccogliere tutti i dati di addestramento per iniziare ad addestrare il modello.

Step2 - Ora, inizia l'addestramento del modello fornendo tutti i dati di addestramento in una volta.

Step3 - Successivamente, interrompi il processo di apprendimento / formazione una volta ottenuti risultati / prestazioni soddisfacenti.

Step4- Infine, distribuisci questo modello addestrato nella produzione. Qui, predice l'output per un nuovo campione di dati.

Apprendimento online

È completamente opposto ai metodi di apprendimento batch o offline. In questi metodi di apprendimento, i dati di addestramento vengono forniti in più batch incrementali, chiamati mini-batch, all'algoritmo. I seguenti sono i passaggi principali dei metodi di apprendimento online:

Step1 - Innanzitutto, dobbiamo raccogliere tutti i dati di addestramento per iniziare l'addestramento del modello.

Step2 - Ora, avvia l'addestramento del modello fornendo un mini-batch di dati di addestramento all'algoritmo.

Step3 - Successivamente, dobbiamo fornire i mini-batch di dati di addestramento in più incrementi all'algoritmo.

Step4 - Poiché non si fermerà come l'apprendimento in batch, quindi dopo aver fornito interi dati di addestramento in mini-batch, fornire anche nuovi campioni di dati.

Step5 - Infine, continuerà ad apprendere per un periodo di tempo sulla base dei nuovi campioni di dati.

Basato sull'approccio di generalizzazione

Nel processo di apprendimento, i seguenti sono alcuni metodi basati su approcci di generalizzazione:

Apprendimento basato su istanze

Il metodo di apprendimento basato sull'istanza è uno dei metodi utili che costruiscono i modelli ML effettuando la generalizzazione basata sui dati di input. È l'opposto dei metodi di apprendimento studiati in precedenza nel modo in cui questo tipo di apprendimento coinvolge i sistemi ML, nonché i metodi che utilizzano i punti di dati grezzi stessi per disegnare i risultati per i campioni di dati più recenti senza costruire un modello esplicito sui dati di addestramento.

In parole semplici, l'apprendimento basato sull'istanza inizia fondamentalmente a funzionare guardando i punti dati di input e quindi utilizzando una metrica di somiglianza, generalizzerà e prevederà i nuovi punti dati.

Apprendimento basato su modelli

Nei metodi di apprendimento basati su modelli, viene eseguito un processo iterativo sui modelli ML che sono costruiti sulla base di vari parametri del modello, chiamati iperparametri e in cui i dati di input vengono utilizzati per estrarre le funzionalità. In questo apprendimento, gli iperparametri vengono ottimizzati sulla base di varie tecniche di convalida del modello. Questo è il motivo per cui possiamo affermare che i metodi di apprendimento basati su modelli utilizzano un approccio ML più tradizionale verso la generalizzazione.

Supponi di voler avviare un progetto ML, qual è la prima e più importante cosa di cui hai bisogno? Sono i dati che dobbiamo caricare per avviare qualsiasi progetto ML. Per quanto riguarda i dati, il formato più comune di dati per i progetti ML è CSV (valori separati da virgola).

Fondamentalmente, CSV è un semplice formato di file che viene utilizzato per memorizzare dati tabulari (numero e testo) come un foglio di calcolo in testo normale. In Python, possiamo caricare i dati CSV in modi diversi, ma prima di caricare i dati CSV dobbiamo fare attenzione ad alcune considerazioni.

Considerazioni durante il caricamento dei dati CSV

Il formato dati CSV è il formato più comune per i dati ML, ma dobbiamo fare attenzione a seguire le principali considerazioni durante il caricamento dello stesso nei nostri progetti ML -

Intestazione del file

Nei file di dati CSV, l'intestazione contiene le informazioni per ogni campo. Dobbiamo usare lo stesso delimitatore per il file di intestazione e per il file di dati perché è il file di intestazione che specifica come devono essere interpretati i campi di dati.

I seguenti sono i due casi relativi all'intestazione del file CSV che devono essere considerati:

Case-I: When Data file is having a file header - Assegnerà automaticamente i nomi a ciascuna colonna di dati se il file di dati ha un'intestazione di file.

Case-II: When Data file is not having a file header - Dobbiamo assegnare manualmente i nomi a ciascuna colonna di dati se il file di dati non ha un'intestazione di file.

In entrambi i casi, dobbiamo specificare esplicitamente se il nostro file CSV contiene un'intestazione o meno.

Commenti

I commenti in qualsiasi file di dati hanno il loro significato. Nel file di dati CSV, i commenti sono indicati da un cancelletto (#) all'inizio della riga. Dobbiamo considerare i commenti durante il caricamento dei dati CSV nei progetti ML perché se abbiamo commenti nel file, potrebbe essere necessario indicare, dipende dal metodo che scegliamo per il caricamento, se aspettarci quei commenti o meno.

Delimitatore

Nei file di dati CSV, il carattere virgola (,) è il delimitatore standard. Il ruolo del delimitatore è separare i valori nei campi. È importante considerare il ruolo del delimitatore durante il caricamento del file CSV nei progetti ML perché possiamo anche utilizzare un delimitatore diverso come una scheda o uno spazio vuoto. Ma nel caso di utilizzo di un delimitatore diverso da quello standard, dobbiamo specificarlo esplicitamente.

Citazioni

Nei file di dati CSV, le virgolette doppie ("") sono le virgolette predefinite. È importante considerare il ruolo delle virgolette durante il caricamento del file CSV nei progetti ML perché possiamo anche utilizzare virgolette diverse dalle virgolette doppie. Ma in caso di utilizzo di un carattere di citazione diverso da quello standard, dobbiamo specificarlo esplicitamente.

Metodi per caricare il file di dati CSV

Mentre si lavora con progetti ML, l'attività più cruciale è caricare correttamente i dati al suo interno. Il formato di dati più comune per i progetti ML è CSV ed è disponibile in vari gusti e diverse difficoltà di analisi. In questa sezione, discuteremo di tre approcci comuni in Python per caricare il file di dati CSV:

Carica CSV con la libreria standard Python

Il primo e più utilizzato approccio per caricare il file di dati CSV è l'uso della libreria standard Python che fornisce una varietà di moduli incorporati, ovvero il modulo csv e la funzione reader (). Il seguente è un esempio di caricamento di file di dati CSV con l'aiuto di esso:

Esempio

In questo esempio, stiamo usando il set di dati del fiore di iris che può essere scaricato nella nostra directory locale. Dopo aver caricato il file di dati, possiamo convertirlo in array NumPy e usarlo per progetti ML. Di seguito è riportato lo script Python per il caricamento del file di dati CSV -

Innanzitutto, dobbiamo importare il modulo csv fornito dalla libreria standard di Python come segue:

import csvSuccessivamente, dobbiamo importare il modulo Numpy per convertire i dati caricati nell'array NumPy.

import numpy as npOra, fornisci il percorso completo del file, memorizzato nella nostra directory locale, con il file di dati CSV -

path = r"c:\iris.csv"Quindi, usa la funzione csv.reader () per leggere i dati dal file CSV -

with open(path,'r') as f:

reader = csv.reader(f,delimiter = ',')

headers = next(reader)

data = list(reader)

data = np.array(data).astype(float)Possiamo stampare i nomi delle intestazioni con la seguente riga di script:

print(headers)La seguente riga di script stamperà la forma dei dati cioè il numero di righe e colonne nel file -

print(data.shape)La prossima riga di script darà le prime tre righe di file di dati -

print(data[:3])Output

['sepal_length', 'sepal_width', 'petal_length', 'petal_width']

(150, 4)

[ [5.1 3.5 1.4 0.2]

[4.9 3. 1.4 0.2]

[4.7 3.2 1.3 0.2]]Carica CSV con NumPy

Un altro approccio per caricare il file di dati CSV è la funzione NumPy e numpy.loadtxt (). Il seguente è un esempio di caricamento di file di dati CSV con l'aiuto di esso:

Esempio

In questo esempio, utilizziamo il set di dati Pima Indians contenente i dati dei pazienti diabetici. Questo set di dati è un set di dati numerico senza intestazione. Può anche essere scaricato nella nostra directory locale. Dopo aver caricato il file di dati, possiamo convertirlo in array NumPy e usarlo per progetti ML. Di seguito è riportato lo script Python per il caricamento del file di dati CSV -

from numpy import loadtxt

path = r"C:\pima-indians-diabetes.csv"

datapath= open(path, 'r')

data = loadtxt(datapath, delimiter=",")

print(data.shape)

print(data[:3])Produzione

(768, 9)

[ [ 6. 148. 72. 35. 0. 33.6 0.627 50. 1.]

[ 1. 85. 66. 29. 0. 26.6 0.351 31. 0.]

[ 8. 183. 64. 0. 0. 23.3 0.672 32. 1.]]Carica CSV con Panda

Un altro approccio per caricare il file di dati CSV è la funzione Pandas e pandas.read_csv (). Questa è la funzione molto flessibile che restituisce un pandas.DataFrame che può essere utilizzato immediatamente per la stampa. Il seguente è un esempio di caricamento di file di dati CSV con l'aiuto di esso:

Esempio

Qui, implementeremo due script Python, il primo è con il set di dati Iris con intestazioni e un altro è utilizzando il set di dati Pima Indians che è un set di dati numerico senza intestazione. Entrambi i set di dati possono essere scaricati nella directory locale.

Script-1

Di seguito è riportato lo script Python per il caricamento del file di dati CSV utilizzando Pandas on Iris Data set -

from pandas import read_csv

path = r"C:\iris.csv"

data = read_csv(path)

print(data.shape)

print(data[:3])

Output:

(150, 4)

sepal_length sepal_width petal_length petal_width

0 5.1 3.5 1.4 0.2

1 4.9 3.0 1.4 0.2

2 4.7 3.2 1.3 0.2Script-2

Di seguito è riportato lo script Python per il caricamento del file di dati CSV, oltre a fornire anche i nomi delle intestazioni, utilizzando Pandas sul set di dati del diabete degli indiani Pima -

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

headernames = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=headernames)

print(data.shape)

print(data[:3])Output

(768, 9)

preg plas pres skin test mass pedi age class

0 6 148 72 35 0 33.6 0.627 50 1

1 1 85 66 29 0 26.6 0.351 31 0

2 8 183 64 0 0 23.3 0.672 32 1La differenza tra i tre approcci utilizzati sopra per caricare il file di dati CSV può essere facilmente compresa con l'aiuto degli esempi forniti.

introduzione

Mentre lavoriamo con progetti di machine learning, di solito ignoriamo due parti più importanti chiamate mathematics e data. È perché sappiamo che il ML è un approccio basato sui dati e il nostro modello ML produrrà solo risultati buoni o cattivi come i dati che gli abbiamo fornito.

Nel capitolo precedente, abbiamo discusso di come caricare i dati CSV nel nostro progetto ML, ma sarebbe bene comprendere i dati prima di caricarli. Possiamo comprendere i dati in due modi, con le statistiche e con la visualizzazione.

In questo capitolo, con l'aiuto di seguire le ricette di Python, comprenderemo i dati ML con le statistiche.

Guardando i dati grezzi

La prima ricetta è guardare i tuoi dati grezzi. È importante esaminare i dati grezzi perché le informazioni che otterremo dopo aver esaminato i dati grezzi aumenteranno le nostre possibilità di una migliore pre-elaborazione e gestione dei dati per i progetti ML.

Di seguito è riportato uno script Python implementato utilizzando la funzione head () di Pandas DataFrame sul set di dati del diabete degli indiani Pima per esaminare le prime 50 righe per comprenderlo meglio -

Esempio

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

headernames = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=headernames)

print(data.head(50))Produzione

preg plas pres skin test mass pedi age class

0 6 148 72 35 0 33.6 0.627 50 1

1 1 85 66 29 0 26.6 0.351 31 0

2 8 183 64 0 0 23.3 0.672 32 1

3 1 89 66 23 94 28.1 0.167 21 0

4 0 137 40 35 168 43.1 2.288 33 1

5 5 116 74 0 0 25.6 0.201 30 0

6 3 78 50 32 88 31.0 0.248 26 1

7 10 115 0 0 0 35.3 0.134 29 0

8 2 197 70 45 543 30.5 0.158 53 1

9 8 125 96 0 0 0.0 0.232 54 1

10 4 110 92 0 0 37.6 0.191 30 0

11 10 168 74 0 0 38.0 0.537 34 1

12 10 139 80 0 0 27.1 1.441 57 0

13 1 189 60 23 846 30.1 0.398 59 1

14 5 166 72 19 175 25.8 0.587 51 1

15 7 100 0 0 0 30.0 0.484 32 1

16 0 118 84 47 230 45.8 0.551 31 1

17 7 107 74 0 0 29.6 0.254 31 1

18 1 103 30 38 83 43.3 0.183 33 0

19 1 115 70 30 96 34.6 0.529 32 1

20 3 126 88 41 235 39.3 0.704 27 0

21 8 99 84 0 0 35.4 0.388 50 0

22 7 196 90 0 0 39.8 0.451 41 1

23 9 119 80 35 0 29.0 0.263 29 1

24 11 143 94 33 146 36.6 0.254 51 1

25 10 125 70 26 115 31.1 0.205 41 1

26 7 147 76 0 0 39.4 0.257 43 1

27 1 97 66 15 140 23.2 0.487 22 0

28 13 145 82 19 110 22.2 0.245 57 0

29 5 117 92 0 0 34.1 0.337 38 0

30 5 109 75 26 0 36.0 0.546 60 0

31 3 158 76 36 245 31.6 0.851 28 1

32 3 88 58 11 54 24.8 0.267 22 0

33 6 92 92 0 0 19.9 0.188 28 0

34 10 122 78 31 0 27.6 0.512 45 0

35 4 103 60 33 192 24.0 0.966 33 0

36 11 138 76 0 0 33.2 0.420 35 0

37 9 102 76 37 0 32.9 0.665 46 1

38 2 90 68 42 0 38.2 0.503 27 1

39 4 111 72 47 207 37.1 1.390 56 1

40 3 180 64 25 70 34.0 0.271 26 0

41 7 133 84 0 0 40.2 0.696 37 0

42 7 106 92 18 0 22.7 0.235 48 0

43 9 171 110 24 240 45.4 0.721 54 1

44 7 159 64 0 0 27.4 0.294 40 0

45 0 180 66 39 0 42.0 1.893 25 1

46 1 146 56 0 0 29.7 0.564 29 0

47 2 71 70 27 0 28.0 0.586 22 0

48 7 103 66 32 0 39.1 0.344 31 1

49 7 105 0 0 0 0.0 0.305 24 0Possiamo osservare dall'output precedente che la prima colonna fornisce il numero di riga che può essere molto utile per fare riferimento a un'osservazione specifica.

Controllo delle dimensioni dei dati

È sempre una buona pratica sapere quanti dati, in termini di righe e colonne, abbiamo per il nostro progetto ML. Le ragioni alla base sono:

Supponiamo che se abbiamo troppe righe e colonne, sarebbe necessario molto tempo per eseguire l'algoritmo e addestrare il modello.

Supponiamo che se abbiamo troppo meno righe e colonne, allora non avremmo abbastanza dati per addestrare bene il modello.

Di seguito è riportato uno script Python implementato stampando la proprietà shape su Pandas Data Frame. Lo implementeremo sul set di dati iris per ottenere il numero totale di righe e colonne in esso.

Esempio

from pandas import read_csv

path = r"C:\iris.csv"

data = read_csv(path)

print(data.shape)Produzione

(150, 4)Possiamo facilmente osservare dall'output che il set di dati iris, che useremo, ha 150 righe e 4 colonne.

Ottenere il tipo di dati di ogni attributo

Un'altra buona pratica è conoscere il tipo di dati di ogni attributo. Il motivo è che, in base al requisito, a volte potrebbe essere necessario convertire un tipo di dati in un altro. Ad esempio, potrebbe essere necessario convertire la stringa in virgola mobile o int per rappresentare valori categoriali o ordinali. Possiamo avere un'idea del tipo di dati dell'attributo guardando i dati grezzi, ma un altro modo è usare la proprietà dtypes di Pandas DataFrame. Con l'aiuto della proprietà dtypes possiamo classificare ogni tipo di dati degli attributi. Può essere compreso con l'aiuto del seguente script Python -

Esempio

from pandas import read_csv

path = r"C:\iris.csv"

data = read_csv(path)

print(data.dtypes)Produzione

sepal_length float64

sepal_width float64

petal_length float64

petal_width float64

dtype: objectDall'output di cui sopra, possiamo facilmente ottenere i tipi di dati di ogni attributo.

Riepilogo statistico dei dati

Abbiamo discusso la ricetta di Python per ottenere la forma, cioè il numero di righe e colonne, dei dati, ma molte volte abbiamo bisogno di rivedere i riepiloghi da quella forma di dati. Può essere fatto con l'aiuto della funzione description () di Pandas DataFrame che fornisce inoltre le seguenti 8 proprietà statistiche di ogni attributo di dati:

Count

Mean

Deviazione standard

Valore minimo

Valore massimo

25%

Mediana cioè 50%

75%

Esempio

from pandas import read_csv

from pandas import set_option

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

set_option('display.width', 100)

set_option('precision', 2)

print(data.shape)

print(data.describe())Produzione

(768, 9)

preg plas pres skin test mass pedi age class

count 768.00 768.00 768.00 768.00 768.00 768.00 768.00 768.00 768.00

mean 3.85 120.89 69.11 20.54 79.80 31.99 0.47 33.24 0.35

std 3.37 31.97 19.36 15.95 115.24 7.88 0.33 11.76 0.48

min 0.00 0.00 0.00 0.00 0.00 0.00 0.08 21.00 0.00

25% 1.00 99.00 62.00 0.00 0.00 27.30 0.24 24.00 0.00

50% 3.00 117.00 72.00 23.00 30.50 32.00 0.37 29.00 0.00

75% 6.00 140.25 80.00 32.00 127.25 36.60 0.63 41.00 1.00

max 17.00 199.00 122.00 99.00 846.00 67.10 2.42 81.00 1.00Dall'output di cui sopra, possiamo osservare il riepilogo statistico dei dati del set di dati Pima Indian Diabetes insieme alla forma dei dati.

Revisione della distribuzione delle classi

Le statistiche sulla distribuzione delle classi sono utili nei problemi di classificazione in cui è necessario conoscere l'equilibrio dei valori delle classi. È importante conoscere la distribuzione del valore della classe perché se abbiamo una distribuzione delle classi altamente sbilanciata, ovvero una classe sta avendo molte più osservazioni rispetto ad un'altra classe, potrebbe essere necessaria una gestione speciale nella fase di preparazione dei dati del nostro progetto ML. Possiamo facilmente ottenere la distribuzione delle classi in Python con l'aiuto di Pandas DataFrame.

Esempio

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

count_class = data.groupby('class').size()

print(count_class)Produzione

Class

0 500

1 268

dtype: int64Dall'output di cui sopra, si può vedere chiaramente che il numero di osservazioni con la classe 0 è quasi il doppio del numero di osservazioni con la classe 1.

Revisione della correlazione tra attributi

La relazione tra due variabili è chiamata correlazione. Nelle statistiche, il metodo più comune per calcolare la correlazione è il coefficiente di correlazione di Pearson. Può avere tre valori come segue:

Coefficient value = 1 - Rappresenta il pieno positive correlazione tra variabili.

Coefficient value = -1 - Rappresenta il pieno negative correlazione tra variabili.

Coefficient value = 0 - Rappresenta no correlazione tra le variabili.

È sempre positivo per noi rivedere le correlazioni a coppie degli attributi nel nostro set di dati prima di utilizzarlo nel progetto ML perché alcuni algoritmi di apprendimento automatico come la regressione lineare e logistica funzioneranno male se abbiamo attributi altamente correlati. In Python, possiamo facilmente calcolare una matrice di correlazione degli attributi del set di dati con l'aiuto della funzione corr () su Pandas DataFrame.

Esempio

from pandas import read_csv

from pandas import set_option

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

set_option('display.width', 100)

set_option('precision', 2)

correlations = data.corr(method='pearson')

print(correlations)Produzione

preg plas pres skin test mass pedi age class

preg 1.00 0.13 0.14 -0.08 -0.07 0.02 -0.03 0.54 0.22

plas 0.13 1.00 0.15 0.06 0.33 0.22 0.14 0.26 0.47

pres 0.14 0.15 1.00 0.21 0.09 0.28 0.04 0.24 0.07

skin -0.08 0.06 0.21 1.00 0.44 0.39 0.18 -0.11 0.07

test -0.07 0.33 0.09 0.44 1.00 0.20 0.19 -0.04 0.13

mass 0.02 0.22 0.28 0.39 0.20 1.00 0.14 0.04 0.29

pedi -0.03 0.14 0.04 0.18 0.19 0.14 1.00 0.03 0.17

age 0.54 0.26 0.24 -0.11 -0.04 0.04 0.03 1.00 0.24

class 0.22 0.47 0.07 0.07 0.13 0.29 0.17 0.24 1.00La matrice nell'output sopra fornisce la correlazione tra tutte le coppie dell'attributo nel set di dati.

Revisione dell'inclinazione della distribuzione degli attributi

L'asimmetria può essere definita come la distribuzione che si presume sia gaussiana ma che appare distorta o spostata in una direzione o nell'altra, o a sinistra oa destra. La revisione dell'asimmetria degli attributi è uno dei compiti importanti per i seguenti motivi:

La presenza di asimmetria nei dati richiede la correzione in fase di preparazione dei dati in modo da poter ottenere una maggiore precisione dal nostro modello.

La maggior parte degli algoritmi ML presume che i dati abbiano una distribuzione gaussiana, ovvero normale dei dati con curva a campana.

In Python, possiamo facilmente calcolare l'inclinazione di ogni attributo usando la funzione skew () su Pandas DataFrame.

Esempio

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

print(data.skew())Produzione

preg 0.90

plas 0.17

pres -1.84

skin 0.11

test 2.27

mass -0.43

pedi 1.92

age 1.13

class 0.64

dtype: float64Dall'output di cui sopra, si può osservare un disallineamento positivo o negativo. Se il valore è più vicino a zero, mostra meno inclinazione.

introduzione

Nel capitolo precedente, abbiamo discusso l'importanza dei dati per gli algoritmi di Machine Learning insieme ad alcune ricette Python per comprendere i dati con le statistiche. C'è un altro modo chiamato Visualizzazione, per comprendere i dati.

Con l'aiuto della visualizzazione dei dati, possiamo vedere come appaiono i dati e che tipo di correlazione è tenuta dagli attributi dei dati. È il modo più veloce per vedere se le caratteristiche corrispondono all'output. Con l'aiuto di seguire le ricette di Python, possiamo comprendere i dati ML con le statistiche.

Grafici univariati: comprensione indipendente degli attributi

Il tipo più semplice di visualizzazione è la visualizzazione a variabile singola o "univariata". Con l'aiuto della visualizzazione univariata, possiamo comprendere ogni attributo del nostro set di dati in modo indipendente. Di seguito sono riportate alcune tecniche in Python per implementare la visualizzazione univariata:

Istogrammi

Gli istogrammi raggruppano i dati in contenitori ed è il modo più veloce per avere un'idea della distribuzione di ogni attributo nel set di dati. Di seguito sono riportate alcune delle caratteristiche degli istogrammi:

Ci fornisce un conteggio del numero di osservazioni in ogni contenitore creato per la visualizzazione.

Dalla forma del bidone, possiamo facilmente osservare la distribuzione, cioè il tempo è gaussiano, asimmetrico o esponenziale.

Gli istogrammi ci aiutano anche a vedere possibili valori anomali.

Esempio

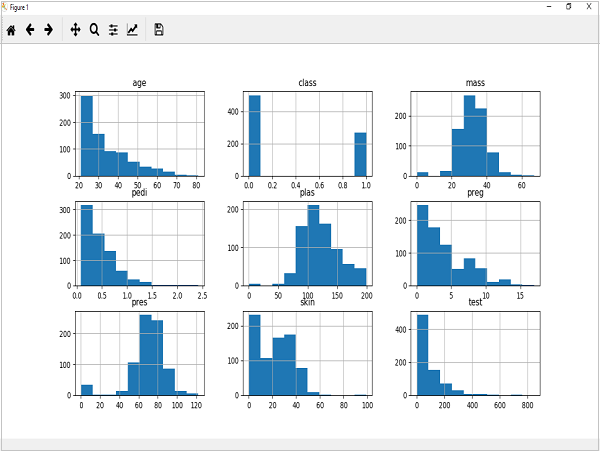

Il codice mostrato di seguito è un esempio di script Python che crea l'istogramma degli attributi del set di dati Pima Indian Diabetes. Qui, useremo la funzione hist () su Pandas DataFrame per generare istogrammi ematplotlib per averli tracciati.

from matplotlib import pyplot

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

data.hist()

pyplot.show()Produzione

L'output sopra mostra che ha creato l'istogramma per ogni attributo nel set di dati. Da questo, possiamo osservare che forse gli attributi età, pedi e test possono avere distribuzione esponenziale mentre massa e plas hanno distribuzione gaussiana.

Grafici di densità

Un'altra tecnica rapida e semplice per ottenere la distribuzione di ogni attributo è rappresentata dai grafici di densità. È anche come un istogramma ma ha una curva liscia disegnata attraverso la parte superiore di ogni contenitore. Possiamo chiamarli istogrammi astratti.

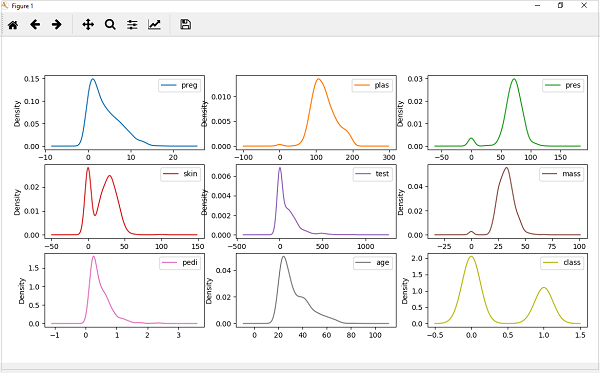

Esempio

Nell'esempio seguente, lo script Python genererà diagrammi di densità per la distribuzione degli attributi del set di dati di Pima Indian Diabetes.

from matplotlib import pyplot

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

data.plot(kind='density', subplots=True, layout=(3,3), sharex=False)

pyplot.show()Produzione

Dall'output di cui sopra, la differenza tra i grafici di densità e gli istogrammi può essere facilmente compresa.

Diagrammi Box e Whisker

I grafici Box e Whisker, chiamati anche boxplots in breve, sono un'altra tecnica utile per rivedere la distribuzione della distribuzione di ogni attributo. Le seguenti sono le caratteristiche di questa tecnica:

È di natura univariata e riassume la distribuzione di ogni attributo.

Traccia una linea per il valore medio, cioè per la mediana.

Disegna una casella intorno al 25% e al 75%.

Disegna anche baffi che ci daranno un'idea della diffusione dei dati.

I punti all'esterno dei baffi indicano i valori anomali. I valori anomali sarebbero 1,5 volte maggiori della dimensione della diffusione dei dati centrali.

Esempio

Nell'esempio seguente, lo script Python genererà diagrammi di densità per la distribuzione degli attributi del set di dati di Pima Indian Diabetes.

from matplotlib import pyplot

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

data.plot(kind='box', subplots=True, layout=(3,3), sharex=False,sharey=False)

pyplot.show()Produzione

Dal grafico sopra della distribuzione degli attributi, si può osservare che età, test e pelle appaiono distorti verso valori più piccoli.

Grafici multivariati: interazione tra più variabili

Un altro tipo di visualizzazione è la visualizzazione multivariabile o "multivariata". Con l'aiuto della visualizzazione multivariata, possiamo comprendere l'interazione tra più attributi del nostro set di dati. Di seguito sono riportate alcune tecniche in Python per implementare la visualizzazione multivariata:

Grafico a matrice di correlazione

La correlazione è un'indicazione sui cambiamenti tra due variabili. Nei nostri capitoli precedenti, abbiamo discusso i coefficienti di correlazione di Pearson e anche l'importanza della correlazione. Possiamo tracciare una matrice di correlazione per mostrare quale variabile ha una correlazione alta o bassa rispetto a un'altra variabile.

Esempio

Nell'esempio seguente, lo script Python genererà e traccerà una matrice di correlazione per il set di dati Pima Indian Diabetes. Può essere generato con l'aiuto della funzione corr () su Pandas DataFrame e tracciato con l'aiuto di pyplot.

from matplotlib import pyplot

from pandas import read_csv

import numpy

Path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(Path, names=names)

correlations = data.corr()

fig = pyplot.figure()

ax = fig.add_subplot(111)

cax = ax.matshow(correlations, vmin=-1, vmax=1)

fig.colorbar(cax)

ticks = numpy.arange(0,9,1)

ax.set_xticks(ticks)

ax.set_yticks(ticks)

ax.set_xticklabels(names)

ax.set_yticklabels(names)

pyplot.show()Produzione

Dall'output precedente della matrice di correlazione, possiamo vedere che è simmetrico, ovvero l'angolo in basso a sinistra è lo stesso in alto a destra. Si osserva inoltre che ogni variabile è positivamente correlata tra loro.

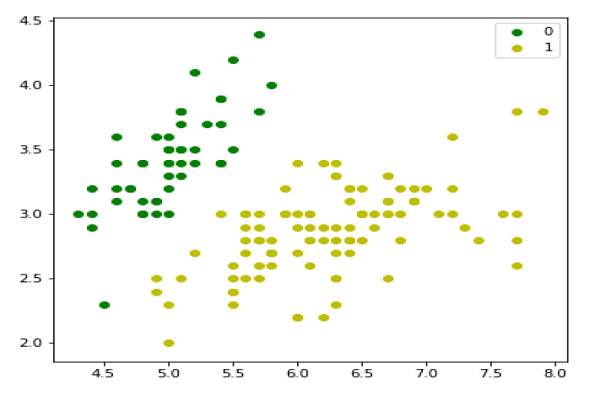

Grafico a matrice a dispersione

I grafici a dispersione mostrano quanto una variabile è influenzata da un'altra o la relazione tra loro con l'aiuto di punti in due dimensioni. I grafici a dispersione sono molto simili ai grafici a linee nel concetto che utilizzano assi orizzontale e verticale per tracciare i punti dati.

Esempio

Nell'esempio seguente, lo script Python genererà e traccerà una matrice Scatter per il set di dati Pima Indian Diabetes. Può essere generato con l'aiuto della funzione scatter_matrix () su Pandas DataFrame e tracciato con l'aiuto di pyplot.

from matplotlib import pyplot

from pandas import read_csv

from pandas.tools.plotting import scatter_matrix

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

scatter_matrix(data)

pyplot.show()Produzione

introduzione

Gli algoritmi di Machine Learning dipendono completamente dai dati perché è l'aspetto più cruciale che rende possibile l'addestramento del modello. D'altra parte, se non saremo in grado di dare un senso a quei dati, prima di fornirli agli algoritmi di ML, una macchina sarà inutile. In parole semplici, abbiamo sempre bisogno di inserire i dati corretti, cioè i dati in scala, formato e caratteristiche significative corretti, per il problema che vogliamo che la macchina risolva.

Ciò rende la preparazione dei dati il passaggio più importante nel processo ML. La preparazione dei dati può essere definita come la procedura che rende il nostro set di dati più appropriato per il processo di ML.

Perché la pre-elaborazione dei dati?

Dopo aver selezionato i dati grezzi per l'addestramento ML, l'attività più importante è la pre-elaborazione dei dati. In senso lato, la preelaborazione dei dati convertirà i dati selezionati in una forma con cui possiamo lavorare o che possiamo fornire agli algoritmi ML. Abbiamo sempre bisogno di preelaborare i nostri dati in modo che possano essere conformi alle aspettative dell'algoritmo di apprendimento automatico.

Tecniche di pre-elaborazione dei dati

Abbiamo le seguenti tecniche di pre-elaborazione dei dati che possono essere applicate al set di dati per produrre dati per algoritmi ML:

Ridimensionamento

Molto probabilmente il nostro set di dati comprende attributi con scala variabile, ma non siamo in grado di fornire tali dati all'algoritmo ML, quindi richiede il ridimensionamento. Il ridimensionamento dei dati garantisce che gli attributi siano sulla stessa scala. In genere, gli attributi vengono ridimensionati nell'intervallo 0 e 1. Gli algoritmi ML come la discesa del gradiente e k-Nearest Neighbors richiedono dati in scala. Possiamo riscalare i dati con l'aiuto della classe MinMaxScaler della libreria Python scikit-learn.

Esempio

In questo esempio riscaleremo i dati del set di dati del diabete degli indiani Pima che abbiamo usato in precedenza. Per prima cosa verranno caricati i dati CSV (come fatto nei capitoli precedenti) e poi con l'aiuto della classe MinMaxScaler, verranno riscalati nell'intervallo 0 e 1.

Le prime righe del seguente script sono le stesse che abbiamo scritto nei capitoli precedenti durante il caricamento dei dati CSV.

from pandas import read_csv

from numpy import set_printoptions

from sklearn import preprocessing

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesOra possiamo usare la classe MinMaxScaler per ridimensionare i dati nell'intervallo 0 e 1.

data_scaler = preprocessing.MinMaxScaler(feature_range=(0,1))

data_rescaled = data_scaler.fit_transform(array)Possiamo anche riassumere i dati per l'output secondo la nostra scelta. Qui, stiamo impostando la precisione su 1 e mostriamo le prime 10 righe nell'output.

set_printoptions(precision=1)

print ("\nScaled data:\n", data_rescaled[0:10])Produzione

Scaled data:

[[0.4 0.7 0.6 0.4 0. 0.5 0.2 0.5 1. ]

[0.1 0.4 0.5 0.3 0. 0.4 0.1 0.2 0. ]

[0.5 0.9 0.5 0. 0. 0.3 0.3 0.2 1. ]

[0.1 0.4 0.5 0.2 0.1 0.4 0. 0. 0. ]

[0. 0.7 0.3 0.4 0.2 0.6 0.9 0.2 1. ]

[0.3 0.6 0.6 0. 0. 0.4 0.1 0.2 0. ]

[0.2 0.4 0.4 0.3 0.1 0.5 0.1 0.1 1. ]

[0.6 0.6 0. 0. 0. 0.5 0. 0.1 0. ]

[0.1 1. 0.6 0.5 0.6 0.5 0. 0.5 1. ]

[0.5 0.6 0.8 0. 0. 0. 0.1 0.6 1. ]]Dall'output precedente, tutti i dati sono stati ridimensionati nell'intervallo 0 e 1.

Normalizzazione

Un'altra tecnica utile per la pre-elaborazione dei dati è la normalizzazione. Questo viene utilizzato per ridimensionare ogni riga di dati in modo che abbia una lunghezza pari a 1. È utile principalmente nei dataset sparsi dove abbiamo molti zeri. Possiamo ridimensionare i dati con l'aiuto della classe Normalizer della libreria Python scikit-learn.

Tipi di normalizzazione

Nell'apprendimento automatico, ci sono due tipi di tecniche di pre-elaborazione della normalizzazione come segue:

Normalizzazione L1

Può essere definita come la tecnica di normalizzazione che modifica i valori del set di dati in modo tale che in ogni riga la somma dei valori assoluti sia sempre fino a 1. Viene anche chiamata Deviazione minima assoluta.

Example

In questo esempio, utilizziamo la tecnica di normalizzazione L1 per normalizzare i dati del set di dati del diabete degli indiani Pima che abbiamo utilizzato in precedenza. Innanzitutto, i dati CSV verranno caricati e quindi con l'aiuto della classe Normalizer verranno normalizzati.

Le prime righe del seguente script sono le stesse che abbiamo scritto nei capitoli precedenti durante il caricamento dei dati CSV.

from pandas import read_csv

from numpy import set_printoptions

from sklearn.preprocessing import Normalizer

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv (path, names=names)

array = dataframe.valuesOra possiamo usare la classe Normalizer con L1 per normalizzare i dati.

Data_normalizer = Normalizer(norm='l1').fit(array)

Data_normalized = Data_normalizer.transform(array)Possiamo anche riassumere i dati per l'output secondo la nostra scelta. Qui, stiamo impostando la precisione su 2 e mostriamo le prime 3 righe nell'output.

set_printoptions(precision=2)

print ("\nNormalized data:\n", Data_normalized [0:3])Output

Normalized data:

[[0.02 0.43 0.21 0.1 0. 0.1 0. 0.14 0. ]

[0. 0.36 0.28 0.12 0. 0.11 0. 0.13 0. ]

[0.03 0.59 0.21 0. 0. 0.07 0. 0.1 0. ]]Normalizzazione L2

Può essere definita come la tecnica di normalizzazione che modifica i valori del set di dati in modo che in ogni riga la somma dei quadrati sia sempre fino a 1. Viene anche chiamata minimi quadrati.

Example

In questo esempio, utilizziamo la tecnica di normalizzazione L2 per normalizzare i dati del set di dati del diabete degli indiani Pima che abbiamo utilizzato in precedenza. Per prima cosa verranno caricati i dati CSV (come fatto nei capitoli precedenti) e poi con l'aiuto della classe Normalizer verranno normalizzati.

Le prime righe del seguente script sono le stesse che abbiamo scritto nei capitoli precedenti durante il caricamento dei dati CSV.

from pandas import read_csv

from numpy import set_printoptions

from sklearn.preprocessing import Normalizer

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv (path, names=names)

array = dataframe.valuesOra possiamo usare la classe Normalizer con L1 per normalizzare i dati.

Data_normalizer = Normalizer(norm='l2').fit(array)

Data_normalized = Data_normalizer.transform(array)Possiamo anche riassumere i dati per l'output secondo la nostra scelta. Qui, stiamo impostando la precisione su 2 e mostriamo le prime 3 righe nell'output.

set_printoptions(precision=2)

print ("\nNormalized data:\n", Data_normalized [0:3])Output

Normalized data:

[[0.03 0.83 0.4 0.2 0. 0.19 0. 0.28 0.01]

[0.01 0.72 0.56 0.24 0. 0.22 0. 0.26 0. ]

[0.04 0.92 0.32 0. 0. 0.12 0. 0.16 0.01]]Binarizzazione

Come suggerisce il nome, questa è la tecnica con cui possiamo rendere i nostri dati binari. Possiamo usare una soglia binaria per rendere i nostri dati binari. I valori al di sopra di quel valore di soglia verranno convertiti in 1 e al di sotto di tale soglia verranno convertiti in 0. Ad esempio, se scegliamo il valore di soglia = 0,5, il valore del set di dati sopra di esso diventerà 1 e al di sotto diventerà 0. Ovvero perché possiamo chiamarlobinarizing i dati o thresholdingi dati. Questa tecnica è utile quando abbiamo probabilità nel nostro set di dati e vogliamo convertirle in valori nitidi.

Possiamo binarizzare i dati con l'aiuto della classe Binarizer della libreria Python scikit-learn.

Esempio

In questo esempio, ridimensioneremo i dati del set di dati del diabete degli indiani Pima che abbiamo utilizzato in precedenza. Innanzitutto, i dati CSV verranno caricati e quindi con l'aiuto della classe Binarizer verranno convertiti in valori binari, ovvero 0 e 1 a seconda del valore di soglia. Prendiamo 0,5 come valore di soglia.

Le prime righe del seguente script sono le stesse che abbiamo scritto nei capitoli precedenti durante il caricamento dei dati CSV.

from pandas import read_csv

from sklearn.preprocessing import Binarizer

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesOra possiamo usare la classe Binarize per convertire i dati in valori binari.

binarizer = Binarizer(threshold=0.5).fit(array)

Data_binarized = binarizer.transform(array)Qui, stiamo mostrando le prime 5 righe nell'output.

print ("\nBinary data:\n", Data_binarized [0:5])Produzione

Binary data:

[[1. 1. 1. 1. 0. 1. 1. 1. 1.]

[1. 1. 1. 1. 0. 1. 0. 1. 0.]

[1. 1. 1. 0. 0. 1. 1. 1. 1.]

[1. 1. 1. 1. 1. 1. 0. 1. 0.]

[0. 1. 1. 1. 1. 1. 1. 1. 1.]]Standardizzazione

Un'altra utile tecnica di pre-elaborazione dei dati che è fondamentalmente utilizzata per trasformare gli attributi dei dati con una distribuzione gaussiana. Differisce la media e la deviazione standard (deviazione standard) da una distribuzione gaussiana standard con una media di 0 e una deviazione standard di 1. Questa tecnica è utile negli algoritmi ML come la regressione lineare, la regressione logistica che presuppone una distribuzione gaussiana nel set di dati di input e produce una migliore risultati con dati riscalati. Possiamo standardizzare i dati (media = 0 e SD = 1) con l'aiuto della classe StandardScaler della libreria Python scikit-learn.

Esempio

In questo esempio, ridimensioneremo i dati del set di dati del diabete degli indiani Pima che abbiamo utilizzato in precedenza. Prima verranno caricati i dati CSV e poi con l'aiuto della classe StandardScaler verranno convertiti in distribuzione gaussiana con media = 0 e SD = 1.

Le prime righe del seguente script sono le stesse che abbiamo scritto nei capitoli precedenti durante il caricamento dei dati CSV.

from sklearn.preprocessing import StandardScaler

from pandas import read_csv

from numpy import set_printoptions

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesOra possiamo usare la classe StandardScaler per ridimensionare i dati.

data_scaler = StandardScaler().fit(array)

data_rescaled = data_scaler.transform(array)Possiamo anche riassumere i dati per l'output secondo la nostra scelta. Qui stiamo impostando la precisione su 2 e mostriamo le prime 5 righe nell'output.

set_printoptions(precision=2)

print ("\nRescaled data:\n", data_rescaled [0:5])Produzione

Rescaled data:

[[ 0.64 0.85 0.15 0.91 -0.69 0.2 0.47 1.43 1.37]

[-0.84 -1.12 -0.16 0.53 -0.69 -0.68 -0.37 -0.19 -0.73]

[ 1.23 1.94 -0.26 -1.29 -0.69 -1.1 0.6 -0.11 1.37]

[-0.84 -1. -0.16 0.15 0.12 -0.49 -0.92 -1.04 -0.73]

[-1.14 0.5 -1.5 0.91 0.77 1.41 5.48 -0.02 1.37]]Etichettatura dei dati

Abbiamo discusso l'importanza di una buona fata per gli algoritmi di ML e di alcune tecniche per pre-elaborare i dati prima di inviarli agli algoritmi di ML. Un altro aspetto a questo riguardo è l'etichettatura dei dati. È anche molto importante inviare i dati ad algoritmi ML con un'etichettatura adeguata. Ad esempio, in caso di problemi di classificazione, sui dati sono presenti molte etichette sotto forma di parole, numeri, ecc.

Cos'è la codifica dell'etichetta?

La maggior parte delle funzioni sklearn prevede che i dati abbiano etichette numeriche anziché etichette di parole. Quindi, dobbiamo convertire tali etichette in etichette numeriche. Questo processo è chiamato codifica dell'etichetta. Possiamo eseguire la codifica delle etichette dei dati con l'aiuto della funzione LabelEncoder () della libreria Python scikit-learn.

Esempio

Nell'esempio seguente, lo script Python eseguirà la codifica dell'etichetta.

Innanzitutto, importa le librerie Python richieste come segue:

import numpy as np

from sklearn import preprocessingOra, dobbiamo fornire le etichette di input come segue:

input_labels = ['red','black','red','green','black','yellow','white']La riga di codice successiva creerà il codificatore dell'etichetta e lo addestrerà.

encoder = preprocessing.LabelEncoder()

encoder.fit(input_labels)Le successive righe di script controlleranno le prestazioni codificando l'elenco ordinato casuale -

test_labels = ['green','red','black']

encoded_values = encoder.transform(test_labels)

print("\nLabels =", test_labels)

print("Encoded values =", list(encoded_values))

encoded_values = [3,0,4,1]

decoded_list = encoder.inverse_transform(encoded_values)Possiamo ottenere l'elenco dei valori codificati con l'aiuto del seguente script python -

print("\nEncoded values =", encoded_values)

print("\nDecoded labels =", list(decoded_list))Produzione

Labels = ['green', 'red', 'black']

Encoded values = [1, 2, 0]

Encoded values = [3, 0, 4, 1]