Apache MXNet-빠른 가이드

이 장에서는 Apache MXNet의 기능을 강조하고이 딥 러닝 소프트웨어 프레임 워크의 최신 버전에 대해 설명합니다.

MXNet이란 무엇입니까?

Apache MXNet은 개발자가 딥 러닝 모델을 구축, 교육 및 배포하는 데 도움이되는 강력한 오픈 소스 딥 러닝 소프트웨어 프레임 워크 도구입니다. 지난 몇 년 동안 의료에서 운송, 제조에 이르기까지, 실제로 일상 생활의 모든 측면에서 딥 러닝의 영향이 널리 퍼졌습니다. 오늘날 기업은 얼굴 인식, 물체 감지, 광학 문자 인식 (OCR), 음성 인식 및 기계 번역과 같은 몇 가지 어려운 문제를 해결하기 위해 딥 러닝을 추구합니다.

이것이 Apache MXNet이 다음에서 지원되는 이유입니다.

Intel, Baidu, Microsoft, Wolfram Research 등과 같은 일부 대기업

Amazon Web Services (AWS) 및 Microsoft Azure를 포함한 퍼블릭 클라우드 공급자

Carnegie Mellon, MIT, University of Washington, Hong Kong University of Science & Technology와 같은 대규모 연구 기관.

왜 Apache MXNet인가?

Torch7, Caffe, Theano, TensorFlow, Keras, Microsoft Cognitive Toolkit 등과 같은 다양한 딥 러닝 플랫폼이 존재하며 Apache MXNet이 왜 존재하는지 궁금 할 것입니다. 그 뒤에있는 몇 가지 이유를 확인해 보겠습니다.

Apache MXNet은 기존 딥 러닝 플랫폼의 가장 큰 문제 중 하나를 해결합니다. 문제는 딥 러닝 플랫폼을 사용하려면 다른 프로그래밍 풍미를 위해 다른 시스템을 학습해야한다는 것입니다.

Apache MXNet의 도움으로 개발자는 GPU 및 클라우드 컴퓨팅의 모든 기능을 활용할 수 있습니다.

Apache MXNet은 모든 수치 계산을 가속화 할 수 있으며 대규모 DNN (심층 신경망)의 개발 및 배포 속도를 높이는 데 특히 중점을 둡니다.

사용자에게 명령형 프로그래밍과 기호 프로그래밍의 기능을 모두 제공합니다.

다양한 기능

최첨단 딥 러닝 연구를 신속하게 개발하기위한 유연한 딥 러닝 라이브러리 또는 프로덕션 워크로드를 푸시하기위한 강력한 플랫폼을 찾고 있다면 검색은 Apache MXNet에서 끝납니다. 다음과 같은 기능 때문입니다.

분산 교육

선형에 가까운 확장 효율성을 갖춘 다중 GPU 든 다중 호스트 교육이든 Apache MXNet을 사용하면 개발자가 하드웨어를 최대한 활용할 수 있습니다. MXNet은 Uber에서 만든 오픈 소스 분산 딥 러닝 프레임 워크 인 Horovod와의 통합도 지원합니다.

이 통합을 위해 다음은 Horovod에 정의 된 공통 분산 API 중 일부입니다.

horovod.broadcast()

horovod.allgather()

horovod.allgather()

이와 관련하여 MXNet은 다음과 같은 기능을 제공합니다.

Device Placement − MXNet의 도움으로 우리는 각 데이터 구조 (DS)를 쉽게 지정할 수 있습니다.

Automatic Differentiation − Apache MXNet은 미분, 즉 미분 계산을 자동화합니다.

Multi-GPU training − MXNet을 사용하면 사용 가능한 GPU 수로 확장 효율성을 달성 할 수 있습니다.

Optimized Predefined Layers − MXNet에서 자체 레이어를 코딩 할 수있을뿐만 아니라 속도를 위해 미리 정의 된 레이어도 최적화 할 수 있습니다.

이종 교잡

Apache MXNet은 사용자에게 하이브리드 프런트 엔드를 제공합니다. Gluon Python API의 도움으로 명령 적 기능과 상징적 기능 사이의 격차를 해소 할 수 있습니다. 하이브리드 화 기능을 호출하여 수행 할 수 있습니다.

더 빠른 계산

수십 또는 수백 개의 행렬 곱셈과 같은 선형 연산은 심층 신경망의 계산 병목 현상입니다. 이 병목 현상을 해결하기 위해 MXNet은-

GPU에 최적화 된 수치 계산

분산 생태계에 최적화 된 수치 계산

표준 NN을 간략하게 표현할 수있는 일반적인 워크 플로우 자동화.

언어 바인딩

MXNet은 Python 및 R과 같은 고급 언어에 깊이 통합되어 있습니다. 또한 다음과 같은 다른 프로그래밍 언어도 지원합니다.

Scala

Julia

Clojure

Java

C/C++

Perl

우리는 새로운 프로그래밍 언어를 배울 필요가 없습니다. MXNet은 하이브리드 화 기능과 결합되어 Python에서 우리가 선택한 프로그래밍 언어의 배포로 매우 원활하게 전환 할 수 있습니다.

최신 버전 MXNet 1.6.0

Apache Software Foundation (ASF)은 Apache License 2.0에 따라 2020 년 2 월 21 일 Apache MXNet의 안정적인 버전 1.6.0을 출시했습니다. MXNet 커뮤니티가 추가 릴리스에서 더 이상 Python 2를 지원하지 않기로 투표함에 따라 이것은 Python 2를 지원하는 마지막 MXNet 릴리스입니다. 이 릴리스가 사용자에게 제공하는 몇 가지 새로운 기능을 확인해 보겠습니다.

NumPy 호환 인터페이스

유연성과 일반성으로 인해 NumPy는 기계 학습 실무자, 과학자 및 학생이 널리 사용했습니다. 그러나 우리가 알고 있듯이 요즘 GPU (그래픽 처리 장치)와 같은 하드웨어 가속기는 GPU의 속도를 활용하기 위해 다양한 ML (머신 러닝) 툴킷 인 NumPy 사용자에 점점 더 동화되어 새로운 프레임 워크로 전환해야합니다. 다른 구문으로.

MXNet 1.6.0을 통해 Apache MXNet은 NumPy 호환 프로그래밍 환경으로 이동하고 있습니다. 새로운 인터페이스는 NumPy 구문에 익숙한 실무자에게 동일한 유용성과 표현력을 제공합니다. MXNet 1.6.0과 함께 기존 Numpy 시스템은 GPU와 같은 하드웨어 가속기를 활용하여 대규모 계산 속도를 높일 수 있습니다.

Apache TVM과 통합

CPU, GPU 및 특수 가속기와 같은 하드웨어 백엔드를위한 오픈 소스 엔드 투 엔드 딥 러닝 컴파일러 스택 인 Apache TVM은 생산성 중심의 딥 러닝 프레임 워크와 성능 중심의 하드웨어 백엔드 간의 격차를 메우는 것을 목표로합니다. . 최신 릴리스 MXNet 1.6.0을 통해 사용자는 Apache (incubating) TVM을 활용하여 Python 프로그래밍 언어로 고성능 운영자 커널을 구현할 수 있습니다. 이 새로운 기능의 두 가지 주요 이점은 다음과 같습니다.

이전 C ++ 기반 개발 프로세스를 단순화합니다.

CPU, GPU 등과 같은 여러 하드웨어 백엔드에서 동일한 구현을 공유 할 수 있습니다.

기존 기능 개선

위에 나열된 MXNet 1.6.0의 기능 외에도 기존 기능에 비해 몇 가지 개선 사항을 제공합니다. 개선 사항은 다음과 같습니다.

GPU에 대한 요소 별 연산 그룹화

요소 별 작업의 성능이 메모리 대역폭이라는 것을 알고 있으므로 이러한 작업을 연결하면 전체 성능이 저하 될 수 있습니다. Apache MXNet 1.6.0은 가능한 경우 실제로 Just-In-Time 융합 작업을 생성하는 요소 별 작업 융합을 수행합니다. 이러한 요소 별 운영 융합은 또한 스토리지 요구를 줄이고 전반적인 성능을 향상시킵니다.

일반적인 표현 단순화

MXNet 1.6.0은 중복 표현식을 제거하고 공통 표현식을 단순화합니다. 이러한 향상은 또한 메모리 사용량과 총 실행 시간을 향상시킵니다.

최적화

MXNet 1.6.0은 또한 다음과 같은 기존 기능 및 연산자에 대한 다양한 최적화를 제공합니다.

자동 혼합 정밀도

Gluon Fit API

MKL-DNN

큰 텐서 지원

TensorRT 완성

고차 그라디언트 지원

Operators

운영자 성능 프로파일 러

ONNX 가져 오기 / 내보내기

Gluon API 개선

Symbol API 개선

100 개 이상의 버그 수정

MXNet을 시작하려면 가장 먼저해야 할 일은 컴퓨터에 설치하는 것입니다. Apache MXNet은 Windows, Mac 및 Linux를 포함하여 사용 가능한 거의 모든 플랫폼에서 작동합니다.

Linux OS

다음과 같은 방법으로 Linux OS에 MXNet을 설치할 수 있습니다.

그래픽 처리 장치 (GPU)

여기서는 처리를 위해 GPU를 사용할 때 MXNet을 설치하기 위해 Pip, Docker 및 Source라는 다양한 방법을 사용합니다.

Pip 방식을 사용하여

다음 명령을 사용하여 Linus OS에 MXNet을 설치할 수 있습니다.

pip install mxnetApache MXNet은 또한 인텔 하드웨어에서 실행할 때 훨씬 빠른 MKL pip 패키지를 제공합니다. 예를 들어 여기mxnet-cu101mkl 의미-

이 패키지는 CUDA / cuDNN으로 구축되었습니다.

패키지는 MKL-DNN을 지원합니다.

CUDA 버전은 10.1입니다.

다른 옵션에 대해서는 다음을 참조하십시오. https://pypi.org/project/mxnet/.

Docker를 사용하여

MXNet을 사용하는 Docker 이미지는 DockerHub에서 찾을 수 있습니다. https://hub.docker.com/u/mxnet Docker와 GPU를 사용하여 MXNet을 설치하려면 아래 단계를 확인하십시오.

Step 1− 먼저 다음 위치에서 제공되는 도커 설치 지침을 따릅니다. https://docs.docker.com/engine/install/ubuntu/. 컴퓨터에 Docker를 설치해야합니다.

Step 2− 도커 컨테이너에서 GPU 사용을 활성화하려면 다음으로 nvidia-docker-plugin을 설치해야합니다. 다음에서 제공되는 설치 지침을 따를 수 있습니다.https://github.com/NVIDIA/nvidia-docker/wiki.

Step 3− 다음 명령을 사용하여 MXNet 도커 이미지를 가져올 수 있습니다. −

$ sudo docker pull mxnet/python:gpu이제 mxnet / python 도커 이미지 풀이 성공했는지 확인하기 위해 다음과 같이 도커 이미지를 나열 할 수 있습니다.

$ sudo docker imagesMXNet에서 가장 빠른 추론 속도를 위해 Intel MKL-DNN과 함께 최신 MXNet을 사용하는 것이 좋습니다. 아래 명령을 확인하십시오-

$ sudo docker pull mxnet/python:1.3.0_cpu_mkl $ sudo docker images소스에서

GPU를 사용하여 소스에서 MXNet 공유 라이브러리를 빌드하려면 먼저 다음과 같이 CUDA 및 cuDNN 환경을 설정해야합니다.

CUDA 툴킷을 다운로드하여 설치하십시오. 여기서 CUDA 9.2를 권장합니다.

다음 다운로드 cuDNN 7.1.4.

이제 파일의 압축을 풀어야합니다. 또한 cuDNN 루트 디렉토리로 변경해야합니다. 또한 다음과 같이 헤더와 라이브러리를 로컬 CUDA Toolkit 폴더로 이동하십시오.

tar xvzf cudnn-9.2-linux-x64-v7.1

sudo cp -P cuda/include/cudnn.h /usr/local/cuda/include

sudo cp -P cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

sudo ldconfigCUDA 및 cuDNN에 대한 환경을 설정 한 후 아래 단계에 따라 소스에서 MXNet 공유 라이브러리를 빌드하십시오.

Step 1− 먼저 필수 패키지를 설치해야합니다. 이러한 종속성은 Ubuntu 버전 16.04 이상에서 필요합니다.

sudo apt-get update

sudo apt-get install -y build-essential git ninja-build ccache libopenblas-dev

libopencv-dev cmakeStep 2−이 단계에서는 MXNet 소스를 다운로드하고 구성합니다. 먼저 다음 명령을 사용하여 저장소를 복제하겠습니다.

git clone –recursive https://github.com/apache/incubator-mxnet.git mxnet

cd mxnet

cp config/linux_gpu.cmake #for build with CUDAStep 3− 다음 명령어를 사용하여 MXNet core 공유 라이브러리를 구축 할 수 있습니다.

rm -rf build

mkdir -p build && cd build

cmake -GNinja ..

cmake --build .Two important points regarding the above step is as follows−

디버그 버전을 빌드하려면 다음과 같이 지정하십시오.

cmake -DCMAKE_BUILD_TYPE=Debug -GNinja ..병렬 컴파일 작업의 수를 설정하려면 다음을 지정하십시오.

cmake --build . --parallel NMXNet 코어 공유 라이브러리를 성공적으로 빌드하면 build 귀하의 폴더 MXNet project root, 당신은 발견 할 것이다 libmxnet.so 언어 바인딩을 설치하는 데 필요합니다 (선택 사항).

중앙 처리 장치 (CPU)

여기서는 처리를 위해 CPU를 사용할 때 MXNet을 설치하기 위해 Pip, Docker 및 Source라는 다양한 방법을 사용합니다.

Pip 방식을 사용하여

다음 명령을 사용하여 Linus OS에 MXNet을 설치할 수 있습니다.

pip install mxnetApache MXNet은 인텔 하드웨어에서 실행할 때 훨씬 더 빠른 MKL-DNN 지원 pip 패키지도 제공합니다.

pip install mxnet-mklDocker를 사용하여

MXNet을 사용하는 Docker 이미지는 DockerHub에서 찾을 수 있습니다. https://hub.docker.com/u/mxnet. CPU와 함께 Docker를 사용하여 MXNet을 설치하려면 아래 단계를 확인하십시오.

Step 1− 먼저 다음 위치에서 제공되는 도커 설치 지침을 따릅니다. https://docs.docker.com/engine/install/ubuntu/. 컴퓨터에 Docker를 설치해야합니다.

Step 2− 다음 명령을 사용하여 MXNet 도커 이미지를 가져올 수 있습니다.

$ sudo docker pull mxnet/python이제 mxnet / python 도커 이미지 풀이 성공했는지 확인하기 위해 다음과 같이 도커 이미지를 나열 할 수 있습니다.

$ sudo docker imagesMXNet에서 가장 빠른 추론 속도를 위해 Intel MKL-DNN과 함께 최신 MXNet을 사용하는 것이 좋습니다.

아래 명령을 확인하십시오-

$ sudo docker pull mxnet/python:1.3.0_cpu_mkl $ sudo docker images소스에서

CPU가있는 소스에서 MXNet 공유 라이브러리를 빌드하려면 아래 단계를 따르십시오.

Step 1− 먼저 필수 패키지를 설치해야합니다. 이러한 종속성은 Ubuntu 버전 16.04 이상에서 필요합니다.

sudo apt-get update

sudo apt-get install -y build-essential git ninja-build ccache libopenblas-dev libopencv-dev cmakeStep 2−이 단계에서는 MXNet 소스를 다운로드하고 구성합니다. 먼저 다음 명령을 사용하여 저장소를 복제하겠습니다.

git clone –recursive https://github.com/apache/incubator-mxnet.git mxnet

cd mxnet

cp config/linux.cmake config.cmakeStep 3− 다음 명령을 사용하여 MXNet 코어 공유 라이브러리를 구축 할 수 있습니다.

rm -rf build

mkdir -p build && cd build

cmake -GNinja ..

cmake --build .Two important points regarding the above step is as follows−

디버그 버전을 빌드하려면 다음과 같이 지정하십시오.

cmake -DCMAKE_BUILD_TYPE=Debug -GNinja ..병렬 컴파일 작업 수를 설정하려면 다음을 지정하십시오.

cmake --build . --parallel NMXNet 코어 공유 라이브러리를 성공적으로 빌드하면 build MXNet 프로젝트 루트의 폴더에서 libmxnet.so를 찾을 수 있으며, 이는 언어 바인딩을 설치하는 데 필요합니다 (선택 사항).

맥 OS

다음과 같은 방법으로 MacOS에 MXNet을 설치할 수 있습니다.

그래픽 처리 장치 (GPU)

GPU를 사용하는 MacOS에서 MXNet을 빌드하려는 경우 사용 가능한 Pip 및 Docker 방법이 없습니다. 이 경우 유일한 방법은 소스에서 빌드하는 것입니다.

소스에서

GPU가있는 소스에서 MXNet 공유 라이브러리를 빌드하려면 먼저 CUDA 및 cuDNN을위한 환경을 설정해야합니다. 당신은 따라야NVIDIA CUDA Installation Guide 사용할 수있는 https://docs.nvidia.com 과 cuDNN Installation Guide, 사용할 수있는 https://docs.nvidia.com/deeplearning Mac OS 용.

2019 년에 CUDA는 macOS 지원을 중단했습니다. 사실 향후 CUDA 버전도 macOS를 지원하지 않을 수 있습니다.

CUDA 및 cuDNN에 대한 환경을 설정했으면 아래 단계에 따라 OS X (Mac)의 소스에서 MXNet을 설치합니다.

Step 1− OS x에 대한 종속성이 필요하므로 먼저 필수 패키지를 설치해야합니다.

xcode-select –-install #Install OS X Developer Tools

/usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)" #Install Homebrew

brew install cmake ninja ccache opencv # Install dependenciesopencv는 선택적 종속성이므로 OpenCV없이 MXNet을 빌드 할 수도 있습니다.

Step 2−이 단계에서는 MXNet 소스를 다운로드하고 구성합니다. 먼저 다음 명령을 사용하여 저장소를 복제하겠습니다.

git clone –-recursive https://github.com/apache/incubator-mxnet.git mxnet

cd mxnet

cp config/linux.cmake config.cmakeGPU 지원의 경우 GPU가없는 컴퓨터에서 GPU 지원 빌드를 빌드하려고하면 MXNet 빌드가 GPU 아키텍처를 자동 감지 할 수 없기 때문에 먼저 CUDA 종속성을 설치해야합니다. 이러한 경우 MXNet은 사용 가능한 모든 GPU 아키텍처를 대상으로합니다.

Step 3− 다음 명령어를 사용하여 MXNet core 공유 라이브러리를 구축 할 수 있습니다.

rm -rf build

mkdir -p build && cd build

cmake -GNinja ..

cmake --build .위 단계에서 두 가지 중요한 점은 다음과 같습니다.

디버그 버전을 빌드하려면 다음과 같이 지정하십시오.

cmake -DCMAKE_BUILD_TYPE=Debug -GNinja ..병렬 컴파일 작업 수를 설정하려면 다음을 지정하십시오.

cmake --build . --parallel NMXNet 코어 공유 라이브러리를 성공적으로 빌드하면 build 귀하의 폴더 MXNet project root, 당신은 발견 할 것이다 libmxnet.dylib, 언어 바인딩을 설치하는 데 필요합니다 (선택 사항).

중앙 처리 장치 (CPU)

여기서는 처리를 위해 CPU를 사용할 때 MXNet을 설치하기 위해 Pip, Docker, Source 등 다양한 방법을 사용할 것입니다.

Pip 방식을 사용하여

다음 명령을 사용하여 Linus OS에 MXNet을 설치할 수 있습니다.

pip install mxnetDocker를 사용하여

MXNet을 사용하는 Docker 이미지는 DockerHub에서 찾을 수 있습니다. https://hub.docker.com/u/mxnet. CPU와 함께 Docker를 사용하여 MXNet을 설치하려면 아래 단계를 확인하십시오.

Step 1− 먼저 docker installation instructions 사용할 수있는 https://docs.docker.com/docker-for-mac 컴퓨터에 Docker를 설치해야합니다.

Step 2− 다음 명령을 사용하여 MXNet 도커 이미지를 가져올 수 있습니다.

$ docker pull mxnet/python이제 mxnet / python 도커 이미지 풀이 성공했는지 확인하기 위해 다음과 같이 도커 이미지를 나열 할 수 있습니다.

$ docker imagesMXNet에서 가장 빠른 추론 속도를 위해 Intel MKL-DNN과 함께 최신 MXNet을 사용하는 것이 좋습니다. 아래 명령을 확인하십시오.

$ docker pull mxnet/python:1.3.0_cpu_mkl

$ docker images소스에서

OS X (Mac)의 소스에서 MXNet을 설치하려면 아래 단계를 따르십시오.

Step 1− OS x에 대한 종속성이 필요하기 때문에 먼저 필수 패키지를 설치해야합니다.

xcode-select –-install #Install OS X Developer Tools

/usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)" #Install Homebrew

brew install cmake ninja ccache opencv # Install dependenciesopencv는 선택적 종속성이므로 OpenCV없이 MXNet을 빌드 할 수도 있습니다.

Step 2−이 단계에서는 MXNet 소스를 다운로드하고 구성합니다. 먼저 다음 명령을 사용하여 저장소를 복제합니다.

git clone –-recursive https://github.com/apache/incubator-mxnet.git mxnet

cd mxnet

cp config/linux.cmake config.cmakeStep 3− 다음 명령을 사용하여 MXNet 코어 공유 라이브러리를 구축 할 수 있습니다.

rm -rf build

mkdir -p build && cd build

cmake -GNinja ..

cmake --build .Two important points regarding the above step is as follows−

디버그 버전을 빌드하려면 다음과 같이 지정하십시오.

cmake -DCMAKE_BUILD_TYPE=Debug -GNinja ..병렬 컴파일 작업 수를 설정하려면 다음을 지정하십시오.

cmake --build . --parallel NMXNet 코어 공유 라이브러리를 성공적으로 빌드하면 build 귀하의 폴더 MXNet project root, 당신은 발견 할 것이다 libmxnet.dylib, 언어 바인딩을 설치하는 데 필요합니다 (선택 사항).

Windows OS

Windows에 MXNet을 설치하기위한 전제 조건은 다음과 같습니다.

최소 시스템 요구 사항

Windows 7, 10, Server 2012 R2 또는 Server 2016

Visual Studio 2015 또는 2017 (모든 유형)

Python 2.7 또는 3.6

pip

권장 시스템 요구 사항

Windows 10, Server 2012 R2 또는 Server 2016

비주얼 스튜디오 2017

At least one NVIDIA CUDA-enabled GPU

MKL-enabled CPU: Intel® Xeon® processor, Intel® Core™ processor family, Intel Atom® processor, or Intel® Xeon Phi™ processor

Python 2.7 or 3.6

pip

Graphical Processing Unit (GPU)

By using Pip method−

If you plan to build MXNet on Windows with NVIDIA GPUs, there are two options for installing MXNet with CUDA support with a Python package−

Install with CUDA Support

Below are the steps with the help of which, we can setup MXNet with CUDA.

Step 1− First install Microsoft Visual Studio 2017 or Microsoft Visual Studio 2015.

Step 2− Next, download and install NVIDIA CUDA. It is recommended to use CUDA versions 9.2 or 9.0 because some issues with CUDA 9.1 have been identified in the past.

Step 3− Now, download and install NVIDIA_CUDA_DNN.

Step 4− Finally, by using following pip command, install MXNet with CUDA−

pip install mxnet-cu92Install with CUDA and MKL Support

Below are the steps with the help of which, we can setup MXNet with CUDA and MKL.

Step 1− First install Microsoft Visual Studio 2017 or Microsoft Visual Studio 2015.

Step 2− Next, download and install intel MKL

Step 3− Now, download and install NVIDIA CUDA.

Step 4− Now, download and install NVIDIA_CUDA_DNN.

Step 5− Finally, by using following pip command, install MXNet with MKL.

pip install mxnet-cu92mklFrom source

To build the MXNet core library from source with GPU, we have the following two options−

Option 1− Build with Microsoft Visual Studio 2017

In order to build and install MXNet yourself by using Microsoft Visual Studio 2017, you need the following dependencies.

Install/update Microsoft Visual Studio.

If Microsoft Visual Studio is not already installed on your machine, first download and install it.

It will prompt about installing Git. Install it also.

If Microsoft Visual Studio is already installed on your machine but you want to update it then proceed to the next step to modify your installation. Here you will be given the opportunity to update Microsoft Visual Studio as well.

Follow the instructions for opening the Visual Studio Installer available at https://docs.microsoft.com/en-us to modify Individual components.

In the Visual Studio Installer application, update as required. After that look for and check VC++ 2017 version 15.4 v14.11 toolset and click Modify.

Now by using the following command, change the version of the Microsoft VS2017 to v14.11−

"C:\Program Files (x86)\Microsoft Visual Studio\2017\Community\VC\Auxiliary\Build\vcvars64.bat" -vcvars_ver=14.11Next, you need to download and install CMake available at https://cmake.org/download/ It is recommended to use CMake v3.12.2 which is available at https://cmake.org/download/ because it is tested with MXNet.

Now, download and run the OpenCV package available at https://sourceforge.net/projects/opencvlibrary/which will unzip several files. It is up to you if you want to place them in another directory or not. Here, we will use the path C:\utils(mkdir C:\utils) as our default path.

Next, we need to set the environment variable OpenCV_DIR to point to the OpenCV build directory that we have just unzipped. For this open command prompt and type set OpenCV_DIR=C:\utils\opencv\build.

One important point is that if you do not have the Intel MKL (Math Kernel Library) installed the you can install it.

Another open source package you can use is OpenBLAS. Here for the further instructions we are assuming that you are using OpenBLAS.

So, Download the OpenBlas package which is available at https://sourceforge.net and unzip the file, rename it to OpenBLAS and put it under C:\utils.

Next, we need to set the environment variable OpenBLAS_HOME to point to the OpenBLAS directory that contains the include and lib directories. For this open command prompt and type set OpenBLAS_HOME=C:\utils\OpenBLAS.

Now, download and install CUDA available at https://developer.nvidia.com. Note that, if you already had CUDA, then installed Microsoft VS2017, you need to reinstall CUDA now, so that you can get the CUDA toolkit components for Microsoft VS2017 integration.

Next, you need to download and install cuDNN.

Next, you need to download and install git which is at https://gitforwindows.org/ also.

Once you have installed all the required dependencies, follow the steps given below to build the MXNet source code−

Step 1− Open command prompt in windows.

Step 2− Now, by using the following command, download the MXNet source code from GitHub:

cd C:\

git clone https://github.com/apache/incubator-mxnet.git --recursiveStep 3− Next, verify the following−

DCUDNN_INCLUDE and DCUDNN_LIBRARY environment variables are pointing to the include folder and cudnn.lib file of your CUDA installed location

C:\incubator-mxnet is the location of the source code you just cloned in the previous step.

Step 4− Next by using the following command, create a build directory and also go to the directory, for example−

mkdir C:\incubator-mxnet\build

cd C:\incubator-mxnet\buildStep 5− Now, by using cmake, compile the MXNet source code as follows−

cmake -G "Visual Studio 15 2017 Win64" -T cuda=9.2,host=x64 -DUSE_CUDA=1 -DUSE_CUDNN=1 -DUSE_NVRTC=1 -DUSE_OPENCV=1 -DUSE_OPENMP=1 -DUSE_BLAS=open -DUSE_LAPACK=1 -DUSE_DIST_KVSTORE=0 -DCUDA_ARCH_LIST=Common -DCUDA_TOOLSET=9.2 -DCUDNN_INCLUDE=C:\cuda\include -DCUDNN_LIBRARY=C:\cuda\lib\x64\cudnn.lib "C:\incubator-mxnet"Step 6− Once the CMake successfully completed, use the following command to compile the MXNet source code−

msbuild mxnet.sln /p:Configuration=Release;Platform=x64 /maxcpucountOption 2: Build with Microsoft Visual Studio 2015

In order to build and install MXNet yourself by using Microsoft Visual Studio 2015, you need the following dependencies.

Install/update Microsoft Visual Studio 2015. The minimum requirement to build MXnet from source is of Update 3 of Microsoft Visual Studio 2015. You can use Tools -> Extensions and Updates... | Product Updates menu to upgrade it.

Next, you need to download and install CMake which is available at https://cmake.org/download/. It is recommended to use CMake v3.12.2 which is at https://cmake.org/download/, because it is tested with MXNet.

Now, download and run the OpenCV package available at https://excellmedia.dl.sourceforge.net which will unzip several files. It is up to you, if you want to place them in another directory or not.

Next, we need to set the environment variable OpenCV_DIR to point to the OpenCV build directory that we have just unzipped. For this, open command prompt and type set OpenCV_DIR=C:\opencv\build\x64\vc14\bin.

One important point is that if you do not have the Intel MKL (Math Kernel Library) installed the you can install it.

Another open source package you can use is OpenBLAS. Here for the further instructions we are assuming that you are using OpenBLAS.

So, Download the OpenBLAS package available at https://excellmedia.dl.sourceforge.net and unzip the file, rename it to OpenBLAS and put it under C:\utils.

Next, we need to set the environment variable OpenBLAS_HOME to point to the OpenBLAS directory that contains the include and lib directories. You can find the directory in C:\Program files (x86)\OpenBLAS\

Note that, if you already had CUDA, then installed Microsoft VS2015, you need to reinstall CUDA now so that, you can get the CUDA toolkit components for Microsoft VS2017 integration.

Next, you need to download and install cuDNN.

Now, we need to Set the environment variable CUDACXX to point to the CUDA Compiler(C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v9.1\bin\nvcc.exe for example).

Similarly, we also need to set the environment variable CUDNN_ROOT to point to the cuDNN directory that contains the include, lib and bin directories (C:\Downloads\cudnn-9.1-windows7-x64-v7\cuda for example).

Once you have installed all the required dependencies, follow the steps given below to build the MXNet source code−

Step 1− First, download the MXNet source code from GitHub−

cd C:\

git clone https://github.com/apache/incubator-mxnet.git --recursiveStep 2− Next, use CMake to create a Visual Studio in ./build.

Step 3− Now, in Visual Studio, we need to open the solution file,.sln, and compile it. These commands will produce a library called mxnet.dll in the ./build/Release/ or ./build/Debug folder

Step 4− Once the CMake successfully completed, use the following command to compile the MXNet source code

msbuild mxnet.sln /p:Configuration=Release;Platform=x64 /maxcpucountCentral Processing Unit (CPU)

Here, we will use various methods namely Pip, Docker, and Source to install MXNet when we are using CPU for processing−

By using Pip method

If you plan to build MXNet on Windows with CPUs, there are two options for installing MXNet using a Python package−

Install with CPUs

Use the following command to install MXNet with CPU with Python−

pip install mxnetInstall with Intel CPUs

As discussed above, MXNet has experimental support for Intel MKL as well as MKL-DNN. Use the following command to install MXNet with Intel CPU with Python−

pip install mxnet-mklBy using Docker

You can find the docker images with MXNet at DockerHub, available at https://hub.docker.com/u/mxnet Let us check out the steps below, to install MXNet by using Docker with CPU−

Step 1− First, by following the docker installation instructions which can be read at https://docs.docker.com/docker-for-mac/install. We need to install Docker on our machine.

Step 2− By using the following command, you can pull the MXNet docker image−

$ docker pull mxnet/pythonNow in order to see if mxnet/python docker image pull was successful, we can list docker images as follows−

$ docker imagesFor the fastest inference speeds with MXNet, it is recommended to use the latest MXNet with Intel MKL-DNN.

Check the commands below−

$ docker pull mxnet/python:1.3.0_cpu_mkl $ docker imagesInstalling MXNet On Cloud and Devices

This section highlights how to install Apache MXNet on Cloud and on devices. Let us begin by learning about installing MXNet on cloud.

Installing MXNet On Cloud

You can also get Apache MXNet on several cloud providers with Graphical Processing Unit (GPU) support. Two other kind of support you can find are as follows−

- GPU/CPU-hybrid support for use cases like scalable inference.

- Factorial GPU support with AWS Elastic Inference.

Following are cloud providers providing GPU support with different virtual machine for Apache MXNet−

The Alibaba Console

You can create the NVIDIA GPU Cloud Virtual Machine (VM) available at https://docs.nvidia.com/ngc with the Alibaba Console and use Apache MXNet.

Amazon Web Services

It also provides GPU support and gives the following services for Apache MXNet−

Amazon SageMaker

It manages training and deployment of Apache MXNet models.

AWS Deep Learning AMI

It provides preinstalled Conda environment for both Python 2 and Python 3 with Apache MXNet, CUDA, cuDNN, MKL-DNN, and AWS Elastic Inference.

Dynamic Training on AWS

It provides the training for experimental manual EC2 setup as well as for semi-automated CloudFormation setup.

You can use NVIDIA VM available at https://aws.amazon.com with Amazon web services.

Google Cloud Platform

Google is also providing NVIDIA GPU cloud image which is available at https://console.cloud.google.com to work with Apache MXNet.

Microsoft Azure

Microsoft Azure Marketplace is also providing NVIDIA GPU cloud image available at https://azuremarketplace.microsoft.com to work with Apache MXNet.

Oracle Cloud

Oracle is also providing NVIDIA GPU cloud image available at https://docs.cloud.oracle.com to work with Apache MXNet.

Central Processing Unit (CPU)

Apache MXNet works on every cloud provider’s CPU-only instance. There are various methods to install such as−

Python pip install instructions.

Docker instructions.

Preinstalled option like Amazon Web Services which provides AWS Deep Learning AMI (having preinstalled Conda environment for both Python 2 and Python 3 with MXNet and MKL-DNN).

Installing MXNet on Devices

Let us learn how to install MXNet on devices.

Raspberry Pi

You can also run Apache MXNet on Raspberry Pi 3B devices as MXNet also support Respbian ARM based OS. In order to run MXNet smoothly on the Raspberry Pi3, it is recommended to have a device that has more than 1 GB of RAM and a SD card with at least 4GB of free space.

Following are the ways with the help of which you can build MXNet for the Raspberry Pi and install the Python bindings for the library as well−

Quick installation

The pre-built Python wheel can be used on a Raspberry Pi 3B with Stretch for quick installation. One of the important issues with this method is that, we need to install several dependencies to get Apache MXNet to work.

Docker installation

You can follow the docker installation instructions, which is available at https://docs.docker.com/engine/install/ubuntu/ to install Docker on your machine. For this purpose, we can install and use Community Edition (CE) also.

Native Build (from source)

In order to install MXNet from source, we need to follow the following two steps−

Step 1

Build the shared library from the Apache MXNet C++ source code

To build the shared library on Raspberry version Wheezy and later, we need the following dependencies:

Git− It is required to pull code from GitHub.

Libblas− It is required for linear algebraic operations.

Libopencv− It is required for computer vision related operations. However, it is optional if you would like to save your RAM and Disk Space.

C++ Compiler− It is required to compiles and builds MXNet source code. Following are the supported compilers that supports C++ 11−

G++ (4.8 or later version)

Clang(3.9-6)

Use the following commands to install the above-mentioned dependencies−

sudo apt-get update

sudo apt-get -y install git cmake ninja-build build-essential g++-4.9 c++-4.9 liblapack*

libblas* libopencv*

libopenblas* python3-dev python-dev virtualenvNext, we need to clone the MXNet source code repository. For this use the following git command in your home directory−

git clone https://github.com/apache/incubator-mxnet.git --recursive

cd incubator-mxnetNow, with the help of following commands, build the shared library:

mkdir -p build && cd build

cmake \

-DUSE_SSE=OFF \

-DUSE_CUDA=OFF \

-DUSE_OPENCV=ON \

-DUSE_OPENMP=ON \

-DUSE_MKL_IF_AVAILABLE=OFF \

-DUSE_SIGNAL_HANDLER=ON \

-DCMAKE_BUILD_TYPE=Release \

-GNinja ..

ninja -j$(nproc)Once you execute the above commands, it will start the build process which will take couple of hours to finish. You will get a file named libmxnet.so in the build directory.

Step 2

Install the supported language-specific packages for Apache MXNet

In this step, we will install MXNet Pythin bindings. To do so, we need to run the following command in the MXNet directory−

cd python

pip install --upgrade pip

pip install -e .Alternatively, with the following command, you can also create a whl package installable with pip−

ci/docker/runtime_functions.sh build_wheel python/ $(realpath build)NVIDIA Jetson Devices

You can also run Apache MXNet on NVIDIA Jetson Devices, such as TX2 or Nano as MXNet also support the Ubuntu Arch64 based OS. In order to run, MXNet smoothly on the NVIDIA Jetson Devices, it is necessary to have CUDA installed on your Jetson device.

Following are the ways with the help of which you can build MXNet for NVIDIA Jetson devices:

By using a Jetson MXNet pip wheel for Python development

From source

But, before building MXNet from any of the above-mentioned ways, you need to install following dependencies on your Jetson devices−

Python Dependencies

In order to use the Python API, we need the following dependencies−

sudo apt update

sudo apt -y install \

build-essential \

git \

graphviz \

libatlas-base-dev \

libopencv-dev \

python-pip

sudo pip install --upgrade \

pip \

setuptools

sudo pip install \

graphviz==0.8.4 \

jupyter \

numpy==1.15.2Clone the MXNet source code repository

By using the following git command in your home directory, clone the MXNet source code repository−

git clone --recursive https://github.com/apache/incubator-mxnet.git mxnetSetup environment variables

Add the following in your .profile file in your home directory−

export PATH=/usr/local/cuda/bin:$PATH export MXNET_HOME=$HOME/mxnet/

export PYTHONPATH=$MXNET_HOME/python:$PYTHONPATHNow, apply the change immediately with the following command−

source .profileConfigure CUDA

Before configuring CUDA, with nvcc, you need to check what version of CUDA is running−

nvcc --versionSuppose, if more than one CUDA version is installed on your device or computer and you want to switch CUDA versions then, use the following and replace the symbolic link to the version you want−

sudo rm /usr/local/cuda

sudo ln -s /usr/local/cuda-10.0 /usr/local/cudaThe above command will switch to CUDA 10.0, which is preinstalled on NVIDIA Jetson device Nano.

Once you done with the above-mentioned prerequisites, you can now install MXNet on NVIDIA Jetson Devices. So, let us understand the ways with the help of which you can install MXNet−

By using a Jetson MXNet pip wheel for Python development− If you want to use a prepared Python wheel then download the following to your Jetson and run it−

MXNet 1.4.0 (for Python 3) available at https://docs.docker.com

MXNet 1.4.0 (for Python 2) available at https://docs.docker.com

Native Build (from source)

In order to install MXNet from source, we need to follow the following two steps−

Step 1

Build the shared library from the Apache MXNet C++ source code

To build the shared library from the Apache MXNet C++ source code, you can either use Docker method or do it manually−

Docker method

In this method, you first need to install Docker and able to run it without sudo (which is also explained in previous steps). Once done, run the following to execute cross-compilation via Docker−

$MXNET_HOME/ci/build.py -p jetsonManual

In this method, you need to edit the Makefile (with below command) to install the MXNet with CUDA bindings to leverage the Graphical Processing units (GPU) on NVIDIA Jetson devices:

cp $MXNET_HOME/make/crosscompile.jetson.mk config.mkAfter editing the Makefile, you need to edit config.mk file to make some additional changes for the NVIDIA Jetson device.

For this, update the following settings−

Update the CUDA path: USE_CUDA_PATH = /usr/local/cuda

Add -gencode arch=compute-63, code=sm_62 to the CUDA_ARCH setting.

Update the NVCC settings: NVCCFLAGS := -m64

Turn on OpenCV: USE_OPENCV = 1

Now to ensure that the MXNet builds with Pascal’s hardware level low precision acceleration, we need to edit the Mshadow Makefile as follow−

MSHADOW_CFLAGS += -DMSHADOW_USE_PASCAL=1Finally, with the help of following command you can build the complete Apache MXNet library−

cd $MXNET_HOME make -j $(nproc)Once you execute the above commands, it will start the build process which will take couple of hours to finish. You will get a file named libmxnet.so in the mxnet/lib directory.

Step 2

Install the Apache MXNet Python Bindings

In this step, we will install MXNet Python bindings. To do so we need to run the following command in the MXNet directory−

cd $MXNET_HOME/python

sudo pip install -e .Once done with above steps, you are now ready to run MXNet on your NVIDIA Jetson devices TX2 or Nano. It can be verified with the following command−

import mxnet

mxnet.__version__It will return the version number if everything is properly working.

To support the research and development of Deep Learning applications across many fields, Apache MXNet provides us a rich ecosystem of toolkits, libraries and many more. Let us explore them −

ToolKits

Following are some of the most used and important toolkits provided by MXNet −

GluonCV

As name implies GluonCV is a Gluon toolkit for computer vision powered by MXNet. It provides implementation of state-of-the-art DL (Deep Learning) algorithms in computer vision (CV). With the help of GluonCV toolkit engineers, researchers, and students can validate new ideas and learn CV easily.

Given below are some of the features of GluonCV −

It trains scripts for reproducing state-of-the-art results reported in latest research.

More than 170+ high quality pretrained models.

Embrace flexible development pattern.

GluonCV is easy to optimize. We can deploy it without retaining heavy weight DL framework.

It provides carefully designed APIs that greatly lessen the implementation intricacy.

Community support.

Easy to understand implementations.

Following are the supported applications by GluonCV toolkit:

Image Classification

Object Detection

Semantic Segmentation

Instance Segmentation

Pose Estimation

Video Action Recognition

We can install GluonCV by using pip as follows −

pip install --upgrade mxnet gluoncvGluonNLP

As name implies GluonNLP is a Gluon toolkit for Natural Language Processing (NLP) powered by MXNet. It provides implementation of state-of-the-art DL (Deep Learning) models in NLP.

GluonNLP 툴킷 엔지니어, 연구원 및 학생의 도움으로 텍스트 데이터 파이프 라인 및 모델을위한 블록을 구축 할 수 있습니다. 이러한 모델을 기반으로 연구 아이디어와 제품의 프로토 타입을 신속하게 만들 수 있습니다.

다음은 GluonNLP의 일부 기능입니다.

최신 연구에서보고 된 최첨단 결과를 재현하기위한 스크립트를 훈련합니다.

일반적인 NLP 작업을위한 사전 훈련 된 모델 세트입니다.

구현 복잡성을 크게 줄여주는 신중하게 설계된 API를 제공합니다.

커뮤니티 지원.

또한 새로운 NLP 작업을 시작하는 데 도움이되는 자습서를 제공합니다.

다음은 GluonNLP 툴킷으로 구현할 수있는 NLP 작업입니다.

단어 삽입

언어 모델

기계 번역

텍스트 분류

감정 분석

자연어 추론

텍스트 생성

종속성 구문 분석

명명 된 엔티티 인식

의도 분류 및 슬롯 레이블링

다음과 같이 pip를 사용하여 GluonNLP를 설치할 수 있습니다.

pip install --upgrade mxnet gluonnlpGluonTS

이름에서 알 수 있듯이 GluonTS는 MXNet에서 제공하는 확률 적 시계열 모델링을위한 Gluon 툴킷입니다.

그것은 다음과 같은 기능을 제공합니다-

훈련 준비가 된 최첨단 (SOTA) 딥 러닝 모델.

시계열 데이터 세트에 대한로드 및 반복을위한 유틸리티입니다.

자신의 모델을 정의하기위한 빌딩 블록.

GluonTS 툴킷 엔지니어의 도움으로 연구원 및 학생은 자체 데이터에 대해 내장 된 모델을 교육 및 평가하고 다양한 솔루션을 빠르게 실험하고 시계열 작업에 대한 솔루션을 찾을 수 있습니다.

또한 제공된 추상화 및 빌딩 블록을 사용하여 사용자 지정 시계열 모델을 만들고 기준 알고리즘에 대해 빠르게 벤치마킹 할 수 있습니다.

다음과 같이 pip를 사용하여 GluonTS를 설치할 수 있습니다.

pip install gluontsGluonFR

이름에서 알 수 있듯이 FR (Face Recognition) 용 Apache MXNet Gluon 툴킷입니다. 그것은 다음과 같은 기능을 제공합니다-

얼굴 인식의 최첨단 (SOTA) 딥 러닝 모델.

SoftmaxCrossEntropyLoss, ArcLoss, TripletLoss, RingLoss, CosLoss / AMsoftmax, L2-Softmax, A-Softmax, CenterLoss, ContrastiveLoss, LGM Loss 등의 구현.

Gluon Face를 설치하려면 Python 3.5 이상이 필요합니다. 먼저 다음과 같이 GluonCV와 MXNet을 먼저 설치해야합니다.

pip install gluoncv --pre

pip install mxnet-mkl --pre --upgrade

pip install mxnet-cuXXmkl --pre –upgrade # if cuda XX is installed종속성을 설치 한 후 다음 명령을 사용하여 GluonFR을 설치할 수 있습니다.

From Source

pip install git+https://github.com/THUFutureLab/gluon-face.git@masterPip

pip install gluonfr생태계

이제 MXNet의 풍부한 라이브러리, 패키지 및 프레임 워크를 살펴 보겠습니다.

코치 RL

Coach, Intel AI 연구소에서 만든 Python RL (강화 학습) 프레임 워크입니다. 최첨단 RL 알고리즘으로 쉽게 실험 할 수 있습니다. Coach RL은 Apache MXNet을 백엔드로 지원하며 새로운 환경을 간단하게 통합하여 해결할 수 있습니다.

기존 구성 요소를 쉽게 확장하고 재사용하기 위해 Coach RL은 알고리즘, 환경, NN 아키텍처, 탐색 정책과 같은 기본 강화 학습 구성 요소를 매우 잘 분리했습니다.

다음은 Coach RL 프레임 워크에 대한 에이전트 및 지원되는 알고리즘입니다.

가치 최적화 에이전트

Deep Q 네트워크 (DQN)

더블 딥 Q 네트워크 (DDQN)

듀얼 링 Q 네트워크

혼합 몬테카를로 (MMC)

Persistent Advantage Learning (PAL)

범주 형 딥 Q 네트워크 (C51)

분위수 회귀 심층 Q 네트워크 (QR-DQN)

N-Step Q 학습

신경 에피소드 제어 (NEC)

정규화 된 이점 함수 (NAF)

Rainbow

정책 최적화 에이전트

정책 그라디언트 (PG)

A3C (Asynchronous Advantage Actor-Critic)

DDPG (Deep Deterministic Policy Gradients)

근접 정책 최적화 (PPO)

클리핑 된 근접 정책 최적화 (CPPO)

일반화 된 이점 추정 (GAE)

Experience Replay (ACER)를 통한 효율적인 배우 비평가 샘플

연약한 배우 비평 (SAC)

TD3 (Twin Delayed Deep Deterministic Policy Gradient)

일반 요원

직접 미래 예측 (DFP)

모방 학습 에이전트

행동 복제 (BC)

조건부 모방 학습

계층 적 강화 학습 에이전트

계층 적 배우 비평가 (HAC)

딥 그래프 라이브러리

NYU 및 AWS 팀 상하이에서 개발 한 DGL (Deep Graph Library)은 MXNet 위에 그래프 신경망 (GNN)을 쉽게 구현할 수있는 Python 패키지입니다. 또한 PyTorch, Gluon 등과 같은 기존의 다른 주요 딥 러닝 라이브러리 위에 GNN을 쉽게 구현할 수 있습니다.

Deep Graph Library는 무료 소프트웨어입니다. Ubuntu 16.04, macOS X 및 Windows 7 이상 이후의 모든 Linux 배포에서 사용할 수 있습니다. 또한 Python 3.5 버전 이상이 필요합니다.

다음은 DGL의 기능입니다-

No Migration cost − DGL은 널리 사용되는 기존 DL 프레임 워크를 기반으로 구축되므로 마이그레이션 비용이 없습니다.

Message Passing− DGL은 메시지 전달 기능을 제공하며 다양한 제어 기능을 제공합니다. 메시지 전달 범위는 선택한 에지를 따라 전송하는 것과 같은 낮은 수준의 작업에서 그래프 전체 기능 업데이트와 같은 높은 수준의 제어에 이르기까지 다양합니다.

Smooth Learning Curve − 강력한 사용자 정의 함수가 유연하고 사용하기 쉽기 때문에 DGL을 배우고 사용하는 것이 매우 쉽습니다.

Transparent Speed Optimization − DGL은 계산 및 희소 행렬 곱셈의 자동 일괄 처리를 수행하여 투명한 속도 최적화를 제공합니다.

High performance − 최대 효율성을 달성하기 위해 DGL은 하나 또는 여러 그래프에 DNN (심층 신경망) 훈련을 자동으로 일괄 처리합니다.

Easy & friendly interface − DGL은 엣지 피처 액세스 및 그래프 구조 조작을위한 쉽고 친숙한 인터페이스를 제공합니다.

InsightFace

MXNet으로 구동되는 컴퓨터 비전에서 SOTA (최신) 얼굴 분석 알고리즘의 구현을 제공하는 얼굴 분석 용 딥 러닝 툴킷 인 InsightFace. 그것은 제공합니다-

사전 훈련 된 고품질 대형 모델 세트.

최첨단 (SOTA) 교육 스크립트.

InsightFace는 최적화하기 쉽습니다. 무거운 DL 프레임 워크를 유지하지 않고도 배포 할 수 있습니다.

구현 복잡성을 크게 줄여주는 신중하게 설계된 API를 제공합니다.

자신의 모델을 정의하기위한 빌딩 블록.

다음과 같이 pip를 사용하여 InsightFace를 설치할 수 있습니다.

pip install --upgrade insightfaceInsightFace를 설치하기 전에 시스템 구성에 따라 올바른 MXNet 패키지를 설치하십시오.

Keras-MXNet

Keras가 Python으로 작성된 고수준 신경망 (NN) API라는 것을 알고 있듯이 Keras-MXNet은 Keras에 대한 백엔드 지원을 제공합니다. 고성능의 확장 가능한 Apache MXNet DL 프레임 워크 위에서 실행할 수 있습니다.

Keras-MXNet의 기능은 다음과 같습니다.

사용자가 쉽고 부드럽고 빠른 프로토 타이핑을 할 수 있습니다. 이는 모두 사용자 친 화성, 모듈성 및 확장 성을 통해 발생합니다.

CNN (Convolutional Neural Networks) 및 RNN (Recurrent Neural Networks)을 모두 지원하며 둘 다의 조합도 지원합니다.

중앙 처리 장치 (CPU)와 그래픽 처리 장치 (GPU) 모두에서 완벽하게 실행됩니다.

하나 또는 다중 GPU에서 실행할 수 있습니다.

이 백엔드를 사용하려면 먼저 다음과 같이 keras-mxnet을 설치해야합니다.

pip install keras-mxnet이제 GPU를 사용하는 경우 다음과 같이 CUDA 9를 지원하는 MXNet을 설치하십시오.

pip install mxnet-cu90그러나 CPU 만 사용하는 경우 다음과 같이 기본 MXNet을 설치하십시오.

pip install mxnetMXBoard

MXBoard는 Python으로 작성된 로깅 도구로 MXNet 데이터 프레임을 기록하고 TensorBoard에 표시하는 데 사용됩니다. 즉, MXBoard는 tensorboard-pytorch API를 따르도록되어 있습니다. TensorBoard에서 대부분의 데이터 유형을 지원합니다.

그들 중 일부는 아래에 언급되어 있습니다.

Graph

Scalar

Histogram

Embedding

Image

Text

Audio

정밀도-재현율 곡선

MXFusion

MXFusion은 딥 러닝이 포함 된 모듈 식 확률 프로그래밍 라이브러리입니다. MXFusion을 사용하면 확률 적 프로그래밍을 위해 딥 러닝 라이브러리의 핵심 기능인 모듈성을 완전히 활용할 수 있습니다. 사용이 간편하고 사용자에게 확률 모델을 설계하고이를 실제 문제에 적용 할 수있는 편리한 인터페이스를 제공합니다.

MXFusion은 MacOS 및 Linux OS의 Python 버전 3.4 이상에서 확인되었습니다. MXFusion을 설치하려면 먼저 다음 종속성을 설치해야합니다.

MXNet> = 1.3

Networkx> = 2.1

다음 pip 명령의 도움으로 MXFusion을 설치할 수 있습니다-

pip install mxfusionTVM

CPU, GPU 및 특수 가속기와 같은 하드웨어 백엔드를위한 오픈 소스 엔드 투 엔드 딥 러닝 컴파일러 스택 인 Apache TVM은 생산성 중심의 딥 러닝 프레임 워크와 성능 중심의 하드웨어 백엔드 간의 격차를 메우는 것을 목표로합니다. . 최신 릴리스 MXNet 1.6.0을 통해 사용자는 Apache (incubating) TVM을 활용하여 Python 프로그래밍 언어로 고성능 운영자 커널을 구현할 수 있습니다.

Apache TVM은 실제로 워싱턴 대학에있는 Paul G. Allen 컴퓨터 과학 및 공학 학교의 SAMPL 그룹에서 연구 프로젝트로 시작했으며 현재 OSC ( 오픈 소스 커뮤니티)는 Apache 방식의 여러 산업 및 학술 기관을 포함합니다.

다음은 Apache (incubating) TVM의 주요 기능입니다.

이전 C ++ 기반 개발 프로세스를 단순화합니다.

CPU, GPU 등과 같은 여러 하드웨어 백엔드에서 동일한 구현을 공유 할 수 있습니다.

TVM은 Kears, MXNet, PyTorch, Tensorflow, CoreML, DarkNet과 같은 다양한 프레임 워크의 DL 모델을 다양한 하드웨어 백엔드에 배포 가능한 최소 모듈로 컴파일합니다.

또한 더 나은 성능으로 텐서 연산자를 자동으로 생성하고 최적화 할 수있는 인프라를 제공합니다.

XFer

전이 학습 프레임 워크 인 Xfer는 Python으로 작성되었습니다. 기본적으로 MXNet 모델을 사용하고 메타 모델을 학습하거나 새 대상 데이터 세트에 대한 모델을 수정합니다.

간단히 말해서 Xfer는 사용자가 DNN (심층 신경망)에 저장된 지식을 빠르고 쉽게 전송할 수있는 Python 라이브러리입니다.

Xfer를 사용할 수 있습니다-

임의의 숫자 형식의 데이터 분류 용.

이미지 또는 텍스트 데이터의 일반적인 경우.

기능 추출에서 재목 적자 (대상 작업에서 분류를 수행하는 객체)를 교육하기 위해 스팸을 보내는 파이프 라인으로 사용됩니다.

다음은 Xfer의 기능입니다.

자원 효율성

데이터 효율성

신경망에 쉽게 액세스

불확실성 모델링

신속한 프로토 타입

NN에서 기능 추출을위한 유틸리티

이 장은 MXNet 시스템 아키텍처를 이해하는 데 도움이 될 것입니다. MXNet 모듈에 대해 배우면서 시작하겠습니다.

MXNet 모듈

아래 다이어그램은 MXNet 시스템 아키텍처이며 주요 모듈 및 구성 요소를 보여줍니다. MXNet modules and their interaction.

위의 다이어그램에서-

파란색 상자의 모듈은 User Facing Modules.

녹색 색상 상자의 모듈은 System Modules.

단색 화살표는 높은 종속성을 나타냅니다. 즉, 인터페이스에 크게 의존합니다.

점선 화살표는 가벼운 의존성을 나타냅니다. 즉, 편의성과 인터페이스 일관성을 위해 사용 된 데이터 구조입니다. 사실, 대안으로 대체 할 수 있습니다.

사용자 대면 및 시스템 모듈에 대해 자세히 설명하겠습니다.

사용자 용 모듈

사용자 용 모듈은 다음과 같습니다.

NDArray− Apache MXNet을위한 유연한 명령형 프로그램을 제공합니다. 동적 및 비동기식 n 차원 배열입니다.

KVStore− 효율적인 파라미터 동기화를위한 인터페이스 역할을합니다. KVStore에서 KV는 Key-Value를 나타냅니다. 따라서 키-값 저장소 인터페이스입니다.

Data Loading (IO) −이 사용자 용 모듈은 효율적인 분산 데이터로드 및 증대를 위해 사용됩니다.

Symbol Execution− 정적 기호 그래프 실행기입니다. 효율적인 기호 그래프 실행 및 최적화를 제공합니다.

Symbol Construction −이 사용자 용 모듈은 사용자에게 계산 그래프, 즉 넷 구성을 구성하는 방법을 제공합니다.

시스템 모듈

시스템 모듈은 다음과 같습니다-

Storage Allocator − 이름에서 알 수 있듯이이 시스템 모듈은 호스트, 즉 CPU 및 다른 장치 (예 : GPU)에서 메모리 블록을 효율적으로 할당하고 재활용합니다.

Runtime Dependency Engine − 런타임 종속성 엔진 모듈은 읽기 / 쓰기 종속성에 따라 작업을 예약하고 실행합니다.

Resource Manager − RM (Resource Manager) 시스템 모듈은 난수 생성기 및 시간 공간과 같은 전역 리소스를 관리합니다.

Operator − 운영자 시스템 모듈은 정적 순방향 및 기울기 계산 (예 : 역 전파)을 정의하는 모든 연산자로 구성됩니다.

여기에서는 Apache MXNet의 시스템 구성 요소에 대해 자세히 설명합니다. 먼저 MXNet의 실행 엔진에 대해 공부합니다.

실행 엔진

Apache MXNet의 실행 엔진은 매우 다양합니다. 딥 러닝은 물론 도메인 별 문제에 사용할 수 있습니다. 종속성에 따라 여러 함수를 실행합니다. 종속성이있는 함수는 직렬화되는 반면 종속성이없는 함수는 병렬로 실행될 수 있도록 설계되었습니다.

핵심 인터페이스

아래에 주어진 API는 Apache MXNet의 실행 엔진을위한 핵심 인터페이스입니다.

virtual void PushSync(Fn exec_fun, Context exec_ctx,

std::vector<VarHandle> const& const_vars,

std::vector<VarHandle> const& mutate_vars) = 0;위의 API는 다음과 같습니다.

exec_fun − MXNet의 핵심 인터페이스 API를 사용하면 컨텍스트 정보 및 종속성과 함께 exec_fun이라는 함수를 실행 엔진에 푸시 할 수 있습니다.

exec_ctx − 위에서 언급 한 exec_fun 함수가 실행되어야하는 컨텍스트 정보.

const_vars − 함수가 읽는 변수입니다.

mutate_vars − 수정할 변수입니다.

실행 엔진은 사용자에게 공통 변수를 수정하는 두 함수의 실행이 푸시 순서로 직렬화되도록 보장합니다.

함수

다음은 Apache MXNet 실행 엔진의 기능 유형입니다.

using Fn = std::function<void(RunContext)>;위의 기능에서 RunContext런타임 정보를 포함합니다. 런타임 정보는 실행 엔진에 의해 결정되어야합니다. 구문RunContext 다음과 같습니다-

struct RunContext {

// stream pointer which could be safely cast to

// cudaStream_t* type

void *stream;

};다음은 실행 엔진의 기능에 대한 몇 가지 중요한 사항입니다.

모든 기능은 MXNet의 실행 엔진의 내부 스레드에 의해 실행됩니다.

함수가 실행 스레드를 차지하고 총 처리량도 줄어들 기 때문에 함수 차단을 실행 엔진으로 푸시하는 것은 좋지 않습니다.

이를 위해 MXNet은 다음과 같은 또 다른 비동기 기능을 제공합니다.

using Callback = std::function<void()>;

using AsyncFn = std::function<void(RunContext, Callback)>;이것에 AsyncFn 함수는 스레드의 무거운 부분을 전달할 수 있지만 실행 엔진은 다음을 호출 할 때까지 함수가 완료된 것으로 간주하지 않습니다. callback 함수.

문맥

에 Context에서 실행할 함수의 컨텍스트를 지정할 수 있습니다. 이것은 일반적으로 다음을 포함합니다-

함수가 CPU 또는 GPU에서 실행되어야하는지 여부.

컨텍스트에서 GPU를 지정하면 사용할 GPU.

Context와 RunContext 사이에는 큰 차이가 있습니다. 컨텍스트에는 장치 유형과 장치 ID가있는 반면 RunContext에는 런타임 중에 만 결정할 수있는 정보가 있습니다.

VarHandle

함수의 종속성을 지정하는 데 사용되는 VarHandle은 함수가 수정하거나 사용할 수있는 외부 리소스를 나타내는 데 사용할 수있는 토큰 (특히 실행 엔진에서 제공)과 같습니다.

하지만 왜 VarHandle을 사용해야합니까? 이는 Apache MXNet 엔진이 다른 MXNet 모듈과 분리되도록 설계 되었기 때문입니다.

다음은 VarHandle에 대한 몇 가지 중요한 사항입니다.

가볍기 때문에 변수를 생성, 삭제 또는 복사하는 데 운영 비용이 거의 들지 않습니다.

우리는 불변 변수를 지정해야합니다. const_vars.

변경 가능한 변수를 지정해야합니다. 즉, mutate_vars.

함수 간의 종속성을 해결하기 위해 실행 엔진에서 사용하는 규칙은 두 함수 중 하나가 적어도 하나의 공통 변수를 수정할 때 두 함수의 실행이 푸시 순서로 직렬화된다는 것입니다.

새 변수를 생성하기 위해 NewVar() API.

변수를 삭제하려면 PushDelete API.

간단한 예를 들어 그 작업을 이해합시다.

F1과 F2라는 두 개의 함수가 있고 둘 다 변수 즉 V2를 변경한다고 가정합니다. 이 경우 F1 이후에 F2를 누르면 F1 이후에 F2가 실행되도록 보장됩니다. 반면에 F1과 F2가 모두 V2를 사용하는 경우 실제 실행 순서는 무작위 일 수 있습니다.

밀고 기다리기

Push 과 wait 실행 엔진의 두 가지 더 유용한 API입니다.

다음은의 두 가지 중요한 기능입니다. Push API :

모든 Push API는 비동기식이므로 푸시 된 함수의 완료 여부에 관계없이 API 호출이 즉시 반환됩니다.

Push API는 스레드로부터 안전하지 않으므로 한 번에 하나의 스레드 만 엔진 API를 호출해야합니다.

이제 Wait API에 대해 이야기하면 다음과 같은 점이 나타납니다.

사용자가 특정 함수가 완료되기를 기다리려면 클로저에 콜백 함수를 포함해야합니다. 포함되면 함수 끝에서 함수를 호출합니다.

반면 사용자가 특정 변수를 포함하는 모든 기능이 완료 될 때까지 기다리려면 다음을 사용해야합니다. WaitForVar(var) API.

누군가 푸시 된 모든 기능이 완료 될 때까지 기다리려면 WaitForAll () API.

함수의 종속성을 지정하는 데 사용되며 토큰과 같습니다.

연산자

Apache MXNet의 연산자는 실제 계산 논리와 보조 정보를 포함하고 시스템이 최적화를 수행하는 데 도움이되는 클래스입니다.

운영자 인터페이스

Forward 구문이 다음과 같은 핵심 운영자 인터페이스입니다.

virtual void Forward(const OpContext &ctx,

const std::vector<TBlob> &in_data,

const std::vector<OpReqType> &req,

const std::vector<TBlob> &out_data,

const std::vector<TBlob> &aux_states) = 0;구조 OpContext, 정의 Forward() 다음과 같다:

struct OpContext {

int is_train;

RunContext run_ctx;

std::vector<Resource> requested;

}그만큼 OpContext운영자의 상태 (열차 또는 테스트 단계), 운영자가 실행되어야하는 장치 및 요청 된 리소스를 설명합니다. 실행 엔진의 두 가지 더 유용한 API.

위에서 Forward 핵심 인터페이스, 우리는 다음과 같이 요청 된 리소스를 이해할 수 있습니다-

in_data 과 out_data 입력 및 출력 텐서를 나타냅니다.

req 계산 결과가 out_data.

그만큼 OpReqType 다음과 같이 정의 할 수 있습니다-

enum OpReqType {

kNullOp,

kWriteTo,

kWriteInplace,

kAddTo

};처럼 Forward 연산자를 선택적으로 구현할 수 있습니다. Backward 다음과 같이 인터페이스-

virtual void Backward(const OpContext &ctx,

const std::vector<TBlob> &out_grad,

const std::vector<TBlob> &in_data,

const std::vector<TBlob> &out_data,

const std::vector<OpReqType> &req,

const std::vector<TBlob> &in_grad,

const std::vector<TBlob> &aux_states);다양한 작업

Operator 인터페이스를 통해 사용자는 다음 작업을 수행 할 수 있습니다.

사용자는 내부 업데이트를 지정할 수 있으며 메모리 할당 비용을 줄일 수 있습니다.

더 깔끔하게 만들기 위해 사용자는 Python에서 내부 인수를 숨길 수 있습니다.

사용자는 텐서와 출력 텐서 간의 관계를 정의 할 수 있습니다.

계산을 수행하기 위해 사용자는 시스템에서 추가 임시 공간을 확보 할 수 있습니다.

연산자 속성

컨볼 루션 신경망 (CNN)에서 하나의 컨볼 루션에는 여러 가지 구현이 있다는 것을 알고 있습니다. 그들로부터 최고의 성능을 얻기 위해 우리는 이러한 여러 컨볼 루션 사이를 전환 할 수 있습니다.

이것이 Apache MXNet이 구현 인터페이스에서 연산자 시맨틱 인터페이스를 분리하는 이유입니다. 이 분리는 다음과 같은 형태로 이루어집니다.OperatorProperty 다음으로 구성된 클래스

InferShape − InferShape 인터페이스는 다음과 같이 두 가지 용도로 사용됩니다.

첫 번째 목적은 시스템에 각 입력 및 출력 텐서의 크기를 알려 주어 공간이 이전에 할당 될 수 있도록하는 것입니다. Forward 과 Backward 요구.

두 번째 목적은 실행하기 전에 오류가 없는지 확인하기 위해 크기 검사를 수행하는 것입니다.

구문은 다음과 같습니다.

virtual bool InferShape(mxnet::ShapeVector *in_shape,

mxnet::ShapeVector *out_shape,

mxnet::ShapeVector *aux_shape) const = 0;Request Resource− 시스템이 cudnnConvolutionForward와 같은 작업을 위해 계산 작업 공간을 관리 할 수 있다면 어떨까요? 시스템은 공간 재사용 등의 최적화를 수행 할 수 있습니다. 여기에서 MXNet은 다음 두 인터페이스의 도움으로이를 쉽게 달성 할 수 있습니다.

virtual std::vector<ResourceRequest> ForwardResource(

const mxnet::ShapeVector &in_shape) const;

virtual std::vector<ResourceRequest> BackwardResource(

const mxnet::ShapeVector &in_shape) const;그러나 만약 ForwardResource 과 BackwardResource비어 있지 않은 배열을 반환합니까? 이 경우 시스템은 다음을 통해 해당 리소스를 제공합니다.ctx 매개 변수 Forward 과 Backward 인터페이스 Operator.

Backward dependency − Apache MXNet은 역 의존성을 처리하기 위해 다음과 같은 두 가지 연산자 서명을 가지고 있습니다.

void FullyConnectedForward(TBlob weight, TBlob in_data, TBlob out_data);

void FullyConnectedBackward(TBlob weight, TBlob in_data, TBlob out_grad, TBlob in_grad);

void PoolingForward(TBlob in_data, TBlob out_data);

void PoolingBackward(TBlob in_data, TBlob out_data, TBlob out_grad, TBlob in_grad);여기서 주목해야 할 두 가지 중요한 사항은-

FullyConnectedForward의 out_data는 FullyConnectedBackward에서 사용되지 않습니다.

PoolingBackward에는 PoolingForward의 모든 인수가 필요합니다.

그래서 FullyConnectedForward, out_data일단 소비 된 텐서는 역방향 함수가 필요하지 않기 때문에 안전하게 해제 될 수 있습니다. 이 시스템의 도움으로 가능한 한 빨리 쓰레기로 일부 텐서를 수집했습니다.

In place Option− Apache MXNet은 메모리 할당 비용을 절약하기 위해 사용자에게 또 다른 인터페이스를 제공합니다. 인터페이스는 입력 및 출력 텐서의 모양이 동일한 요소 별 연산에 적합합니다.

다음은 내부 업데이트를 지정하는 구문입니다.

연산자 생성 예

OperatorProperty의 도움으로 연산자를 만들 수 있습니다. 그렇게하려면 아래 단계를 따르십시오.

virtual std::vector<std::pair<int, void*>> ElewiseOpProperty::ForwardInplaceOption(

const std::vector<int> &in_data,

const std::vector<void*> &out_data)

const {

return { {in_data[0], out_data[0]} };

}

virtual std::vector<std::pair<int, void*>> ElewiseOpProperty::BackwardInplaceOption(

const std::vector<int> &out_grad,

const std::vector<int> &in_data,

const std::vector<int> &out_data,

const std::vector<void*> &in_grad)

const {

return { {out_grad[0], in_grad[0]} }

}1 단계

Create Operator

먼저 OperatorProperty에서 다음 인터페이스를 구현합니다.

virtual Operator* CreateOperator(Context ctx) const = 0;예는 다음과 같습니다.

class ConvolutionOp {

public:

void Forward( ... ) { ... }

void Backward( ... ) { ... }

};

class ConvolutionOpProperty : public OperatorProperty {

public:

Operator* CreateOperator(Context ctx) const {

return new ConvolutionOp;

}

};2 단계

Parameterize Operator

컨볼 루션 연산자를 구현하려면 커널 크기, 보폭 크기, 패딩 크기 등을 알아야합니다. 이유는 이러한 매개 변수를 호출하기 전에 연산자에게 전달해야하기 때문입니다.Forward 또는 backward 상호 작용.

이를 위해 우리는 ConvolutionParam 아래 구조-

#include <dmlc/parameter.h>

struct ConvolutionParam : public dmlc::Parameter<ConvolutionParam> {

mxnet::TShape kernel, stride, pad;

uint32_t num_filter, num_group, workspace;

bool no_bias;

};이제 이것을 넣어야합니다 ConvolutionOpProperty 다음과 같이 연산자에게 전달합니다.

class ConvolutionOp {

public:

ConvolutionOp(ConvolutionParam p): param_(p) {}

void Forward( ... ) { ... }

void Backward( ... ) { ... }

private:

ConvolutionParam param_;

};

class ConvolutionOpProperty : public OperatorProperty {

public:

void Init(const vector<pair<string, string>& kwargs) {

// initialize param_ using kwargs

}

Operator* CreateOperator(Context ctx) const {

return new ConvolutionOp(param_);

}

private:

ConvolutionParam param_;

};3 단계

Register the Operator Property Class and the Parameter Class to Apache MXNet

마지막으로 Operator Property Class와 Parameter Class를 MXNet에 등록해야합니다. 다음 매크로의 도움으로 수행 할 수 있습니다.

DMLC_REGISTER_PARAMETER(ConvolutionParam);

MXNET_REGISTER_OP_PROPERTY(Convolution, ConvolutionOpProperty);위의 매크로에서 첫 번째 인수는 이름 문자열이고 두 번째 인수는 속성 클래스 이름입니다.

이 장에서는 Apache MXNet의 통합 운영자 API (응용 프로그래밍 인터페이스)에 대한 정보를 제공합니다.

SimpleOp

SimpleOp는 다양한 호출 프로세스를 통합하는 새로운 통합 운영자 API입니다. 호출되면 연산자의 기본 요소로 돌아갑니다. 통합 연산자는 단항 및 이항 연산을 위해 특별히 설계되었습니다. 대부분의 수학적 연산자가 하나 또는 두 개의 피연산자에 참여하고 더 많은 피연산자가 종속성과 관련된 최적화를 유용하게 만들기 때문입니다.

예제를 통해 SimpleOp 통합 연산자를 이해하게 될 것입니다. 이 예에서는 역할을하는 연산자를 만들 것입니다.smooth l1 loss, l1 및 l2 손실의 혼합입니다. 다음과 같이 손실을 정의하고 작성할 수 있습니다.

loss = outside_weight .* f(inside_weight .* (data - label))

grad = outside_weight .* inside_weight .* f'(inside_weight .* (data - label))여기 위의 예에서

. *는 요소 별 곱셈을 나타냅니다.

f, f’ 우리가 가정하고있는 부드러운 l1 손실 함수입니다. mshadow.

이 특정 손실을 단항 또는 이항 연산자로 구현하는 것은 불가능 해 보이지만 MXNet은 사용자에게 기호 실행에서 자동 차별화를 제공하여 f 및 f '에 대한 손실을 직접 단순화합니다. 그렇기 때문에이 특정 손실을 단항 연산자로 구현할 수 있습니다.

모양 정의

우리가 알고 있듯이 MXNet의 mshadow library명시적인 메모리 할당이 필요하므로 계산이 발생하기 전에 모든 데이터 형태를 제공해야합니다. 함수와 그라디언트를 정의하기 전에 다음과 같이 입력 모양 일관성과 출력 모양을 제공해야합니다.

typedef mxnet::TShape (*UnaryShapeFunction)(const mxnet::TShape& src,

const EnvArguments& env);

typedef mxnet::TShape (*BinaryShapeFunction)(const mxnet::TShape& lhs,

const mxnet::TShape& rhs,

const EnvArguments& env);mxnet :: Tshape 함수는 입력 데이터 모양과 지정된 출력 데이터 모양을 확인하는 데 사용됩니다. 이 함수를 정의하지 않으면 기본 출력 모양이 입력 모양과 동일합니다. 예를 들어 이항 연산자의 경우 lhs 및 rhs의 모양은 기본적으로 동일하게 확인됩니다.

이제 우리의 smooth l1 loss example. 이를 위해 헤더 구현에서 XPU를 cpu 또는 gpu로 정의해야합니다. smooth_l1_unary-inl.h. 그 이유는 동일한 코드를 smooth_l1_unary.cc 과 smooth_l1_unary.cu.

#include <mxnet/operator_util.h>

#if defined(__CUDACC__)

#define XPU gpu

#else

#define XPU cpu

#endif우리와 마찬가지로 smooth l1 loss example,출력은 소스와 모양이 같으므로 기본 동작을 사용할 수 있습니다. 다음과 같이 쓸 수 있습니다-

inline mxnet::TShape SmoothL1Shape_(const mxnet::TShape& src,const EnvArguments& env) {

return mxnet::TShape(src);

}함수 정의

다음과 같이 하나의 입력으로 단항 또는 이진 함수를 만들 수 있습니다.

typedef void (*UnaryFunction)(const TBlob& src,

const EnvArguments& env,

TBlob* ret,

OpReqType req,

RunContext ctx);

typedef void (*BinaryFunction)(const TBlob& lhs,

const TBlob& rhs,

const EnvArguments& env,

TBlob* ret,

OpReqType req,

RunContext ctx);다음은 RunContext ctx struct 실행을 위해 런타임 동안 필요한 정보를 포함합니다-

struct RunContext {

void *stream; // the stream of the device, can be NULL or Stream<gpu>* in GPU mode

template<typename xpu> inline mshadow::Stream<xpu>* get_stream() // get mshadow stream from Context

} // namespace mxnet이제 계산 결과를 작성하는 방법을 살펴 보겠습니다. ret.

enum OpReqType {

kNullOp, // no operation, do not write anything

kWriteTo, // write gradient to provided space

kWriteInplace, // perform an in-place write

kAddTo // add to the provided space

};이제 우리의 smooth l1 loss example. 이를 위해 UnaryFunction을 사용하여이 연산자의 기능을 다음과 같이 정의합니다.

template<typename xpu>

void SmoothL1Forward_(const TBlob& src,

const EnvArguments& env,

TBlob *ret,

OpReqType req,

RunContext ctx) {

using namespace mshadow;

using namespace mshadow::expr;

mshadow::Stream<xpu> *s = ctx.get_stream<xpu>();

real_t sigma2 = env.scalar * env.scalar;

MSHADOW_TYPE_SWITCH(ret->type_flag_, DType, {

mshadow::Tensor<xpu, 2, DType> out = ret->get<xpu, 2, DType>(s);

mshadow::Tensor<xpu, 2, DType> in = src.get<xpu, 2, DType>(s);

ASSIGN_DISPATCH(out, req,

F<mshadow_op::smooth_l1_loss>(in, ScalarExp<DType>(sigma2)));

});

}그라디언트 정의

외 Input, TBlob, 과 OpReqType이항 연산자의 그라디언트 함수는 비슷한 구조를 가지고 있습니다. 아래에서 다양한 유형의 입력을 사용하여 그래디언트 함수를 만들었습니다.

// depending only on out_grad

typedef void (*UnaryGradFunctionT0)(const OutputGrad& out_grad,

const EnvArguments& env,

TBlob* in_grad,

OpReqType req,

RunContext ctx);

// depending only on out_value

typedef void (*UnaryGradFunctionT1)(const OutputGrad& out_grad,

const OutputValue& out_value,

const EnvArguments& env,

TBlob* in_grad,

OpReqType req,

RunContext ctx);

// depending only on in_data

typedef void (*UnaryGradFunctionT2)(const OutputGrad& out_grad,

const Input0& in_data0,

const EnvArguments& env,

TBlob* in_grad,

OpReqType req,

RunContext ctx);위에 정의 된대로 Input0, Input, OutputValue, 과 OutputGrad 모두의 구조를 공유 GradientFunctionArgument. 다음과 같이 정의됩니다-

struct GradFunctionArgument {

TBlob data;

}이제 우리의 smooth l1 loss example. 이를 위해 그라디언트의 체인 규칙을 활성화하려면out_grad 상단에서 결과까지 in_grad.

template<typename xpu>

void SmoothL1BackwardUseIn_(const OutputGrad& out_grad, const Input0& in_data0,

const EnvArguments& env,

TBlob *in_grad,

OpReqType req,

RunContext ctx) {

using namespace mshadow;

using namespace mshadow::expr;

mshadow::Stream<xpu> *s = ctx.get_stream<xpu>();

real_t sigma2 = env.scalar * env.scalar;

MSHADOW_TYPE_SWITCH(in_grad->type_flag_, DType, {

mshadow::Tensor<xpu, 2, DType> src = in_data0.data.get<xpu, 2, DType>(s);

mshadow::Tensor<xpu, 2, DType> ograd = out_grad.data.get<xpu, 2, DType>(s);

mshadow::Tensor<xpu, 2, DType> igrad = in_grad->get<xpu, 2, DType>(s);

ASSIGN_DISPATCH(igrad, req,

ograd * F<mshadow_op::smooth_l1_gradient>(src, ScalarExp<DType>(sigma2)));

});

}MXNet에 SimpleOp 등록

모양, 기능 및 그라디언트를 만든 후에는 NDArray 연산자와 기호 연산자로 복원해야합니다. 이를 위해 다음과 같이 등록 매크로를 사용할 수 있습니다.

MXNET_REGISTER_SIMPLE_OP(Name, DEV)

.set_shape_function(Shape)

.set_function(DEV::kDevMask, Function<XPU>, SimpleOpInplaceOption)

.set_gradient(DEV::kDevMask, Gradient<XPU>, SimpleOpInplaceOption)

.describe("description");그만큼 SimpleOpInplaceOption 다음과 같이 정의 할 수 있습니다-

enum SimpleOpInplaceOption {

kNoInplace, // do not allow inplace in arguments

kInplaceInOut, // allow inplace in with out (unary)

kInplaceOutIn, // allow inplace out_grad with in_grad (unary)

kInplaceLhsOut, // allow inplace left operand with out (binary)

kInplaceOutLhs // allow inplace out_grad with lhs_grad (binary)

};이제 우리의 smooth l1 loss example. 이를 위해 입력 데이터에 의존하는 그래디언트 함수가 있으므로 함수를 제자리에 작성할 수 없습니다.

MXNET_REGISTER_SIMPLE_OP(smooth_l1, XPU)

.set_function(XPU::kDevMask, SmoothL1Forward_<XPU>, kNoInplace)

.set_gradient(XPU::kDevMask, SmoothL1BackwardUseIn_<XPU>, kInplaceOutIn)

.set_enable_scalar(true)

.describe("Calculate Smooth L1 Loss(lhs, scalar)");EnvArguments에 대한 SimpleOp

우리가 알고 있듯이 일부 작업에는 다음이 필요할 수 있습니다.

그래디언트 스케일과 같은 입력으로서의 스칼라

동작을 제어하는 키워드 인수 세트

계산 속도를 높이기위한 임시 공간입니다.

EnvArguments 사용의 이점은 계산을보다 확장 가능하고 효율적으로 만들기 위해 추가 인수와 리소스를 제공한다는 것입니다.

예

먼저 아래와 같이 구조체를 정의 해 보겠습니다.

struct EnvArguments {

real_t scalar; // scalar argument, if enabled

std::vector<std::pair<std::string, std::string> > kwargs; // keyword arguments

std::vector<Resource> resource; // pointer to the resources requested

};다음으로 다음과 같은 추가 리소스를 요청해야합니다. mshadow::Random<xpu> 및 임시 메모리 공간 EnvArguments.resource. 다음과 같이 할 수 있습니다-

struct ResourceRequest {

enum Type { // Resource type, indicating what the pointer type is

kRandom, // mshadow::Random<xpu> object

kTempSpace // A dynamic temp space that can be arbitrary size

};

Type type; // type of resources

};이제 등록은 선언 된 리소스 요청을 mxnet::ResourceManager. 그 후 리소스를 std::vector<Resource> resource in EnvAgruments.

다음 코드의 도움으로 리소스에 액세스 할 수 있습니다.

auto tmp_space_res = env.resources[0].get_space(some_shape, some_stream);

auto rand_res = env.resources[0].get_random(some_stream);부드러운 l1 손실 예제에서 보면 손실 함수의 전환점을 표시하기 위해 스칼라 입력이 필요합니다. 그래서 등록 과정에서set_enable_scalar(true), 및 env.scalar 함수 및 그라디언트 선언에서.

Tensor 운영 구축

여기서 왜 우리가 텐서 연산을 만들어야 하는가에 대한 질문이 생깁니다. 그 이유는 다음과 같습니다.

Computation은 mshadow 라이브러리를 사용하며 때때로 쉽게 사용할 수있는 함수가 없습니다.

소프트 맥스 손실 및 기울기와 같은 요소 별 방식으로 작업이 수행되지 않는 경우.

예

여기에서는 위의 부드러운 l1 손실 예제를 사용합니다. 부드러운 l1 손실과 기울기의 스칼라 케이스라는 두 개의 매퍼를 만들 것입니다.

namespace mshadow_op {

struct smooth_l1_loss {

// a is x, b is sigma2

MSHADOW_XINLINE static real_t Map(real_t a, real_t b) {

if (a > 1.0f / b) {

return a - 0.5f / b;

} else if (a < -1.0f / b) {

return -a - 0.5f / b;

} else {

return 0.5f * a * a * b;

}

}

};

}이 장은 Apache MXNet의 분산 교육에 관한 것입니다. MXNet의 계산 모드가 무엇인지 이해하는 것으로 시작하겠습니다.

계산 모드

다국어 ML 라이브러리 인 MXNet은 사용자에게 다음 두 가지 계산 모드를 제공합니다.

명령형 모드

이 계산 모드는 NumPy API와 같은 인터페이스를 노출합니다. 예를 들어 MXNet에서 다음 명령형 코드를 사용하여 CPU와 GPU 모두에서 0의 텐서를 생성합니다.

import mxnet as mx

tensor_cpu = mx.nd.zeros((100,), ctx=mx.cpu())

tensor_gpu= mx.nd.zeros((100,), ctx=mx.gpu(0))위의 코드에서 볼 수 있듯이 MXNet은 CPU 또는 GPU 장치에서 텐서를 보관할 위치를 지정합니다. 위의 예에서는 위치 0에 있습니다. MXNet은 모든 계산이 즉시가 아니라 느리게 발생하기 때문에 장치의 놀라운 활용도를 달성합니다.

심볼릭 모드

명령형 모드는 매우 유용하지만이 모드의 단점 중 하나는 강성입니다. 즉, 모든 계산이 미리 정의 된 데이터 구조와 함께 미리 알려 져야합니다.

반면에 Symbolic 모드는 TensorFlow와 같은 계산 그래프를 노출합니다. MXNet이 고정 / 미리 정의 된 데이터 구조 대신 기호 또는 변수로 작업 할 수 있도록하여 명령형 API의 단점을 제거합니다. 그 후, 기호는 다음과 같이 일련의 연산으로 해석 될 수 있습니다.

import mxnet as mx

x = mx.sym.Variable(“X”)

y = mx.sym.Variable(“Y”)

z = (x+y)

m = z/100병렬 처리의 종류

Apache MXNet은 분산 교육을 지원합니다. 이를 통해 더 빠르고 효과적인 교육을 위해 여러 기계를 활용할 수 있습니다.

다음은 여러 장치, CPU 또는 GPU 장치에 걸쳐 NN 훈련 워크로드를 분산 할 수있는 두 가지 방법입니다.

데이터 병렬성

이러한 종류의 병렬 처리에서 각 장치는 모델의 전체 사본을 저장하고 데이터 세트의 다른 부분과 함께 작동합니다. 또한 장치는 공유 모델을 집합 적으로 업데이트합니다. 단일 시스템 또는 여러 시스템에서 모든 장치를 찾을 수 있습니다.

모델 병렬성

모델이 너무 커서 장치 메모리에 맞지 않을 때 유용한 또 다른 종류의 병렬 처리입니다. 모델 병렬화에서는 모델의 다른 부분을 학습하는 작업이 다른 장치에 할당됩니다. 여기서 주목해야 할 중요한 점은 현재 Apache MXNet이 단일 시스템에서만 모델 병렬 처리를 지원한다는 것입니다.

분산 교육 작업

아래에 주어진 개념은 Apache MXNet의 분산 교육 작업을 이해하는 데 핵심입니다.

프로세스 유형

프로세스는 모델 학습을 수행하기 위해 서로 통신합니다. Apache MXNet에는 다음 세 가지 프로세스가 있습니다.

노동자

작업자 노드의 역할은 훈련 샘플 배치에 대한 훈련을 수행하는 것입니다. 작업자 노드는 모든 배치를 처리하기 전에 서버에서 가중치를 가져옵니다. 작업자 노드는 배치가 처리되면 서버로 그라디언트를 보냅니다.

섬기는 사람

MXNet은 모델의 매개 변수를 저장하고 작업자 노드와 통신하기위한 여러 서버를 가질 수 있습니다.

스케줄러

스케줄러의 역할은 클러스터를 설정하는 것입니다. 여기에는 각 노드가 표시되는 메시지와 노드가 수신하는 포트를 기다리는 것이 포함됩니다. 클러스터를 설정 한 후 스케줄러는 모든 프로세스가 클러스터의 다른 모든 노드에 대해 알 수 있도록합니다. 프로세스가 서로 통신 할 수 있기 때문입니다. 스케줄러는 하나뿐입니다.

KV 스토어

KV 매장은 Key-Value저장. 다중 장치 교육에 사용되는 중요한 구성 요소입니다. 단일 및 여러 시스템의 장치 간 매개 변수 통신은 매개 변수에 대한 KVStore를 사용하여 하나 이상의 서버를 통해 전송되기 때문에 중요합니다. 다음 포인트의 도움으로 KVStore의 작동을 이해합시다-

KVStore의 각 값은 key 그리고 value.

네트워크의 각 매개 변수 배열에는 key 해당 매개 변수 배열의 가중치는 value.

그 후 작업자 노드 push배치 처리 후 그라디언트. 그들 또한pull 새 배치를 처리하기 전에 가중치를 업데이트했습니다.

KVStore 서버의 개념은 분산 학습 중에 만 존재하며 분산 모드는 호출을 통해 활성화됩니다. mxnet.kvstore.create 단어를 포함하는 문자열 인수가있는 함수 dist −

kv = mxnet.kvstore.create(‘dist_sync’)키 배포

모든 서버가 모든 매개 변수 배열 또는 키를 저장할 필요는 없지만 서로 다른 서버에 분산되어 있습니다. 서로 다른 서버에 걸친 이러한 키 분배는 KVStore에 의해 투명하게 처리되며 특정 키를 저장하는 서버의 결정은 무작위로 이루어집니다.

위에서 설명한대로 KVStore는 키를 가져올 때마다 해당 값을 가진 해당 서버로 요청이 전송되도록합니다. 일부 키의 값이 크면 어떻게됩니까? 이 경우 다른 서버에서 공유 할 수 있습니다.

훈련 데이터 분할

사용자로서 우리는 특히 데이터 병렬 모드에서 분산 훈련을 실행할 때 각 머신이 데이터 세트의 다른 부분에서 작업하기를 원합니다. 단일 작업자에 대한 데이터 병렬 학습을 위해 데이터 반복자가 제공하는 샘플 배치를 분할하려면 다음을 사용할 수 있습니다.mxnet.gluon.utils.split_and_load 그런 다음 배치의 각 부분을 추가로 처리 할 장치에로드합니다.

반면에 분산 훈련의 경우 처음에는 데이터 세트를 n모든 작업자가 다른 부분을 갖도록 일단 획득하면 각 작업자는 다음을 사용할 수 있습니다.split_and_load데이터 세트의 해당 부분을 단일 머신의 여러 장치로 다시 나눕니다. 이 모든 것은 데이터 반복기를 통해 발생합니다.mxnet.io.MNISTIterator 과 mxnet.io.ImageRecordIter 이 기능을 지원하는 MXNet의 두 반복자입니다.

가중치 업데이트

가중치를 업데이트하기 위해 KVStore는 다음 두 가지 모드를 지원합니다.

첫 번째 방법은 그라디언트를 집계하고 해당 그라디언트를 사용하여 가중치를 업데이트합니다.

두 번째 방법에서는 서버가 그라디언트 만 집계합니다.

Gluon을 사용하는 경우 위에 언급 된 방법 중에서 선택할 수있는 옵션이 있습니다. update_on_kvstore변하기 쉬운. 그것을 만들어서 이해합시다trainer 다음과 같이 개체-

trainer = gluon.Trainer(net.collect_params(), optimizer='sgd',

optimizer_params={'learning_rate': opt.lr,

'wd': opt.wd,

'momentum': opt.momentum,

'multi_precision': True},

kvstore=kv,

update_on_kvstore=True)분산 교육 모드

KVStore 생성 문자열에 단어 dist가 포함되어 있으면 분산 교육이 활성화되었음을 의미합니다. 다음은 다양한 유형의 KVStore를 사용하여 활성화 할 수있는 분산 교육의 다양한 모드입니다.

dist_sync

이름에서 알 수 있듯이 동기식 분산 교육을 나타냅니다. 여기에서 모든 작업자는 모든 배치 시작시 동일한 동기화 된 모델 매개 변수 집합을 사용합니다.

이 모드의 단점은 각 배치 후에 서버가 모델 매개 변수를 업데이트하기 전에 각 작업자로부터 그라디언트를 수신 할 때까지 기다려야한다는 것입니다. 즉, 작업자가 충돌하면 모든 작업자의 진행이 중단됩니다.

dist_async

이름에서 알 수 있듯이 동기식 분산 교육을 나타냅니다. 여기에서 서버는 한 작업자로부터 그라디언트를 수신하고 즉시 저장소를 업데이트합니다. 서버는 업데이트 된 저장소를 사용하여 추가 가져 오기에 응답합니다.

에 비해 장점 dist_sync mode, 배치 처리를 완료 한 작업자는 서버에서 현재 매개 변수를 가져와 다음 배치를 시작할 수 있습니다. 작업자는 다른 작업자가 이전 배치 처리를 아직 완료하지 않은 경우에도 그렇게 할 수 있습니다. 또한 동기화 비용없이 수렴하는 데 더 많은 epoch가 걸릴 수 있기 때문에 dist_sync 모드보다 빠릅니다.

dist_sync_device

이 모드는 dist_sync방법. 유일한 차이점은 모든 노드에서 여러 GPU가 사용되는 경우dist_sync_device 그래디언트를 집계하고 GPU에서 가중치를 업데이트하는 반면, dist_sync 그래디언트를 집계하고 CPU 메모리의 가중치를 업데이트합니다.

GPU와 CPU 간의 값 비싼 통신을 줄입니다. 그렇기 때문에dist_sync. 단점은 GPU에서 메모리 사용량이 증가한다는 것입니다.

dist_async_device

이 모드는 다음과 동일하게 작동합니다. dist_sync_device 모드이지만 비동기 모드입니다.

이 장에서는 Apache MXNet에서 사용할 수있는 Python 패키지에 대해 알아 봅니다.

중요한 MXNet Python 패키지

MXNet은 우리가 하나씩 논의 할 다음과 같은 중요한 파이썬 패키지를 가지고 있습니다.

Autograd (자동 미분)

NDArray

KVStore

Gluon

Visualization

먼저 Autograd Apache MXNet 용 Python 패키지.

Autograd

Autograd 약자 automatic differentiation손실 측정 항목의 기울기를 각 매개 변수로 역 전파하는 데 사용됩니다. 역전 파와 함께 동적 프로그래밍 접근 방식을 사용하여 기울기를 효율적으로 계산합니다. 역방향 모드 자동 미분이라고도합니다. 이 기술은 많은 매개 변수가 단일 손실 지표에 영향을 미치는 '팬인'상황에서 매우 효율적입니다.

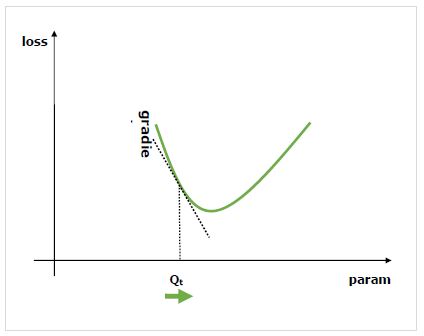

그라디언트 란 무엇입니까?

그라디언트는 신경망 훈련 과정의 기초입니다. 기본적으로 성능을 향상시키기 위해 네트워크의 매개 변수를 변경하는 방법을 알려줍니다.

우리가 알고 있듯이 신경망 (NN)은 합, 곱, 컨볼 루션 등과 같은 연산자로 구성됩니다. 이러한 연산자는 계산을 위해 컨볼 루션 커널의 가중치와 같은 매개 변수를 사용합니다. 이러한 매개 변수에 대한 최적의 값을 찾아야합니다. 그래디언트는 우리에게 방법을 보여주고 솔루션으로이 끕니다.

우리는 네트워크의 성능에 대한 매개 변수 변경의 효과에 관심이 있으며 기울기는 주어진 변수가 의존하는 변수를 변경할 때 얼마나 증가하거나 감소하는지 알려줍니다. 성능은 일반적으로 최소화하려는 손실 메트릭을 사용하여 정의됩니다. 예를 들어 회귀의 경우L2 예측과 정확한 값 사이의 손실, 분류를 위해 우리는 cross-entropy loss.

손실과 관련하여 각 매개 변수의 기울기를 계산하면 확률 적 기울기 하강과 같은 옵티 마이저를 사용할 수 있습니다.

그라디언트를 계산하는 방법?

그라디언트를 계산하는 데 다음과 같은 옵션이 있습니다.

Symbolic Differentiation− 첫 번째 옵션은 각 그라데이션에 대한 공식을 계산하는 Symbolic Differentiation입니다. 이 방법의 단점은 네트워크가 더 깊어지고 운영자가 더 복잡 해짐에 따라 믿을 수 없을 정도로 긴 공식으로 빠르게 이어진다는 것입니다.

Finite Differencing− 또 다른 옵션은 유한 차분을 사용하여 각 매개 변수에 대해 약간의 차이를 시도하고 손실 메트릭이 어떻게 반응하는지 확인하는 것입니다. 이 방법의 단점은 계산 비용이 많이 들고 수치 정밀도가 떨어질 수 있다는 것입니다.

Automatic differentiation− 위 방법의 단점에 대한 해결책은 자동 미분을 사용하여 손실 측정 항목의 기울기를 각 매개 변수로 역 전파하는 것입니다. 전파를 사용하면 동적 프로그래밍 접근 방식을 사용하여 기울기를 효율적으로 계산할 수 있습니다. 이 방법은 역방향 모드 자동 미분이라고도합니다.

자동 미분 (autograd)

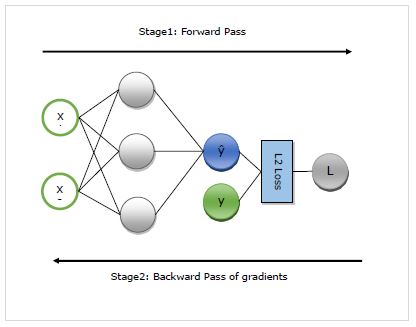

여기서 우리는 autograd의 작동을 자세히 이해할 것입니다. 기본적으로 다음 두 단계로 작동합니다.

Stage 1 −이 단계는 ‘Forward Pass’훈련 이름에서 알 수 있듯이이 단계에서는 네트워크에서 예측을 수행하고 손실 메트릭을 계산하는 데 사용하는 연산자의 레코드를 만듭니다.

Stage 2 −이 단계는 ‘Backward Pass’훈련 이름에서 알 수 있듯이이 단계에서는이 레코드를 통해 거꾸로 작동합니다. 거꾸로, 각 연산자의 편도 함수를 네트워크 매개 변수까지 평가합니다.

autograd의 장점

다음은 자동 미분 (autograd) 사용의 장점입니다.

Flexible− 네트워크를 정의 할 때 제공하는 유연성은 autograd 사용의 큰 이점 중 하나입니다. 반복 할 때마다 작업을 변경할 수 있습니다. 이를 동적 그래프라고하며 정적 그래프가 필요한 프레임 워크에서 구현하기가 훨씬 더 복잡합니다. 이러한 경우에도 Autograd는 그래디언트를 올바르게 역 전파 할 수 있습니다.

Automatic− Autograd는 자동입니다. 즉, 역 전파 절차의 복잡성이 자동으로 처리됩니다. 계산할 그라디언트를 지정하기 만하면됩니다.

Efficient − Autogard는 그라디언트를 매우 효율적으로 계산합니다.

Can use native Python control flow operators− if 조건 및 while 루프와 같은 기본 Python 제어 흐름 연산자를 사용할 수 있습니다. autograd는 그래디언트를 효율적이고 정확하게 역 전파 할 수 있습니다.

MXNet Gluon에서 autograd 사용

여기에서 예제의 도움을 받아 autograd MXNet Gluon에서.

구현 예

다음 예제에서는 두 개의 계층이있는 회귀 모델을 구현합니다. 구현 후 autograd를 사용하여 각 가중치 매개 변수를 참조하여 손실의 기울기를 자동으로 계산합니다.

먼저 다음과 같이 autogrard 및 기타 필수 패키지를 가져옵니다.

from mxnet import autograd

import mxnet as mx

from mxnet.gluon.nn import HybridSequential, Dense

from mxnet.gluon.loss import L2Loss이제 네트워크를 다음과 같이 정의해야합니다.

N_net = HybridSequential()

N_net.add(Dense(units=3))

N_net.add(Dense(units=1))

N_net.initialize()이제 다음과 같이 손실을 정의해야합니다.

loss_function = L2Loss()다음으로, 다음과 같이 더미 데이터를 생성해야합니다.

x = mx.nd.array([[0.5, 0.9]])

y = mx.nd.array([[1.5]])이제 우리는 네트워크를 통한 첫 번째 순방향 패스를 할 준비가되었습니다. 우리는 기울기를 계산할 수 있도록 autograd가 계산 그래프를 기록하기를 원합니다. 이를 위해 우리는 범위 내에서 네트워크 코드를 실행해야합니다.autograd.record 다음과 같이 컨텍스트-

with autograd.record():

y_hat = N_net(x)

loss = loss_function(y_hat, y)이제 관심 수량에 대해 backward 메소드를 호출하여 시작하는 역방향 패스에 대한 준비가되었습니다. 이 예제에서 관심있는 quatity는 손실입니다. 왜냐하면 매개 변수를 참조하여 손실의 기울기를 계산하려고하기 때문입니다.

loss.backward()이제 네트워크의 각 매개 변수에 대한 기울기가 있으며, 이는 최적화 프로그램에서 성능 향상을 위해 매개 변수 값을 업데이트하는 데 사용됩니다. 다음과 같이 첫 번째 레이어의 그라디언트를 확인하십시오.

N_net[0].weight.grad()Output

출력은 다음과 같습니다.

[[-0.00470527 -0.00846948]

[-0.03640365 -0.06552657]

[ 0.00800354 0.01440637]]

<NDArray 3x2 @cpu(0)>완전한 구현 예

아래에 전체 구현 예가 나와 있습니다.

from mxnet import autograd

import mxnet as mx

from mxnet.gluon.nn import HybridSequential, Dense

from mxnet.gluon.loss import L2Loss

N_net = HybridSequential()

N_net.add(Dense(units=3))

N_net.add(Dense(units=1))

N_net.initialize()

loss_function = L2Loss()

x = mx.nd.array([[0.5, 0.9]])

y = mx.nd.array([[1.5]])

with autograd.record():

y_hat = N_net(x)

loss = loss_function(y_hat, y)

loss.backward()

N_net[0].weight.grad()이 장에서는 MXNet의 다차원 배열 형식에 대해 설명합니다. ndarray.

NDArray로 데이터 처리

먼저 NDArray로 데이터를 처리하는 방법을 살펴 보겠습니다. 다음은 동일한 전제 조건입니다-

전제 조건

이 다차원 배열 형식으로 데이터를 처리하는 방법을 이해하려면 다음 전제 조건을 충족해야합니다.

Python 환경에 설치된 MXNet

Python 2.7.x 또는 Python 3.x

구현 예

아래의 예제를 통해 기본 기능을 이해하겠습니다.

먼저 다음과 같이 MXNet에서 MXNet 및 ndarray를 가져와야합니다.

import mxnet as mx

from mxnet import nd필요한 라이브러리를 가져 오면 다음과 같은 기본 기능을 사용할 수 있습니다.

파이썬 목록이있는 간단한 1 차원 배열

Example

x = nd.array([1,2,3,4,5,6,7,8,9,10])

print(x)Output

출력은 다음과 같습니다.

[ 1. 2. 3. 4. 5. 6. 7. 8. 9. 10.]

<NDArray 10 @cpu(0)>파이썬 목록이있는 2 차원 배열

Example

y = nd.array([[1,2,3,4,5,6,7,8,9,10], [1,2,3,4,5,6,7,8,9,10], [1,2,3,4,5,6,7,8,9,10]])

print(y)Output

출력은 다음과 같습니다.

[[ 1. 2. 3. 4. 5. 6. 7. 8. 9. 10.]

[ 1. 2. 3. 4. 5. 6. 7. 8. 9. 10.]

[ 1. 2. 3. 4. 5. 6. 7. 8. 9. 10.]]

<NDArray 3x10 @cpu(0)>초기화없이 NDArray 만들기

여기서는 다음을 사용하여 3 행 4 열의 행렬을 만듭니다. .empty함수. 우리는 또한 사용할 것입니다.full 함수는 배열에 채우려는 값에 대한 추가 연산자를 사용합니다.

Example

x = nd.empty((3, 4))

print(x)

x = nd.full((3,4), 8)

print(x)Output

출력은 다음과 같습니다.

[[0.000e+00 0.000e+00 0.000e+00 0.000e+00]

[0.000e+00 0.000e+00 2.887e-42 0.000e+00]

[0.000e+00 0.000e+00 0.000e+00 0.000e+00]]

<NDArray 3x4 @cpu(0)>

[[8. 8. 8. 8.]

[8. 8. 8. 8.]

[8. 8. 8. 8.]]

<NDArray 3x4 @cpu(0)>.zeros 함수를 사용하는 모든 0으로 구성된 행렬

Example

x = nd.zeros((3, 8))

print(x)Output

출력은 다음과 같습니다.

[[0. 0. 0. 0. 0. 0. 0. 0.]

[0. 0. 0. 0. 0. 0. 0. 0.]

[0. 0. 0. 0. 0. 0. 0. 0.]]

<NDArray 3x8 @cpu(0)>.ones 함수를 사용하는 모든 1의 행렬

Example

x = nd.ones((3, 8))

print(x)Output

출력은 아래에 언급되어 있습니다.

[[1. 1. 1. 1. 1. 1. 1. 1.]

[1. 1. 1. 1. 1. 1. 1. 1.]

[1. 1. 1. 1. 1. 1. 1. 1.]]

<NDArray 3x8 @cpu(0)>값이 무작위로 샘플링되는 배열 만들기

Example

y = nd.random_normal(0, 1, shape=(3, 4))

print(y)Output

출력은 다음과 같습니다.

[[ 1.2673576 -2.0345826 -0.32537818 -1.4583491 ]

[-0.11176403 1.3606371 -0.7889914 -0.17639421]

[-0.2532185 -0.42614475 -0.12548696 1.4022992 ]]

<NDArray 3x4 @cpu(0)>각 NDArray의 차원 찾기

Example

y.shapeOutput

출력은 다음과 같습니다.

(3, 4)각 NDArray의 크기 찾기

Example

y.sizeOutput

12각 NDArray의 데이터 유형 찾기

Example

y.dtypeOutput

numpy.float32NDArray 작업

이 섹션에서는 MXNet의 어레이 작업을 소개합니다. NDArray는 많은 수의 표준 수학 및 내부 연산을 지원합니다.

표준 수학 연산

다음은 NDArray가 지원하는 표준 수학 연산입니다-

요소 별 덧셈

먼저 다음과 같이 MXNet에서 MXNet 및 ndarray를 가져와야합니다.

import mxnet as mx

from mxnet import nd

x = nd.ones((3, 5))

y = nd.random_normal(0, 1, shape=(3, 5))

print('x=', x)

print('y=', y)

x = x + y

print('x = x + y, x=', x)Output

출력은 여기에 주어진다-

x=

[[1. 1. 1. 1. 1.]

[1. 1. 1. 1. 1.]

[1. 1. 1. 1. 1.]]

<NDArray 3x5 @cpu(0)>

y=

[[-1.0554522 -1.3118273 -0.14674698 0.641493 -0.73820823]

[ 2.031364 0.5932667 0.10228804 1.179526 -0.5444829 ]

[-0.34249446 1.1086396 1.2756858 -1.8332436 -0.5289873 ]]

<NDArray 3x5 @cpu(0)>

x = x + y, x=

[[-0.05545223 -0.3118273 0.853253 1.6414931 0.26179177]

[ 3.031364 1.5932667 1.102288 2.1795259 0.4555171 ]

[ 0.6575055 2.1086397 2.2756858 -0.8332436 0.4710127 ]]

<NDArray 3x5 @cpu(0)>요소 별 곱셈

Example

x = nd.array([1, 2, 3, 4])

y = nd.array([2, 2, 2, 1])

x * yOutput

다음 출력이 표시됩니다.

[2. 4. 6. 4.]

<NDArray 4 @cpu(0)>지수화

Example

nd.exp(x)Output

코드를 실행하면 다음 출력이 표시됩니다.

[ 2.7182817 7.389056 20.085537 54.59815 ]

<NDArray 4 @cpu(0)>행렬-행렬 곱을 계산하기위한 행렬 전치

Example

nd.dot(x, y.T)Output

다음은 코드의 출력입니다.

[16.]

<NDArray 1 @cpu(0)>현재 위치 작업

위의 예에서 작업을 실행할 때마다 결과를 호스팅하기 위해 새 메모리를 할당했습니다.

예를 들어 A = A + B라고 쓰면 A가 가리키는 데 사용한 행렬을 역 참조하고 대신 새로 할당 된 메모리를 가리 킵니다. 파이썬의 id () 함수를 사용하여 아래에 주어진 예를 들어 이해합시다.

print('y=', y)

print('id(y):', id(y))

y = y + x

print('after y=y+x, y=', y)

print('id(y):', id(y))Output

실행하면 다음과 같은 출력이 표시됩니다.

y=

[2. 2. 2. 1.]

<NDArray 4 @cpu(0)>

id(y): 2438905634376

after y=y+x, y=

[3. 4. 5. 5.]

<NDArray 4 @cpu(0)>

id(y): 2438905685664사실, 다음과 같이 이전에 할당 된 배열에 결과를 할당 할 수도 있습니다.

print('x=', x)

z = nd.zeros_like(x)

print('z is zeros_like x, z=', z)

print('id(z):', id(z))

print('y=', y)

z[:] = x + y

print('z[:] = x + y, z=', z)

print('id(z) is the same as before:', id(z))Output

출력은 다음과 같습니다.

x=

[1. 2. 3. 4.]

<NDArray 4 @cpu(0)>

z is zeros_like x, z=

[0. 0. 0. 0.]

<NDArray 4 @cpu(0)>

id(z): 2438905790760

y=

[3. 4. 5. 5.]

<NDArray 4 @cpu(0)>

z[:] = x + y, z=

[4. 6. 8. 9.]

<NDArray 4 @cpu(0)>

id(z) is the same as before: 2438905790760위의 출력에서 x + y는 결과를 z에 복사하기 전에 결과를 저장할 임시 버퍼를 할당한다는 것을 알 수 있습니다. 이제 메모리를 더 잘 사용하고 임시 버퍼를 피하기 위해 작업을 제자리에서 수행 할 수 있습니다. 이를 위해 모든 연산자가 지원하는 out 키워드 인수를 다음과 같이 지정합니다.

print('x=', x, 'is in id(x):', id(x))

print('y=', y, 'is in id(y):', id(y))

print('z=', z, 'is in id(z):', id(z))

nd.elemwise_add(x, y, out=z)

print('after nd.elemwise_add(x, y, out=z), x=', x, 'is in id(x):', id(x))

print('after nd.elemwise_add(x, y, out=z), y=', y, 'is in id(y):', id(y))

print('after nd.elemwise_add(x, y, out=z), z=', z, 'is in id(z):', id(z))Output

위의 프로그램을 실행하면 다음과 같은 결과를 얻을 수 있습니다.

x=

[1. 2. 3. 4.]

<NDArray 4 @cpu(0)> is in id(x): 2438905791152

y=

[3. 4. 5. 5.]

<NDArray 4 @cpu(0)> is in id(y): 2438905685664

z=

[4. 6. 8. 9.]

<NDArray 4 @cpu(0)> is in id(z): 2438905790760

after nd.elemwise_add(x, y, out=z), x=

[1. 2. 3. 4.]

<NDArray 4 @cpu(0)> is in id(x): 2438905791152

after nd.elemwise_add(x, y, out=z), y=

[3. 4. 5. 5.]

<NDArray 4 @cpu(0)> is in id(y): 2438905685664

after nd.elemwise_add(x, y, out=z), z=

[4. 6. 8. 9.]

<NDArray 4 @cpu(0)> is in id(z): 2438905790760NDArray 컨텍스트

Apache MXNet에서 각 어레이에는 컨텍스트가 있고 하나의 컨텍스트는 CPU가 될 수있는 반면 다른 컨텍스트는 여러 GPU가 될 수 있습니다. 작업을 여러 서버에 배포하면 상황이 최악이 될 수 있습니다. 그렇기 때문에 컨텍스트에 지능적으로 배열을 할당해야합니다. 장치간에 데이터를 전송하는 데 소요되는 시간을 최소화합니다.

예를 들어, 다음과 같이 배열을 초기화하십시오.

from mxnet import nd

z = nd.ones(shape=(3,3), ctx=mx.cpu(0))

print(z)Output

위의 코드를 실행하면 다음 출력이 표시됩니다.

[[1. 1. 1.]

[1. 1. 1.]

[1. 1. 1.]]

<NDArray 3x3 @cpu(0)>다음과 같이 copyto () 메서드를 사용하여 주어진 NDArray를 한 컨텍스트에서 다른 컨텍스트로 복사 할 수 있습니다.

x_gpu = x.copyto(gpu(0))

print(x_gpu)NumPy 어레이 대 NDArray

우리는 모두 NumPy 배열에 익숙하지만 Apache MXNet은 NDArray라는 자체 배열 구현을 제공합니다. 사실, 처음에는 NumPy와 비슷하게 설계되었지만 중요한 차이점이 있습니다.

주요 차이점은 NumPy 및 NDArray에서 계산이 실행되는 방식에 있습니다. MXNet의 모든 NDArray 조작은 비동기식 및 비 차단 방식으로 수행됩니다. 즉, c = a * b와 같은 코드를 작성할 때 함수가Execution Engine, 계산을 시작합니다.

여기서 a와 b는 모두 NDArray입니다. 이를 사용하는 이점은 함수가 즉시 반환되고 이전 계산이 아직 완료되지 않았더라도 사용자 스레드가 계속 실행될 수 있다는 것입니다.

실행 엔진의 작동

실행 엔진의 작동에 대해 이야기하면 계산 그래프를 작성합니다. 계산 그래프는 일부 계산을 재정렬하거나 결합 할 수 있지만 항상 종속성 순서를 따릅니다.

예를 들어, 나중에 프로그래밍 코드에서 'X'를 사용한 다른 조작이있는 경우 'X'의 결과를 사용할 수있게되면 Execution Engine이이를 수행하기 시작합니다. 실행 엔진은 후속 코드 실행을 시작하기위한 콜백 작성과 같이 사용자를위한 몇 가지 중요한 작업을 처리합니다.

Apache MXNet에서 NDArray의 도움으로 계산 결과를 얻으려면 결과 변수에만 액세스하면됩니다. 계산 결과가 결과 변수에 할당 될 때까지 코드 흐름이 차단됩니다. 이러한 방식으로 명령형 프로그래밍 모드를 계속 지원하면서 코드 성능을 향상시킵니다.

NDArray를 NumPy 배열로 변환

MXNet에서 NDArray를 NumPy Array로 변환하는 방법을 알아 보겠습니다.

Combining higher-level operator with the help of few lower-level operators

때로는 기존 연산자를 사용하여 상위 수준의 연산자를 조합 할 수 있습니다. 이것의 가장 좋은 예 중 하나는np.full_like()NDArray API에는 없습니다. 다음과 같이 기존 연산자 조합으로 쉽게 대체 할 수 있습니다.

from mxnet import nd

import numpy as np

np_x = np.full_like(a=np.arange(7, dtype=int), fill_value=15)

nd_x = nd.ones(shape=(7,)) * 15

np.array_equal(np_x, nd_x.asnumpy())Output

다음과 유사한 출력을 얻을 수 있습니다.

TrueFinding similar operator with different name and/or signature

모든 연산자 중 일부는 이름이 약간 다르지만 기능면에서 비슷합니다. 이것의 예는nd.ravel_index() 와 np.ravel()기능. 같은 방식으로 일부 연산자는 이름이 비슷할 수 있지만 서명이 다릅니다. 이것의 예는np.split() 과 nd.split() 비슷합니다.

다음 프로그래밍 예제를 통해 이해해 보겠습니다.

def pad_array123(data, max_length):

data_expanded = data.reshape(1, 1, 1, data.shape[0])

data_padded = nd.pad(data_expanded,

mode='constant',

pad_width=[0, 0, 0, 0, 0, 0, 0, max_length - data.shape[0]],

constant_value=0)

data_reshaped_back = data_padded.reshape(max_length)

return data_reshaped_back

pad_array123(nd.array([1, 2, 3]), max_length=10)Output

출력은 다음과 같습니다.

[1. 2. 3. 0. 0. 0. 0. 0. 0. 0.]

<NDArray 10 @cpu(0)>통화 차단의 영향 최소화

일부 경우에는 다음 중 하나를 사용해야합니다. .asnumpy() 또는 .asscalar()하지만 이렇게하면 결과를 검색 할 수있을 때까지 MXNet이 실행을 강제로 차단합니다. 다음을 호출하여 차단 호출의 영향을 최소화 할 수 있습니다..asnumpy() 또는 .asscalar() 이 값의 계산이 이미 완료되었다고 생각하는 순간의 방법.

구현 예

Example

from __future__ import print_function

import mxnet as mx

from mxnet import gluon, nd, autograd

from mxnet.ndarray import NDArray

from mxnet.gluon import HybridBlock

import numpy as np

class LossBuffer(object):

"""

Simple buffer for storing loss value

"""

def __init__(self):

self._loss = None

def new_loss(self, loss):

ret = self._loss

self._loss = loss

return ret

@property

def loss(self):

return self._loss

net = gluon.nn.Dense(10)

ce = gluon.loss.SoftmaxCELoss()

net.initialize()

data = nd.random.uniform(shape=(1024, 100))

label = nd.array(np.random.randint(0, 10, (1024,)), dtype='int32')