Hadoop-빅 데이터 솔루션

전통적인 접근 방식

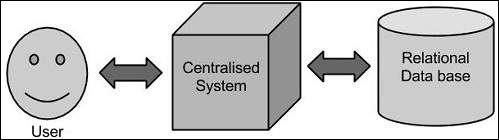

이 접근 방식에서 기업은 빅 데이터를 저장하고 처리 할 컴퓨터를 갖게됩니다. 스토리지 목적을 위해 프로그래머는 Oracle, IBM 등과 같은 데이터베이스 공급 업체를 선택하여 도움을받습니다.이 접근 방식에서 사용자는 애플리케이션과 상호 작용하여 데이터 스토리지 및 분석의 일부를 처리합니다.

한정

이 접근 방식은 표준 데이터베이스 서버에서 수용 할 수있는 적은 양의 데이터를 처리하는 응용 프로그램이나 데이터를 처리하는 프로세서의 한계까지 잘 작동합니다. 그러나 엄청난 양의 확장 가능한 데이터를 처리 할 때 단일 데이터베이스 병목 현상을 통해 이러한 데이터를 처리하는 것은 바쁜 작업입니다.

Google의 솔루션

Google은 MapReduce라는 알고리즘을 사용하여이 문제를 해결했습니다. 이 알고리즘은 작업을 작은 부분으로 나누어 여러 컴퓨터에 할당하고 통합 될 때 결과 데이터 세트를 형성하는 결과를 수집합니다.

하둡

Google에서 제공하는 솔루션을 사용하여 Doug Cutting 그의 팀은 오픈 소스 프로젝트를 개발했습니다. HADOOP.

Hadoop은 데이터가 다른 데이터와 병렬로 처리되는 MapReduce 알고리즘을 사용하여 애플리케이션을 실행합니다. 요컨대, Hadoop은 방대한 양의 데이터에 대해 완전한 통계 분석을 수행 할 수있는 애플리케이션을 개발하는 데 사용됩니다.