Kit de ferramentas de linguagem natural - guia rápido

O que é Processamento de Linguagem Natural (PNL)?

O método de comunicação com a ajuda do qual os humanos podem falar, ler e escrever é a linguagem. Em outras palavras, nós, humanos, podemos pensar, fazer planos, tomar decisões em nossa linguagem natural. Aqui, a grande questão é: na era da inteligência artificial, aprendizado de máquina e aprendizado profundo, os humanos podem se comunicar em linguagem natural com computadores / máquinas? O desenvolvimento de aplicativos de PNL é um grande desafio para nós, porque os computadores exigem dados estruturados, mas, por outro lado, a fala humana não é estruturada e geralmente é ambígua por natureza.

A linguagem natural é o subcampo da ciência da computação, mais especificamente da IA, que permite que computadores / máquinas entendam, processem e manipulem a linguagem humana. Em palavras simples, a PNL é uma forma das máquinas analisar, compreender e derivar significado de línguas naturais humanas como hindi, inglês, francês, holandês, etc.

Como funciona?

Antes de nos aprofundarmos no funcionamento da PNL, devemos entender como os seres humanos usam a linguagem. Todos os dias, nós, humanos, usamos centenas ou milhares de palavras e outros humanos as interpretam e respondem de acordo. É uma comunicação simples para humanos, não é? Mas sabemos que as palavras são muito mais profundas do que isso e sempre derivamos um contexto do que dizemos e como dizemos. É por isso que podemos dizer que, em vez de focar na modulação da voz, a PNL se baseia no padrão contextual.

Vamos entender com um exemplo -

Man is to woman as king is to what?

We can interpret it easily and answer as follows:

Man relates to king, so woman can relate to queen.

Hence the answer is Queen.Como os humanos sabem que palavra significa o quê? A resposta a essa pergunta é que aprendemos com nossa experiência. Mas, como as máquinas / computadores aprendem o mesmo?

Deixe-nos entender seguindo etapas fáceis -

Primeiro, precisamos alimentar as máquinas com dados suficientes para que as máquinas possam aprender com a experiência.

Então, a máquina criará vetores de palavras, usando algoritmos de aprendizado profundo, a partir dos dados que alimentamos anteriormente, bem como de seus dados adjacentes.

Então, ao realizar operações algébricas simples nesses vetores de palavras, a máquina seria capaz de fornecer as respostas como seres humanos.

Componentes da PNL

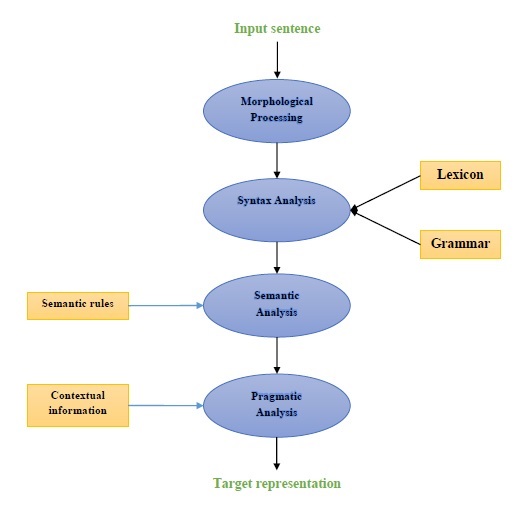

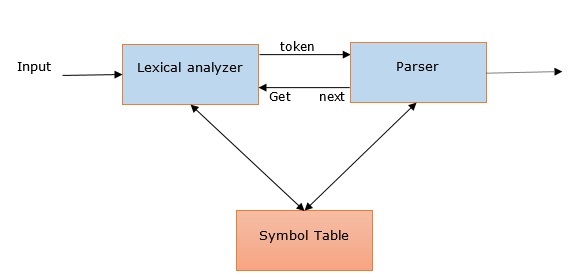

O diagrama a seguir representa os componentes do processamento de linguagem natural (PNL) -

Processamento Morfológico

O processamento morfológico é o primeiro componente da PNL. Inclui a divisão de pedaços de entrada de idioma em conjuntos de tokens correspondentes a parágrafos, frases e palavras. Por exemplo, uma palavra como“everyday” pode ser dividido em dois tokens de subpalavra como “every-day”.

Análise de sintaxe

A análise sintática, o segundo componente, é um dos componentes mais importantes da PNL. Os objetivos deste componente são os seguintes -

Para verificar se uma frase está bem formada ou não.

Para dividi-lo em uma estrutura que mostra as relações sintáticas entre as diferentes palavras.

Por exemplo, as frases como “The school goes to the student” seria rejeitado pelo analisador de sintaxe.

Análise semântica

A Análise Semântica é o terceiro componente da PNL que é usado para verificar a significância do texto. Inclui desenhar o significado exato, ou podemos dizer o significado do dicionário a partir do texto. Por exemplo, frases como “É um sorvete quente”. seria descartado pelo analisador semântico.

Análise pragmática

A análise pragmática é o quarto componente da PNL. Inclui ajustar os objetos reais ou eventos que existem em cada contexto com referências de objeto obtidas por componente anterior, isto é, análise semântica. Por exemplo, as frases como“Put the fruits in the basket on the table” pode ter duas interpretações semânticas, portanto, o analisador pragmático escolherá entre essas duas possibilidades.

Exemplos de aplicativos de PNL

PNL, uma tecnologia emergente, deriva várias formas de IA que costumávamos ver atualmente. Para as aplicações cada vez mais cognitivas de hoje e de amanhã, o uso da PNL na criação de uma interface interativa e contínua entre humanos e máquinas continuará a ser uma prioridade. A seguir estão algumas das aplicações muito úteis da PNL.

Maquina de tradução

A tradução automática (MT) é uma das aplicações mais importantes do processamento de linguagem natural. MT é basicamente um processo de tradução de um idioma ou texto de origem para outro idioma. O sistema de tradução automática pode ser bilíngue ou multilíngue.

Luta contra o spam

Devido ao enorme aumento de e-mails indesejados, os filtros de spam se tornaram importantes porque são a primeira linha de defesa contra esse problema. Considerando seus problemas de falso-positivo e falso-negativo como os principais problemas, a funcionalidade da PNL pode ser usada para desenvolver um sistema de filtragem de spam.

Modelagem de N-gram, Word Stemming e classificação Bayesiana são alguns dos modelos de PNL existentes que podem ser usados para filtragem de spam.

Recuperação de informação e pesquisa na web

A maioria dos mecanismos de pesquisa, como Google, Yahoo, Bing, WolframAlpha, etc., baseiam sua tecnologia de tradução automática (MT) em modelos de aprendizado profundo de PNL. Esses modelos de aprendizagem profunda permitem que os algoritmos leiam o texto na página da Web, interpretem seu significado e o traduzam para outro idioma.

Resumo Automático de Texto

O resumo automático de texto é uma técnica que cria um resumo curto e preciso de documentos de texto mais longos. Portanto, nos ajuda a obter informações relevantes em menos tempo. Nesta era digital, temos uma grande necessidade de sumarização automática de textos porque temos uma enxurrada de informações pela internet que não vai parar. A PNL e suas funcionalidades desempenham um papel importante no desenvolvimento de um resumo automático de texto.

Correção de gramática

A correção ortográfica e gramatical é um recurso muito útil de software de processamento de texto como o Microsoft Word. O processamento de linguagem natural (PNL) é amplamente utilizado para essa finalidade.

Responder perguntas

O atendimento de perguntas, outra aplicação principal do processamento de linguagem natural (PNL), concentra-se na construção de sistemas que respondem automaticamente às perguntas postadas pelo usuário em sua linguagem natural.

Análise de sentimentos

A análise de sentimento está entre uma das outras aplicações importantes do processamento de linguagem natural (PNL). Como o próprio nome indica, a análise de sentimento é usada para -

Identifique os sentimentos entre vários posts e

Identifique o sentimento em que as emoções não são expressas explicitamente.

Empresas de comércio eletrônico online, como Amazon, ebay, etc., estão usando a análise de sentimento para identificar a opinião e o sentimento de seus clientes online. Isso os ajudará a entender o que seus clientes pensam sobre seus produtos e serviços.

Motores de fala

Mecanismos de fala como Siri, Google Voice, Alexa são construídos em PNL para que possamos nos comunicar com eles em nossa linguagem natural.

Implementando PNL

Para construir os aplicativos mencionados acima, precisamos ter um conjunto de habilidades específicas com um grande conhecimento da linguagem e ferramentas para processar a linguagem de forma eficiente. Para isso, temos várias ferramentas de código aberto disponíveis. Alguns deles são de código aberto, enquanto outros são desenvolvidos por organizações para construir seus próprios aplicativos de PNL. A seguir está a lista de algumas ferramentas de PNL -

Kit de ferramentas de linguagem natural (NLTK)

Mallet

GATE

Open NLP

UIMA

Genism

Kit de ferramentas de Stanford

A maioria dessas ferramentas é escrita em Java.

Kit de ferramentas de linguagem natural (NLTK)

Entre as ferramentas de PNL mencionadas acima, o NLTK tem uma pontuação muito alta quando se trata de facilidade de uso e explicação do conceito. A curva de aprendizado do Python é muito rápida e o NLTK é escrito em Python, então o NLTK também tem um kit de aprendizado muito bom. O NLTK incorporou a maioria das tarefas como tokenização, lematização, lematização, pontuação, contagem de caracteres e contagem de palavras. É muito elegante e fácil de trabalhar.

Para instalar o NLTK, devemos ter o Python instalado em nossos computadores. Você pode acessar o link www.python.org/downloads e selecionar a versão mais recente para o seu sistema operacional, ou seja, Windows, Mac e Linux / Unix. Para o tutorial básico sobre Python, você pode consultar o link www.tutorialspoint.com/python3/index.htm .

Agora, depois de instalar o Python em seu sistema de computador, vamos entender como podemos instalar o NLTK.

Instalando NLTK

Podemos instalar o NLTK em vários sistemas operacionais da seguinte maneira -

No Windows

Para instalar o NLTK no sistema operacional Windows, siga as etapas abaixo -

Primeiro, abra o prompt de comando do Windows e navegue até o local do pip pasta.

Em seguida, digite o seguinte comando para instalar o NLTK -

pip3 install nltkAgora, abra o PythonShell no menu Iniciar do Windows e digite o seguinte comando para verificar a instalação do NLTK -

Import nltkSe não obtiver nenhum erro, você instalou com êxito o NLTK em seu sistema operacional Windows com Python3.

No Mac / Linux

Para instalar o NLTK no Mac / Linux OS, escreva o seguinte comando -

sudo pip install -U nltkSe você não tem o pip instalado no seu computador, siga as instruções fornecidas abaixo para instalar primeiro pip -

Primeiro, atualize o índice do pacote seguindo o seguinte comando -

sudo apt updateAgora, digite o seguinte comando para instalar pip para python 3 -

sudo apt install python3-pipAtravés da Anaconda

Para instalar o NLTK através do Anaconda, siga os passos abaixo -

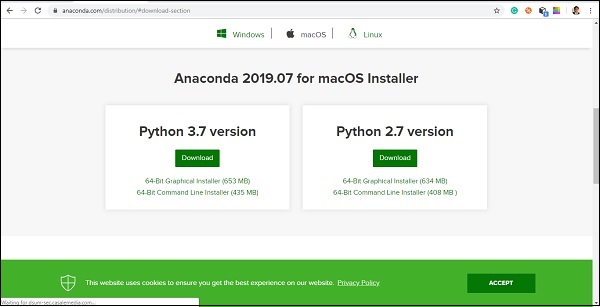

Primeiro, para instalar o Anaconda, vá para o link www.anaconda.com/distribution/#download-section e selecione a versão do Python que você precisa instalar.

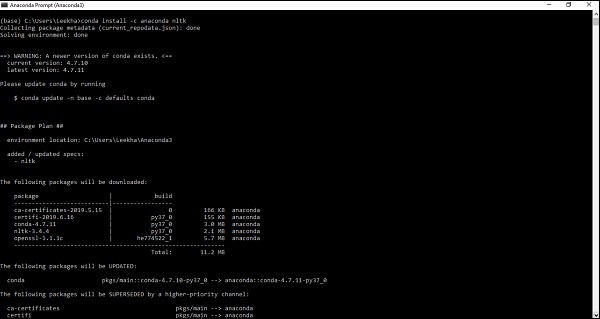

Depois de ter o Anaconda no sistema do seu computador, vá para o prompt de comando e escreva o seguinte comando -

conda install -c anaconda nltk

Você precisa revisar a saída e inserir 'sim'. O NLTK será baixado e instalado em seu pacote Anaconda.

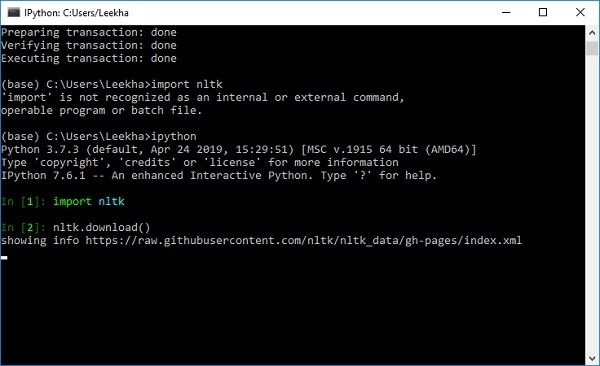

Baixando o conjunto de dados e pacotes da NLTK

Agora temos o NLTK instalado em nossos computadores, mas para usá-lo precisamos baixar os conjuntos de dados (corpus) disponíveis nele. Alguns dos conjuntos de dados importantes disponíveis sãostpwords, guntenberg, framenet_v15 e assim por diante.

Com a ajuda dos comandos a seguir, podemos baixar todos os conjuntos de dados NLTK -

import nltk

nltk.download()

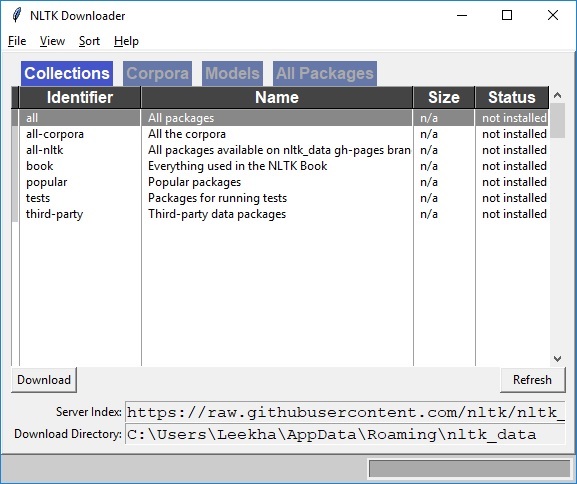

Você obterá a seguinte janela de download do NLTK.

Agora, clique no botão de download para baixar os conjuntos de dados.

Como executar o script NLTK?

A seguir está o exemplo em que estamos implementando o algoritmo Porter Stemmer usando PorterStemmerclasse nltk. com este exemplo, você seria capaz de entender como executar o script NLTK.

Primeiro, precisamos importar o kit de ferramentas de linguagem natural (nltk).

import nltkAgora, importe o PorterStemmer classe para implementar o algoritmo Porter Stemmer.

from nltk.stem import PorterStemmerEm seguida, crie uma instância da classe Porter Stemmer da seguinte maneira -

word_stemmer = PorterStemmer()Agora, insira a palavra que você deseja radicalizar. -

word_stemmer.stem('writing')Resultado

'write'word_stemmer.stem('eating')Resultado

'eat'O que é tokenização?

Pode ser definido como o processo de quebrar um pedaço de texto em partes menores, como frases e palavras. Essas partes menores são chamadas de tokens. Por exemplo, uma palavra é um token em uma frase, e uma frase é um token em um parágrafo.

Como sabemos que a PNL é usada para construir aplicativos como análise de sentimento, sistemas de controle de qualidade, tradução de idiomas, chatbots inteligentes, sistemas de voz, etc., portanto, para construí-los, torna-se vital entender o padrão no texto. Os tokens, mencionados acima, são muito úteis para encontrar e compreender esses padrões. Podemos considerar a tokenização como a etapa base para outras receitas, como lematização e lematização.

Pacote NLTK

nltk.tokenize é o pacote fornecido pelo módulo NLTK para realizar o processo de tokenização.

Tokenização de frases em palavras

Dividir a frase em palavras ou criar uma lista de palavras a partir de uma string é uma parte essencial de toda atividade de processamento de texto. Vamos entendê-lo com a ajuda de várias funções / módulos fornecidos pornltk.tokenize pacote.

módulo word_tokenize

word_tokenizemódulo é usado para tokenização de palavras básicas. O exemplo a seguir usará este módulo para dividir uma frase em palavras.

Exemplo

import nltk

from nltk.tokenize import word_tokenize

word_tokenize('Tutorialspoint.com provides high quality technical tutorials for free.')Resultado

['Tutorialspoint.com', 'provides', 'high', 'quality', 'technical', 'tutorials', 'for', 'free', '.']Classe TreebankWordTokenizer

word_tokenize módulo, usado acima é basicamente uma função de wrapper que chama a função tokenize () como uma instância do TreebankWordTokenizerclasse. Ele dará a mesma saída que obtemos ao usar o módulo word_tokenize () para dividir as sentenças em palavras. Vamos ver o mesmo exemplo implementado acima -

Exemplo

Primeiro, precisamos importar o kit de ferramentas de linguagem natural (nltk).

import nltkAgora, importe o TreebankWordTokenizer classe para implementar o algoritmo de tokenizador de palavras -

from nltk.tokenize import TreebankWordTokenizerEm seguida, crie uma instância da classe TreebankWordTokenizer da seguinte maneira -

Tokenizer_wrd = TreebankWordTokenizer()Agora, insira a frase que deseja converter em tokens -

Tokenizer_wrd.tokenize(

'Tutorialspoint.com provides high quality technical tutorials for free.'

)Resultado

[

'Tutorialspoint.com', 'provides', 'high', 'quality',

'technical', 'tutorials', 'for', 'free', '.'

]Exemplo de implementação completo

Vamos ver o exemplo de implementação completo abaixo

import nltk

from nltk.tokenize import TreebankWordTokenizer

tokenizer_wrd = TreebankWordTokenizer()

tokenizer_wrd.tokenize('Tutorialspoint.com provides high quality technical

tutorials for free.')Resultado

[

'Tutorialspoint.com', 'provides', 'high', 'quality',

'technical', 'tutorials','for', 'free', '.'

]A convenção mais significativa de um tokenizer é separar as contrações. Por exemplo, se usarmos o módulo word_tokenize () para este propósito, ele dará a saída da seguinte forma -

Exemplo

import nltk

from nltk.tokenize import word_tokenize

word_tokenize('won’t')Resultado

['wo', "n't"]]Esse tipo de convenção por TreebankWordTokenizeré inaceitável. É por isso que temos dois tokenizadores de palavras alternativos, a saberPunktWordTokenizer e WordPunctTokenizer.

Classe WordPunktTokenizer

Um tokenizador de palavra alternativo que divide toda a pontuação em tokens separados. Vamos entender isso com o seguinte exemplo simples -

Exemplo

from nltk.tokenize import WordPunctTokenizer

tokenizer = WordPunctTokenizer()

tokenizer.tokenize(" I can't allow you to go home early")Resultado

['I', 'can', "'", 't', 'allow', 'you', 'to', 'go', 'home', 'early']Tokenização de texto em frases

Nesta seção, vamos dividir o texto / parágrafo em sentenças. NLTK fornecesent_tokenize módulo para este fim.

Por que é necessário?

Uma pergunta óbvia que surgiu em nossa mente é que, quando temos um tokenizador de palavras, por que precisamos do tokenizador de frases ou por que precisamos tokenizar o texto em frases. Suponha que precisemos contar palavras médias em sentenças, como podemos fazer isso? Para realizar esta tarefa, precisamos de tokenização de frase e tokenização de palavra.

Vamos entender a diferença entre frase e tokenizador de palavras com a ajuda do seguinte exemplo simples -

Exemplo

import nltk

from nltk.tokenize import sent_tokenize

text = "Let us understand the difference between sentence & word tokenizer.

It is going to be a simple example."

sent_tokenize(text)Resultado

[

"Let us understand the difference between sentence & word tokenizer.",

'It is going to be a simple example.'

]Tokenização de frases usando expressões regulares

Se você acha que a saída do tokenizer de palavras é inaceitável e deseja controle completo sobre como tokenizar o texto, temos uma expressão regular que pode ser usada ao fazer a tokenização de frases. NLTK fornecerRegexpTokenizer classe para conseguir isso.

Vamos entender o conceito com a ajuda de dois exemplos abaixo.

No primeiro exemplo, usaremos uma expressão regular para combinar tokens alfanuméricos mais aspas simples, de modo que não dividamos as contrações como “won’t”.

Exemplo 1

import nltk

from nltk.tokenize import RegexpTokenizer

tokenizer = RegexpTokenizer("[\w']+")

tokenizer.tokenize("won't is a contraction.")

tokenizer.tokenize("can't is a contraction.")Resultado

["won't", 'is', 'a', 'contraction']

["can't", 'is', 'a', 'contraction']No primeiro exemplo, usaremos uma expressão regular para tokenizar em espaços em branco.

Exemplo 2

import nltk

from nltk.tokenize import RegexpTokenizer

tokenizer = RegexpTokenizer('/s+' , gaps = True)

tokenizer.tokenize("won't is a contraction.")Resultado

["won't", 'is', 'a', 'contraction']Na saída acima, podemos ver que a pontuação permanece nos tokens. O parâmetro gaps = True significa que o padrão identificará os gaps para tokenizar. Por outro lado, se usarmos o parâmetro gaps = False, o padrão será usado para identificar os tokens que podem ser vistos no exemplo a seguir -

import nltk

from nltk.tokenize import RegexpTokenizer

tokenizer = RegexpTokenizer('/s+' , gaps = False)

tokenizer.tokenize("won't is a contraction.")Resultado

[ ]Isso nos dará a saída em branco.

Por que treinar o próprio tokenizer de frase?

Esta é uma questão muito importante: se temos o tokenizador de frase padrão do NLTK, por que precisamos treinar um tokenizador de frase? A resposta a esta pergunta está na qualidade do tokenizer de frase padrão do NLTK. O tokenizer padrão do NLTK é basicamente um tokenizer de uso geral. Embora funcione muito bem, pode não ser uma boa escolha para texto fora do padrão, que talvez seja o nosso texto, ou para um texto que esteja tendo uma formatação única. Para tokenizar esse texto e obter melhores resultados, devemos treinar nosso próprio tokenizer de frase.

Exemplo de Implementação

Para este exemplo, usaremos o corpus do webtext. O arquivo de texto que vamos usar a partir deste corpus está tendo o texto formatado como as caixas de diálogo mostradas abaixo -

Guy: How old are you?

Hipster girl: You know, I never answer that question. Because to me, it's about

how mature you are, you know? I mean, a fourteen year old could be more mature

than a twenty-five year old, right? I'm sorry, I just never answer that question.

Guy: But, uh, you're older than eighteen, right?

Hipster girl: Oh, yeah.Salvamos este arquivo de texto com o nome de training_tokenizer. NLTK fornece uma classe chamadaPunktSentenceTokenizercom a ajuda do qual podemos treinar em texto bruto para produzir um tokenizer de frase personalizado. Podemos obter texto bruto lendo um arquivo ou de um corpus NLTK usando oraw() método.

Vejamos o exemplo abaixo para obter mais informações sobre ele -

Primeiro, importe PunktSentenceTokenizer classe de nltk.tokenize pacote -

from nltk.tokenize import PunktSentenceTokenizerAgora importe webtext corpus de nltk.corpus pacote

from nltk.corpus import webtextEm seguida, usando raw() método, obter o texto bruto de training_tokenizer.txt arquivo da seguinte forma -

text = webtext.raw('C://Users/Leekha/training_tokenizer.txt')Agora, crie uma instância de PunktSentenceTokenizer e imprimir as frases tokenizadas do arquivo de texto da seguinte forma -

sent_tokenizer = PunktSentenceTokenizer(text)

sents_1 = sent_tokenizer.tokenize(text)

print(sents_1[0])Resultado

White guy: So, do you have any plans for this evening?

print(sents_1[1])

Output:

Asian girl: Yeah, being angry!

print(sents_1[670])

Output:

Guy: A hundred bucks?

print(sents_1[675])

Output:

Girl: But you already have a Big Mac...Exemplo de implementação completo

from nltk.tokenize import PunktSentenceTokenizer

from nltk.corpus import webtext

text = webtext.raw('C://Users/Leekha/training_tokenizer.txt')

sent_tokenizer = PunktSentenceTokenizer(text)

sents_1 = sent_tokenizer.tokenize(text)

print(sents_1[0])Resultado

White guy: So, do you have any plans for this evening?Para entender a diferença entre o tokenizer de frase padrão do NLTK e nosso próprio tokenizer de frase treinado, vamos tokenizar o mesmo arquivo com o tokenizer de frase padrão, isto é, sent_tokenize ().

from nltk.tokenize import sent_tokenize

from nltk.corpus import webtext

text = webtext.raw('C://Users/Leekha/training_tokenizer.txt')

sents_2 = sent_tokenize(text)

print(sents_2[0])

Output:

White guy: So, do you have any plans for this evening?

print(sents_2[675])

Output:

Hobo: Y'know what I'd do if I was rich?Com a ajuda da diferença na saída, podemos entender o conceito por que é útil treinar nosso próprio tokenizer de frase.

O que são palavras irrelevantes?

Algumas palavras comuns que estão presentes no texto, mas não contribuem para o significado de uma frase. Essas palavras não são importantes para o propósito de recuperação de informações ou processamento de linguagem natural. As palavras irrelevantes mais comuns são 'o' e 'a'.

Corpus de palavras irrelevantes NLTK

Na verdade, o kit de ferramentas Natural Language vem com um corpus de palavras irrelevantes contendo listas de palavras para vários idiomas. Vamos entender seu uso com a ajuda do seguinte exemplo -

Primeiro, importe as palavras de interrupção Copus de nltk.corpus pacote -

from nltk.corpus import stopwordsAgora, usaremos palavras irrelevantes de idiomas ingleses

english_stops = set(stopwords.words('english'))

words = ['I', 'am', 'a', 'writer']

[word for word in words if word not in english_stops]Resultado

['I', 'writer']Exemplo de implementação completo

from nltk.corpus import stopwords

english_stops = set(stopwords.words('english'))

words = ['I', 'am', 'a', 'writer']

[word for word in words if word not in english_stops]Resultado

['I', 'writer']Encontrando a lista completa de idiomas suportados

Com a ajuda do seguinte script Python, também podemos encontrar a lista completa de linguagens suportadas pelo corpus de palavras irrelevantes NLTK -

from nltk.corpus import stopwords

stopwords.fileids()Resultado

[

'arabic', 'azerbaijani', 'danish', 'dutch', 'english', 'finnish', 'french',

'german', 'greek', 'hungarian', 'indonesian', 'italian', 'kazakh', 'nepali',

'norwegian', 'portuguese', 'romanian', 'russian', 'slovene', 'spanish',

'swedish', 'tajik', 'turkish'

]O que é Wordnet?

Wordnet é um grande banco de dados lexical em inglês, criado por Princeton. Faz parte do corpus NLTK. Substantivos, verbos, adjetivos e advérbios, todos são agrupados em conjuntos de synsets, ou seja, sinônimos cognitivos. Aqui, cada conjunto de synsets expressa um significado distinto. A seguir estão alguns casos de uso do Wordnet -

- Pode ser usado para pesquisar a definição de uma palavra

- Podemos encontrar sinônimos e antônimos de uma palavra

- Relações de palavras e semelhanças podem ser exploradas usando Wordnet

- Desambiguação de sentido de palavra para aquelas palavras com múltiplos usos e definições

Como importar Wordnet?

Wordnet pode ser importado com a ajuda do seguinte comando -

from nltk.corpus import wordnetPara um comando mais compacto, use o seguinte -

from nltk.corpus import wordnet as wnInstâncias Synset

Synset são agrupamentos de palavras sinônimos que expressam o mesmo conceito. Ao usar o Wordnet para pesquisar palavras, você obterá uma lista de ocorrências de Synset.

wordnet.synsets (word)

Para obter uma lista de Synsets, podemos procurar qualquer palavra no Wordnet usando wordnet.synsets(word). Por exemplo, na próxima receita do Python, vamos procurar o Synset para o 'cachorro' junto com algumas propriedades e métodos de Synset -

Exemplo

Primeiro, importe o wordnet da seguinte forma -

from nltk.corpus import wordnet as wnAgora, forneça a palavra que deseja procurar no Synset -

syn = wn.synsets('dog')[0]Aqui, estamos usando o método name () para obter o nome exclusivo do synset, que pode ser usado para obter o Synset diretamente -

syn.name()

Output:

'dog.n.01'Em seguida, estamos usando o método definition () que nos dará a definição da palavra -

syn.definition()

Output:

'a member of the genus Canis (probably descended from the common wolf) that has

been domesticated by man since prehistoric times; occurs in many breeds'Outro método é o examples () que nos dará os exemplos relacionados à palavra -

syn.examples()

Output:

['the dog barked all night']Exemplo de implementação completo

from nltk.corpus import wordnet as wn

syn = wn.synsets('dog')[0]

syn.name()

syn.definition()

syn.examples()Obtendo Hypernyms

Synsets são organizados em uma estrutura semelhante a uma árvore de herança na qual Hypernyms representa termos mais abstratos enquanto Hyponymsrepresenta os termos mais específicos. Uma das coisas importantes é que essa árvore pode ser rastreada até um hiperônimo raiz. Vamos entender o conceito com a ajuda do seguinte exemplo -

from nltk.corpus import wordnet as wn

syn = wn.synsets('dog')[0]

syn.hypernyms()Resultado

[Synset('canine.n.02'), Synset('domestic_animal.n.01')]Aqui, podemos ver que canino e domestic_animal são os hiperônimos de 'cão'.

Agora, podemos encontrar hipônimos de 'cachorro' da seguinte forma -

syn.hypernyms()[0].hyponyms()Resultado

[

Synset('bitch.n.04'),

Synset('dog.n.01'),

Synset('fox.n.01'),

Synset('hyena.n.01'),

Synset('jackal.n.01'),

Synset('wild_dog.n.01'),

Synset('wolf.n.01')

]Na saída acima, podemos ver que 'cachorro' é apenas um dos muitos hipônimos de 'animais_ domésticos'.

Para encontrar a raiz de tudo isso, podemos usar o seguinte comando -

syn.root_hypernyms()Resultado

[Synset('entity.n.01')]Pela saída acima, podemos ver que ele tem apenas uma raiz.

Exemplo de implementação completo

from nltk.corpus import wordnet as wn

syn = wn.synsets('dog')[0]

syn.hypernyms()

syn.hypernyms()[0].hyponyms()

syn.root_hypernyms()Resultado

[Synset('entity.n.01')]Lemas em Wordnet

Em linguística, a forma canônica ou morfológica de uma palavra é chamada de lema. Para encontrar um sinônimo, bem como um antônimo de uma palavra, também podemos pesquisar lemas no WordNet. Vamos ver como.

Encontrar sinônimos

Usando o método lemma (), podemos encontrar o número de sinônimos de um Synset. Vamos aplicar este método no synset 'dog' -

Exemplo

from nltk.corpus import wordnet as wn

syn = wn.synsets('dog')[0]

lemmas = syn.lemmas()

len(lemmas)Resultado

3A saída acima mostra que 'cachorro' tem três lemas.

Obtendo o nome do primeiro lema da seguinte maneira -

lemmas[0].name()

Output:

'dog'Obtendo o nome do segundo lema da seguinte maneira -

lemmas[1].name()

Output:

'domestic_dog'Obtendo o nome do terceiro lema da seguinte maneira -

lemmas[2].name()

Output:

'Canis_familiaris'Na verdade, um Synset representa um grupo de lemas que têm significados semelhantes, enquanto um lema representa uma forma de palavra distinta.

Encontrando antônimos

No WordNet, alguns lemas também têm antônimos. Por exemplo, a palavra 'bom' tem um total de 27 sinets, entre eles, 5 possuem lemas com antônimos. Vamos encontrar os antônimos (quando a palavra 'bom' é usada como substantivo e quando a palavra 'bom' é usada como adjetivo).

Exemplo 1

from nltk.corpus import wordnet as wn

syn1 = wn.synset('good.n.02')

antonym1 = syn1.lemmas()[0].antonyms()[0]

antonym1.name()Resultado

'evil'antonym1.synset().definition()Resultado

'the quality of being morally wrong in principle or practice'O exemplo acima mostra que a palavra 'bom', quando usada como substantivo, tem o primeiro antônimo 'mal'.

Exemplo 2

from nltk.corpus import wordnet as wn

syn2 = wn.synset('good.a.01')

antonym2 = syn2.lemmas()[0].antonyms()[0]

antonym2.name()Resultado

'bad'antonym2.synset().definition()Resultado

'having undesirable or negative qualities’O exemplo acima mostra que a palavra 'bom', quando usada como adjetivo, tem o primeiro antônimo 'ruim'.

O que é Stemming?

Stemming é uma técnica usada para extrair a forma básica das palavras removendo afixos delas. É como cortar os galhos de uma árvore até o caule. Por exemplo, a raiz das palavraseating, eats, eaten é eat.

Os mecanismos de pesquisa usam derivação para indexar as palavras. É por isso que, em vez de armazenar todas as formas de uma palavra, um mecanismo de pesquisa pode armazenar apenas as raízes. Dessa forma, a derivação reduz o tamanho do índice e aumenta a precisão da recuperação.

Vários algoritmos de stemming

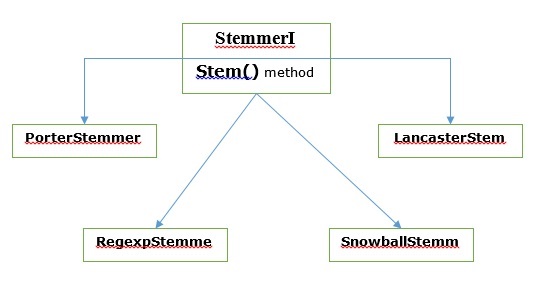

Em NLTK, stemmerI, que tem stem(), interface tem todos os lematizadores que iremos cobrir a seguir. Vamos entendê-lo com o seguinte diagrama

Algoritmo de lematização de Porter

É um dos algoritmos de lematização mais comuns que basicamente é projetado para remover e substituir sufixos conhecidos de palavras em inglês.

Aula PorterStemmer

NLTK tem PorterStemmercom a ajuda da qual podemos facilmente implementar algoritmos de Porter Stemmer para a palavra que queremos derivar. Esta classe conhece várias formas de palavras regulares e sufixos com a ajuda dos quais ela pode transformar a palavra de entrada em um radical final. O radical resultante geralmente é uma palavra mais curta com o mesmo significado de raiz. Vamos ver um exemplo -

Primeiro, precisamos importar o kit de ferramentas de linguagem natural (nltk).

import nltkAgora, importe o PorterStemmer classe para implementar o algoritmo Porter Stemmer.

from nltk.stem import PorterStemmerEm seguida, crie uma instância da classe Porter Stemmer da seguinte maneira -

word_stemmer = PorterStemmer()Agora, insira a palavra que você deseja radicalizar.

word_stemmer.stem('writing')Resultado

'write'word_stemmer.stem('eating')Resultado

'eat'Exemplo de implementação completo

import nltk

from nltk.stem import PorterStemmer

word_stemmer = PorterStemmer()

word_stemmer.stem('writing')Resultado

'write'Lancaster stemming algoritmo

Foi desenvolvido na Lancaster University e é outro algoritmo de derivação muito comum.

Classe LancasterStemmer

NLTK tem LancasterStemmerclasse com a ajuda da qual podemos facilmente implementar algoritmos Lancaster Stemmer para a palavra que queremos derivar. Vamos ver um exemplo -

Primeiro, precisamos importar o kit de ferramentas de linguagem natural (nltk).

import nltkAgora, importe o LancasterStemmer classe para implementar o algoritmo Lancaster Stemmer

from nltk.stem import LancasterStemmerEm seguida, crie uma instância de LancasterStemmer classe como segue -

Lanc_stemmer = LancasterStemmer()Agora, insira a palavra que você deseja radicalizar.

Lanc_stemmer.stem('eats')Resultado

'eat'Exemplo de implementação completo

import nltk

from nltk.stem import LancatserStemmer

Lanc_stemmer = LancasterStemmer()

Lanc_stemmer.stem('eats')Resultado

'eat'Algoritmo de lematização de expressão regular

Com a ajuda deste algoritmo de lematização, podemos construir nosso próprio lematizador.

Classe RegexpStemmer

NLTK tem RegexpStemmerclasse com a ajuda da qual podemos facilmente implementar algoritmos de Stemmer de expressão regular. Basicamente, ele pega uma única expressão regular e remove qualquer prefixo ou sufixo que corresponda à expressão. Vamos ver um exemplo -

Primeiro, precisamos importar o kit de ferramentas de linguagem natural (nltk).

import nltkAgora, importe o RegexpStemmer classe para implementar o algoritmo Regular Expression Stemmer.

from nltk.stem import RegexpStemmerEm seguida, crie uma instância de RegexpStemmer classe e fornece o sufixo ou prefixo que você deseja remover da palavra da seguinte maneira -

Reg_stemmer = RegexpStemmer(‘ing’)Agora, insira a palavra que você deseja radicalizar.

Reg_stemmer.stem('eating')Resultado

'eat'Reg_stemmer.stem('ingeat')Resultado

'eat'

Reg_stemmer.stem('eats')Resultado

'eat'Exemplo de implementação completo

import nltk

from nltk.stem import RegexpStemmer

Reg_stemmer = RegexpStemmer()

Reg_stemmer.stem('ingeat')Resultado

'eat'Algoritmo de stemming bola de neve

É outro algoritmo de lematização muito útil.

Aula SnowballStemmer

NLTK tem SnowballStemmerclasse com a ajuda da qual podemos facilmente implementar algoritmos Snowball Stemmer. Ele suporta 15 idiomas diferentes do inglês. Para usar essa classe fumegante, precisamos criar uma instância com o nome da linguagem que estamos usando e, em seguida, chamar o método stem (). Vamos ver um exemplo -

Primeiro, precisamos importar o kit de ferramentas de linguagem natural (nltk).

import nltkAgora, importe o SnowballStemmer classe para implementar o algoritmo Snowball Stemmer

from nltk.stem import SnowballStemmerVamos ver os idiomas que ele suporta -

SnowballStemmer.languagesResultado

(

'arabic',

'danish',

'dutch',

'english',

'finnish',

'french',

'german',

'hungarian',

'italian',

'norwegian',

'porter',

'portuguese',

'romanian',

'russian',

'spanish',

'swedish'

)Em seguida, crie uma instância da classe SnowballStemmer com o idioma que deseja usar. Aqui, estamos criando o lematizador para o idioma 'francês'.

French_stemmer = SnowballStemmer(‘french’)Agora, chame o método stem () e insira a palavra que você deseja transformar.

French_stemmer.stem (‘Bonjoura’)Resultado

'bonjour'Exemplo de implementação completo

import nltk

from nltk.stem import SnowballStemmer

French_stemmer = SnowballStemmer(‘french’)

French_stemmer.stem (‘Bonjoura’)Resultado

'bonjour'O que é Lemmatização?

A técnica de lematização é como uma derivação. A saída que obteremos após a lematização é chamada de 'lema', que é uma palavra raiz em vez de radical, a saída da lematização. Após a lematização, estaremos obtendo uma palavra válida que significa a mesma coisa.

NLTK fornece WordNetLemmatizer classe que é um invólucro fino em torno do wordnetcorpus. Esta classe usamorphy() função para o WordNet CorpusReaderclasse para encontrar um lema. Vamos entender com um exemplo -

Exemplo

Primeiro, precisamos importar o kit de ferramentas de linguagem natural (nltk).

import nltkAgora, importe o WordNetLemmatizer aula para implementar a técnica de lematização.

from nltk.stem import WordNetLemmatizerEm seguida, crie uma instância de WordNetLemmatizer classe.

lemmatizer = WordNetLemmatizer()Agora, chame o método lemmatize () e insira a palavra da qual deseja encontrar o lema.

lemmatizer.lemmatize('eating')Resultado

'eating'lemmatizer.lemmatize('books')Resultado

'book'Exemplo de implementação completo

import nltk

from nltk.stem import WordNetLemmatizer

lemmatizer = WordNetLemmatizer()

lemmatizer.lemmatize('books')Resultado

'book'Diferença entre Stemming e Lemmatization

Vamos entender a diferença entre Stemming e Lemmatization com a ajuda do seguinte exemplo -

import nltk

from nltk.stem import PorterStemmer

word_stemmer = PorterStemmer()

word_stemmer.stem('believes')Resultado

believimport nltk

from nltk.stem import WordNetLemmatizer

lemmatizer = WordNetLemmatizer()

lemmatizer.lemmatize(' believes ')Resultado

believA saída de ambos os programas indica a principal diferença entre lematização e lematização. PorterStemmera classe corta os 'es' da palavra. Por outro lado,WordNetLemmatizerclasse encontra uma palavra válida. Em palavras simples, a técnica de lematização analisa apenas a forma da palavra, enquanto a técnica de lematização analisa o significado da palavra. Isso significa que depois de aplicar a lematização, sempre teremos uma palavra válida.

O stemming e a lematização podem ser considerados um tipo de compressão linguística. No mesmo sentido, a substituição de palavras pode ser considerada como normalização de texto ou correção de erros.

Mas por que precisamos de substituição de palavras? Suponha que se falamos sobre tokenização, então ele está tendo problemas com contrações (como não consigo, não vou, etc.). Portanto, para lidar com essas questões, precisamos substituir palavras. Por exemplo, podemos substituir as contrações por suas formas expandidas.

Substituição de palavras usando expressão regular

Primeiro, vamos substituir palavras que correspondem à expressão regular. Mas, para isso, devemos ter um conhecimento básico das expressões regulares, bem como do módulo python re. No exemplo abaixo, estaremos substituindo a contração por suas formas expandidas (por exemplo, “não posso” será substituído por “não posso”), tudo isso usando expressões regulares.

Exemplo

Primeiro, importe o pacote necessário para trabalhar com expressões regulares.

import re

from nltk.corpus import wordnetEm seguida, defina os padrões de substituição de sua escolha da seguinte forma -

R_patterns = [

(r'won\'t', 'will not'),

(r'can\'t', 'cannot'),

(r'i\'m', 'i am'),

r'(\w+)\'ll', '\g<1> will'),

(r'(\w+)n\'t', '\g<1> not'),

(r'(\w+)\'ve', '\g<1> have'),

(r'(\w+)\'s', '\g<1> is'),

(r'(\w+)\'re', '\g<1> are'),

]Agora, crie uma classe que pode ser usada para substituir palavras -

class REReplacer(object):

def __init__(self, pattern = R_patterns):

self.pattern = [(re.compile(regex), repl) for (regex, repl) in patterns]

def replace(self, text):

s = text

for (pattern, repl) in self.pattern:

s = re.sub(pattern, repl, s)

return sSalve este programa python (digamos repRE.py) e execute-o no prompt de comando python. Depois de executá-lo, importe a classe REReplacer quando quiser substituir palavras. Vamos ver como.

from repRE import REReplacer

rep_word = REReplacer()

rep_word.replace("I won't do it")

Output:

'I will not do it'

rep_word.replace("I can’t do it")

Output:

'I cannot do it'Exemplo de implementação completo

import re

from nltk.corpus import wordnet

R_patterns = [

(r'won\'t', 'will not'),

(r'can\'t', 'cannot'),

(r'i\'m', 'i am'),

r'(\w+)\'ll', '\g<1> will'),

(r'(\w+)n\'t', '\g<1> not'),

(r'(\w+)\'ve', '\g<1> have'),

(r'(\w+)\'s', '\g<1> is'),

(r'(\w+)\'re', '\g<1> are'),

]

class REReplacer(object):

def __init__(self, patterns=R_patterns):

self.patterns = [(re.compile(regex), repl) for (regex, repl) in patterns]

def replace(self, text):

s = text

for (pattern, repl) in self.patterns:

s = re.sub(pattern, repl, s)

return sAgora, depois de salvar o programa acima e executá-lo, você pode importar a classe e usá-la da seguinte maneira -

from replacerRE import REReplacer

rep_word = REReplacer()

rep_word.replace("I won't do it")Resultado

'I will not do it'Substituição antes do processamento do texto

Uma das práticas comuns ao trabalhar com processamento de linguagem natural (PNL) é limpar o texto antes de processá-lo. Nesse sentido, também podemos usar nossoREReplacer classe criada acima no exemplo anterior, como uma etapa preliminar antes do processamento de texto, ou seja, a tokenização.

Exemplo

from nltk.tokenize import word_tokenize

from replacerRE import REReplacer

rep_word = REReplacer()

word_tokenize("I won't be able to do this now")

Output:

['I', 'wo', "n't", 'be', 'able', 'to', 'do', 'this', 'now']

word_tokenize(rep_word.replace("I won't be able to do this now"))

Output:

['I', 'will', 'not', 'be', 'able', 'to', 'do', 'this', 'now']Na receita Python acima, podemos entender facilmente a diferença entre a saída do tokenizer de palavras sem e com o uso de substituição de expressão regular.

Remoção de caracteres repetidos

Nós estritamente gramaticais em nossa linguagem cotidiana? Não, nós não somos. Por exemplo, às vezes escrevemos 'Hiiiiiiiiiiii Mohan' para enfatizar a palavra 'Hi'. Mas o sistema de computador não sabe que 'Hiiiiiiiiiiii' é uma variação da palavra “Oi”. No exemplo abaixo, estaremos criando uma classe chamadarep_word_removal que pode ser usado para remover as palavras repetidas.

Exemplo

Primeiro, importe o pacote necessário para trabalhar com expressões regulares

import re

from nltk.corpus import wordnetAgora, crie uma classe que pode ser usada para remover as palavras repetidas -

class Rep_word_removal(object):

def __init__(self):

self.repeat_regexp = re.compile(r'(\w*)(\w)\2(\w*)')

self.repl = r'\1\2\3'

def replace(self, word):

if wordnet.synsets(word):

return word

repl_word = self.repeat_regexp.sub(self.repl, word)

if repl_word != word:

return self.replace(repl_word)

else:

return repl_wordSalve este programa python (digamos, removerepeat.py) e execute-o no prompt de comando do python. Depois de executá-lo, importeRep_word_removalclasse quando você deseja remover as palavras repetidas. Vamos ver como?

from removalrepeat import Rep_word_removal

rep_word = Rep_word_removal()

rep_word.replace ("Hiiiiiiiiiiiiiiiiiiiii")

Output:

'Hi'

rep_word.replace("Hellooooooooooooooo")

Output:

'Hello'Exemplo de implementação completo

import re

from nltk.corpus import wordnet

class Rep_word_removal(object):

def __init__(self):

self.repeat_regexp = re.compile(r'(\w*)(\w)\2(\w*)')

self.repl = r'\1\2\3'

def replace(self, word):

if wordnet.synsets(word):

return word

replace_word = self.repeat_regexp.sub(self.repl, word)

if replace_word != word:

return self.replace(replace_word)

else:

return replace_wordAgora, depois de salvar o programa acima e executá-lo, você pode importar a classe e usá-la da seguinte maneira -

from removalrepeat import Rep_word_removal

rep_word = Rep_word_removal()

rep_word.replace ("Hiiiiiiiiiiiiiiiiiiiii")Resultado

'Hi'Substituindo palavras por sinônimos comuns

Ao trabalhar com PNL, especialmente no caso de análise de frequência e indexação de texto, é sempre benéfico compactar o vocabulário sem perder o significado, pois isso economiza muita memória. Para conseguir isso, devemos definir o mapeamento de uma palavra para seus sinônimos. No exemplo abaixo, estaremos criando uma classe chamadaword_syn_replacer que pode ser usado para substituir as palavras por seus sinônimos comuns.

Exemplo

Primeiro, importe o pacote necessário re para trabalhar com expressões regulares.

import re

from nltk.corpus import wordnetEm seguida, crie a classe que usa um mapeamento de substituição de palavras -

class word_syn_replacer(object):

def __init__(self, word_map):

self.word_map = word_map

def replace(self, word):

return self.word_map.get(word, word)Salve este programa python (digamos, replacesyn.py) e execute-o no prompt de comando python. Depois de executá-lo, importeword_syn_replacerclasse quando você deseja substituir palavras por sinônimos comuns. Vamos ver como.

from replacesyn import word_syn_replacer

rep_syn = word_syn_replacer ({‘bday’: ‘birthday’)

rep_syn.replace(‘bday’)Resultado

'birthday'Exemplo de implementação completo

import re

from nltk.corpus import wordnet

class word_syn_replacer(object):

def __init__(self, word_map):

self.word_map = word_map

def replace(self, word):

return self.word_map.get(word, word)Agora, depois de salvar o programa acima e executá-lo, você pode importar a classe e usá-la da seguinte maneira -

from replacesyn import word_syn_replacer

rep_syn = word_syn_replacer ({‘bday’: ‘birthday’)

rep_syn.replace(‘bday’)Resultado

'birthday'A desvantagem do método acima é que devemos codificar os sinônimos em um dicionário Python. Temos duas alternativas melhores na forma de arquivo CSV e YAML. Podemos salvar nosso vocabulário de sinônimos em qualquer um dos arquivos mencionados acima e podemos construirword_mapdicionário deles. Vamos entender o conceito com a ajuda de exemplos.

Usando arquivo CSV

Para utilizar o arquivo CSV para este fim, o arquivo deve ter duas colunas, a primeira coluna consiste em palavra e a segunda coluna consiste nos sinônimos destinados a substituí-la. Vamos salvar este arquivo comosyn.csv. No exemplo abaixo, estaremos criando uma classe chamada CSVword_syn_replacer que irá estender word_syn_replacer dentro replacesyn.py arquivo e será usado para construir o word_map dicionário de syn.csv Arquivo.

Exemplo

Primeiro, importe os pacotes necessários.

import csvEm seguida, crie a classe que usa um mapeamento de substituição de palavras -

class CSVword_syn_replacer(word_syn_replacer):

def __init__(self, fname):

word_map = {}

for line in csv.reader(open(fname)):

word, syn = line

word_map[word] = syn

super(Csvword_syn_replacer, self).__init__(word_map)Depois de executá-lo, importe CSVword_syn_replacerclasse quando você deseja substituir palavras por sinônimos comuns. Vamos ver como?

from replacesyn import CSVword_syn_replacer

rep_syn = CSVword_syn_replacer (‘syn.csv’)

rep_syn.replace(‘bday’)Resultado

'birthday'Exemplo de implementação completo

import csv

class CSVword_syn_replacer(word_syn_replacer):

def __init__(self, fname):

word_map = {}

for line in csv.reader(open(fname)):

word, syn = line

word_map[word] = syn

super(Csvword_syn_replacer, self).__init__(word_map)Agora, depois de salvar o programa acima e executá-lo, você pode importar a classe e usá-la da seguinte maneira -

from replacesyn import CSVword_syn_replacer

rep_syn = CSVword_syn_replacer (‘syn.csv’)

rep_syn.replace(‘bday’)Resultado

'birthday'Usando arquivo YAML

Como usamos o arquivo CSV, também podemos usar o arquivo YAML para essa finalidade (devemos ter o PyYAML instalado). Vamos salvar o arquivo comosyn.yaml. No exemplo abaixo, estaremos criando uma classe chamada YAMLword_syn_replacer que irá estender word_syn_replacer dentro replacesyn.py arquivo e será usado para construir o word_map dicionário de syn.yaml Arquivo.

Exemplo

Primeiro, importe os pacotes necessários.

import yamlEm seguida, crie a classe que usa um mapeamento de substituição de palavras -

class YAMLword_syn_replacer(word_syn_replacer):

def __init__(self, fname):

word_map = yaml.load(open(fname))

super(YamlWordReplacer, self).__init__(word_map)Depois de executá-lo, importe YAMLword_syn_replacerclasse quando você deseja substituir palavras por sinônimos comuns. Vamos ver como?

from replacesyn import YAMLword_syn_replacer

rep_syn = YAMLword_syn_replacer (‘syn.yaml’)

rep_syn.replace(‘bday’)Resultado

'birthday'Exemplo de implementação completo

import yaml

class YAMLword_syn_replacer(word_syn_replacer):

def __init__(self, fname):

word_map = yaml.load(open(fname))

super(YamlWordReplacer, self).__init__(word_map)Agora, depois de salvar o programa acima e executá-lo, você pode importar a classe e usá-la da seguinte maneira -

from replacesyn import YAMLword_syn_replacer

rep_syn = YAMLword_syn_replacer (‘syn.yaml’)

rep_syn.replace(‘bday’)Resultado

'birthday'Substituto do antônimo

Como sabemos, um antônimo é uma palavra que tem o significado oposto de outra palavra, e o oposto de substituição de sinônimo é chamado de substituição de antônimo. Nesta seção, estaremos lidando com a substituição de antônimos, isto é, substituindo palavras por antônimos inequívocos usando o WordNet. No exemplo abaixo, estaremos criando uma classe chamadaword_antonym_replacer que possuem dois métodos, um para substituir a palavra e outro para remover as negações.

Exemplo

Primeiro, importe os pacotes necessários.

from nltk.corpus import wordnetEm seguida, crie a classe chamada word_antonym_replacer -

class word_antonym_replacer(object):

def replace(self, word, pos=None):

antonyms = set()

for syn in wordnet.synsets(word, pos=pos):

for lemma in syn.lemmas():

for antonym in lemma.antonyms():

antonyms.add(antonym.name())

if len(antonyms) == 1:

return antonyms.pop()

else:

return None

def replace_negations(self, sent):

i, l = 0, len(sent)

words = []

while i < l:

word = sent[i]

if word == 'not' and i+1 < l:

ant = self.replace(sent[i+1])

if ant:

words.append(ant)

i += 2

continue

words.append(word)

i += 1

return wordsSalve este programa python (por exemplo, replaceeantonym.py) e execute-o no prompt de comando do python. Depois de executá-lo, importeword_antonym_replacerclasse quando você deseja substituir palavras por seus antônimos inequívocos. Vamos ver como.

from replacerantonym import word_antonym_replacer

rep_antonym = word_antonym_replacer ()

rep_antonym.replace(‘uglify’)Resultado

['beautify'']

sentence = ["Let us", 'not', 'uglify', 'our', 'country']

rep_antonym.replace _negations(sentence)Resultado

["Let us", 'beautify', 'our', 'country']Exemplo de implementação completo

nltk.corpus import wordnet

class word_antonym_replacer(object):

def replace(self, word, pos=None):

antonyms = set()

for syn in wordnet.synsets(word, pos=pos):

for lemma in syn.lemmas():

for antonym in lemma.antonyms():

antonyms.add(antonym.name())

if len(antonyms) == 1:

return antonyms.pop()

else:

return None

def replace_negations(self, sent):

i, l = 0, len(sent)

words = []

while i < l:

word = sent[i]

if word == 'not' and i+1 < l:

ant = self.replace(sent[i+1])

if ant:

words.append(ant)

i += 2

continue

words.append(word)

i += 1

return wordsAgora, depois de salvar o programa acima e executá-lo, você pode importar a classe e usá-la da seguinte maneira -

from replacerantonym import word_antonym_replacer

rep_antonym = word_antonym_replacer ()

rep_antonym.replace(‘uglify’)

sentence = ["Let us", 'not', 'uglify', 'our', 'country']

rep_antonym.replace _negations(sentence)Resultado

["Let us", 'beautify', 'our', 'country']O que é um corpus?

Um corpus é uma grande coleção, em formato estruturado, de textos legíveis por máquina que foram produzidos em um ambiente comunicativo natural. A palavra Corpora é o plural de Corpus. Corpus pode ser derivado de várias maneiras, como segue -

- Do texto que era originalmente eletrônico

- Das transcrições da língua falada

- Do reconhecimento óptico de caracteres e assim por diante

Representatividade do Corpus, Equilíbrio do Corpus, Amostragem, Tamanho do Corpus são os elementos que desempenham um papel importante na concepção do corpus. Alguns dos corpus mais populares para tarefas de PNL são TreeBank, PropBank, VarbNet e WordNet.

Como construir corpus customizado?

Durante o download do NLTK, também instalamos o pacote de dados do NLTK. Portanto, já temos o pacote de dados NLTK instalado em nosso computador. Se falarmos sobre o Windows, vamos supor que este pacote de dados está instalado emC:\natural_language_toolkit_data e se falarmos sobre Linux, Unix e Mac OS X, vamos assumir que este pacote de dados está instalado em /usr/share/natural_language_toolkit_data.

Na receita Python a seguir, vamos criar corpora customizados que devem estar dentro de um dos caminhos definidos por NLTK. É assim porque pode ser encontrado pelo NLTK. Para evitar conflito com o pacote de dados NLTK oficial, vamos criar um diretório natural_language_toolkit_data personalizado em nosso diretório inicial.

import os, os.path

path = os.path.expanduser('~/natural_language_toolkit_data')

if not os.path.exists(path):

os.mkdir(path)

os.path.exists(path)Resultado

TrueAgora, vamos verificar se temos o diretório natural_language_toolkit_data em nosso diretório inicial ou não -

import nltk.data

path in nltk.data.pathResultado

TrueComo temos a saída True, significa que temos nltk_data diretório em nosso diretório inicial.

Agora faremos um arquivo de lista de palavras, chamado wordfile.txt e colocá-lo em uma pasta, chamada corpus em nltk_data diretório (~/nltk_data/corpus/wordfile.txt) e irá carregá-lo usando nltk.data.load -

import nltk.data

nltk.data.load(‘corpus/wordfile.txt’, format = ‘raw’)Resultado

b’tutorialspoint\n’Leitores corpus

O NLTK oferece várias classes CorpusReader. Vamos abordá-los nas seguintes receitas de python

Criando um corpus de lista de palavras

NLTK tem WordListCorpusReaderclasse que fornece acesso ao arquivo que contém uma lista de palavras. Para a seguinte receita do Python, precisamos criar um arquivo de lista de palavras que pode ser CSV ou arquivo de texto normal. Por exemplo, criamos um arquivo chamado 'lista' que contém os seguintes dados -

tutorialspoint

Online

Free

TutorialsAgora vamos instanciar um WordListCorpusReader classe produzindo a lista de palavras de nosso arquivo criado ‘list’.

from nltk.corpus.reader import WordListCorpusReader

reader_corpus = WordListCorpusReader('.', ['list'])

reader_corpus.words()Resultado

['tutorialspoint', 'Online', 'Free', 'Tutorials']Criação de corpus de palavras marcadas em PDV

NLTK tem TaggedCorpusReaderclasse com a ajuda da qual podemos criar um corpus de palavras marcadas POS. Na verdade, a marcação de POS é o processo de identificar a etiqueta da classe gramatical para uma palavra.

Um dos formatos mais simples para um corpus marcado é no formato 'palavra / tag', como o trecho do corpus marrom -

The/at-tl expense/nn and/cc time/nn involved/vbn are/ber

astronomical/jj ./.No trecho acima, cada palavra possui uma tag que denota seu PDV. Por exemplo,vb refere-se a um verbo.

Agora vamos instanciar um TaggedCorpusReaderclasse que produz palavras marcadas em POS formam o arquivo ‘list.pos’, que contém o trecho acima.

from nltk.corpus.reader import TaggedCorpusReader

reader_corpus = TaggedCorpusReader('.', r'.*\.pos')

reader_corpus.tagged_words()Resultado

[('The', 'AT-TL'), ('expense', 'NN'), ('and', 'CC'), ...]Criando um corpus de frase fragmentada

NLTK tem ChnkedCorpusReaderclasse com a ajuda da qual podemos criar um corpus de frases fragmentadas. Na verdade, um pedaço é uma frase curta em uma frase.

Por exemplo, temos o seguinte trecho do treebank corpus -

[Earlier/JJR staff-reduction/NN moves/NNS] have/VBP trimmed/VBN about/

IN [300/CD jobs/NNS] ,/, [the/DT spokesman/NN] said/VBD ./.No trecho acima, cada bloco é um sintagma nominal, mas as palavras que não estão entre colchetes fazem parte da árvore de frases e não de nenhuma subárvore do sintagma nominal.

Agora vamos instanciar um ChunkedCorpusReader classe produzindo frase fragmentada do arquivo ‘list.chunk’, que contém o trecho acima.

from nltk.corpus.reader import ChunkedCorpusReader

reader_corpus = TaggedCorpusReader('.', r'.*\.chunk')

reader_corpus.chunked_words()Resultado

[

Tree('NP', [('Earlier', 'JJR'), ('staff-reduction', 'NN'), ('moves', 'NNS')]),

('have', 'VBP'), ...

]Criação de corpus de texto categorizado

NLTK tem CategorizedPlaintextCorpusReaderclasse com a ajuda da qual podemos criar um corpus de texto categorizado. É muito útil no caso em que temos um grande corpus de texto e queremos categorizá-lo em seções separadas.

Por exemplo, o corpus marrom tem várias categorias diferentes. Vamos descobri-los com a ajuda do seguinte código Python -

from nltk.corpus import brown^M

brown.categories()Resultado

[

'adventure', 'belles_lettres', 'editorial', 'fiction', 'government',

'hobbies', 'humor', 'learned', 'lore', 'mystery', 'news', 'religion',

'reviews', 'romance', 'science_fiction'

]Uma das maneiras mais fáceis de categorizar um corpus é ter um arquivo para cada categoria. Por exemplo, vamos ver os dois trechos domovie_reviews corpus -

movie_pos.txt

A fina linha vermelha é falha, mas provoca.

movie_neg.txt

Uma produção brilhante e de grande orçamento não pode compensar a falta de espontaneidade que permeia seu programa de TV.

Então, dos dois arquivos acima, temos duas categorias, a saber pos e neg.

Agora vamos instanciar um CategorizedPlaintextCorpusReader classe.

from nltk.corpus.reader import CategorizedPlaintextCorpusReader

reader_corpus = CategorizedPlaintextCorpusReader('.', r'movie_.*\.txt',

cat_pattern = r'movie_(\w+)\.txt')

reader_corpus.categories()

reader_corpus.fileids(categories = [‘neg’])

reader_corpus.fileids(categories = [‘pos’])Resultado

['neg', 'pos']

['movie_neg.txt']

['movie_pos.txt']O que é marcação de PDV?

A marcação, um tipo de classificação, é a atribuição automática da descrição dos tokens. Chamamos o descritor de 'tag', que representa uma das classes gramaticais (substantivos, verbo, advérbios, adjetivos, pronomes, conjunção e suas subcategorias), informação semântica e assim por diante.

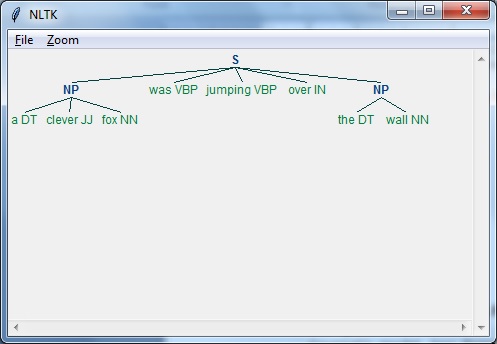

Por outro lado, se falamos de tagging Part-of-Speech (POS), pode ser definido como o processo de conversão de uma frase na forma de uma lista de palavras, em uma lista de tuplas. Aqui, as tuplas estão na forma de (palavra, tag). Também podemos chamar de marcação POS um processo de atribuição de uma das classes gramaticais à palavra dada.

A tabela a seguir representa a notificação de PDV mais frequente usada no Penn Treebank corpus -

| Sr. Não | Tag | Descrição |

|---|---|---|

| 1 | NNP | Nome próprio, singular |

| 2 | NNPS | Substantivo próprio, plural |

| 3 | PDT | Pré determinante |

| 4 | POS | Final possessivo |

| 5 | PRP | Pronome pessoal |

| 6 | PRP $ | Pronome possessivo |

| 7 | RB | Advérbio |

| 8 | RBR | Advérbio, comparativo |

| 9 | RBS | Advérbio, superlativo |

| 10 | RP | Partícula |

| 11 | SYM | Símbolo (matemático ou científico) |

| 12 | PARA | para |

| 13 | UH | Interjeição |

| 14 | VB | Verbo, forma básica |

| 15 | VBD | Verbo, pretérito |

| 16 | VBG | Verbo, gerúndio / particípio presente |

| 17 | VBN | Verbo, passado |

| 18 | WP | Pronome Wh |

| 19 | WP $ | Pronome wh possessivo |

| 20 | WRB | Wh-advérbio |

| 21 | # | Sinal de libra |

| 22 | $ | Cifrão |

| 23 | . | Pontuação final de frase |

| 24 | , | Vírgula |

| 25 | : | Cólon, ponto e vírgula |

| 26 | ( | Parêntese esquerdo |

| 27 | ) | Caráter de colchete direito |

| 28 | " | Aspas duplas diretas |

| 29 | ' | Aspas simples abertas |

| 30 | " | Aspas duplas abertas |

| 31 | ' | Aspas simples fechadas à direita |

| 32 | " | Aspas duplas abertas à direita |

Exemplo

Vamos entender isso com um experimento Python -

import nltk

from nltk import word_tokenize

sentence = "I am going to school"

print (nltk.pos_tag(word_tokenize(sentence)))Resultado

[('I', 'PRP'), ('am', 'VBP'), ('going', 'VBG'), ('to', 'TO'), ('school', 'NN')]Por que marcação de PDV?

A marcação de POS é uma parte importante da PNL porque funciona como um pré-requisito para análises adicionais da PNL da seguinte maneira -

- Chunking

- Análise sintática

- Extração de informação

- Maquina de tradução

- Análise de sentimentos

- Análise gramatical e desambiguação do sentido das palavras

TaggerI - classe base

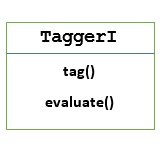

Todos os taggers residem no pacote nltk.tag da NLTK. A classe base desses taggers éTaggerI, significa que todos os marcadores herdam desta classe.

Methods - A classe TaggerI tem os dois métodos a seguir que devem ser implementados por todas as suas subclasses -

tag() method - Como o nome indica, este método pega uma lista de palavras como entrada e retorna uma lista de palavras marcadas como saída.

evaluate() method - Com a ajuda deste método, podemos avaliar a precisão do tagger.

A linha de base da marcação de PDV

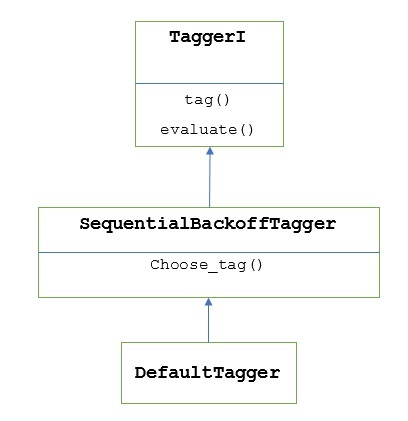

A linha de base ou a etapa básica da marcação de POS é Default Tagging, que pode ser executado usando a classe DefaultTagger do NLTK. A marcação padrão simplesmente atribui a mesma tag POS a cada token. A marcação padrão também fornece uma linha de base para medir as melhorias de precisão.

Classe DefaultTagger

A marcação padrão é realizada usando DefaultTagging classe, que recebe um único argumento, ou seja, a tag que queremos aplicar.

Como funciona?

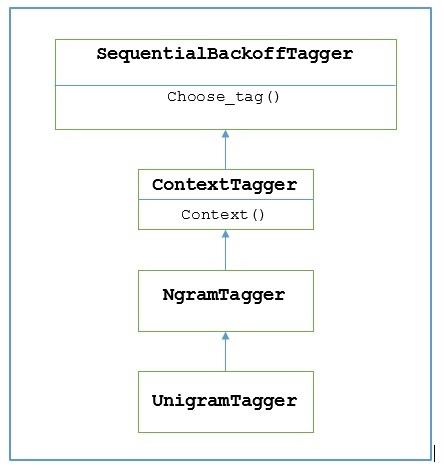

Como dito anteriormente, todos os etiquetadores são herdados de TaggerIclasse. oDefaultTagger é herdado de SequentialBackoffTagger que é uma subclasse de TaggerI class. Vamos entender isso com o seguinte diagrama -

Como sendo parte de SeuentialBackoffTagger, a DefaultTagger deve implementar o método choose_tag () que leva os três argumentos a seguir.

- Lista de token

- Índice do token atual

- Lista do token anterior, ou seja, o histórico

Exemplo

import nltk

from nltk.tag import DefaultTagger

exptagger = DefaultTagger('NN')

exptagger.tag(['Tutorials','Point'])Resultado

[('Tutorials', 'NN'), ('Point', 'NN')]Neste exemplo, escolhemos uma tag de substantivo porque é o tipo de palavra mais comum. Além disso,DefaultTagger também é mais útil quando escolhemos a tag de PDV mais comum.

Avaliação de precisão

o DefaultTaggertambém é a linha de base para avaliar a precisão dos etiquetadores. Essa é a razão pela qual podemos usá-lo junto comevaluate()método para medir a precisão. oevaluate() O método usa uma lista de tokens marcados como padrão-ouro para avaliar o marcador.

A seguir está um exemplo em que usamos nosso tagger padrão, chamado exptagger, criado acima, para avaliar a precisão de um subconjunto de treebank frases marcadas com corpus -

Exemplo

import nltk

from nltk.tag import DefaultTagger

exptagger = DefaultTagger('NN')

from nltk.corpus import treebank

testsentences = treebank.tagged_sents() [1000:]

exptagger.evaluate (testsentences)Resultado

0.13198749536374715A saída acima mostra que escolhendo NN para cada tag, podemos atingir cerca de 13% de teste de precisão em 1000 entradas do treebank corpus.

Marcando uma lista de frases

Em vez de marcar uma única frase, o NLTK's TaggerI classe também nos fornece um tag_sents()método com a ajuda do qual podemos marcar uma lista de frases. A seguir está o exemplo em que marcamos duas frases simples

Exemplo

import nltk

from nltk.tag import DefaultTagger

exptagger = DefaultTagger('NN')

exptagger.tag_sents([['Hi', ','], ['How', 'are', 'you', '?']])Resultado

[

[

('Hi', 'NN'),

(',', 'NN')

],

[

('How', 'NN'),

('are', 'NN'),

('you', 'NN'),

('?', 'NN')

]

]No exemplo acima, usamos nosso tagger padrão criado anteriormente, denominado exptagger.

Desmarcando uma frase

Também podemos desmarcar uma frase. O NLTK fornece o método nltk.tag.untag () para esse propósito. Receberá uma frase com tags como entrada e fornece uma lista de palavras sem tags. Vamos ver um exemplo -

Exemplo

import nltk

from nltk.tag import untag

untag([('Tutorials', 'NN'), ('Point', 'NN')])Resultado

['Tutorials', 'Point']O que é Unigram Tagger?

Como o nome indica, unigram tagger é um tagger que usa apenas uma única palavra como contexto para determinar a tag POS (Part-of-Speech). Em palavras simples, Unigram Tagger é um tagger baseado em contexto cujo contexto é uma única palavra, ou seja, Unigram.

Como funciona?

NLTK fornece um módulo chamado UnigramTaggerpara este propósito. Mas antes de nos aprofundarmos em seu funcionamento, vamos entender a hierarquia com a ajuda do diagrama a seguir -

A partir do diagrama acima, entende-se que UnigramTagger é herdado de NgramTagger que é uma subclasse de ContextTagger, que herda de SequentialBackoffTagger.

O trabalho de UnigramTagger é explicado com a ajuda das seguintes etapas -

Como nós vimos, UnigramTagger herda de ContextTagger, ele implementa um context()método. estecontext() método leva os mesmos três argumentos que choose_tag() método.

O resultado de context()método será a palavra token que será usada posteriormente para criar o modelo. Depois que o modelo é criado, a palavra token também é usada para pesquisar a melhor tag.

Nesse caminho, UnigramTagger irá construir um modelo de contexto a partir da lista de frases marcadas.

Treinando um Unigram Tagger

NLTK's UnigramTaggerpode ser treinado fornecendo uma lista de frases marcadas no momento da inicialização. No exemplo abaixo, vamos usar as frases marcadas do treebank corpus. Estaremos usando as primeiras 2.500 frases desse corpus.

Exemplo

Primeiro importe o módulo UniframTagger do nltk -

from nltk.tag import UnigramTaggerEm seguida, importe o corpus que deseja usar. Aqui, estamos usando treebank corpus -

from nltk.corpus import treebankAgora, pegue as frases para fins de treinamento. Estamos pegando as primeiras 2.500 frases para fins de treinamento e as marcaremos -

train_sentences = treebank.tagged_sents()[:2500]Em seguida, aplique UnigramTagger nas sentenças usadas para fins de treinamento -

Uni_tagger = UnigramTagger(train_sentences)Tome algumas sentenças, iguais ou menores, para fins de treinamento, ou seja, 2500, para fins de teste. Aqui estamos pegando os primeiros 1500 para fins de teste -

test_sentences = treebank.tagged_sents()[1500:]

Uni_tagger.evaluate(test_sents)Resultado

0.8942306156033808Aqui, obtivemos cerca de 89 por cento de precisão para um tagger que usa pesquisa de palavra única para determinar a tag POS.

Exemplo de implementação completo

from nltk.tag import UnigramTagger

from nltk.corpus import treebank

train_sentences = treebank.tagged_sents()[:2500]

Uni_tagger = UnigramTagger(train_sentences)

test_sentences = treebank.tagged_sents()[1500:]

Uni_tagger.evaluate(test_sentences)Resultado

0.8942306156033808Substituindo o modelo de contexto

Do diagrama acima, mostrando a hierarquia para UnigramTagger, conhecemos todos os etiquetadores que herdam de ContextTagger, em vez de treinar seu próprio, pode usar um modelo pré-construído. Este modelo pré-construído é simplesmente um mapeamento de dicionário Python de uma chave de contexto para uma tag. E paraUnigramTagger, as chaves de contexto são palavras individuais, enquanto para outras NgramTagger subclasses, serão tuplas.

Podemos substituir este modelo de contexto, passando outro modelo simples para o UnigramTaggerclasse em vez de passar no conjunto de treinamento. Vamos entender com a ajuda de um exemplo fácil abaixo -

Exemplo

from nltk.tag import UnigramTagger

from nltk.corpus import treebank

Override_tagger = UnigramTagger(model = {‘Vinken’ : ‘NN’})

Override_tagger.tag(treebank.sents()[0])Resultado

[

('Pierre', None),

('Vinken', 'NN'),

(',', None),

('61', None),

('years', None),

('old', None),

(',', None),

('will', None),

('join', None),

('the', None),

('board', None),

('as', None),

('a', None),

('nonexecutive', None),

('director', None),

('Nov.', None),

('29', None),

('.', None)

]Como nosso modelo contém 'Vinken' como a única chave de contexto, você pode observar a partir da saída acima que apenas essa palavra tem tag e todas as outras palavras têm None como tag.

Definir um limite mínimo de frequência

Para decidir qual tag é mais provável para um determinado contexto, o ContextTaggerclasse usa frequência de ocorrência. Ele fará isso por padrão, mesmo se a palavra de contexto e a tag ocorrerem apenas uma vez, mas podemos definir um limite mínimo de frequência passando umcutoff valor para o UnigramTaggerclasse. No exemplo abaixo, estamos passando o valor de corte na receita anterior em que treinamos um UnigramTagger -

Exemplo

from nltk.tag import UnigramTagger

from nltk.corpus import treebank

train_sentences = treebank.tagged_sents()[:2500]

Uni_tagger = UnigramTagger(train_sentences, cutoff = 4)

test_sentences = treebank.tagged_sents()[1500:]

Uni_tagger.evaluate(test_sentences)Resultado

0.7357651629613641Combinando Taggers

Combinar taggers ou encadear taggers entre si é uma das características importantes do NLTK. O principal conceito por trás da combinação de taggers é que, caso um tagger não saiba como rotular uma palavra, ela será passada para o tagger encadeado. Para alcançar este propósito,SequentialBackoffTagger nos fornece o Backoff tagging característica.

Marcação de backoff

Como dito anteriormente, a marcação de backoff é uma das características importantes do SequentialBackoffTagger, que nos permite combinar etiquetadores de uma forma que, se um etiquetador não souber como etiquetar uma palavra, a palavra será passada para o próximo etiquetador e assim por diante até que não haja mais etiquetadores de backoff para verificar.

Como funciona?

Na verdade, cada subclasse de SequentialBackoffTaggerpode usar um argumento de palavra-chave 'recuar'. O valor deste argumento de palavra-chave é outra instância de umSequentialBackoffTagger. Agora, sempre que issoSequentialBackoffTaggerclasse é inicializada, uma lista interna de taggers de backoff (com ele mesmo como o primeiro elemento) será criada. Além disso, se um tagger de backoff for fornecido, a lista interna desses taggers de backoff será anexada.

No exemplo abaixo, estamos pegando DefaulTagger como o tagger de backoff na receita Python acima com a qual treinamos o UnigramTagger.

Exemplo

Neste exemplo, estamos usando DefaulTaggercomo o identificador de backoff. Sempre queUnigramTagger é incapaz de marcar uma palavra, backoff tagger, ou seja, DefaulTagger, no nosso caso, irá marcá-lo com 'NN'.

from nltk.tag import UnigramTagger

from nltk.tag import DefaultTagger

from nltk.corpus import treebank

train_sentences = treebank.tagged_sents()[:2500]

back_tagger = DefaultTagger('NN')

Uni_tagger = UnigramTagger(train_sentences, backoff = back_tagger)

test_sentences = treebank.tagged_sents()[1500:]

Uni_tagger.evaluate(test_sentences)Resultado

0.9061975746536931A partir da saída acima, você pode observar que ao adicionar um tagger de backoff a precisão aumenta em cerca de 2%.

Salvando picles com picles

Como vimos, treinar um tagger é muito complicado e também leva tempo. Para economizar tempo, podemos escolher um tagger treinado para usá-lo mais tarde. No exemplo abaixo, vamos fazer isso com nosso tagger já treinado chamado‘Uni_tagger’.

Exemplo

import pickle

f = open('Uni_tagger.pickle','wb')

pickle.dump(Uni_tagger, f)

f.close()

f = open('Uni_tagger.pickle','rb')

Uni_tagger = pickle.load(f)Classe NgramTagger

A partir do diagrama de hierarquia discutido na unidade anterior, UnigramTagger é herdado de NgarmTagger classe, mas temos mais duas subclasses de NgarmTagger classe -

Subclasse BigramTagger

Na verdade, um ngram é uma subsequência de n itens, portanto, como o nome indica, BigramTaggera subclasse analisa os dois itens. O primeiro item é a palavra marcada anterior e o segundo item é a palavra marcada atual.

Subclasse TrigramTagger

Na mesma nota de BigramTagger, TrigramTagger subclass olha para os três itens, ou seja, duas palavras marcadas anteriores e uma palavra marcada atual.

Praticamente se aplicarmos BigramTagger e TrigramTaggersubclasses individualmente como fizemos com a subclasse UnigramTagger, ambas têm um desempenho muito ruim. Vejamos nos exemplos abaixo:

Usando a subclasse BigramTagger

from nltk.tag import BigramTagger

from nltk.corpus import treebank

train_sentences = treebank.tagged_sents()[:2500]

Bi_tagger = BigramTagger(train_sentences)

test_sentences = treebank.tagged_sents()[1500:]

Bi_tagger.evaluate(test_sentences)Resultado

0.44669191071913594Usando a subclasse TrigramTagger

from nltk.tag import TrigramTagger

from nltk.corpus import treebank

train_sentences = treebank.tagged_sents()[:2500]

Tri_tagger = TrigramTagger(train_sentences)

test_sentences = treebank.tagged_sents()[1500:]

Tri_tagger.evaluate(test_sentences)Resultado

0.41949863394526193Você pode comparar o desempenho do UnigramTagger, que usamos anteriormente (forneceu cerca de 89% de precisão) com BigramTagger (deu cerca de 44% de precisão) e TrigramTagger (deu cerca de 41% de precisão). A razão é que os marcadores Bigram e Trigram não podem aprender o contexto da (s) primeira (s) palavra (s) em uma frase. Por outro lado, a classe UnigramTagger não se preocupa com o contexto anterior e adivinha a tag mais comum para cada palavra, portanto, capaz de ter alta precisão de linha de base.

Combinando ngram taggers

A partir dos exemplos acima, é óbvio que os etiquetadores Bigram e Trigram podem contribuir quando os combinamos com etiquetagem de backoff. No exemplo abaixo, estamos combinando os identificadores Unigram, Bigram e Trigram com a marcação de backoff. O conceito é o mesmo da receita anterior, combinando o UnigramTagger com o backoff tagger. A única diferença é que estamos usando a função chamada backoff_tagger () de tagger_util.py, fornecida abaixo, para a operação de backoff.

def backoff_tagger(train_sentences, tagger_classes, backoff=None):

for cls in tagger_classes:

backoff = cls(train_sentences, backoff=backoff)

return backoffExemplo

from tagger_util import backoff_tagger

from nltk.tag import UnigramTagger

from nltk.tag import BigramTagger

from nltk.tag import TrigramTagger

from nltk.tag import DefaultTagger

from nltk.corpus import treebank

train_sentences = treebank.tagged_sents()[:2500]

back_tagger = DefaultTagger('NN')

Combine_tagger = backoff_tagger(train_sentences,

[UnigramTagger, BigramTagger, TrigramTagger], backoff = back_tagger)

test_sentences = treebank.tagged_sents()[1500:]

Combine_tagger.evaluate(test_sentences)Resultado

0.9234530029238365Pelo resultado acima, podemos ver que aumenta a precisão em cerca de 3%.

Affix Tagger

Uma outra classe importante da subclasse ContextTagger é AffixTagger. Na classe AffixTagger, o contexto é prefixo ou sufixo de uma palavra. Essa é a razão pela qual a classe AffixTagger pode aprender tags com base em substrings de comprimento fixo do início ou do final de uma palavra.

Como funciona?

Seu funcionamento depende do argumento denominado affix_length que especifica o comprimento do prefixo ou sufixo. O valor padrão é 3. Mas como ele distingue se a classe AffixTagger aprendeu o prefixo ou o sufixo da palavra?

affix_length=positive - Se o valor de affix_lenght for positivo, significa que a classe AffixTagger aprenderá os prefixos das palavras.

affix_length=negative - Se o valor de affix_lenght for negativo, significa que a classe AffixTagger aprenderá os sufixos da palavra.

Para deixar mais claro, no exemplo abaixo, estaremos usando a classe AffixTagger em frases de treebank marcadas.

Exemplo

Neste exemplo, AffixTagger aprenderá o prefixo da palavra porque não estamos especificando nenhum valor para o argumento affix_length. O argumento terá o valor padrão 3 -

from nltk.tag import AffixTagger

from nltk.corpus import treebank

train_sentences = treebank.tagged_sents()[:2500]

Prefix_tagger = AffixTagger(train_sentences)

test_sentences = treebank.tagged_sents()[1500:]

Prefix_tagger.evaluate(test_sentences)Resultado

0.2800492099250667Vamos ver no exemplo abaixo qual será a precisão quando fornecermos o valor 4 para o argumento affix_length -

from nltk.tag import AffixTagger

from nltk.corpus import treebank

train_sentences = treebank.tagged_sents()[:2500]

Prefix_tagger = AffixTagger(train_sentences, affix_length=4 )

test_sentences = treebank.tagged_sents()[1500:]

Prefix_tagger.evaluate(test_sentences)Resultado

0.18154947354966527Exemplo

Neste exemplo, AffixTagger aprenderá o sufixo da palavra porque especificaremos o valor negativo para o argumento affix_length.

from nltk.tag import AffixTagger

from nltk.corpus import treebank

train_sentences = treebank.tagged_sents()[:2500]

Suffix_tagger = AffixTagger(train_sentences, affix_length = -3)

test_sentences = treebank.tagged_sents()[1500:]

Suffix_tagger.evaluate(test_sentences)Resultado

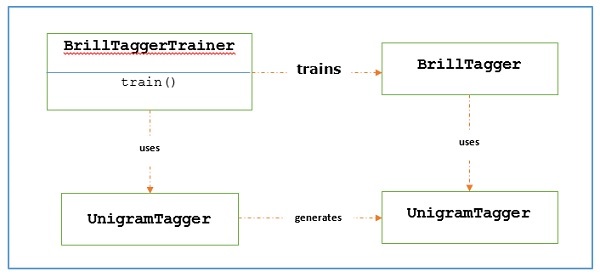

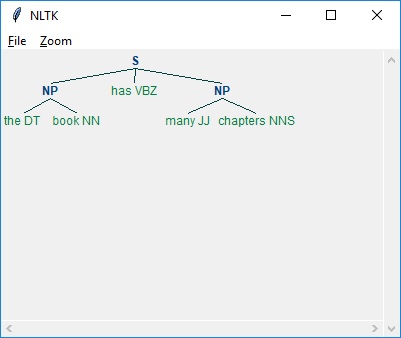

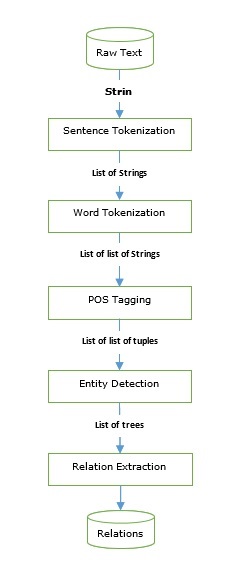

0.2800492099250667Brill Tagger