Apache MXNet - Hướng dẫn nhanh

Chương này nêu bật các tính năng của Apache MXNet và nói về phiên bản mới nhất của khung phần mềm học sâu này.

MXNet là gì?

Apache MXNet là một công cụ khung phần mềm học sâu mã nguồn mở mạnh mẽ giúp các nhà phát triển xây dựng, đào tạo và triển khai các mô hình Học sâu. Trong vài năm qua, từ chăm sóc sức khỏe đến giao thông vận tải đến sản xuất và trên thực tế, trong mọi khía cạnh của cuộc sống hàng ngày của chúng ta, tác động của học sâu đã trở nên phổ biến. Ngày nay, học sâu được các công ty tìm kiếm để giải quyết một số vấn đề khó khăn như Nhận dạng khuôn mặt, phát hiện đối tượng, Nhận dạng ký tự quang học (OCR), Nhận dạng giọng nói và Dịch máy.

Đó là lý do Apache MXNet được hỗ trợ bởi:

Một số công ty lớn như Intel, Baidu, Microsoft, Wolfram Research, v.v.

Các nhà cung cấp đám mây công cộng bao gồm Amazon Web Services (AWS) và Microsoft Azure

Một số viện nghiên cứu lớn như Carnegie Mellon, MIT, Đại học Washington, và Đại học Khoa học & Công nghệ Hồng Kông.

Tại sao sử dụng Apache MXNet?

Có rất nhiều nền tảng học sâu khác nhau như Torch7, Caffe, Theano, TensorFlow, Keras, Bộ công cụ nhận thức của Microsoft, v.v. tồn tại và bạn có thể thắc mắc tại sao Apache MXNet? Hãy cùng kiểm tra một số lý do đằng sau nó:

Apache MXNet giải quyết một trong những vấn đề lớn nhất của các nền tảng học sâu hiện có. Vấn đề là để sử dụng các nền tảng học sâu, người ta phải học một hệ thống khác để có một hương vị lập trình khác.

Với sự trợ giúp của Apache MXNet các nhà phát triển có thể khai thác hết khả năng của GPU cũng như điện toán đám mây.

Apache MXNet có thể tăng tốc bất kỳ tính toán số nào và đặc biệt chú trọng vào việc tăng tốc độ phát triển và triển khai DNN quy mô lớn (mạng nơ ron sâu).

Nó cung cấp cho người dùng khả năng của cả lập trình mệnh lệnh và biểu tượng.

Các tính năng khác nhau

Nếu bạn đang tìm kiếm một thư viện học sâu linh hoạt để nhanh chóng phát triển nghiên cứu học sâu tiên tiến hoặc một nền tảng mạnh mẽ để đẩy khối lượng công việc sản xuất, tìm kiếm của bạn sẽ kết thúc tại Apache MXNet. Đó là vì các tính năng sau của nó:

Đào tạo phân tán

Cho dù đó là đào tạo đa gpu hay đa máy chủ với hiệu quả mở rộng gần tuyến tính, Apache MXNet cho phép các nhà phát triển tận dụng tối đa phần cứng của họ. MXNet cũng hỗ trợ tích hợp với Horovod, một khung học sâu phân tán mã nguồn mở được tạo ra tại Uber.

Đối với tích hợp này, sau đây là một số API phân phối phổ biến được xác định trong Horovod:

horovod.broadcast()

horovod.allgather()

horovod.allgather()

Về vấn đề này, MXNet cung cấp cho chúng tôi các khả năng sau:

Device Placement - Với sự trợ giúp của MXNet, chúng ta có thể dễ dàng chỉ định từng cấu trúc dữ liệu (DS).

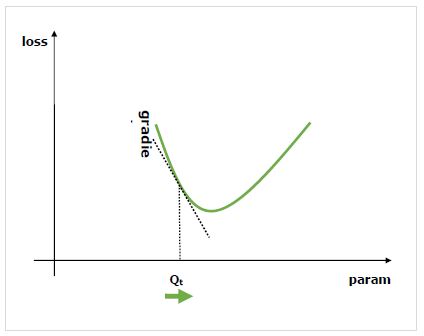

Automatic Differentiation - Apache MXNet tự động hóa phân biệt tức là tính toán đạo hàm.

Multi-GPU training - MXNet cho phép chúng tôi đạt được hiệu quả mở rộng với số lượng GPU có sẵn.

Optimized Predefined Layers - Chúng tôi có thể mã hóa các lớp của riêng mình trong MXNet cũng như tối ưu hóa các lớp được xác định trước để tăng tốc độ.

Lai ghép

Apache MXNet cung cấp cho người dùng một giao diện người dùng kết hợp. Với sự trợ giúp của API Gluon Python, nó có thể thu hẹp khoảng cách giữa khả năng bắt buộc và biểu tượng của nó. Nó có thể được thực hiện bằng cách gọi nó là chức năng hybridize.

Tính toán nhanh hơn

Các phép toán tuyến tính như hàng chục hoặc hàng trăm phép nhân ma trận là nút thắt cổ chai tính toán cho các mạng nơron sâu. Để giải quyết nút thắt cổ chai này, MXNet cung cấp:

Tính toán số được tối ưu hóa cho GPU

Tính toán số được tối ưu hóa cho hệ sinh thái phân tán

Tự động hóa các quy trình công việc chung với sự trợ giúp của NN tiêu chuẩn có thể được diễn đạt ngắn gọn.

Ràng buộc ngôn ngữ

MXNet có khả năng tích hợp sâu vào các ngôn ngữ cấp cao như Python và R. Nó cũng cung cấp hỗ trợ cho các ngôn ngữ lập trình khác như-

Scala

Julia

Clojure

Java

C/C++

Perl

Chúng tôi không cần phải học bất kỳ ngôn ngữ lập trình mới nào thay vào đó MXNet, kết hợp với tính năng lai tạo, cho phép chuyển đổi đặc biệt trơn tru từ Python sang triển khai bằng ngôn ngữ lập trình mà chúng tôi lựa chọn.

Phiên bản mới nhất MXNet 1.6.0

Apache Software Foundation (ASF) đã phát hành phiên bản ổn định 1.6.0 của Apache MXNet vào ngày 21 tháng 2 năm 2020 theo Giấy phép Apache 2.0. Đây là bản phát hành MXNet cuối cùng hỗ trợ Python 2 vì cộng đồng MXNet đã bỏ phiếu không hỗ trợ Python 2 trong các bản phát hành tiếp theo. Hãy để chúng tôi kiểm tra một số tính năng mới mà bản phát hành này mang lại cho người dùng.

Giao diện tương thích NumPy

Do tính linh hoạt và tính tổng quát của nó, NumPy đã được sử dụng rộng rãi bởi các nhà thực hành Máy học, nhà khoa học và sinh viên. Nhưng như chúng ta biết rằng, những bộ tăng tốc phần cứng ngày nay như Bộ xử lý đồ họa (GPU) ngày càng được đồng hóa với nhiều bộ công cụ Học máy (ML) khác nhau, người dùng NumPy, để tận dụng tốc độ của GPU, cần phải chuyển sang các khuôn khổ mới với các cú pháp khác nhau.

Với MXNet 1.6.0, Apache MXNet đang hướng tới trải nghiệm lập trình tương thích với NumPy. Giao diện mới cung cấp khả năng sử dụng tương đương cũng như tính biểu cảm cho những người thực hành quen thuộc với cú pháp NumPy. Cùng với đó, MXNet 1.6.0 cũng cho phép hệ thống Numpy hiện có sử dụng các bộ tăng tốc phần cứng như GPU để tăng tốc các phép tính quy mô lớn.

Tích hợp với Apache TVM

Apache TVM, một ngăn xếp trình biên dịch học sâu mã nguồn mở end-to-end dành cho phần cứng-phụ trợ như CPU, GPU và các bộ tăng tốc chuyên dụng, nhằm mục đích lấp đầy khoảng cách giữa khung học sâu tập trung vào năng suất và phần cứng phụ trợ phần cứng theo định hướng hiệu suất . Với bản phát hành mới nhất MXNet 1.6.0, người dùng có thể tận dụng Apache (đang ấp ủ) TVM để triển khai các hạt nhân toán tử hiệu suất cao bằng ngôn ngữ lập trình Python. Hai ưu điểm chính của tính năng mới này là:

Đơn giản hóa quy trình phát triển dựa trên C ++ trước đây.

Cho phép chia sẻ cùng một triển khai trên nhiều phần cứng phần cứng như CPU, GPU, v.v.

Cải tiến các tính năng hiện có

Ngoài các tính năng được liệt kê ở trên của MXNet 1.6.0, nó cũng cung cấp một số cải tiến so với các tính năng hiện có. Các cải tiến như sau:

Phân nhóm hoạt động khôn ngoan cho GPU

Như chúng ta biết hiệu suất của các hoạt động khôn ngoan là băng thông bộ nhớ và đó là lý do, việc xâu chuỗi các hoạt động đó có thể làm giảm hiệu suất tổng thể. Apache MXNet 1.6.0 thực hiện sự kết hợp hoạt động khôn ngoan của phần tử, thực sự tạo ra các hoạt động được hợp nhất đúng lúc và khi có thể. Sự kết hợp hoạt động khôn ngoan như vậy cũng làm giảm nhu cầu lưu trữ và cải thiện hiệu suất tổng thể.

Đơn giản hóa các biểu thức phổ biến

MXNet 1.6.0 loại bỏ các biểu thức thừa và đơn giản hóa các biểu thức phổ biến. Việc tăng cường như vậy cũng cải thiện việc sử dụng bộ nhớ và tổng thời gian thực thi.

Tối ưu hóa

MXNet 1.6.0 cũng cung cấp các tối ưu hóa khác nhau cho các tính năng và toán tử hiện có, như sau:

Độ chính xác hỗn hợp tự động

API Gluon Fit

MKL-DNN

Hỗ trợ căng thẳng lớn

TensorRT hội nhập

Hỗ trợ gradient bậc cao hơn

Operators

Hồ sơ hiệu suất của người vận hành

Nhập / xuất ONNX

Cải tiến đối với API Gluon

Cải tiến đối với API biểu tượng

Hơn 100 bản sửa lỗi

Để bắt đầu với MXNet, điều đầu tiên chúng ta cần làm là cài đặt nó trên máy tính của mình. Apache MXNet hoạt động trên hầu hết các nền tảng có sẵn, bao gồm Windows, Mac và Linux.

Hệ điều hành Linux

Chúng ta có thể cài đặt MXNet trên HĐH Linux theo các cách sau:

Bộ xử lý đồ họa (GPU)

Ở đây, chúng tôi sẽ sử dụng các phương pháp khác nhau cụ thể là Pip, Docker và Nguồn để cài đặt MXNet khi chúng tôi đang sử dụng GPU để xử lý -

Bằng cách sử dụng phương pháp Pip

Bạn có thể sử dụng lệnh sau để cài đặt MXNet trên Hệ điều hành Linus của mình -

pip install mxnetApache MXNet cũng cung cấp gói pip MKL, nhanh hơn nhiều khi chạy trên phần cứng intel. Ví dụ ở đâymxnet-cu101mkl có nghĩa là -

Gói được xây dựng bằng CUDA / cuDNN

Gói được bật MKL-DNN

Phiên bản CUDA là 10.1

Đối với tùy chọn khác, bạn cũng có thể tham khảo https://pypi.org/project/mxnet/.

Bằng cách sử dụng Docker

Bạn có thể tìm hình ảnh docker bằng MXNet tại DockerHub, có sẵn tại https://hub.docker.com/u/mxnet Hãy để chúng tôi kiểm tra các bước dưới đây để cài đặt MXNet bằng cách sử dụng Docker với GPU -

Step 1- Đầu tiên, bằng cách làm theo hướng dẫn cài đặt docker có sẵn tại https://docs.docker.com/engine/install/ubuntu/. Chúng tôi cần cài đặt Docker trên máy của mình.

Step 2- Để cho phép sử dụng GPU từ bộ chứa docker, tiếp theo chúng ta cần cài đặt nvidia-docker-plugin. Bạn có thể làm theo hướng dẫn cài đặt được cung cấp tạihttps://github.com/NVIDIA/nvidia-docker/wiki.

Step 3- Bằng cách sử dụng lệnh sau, bạn có thể kéo hình ảnh bộ đế MXNet -

$ sudo docker pull mxnet/python:gpuBây giờ để xem liệu việc kéo hình ảnh docker mxnet / python có thành công hay không, chúng ta có thể liệt kê các hình ảnh docker như sau:

$ sudo docker imagesĐể có tốc độ suy luận nhanh nhất với MXNet, bạn nên sử dụng MXNet mới nhất với Intel MKL-DNN. Kiểm tra các lệnh bên dưới -

$ sudo docker pull mxnet/python:1.3.0_cpu_mkl $ sudo docker imagesTừ nguồn

Để xây dựng thư viện chia sẻ MXNet từ nguồn với GPU, trước tiên chúng ta cần thiết lập môi trường cho CUDA và cuDNN như sau−

Tải xuống và cài đặt bộ công cụ CUDA, tại đây khuyến nghị sử dụng CUDA 9.2.

Tiếp theo tải về cuDNN 7.1.4.

Bây giờ chúng ta cần giải nén tệp. Nó cũng được yêu cầu để thay đổi thư mục gốc cuDNN. Đồng thời di chuyển tiêu đề và thư viện vào thư mục Bộ công cụ CUDA cục bộ như sau:

tar xvzf cudnn-9.2-linux-x64-v7.1

sudo cp -P cuda/include/cudnn.h /usr/local/cuda/include

sudo cp -P cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

sudo ldconfigSau khi thiết lập môi trường cho CUDA và cuDNN, hãy làm theo các bước bên dưới để xây dựng thư viện được chia sẻ MXNet từ nguồn -

Step 1- Đầu tiên, chúng ta cần cài đặt các gói tiên quyết. Các phụ thuộc này được yêu cầu trên Ubuntu phiên bản 16.04 trở lên.

sudo apt-get update

sudo apt-get install -y build-essential git ninja-build ccache libopenblas-dev

libopencv-dev cmakeStep 2- Ở bước này, chúng ta sẽ tải mã nguồn MXNet và cấu hình. Trước tiên, hãy để chúng tôi sao chép kho lưu trữ bằng cách sử dụng lệnh sau

git clone –recursive https://github.com/apache/incubator-mxnet.git mxnet

cd mxnet

cp config/linux_gpu.cmake #for build with CUDAStep 3- Bằng cách sử dụng các lệnh sau, bạn có thể xây dựng thư viện chia sẻ lõi MXNet

rm -rf build

mkdir -p build && cd build

cmake -GNinja ..

cmake --build .Two important points regarding the above step is as follows−

Nếu bạn muốn tạo phiên bản Gỡ lỗi, hãy chỉ định như sau:

cmake -DCMAKE_BUILD_TYPE=Debug -GNinja ..Để đặt số lượng công việc biên dịch song song, hãy chỉ định như sau:

cmake --build . --parallel NSau khi bạn xây dựng thành công thư viện chia sẻ lõi MXNet, trong build thư mục trong của bạn MXNet project root, Bạn sẽ thấy libmxnet.so được yêu cầu để cài đặt ràng buộc ngôn ngữ (tùy chọn).

Bộ phận xử lý trung tâm (CPU)

Ở đây, chúng tôi sẽ sử dụng các phương pháp khác nhau cụ thể là Pip, Docker và Nguồn để cài đặt MXNet khi chúng tôi đang sử dụng CPU để xử lý -

Bằng cách sử dụng phương pháp Pip

Bạn có thể sử dụng lệnh sau để cài đặt MXNet trên Linus OS−

pip install mxnetApache MXNet cũng cung cấp các gói pip hỗ trợ MKL-DNN nhanh hơn nhiều khi chạy trên phần cứng intel.

pip install mxnet-mklBằng cách sử dụng Docker

Bạn có thể tìm hình ảnh docker bằng MXNet tại DockerHub, có sẵn tại https://hub.docker.com/u/mxnet. Hãy để chúng tôi kiểm tra các bước dưới đây để cài đặt MXNet bằng cách sử dụng Docker với CPU -

Step 1- Đầu tiên, bằng cách làm theo hướng dẫn cài đặt docker có sẵn tại https://docs.docker.com/engine/install/ubuntu/. Chúng tôi cần cài đặt Docker trên máy của mình.

Step 2- Bằng cách sử dụng lệnh sau, bạn có thể kéo hình ảnh bộ đế MXNet:

$ sudo docker pull mxnet/pythonBây giờ, để xem liệu việc kéo hình ảnh docker mxnet / python có thành công hay không, chúng ta có thể liệt kê các hình ảnh docker như sau:

$ sudo docker imagesĐể có tốc độ suy luận nhanh nhất với MXNet, bạn nên sử dụng MXNet mới nhất với Intel MKL-DNN.

Kiểm tra các lệnh bên dưới -

$ sudo docker pull mxnet/python:1.3.0_cpu_mkl $ sudo docker imagesTừ nguồn

Để xây dựng thư viện được chia sẻ MXNet từ nguồn với CPU, hãy làm theo các bước bên dưới:

Step 1- Đầu tiên, chúng ta cần cài đặt các gói tiên quyết. Các phụ thuộc này được yêu cầu trên Ubuntu phiên bản 16.04 trở lên.

sudo apt-get update

sudo apt-get install -y build-essential git ninja-build ccache libopenblas-dev libopencv-dev cmakeStep 2- Ở bước này chúng ta sẽ tải mã nguồn MXNet và cấu hình. Trước tiên, chúng ta hãy sao chép kho lưu trữ bằng cách sử dụng lệnh sau:

git clone –recursive https://github.com/apache/incubator-mxnet.git mxnet

cd mxnet

cp config/linux.cmake config.cmakeStep 3- Bằng cách sử dụng các lệnh sau, bạn có thể xây dựng thư viện chia sẻ lõi MXNet:

rm -rf build

mkdir -p build && cd build

cmake -GNinja ..

cmake --build .Two important points regarding the above step is as follows−

Nếu bạn muốn xây dựng phiên bản Gỡ lỗi, hãy chỉ định như sau:

cmake -DCMAKE_BUILD_TYPE=Debug -GNinja ..Để đặt số lượng công việc biên dịch song song, hãy chỉ định như sau:

cmake --build . --parallel NSau khi bạn xây dựng thành công thư viện chia sẻ lõi MXNet, trong build trong thư mục gốc dự án MXNet của bạn, bạn sẽ tìm thấy libmxnet.so, được yêu cầu để cài đặt ràng buộc ngôn ngữ (tùy chọn).

Hệ điều hành Mac

Chúng tôi có thể cài đặt MXNet trên MacOS theo những cách sau

Bộ xử lý đồ họa (GPU)

Nếu bạn định xây dựng MXNet trên MacOS với GPU, thì KHÔNG có sẵn phương pháp Pip và Docker. Phương pháp duy nhất trong trường hợp này là xây dựng nó từ nguồn.

Từ nguồn

Để xây dựng thư viện chia sẻ MXNet từ nguồn với GPU, trước tiên chúng ta cần thiết lập môi trường cho CUDA và cuDNN. Bạn cần làm theoNVIDIA CUDA Installation Guide có sẵn tại https://docs.nvidia.com và cuDNN Installation Guide, có sẵn tại https://docs.nvidia.com/deeplearning cho mac OS.

Xin lưu ý rằng vào năm 2019 CUDA đã ngừng hỗ trợ macOS. Trên thực tế, các phiên bản CUDA trong tương lai cũng có thể không hỗ trợ macOS.

Sau khi bạn thiết lập môi trường cho CUDA và cuDNN, hãy làm theo các bước dưới đây để cài đặt MXNet từ nguồn trên OS X (Mac) -

Step 1- Vì chúng ta cần một số phụ thuộc vào OS x, Đầu tiên, chúng ta cần cài đặt các gói tiên quyết.

xcode-select –-install #Install OS X Developer Tools

/usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)" #Install Homebrew

brew install cmake ninja ccache opencv # Install dependenciesChúng tôi cũng có thể xây dựng MXNet mà không cần OpenCV vì opencv là một phụ thuộc tùy chọn.

Step 2- Ở bước này chúng ta sẽ tải mã nguồn MXNet và cấu hình. Trước tiên, hãy để chúng tôi sao chép kho lưu trữ bằng cách sử dụng lệnh sau

git clone –-recursive https://github.com/apache/incubator-mxnet.git mxnet

cd mxnet

cp config/linux.cmake config.cmakeĐối với một GPU hỗ trợ, trước tiên cần phải cài đặt các phụ thuộc CUDA bởi vì khi một người cố gắng tạo một bản dựng hỗ trợ GPU trên một máy không có GPU, bản dựng MXNet không thể tự động phát hiện kiến trúc GPU của bạn. Trong những trường hợp như vậy MXNet sẽ nhắm mục tiêu tất cả các kiến trúc GPU có sẵn.

Step 3- Bằng cách sử dụng các lệnh sau, bạn có thể xây dựng thư viện chia sẻ lõi MXNet

rm -rf build

mkdir -p build && cd build

cmake -GNinja ..

cmake --build .Hai điểm quan trọng liên quan đến bước trên như sau:

Nếu bạn muốn tạo phiên bản Gỡ lỗi, hãy chỉ định như sau:

cmake -DCMAKE_BUILD_TYPE=Debug -GNinja ..Để đặt số lượng công việc biên dịch song song, hãy chỉ định như sau:

cmake --build . --parallel NSau khi bạn xây dựng thành công thư viện chia sẻ lõi MXNet, trong build thư mục trong của bạn MXNet project root, Bạn sẽ thấy libmxnet.dylib, được yêu cầu để cài đặt ràng buộc ngôn ngữ (tùy chọn).

Bộ phận xử lý trung tâm (CPU)

Ở đây, chúng tôi sẽ sử dụng các phương pháp khác nhau cụ thể là Pip, Docker và Nguồn để cài đặt MXNet khi chúng tôi đang sử dụng CPU để xử lý−

Bằng cách sử dụng phương pháp Pip

Bạn có thể sử dụng lệnh sau để cài đặt MXNet trên Hệ điều hành Linus của mình

pip install mxnetBằng cách sử dụng Docker

Bạn có thể tìm hình ảnh docker bằng MXNet tại DockerHub, có sẵn tại https://hub.docker.com/u/mxnet. Hãy để chúng tôi kiểm tra các bước dưới đây để cài đặt MXNet bằng cách sử dụng Docker với CPU−

Step 1- Đầu tiên, bằng cách làm theo docker installation instructions có sẵn tại https://docs.docker.com/docker-for-mac chúng ta cần cài đặt Docker trên máy của mình.

Step 2- Bằng cách sử dụng lệnh sau, bạn có thể kéo hình ảnh bộ đế MXNet

$ docker pull mxnet/pythonBây giờ để xem liệu việc kéo hình ảnh docker mxnet / python có thành công hay không, chúng ta có thể liệt kê các hình ảnh docker như sau−

$ docker imagesĐể có tốc độ suy luận nhanh nhất với MXNet, bạn nên sử dụng MXNet mới nhất với Intel MKL-DNN. Kiểm tra các lệnh bên dưới−

$ docker pull mxnet/python:1.3.0_cpu_mkl

$ docker imagesTừ nguồn

Làm theo các bước dưới đây để cài đặt MXNet từ nguồn trên OS X (Mac) -

Step 1- Vì chúng ta cần một số phụ thuộc vào OS x, trước tiên, chúng ta cần cài đặt các gói điều kiện tiên quyết.

xcode-select –-install #Install OS X Developer Tools

/usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)" #Install Homebrew

brew install cmake ninja ccache opencv # Install dependenciesChúng tôi cũng có thể xây dựng MXNet mà không cần OpenCV vì opencv là một phụ thuộc tùy chọn.

Step 2- Ở bước này chúng ta sẽ tải mã nguồn MXNet và cấu hình. Trước tiên, chúng ta hãy sao chép kho lưu trữ bằng cách sử dụng lệnh sau

git clone –-recursive https://github.com/apache/incubator-mxnet.git mxnet

cd mxnet

cp config/linux.cmake config.cmakeStep 3- Bằng cách sử dụng các lệnh sau, bạn có thể xây dựng thư viện chia sẻ lõi MXNet:

rm -rf build

mkdir -p build && cd build

cmake -GNinja ..

cmake --build .Two important points regarding the above step is as follows−

Nếu bạn muốn tạo phiên bản Gỡ lỗi, hãy chỉ định như sau:

cmake -DCMAKE_BUILD_TYPE=Debug -GNinja ..Để đặt số lượng công việc biên dịch song song, hãy chỉ định như sau:

cmake --build . --parallel NSau khi bạn xây dựng thành công thư viện chia sẻ lõi MXNet, trong build thư mục trong của bạn MXNet project root, Bạn sẽ thấy libmxnet.dylib, được yêu cầu để cài đặt ràng buộc ngôn ngữ (tùy chọn).

HĐH Windows

Để cài đặt MXNet trên Windows, sau đây là các điều kiện tiên quyết−

Yêu cầu hệ thống tối thiểu

Windows 7, 10, Server 2012 R2 hoặc Server 2016

Visual Studio 2015 hoặc 2017 (bất kỳ loại nào)

Python 2.7 hoặc 3.6

pip

Yêu cầu hệ thống được đề xuất

Windows 10, Server 2012 R2 hoặc Server 2016

Visual Studio 2017

Ít nhất một GPU hỗ trợ NVIDIA CUDA

CPU hỗ trợ MKL: bộ xử lý Intel® Xeon®, dòng bộ xử lý Intel® Core ™, bộ xử lý Intel Atom® hoặc bộ xử lý Intel® Xeon Phi ™

Python 2.7 hoặc 3.6

pip

Bộ xử lý đồ họa (GPU)

Bằng cách sử dụng phương pháp Pip−

Nếu bạn định xây dựng MXNet trên Windows với GPU NVIDIA, có hai tùy chọn để cài đặt MXNet có hỗ trợ CUDA với gói Python−

Cài đặt với Hỗ trợ CUDA

Dưới đây là các bước với sự trợ giúp của chúng, chúng ta có thể thiết lập MXNet với CUDA.

Step 1- Trước tiên hãy cài đặt Microsoft Visual Studio 2017 hoặc Microsoft Visual Studio 2015.

Step 2- Tiếp theo, tải và cài đặt NVIDIA CUDA. Bạn nên sử dụng CUDA phiên bản 9.2 hoặc 9.0 vì một số vấn đề với CUDA 9.1 đã được xác định trong quá khứ.

Step 3- Bây giờ, tải xuống và cài đặt NVIDIA_CUDA_DNN.

Step 4- Cuối cùng, bằng cách sử dụng lệnh pip sau, cài đặt MXNet với CUDA−

pip install mxnet-cu92Cài đặt với Hỗ trợ CUDA và MKL

Dưới đây là các bước với sự trợ giúp của chúng, chúng ta có thể thiết lập MXNet với CUDA và MKL.

Step 1- Trước tiên hãy cài đặt Microsoft Visual Studio 2017 hoặc Microsoft Visual Studio 2015.

Step 2- Tiếp theo, tải và cài đặt intel MKL

Step 3- Bây giờ, tải xuống và cài đặt NVIDIA CUDA.

Step 4- Bây giờ, tải xuống và cài đặt NVIDIA_CUDA_DNN.

Step 5- Cuối cùng, bằng cách sử dụng lệnh pip sau, cài đặt MXNet với MKL.

pip install mxnet-cu92mklTừ nguồn

Để xây dựng thư viện lõi MXNet từ nguồn với GPU, chúng tôi có hai tùy chọn sau:

Option 1− Build with Microsoft Visual Studio 2017

Để tự xây dựng và cài đặt MXNet bằng Microsoft Visual Studio 2017, bạn cần có các phụ thuộc sau.

Install/update Microsoft Visual Studio.

Nếu Microsoft Visual Studio chưa được cài đặt trên máy của bạn, trước tiên hãy tải xuống và cài đặt nó.

Nó sẽ nhắc về việc cài đặt Git. Cài đặt nó cũng được.

Nếu Microsoft Visual Studio đã được cài đặt trên máy của bạn nhưng bạn muốn cập nhật nó thì hãy tiến hành bước tiếp theo để sửa đổi cài đặt của bạn. Tại đây, bạn cũng sẽ có cơ hội cập nhật Microsoft Visual Studio.

Làm theo hướng dẫn để mở Trình cài đặt Visual Studio có sẵn tại https://docs.microsoft.com/en-us để sửa đổi các thành phần riêng lẻ.

Trong ứng dụng Visual Studio Installer, cập nhật theo yêu cầu. Sau đó tìm kiếm và kiểm traVC++ 2017 version 15.4 v14.11 toolset và bấm vào Modify.

Bây giờ bằng cách sử dụng lệnh sau, hãy thay đổi phiên bản của Microsoft VS2017 thành v14.11−

"C:\Program Files (x86)\Microsoft Visual Studio\2017\Community\VC\Auxiliary\Build\vcvars64.bat" -vcvars_ver=14.11Tiếp theo, bạn cần tải xuống và cài đặt CMake có sẵn tại https://cmake.org/download/ Nó được khuyến khích sử dụng CMake v3.12.2 có sẵn tại https://cmake.org/download/ vì nó được thử nghiệm với MXNet.

Bây giờ, tải xuống và chạy OpenCV gói có sẵn tại https://sourceforge.net/projects/opencvlibrary/sẽ giải nén một số tệp. Bạn có muốn đặt chúng vào thư mục khác hay không là tùy thuộc vào bạn. Ở đây, chúng ta sẽ sử dụng đường dẫnC:\utils(mkdir C:\utils) làm đường dẫn mặc định của chúng tôi.

Tiếp theo, chúng ta cần đặt biến môi trường OpenCV_DIR trỏ đến thư mục xây dựng OpenCV mà chúng ta vừa giải nén. Đối với dấu nhắc lệnh mở này và nhậpset OpenCV_DIR=C:\utils\opencv\build.

Một điểm quan trọng là nếu bạn chưa cài đặt Intel MKL (Math Kernel Library), bạn có thể cài đặt nó.

Một gói mã nguồn mở khác mà bạn có thể sử dụng là OpenBLAS. Tại đây để biết thêm các hướng dẫn, chúng tôi giả định rằng bạn đang sử dụngOpenBLAS.

Vì vậy, hãy tải xuống OpenBlas gói có sẵn tại https://sourceforge.net và giải nén tệp, đổi tên nó thành OpenBLAS và đặt nó dưới C:\utils.

Tiếp theo, chúng ta cần đặt biến môi trường OpenBLAS_HOME để trỏ đến thư mục OpenBLAS có chứa include và libcác thư mục. Đối với dấu nhắc lệnh mở này và nhậpset OpenBLAS_HOME=C:\utils\OpenBLAS.

Bây giờ, tải xuống và cài đặt CUDA có sẵn tại https://developer.nvidia.com. Lưu ý rằng, nếu bạn đã có CUDA, sau đó đã cài đặt Microsoft VS2017, bạn cần cài đặt lại CUDA ngay bây giờ để có thể nhận các thành phần bộ công cụ CUDA cho tích hợp Microsoft VS2017.

Tiếp theo, bạn cần tải xuống và cài đặt cuDNN.

Tiếp theo, bạn cần tải xuống và cài đặt git tại https://gitforwindows.org/ cũng thế.

Khi bạn đã cài đặt tất cả các phần phụ thuộc bắt buộc, hãy làm theo các bước được cung cấp bên dưới để tạo mã nguồn MXNet−

Step 1- Mở dấu nhắc lệnh trong cửa sổ.

Step 2- Bây giờ, bằng cách sử dụng lệnh sau, tải xuống mã nguồn MXNet từ GitHub:

cd C:\

git clone https://github.com/apache/incubator-mxnet.git --recursiveStep 3- Tiếp theo, xác minh những điều sau−

DCUDNN_INCLUDE and DCUDNN_LIBRARY các biến môi trường đang trỏ đến include thư mục và cudnn.lib tệp vị trí đã cài đặt CUDA của bạn

C:\incubator-mxnet là vị trí của mã nguồn bạn vừa sao chép ở bước trước.

Step 4- Tiếp theo bằng cách sử dụng lệnh sau, tạo một bản dựng directory và cũng đi đến thư mục, chẳng hạn như

mkdir C:\incubator-mxnet\build

cd C:\incubator-mxnet\buildStep 5- Bây giờ, bằng cách sử dụng cmake, hãy biên dịch mã nguồn MXNet như sau−

cmake -G "Visual Studio 15 2017 Win64" -T cuda=9.2,host=x64 -DUSE_CUDA=1 -DUSE_CUDNN=1 -DUSE_NVRTC=1 -DUSE_OPENCV=1 -DUSE_OPENMP=1 -DUSE_BLAS=open -DUSE_LAPACK=1 -DUSE_DIST_KVSTORE=0 -DCUDA_ARCH_LIST=Common -DCUDA_TOOLSET=9.2 -DCUDNN_INCLUDE=C:\cuda\include -DCUDNN_LIBRARY=C:\cuda\lib\x64\cudnn.lib "C:\incubator-mxnet"Step 6- Sau khi CMake hoàn tất thành công, hãy sử dụng lệnh sau để biên dịch mã nguồn MXNet

msbuild mxnet.sln /p:Configuration=Release;Platform=x64 /maxcpucountOption 2: Build with Microsoft Visual Studio 2015

Để tự xây dựng và cài đặt MXNet bằng Microsoft Visual Studio 2015, bạn cần có các phụ thuộc sau.

Cài đặt / cập nhật Microsoft Visual Studio 2015. Yêu cầu tối thiểu để xây dựng MXnet từ nguồn là Cập nhật 3 của Microsoft Visual Studio 2015. Bạn có thể sử dụng Tools -> Extensions and Updates... | Product Updates để nâng cấp nó.

Tiếp theo, bạn cần tải xuống và cài đặt CMake có sẵn tại https://cmake.org/download/. Nó được khuyến khích sử dụngCMake v3.12.2 đó là ở https://cmake.org/download/, bởi vì nó được thử nghiệm với MXNet.

Bây giờ, hãy tải xuống và chạy gói OpenCV có sẵn tại https://excellmedia.dl.sourceforge.netsẽ giải nén một số tệp. Bạn có muốn đặt chúng vào thư mục khác hay không.

Tiếp theo, chúng ta cần đặt biến môi trường OpenCV_DIR để chỉ vào OpenCVxây dựng thư mục mà chúng tôi vừa giải nén. Đối với điều này, hãy mở dấu nhắc lệnh và nhập setOpenCV_DIR=C:\opencv\build\x64\vc14\bin.

Một điểm quan trọng là nếu bạn chưa cài đặt Intel MKL (Math Kernel Library), bạn có thể cài đặt nó.

Một gói mã nguồn mở khác mà bạn có thể sử dụng là OpenBLAS. Tại đây để biết thêm các hướng dẫn, chúng tôi giả định rằng bạn đang sử dụngOpenBLAS.

Vì vậy, hãy tải xuống OpenBLAS gói có sẵn tại https://excellmedia.dl.sourceforge.net và giải nén tệp, đổi tên tệp thành OpenBLAS và đặt nó dưới C: \ utils.

Tiếp theo, chúng ta cần thiết lập biến môi trường OpenBLAS_HOME trỏ đến thư mục OpenBLAS có chứa thư mục include và lib. Bạn có thể tìm thấy thư mục trongC:\Program files (x86)\OpenBLAS\

Lưu ý rằng, nếu bạn đã có CUDA, sau đó đã cài đặt Microsoft VS2015, bạn cần cài đặt lại CUDA ngay bây giờ để có thể nhận các thành phần bộ công cụ CUDA để tích hợp Microsoft VS2017.

Tiếp theo, bạn cần tải xuống và cài đặt cuDNN.

Bây giờ, chúng ta cần Đặt biến môi trường CUDACXX trỏ đến CUDA Compiler(C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v9.1\bin\nvcc.exe ví dụ).

Tương tự, chúng ta cũng cần đặt biến môi trường CUDNN_ROOT để chỉ vào cuDNN thư mục chứa include, lib và bin thư mục (C:\Downloads\cudnn-9.1-windows7-x64-v7\cuda ví dụ).

Khi bạn đã cài đặt tất cả các phần phụ thuộc bắt buộc, hãy làm theo các bước được cung cấp bên dưới để tạo mã nguồn MXNet−

Step 1- Đầu tiên, tải xuống mã nguồn MXNet từ GitHub−

cd C:\

git clone https://github.com/apache/incubator-mxnet.git --recursiveStep 2- Tiếp theo, sử dụng CMake để tạo Visual Studio trong ./build.

Step 3- Bây giờ, trong Visual Studio, chúng ta cần mở tệp giải pháp,.slnvà biên dịch nó. Các lệnh này sẽ tạo ra một thư viện có tên làmxnet.dll bên trong ./build/Release/ or ./build/Debug thư mục

Step 4- Sau khi CMake hoàn tất thành công, hãy sử dụng lệnh sau để biên dịch mã nguồn MXNet

msbuild mxnet.sln /p:Configuration=Release;Platform=x64 /maxcpucountBộ phận xử lý trung tâm (CPU)

Ở đây, chúng tôi sẽ sử dụng các phương pháp khác nhau cụ thể là Pip, Docker và Nguồn để cài đặt MXNet khi chúng tôi đang sử dụng CPU để xử lý−

Bằng cách sử dụng phương pháp Pip

Nếu bạn định xây dựng MXNet trên Windows với CPU, có hai tùy chọn để cài đặt MXNet bằng gói Python−

Install with CPUs

Sử dụng lệnh sau để cài đặt MXNet với CPU với Python−

pip install mxnetInstall with Intel CPUs

Như đã thảo luận ở trên, MXNet có hỗ trợ thử nghiệm cho Intel MKL cũng như MKL-DNN. Sử dụng lệnh sau để cài đặt MXNet với CPU Intel với Python−

pip install mxnet-mklBằng cách sử dụng Docker

Bạn có thể tìm thấy hình ảnh docker với MXNet tại DockerHub, có sẵn tại https://hub.docker.com/u/mxnet Hãy để chúng tôi kiểm tra các bước bên dưới, để cài đặt MXNet bằng cách sử dụng Docker với CPU−

Step 1- Đầu tiên, bằng cách làm theo hướng dẫn cài đặt docker có thể đọc tại https://docs.docker.com/docker-for-mac/install. Chúng tôi cần cài đặt Docker trên máy của mình.

Step 2- Bằng cách sử dụng lệnh sau, bạn có thể kéo hình ảnh bộ đế MXNet

$ docker pull mxnet/pythonBây giờ để xem liệu việc kéo hình ảnh docker mxnet / python có thành công hay không, chúng ta có thể liệt kê các hình ảnh docker như sau−

$ docker imagesĐể có tốc độ suy luận nhanh nhất với MXNet, bạn nên sử dụng MXNet mới nhất với Intel MKL-DNN.

Kiểm tra các lệnh bên dưới−

$ docker pull mxnet/python:1.3.0_cpu_mkl $ docker imagesCài đặt MXNet trên đám mây và thiết bị

Phần này nêu bật cách cài đặt Apache MXNet trên Đám mây và trên các thiết bị. Chúng ta hãy bắt đầu bằng cách tìm hiểu về cách cài đặt MXNet trên đám mây.

Cài đặt MXNet trên đám mây

Bạn cũng có thể tải Apache MXNet trên một số nhà cung cấp đám mây với Graphical Processing Unit (GPU)ủng hộ. Hai loại hỗ trợ khác mà bạn có thể tìm thấy như sau:

- Hỗ trợ kết hợp giữa GPU / CPU cho các trường hợp sử dụng như suy luận có thể mở rộng.

- Hỗ trợ GPU giai thừa với AWS Elastic Inference.

Sau đây là các nhà cung cấp đám mây cung cấp hỗ trợ GPU với máy ảo khác nhau cho Apache MXNet−

Bảng điều khiển Alibaba

Bạn có thể tạo NVIDIA GPU Cloud Virtual Machine (VM) có sẵn tại https://docs.nvidia.com/ngc với Bảng điều khiển Alibaba và sử dụng Apache MXNet.

Dịch vụ web của Amazon

Nó cũng cung cấp hỗ trợ GPU và cung cấp các dịch vụ sau cho Apache MXNet−

Amazon SageMaker

Nó quản lý đào tạo và triển khai các mô hình Apache MXNet.

AWS Deep Learning AMI

Nó cung cấp môi trường Conda được cài đặt sẵn cho cả Python 2 và Python 3 với Apache MXNet, CUDA, cuDNN, MKL-DNN và AWS Elastic Inference.

Đào tạo động trên AWS

Nó cung cấp đào tạo để thiết lập EC2 thủ công thử nghiệm cũng như thiết lập CloudFormation bán tự động.

Bạn có thể dùng NVIDIA VM có sẵn tại https://aws.amazon.com với các dịch vụ web của Amazon.

Nền tảng đám mây của Google

Google cũng đang cung cấp NVIDIA GPU cloud image có sẵn tại https://console.cloud.google.com để làm việc với Apache MXNet.

Microsoft Azure

Microsoft Azure Marketplace cũng đang cung cấp NVIDIA GPU cloud image có sẵn tại https://azuremarketplace.microsoft.com để làm việc với Apache MXNet.

Đám mây Oracle

Oracle cũng đang cung cấp NVIDIA GPU cloud image có sẵn tại https://docs.cloud.oracle.com để làm việc với Apache MXNet.

Bộ phận xử lý trung tâm (CPU)

Apache MXNet hoạt động trên mọi phiên bản chỉ dành cho CPU của nhà cung cấp đám mây. Có nhiều phương pháp khác nhau để cài đặt như

Hướng dẫn cài đặt pip trong Python.

Hướng dẫn Docker.

Tùy chọn cài đặt sẵn như Amazon Web Services cung cấp AWS Deep Learning AMI (có môi trường Conda được cài đặt sẵn cho cả Python 2 và Python 3 với MXNet và MKL-DNN).

Cài đặt MXNet trên thiết bị

Hãy để chúng tôi tìm hiểu cách cài đặt MXNet trên các thiết bị.

Raspberry Pi

Bạn cũng có thể chạy Apache MXNet trên các thiết bị Raspberry Pi 3B vì MXNet cũng hỗ trợ Hệ điều hành dựa trên ARM Respbian. Để chạy MXNet trơn tru trên Raspberry Pi3, bạn nên trang bị thiết bị có RAM hơn 1 GB và thẻ SD với ít nhất 4GB dung lượng trống.

Sau đây là các cách với sự trợ giúp mà bạn có thể xây dựng MXNet cho Raspberry Pi và cài đặt các liên kết Python cho thư viện

Cài đặt nhanh chóng

Bánh xe Python được tạo sẵn có thể được sử dụng trên Raspberry Pi 3B với tính năng Stretch để cài đặt nhanh chóng. Một trong những vấn đề quan trọng với phương pháp này là chúng ta cần cài đặt một số phụ thuộc để Apache MXNet hoạt động.

Cài đặt Docker

Bạn có thể làm theo hướng dẫn cài đặt docker, có sẵn tại https://docs.docker.com/engine/install/ubuntu/để cài đặt Docker trên máy của bạn. Vì mục đích này, chúng tôi cũng có thể cài đặt và sử dụng Phiên bản Cộng đồng (CE).

Bản dựng gốc (từ nguồn)

Để cài đặt MXNet từ nguồn, chúng ta cần làm theo hai bước sau:

Bước 1

Build the shared library from the Apache MXNet C++ source code

Để xây dựng thư viện được chia sẻ trên phiên bản Raspberry Wheezy trở lên, chúng ta cần các phụ thuộc sau:

Git- Bắt buộc phải lấy mã từ GitHub.

Libblas- Nó được yêu cầu cho các phép toán đại số tuyến tính.

Libopencv- Nó được yêu cầu cho các hoạt động liên quan đến thị giác máy tính. Tuy nhiên, nó là tùy chọn nếu bạn muốn tiết kiệm RAM và Dung lượng đĩa của mình.

C++ Compiler- Yêu cầu biên dịch và xây dựng mã nguồn MXNet. Sau đây là các trình biên dịch được hỗ trợ hỗ trợ C ++ 11−

G ++ (phiên bản 4.8 trở lên)

Clang(3.9-6)

Sử dụng các lệnh sau để cài đặt các phần phụ thuộc nêu trên−

sudo apt-get update

sudo apt-get -y install git cmake ninja-build build-essential g++-4.9 c++-4.9 liblapack*

libblas* libopencv*

libopenblas* python3-dev python-dev virtualenvTiếp theo, chúng ta cần sao chép kho mã nguồn MXNet. Đối với điều này, hãy sử dụng lệnh git sau trong thư mục chính của bạn−

git clone https://github.com/apache/incubator-mxnet.git --recursive

cd incubator-mxnetBây giờ, với sự trợ giúp của các lệnh sau, hãy xây dựng thư viện được chia sẻ:

mkdir -p build && cd build

cmake \

-DUSE_SSE=OFF \

-DUSE_CUDA=OFF \

-DUSE_OPENCV=ON \

-DUSE_OPENMP=ON \

-DUSE_MKL_IF_AVAILABLE=OFF \

-DUSE_SIGNAL_HANDLER=ON \

-DCMAKE_BUILD_TYPE=Release \

-GNinja ..

ninja -j$(nproc)Sau khi bạn thực hiện các lệnh trên, nó sẽ bắt đầu quá trình xây dựng sẽ mất vài giờ để hoàn thành. Bạn sẽ nhận được một tệp có tênlibmxnet.so trong thư mục xây dựng.

Bước 2

Install the supported language-specific packages for Apache MXNet

Trong bước này, chúng tôi sẽ cài đặt các ràng buộc MXNet Pythin. Để làm như vậy, chúng ta cần chạy lệnh sau trong thư mục MXNet−

cd python

pip install --upgrade pip

pip install -e .Ngoài ra, với lệnh sau, bạn cũng có thể tạo whl package có thể cài đặt với pip-

ci/docker/runtime_functions.sh build_wheel python/ $(realpath build)Thiết bị NVIDIA Jetson

Bạn cũng có thể chạy Apache MXNet trên Thiết bị NVIDIA Jetson, chẳng hạn như TX2 hoặc là Nanovì MXNet cũng hỗ trợ HĐH dựa trên Ubuntu Arch64. Để chạy mượt mà MXNet trên Thiết bị NVIDIA Jetson, bạn cần phải cài đặt CUDA trên thiết bị Jetson của mình.

Sau đây là các cách với sự trợ giúp mà bạn có thể tạo MXNet cho các thiết bị NVIDIA Jetson:

Bằng cách sử dụng bánh xe pip Jetson MXNet để phát triển Python

Từ nguồn

Tuy nhiên, trước khi xây dựng MXNet từ bất kỳ cách nào được đề cập ở trên, bạn cần cài đặt các phần phụ thuộc sau trên thiết bị Jetson của mình−

Sự phụ thuộc Python

Để sử dụng API Python, chúng ta cần có các phụ thuộc sau:

sudo apt update

sudo apt -y install \

build-essential \

git \

graphviz \

libatlas-base-dev \

libopencv-dev \

python-pip

sudo pip install --upgrade \

pip \

setuptools

sudo pip install \

graphviz==0.8.4 \

jupyter \

numpy==1.15.2Sao chép kho lưu trữ mã nguồn MXNet

Bằng cách sử dụng lệnh git sau trong thư mục chính của bạn, sao chép kho lưu trữ mã nguồn MXNet−

git clone --recursive https://github.com/apache/incubator-mxnet.git mxnetThiết lập các biến môi trường

Thêm phần sau vào của bạn .profile tập tin trong thư mục chính của bạn

export PATH=/usr/local/cuda/bin:$PATH export MXNET_HOME=$HOME/mxnet/

export PYTHONPATH=$MXNET_HOME/python:$PYTHONPATHBây giờ, hãy áp dụng thay đổi ngay lập tức bằng lệnh sau

source .profileĐịnh cấu hình CUDA

Trước khi định cấu hình CUDA, với nvcc, bạn cần kiểm tra phiên bản CUDA đang chạy

nvcc --versionGiả sử, nếu nhiều phiên bản CUDA được cài đặt trên thiết bị hoặc máy tính của bạn và bạn muốn chuyển đổi phiên bản CUDA, hãy sử dụng cách sau và thay thế liên kết tượng trưng thành phiên bản bạn muốn−

sudo rm /usr/local/cuda

sudo ln -s /usr/local/cuda-10.0 /usr/local/cudaLệnh trên sẽ chuyển sang CUDA 10.0, được cài đặt sẵn trên thiết bị NVIDIA Jetson Nano.

Sau khi thực hiện xong các điều kiện tiên quyết nêu trên, bây giờ bạn có thể cài đặt MXNet trên Thiết bị NVIDIA Jetson. Vì vậy, hãy để chúng tôi hiểu các cách mà bạn có thể cài đặt MXNet−

By using a Jetson MXNet pip wheel for Python development- Nếu bạn muốn sử dụng bánh xe Python đã chuẩn bị, hãy tải phần sau xuống Jetson của bạn và chạy nó−

MXNet 1.4.0 (cho Python 3) có sẵn tại https://docs.docker.com

MXNet 1.4.0 (cho Python 2) có sẵn tại https://docs.docker.com

Bản dựng gốc (từ nguồn)

Để cài đặt MXNet từ nguồn, chúng ta cần làm theo hai bước sau:

Bước 1

Build the shared library from the Apache MXNet C++ source code

Để xây dựng thư viện được chia sẻ từ mã nguồn Apache MXNet C ++, bạn có thể sử dụng phương pháp Docker hoặc thực hiện theo cách thủ công−

Phương pháp Docker

Trong phương pháp này, trước tiên bạn cần cài đặt Docker và có thể chạy nó mà không cần sudo (cũng được giải thích trong các bước trước). Sau khi hoàn tất, hãy chạy phần sau để thực hiện biên dịch chéo qua Docker−

$MXNET_HOME/ci/build.py -p jetsonThủ công

Trong phương pháp này, bạn cần chỉnh sửa Makefile (với lệnh bên dưới) để cài đặt MXNet với các ràng buộc CUDA để tận dụng các đơn vị Xử lý Đồ họa (GPU) trên các thiết bị NVIDIA Jetson:

cp $MXNET_HOME/make/crosscompile.jetson.mk config.mkSau khi chỉnh sửa Makefile, bạn cần chỉnh sửa tệp config.mk để thực hiện một số thay đổi bổ sung cho thiết bị NVIDIA Jetson.

Đối với điều này, hãy cập nhật các cài đặt sau

Cập nhật đường dẫn CUDA: USE_CUDA_PATH = / usr / local / cuda

Thêm -gencode Arch = compute-63, code = sm_62 vào cài đặt CUDA_ARCH.

Cập nhật cài đặt NVCC: NVCCFLAGS: = -m64

Bật OpenCV: USE_OPENCV = 1

Bây giờ để đảm bảo rằng MXNet xây dựng với khả năng tăng tốc chính xác thấp ở cấp phần cứng của Pascal, chúng ta cần chỉnh sửa Mshadow Makefile như sau:

MSHADOW_CFLAGS += -DMSHADOW_USE_PASCAL=1Cuối cùng, với sự trợ giúp của lệnh sau, bạn có thể tạo thư viện Apache MXNet hoàn chỉnh−

cd $MXNET_HOME make -j $(nproc)Sau khi bạn thực hiện các lệnh trên, nó sẽ bắt đầu quá trình xây dựng sẽ mất vài giờ để hoàn thành. Bạn sẽ nhận được một tệp có tênlibmxnet.so bên trong mxnet/lib directory.

Bước 2

Install the Apache MXNet Python Bindings

Trong bước này, chúng tôi sẽ cài đặt các liên kết MXNet Python. Để làm như vậy, chúng ta cần chạy lệnh sau trong thư mục MXNet−

cd $MXNET_HOME/python

sudo pip install -e .Sau khi thực hiện xong các bước trên, bây giờ bạn đã sẵn sàng chạy MXNet trên các thiết bị NVIDIA Jetson TX2 hoặc Nano của mình. Nó có thể được xác minh bằng lệnh sau

import mxnet

mxnet.__version__Nó sẽ trả về số phiên bản nếu mọi thứ hoạt động bình thường.

Để hỗ trợ việc nghiên cứu và phát triển các ứng dụng Deep Learning trên nhiều lĩnh vực, Apache MXNet cung cấp cho chúng ta một hệ sinh thái phong phú gồm các bộ công cụ, thư viện và nhiều hơn nữa. Hãy để chúng tôi khám phá chúng -

Bộ dụng cụ

Sau đây là một số bộ công cụ quan trọng và được sử dụng nhiều nhất do MXNet cung cấp -

GluonCV

Như tên của nó GluonCV là một bộ công cụ Gluon dành cho thị giác máy tính được cung cấp bởi MXNet. Nó cung cấp việc triển khai các thuật toán DL (Deep Learning) hiện đại nhất trong thị giác máy tính (CV). Với sự trợ giúp của các kỹ sư, nhà nghiên cứu và sinh viên của bộ công cụ GluonCV có thể xác nhận các ý tưởng mới và tìm hiểu CV một cách dễ dàng.

Dưới đây là một số features of GluonCV -

Nó đào tạo các tập lệnh để tái tạo các kết quả hiện đại được báo cáo trong nghiên cứu mới nhất.

Hơn 170+ mô hình chất lượng cao.

Nắm bắt mô hình phát triển linh hoạt.

GluonCV rất dễ tối ưu hóa. Chúng tôi có thể triển khai nó mà không cần giữ lại khung DL nặng.

Nó cung cấp các API được thiết kế cẩn thận giúp giảm bớt sự phức tạp khi triển khai.

Sự đóng góp cho cộng đồng.

Cách triển khai dễ hiểu.

Sau đây là supported applications bởi bộ công cụ GluonCV:

Phân loại hình ảnh

Phát hiện đối tượng

Phân đoạn ngữ nghĩa

Phân đoạn phiên bản

Ước tính tư thế

Nhận dạng hành động video

Chúng ta có thể cài đặt GluonCV bằng cách sử dụng pip như sau:

pip install --upgrade mxnet gluoncvGluonNLP

Như tên của nó, GluonNLP là một bộ công cụ Gluon để xử lý ngôn ngữ tự nhiên (NLP) được cung cấp bởi MXNet. Nó cung cấp việc triển khai các mô hình DL (Học sâu) tiên tiến trong NLP.

Với sự trợ giúp của các kỹ sư, nhà nghiên cứu và sinh viên bộ công cụ GluonNLP có thể xây dựng các khối cho mô hình và đường ống dẫn dữ liệu văn bản. Dựa trên các mô hình này, họ có thể nhanh chóng tạo mẫu cho các ý tưởng và sản phẩm nghiên cứu.

Dưới đây là một số tính năng của GluonNLP:

Nó đào tạo các tập lệnh để tái tạo các kết quả hiện đại được báo cáo trong nghiên cứu mới nhất.

Tập hợp các mô hình được đào tạo trước cho các nhiệm vụ NLP phổ biến.

Nó cung cấp các API được thiết kế cẩn thận giúp giảm bớt sự phức tạp khi triển khai.

Sự đóng góp cho cộng đồng.

Nó cũng cung cấp các hướng dẫn để giúp bạn bắt đầu với các nhiệm vụ NLP mới.

Sau đây là các tác vụ NLP mà chúng ta có thể thực hiện với bộ công cụ GluonNLP -

Nhúng từ

Mô hình ngôn ngữ

Dịch máy

Phân loại văn bản

Phân tích cảm xúc

Suy luận ngôn ngữ tự nhiên

Tạo văn bản

Phân tích cú pháp phụ thuộc

Nhận dạng đối tượng được đặt tên

Phân loại ý định và ghi nhãn vị trí

Chúng ta có thể cài đặt GluonNLP bằng cách sử dụng pip như sau:

pip install --upgrade mxnet gluonnlpGluonTS

Như tên của nó, GluonTS là một bộ công cụ Gluon để Lập mô hình chuỗi thời gian xác suất được cung cấp bởi MXNet.

Nó cung cấp các tính năng sau:

Các mô hình học sâu hiện đại (SOTA) sẵn sàng được đào tạo.

Các tiện ích để tải cũng như lặp qua các tập dữ liệu chuỗi thời gian.

Các khối xây dựng để xác định mô hình của riêng bạn.

Với sự trợ giúp của các kỹ sư bộ công cụ GluonTS, các nhà nghiên cứu và sinh viên có thể đào tạo và đánh giá bất kỳ mô hình tích hợp nào trên dữ liệu của riêng họ, nhanh chóng thử nghiệm các giải pháp khác nhau và đưa ra giải pháp cho các nhiệm vụ chuỗi thời gian của họ.

Họ cũng có thể sử dụng các khối xây dựng và trừu tượng được cung cấp để tạo các mô hình chuỗi thời gian tùy chỉnh và nhanh chóng đánh giá chúng theo các thuật toán cơ sở.

Chúng ta có thể cài đặt GluonTS bằng cách sử dụng pip như sau:

pip install gluontsGluonFR

Như tên của nó, nó là một bộ công cụ Apache MXNet Gluon cho FR (Nhận dạng khuôn mặt). Nó cung cấp các tính năng sau:

Mô hình học sâu hiện đại (SOTA) trong nhận dạng khuôn mặt.

Việc triển khai SoftmaxCrossEntropyLoss, ArcLoss, TripletLoss, RingLoss, CosLoss / AMsoftmax, L2-Softmax, A-Softmax, CenterLoss, ContrastiveLoss và LGM Loss, v.v.

Để cài đặt Gluon Face, chúng ta cần Python 3.5 trở lên. Trước tiên, chúng ta cũng cần cài đặt GluonCV và MXNet như sau:

pip install gluoncv --pre

pip install mxnet-mkl --pre --upgrade

pip install mxnet-cuXXmkl --pre –upgrade # if cuda XX is installedKhi bạn đã cài đặt các phụ thuộc, bạn có thể sử dụng lệnh sau để cài đặt GluonFR:

From Source

pip install git+https://github.com/THUFutureLab/gluon-face.git@masterPip

pip install gluonfrHệ sinh thái

Bây giờ chúng ta hãy khám phá các thư viện, gói và khuôn khổ phong phú của MXNet -

Huấn luyện viên RL

Coach, một khung học tập củng cố Python (RL) được tạo bởi phòng thí nghiệm AI của Intel. Nó cho phép thử nghiệm dễ dàng với các thuật toán RL hiện đại. Coach RL hỗ trợ Apache MXNet như một phần mềm hỗ trợ và cho phép tích hợp đơn giản môi trường mới để giải quyết.

Để mở rộng và sử dụng lại các thành phần hiện có một cách dễ dàng, Coach RL đã tách rất tốt các thành phần học tăng cường cơ bản như thuật toán, môi trường, kiến trúc NN, chính sách khám phá.

Sau đây là các tác nhân và thuật toán được hỗ trợ cho khung Coach RL:

Đại lý tối ưu hóa giá trị

Mạng Q sâu (DQN)

Mạng Double Deep Q (DDQN)

Dueling Q Mạng

Monte Carlo hỗn hợp (MMC)

Học tập lợi thế liên tục (PAL)

Mạng Q sâu Categorical (C51)

Hồi quy lượng tử Deep Q Network (QR-DQN)

Học N-Step Q

Kiểm soát giai đoạn thần kinh (NEC)

Chức năng lợi thế chuẩn hóa (NAF)

Rainbow

Đại lý tối ưu hóa chính sách

Thành viên chính sách (PG)

Diễn viên-phê bình lợi thế không đồng bộ (A3C)

Trọng tài chính sách xác định sâu (DDPG)

Tối ưu hóa chính sách gần (PPO)

Tối ưu hóa chính sách gần đã được cắt bớt (CPPO)

Ước tính lợi thế chung (GAE)

Mẫu-Phê bình diễn viên hiệu quả với phát lại kinh nghiệm (ACER)

Diễn viên mềm-Phê bình (SAC)

Dốc chính sách xác định sâu đôi bị trì hoãn (TD3)

Tổng đại lý

Dự đoán tương lai trực tiếp (DFP)

Đại lý học bắt chước

Nhân bản hành vi (BC)

Học bắt chước có điều kiện

Tác nhân học tập củng cố thứ bậc

Nhà phê bình diễn viên phân cấp (HAC)

Thư viện đồ thị sâu

Thư viện đồ thị sâu (DGL), được phát triển bởi nhóm NYU và AWS, Thượng Hải, là một gói Python cung cấp các triển khai dễ dàng của Mạng thần kinh đồ thị (GNN) trên MXNet. Nó cũng cung cấp khả năng triển khai GNN dễ dàng trên các thư viện học sâu hiện có khác như PyTorch, Gluon, v.v.

Thư viện Deep Graph là một phần mềm miễn phí. Nó có sẵn trên tất cả các bản phân phối Linux sau Ubuntu 16.04, macOS X và Windows 7 trở lên. Nó cũng yêu cầu phiên bản Python 3.5 trở lên.

Sau đây là các tính năng của DGL -

No Migration cost - Không có chi phí di chuyển khi sử dụng DGL vì nó được xây dựng trên các khuôn khổ DL phổ biến.

Message Passing- DGL cung cấp khả năng truyền thông điệp và nó có khả năng kiểm soát linh hoạt đối với nó. Việc truyền thông báo có phạm vi từ các hoạt động cấp thấp như gửi dọc theo các cạnh đã chọn đến kiểm soát cấp cao như cập nhật tính năng trên toàn đồ thị.

Smooth Learning Curve - Nó khá dễ dàng để học và sử dụng DGL vì các chức năng mạnh mẽ do người dùng định nghĩa rất linh hoạt cũng như dễ sử dụng.

Transparent Speed Optimization - DGL cung cấp tối ưu hóa tốc độ minh bạch bằng cách thực hiện các phép tính tự động và nhân ma trận thưa thớt.

High performance - Để đạt được hiệu quả tối đa, DGL tự động đào tạo hàng loạt DNN (mạng nơ ron sâu) trên một hoặc nhiều đồ thị với nhau.

Easy & friendly interface - DGL cung cấp cho chúng ta giao diện dễ dàng và thân thiện để truy cập tính năng cạnh cũng như thao tác cấu trúc đồ thị.

InsightFace

InsightFace, Bộ công cụ học sâu dành cho Phân tích khuôn mặt cung cấp việc triển khai thuật toán phân tích khuôn mặt SOTA (hiện đại) trong thị giác máy tính do MXNet cung cấp. Nó cung cấp -

Bộ mô hình lớn chất lượng cao được đào tạo trước.

Các kịch bản đào tạo hiện đại (SOTA).

InsightFace rất dễ tối ưu hóa. Chúng tôi có thể triển khai nó mà không cần giữ lại khung DL nặng.

Nó cung cấp các API được thiết kế cẩn thận giúp giảm bớt sự phức tạp khi triển khai.

Các khối xây dựng để xác định mô hình của riêng bạn.

Chúng ta có thể cài đặt InsightFace bằng cách sử dụng pip như sau:

pip install --upgrade insightfaceXin lưu ý rằng trước khi cài đặt InsightFace, hãy cài đặt đúng gói MXNet theo cấu hình hệ thống của bạn.

Keras-MXNet

Như chúng ta biết rằng Keras là một API Mạng Nơ-ron (NN) cấp cao được viết bằng Python, Keras-MXNet cung cấp cho chúng ta một hỗ trợ phụ trợ cho Keras. Nó có thể chạy trên khung công tác Apache MXNet DL hiệu suất cao và có thể mở rộng.

Các tính năng của Keras-MXNet được đề cập dưới đây:

Cho phép người dùng tạo mẫu dễ dàng, mượt mà và nhanh chóng. Tất cả đều xảy ra thông qua tính thân thiện với người dùng, tính mô-đun và khả năng mở rộng.

Hỗ trợ cả CNN (Mạng thần kinh chuyển đổi) và RNN (Mạng thần kinh định kỳ) cũng như sự kết hợp của cả hai.

Chạy hoàn hảo trên cả Bộ xử lý trung tâm (CPU) và Bộ xử lý đồ họa (GPU).

Có thể chạy trên một hoặc nhiều GPU.

Để làm việc với chương trình phụ trợ này, trước tiên bạn cần cài đặt keras-mxnet như sau:

pip install keras-mxnetBây giờ, nếu bạn đang sử dụng GPU, hãy cài đặt MXNet với hỗ trợ CUDA 9 như sau:

pip install mxnet-cu90Nhưng nếu bạn chỉ sử dụng CPU thì hãy cài đặt MXNet cơ bản như sau:

pip install mxnetMXBoard

MXBoard là công cụ ghi nhật ký, được viết bằng Python, được sử dụng để ghi lại các khung dữ liệu MXNet và hiển thị trong TensorBoard. Nói cách khác, MXBoard có nghĩa là tuân theo API tensorboard-pytorch. Nó hỗ trợ hầu hết các kiểu dữ liệu trong TensorBoard.

Một số trong số chúng được đề cập dưới đây -

Graph

Scalar

Histogram

Embedding

Image

Text

Audio

Đường cong thu hồi chính xác

MXFusion

MXFusion là một thư viện lập trình xác suất theo mô-đun với tính năng học sâu. MXFusion cho phép chúng tôi khai thác triệt để tính mô-đun, đây là một tính năng chính của thư viện học sâu, để lập trình xác suất. Nó đơn giản để sử dụng và cung cấp cho người dùng một giao diện thuận tiện để thiết kế các mô hình xác suất và áp dụng chúng vào các bài toán trong thế giới thực.

MXFusion được xác minh trên Python phiên bản 3.4 trở lên trên MacOS và Linux OS. Để cài đặt MXFusion, trước tiên chúng ta cần cài đặt các phần phụ thuộc sau:

MXNet> = 1,3

Networkx> = 2.1

Với sự trợ giúp của lệnh pip sau, bạn có thể cài đặt MXFusion -

pip install mxfusionTVM

Apache TVM, một ngăn xếp trình biên dịch học sâu mã nguồn mở end-to-end dành cho phần cứng-phụ trợ như CPU, GPU và các bộ tăng tốc chuyên dụng, nhằm mục đích lấp đầy khoảng cách giữa khung học sâu tập trung vào năng suất và phần cứng phụ trợ phần cứng theo định hướng hiệu suất . Với bản phát hành mới nhất MXNet 1.6.0, người dùng có thể tận dụng Apache (đang ấp ủ) TVM để triển khai các hạt nhân toán tử hiệu suất cao bằng ngôn ngữ lập trình Python.

Apache TVM thực sự bắt đầu như một dự án nghiên cứu tại nhóm SAMPL của Trường Khoa học Máy tính & Kỹ thuật Paul G. Allen, Đại học Washington và bây giờ nó là một nỗ lực đang được ấp ủ tại Tổ chức Phần mềm Apache (ASF) được điều hành bởi một OSC ( cộng đồng mã nguồn mở) liên quan đến nhiều ngành cũng như các tổ chức học thuật theo cách Apache.

Sau đây là các tính năng chính của Apache (ươm tạo) TVM:

Đơn giản hóa quy trình phát triển dựa trên C ++ trước đây.

Cho phép chia sẻ cùng một triển khai trên nhiều phần cứng phụ trợ như CPU, GPU, v.v.

TVM cung cấp việc biên dịch các mô hình DL trong nhiều khuôn khổ khác nhau như Kears, MXNet, PyTorch, Tensorflow, CoreML, DarkNet thành các mô-đun có thể triển khai tối thiểu trên các phần cứng phụ trợ đa dạng.

Nó cũng cung cấp cho chúng tôi cơ sở hạ tầng để tự động tạo và tối ưu hóa các nhà khai thác tensor với hiệu suất tốt hơn.

XFer

Xfer, một khung học tập chuyển giao, được viết bằng Python. Về cơ bản, nó cần có một mô hình MXNet và đào tạo một mô hình meta hoặc sửa đổi mô hình cho một tập dữ liệu mục tiêu mới.

Nói một cách dễ hiểu, Xfer là một thư viện Python cho phép người dùng truyền nhanh chóng và dễ dàng kiến thức được lưu trữ trong DNN (mạng nơ ron sâu).

Xfer có thể được sử dụng -

Đối với việc phân loại dữ liệu có định dạng số tùy ý.

Đối với các trường hợp phổ biến của hình ảnh hoặc dữ liệu văn bản.

Là một đường ống gửi thư rác từ việc trích xuất các tính năng để đào tạo một repurposer (một đối tượng thực hiện phân loại trong nhiệm vụ đích).

Sau đây là các tính năng của Xfer:

Hiệu quả tài nguyên

Hiệu quả dữ liệu

Dễ dàng truy cập vào mạng nơ-ron

Mô hình không chắc chắn

Tạo mẫu nhanh

Các tiện ích để trích xuất tính năng từ NN

Chương này sẽ giúp bạn hiểu về kiến trúc hệ thống MXNet. Chúng ta hãy bắt đầu bằng cách tìm hiểu về Mô-đun MXNet.

Mô-đun MXNet

Sơ đồ dưới đây là kiến trúc hệ thống MXNet và nó cho thấy các mô-đun và thành phần chính của MXNet modules and their interaction.

Trong sơ đồ trên -

Các mô-đun trong hộp màu xanh lam là User Facing Modules.

Các mô-đun trong hộp màu xanh lá cây là System Modules.

Mũi tên đặc thể hiện sự phụ thuộc cao, tức là phụ thuộc nhiều vào giao diện.

Mũi tên chấm biểu thị sự phụ thuộc ánh sáng, tức là Cấu trúc dữ liệu được sử dụng để thuận tiện và nhất quán giao diện. Trong thực tế, nó có thể được thay thế bằng các lựa chọn thay thế.

Hãy để chúng tôi thảo luận thêm về mô-đun hệ thống và giao diện người dùng.

Mô-đun giao diện người dùng

Các mô-đun hướng tới người dùng như sau:

NDArray- Nó cung cấp các chương trình mệnh lệnh linh hoạt cho Apache MXNet. Chúng là mảng n chiều động và không đồng bộ.

KVStore- Nó hoạt động như một giao diện để đồng bộ tham số hiệu quả. Trong KVStore, KV là viết tắt của Key-Value. Vì vậy, nó là một giao diện cửa hàng khóa-giá trị.

Data Loading (IO) - Mô-đun hướng về người dùng này được sử dụng để tải và tăng dữ liệu phân tán hiệu quả.

Symbol Execution- Nó là một trình thực thi đồ thị biểu tượng tĩnh. Nó cung cấp hiệu quả thực thi và tối ưu hóa đồ thị biểu tượng.

Symbol Construction - Mô-đun hướng về người dùng này cung cấp cho người dùng một cách để xây dựng một đồ thị tính toán tức là cấu hình mạng.

Mô-đun hệ thống

Các mô-đun hệ thống như sau:

Storage Allocator - Mô-đun hệ thống này, như tên cho thấy, phân bổ và tái chế các khối bộ nhớ một cách hiệu quả trên máy chủ, tức là CPU và các thiết bị khác nhau tức là GPU.

Runtime Dependency Engine - Lịch trình mô-đun công cụ phụ thuộc thời gian chạy cũng như thực hiện các hoạt động theo sự phụ thuộc đọc / ghi của chúng.

Resource Manager - Mô-đun hệ thống Quản lý tài nguyên (RM) quản lý các tài nguyên toàn cầu như trình tạo số ngẫu nhiên và không gian thời gian.

Operator - Mô-đun hệ thống toán tử bao gồm tất cả các toán tử xác định tính toán chuyển tiếp và gradient tĩnh tức là sự lan truyền ngược.

Tại đây, các thành phần hệ thống trong Apache MXNet được giải thích chi tiết. Đầu tiên, chúng ta sẽ nghiên cứu về công cụ thực thi trong MXNet.

Công cụ thực thi

Công cụ thực thi của Apache MXNet rất linh hoạt. Chúng tôi có thể sử dụng nó cho việc học sâu cũng như bất kỳ vấn đề nào về miền cụ thể: thực thi một loạt các hàm theo sau sự phụ thuộc của chúng. Nó được thiết kế theo cách mà các hàm có phụ thuộc được tuần tự hóa trong khi các hàm không có phụ thuộc có thể được thực thi song song.

Giao diện cốt lõi

API được cung cấp bên dưới là giao diện cốt lõi cho công cụ thực thi của Apache MXNet -

virtual void PushSync(Fn exec_fun, Context exec_ctx,

std::vector<VarHandle> const& const_vars,

std::vector<VarHandle> const& mutate_vars) = 0;API trên có những điều sau:

exec_fun - API giao diện cốt lõi của MXNet cho phép chúng ta đẩy hàm có tên là execute_fun, cùng với thông tin ngữ cảnh và các phụ thuộc của nó, tới công cụ thực thi.

exec_ctx - Thông tin ngữ cảnh mà trong đó hàm execute_fun nói trên sẽ được thực thi.

const_vars - Đây là các biến mà hàm đọc từ đó.

mutate_vars - Đây là những biến sẽ được sửa đổi.

Công cụ thực thi cung cấp cho người dùng sự đảm bảo rằng việc thực thi bất kỳ hai hàm nào sửa đổi một biến chung được tuần tự hóa theo thứ tự đẩy của chúng.

Chức năng

Sau đây là loại chức năng của công cụ thực thi của Apache MXNet:

using Fn = std::function<void(RunContext)>;Trong hàm trên, RunContextchứa thông tin thời gian chạy. Thông tin thời gian chạy phải được xác định bởi công cụ thực thi. Cú pháp củaRunContext như sau

struct RunContext {

// stream pointer which could be safely cast to

// cudaStream_t* type

void *stream;

};Dưới đây là một số điểm quan trọng về các chức năng của công cụ thực thi:

Tất cả các chức năng được thực thi bởi các luồng nội bộ của công cụ thực thi MXNet.

Sẽ không tốt nếu đẩy chức năng chặn đến công cụ thực thi vì cùng với đó, chức năng sẽ chiếm luồng thực thi và cũng sẽ làm giảm tổng thông lượng.

Đối với MXNet này, cung cấp một hàm không đồng bộ khác như sau:

using Callback = std::function<void()>;

using AsyncFn = std::function<void(RunContext, Callback)>;Trong này AsyncFn hàm, chúng ta có thể chuyển phần nặng của các luồng của chúng ta, nhưng bộ máy thực thi không coi hàm đã hoàn thành cho đến khi chúng ta gọi callback chức năng.

Bối cảnh

Trong Context, chúng ta có thể chỉ định ngữ cảnh của hàm sẽ được thực thi bên trong. Điều này thường bao gồm những điều sau:

Cho dù chức năng sẽ được chạy trên CPU hay GPU.

Nếu chúng tôi chỉ định GPU trong Ngữ cảnh, thì GPU nào sẽ sử dụng.

Có một sự khác biệt rất lớn giữa Context và RunContext. Ngữ cảnh có loại thiết bị và id thiết bị, trong khi RunContext có thông tin chỉ có thể được quyết định trong thời gian chạy.

VarHandle

VarHandle, được sử dụng để chỉ định các phụ thuộc của các hàm, giống như một mã thông báo (đặc biệt được cung cấp bởi công cụ thực thi) mà chúng ta có thể sử dụng để đại diện cho các tài nguyên bên ngoài mà hàm có thể sửa đổi hoặc sử dụng.

Nhưng câu hỏi đặt ra, tại sao chúng ta cần sử dụng VarHandle? Đó là bởi vì, công cụ Apache MXNet được thiết kế để tách khỏi các mô-đun MXNet khác.

Sau đây là một số điểm quan trọng về VarHandle -

Nó nhẹ, do đó, để tạo, xóa hoặc sao chép một biến sẽ tốn ít chi phí vận hành.

Chúng ta cần chỉ định các biến bất biến, tức là các biến sẽ được sử dụng trong const_vars.

Chúng ta cần chỉ định các biến có thể thay đổi, tức là các biến sẽ được sửa đổi trong mutate_vars.

Quy tắc được sử dụng bởi công cụ thực thi để giải quyết sự phụ thuộc giữa các hàm là việc thực thi hai hàm bất kỳ khi một trong số chúng sửa đổi ít nhất một biến chung được tuần tự hóa theo thứ tự đẩy của chúng.

Để tạo một biến mới, chúng ta có thể sử dụng NewVar() API.

Để xóa một biến, chúng ta có thể sử dụng PushDelete API.

Hãy để chúng tôi hiểu cách hoạt động của nó với một ví dụ đơn giản -

Giả sử nếu ta có hai hàm là F1 và F2 và chúng đều đồng biến là V2. Trong trường hợp đó, F2 được đảm bảo thực hiện sau F1 nếu F2 được đẩy sau F1. Mặt khác, nếu F1 và F2 đều sử dụng V2 thì thứ tự thực hiện thực tế của chúng có thể là ngẫu nhiên.

Đẩy và chờ

Push và wait là hai API hữu ích hơn của công cụ thực thi.

Sau đây là hai tính năng quan trọng của Push API:

Tất cả các API đẩy là không đồng bộ, có nghĩa là lệnh gọi API ngay lập tức trả về bất kể chức năng được đẩy đã kết thúc hay chưa.

API đẩy không an toàn cho luồng, có nghĩa là chỉ một luồng nên thực hiện lệnh gọi API công cụ tại một thời điểm.

Bây giờ nếu chúng ta nói về Wait API, các điểm sau thể hiện nó:

Nếu người dùng muốn đợi một chức năng cụ thể kết thúc, họ nên bao gồm một hàm gọi lại trong bao đóng. Sau khi được bao gồm, hãy gọi hàm ở cuối hàm.

Mặt khác, nếu người dùng muốn đợi tất cả các hàm liên quan đến một biến nào đó kết thúc, họ nên sử dụng WaitForVar(var) API.

Nếu ai đó muốn đợi tất cả các chức năng được đẩy kết thúc, hãy sử dụng WaitForAll () API.

Được sử dụng để chỉ định các phụ thuộc của các hàm, giống như một mã thông báo.

Các nhà khai thác

Toán tử trong Apache MXNet là một lớp chứa logic tính toán thực tế cũng như thông tin bổ trợ và hỗ trợ hệ thống thực hiện tối ưu hóa.

Giao diện điều hành

Forward là giao diện toán tử cốt lõi có cú pháp như sau:

virtual void Forward(const OpContext &ctx,

const std::vector<TBlob> &in_data,

const std::vector<OpReqType> &req,

const std::vector<TBlob> &out_data,

const std::vector<TBlob> &aux_states) = 0;Cấu trúc của OpContext, được định nghĩa trong Forward() là như sau:

struct OpContext {

int is_train;

RunContext run_ctx;

std::vector<Resource> requested;

}Các OpContextmô tả trạng thái của người vận hành (cho dù đang trong giai đoạn chạy tàu hay chạy thử), thiết bị nào mà người vận hành nên được chạy và cả các tài nguyên được yêu cầu. hai API hữu ích hơn của công cụ thực thi.

Từ trên Forward giao diện cốt lõi, chúng ta có thể hiểu các tài nguyên được yêu cầu như sau:

in_data và out_data đại diện cho đầu vào và đầu ra tensors.

req biểu thị cách kết quả tính toán được ghi vào out_data.

Các OpReqType có thể được định nghĩa là -

enum OpReqType {

kNullOp,

kWriteTo,

kWriteInplace,

kAddTo

};Như thể là Forward , chúng tôi có thể tùy chọn triển khai Backward giao diện như sau -

virtual void Backward(const OpContext &ctx,

const std::vector<TBlob> &out_grad,

const std::vector<TBlob> &in_data,

const std::vector<TBlob> &out_data,

const std::vector<OpReqType> &req,

const std::vector<TBlob> &in_grad,

const std::vector<TBlob> &aux_states);Các nhiệm vụ khác nhau

Operator giao diện cho phép người dùng thực hiện các tác vụ sau:

Người dùng có thể chỉ định các bản cập nhật tại chỗ và có thể giảm chi phí phân bổ bộ nhớ

Để làm cho nó rõ ràng hơn, người dùng có thể ẩn một số đối số nội bộ khỏi Python.

Người dùng có thể xác định mối quan hệ giữa các tensor và tensors đầu ra.

Để thực hiện tính toán, người dùng có thể có thêm không gian tạm thời từ hệ thống.

Thuộc tính nhà điều hành

Như chúng ta đã biết rằng trong mạng nơ-ron hợp hiến (CNN), một tích chập có một số cách triển khai. Để đạt được hiệu suất tốt nhất từ chúng, chúng tôi có thể muốn chuyển đổi giữa một số phức hợp đó.

Đó là lý do, Apache MXNet tách giao diện ngữ nghĩa của nhà điều hành khỏi giao diện thực thi. Sự tách biệt này được thực hiện dưới dạngOperatorProperty lớp bao gồm các lớp sau

InferShape - Giao diện InferShape có hai mục đích như dưới đây:

Mục đích đầu tiên là cho hệ thống biết kích thước của mỗi tensor đầu vào và đầu ra để không gian có thể được phân bổ trước Forward và Backward gọi.

Mục đích thứ hai là thực hiện kiểm tra kích thước để đảm bảo rằng không có lỗi trước khi chạy.

Cú pháp được đưa ra dưới đây:

virtual bool InferShape(mxnet::ShapeVector *in_shape,

mxnet::ShapeVector *out_shape,

mxnet::ShapeVector *aux_shape) const = 0;Request Resource- Điều gì sẽ xảy ra nếu hệ thống của bạn có thể quản lý không gian làm việc tính toán cho các hoạt động như cudnnConvolutionForward? Hệ thống của bạn có thể thực hiện các tối ưu hóa chẳng hạn như tái sử dụng không gian và nhiều hơn nữa. Ở đây, MXNet dễ dàng đạt được điều này với sự trợ giúp của hai giao diện sau:

virtual std::vector<ResourceRequest> ForwardResource(

const mxnet::ShapeVector &in_shape) const;

virtual std::vector<ResourceRequest> BackwardResource(

const mxnet::ShapeVector &in_shape) const;Nhưng, điều gì sẽ xảy ra nếu ForwardResource và BackwardResourcetrả về mảng không trống? Trong trường hợp đó, hệ thống cung cấp các tài nguyên tương ứng thông quactx tham số trong Forward và Backward giao diện của Operator.

Backward dependency - Apache MXNet có hai chữ ký toán tử khác nhau sau đây để đối phó với sự phụ thuộc ngược -

void FullyConnectedForward(TBlob weight, TBlob in_data, TBlob out_data);

void FullyConnectedBackward(TBlob weight, TBlob in_data, TBlob out_grad, TBlob in_grad);

void PoolingForward(TBlob in_data, TBlob out_data);

void PoolingBackward(TBlob in_data, TBlob out_data, TBlob out_grad, TBlob in_grad);Ở đây, hai điểm quan trọng cần lưu ý -

Dữ liệu out_data trong CompleteConnectedForward không được sử dụng bởi FullConnectedBackward và

PoolingBackward yêu cầu tất cả các đối số của PoolingForward.

Đó là lý do tại sao FullyConnectedForward, các out_datatensor một khi được tiêu thụ có thể được giải phóng an toàn vì hàm lùi sẽ không cần đến nó. Với sự trợ giúp của hệ thống này có thể thu thập một số tensors rác càng sớm càng tốt.

In place Option- Apache MXNet cung cấp một giao diện khác cho người dùng để tiết kiệm chi phí cấp phát bộ nhớ. Giao diện thích hợp cho các hoạt động khôn ngoan trong đó cả bộ căng đầu vào và đầu ra có hình dạng giống nhau.

Sau đây là cú pháp để chỉ định cập nhật tại chỗ:

Ví dụ để tạo một toán tử

Với sự trợ giúp của OperatorProperty, chúng ta có thể tạo một toán tử. Để làm như vậy, hãy làm theo các bước dưới đây:

virtual std::vector<std::pair<int, void*>> ElewiseOpProperty::ForwardInplaceOption(

const std::vector<int> &in_data,

const std::vector<void*> &out_data)

const {

return { {in_data[0], out_data[0]} };

}

virtual std::vector<std::pair<int, void*>> ElewiseOpProperty::BackwardInplaceOption(

const std::vector<int> &out_grad,

const std::vector<int> &in_data,

const std::vector<int> &out_data,

const std::vector<void*> &in_grad)

const {

return { {out_grad[0], in_grad[0]} }

}Bước 1

Create Operator

Đầu tiên hãy triển khai giao diện sau trong OperatorProperty:

virtual Operator* CreateOperator(Context ctx) const = 0;Ví dụ được đưa ra dưới đây -

class ConvolutionOp {

public:

void Forward( ... ) { ... }

void Backward( ... ) { ... }

};

class ConvolutionOpProperty : public OperatorProperty {

public:

Operator* CreateOperator(Context ctx) const {

return new ConvolutionOp;

}

};Bước 2

Parameterize Operator

Nếu bạn định triển khai toán tử tích chập, bạn bắt buộc phải biết kích thước hạt nhân, kích thước bước sóng, kích thước phần đệm, v.v. Tại sao, vì các tham số này phải được chuyển cho nhà điều hành trước khi gọi bất kỳForward hoặc là backward giao diện.

Đối với điều này, chúng ta cần xác định ConvolutionParam cấu trúc như bên dưới -

#include <dmlc/parameter.h>

struct ConvolutionParam : public dmlc::Parameter<ConvolutionParam> {

mxnet::TShape kernel, stride, pad;

uint32_t num_filter, num_group, workspace;

bool no_bias;

};Bây giờ, chúng ta cần đưa cái này vào ConvolutionOpProperty và chuyển nó cho nhà điều hành như sau:

class ConvolutionOp {

public:

ConvolutionOp(ConvolutionParam p): param_(p) {}

void Forward( ... ) { ... }

void Backward( ... ) { ... }

private:

ConvolutionParam param_;

};

class ConvolutionOpProperty : public OperatorProperty {

public:

void Init(const vector<pair<string, string>& kwargs) {

// initialize param_ using kwargs

}

Operator* CreateOperator(Context ctx) const {

return new ConvolutionOp(param_);

}

private:

ConvolutionParam param_;

};Bước 3

Register the Operator Property Class and the Parameter Class to Apache MXNet

Cuối cùng, chúng ta cần đăng ký Lớp thuộc tính toán tử và Lớp tham số cho MXNet. Nó có thể được thực hiện với sự trợ giúp của các macro sau:

DMLC_REGISTER_PARAMETER(ConvolutionParam);

MXNET_REGISTER_OP_PROPERTY(Convolution, ConvolutionOpProperty);Trong macro trên, đối số đầu tiên là chuỗi tên và đối số thứ hai là tên lớp thuộc tính.

Chương này cung cấp thông tin về giao diện lập trình ứng dụng điều hành hợp nhất (API) trong Apache MXNet.

SimpleOp

SimpleOp là một API toán tử hợp nhất mới hợp nhất các quy trình gọi khác nhau. Sau khi được gọi, nó quay trở lại các phần tử cơ bản của các toán tử. Toán tử hợp nhất được thiết kế đặc biệt cho các phép toán đơn phân cũng như nhị phân. Đó là bởi vì hầu hết các toán tử toán học tham gia vào một hoặc hai toán hạng và nhiều toán hạng hơn làm cho việc tối ưu hóa, liên quan đến phụ thuộc, hữu ích.

Chúng ta sẽ hiểu toán tử hợp nhất SimpleOp của nó hoạt động với sự trợ giúp của một ví dụ. Trong ví dụ này, chúng tôi sẽ tạo một toán tử hoạt động như mộtsmooth l1 loss, là hỗn hợp mất đi l1 và l2. Chúng ta có thể xác định và viết khoản lỗ như dưới đây:

loss = outside_weight .* f(inside_weight .* (data - label))

grad = outside_weight .* inside_weight .* f'(inside_weight .* (data - label))Đây, trong ví dụ trên,

. * là viết tắt của phép nhân theo nguyên tố

f, f’ là hàm mất mát l1 mượt mà chúng ta đang giả định là mshadow.

Có vẻ như không thể thực hiện sự mất mát cụ thể này dưới dạng toán tử một ngôi hoặc nhị phân nhưng MXNet cung cấp cho người dùng sự khác biệt tự động trong việc thực thi ký hiệu giúp đơn giản hóa sự mất mát đối với f và f 'một cách trực tiếp. Đó là lý do tại sao chúng tôi chắc chắn có thể thực hiện lỗ cụ thể này với tư cách là toán tử một ngôi.

Xác định hình dạng

Như chúng ta biết MXNet's mshadow libraryyêu cầu phân bổ bộ nhớ rõ ràng do đó chúng tôi cần cung cấp tất cả các hình dạng dữ liệu trước khi bất kỳ phép tính nào xảy ra. Trước khi xác định các hàm và gradient, chúng ta cần cung cấp tính nhất quán của hình dạng đầu vào và hình dạng đầu ra như sau:

typedef mxnet::TShape (*UnaryShapeFunction)(const mxnet::TShape& src,

const EnvArguments& env);

typedef mxnet::TShape (*BinaryShapeFunction)(const mxnet::TShape& lhs,

const mxnet::TShape& rhs,

const EnvArguments& env);Hàm mxnet :: Tshape được sử dụng để kiểm tra hình dạng dữ liệu đầu vào và hình dạng dữ liệu đầu ra được chỉ định. Trong trường hợp, nếu bạn không xác định hàm này thì hình dạng đầu ra mặc định sẽ giống như hình dạng đầu vào. Ví dụ, trong trường hợp toán tử nhị phân, hình dạng của lhs và rhs theo mặc định được kiểm tra là giống nhau.

Bây giờ chúng ta hãy chuyển sang smooth l1 loss example. Đối với điều này, chúng ta cần xác định XPU thành cpu hoặc gpu trong triển khai tiêu đề smooth_l1_unary-inl.h. Lý do là sử dụng lại cùng một mã trong smooth_l1_unary.cc và smooth_l1_unary.cu.

#include <mxnet/operator_util.h>

#if defined(__CUDACC__)

#define XPU gpu

#else

#define XPU cpu

#endifNhư trong của chúng tôi smooth l1 loss example,đầu ra có cùng hình dạng với nguồn, chúng ta có thể sử dụng hành vi mặc định. Nó có thể được viết như sau:

inline mxnet::TShape SmoothL1Shape_(const mxnet::TShape& src,const EnvArguments& env) {

return mxnet::TShape(src);

}Xác định chức năng

Chúng ta có thể tạo một hàm đơn phân hoặc nhị phân với một đầu vào như sau:

typedef void (*UnaryFunction)(const TBlob& src,

const EnvArguments& env,

TBlob* ret,

OpReqType req,

RunContext ctx);

typedef void (*BinaryFunction)(const TBlob& lhs,

const TBlob& rhs,

const EnvArguments& env,

TBlob* ret,

OpReqType req,

RunContext ctx);Sau đây là RunContext ctx struct chứa thông tin cần thiết trong thời gian chạy để thực thi -

struct RunContext {

void *stream; // the stream of the device, can be NULL or Stream<gpu>* in GPU mode

template<typename xpu> inline mshadow::Stream<xpu>* get_stream() // get mshadow stream from Context

} // namespace mxnetBây giờ, hãy xem cách chúng ta có thể viết kết quả tính toán trong ret.

enum OpReqType {

kNullOp, // no operation, do not write anything

kWriteTo, // write gradient to provided space

kWriteInplace, // perform an in-place write

kAddTo // add to the provided space

};Bây giờ, hãy chuyển sang smooth l1 loss example. Đối với điều này, chúng tôi sẽ sử dụng UnaryFunction để xác định chức năng của toán tử này như sau:

template<typename xpu>

void SmoothL1Forward_(const TBlob& src,

const EnvArguments& env,

TBlob *ret,

OpReqType req,

RunContext ctx) {

using namespace mshadow;

using namespace mshadow::expr;

mshadow::Stream<xpu> *s = ctx.get_stream<xpu>();

real_t sigma2 = env.scalar * env.scalar;

MSHADOW_TYPE_SWITCH(ret->type_flag_, DType, {

mshadow::Tensor<xpu, 2, DType> out = ret->get<xpu, 2, DType>(s);

mshadow::Tensor<xpu, 2, DType> in = src.get<xpu, 2, DType>(s);

ASSIGN_DISPATCH(out, req,

F<mshadow_op::smooth_l1_loss>(in, ScalarExp<DType>(sigma2)));

});

}Định nghĩa Gradients

Ngoại trừ Input, TBlob, và OpReqTypeđược nhân đôi, các hàm Gradients của toán tử nhị phân có cấu trúc tương tự. Hãy kiểm tra bên dưới, nơi chúng tôi đã tạo một hàm gradient với nhiều kiểu đầu vào:

// depending only on out_grad

typedef void (*UnaryGradFunctionT0)(const OutputGrad& out_grad,

const EnvArguments& env,

TBlob* in_grad,

OpReqType req,

RunContext ctx);

// depending only on out_value

typedef void (*UnaryGradFunctionT1)(const OutputGrad& out_grad,

const OutputValue& out_value,

const EnvArguments& env,

TBlob* in_grad,

OpReqType req,

RunContext ctx);

// depending only on in_data

typedef void (*UnaryGradFunctionT2)(const OutputGrad& out_grad,

const Input0& in_data0,

const EnvArguments& env,

TBlob* in_grad,

OpReqType req,

RunContext ctx);Như đã định nghĩa ở trên Input0, Input, OutputValue, và OutputGrad tất cả đều chia sẻ cấu trúc của GradientFunctionArgument. Nó được định nghĩa như sau:

struct GradFunctionArgument {

TBlob data;

}Bây giờ chúng ta hãy chuyển sang smooth l1 loss example. Đối với điều này để kích hoạt quy tắc chuỗi của gradient, chúng ta cần nhânout_grad từ đầu đến kết quả của in_grad.

template<typename xpu>

void SmoothL1BackwardUseIn_(const OutputGrad& out_grad, const Input0& in_data0,

const EnvArguments& env,

TBlob *in_grad,

OpReqType req,

RunContext ctx) {

using namespace mshadow;

using namespace mshadow::expr;

mshadow::Stream<xpu> *s = ctx.get_stream<xpu>();

real_t sigma2 = env.scalar * env.scalar;

MSHADOW_TYPE_SWITCH(in_grad->type_flag_, DType, {

mshadow::Tensor<xpu, 2, DType> src = in_data0.data.get<xpu, 2, DType>(s);

mshadow::Tensor<xpu, 2, DType> ograd = out_grad.data.get<xpu, 2, DType>(s);

mshadow::Tensor<xpu, 2, DType> igrad = in_grad->get<xpu, 2, DType>(s);

ASSIGN_DISPATCH(igrad, req,

ograd * F<mshadow_op::smooth_l1_gradient>(src, ScalarExp<DType>(sigma2)));

});

}Đăng ký SimpleOp với MXNet

Khi chúng ta đã tạo hình dạng, hàm và độ dốc, chúng ta cần khôi phục chúng thành cả toán tử NDArray cũng như thành toán tử tượng trưng. Đối với điều này, chúng ta có thể sử dụng macro đăng ký như sau:

MXNET_REGISTER_SIMPLE_OP(Name, DEV)

.set_shape_function(Shape)

.set_function(DEV::kDevMask, Function<XPU>, SimpleOpInplaceOption)

.set_gradient(DEV::kDevMask, Gradient<XPU>, SimpleOpInplaceOption)

.describe("description");Các SimpleOpInplaceOption có thể được định nghĩa như sau:

enum SimpleOpInplaceOption {

kNoInplace, // do not allow inplace in arguments

kInplaceInOut, // allow inplace in with out (unary)

kInplaceOutIn, // allow inplace out_grad with in_grad (unary)

kInplaceLhsOut, // allow inplace left operand with out (binary)

kInplaceOutLhs // allow inplace out_grad with lhs_grad (binary)

};Bây giờ chúng ta hãy chuyển sang smooth l1 loss example. Đối với điều này, chúng ta có một hàm gradient dựa vào dữ liệu đầu vào để hàm không thể được viết tại chỗ.

MXNET_REGISTER_SIMPLE_OP(smooth_l1, XPU)

.set_function(XPU::kDevMask, SmoothL1Forward_<XPU>, kNoInplace)

.set_gradient(XPU::kDevMask, SmoothL1BackwardUseIn_<XPU>, kInplaceOutIn)

.set_enable_scalar(true)

.describe("Calculate Smooth L1 Loss(lhs, scalar)");SimpleOp trên EnvArguments

Như chúng ta biết một số thao tác có thể cần những điều sau:

Một đại lượng vô hướng như đầu vào chẳng hạn như thang độ dốc

Một tập hợp các đối số từ khóa kiểm soát hành vi

Một không gian tạm thời để tăng tốc độ tính toán.

Lợi ích của việc sử dụng EnvArguments là nó cung cấp các đối số và tài nguyên bổ sung để làm cho các phép tính có thể mở rộng và hiệu quả hơn.

Thí dụ

Đầu tiên, hãy xác định cấu trúc như bên dưới:

struct EnvArguments {

real_t scalar; // scalar argument, if enabled

std::vector<std::pair<std::string, std::string> > kwargs; // keyword arguments

std::vector<Resource> resource; // pointer to the resources requested

};Tiếp theo, chúng tôi cần yêu cầu các tài nguyên bổ sung như mshadow::Random<xpu> và không gian bộ nhớ tạm thời từ EnvArguments.resource. Nó có thể được thực hiện như sau:

struct ResourceRequest {

enum Type { // Resource type, indicating what the pointer type is

kRandom, // mshadow::Random<xpu> object

kTempSpace // A dynamic temp space that can be arbitrary size

};

Type type; // type of resources

};Bây giờ, đăng ký sẽ yêu cầu yêu cầu tài nguyên được khai báo từ mxnet::ResourceManager. Sau đó, nó sẽ đặt các tài nguyên vào std::vector<Resource> resource in EnvAgruments.

Chúng tôi có thể truy cập các tài nguyên với sự trợ giúp của mã sau:

auto tmp_space_res = env.resources[0].get_space(some_shape, some_stream);

auto rand_res = env.resources[0].get_random(some_stream);Nếu bạn thấy trong ví dụ về mất mát l1 trơn tru của chúng tôi, thì cần có một đầu vào vô hướng để đánh dấu bước ngoặt của một hàm lỗ. Đó là lý do tại sao trong quá trình đăng ký, chúng tôi sử dụngset_enable_scalar(true)và env.scalar trong khai báo hàm và gradient.

Xây dựng hoạt động Tensor

Ở đây câu hỏi đặt ra rằng tại sao chúng ta cần phải tạo ra các hoạt động tensor? Lý do như sau:

Tính toán sử dụng thư viện mshadow và đôi khi chúng tôi không có sẵn các chức năng.

Nếu một hoạt động không được thực hiện theo cách khôn ngoan như mất softmax và gradient.

Thí dụ

Ở đây, chúng tôi đang sử dụng ví dụ mất mát l1 mịn ở trên. Chúng tôi sẽ tạo hai ánh xạ cụ thể là các trường hợp vô hướng của mất l1 mịn và gradient:

namespace mshadow_op {

struct smooth_l1_loss {

// a is x, b is sigma2

MSHADOW_XINLINE static real_t Map(real_t a, real_t b) {

if (a > 1.0f / b) {

return a - 0.5f / b;

} else if (a < -1.0f / b) {

return -a - 0.5f / b;

} else {

return 0.5f * a * a * b;

}

}

};

}Chương này nói về đào tạo phân tán trong Apache MXNet. Chúng ta hãy bắt đầu bằng cách hiểu các chế độ tính toán trong MXNet là gì.

Các phương thức tính toán