Scikit Learn - Hướng dẫn Nhanh

Trong chương này, chúng ta sẽ hiểu Scikit-Learn hoặc Sklearn là gì, nguồn gốc của Scikit-Learn và một số chủ đề liên quan khác như cộng đồng và cộng tác viên chịu trách nhiệm phát triển và duy trì Scikit-Learn, điều kiện tiên quyết, cách cài đặt và các tính năng của nó.

Scikit-Learn là gì (Sklearn)

Scikit-learning (Sklearn) là thư viện hữu ích và mạnh mẽ nhất để học máy bằng Python. Nó cung cấp một loạt các công cụ hiệu quả để học máy và mô hình thống kê bao gồm phân loại, hồi quy, phân cụm và giảm kích thước thông qua giao diện nhất quán trong Python. Thư viện này, phần lớn được viết bằng Python, được xây dựng dựa trênNumPy, SciPy và Matplotlib.

Nguồn gốc của Scikit-Learn

Ban đầu nó được gọi là scikits.learn và ban đầu được phát triển bởi David Cournapeau như một dự án mã mùa hè của Google vào năm 2007. Sau đó, vào năm 2010, Fabian Pedregosa, Gael Varoquaux, Alexandre Gramfort và Vincent Michel, từ FIRCA (Viện Nghiên cứu Khoa học Máy tính và Tự động hóa của Pháp), đã dự án này ở cấp độ khác và phát hành bản phát hành công khai đầu tiên (v0.1 beta) vào ngày 1 tháng 2 năm 2010.

Hãy xem lịch sử phiên bản của nó -

Tháng 5 năm 2019: scikit-learning 0.21.0

Tháng 3 năm 2019: scikit-learning 0.20.3

Tháng 12 năm 2018: scikit-learning 0.20.2

Tháng 11 năm 2018: scikit-learning 0.20.1

Tháng 9 năm 2018: scikit-learning 0.20.0

Tháng 7 năm 2018: scikit-learning 0.19.2

Tháng 7 năm 2017: scikit-learning 0.19.0

Tháng 9 năm 2016. scikit-learning 0.18.0

Tháng 11 năm 2015. scikit-learning 0.17.0

Tháng 3 năm 2015. scikit-learning 0.16.0

Tháng 7 năm 2014. scikit-learning 0.15.0

Tháng 8 năm 2013. scikit-learning 0.14

Cộng đồng và cộng tác viên

Scikit-learning là một nỗ lực của cộng đồng và bất kỳ ai cũng có thể đóng góp cho nó. Dự án này được lưu trữ trênhttps://github.com/scikit-learn/scikit-learn. Những người sau hiện là những người đóng góp cốt lõi cho sự phát triển và duy trì của Sklearn -

Joris Van den Bossche (Nhà khoa học dữ liệu)

Thomas J Fan (Nhà phát triển phần mềm)

Alexandre Gramfort (Nhà nghiên cứu Máy học)

Olivier Grisel (Chuyên gia học máy)

Nicolas Hug (Nhà khoa học nghiên cứu liên kết)

Andreas Mueller (Nhà khoa học học máy)

Hanmin Qin (Kỹ sư phần mềm)

Adrin Jalali (Nhà phát triển nguồn mở)

Nelle Varoquaux (Nhà nghiên cứu Khoa học Dữ liệu)

Roman Yurchak (Nhà khoa học dữ liệu)

Nhiều tổ chức khác nhau như Booking.com, JP Morgan, Evernote, Inria, AWeber, Spotify và nhiều tổ chức khác đang sử dụng Sklearn.

Điều kiện tiên quyết

Trước khi bắt đầu sử dụng bản phát hành mới nhất của scikit-learning, chúng tôi yêu cầu những điều sau:

Python (> = 3.5)

NumPy (> = 1.11.0)

Scipy (> = 0,17,0) li

Joblib (> = 0,11)

Matplotlib (> = 1.5.1) là cần thiết cho khả năng vẽ đồ thị của Sklearn.

Pandas (> = 0.18.0) là bắt buộc đối với một số ví dụ scikit-learning sử dụng cấu trúc và phân tích dữ liệu.

Cài đặt

Nếu bạn đã cài đặt NumPy và Scipy, sau đây là hai cách dễ nhất để cài đặt scikit-learning:

Sử dụng pip

Lệnh sau có thể được sử dụng để cài đặt scikit-learning qua pip:

pip install -U scikit-learnSử dụng chung cư

Lệnh sau có thể được sử dụng để cài đặt scikit-learning qua conda -

conda install scikit-learnMặt khác, nếu NumPy và Scipy chưa được cài đặt trên máy trạm Python của bạn thì bạn có thể cài đặt chúng bằng cách sử dụng pip hoặc là conda.

Một tùy chọn khác để sử dụng scikit-learning là sử dụng các bản phân phối Python như Canopy và Anaconda vì cả hai đều cung cấp phiên bản mới nhất của scikit-learning.

Đặc trưng

Thay vì tập trung vào tải, thao tác và tóm tắt dữ liệu, thư viện Scikit-learning tập trung vào việc mô hình hóa dữ liệu. Một số nhóm mô hình phổ biến nhất do Sklearn cung cấp như sau:

Supervised Learning algorithms - Hầu như tất cả các thuật toán học có giám sát phổ biến, như Hồi quy tuyến tính, Máy vectơ hỗ trợ (SVM), Cây quyết định, v.v., là một phần của scikit-learning.

Unsupervised Learning algorithms - Mặt khác, nó cũng có tất cả các thuật toán học không giám sát phổ biến từ phân nhóm, phân tích nhân tố, PCA (Phân tích thành phần chính) đến mạng nơ-ron không giám sát.

Clustering - Mô hình này được sử dụng để nhóm dữ liệu không được gắn nhãn.

Cross Validation - Nó được sử dụng để kiểm tra độ chính xác của các mô hình được giám sát trên dữ liệu không nhìn thấy.

Dimensionality Reduction - Nó được sử dụng để giảm số lượng các thuộc tính trong dữ liệu có thể được sử dụng thêm để tổng hợp, hiển thị và lựa chọn tính năng.

Ensemble methods - Như tên gợi ý, nó được sử dụng để kết hợp các dự đoán của nhiều mô hình được giám sát.

Feature extraction - Nó được sử dụng để trích xuất các tính năng từ dữ liệu để xác định các thuộc tính trong dữ liệu hình ảnh và văn bản.

Feature selection - Nó được sử dụng để xác định các thuộc tính hữu ích để tạo ra các mô hình được giám sát.

Open Source - Đây là thư viện mã nguồn mở và cũng có thể sử dụng thương mại theo giấy phép BSD.

Chương này đề cập đến quá trình mô hình hóa liên quan đến Sklearn. Hãy để chúng tôi hiểu chi tiết về điều tương tự và bắt đầu với việc tải tập dữ liệu.

Đang tải tập dữ liệu

Tập hợp dữ liệu được gọi là tập dữ liệu. Nó có hai thành phần sau:

Features- Các biến của dữ liệu được gọi là các đặc trưng của nó. Chúng còn được gọi là yếu tố dự đoán, đầu vào hoặc thuộc tính.

Feature matrix - Nó là tập hợp các tính năng, trong trường hợp có nhiều hơn một.

Feature Names - Đây là danh sách tất cả các tên của các đối tượng địa lý.

Response- Biến đầu ra về cơ bản phụ thuộc vào các biến đặc trưng. Chúng còn được gọi là mục tiêu, nhãn hoặc đầu ra.

Response Vector- Nó được sử dụng để biểu diễn cột phản hồi. Nói chung, chúng tôi chỉ có một cột phản hồi.

Target Names - Nó đại diện cho các giá trị có thể được thực hiện bởi một vectơ phản hồi.

Scikit-learning có một số bộ dữ liệu mẫu như iris và digits để phân loại và Boston house prices để hồi quy.

Thí dụ

Sau đây là một ví dụ để tải iris tập dữ liệu -

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

feature_names = iris.feature_names

target_names = iris.target_names

print("Feature names:", feature_names)

print("Target names:", target_names)

print("\nFirst 10 rows of X:\n", X[:10])Đầu ra

Feature names: ['sepal length (cm)', 'sepal width (cm)', 'petal length (cm)', 'petal width (cm)']

Target names: ['setosa' 'versicolor' 'virginica']

First 10 rows of X:

[

[5.1 3.5 1.4 0.2]

[4.9 3. 1.4 0.2]

[4.7 3.2 1.3 0.2]

[4.6 3.1 1.5 0.2]

[5. 3.6 1.4 0.2]

[5.4 3.9 1.7 0.4]

[4.6 3.4 1.4 0.3]

[5. 3.4 1.5 0.2]

[4.4 2.9 1.4 0.2]

[4.9 3.1 1.5 0.1]

]Tách tập dữ liệu

Để kiểm tra độ chính xác của mô hình của chúng tôi, chúng tôi có thể chia tập dữ liệu thành hai phần-a training set và a testing set. Sử dụng tập huấn luyện để huấn luyện mô hình và tập thử nghiệm để kiểm tra mô hình. Sau đó, chúng tôi có thể đánh giá mô hình của chúng tôi đã hoạt động tốt như thế nào.

Thí dụ

Ví dụ sau sẽ chia dữ liệu thành tỷ lệ 70:30, tức là 70% dữ liệu sẽ được sử dụng làm dữ liệu đào tạo và 30% sẽ được sử dụng làm dữ liệu thử nghiệm. Tập dữ liệu là tập dữ liệu mống mắt như trong ví dụ trên.

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size = 0.3, random_state = 1

)

print(X_train.shape)

print(X_test.shape)

print(y_train.shape)

print(y_test.shape)Đầu ra

(105, 4)

(45, 4)

(105,)

(45,)Như đã thấy trong ví dụ trên, nó sử dụng train_test_split()chức năng của scikit-learning để chia nhỏ tập dữ liệu. Hàm này có các đối số sau:

X, y - Đây, X là feature matrix và y là response vector, cần được chia nhỏ.

test_size- Điều này thể hiện tỷ lệ của dữ liệu thử nghiệm trên tổng số dữ liệu đã cho. Như trong ví dụ trên, chúng tôi đang thiết lậptest_data = 0.3 cho 150 hàng X. Nó sẽ tạo ra dữ liệu thử nghiệm là 150 * 0,3 = 45 hàng.

random_size- Nó được sử dụng để đảm bảo rằng sự phân chia sẽ luôn giống nhau. Điều này hữu ích trong những trường hợp bạn muốn có kết quả có thể lặp lại.

Huấn luyện người mẫu

Tiếp theo, chúng ta có thể sử dụng tập dữ liệu của mình để đào tạo một số mô hình dự đoán. Như đã thảo luận, scikit-learning có nhiều loạiMachine Learning (ML) algorithms có giao diện nhất quán để lắp, dự đoán độ chính xác, thu hồi, v.v.

Thí dụ

Trong ví dụ dưới đây, chúng ta sẽ sử dụng bộ phân loại KNN (K hàng xóm gần nhất). Đừng đi vào chi tiết của các thuật toán KNN, vì sẽ có một chương riêng cho điều đó. Ví dụ này được sử dụng để giúp bạn chỉ hiểu phần triển khai.

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size = 0.4, random_state=1

)

from sklearn.neighbors import KNeighborsClassifier

from sklearn import metrics

classifier_knn = KNeighborsClassifier(n_neighbors = 3)

classifier_knn.fit(X_train, y_train)

y_pred = classifier_knn.predict(X_test)

# Finding accuracy by comparing actual response values(y_test)with predicted response value(y_pred)

print("Accuracy:", metrics.accuracy_score(y_test, y_pred))

# Providing sample data and the model will make prediction out of that data

sample = [[5, 5, 3, 2], [2, 4, 3, 5]]

preds = classifier_knn.predict(sample)

pred_species = [iris.target_names[p] for p in preds] print("Predictions:", pred_species)Đầu ra

Accuracy: 0.9833333333333333

Predictions: ['versicolor', 'virginica']Độ bền của mô hình

Sau khi bạn đào tạo mô hình, bạn nên duy trì mô hình đó để sử dụng trong tương lai để chúng ta không cần phải đào tạo lại nó nhiều lần. Nó có thể được thực hiện với sự giúp đỡ củadump và load tính năng của joblib gói hàng.

Hãy xem xét ví dụ dưới đây, trong đó chúng tôi sẽ lưu mô hình được đào tạo ở trên (classifier_knn) để sử dụng trong tương lai -

from sklearn.externals import joblib

joblib.dump(classifier_knn, 'iris_classifier_knn.joblib')Đoạn mã trên sẽ lưu mô hình vào tệp có tên iris_classifier_knn.joblib. Bây giờ, đối tượng có thể được tải lại từ tệp với sự trợ giúp của mã sau:

joblib.load('iris_classifier_knn.joblib')Xử lý trước dữ liệu

Vì chúng ta đang xử lý nhiều dữ liệu và dữ liệu đó ở dạng thô, trước khi nhập dữ liệu đó vào các thuật toán học máy, chúng ta cần chuyển đổi nó thành dữ liệu có ý nghĩa. Quá trình này được gọi là tiền xử lý dữ liệu. Scikit-learning có gói có tênpreprocessingvì mục đích này. Cácpreprocessing gói có các kỹ thuật sau:

Binarisation

Kỹ thuật tiền xử lý này được sử dụng khi chúng ta cần chuyển đổi các giá trị số thành các giá trị Boolean.

Thí dụ

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]]

)

data_binarized = preprocessing.Binarizer(threshold=0.5).transform(input_data)

print("\nBinarized data:\n", data_binarized)Trong ví dụ trên, chúng tôi đã sử dụng threshold value = 0,5 và đó là lý do tại sao, tất cả các giá trị trên 0,5 sẽ được chuyển đổi thành 1 và tất cả các giá trị dưới 0,5 sẽ được chuyển thành 0.

Đầu ra

Binarized data:

[

[ 1. 0. 1.]

[ 0. 1. 1.]

[ 0. 0. 1.]

[ 1. 1. 0.]

]Loại bỏ trung bình

Kỹ thuật này được sử dụng để loại bỏ giá trị trung bình khỏi vectơ đặc trưng để mọi đối tượng đều có tâm là 0.

Thí dụ

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]]

)

#displaying the mean and the standard deviation of the input data

print("Mean =", input_data.mean(axis=0))

print("Stddeviation = ", input_data.std(axis=0))

#Removing the mean and the standard deviation of the input data

data_scaled = preprocessing.scale(input_data)

print("Mean_removed =", data_scaled.mean(axis=0))

print("Stddeviation_removed =", data_scaled.std(axis=0))Đầu ra

Mean = [ 1.75 -1.275 2.2 ]

Stddeviation = [ 2.71431391 4.20022321 4.69414529]

Mean_removed = [ 1.11022302e-16 0.00000000e+00 0.00000000e+00]

Stddeviation_removed = [ 1. 1. 1.]Mở rộng quy mô

Chúng tôi sử dụng kỹ thuật tiền xử lý này để chia tỷ lệ các vectơ đặc trưng. Tỷ lệ của vectơ đối tượng là rất quan trọng, bởi vì các đối tượng địa lý không được tổng hợp lớn hoặc nhỏ.

Thí dụ

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_scaler_minmax = preprocessing.MinMaxScaler(feature_range=(0,1))

data_scaled_minmax = data_scaler_minmax.fit_transform(input_data)

print ("\nMin max scaled data:\n", data_scaled_minmax)Đầu ra

Min max scaled data:

[

[ 0.48648649 0.58252427 0.99122807]

[ 0. 1. 0.81578947]

[ 0.27027027 0. 1. ]

[ 1. 0.99029126 0. ]

]Bình thường hóa

Chúng tôi sử dụng kỹ thuật tiền xử lý này để sửa đổi các vectơ đặc trưng. Chuẩn hóa các vectơ đặc trưng là cần thiết để các vectơ đặc trưng có thể được đo lường ở quy mô chung. Có hai loại chuẩn hóa như sau:

Chuẩn hóa L1

Nó còn được gọi là Sai lệch tuyệt đối ít nhất. Nó sửa đổi giá trị theo cách mà tổng các giá trị tuyệt đối luôn luôn tối đa 1 trong mỗi hàng. Ví dụ sau cho thấy việc thực hiện chuẩn hóa L1 trên dữ liệu đầu vào.

Thí dụ

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_normalized_l1 = preprocessing.normalize(input_data, norm='l1')

print("\nL1 normalized data:\n", data_normalized_l1)Đầu ra

L1 normalized data:

[

[ 0.22105263 -0.2 0.57894737]

[-0.2027027 0.32432432 0.47297297]

[ 0.03571429 -0.56428571 0.4 ]

[ 0.42142857 0.16428571 -0.41428571]

]Chuẩn hóa L2

Còn được gọi là Hình vuông nhỏ nhất. Nó sửa đổi giá trị theo cách mà tổng các ô vuông luôn luôn tối đa 1 trong mỗi hàng. Ví dụ sau cho thấy việc thực hiện chuẩn hóa L2 trên dữ liệu đầu vào.

Thí dụ

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_normalized_l2 = preprocessing.normalize(input_data, norm='l2')

print("\nL1 normalized data:\n", data_normalized_l2)Đầu ra

L2 normalized data:

[

[ 0.33946114 -0.30713151 0.88906489]

[-0.33325106 0.53320169 0.7775858 ]

[ 0.05156558 -0.81473612 0.57753446]

[ 0.68706914 0.26784051 -0.6754239 ]

]Như chúng ta biết rằng học máy là để tạo mô hình từ dữ liệu. Với mục đích này, máy tính phải hiểu dữ liệu trước. Tiếp theo, chúng ta sẽ thảo luận về các cách khác nhau để biểu diễn dữ liệu để máy tính có thể hiểu được -

Dữ liệu dưới dạng bảng

Cách tốt nhất để biểu diễn dữ liệu trong Scikit-learning là dưới dạng bảng. Một bảng đại diện cho lưới dữ liệu 2-D trong đó các hàng đại diện cho các phần tử riêng lẻ của tập dữ liệu và các cột đại diện cho các đại lượng liên quan đến các phần tử riêng lẻ đó.

Thí dụ

Với ví dụ dưới đây, chúng ta có thể tải xuống iris dataset ở dạng Pandas DataFrame với sự trợ giúp của python seaborn thư viện.

import seaborn as sns

iris = sns.load_dataset('iris')

iris.head()Đầu ra

sepal_length sepal_width petal_length petal_width species

0 5.1 3.5 1.4 0.2 setosa

1 4.9 3.0 1.4 0.2 setosa

2 4.7 3.2 1.3 0.2 setosa

3 4.6 3.1 1.5 0.2 setosa

4 5.0 3.6 1.4 0.2 setosaTừ kết quả trên, chúng ta có thể thấy rằng mỗi hàng dữ liệu đại diện cho một bông hoa được quan sát duy nhất và số hàng biểu thị tổng số bông hoa trong tập dữ liệu. Nói chung, chúng tôi coi các hàng của ma trận là các mẫu.

Mặt khác, mỗi cột dữ liệu đại diện cho một thông tin định lượng mô tả mỗi mẫu. Nói chung, chúng tôi gọi các cột của ma trận là các đặc trưng.

Dữ liệu dưới dạng Ma trận tính năng

Ma trận tính năng có thể được định nghĩa là bố cục bảng mà thông tin có thể được coi là ma trận 2-D. Nó được lưu trữ trong một biến có tênXvà giả định là hai chiều với shape [n_samples, n_features]. Hầu hết, nó được chứa trong một mảng NumPy hoặc một Pandas DataFrame. Như đã nói trước đó, các mẫu luôn đại diện cho các đối tượng riêng lẻ được mô tả bởi tập dữ liệu và các tính năng đại diện cho các quan sát riêng biệt mô tả từng mẫu theo cách định lượng.

Dữ liệu dưới dạng mảng Mục tiêu

Cùng với ma trận Đặc điểm, ký hiệu là X, chúng ta cũng có mảng đích. Nó còn được gọi là nhãn. Nó được ký hiệu là y. Nhãn hoặc mảng đích thường là một chiều có độ dài n_samples. Nó thường được chứa trong NumPyarray hoặc gấu trúc Series. Mảng đích có thể có cả giá trị, giá trị số liên tục và giá trị rời rạc.

Mảng mục tiêu khác với các cột tính năng như thế nào?

Chúng ta có thể phân biệt cả hai bằng một điểm rằng mảng đích thường là đại lượng mà chúng ta muốn dự đoán từ dữ liệu, tức là theo thuật ngữ thống kê, nó là biến phụ thuộc.

Thí dụ

Trong ví dụ dưới đây, từ tập dữ liệu mống mắt, chúng tôi dự đoán loài hoa dựa trên các phép đo khác. Trong trường hợp này, cột Loài sẽ được coi là đối tượng địa lý.

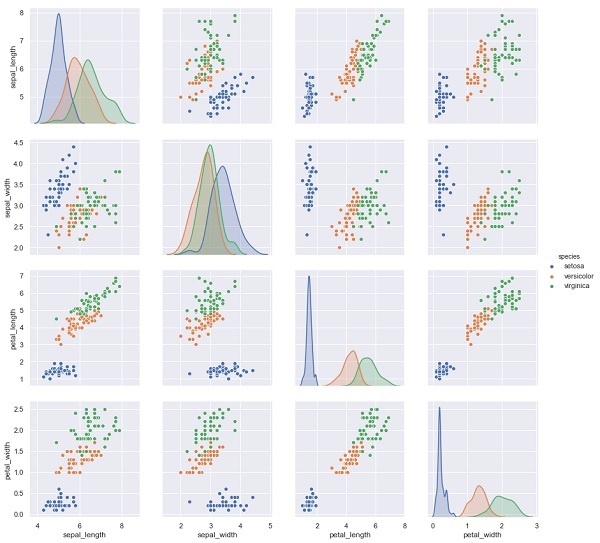

import seaborn as sns

iris = sns.load_dataset('iris')

%matplotlib inline

import seaborn as sns; sns.set()

sns.pairplot(iris, hue='species', height=3);Đầu ra

X_iris = iris.drop('species', axis=1)

X_iris.shape

y_iris = iris['species']

y_iris.shapeĐầu ra

(150,4)

(150,)Trong chương này, chúng ta sẽ tìm hiểu về Estimator API(giao diện lập trình ứng dụng). Chúng ta hãy bắt đầu bằng cách hiểu API Công cụ ước tính là gì.

API công cụ ước tính là gì

Nó là một trong những API chính do Scikit-learning triển khai. Nó cung cấp một giao diện nhất quán cho một loạt các ứng dụng ML, đó là lý do tại sao tất cả các thuật toán học máy trong Scikit-Learn đều được triển khai thông qua API Ước tính. Đối tượng học hỏi từ dữ liệu (phù hợp với dữ liệu) là một bộ ước lượng. Nó có thể được sử dụng với bất kỳ thuật toán nào như phân loại, hồi quy, phân cụm hoặc thậm chí với máy biến áp, trích xuất các tính năng hữu ích từ dữ liệu thô.

Để phù hợp với dữ liệu, tất cả các đối tượng ước tính hiển thị một phương thức phù hợp lấy một tập dữ liệu được hiển thị như sau:

estimator.fit(data)Tiếp theo, tất cả các tham số của công cụ ước tính có thể được đặt, như sau, khi nó được khởi tạo bởi thuộc tính tương ứng.

estimator = Estimator (param1=1, param2=2)

estimator.param1Kết quả của phần trên sẽ là 1.

Sau khi dữ liệu được trang bị với công cụ ước tính, các tham số sẽ được ước tính từ dữ liệu hiện có. Bây giờ, tất cả các tham số ước tính sẽ là thuộc tính của đối tượng ước tính kết thúc bằng dấu gạch dưới như sau:

estimator.estimated_param_Sử dụng API công cụ ước tính

Công dụng chính của công cụ ước tính như sau:

Ước tính và giải mã mô hình

Đối tượng Estimator được sử dụng để ước tính và giải mã một mô hình. Hơn nữa, mô hình được ước tính như một hàm xác định của những điều sau:

Các tham số được cung cấp trong cấu trúc đối tượng.

Trạng thái ngẫu nhiên toàn cục (numpy.random) nếu tham số random_state của công cụ ước tính được đặt thành không.

Mọi dữ liệu được chuyển đến cuộc gọi gần đây nhất tới fit, fit_transform, or fit_predict.

Mọi dữ liệu được chuyển trong một chuỗi lệnh gọi tới partial_fit.

Ánh xạ biểu diễn dữ liệu không phải hình chữ nhật thành dữ liệu hình chữ nhật

Nó ánh xạ một biểu diễn dữ liệu không phải hình chữ nhật thành dữ liệu hình chữ nhật. Nói cách đơn giản, nó lấy đầu vào trong đó mỗi mẫu không được biểu diễn dưới dạng đối tượng dạng mảng có độ dài cố định và tạo ra đối tượng dạng mảng gồm các tính năng cho mỗi mẫu.

Phân biệt giữa mẫu lõi và mẫu bên ngoài

Nó mô hình hóa sự phân biệt giữa các mẫu lõi và mẫu bên ngoài bằng cách sử dụng các phương pháp sau:

fit

fit_p Dự đoán nếu chuyển đổi

dự đoán nếu quy nạp

Nguyên tắc hướng dẫn

Trong khi thiết kế API Scikit-Learn, hãy ghi nhớ các nguyên tắc hướng dẫn -

Tính nhất quán

Nguyên tắc này nói rằng tất cả các đối tượng nên chia sẻ một giao diện chung được vẽ từ một tập hợp các phương thức giới hạn. Các tài liệu cũng phải nhất quán.

Hệ thống phân cấp đối tượng hạn chế

Nguyên tắc hướng dẫn này nói:

Các thuật toán phải được biểu diễn bằng các lớp Python

Tập dữ liệu nên được biểu diễn ở định dạng chuẩn như mảng NumPy, Pandas DataFrames, ma trận thưa thớt SciPy.

Tên tham số nên sử dụng chuỗi Python tiêu chuẩn.

Thành phần

Như chúng ta đã biết, các thuật toán ML có thể được biểu thị dưới dạng chuỗi của nhiều thuật toán cơ bản. Scikit-learning sử dụng các thuật toán cơ bản này bất cứ khi nào cần.

Giá trị mặc định hợp lý

Theo nguyên tắc này, thư viện Scikit-learning xác định một giá trị mặc định thích hợp bất cứ khi nào các mô hình ML yêu cầu các tham số do người dùng chỉ định.

Kiểm tra

Theo nguyên tắc hướng dẫn này, mọi giá trị tham số được chỉ định được hiển thị dưới dạng thuộc tính pubic.

Các bước sử dụng API Công cụ ước tính

Tiếp theo là các bước sử dụng API công cụ ước tính Scikit-Learn -

Bước 1: Chọn một loại mô hình

Trong bước đầu tiên này, chúng ta cần chọn một lớp mô hình. Nó có thể được thực hiện bằng cách nhập lớp Công cụ ước tính thích hợp từ Scikit-learning.

Bước 2: Chọn siêu tham số của mô hình

Trong bước này, chúng ta cần chọn siêu tham số của mô hình lớp. Nó có thể được thực hiện bằng cách khởi tạo lớp với các giá trị mong muốn.

Bước 3: Sắp xếp dữ liệu

Tiếp theo, chúng ta cần sắp xếp dữ liệu thành ma trận đặc trưng (X) và vector mục tiêu (y).

Bước 4: Lắp mô hình

Bây giờ, chúng tôi cần điều chỉnh mô hình phù hợp với dữ liệu của bạn. Nó có thể được thực hiện bằng cách gọi phương thức fit () của cá thể mô hình.

Bước 5: Áp dụng mô hình

Sau khi phù hợp với mô hình, chúng tôi có thể áp dụng nó vào dữ liệu mới. Để học có giám sát, hãy sử dụngpredict()phương pháp dự đoán các nhãn cho dữ liệu không xác định. Trong khi học không có giám sát, hãy sử dụngpredict() hoặc là transform() để suy ra các thuộc tính của dữ liệu.

Ví dụ về học tập có giám sát

Ở đây, là một ví dụ về quy trình này, chúng tôi đang sử dụng trường hợp phổ biến của việc điều chỉnh một dòng với (x, y) dữ liệu tức là simple linear regression.

Đầu tiên, chúng ta cần tải tập dữ liệu, chúng tôi đang sử dụng tập dữ liệu mống mắt -

Thí dụ

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shapeĐầu ra

(150, 4)Thí dụ

y_iris = iris['species']

y_iris.shapeĐầu ra

(150,)Thí dụ

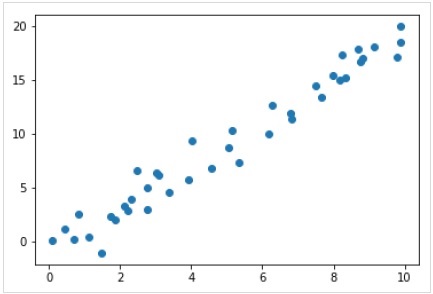

Bây giờ, đối với ví dụ hồi quy này, chúng ta sẽ sử dụng dữ liệu mẫu sau:

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);Đầu ra

Vì vậy, chúng tôi có dữ liệu trên cho ví dụ hồi quy tuyến tính của chúng tôi.

Bây giờ, với dữ liệu này, chúng ta có thể áp dụng các bước nêu trên.

Chọn một loại mô hình

Ở đây, để tính toán một mô hình hồi quy tuyến tính đơn giản, chúng ta cần nhập lớp hồi quy tuyến tính như sau:

from sklearn.linear_model import LinearRegressionChọn siêu tham số của mô hình

Khi chúng ta chọn một loại mô hình, chúng ta cần thực hiện một số lựa chọn quan trọng thường được biểu diễn dưới dạng siêu tham số hoặc các tham số phải đặt trước khi mô hình phù hợp với dữ liệu. Ở đây, đối với ví dụ này về hồi quy tuyến tính, chúng tôi muốn điều chỉnh hệ số chặn bằng cách sử dụngfit_intercept siêu tham số như sau -

Example

model = LinearRegression(fit_intercept = True)

modelOutput

LinearRegression(copy_X = True, fit_intercept = True, n_jobs = None, normalize = False)Sắp xếp dữ liệu

Bây giờ, như chúng ta biết rằng biến mục tiêu của chúng ta y ở dạng đúng nghĩa là chiều dài n_samplesmảng 1-D. Tuy nhiên, chúng ta cần định hình lại ma trận tính năngX để biến nó thành một ma trận có kích thước [n_samples, n_features]. Nó có thể được thực hiện như sau:

Example

X = x[:, np.newaxis]

X.shapeOutput

(40, 1)Phù hợp mô hình

Một khi chúng ta sắp xếp dữ liệu, đã đến lúc phù hợp với mô hình tức là áp dụng mô hình của chúng ta vào dữ liệu. Điều này có thể được thực hiện với sự trợ giúp củafit() phương pháp như sau -

Example

model.fit(X, y)Output

LinearRegression(copy_X = True, fit_intercept = True, n_jobs = None,normalize = False)Trong Scikit-learning, fit() quy trình có một số dấu gạch dưới ở cuối.

Đối với ví dụ này, tham số dưới đây cho thấy độ dốc của sự phù hợp tuyến tính đơn giản của dữ liệu:

Example

model.coef_Output

array([1.99839352])Tham số dưới đây đại diện cho điểm chặn của sự phù hợp tuyến tính đơn giản với dữ liệu -

Example

model.intercept_Output

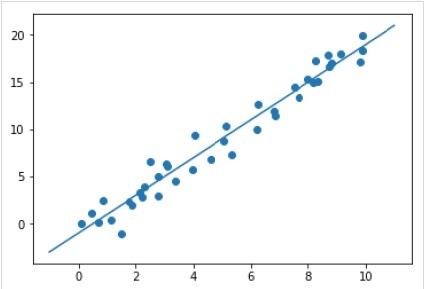

-0.9895459457775022Áp dụng mô hình cho dữ liệu mới

Sau khi đào tạo mô hình, chúng tôi có thể áp dụng nó vào dữ liệu mới. Vì nhiệm vụ chính của học máy có giám sát là đánh giá mô hình dựa trên dữ liệu mới không phải là một phần của tập huấn luyện. Nó có thể được thực hiện với sự giúp đỡ củapredict() phương pháp như sau -

Example

xfit = np.linspace(-1, 11)

Xfit = xfit[:, np.newaxis]

yfit = model.predict(Xfit)

plt.scatter(x, y)

plt.plot(xfit, yfit);Output

Hoàn thành ví dụ làm việc / thực thi

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shape

y_iris = iris['species']

y_iris.shape

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);

from sklearn.linear_model import LinearRegression

model = LinearRegression(fit_intercept=True)

model

X = x[:, np.newaxis]

X.shape

model.fit(X, y)

model.coef_

model.intercept_

xfit = np.linspace(-1, 11)

Xfit = xfit[:, np.newaxis]

yfit = model.predict(Xfit)

plt.scatter(x, y)

plt.plot(xfit, yfit);Ví dụ về học tập không giám sát

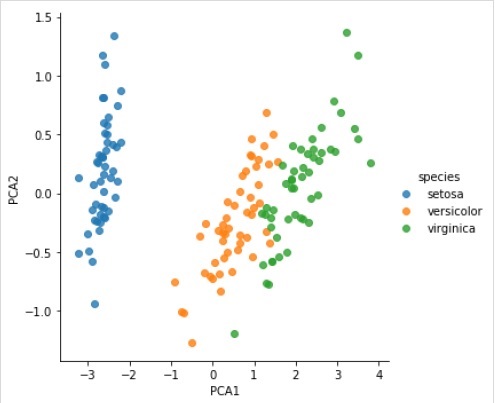

Ở đây, như một ví dụ về quy trình này, chúng tôi đang sử dụng trường hợp phổ biến là giảm kích thước của tập dữ liệu Iris để chúng ta có thể hình dung nó dễ dàng hơn. Đối với ví dụ này, chúng ta sẽ sử dụng phân tích thành phần chính (PCA), một kỹ thuật giảm kích thước tuyến tính nhanh.

Giống như ví dụ đã cho ở trên, chúng ta có thể tải và vẽ biểu đồ dữ liệu ngẫu nhiên từ tập dữ liệu mống mắt. Sau đó, chúng ta có thể làm theo các bước như sau:

Chọn một loại mô hình

from sklearn.decomposition import PCAChọn siêu tham số của mô hình

Example

model = PCA(n_components=2)

modelOutput

PCA(copy = True, iterated_power = 'auto', n_components = 2, random_state = None,

svd_solver = 'auto', tol = 0.0, whiten = False)Phù hợp mô hình

Example

model.fit(X_iris)Output

PCA(copy = True, iterated_power = 'auto', n_components = 2, random_state = None,

svd_solver = 'auto', tol = 0.0, whiten = False)Chuyển đổi dữ liệu sang hai chiều

Example

X_2D = model.transform(X_iris)Bây giờ, chúng ta có thể vẽ biểu đồ kết quả như sau:

Output

iris['PCA1'] = X_2D[:, 0]

iris['PCA2'] = X_2D[:, 1]

sns.lmplot("PCA1", "PCA2", hue = 'species', data = iris, fit_reg = False);Output

Hoàn thành ví dụ làm việc / thực thi

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shape

y_iris = iris['species']

y_iris.shape

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);

from sklearn.decomposition import PCA

model = PCA(n_components=2)

model

model.fit(X_iris)

X_2D = model.transform(X_iris)

iris['PCA1'] = X_2D[:, 0]

iris['PCA2'] = X_2D[:, 1]

sns.lmplot("PCA1", "PCA2", hue='species', data=iris, fit_reg=False);Các đối tượng của Scikit-learning chia sẻ một API cơ bản thống nhất bao gồm ba giao diện bổ sung sau:

Estimator interface - Nó là để xây dựng và lắp các mô hình.

Predictor interface - Nó là để đưa ra dự đoán.

Transformer interface - Nó là để chuyển đổi dữ liệu.

Các API áp dụng các quy ước đơn giản và các lựa chọn thiết kế đã được hướng dẫn theo cách để tránh sự phổ biến của mã khung.

Mục đích của Công ước

Mục đích của các quy ước là để đảm bảo rằng API tuân thủ các nguyên tắc chung sau:

Consistency - Tất cả các đối tượng cho dù chúng là cơ bản hay hỗn hợp đều phải chia sẻ một giao diện nhất quán bao gồm một tập hợp các phương thức hạn chế.

Inspection - Các tham số cấu tạo và các giá trị tham số được xác định bởi thuật toán học cần được lưu trữ và hiển thị dưới dạng các thuộc tính công khai.

Non-proliferation of classes - Tập dữ liệu nên được biểu diễn dưới dạng mảng NumPy hoặc ma trận thưa thớt Scipy trong khi tên và giá trị siêu tham số nên được biểu diễn dưới dạng chuỗi Python tiêu chuẩn để tránh sự gia tăng của mã khung.

Composition - Các thuật toán cho dù chúng có thể diễn đạt được dưới dạng chuỗi hoặc kết hợp của các phép biến đổi đối với dữ liệu hoặc được xem một cách tự nhiên như các thuật toán meta được tham số hóa trên các thuật toán khác, nên được triển khai và cấu thành từ các khối xây dựng hiện có.

Sensible defaults- Trong scikit-learning bất cứ khi nào một thao tác yêu cầu tham số do người dùng xác định, một giá trị mặc định thích hợp sẽ được xác định. Giá trị mặc định này sẽ làm cho hoạt động được thực hiện theo một cách hợp lý, chẳng hạn như đưa ra giải pháp đường cơ sở cho nhiệm vụ đang thực hiện.

Các quy ước khác nhau

Các quy ước có sẵn trong Sklearn được giải thích dưới đây:

Loại đúc

Nó nói rằng đầu vào phải được truyền tới float64. Trong ví dụ sau, trong đósklearn.random_projection mô-đun được sử dụng để giảm kích thước của dữ liệu, sẽ giải thích nó -

Example

import numpy as np

from sklearn import random_projection

rannge = np.random.RandomState(0)

X = range.rand(10,2000)

X = np.array(X, dtype = 'float32')

X.dtype

Transformer_data = random_projection.GaussianRandomProjection()

X_new = transformer.fit_transform(X)

X_new.dtypeOutput

dtype('float32')

dtype('float64')Trong ví dụ trên, chúng ta có thể thấy rằng X là float32 được đúc tới float64 bởi fit_transform(X).

Trang bị lại và cập nhật các thông số

Siêu tham số của một công cụ ước tính có thể được cập nhật và trang bị lại sau khi nó đã được xây dựng thông qua set_params()phương pháp. Hãy xem ví dụ sau để hiểu nó -

Example

import numpy as np

from sklearn.datasets import load_iris

from sklearn.svm import SVC

X, y = load_iris(return_X_y = True)

clf = SVC()

clf.set_params(kernel = 'linear').fit(X, y)

clf.predict(X[:5])Output

array([0, 0, 0, 0, 0])Khi công cụ ước tính đã được xây dựng, đoạn mã trên sẽ thay đổi hạt nhân mặc định rbf tuyến tính qua SVC.set_params().

Bây giờ, đoạn mã sau sẽ thay đổi kernel thành rbf để trang bị lại bộ ước lượng và đưa ra dự đoán thứ hai.

Example

clf.set_params(kernel = 'rbf', gamma = 'scale').fit(X, y)

clf.predict(X[:5])Output

array([0, 0, 0, 0, 0])Hoàn thành mã

Sau đây là chương trình thực thi hoàn chỉnh:

import numpy as np

from sklearn.datasets import load_iris

from sklearn.svm import SVC

X, y = load_iris(return_X_y = True)

clf = SVC()

clf.set_params(kernel = 'linear').fit(X, y)

clf.predict(X[:5])

clf.set_params(kernel = 'rbf', gamma = 'scale').fit(X, y)

clf.predict(X[:5])Đa thủy tinh & phù hợp nhiều nhãn

Trong trường hợp phù hợp nhiều lớp, cả nhiệm vụ học tập và dự đoán đều phụ thuộc vào định dạng của dữ liệu mục tiêu phù hợp. Mô-đun được sử dụng làsklearn.multiclass. Kiểm tra ví dụ bên dưới, nơi bộ phân loại nhiều lớp phù hợp trên một mảng 1d.

Example

from sklearn.svm import SVC

from sklearn.multiclass import OneVsRestClassifier

from sklearn.preprocessing import LabelBinarizer

X = [[1, 2], [3, 4], [4, 5], [5, 2], [1, 1]]

y = [0, 0, 1, 1, 2]

classif = OneVsRestClassifier(estimator = SVC(gamma = 'scale',random_state = 0))

classif.fit(X, y).predict(X)Output

array([0, 0, 1, 1, 2])Trong ví dụ trên, bộ phân loại phù hợp trên mảng một chiều của các nhãn đa kính và predict()do đó cung cấp dự đoán đa kính tương ứng. Nhưng mặt khác, nó cũng có thể phù hợp với một mảng hai chiều của các chỉ báo nhãn nhị phân như sau:

Example

from sklearn.svm import SVC

from sklearn.multiclass import OneVsRestClassifier

from sklearn.preprocessing import LabelBinarizer

X = [[1, 2], [3, 4], [4, 5], [5, 2], [1, 1]]

y = LabelBinarizer().fit_transform(y)

classif.fit(X, y).predict(X)Output

array(

[

[0, 0, 0],

[0, 0, 0],

[0, 1, 0],

[0, 1, 0],

[0, 0, 0]

]

)Tương tự, trong trường hợp phù hợp nhiều nhãn, một thể hiện có thể được gán nhiều nhãn như sau:

Example

from sklearn.preprocessing import MultiLabelBinarizer

y = [[0, 1], [0, 2], [1, 3], [0, 2, 3], [2, 4]]

y = MultiLabelBinarizer().fit_transform(y)

classif.fit(X, y).predict(X)Output

array(

[

[1, 0, 1, 0, 0],

[1, 0, 1, 0, 0],

[1, 0, 1, 1, 0],

[1, 0, 1, 1, 0],

[1, 0, 1, 0, 0]

]

)Trong ví dụ trên, sklearn.MultiLabelBinarizerđược sử dụng để mã hóa mảng đa nhãn hai chiều để vừa với. Đó là lý do tại sao hàm dự đoán () cung cấp một mảng 2d dưới dạng đầu ra với nhiều nhãn cho mỗi trường hợp.

Chương này sẽ giúp bạn tìm hiểu về mô hình tuyến tính trong Scikit-Learn. Chúng ta hãy bắt đầu bằng cách hiểu hồi quy tuyến tính trong Sklearn là gì.

Bảng sau liệt kê các mô hình tuyến tính khác nhau do Scikit-Learn cung cấp -

| Sr.No | Mô tả về mô hình |

|---|---|

| 1 | Hồi quy tuyến tính Đây là một trong những mô hình thống kê tốt nhất nghiên cứu mối quan hệ giữa một biến phụ thuộc (Y) với một tập hợp các biến độc lập (X) nhất định. |

| 2 | Hồi quy logistic Hồi quy logistic, bất chấp tên gọi của nó, là một thuật toán phân loại chứ không phải là thuật toán hồi quy. Dựa trên một tập hợp các biến độc lập nhất định, nó được sử dụng để ước tính giá trị rời rạc (0 hoặc 1, có / không, đúng / sai). |

| 3 | Hồi quy Ridge Hồi quy Ridge hoặc chính quy Tikhonov là kỹ thuật chính quy hóa thực hiện chính quy hóa L2. Nó sửa đổi hàm mất mát bằng cách thêm phần phạt (đại lượng co rút) tương đương với bình phương độ lớn của các hệ số. |

| 4 | Hồi quy Bayesian Ridge Hồi quy Bayes cho phép một cơ chế tự nhiên tồn tại khi không đủ dữ liệu hoặc dữ liệu được phân phối kém bằng cách xây dựng hồi quy tuyến tính sử dụng các nhà phân phối xác suất thay vì ước lượng điểm. |

| 5 | DÂY CỘT NGỰA LASSO là kỹ thuật chính quy thực hiện chính quy hóa L1. Nó sửa đổi hàm mất mát bằng cách thêm phần phạt (đại lượng co rút) tương đương với tổng giá trị tuyệt đối của các hệ số. |

| 6 | LASSO đa tác vụ Nó cho phép kết hợp nhiều vấn đề hồi quy cùng thực thi các tính năng đã chọn giống nhau cho tất cả các vấn đề hồi quy, còn được gọi là nhiệm vụ. Sklearn cung cấp một mô hình tuyến tính có tên MultiTaskLasso, được đào tạo với chuẩn L1, L2 hỗn hợp để chính quy hóa, ước tính các hệ số thưa thớt cho nhiều bài toán hồi quy cùng nhau. |

| 7 | Mạng đàn hồi Elastic-Net là một phương pháp hồi quy chính quy kết hợp tuyến tính cả hai hình phạt tức là L1 và L2 của phương pháp hồi quy Lasso và Ridge. Nó hữu ích khi có nhiều tính năng tương quan. |

| số 8 | Multi-task Elastic-Net Đây là một mô hình Elastic-Net cho phép kết hợp nhiều vấn đề hồi quy cùng thực thi các tính năng đã chọn giống nhau cho tất cả các vấn đề hồi quy, còn được gọi là nhiệm vụ |

Chương này tập trung vào các tính năng đa thức và các công cụ tạo chuỗi trong Sklearn.

Giới thiệu về các tính năng đa thức

Các mô hình tuyến tính được đào tạo về các hàm phi tuyến tính của dữ liệu thường duy trì hiệu suất nhanh chóng của các phương pháp tuyến tính. Nó cũng cho phép chúng phù hợp với nhiều loại dữ liệu hơn. Đó là lý do trong máy học, các mô hình tuyến tính được đào tạo về các hàm phi tuyến được sử dụng.

Một ví dụ như vậy là một hồi quy tuyến tính đơn giản có thể được mở rộng bằng cách xây dựng các đặc trưng đa thức từ các hệ số.

Về mặt toán học, giả sử chúng ta có mô hình hồi quy tuyến tính tiêu chuẩn thì đối với dữ liệu 2-D, nó sẽ giống như sau:

$$Y=W_{0}+W_{1}X_{1}+W_{2}X_{2}$$Bây giờ, chúng ta có thể kết hợp các tính năng trong đa thức bậc hai và mô hình của chúng ta sẽ giống như sau:

$$Y=W_{0}+W_{1}X_{1}+W_{2}X_{2}+W_{3}X_{1}X_{2}+W_{4}X_1^2+W_{5}X_2^2$$Trên đây vẫn là mô hình tuyến tính. Ở đây, chúng ta thấy rằng hồi quy đa thức thu được nằm trong cùng một loại mô hình tuyến tính và có thể được giải quyết tương tự.

Để làm như vậy, scikit-learning cung cấp một mô-đun có tên PolynomialFeatures. Mô-đun này chuyển ma trận dữ liệu đầu vào thành một ma trận dữ liệu mới có mức độ nhất định.

Thông số

Bảng theo dõi bao gồm các thông số được sử dụng bởi PolynomialFeatures mô-đun

| Sr.No | Mô tả về Thông Số |

|---|---|

| 1 | degree - số nguyên, mặc định = 2 Nó đại diện cho mức độ của các đối tượng đa thức. |

| 2 | interaction_only - Boolean, default = false Theo mặc định, nó là false nhưng nếu được đặt là true, các đối tượng địa lý là sản phẩm của hầu hết các tính năng đầu vào khác biệt ở mức độ khác nhau, được tạo ra. Các tính năng như vậy được gọi là tính năng tương tác. |

| 3 | include_bias - Boolean, default = true Nó bao gồm một cột thiên vị tức là tính năng trong đó tất cả các lũy thừa của đa thức đều bằng không. |

| 4 | order - str trong {'C', 'F'}, default = 'C' Tham số này đại diện cho thứ tự của mảng đầu ra trong trường hợp dày đặc. Lệnh 'F' có nghĩa là tính toán nhanh hơn nhưng mặt khác, nó có thể làm chậm các công cụ ước tính tiếp theo. |

Thuộc tính

Bảng theo dõi bao gồm các thuộc tính được sử dụng bởi PolynomialFeatures mô-đun

| Sr.No | Thuộc tính & Mô tả |

|---|---|

| 1 | powers_ - mảng, hình dạng (n_output_features, n_input_features) Nó cho thấy powers_ [i, j] là số mũ của đầu vào thứ j trong đầu ra thứ i. |

| 2 | n_input_features _ - int Như tên cho thấy, nó cung cấp tổng số tính năng đầu vào. |

| 3 | n_output_features _ - int Như tên cho thấy, nó cung cấp tổng số các tính năng đầu ra đa thức. |

Ví dụ triển khai

Sử dụng script Python sau PolynomialFeatures biến áp để biến đổi mảng 8 thành hình dạng (4,2) -

from sklearn.preprocessing import PolynomialFeatures

import numpy as np

Y = np.arange(8).reshape(4, 2)

poly = PolynomialFeatures(degree=2)

poly.fit_transform(Y)Đầu ra

array(

[

[ 1., 0., 1., 0., 0., 1.],

[ 1., 2., 3., 4., 6., 9.],

[ 1., 4., 5., 16., 20., 25.],

[ 1., 6., 7., 36., 42., 49.]

]

)Hợp lý hóa bằng các công cụ Pipeline

Loại tiền xử lý ở trên tức là chuyển đổi ma trận dữ liệu đầu vào thành ma trận dữ liệu mới ở mức độ nhất định, có thể được sắp xếp hợp lý với Pipeline các công cụ về cơ bản được sử dụng để xâu chuỗi nhiều công cụ ước tính thành một.

Thí dụ

Các tập lệnh python dưới đây sử dụng các công cụ Pipeline của Scikit-learning để hợp lý hóa quá trình tiền xử lý (sẽ phù hợp với dữ liệu đa thức bậc 3).

#First, import the necessary packages.

from sklearn.preprocessing import PolynomialFeatures

from sklearn.linear_model import LinearRegression

from sklearn.pipeline import Pipeline

import numpy as np

#Next, create an object of Pipeline tool

Stream_model = Pipeline([('poly', PolynomialFeatures(degree=3)), ('linear', LinearRegression(fit_intercept=False))])

#Provide the size of array and order of polynomial data to fit the model.

x = np.arange(5)

y = 3 - 2 * x + x ** 2 - x ** 3

Stream_model = model.fit(x[:, np.newaxis], y)

#Calculate the input polynomial coefficients.

Stream_model.named_steps['linear'].coef_Đầu ra

array([ 3., -2., 1., -1.])Kết quả đầu ra ở trên cho thấy rằng mô hình tuyến tính được đào tạo về các đặc trưng của đa thức có thể khôi phục các hệ số đa thức đầu vào chính xác.

Ở đây, chúng ta sẽ tìm hiểu về một thuật toán tối ưu hóa trong Sklearn, được gọi là Stochastic Gradient Descent (SGD).

Stochastic Gradient Descent (SGD) là một thuật toán tối ưu hóa đơn giản nhưng hiệu quả được sử dụng để tìm các giá trị của tham số / hệ số của các hàm làm tối thiểu hóa hàm chi phí. Nói cách khác, nó được sử dụng để học phân biệt các bộ phân loại tuyến tính dưới các hàm mất lồi như hồi quy SVM và Logistic. Nó đã được áp dụng thành công cho các bộ dữ liệu quy mô lớn bởi vì việc cập nhật các hệ số được thực hiện cho từng phiên bản huấn luyện, thay vì ở cuối các phiên bản.

Bộ phân loại SGD

Bộ phân loại Stochastic Gradient Descent (SGD) về cơ bản thực hiện một quy trình học SGD đơn giản hỗ trợ các hàm và hình phạt mất mát khác nhau để phân loại. Scikit-learning cung cấpSGDClassifier phân hệ thực hiện phân loại SGD.

Thông số

Bảng theo dõi bao gồm các thông số được sử dụng bởi SGDClassifier mô-đun -

| Sr.No | Mô tả về Thông Số |

|---|---|

| 1 | loss - str, default = 'bản lề' Nó đại diện cho hàm mất mát được sử dụng trong khi thực hiện. Giá trị mặc định là 'bản lề' sẽ cung cấp cho chúng ta một SVM tuyến tính. Các tùy chọn khác có thể được sử dụng là -

|

| 2 | penalty - str, 'none', 'l2', 'l1','asticnet ' Nó là thuật ngữ chính quy hóa được sử dụng trong mô hình. Theo mặc định, nó là L2. Chúng ta có thể sử dụng L1 hoặc'asticnet; nhưng cả hai đều có thể mang lại sự thưa thớt cho mô hình, do đó không thể đạt được với L2. |

| 3 | alpha - float, default = 0,0001 Alpha, hằng số nhân với thuật ngữ chính quy, là tham số điều chỉnh quyết định mức độ chúng ta muốn phạt mô hình. Giá trị mặc định là 0,0001. |

| 4 | l1_ratio - float, default = 0.15 Đây được gọi là tham số trộn ElasticNet. Phạm vi của nó là 0 <= l1_ratio <= 1. Nếu l1_ratio = 1, hình phạt sẽ là hình phạt L1. Nếu l1_ratio = 0, hình phạt sẽ là hình phạt L2. |

| 5 | fit_intercept - Boolean, Mặc định = Đúng Tham số này chỉ định rằng một hằng số (thiên vị hoặc chặn) nên được thêm vào hàm quyết định. Không có điểm chặn nào sẽ được sử dụng trong tính toán và dữ liệu sẽ được giả định là đã được căn giữa, nếu nó sẽ được đặt thành false. |

| 6 | tol - float hoặc none, tùy chọn, mặc định = 1.e-3 Tham số này đại diện cho tiêu chí dừng cho các lần lặp. Giá trị mặc định của nó là Sai nhưng nếu được đặt thành Không, các lần lặp sẽ dừng lại khiloss > best_loss - tol for n_iter_no_changecác kỷ nguyên kế tiếp nhau. |

| 7 | shuffle - Boolean, tùy chọn, mặc định = True Tham số này thể hiện rằng chúng ta có muốn dữ liệu đào tạo của mình được xáo trộn sau mỗi kỷ nguyên hay không. |

| số 8 | verbose - số nguyên, mặc định = 0 Nó thể hiện mức độ chi tiết. Giá trị mặc định của nó là 0. |

| 9 | epsilon - float, default = 0,1 Tham số này chỉ định độ rộng của vùng không nhạy cảm. Nếu loss = 'epsilon-insensitive', bất kỳ sự khác biệt nào, giữa dự đoán hiện tại và nhãn chính xác, nhỏ hơn ngưỡng sẽ bị bỏ qua. |

| 10 | max_iter - int, tùy chọn, mặc định = 1000 Như tên gợi ý, nó đại diện cho số lần vượt qua tối đa trong các kỷ nguyên tức là dữ liệu đào tạo. |

| 11 | warm_start - bool, tùy chọn, mặc định = false Với tham số này được đặt thành True, chúng ta có thể sử dụng lại giải pháp của cuộc gọi trước đó để phù hợp với vai trò khởi tạo. Nếu chúng ta chọn default tức là false, nó sẽ xóa giải pháp trước đó. |

| 12 | random_state - int, RandomState instance hoặc None, tùy chọn, default = none Tham số này đại diện cho hạt giống của số ngẫu nhiên giả được tạo ra được sử dụng trong khi xáo trộn dữ liệu. Tiếp theo là các tùy chọn.

|

| 13 | n_jobs - int hoặc none, tùy chọn, Mặc định = Không có Nó đại diện cho số lượng CPU được sử dụng trong tính toán OVA (Một so với tất cả), cho các bài toán nhiều lớp. Giá trị mặc định không có nghĩa là 1. |

| 14 | learning_rate - chuỗi, tùy chọn, mặc định = 'tối ưu'

|

| 15 | eta0 - gấp đôi, mặc định = 0,0 Nó đại diện cho tốc độ học ban đầu cho các tùy chọn tốc độ học tập đã đề cập ở trên, tức là 'không đổi', 'gọi điện' hoặc 'thích ứng'. |

| 16 | power_t - idouble, mặc định = 0,5 Nó là số mũ cho tỷ lệ học tập 'incscalling'. |

| 17 | early_stopping - bool, mặc định = Sai Tham số này thể hiện việc sử dụng tính năng dừng sớm để chấm dứt đào tạo khi điểm xác nhận không được cải thiện. Giá trị mặc định của nó là false nhưng khi được đặt thành true, nó sẽ tự động dành một phần dữ liệu huấn luyện được phân tầng để xác thực và dừng huấn luyện khi điểm xác thực không cải thiện. |

| 18 | validation_fraction - float, default = 0,1 Nó chỉ được sử dụng khi early_stopping là true. Nó đại diện cho tỷ lệ dữ liệu đào tạo để đặt phụ trợ làm bộ xác nhận để kết thúc sớm dữ liệu đào tạo .. |

| 19 | n_iter_no_change - int, default = 5 Nó đại diện cho số lần lặp lại không có cải tiến nên thuật toán chạy trước khi dừng sớm. |

| 20 | classs_weight - dict, {class_label: weight} hoặc "balance", hoặc Không, tùy chọn Tham số này đại diện cho trọng số liên quan đến các lớp. Nếu không được cung cấp, các lớp phải có trọng số 1. |

| 20 | warm_start - bool, tùy chọn, mặc định = false Với tham số này được đặt thành True, chúng ta có thể sử dụng lại giải pháp của cuộc gọi trước đó để phù hợp với vai trò khởi tạo. Nếu chúng ta chọn default tức là false, nó sẽ xóa giải pháp trước đó. |

| 21 | average - iBoolean hoặc int, tùy chọn, default = false Nó đại diện cho số lượng CPU được sử dụng trong tính toán OVA (Một so với tất cả), cho các bài toán nhiều lớp. Giá trị mặc định không có nghĩa là 1. |

Thuộc tính

Bảng sau bao gồm các thuộc tính được sử dụng bởi SGDClassifier mô-đun -

| Sr.No | Thuộc tính & Mô tả |

|---|---|

| 1 | coef_ - mảng, hình dạng (1, n_features) if n_classes == 2, else (n_classes, n_features) Thuộc tính này cung cấp trọng số được gán cho các đối tượng địa lý. |

| 2 | intercept_ - mảng, hình dạng (1,) if n_classes == 2, else (n_classes,) Nó thể hiện thuật ngữ độc lập trong chức năng quyết định. |

| 3 | n_iter_ - int Nó cung cấp số lần lặp lại để đạt được tiêu chí dừng. |

Implementation Example

Giống như các bộ phân loại khác, Stochastic Gradient Descent (SGD) phải được trang bị với hai mảng sau:

Một mảng X chứa các mẫu huấn luyện. Nó có kích thước [n_samples, n_features].

Một mảng Y chứa các giá trị đích tức là nhãn lớp cho các mẫu huấn luyện. Nó có kích thước [n_samples].

Example

Tập lệnh Python sau sử dụng mô hình tuyến tính SGDClassifier -

import numpy as np

from sklearn import linear_model

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

Y = np.array([1, 1, 2, 2])

SGDClf = linear_model.SGDClassifier(max_iter = 1000, tol=1e-3,penalty = "elasticnet")

SGDClf.fit(X, Y)Output

SGDClassifier(

alpha = 0.0001, average = False, class_weight = None,

early_stopping = False, epsilon = 0.1, eta0 = 0.0, fit_intercept = True,

l1_ratio = 0.15, learning_rate = 'optimal', loss = 'hinge', max_iter = 1000,

n_iter = None, n_iter_no_change = 5, n_jobs = None, penalty = 'elasticnet',

power_t = 0.5, random_state = None, shuffle = True, tol = 0.001,

validation_fraction = 0.1, verbose = 0, warm_start = False

)Example

Bây giờ, sau khi được trang bị, mô hình có thể dự đoán các giá trị mới như sau:

SGDClf.predict([[2.,2.]])Output

array([2])Example

Đối với ví dụ trên, chúng ta có thể lấy vector trọng số với sự trợ giúp của tập lệnh python sau:

SGDClf.coef_Output

array([[19.54811198, 9.77200712]])Example

Tương tự, chúng ta có thể nhận giá trị của intercept với sự trợ giúp của tập lệnh python sau:

SGDClf.intercept_Output

array([10.])Example

Chúng ta có thể nhận được khoảng cách đã ký đến siêu phẳng bằng cách sử dụng SGDClassifier.decision_function như được sử dụng trong tập lệnh python sau:

SGDClf.decision_function([[2., 2.]])Output

array([68.6402382])Bộ điều chỉnh SGD

Bộ hồi quy Stochastic Gradient Descent (SGD) về cơ bản thực hiện một quy trình học SGD đơn giản hỗ trợ các hàm và hình phạt mất mát khác nhau để phù hợp với các mô hình hồi quy tuyến tính. Scikit-learning cung cấpSGDRegressor mô-đun thực hiện hồi quy SGD.

Thông số

Các thông số được sử dụng bởi SGDRegressorgần giống như được sử dụng trong mô-đun SGDClassifier. Sự khác biệt nằm ở tham số 'mất mát'. Đối vớiSGDRegressor tham số mất mát của mô-đun các giá trị tích cực như sau:

squared_loss - Nó đề cập đến sự phù hợp với hình vuông nhỏ nhất thông thường.

huber: SGDRegressor- sửa các giá trị ngoại lệ bằng cách chuyển từ tổn thất bình phương sang tuyến tính trong khoảng cách epsilon. Công việc của 'huber' là sửa đổi 'squared_loss' để thuật toán tập trung ít hơn vào việc điều chỉnh các ngoại lệ.

epsilon_insensitive - Trên thực tế, nó bỏ qua các lỗi ít hơn epsilon.

squared_epsilon_insensitive- Nó giống như epsilon_insensitive. Sự khác biệt duy nhất là nó trở thành tổn thất bình phương trước một dung sai epsilon.

Một điểm khác biệt nữa là tham số có tên 'power_t' có giá trị mặc định là 0,25 thay vì 0,5 như trong SGDClassifier. Hơn nữa, nó không có các tham số 'class_weight' và 'n_jobs'.

Thuộc tính

Các thuộc tính của SGDRegressor cũng giống như thuộc tính của mô-đun SGDClassifier. Đúng hơn nó có ba thuộc tính bổ sung như sau:

average_coef_ - mảng, hình dạng (n_features,)

Như tên gợi ý, nó cung cấp trọng lượng trung bình được gán cho các tính năng.

average_intercept_ - mảng, hình dạng (1,)

Như tên gợi ý, nó cung cấp thuật ngữ đánh chặn trung bình.

t_ - int

Nó cung cấp số lần cập nhật trọng lượng được thực hiện trong giai đoạn đào tạo.

Note - các thuộc tính average_coef_ và average_intercept_ sẽ hoạt động sau khi bật tham số 'average' thành True.

Implementation Example

Sử dụng script Python sau SGDRegressor mô hình tuyến tính -

import numpy as np

from sklearn import linear_model

n_samples, n_features = 10, 5

rng = np.random.RandomState(0)

y = rng.randn(n_samples)

X = rng.randn(n_samples, n_features)

SGDReg =linear_model.SGDRegressor(

max_iter = 1000,penalty = "elasticnet",loss = 'huber',tol = 1e-3, average = True

)

SGDReg.fit(X, y)Output

SGDRegressor(

alpha = 0.0001, average = True, early_stopping = False, epsilon = 0.1,

eta0 = 0.01, fit_intercept = True, l1_ratio = 0.15,

learning_rate = 'invscaling', loss = 'huber', max_iter = 1000,

n_iter = None, n_iter_no_change = 5, penalty = 'elasticnet', power_t = 0.25,

random_state = None, shuffle = True, tol = 0.001, validation_fraction = 0.1,

verbose = 0, warm_start = False

)Example

Bây giờ, sau khi được trang bị, chúng ta có thể lấy vector trọng lượng với sự trợ giúp của tập lệnh python sau:

SGDReg.coef_Output

array([-0.00423314, 0.00362922, -0.00380136, 0.00585455, 0.00396787])Example

Tương tự, chúng ta có thể nhận giá trị của intercept với sự trợ giúp của tập lệnh python sau:

SGReg.intercept_Output

SGReg.intercept_Example

Chúng tôi có thể nhận được số lần cập nhật trọng lượng trong giai đoạn đào tạo với sự trợ giúp của tập lệnh python sau:

SGDReg.t_Output

61.0Ưu và nhược điểm của SGD

Theo những ưu điểm của SGD -

Stochastic Gradient Descent (SGD) rất hiệu quả.

Nó rất dễ thực hiện vì có rất nhiều cơ hội để điều chỉnh mã.

Theo nhược điểm của SGD -

Stochastic Gradient Descent (SGD) yêu cầu một số siêu tham số như các tham số chính quy.

Nó nhạy cảm với việc mở rộng tính năng.

Chương này đề cập đến một phương pháp học máy được gọi là Máy vectơ hỗ trợ (SVM).

Giới thiệu

Máy vectơ hỗ trợ (SVM) là phương pháp học máy được giám sát mạnh mẽ nhưng linh hoạt được sử dụng để phân loại, hồi quy và phát hiện các ngoại lệ. SVM rất hiệu quả trong không gian chiều cao và thường được sử dụng trong các bài toán phân loại. SVM phổ biến và hiệu quả về bộ nhớ vì chúng sử dụng một tập hợp con các điểm huấn luyện trong hàm quyết định.

Mục tiêu chính của SVM là chia bộ dữ liệu thành số lớp để tìm maximum marginal hyperplane (MMH) có thể được thực hiện theo hai bước sau:

Máy hỗ trợ Vector đầu tiên sẽ tạo lặp đi lặp lại các siêu máy bay để phân tách các lớp theo cách tốt nhất.

Sau đó, nó sẽ chọn siêu phẳng phân tách các lớp một cách chính xác.

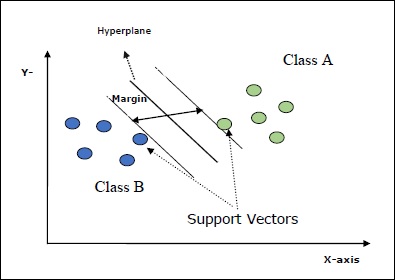

Một số khái niệm quan trọng trong SVM như sau:

Support Vectors- Chúng có thể được định nghĩa là các điểm dữ liệu gần nhất với siêu phẳng. Các vectơ hỗ trợ giúp quyết định đường phân cách.

Hyperplane - Mặt phẳng quyết định hoặc không gian phân chia tập hợp các đối tượng có các lớp khác nhau.

Margin - Khoảng cách giữa hai dòng trên các điểm dữ liệu tủ của các lớp khác nhau được gọi là lề.

Các sơ đồ sau sẽ cung cấp cho bạn cái nhìn sâu sắc về các khái niệm SVM này -

SVM trong Scikit-learning hỗ trợ cả vectơ mẫu thưa thớt và dày đặc làm đầu vào.

Phân loại SVM

Scikit-learning cung cấp ba lớp cụ thể là SVC, NuSVC và LinearSVC có thể thực hiện phân loại lớp đa kính.

SVC

Đó là phân loại vectơ hỗ trợ C mà việc triển khai dựa trên libsvm. Mô-đun được sử dụng bởi scikit-learning làsklearn.svm.SVC. Lớp này xử lý hỗ trợ đa kính theo sơ đồ một chọi một.

Thông số

Bảng theo dõi bao gồm các thông số được sử dụng bởi sklearn.svm.SVC lớp học -

| Sr.No | Mô tả về Thông Số |

|---|---|

| 1 | C - float, tùy chọn, mặc định = 1.0 Nó là tham số phạt của thuật ngữ lỗi. |

| 2 | kernel - string, option, default = 'rbf' Tham số này chỉ định loại hạt nhân sẽ được sử dụng trong thuật toán. chúng ta có thể chọn bất kỳ cái nào trong số,‘linear’, ‘poly’, ‘rbf’, ‘sigmoid’, ‘precomputed’. Giá trị mặc định của kernel sẽ là‘rbf’. |

| 3 | degree - int, tùy chọn, mặc định = 3 Nó đại diện cho mức độ của chức năng hạt nhân 'poly' và sẽ bị bỏ qua bởi tất cả các hạt nhân khác. |

| 4 | gamma - {'scale', 'auto'} hoặc float, Nó là hệ số nhân cho các nhân 'rbf', 'poly' và 'sigmoid'. |

| 5 | optinal default - = 'quy mô' Nếu bạn chọn mặc định tức là gamma = 'scale' thì giá trị của gamma được SVC sử dụng là 1 / (_ ∗. ()). Mặt khác, nếu gamma = 'auto', nó sử dụng 1 / _. |

| 6 | coef0 - float, tùy chọn, Mặc định = 0.0 Một thuật ngữ độc lập trong hàm nhân chỉ có ý nghĩa trong 'poly' và 'sigmoid'. |

| 7 | tol - float, tùy chọn, mặc định = 1.e-3 Tham số này đại diện cho tiêu chí dừng cho các lần lặp. |

| số 8 | shrinking - Boolean, tùy chọn, mặc định = True Tham số này thể hiện rằng chúng ta có muốn sử dụng heuristic thu nhỏ hay không. |

| 9 | verbose - Boolean, mặc định: false Nó bật hoặc tắt đầu ra dài dòng. Giá trị mặc định của nó là sai. |

| 10 | probability - boolean, tùy chọn, mặc định = true Tham số này bật hoặc tắt các ước tính xác suất. Giá trị mặc định là false, nhưng nó phải được kích hoạt trước khi chúng tôi gọi là fit. |

| 11 | max_iter - int, tùy chọn, mặc định = -1 Như tên gợi ý, nó đại diện cho số lần lặp lại tối đa trong bộ giải. Giá trị -1 nghĩa là không có giới hạn về số lần lặp. |

| 12 | cache_size - phao, tùy chọn Tham số này sẽ chỉ định kích thước của bộ đệm ẩn hạt nhân. Giá trị sẽ tính bằng MB (MegaBytes). |

| 13 | random_state - int, RandomState instance hoặc None, tùy chọn, default = none Tham số này đại diện cho hạt giống của số ngẫu nhiên giả được tạo ra được sử dụng trong khi xáo trộn dữ liệu. Tiếp theo là các tùy chọn -

|

| 14 | class_weight - {dict, 'balance'}, tùy chọn Tham số này sẽ đặt tham số C của lớp j là _ℎ [] ∗ cho SVC. Nếu chúng ta sử dụng tùy chọn mặc định, điều đó có nghĩa là tất cả các lớp phải có trọng số là một. Mặt khác, nếu bạn chọnclass_weight:balanced, nó sẽ sử dụng các giá trị của y để tự động điều chỉnh trọng số. |

| 15 | decision_function_shape - ovo ',' ovr ', default =' ovr ' Tham số này sẽ quyết định liệu thuật toán có trả về hay không ‘ovr’ (một so với phần còn lại) chức năng quyết định của hình dạng như tất cả các bộ phân loại khác, hoặc ban đầu ovo(một đối một) chức năng quyết định của libsvm. |

| 16 | break_ties - boolean, tùy chọn, mặc định = false True - Dự đoán sẽ phá vỡ mối quan hệ theo các giá trị tin cậy của hàm quyết định False - Dự đoán sẽ trả về lớp đầu tiên trong số các lớp bị ràng buộc. |

Thuộc tính

Bảng theo dõi bao gồm các thuộc tính được sử dụng bởi sklearn.svm.SVC lớp học -

| Sr.No | Thuộc tính & Mô tả |

|---|---|

| 1 | support_ - dạng mảng, hình dạng = [n_SV] Nó trả về các chỉ số của các vectơ hỗ trợ. |

| 2 | support_vectors_ - dạng mảng, hình dạng = [n_SV, n_features] Nó trả về các vectơ hỗ trợ. |

| 3 | n_support_ - dạng mảng, dtype = int32, shape = [n_class] Nó đại diện cho số lượng các vectơ hỗ trợ cho mỗi lớp. |

| 4 | dual_coef_ - mảng, hình dạng = [n_class-1, n_SV] Đây là hệ số của các vectơ hỗ trợ trong hàm quyết định. |

| 5 | coef_ - mảng, hình dạng = [n_class * (n_class-1) / 2, n_features] Thuộc tính này, chỉ khả dụng trong trường hợp hạt nhân tuyến tính, cung cấp trọng số được gán cho các tính năng. |

| 6 | intercept_ - mảng, hình dạng = [n_class * (n_class-1) / 2] Nó đại diện cho thuật ngữ độc lập (hằng số) trong chức năng quyết định. |

| 7 | fit_status_ - int Đầu ra sẽ là 0 nếu nó được lắp đúng cách. Đầu ra sẽ là 1 nếu nó được lắp không chính xác. |

| số 8 | classes_ - mảng hình dạng = [n_classes] Nó cung cấp các nhãn của các lớp. |

Implementation Example

Giống như các bộ phân loại khác, SVC cũng phải được trang bị hai mảng sau:

Một mảng Xgiữ các mẫu đào tạo. Nó có kích thước [n_samples, n_features].

Một mảng Ygiữ các giá trị đích tức là nhãn lớp cho các mẫu huấn luyện. Nó có kích thước [n_samples].

Sử dụng script Python sau sklearn.svm.SVC lớp học -

import numpy as np

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

y = np.array([1, 1, 2, 2])

from sklearn.svm import SVC

SVCClf = SVC(kernel = 'linear',gamma = 'scale', shrinking = False,)

SVCClf.fit(X, y)Output

SVC(C = 1.0, cache_size = 200, class_weight = None, coef0 = 0.0,

decision_function_shape = 'ovr', degree = 3, gamma = 'scale', kernel = 'linear',

max_iter = -1, probability = False, random_state = None, shrinking = False,

tol = 0.001, verbose = False)Example

Bây giờ, sau khi được trang bị, chúng ta có thể lấy vector trọng lượng với sự trợ giúp của tập lệnh python sau:

SVCClf.coef_Output

array([[0.5, 0.5]])Example

Tương tự, chúng ta có thể lấy giá trị của các thuộc tính khác như sau:

SVCClf.predict([[-0.5,-0.8]])Output

array([1])Example

SVCClf.n_support_Output

array([1, 1])Example

SVCClf.support_vectors_Output

array(

[

[-1., -1.],

[ 1., 1.]

]

)Example

SVCClf.support_Output

array([0, 2])Example

SVCClf.intercept_Output

array([-0.])Example

SVCClf.fit_status_Output

0NuSVC

NuSVC là Phân loại Vectơ hỗ trợ Nu. Nó là một lớp khác được cung cấp bởi scikit-learning có thể thực hiện phân loại nhiều lớp. Nó giống như SVC nhưng NuSVC chấp nhận các bộ tham số hơi khác một chút. Tham số khác với SVC như sau:

nu - float, tùy chọn, mặc định = 0.5

Nó đại diện cho giới hạn trên của phần nhỏ lỗi huấn luyện và giới hạn dưới của phần nhỏ của vectơ hỗ trợ. Giá trị của nó phải nằm trong khoảng (o, 1].

Phần còn lại của các tham số và thuộc tính giống như của SVC.

Ví dụ triển khai

Chúng ta có thể triển khai cùng một ví dụ bằng cách sử dụng sklearn.svm.NuSVC lớp cũng vậy.

import numpy as np

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

y = np.array([1, 1, 2, 2])

from sklearn.svm import NuSVC

NuSVCClf = NuSVC(kernel = 'linear',gamma = 'scale', shrinking = False,)

NuSVCClf.fit(X, y)Đầu ra

NuSVC(cache_size = 200, class_weight = None, coef0 = 0.0,

decision_function_shape = 'ovr', degree = 3, gamma = 'scale', kernel = 'linear',

max_iter = -1, nu = 0.5, probability = False, random_state = None,

shrinking = False, tol = 0.001, verbose = False)Chúng ta có thể lấy kết quả đầu ra của phần còn lại của các thuộc tính như đã làm trong trường hợp SVC.

LinearSVC

Đó là Phân loại véc tơ hỗ trợ tuyến tính. Nó tương tự như SVC có kernel = 'linear'. Sự khác biệt giữa chúng làLinearSVC được triển khai theo liblinear trong khi SVC được triển khai trong libsvm. Đó là lý doLinearSVClinh hoạt hơn trong việc lựa chọn hình phạt và chức năng thua lỗ. Nó cũng mở rộng quy mô tốt hơn với số lượng lớn mẫu.

Nếu chúng ta nói về các tham số và thuộc tính của nó thì nó không hỗ trợ ‘kernel’ bởi vì nó được giả định là tuyến tính và nó cũng thiếu một số thuộc tính như support_, support_vectors_, n_support_, fit_status_ và, dual_coef_.

Tuy nhiên, nó hỗ trợ penalty và loss các thông số như sau -

penalty − string, L1 or L2(default = ‘L2’)

Tham số này được sử dụng để xác định quy chuẩn (L1 hoặc L2) được sử dụng trong hình phạt (chính quy hóa).

loss − string, hinge, squared_hinge (default = squared_hinge)

Nó đại diện cho hàm mất mát trong đó 'bản lề' là tổn thất SVM tiêu chuẩn và 'bình phương_hóa' là bình phương của tổn thất bản lề.

Ví dụ triển khai

Sử dụng script Python sau sklearn.svm.LinearSVC lớp học -

from sklearn.svm import LinearSVC

from sklearn.datasets import make_classification

X, y = make_classification(n_features = 4, random_state = 0)

LSVCClf = LinearSVC(dual = False, random_state = 0, penalty = 'l1',tol = 1e-5)

LSVCClf.fit(X, y)Đầu ra

LinearSVC(C = 1.0, class_weight = None, dual = False, fit_intercept = True,

intercept_scaling = 1, loss = 'squared_hinge', max_iter = 1000,

multi_class = 'ovr', penalty = 'l1', random_state = 0, tol = 1e-05, verbose = 0)Thí dụ

Bây giờ, sau khi được trang bị, mô hình có thể dự đoán các giá trị mới như sau:

LSVCClf.predict([[0,0,0,0]])Đầu ra

[1]Thí dụ

Đối với ví dụ trên, chúng ta có thể lấy vector trọng số với sự trợ giúp của tập lệnh python sau:

LSVCClf.coef_Đầu ra

[[0. 0. 0.91214955 0.22630686]]Thí dụ

Tương tự, chúng ta có thể nhận giá trị của intercept với sự trợ giúp của tập lệnh python sau:

LSVCClf.intercept_Đầu ra

[0.26860518]Hồi quy với SVM

Như đã thảo luận trước đó, SVM được sử dụng cho cả vấn đề phân loại và hồi quy. Phương pháp phân loại véc tơ hỗ trợ (SVC) của Scikit-learning cũng có thể được mở rộng để giải các bài toán hồi quy. Phương pháp mở rộng đó được gọi là hồi quy vectơ hỗ trợ (SVR).

Điểm giống nhau cơ bản giữa SVM và SVR

Mô hình do SVC tạo ra chỉ phụ thuộc vào một tập con dữ liệu huấn luyện. Tại sao? Bởi vì hàm chi phí cho việc xây dựng mô hình không quan tâm đến các điểm dữ liệu huấn luyện nằm ngoài lề.

Trong khi đó, mô hình được tạo ra bởi SVR (Hồi quy vectơ hỗ trợ) cũng chỉ phụ thuộc vào một tập con của dữ liệu huấn luyện. Tại sao? Bởi vì hàm chi phí để xây dựng mô hình bỏ qua bất kỳ điểm dữ liệu huấn luyện nào gần với dự đoán của mô hình.

Scikit-learning cung cấp ba lớp cụ thể là SVR, NuSVR and LinearSVR như ba cách triển khai khác nhau của SVR.

SVR

Nó là hồi quy vectơ hỗ trợ Epsilon mà việc triển khai dựa trên libsvm. Đối lập vớiSVC Có hai tham số miễn phí trong mô hình là ‘C’ và ‘epsilon’.

epsilon - float, tùy chọn, mặc định = 0,1

Nó đại diện cho epsilon trong mô hình epsilon-SVR và chỉ định ống epsilon trong đó không có hình phạt nào được liên kết trong chức năng mất tập luyện với các điểm được dự đoán trong khoảng cách epsilon so với giá trị thực.

Phần còn lại của các tham số và thuộc tính tương tự như chúng tôi đã sử dụng trong SVC.

Ví dụ triển khai

Sử dụng script Python sau sklearn.svm.SVR lớp học -

from sklearn import svm

X = [[1, 1], [2, 2]]

y = [1, 2]

SVRReg = svm.SVR(kernel = ’linear’, gamma = ’auto’)

SVRReg.fit(X, y)Đầu ra

SVR(C = 1.0, cache_size = 200, coef0 = 0.0, degree = 3, epsilon = 0.1, gamma = 'auto',

kernel = 'linear', max_iter = -1, shrinking = True, tol = 0.001, verbose = False)Thí dụ

Bây giờ, sau khi được trang bị, chúng ta có thể lấy vector trọng lượng với sự trợ giúp của tập lệnh python sau:

SVRReg.coef_Đầu ra

array([[0.4, 0.4]])Thí dụ

Tương tự, chúng ta có thể lấy giá trị của các thuộc tính khác như sau:

SVRReg.predict([[1,1]])Đầu ra

array([1.1])Tương tự, chúng ta cũng có thể lấy giá trị của các thuộc tính khác.

NuSVR

NuSVR là hồi quy vectơ hỗ trợ Nu. Nó giống như NuSVC, nhưng NuSVR sử dụng một tham sốnuđể kiểm soát số lượng vectơ hỗ trợ. Và hơn nữa, không giống như NuSVC, nơinu đã thay thế tham số C, ở đây nó thay thế epsilon.

Ví dụ triển khai

Sử dụng script Python sau sklearn.svm.SVR lớp học -

from sklearn.svm import NuSVR

import numpy as np

n_samples, n_features = 20, 15

np.random.seed(0)

y = np.random.randn(n_samples)

X = np.random.randn(n_samples, n_features)

NuSVRReg = NuSVR(kernel = 'linear', gamma = 'auto',C = 1.0, nu = 0.1)^M

NuSVRReg.fit(X, y)Đầu ra

NuSVR(C = 1.0, cache_size = 200, coef0 = 0.0, degree = 3, gamma = 'auto',

kernel = 'linear', max_iter = -1, nu = 0.1, shrinking = True, tol = 0.001,

verbose = False)Thí dụ

Bây giờ, sau khi được trang bị, chúng ta có thể lấy vector trọng lượng với sự trợ giúp của tập lệnh python sau:

NuSVRReg.coef_Đầu ra

array(

[

[-0.14904483, 0.04596145, 0.22605216, -0.08125403, 0.06564533,

0.01104285, 0.04068767, 0.2918337 , -0.13473211, 0.36006765,

-0.2185713 , -0.31836476, -0.03048429, 0.16102126, -0.29317051]

]

)Tương tự, chúng ta cũng có thể lấy giá trị của các thuộc tính khác.

Tuyến tínhSVR

Nó là hồi quy vectơ hỗ trợ tuyến tính. Nó tương tự như SVR có kernel = 'linear'. Sự khác biệt giữa chúng làLinearSVR được thực hiện trong điều kiện liblinear, trong khi SVC được triển khai trong libsvm. Đó là lý doLinearSVRlinh hoạt hơn trong việc lựa chọn hình phạt và chức năng thua lỗ. Nó cũng mở rộng quy mô tốt hơn với số lượng lớn mẫu.

Nếu chúng ta nói về các tham số và thuộc tính của nó thì nó không hỗ trợ ‘kernel’ bởi vì nó được giả định là tuyến tính và nó cũng thiếu một số thuộc tính như support_, support_vectors_, n_support_, fit_status_ và, dual_coef_.

Tuy nhiên, nó hỗ trợ các thông số 'mất mát' như sau:

loss - string, option, default = 'epsilon_insensitive'

Nó đại diện cho hàm mất mát trong đó tổn thất epsilon_insensitive là tổn thất L1 và tổn thất không nhạy epsilon bình phương là tổn thất L2.

Ví dụ triển khai

Sử dụng script Python sau sklearn.svm.LinearSVR lớp học -

from sklearn.svm import LinearSVR

from sklearn.datasets import make_regression

X, y = make_regression(n_features = 4, random_state = 0)

LSVRReg = LinearSVR(dual = False, random_state = 0,

loss = 'squared_epsilon_insensitive',tol = 1e-5)

LSVRReg.fit(X, y)Đầu ra

LinearSVR(

C=1.0, dual=False, epsilon=0.0, fit_intercept=True,

intercept_scaling=1.0, loss='squared_epsilon_insensitive',

max_iter=1000, random_state=0, tol=1e-05, verbose=0

)Thí dụ

Bây giờ, sau khi được trang bị, mô hình có thể dự đoán các giá trị mới như sau:

LSRReg.predict([[0,0,0,0]])Đầu ra

array([-0.01041416])Thí dụ

Đối với ví dụ trên, chúng ta có thể lấy vector trọng số với sự trợ giúp của tập lệnh python sau:

LSRReg.coef_Đầu ra

array([20.47354746, 34.08619401, 67.23189022, 87.47017787])Thí dụ

Tương tự, chúng ta có thể nhận giá trị của intercept với sự trợ giúp của tập lệnh python sau:

LSRReg.intercept_Đầu ra

array([-0.01041416])Ở đây, chúng ta sẽ tìm hiểu về phát hiện bất thường trong Sklearn là gì và cách nó được sử dụng để xác định các điểm dữ liệu.

Phát hiện bất thường là một kỹ thuật được sử dụng để xác định các điểm dữ liệu trong tập dữ liệu không khớp với phần còn lại của dữ liệu. Nó có nhiều ứng dụng trong kinh doanh như phát hiện gian lận, phát hiện xâm nhập, theo dõi sức khỏe hệ thống, giám sát và bảo trì dự đoán. Các dị thường, còn được gọi là ngoại lệ, có thể được chia thành ba loại sau:

Point anomalies - Nó xảy ra khi một cá thể dữ liệu riêng lẻ được coi là bất thường trong phần còn lại của dữ liệu.

Contextual anomalies- Loại dị thường như vậy là theo ngữ cảnh cụ thể. Nó xảy ra nếu một cá thể dữ liệu là bất thường trong một ngữ cảnh cụ thể.

Collective anomalies - Nó xảy ra khi một tập hợp các cá thể dữ liệu có liên quan là toàn bộ tập dữ liệu wrt bất thường chứ không phải các giá trị riêng lẻ.

Phương pháp

Hai phương pháp cụ thể là outlier detection và novelty detectioncó thể được sử dụng để phát hiện bất thường. Cần phải xem sự phân biệt giữa chúng.

Phát hiện ngoại vi

Dữ liệu đào tạo chứa các ngoại lệ khác xa với phần còn lại của dữ liệu. Những ngoại lệ như vậy được định nghĩa là những quan sát. Đó là lý do, các nhà ước tính phát hiện ngoại lệ luôn cố gắng điều chỉnh khu vực có dữ liệu đào tạo tập trung nhất trong khi bỏ qua các quan sát sai lệch. Nó còn được gọi là phát hiện bất thường không giám sát.

Phát hiện mới lạ

Nó liên quan đến việc phát hiện một mẫu không được quan sát trong các quan sát mới không được đưa vào dữ liệu đào tạo. Ở đây, dữ liệu đào tạo không bị ô nhiễm bởi các yếu tố bên ngoài. Nó còn được gọi là phát hiện bất thường bán giám sát.

Có một bộ công cụ ML, được cung cấp bởi scikit-learning, có thể được sử dụng cho cả phát hiện ngoại lệ cũng như phát hiện tính mới. Các công cụ này đầu tiên triển khai việc học đối tượng từ dữ liệu trong một phương thức không được giám sát bằng cách sử dụng phương thức fit () như sau:

estimator.fit(X_train)Bây giờ, các quan sát mới sẽ được sắp xếp như inliers (labeled 1) hoặc là outliers (labeled -1) bằng cách sử dụng phương thức dự đoán () như sau:

estimator.fit(X_test)Công cụ ước tính trước tiên sẽ tính toán chức năng tính điểm thô và sau đó phương pháp dự đoán sẽ sử dụng ngưỡng trên chức năng tính điểm thô đó. Chúng tôi có thể truy cập chức năng tính điểm thô này với sự trợ giúp củascore_sample và có thể kiểm soát ngưỡng bằng cách contamination tham số.

Chúng tôi cũng có thể xác định decision_function phương pháp xác định giá trị ngoại lai là giá trị âm và giá trị ngoại lai là giá trị không âm.

estimator.decision_function(X_test)Các thuật toán Sklearn để phát hiện ngoại lệ

Chúng ta hãy bắt đầu bằng cách hiểu một bao thư elip là gì.

Lắp một phong bì hình elip

Thuật toán này giả định rằng dữ liệu thông thường đến từ một phân phối đã biết, chẳng hạn như phân phối Gaussian. Để phát hiện ngoại lệ, Scikit-learning cung cấp một đối tượng có têncovariance.EllipticEnvelop.

Đối tượng này phù hợp với một ước tính hiệp phương sai mạnh mẽ cho dữ liệu và do đó, phù hợp với một hình elip với các điểm dữ liệu trung tâm. Nó bỏ qua những điểm bên ngoài chế độ trung tâm.

Thông số

Bảng sau bao gồm các tham số được sử dụng bởi sklearn. covariance.EllipticEnvelop phương pháp -

| Sr.No | Mô tả về Thông Số |

|---|---|

| 1 | store_precision - Boolean, tùy chọn, mặc định = True Chúng tôi có thể chỉ định nó nếu độ chính xác ước tính được lưu trữ. |

| 2 | assume_centered - Boolean, tùy chọn, mặc định = Sai Nếu chúng ta đặt nó là False, nó sẽ tính toán vị trí và hiệp phương sai mạnh mẽ trực tiếp với sự trợ giúp của thuật toán FastMCD. Mặt khác, nếu đặt True, nó sẽ tính toán hỗ trợ của vị trí mạnh mẽ và đồng loại. |

| 3 | support_fraction - float in (0., 1.), tùy chọn, mặc định = Không có Tham số này cho phương pháp biết tỷ lệ điểm được bao gồm trong hỗ trợ của các ước tính MCD thô. |

| 4 | contamination - float in (0., 1.), tùy chọn, mặc định = 0.1 Nó cung cấp tỷ lệ của các giá trị ngoại lai trong tập dữ liệu. |

| 5 | random_state - int, RandomState instance hoặc None, tùy chọn, default = none Tham số này đại diện cho hạt giống của số ngẫu nhiên giả được tạo ra được sử dụng trong khi xáo trộn dữ liệu. Tiếp theo là các tùy chọn -

|

Thuộc tính

Bảng sau bao gồm các thuộc tính được sử dụng bởi sklearn. covariance.EllipticEnvelop phương pháp -

| Sr.No | Thuộc tính & Mô tả |

|---|---|

| 1 | support_ - dạng mảng, hình dạng (n_samples,) Nó đại diện cho mặt nạ của các quan sát được sử dụng để tính toán các ước tính mạnh mẽ về vị trí và hình dạng. |

| 2 | location_ - dạng mảng, hình dạng (n_features) Nó trả về vị trí mạnh mẽ ước tính. |

| 3 | covariance_ - dạng mảng, hình dạng (n_features, n_features) Nó trả về ma trận hiệp phương sai mạnh mẽ được ước tính. |

| 4 | precision_ - dạng mảng, hình dạng (n_features, n_features) Nó trả về ma trận nghịch đảo giả ước tính. |

| 5 | offset_ - phao Nó được sử dụng để xác định chức năng quyết định từ các điểm số thô. decision_function = score_samples -offset_ |

Implementation Example

import numpy as np^M

from sklearn.covariance import EllipticEnvelope^M

true_cov = np.array([[.5, .6],[.6, .4]])

X = np.random.RandomState(0).multivariate_normal(mean = [0, 0], cov=true_cov,size=500)

cov = EllipticEnvelope(random_state = 0).fit(X)^M

# Now we can use predict method. It will return 1 for an inlier and -1 for an outlier.

cov.predict([[0, 0],[2, 2]])Output

array([ 1, -1])Rừng cách ly

Trong trường hợp tập dữ liệu chiều cao, một cách hiệu quả để phát hiện ngoại lệ là sử dụng các khu rừng ngẫu nhiên. Scikit-learning cung cấpensemble.IsolationForestphương pháp cô lập các quan sát bằng cách chọn ngẫu nhiên một đối tượng địa lý. Sau đó, nó chọn ngẫu nhiên một giá trị giữa các giá trị lớn nhất và nhỏ nhất của các đối tượng địa lý đã chọn.

Ở đây, số lần phân tách cần thiết để phân lập một mẫu tương đương với độ dài đường dẫn từ nút gốc đến nút kết thúc.

Thông số

Bảng theo dõi bao gồm các thông số được sử dụng bởi sklearn. ensemble.IsolationForest phương pháp -

| Sr.No | Mô tả về Thông Số |

|---|---|

| 1 | n_estimators - int, tùy chọn, mặc định = 100 Nó đại diện cho số lượng bộ ước lượng cơ sở trong tập hợp. |

| 2 | max_samples - int hoặc float, tùy chọn, default = “auto” Nó đại diện cho số lượng mẫu sẽ được rút ra từ X để đào tạo mỗi công cụ ước lượng cơ sở. Nếu chúng ta chọn int làm giá trị của nó, nó sẽ vẽ các mẫu max_samples. Nếu chúng ta chọn float làm giá trị của nó, nó sẽ vẽ các mẫu max_samples ∗ .shape [0]. Và, nếu chúng ta chọn auto làm giá trị của nó, nó sẽ vẽ max_samples = min (256, n_samples). |

| 3 | support_fraction - float in (0., 1.), tùy chọn, mặc định = Không có Tham số này cho phương pháp biết tỷ lệ điểm được bao gồm trong hỗ trợ của các ước tính MCD thô. |

| 4 | contamination - auto hoặc float, tùy chọn, default = auto Nó cung cấp tỷ lệ của các giá trị ngoại lai trong tập dữ liệu. Nếu chúng ta đặt nó mặc định tức là tự động, nó sẽ xác định ngưỡng như trong bài báo gốc. Nếu được thiết lập để thả nổi, phạm vi ô nhiễm sẽ nằm trong khoảng [0,0,5]. |

| 5 | random_state - int, RandomState instance hoặc None, tùy chọn, default = none Tham số này đại diện cho hạt giống của số ngẫu nhiên giả được tạo ra được sử dụng trong khi xáo trộn dữ liệu. Tiếp theo là các tùy chọn -

|

| 6 | max_features - int hoặc float, tùy chọn (mặc định = 1.0) Nó đại diện cho số lượng các tính năng được rút ra từ X để đào tạo mỗi công cụ ước tính cơ sở. Nếu chúng ta chọn int làm giá trị của nó, nó sẽ vẽ các đặc điểm max_features. Nếu chúng ta chọn float làm giá trị của nó, nó sẽ vẽ các mẫu max_features * X.shape []. |

| 7 | bootstrap - Boolean, tùy chọn (mặc định = Sai) Tùy chọn mặc định của nó là Sai có nghĩa là việc lấy mẫu sẽ được thực hiện mà không cần thay thế. Và mặt khác, nếu được đặt thành True, có nghĩa là các cây riêng lẻ phù hợp với một tập hợp con ngẫu nhiên của dữ liệu huấn luyện được lấy mẫu thay thế. |

| số 8 | n_jobs - int hoặc None, tùy chọn (mặc định = None) Nó đại diện cho số lượng công việc được chạy song song fit() và predict() cả hai phương pháp. |

| 9 | verbose - int, tùy chọn (mặc định = 0) Tham số này kiểm soát tính chi tiết của quá trình xây dựng cây. |

| 10 | warm_start - Bool, tùy chọn (mặc định = Sai) Nếu warm_start = true, chúng ta có thể sử dụng lại giải pháp cuộc gọi trước đó để phù hợp và có thể thêm nhiều công cụ ước tính hơn vào nhóm. Nhưng nếu được đặt thành false, chúng ta cần phải điều chỉnh một khu rừng hoàn toàn mới. |

Thuộc tính

Bảng sau bao gồm các thuộc tính được sử dụng bởi sklearn. ensemble.IsolationForest phương pháp -

| Sr.No | Thuộc tính & Mô tả |

|---|---|

| 1 | estimators_ - danh sách của Người phân loại Quyết định Cung cấp bộ sưu tập của tất cả các công cụ ước tính phụ được trang bị. |

| 2 | max_samples_ - số nguyên Nó cung cấp số lượng mẫu thực tế được sử dụng. |

| 3 | offset_ - phao Nó được sử dụng để xác định chức năng quyết định từ các điểm số thô. decision_function = score_samples -offset_ |

Implementation Example

Tập lệnh Python bên dưới sẽ sử dụng sklearn. ensemble.IsolationForest phương pháp để phù hợp với 10 cây trên dữ liệu đã cho

from sklearn.ensemble import IsolationForest

import numpy as np

X = np.array([[-1, -2], [-3, -3], [-3, -4], [0, 0], [-50, 60]])

OUTDClf = IsolationForest(n_estimators = 10)

OUTDclf.fit(X)Output

IsolationForest(

behaviour = 'old', bootstrap = False, contamination='legacy',

max_features = 1.0, max_samples = 'auto', n_estimators = 10, n_jobs=None,

random_state = None, verbose = 0

)Yếu tố ngoại lai địa phương