वेक्टर मात्रा सीखना

सदिश परिमाणीकरण (LVQ) सीखना, सदिश परिमाणीकरण (VQ) और कोहेनन सेल्फ-आर्गेनाइजिंग मैप्स (KSOM) से अलग है, मूल रूप से एक प्रतिस्पर्धी नेटवर्क है जो पर्यवेक्षित शिक्षण का उपयोग करता है। हम इसे उन पैटर्नों को वर्गीकृत करने की प्रक्रिया के रूप में परिभाषित कर सकते हैं जहां प्रत्येक आउटपुट यूनिट एक क्लास का प्रतिनिधित्व करती है। जैसा कि यह पर्यवेक्षित शिक्षण का उपयोग करता है, नेटवर्क को आउटपुट वर्ग के प्रारंभिक वितरण के साथ ज्ञात वर्गीकरण के साथ प्रशिक्षण पैटर्न का एक सेट दिया जाएगा। प्रशिक्षण प्रक्रिया को पूरा करने के बाद, LVQ एक इनपुट वेक्टर को आउटपुट यूनिट के समान कक्षा में असाइन करके वर्गीकृत करेगा।

आर्किटेक्चर

निम्नलिखित आंकड़ा LVQ की वास्तुकला को दर्शाता है जो KSOM की वास्तुकला के समान है। जैसा कि हम देख सकते हैं, वहाँ हैं“n” इनपुट इकाइयों की संख्या और “m”उत्पादन इकाइयों की संख्या। उन पर भार होने के साथ परतें पूरी तरह से परस्पर जुड़ी हुई हैं।

पैरामीटर्स का इस्तेमाल किया

एलवीक्यू प्रशिक्षण प्रक्रिया के साथ-साथ फ्लोचार्ट में उपयोग किए जाने वाले पैरामीटर निम्नलिखित हैं

x= प्रशिक्षण वेक्टर (x 1 , ..., x i , ..., x n )

T = सदिश प्रशिक्षण के लिए कक्षा x

wj = के लिए वजन वेक्टर jth उत्पादन इकाई

Cj = के साथ जुड़े वर्ग jth उत्पादन इकाई

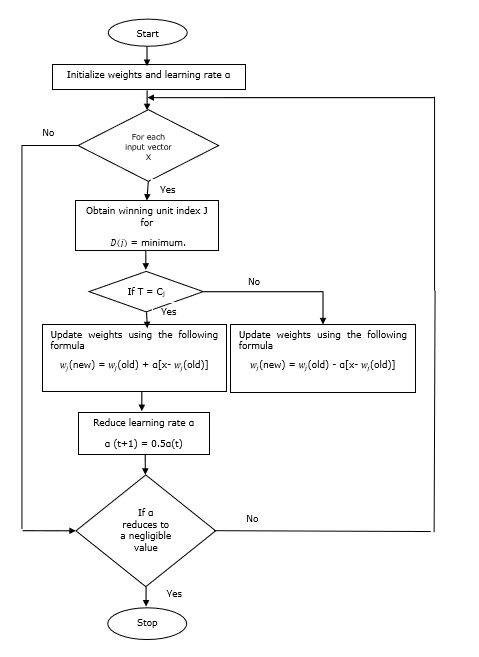

प्रशिक्षण एल्गोरिथ्म

Step 1 - प्रारंभिक संदर्भ वैक्टर, जो निम्नानुसार किया जा सकता है -

Step 1(a) - प्रशिक्षण वैक्टर के दिए गए सेट से, पहले ले लो "m"(क्लस्टर्स की संख्या) प्रशिक्षण वैक्टर और उन्हें वजन वैक्टर के रूप में उपयोग करते हैं। शेष वैक्टर का उपयोग प्रशिक्षण के लिए किया जा सकता है।

Step 1(b) - प्रारंभिक वजन और वर्गीकरण को यादृच्छिक रूप से असाइन करें।

Step 1(c) - K- साधन क्लस्टरिंग विधि लागू करें।

Step 2 - प्रारंभिक संदर्भ वेक्टर $ \ अल्फा $

Step 3 - 4-9 कदम के साथ जारी रखें, अगर इस एल्गोरिथ्म को रोकने के लिए शर्त पूरी नहीं हुई है।

Step 4 - प्रत्येक प्रशिक्षण इनपुट वेक्टर के लिए चरण 5-6 का पालन करें x।

Step 5 - यूक्लिडियन दूरी के वर्ग की गणना करें j = 1 to m तथा i = 1 to n

$ $ D (j) \: = \: \ displaystyle \ sum \ limit_ {i = 1} ^ n \ displaystyle \ sum \ limit_ {j = 1} ^ m (x_ {i} \: - \ _ \ _j] }) ^ 2 $$

Step 6 - विजेता इकाई को प्राप्त करें J कहाँ पे D(j) न्यूनतम है।

Step 7 - निम्नलिखित संबंध द्वारा विजेता इकाई के नए वजन की गणना करें -

अगर T = Cj तब $ w_ {j} (नया) \: = \: w_ {j} (पुराना) \: + \: \ अल्फा [x \: - \: w_ {j} (पुराना)] $

अगर T ≠ Cj तब $ w_ {j} (नया) \: = \: w_ {j} (पुराना) \: - \: \ अल्फा [x \: - \: w_ {j} (पुराना)] $

Step 8 - सीखने की दर $ \ अल्फा $ कम करें।

Step 9- रोकने की स्थिति के लिए परीक्षण। यह इस प्रकार हो सकता है -

- अधिक से अधिक संख्या में युगान्तर पहुँचे।

- सीखने की दर एक नगण्य मूल्य तक कम हो गई।

फ़्लोचार्ट

वेरिएंट

तीन अन्य वेरिएंट जैसे कि LVQ2, LVQ2.1 और LVQ3 को कोहेन द्वारा विकसित किया गया है। इन तीनों वेरिएंट में जटिलता, इस अवधारणा के कारण कि विजेता के साथ-साथ उपविजेता इकाई भी सीखेगी, LVQ से अधिक है।

LVQ2

जैसा कि चर्चा की गई है, ऊपर एलवीक्यू के अन्य वेरिएंट की अवधारणा, एलवीक्यू 2 की स्थिति खिड़की से बनती है। यह विंडो निम्नलिखित मापदंडों पर आधारित होगी -

x - वर्तमान इनपुट वेक्टर

yc - संदर्भ वेक्टर निकटतम है x

yr - अन्य संदर्भ वेक्टर, जो अगले निकटतम है x

dc - से दूरी x सेवा yc

dr - से दूरी x सेवा yr

इनपुट वेक्टर x खिड़की में गिर जाता है, अगर

$$ \ frac {d_ {c}} {d_ {r}} \:> \: 1 \: - \: \ थीटा \: \: और \: \: \ frac {d_ {r}} {{c d_ }} \:> \: 1 \: + \: \ थीटा $$

यहाँ, $ theta $ प्रशिक्षण नमूनों की संख्या है।

अद्यतन निम्न सूत्र के साथ किया जा सकता है -

$ Y_ {c} (टी \: + \: 1) \: = \: y_ {c} (टी) \: + \: \ अल्फा (टी) [x (टी) \: - \: y_ {c} (टी)] $ (belongs to different class)

$ Y_ {r} (टी \: + \: 1) \: = \: y_ {r} (टी) \: + \: \ अल्फा (टी) [x (टी) \: - \: y_ {r} (टी)] $ (belongs to same class)

यहाँ $ \ अल्फा $ सीखने की दर है।

LVQ2.1

LVQ2.1 में, हम क्रमशः दो निकटतम वैक्टर लेंगे yc1 तथा yc2 और खिड़की की स्थिति इस प्रकार है -

$$ मिनट \ शुरू {bmatrix} \ frac {{d_ c1}} {{d_ c2}} \ frac {{d_ c2}} {{d_ c1}} \ अंत {bmatrix} \:> \ :( 1 \ : - \: \ थीटा) $$

$$ मैक्स \ begin {bmatrix} \ frac {{d_ c1}} {{d_ c2}} \ frac {{d_ c2}} {{d_ c1}} \ अंत {bmatrix} \: <\ :( 1 \ : + \: \ थीटा) $$

अद्यतन निम्न सूत्र के साथ किया जा सकता है -

$ Y_ {c1} (टी \: + \: 1) \: = \: y_ {c1} (टी) \: + \: \ अल्फा (टी) [x (टी) \: - \: y_ {c1} (टी)] $ (belongs to different class)

$ Y_ {c2} (टी \: + \: 1) \: = \: y_ {c2} (टी) \: + \: \ अल्फा (टी) [x (टी) \: - \: y_ {c2} (टी)] $ (belongs to same class)

यहाँ, $ \ Alpha $ सीखने की दर है।

LVQ3

LVQ3 में, हम दो निकटतम वैक्टरों को लेंगे yc1 तथा yc2 और खिड़की की स्थिति इस प्रकार है -

$$ मिनट \ शुरू {bmatrix} \ frac {{d_ c1}} {{d_ c2}} \ frac {{d_ c2}} {{d_ c1}} \ अंत {bmatrix} \:> \ :( 1 \ : - \: \ थीटा) (1 \: + \: \ थीटा) $$

यहाँ $ $ थीटा लगभग $ 0.2 है

अद्यतन निम्न सूत्र के साथ किया जा सकता है -

$ Y_ {c1} (टी \: + \: 1) \: = \: y_ {c1} (टी) \: + \: \ बीटा (टी) [x (टी) \: - \: y_ {c1} (टी)] $ (belongs to different class)

$ Y_ {c2} (टी \: + \: 1) \: = \: y_ {c2} (टी) \: + \: \ बीटा (टी) [x (टी) \: - \: y_ {c2} (टी)] $ (belongs to same class)

यहाँ $ \ beta $ सीखने की दर $ \ अल्फा $ और के कई है $\beta\:=\:m \alpha(t)$ हर एक के लिए 0.1 < m < 0.5