ニューラルネットワークトレーニングの推奨事項

この章では、TensorFlowフレームワークを使用して実装できるニューラルネットワークトレーニングのさまざまな側面を理解します。

以下は、評価できる10の推奨事項です。

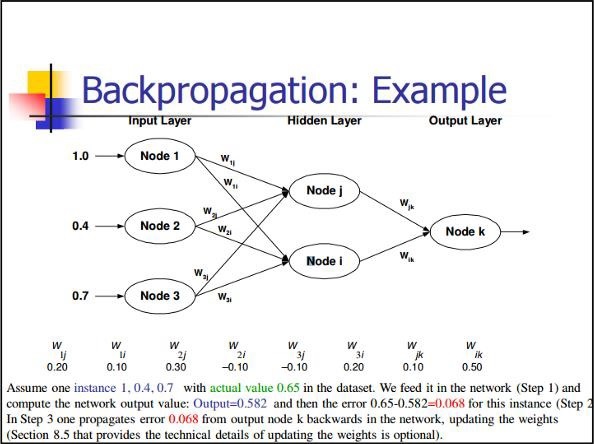

誤差逆伝播法

バックプロパゲーションは偏導関数を計算する簡単な方法であり、ニューラルネットに最適な基本的な構成形式が含まれています。

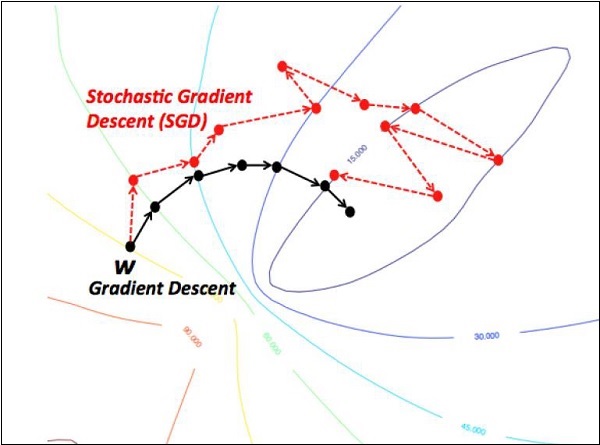

確率的勾配降下法

確率的勾配降下法では、 batchは、ユーザーが1回の反復で勾配を計算するために使用する例の総数です。これまでのところ、バッチはデータセット全体であると想定されています。最高のイラストはGoogleスケールで動作しています。多くの場合、データセットには数十億または数千億の例が含まれています。

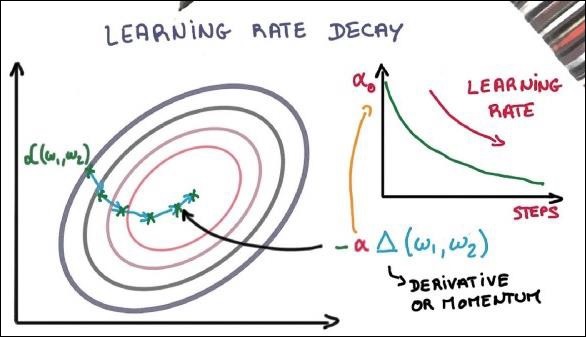

学習率の低下

学習率の適応は、最急降下法の最適化の最も重要な機能の1つです。これはTensorFlowの実装にとって非常に重要です。

脱落

多数のパラメーターを備えたディープニューラルネットは、強力な機械学習システムを形成します。ただし、このようなネットワークでは、過剰適合は深刻な問題です。

最大プーリング

最大プーリングは、サンプルベースの離散化プロセスです。目的は、入力表現をダウンサンプリングすることです。これにより、必要な仮定で次元が削減されます。

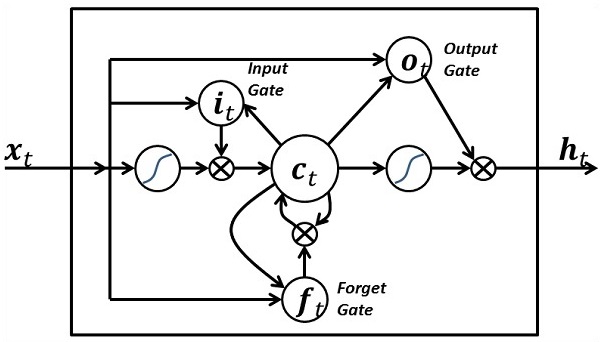

長短期記憶(LSTM)

LSTMは、指定されたニューロン内でどの入力を取得するかに関する決定を制御します。これには、何を計算し、どの出力を生成するかを決定するための制御が含まれます。