Pobieranie z sieci Python - wprowadzenie

Skrobanie sieci to automatyczny proces wyodrębniania informacji z sieci. Ten rozdział zawiera szczegółowe informacje na temat skrobania sieci, jego porównania z indeksowaniem sieci oraz powodów, dla których warto wybrać tę metodę. Dowiesz się również o elementach i działaniu skrobaka do wstęgi.

Co to jest przeglądanie sieci?

Słownikowe znaczenie słowa „złomowanie” oznacza pobieranie czegoś z sieci. Pojawiają się dwa pytania: co możemy uzyskać z sieci i jak to osiągnąć.

Odpowiedź na pierwsze pytanie brzmi ‘data’. Dane są niezbędne dla każdego programisty, a podstawowym wymaganiem każdego projektu programistycznego jest duża ilość użytecznych danych.

Odpowiedź na drugie pytanie jest nieco trudna, ponieważ istnieje wiele sposobów uzyskiwania danych. Ogólnie możemy uzyskać dane z bazy danych lub pliku danych i innych źródeł. Ale co, jeśli potrzebujemy dużej ilości danych dostępnych online? Jednym ze sposobów uzyskania takich danych jest ręczne wyszukiwanie (kliknięcie w przeglądarce internetowej) i zapisanie (skopiowanie i wklejenie do arkusza kalkulacyjnego lub pliku) wymaganych danych. Ta metoda jest dość żmudna i czasochłonna. Innym sposobem uzyskania takich danych jest użycieweb scraping.

Web scraping, nazywany również web data mining lub web harvesting, to proces tworzenia agenta, który może automatycznie wyodrębniać, analizować, pobierać i organizować przydatne informacje z sieci. Innymi słowy, możemy powiedzieć, że zamiast ręcznie zapisywać dane ze stron internetowych, oprogramowanie do skrobania stron internetowych automatycznie ładuje i wyodrębnia dane z wielu witryn internetowych zgodnie z naszymi wymaganiami.

Pochodzenie skrobania sieci

Źródłem skrobania stron internetowych jest zrzut ekranu, który był używany do integracji aplikacji innych niż internetowe lub natywnych aplikacji systemu Windows. Pierwotnie skrobanie ekranu było używane przed szerokim użyciem World Wide Web (WWW), ale nie było możliwe skalowanie rozszerzonego WWW. Z tego powodu konieczne było zautomatyzowanie podejścia do skrobania ekranu i techniki tzw‘Web Scraping’ powstała.

Indeksowanie sieci a przeszukiwanie sieci

Pojęcia „indeksowanie sieci i pobieranie danych” są często używane zamiennie, ponieważ ich podstawową koncepcją jest wyodrębnianie danych. Jednak różnią się od siebie. Możemy zrozumieć podstawową różnicę w ich definicjach.

Indeksowanie sieci jest zasadniczo używane do indeksowania informacji na stronie przy użyciu botów zwanych przeszukiwaczami. Nazywa się to równieżindexing. Z drugiej strony, skrobanie sieci to zautomatyzowany sposób wydobywania informacji za pomocą botów zwanych skrobakami. Nazywa się to równieżdata extraction.

Aby zrozumieć różnicę między tymi dwoma terminami, spójrzmy na tabelę porównawczą podaną poniżej -

| Indeksowanie sieci | Skrobanie sieci |

|---|---|

| Odnosi się do pobierania i przechowywania zawartości dużej liczby witryn internetowych. | Odnosi się do wyodrębniania poszczególnych elementów danych ze strony internetowej przy użyciu struktury specyficznej dla witryny. |

| Przeważnie wykonywane na dużą skalę. | Może być wdrożony w dowolnej skali. |

| Dostarcza ogólnych informacji. | Podaje konkretne informacje. |

| Używany przez główne wyszukiwarki, takie jak Google, Bing, Yahoo. Googlebot to przykład robota sieciowego. | Informacje wyodrębnione za pomocą skrobania sieci można wykorzystać do powielenia w innej witrynie internetowej lub do przeprowadzenia analizy danych. Na przykład elementami danych mogą być nazwy, adres, cena itp. |

Zastosowania skrobania sieci

Zastosowania i powody używania skrobania sieci są tak samo nieograniczone, jak zastosowania sieci WWW. Skrobaki internetowe mogą robić wszystko, na przykład zamawiać jedzenie online, skanować witrynę zakupów online i kupować bilety na mecz, gdy tylko są dostępne itp., Tak jak może to zrobić człowiek. Omówiono tutaj niektóre z ważnych zastosowań skrobania sieci -

E-commerce Websites - Skrobaki internetowe mogą zbierać dane dotyczące ceny konkretnego produktu z różnych witryn e-commerce w celu ich porównania.

Content Aggregators - Web scraping jest szeroko stosowany przez agregatory treści, takie jak agregatory wiadomości i agregatory ofert pracy, do dostarczania zaktualizowanych danych swoim użytkownikom.

Marketing and Sales Campaigns - Skrobaki internetowe mogą być używane do pobierania danych, takich jak e-maile, numer telefonu itp. Na potrzeby kampanii sprzedażowych i marketingowych.

Search Engine Optimization (SEO) - Skrobanie stron internetowych jest szeroko stosowane przez narzędzia SEO, takie jak SEMRush, Majestic itp., Aby poinformować firmy, jak pozycjonują się w wyszukiwanych słowach kluczowych, które są dla nich ważne.

Data for Machine Learning Projects - Pobieranie danych do projektów uczenia maszynowego zależy od skrobania sieci.

Data for Research - Naukowcy mogą zbierać przydatne dane do swoich prac badawczych, oszczędzając czas dzięki temu zautomatyzowanemu procesowi.

Składniki skrobaka internetowego

Skrobak do wstęgi składa się z następujących elementów -

Moduł robota indeksującego

Bardzo niezbędny składnik skrobaka internetowego, moduł robota indeksującego, służy do nawigacji po docelowej witrynie poprzez wysyłanie żądań HTTP lub HTTPS do adresów URL. Przeszukiwacz pobiera nieustrukturyzowane dane (zawartość HTML) i przekazuje je do ekstraktora, następnego modułu.

Ekstraktor

Ekstraktor przetwarza pobraną zawartość HTML i wyodrębnia dane do półstrukturalnego formatu. Jest to również nazywane modułem parsera i wykorzystuje różne techniki parsowania, takie jak wyrażenie regularne, analiza HTML, analizowanie DOM lub sztuczna inteligencja.

Moduł Transformacji i Czyszczenia Danych

Dane wyodrębnione powyżej nie nadają się do użycia. Musi przejść przez jakiś moduł czyszczący, żebyśmy mogli z niego skorzystać. W tym celu można użyć metod, takich jak manipulacja ciągami znaków lub wyrażenie regularne. Należy pamiętać, że ekstrakcję i transformację można również przeprowadzić w jednym kroku.

Moduł pamięci

Po wyodrębnieniu danych musimy je przechowywać zgodnie z naszymi wymaganiami. Moduł pamięci wyprowadza dane w standardowym formacie, który można przechowywać w bazie danych lub formacie JSON lub CSV.

Działanie skrobaka internetowego

Skrobak sieciowy można zdefiniować jako oprogramowanie lub skrypt używany do pobierania zawartości wielu stron internetowych i wyodrębniania z nich danych.

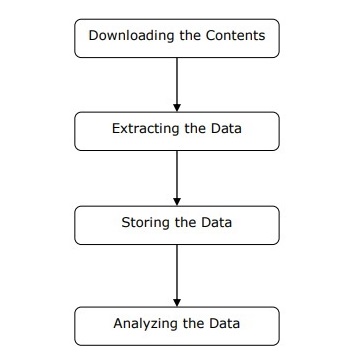

Działanie skrobaka można zrozumieć w prostych krokach, jak pokazano na powyższym schemacie.

Krok 1: Pobieranie treści ze stron internetowych

Na tym etapie skrobak sieciowy pobierze żądaną zawartość z wielu stron internetowych.

Krok 2: Wyodrębnianie danych

Dane na stronach internetowych to HTML i przeważnie nieustrukturyzowane. W związku z tym na tym etapie skrobak sieciowy przeanalizuje i wyodrębni ustrukturyzowane dane z pobranych treści.

Krok 3: Przechowywanie danych

Tutaj skrobak sieciowy będzie przechowywać i zapisywać wyodrębnione dane w dowolnym formacie, takim jak CSV, JSON lub w bazie danych.

Krok 4: Analiza danych

Po pomyślnym wykonaniu wszystkich tych kroków skrobak sieci przeanalizuje uzyskane w ten sposób dane.