Kit de ferramentas cognitivas da Microsoft - Guia rápido

Neste capítulo, aprenderemos o que é CNTK, suas características, diferença entre sua versão 1.0 e 2.0 e importantes destaques da versão 2.7.

O que é o Microsoft Cognitive Toolkit (CNTK)?

O Microsoft Cognitive Toolkit (CNTK), anteriormente conhecido como Computational Network Toolkit, é um kit de ferramentas de nível comercial gratuito, fácil de usar e de código aberto que nos permite treinar algoritmos de aprendizagem profunda para aprender como o cérebro humano. Isso nos permite criar alguns sistemas populares de aprendizagem profunda, comofeed-forward neural network time series prediction systems and Convolutional neural network (CNN) image classifiers.

Para um desempenho ideal, suas funções de estrutura são escritas em C ++. Embora possamos chamar sua função usando C ++, a abordagem mais comumente usada para o mesmo é usar um programa Python.

Recursos do CNTK

A seguir estão alguns dos recursos e capacidades oferecidos na versão mais recente do Microsoft CNTK:

Componentes integrados

O CNTK possui componentes integrados altamente otimizados que podem lidar com dados multidimensionais densos ou esparsos de Python, C ++ ou BrainScript.

Podemos implementar CNN, FNN, RNN, normalização em lote e sequência a sequência com atenção.

Ele nos fornece a funcionalidade para adicionar novos componentes principais definidos pelo usuário na GPU do Python.

Ele também fornece ajuste automático de hiperparâmetros.

Podemos implementar aprendizagem por reforço, redes adversárias gerativas (GANs), aprendizagem supervisionada e não supervisionada.

Para conjuntos de dados massivos, o CNTK possui leitores otimizados integrados.

Uso de recursos de forma eficiente

O CNTK nos fornece paralelismo com alta precisão em várias GPUs / máquinas via SGD de 1 bit.

Para caber nos maiores modelos de memória GPU, ele fornece compartilhamento de memória e outros métodos integrados.

Expresse nossas próprias redes facilmente

CNTK tem APIs completas para definir sua própria rede, alunos, leitores, treinamento e avaliação de Python, C ++ e BrainScript.

Usando CNTK, podemos avaliar facilmente modelos com Python, C ++, C # ou BrainScript.

Ele fornece APIs de alto e baixo nível.

Com base em nossos dados, ele pode moldar automaticamente a inferência.

Ele tem loops de Rede Neural Recorrente Simbólica (RNN) totalmente otimizado.

Medindo o desempenho do modelo

O CNTK fornece vários componentes para medir o desempenho das redes neurais que você constrói.

Gera dados de registro do seu modelo e do otimizador associado, que podemos usar para monitorar o processo de treinamento.

Versão 1.0 vs Versão 2.0

A tabela a seguir compara o CNTK Versão 1.0 e 2.0:

| Versão 1.0 | Versão 2.0 |

|---|---|

| Foi lançado em 2016. | É uma reescrita significativa da versão 1.0 e foi lançada em junho de 2017. |

| Ele usava uma linguagem de script proprietária chamada BrainScript. | Suas funções de framework podem ser chamadas usando C ++, Python. Podemos carregar facilmente nossos módulos em C # ou Java. BrainScript também é compatível com a versão 2.0. |

| Ele roda em sistemas Windows e Linux, mas não diretamente no Mac OS. | Também é executado em sistemas Windows (Win 8.1, Win 10, Server 2012 R2 e posterior) e Linux, mas não diretamente no Mac OS. |

Destaques importantes da versão 2.7

Version 2.7é a última versão principal lançada do Microsoft Cognitive Toolkit. Tem suporte total para ONNX 1.4.1. A seguir estão alguns destaques importantes desta última versão lançada do CNTK.

Suporte total para ONNX 1.4.1.

Suporte para CUDA 10 para sistemas Windows e Linux.

Suporta loop avançado de Redes Neurais Recorrentes (RNN) na exportação ONNX.

Pode exportar mais de modelos de 2 GB no formato ONNX.

Ele suporta FP16 na ação de treinamento da linguagem de script BrainScript.

Aqui, vamos entender sobre a instalação do CNTK no Windows e no Linux. Além disso, o capítulo explica a instalação do pacote CNTK, etapas para instalar o Anaconda, arquivos CNTK, estrutura de diretório e organização da biblioteca CNTK.

Pré-requisitos

Para instalar o CNTK, devemos ter o Python instalado em nossos computadores. Você pode ir para o linkhttps://www.python.org/downloads/e selecione a versão mais recente para o seu sistema operacional, ou seja, Windows e Linux / Unix. Para um tutorial básico sobre Python, você pode consultar o linkhttps://www.tutorialspoint.com/python3/index.htm.

O CNTK é compatível com o Windows e também com o Linux, portanto, examinaremos ambos.

Instalando no Windows

Para executar o CNTK no Windows, usaremos o Anaconda versionde Python. Nós sabemos disso, o Anaconda é uma redistribuição do Python. Inclui pacotes adicionais comoScipy eScikit-learn que são usados pelo CNTK para realizar vários cálculos úteis.

Então, primeiro vamos ver os passos para instalar o Anaconda em sua máquina -

Step 1−Primeiro baixe os arquivos de configuração do site público https://www.anaconda.com/distribution/.

Step 2 - Depois de baixar os arquivos de configuração, inicie a instalação e siga as instruções do link https://docs.anaconda.com/anaconda/install/.

Step 3- Uma vez instalado, o Anaconda também instalará alguns outros utilitários, que irão incluir automaticamente todos os executáveis do Anaconda na variável PATH do seu computador. Podemos gerenciar nosso ambiente Python a partir deste prompt, podemos instalar pacotes e executar scripts Python.

Instalando o pacote CNTK

Assim que a instalação do Anaconda estiver concluída, você pode usar a maneira mais comum de instalar o pacote CNTK através do executável pip usando o seguinte comando -

pip install cntkExistem vários outros métodos para instalar o Cognitive Toolkit em sua máquina. A Microsoft possui um conjunto organizado de documentação que explica os outros métodos de instalação em detalhes. Por favor siga o linkhttps://docs.microsoft.com/en-us/cognitive-toolkit/Setup-CNTK-on-your-machine.

Instalando no Linux

A instalação do CNTK no Linux é um pouco diferente da instalação no Windows. Aqui, para o Linux, vamos usar o Anaconda para instalar o CNTK, mas em vez de um instalador gráfico para o Anaconda, usaremos um instalador baseado em terminal no Linux. Embora o instalador funcione com quase todas as distribuições Linux, limitamos a descrição ao Ubuntu.

Então, primeiro vamos ver os passos para instalar o Anaconda em sua máquina -

Passos para instalar o Anaconda

Step 1- Antes de instalar o Anaconda, certifique-se de que o sistema está totalmente atualizado. Para verificar, primeiro execute os dois comandos a seguir dentro de um terminal -

sudo apt update

sudo apt upgradeStep 2 - Assim que o computador for atualizado, obtenha o URL do site público https://www.anaconda.com/distribution/ para os arquivos de instalação mais recentes do Anaconda.

Step 3 - Assim que o URL for copiado, abra uma janela de terminal e execute o seguinte comando -

wget -0 anaconda-installer.sh url SHAPE \* MERGEFORMAT

y

f

x

| }Substitua o url placeholder com a URL copiada do site do Anaconda.

Step 4 - Em seguida, com a ajuda do seguinte comando, podemos instalar o Anaconda -

sh ./anaconda-installer.shO comando acima irá instalar por padrão Anaconda3 dentro de nosso diretório inicial.

Instalando o pacote CNTK

Assim que a instalação do Anaconda estiver concluída, você pode usar a maneira mais comum de instalar o pacote CNTK através do executável pip usando o seguinte comando -

pip install cntkExaminando arquivos CNTK e estrutura de diretório

Assim que o CNTK for instalado como um pacote Python, podemos examinar sua estrutura de arquivos e diretórios. Está emC:\Users\

Verificando a instalação do CNTK

Depois que o CNTK for instalado como um pacote Python, você deve verificar se o CNTK foi instalado corretamente. No shell de comando do Anaconda, inicie o interpretador Python digitandoipython. Então, importe CNTK digitando o seguinte comando.

import cntk as cUma vez importado, verifique sua versão com a ajuda do seguinte comando -

print(c.__version__)O intérprete responderá com a versão CNTK instalada. Se não responder, haverá um problema com a instalação.

A organização da biblioteca CNTK

CNTK, um pacote python tecnicamente, é organizado em 13 subpacotes de alto nível e 8 subpacotes menores. A tabela a seguir consiste nos 10 pacotes usados com mais frequência:

| Sr. Não | Nome e descrição do pacote |

|---|---|

| 1 | cntk.io Contém funções para leitura de dados. Por exemplo: next_minibatch () |

| 2 | cntk.layers Contém funções de alto nível para a criação de redes neurais. Por exemplo: Denso () |

| 3 | cntk.learners Contém funções para treinamento. Por exemplo: sgd () |

| 4 | cntk.losses Contém funções para medir o erro de treinamento. Por exemplo: squared_error () |

| 5 | cntk.metrics Contém funções para medir o erro do modelo. Por exemplo: classificatoin_error |

| 6 | cntk.ops Contém funções de baixo nível para a criação de redes neurais. Por exemplo: tanh () |

| 7 | cntk.random Contém funções para gerar números aleatórios. Por exemplo: normal () |

| 8 | cntk.train Contém funções de treinamento. Por exemplo: train_minibatch () |

| 9 | cntk.initializer Contém inicializadores de parâmetro de modelo. Por exemplo: normal () e uniforme () |

| 10 | cntk.variables Contém construções de baixo nível. Por exemplo: Parameter () e Variable () |

O Microsoft Cognitive Toolkit oferece duas versões de compilação diferentes, ou seja, somente CPU e somente GPU.

Versão de compilação apenas para CPU

A versão compilada apenas para CPU do CNTK usa o Intel MKLML otimizado, onde MKLML é o subconjunto de MKL (Math Kernel Library) e lançado com Intel MKL-DNN como uma versão finalizada do Intel MKL para MKL-DNN.

GPU apenas compilar versão

Por outro lado, a versão compilada apenas para GPU do CNTK usa bibliotecas NVIDIA altamente otimizadas, como CUB e cuDNN. Ele oferece suporte a treinamento distribuído em várias GPUs e várias máquinas. Para um treinamento distribuído ainda mais rápido em CNTK, a versão de construção de GPU também inclui -

SGD quantizado em 1 bit desenvolvido por MSR.

Algoritmos de treinamento paralelo SGD de momento de bloco.

Ativando GPU com CNTK no Windows

Na seção anterior, vimos como instalar a versão básica do CNTK para usar com a CPU. Agora vamos discutir como podemos instalar o CNTK para usar com uma GPU. Mas, antes de se aprofundar nisso, primeiro você deve ter uma placa de vídeo compatível.

No momento, o CNTK suporta a placa de vídeo NVIDIA com pelo menos suporte CUDA 3.0. Para ter certeza, você pode verificar emhttps://developer.nvidia.com/cuda-gpus se sua GPU suporta CUDA.

Então, vamos ver as etapas para habilitar a GPU com CNTK no sistema operacional Windows -

Step 1 - Dependendo da placa gráfica que você está usando, primeiro você precisa ter os drivers GeForce ou Quadro mais recentes para sua placa gráfica.

Step 2 - Depois de baixar os drivers, você precisa instalar o kit de ferramentas CUDA Versão 9.0 para Windows do site da NVIDIA https://developer.nvidia.com/cuda-90-download-archive?target_os=Windows&target_arch=x86_64. Após a instalação, execute o instalador e siga as instruções.

Step 3 - Em seguida, você precisa instalar os binários cuDNN do site da NVIDIA https://developer.nvidia.com/rdp/form/cudnn-download-survey. Com a versão CUDA 9.0, cuDNN 7.4.1 funciona bem. Basicamente, cuDNN é uma camada no topo do CUDA, usada pelo CNTK.

Step 4 - Depois de baixar os binários cuDNN, você precisa extrair o arquivo zip para a pasta raiz da instalação do kit de ferramentas CUDA.

Step 5- Esta é a última etapa que permitirá o uso da GPU dentro do CNTK. Execute o seguinte comando dentro do prompt do Anaconda no sistema operacional Windows -

pip install cntk-gpuAtivando GPU com CNTK no Linux

Vamos ver como podemos habilitar GPU com CNTK no sistema operacional Linux -

Baixando o kit de ferramentas CUDA

Primeiro, você precisa instalar o kit de ferramentas CUDA do site da NVIDIA https://developer.nvidia.com/cuda-90-download-archive?target_os=Linux&target_arch=x86_64&target_distro=Ubuntu&target_version=1604&target_type = runfilelocal .

Executando o instalador

Agora, uma vez que você tenha binários no disco, execute o instalador abrindo um terminal e executando o seguinte comando e as instruções na tela -

sh cuda_9.0.176_384.81_linux-runModificar script de perfil Bash

Depois de instalar o kit de ferramentas CUDA em sua máquina Linux, você precisa modificar o script de perfil BASH. Para isso, primeiro abra o arquivo $ HOME / .bashrc no editor de texto. Agora, no final do script, inclua as seguintes linhas -

export PATH=/usr/local/cuda-9.0/bin${PATH:+:${PATH}} export LD_LIBRARY_PATH=/usr/local/cuda-9.0/lib64\ ${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}

InstallingInstalando bibliotecas cuDNN

Por fim, precisamos instalar os binários cuDNN. Ele pode ser baixado do site da NVIDIAhttps://developer.nvidia.com/rdp/form/cudnn-download-survey. Com a versão CUDA 9.0, cuDNN 7.4.1 funciona bem. Basicamente, cuDNN é uma camada no topo do CUDA, usada pelo CNTK.

Depois de baixar a versão para Linux, extraia-a para o /usr/local/cuda-9.0 pasta usando o seguinte comando -

tar xvzf -C /usr/local/cuda-9.0/ cudnn-9.0-linux-x64-v7.4.1.5.tgzAltere o caminho para o nome do arquivo conforme necessário.

Neste capítulo, aprenderemos em detalhes sobre as sequências no CNTK e sua classificação.

Tensores

O conceito sobre o qual CNTK trabalha é tensor. Basicamente, as entradas, saídas e parâmetros do CNTK são organizados comotensors, que muitas vezes é considerada uma matriz generalizada. Cada tensor tem umrank -

Tensor de classificação 0 é um escalar.

Tensor de classificação 1 é um vetor.

Tensor de classificação 2 é amatrix.

Aqui, essas diferentes dimensões são chamadas de axes.

Eixos estáticos e eixos dinâmicos

Como o nome indica, os eixos estáticos têm o mesmo comprimento ao longo da vida da rede. Por outro lado, o comprimento dos eixos dinâmicos pode variar de instância para instância. Na verdade, seu comprimento normalmente não é conhecido antes de cada minibatch ser apresentado.

Os eixos dinâmicos são como eixos estáticos porque também definem um agrupamento significativo dos números contidos no tensor.

Exemplo

Para esclarecer, vamos ver como um minibatch de clipes de vídeo curtos é representado no CNTK. Suponha que a resolução dos clipes de vídeo seja de 640 * 480. E também os clipes são filmados em cores que normalmente são codificados com três canais. Além disso, significa que nosso minibatch tem o seguinte -

3 eixos estáticos de comprimento 640, 480 e 3, respectivamente.

Dois eixos dinâmicos; a duração do vídeo e os eixos do minibatch.

Isso significa que se um minibatch tiver 16 vídeos, cada um com 240 quadros de comprimento, será representado como 16*240*3*640*480 tensores.

Trabalhando com sequências em CNTK

Vamos entender as sequências em CNTK aprendendo primeiro sobre Rede de memória de longo-curto prazo.

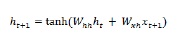

Rede de memória de longo-curto prazo (LSTM)

As redes de memória de longo-curto prazo (LSTMs) foram introduzidas por Hochreiter & Schmidhuber. Resolveu o problema de obter uma camada básica recorrente para lembrar coisas por um longo tempo. A arquitetura do LSTM é fornecida acima no diagrama. Como podemos ver, ele possui neurônios de entrada, células de memória e neurônios de saída. A fim de combater o problema do gradiente de desaparecimento, as redes de memória de longo-curto prazo usam uma célula de memória explícita (armazena os valores anteriores) e as seguintes portas -

Forget gate- Como o nome indica, diz à célula de memória para esquecer os valores anteriores. A célula de memória armazena os valores até que o portão, ou seja, 'esqueça o portão', diga para esquecê-los.

Input gate - Como o nome indica, adiciona coisas novas à célula.

Output gate - Como o nome indica, a porta de saída decide quando passar os vetores da célula para o próximo estado oculto.

É muito fácil trabalhar com sequências no CNTK. Vamos ver com a ajuda do seguinte exemplo -

import sys

import os

from cntk import Trainer, Axis

from cntk.io import MinibatchSource, CTFDeserializer, StreamDef, StreamDefs,\

INFINITELY_REPEAT

from cntk.learners import sgd, learning_parameter_schedule_per_sample

from cntk import input_variable, cross_entropy_with_softmax, \

classification_error, sequence

from cntk.logging import ProgressPrinter

from cntk.layers import Sequential, Embedding, Recurrence, LSTM, Dense

def create_reader(path, is_training, input_dim, label_dim):

return MinibatchSource(CTFDeserializer(path, StreamDefs(

features=StreamDef(field='x', shape=input_dim, is_sparse=True),

labels=StreamDef(field='y', shape=label_dim, is_sparse=False)

)), randomize=is_training,

max_sweeps=INFINITELY_REPEAT if is_training else 1)

def LSTM_sequence_classifier_net(input, num_output_classes, embedding_dim,

LSTM_dim, cell_dim):

lstm_classifier = Sequential([Embedding(embedding_dim),

Recurrence(LSTM(LSTM_dim, cell_dim)),

sequence.last,

Dense(num_output_classes)])

return lstm_classifier(input)

def train_sequence_classifier():

input_dim = 2000

cell_dim = 25

hidden_dim = 25

embedding_dim = 50

num_output_classes = 5

features = sequence.input_variable(shape=input_dim, is_sparse=True)

label = input_variable(num_output_classes)

classifier_output = LSTM_sequence_classifier_net(

features, num_output_classes, embedding_dim, hidden_dim, cell_dim)

ce = cross_entropy_with_softmax(classifier_output, label)

pe = classification_error(classifier_output, label)

rel_path = ("../../../Tests/EndToEndTests/Text/" +

"SequenceClassification/Data/Train.ctf")

path = os.path.join(os.path.dirname(os.path.abspath(__file__)), rel_path)

reader = create_reader(path, True, input_dim, num_output_classes)

input_map = {

features: reader.streams.features,

label: reader.streams.labels

}

lr_per_sample = learning_parameter_schedule_per_sample(0.0005)

progress_printer = ProgressPrinter(0)

trainer = Trainer(classifier_output, (ce, pe),

sgd(classifier_output.parameters, lr=lr_per_sample),progress_printer)

minibatch_size = 200

for i in range(255):

mb = reader.next_minibatch(minibatch_size, input_map=input_map)

trainer.train_minibatch(mb)

evaluation_average = float(trainer.previous_minibatch_evaluation_average)

loss_average = float(trainer.previous_minibatch_loss_average)

return evaluation_average, loss_average

if __name__ == '__main__':

error, _ = train_sequence_classifier()

print(" error: %f" % error)average since average since examples

loss last metric last

------------------------------------------------------

1.61 1.61 0.886 0.886 44

1.61 1.6 0.714 0.629 133

1.6 1.59 0.56 0.448 316

1.57 1.55 0.479 0.41 682

1.53 1.5 0.464 0.449 1379

1.46 1.4 0.453 0.441 2813

1.37 1.28 0.45 0.447 5679

1.3 1.23 0.448 0.447 11365

error: 0.333333A explicação detalhada do programa acima será abordada nas próximas seções, especialmente quando estivermos construindo redes neurais recorrentes.

Este capítulo trata da construção de um modelo de regressão logística no CNTK.

Noções básicas do modelo de regressão logística

A regressão logística, uma das técnicas de ML mais simples, é uma técnica especialmente para classificação binária. Em outras palavras, para criar um modelo de previsão em situações em que o valor da variável a ser prevista pode ser um de apenas dois valores categóricos. Um dos exemplos mais simples de Regressão Logística é prever se a pessoa é homem ou mulher, com base na idade, voz, cabelos e assim por diante.

Exemplo

Vamos entender o conceito de Regressão Logística matematicamente com a ajuda de outro exemplo -

Suponha que queiramos prever a capacidade de crédito de um pedido de empréstimo; 0 significa rejeitar e 1 significa aprovar, com base no candidatodebt , income e credit rating. Representamos dívida com X1, receita com X2 e classificação de crédito com X3.

Na Regressão Logística, determinamos um valor de peso, representado por w, para cada recurso e um único valor de polarização, representado por b.

Agora suponha,

X1 = 3.0

X2 = -2.0

X3 = 1.0E suponha que determinemos o peso e o viés da seguinte forma -

W1 = 0.65, W2 = 1.75, W3 = 2.05 and b = 0.33Agora, para prever a classe, precisamos aplicar a seguinte fórmula -

Z = (X1*W1)+(X2*W2)+(X3+W3)+b

i.e. Z = (3.0)*(0.65) + (-2.0)*(1.75) + (1.0)*(2.05) + 0.33

= 0.83Em seguida, precisamos calcular P = 1.0/(1.0 + exp(-Z)). Aqui, a função exp () é o número de Euler.

P = 1.0/(1.0 + exp(-0.83)

= 0.6963O valor P pode ser interpretado como a probabilidade de que a classe seja 1. Se P <0,5, a previsão é classe = 0, caso contrário, a previsão (P> = 0,5) é classe = 1.

Para determinar os valores de peso e polarização, devemos obter um conjunto de dados de treinamento com os valores preditores de entrada conhecidos e os valores de rótulos de classe corretos conhecidos. Depois disso, podemos usar um algoritmo, geralmente Gradient Descent, para encontrar os valores de peso e viés.

Exemplo de implementação de modelo LR

Para este modelo LR, vamos usar o seguinte conjunto de dados -

1.0, 2.0, 0

3.0, 4.0, 0

5.0, 2.0, 0

6.0, 3.0, 0

8.0, 1.0, 0

9.0, 2.0, 0

1.0, 4.0, 1

2.0, 5.0, 1

4.0, 6.0, 1

6.0, 5.0, 1

7.0, 3.0, 1

8.0, 5.0, 1Para iniciar a implementação deste modelo LR no CNTK, precisamos primeiro importar os seguintes pacotes -

import numpy as np

import cntk as CO programa é estruturado com a função main () da seguinte forma -

def main():

print("Using CNTK version = " + str(C.__version__) + "\n")Agora, precisamos carregar os dados de treinamento na memória da seguinte maneira -

data_file = ".\\dataLRmodel.txt"

print("Loading data from " + data_file + "\n")

features_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",", skiprows=0, usecols=[0,1])

labels_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",", skiprows=0, usecols=[2], ndmin=2)Agora, estaremos criando um programa de treinamento que cria um modelo de regressão logística compatível com os dados de treinamento -

features_dim = 2

labels_dim = 1

X = C.ops.input_variable(features_dim, np.float32)

y = C.input_variable(labels_dim, np.float32)

W = C.parameter(shape=(features_dim, 1)) # trainable cntk.Parameter

b = C.parameter(shape=(labels_dim))

z = C.times(X, W) + b

p = 1.0 / (1.0 + C.exp(-z))

model = pAgora, precisamos criar Lerner e treinador da seguinte maneira -

ce_error = C.binary_cross_entropy(model, y) # CE a bit more principled for LR

fixed_lr = 0.010

learner = C.sgd(model.parameters, fixed_lr)

trainer = C.Trainer(model, (ce_error), [learner])

max_iterations = 4000Treinamento de modelo LR

Depois de criar o modelo LR, em seguida, é hora de iniciar o processo de treinamento -

np.random.seed(4)

N = len(features_mat)

for i in range(0, max_iterations):

row = np.random.choice(N,1) # pick a random row from training items

trainer.train_minibatch({ X: features_mat[row], y: labels_mat[row] })

if i % 1000 == 0 and i > 0:

mcee = trainer.previous_minibatch_loss_average

print(str(i) + " Cross-entropy error on curr item = %0.4f " % mcee)Agora, com a ajuda do código a seguir, podemos imprimir os pesos e o viés do modelo -

np.set_printoptions(precision=4, suppress=True)

print("Model weights: ")

print(W.value)

print("Model bias:")

print(b.value)

print("")

if __name__ == "__main__":

main()Treinando um modelo de regressão logística - exemplo completo

import numpy as np

import cntk as C

def main():

print("Using CNTK version = " + str(C.__version__) + "\n")

data_file = ".\\dataLRmodel.txt" # provide the name and the location of data file

print("Loading data from " + data_file + "\n")

features_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",", skiprows=0, usecols=[0,1])

labels_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",", skiprows=0, usecols=[2], ndmin=2)

features_dim = 2

labels_dim = 1

X = C.ops.input_variable(features_dim, np.float32)

y = C.input_variable(labels_dim, np.float32)

W = C.parameter(shape=(features_dim, 1)) # trainable cntk.Parameter

b = C.parameter(shape=(labels_dim))

z = C.times(X, W) + b

p = 1.0 / (1.0 + C.exp(-z))

model = p

ce_error = C.binary_cross_entropy(model, y) # CE a bit more principled for LR

fixed_lr = 0.010

learner = C.sgd(model.parameters, fixed_lr)

trainer = C.Trainer(model, (ce_error), [learner])

max_iterations = 4000

np.random.seed(4)

N = len(features_mat)

for i in range(0, max_iterations):

row = np.random.choice(N,1) # pick a random row from training items

trainer.train_minibatch({ X: features_mat[row], y: labels_mat[row] })

if i % 1000 == 0 and i > 0:

mcee = trainer.previous_minibatch_loss_average

print(str(i) + " Cross-entropy error on curr item = %0.4f " % mcee)

np.set_printoptions(precision=4, suppress=True)

print("Model weights: ")

print(W.value)

print("Model bias:")

print(b.value)

if __name__ == "__main__":

main()Resultado

Using CNTK version = 2.7

1000 cross entropy error on curr item = 0.1941

2000 cross entropy error on curr item = 0.1746

3000 cross entropy error on curr item = 0.0563

Model weights:

[-0.2049]

[0.9666]]

Model bias:

[-2.2846]Predição usando modelo LR treinado

Uma vez que o modelo LR foi treinado, podemos usá-lo para predição da seguinte forma -

Em primeiro lugar, nosso programa de avaliação importa o pacote numpy e carrega os dados de treinamento em uma matriz de recursos e uma matriz de rótulo de classe da mesma forma que o programa de treinamento que implementamos acima -

import numpy as np

def main():

data_file = ".\\dataLRmodel.txt" # provide the name and the location of data file

features_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",",

skiprows=0, usecols=(0,1))

labels_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",",

skiprows=0, usecols=[2], ndmin=2)Em seguida, é hora de definir os valores dos pesos e do viés que foram determinados por nosso programa de treinamento -

print("Setting weights and bias values \n")

weights = np.array([0.0925, 1.1722], dtype=np.float32)

bias = np.array([-4.5400], dtype=np.float32)

N = len(features_mat)

features_dim = 2Em seguida, nosso programa de avaliação calculará a probabilidade de regressão logística percorrendo cada item de treinamento da seguinte forma -

print("item pred_prob pred_label act_label result")

for i in range(0, N): # each item

x = features_mat[i]

z = 0.0

for j in range(0, features_dim):

z += x[j] * weights[j]

z += bias[0]

pred_prob = 1.0 / (1.0 + np.exp(-z))

pred_label = 0 if pred_prob < 0.5 else 1

act_label = labels_mat[i]

pred_str = ‘correct’ if np.absolute(pred_label - act_label) < 1.0e-5 \

else ‘WRONG’

print("%2d %0.4f %0.0f %0.0f %s" % \ (i, pred_prob, pred_label, act_label, pred_str))Agora vamos demonstrar como fazer previsões -

x = np.array([9.5, 4.5], dtype=np.float32)

print("\nPredicting class for age, education = ")

print(x)

z = 0.0

for j in range(0, features_dim):

z += x[j] * weights[j]

z += bias[0]

p = 1.0 / (1.0 + np.exp(-z))

print("Predicted p = " + str(p))

if p < 0.5: print("Predicted class = 0")

else: print("Predicted class = 1")Programa completo de avaliação de previsão

import numpy as np

def main():

data_file = ".\\dataLRmodel.txt" # provide the name and the location of data file

features_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",",

skiprows=0, usecols=(0,1))

labels_mat = np.loadtxt(data_file, dtype=np.float32, delimiter=",",

skiprows=0, usecols=[2], ndmin=2)

print("Setting weights and bias values \n")

weights = np.array([0.0925, 1.1722], dtype=np.float32)

bias = np.array([-4.5400], dtype=np.float32)

N = len(features_mat)

features_dim = 2

print("item pred_prob pred_label act_label result")

for i in range(0, N): # each item

x = features_mat[i]

z = 0.0

for j in range(0, features_dim):

z += x[j] * weights[j]

z += bias[0]

pred_prob = 1.0 / (1.0 + np.exp(-z))

pred_label = 0 if pred_prob < 0.5 else 1

act_label = labels_mat[i]

pred_str = ‘correct’ if np.absolute(pred_label - act_label) < 1.0e-5 \

else ‘WRONG’

print("%2d %0.4f %0.0f %0.0f %s" % \ (i, pred_prob, pred_label, act_label, pred_str))

x = np.array([9.5, 4.5], dtype=np.float32)

print("\nPredicting class for age, education = ")

print(x)

z = 0.0

for j in range(0, features_dim):

z += x[j] * weights[j]

z += bias[0]

p = 1.0 / (1.0 + np.exp(-z))

print("Predicted p = " + str(p))

if p < 0.5: print("Predicted class = 0")

else: print("Predicted class = 1")

if __name__ == "__main__":

main()Resultado

Definir pesos e valores de polarização.

Item pred_prob pred_label act_label result

0 0.3640 0 0 correct

1 0.7254 1 0 WRONG

2 0.2019 0 0 correct

3 0.3562 0 0 correct

4 0.0493 0 0 correct

5 0.1005 0 0 correct

6 0.7892 1 1 correct

7 0.8564 1 1 correct

8 0.9654 1 1 correct

9 0.7587 1 1 correct

10 0.3040 0 1 WRONG

11 0.7129 1 1 correct

Predicting class for age, education =

[9.5 4.5]

Predicting p = 0.526487952

Predicting class = 1Este capítulo trata de conceitos de Rede Neural em relação ao CNTK.

Como sabemos, várias camadas de neurônios são usadas para fazer uma rede neural. Mas, surge a pergunta que no CNTK como podemos modelar as camadas de um NN? Isso pode ser feito com a ajuda de funções de camada definidas no módulo de camada.

Função de camada

Na verdade, no CNTK, trabalhar com as camadas tem uma sensação de programação funcional distinta. A função de camada se parece com uma função regular e produz uma função matemática com um conjunto de parâmetros predefinidos. Vamos ver como podemos criar o tipo de camada mais básico, Denso, com a ajuda da função de camada.

Exemplo

Com a ajuda das etapas básicas a seguir, podemos criar o tipo de camada mais básico -

Step 1 - Primeiro, precisamos importar a função de camada Densa do pacote de camadas do CNTK.

from cntk.layers import DenseStep 2 - Em seguida, a partir do pacote raiz CNTK, precisamos importar a função input_variable.

from cntk import input_variableStep 3- Agora, precisamos criar uma nova variável de entrada usando a função input_variable. Também precisamos fornecer o seu tamanho.

feature = input_variable(100)Step 4 - Por fim, iremos criar uma nova camada usando a função Densi juntamente com o número de neurônios que queremos.

layer = Dense(40)(feature)Agora, podemos invocar a função de camada Densa configurada para conectar a camada Densa à entrada.

Exemplo de implementação completo

from cntk.layers import Dense

from cntk import input_variable

feature= input_variable(100)

layer = Dense(40)(feature)Personalização de camadas

Como vimos, o CNTK nos fornece um bom conjunto de padrões para a construção de NNs. Baseado emactivationfunção e outras configurações que escolhermos, o comportamento, bem como o desempenho do NN é diferente. É outro algoritmo de derivação muito útil. Por isso, é bom entender o que podemos configurar.

Etapas para configurar uma camada densa

Cada camada no NN tem suas opções de configuração exclusivas e quando falamos sobre a camada Densa, temos as seguintes configurações importantes para definir -

shape - Como o nome indica, ele define a forma de saída da camada que determina ainda mais o número de neurônios nessa camada.

activation - Define a função de ativação dessa camada, para que possa transformar os dados de entrada.

init- Define a função de inicialização dessa camada. Ele inicializará os parâmetros da camada quando começarmos a treinar o NN.

Vamos ver as etapas com a ajuda das quais podemos configurar um Dense camada -

Step1 - Primeiro, precisamos importar o Dense função de camada do pacote de camadas do CNTK.

from cntk.layers import DenseStep2 - Em seguida, do pacote de operações CNTK, precisamos importar o sigmoid operator. Ele será usado para configurar como uma função de ativação.

from cntk.ops import sigmoidStep3 - Agora, do pacote inicializador, precisamos importar o glorot_uniform inicializador.

from cntk.initializer import glorot_uniformStep4 - Por fim, vamos criar uma nova camada usando a função Densi juntamente com o número de neurônios como primeiro argumento. Além disso, forneça osigmoid operador como activation função e o glorot_uniform Enquanto o init função para a camada.

layer = Dense(50, activation = sigmoid, init = glorot_uniform)Exemplo de implementação completo -

from cntk.layers import Dense

from cntk.ops import sigmoid

from cntk.initializer import glorot_uniform

layer = Dense(50, activation = sigmoid, init = glorot_uniform)Otimizando os parâmetros

Até agora, vimos como criar a estrutura de um NN e como definir várias configurações. Aqui, veremos como podemos otimizar os parâmetros de um NN. Com a ajuda da combinação de dois componentes, a saberlearners e trainers, podemos otimizar os parâmetros de um NN.

componente de treinador

O primeiro componente que é usado para otimizar os parâmetros de um NN é trainercomponente. Basicamente, ele implementa o processo de retropropagação. Se falarmos sobre seu funcionamento, ele passa os dados pelo NN para obter uma previsão.

Em seguida, utiliza outro componente denominado learner para obter os novos valores para os parâmetros de um NN. Depois de obter os novos valores, ele aplica esses novos valores e repete o processo até que um critério de saída seja atendido.

componente do aluno

O segundo componente que é usado para otimizar os parâmetros de um NN é learner componente, basicamente responsável pela execução do algoritmo de descida gradiente.

Alunos incluídos na biblioteca CNTK

A seguir está a lista de alguns dos alunos interessantes incluídos na biblioteca CNTK -

Stochastic Gradient Descent (SGD) - Este aluno representa a descida gradiente estocástica básica, sem quaisquer extras.

Momentum Stochastic Gradient Descent (MomentumSGD) - Com SGD, este aluno aplica o momentum para superar o problema dos máximos locais.

RMSProp - Este aluno, para controlar a taxa de descida, usa taxas de aprendizado decrescentes.

Adam - Esse aluno, para diminuir a taxa de descida ao longo do tempo, usa o momento de decadência.

Adagrad - Este aluno, para recursos de ocorrência frequente ou infrequente, usa taxas de aprendizagem diferentes.

CNTK - Criando a primeira rede neural

Este capítulo irá elaborar sobre a criação de uma rede neural no CNTK.

Construa a estrutura da rede

A fim de aplicar os conceitos de CNTK para construir nosso primeiro NN, vamos usar o NN para classificar as espécies de flores de íris com base nas propriedades físicas de largura e comprimento da sépala e largura e comprimento da pétala. O conjunto de dados que usaremos usando o conjunto de dados da íris que descreve as propriedades físicas de diferentes variedades de flores da íris -

- Comprimento da sépala

- Largura sépala

- Comprimento da pétala

- Largura da pétala

- Classe ie iris setosa ou iris versicolor ou iris virginica

Aqui, estaremos construindo um NN regular chamado NN feedforward. Vejamos as etapas de implementação para construir a estrutura do NN -

Step 1 - Primeiro, importaremos os componentes necessários, como nossos tipos de camada, funções de ativação e uma função que nos permite definir uma variável de entrada para nosso NN, da biblioteca CNTK.

from cntk import default_options, input_variable

from cntk.layers import Dense, Sequential

from cntk.ops import log_softmax, reluStep 2- Depois disso, vamos criar nosso modelo usando a função sequencial. Uma vez criado, iremos alimentá-lo com as camadas que desejamos. Aqui, vamos criar duas camadas distintas em nosso NN; um com quatro neurônios e outro com três neurônios.

model = Sequential([Dense(4, activation=relu), Dense(3, activation=log_sogtmax)])Step 3- Por fim, para compilar o NN, vamos vincular a rede à variável de entrada. Possui uma camada de entrada com quatro neurônios e uma camada de saída com três neurônios.

feature= input_variable(4)

z = model(feature)Aplicando uma função de ativação

Existem muitas funções de ativação para escolher e escolher a função de ativação certa definitivamente fará uma grande diferença no desempenho de nosso modelo de aprendizado profundo.

Na camada de saída

Escolhendo um activation função na camada de saída dependerá do tipo de problema que vamos resolver com nosso modelo.

Para um problema de regressão, devemos usar um linear activation function na camada de saída.

Para um problema de classificação binária, devemos usar um sigmoid activation function na camada de saída.

Para o problema de classificação multi-classe, devemos usar um softmax activation function na camada de saída.

Aqui, vamos construir um modelo para prever uma das três classes. Isso significa que precisamos usarsoftmax activation function na camada de saída.

Na camada oculta

Escolhendo um activation A função na camada oculta requer alguma experimentação para monitorar o desempenho para ver qual função de ativação funciona bem.

Em um problema de classificação, precisamos prever a probabilidade de uma amostra pertencer a uma classe específica. É por isso que precisamos de umactivation functionque nos dá valores probabilísticos. Para alcançar este objetivo,sigmoid activation function pode nos ajudar.

Um dos principais problemas associados à função sigmóide é o problema do gradiente de desaparecimento. Para superar esse problema, podemos usarReLU activation function que cobre todos os valores negativos a zero e funciona como um filtro de passagem para valores positivos.

Escolha uma função de perda

Uma vez que temos a estrutura para nosso modelo NN, devemos otimizá-lo. Para otimizar, precisamos de umloss function. Ao contrárioactivation functions, temos muito menos funções de perda para escolher. No entanto, a escolha de uma função de perda dependerá do tipo de problema que vamos resolver com nosso modelo.

Por exemplo, em um problema de classificação, devemos usar uma função de perda que pode medir a diferença entre uma classe prevista e uma classe real.

função de perda

Para o problema de classificação, vamos resolver com nosso modelo NN, categorical cross entropya função de perda é a melhor candidata. No CNTK, é implementado comocross_entropy_with_softmax que pode ser importado de cntk.losses pacote, como segue -

label= input_variable(3)

loss = cross_entropy_with_softmax(z, label)Métricas

Com a estrutura para nosso modelo NN e uma função de perda para aplicar, temos todos os ingredientes para começar a fazer a receita para otimizar nosso modelo de aprendizado profundo. Mas, antes de nos aprofundarmos nisso, devemos aprender sobre métricas.

cntk.metricsCNTK tem o pacote denominado cntk.metricsa partir do qual podemos importar as métricas que vamos usar. Enquanto estamos construindo um modelo de classificação, estaremos usandoclassification_error matric que irá produzir um número entre 0 e 1. O número entre 0 e 1 indica a porcentagem de amostras previstas corretamente -

Primeiro, precisamos importar a métrica de cntk.metrics pacote -

from cntk.metrics import classification_error

error_rate = classification_error(z, label)A função acima realmente precisa da saída do NN e do rótulo esperado como entrada.

CNTK - Treinamento da Rede Neural

Aqui, vamos entender sobre o treinamento da Rede Neural em CNTK.

Treinando um modelo em CNTK

Na seção anterior, definimos todos os componentes do modelo de aprendizado profundo. Agora é hora de treiná-lo. Como discutimos anteriormente, podemos treinar um modelo NN em CNTK usando a combinação delearner e trainer.

Escolher um aluno e configurar o treinamento

Nesta seção, iremos definir o learner. CNTK fornece várioslearnersescolher a partir de. Para o nosso modelo, definido nas seções anteriores, estaremos usandoStochastic Gradient Descent (SGD) learner.

Para treinar a rede neural, vamos configurar o learner e trainer com a ajuda das seguintes etapas -

Step 1 - Primeiro, precisamos importar sgd função de cntk.lerners pacote.

from cntk.learners import sgdStep 2 - Em seguida, precisamos importar Trainer função de cntk.trainpacote .trainer.

from cntk.train.trainer import TrainerStep 3 - Agora, precisamos criar um learner. Pode ser criado invocandosgd funcionar junto com o fornecimento de parâmetros do modelo e um valor para a taxa de aprendizagem.

learner = sgd(z.parametrs, 0.01)Step 4 - Por fim, precisamos inicializar o trainer. Deve ser fornecida a rede, a combinação doloss e metric juntamente com o learner.

trainer = Trainer(z, (loss, error_rate), [learner])A taxa de aprendizagem que controla a velocidade da otimização deve ser um pequeno número entre 0,1 e 0,001.

Escolhendo um aluno e configurando o treinamento - Exemplo completo

from cntk.learners import sgd

from cntk.train.trainer import Trainer

learner = sgd(z.parametrs, 0.01)

trainer = Trainer(z, (loss, error_rate), [learner])Alimentando dados para o treinador

Depois de escolher e configurar o treinador, é hora de carregar o conjunto de dados. Nós salvamos oiris conjunto de dados como um.CSV arquivo e usaremos o pacote de wrangling de dados chamado pandas para carregar o conjunto de dados.

Etapas para carregar o conjunto de dados do arquivo .CSV

Step 1 - Primeiro, precisamos importar o pandas pacote.

from import pandas as pdStep 2 - Agora, precisamos invocar a função chamada read_csv função para carregar o arquivo .csv do disco.

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’,

‘petal_length’, ‘petal_width’, index_col=False)Depois de carregar o conjunto de dados, precisamos dividi-lo em um conjunto de recursos e um rótulo.

Etapas para dividir o conjunto de dados em recursos e rótulo

Step 1- Primeiro, precisamos selecionar todas as linhas e as primeiras quatro colunas do conjunto de dados. Isso pode ser feito usandoiloc função.

x = df_source.iloc[:, :4].valuesStep 2- Em seguida, precisamos selecionar a coluna de espécies do conjunto de dados da íris. Estaremos usando a propriedade values para acessar o subjacentenumpy array.

x = df_source[‘species’].valuesEtapas para codificar a coluna de espécies em uma representação vetorial numérica

Como discutimos anteriormente, nosso modelo é baseado na classificação, requer valores de entrada numéricos. Portanto, aqui precisamos codificar a coluna de espécies em uma representação vetorial numérica. Vamos ver as etapas para fazer isso -

Step 1- Primeiro, precisamos criar uma expressão de lista para iterar sobre todos os elementos do array. Em seguida, execute uma pesquisa no dicionário label_mapping para cada valor.

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}Step 2- Em seguida, converta este valor numérico convertido em um vetor codificado de um ponto. Estaremos usandoone_hot funcionar da seguinte forma -

def one_hot(index, length):

result = np.zeros(length)

result[index] = 1

return resultStep 3 - Por fim, precisamos transformar essa lista convertida em um numpy array.

y = np.array([one_hot(label_mapping[v], 3) for v in y])Etapas para detectar overfitting

A situação, quando seu modelo lembra das amostras, mas não pode deduzir regras das amostras de treinamento, é overfitting. Com a ajuda das etapas a seguir, podemos detectar overfitting em nosso modelo -

Step 1 - Primeiro, de sklearn pacote, importe o train_test_split função do model_selection módulo.

from sklearn.model_selection import train_test_splitStep 2 - Em seguida, precisamos invocar a função train_test_split com os recursos xe rótulos y da seguinte forma -

x_train, x_test, y_train, y_test = train_test_split(X, y, test_size=0-2,

stratify=y)Especificamos um test_size de 0,2 para reservar 20% dos dados totais.

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}Etapas para alimentar o conjunto de treinamento e o conjunto de validação para nosso modelo

Step 1 - Para treinar nosso modelo, primeiro, vamos invocar o train_minibatchmétodo. Em seguida, forneça a ele um dicionário que mapeie os dados de entrada para a variável de entrada que usamos para definir o NN e sua função de perda associada.

trainer.train_minibatch({ features: X_train, label: y_train})Step 2 - Em seguida, ligue train_minibatch usando o seguinte for loop -

for _epoch in range(10):

trainer.train_minbatch ({ feature: X_train, label: y_train})

print(‘Loss: {}, Acc: {}’.format(

trainer.previous_minibatch_loss_average,

trainer.previous_minibatch_evaluation_average))Alimentando dados para o treinador - exemplo completo

from import pandas as pd

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’, ‘petal_length’, ‘petal_width’, index_col=False)

x = df_source.iloc[:, :4].values

x = df_source[‘species’].values

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}

def one_hot(index, length):

result = np.zeros(length)

result[index] = 1

return result

y = np.array([one_hot(label_mapping[v], 3) for v in y])

from sklearn.model_selection import train_test_split

x_train, x_test, y_train, y_test = train_test_split(X, y, test_size=0-2, stratify=y)

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}

trainer.train_minibatch({ features: X_train, label: y_train})

for _epoch in range(10):

trainer.train_minbatch ({ feature: X_train, label: y_train})

print(‘Loss: {}, Acc: {}’.format(

trainer.previous_minibatch_loss_average,

trainer.previous_minibatch_evaluation_average))Medindo o desempenho de NN

Para otimizar nosso modelo NN, sempre que passamos dados pelo treinador, ele mede o desempenho do modelo por meio da métrica que configuramos para o treinador. Essa medida de desempenho do modelo NN durante o treinamento é nos dados de treinamento. Mas, por outro lado, para uma análise completa do desempenho do modelo, precisamos usar dados de teste também.

Portanto, para medir o desempenho do modelo usando os dados de teste, podemos invocar o test_minibatch método no trainer como segue -

trainer.test_minibatch({ features: X_test, label: y_test})Fazendo previsão com NN

Depois de treinar um modelo de aprendizado profundo, o mais importante é fazer previsões usando isso. Para fazer a previsão do NN treinado acima, podemos seguir os passos dados−

Step 1 - Primeiro, precisamos escolher um item aleatório do conjunto de teste usando a seguinte função -

np.random.choiceStep 2 - Em seguida, precisamos selecionar os dados de amostra do conjunto de teste usando sample_index.

Step 3 - Agora, a fim de converter a saída numérica para o NN em um rótulo real, crie um mapeamento invertido.

Step 4 - Agora, use o selecionado sampledados. Faça uma previsão invocando o NN z como uma função.

Step 5- Agora, uma vez que você obteve a saída prevista, pegue o índice do neurônio que tem o valor mais alto como o valor previsto. Isso pode ser feito usando onp.argmax função do numpy pacote.

Step 6 - Por último, converta o valor do índice no rótulo real usando inverted_mapping.

Fazendo previsões com NN - exemplo completo

sample_index = np.random.choice(X_test.shape[0])

sample = X_test[sample_index]

inverted_mapping = {

1:’Iris-setosa’,

2:’Iris-versicolor’,

3:’Iris-virginica’

}

prediction = z(sample)

predicted_label = inverted_mapping[np.argmax(prediction)]

print(predicted_label)Resultado

Depois de treinar o modelo de aprendizado profundo acima e executá-lo, você obterá o seguinte resultado -

Iris-versicolorCNTK - In-Memory e grandes conjuntos de dados

Neste capítulo, aprenderemos como trabalhar com os conjuntos de dados na memória e grandes no CNTK.

Treinamento com pequenos conjuntos de dados de memória

Quando falamos sobre alimentar dados no treinador CNTK, pode haver muitas maneiras, mas vai depender do tamanho do conjunto de dados e formato dos dados. Os conjuntos de dados podem ser pequenos na memória ou grandes conjuntos de dados.

Nesta seção, trabalharemos com conjuntos de dados na memória. Para isso, usaremos as duas estruturas a seguir -

- Numpy

- Pandas

Usando matrizes Numpy

Aqui, trabalharemos com um conjunto de dados gerado aleatoriamente baseado em numpy no CNTK. Neste exemplo, vamos simular dados para um problema de classificação binária. Suponha que temos um conjunto de observações com 4 recursos e queremos prever dois rótulos possíveis com nosso modelo de aprendizado profundo.

Exemplo de Implementação

Para isso, primeiro devemos gerar um conjunto de rótulos contendo uma representação vetorial de um elemento dos rótulos que queremos prever. Isso pode ser feito com a ajuda das seguintes etapas -

Step 1 - Importe o numpy pacote da seguinte forma -

import numpy as np

num_samples = 20000Step 2 - Em seguida, gere um mapeamento de rótulo usando np.eye funcionar da seguinte forma -

label_mapping = np.eye(2)Step 3 - Agora usando np.random.choice função, colete as 20000 amostras aleatórias da seguinte forma -

y = label_mapping[np.random.choice(2,num_samples)].astype(np.float32)Step 4 - Agora, finalmente, usando a função np.random.random, gere uma matriz de valores de ponto flutuante aleatório da seguinte forma -

x = np.random.random(size=(num_samples, 4)).astype(np.float32)Uma vez que geramos uma matriz de valores de ponto flutuante aleatórios, precisamos convertê-los em números de ponto flutuante de 32 bits para que possam corresponder ao formato esperado pelo CNTK. Vamos seguir as etapas abaixo para fazer isso -

Step 5 - Importe as funções das camadas Densa e Sequencial do módulo cntk.layers da seguinte forma -

from cntk.layers import Dense, SequentialStep 6- Agora, precisamos importar a função de ativação para as camadas da rede. Vamos importar osigmoid como função de ativação -

from cntk import input_variable, default_options

from cntk.ops import sigmoidStep 7- Agora, precisamos importar a função de perda para treinar a rede. Deixe-nos importarbinary_cross_entropy como função de perda -

from cntk.losses import binary_cross_entropyStep 8- Em seguida, precisamos definir as opções padrão para a rede. Aqui, estaremos fornecendo osigmoidfunção de ativação como uma configuração padrão. Além disso, crie o modelo usando a função da camada sequencial da seguinte maneira -

with default_options(activation=sigmoid):

model = Sequential([Dense(6),Dense(2)])Step 9 - Em seguida, inicialize um input_variable com 4 recursos de entrada servindo como entrada para a rede.

features = input_variable(4)Step 10 - Agora, para completá-lo, precisamos conectar a variável features ao NN.

z = model(features)Então, agora temos um NN, com a ajuda das etapas a seguir, vamos treiná-lo usando um conjunto de dados na memória -

Step 11 - Para treinar este NN, primeiro precisamos importar o aluno de cntk.learnersmódulo. Vamos importarsgd aluno da seguinte forma -

from cntk.learners import sgdStep 12 - Junto com essa importação, o ProgressPrinter de cntk.logging módulo também.

from cntk.logging import ProgressPrinter

progress_writer = ProgressPrinter(0)Step 13 - Em seguida, defina uma nova variável de entrada para os rótulos da seguinte forma -

labels = input_variable(2)Step 14 - A fim de treinar o modelo NN, a seguir, precisamos definir uma perda usando o binary_cross_entropyfunção. Além disso, forneça o modelo zea variável de rótulos.

loss = binary_cross_entropy(z, labels)Step 15 - Em seguida, inicialize o sgd aluno da seguinte forma -

learner = sgd(z.parameters, lr=0.1)Step 16- Por fim, chame o método train na função de perda. Além disso, forneça-lhe os dados de entrada, osgd aluno e o progress_printer.−

training_summary=loss.train((x,y),parameter_learners=[learner],callbacks=[progress_writer])Exemplo de implementação completo

import numpy as np

num_samples = 20000

label_mapping = np.eye(2)

y = label_mapping[np.random.choice(2,num_samples)].astype(np.float32)

x = np.random.random(size=(num_samples, 4)).astype(np.float32)

from cntk.layers import Dense, Sequential

from cntk import input_variable, default_options

from cntk.ops import sigmoid

from cntk.losses import binary_cross_entropy

with default_options(activation=sigmoid):

model = Sequential([Dense(6),Dense(2)])

features = input_variable(4)

z = model(features)

from cntk.learners import sgd

from cntk.logging import ProgressPrinter

progress_writer = ProgressPrinter(0)

labels = input_variable(2)

loss = binary_cross_entropy(z, labels)

learner = sgd(z.parameters, lr=0.1)

training_summary=loss.train((x,y),parameter_learners=[learner],callbacks=[progress_writer])Resultado

Build info:

Built time: *** ** **** 21:40:10

Last modified date: *** *** ** 21:08:46 2019

Build type: Release

Build target: CPU-only

With ASGD: yes

Math lib: mkl

Build Branch: HEAD

Build SHA1:ae9c9c7c5f9e6072cc9c94c254f816dbdc1c5be6 (modified)

MPI distribution: Microsoft MPI

MPI version: 7.0.12437.6

-------------------------------------------------------------------

average since average since examples

loss last metric last

------------------------------------------------------

Learning rate per minibatch: 0.1

1.52 1.52 0 0 32

1.51 1.51 0 0 96

1.48 1.46 0 0 224

1.45 1.42 0 0 480

1.42 1.4 0 0 992

1.41 1.39 0 0 2016

1.4 1.39 0 0 4064

1.39 1.39 0 0 8160

1.39 1.39 0 0 16352Usando Pandas DataFrames

Matrizes Numpy são muito limitadas no que podem conter e uma das formas mais básicas de armazenamento de dados. Por exemplo, uma única matriz n-dimensional pode conter dados de um único tipo de dados. Mas, por outro lado, para muitos casos do mundo real, precisamos de uma biblioteca que possa lidar com mais de um tipo de dados em um único conjunto de dados.

Uma das bibliotecas Python chamada Pandas torna mais fácil trabalhar com esse tipo de conjunto de dados. Ele apresenta o conceito de DataFrame (DF) e nos permite carregar conjuntos de dados do disco armazenado em vários formatos como DFs. Por exemplo, podemos ler DFs armazenados como CSV, JSON, Excel, etc.

Você pode aprender a biblioteca Python Pandas em mais detalhes em https://www.tutorialspoint.com/python_pandas/index.htm.

Exemplo de Implementação

Neste exemplo, vamos usar o exemplo de classificação de três espécies possíveis de flores de íris com base em quatro propriedades. Também criamos esse modelo de aprendizado profundo nas seções anteriores. O modelo é o seguinte -

from cntk.layers import Dense, Sequential

from cntk import input_variable, default_options

from cntk.ops import sigmoid, log_softmax

from cntk.losses import binary_cross_entropy

model = Sequential([

Dense(4, activation=sigmoid),

Dense(3, activation=log_softmax)

])

features = input_variable(4)

z = model(features)O modelo acima contém uma camada oculta e uma camada de saída com três neurônios para corresponder ao número de classes que podemos prever.

Em seguida, usaremos o train método e lossfunção para treinar a rede. Para isso, primeiro devemos carregar e pré-processar o conjunto de dados da íris, de modo que corresponda ao layout e formato de dados esperados para o NN. Isso pode ser feito com a ajuda das seguintes etapas -

Step 1 - Importe o numpy e Pandas pacote da seguinte forma -

import numpy as np

import pandas as pdStep 2 - Em seguida, use o read_csv função para carregar o conjunto de dados na memória -

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’,

‘petal_length’, ‘petal_width’, ‘species’], index_col=False)Step 3 - Agora, precisamos criar um dicionário que mapeará os rótulos no conjunto de dados com sua representação numérica correspondente.

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}Step 4 - Agora, usando iloc indexador no DataFrame, selecione as primeiras quatro colunas da seguinte forma -

x = df_source.iloc[:, :4].valuesStep 5−Em seguida, precisamos selecionar as colunas de espécies como rótulos para o conjunto de dados. Isso pode ser feito da seguinte forma -

y = df_source[‘species’].valuesStep 6 - Agora, precisamos mapear os rótulos no conjunto de dados, o que pode ser feito usando label_mapping. Além disso, useone_hot codificação para convertê-los em matrizes de codificação one-hot.

y = np.array([one_hot(label_mapping[v], 3) for v in y])Step 7 - Em seguida, para usar os recursos e os rótulos mapeados com CNTK, precisamos convertê-los em flutuantes -

x= x.astype(np.float32)

y= y.astype(np.float32)Como sabemos, os rótulos são armazenados no conjunto de dados como strings e o CNTK não pode funcionar com essas strings. Essa é a razão, ele precisa de vetores codificados com um elemento representando os rótulos. Para isso, podemos definir uma função, digamosone_hot como segue -

def one_hot(index, length):

result = np.zeros(length)

result[index] = index

return resultAgora, temos o array numpy no formato correto, com a ajuda das etapas a seguir, podemos usá-los para treinar nosso modelo -

Step 8- Primeiro, precisamos importar a função de perda para treinar a rede. Deixe-nos importarbinary_cross_entropy_with_softmax como função de perda -

from cntk.losses import binary_cross_entropy_with_softmaxStep 9 - Para treinar este NN, também precisamos importar o aluno de cntk.learnersmódulo. Vamos importarsgd aluno da seguinte forma -

from cntk.learners import sgdStep 10 - Junto com essa importação, o ProgressPrinter de cntk.logging módulo também.

from cntk.logging import ProgressPrinter

progress_writer = ProgressPrinter(0)Step 11 - Em seguida, defina uma nova variável de entrada para os rótulos da seguinte forma -

labels = input_variable(3)Step 12 - A fim de treinar o modelo NN, a seguir, precisamos definir uma perda usando o binary_cross_entropy_with_softmaxfunção. Forneça também o modelo ze a variável de rótulos.

loss = binary_cross_entropy_with_softmax (z, labels)Step 13 - Em seguida, inicialize o sgd aluno da seguinte forma -

learner = sgd(z.parameters, 0.1)Step 14- Por fim, chame o método train na função de perda. Além disso, forneça-lhe os dados de entrada, osgd aluno e o progress_printer.

training_summary=loss.train((x,y),parameter_learners=[learner],callbacks=

[progress_writer],minibatch_size=16,max_epochs=5)Exemplo de implementação completo

from cntk.layers import Dense, Sequential

from cntk import input_variable, default_options

from cntk.ops import sigmoid, log_softmax

from cntk.losses import binary_cross_entropy

model = Sequential([

Dense(4, activation=sigmoid),

Dense(3, activation=log_softmax)

])

features = input_variable(4)

z = model(features)

import numpy as np

import pandas as pd

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’, ‘petal_length’, ‘petal_width’, ‘species’], index_col=False)

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}

x = df_source.iloc[:, :4].values

y = df_source[‘species’].values

y = np.array([one_hot(label_mapping[v], 3) for v in y])

x= x.astype(np.float32)

y= y.astype(np.float32)

def one_hot(index, length):

result = np.zeros(length)

result[index] = index

return result

from cntk.losses import binary_cross_entropy_with_softmax

from cntk.learners import sgd

from cntk.logging import ProgressPrinter

progress_writer = ProgressPrinter(0)

labels = input_variable(3)

loss = binary_cross_entropy_with_softmax (z, labels)

learner = sgd(z.parameters, 0.1)

training_summary=loss.train((x,y),parameter_learners=[learner],callbacks=[progress_writer],minibatch_size=16,max_epochs=5)Resultado

Build info:

Built time: *** ** **** 21:40:10

Last modified date: *** *** ** 21:08:46 2019

Build type: Release

Build target: CPU-only

With ASGD: yes

Math lib: mkl

Build Branch: HEAD

Build SHA1:ae9c9c7c5f9e6072cc9c94c254f816dbdc1c5be6 (modified)

MPI distribution: Microsoft MPI

MPI version: 7.0.12437.6

-------------------------------------------------------------------

average since average since examples

loss last metric last

------------------------------------------------------

Learning rate per minibatch: 0.1

1.1 1.1 0 0 16

0.835 0.704 0 0 32

1.993 1.11 0 0 48

1.14 1.14 0 0 112

[………]Treinamento com grandes conjuntos de dados

Na seção anterior, trabalhamos com pequenos conjuntos de dados na memória usando Numpy e pandas, mas nem todos os conjuntos de dados são tão pequenos. Especialmente os conjuntos de dados contendo imagens, vídeos e amostras de som são grandes.MinibatchSourceé um componente que pode carregar dados em blocos, fornecido pelo CNTK para trabalhar com conjuntos de dados tão grandes. Algumas das características doMinibatchSource os componentes são os seguintes -

MinibatchSource pode evitar que o NN super ajuste aleatoriamente automaticamente as amostras lidas da fonte de dados.

Possui pipeline de transformação integrado que pode ser usado para aumentar os dados.

Ele carrega os dados em um thread de segundo plano separado do processo de treinamento.

Nas seções a seguir, vamos explorar como usar uma fonte de minibatch com dados sem memória para trabalhar com grandes conjuntos de dados. Também exploraremos como podemos usá-lo para alimentar um NN.

Criação de instância MinibatchSource

Na seção anterior, usamos o exemplo de flor de íris e trabalhamos com um pequeno conjunto de dados na memória usando Pandas DataFrames. Aqui, estaremos substituindo o código que usa dados de um pandas DF porMinibatchSource. Primeiro, precisamos criar uma instância deMinibatchSource com a ajuda das seguintes etapas -

Exemplo de Implementação

Step 1 - Primeiro, de cntk.io módulo importe os componentes para a fonte de minibatch da seguinte forma -

from cntk.io import StreamDef, StreamDefs, MinibatchSource, CTFDeserializer,

INFINITY_REPEATStep 2 - Agora, usando StreamDef classe, crie uma definição de fluxo para os rótulos.

labels_stream = StreamDef(field=’labels’, shape=3, is_sparse=False)Step 3 - Em seguida, crie para ler os recursos arquivados do arquivo de entrada, crie outra instância de StreamDef do seguinte modo.

feature_stream = StreamDef(field=’features’, shape=4, is_sparse=False)Step 4 - Agora, precisamos fornecer iris.ctf arquivo como entrada e inicializar o deserializer como segue -

deserializer = CTFDeserializer(‘iris.ctf’, StreamDefs(labels=

label_stream, features=features_stream)Step 5 - Por fim, precisamos criar uma instância de minisourceBatch usando deserializer como segue -

Minibatch_source = MinibatchSource(deserializer, randomize=True)Criando uma instância MinibatchSource - Exemplo de implementação completo

from cntk.io import StreamDef, StreamDefs, MinibatchSource, CTFDeserializer, INFINITY_REPEAT

labels_stream = StreamDef(field=’labels’, shape=3, is_sparse=False)

feature_stream = StreamDef(field=’features’, shape=4, is_sparse=False)

deserializer = CTFDeserializer(‘iris.ctf’, StreamDefs(labels=label_stream, features=features_stream)

Minibatch_source = MinibatchSource(deserializer, randomize=True)Criando arquivo MCTF

Como você viu acima, estamos pegando os dados do arquivo 'iris.ctf'. Possui o formato de arquivo denominado CNTK Text Format (CTF). É obrigatório criar um arquivo CTF para obter os dados para oMinibatchSourceinstância que criamos acima. Vamos ver como podemos criar um arquivo CTF.

Exemplo de Implementação

Step 1 - Primeiro, precisamos importar os pacotes pandas e numpy da seguinte forma -

import pandas as pd

import numpy as npStep 2- Em seguida, precisamos carregar nosso arquivo de dados, ou seja, iris.csv na memória. Em seguida, armazene-o nodf_source variável.

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’, ‘petal_length’, ‘petal_width’, ‘species’], index_col=False)Step 3 - Agora, usando ilocindexador como os recursos, pegue o conteúdo das primeiras quatro colunas. Além disso, use os dados da coluna de espécies da seguinte forma -

features = df_source.iloc[: , :4].values

labels = df_source[‘species’].valuesStep 4- Em seguida, precisamos criar um mapeamento entre o nome do rótulo e sua representação numérica. Isso pode ser feito criandolabel_mapping como segue -

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}Step 5 - Agora, converta os rótulos em um conjunto de vetores codificados de um hot como segue -

labels = [one_hot(label_mapping[v], 3) for v in labels]Agora, como fizemos antes, crie uma função de utilidade chamada one_hotpara codificar os rótulos. Isso pode ser feito da seguinte forma -

def one_hot(index, length):

result = np.zeros(length)

result[index] = 1

return resultComo carregamos e pré-processamos os dados, é hora de armazená-los em disco no formato de arquivo CTF. Podemos fazer isso com a ajuda do seguinte código Python -

With open(‘iris.ctf’, ‘w’) as output_file:

for index in range(0, feature.shape[0]):

feature_values = ‘ ‘.join([str(x) for x in np.nditer(features[index])])

label_values = ‘ ‘.join([str(x) for x in np.nditer(labels[index])])

output_file.write(‘features {} | labels {} \n’.format(feature_values, label_values))Criação de um arquivo MCTF - Exemplo de implementação completo

import pandas as pd

import numpy as np

df_source = pd.read_csv(‘iris.csv’, names = [‘sepal_length’, ‘sepal_width’, ‘petal_length’, ‘petal_width’, ‘species’], index_col=False)

features = df_source.iloc[: , :4].values

labels = df_source[‘species’].values

label_mapping = {‘Iris-Setosa’ : 0, ‘Iris-Versicolor’ : 1, ‘Iris-Virginica’ : 2}

labels = [one_hot(label_mapping[v], 3) for v in labels]

def one_hot(index, length):

result = np.zeros(length)

result[index] = 1

return result

With open(‘iris.ctf’, ‘w’) as output_file:

for index in range(0, feature.shape[0]):

feature_values = ‘ ‘.join([str(x) for x in np.nditer(features[index])])

label_values = ‘ ‘.join([str(x) for x in np.nditer(labels[index])])

output_file.write(‘features {} | labels {} \n’.format(feature_values, label_values))Alimentando os dados

Depois de criar MinibatchSource,exemplo, precisamos treiná-lo. Podemos usar a mesma lógica de treinamento usada quando trabalhamos com pequenos conjuntos de dados na memória. Aqui, vamos usarMinibatchSource instância como a entrada para o método de trem na função de perda da seguinte forma -

Exemplo de Implementação

Step 1 - Para registrar a saída da sessão de treinamento, primeiro importe o ProgressPrinter de cntk.logging módulo da seguinte forma -

from cntk.logging import ProgressPrinterStep 2 - Em seguida, para configurar a sessão de treinamento, importe o trainer e training_session de cntk.train módulo da seguinte forma -

from cntk.train import Trainer,Step 3 - Agora, precisamos definir algum conjunto de constantes como minibatch_size, samples_per_epoch e num_epochs como segue -

minbatch_size = 16

samples_per_epoch = 150

num_epochs = 30Step 4 - Em seguida, para saber o CNTK como ler dados durante o treinamento, precisamos definir um mapeamento entre a variável de entrada para a rede e os fluxos na fonte do minibatch.

input_map = {

features: minibatch.source.streams.features,

labels: minibatch.source.streams.features

}Step 5 - Em seguida, para registrar a saída do processo de treinamento, inicialize o progress_printer variável com um novo ProgressPrinter instância da seguinte forma -

progress_writer = ProgressPrinter(0)Step 6 - Por fim, precisamos invocar o método train na perda da seguinte forma -

train_history = loss.train(minibatch_source,

parameter_learners=[learner],

model_inputs_to_streams=input_map,

callbacks=[progress_writer],

epoch_size=samples_per_epoch,

max_epochs=num_epochs)Alimentando os dados - Exemplo de implementação completo

from cntk.logging import ProgressPrinter

from cntk.train import Trainer, training_session

minbatch_size = 16

samples_per_epoch = 150

num_epochs = 30

input_map = {

features: minibatch.source.streams.features,

labels: minibatch.source.streams.features

}

progress_writer = ProgressPrinter(0)

train_history = loss.train(minibatch_source,

parameter_learners=[learner],

model_inputs_to_streams=input_map,

callbacks=[progress_writer],

epoch_size=samples_per_epoch,

max_epochs=num_epochs)Resultado

-------------------------------------------------------------------

average since average since examples

loss last metric last

------------------------------------------------------

Learning rate per minibatch: 0.1

1.21 1.21 0 0 32

1.15 0.12 0 0 96

[………]CNTK - Medindo Desempenho

Este capítulo irá explicar como medir o desempenho do modelo no CNKT.

Estratégia para validar o desempenho do modelo

Depois de construir um modelo de ML, costumávamos treiná-lo usando um conjunto de amostras de dados. Por causa desse treinamento, nosso modelo de ML aprende e deriva algumas regras gerais. O desempenho do modelo de ML é importante quando fornecemos ao modelo novas amostras, ou seja, amostras diferentes das fornecidas no momento do treinamento. O modelo se comporta de maneira diferente nesse caso. Pode ser pior fazer uma boa previsão sobre essas novas amostras.

Mas o modelo também deve funcionar bem para novas amostras, porque no ambiente de produção obteremos uma entrada diferente daquela usada para os dados de amostra para fins de treinamento. É por isso que devemos validar o modelo de ML usando um conjunto de amostras diferente das amostras que usamos para fins de treinamento. Aqui, vamos discutir duas técnicas diferentes para criar um conjunto de dados para validar um NN.

Conjunto de dados de retenção

É um dos métodos mais fáceis de criar um conjunto de dados para validar um NN. Como o nome indica, neste método iremos reter um conjunto de amostras do treinamento (digamos, 20%) e usá-lo para testar o desempenho do nosso modelo de ML. O diagrama a seguir mostra a proporção entre as amostras de treinamento e validação -

O modelo de conjunto de dados de sustentação garante que tenhamos dados suficientes para treinar nosso modelo de ML e, ao mesmo tempo, teremos um número razoável de amostras para obter uma boa medição do desempenho do modelo.

Para incluir no conjunto de treinamento e no conjunto de teste, é uma boa prática escolher amostras aleatórias do conjunto de dados principal. Ele garante uma distribuição uniforme entre o conjunto de treinamento e teste.

A seguir está um exemplo em que estamos produzindo nosso próprio conjunto de dados de validação usando train_test_split função do scikit-learn biblioteca.

Exemplo

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=1)

# Here above test_size = 0.2 represents that we provided 20% of the data as test data.

from sklearn.neighbors import KNeighborsClassifier

from sklearn import metrics

classifier_knn = KNeighborsClassifier(n_neighbors=3)

classifier_knn.fit(X_train, y_train)

y_pred = classifier_knn.predict(X_test)

# Providing sample data and the model will make prediction out of that data

sample = [[5, 5, 3, 2], [2, 4, 3, 5]]

preds = classifier_knn.predict(sample)

pred_species = [iris.target_names[p] for p in preds] print("Predictions:", pred_species)Resultado

Predictions: ['versicolor', 'virginica']Ao usar CNTK, precisamos randomizar a ordem de nosso conjunto de dados cada vez que treinamos nosso modelo porque -

Algoritmos de aprendizado profundo são altamente influenciados pelos geradores de números aleatórios.

A ordem em que fornecemos as amostras ao NN durante o treinamento afeta muito seu desempenho.

A principal desvantagem de usar a técnica de conjunto de dados de validação é que ela não é confiável porque às vezes obtemos resultados muito bons, mas às vezes, obtemos resultados ruins.

Validação cruzada K-fold

Para tornar nosso modelo de ML mais confiável, existe uma técnica chamada validação cruzada K-fold. Na natureza, a técnica de validação cruzada K-fold é a mesma que a técnica anterior, mas a repete várias vezes - geralmente cerca de 5 a 10 vezes. O diagrama a seguir representa seu conceito -

Trabalho de validação cruzada K-fold

O funcionamento da validação cruzada K-fold pode ser compreendido com a ajuda das seguintes etapas -

Step 1- Como na técnica de conjunto de dados Hand-out, na técnica de validação cruzada K-fold, primeiro precisamos dividir o conjunto de dados em um conjunto de treinamento e teste. Idealmente, a proporção é de 80-20, ou seja, 80% do conjunto de treinamento e 20% do conjunto de teste.

Step 2 - Em seguida, precisamos treinar nosso modelo usando o conjunto de treinamento.

Step 3- Por último, usaremos o conjunto de testes para medir o desempenho do nosso modelo. A única diferença entre a técnica de conjunto de dados Hold-out e a técnica de validação k-cross é que o processo acima é repetido geralmente de 5 a 10 vezes e, no final, a média é calculada sobre todas as métricas de desempenho. Essa média seria a métrica de desempenho final.

Vejamos um exemplo com um pequeno conjunto de dados -

Exemplo

from numpy import array

from sklearn.model_selection import KFold

data = array([0.1, 0.2, 0.3, 0.4, 0.5, 0.6, 0.7, 0.8, 0.9, 1.0])

kfold = KFold(5, True, 1)

for train, test in kfold.split(data):

print('train: %s, test: %s' % (data[train],(data[test]))Resultado

train: [0.1 0.2 0.4 0.5 0.6 0.7 0.8 0.9], test: [0.3 1. ]

train: [0.1 0.2 0.3 0.4 0.6 0.8 0.9 1. ], test: [0.5 0.7]

train: [0.2 0.3 0.5 0.6 0.7 0.8 0.9 1. ], test: [0.1 0.4]

train: [0.1 0.3 0.4 0.5 0.6 0.7 0.9 1. ], test: [0.2 0.8]

train: [0.1 0.2 0.3 0.4 0.5 0.7 0.8 1. ], test: [0.6 0.9]Como vemos, por usar um cenário de treinamento e teste mais realista, a técnica de validação cruzada k-fold nos dá uma medição de desempenho muito mais estável, mas, por outro lado, leva muito tempo para validar modelos de aprendizado profundo.

CNTK não oferece suporte para validação k-cross, portanto, precisamos escrever nosso próprio script para fazer isso.

Detectando underfitting e overfitting

Quer usemos o conjunto de dados Hand-out ou a técnica de validação cruzada k-fold, descobriremos que a saída para as métricas será diferente para o conjunto de dados usado para treinamento e o conjunto de dados usado para validação.

Detectando overfitting

O fenômeno chamado overfitting é uma situação em que nosso modelo de ML modela os dados de treinamento excepcionalmente bem, mas falha em ter um bom desempenho nos dados de teste, ou seja, não foi capaz de prever os dados de teste.

Acontece quando um modelo de ML aprende um padrão específico e ruído dos dados de treinamento a tal ponto que afeta negativamente a capacidade do modelo de generalizar a partir dos dados de treinamento para novos, ou seja, dados não vistos. Aqui, o ruído é a informação irrelevante ou aleatoriedade em um conjunto de dados.

A seguir estão as duas maneiras com a ajuda das quais podemos detectar se nosso modelo está ajustado demais ou não -

O modelo overfit terá um bom desempenho nas mesmas amostras que usamos para o treinamento, mas terá um desempenho muito ruim nas novas amostras, ou seja, amostras diferentes do treinamento.

O modelo é ajustado em excesso durante a validação se a métrica no conjunto de teste for inferior à mesma métrica que usamos em nosso conjunto de treinamento.

Detectando underfitting

Outra situação que pode surgir em nosso ML é underfitting. Esta é uma situação em que nosso modelo de ML não modelou bem os dados de treinamento e não consegue prever resultados úteis. Quando começamos a treinar na primeira época, nosso modelo será insuficiente, mas se tornará menos inadequado com o progresso do treinamento.

Uma das maneiras de detectar se nosso modelo é insuficiente ou não é examinar as métricas do conjunto de treinamento e do conjunto de teste. Nosso modelo será insuficiente se a métrica do conjunto de teste for maior do que a métrica do conjunto de treinamento.

CNTK - Classificação da Rede Neural