Веб-парсинг Python - Введение

Веб-скрапинг - это автоматический процесс извлечения информации из Интернета. В этой главе вы получите подробное представление о парсинге веб-страниц, его сравнении с обходом веб-страниц и о том, почему вам следует выбрать парсинг веб-страниц. Вы также узнаете о компонентах и работе парсера.

Что такое веб-парсинг?

Словарное значение слова «Утилизация» подразумевает получение чего-либо из Интернета. Здесь возникают два вопроса: что мы можем получить из Интернета и как это получить.

Ответ на первый вопрос: ‘data’. Данные необходимы любому программисту, и основным требованием каждого программного проекта является большой объем полезных данных.

Ответ на второй вопрос немного сложен, потому что есть много способов получить данные. Как правило, мы можем получать данные из базы данных или файла данных и из других источников. Но что, если нам нужен большой объем данных, доступных в Интернете? Один из способов получить такие данные - это вручную выполнить поиск (щелкнув мышью в веб-браузере) и сохранить (скопировать и вставить в электронную таблицу или файл) необходимые данные. Этот метод довольно утомителен и требует много времени. Другой способ получить такие данные - использоватьweb scraping.

Web scraping, также называется web data mining или же web harvesting, представляет собой процесс создания агента, который может автоматически извлекать, анализировать, загружать и систематизировать полезную информацию из Интернета. Другими словами, мы можем сказать, что вместо того, чтобы вручную сохранять данные с веб-сайтов, программное обеспечение для очистки веб-страниц автоматически загружает и извлекает данные с нескольких веб-сайтов в соответствии с нашими требованиями.

Происхождение веб-скрапинга

Происхождение веб-скрейпинга - это удаление экрана, которое использовалось для интеграции не веб-приложений или собственных приложений Windows. Первоначально очистка экрана использовалась до широкого использования Всемирной паутины (WWW), но она не могла масштабироваться в расширенном масштабе. Это потребовало автоматизации подхода соскабливания экрана и техники, называемой‘Web Scraping’ возникла.

Веб-сканирование против веб-скрапинга

Термины «Веб-сканирование» и «Скрейпинг» часто используются как синонимы, поскольку их основная концепция заключается в извлечении данных. Однако они отличаются друг от друга. Мы можем понять основное отличие из их определений.

Веб-сканирование в основном используется для индексации информации на странице с помощью ботов, известных как сканеры. Его еще называютindexing. С другой стороны, веб-парсинг - это автоматический способ извлечения информации с помощью ботов, известных как парсеры. Его еще называютdata extraction.

Чтобы понять разницу между этими двумя терминами, давайте посмотрим на сравнительную таблицу, приведенную ниже -

| Веб-сканирование | Веб-парсинг |

|---|---|

| Относится к загрузке и хранению содержимого большого количества веб-сайтов. | Относится к извлечению отдельных элементов данных с веб-сайта с использованием специфичной для сайта структуры. |

| В основном делается в больших масштабах. | Может быть реализован в любом масштабе. |

| Предоставляет общую информацию. | Предоставляет конкретную информацию. |

| Используется основными поисковыми системами, такими как Google, Bing, Yahoo. Googlebot является примером поискового робота. | Информация, извлеченная с помощью веб-скрейпинга, может быть использована для воспроизведения на каком-либо другом веб-сайте или может использоваться для выполнения анализа данных. Например, элементами данных могут быть имена, адрес, цена и т. Д. |

Использование веб-скрапинга

Использование и причины использования веб-скрапинга безграничны, как и использование Всемирной паутины. Веб-скребки могут делать что угодно, например заказывать еду в Интернете, сканировать веб-сайт онлайн-покупок для вас, покупать билеты на матч, как только они становятся доступны, и т. Д. Точно так же, как это может сделать человек. Здесь обсуждаются некоторые из важных применений парсинга веб-страниц -

E-commerce Websites - Веб-скреперы могут собирать данные, специально относящиеся к цене определенного продукта, с различных веб-сайтов электронной коммерции для их сравнения.

Content Aggregators - Веб-скрапинг широко используется агрегаторами контента, такими как агрегаторы новостей и агрегаторы вакансий, для предоставления обновленных данных своим пользователям.

Marketing and Sales Campaigns - Веб-парсеры могут использоваться для получения данных, таких как электронные письма, номер телефона и т. Д., Для продаж и маркетинговых кампаний.

Search Engine Optimization (SEO) - Веб-скрапинг широко используется инструментами SEO, такими как SEMRush, Majestic и т. Д., Чтобы сообщить бизнесу, как они ранжируются по ключевым словам поиска, которые для них важны.

Data for Machine Learning Projects - Получение данных для проектов машинного обучения зависит от парсинга веб-страниц.

Data for Research - Исследователи могут собирать полезные данные для исследовательской работы, экономя свое время с помощью этого автоматизированного процесса.

Компоненты веб-парсера

Веб-парсер состоит из следующих компонентов -

Модуль веб-сканера

Очень необходимый компонент веб-парсера, модуль веб-сканера, используется для навигации по целевому веб-сайту, выполняя HTTP или HTTPS-запросы к URL-адресам. Сканер загружает неструктурированные данные (содержимое HTML) и передает их экстрактору, следующему модулю.

Экстрактор

Экстрактор обрабатывает полученный HTML-контент и извлекает данные в полуструктурированный формат. Он также называется модулем синтаксического анализатора и для его работы использует различные методы синтаксического анализа, такие как регулярное выражение, анализ HTML, анализ DOM или искусственный интеллект.

Модуль преобразования и очистки данных

Извлеченные выше данные не подходят для использования в готовом виде. Он должен пройти через какой-то модуль очистки, чтобы мы могли его использовать. Для этой цели можно использовать такие методы, как манипуляции со строками или регулярные выражения. Обратите внимание, что извлечение и преобразование также можно выполнить за один шаг.

Модуль хранения

После извлечения данных нам нужно сохранить их в соответствии с нашим требованием. Модуль хранения будет выводить данные в стандартном формате, который может быть сохранен в базе данных или в формате JSON или CSV.

Работа веб-парсера

Веб-парсер можно определить как программное обеспечение или сценарий, используемый для загрузки содержимого нескольких веб-страниц и извлечения из него данных.

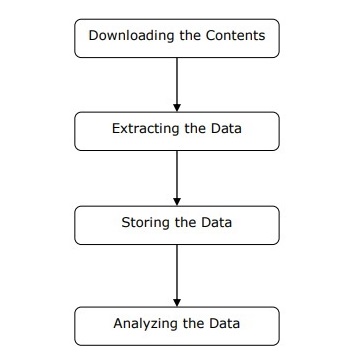

Мы можем понять работу веб-скребка, выполнив простые шаги, как показано на схеме, приведенной выше.

Шаг 1. Загрузка содержимого с веб-страниц

На этом этапе веб-парсер загружает запрошенное содержимое с нескольких веб-страниц.

Шаг 2: извлечение данных

Данные на веб-сайтах представлены в формате HTML и в основном неструктурированы. Следовательно, на этом этапе веб-парсер проанализирует и извлечет структурированные данные из загруженного содержимого.

Шаг 3: Хранение данных

Здесь веб-парсер будет хранить и сохранять извлеченные данные в любом формате, таком как CSV, JSON или в базе данных.

Шаг 4: Анализ данных

После успешного выполнения всех этих шагов веб-скребок проанализирует полученные таким образом данные.