Scikit Learn - Краткое руководство

В этой главе мы поймем, что такое Scikit-Learn или Sklearn, происхождение Scikit-Learn и некоторые другие связанные темы, такие как сообщества и участники, ответственные за разработку и обслуживание Scikit-Learn, его предварительные условия, установку и его функции.

Что такое Scikit-Learn (Sklearn)

Scikit-learn (Sklearn) - самая полезная и надежная библиотека для машинного обучения на Python. Он предоставляет набор эффективных инструментов для машинного обучения и статистического моделирования, включая классификацию, регрессию, кластеризацию и уменьшение размерности через интерфейс согласованности в Python. Эта библиотека, которая в основном написана на Python, построена наNumPy, SciPy и Matplotlib.

Происхождение Scikit-Learn

Первоначально он назывался scikits.learn и первоначально был разработан Дэвидом Курнапо как проект Google Summer of Code в 2007 году. Позже, в 2010 году, Фабиан Педрегоса, Гаэль Вароко, Александр Грамфор и Винсент Мишель из FIRCA (Французский институт исследований в области компьютерных наук и автоматизации) приняли этот проект находится на другом уровне и сделал первый публичный релиз (v0.1 beta) 1 февраля 2010 года.

Давайте посмотрим на его историю версий -

Май 2019: scikit-learn 0.21.0

Март 2019: scikit-learn 0.20.3

Декабрь 2018: scikit-learn 0.20.2

Ноябрь 2018: scikit-learn 0.20.1

Сентябрь 2018: scikit-learn 0.20.0

Июль 2018: scikit-learn 0.19.2

Июль 2017: scikit-learn 0.19.0

Сентябрь 2016 г. scikit-learn 0.18.0

Ноябрь 2015 г. scikit-learn 0.17.0

Март 2015 г. scikit-learn 0.16.0

Июль 2014 г. scikit-learn 0.15.0

Август 2013. scikit-learn 0.14.

Сообщество и участники

Scikit-learn - это работа сообщества, и каждый может внести в нее свой вклад. Этот проект размещен наhttps://github.com/scikit-learn/scikit-learn. Следующие люди в настоящее время являются основными участниками разработки и поддержки Sklearn:

Йорис Ван ден Босше (специалист по данным)

Томас Джей Фан (разработчик программного обеспечения)

Александр Грамфор (исследователь машинного обучения)

Оливье Гризель (эксперт по машинному обучению)

Николас Хуг (младший научный сотрудник)

Андреас Мюллер (специалист по машинному обучению)

Ханьминь Цинь (инженер-программист)

Адрин Джалали (разработчик открытого исходного кода)

Нелле Варокуо (научный сотрудник)

Роман Юрчак (Data Scientist)

Различные организации, такие как Booking.com, JP Morgan, Evernote, Inria, AWeber, Spotify и многие другие, используют Sklearn.

Предпосылки

Прежде чем мы начнем использовать последнюю версию scikit-learn, нам потребуется следующее:

Python (> = 3,5)

NumPy (> = 1.11.0)

Scipy (> = 0,17,0) li

Джоблиб (> = 0,11)

Matplotlib (> = 1.5.1) требуется для возможностей построения графиков Sklearn.

Pandas (> = 0.18.0) требуется для некоторых примеров scikit-learn с использованием структуры данных и анализа.

Установка

Если вы уже установили NumPy и Scipy, ниже приведены два самых простых способа установить scikit-learn:

Использование pip

Следующую команду можно использовать для установки scikit-learn через pip -

pip install -U scikit-learnИспользование conda

Следующую команду можно использовать для установки scikit-learn через conda -

conda install scikit-learnС другой стороны, если NumPy и Scipy еще не установлены на вашей рабочей станции Python, вы можете установить их, используя либо pip или же conda.

Еще один вариант использования scikit-learn - использовать такие дистрибутивы Python, как Canopy и Anaconda потому что они оба поставляют последнюю версию scikit-learn.

Особенности

Вместо того, чтобы сосредоточиться на загрузке, манипулировании и суммировании данных, библиотека Scikit-learn сосредоточена на моделировании данных. Некоторые из самых популярных групп моделей, предоставляемых Sklearn, следующие:

Supervised Learning algorithms - Почти все популярные алгоритмы контролируемого обучения, такие как линейная регрессия, машина опорных векторов (SVM), дерево решений и т. Д., Являются частью scikit-learn.

Unsupervised Learning algorithms - С другой стороны, в нем также есть все популярные алгоритмы неконтролируемого обучения, от кластеризации, факторного анализа, PCA (анализа главных компонентов) до неконтролируемых нейронных сетей.

Clustering - Эта модель используется для группировки немаркированных данных.

Cross Validation - Используется для проверки точности контролируемых моделей на невидимых данных.

Dimensionality Reduction - Он используется для уменьшения количества атрибутов в данных, которые в дальнейшем можно использовать для обобщения, визуализации и выбора функций.

Ensemble methods - Как следует из названия, он используется для объединения прогнозов нескольких контролируемых моделей.

Feature extraction - Он используется для извлечения функций из данных для определения атрибутов в данных изображения и текста.

Feature selection - Он используется для определения полезных атрибутов для создания контролируемых моделей.

Open Source - Это библиотека с открытым исходным кодом, которую также можно использовать в коммерческих целях по лицензии BSD.

В этой главе рассматривается процесс моделирования в Sklearn. Давайте разберемся примерно с тем же подробнее и начнем с загрузки набора данных.

Загрузка набора данных

Набор данных называется набором данных. Он имеет следующие два компонента -

Features- Переменные данных называются его характеристиками. Они также известны как предикторы, входные данные или атрибуты.

Feature matrix - Это набор функций, если их несколько.

Feature Names - Это список всех названий функций.

Response- Это выходная переменная, которая в основном зависит от переменных функции. Они также известны как цель, метка или выход.

Response Vector- Используется для представления столбца ответа. Обычно у нас есть только один столбец ответов.

Target Names - Это возможные значения, принимаемые вектором ответа.

В Scikit-learn есть несколько примеров наборов данных, например iris и digits для классификации и Boston house prices для регресса.

пример

Ниже приведен пример загрузки iris набор данных -

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

feature_names = iris.feature_names

target_names = iris.target_names

print("Feature names:", feature_names)

print("Target names:", target_names)

print("\nFirst 10 rows of X:\n", X[:10])Вывод

Feature names: ['sepal length (cm)', 'sepal width (cm)', 'petal length (cm)', 'petal width (cm)']

Target names: ['setosa' 'versicolor' 'virginica']

First 10 rows of X:

[

[5.1 3.5 1.4 0.2]

[4.9 3. 1.4 0.2]

[4.7 3.2 1.3 0.2]

[4.6 3.1 1.5 0.2]

[5. 3.6 1.4 0.2]

[5.4 3.9 1.7 0.4]

[4.6 3.4 1.4 0.3]

[5. 3.4 1.5 0.2]

[4.4 2.9 1.4 0.2]

[4.9 3.1 1.5 0.1]

]Разделение набора данных

Чтобы проверить точность нашей модели, мы можем разделить набор данных на две части:a training set и a testing set. Используйте обучающий набор для обучения модели и тестовый набор для тестирования модели. После этого мы можем оценить, насколько хорошо работает наша модель.

пример

В следующем примере данные будут разделены на соотношение 70:30, т.е. 70% данных будут использоваться в качестве данных обучения, а 30% - в качестве данных тестирования. Набор данных - это набор данных радужной оболочки глаза, как в примере выше.

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size = 0.3, random_state = 1

)

print(X_train.shape)

print(X_test.shape)

print(y_train.shape)

print(y_test.shape)Вывод

(105, 4)

(45, 4)

(105,)

(45,)Как видно из приведенного выше примера, он использует train_test_split()функция scikit-learn для разделения набора данных. Эта функция имеет следующие аргументы -

X, y - Здесь, X это feature matrix а y - это response vector, которые нужно разделить.

test_size- Представляет собой отношение тестовых данных к общему количеству данных. Как и в приведенном выше примере, мы устанавливаемtest_data = 0.3 для 150 строк X. Это даст тестовые данные размером 150 * 0,3 = 45 строк.

random_size- Используется для гарантии того, что раскол всегда будет одинаковым. Это полезно в ситуациях, когда вы хотите получить воспроизводимые результаты.

Обучите модель

Затем мы можем использовать наш набор данных для обучения некоторой модели прогнозирования. Как уже говорилось, scikit-learn имеет широкий диапазонMachine Learning (ML) algorithms которые имеют согласованный интерфейс для настройки, прогнозирования точности, отзыва и т. д.

пример

В приведенном ниже примере мы собираемся использовать классификатор KNN (K ближайших соседей). Не вдавайтесь в подробности алгоритмов KNN, для этого будет отдельная глава. Этот пример используется только для понимания части реализации.

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size = 0.4, random_state=1

)

from sklearn.neighbors import KNeighborsClassifier

from sklearn import metrics

classifier_knn = KNeighborsClassifier(n_neighbors = 3)

classifier_knn.fit(X_train, y_train)

y_pred = classifier_knn.predict(X_test)

# Finding accuracy by comparing actual response values(y_test)with predicted response value(y_pred)

print("Accuracy:", metrics.accuracy_score(y_test, y_pred))

# Providing sample data and the model will make prediction out of that data

sample = [[5, 5, 3, 2], [2, 4, 3, 5]]

preds = classifier_knn.predict(sample)

pred_species = [iris.target_names[p] for p in preds] print("Predictions:", pred_species)Вывод

Accuracy: 0.9833333333333333

Predictions: ['versicolor', 'virginica']Сохранение модели

После обучения модели желательно, чтобы она сохранялась для будущего использования, чтобы нам не приходилось повторно обучать ее снова и снова. Это можно сделать с помощьюdump и load особенности joblib пакет.

Рассмотрим приведенный ниже пример, в котором мы будем сохранять обученную выше модель (classifier_knn) для будущего использования -

from sklearn.externals import joblib

joblib.dump(classifier_knn, 'iris_classifier_knn.joblib')Приведенный выше код сохранит модель в файле iris_classifier_knn.joblib. Теперь объект можно перезагрузить из файла с помощью следующего кода -

joblib.load('iris_classifier_knn.joblib')Предварительная обработка данных

Поскольку мы имеем дело с большим количеством данных, и эти данные находятся в необработанном виде, перед вводом этих данных в алгоритмы машинного обучения нам необходимо преобразовать их в значимые данные. Этот процесс называется предварительной обработкой данных. Scikit-learn имеет пакет с именемpreprocessingдля этого. Вpreprocessing пакет имеет следующие методы -

Бинаризация

Этот метод предварительной обработки используется, когда нам нужно преобразовать наши числовые значения в логические значения.

пример

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]]

)

data_binarized = preprocessing.Binarizer(threshold=0.5).transform(input_data)

print("\nBinarized data:\n", data_binarized)В приведенном выше примере мы использовали threshold value = 0,5, и поэтому все значения выше 0,5 будут преобразованы в 1, а все значения ниже 0,5 будут преобразованы в 0.

Вывод

Binarized data:

[

[ 1. 0. 1.]

[ 0. 1. 1.]

[ 0. 0. 1.]

[ 1. 1. 0.]

]Среднее удаление

Этот метод используется для исключения среднего значения из вектора признаков, чтобы центр каждого объекта был нулевым.

пример

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]]

)

#displaying the mean and the standard deviation of the input data

print("Mean =", input_data.mean(axis=0))

print("Stddeviation = ", input_data.std(axis=0))

#Removing the mean and the standard deviation of the input data

data_scaled = preprocessing.scale(input_data)

print("Mean_removed =", data_scaled.mean(axis=0))

print("Stddeviation_removed =", data_scaled.std(axis=0))Вывод

Mean = [ 1.75 -1.275 2.2 ]

Stddeviation = [ 2.71431391 4.20022321 4.69414529]

Mean_removed = [ 1.11022302e-16 0.00000000e+00 0.00000000e+00]

Stddeviation_removed = [ 1. 1. 1.]Масштабирование

Мы используем эту технику предварительной обработки для масштабирования векторов признаков. Масштабирование векторов признаков важно, поскольку объекты не должны быть синтетически большими или маленькими.

пример

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_scaler_minmax = preprocessing.MinMaxScaler(feature_range=(0,1))

data_scaled_minmax = data_scaler_minmax.fit_transform(input_data)

print ("\nMin max scaled data:\n", data_scaled_minmax)Вывод

Min max scaled data:

[

[ 0.48648649 0.58252427 0.99122807]

[ 0. 1. 0.81578947]

[ 0.27027027 0. 1. ]

[ 1. 0.99029126 0. ]

]Нормализация

Мы используем эту технику предварительной обработки для изменения векторов признаков. Нормализация векторов признаков необходима для того, чтобы векторы признаков можно было измерить в обычном масштабе. Существует два типа нормализации:

L1 нормализация

Его также называют наименьшими абсолютными отклонениями. Он изменяет значение таким образом, что сумма абсолютных значений всегда остается до 1 в каждой строке. В следующем примере показана реализация нормализации L1 для входных данных.

пример

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_normalized_l1 = preprocessing.normalize(input_data, norm='l1')

print("\nL1 normalized data:\n", data_normalized_l1)Вывод

L1 normalized data:

[

[ 0.22105263 -0.2 0.57894737]

[-0.2027027 0.32432432 0.47297297]

[ 0.03571429 -0.56428571 0.4 ]

[ 0.42142857 0.16428571 -0.41428571]

]L2 нормализация

Также называется методом наименьших квадратов. Он изменяет значение таким образом, что сумма квадратов всегда остается до 1 в каждой строке. В следующем примере показана реализация нормализации L2 для входных данных.

пример

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_normalized_l2 = preprocessing.normalize(input_data, norm='l2')

print("\nL1 normalized data:\n", data_normalized_l2)Вывод

L2 normalized data:

[

[ 0.33946114 -0.30713151 0.88906489]

[-0.33325106 0.53320169 0.7775858 ]

[ 0.05156558 -0.81473612 0.57753446]

[ 0.68706914 0.26784051 -0.6754239 ]

]Как мы знаем, машинное обучение собирается создать модель из данных. Для этого компьютер должен сначала понять данные. Далее мы собираемся обсудить различные способы представления данных, чтобы их мог понять компьютер.

Данные в виде таблицы

Лучший способ представления данных в Scikit-learn - в виде таблиц. Таблица представляет собой двумерную сетку данных, где строки представляют отдельные элементы набора данных, а столбцы представляют количества, связанные с этими отдельными элементами.

пример

В примере, приведенном ниже, мы можем скачать iris dataset в виде Pandas DataFrame с помощью python seaborn библиотека.

import seaborn as sns

iris = sns.load_dataset('iris')

iris.head()Вывод

sepal_length sepal_width petal_length petal_width species

0 5.1 3.5 1.4 0.2 setosa

1 4.9 3.0 1.4 0.2 setosa

2 4.7 3.2 1.3 0.2 setosa

3 4.6 3.1 1.5 0.2 setosa

4 5.0 3.6 1.4 0.2 setosaИз вышеприведенного вывода мы видим, что каждая строка данных представляет один наблюдаемый цветок, а количество строк представляет собой общее количество цветов в наборе данных. Обычно мы называем строки матрицы образцами.

С другой стороны, каждый столбец данных представляет количественную информацию, описывающую каждый образец. Обычно мы называем столбцы матрицы функциями.

Данные как матрица признаков

Матрица характеристик может быть определена как макет таблицы, где информацию можно рассматривать как двумерную матрицу. Он хранится в переменной с именемXи предполагается, что он двумерный с формой [n_samples, n_features]. В основном он содержится в массиве NumPy или DataFrame Pandas. Как было сказано ранее, образцы всегда представляют отдельные объекты, описанные набором данных, а функции представляют собой отдельные наблюдения, которые описывают каждый образец количественным образом.

Данные как целевой массив

Наряду с матрицей функций, обозначенной X, у нас также есть целевой массив. Его еще называют этикеткой. Обозначается y. Метка или целевой массив обычно одномерны и имеют длину n_samples. Обычно он содержится в NumPyarray или панды Series. Целевой массив может иметь как значения, непрерывные числовые значения, так и дискретные значения.

Чем целевой массив отличается от столбцов функций?

Мы можем различить их по одному пункту, что целевой массив обычно является величиной, которую мы хотим предсказать на основе данных, то есть в статистическом плане это зависимая переменная.

пример

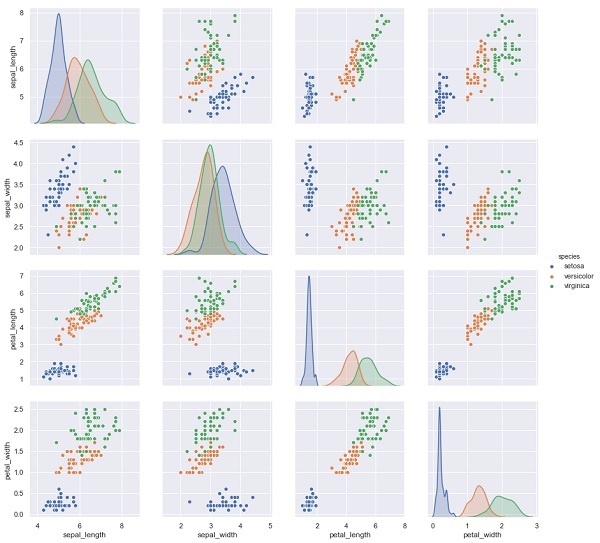

В приведенном ниже примере из набора данных ириса мы прогнозируем вид цветка на основе других измерений. В этом случае столбец "Виды" будет рассматриваться как объект.

import seaborn as sns

iris = sns.load_dataset('iris')

%matplotlib inline

import seaborn as sns; sns.set()

sns.pairplot(iris, hue='species', height=3);Вывод

X_iris = iris.drop('species', axis=1)

X_iris.shape

y_iris = iris['species']

y_iris.shapeВывод

(150,4)

(150,)В этой главе мы узнаем о Estimator API(интерфейс прикладного программирования). Давайте начнем с понимания, что такое API-интерфейс оценщика.

Что такое API-интерфейс оценщика

Это один из основных API, реализованных Scikit-learn. Он обеспечивает согласованный интерфейс для широкого спектра приложений машинного обучения, поэтому все алгоритмы машинного обучения в Scikit-Learn реализованы через API-интерфейс Estimator. Объект, который учится на данных (соответствует данным), является оценщиком. Его можно использовать с любым из алгоритмов, таких как классификация, регрессия, кластеризация, или даже с преобразователем, который извлекает полезные функции из необработанных данных.

Для подгонки данных все объекты оценщика предоставляют метод подбора, который принимает набор данных, показанный ниже:

estimator.fit(data)Затем все параметры оценщика могут быть установлены следующим образом, когда он создается соответствующим атрибутом.

estimator = Estimator (param1=1, param2=2)

estimator.param1Результатом выше будет 1.

После того, как данные подобраны с помощью оценщика, параметры оцениваются на основе имеющихся данных. Теперь все предполагаемые параметры будут атрибутами объекта оценки, оканчивающимися подчеркиванием следующим образом:

estimator.estimated_param_Использование API-интерфейса оценщика

Основные виды использования оценщиков следующие:

Оценка и расшифровка модели

Объект оценщика используется для оценки и декодирования модели. Кроме того, модель оценивается как детерминированная функция следующего:

Параметры, предусмотренные при строительстве объекта.

Глобальное случайное состояние (numpy.random), если для параметра random_state оценщика установлено значение none.

Любые данные, переданные последнему вызову fit, fit_transform, or fit_predict.

Любые данные, передаваемые в последовательности обращений к partial_fit.

Отображение непрямоугольного представления данных в прямоугольные данные

Он отображает непрямоугольное представление данных в прямоугольные данные. Проще говоря, он принимает входные данные, где каждый образец не представлен как объект, подобный массиву, фиксированной длины, и создает подобный массиву объект функций для каждого образца.

Различие между керном и удаленными образцами

Он моделирует различие между керном и удаленными образцами, используя следующие методы:

fit

fit_predict, если трансдуктивный

предсказать, если индуктивный

Руководящие принципы

При разработке Scikit-Learn API необходимо учитывать следующие руководящие принципы:

Последовательность

Этот принцип гласит, что все объекты должны иметь общий интерфейс, созданный из ограниченного набора методов. Документация также должна быть согласованной.

Ограниченная иерархия объектов

Этот руководящий принцип гласит:

Алгоритмы должны быть представлены классами Python

Наборы данных должны быть представлены в стандартном формате, таком как массивы NumPy, Pandas DataFrames, разреженная матрица SciPy.

Имена параметров должны использовать стандартные строки Python.

Сочинение

Как мы знаем, алгоритмы машинного обучения можно выразить как последовательность многих фундаментальных алгоритмов. Scikit-learn использует эти фундаментальные алгоритмы всякий раз, когда это необходимо.

Разумные настройки по умолчанию

В соответствии с этим принципом библиотека Scikit-learn определяет соответствующее значение по умолчанию, когда модели машинного обучения требуют параметров, задаваемых пользователем.

Осмотр

В соответствии с этим руководящим принципом каждое указанное значение параметра отображается как публичные атрибуты.

Шаги по использованию API-интерфейса оценщика

Ниже приведены шаги по использованию API оценки Scikit-Learn.

Шаг 1. Выберите класс модели

На этом первом этапе нам нужно выбрать класс модели. Это можно сделать, импортировав соответствующий класс оценщика из Scikit-learn.

Шаг 2: Выберите гиперпараметры модели

На этом этапе нам нужно выбрать гиперпараметры модели класса. Это можно сделать, создав экземпляр класса с желаемыми значениями.

Шаг 3. Упорядочение данных

Затем нам нужно организовать данные в матрицу функций (X) и целевой вектор (y).

Шаг 4: Примерка модели

Теперь нам нужно подогнать модель к вашим данным. Это можно сделать, вызвав метод fit () экземпляра модели.

Шаг 5: Применение модели

После подбора модели мы можем применить ее к новым данным. Для обучения с учителем используйтеpredict()метод прогнозирования меток для неизвестных данных. В то время как для обучения без учителя используйтеpredict() или же transform() для вывода свойств данных.

Пример контролируемого обучения

Здесь, в качестве примера этого процесса, мы используем общий случай подгонки строки к данным (x, y), т.е. simple linear regression.

Во-первых, нам нужно загрузить набор данных, мы используем набор данных iris -

пример

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shapeВывод

(150, 4)пример

y_iris = iris['species']

y_iris.shapeВывод

(150,)пример

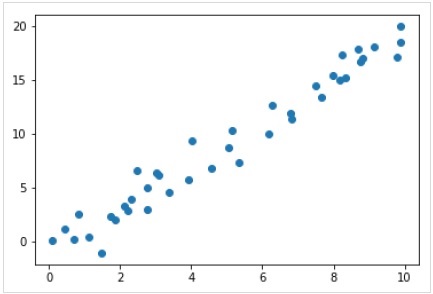

Теперь для этого примера регрессии мы собираемся использовать следующие образцы данных -

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);Вывод

Итак, у нас есть приведенные выше данные для нашего примера линейной регрессии.

Теперь, имея эти данные, мы можем применить вышеупомянутые шаги.

Выберите класс модели

Здесь, чтобы вычислить простую модель линейной регрессии, нам нужно импортировать класс линейной регрессии следующим образом:

from sklearn.linear_model import LinearRegressionВыберите гиперпараметры модели

После того, как мы выбрали класс модели, нам нужно сделать некоторые важные выборы, которые часто представлены как гиперпараметры, или параметры, которые должны быть установлены, прежде чем модель будет соответствовать данным. Здесь, для этого примера линейной регрессии, мы хотели бы подогнать точку пересечения с помощьюfit_intercept гиперпараметр следующим образом -

Example

model = LinearRegression(fit_intercept = True)

modelOutput

LinearRegression(copy_X = True, fit_intercept = True, n_jobs = None, normalize = False)Организация данных

Теперь, когда мы знаем, что наша целевая переменная y в правильной форме, т.е. длина n_samplesмассив 1-D. Но нам нужно изменить форму матрицы функций.X сделать матрицу размера [n_samples, n_features]. Это можно сделать следующим образом -

Example

X = x[:, np.newaxis]

X.shapeOutput

(40, 1)Подгонка модели

После того, как мы упорядочим данные, пора подобрать модель, то есть применить нашу модель к данным. Это можно сделать с помощьюfit() метод следующим образом -

Example

model.fit(X, y)Output

LinearRegression(copy_X = True, fit_intercept = True, n_jobs = None,normalize = False)В Scikit-learn fit() В конце процесса есть символы подчеркивания.

В этом примере параметр ниже показывает наклон простой линейной аппроксимации данных -

Example

model.coef_Output

array([1.99839352])Параметр ниже представляет собой пересечение простого линейного соответствия данным -

Example

model.intercept_Output

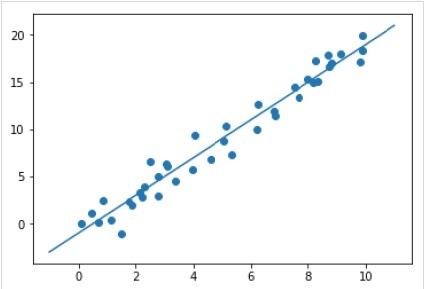

-0.9895459457775022Применение модели к новым данным

После обучения модели мы можем применить ее к новым данным. Поскольку основной задачей машинного обучения с учителем является оценка модели на основе новых данных, которые не входят в обучающий набор. Это можно сделать с помощьюpredict() метод следующим образом -

Example

xfit = np.linspace(-1, 11)

Xfit = xfit[:, np.newaxis]

yfit = model.predict(Xfit)

plt.scatter(x, y)

plt.plot(xfit, yfit);Output

Полный рабочий / исполняемый пример

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shape

y_iris = iris['species']

y_iris.shape

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);

from sklearn.linear_model import LinearRegression

model = LinearRegression(fit_intercept=True)

model

X = x[:, np.newaxis]

X.shape

model.fit(X, y)

model.coef_

model.intercept_

xfit = np.linspace(-1, 11)

Xfit = xfit[:, np.newaxis]

yfit = model.predict(Xfit)

plt.scatter(x, y)

plt.plot(xfit, yfit);Пример неконтролируемого обучения

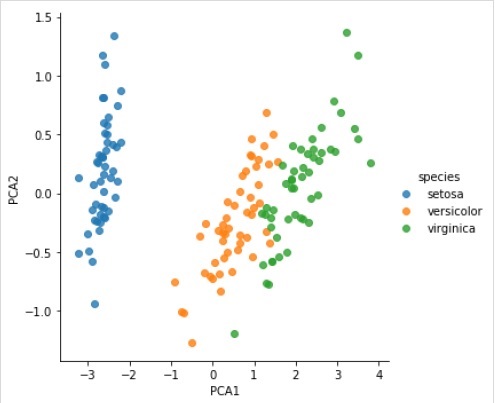

Здесь, в качестве примера этого процесса, мы берем общий случай уменьшения размерности набора данных Iris, чтобы его было легче визуализировать. В этом примере мы собираемся использовать анализ главных компонентов (PCA), метод быстрого линейного уменьшения размерности.

Как и в приведенном выше примере, мы можем загрузить и построить случайные данные из набора данных iris. После этого мы можем выполнить следующие шаги:

Выберите класс модели

from sklearn.decomposition import PCAВыберите гиперпараметры модели

Example

model = PCA(n_components=2)

modelOutput

PCA(copy = True, iterated_power = 'auto', n_components = 2, random_state = None,

svd_solver = 'auto', tol = 0.0, whiten = False)Подгонка модели

Example

model.fit(X_iris)Output

PCA(copy = True, iterated_power = 'auto', n_components = 2, random_state = None,

svd_solver = 'auto', tol = 0.0, whiten = False)Преобразуйте данные в двумерные

Example

X_2D = model.transform(X_iris)Теперь мы можем построить результат следующим образом -

Output

iris['PCA1'] = X_2D[:, 0]

iris['PCA2'] = X_2D[:, 1]

sns.lmplot("PCA1", "PCA2", hue = 'species', data = iris, fit_reg = False);Output

Полный рабочий / исполняемый пример

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shape

y_iris = iris['species']

y_iris.shape

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);

from sklearn.decomposition import PCA

model = PCA(n_components=2)

model

model.fit(X_iris)

X_2D = model.transform(X_iris)

iris['PCA1'] = X_2D[:, 0]

iris['PCA2'] = X_2D[:, 1]

sns.lmplot("PCA1", "PCA2", hue='species', data=iris, fit_reg=False);Объекты Scikit-learn используют единый базовый API, который состоит из следующих трех дополнительных интерфейсов:

Estimator interface - Это для сборки и подгонки моделей.

Predictor interface - Это для прогнозов.

Transformer interface - Это для преобразования данных.

API-интерфейсы принимают простые соглашения, а выбор дизайна направлен таким образом, чтобы избежать увеличения количества кода фреймворка.

Цель конвенций

Цель соглашений - убедиться, что API придерживается следующих общих принципов:

Consistency - Все объекты, будь то базовые или составные, должны иметь согласованный интерфейс, который в свою очередь состоит из ограниченного набора методов.

Inspection - Параметры конструктора и значения параметров, определенные алгоритмом обучения, должны храниться и отображаться как общедоступные атрибуты.

Non-proliferation of classes - Наборы данных должны быть представлены в виде массивов NumPy или разреженной матрицы Scipy, тогда как имена и значения гиперпараметров должны быть представлены как стандартные строки Python, чтобы избежать распространения кода фреймворка.

Composition - Алгоритмы, независимо от того, выражаются ли они в виде последовательностей или комбинаций преобразований данных или естественно рассматриваются как метаалгоритмы, параметризованные на других алгоритмах, должны быть реализованы и составлены из существующих строительных блоков.

Sensible defaults- В scikit-learn всякий раз, когда для операции требуется пользовательский параметр, определяется соответствующее значение по умолчанию. Это значение по умолчанию должно приводить к разумному выполнению операции, например, давая базовое решение для текущей задачи.

Различные соглашения

Соглашения, доступные в Sklearn, объясняются ниже -

Приведение типов

В нем говорится, что ввод должен быть приведен к float64. В следующем примере, в которомsklearn.random_projection модуль, используемый для уменьшения размерности данных, объяснит это -

Example

import numpy as np

from sklearn import random_projection

rannge = np.random.RandomState(0)

X = range.rand(10,2000)

X = np.array(X, dtype = 'float32')

X.dtype

Transformer_data = random_projection.GaussianRandomProjection()

X_new = transformer.fit_transform(X)

X_new.dtypeOutput

dtype('float32')

dtype('float64')В приведенном выше примере мы видим, что X - это float32 который бросается в float64 по fit_transform(X).

Установка и обновление параметров

Гиперпараметры оценщика могут быть обновлены и переустановлены после того, как он был построен с помощью set_params()метод. Давайте посмотрим на следующий пример, чтобы понять это -

Example

import numpy as np

from sklearn.datasets import load_iris

from sklearn.svm import SVC

X, y = load_iris(return_X_y = True)

clf = SVC()

clf.set_params(kernel = 'linear').fit(X, y)

clf.predict(X[:5])Output

array([0, 0, 0, 0, 0])После создания оценщика приведенный выше код изменит ядро по умолчанию. rbf линейно через SVC.set_params().

Теперь следующий код изменит ядро обратно на rbf, чтобы переустановить оценщик и сделать второй прогноз.

Example

clf.set_params(kernel = 'rbf', gamma = 'scale').fit(X, y)

clf.predict(X[:5])Output

array([0, 0, 0, 0, 0])Полный код

Ниже приводится полная исполняемая программа -

import numpy as np

from sklearn.datasets import load_iris

from sklearn.svm import SVC

X, y = load_iris(return_X_y = True)

clf = SVC()

clf.set_params(kernel = 'linear').fit(X, y)

clf.predict(X[:5])

clf.set_params(kernel = 'rbf', gamma = 'scale').fit(X, y)

clf.predict(X[:5])Примерка Multiclass и Multilabel

В случае подбора мультикласса задачи обучения и прогнозирования зависят от формата целевых данных. Используемый модульsklearn.multiclass. Посмотрите пример ниже, где мультиклассовый классификатор помещается в 1d-массив.

Example

from sklearn.svm import SVC

from sklearn.multiclass import OneVsRestClassifier

from sklearn.preprocessing import LabelBinarizer

X = [[1, 2], [3, 4], [4, 5], [5, 2], [1, 1]]

y = [0, 0, 1, 1, 2]

classif = OneVsRestClassifier(estimator = SVC(gamma = 'scale',random_state = 0))

classif.fit(X, y).predict(X)Output

array([0, 0, 1, 1, 2])В приведенном выше примере классификатор помещается в одномерный массив меток мультикласса, а predict()Таким образом, метод обеспечивает соответствующее многоклассовое предсказание. Но, с другой стороны, также возможно уместить двумерный массив бинарных индикаторов меток следующим образом:

Example

from sklearn.svm import SVC

from sklearn.multiclass import OneVsRestClassifier

from sklearn.preprocessing import LabelBinarizer

X = [[1, 2], [3, 4], [4, 5], [5, 2], [1, 1]]

y = LabelBinarizer().fit_transform(y)

classif.fit(X, y).predict(X)Output

array(

[

[0, 0, 0],

[0, 0, 0],

[0, 1, 0],

[0, 1, 0],

[0, 0, 0]

]

)Точно так же в случае установки нескольких меток экземпляру можно присвоить несколько меток следующим образом:

Example

from sklearn.preprocessing import MultiLabelBinarizer

y = [[0, 1], [0, 2], [1, 3], [0, 2, 3], [2, 4]]

y = MultiLabelBinarizer().fit_transform(y)

classif.fit(X, y).predict(X)Output

array(

[

[1, 0, 1, 0, 0],

[1, 0, 1, 0, 0],

[1, 0, 1, 1, 0],

[1, 0, 1, 1, 0],

[1, 0, 1, 0, 0]

]

)В приведенном выше примере sklearn.MultiLabelBinarizerиспользуется для преобразования в двоичную форму двумерного массива мультиэлементов для размещения на нем. Вот почему функция predic () выдает 2d-массив в качестве вывода с несколькими метками для каждого экземпляра.

Эта глава поможет вам узнать о линейном моделировании в Scikit-Learn. Давайте начнем с понимания того, что такое линейная регрессия в Sklearn.

В следующей таблице перечислены различные линейные модели, предоставляемые Scikit-Learn.

| Старший Нет | Модель и описание |

|---|---|

| 1 | Линейная регрессия Это одна из лучших статистических моделей, изучающая связь между зависимой переменной (Y) с заданным набором независимых переменных (X). |

| 2 | Логистическая регрессия Логистическая регрессия, несмотря на свое название, представляет собой алгоритм классификации, а не алгоритм регрессии. На основе заданного набора независимых переменных он используется для оценки дискретного значения (0 или 1, да / нет, истина / ложь). |

| 3 | Риджская регрессия Риджерная регрессия или регуляризация Тихонова - это метод регуляризации, который выполняет регуляризацию L2. Он изменяет функцию потерь, добавляя штраф (величина усадки), эквивалентный квадрату величины коэффициентов. |

| 4 | Регрессия Байесовского хребта Байесовская регрессия позволяет естественному механизму выжить при недостаточном количестве данных или плохо распределенных данных, формулируя линейную регрессию с использованием распределителей вероятностей, а не точечных оценок. |

| 5 | ЛАССО LASSO - это метод регуляризации, который выполняет регуляризацию L1. Он изменяет функцию потерь, добавляя штраф (количество усадки), эквивалентный суммированию абсолютных значений коэффициентов. |

| 6 | Многозадачность LASSO Это позволяет согласовывать несколько задач регрессии, одновременно обеспечивая, чтобы выбранные функции были одинаковыми для всех задач регрессии, также называемых задачами. Sklearn предоставляет линейную модель под названием MultiTaskLasso, обученную со смешанной L1, L2-нормой для регуляризации, которая совместно оценивает разреженные коэффициенты для множественных задач регрессии. |

| 7 | Эластичная сетка Elastic-Net - это метод регуляризованной регрессии, который линейно комбинирует оба штрафа, то есть L1 и L2 методов регрессии Лассо и Риджа. Это полезно, когда есть несколько коррелированных функций. |

| 8 | Многозадачная Elastic-Net Это модель Elastic-Net, которая позволяет решать несколько задач регрессии, совместно применяя выбранные функции, чтобы они были одинаковыми для всех задач регрессии, также называемых задачами. |

В этой главе основное внимание уделяется полиномиальным функциям и инструментам конвейерной обработки в Sklearn.

Введение в полиномиальные характеристики

Линейные модели, обученные нелинейным функциям данных, обычно обеспечивают высокую производительность линейных методов. Это также позволяет им обрабатывать гораздо более широкий диапазон данных. Поэтому в машинном обучении используются такие линейные модели, которые обучаются на нелинейных функциях.

Одним из таких примеров является то, что простая линейная регрессия может быть расширена путем построения полиномиальных функций из коэффициентов.

Математически предположим, что у нас есть стандартная модель линейной регрессии, тогда для двухмерных данных это будет выглядеть так:

$$Y=W_{0}+W_{1}X_{1}+W_{2}X_{2}$$Теперь мы можем объединить функции в полиномы второго порядка, и наша модель будет выглядеть следующим образом:

$$Y=W_{0}+W_{1}X_{1}+W_{2}X_{2}+W_{3}X_{1}X_{2}+W_{4}X_1^2+W_{5}X_2^2$$Вышеупомянутая модель все еще является линейной. Здесь мы увидели, что полученная полиномиальная регрессия относится к тому же классу линейных моделей и может быть решена аналогичным образом.

Для этого scikit-learn предоставляет модуль с именем PolynomialFeatures. Этот модуль преобразует матрицу входных данных в новую матрицу данных заданной степени.

Параметры

В следующей таблице представлены параметры, используемые PolynomialFeatures модуль

| Старший Нет | Параметр и описание |

|---|---|

| 1 | degree - целое число, по умолчанию = 2 Он представляет собой степень полиномиальных характеристик. |

| 2 | interaction_only - Boolean, по умолчанию = false По умолчанию это false, но если установлено как true, создаются функции, которые являются продуктами большей части различных входных функций. Такие функции называются функциями взаимодействия. |

| 3 | include_bias - Boolean, по умолчанию = true Он включает столбец смещения, т. Е. Функцию, в которой все степени полиномов равны нулю. |

| 4 | order - str in {'C', 'F'}, по умолчанию = 'C' Этот параметр представляет порядок вывода массива в плотном случае. Порядок «F» означает более быстрое вычисление, но, с другой стороны, он может замедлить последующие оценки. |

Атрибуты

Следующая таблица содержит атрибуты, используемые PolynomialFeatures модуль

| Старший Нет | Атрибуты и описание |

|---|---|

| 1 | powers_ - массив, форма (n_output_features, n_input_features) Он показывает, что powers_ [i, j] - это показатель степени j-го входа в i-м выходе. |

| 2 | n_input_features _ - int Как следует из названия, он дает общее количество входных функций. |

| 3 | n_output_features _ - int Как следует из названия, он дает общее количество полиномиальных выходных функций. |

Пример реализации

Следующий скрипт Python использует PolynomialFeatures трансформатор для преобразования массива из 8 в форму (4,2) -

from sklearn.preprocessing import PolynomialFeatures

import numpy as np

Y = np.arange(8).reshape(4, 2)

poly = PolynomialFeatures(degree=2)

poly.fit_transform(Y)Вывод

array(

[

[ 1., 0., 1., 0., 0., 1.],

[ 1., 2., 3., 4., 6., 9.],

[ 1., 4., 5., 16., 20., 25.],

[ 1., 6., 7., 36., 42., 49.]

]

)Оптимизация с помощью инструментов конвейера

Вышеупомянутый вид предварительной обработки, то есть преобразование матрицы входных данных в новую матрицу данных заданной степени, может быть оптимизирован с помощью Pipeline инструменты, которые в основном используются для объединения нескольких оценщиков в одну.

пример

Приведенные ниже сценарии python с использованием инструментов Scikit-learn Pipeline для оптимизации предварительной обработки (будут соответствовать полиномиальным данным третьего порядка).

#First, import the necessary packages.

from sklearn.preprocessing import PolynomialFeatures

from sklearn.linear_model import LinearRegression

from sklearn.pipeline import Pipeline

import numpy as np

#Next, create an object of Pipeline tool

Stream_model = Pipeline([('poly', PolynomialFeatures(degree=3)), ('linear', LinearRegression(fit_intercept=False))])

#Provide the size of array and order of polynomial data to fit the model.

x = np.arange(5)

y = 3 - 2 * x + x ** 2 - x ** 3

Stream_model = model.fit(x[:, np.newaxis], y)

#Calculate the input polynomial coefficients.

Stream_model.named_steps['linear'].coef_Вывод

array([ 3., -2., 1., -1.])Приведенные выше выходные данные показывают, что линейная модель, обученная полиномиальным признакам, способна восстановить точные входные коэффициенты полинома.

Здесь мы узнаем об алгоритме оптимизации в Sklearn, называемом стохастическим градиентным спуском (SGD).

Стохастический градиентный спуск (SGD) - это простой, но эффективный алгоритм оптимизации, используемый для поиска значений параметров / коэффициентов функций, которые минимизируют функцию стоимости. Другими словами, он используется для дискриминативного обучения линейных классификаторов при выпуклых функциях потерь, таких как SVM и логистическая регрессия. Он был успешно применен к крупномасштабным наборам данных, поскольку обновление коэффициентов выполняется для каждого обучающего экземпляра, а не в конце экземпляров.

Классификатор SGD

Классификатор стохастического градиентного спуска (SGD) в основном реализует простую процедуру обучения SGD, поддерживающую различные функции потерь и штрафы за классификацию. Scikit-learn предоставляетSGDClassifier модуль для реализации классификации SGD.

Параметры

В следующей таблице представлены параметры, используемые SGDClassifier модуль -

| Старший Нет | Параметр и описание |

|---|---|

| 1 | loss - str, по умолчанию = 'шарнир' Он представляет функцию потерь, которая будет использоваться при реализации. Значение по умолчанию - «шарнир», что даст нам линейную SVM. Другие варианты, которые можно использовать:

|

| 2 | penalty - str, 'none', 'l2', 'l1', 'elasticnet' Это термин регуляризации, используемый в модели. По умолчанию это L2. Мы можем использовать L1 или 'elasticnet; также, но оба могут сделать модель разреженной, что недостижимо с L2. |

| 3 | alpha - float, по умолчанию = 0,0001 Альфа, константа, которая умножает член регуляризации, является параметром настройки, который определяет, насколько мы хотим наказать модель. Значение по умолчанию - 0,0001. |

| 4 | l1_ratio - float, по умолчанию = 0,15 Это называется параметром смешивания ElasticNet. Его диапазон: 0 <= l1_ratio <= 1. Если l1_ratio = 1, штраф будет L1. Если l1_ratio = 0, штраф будет штрафом L2. |

| 5 | fit_intercept - Boolean, по умолчанию = True Этот параметр указывает, что к функции принятия решения должна быть добавлена константа (смещение или перехват). В расчетах не будет использоваться перехват, и данные будут считаться уже центрированными, если для него будет установлено значение false. |

| 6 | tol - float или none, необязательно, по умолчанию = 1.e-3 Этот параметр представляет собой критерий остановки для итераций. Его значение по умолчанию - False, но если установлено None, итерации остановятся, когдаloss > best_loss - tol for n_iter_no_changeсменяющие друг друга эпохи. |

| 7 | shuffle - Логическое значение, необязательно, по умолчанию = True Этот параметр указывает, хотим ли мы, чтобы наши обучающие данные перетасовывались после каждой эпохи или нет. |

| 8 | verbose - целое число, по умолчанию = 0 Он представляет уровень детализации. Его значение по умолчанию - 0. |

| 9 | epsilon - float, по умолчанию = 0,1 Этот параметр указывает ширину нечувствительной области. Если потеря = 'epsilon-нечувствительность', любая разница между текущим предсказанием и правильной меткой, меньше порогового значения, будет игнорироваться. |

| 10 | max_iter - int, необязательно, по умолчанию = 1000 Как следует из названия, он представляет максимальное количество проходов за эпохи, т.е. данные обучения. |

| 11 | warm_start - bool, необязательно, по умолчанию = false Если для этого параметра установлено значение True, мы можем повторно использовать решение предыдущего вызова, чтобы оно соответствовало инициализации. Если мы выберем default, то есть false, предыдущее решение будет удалено. |

| 12 | random_state - int, экземпляр RandomState или None, необязательно, по умолчанию = none Этот параметр представляет собой начальное число сгенерированного псевдослучайного числа, которое используется при перетасовке данных. Следующие варианты.

|

| 13 | n_jobs - int или none, необязательно, по умолчанию = None Он представляет собой количество процессоров, которые будут использоваться в вычислениях OVA (один против всех) для задач с несколькими классами. Значение по умолчанию - none, что означает 1. |

| 14 | learning_rate - строка, необязательный, по умолчанию = 'оптимальный'

|

| 15 | eta0 - двойной, по умолчанию = 0,0 Он представляет собой начальную скорость обучения для вышеупомянутых вариантов скорости обучения, то есть «постоянный», «invscalling» или «адаптивный». |

| 16 | power_t - idouble, по умолчанию = 0,5 Это показатель «ускоряющейся» скорости обучения. |

| 17 | early_stopping - bool, по умолчанию = False Этот параметр представляет использование ранней остановки для завершения обучения, когда оценка валидации не улучшается. Его значение по умолчанию - false, но если установлено значение true, оно автоматически откладывает стратифицированную часть обучающих данных как проверку и останавливает обучение, когда оценка проверки не улучшается. |

| 18 | validation_fraction - float, по умолчанию = 0,1 Он используется только тогда, когда Early_stopping истинно. Он представляет собой долю обучающих данных, которую нужно отложить в качестве набора для проверки для досрочного завершения обучающих данных. |

| 19 | n_iter_no_change - int, по умолчанию = 5 Он представляет собой количество итераций без каких-либо улучшений, если алгоритм будет запущен до ранней остановки. |

| 20 | classs_weight - dict, {class_label: weight} или «сбалансированный», или None, необязательно Этот параметр представляет веса, связанные с классами. Если не указано иное, классы должны иметь вес 1. |

| 20 | warm_start - bool, необязательно, по умолчанию = false Если для этого параметра установлено значение True, мы можем повторно использовать решение предыдущего вызова, чтобы оно соответствовало инициализации. Если мы выберем default, то есть false, предыдущее решение будет удалено. |

| 21 год | average - iBoolean или int, необязательно, по умолчанию = false Он представляет собой количество процессоров, которые будут использоваться в вычислениях OVA (один против всех) для задач с несколькими классами. Значение по умолчанию - none, что означает 1. |

Атрибуты

В следующей таблице представлены атрибуты, используемые SGDClassifier модуль -

| Старший Нет | Атрибуты и описание |

|---|---|

| 1 | coef_ - массив, форма (1, n_features), если n_classes == 2, else (n_classes, n_features) Этот атрибут обеспечивает вес, присвоенный функциям. |

| 2 | intercept_ - массив, shape (1,) if n_classes == 2, else (n_classes,) Он представляет собой независимый член в функции принятия решения. |

| 3 | n_iter_ - int Он дает количество итераций для достижения критерия остановки. |

Implementation Example

Как и другие классификаторы, стохастический градиентный спуск (SGD) должен быть оснащен следующими двумя массивами:

Массив X, содержащий обучающие образцы. Он имеет размер [n_samples, n_features].

Массив Y, содержащий целевые значения, т.е. метки классов для обучающих выборок. Его размер [n_samples].

Example

Следующий скрипт Python использует линейную модель SGDClassifier -

import numpy as np

from sklearn import linear_model

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

Y = np.array([1, 1, 2, 2])

SGDClf = linear_model.SGDClassifier(max_iter = 1000, tol=1e-3,penalty = "elasticnet")

SGDClf.fit(X, Y)Output

SGDClassifier(

alpha = 0.0001, average = False, class_weight = None,

early_stopping = False, epsilon = 0.1, eta0 = 0.0, fit_intercept = True,

l1_ratio = 0.15, learning_rate = 'optimal', loss = 'hinge', max_iter = 1000,

n_iter = None, n_iter_no_change = 5, n_jobs = None, penalty = 'elasticnet',

power_t = 0.5, random_state = None, shuffle = True, tol = 0.001,

validation_fraction = 0.1, verbose = 0, warm_start = False

)Example

Теперь, после подбора, модель может предсказывать новые значения следующим образом:

SGDClf.predict([[2.,2.]])Output

array([2])Example

В приведенном выше примере мы можем получить вектор веса с помощью следующего скрипта Python:

SGDClf.coef_Output

array([[19.54811198, 9.77200712]])Example

Точно так же мы можем получить значение перехвата с помощью следующего скрипта Python -

SGDClf.intercept_Output

array([10.])Example

Мы можем получить расстояние со знаком до гиперплоскости, используя SGDClassifier.decision_function как используется в следующем скрипте Python -

SGDClf.decision_function([[2., 2.]])Output

array([68.6402382])Регрессор SGD

Регрессор стохастического градиентного спуска (SGD) в основном реализует простую процедуру обучения SGD, поддерживающую различные функции потерь и штрафы для соответствия моделям линейной регрессии. Scikit-learn предоставляетSGDRegressor модуль для реализации регрессии SGD.

Параметры

Параметры, используемые SGDRegressorпочти такие же, как и в модуле SGDClassifier. Отличие заключается в параметре «убыток». ЗаSGDRegressor Параметр потерь модулей положительные значения следующие:

squared_loss - Относится к обычному методу наименьших квадратов.

huber: SGDRegressor- исправить выбросы, переключившись с квадратов на линейные потери на расстоянии эпсилон. Работа huber заключается в том, чтобы изменить squared_loss, чтобы алгоритм меньше фокусировался на исправлении выбросов.

epsilon_insensitive - На самом деле он игнорирует ошибки меньше, чем epsilon.

squared_epsilon_insensitive- То же, что и epsilon_insensitive. Единственная разница в том, что это становится квадратом потерь сверх допуска эпсилон.

Еще одно отличие состоит в том, что параметр power_t имеет значение по умолчанию 0,25, а не 0,5, как в SGDClassifier. Кроме того, у него нет параметров class_weight и n_jobs.

Атрибуты

Атрибуты SGDRegressor такие же, как и у модуля SGDClassifier. Скорее у него есть три дополнительных атрибута, а именно:

average_coef_ - массив, форма (n_features,)

Как следует из названия, он предоставляет средние веса, присвоенные функциям.

average_intercept_ - массив, форма (1,)

Как следует из названия, он обеспечивает усредненный член перехвата.

t_ - int

Он предоставляет количество обновлений веса, выполненных во время фазы тренировки.

Note - атрибуты average_coef_ и average_intercept_ будут работать после включения параметра «средний» в значение True.

Implementation Example

Следующий скрипт Python использует SGDRegressor линейная модель -

import numpy as np

from sklearn import linear_model

n_samples, n_features = 10, 5

rng = np.random.RandomState(0)

y = rng.randn(n_samples)

X = rng.randn(n_samples, n_features)

SGDReg =linear_model.SGDRegressor(

max_iter = 1000,penalty = "elasticnet",loss = 'huber',tol = 1e-3, average = True

)

SGDReg.fit(X, y)Output

SGDRegressor(

alpha = 0.0001, average = True, early_stopping = False, epsilon = 0.1,

eta0 = 0.01, fit_intercept = True, l1_ratio = 0.15,

learning_rate = 'invscaling', loss = 'huber', max_iter = 1000,

n_iter = None, n_iter_no_change = 5, penalty = 'elasticnet', power_t = 0.25,

random_state = None, shuffle = True, tol = 0.001, validation_fraction = 0.1,

verbose = 0, warm_start = False

)Example

Теперь, после установки, мы можем получить вектор веса с помощью следующего скрипта Python -

SGDReg.coef_Output

array([-0.00423314, 0.00362922, -0.00380136, 0.00585455, 0.00396787])Example

Точно так же мы можем получить значение перехвата с помощью следующего скрипта Python -

SGReg.intercept_Output

SGReg.intercept_Example

Мы можем получить количество обновлений веса во время фазы тренировки с помощью следующего скрипта Python:

SGDReg.t_Output

61.0Плюсы и минусы SGD

Следуя за плюсами SGD -

Стохастический градиентный спуск (SGD) очень эффективен.

Это очень легко реализовать, так как есть много возможностей для настройки кода.

После минусов SGD -

Для стохастического градиентного спуска (SGD) требуется несколько гиперпараметров, таких как параметры регуляризации.

Он чувствителен к масштабированию функции.

В этой главе рассматривается метод машинного обучения, называемый машинами опорных векторов (SVM).

Введение

Машины опорных векторов (SVM) - это мощные, но гибкие методы контролируемого машинного обучения, используемые для классификации, регрессии и обнаружения выбросов. SVM очень эффективны в пространствах большой размерности и обычно используются в задачах классификации. SVM популярны и эффективны с точки зрения памяти, потому что они используют подмножество обучающих точек в функции принятия решения.

Основная цель SVM - разделить наборы данных на несколько классов, чтобы найти maximum marginal hyperplane (MMH) что можно сделать в следующие два шага -

Машины опорных векторов сначала будут генерировать гиперплоскости итеративно, что наилучшим образом разделяет классы.

После этого он выберет гиперплоскость, которая правильно разделяет классы.

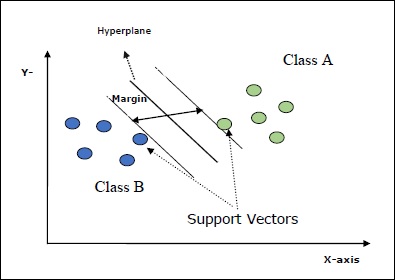

Некоторые важные концепции в SVM следующие:

Support Vectors- Их можно определить как точки данных, которые находятся ближе всего к гиперплоскости. Опорные векторы помогают определить разделительную линию.

Hyperplane - Плоскость решения или пространство, разделяющее множество объектов разных классов.

Margin - Промежуток между двумя линиями на контрольных точках шкафа разных классов называется маржей.

Следующие диаграммы дадут вам представление об этих концепциях SVM.

SVM в Scikit-learn поддерживает в качестве входных данных как разреженные, так и плотные выборочные векторы.

Классификация SVM

Scikit-learn предоставляет три класса, а именно: SVC, NuSVC и LinearSVC который может выполнять классификацию мультиклассов.

SVC

Это классификация C-опорных векторов, реализация которой основана на libsvm. Модуль, используемый scikit-learn:sklearn.svm.SVC. Этот класс обрабатывает поддержку мультикласса по схеме «один против одного».

Параметры

В следующей таблице представлены параметры, используемые sklearn.svm.SVC класс -

| Старший Нет | Параметр и описание |

|---|---|

| 1 | C - float, необязательно, по умолчанию = 1.0 Это штрафной параметр члена ошибки. |

| 2 | kernel - строка, необязательно, по умолчанию = 'rbf' Этот параметр указывает тип ядра, которое будет использоваться в алгоритме. мы можем выбрать любой среди,‘linear’, ‘poly’, ‘rbf’, ‘sigmoid’, ‘precomputed’. Значение ядра по умолчанию будет‘rbf’. |

| 3 | degree - int, необязательно, по умолчанию = 3 Он представляет собой степень функции ядра «poly» и будет игнорироваться всеми другими ядрами. |

| 4 | gamma - {'scale', 'auto'} или float, Это коэффициент ядра для ядер "rbf", "poly" и "sigmoid". |

| 5 | optinal default - = 'масштаб' Если вы выберете значение по умолчанию, то есть gamma = 'scale', тогда значение гаммы, которое будет использоваться SVC, будет 1 / (_ ∗. ()). С другой стороны, если gamma = 'auto', используется 1 / _. |

| 6 | coef0 - float, необязательно, по умолчанию = 0,0 Независимый термин в функции ядра, который имеет значение только в 'poly' и 'sigmoid'. |

| 7 | tol - float, необязательно, по умолчанию = 1.e-3 Этот параметр представляет собой критерий остановки для итераций. |

| 8 | shrinking - Логическое значение, необязательно, по умолчанию = True Этот параметр указывает, хотим ли мы использовать эвристику сжатия или нет. |

| 9 | verbose - Boolean, по умолчанию: false Он включает или отключает подробный вывод. Его значение по умолчанию - false. |

| 10 | probability - логическое, необязательное, по умолчанию = true Этот параметр включает или отключает оценки вероятности. Значение по умолчанию - false, но оно должно быть включено перед вызовом fit. |

| 11 | max_iter - int, необязательно, по умолчанию = -1 Как следует из названия, он представляет собой максимальное количество итераций в решателе. Значение -1 означает, что ограничение на количество итераций отсутствует. |

| 12 | cache_size - поплавок, необязательно Этот параметр укажет размер кеша ядра. Значение будет в МБ (мегабайтах). |

| 13 | random_state - int, экземпляр RandomState или None, необязательно, по умолчанию = none Этот параметр представляет собой начальное число сгенерированного псевдослучайного числа, которое используется при перетасовке данных. Следующие варианты -

|

| 14 | class_weight - {dict, 'balance'}, необязательно Этот параметр устанавливает для параметра C класса j значение _ℎ [] ∗ для SVC. Если мы используем вариант по умолчанию, это означает, что все классы должны иметь единичный вес. С другой стороны, если вы выберетеclass_weight:balanced, он будет использовать значения y для автоматической настройки весов. |

| 15 | decision_function_shape - ovo ',' ovr ', по умолчанию =' ovr ' Этот параметр решает, вернет ли алгоритм ‘ovr’ (one-vs-rest) решающая функция формы, как и все другие классификаторы, или исходная ovo(один против одного) решающая функция libsvm. |

| 16 | break_ties - логическое, необязательное, по умолчанию = false True - Прогноз разорвет связи в соответствии со значениями достоверности solution_function False - Прогноз вернет первый класс среди связанных классов. |

Атрибуты

Следующая таблица содержит атрибуты, используемые sklearn.svm.SVC класс -

| Старший Нет | Атрибуты и описание |

|---|---|

| 1 | support_ - в виде массива, shape = [n_SV] Возвращает индексы опорных векторов. |

| 2 | support_vectors_ - в виде массива, shape = [n_SV, n_features] Он возвращает опорные векторы. |

| 3 | n_support_ - как массив, dtype = int32, shape = [n_class] Он представляет количество опорных векторов для каждого класса. |

| 4 | dual_coef_ - массив, shape = [n_class-1, n_SV] Это коэффициенты опорных векторов в решающей функции. |

| 5 | coef_ - массив, shape = [n_class * (n_class-1) / 2, n_features] Этот атрибут, доступный только в случае линейного ядра, обеспечивает вес, присвоенный функциям. |

| 6 | intercept_ - массив, форма = [n_class * (n_class-1) / 2] Он представляет собой независимый член (константу) в решающей функции. |

| 7 | fit_status_ - int Если он установлен правильно, то на выходе будет 0. Если он установлен неправильно, выход будет 1. |

| 8 | classes_ - массив формы = [n_classes] Он дает метки классов. |

Implementation Example

Как и другие классификаторы, SVC также должен быть оснащен следующими двумя массивами:

Массив Xпроведение обучающих выборок. Он имеет размер [n_samples, n_features].

Массив Yудерживание целевых значений, то есть меток классов для обучающих выборок. Его размер [n_samples].

Следующий скрипт Python использует sklearn.svm.SVC класс -

import numpy as np

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

y = np.array([1, 1, 2, 2])

from sklearn.svm import SVC

SVCClf = SVC(kernel = 'linear',gamma = 'scale', shrinking = False,)

SVCClf.fit(X, y)Output

SVC(C = 1.0, cache_size = 200, class_weight = None, coef0 = 0.0,

decision_function_shape = 'ovr', degree = 3, gamma = 'scale', kernel = 'linear',

max_iter = -1, probability = False, random_state = None, shrinking = False,

tol = 0.001, verbose = False)Example

Теперь, после установки, мы можем получить вектор веса с помощью следующего скрипта Python -

SVCClf.coef_Output

array([[0.5, 0.5]])Example

Точно так же мы можем получить значение других атрибутов следующим образом:

SVCClf.predict([[-0.5,-0.8]])Output

array([1])Example

SVCClf.n_support_Output

array([1, 1])Example

SVCClf.support_vectors_Output

array(

[

[-1., -1.],

[ 1., 1.]

]

)Example

SVCClf.support_Output

array([0, 2])Example

SVCClf.intercept_Output

array([-0.])Example

SVCClf.fit_status_Output

0NuSVC

NuSVC - это классификация опорных векторов Nu. Это еще один класс, предоставляемый scikit-learn, который может выполнять мультиклассовую классификацию. Это похоже на SVC, но NuSVC принимает несколько другие наборы параметров. Параметр, который отличается от SVC, выглядит следующим образом -

nu - float, необязательно, по умолчанию = 0.5

Он представляет собой верхнюю границу доли ошибок обучения и нижнюю границу доли опорных векторов. Его значение должно быть в интервале (o, 1].

Остальные параметры и атрибуты такие же, как у SVC.

Пример реализации

Мы можем реализовать тот же пример, используя sklearn.svm.NuSVC класс тоже.

import numpy as np

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

y = np.array([1, 1, 2, 2])

from sklearn.svm import NuSVC

NuSVCClf = NuSVC(kernel = 'linear',gamma = 'scale', shrinking = False,)

NuSVCClf.fit(X, y)Вывод

NuSVC(cache_size = 200, class_weight = None, coef0 = 0.0,

decision_function_shape = 'ovr', degree = 3, gamma = 'scale', kernel = 'linear',

max_iter = -1, nu = 0.5, probability = False, random_state = None,

shrinking = False, tol = 0.001, verbose = False)Мы можем получить выходные данные остальных атрибутов, как это было в случае с SVC.

LinearSVC

Это классификация линейных опорных векторов. Это похоже на SVC с ядром = 'linear'. Разница между ними в том, чтоLinearSVC реализован в терминах liblinear, в то время как SVC реализован в libsvm. Вот в чем причинаLinearSVCимеет большую гибкость в выборе функций штрафов и потерь. Он также лучше масштабируется для большого количества выборок.

Если говорить о его параметрах и атрибутах, то он не поддерживает ‘kernel’ поскольку предполагается, что он линейный, и ему также не хватает некоторых атрибутов, таких как support_, support_vectors_, n_support_, fit_status_ и, dual_coef_.

Однако он поддерживает penalty и loss параметры следующим образом -

penalty − string, L1 or L2(default = ‘L2’)

Этот параметр используется для указания нормы (L1 или L2), используемой при пенализации (регуляризации).

loss − string, hinge, squared_hinge (default = squared_hinge)

Он представляет функцию потерь, где «шарнир» - это стандартные потери SVM, а «квадрат_холоста» - квадрат потерь в шарнире.

Пример реализации

Следующий скрипт Python использует sklearn.svm.LinearSVC класс -

from sklearn.svm import LinearSVC

from sklearn.datasets import make_classification

X, y = make_classification(n_features = 4, random_state = 0)

LSVCClf = LinearSVC(dual = False, random_state = 0, penalty = 'l1',tol = 1e-5)

LSVCClf.fit(X, y)Вывод

LinearSVC(C = 1.0, class_weight = None, dual = False, fit_intercept = True,

intercept_scaling = 1, loss = 'squared_hinge', max_iter = 1000,

multi_class = 'ovr', penalty = 'l1', random_state = 0, tol = 1e-05, verbose = 0)пример

Теперь, после подбора, модель может предсказывать новые значения следующим образом:

LSVCClf.predict([[0,0,0,0]])Вывод

[1]пример

В приведенном выше примере мы можем получить вектор веса с помощью следующего скрипта Python:

LSVCClf.coef_Вывод

[[0. 0. 0.91214955 0.22630686]]пример

Точно так же мы можем получить значение перехвата с помощью следующего скрипта Python -

LSVCClf.intercept_Вывод

[0.26860518]Регрессия с SVM

Как обсуждалось ранее, SVM используется как для задач классификации, так и для решения задач регрессии. Метод классификации опорных векторов (SVC) Scikit-learn также может быть расширен для решения задач регрессии. Этот расширенный метод называется регрессией опорных векторов (SVR).

Основное сходство между SVM и SVR

Модель, созданная SVC, зависит только от подмножества обучающих данных. Почему? Потому что функция затрат для построения модели не заботится о точках обучающих данных, которые лежат за пределами поля.

Принимая во внимание, что модель, созданная SVR (регрессия опорных векторов), также зависит только от подмножества обучающих данных. Почему? Поскольку функция стоимости для построения модели игнорирует любые точки обучающих данных, близкие к предсказанию модели.

Scikit-learn предоставляет три класса, а именно: SVR, NuSVR and LinearSVR как три разные реализации SVR.

СВР

Это векторная регрессия с поддержкой Epsilon, реализация которой основана на libsvm. В отличие отSVC В модели есть два свободных параметра, а именно ‘C’ и ‘epsilon’.

epsilon - float, необязательно, по умолчанию = 0,1

Он представляет собой эпсилон в модели эпсилон-SVR и определяет эпсилон-трубку, в которой в функции потерь при обучении не связано никаких штрафов с точками, предсказанными в пределах эпсилон-расстояния от фактического значения.

Остальные параметры и атрибуты аналогичны тем, которые мы использовали в SVC.

Пример реализации

Следующий скрипт Python использует sklearn.svm.SVR класс -

from sklearn import svm

X = [[1, 1], [2, 2]]

y = [1, 2]

SVRReg = svm.SVR(kernel = ’linear’, gamma = ’auto’)

SVRReg.fit(X, y)Вывод

SVR(C = 1.0, cache_size = 200, coef0 = 0.0, degree = 3, epsilon = 0.1, gamma = 'auto',

kernel = 'linear', max_iter = -1, shrinking = True, tol = 0.001, verbose = False)пример

Теперь, после установки, мы можем получить вектор веса с помощью следующего скрипта Python -

SVRReg.coef_Вывод

array([[0.4, 0.4]])пример

Точно так же мы можем получить значение других атрибутов следующим образом:

SVRReg.predict([[1,1]])Вывод

array([1.1])Точно так же мы можем получить значения других атрибутов.

NuSVR

NuSVR является Nu Support Vector регрессия. Это похоже на NuSVC, но NuSVR использует параметрnuдля контроля количества опорных векторов. Причем, в отличие от NuSVC, гдеnu заменен параметр C, здесь он заменяет epsilon.

Пример реализации

Следующий скрипт Python использует sklearn.svm.SVR класс -

from sklearn.svm import NuSVR

import numpy as np

n_samples, n_features = 20, 15

np.random.seed(0)

y = np.random.randn(n_samples)

X = np.random.randn(n_samples, n_features)

NuSVRReg = NuSVR(kernel = 'linear', gamma = 'auto',C = 1.0, nu = 0.1)^M

NuSVRReg.fit(X, y)Вывод

NuSVR(C = 1.0, cache_size = 200, coef0 = 0.0, degree = 3, gamma = 'auto',

kernel = 'linear', max_iter = -1, nu = 0.1, shrinking = True, tol = 0.001,

verbose = False)пример

Теперь, после установки, мы можем получить вектор веса с помощью следующего скрипта Python -

NuSVRReg.coef_Вывод

array(

[

[-0.14904483, 0.04596145, 0.22605216, -0.08125403, 0.06564533,

0.01104285, 0.04068767, 0.2918337 , -0.13473211, 0.36006765,

-0.2185713 , -0.31836476, -0.03048429, 0.16102126, -0.29317051]

]

)Точно так же мы можем получить значение других атрибутов.

LinearSVR

Это линейная регрессия опорных векторов. Это похоже на SVR с ядром = 'linear'. Разница между ними в том, чтоLinearSVR реализовано с точки зрения liblinear, а SVC реализован в libsvm. Вот в чем причинаLinearSVRимеет большую гибкость в выборе функций штрафов и потерь. Он также лучше масштабируется для большого количества выборок.

Если говорить о его параметрах и атрибутах, то он не поддерживает ‘kernel’ поскольку предполагается, что он линейный, и ему также не хватает некоторых атрибутов, таких как support_, support_vectors_, n_support_, fit_status_ и, dual_coef_.

Однако он поддерживает следующие параметры «потери»:

loss - строка, необязательно, по умолчанию = 'epsilon_insensitive'

Он представляет функцию потерь, где epsilon_insensitive loss - это потеря L1, а квадратичная потеря нечувствительности к epsilon - это потеря L2.

Пример реализации

Следующий скрипт Python использует sklearn.svm.LinearSVR класс -

from sklearn.svm import LinearSVR

from sklearn.datasets import make_regression

X, y = make_regression(n_features = 4, random_state = 0)

LSVRReg = LinearSVR(dual = False, random_state = 0,

loss = 'squared_epsilon_insensitive',tol = 1e-5)

LSVRReg.fit(X, y)Вывод

LinearSVR(

C=1.0, dual=False, epsilon=0.0, fit_intercept=True,

intercept_scaling=1.0, loss='squared_epsilon_insensitive',

max_iter=1000, random_state=0, tol=1e-05, verbose=0

)пример

Теперь, после подбора, модель может предсказывать новые значения следующим образом:

LSRReg.predict([[0,0,0,0]])Вывод

array([-0.01041416])пример

В приведенном выше примере мы можем получить вектор веса с помощью следующего скрипта Python:

LSRReg.coef_Вывод

array([20.47354746, 34.08619401, 67.23189022, 87.47017787])пример

Точно так же мы можем получить значение перехвата с помощью следующего скрипта Python -

LSRReg.intercept_Вывод

array([-0.01041416])Здесь мы узнаем о том, что такое обнаружение аномалий в Sklearn и как оно используется для идентификации точек данных.

Обнаружение аномалий - это метод, используемый для определения точек данных в наборе данных, которые не соответствуют остальным данным. Он имеет множество приложений в бизнесе, таких как обнаружение мошенничества, обнаружение вторжений, мониторинг состояния системы, наблюдение и профилактическое обслуживание. Аномалии, которые также называют выбросами, можно разделить на следующие три категории:

Point anomalies - Это происходит, когда отдельный экземпляр данных считается аномальным по отношению к остальным данным.

Contextual anomalies- Такая аномалия зависит от контекста. Это происходит, если экземпляр данных является аномальным в определенном контексте.

Collective anomalies - Это происходит, когда набор связанных экземпляров данных является аномальным в отношении всего набора данных, а не отдельных значений.

Методы

Два метода, а именно outlier detection и novelty detectionможет использоваться для обнаружения аномалий. Необходимо видеть разницу между ними.

Обнаружение выбросов

Данные обучения содержат выбросы, которые далеки от остальных данных. Такие выбросы определяются как наблюдения. По этой причине оценщики обнаружения выбросов всегда стараются соответствовать области с наиболее концентрированными обучающими данными, игнорируя отклоняющиеся наблюдения. Это также известно как неконтролируемое обнаружение аномалий.

Обнаружение новинок

Он связан с обнаружением ненаблюдаемого паттерна в новых наблюдениях, который не включается в обучающие данные. Здесь данные обучения не загрязнены выбросами. Это также известно как полу-контролируемое обнаружение аномалий.

Scikit-learn предоставляет набор инструментов машинного обучения, которые можно использовать как для обнаружения выбросов, так и для обнаружения новинок. Эти инструменты сначала реализуют объектное обучение на основе данных без присмотра с использованием метода fit () следующим образом:

estimator.fit(X_train)Теперь новые наблюдения будут отсортированы как inliers (labeled 1) или же outliers (labeled -1) используя метод predic () следующим образом -

estimator.fit(X_test)Оценщик сначала вычислит функцию необработанной оценки, а затем метод прогнозирования будет использовать пороговое значение для этой функции оценки. Мы можем получить доступ к этой необработанной функции оценки с помощьюscore_sample метод и может контролировать порог с помощью contamination параметр.

Мы также можем определить decision_function метод, который определяет выбросы как отрицательное значение, а выбросы как неотрицательное значение.

estimator.decision_function(X_test)Алгоритмы Sklearn для обнаружения выбросов

Начнем с понимания, что такое эллиптическая оболочка.

Установка эллиптического конверта

Этот алгоритм предполагает, что обычные данные поступают из известного распределения, такого как распределение Гаусса. Для обнаружения выбросов Scikit-learn предоставляет объект с именемcovariance.EllipticEnvelop.

Этот объект соответствует надежной оценке ковариации для данных и, таким образом, соответствует эллипсу центральным точкам данных. Он игнорирует точки за пределами центрального режима.

Параметры

В следующей таблице представлены параметры, используемые sklearn. covariance.EllipticEnvelop метод -

| Старший Нет | Параметр и описание |

|---|---|

| 1 | store_precision - Логическое значение, необязательно, по умолчанию = True Мы можем указать его, если сохранена предполагаемая точность. |

| 2 | assume_centered - Логическое значение, необязательно, по умолчанию = False Если мы установим его в False, он будет вычислять устойчивое местоположение и ковариацию напрямую с помощью алгоритма FastMCD. С другой стороны, если установлено True, будет вычислена поддержка надежного местоположения и ковариантности. |

| 3 | support_fraction - float in (0., 1.), необязательно, по умолчанию = None Этот параметр сообщает методу, какая доля точек должна быть включена в поддержку необработанных оценок MCD. |

| 4 | contamination - float in (0., 1.), необязательно, по умолчанию = 0.1 Он показывает долю выбросов в наборе данных. |

| 5 | random_state - int, экземпляр RandomState или None, необязательно, по умолчанию = none Этот параметр представляет собой начальное число сгенерированного псевдослучайного числа, которое используется при перетасовке данных. Следующие варианты -

|

Attributes

Following table consist the attributes used by sklearn. covariance.EllipticEnvelop method −

| Sr.No | Attributes & Description |

|---|---|

| 1 | support_ − array-like, shape(n_samples,) It represents the mask of the observations used to compute robust estimates of location and shape. |

| 2 | location_ − array-like, shape (n_features) It returns the estimated robust location. |

| 3 | covariance_ − array-like, shape (n_features, n_features) It returns the estimated robust covariance matrix. |

| 4 | precision_ − array-like, shape (n_features, n_features) It returns the estimated pseudo inverse matrix. |

| 5 | offset_ − float It is used to define the decision function from the raw scores. decision_function = score_samples -offset_ |

Implementation Example

import numpy as np^M

from sklearn.covariance import EllipticEnvelope^M

true_cov = np.array([[.5, .6],[.6, .4]])

X = np.random.RandomState(0).multivariate_normal(mean = [0, 0], cov=true_cov,size=500)

cov = EllipticEnvelope(random_state = 0).fit(X)^M

# Now we can use predict method. It will return 1 for an inlier and -1 for an outlier.

cov.predict([[0, 0],[2, 2]])Output

array([ 1, -1])Isolation Forest

In case of high-dimensional dataset, one efficient way for outlier detection is to use random forests. The scikit-learn provides ensemble.IsolationForest method that isolates the observations by randomly selecting a feature. Afterwards, it randomly selects a value between the maximum and minimum values of the selected features.

Here, the number of splitting needed to isolate a sample is equivalent to path length from the root node to the terminating node.

Parameters

Followings table consist the parameters used by sklearn. ensemble.IsolationForest method −

| Sr.No | Parameter & Description |

|---|---|

| 1 | n_estimators − int, optional, default = 100 It represents the number of base estimators in the ensemble. |

| 2 | max_samples − int or float, optional, default = “auto” It represents the number of samples to be drawn from X to train each base estimator. If we choose int as its value, it will draw max_samples samples. If we choose float as its value, it will draw max_samples ∗ .shape[0] samples. And, if we choose auto as its value, it will draw max_samples = min(256,n_samples). |

| 3 | support_fraction − float in (0., 1.), optional, default = None This parameter tells the method that how much proportion of points to be included in the support of the raw MCD estimates. |

| 4 | contamination − auto or float, optional, default = auto It provides the proportion of the outliers in the data set. If we set it default i.e. auto, it will determine the threshold as in the original paper. If set to float, the range of contamination will be in the range of [0,0.5]. |

| 5 | random_state − int, RandomState instance or None, optional, default = none This parameter represents the seed of the pseudo random number generated which is used while shuffling the data. Followings are the options −

|

| 6 | max_features − int or float, optional (default = 1.0) It represents the number of features to be drawn from X to train each base estimator. If we choose int as its value, it will draw max_features features. If we choose float as its value, it will draw max_features * X.shape[] samples. |