AI พร้อม Python - คู่มือฉบับย่อ

นับตั้งแต่มีการประดิษฐ์คอมพิวเตอร์หรือเครื่องจักรความสามารถในการทำงานต่าง ๆ ได้รับการเติบโตอย่างทวีคูณ มนุษย์ได้พัฒนาพลังของระบบคอมพิวเตอร์ในแง่ของโดเมนการทำงานที่หลากหลายความเร็วที่เพิ่มขึ้นและการลดขนาดตามเวลา

สาขาวิทยาศาสตร์คอมพิวเตอร์ชื่อปัญญาประดิษฐ์มุ่งสร้างคอมพิวเตอร์หรือเครื่องจักรที่ฉลาดเหมือนมนุษย์

แนวคิดพื้นฐานของปัญญาประดิษฐ์ (AI)

John McCarthy บิดาแห่งปัญญาประดิษฐ์กล่าวว่า“ วิทยาศาสตร์และวิศวกรรมในการสร้างเครื่องจักรอัจฉริยะโดยเฉพาะโปรแกรมคอมพิวเตอร์อัจฉริยะ”

ปัญญาประดิษฐ์เป็นวิธีการสร้างคอมพิวเตอร์หุ่นยนต์ที่ควบคุมด้วยคอมพิวเตอร์หรือซอฟต์แวร์ที่คิดอย่างชาญฉลาดในลักษณะเดียวกับที่มนุษย์ฉลาดคิด AI ทำได้โดยการศึกษาวิธีคิดของสมองมนุษย์และวิธีที่มนุษย์เรียนรู้ตัดสินใจและทำงานในขณะที่พยายามแก้ปัญหาจากนั้นใช้ผลการศึกษานี้เป็นพื้นฐานในการพัฒนาซอฟต์แวร์และระบบอัจฉริยะ

ในขณะที่ใช้ประโยชน์จากพลังของระบบคอมพิวเตอร์ความอยากรู้อยากเห็นของมนุษย์ทำให้เขาสงสัยว่า“ เครื่องจักรสามารถคิดและทำตัวเหมือนมนุษย์ได้หรือไม่”

ดังนั้นการพัฒนา AI จึงเริ่มต้นด้วยความตั้งใจที่จะสร้างความฉลาดที่คล้ายกันในเครื่องจักรที่เราพบและถือว่ามีความเป็นมนุษย์สูง

ความจำเป็นของการเรียนรู้ AI

อย่างที่เราทราบกันดีว่า AI ใฝ่หาการสร้างเครื่องจักรที่ฉลาดเหมือนมนุษย์ มีเหตุผลมากมายที่เราควรศึกษา AI เหตุผลมีดังนี้ -

AI สามารถเรียนรู้ผ่านข้อมูล

ในชีวิตประจำวันของเราเราจัดการกับข้อมูลจำนวนมากและสมองของมนุษย์ไม่สามารถติดตามข้อมูลจำนวนมากได้ นั่นคือเหตุผลที่เราต้องทำให้สิ่งต่างๆเป็นไปโดยอัตโนมัติ สำหรับการทำงานอัตโนมัติเราต้องศึกษา AI เพราะสามารถเรียนรู้จากข้อมูลและสามารถทำงานซ้ำ ๆ ได้อย่างแม่นยำและไม่เหนื่อย

AI สามารถสอนตัวเองได้

จำเป็นมากที่ระบบควรสอนตัวเองเนื่องจากข้อมูลมีการเปลี่ยนแปลงอยู่ตลอดเวลาและความรู้ที่ได้มาจากข้อมูลดังกล่าวจะต้องได้รับการปรับปรุงอย่างต่อเนื่อง เราสามารถใช้ AI เพื่อตอบสนองจุดประสงค์นี้ได้เนื่องจากระบบที่เปิดใช้งาน AI สามารถสอนตัวเองได้

AI สามารถตอบสนองแบบเรียลไทม์

ปัญญาประดิษฐ์ด้วยความช่วยเหลือของโครงข่ายประสาทเทียมสามารถวิเคราะห์ข้อมูลได้ลึกขึ้น เนื่องจากความสามารถนี้ AI สามารถคิดและตอบสนองต่อสถานการณ์ที่เป็นไปตามเงื่อนไขแบบเรียลไทม์

AI บรรลุความแม่นยำ

ด้วยความช่วยเหลือของเครือข่ายประสาทเทียมที่ล้ำลึก AI สามารถบรรลุความแม่นยำอย่างมาก AI ช่วยในด้านการแพทย์ในการวินิจฉัยโรคเช่นมะเร็งจาก MRI ของผู้ป่วย

AI สามารถจัดระเบียบข้อมูลเพื่อให้ได้ประโยชน์สูงสุด

ข้อมูลเป็นทรัพย์สินทางปัญญาสำหรับระบบที่ใช้อัลกอริทึมการเรียนรู้ด้วยตนเอง เราต้องการ AI ในการจัดทำดัชนีและจัดระเบียบข้อมูลในลักษณะที่ให้ผลลัพธ์ที่ดีที่สุดเสมอ

ทำความเข้าใจกับข่าวกรอง

AI สามารถสร้างระบบอัจฉริยะได้ เราจำเป็นต้องเข้าใจแนวคิดของความฉลาดเพื่อที่สมองของเราจะสามารถสร้างระบบความฉลาดอื่นได้เช่นเดียวกับตัวมันเอง

Intelligence คืออะไร?

ความสามารถของระบบในการคำนวณเหตุผลรับรู้ความสัมพันธ์และการเปรียบเทียบเรียนรู้จากประสบการณ์จัดเก็บและดึงข้อมูลจากหน่วยความจำแก้ปัญหาเข้าใจความคิดที่ซับซ้อนใช้ภาษาธรรมชาติอย่างคล่องแคล่วจำแนกสรุปและปรับสถานการณ์ใหม่

ประเภทของข่าวกรอง

ตามที่โฮเวิร์ดการ์ดเนอร์นักจิตวิทยาพัฒนาการชาวอเมริกันได้อธิบายไว้ว่าหน่วยสืบราชการลับมีหลายรูปแบบ -

| ซีเนียร์ No | ข่าวกรองและคำอธิบาย | ตัวอย่าง |

|---|---|---|

| 1 | Linguistic intelligence ความสามารถในการพูดรับรู้และใช้กลไกของการออกเสียง (เสียงพูด) ไวยากรณ์ (ไวยากรณ์) และความหมาย (ความหมาย) |

ผู้บรรยาย, Orators |

| 2 | Musical intelligence ความสามารถในการสร้างสื่อสารและเข้าใจความหมายที่เกิดจากเสียงความเข้าใจระดับเสียงจังหวะ |

นักดนตรีนักร้องนักแต่งเพลง |

| 3 | Logical-mathematical intelligence ความสามารถในการใช้และเข้าใจความสัมพันธ์ในกรณีที่ไม่มีการกระทำหรือวัตถุ ยังเป็นความสามารถในการเข้าใจความคิดที่ซับซ้อนและเป็นนามธรรม |

นักคณิตศาสตร์นักวิทยาศาสตร์ |

| 4 | Spatial intelligence ความสามารถในการรับรู้ข้อมูลภาพหรือเชิงพื้นที่เปลี่ยนแปลงและสร้างภาพใหม่โดยไม่ต้องอ้างอิงถึงวัตถุสร้างภาพ 3 มิติและเพื่อเคลื่อนย้ายและหมุน |

ผู้อ่านแผนที่นักบินอวกาศนักฟิสิกส์ |

| 5 | Bodily-Kinesthetic intelligence ความสามารถในการใช้ร่างกายทั้งหมดหรือบางส่วนในการแก้ปัญหาหรือผลิตภัณฑ์แฟชั่นควบคุมทักษะยนต์ที่ละเอียดและหยาบและจัดการกับวัตถุ |

ผู้เล่นนักเต้น |

| 6 | Intra-personal intelligence ความสามารถในการแยกแยะระหว่างความรู้สึกเจตนาและแรงจูงใจของตนเอง |

กัวตัมพุทธะ |

| 7 | Interpersonal intelligence ความสามารถในการรับรู้และสร้างความแตกต่างท่ามกลางความรู้สึกความเชื่อและความตั้งใจของคนอื่น |

นักสื่อสารมวลชนผู้สัมภาษณ์ |

คุณสามารถพูดได้ว่าเครื่องจักรหรือระบบมีความฉลาดเทียมเมื่อมีความฉลาดอย่างน้อยหนึ่งอย่างหรือทั้งหมดอยู่ในนั้น

Intelligence ประกอบด้วยอะไรบ้าง?

ความฉลาดนั้นจับต้องไม่ได้ ประกอบด้วย -

- Reasoning

- Learning

- การแก้ปัญหา

- Perception

- ความฉลาดทางภาษา

ให้เราดูส่วนประกอบทั้งหมดสั้น ๆ -

การใช้เหตุผล

เป็นชุดของกระบวนการที่ช่วยให้เราสามารถจัดเตรียมพื้นฐานสำหรับการตัดสินการตัดสินใจและการคาดคะเน มีสองประเภทกว้าง ๆ -

| การให้เหตุผลโดยอุปนัย | การให้เหตุผลแบบนิรนัย |

|---|---|

| ดำเนินการสังเกตเฉพาะเพื่อสร้างข้อความทั่วไปอย่างกว้าง ๆ | เริ่มต้นด้วยคำชี้แจงทั่วไปและตรวจสอบความเป็นไปได้ในการบรรลุข้อสรุปเชิงตรรกะที่เฉพาะเจาะจง |

| แม้ว่าสถานที่ทั้งหมดจะเป็นจริงในคำแถลง แต่การให้เหตุผลแบบอุปนัยก็ช่วยให้ข้อสรุปเป็นเท็จได้ | หากสิ่งที่เป็นจริงในชั้นเรียนโดยทั่วไปก็เป็นความจริงสำหรับสมาชิกทุกคนในชั้นเรียนนั้น |

| Example - "นิต้าเป็นครูนิต้าตั้งใจเรียนเพราะฉะนั้นครูทุกคนตั้งใจเรียน" | Example - "ผู้หญิงทุกคนที่อายุมากกว่า 60 ปีเป็นยายชาลินีอายุ 65 ปีดังนั้นชาลินีจึงเป็นยาย" |

การเรียนรู้ - ล

ความสามารถในการเรียนรู้นั้นมีอยู่ในมนุษย์สัตว์บางชนิดและระบบที่เปิดใช้งาน AI การเรียนรู้แบ่งออกเป็นดังนี้ -

การเรียนรู้ด้วยเสียง

เป็นการเรียนรู้โดยการฟังและการได้ยิน ตัวอย่างเช่นนักเรียนฟังเสียงบรรยายที่บันทึกไว้

การเรียนรู้เป็นตอน ๆ

เรียนรู้โดยการจดจำลำดับเหตุการณ์ที่ได้พบเห็นหรือมีประสบการณ์ นี่เป็นเส้นตรงและเป็นระเบียบ

การเรียนรู้ด้วยมอเตอร์

เป็นการเรียนรู้โดยการเคลื่อนไหวของกล้ามเนื้ออย่างแม่นยำ ตัวอย่างเช่นการหยิบสิ่งของการเขียนเป็นต้น

การเรียนรู้เชิงสังเกต

เรียนรู้โดยการดูและเลียนแบบผู้อื่น ตัวอย่างเช่นเด็กพยายามเรียนรู้โดยเลียนแบบพ่อแม่

การเรียนรู้เชิงรับรู้

เป็นการเรียนรู้ที่จะรับรู้สิ่งเร้าที่เราเคยเห็นมาก่อน ตัวอย่างเช่นการระบุและจัดประเภทของวัตถุและสถานการณ์

การเรียนรู้เชิงสัมพันธ์

มันเกี่ยวข้องกับการเรียนรู้ที่จะแยกความแตกต่างระหว่างสิ่งเร้าต่างๆบนพื้นฐานของคุณสมบัติเชิงสัมพันธ์มากกว่าคุณสมบัติที่แน่นอน ตัวอย่างเช่นการใส่เกลือ 'น้อยกว่า' ในเวลาปรุงมันฝรั่งที่มีรสเค็มเมื่อปรุงด้วยการเติมเกลือหนึ่งช้อนโต๊ะ

Spatial Learning - เป็นการเรียนรู้ผ่านสิ่งเร้าทางสายตาเช่นภาพสีแผนที่ ฯลฯ ตัวอย่างเช่นบุคคลสามารถสร้างแผนงานในใจก่อนที่จะไปตามถนนจริง

Stimulus-Response Learning- เป็นการเรียนรู้ที่จะแสดงพฤติกรรมเฉพาะเมื่อมีสิ่งกระตุ้นบางอย่างเกิดขึ้น ตัวอย่างเช่นสุนัขยกหูขึ้นเมื่อได้ยินเสียงกริ่งประตู

การแก้ปัญหา

เป็นกระบวนการที่คนรับรู้และพยายามหาทางออกที่ต้องการจากสถานการณ์ปัจจุบันโดยใช้เส้นทางบางอย่างซึ่งถูกขัดขวางโดยอุปสรรคที่ทราบหรือไม่รู้จัก

การแก้ปัญหายังรวมถึง decision makingซึ่งเป็นกระบวนการในการเลือกทางเลือกที่เหมาะสมที่สุดจากทางเลือกหลายทางเพื่อไปสู่เป้าหมายที่ต้องการ

การรับรู้

เป็นกระบวนการในการรับตีความคัดเลือกและจัดระเบียบข้อมูลทางประสาทสัมผัส

การรับรู้ถือว่า sensing. ในมนุษย์การรับรู้ได้รับความช่วยเหลือจากอวัยวะรับสัมผัส ในโดเมนของ AI กลไกการรับรู้จะทำให้ข้อมูลที่เซ็นเซอร์ได้รับมารวมกันในลักษณะที่มีความหมาย

ความฉลาดทางภาษา

เป็นความสามารถในการใช้เข้าใจพูดและเขียนภาษาพูดและภาษาเขียน เป็นสิ่งสำคัญในการสื่อสารระหว่างบุคคล

สิ่งที่เกี่ยวข้องกับ AI

ปัญญาประดิษฐ์เป็นพื้นที่การศึกษามากมาย สาขาวิชานี้ช่วยในการค้นหาวิธีแก้ปัญหาในโลกแห่งความเป็นจริง

ตอนนี้ให้เราดูสาขาการศึกษาต่างๆภายใน AI -

การเรียนรู้ของเครื่อง

เป็นหนึ่งในสาขา AI ที่ได้รับความนิยมมากที่สุด แนวคิดพื้นฐานของเอกสารนี้คือการทำให้แมชชีนเลิร์นนิงจากข้อมูลซึ่งมนุษย์สามารถเรียนรู้จากประสบการณ์ของเขา / เธอได้ ประกอบด้วยแบบจำลองการเรียนรู้บนพื้นฐานของการคาดการณ์ที่สามารถทำได้โดยใช้ข้อมูลที่ไม่รู้จัก

ตรรกะ

เป็นสาขาการศึกษาที่สำคัญอีกแขนงหนึ่งซึ่งใช้ตรรกะทางคณิตศาสตร์ในการสั่งงานโปรแกรมคอมพิวเตอร์ ประกอบด้วยกฎและข้อเท็จจริงเพื่อดำเนินการจับคู่รูปแบบการวิเคราะห์ความหมาย ฯลฯ

กำลังค้นหา

สาขาวิชานี้ใช้โดยทั่วไปในเกมเช่นหมากรุก, tic-tac-toe อัลกอริทึมการค้นหาเป็นทางออกที่ดีที่สุดหลังจากค้นหาพื้นที่ค้นหาทั้งหมด

โครงข่ายประสาทเทียม

นี่คือเครือข่ายของระบบคอมพิวเตอร์ที่มีประสิทธิภาพซึ่งเป็นธีมหลักที่ยืมมาจากการเปรียบเทียบเครือข่ายประสาททางชีววิทยา ANN สามารถใช้ในวิทยาการหุ่นยนต์การรู้จำเสียงการประมวลผลคำพูด ฯลฯ

อัลกอริทึมทางพันธุกรรม

ขั้นตอนวิธีทางพันธุกรรมช่วยในการแก้ปัญหาด้วยความช่วยเหลือของโปรแกรมมากกว่าหนึ่งโปรแกรม ผลลัพธ์จะขึ้นอยู่กับการเลือกสิ่งที่เหมาะสมที่สุด

การเป็นตัวแทนความรู้

เป็นสาขาวิชาด้วยความช่วยเหลือซึ่งเราสามารถแสดงข้อเท็จจริงด้วยวิธีที่เครื่องจักรที่เข้าใจได้กับเครื่องจักร ยิ่งแสดงความรู้ได้อย่างมีประสิทธิภาพ ระบบก็จะยิ่งฉลาดมากขึ้น

การประยุกต์ใช้ AI

ในส่วนนี้เราจะเห็นช่องต่างๆที่ AI รองรับ -

การเล่นเกม

AI มีบทบาทสำคัญในเกมเชิงกลยุทธ์เช่นหมากรุกโป๊กเกอร์ทิคแทคโทเป็นต้นซึ่งเครื่องจักรสามารถคิดตำแหน่งที่เป็นไปได้จำนวนมากโดยอาศัยความรู้เชิงฮิวริสติก

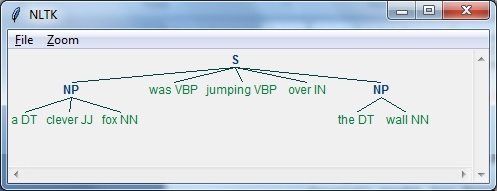

การประมวลผลภาษาธรรมชาติ

เป็นไปได้ที่จะโต้ตอบกับคอมพิวเตอร์ที่เข้าใจภาษาธรรมชาติที่มนุษย์พูด

ระบบผู้เชี่ยวชาญ

มีแอพพลิเคชั่นบางตัวที่รวมเครื่องจักรซอฟต์แวร์และข้อมูลพิเศษเพื่อให้เหตุผลและให้คำปรึกษา พวกเขาให้คำอธิบายและคำแนะนำแก่ผู้ใช้

วิชั่นซิสเต็มส์

ระบบเหล่านี้เข้าใจตีความและเข้าใจอินพุตภาพบนคอมพิวเตอร์ ตัวอย่างเช่น,

เครื่องบินสอดแนมถ่ายภาพซึ่งใช้เพื่อหาข้อมูลเชิงพื้นที่หรือแผนที่ของพื้นที่

แพทย์ใช้ระบบผู้เชี่ยวชาญทางคลินิกในการวินิจฉัยผู้ป่วย

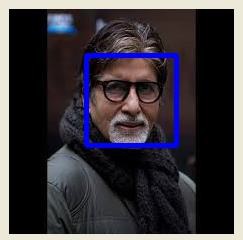

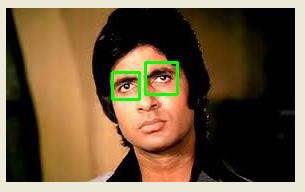

ตำรวจใช้ซอฟต์แวร์คอมพิวเตอร์ที่สามารถจดจำใบหน้าของอาชญากรพร้อมกับภาพที่จัดเก็บไว้โดยศิลปินนิติเวช

การรู้จำเสียง

ระบบอัจฉริยะบางระบบสามารถได้ยินและเข้าใจภาษาในรูปประโยคและความหมายในขณะที่มนุษย์พูดคุยกัน สามารถจัดการกับสำเนียงที่แตกต่างกันคำแสลงเสียงในพื้นหลังการเปลี่ยนแปลงของเสียงของมนุษย์เนื่องจากความเย็น ฯลฯ

การจดจำลายมือ

ซอฟต์แวร์จดจำลายมือจะอ่านข้อความที่เขียนบนกระดาษด้วยปากกาหรือบนหน้าจอด้วยสไตลัส สามารถจดจำรูปร่างของตัวอักษรและแปลงเป็นข้อความที่แก้ไขได้

หุ่นยนต์อัจฉริยะ

หุ่นยนต์สามารถทำงานที่มนุษย์มอบให้ได้ พวกเขามีเซ็นเซอร์เพื่อตรวจจับข้อมูลทางกายภาพจากโลกแห่งความจริงเช่นแสงความร้อนอุณหภูมิการเคลื่อนไหวเสียงกระแทกและแรงกด พวกเขามีโปรเซสเซอร์ที่มีประสิทธิภาพเซ็นเซอร์หลายตัวและหน่วยความจำขนาดใหญ่เพื่อแสดงข้อมูลอัจฉริยะ นอกจากนี้พวกเขายังสามารถเรียนรู้จากความผิดพลาดและปรับตัวเข้ากับสภาพแวดล้อมใหม่ได้

การสร้างแบบจำลองทางปัญญา: การจำลองขั้นตอนการคิดของมนุษย์

การสร้างแบบจำลองความรู้ความเข้าใจโดยพื้นฐานแล้วเป็นสาขาการศึกษาภายในวิทยาศาสตร์คอมพิวเตอร์ที่เกี่ยวข้องกับการศึกษาและจำลองกระบวนการคิดของมนุษย์ งานหลักของ AI คือการทำให้เครื่องจักรคิดเหมือนมนุษย์ คุณลักษณะที่สำคัญที่สุดของกระบวนการคิดของมนุษย์คือการแก้ปัญหา นั่นคือเหตุผลที่การสร้างแบบจำลององค์ความรู้ไม่มากก็น้อยพยายามที่จะเข้าใจว่ามนุษย์สามารถแก้ปัญหาได้อย่างไร หลังจากนั้นโมเดลนี้สามารถใช้กับแอปพลิเคชัน AI ต่างๆเช่นการเรียนรู้ของเครื่องหุ่นยนต์การประมวลผลภาษาธรรมชาติเป็นต้นต่อไปนี้เป็นแผนภาพระดับความคิดที่แตกต่างกันของสมองมนุษย์ -

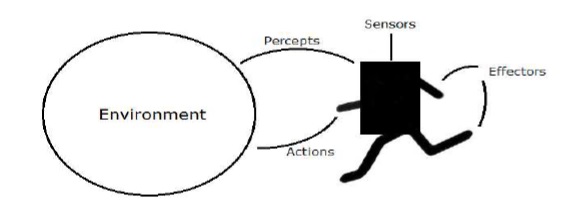

ตัวแทนและสิ่งแวดล้อม

ในส่วนนี้เราจะเน้นไปที่ตัวแทนและสภาพแวดล้อมและความช่วยเหลือเหล่านี้ในปัญญาประดิษฐ์อย่างไร

ตัวแทน

ตัวแทนคืออะไรก็ได้ที่สามารถรับรู้สภาพแวดล้อมของมันผ่านเซ็นเซอร์และกระทำต่อสภาพแวดล้อมนั้นผ่านเอฟเฟกต์

ก human agent มีอวัยวะรับความรู้สึกเช่นตาหูจมูกลิ้นและผิวหนังขนานกับเซ็นเซอร์และอวัยวะอื่น ๆ เช่นมือขาปากสำหรับเอฟเฟกต์

ก robotic agent แทนที่กล้องและตัวค้นหาระยะอินฟราเรดสำหรับเซ็นเซอร์และมอเตอร์และตัวกระตุ้นต่างๆสำหรับเอฟเฟกต์

ก software agent ได้เข้ารหัสบิตสตริงเป็นโปรแกรมและการดำเนินการ

สิ่งแวดล้อม

บางโปรแกรมทำงานในไฟล์ artificial environment จำกัด เฉพาะอินพุตแป้นพิมพ์ฐานข้อมูลระบบไฟล์คอมพิวเตอร์และเอาต์พุตอักขระบนหน้าจอ

ในทางตรงกันข้ามตัวแทนซอฟต์แวร์บางตัว (หุ่นยนต์ซอฟต์แวร์หรือซอฟต์บอท) มีอยู่ในโดเมนซอฟต์บอทที่สมบูรณ์และไม่ จำกัด เครื่องจำลองมีไฟล์very detailed, complex environment. ตัวแทนซอฟต์แวร์จำเป็นต้องเลือกจากการดำเนินการที่หลากหลายแบบเรียลไทม์ softbot ได้รับการออกแบบมาเพื่อสแกนการตั้งค่าออนไลน์ของลูกค้าและแสดงรายการที่น่าสนใจให้กับลูกค้าที่ทำงานในไฟล์real เช่นเดียวกับ artificial สิ่งแวดล้อม.

ในบทนี้เราจะเรียนรู้วิธีเริ่มต้นกับ Python นอกจากนี้เรายังจะเข้าใจว่า Python ช่วยสำหรับปัญญาประดิษฐ์ได้อย่างไร

ทำไมต้อง Python สำหรับ AI

ปัญญาประดิษฐ์ถือเป็นเทคโนโลยีที่ได้รับความนิยมในอนาคต มีแอปพลิเคชั่นจำนวนมากที่สร้างขึ้นแล้ว ด้วยเหตุนี้ บริษัท และนักวิจัยจำนวนมากจึงให้ความสนใจ แต่คำถามหลักที่เกิดขึ้นคือภาษาโปรแกรมเหล่านี้สามารถพัฒนาแอพพลิเคชั่น AI เหล่านี้ได้ มีภาษาโปรแกรมต่างๆเช่น Lisp, Prolog, C ++, Java และ Python ซึ่งสามารถใช้สำหรับการพัฒนาแอปพลิเคชันของ AI ในหมู่พวกเขาภาษาโปรแกรม Python ได้รับความนิยมอย่างมากโดยมีสาเหตุดังนี้ -

ไวยากรณ์ที่เรียบง่ายและการเข้ารหัสน้อย

Python เกี่ยวข้องกับการเข้ารหัสน้อยมากและไวยากรณ์ที่เรียบง่ายท่ามกลางภาษาโปรแกรมอื่น ๆ ซึ่งสามารถใช้สำหรับการพัฒนาแอปพลิเคชัน AI เนื่องจากคุณสมบัตินี้การทดสอบจึงง่ายขึ้นและเราสามารถมุ่งเน้นไปที่การเขียนโปรแกรมได้มากขึ้น

ไลบรารี Inbuilt สำหรับโครงการ AI

ข้อได้เปรียบที่สำคัญสำหรับการใช้ Python สำหรับ AI คือมาพร้อมกับไลบรารี inbuilt Python มีไลบรารีสำหรับโครงการ AI เกือบทุกประเภท ตัวอย่างเช่น,NumPy, SciPy, matplotlib, nltk, SimpleAI เป็นไลบรารีในตัวที่สำคัญของ Python

Open source- Python เป็นภาษาโปรแกรมโอเพ่นซอร์ส ทำให้เป็นที่นิยมอย่างแพร่หลายในชุมชน

Can be used for broad range of programming- Python สามารถใช้สำหรับงานการเขียนโปรแกรมที่หลากหลายเช่นเชลล์สคริปต์ขนาดเล็กไปจนถึงเว็บแอปพลิเคชันขององค์กร นี่เป็นอีกเหตุผลหนึ่งที่ Python เหมาะสำหรับโครงการ AI

คุณสมบัติของ Python

Python เป็นภาษาสคริปต์ระดับสูงที่ตีความโต้ตอบและเชิงวัตถุ Python ออกแบบมาให้อ่านง่าย ใช้คำหลักภาษาอังกฤษบ่อยครั้งเมื่อภาษาอื่นใช้เครื่องหมายวรรคตอนและมีโครงสร้างทางไวยากรณ์น้อยกว่าภาษาอื่น ๆ คุณสมบัติของ Python มีดังต่อไปนี้ -

Easy-to-learn- Python มีคีย์เวิร์ดไม่กี่คำโครงสร้างที่เรียบง่ายและไวยากรณ์ที่กำหนดไว้อย่างชัดเจน ซึ่งจะช่วยให้นักเรียนสามารถเลือกภาษาได้อย่างรวดเร็ว

Easy-to-read - รหัส Python มีความชัดเจนมากขึ้นและมองเห็นได้ด้วยตา

Easy-to-maintain - ซอร์สโค้ดของ Python นั้นค่อนข้างดูแลรักษาง่าย

A broad standard library - ไลบรารีจำนวนมากของ Python สามารถพกพาได้และใช้งานข้ามแพลตฟอร์มได้บน UNIX, Windows และ Macintosh

Interactive Mode - Python รองรับโหมดอินเทอร์แอกทีฟซึ่งช่วยให้สามารถทดสอบและแก้จุดบกพร่องของโค้ดได้

Portable - Python สามารถทำงานบนแพลตฟอร์มฮาร์ดแวร์ที่หลากหลายและมีอินเทอร์เฟซเดียวกันในทุกแพลตฟอร์ม

Extendable- เราสามารถเพิ่มโมดูลระดับต่ำให้กับล่าม Python ได้ โมดูลเหล่านี้ช่วยให้โปรแกรมเมอร์สามารถเพิ่มหรือปรับแต่งเครื่องมือเพื่อให้มีประสิทธิภาพมากขึ้น

Databases - Python มีอินเทอร์เฟซสำหรับฐานข้อมูลเชิงพาณิชย์ที่สำคัญทั้งหมด

GUI Programming - Python รองรับแอพพลิเคชั่น GUI ที่สามารถสร้างและพอร์ตไปยังการโทรระบบไลบรารีและระบบ windows จำนวนมากเช่น Windows MFC, Macintosh และระบบ X Window ของ Unix

Scalable - Python มีโครงสร้างที่ดีกว่าและรองรับโปรแกรมขนาดใหญ่มากกว่าเชลล์สคริปต์

คุณสมบัติที่สำคัญของ Python

ตอนนี้ให้เราพิจารณาคุณสมบัติที่สำคัญต่อไปนี้ของ Python -

สนับสนุนวิธีการเขียนโปรแกรมเชิงฟังก์ชันและโครงสร้างเช่นเดียวกับ OOP

สามารถใช้เป็นภาษาสคริปต์หรือสามารถคอมไพล์เป็นไบต์โค้ดเพื่อสร้างแอปพลิเคชันขนาดใหญ่

ให้ประเภทข้อมูลไดนามิกระดับสูงมากและรองรับการตรวจสอบประเภทไดนามิก

รองรับการเก็บขยะอัตโนมัติ

สามารถรวมเข้ากับ C, C ++, COM, ActiveX, CORBA และ Java ได้อย่างง่ายดาย

การติดตั้ง Python

การแจกจ่าย Python พร้อมใช้งานสำหรับแพลตฟอร์มจำนวนมาก คุณต้องดาวน์โหลดเฉพาะรหัสไบนารีที่ใช้กับแพลตฟอร์มของคุณและติดตั้ง Python

หากไม่มีรหัสไบนารีสำหรับแพลตฟอร์มของคุณคุณต้องมีคอมไพเลอร์ C เพื่อคอมไพล์ซอร์สโค้ดด้วยตนเอง การรวบรวมซอร์สโค้ดให้ความยืดหยุ่นมากขึ้นในแง่ของการเลือกคุณสมบัติที่คุณต้องการในการติดตั้งของคุณ

นี่คือภาพรวมโดยย่อของการติดตั้ง Python บนแพลตฟอร์มต่างๆ -

การติดตั้ง Unix และ Linux

ทำตามขั้นตอนเหล่านี้เพื่อติดตั้ง Python บนเครื่อง Unix / Linux

เปิดเว็บเบราว์เซอร์และไปที่ https://www.python.org/downloads

ไปที่ลิงค์เพื่อดาวน์โหลดซอร์สโค้ดซิปสำหรับ Unix / Linux

ดาวน์โหลดและแตกไฟล์

การแก้ไขไฟล์Modules / Setupหากคุณต้องการปรับแต่งตัวเลือกบางอย่าง

เรียกใช้. / กำหนดค่าสคริปต์

make

ทำการติดตั้ง

สิ่งนี้จะติดตั้ง Python ที่ตำแหน่งมาตรฐาน / usr / local / bin และไลบรารีที่/ usr / local / lib / pythonXXโดยที่ XX คือเวอร์ชันของ Python

การติดตั้ง Windows

ทำตามขั้นตอนเหล่านี้เพื่อติดตั้ง Python บนเครื่อง Windows

เปิดเว็บเบราว์เซอร์และไปที่ https://www.python.org/downloads

ไปที่ลิงค์สำหรับไฟล์ตัวติดตั้ง Windows python-XYZ .msi โดยที่ XYZ คือเวอร์ชันที่คุณต้องติดตั้ง

ในการใช้โปรแกรมติดตั้งpython-XYZ .msi นี้ระบบ Windows ต้องรองรับ Microsoft Installer 2.0 บันทึกไฟล์ตัวติดตั้งลงในเครื่องของคุณจากนั้นเรียกใช้เพื่อดูว่าเครื่องของคุณรองรับ MSI หรือไม่

เรียกใช้ไฟล์ที่ดาวน์โหลด สิ่งนี้จะแสดงวิซาร์ดการติดตั้ง Python ซึ่งใช้งานง่ายมาก เพียงยอมรับการตั้งค่าเริ่มต้นและรอจนกว่าการติดตั้งจะเสร็จสิ้น

การติดตั้ง Macintosh

หากคุณใช้ Mac OS X ขอแนะนำให้คุณใช้ Homebrew เพื่อติดตั้ง Python 3 เป็นโปรแกรมติดตั้งแพ็คเกจที่ยอดเยี่ยมสำหรับ Mac OS X และใช้งานง่ายมาก หากคุณไม่มี Homebrew คุณสามารถติดตั้งได้โดยใช้คำสั่งต่อไปนี้ -

$ ruby -e "$(curl -fsSL

https://raw.githubusercontent.com/Homebrew/install/master/install)"เราสามารถอัปเดตตัวจัดการแพ็คเกจด้วยคำสั่งด้านล่าง -

$ brew updateตอนนี้รันคำสั่งต่อไปนี้เพื่อติดตั้ง Python3 บนระบบของคุณ -

$ brew install python3การตั้งค่า PATH

โปรแกรมและไฟล์ปฏิบัติการอื่น ๆ อาจอยู่ในไดเร็กทอรีจำนวนมากดังนั้นระบบปฏิบัติการจึงจัดเตรียมพา ธ การค้นหาที่แสดงรายการไดเร็กทอรีที่ OS ค้นหาไฟล์ปฏิบัติการ

พา ธ ถูกเก็บไว้ในตัวแปรสภาพแวดล้อมซึ่งเป็นสตริงที่มีชื่อดูแลโดยระบบปฏิบัติการ ตัวแปรนี้มีข้อมูลที่พร้อมใช้งานสำหรับเชลล์คำสั่งและโปรแกรมอื่น ๆ

ตัวแปรพา ธ ถูกตั้งชื่อเป็น PATH ใน Unix หรือ Path ใน Windows (Unix ขึ้นอยู่กับตัวพิมพ์เล็กและตัวพิมพ์ใหญ่ Windows ไม่ใช่)

ใน Mac OS โปรแกรมติดตั้งจะจัดการกับรายละเอียดเส้นทาง ในการเรียกใช้ตัวแปล Python จากไดเร็กทอรีใด ๆ คุณต้องเพิ่มไดเร็กทอรี Python ในพา ธ ของคุณ

การตั้งค่า Path ที่ Unix / Linux

ในการเพิ่มไดเร็กทอรี Python ไปยังพา ธ สำหรับเซสชันเฉพาะใน Unix -

ในเชลล์ csh

ประเภท setenv PATH "$PATH:/usr/local/bin/python" แล้วกด Enter.

ใน bash shell (Linux)

ประเภท export ATH = "$PATH:/usr/local/bin/python" แล้วกด Enter.

ในเปลือก sh หรือ ksh

ประเภท PATH = "$PATH:/usr/local/bin/python" แล้วกด Enter.

Note - / usr / local / bin / python คือพา ธ ของไดเร็กทอรี Python

การตั้งค่าเส้นทางที่ Windows

ในการเพิ่มไดเร็กทอรี Python ไปยังพา ธ สำหรับเซสชันเฉพาะใน Windows -

At the command prompt - ประเภท path %path%;C:\Python แล้วกด Enter.

Note - C: \ Python คือพา ธ ของไดเร็กทอรี Python

กำลังรัน Python

ตอนนี้ให้เราดูวิธีต่างๆในการเรียกใช้ Python วิธีต่างๆอธิบายไว้ด้านล่าง -

ล่ามแบบโต้ตอบ

เราสามารถเริ่ม Python จาก Unix, DOS หรือระบบอื่น ๆ ที่มีตัวแปลบรรทัดคำสั่งหรือหน้าต่างเชลล์

ป้อน python ที่บรรทัดคำสั่ง

เริ่มเขียนโค้ดได้ทันทีในล่ามโต้ตอบ

$python # Unix/Linuxหรือ

python% # Unix/Linuxหรือ

C:> python # Windows/DOSนี่คือรายการของตัวเลือกบรรทัดคำสั่งทั้งหมดที่มี -

| ส. | ตัวเลือกและคำอธิบาย |

|---|---|

| 1 | -d มีเอาต์พุตการดีบัก |

| 2 | -o สร้าง bytecode ที่ปรับให้เหมาะสม (ส่งผลให้เกิดไฟล์. pyo) |

| 3 | -S อย่าเรียกใช้ไซต์นำเข้าเพื่อค้นหาเส้นทาง Python เมื่อเริ่มต้น |

| 4 | -v เอาต์พุต Verbose (การติดตามโดยละเอียดเกี่ยวกับคำสั่งการนำเข้า) |

| 5 | -x ปิดใช้งานข้อยกเว้นในตัวตามคลาส (เพียงใช้สตริง) ล้าสมัยเริ่มต้นด้วยเวอร์ชัน 1.6 |

| 6 | -c cmd เรียกใช้สคริปต์ Python ที่ส่งเป็นสตริง cmd |

| 7 | File เรียกใช้สคริปต์ Python จากไฟล์ที่กำหนด |

สคริปต์จากบรรทัดคำสั่ง

สคริปต์ Python สามารถดำเนินการได้ที่บรรทัดคำสั่งโดยเรียกใช้ตัวแปลในแอปพลิเคชันของคุณดังต่อไปนี้ -

$python script.py # Unix/Linuxหรือ,

python% script.py # Unix/Linuxหรือ,

C:> python script.py # Windows/DOSNote - ตรวจสอบให้แน่ใจว่าโหมดการอนุญาตไฟล์อนุญาตให้ดำเนินการได้

สภาพแวดล้อมการพัฒนาแบบบูรณาการ

คุณสามารถเรียกใช้ Python จากสภาพแวดล้อม Graphical User Interface (GUI) ได้เช่นกันหากคุณมีแอปพลิเคชัน GUI บนระบบของคุณที่รองรับ Python

Unix - IDLE เป็น Unix IDE แรกสำหรับ Python

Windows - PythonWin เป็นอินเทอร์เฟซ Windows ตัวแรกสำหรับ Python และเป็น IDE ที่มี GUI

Macintosh - Python เวอร์ชัน Macintosh พร้อมกับ IDLE IDE สามารถดาวน์โหลดได้จากเว็บไซต์หลักซึ่งสามารถดาวน์โหลดได้ทั้งไฟล์ MacBinary หรือ BinHex'd

หากคุณไม่สามารถตั้งค่าสภาพแวดล้อมได้อย่างเหมาะสมคุณสามารถขอความช่วยเหลือจากผู้ดูแลระบบของคุณ ตรวจสอบให้แน่ใจว่าสภาพแวดล้อม Python ได้รับการตั้งค่าอย่างเหมาะสมและทำงานได้ดีอย่างสมบูรณ์

เรายังสามารถใช้แพลตฟอร์ม Python อื่นที่เรียกว่า Anaconda ประกอบด้วยแพ็คเกจ data science ยอดนิยมหลายร้อยแพ็คเกจ conda และตัวจัดการสภาพแวดล้อมเสมือนสำหรับ Windows, Linux และ MacOS คุณสามารถดาวน์โหลดได้ตามระบบปฏิบัติการของคุณจากลิงค์https://www.anaconda.com/download/.

สำหรับบทช่วยสอนนี้เราใช้ Python 3.6.3 เวอร์ชันบน MS Windows

การเรียนรู้หมายถึงการได้มาซึ่งความรู้หรือทักษะจากการศึกษาหรือประสบการณ์ จากนี้เราสามารถกำหนดการเรียนรู้ของเครื่อง (ML) ได้ดังนี้ -

อาจถูกกำหนดให้เป็นสาขาวิทยาศาสตร์คอมพิวเตอร์โดยเฉพาะอย่างยิ่งการประยุกต์ใช้ปัญญาประดิษฐ์ซึ่งช่วยให้ระบบคอมพิวเตอร์สามารถเรียนรู้กับข้อมูลและปรับปรุงจากประสบการณ์โดยไม่ต้องมีการตั้งโปรแกรมไว้อย่างชัดเจน

โดยพื้นฐานแล้วจุดสนใจหลักของการเรียนรู้ของเครื่องคือการอนุญาตให้คอมพิวเตอร์เรียนรู้โดยอัตโนมัติโดยไม่มีการแทรกแซงจากมนุษย์ ตอนนี้คำถามเกิดขึ้นว่าการเรียนรู้ดังกล่าวสามารถเริ่มต้นและทำได้อย่างไร? สามารถเริ่มต้นด้วยการสังเกตข้อมูล ข้อมูลอาจเป็นตัวอย่างคำแนะนำหรือประสบการณ์ตรงได้เช่นกัน จากนั้นบนพื้นฐานของอินพุตนี้เครื่องจะตัดสินใจได้ดีขึ้นโดยมองหารูปแบบบางอย่างในข้อมูล

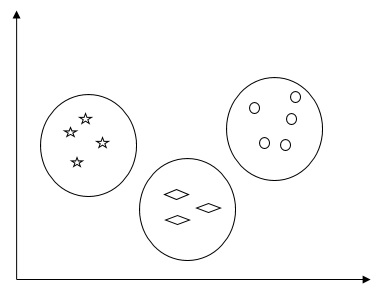

ประเภทของ Machine Learning (ML)

อัลกอริทึมการเรียนรู้ของเครื่องช่วยให้ระบบคอมพิวเตอร์เรียนรู้โดยไม่ต้องมีการตั้งโปรแกรมไว้อย่างชัดเจน อัลกอริทึมเหล่านี้แบ่งออกเป็นภายใต้การดูแลหรือไม่ได้รับการดูแล ตอนนี้ให้เราดูอัลกอริทึมบางส่วน -

อัลกอริทึมการเรียนรู้ของเครื่องภายใต้การดูแล

นี่คืออัลกอริทึมการเรียนรู้ของเครื่องที่ใช้บ่อยที่สุด เรียกว่าภายใต้การดูแลเนื่องจากกระบวนการของอัลกอริทึมการเรียนรู้จากชุดข้อมูลการฝึกอบรมสามารถคิดได้ว่าเป็นครูที่ดูแลกระบวนการเรียนรู้ ในอัลกอริทึม ML ประเภทนี้จะทราบผลลัพธ์ที่เป็นไปได้อยู่แล้วและข้อมูลการฝึกอบรมจะระบุคำตอบที่ถูกต้องด้วย สามารถเข้าใจได้ดังนี้ -

สมมติว่าเรามีตัวแปรอินพุต x และตัวแปรเอาต์พุต y และเราใช้อัลกอริทึมเพื่อเรียนรู้ฟังก์ชันการทำแผนที่จากอินพุตไปยังเอาต์พุตเช่น -

Y = f(x)ตอนนี้เป้าหมายหลักคือการประมาณฟังก์ชันการทำแผนที่ให้ดีเมื่อเรามีข้อมูลอินพุตใหม่ (x) เราสามารถคาดเดาตัวแปรเอาต์พุต (Y) สำหรับข้อมูลนั้นได้

ปัญหาการเอนเอียงที่ได้รับการดูแลเป็นหลักแบ่งออกเป็นปัญหาสองประเภทต่อไปนี้ -

Classification - ปัญหาเรียกว่าปัญหาการจัดหมวดหมู่เมื่อเรามีผลลัพธ์ที่จัดหมวดหมู่เช่น "ดำ" "การสอน" "ไม่ใช่การสอน" เป็นต้น

Regression - ปัญหาเรียกว่าปัญหาการถดถอยเมื่อเรามีผลลัพธ์มูลค่าจริงเช่น "ระยะทาง" "กิโลกรัม" เป็นต้น

ต้นไม้การตัดสินใจฟอเรสต์สุ่ม knn การถดถอยโลจิสติกเป็นตัวอย่างของอัลกอริทึมการเรียนรู้ของเครื่องที่อยู่ภายใต้การดูแล

อัลกอริทึมการเรียนรู้ของเครื่องที่ไม่ได้รับการดูแล

ตามชื่อที่แนะนำอัลกอริธึมแมชชีนเลิร์นนิงประเภทนี้ไม่มีหัวหน้างานคอยให้คำแนะนำใด ๆ นั่นคือเหตุผลที่อัลกอริทึมการเรียนรู้ของเครื่องที่ไม่ได้รับการดูแลมีความสอดคล้องอย่างใกล้ชิดกับสิ่งที่บางคนเรียกว่าปัญญาประดิษฐ์ที่แท้จริง สามารถเข้าใจได้ดังนี้ -

สมมติว่าเรามีตัวแปรอินพุต x จากนั้นจะไม่มีตัวแปรเอาต์พุตที่เกี่ยวข้องเนื่องจากมีอยู่ในอัลกอริทึมการเรียนรู้ภายใต้การดูแล

พูดง่ายๆก็คือเราสามารถพูดได้ว่าในการเรียนรู้ที่ไม่มีผู้ดูแลจะไม่มีคำตอบที่ถูกต้องและไม่มีครูคอยชี้แนะ อัลกอริทึมช่วยในการค้นพบรูปแบบที่น่าสนใจในข้อมูล

ปัญหาการเรียนรู้ที่ไม่ได้รับการดูแลสามารถแบ่งออกเป็นปัญหาสองประเภทต่อไปนี้ -

Clustering- ในปัญหาการจัดกลุ่มเราจำเป็นต้องค้นหาการจัดกลุ่มโดยธรรมชาติในข้อมูล ตัวอย่างเช่นการจัดกลุ่มลูกค้าตามพฤติกรรมการซื้อ

Association- ปัญหาเรียกว่าปัญหาการเชื่อมโยงเนื่องจากปัญหาประเภทนี้ต้องการการค้นพบกฎที่อธิบายข้อมูลส่วนใหญ่ของเรา ตัวอย่างเช่นการค้นหาลูกค้าที่ซื้อทั้งสองอย่างx และ y.

K-mean สำหรับการทำคลัสเตอร์อัลกอริทึม Apriori สำหรับการเชื่อมโยงเป็นตัวอย่างของอัลกอริทึมการเรียนรู้ของเครื่องที่ไม่ได้รับการดูแล

อัลกอริธึมการเรียนรู้ของเครื่องเสริมแรง

อัลกอริธึมการเรียนรู้ของเครื่องประเภทนี้ใช้น้อยมาก อัลกอริทึมเหล่านี้ฝึกระบบเพื่อทำการตัดสินใจเฉพาะ โดยทั่วไปเครื่องจะสัมผัสกับสภาพแวดล้อมที่มันฝึกฝนตัวเองอย่างต่อเนื่องโดยใช้วิธีการลองผิดลองถูก อัลกอริทึมเหล่านี้เรียนรู้จากประสบการณ์ที่ผ่านมาและพยายามรวบรวมความรู้ที่ดีที่สุดเท่าที่จะเป็นไปได้เพื่อทำการตัดสินใจที่ถูกต้อง Markov Decision Process เป็นตัวอย่างของอัลกอริธึมการเรียนรู้ของเครื่องที่เสริมกำลัง

อัลกอริทึมการเรียนรู้ของเครื่องที่พบบ่อยที่สุด

ในส่วนนี้เราจะเรียนรู้เกี่ยวกับอัลกอริทึมการเรียนรู้ของเครื่องที่พบบ่อยที่สุด อัลกอริทึมอธิบายไว้ด้านล่าง -

การถดถอยเชิงเส้น

เป็นหนึ่งในอัลกอริทึมที่เป็นที่รู้จักมากที่สุดในด้านสถิติและการเรียนรู้ของเครื่อง

แนวคิดพื้นฐาน - การถดถอยเชิงเส้นส่วนใหญ่เป็นแบบจำลองเชิงเส้นที่ถือว่าความสัมพันธ์เชิงเส้นระหว่างตัวแปรอินพุตกล่าวว่า x และตัวแปรเอาต์พุตเดี่ยวกล่าวว่า y กล่าวอีกนัยหนึ่งเราสามารถพูดได้ว่า y สามารถคำนวณได้จากการรวมเชิงเส้นของตัวแปรอินพุต x ความสัมพันธ์ระหว่างตัวแปรสามารถกำหนดได้โดยการกำหนดเส้นที่ดีที่สุด

ประเภทของการถดถอยเชิงเส้น

การถดถอยเชิงเส้นมีสองประเภทต่อไปนี้ -

Simple linear regression - อัลกอริธึมการถดถอยเชิงเส้นเรียกว่าการถดถอยเชิงเส้นอย่างง่ายหากมีตัวแปรอิสระเพียงตัวแปรเดียว

Multiple linear regression - อัลกอริทึมการถดถอยเชิงเส้นเรียกว่าการถดถอยเชิงเส้นหลายตัวแปรหากมีตัวแปรอิสระมากกว่าหนึ่งตัวแปร

การถดถอยเชิงเส้นส่วนใหญ่ใช้ในการประมาณค่าจริงตามตัวแปรต่อเนื่อง ตัวอย่างเช่นยอดขายรวมของร้านค้าในหนึ่งวันตามมูลค่าจริงสามารถประมาณได้โดยการถดถอยเชิงเส้น

การถดถอยโลจิสติก

เป็นอัลกอริทึมการจำแนกประเภทและเรียกอีกอย่างว่า logit การถดถอย

การถดถอยโลจิสติกส่วนใหญ่เป็นอัลกอริธึมการจำแนกประเภทที่ใช้ในการประมาณค่าที่ไม่ต่อเนื่องเช่น 0 หรือ 1 จริงหรือเท็จใช่หรือไม่ใช่ตามชุดของตัวแปรอิสระที่กำหนด โดยทั่วไปจะทำนายความน่าจะเป็นดังนั้นผลลัพธ์ของมันจึงอยู่ระหว่าง 0 ถึง 1

ต้นไม้ตัดสินใจ

แผนผังการตัดสินใจคืออัลกอริทึมการเรียนรู้ภายใต้การดูแลซึ่งส่วนใหญ่ใช้สำหรับปัญหาการจำแนกประเภท

โดยทั่วไปจะเป็นลักษณนามที่แสดงเป็นพาร์ติชันแบบเรียกซ้ำตามตัวแปรอิสระ ต้นไม้การตัดสินใจมีโหนดซึ่งเป็นรูปแบบของต้นไม้ที่รูท ต้นไม้ที่ถูกรูทเป็นต้นไม้ที่มีโหนดที่เรียกว่า "ราก" รูทไม่มีขอบขาเข้าและโหนดอื่น ๆ ทั้งหมดมีขอบขาเข้าเดียว โหนดเหล่านี้เรียกว่าใบไม้หรือโหนดการตัดสินใจ ตัวอย่างเช่นพิจารณาโครงสร้างการตัดสินใจต่อไปนี้เพื่อดูว่าบุคคลนั้นเหมาะสมหรือไม่

รองรับ Vector Machine (SVM)

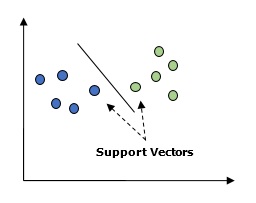

ใช้สำหรับทั้งการจำแนกประเภทและปัญหาการถดถอย แต่ส่วนใหญ่จะใช้สำหรับปัญหาการจำแนกประเภท แนวคิดหลักของ SVM คือการพล็อตรายการข้อมูลแต่ละรายการเป็นจุดในปริภูมิ n มิติโดยค่าของแต่ละคุณลักษณะเป็นค่าของพิกัดเฉพาะ นี่คือคุณสมบัติที่เราจะมี ต่อไปนี้เป็นการแสดงกราฟิกอย่างง่ายเพื่อให้เข้าใจแนวคิดของ SVM -

ในแผนภาพด้านบนเรามีคุณสมบัติสองประการดังนั้นก่อนอื่นเราต้องพล็อตตัวแปรทั้งสองนี้ในพื้นที่สองมิติโดยแต่ละจุดมีสองพิกัดเรียกว่าเวกเตอร์สนับสนุน เส้นแบ่งข้อมูลออกเป็นสองกลุ่มที่แตกต่างกัน บรรทัดนี้จะเป็นลักษณนาม

Naïve Bayes

นอกจากนี้ยังเป็นเทคนิคการจัดหมวดหมู่ ตรรกะเบื้องหลังเทคนิคการจำแนกประเภทนี้คือการใช้ทฤษฎีบทของเบย์ในการสร้างตัวแยกประเภท สมมติฐานคือตัวทำนายมีความเป็นอิสระ กล่าวง่ายๆก็คือถือว่าการมีอยู่ของคุณลักษณะเฉพาะในชั้นเรียนนั้นไม่เกี่ยวข้องกับการมีอยู่ของคุณลักษณะอื่นใด ด้านล่างนี้คือสมการสำหรับทฤษฎีบทเบย์ -

$$ P \ left (\ frac {A} {B} \ right) = \ frac {P \ left (\ frac {B} {A} \ right) P \ left (A \ right)} {P \ left ( B \ right)} $$

แบบจำลองNaïve Bayes นั้นสร้างได้ง่ายและมีประโยชน์อย่างยิ่งสำหรับชุดข้อมูลขนาดใหญ่

K- เพื่อนบ้านที่ใกล้ที่สุด (KNN)

ใช้สำหรับการจำแนกประเภทและการถดถอยของปัญหา มีการใช้กันอย่างแพร่หลายในการแก้ปัญหาการจำแนกประเภท แนวคิดหลักของอัลกอริทึมนี้คือใช้ในการจัดเก็บเคสที่มีอยู่ทั้งหมดและจำแนกเคสใหม่โดยคะแนนเสียงข้างมากของ k เพื่อนบ้าน จากนั้นกรณีจะถูกกำหนดให้กับคลาสซึ่งพบมากที่สุดในบรรดาเพื่อนบ้านที่ใกล้ที่สุด K วัดโดยฟังก์ชันระยะทาง ฟังก์ชั่นระยะทางสามารถเป็นระยะทางแบบยุคลิด, มิงโควสกีและแฮมมิง พิจารณาสิ่งต่อไปนี้เพื่อใช้ KNN -

KNN เชิงคำนวณมีราคาแพงกว่าอัลกอริทึมอื่น ๆ ที่ใช้สำหรับปัญหาการจำแนกประเภท

การทำให้เป็นมาตรฐานของตัวแปรที่จำเป็นอย่างอื่นตัวแปรช่วงที่สูงกว่าอาจทำให้เกิดอคติได้

ใน KNN เราจำเป็นต้องทำงานในขั้นตอนก่อนการประมวลผลเช่นการกำจัดเสียงรบกวน

K-mean Clustering

ตามชื่อที่แนะนำมันถูกใช้เพื่อแก้ปัญหาการทำคลัสเตอร์ โดยพื้นฐานแล้วเป็นการเรียนรู้ประเภทหนึ่งโดยไม่มีผู้ดูแล ตรรกะหลักของอัลกอริทึมการทำคลัสเตอร์ K-Means คือการจำแนกชุดข้อมูลผ่านคลัสเตอร์จำนวนหนึ่ง ทำตามขั้นตอนเหล่านี้เพื่อสร้างคลัสเตอร์โดย K-mean -

K-mean เลือกจำนวนจุด k สำหรับแต่ละคลัสเตอร์ที่เรียกว่าเซนทรอยด์

ตอนนี้แต่ละจุดข้อมูลจะสร้างคลัสเตอร์ที่มีเซนทรอยด์ใกล้เคียงที่สุดนั่นคือ k คลัสเตอร์

ตอนนี้จะพบเซนทรอยด์ของแต่ละคลัสเตอร์ตามสมาชิกคลัสเตอร์ที่มีอยู่

เราจำเป็นต้องทำซ้ำขั้นตอนเหล่านี้จนกว่าการบรรจบกันจะเกิดขึ้น

ป่าสุ่ม

เป็นอัลกอริทึมการจำแนกประเภทภายใต้การดูแล ข้อได้เปรียบของอัลกอริธึมฟอเรสต์แบบสุ่มคือสามารถใช้ได้ทั้งการจำแนกประเภทและการถดถอยของปัญหา โดยทั่วไปแล้วจะเป็นการรวบรวมต้นไม้การตัดสินใจ (เช่นป่าไม้) หรือคุณสามารถพูดได้ว่าทั้งมวลของต้นไม้แห่งการตัดสินใจ แนวคิดพื้นฐานของป่าสุ่มคือต้นไม้แต่ละชนิดให้การจำแนกประเภทและป่าจะเลือกการจำแนกประเภทที่ดีที่สุดจากพวกมัน สิ่งต่อไปนี้เป็นข้อดีของอัลกอริทึม Random Forest -

ลักษณนามฟอเรสต์แบบสุ่มสามารถใช้สำหรับงานการจำแนกประเภทและการถดถอย

พวกเขาสามารถจัดการกับค่าที่ขาดหายไป

มันจะไม่พอดีกับโมเดลแม้ว่าเราจะมีต้นไม้ในป่ามากกว่านี้ก็ตาม

เราได้ศึกษาอัลกอริธึมแมชชีนเลิร์นนิงภายใต้การควบคุมดูแลแล้ว อัลกอริทึมเหล่านี้ต้องการข้อมูลที่จัดรูปแบบเพื่อเริ่มกระบวนการฝึกอบรม เราต้องจัดเตรียมหรือจัดรูปแบบข้อมูลด้วยวิธีใดวิธีหนึ่งเพื่อให้สามารถส่งเป็นอินพุตไปยังอัลกอริทึม ML ได้

บทนี้มุ่งเน้นไปที่การเตรียมข้อมูลสำหรับอัลกอริทึมการเรียนรู้ของเครื่อง

การประมวลผลข้อมูลล่วงหน้า

ในชีวิตประจำวันของเราเราจัดการกับข้อมูลมากมาย แต่ข้อมูลนี้อยู่ในรูปแบบดิบ ในการให้ข้อมูลเป็นอินพุตของอัลกอริทึมการเรียนรู้ของเครื่องเราจำเป็นต้องแปลงเป็นข้อมูลที่มีความหมาย นั่นคือจุดที่การประมวลผลข้อมูลล่วงหน้าเป็นภาพ พูดง่ายๆก็คือเราสามารถพูดได้ว่าก่อนที่จะให้ข้อมูลกับอัลกอริทึมการเรียนรู้ของเครื่องเราจำเป็นต้องประมวลผลข้อมูลล่วงหน้า

ขั้นตอนการประมวลผลข้อมูลล่วงหน้า

ทำตามขั้นตอนเหล่านี้เพื่อประมวลผลข้อมูลล่วงหน้าใน Python -

Step 1 − Importing the useful packages - หากเราใช้ Python นี่จะเป็นขั้นตอนแรกในการแปลงข้อมูลให้อยู่ในรูปแบบที่แน่นอนเช่นการประมวลผลล่วงหน้า สามารถทำได้ดังนี้ -

import numpy as np

import sklearn.preprocessingที่นี่เราได้ใช้สองแพ็คเกจต่อไปนี้ -

NumPy - โดยทั่วไปแล้ว NumPy เป็นแพ็คเกจการประมวลผลอาร์เรย์วัตถุประสงค์ทั่วไปที่ออกแบบมาเพื่อจัดการอาร์เรย์หลายมิติขนาดใหญ่ของเร็กคอร์ดโดยพลการโดยไม่ต้องเสียความเร็วมากเกินไปสำหรับอาร์เรย์หลายมิติขนาดเล็ก

Sklearn.preprocessing - แพ็คเกจนี้มีฟังก์ชั่นยูทิลิตี้ทั่วไปมากมายและคลาสหม้อแปลงเพื่อเปลี่ยนเวกเตอร์คุณสมบัติดิบให้เป็นตัวแทนที่เหมาะสำหรับอัลกอริทึมการเรียนรู้ของเครื่อง

Step 2 − Defining sample data - หลังจากนำเข้าแพ็กเกจเราจำเป็นต้องกำหนดข้อมูลตัวอย่างบางส่วนเพื่อให้เราสามารถใช้เทคนิคการประมวลผลล่วงหน้ากับข้อมูลนั้นได้ ตอนนี้เราจะกำหนดข้อมูลตัวอย่างต่อไปนี้ -

input_data = np.array([2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8])Step3 − Applying preprocessing technique - ในขั้นตอนนี้เราจำเป็นต้องใช้เทคนิคก่อนการประมวลผลใด ๆ

ส่วนต่อไปนี้อธิบายถึงเทคนิคการประมวลผลข้อมูลล่วงหน้า

เทคนิคการประมวลผลข้อมูลล่วงหน้า

เทคนิคสำหรับการประมวลผลข้อมูลล่วงหน้าอธิบายไว้ด้านล่าง -

ไบนาไรเซชั่น

นี่คือเทคนิคก่อนการประมวลผลที่ใช้เมื่อเราต้องการแปลงค่าตัวเลขเป็นค่าบูลีน เราสามารถใช้เมธอด inbuilt เพื่อแยกข้อมูลอินพุตออกเป็นสองส่วนโดยใช้ 0.5 เป็นค่า threshold ด้วยวิธีต่อไปนี้ -

data_binarized = preprocessing.Binarizer(threshold = 0.5).transform(input_data)

print("\nBinarized data:\n", data_binarized)หลังจากรันโค้ดด้านบนแล้วเราจะได้ผลลัพธ์ต่อไปนี้ค่าทั้งหมดที่สูงกว่า 0.5 (ค่าเกณฑ์) จะถูกแปลงเป็น 1 และค่าทั้งหมดที่ต่ำกว่า 0.5 จะถูกแปลงเป็น 0

Binarized data

[[ 1. 0. 1.]

[ 0. 1. 1.]

[ 0. 0. 1.]

[ 1. 1. 0.]]หมายถึงการกำจัด

เป็นอีกหนึ่งเทคนิคก่อนการประมวลผลทั่วไปที่ใช้ในการเรียนรู้ของเครื่อง โดยทั่วไปจะใช้เพื่อกำจัดค่าเฉลี่ยจากเวกเตอร์คุณลักษณะเพื่อให้ทุกคุณลักษณะมีศูนย์กลางอยู่ที่ศูนย์ เรายังสามารถลบอคติออกจากคุณลักษณะในเวกเตอร์คุณลักษณะ สำหรับการใช้เทคนิคการประมวลผลก่อนการลบค่าเฉลี่ยกับข้อมูลตัวอย่างเราสามารถเขียนโค้ด Python ที่แสดงด้านล่าง รหัสจะแสดงค่าเฉลี่ยและค่าเบี่ยงเบนมาตรฐานของข้อมูลอินพุต -

print("Mean = ", input_data.mean(axis = 0))

print("Std deviation = ", input_data.std(axis = 0))เราจะได้ผลลัพธ์ต่อไปนี้หลังจากเรียกใช้โค้ดด้านบน -

Mean = [ 1.75 -1.275 2.2]

Std deviation = [ 2.71431391 4.20022321 4.69414529]ตอนนี้โค้ดด้านล่างจะลบค่าเฉลี่ยและค่าเบี่ยงเบนมาตรฐานของข้อมูลอินพุต -

data_scaled = preprocessing.scale(input_data)

print("Mean =", data_scaled.mean(axis=0))

print("Std deviation =", data_scaled.std(axis = 0))เราจะได้ผลลัพธ์ต่อไปนี้หลังจากเรียกใช้โค้ดด้านบน -

Mean = [ 1.11022302e-16 0.00000000e+00 0.00000000e+00]

Std deviation = [ 1. 1. 1.]การปรับขนาด

เป็นอีกหนึ่งเทคนิคการประมวลผลข้อมูลล่วงหน้าที่ใช้ในการปรับขนาดเวกเตอร์คุณลักษณะ จำเป็นต้องมีการปรับขนาดของเวกเตอร์คุณลักษณะเนื่องจากค่าของทุกคุณลักษณะอาจแตกต่างกันไประหว่างค่าสุ่มจำนวนมาก กล่าวอีกนัยหนึ่งเราสามารถพูดได้ว่าการปรับขนาดมีความสำคัญเนื่องจากเราไม่ต้องการให้คุณลักษณะใด ๆ มีขนาดใหญ่หรือเล็กในเชิงสังเคราะห์ ด้วยความช่วยเหลือของรหัส Python ต่อไปนี้เราสามารถทำการปรับขนาดข้อมูลอินพุตของเราได้เช่นเวกเตอร์คุณลักษณะ -

# Min max scaling

data_scaler_minmax = preprocessing.MinMaxScaler(feature_range=(0,1))

data_scaled_minmax = data_scaler_minmax.fit_transform(input_data)

print ("\nMin max scaled data:\n", data_scaled_minmax)เราจะได้ผลลัพธ์ต่อไปนี้หลังจากเรียกใช้โค้ดด้านบน -

Min max scaled data

[ [ 0.48648649 0.58252427 0.99122807]

[ 0. 1. 0.81578947]

[ 0.27027027 0. 1. ]

[ 1. 0. 99029126 0. ]]Normalization

เป็นอีกหนึ่งเทคนิคการประมวลผลข้อมูลล่วงหน้าที่ใช้ในการปรับเปลี่ยนเวกเตอร์คุณลักษณะ การปรับเปลี่ยนประเภทดังกล่าวจำเป็นในการวัดเวกเตอร์คุณลักษณะในมาตราส่วนทั่วไป สิ่งต่อไปนี้คือการทำให้เป็นมาตรฐานสองประเภทซึ่งสามารถใช้ในการเรียนรู้ของเครื่อง -

L1 Normalization

นอกจากนี้ยังเรียกว่า Least Absolute Deviations. การนอร์มัลไลเซชันประเภทนี้จะปรับเปลี่ยนค่าเพื่อให้ผลรวมของค่าสัมบูรณ์เป็น 1 ในแต่ละแถวเสมอ สามารถนำไปใช้กับข้อมูลอินพุตด้วยความช่วยเหลือของรหัส Python ต่อไปนี้ -

# Normalize data

data_normalized_l1 = preprocessing.normalize(input_data, norm = 'l1')

print("\nL1 normalized data:\n", data_normalized_l1)บรรทัดด้านบนของโค้ดจะสร้างผลลัพธ์ต่อไปนี้ & miuns;

L1 normalized data:

[[ 0.22105263 -0.2 0.57894737]

[ -0.2027027 0.32432432 0.47297297]

[ 0.03571429 -0.56428571 0.4 ]

[ 0.42142857 0.16428571 -0.41428571]]L2 Normalization

นอกจากนี้ยังเรียกว่า least squares. การนอร์มัลไลเซชันประเภทนี้จะแก้ไขค่าเพื่อให้ผลรวมของกำลังสองเป็น 1 ในแต่ละแถวเสมอ สามารถนำไปใช้กับข้อมูลอินพุตด้วยความช่วยเหลือของรหัส Python ต่อไปนี้ -

# Normalize data

data_normalized_l2 = preprocessing.normalize(input_data, norm = 'l2')

print("\nL2 normalized data:\n", data_normalized_l2)บรรทัดโค้ดด้านบนจะสร้างผลลัพธ์ต่อไปนี้ -

L2 normalized data:

[[ 0.33946114 -0.30713151 0.88906489]

[ -0.33325106 0.53320169 0.7775858 ]

[ 0.05156558 -0.81473612 0.57753446]

[ 0.68706914 0.26784051 -0.6754239 ]]การติดฉลากข้อมูล

เราทราบแล้วว่าข้อมูลในรูปแบบหนึ่งจำเป็นสำหรับอัลกอริทึมการเรียนรู้ของเครื่อง ข้อกำหนดที่สำคัญอีกประการหนึ่งคือข้อมูลต้องได้รับการติดฉลากอย่างถูกต้องก่อนที่จะส่งเป็นอินพุตของอัลกอริทึมการเรียนรู้ของเครื่อง ตัวอย่างเช่นหากเราพูดถึงการจัดหมวดหมู่ข้อมูลมีป้ายกำกับจำนวนมาก ป้ายกำกับเหล่านั้นอยู่ในรูปของคำตัวเลข ฯลฯ ฟังก์ชันที่เกี่ยวข้องกับการเรียนรู้ของเครื่องในsklearnคาดว่าข้อมูลจะต้องมีป้ายกำกับตัวเลข ดังนั้นหากข้อมูลอยู่ในรูปแบบอื่นก็จะต้องถูกแปลงเป็นตัวเลข กระบวนการเปลี่ยนป้ายคำให้เป็นรูปแบบตัวเลขนี้เรียกว่าการเข้ารหัสฉลาก

ขั้นตอนการเข้ารหัสฉลาก

ทำตามขั้นตอนเหล่านี้เพื่อเข้ารหัสป้ายกำกับข้อมูลใน Python -

Step1 − Importing the useful packages

ถ้าเราใช้ Python นี่จะเป็นขั้นตอนแรกในการแปลงข้อมูลให้อยู่ในรูปแบบที่แน่นอนนั่นคือการประมวลผลล่วงหน้า สามารถทำได้ดังนี้ -

import numpy as np

from sklearn import preprocessingStep 2 − Defining sample labels

หลังจากนำเข้าแพ็กเกจเราจำเป็นต้องกำหนดป้ายกำกับตัวอย่างเพื่อที่เราจะสามารถสร้างและฝึกตัวเข้ารหัสฉลากได้ ตอนนี้เราจะกำหนดป้ายกำกับตัวอย่างต่อไปนี้ -

# Sample input labels

input_labels = ['red','black','red','green','black','yellow','white']Step 3 − Creating & training of label encoder object

ในขั้นตอนนี้เราต้องสร้างตัวเข้ารหัสฉลากและฝึกมัน รหัส Python ต่อไปนี้จะช่วยในการทำสิ่งนี้ -

# Creating the label encoder

encoder = preprocessing.LabelEncoder()

encoder.fit(input_labels)ต่อไปนี้จะเป็นผลลัพธ์หลังจากรันโค้ด Python ด้านบน -

LabelEncoder()Step4 − Checking the performance by encoding random ordered list

ขั้นตอนนี้สามารถใช้เพื่อตรวจสอบประสิทธิภาพโดยการเข้ารหัสรายการที่เรียงลำดับแบบสุ่ม สามารถเขียนโค้ด Python ต่อไปนี้เพื่อทำเช่นเดียวกัน -

# encoding a set of labels

test_labels = ['green','red','black']

encoded_values = encoder.transform(test_labels)

print("\nLabels =", test_labels)ฉลากจะได้รับการพิมพ์ดังนี้ -

Labels = ['green', 'red', 'black']ตอนนี้เราสามารถรับรายการค่าที่เข้ารหัสเช่นป้ายคำที่แปลงเป็นตัวเลขได้ดังนี้ -

print("Encoded values =", list(encoded_values))ค่าที่เข้ารหัสจะได้รับการพิมพ์ดังนี้ -

Encoded values = [1, 2, 0]Step 5 − Checking the performance by decoding a random set of numbers −

ขั้นตอนนี้สามารถใช้เพื่อตรวจสอบประสิทธิภาพโดยการถอดรหัสชุดตัวเลขแบบสุ่ม สามารถเขียนโค้ด Python ต่อไปนี้เพื่อทำเช่นเดียวกัน -

# decoding a set of values

encoded_values = [3,0,4,1]

decoded_list = encoder.inverse_transform(encoded_values)

print("\nEncoded values =", encoded_values)ตอนนี้ค่าที่เข้ารหัสจะถูกพิมพ์ออกมาดังนี้ -

Encoded values = [3, 0, 4, 1]

print("\nDecoded labels =", list(decoded_list))ตอนนี้ค่าที่ถอดรหัสจะได้รับการพิมพ์ดังนี้ -

Decoded labels = ['white', 'black', 'yellow', 'green']ติดป้ายกำกับ v / s ข้อมูลที่ไม่มีป้ายกำกับ

ข้อมูลที่ไม่มีป้ายกำกับส่วนใหญ่ประกอบด้วยตัวอย่างของวัตถุตามธรรมชาติหรือที่มนุษย์สร้างขึ้นซึ่งหาได้ง่ายจากโลก ซึ่งรวมถึงเสียงวิดีโอภาพถ่ายบทความข่าว ฯลฯ

ในทางกลับกันข้อมูลที่มีป้ายกำกับจะใช้ชุดข้อมูลที่ไม่มีป้ายกำกับและเพิ่มข้อมูลแต่ละส่วนที่ไม่มีป้ายกำกับด้วยแท็กหรือป้ายกำกับหรือคลาสที่มีความหมาย ตัวอย่างเช่นถ้าเรามีรูปถ่ายก็สามารถใส่ป้ายกำกับได้ตามเนื้อหาของรูปถ่ายนั่นคือรูปเด็กผู้ชายหรือเด็กผู้หญิงหรือสัตว์หรืออะไรก็ได้ การติดฉลากข้อมูลจำเป็นต้องอาศัยความเชี่ยวชาญของมนุษย์หรือการตัดสินใจเกี่ยวกับข้อมูลที่ไม่มีป้ายกำกับ

มีหลายสถานการณ์ที่ข้อมูลที่ไม่มีป้ายกำกับมีอยู่มากมายและหาได้ง่าย แต่ข้อมูลที่มีป้ายกำกับมักต้องใช้บุคคล / ผู้เชี่ยวชาญในการใส่คำอธิบายประกอบ การเรียนรู้แบบกึ่งมีผู้ดูแลพยายามรวมข้อมูลที่มีป้ายกำกับและไม่มีป้ายกำกับเพื่อสร้างแบบจำลองที่ดีขึ้น

ในบทนี้เราจะมุ่งเน้นไปที่การใช้การเรียนรู้ภายใต้การดูแล - การจำแนกประเภท

เทคนิคการจำแนกประเภทหรือแบบจำลองพยายามหาข้อสรุปจากค่าที่สังเกตได้ ในปัญหาการจัดหมวดหมู่เรามีผลลัพธ์ที่จัดหมวดหมู่เช่น“ ดำ” หรือ“ ขาว” หรือ“ การสอน” และ“ ไม่ใช่การสอน” ในขณะที่สร้างโมเดลการจำแนกเราจำเป็นต้องมีชุดข้อมูลการฝึกอบรมที่มีจุดข้อมูลและป้ายกำกับที่เกี่ยวข้อง ตัวอย่างเช่นหากเราต้องการตรวจสอบว่าภาพนั้นเป็นของรถยนต์หรือไม่ สำหรับการตรวจสอบสิ่งนี้เราจะสร้างชุดข้อมูลการฝึกอบรมโดยมีสองคลาสที่เกี่ยวข้องกับ "รถ" และ "ไม่มีรถ" จากนั้นเราต้องฝึกโมเดลโดยใช้ตัวอย่างการฝึกอบรม รูปแบบการจำแนกประเภทส่วนใหญ่จะใช้ในการจดจำใบหน้าการระบุสแปมและอื่น ๆ

ขั้นตอนในการสร้างลักษณนามใน Python

สำหรับการสร้างลักษณนามใน Python เราจะใช้ Python 3 และ Scikit-learn ซึ่งเป็นเครื่องมือสำหรับการเรียนรู้ของเครื่อง ทำตามขั้นตอนเหล่านี้เพื่อสร้างลักษณนามใน Python -

ขั้นตอนที่ 1 - นำเข้า Scikit-learn

นี่เป็นขั้นตอนแรกสำหรับการสร้างลักษณนามใน Python ในขั้นตอนนี้เราจะติดตั้งแพ็คเกจ Python ที่เรียกว่า Scikit-learn ซึ่งเป็นหนึ่งในโมดูลการเรียนรู้ของเครื่องที่ดีที่สุดใน Python คำสั่งต่อไปนี้จะช่วยเรานำเข้าแพ็คเกจ -

Import Sklearnขั้นตอนที่ 2 - นำเข้าชุดข้อมูลของ Scikit-learn

ในขั้นตอนนี้เราสามารถเริ่มทำงานกับชุดข้อมูลสำหรับโมเดลแมชชีนเลิร์นนิงของเราได้ ที่นี่เราจะใช้the ฐานข้อมูลการวินิจฉัยมะเร็งเต้านมวิสคอนซิน ชุดข้อมูลประกอบด้วยข้อมูลต่างๆเกี่ยวกับเนื้องอกมะเร็งเต้านมและฉลากการจำแนกประเภทของmalignant หรือ benign. ชุดข้อมูลมี 569 อินสแตนซ์หรือข้อมูลเกี่ยวกับเนื้องอก 569 ชิ้นและมีข้อมูลเกี่ยวกับคุณลักษณะหรือคุณลักษณะ 30 อย่างเช่นรัศมีของเนื้องอกพื้นผิวความเรียบเนียนและพื้นที่ ด้วยความช่วยเหลือของคำสั่งต่อไปนี้เราสามารถนำเข้าชุดข้อมูลมะเร็งเต้านมของ Scikit-learn -

from sklearn.datasets import load_breast_cancerตอนนี้คำสั่งต่อไปนี้จะโหลดชุดข้อมูล

data = load_breast_cancer()ต่อไปนี้เป็นรายการคีย์พจนานุกรมที่สำคัญ -

- ชื่อป้ายกำกับการจำแนก (target_names)

- ป้ายกำกับจริง (เป้าหมาย)

- ชื่อแอตทริบิวต์ / คุณลักษณะ (feature_names)

- แอตทริบิวต์ (ข้อมูล)

ตอนนี้ด้วยความช่วยเหลือของคำสั่งต่อไปนี้เราสามารถสร้างตัวแปรใหม่สำหรับชุดข้อมูลที่สำคัญแต่ละชุดและกำหนดข้อมูลได้ กล่าวอีกนัยหนึ่งเราสามารถจัดระเบียบข้อมูลด้วยคำสั่งต่อไปนี้ -

label_names = data['target_names']

labels = data['target']

feature_names = data['feature_names']

features = data['data']ตอนนี้เพื่อให้ชัดเจนขึ้นเราสามารถพิมพ์ฉลากคลาสฉลากของอินสแตนซ์ข้อมูลแรกชื่อคุณลักษณะและค่าของคุณลักษณะด้วยความช่วยเหลือของคำสั่งต่อไปนี้ -

print(label_names)คำสั่งดังกล่าวจะพิมพ์ชื่อคลาสที่ร้ายกาจและอ่อนโยนตามลำดับ แสดงเป็นผลลัพธ์ด้านล่าง -

['malignant' 'benign']ตอนนี้คำสั่งด้านล่างจะแสดงว่ามีการแมปกับค่าไบนารี 0 และ 1 ในที่นี้ 0 หมายถึงมะเร็งร้ายและ 1 หมายถึงมะเร็งที่อ่อนโยน คุณจะได้รับผลลัพธ์ต่อไปนี้ -

print(labels[0])

0คำสั่งสองคำสั่งด้านล่างนี้จะสร้างชื่อคุณลักษณะและค่าคุณลักษณะ

print(feature_names[0])

mean radius

print(features[0])

[ 1.79900000e+01 1.03800000e+01 1.22800000e+02 1.00100000e+03

1.18400000e-01 2.77600000e-01 3.00100000e-01 1.47100000e-01

2.41900000e-01 7.87100000e-02 1.09500000e+00 9.05300000e-01

8.58900000e+00 1.53400000e+02 6.39900000e-03 4.90400000e-02

5.37300000e-02 1.58700000e-02 3.00300000e-02 6.19300000e-03

2.53800000e+01 1.73300000e+01 1.84600000e+02 2.01900000e+03

1.62200000e-01 6.65600000e-01 7.11900000e-01 2.65400000e-01

4.60100000e-01 1.18900000e-01]จากผลลัพธ์ข้างต้นเราจะเห็นว่าอินสแตนซ์ข้อมูลแรกเป็นเนื้องอกมะเร็งซึ่งมีรัศมี 1.7990000e + 01

ขั้นตอนที่ 3 - จัดระเบียบข้อมูลเป็นชุด

ในขั้นตอนนี้เราจะแบ่งข้อมูลของเราออกเป็นสองส่วนคือชุดฝึกและชุดทดสอบ การแบ่งข้อมูลออกเป็นชุดมีความสำคัญมากเพราะเราต้องทดสอบโมเดลของเรากับข้อมูลที่มองไม่เห็น ในการแบ่งข้อมูลออกเป็นชุด sklearn มีฟังก์ชันที่เรียกว่าtrain_test_split()ฟังก์ชัน ด้วยความช่วยเหลือของคำสั่งต่อไปนี้เราสามารถแบ่งข้อมูลในชุดเหล่านี้ -

from sklearn.model_selection import train_test_splitคำสั่งดังกล่าวจะนำเข้าไฟล์ train_test_splitฟังก์ชั่นจาก sklearn และคำสั่งด้านล่างจะแบ่งข้อมูลออกเป็นข้อมูลการฝึกอบรมและการทดสอบ ในตัวอย่างด้านล่างนี้เรากำลังใช้ข้อมูล 40% สำหรับการทดสอบและข้อมูลที่เหลือจะใช้สำหรับการฝึกโมเดล

train, test, train_labels, test_labels = train_test_split(features,labels,test_size = 0.40, random_state = 42)ขั้นตอนที่ 4 - การสร้างแบบจำลอง

ในขั้นตอนนี้เราจะสร้างแบบจำลองของเรา เราจะใช้อัลกอริทึมNaïve Bayes ในการสร้างแบบจำลอง คำสั่งต่อไปนี้สามารถใช้เพื่อสร้างแบบจำลอง -

from sklearn.naive_bayes import GaussianNBคำสั่งดังกล่าวจะนำเข้าโมดูล GaussianNB ตอนนี้คำสั่งต่อไปนี้จะช่วยคุณเริ่มต้นโมเดล

gnb = GaussianNB()เราจะฝึกโมเดลโดยปรับให้พอดีกับข้อมูลโดยใช้ gnb.fit ()

model = gnb.fit(train, train_labels)ขั้นตอนที่ 5 - การประเมินโมเดลและความแม่นยำ

ในขั้นตอนนี้เราจะประเมินแบบจำลองโดยทำการคาดคะเนข้อมูลการทดสอบของเรา จากนั้นเราจะพบความแม่นยำของมันด้วย สำหรับการทำนายเราจะใช้ฟังก์ชัน Predict () คำสั่งต่อไปนี้จะช่วยคุณทำสิ่งนี้ -

preds = gnb.predict(test)

print(preds)

[1 0 0 1 1 0 0 0 1 1 1 0 1 0 1 0 1 1 1 0 1 1 0 1 1 1 1 1 1

0 1 1 1 1 1 1 0 1 0 1 1 0 1 1 1 1 1 1 1 1 0 0 1 1 1 1 1 0

0 1 1 0 0 1 1 1 0 0 1 1 0 0 1 0 1 1 1 1 1 1 0 1 1 0 0 0 0

0 1 1 1 1 1 1 1 1 0 0 1 0 0 1 0 0 1 1 1 0 1 1 0 1 1 0 0 0

1 1 1 0 0 1 1 0 1 0 0 1 1 0 0 0 1 1 1 0 1 1 0 0 1 0 1 1 0

1 0 0 1 1 1 1 1 1 1 0 0 1 1 1 1 1 1 1 1 1 1 1 1 0 1 1 1 0

1 1 0 1 1 1 1 1 1 0 0 0 1 1 0 1 0 1 1 1 1 0 1 1 0 1 1 1 0

1 0 0 1 1 1 1 1 1 1 1 0 1 1 1 1 1 0 1 0 0 1 1 0 1]ชุด 0 และ 1 ข้างต้นเป็นค่าที่คาดการณ์ไว้สำหรับชั้นเนื้องอก - ร้ายและไม่เป็นพิษเป็นภัย

ตอนนี้โดยการเปรียบเทียบสองอาร์เรย์คือ test_labels และ predsเราสามารถค้นหาความแม่นยำของแบบจำลองของเราได้ เราจะใช้ไฟล์accuracy_score()ฟังก์ชันเพื่อกำหนดความถูกต้อง พิจารณาคำสั่งต่อไปนี้สำหรับสิ่งนี้ -

from sklearn.metrics import accuracy_score

print(accuracy_score(test_labels,preds))

0.951754385965ผลลัพธ์แสดงให้เห็นว่าลักษณนามNaïveBayesมีความแม่นยำ 95.17%

ด้วยวิธีนี้ด้วยความช่วยเหลือของขั้นตอนข้างต้นเราสามารถสร้างลักษณนามของเราใน Python

Building Classifier ใน Python

ในส่วนนี้เราจะเรียนรู้วิธีการสร้างลักษณนามใน Python

ลักษณนามNaïve Bayes

Naïve Bayes เป็นเทคนิคการจำแนกประเภทที่ใช้ในการสร้างลักษณนามโดยใช้ทฤษฎีบทเบย์ สมมติฐานคือตัวทำนายมีความเป็นอิสระ กล่าวง่ายๆก็คือถือว่าการมีอยู่ของคุณลักษณะเฉพาะในชั้นเรียนนั้นไม่เกี่ยวข้องกับการมีอยู่ของคุณลักษณะอื่นใด สำหรับการสร้างลักษณนามNaïve Bayes เราจำเป็นต้องใช้ python library ที่เรียกว่า scikit learn โมเดลNaïve Bayes มีสามประเภทGaussian, Multinomial and Bernoulli ภายใต้แพ็คเกจการเรียนรู้ scikit

ในการสร้างโมเดลลักษณนามการเรียนรู้ของเครื่องNaïve Bayes เราต้องมีสิ่งต่อไปนี้ & ลบ

ชุดข้อมูล

เราจะใช้ชุดข้อมูลที่ชื่อว่าBreast Cancer Wisconsin Diagnostic Database ชุดข้อมูลประกอบด้วยข้อมูลต่างๆเกี่ยวกับเนื้องอกมะเร็งเต้านมและฉลากการจำแนกประเภทของmalignant หรือ benign. ชุดข้อมูลมี 569 อินสแตนซ์หรือข้อมูลเกี่ยวกับเนื้องอก 569 ชิ้นและมีข้อมูลเกี่ยวกับคุณลักษณะหรือคุณลักษณะ 30 อย่างเช่นรัศมีของเนื้องอกพื้นผิวความเรียบเนียนและพื้นที่ เราสามารถนำเข้าชุดข้อมูลนี้จากแพ็คเกจ sklearn

Naïve Bayes Model

สำหรับการสร้างลักษณนามNaïve Bayes เราต้องการแบบจำลองNaïve Bayes อย่างที่บอกไปก่อนหน้านี้มีชื่อรุ่นNaïve Bayes อยู่สามประเภทGaussian, Multinomial และ Bernoulliภายใต้แพ็คเกจการเรียนรู้ scikit ในตัวอย่างต่อไปนี้เราจะใช้แบบจำลอง Gaussian Naïve Bayes

ด้วยการใช้ข้างต้นเราจะสร้างแบบจำลองการเรียนรู้ของเครื่อง Na useve Bayes เพื่อใช้ข้อมูลเนื้องอกในการทำนายว่าเนื้องอกเป็นมะเร็งหรือไม่เป็นพิษ

ในการเริ่มต้นเราต้องติดตั้งโมดูล sklearn สามารถทำได้ด้วยความช่วยเหลือของคำสั่งต่อไปนี้ -

Import Sklearnตอนนี้เราต้องนำเข้าชุดข้อมูลที่ชื่อว่า Breast Cancer Wisconsin Diagnostic Database

from sklearn.datasets import load_breast_cancerตอนนี้คำสั่งต่อไปนี้จะโหลดชุดข้อมูล

data = load_breast_cancer()สามารถจัดระเบียบข้อมูลได้ดังนี้ -

label_names = data['target_names']

labels = data['target']

feature_names = data['feature_names']

features = data['data']ตอนนี้เพื่อให้ชัดเจนขึ้นเราสามารถพิมพ์ฉลากคลาสฉลากของอินสแตนซ์ข้อมูลแรกชื่อคุณลักษณะและค่าของคุณลักษณะได้ด้วยความช่วยเหลือของคำสั่งต่อไปนี้ -

print(label_names)คำสั่งดังกล่าวจะพิมพ์ชื่อคลาสที่ร้ายกาจและอ่อนโยนตามลำดับ แสดงเป็นผลลัพธ์ด้านล่าง -

['malignant' 'benign']ตอนนี้คำสั่งที่ระบุด้านล่างจะแสดงว่ามีการแมปกับค่าไบนารี 0 และ 1 ในที่นี้ 0 หมายถึงมะเร็งร้ายและ 1 หมายถึงมะเร็งที่ไม่เป็นพิษเป็นภัย แสดงเป็นผลลัพธ์ด้านล่าง -

print(labels[0])

0คำสั่งสองคำสั่งต่อไปนี้จะสร้างชื่อคุณลักษณะและค่าคุณลักษณะ

print(feature_names[0])

mean radius

print(features[0])

[ 1.79900000e+01 1.03800000e+01 1.22800000e+02 1.00100000e+03

1.18400000e-01 2.77600000e-01 3.00100000e-01 1.47100000e-01

2.41900000e-01 7.87100000e-02 1.09500000e+00 9.05300000e-01

8.58900000e+00 1.53400000e+02 6.39900000e-03 4.90400000e-02

5.37300000e-02 1.58700000e-02 3.00300000e-02 6.19300000e-03

2.53800000e+01 1.73300000e+01 1.84600000e+02 2.01900000e+03

1.62200000e-01 6.65600000e-01 7.11900000e-01 2.65400000e-01

4.60100000e-01 1.18900000e-01]จากผลลัพธ์ข้างต้นเราจะเห็นว่าอินสแตนซ์ข้อมูลแรกเป็นเนื้องอกมะเร็งซึ่งรัศมีหลักคือ 1.7990000e + 01

สำหรับการทดสอบโมเดลของเรากับข้อมูลที่มองไม่เห็นเราจำเป็นต้องแยกข้อมูลของเราออกเป็นข้อมูลการฝึกอบรมและการทดสอบ สามารถทำได้ด้วยความช่วยเหลือของรหัสต่อไปนี้ -

from sklearn.model_selection import train_test_splitคำสั่งดังกล่าวจะนำเข้าไฟล์ train_test_splitฟังก์ชั่นจาก sklearn และคำสั่งด้านล่างจะแบ่งข้อมูลออกเป็นข้อมูลการฝึกอบรมและการทดสอบ ในตัวอย่างด้านล่างเราใช้ 40% ของข้อมูลสำหรับการทดสอบและข้อมูลการปรับปรุงจะถูกใช้สำหรับการฝึกโมเดล

train, test, train_labels, test_labels =

train_test_split(features,labels,test_size = 0.40, random_state = 42)ตอนนี้เรากำลังสร้างโมเดลด้วยคำสั่งต่อไปนี้ -

from sklearn.naive_bayes import GaussianNBคำสั่งดังกล่าวจะนำเข้าไฟล์ GaussianNBโมดูล. ตอนนี้ด้วยคำสั่งที่ระบุด้านล่างเราจำเป็นต้องเริ่มต้นโมเดล

gnb = GaussianNB()เราจะฝึกโมเดลโดยปรับให้พอดีกับข้อมูลโดยใช้ gnb.fit().

model = gnb.fit(train, train_labels)ตอนนี้ประเมินแบบจำลองโดยทำการคาดคะเนข้อมูลการทดสอบและสามารถทำได้ดังนี้ -

preds = gnb.predict(test)

print(preds)

[1 0 0 1 1 0 0 0 1 1 1 0 1 0 1 0 1 1 1 0 1 1 0 1 1 1 1 1 1

0 1 1 1 1 1 1 0 1 0 1 1 0 1 1 1 1 1 1 1 1 0 0 1 1 1 1 1 0

0 1 1 0 0 1 1 1 0 0 1 1 0 0 1 0 1 1 1 1 1 1 0 1 1 0 0 0 0

0 1 1 1 1 1 1 1 1 0 0 1 0 0 1 0 0 1 1 1 0 1 1 0 1 1 0 0 0

1 1 1 0 0 1 1 0 1 0 0 1 1 0 0 0 1 1 1 0 1 1 0 0 1 0 1 1 0

1 0 0 1 1 1 1 1 1 1 0 0 1 1 1 1 1 1 1 1 1 1 1 1 0 1 1 1 0

1 1 0 1 1 1 1 1 1 0 0 0 1 1 0 1 0 1 1 1 1 0 1 1 0 1 1 1 0

1 0 0 1 1 1 1 1 1 1 1 0 1 1 1 1 1 0 1 0 0 1 1 0 1]ชุด 0 และ 1 ข้างต้นเป็นค่าที่คาดการณ์ไว้สำหรับชั้นเนื้องอกเช่นมะเร็งและไม่เป็นพิษเป็นภัย

ตอนนี้โดยการเปรียบเทียบสองอาร์เรย์คือ test_labels และ predsเราสามารถค้นหาความแม่นยำของแบบจำลองของเราได้ เราจะใช้ไฟล์accuracy_score()ฟังก์ชันเพื่อกำหนดความถูกต้อง พิจารณาคำสั่งต่อไปนี้ -

from sklearn.metrics import accuracy_score

print(accuracy_score(test_labels,preds))

0.951754385965ผลลัพธ์แสดงให้เห็นว่าลักษณนามNaïveBayesมีความแม่นยำ 95.17%

นั่นคือลักษณนามแมชชีนเลิร์นนิงตามแบบจำลองNaïve Bayse Gaussian

รองรับ Vector Machines (SVM)

โดยพื้นฐานแล้ว Support vector machine (SVM) เป็นอัลกอริธึมการเรียนรู้ของเครื่องที่อยู่ภายใต้การดูแลซึ่งสามารถใช้ได้ทั้งการถดถอยและการจำแนกประเภท แนวคิดหลักของ SVM คือการพล็อตรายการข้อมูลแต่ละรายการเป็นจุดในปริภูมิ n มิติโดยค่าของแต่ละคุณลักษณะเป็นค่าของพิกัดเฉพาะ นี่คือคุณสมบัติที่เราจะมี ต่อไปนี้เป็นการแสดงกราฟิกอย่างง่ายเพื่อให้เข้าใจแนวคิดของ SVM -

ในแผนภาพด้านบนเรามีคุณสมบัติสองประการ ดังนั้นก่อนอื่นเราต้องพล็อตตัวแปรทั้งสองนี้ในพื้นที่สองมิติโดยแต่ละจุดมีสองพิกัดเรียกว่าเวกเตอร์สนับสนุน เส้นแบ่งข้อมูลออกเป็นสองกลุ่มที่แตกต่างกัน บรรทัดนี้จะเป็นลักษณนาม

ที่นี่เราจะสร้างตัวจำแนก SVM โดยใช้ชุดข้อมูล scikit-learn และ iris ห้องสมุด Scikitlearn มีไฟล์sklearn.svmโมดูลและจัดเตรียม sklearn.svm.svc สำหรับการจำแนกประเภท ลักษณนาม SVM เพื่อทำนายคลาสของพืชไอริสตามคุณสมบัติ 4 ประการดังแสดงด้านล่าง

ชุดข้อมูล

เราจะใช้ชุดข้อมูลไอริสซึ่งมี 3 คลาสละ 50 อินสแตนซ์โดยแต่ละคลาสหมายถึงพืชไอริสชนิดหนึ่ง แต่ละอินสแตนซ์มีคุณสมบัติสี่ประการ ได้แก่ ความยาวกลีบเลี้ยงความกว้างของกลีบเลี้ยงความยาวกลีบดอกและความกว้างของกลีบดอก ลักษณนาม SVM เพื่อทำนายคลาสของพืชไอริสตามคุณสมบัติ 4 ประการดังแสดงด้านล่าง

เคอร์เนล

เป็นเทคนิคที่ SVM ใช้ โดยพื้นฐานแล้วนี่คือฟังก์ชันที่ใช้พื้นที่อินพุตมิติต่ำและเปลี่ยนเป็นพื้นที่มิติที่สูงขึ้น จะแปลงปัญหาที่ไม่สามารถแยกออกเป็นปัญหาที่แยกออกจากกันได้ ฟังก์ชันเคอร์เนลสามารถเป็นฟังก์ชันใดก็ได้ระหว่าง linear, polynomial, rbf และ sigmoid ในตัวอย่างนี้เราจะใช้เคอร์เนลเชิงเส้น

ให้เรานำเข้าแพ็คเกจต่อไปนี้ -

import pandas as pd

import numpy as np

from sklearn import svm, datasets

import matplotlib.pyplot as pltตอนนี้โหลดข้อมูลอินพุต -

iris = datasets.load_iris()เรากำลังใช้คุณสมบัติสองประการแรก -

X = iris.data[:, :2]

y = iris.targetเราจะพล็อตขอบเขตเครื่องเวกเตอร์สนับสนุนด้วยข้อมูลต้นฉบับ เรากำลังสร้างตาข่ายเพื่อลงจุด

x_min, x_max = X[:, 0].min() - 1, X[:, 0].max() + 1

y_min, y_max = X[:, 1].min() - 1, X[:, 1].max() + 1

h = (x_max / x_min)/100

xx, yy = np.meshgrid(np.arange(x_min, x_max, h),

np.arange(y_min, y_max, h))

X_plot = np.c_[xx.ravel(), yy.ravel()]เราจำเป็นต้องให้ค่าของพารามิเตอร์การทำให้เป็นมาตรฐาน

C = 1.0เราจำเป็นต้องสร้างวัตถุลักษณนาม SVM

Svc_classifier = svm_classifier.SVC(kernel='linear',

C=C, decision_function_shape = 'ovr').fit(X, y)

Z = svc_classifier.predict(X_plot)

Z = Z.reshape(xx.shape)

plt.figure(figsize = (15, 5))

plt.subplot(121)

plt.contourf(xx, yy, Z, cmap = plt.cm.tab10, alpha = 0.3)

plt.scatter(X[:, 0], X[:, 1], c = y, cmap = plt.cm.Set1)

plt.xlabel('Sepal length')

plt.ylabel('Sepal width')

plt.xlim(xx.min(), xx.max())

plt.title('SVC with linear kernel')

การถดถอยโลจิสติก

โดยพื้นฐานแล้วแบบจำลองการถดถอยโลจิสติกเป็นหนึ่งในสมาชิกของกลุ่มอัลกอริธึมการจำแนกประเภทภายใต้การดูแล การถดถอยโลจิสติกจะวัดความสัมพันธ์ระหว่างตัวแปรตามและตัวแปรอิสระโดยการประมาณความน่าจะเป็นโดยใช้ฟังก์ชันโลจิสติกส์

ที่นี่ถ้าเราพูดถึงตัวแปรตามและตัวแปรอิสระตัวแปรตามคือตัวแปรคลาสเป้าหมายที่เราจะทำนายและอีกด้านหนึ่งตัวแปรอิสระคือคุณสมบัติที่เราจะใช้ในการทำนายคลาสเป้าหมาย

ในการถดถอยโลจิสติกการประมาณความน่าจะเป็นหมายถึงการทำนายโอกาสที่จะเกิดเหตุการณ์ ตัวอย่างเช่นเจ้าของร้านต้องการทำนายว่าลูกค้าที่เข้ามาในร้านจะซื้อ play station (เป็นต้น) หรือไม่ จะมีคุณสมบัติหลายอย่างของลูกค้า - เพศอายุ ฯลฯ ซึ่งจะสังเกตได้จากผู้ดูแลร้านเพื่อทำนายความเป็นไปได้ที่จะเกิดขึ้นเช่นซื้อเครื่องเล่นหรือไม่ ฟังก์ชันโลจิสติกคือเส้นโค้งซิกมอยด์ที่ใช้ในการสร้างฟังก์ชันด้วยพารามิเตอร์ต่างๆ

ข้อกำหนดเบื้องต้น

ก่อนสร้างลักษณนามโดยใช้การถดถอยโลจิสติกเราจำเป็นต้องติดตั้งแพ็คเกจ Tkinter ในระบบของเรา สามารถติดตั้งได้จากhttps://docs.python.org/2/library/tkinter.html.

ตอนนี้ด้วยความช่วยเหลือของรหัสที่ระบุด้านล่างเราสามารถสร้างลักษณนามโดยใช้การถดถอยโลจิสติก -

ขั้นแรกเราจะนำเข้าบางแพ็คเกจ -

import numpy as np

from sklearn import linear_model

import matplotlib.pyplot as pltตอนนี้เราต้องกำหนดข้อมูลตัวอย่างซึ่งสามารถทำได้ดังนี้ -

X = np.array([[2, 4.8], [2.9, 4.7], [2.5, 5], [3.2, 5.5], [6, 5], [7.6, 4],

[3.2, 0.9], [2.9, 1.9],[2.4, 3.5], [0.5, 3.4], [1, 4], [0.9, 5.9]])

y = np.array([0, 0, 0, 1, 1, 1, 2, 2, 2, 3, 3, 3])ต่อไปเราต้องสร้างลักษณนามการถดถอยโลจิสติกซึ่งสามารถทำได้ดังนี้ -

Classifier_LR = linear_model.LogisticRegression(solver = 'liblinear', C = 75)สุดท้าย แต่ไม่ท้ายสุดเราต้องฝึกลักษณนามนี้ -

Classifier_LR.fit(X, y)ทีนี้เราจะเห็นภาพผลลัพธ์ได้อย่างไร? สามารถทำได้โดยสร้างฟังก์ชันชื่อ Logistic_visualize () -

Def Logistic_visualize(Classifier_LR, X, y):

min_x, max_x = X[:, 0].min() - 1.0, X[:, 0].max() + 1.0

min_y, max_y = X[:, 1].min() - 1.0, X[:, 1].max() + 1.0ในบรรทัดด้านบนเรากำหนดค่าต่ำสุดและสูงสุด X และ Y ที่จะใช้ในตารางตาข่าย นอกจากนี้เราจะกำหนดขนาดขั้นตอนสำหรับการลงจุดตารางตาข่าย

mesh_step_size = 0.02ให้เรากำหนดตารางตาข่ายของค่า X และ Y ดังต่อไปนี้ -

x_vals, y_vals = np.meshgrid(np.arange(min_x, max_x, mesh_step_size),

np.arange(min_y, max_y, mesh_step_size))ด้วยความช่วยเหลือของรหัสต่อไปนี้เราสามารถเรียกใช้ลักษณนามบนตารางตาข่าย -

output = classifier.predict(np.c_[x_vals.ravel(), y_vals.ravel()])

output = output.reshape(x_vals.shape)

plt.figure()

plt.pcolormesh(x_vals, y_vals, output, cmap = plt.cm.gray)

plt.scatter(X[:, 0], X[:, 1], c = y, s = 75, edgecolors = 'black',

linewidth=1, cmap = plt.cm.Paired)โค้ดบรรทัดต่อไปนี้จะระบุขอบเขตของพล็อต

plt.xlim(x_vals.min(), x_vals.max())

plt.ylim(y_vals.min(), y_vals.max())

plt.xticks((np.arange(int(X[:, 0].min() - 1), int(X[:, 0].max() + 1), 1.0)))

plt.yticks((np.arange(int(X[:, 1].min() - 1), int(X[:, 1].max() + 1), 1.0)))

plt.show()ตอนนี้หลังจากรันโค้ดแล้วเราจะได้ผลลัพธ์ต่อไปนี้ลักษณนามการถดถอยโลจิสติกส์ -

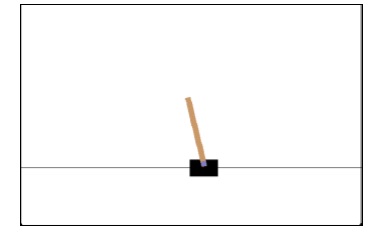

ลักษณนามทรีการตัดสินใจ

แผนผังการตัดสินใจเป็นผังงานต้นไม้ไบนารีที่แต่ละโหนดแยกกลุ่มการสังเกตตามตัวแปรคุณลักษณะบางอย่าง

ที่นี่เรากำลังสร้างลักษณนาม Decision Tree สำหรับทำนายเพศชายหรือเพศหญิง เราจะใช้ชุดข้อมูลขนาดเล็กมากซึ่งมี 19 ตัวอย่าง ตัวอย่างเหล่านี้จะประกอบด้วยคุณสมบัติสองประการ - "ความสูง" และ "ความยาวของผม"

ข้อกำหนดเบื้องต้น

สำหรับการสร้างลักษณนามต่อไปนี้เราจำเป็นต้องติดตั้ง pydotplus และ graphviz. โดยทั่วไปแล้ว graphviz เป็นเครื่องมือสำหรับการวาดภาพกราฟิกโดยใช้ไฟล์ dot และpydotplusเป็นโมดูลสำหรับภาษา Dot ของ Graphviz สามารถติดตั้งด้วยตัวจัดการแพ็คเกจหรือ pip

ตอนนี้เราสามารถสร้างลักษณนามทรีการตัดสินใจได้โดยใช้รหัส Python ต่อไปนี้ -

ในการเริ่มต้นให้เรานำเข้าไลบรารีที่สำคัญบางส่วนดังนี้ -

import pydotplus

from sklearn import tree

from sklearn.datasets import load_iris

from sklearn.metrics import classification_report

from sklearn import cross_validation

import collectionsตอนนี้เราต้องจัดเตรียมชุดข้อมูลดังนี้ -

X = [[165,19],[175,32],[136,35],[174,65],[141,28],[176,15],[131,32],

[166,6],[128,32],[179,10],[136,34],[186,2],[126,25],[176,28],[112,38],

[169,9],[171,36],[116,25],[196,25]]

Y = ['Man','Woman','Woman','Man','Woman','Man','Woman','Man','Woman',

'Man','Woman','Man','Woman','Woman','Woman','Man','Woman','Woman','Man']

data_feature_names = ['height','length of hair']

X_train, X_test, Y_train, Y_test = cross_validation.train_test_split

(X, Y, test_size=0.40, random_state=5)หลังจากจัดเตรียมชุดข้อมูลแล้วเราจำเป็นต้องใส่แบบจำลองซึ่งสามารถทำได้ดังนี้ -

clf = tree.DecisionTreeClassifier()

clf = clf.fit(X,Y)การทำนายสามารถทำได้ด้วยความช่วยเหลือของรหัส Python ต่อไปนี้ -

prediction = clf.predict([[133,37]])

print(prediction)เราสามารถเห็นภาพแผนผังการตัดสินใจด้วยความช่วยเหลือของรหัส Python ต่อไปนี้ -

dot_data = tree.export_graphviz(clf,feature_names = data_feature_names,

out_file = None,filled = True,rounded = True)

graph = pydotplus.graph_from_dot_data(dot_data)

colors = ('orange', 'yellow')

edges = collections.defaultdict(list)

for edge in graph.get_edge_list():

edges[edge.get_source()].append(int(edge.get_destination()))

for edge in edges: edges[edge].sort()

for i in range(2):dest = graph.get_node(str(edges[edge][i]))[0]

dest.set_fillcolor(colors[i])

graph.write_png('Decisiontree16.png')มันจะให้การคาดการณ์สำหรับรหัสข้างต้นเป็น [‘Woman’] และสร้างแผนผังการตัดสินใจต่อไปนี้ -

เราสามารถเปลี่ยนค่าของคุณสมบัติในการทำนายเพื่อทดสอบได้

ลักษณนามป่าสุ่ม

อย่างที่เราทราบกันดีว่าวิธีการทั้งมวลเป็นวิธีการที่รวมโมเดลการเรียนรู้ของเครื่องเข้ากับโมเดลการเรียนรู้ของเครื่องที่มีประสิทธิภาพมากขึ้น Random Forest ซึ่งเป็นกลุ่มของต้นไม้แห่งการตัดสินใจเป็นหนึ่งในนั้น จะดีกว่าโครงสร้างการตัดสินใจเพียงครั้งเดียวเนื่องจากในขณะที่รักษาอำนาจในการคาดการณ์ไว้ก็สามารถลดความเหมาะสมมากเกินไปโดยการหาค่าเฉลี่ยของผลลัพธ์ ที่นี่เราจะนำแบบจำลองฟอเรสต์สุ่มไปใช้กับชุดข้อมูลการเรียนรู้มะเร็งของ scikit

นำเข้าแพ็คเกจที่จำเป็น -

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_breast_cancer

cancer = load_breast_cancer()

import matplotlib.pyplot as plt

import numpy as npตอนนี้เราต้องจัดเตรียมชุดข้อมูลซึ่งสามารถทำได้ดังนี้ & ลบ

cancer = load_breast_cancer()

X_train, X_test, y_train,

y_test = train_test_split(cancer.data, cancer.target, random_state = 0)หลังจากจัดเตรียมชุดข้อมูลแล้วเราจำเป็นต้องใส่แบบจำลองซึ่งสามารถทำได้ดังนี้ -

forest = RandomForestClassifier(n_estimators = 50, random_state = 0)

forest.fit(X_train,y_train)ตอนนี้รับความแม่นยำในการฝึกอบรมและชุดย่อยการทดสอบ: ถ้าเราจะเพิ่มจำนวนตัวประมาณค่าความแม่นยำของชุดทดสอบก็จะเพิ่มขึ้นด้วย

print('Accuracy on the training subset:(:.3f)',format(forest.score(X_train,y_train)))

print('Accuracy on the training subset:(:.3f)',format(forest.score(X_test,y_test)))เอาต์พุต

Accuracy on the training subset:(:.3f) 1.0

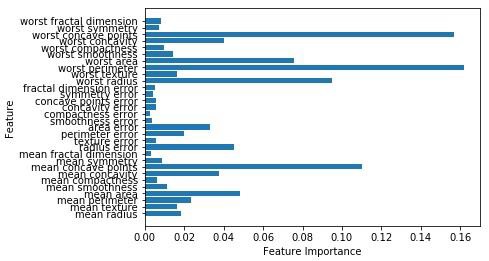

Accuracy on the training subset:(:.3f) 0.965034965034965ตอนนี้เช่นเดียวกับต้นไม้ตัดสินใจป่าสุ่มมี feature_importanceโมดูลซึ่งจะให้มุมมองของน้ำหนักคุณลักษณะได้ดีกว่าโครงสร้างการตัดสินใจ สามารถพล็อตและเห็นภาพได้ดังนี้ -

n_features = cancer.data.shape[1]

plt.barh(range(n_features),forest.feature_importances_, align='center')

plt.yticks(np.arange(n_features),cancer.feature_names)

plt.xlabel('Feature Importance')

plt.ylabel('Feature')

plt.show()

ประสิทธิภาพของลักษณนาม

หลังจากใช้อัลกอริธึมแมชชีนเลิร์นนิงแล้วเราจำเป็นต้องค้นหาว่าโมเดลมีประสิทธิภาพเพียงใด เกณฑ์ในการวัดประสิทธิภาพอาจขึ้นอยู่กับชุดข้อมูลและเมตริก สำหรับการประเมินอัลกอริทึมการเรียนรู้ของเครื่องที่แตกต่างกันเราสามารถใช้เมตริกประสิทธิภาพที่แตกต่างกันได้ ตัวอย่างเช่นสมมติว่าหากมีการใช้ลักษณนามเพื่อแยกความแตกต่างระหว่างรูปภาพของวัตถุต่าง ๆ เราสามารถใช้เมตริกประสิทธิภาพการจัดหมวดหมู่เช่นความแม่นยำเฉลี่ย AUC เป็นต้นหรือในอีกแง่หนึ่งเมตริกที่เราเลือกเพื่อประเมินโมเดลการเรียนรู้ของเครื่องคือ สำคัญมากเนื่องจากการเลือกเมตริกมีผลต่อการวัดและเปรียบเทียบประสิทธิภาพของอัลกอริทึมการเรียนรู้ของเครื่อง ต่อไปนี้เป็นเมตริกบางส่วน -

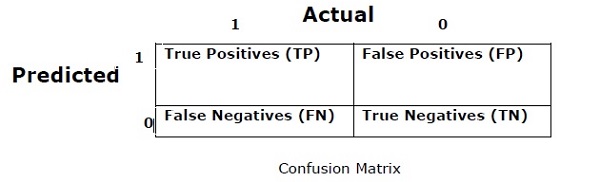

เมทริกซ์ความสับสน

โดยทั่วไปจะใช้สำหรับปัญหาการจำแนกประเภทที่เอาต์พุตอาจเป็นคลาสสองประเภทขึ้นไป เป็นวิธีที่ง่ายที่สุดในการวัดประสิทธิภาพของลักษณนาม เมทริกซ์ความสับสนโดยพื้นฐานแล้วเป็นตารางที่มีสองมิติคือ "ตามจริง" และ "คาดการณ์" มิติข้อมูลทั้งสองมี“ True Positives (TP)”,“ True Negatives (TN)”,“ False Positives (FP)”,“ False Negatives (FN)”

ในเมทริกซ์ความสับสนด้านบน 1 คือคลาสบวกและ 0 สำหรับคลาสลบ

ต่อไปนี้เป็นคำศัพท์ที่เกี่ยวข้องกับ Confusion matrix -

True Positives − TPs คือกรณีที่คลาสจริงของจุดข้อมูลคือ 1 และการคาดการณ์ก็คือ 1 เช่นกัน

True Negatives − TN เป็นกรณีที่คลาสจริงของจุดข้อมูลคือ 0 และการทำนายเป็น 0 ด้วย

False Positives − FPs คือกรณีที่คลาสจริงของจุดข้อมูลคือ 0 และการคาดการณ์ก็คือ 1 เช่นกัน

False Negatives − FN เป็นกรณีที่คลาสจริงของจุดข้อมูลคือ 1 และการคาดการณ์เป็น 0 เช่นกัน

ความถูกต้อง

เมทริกซ์ความสับสนนั้นไม่ได้เป็นตัวชี้วัดประสิทธิภาพเช่นนี้ แต่เมทริกซ์ประสิทธิภาพเกือบทั้งหมดจะขึ้นอยู่กับเมทริกซ์ความสับสน หนึ่งในนั้นคือความถูกต้อง ในปัญหาการจำแนกประเภทอาจกำหนดเป็นจำนวนการคาดคะเนที่ถูกต้องซึ่งทำโดยแบบจำลองมากกว่าการคาดคะเนทุกประเภท สูตรการคำนวณความแม่นยำมีดังนี้ -

$$ ความแม่นยำ = \ frac {TP + TN} {TP + FP + FN + TN} $$

ความแม่นยำ

ส่วนใหญ่จะใช้ในการดึงเอกสาร อาจกำหนดเป็นจำนวนเอกสารที่ส่งคืนถูกต้อง ต่อไปนี้เป็นสูตรคำนวณความแม่นยำ -

$$ แม่นยำ = \ frac {TP} {TP + FP} $$

การเรียกคืนหรือความอ่อนไหว

อาจกำหนดเป็นจำนวนผลบวกที่โมเดลส่งกลับมา ต่อไปนี้เป็นสูตรคำนวณการเรียกคืน / ความไวของแบบจำลอง -

$$ Recall = \ frac {TP} {TP + FN} $$

ความจำเพาะ

อาจกำหนดเป็นจำนวนเชิงลบที่โมเดลส่งคืน มันตรงข้ามกับการจำ ต่อไปนี้เป็นสูตรคำนวณความจำเพาะของแบบจำลอง -

$$ ความจำเพาะ = \ frac {TN} {TN + FP} $$

ปัญหาความไม่สมดุลของคลาส

ความไม่สมดุลของคลาสคือสถานการณ์ที่จำนวนการสังเกตของคลาสหนึ่งต่ำกว่าคลาสอื่นอย่างมีนัยสำคัญ ตัวอย่างเช่นปัญหานี้มีความโดดเด่นในสถานการณ์ที่เราจำเป็นต้องระบุโรคที่หายากธุรกรรมหลอกลวงในธนาคารเป็นต้น

ตัวอย่างคลาสที่ไม่สมดุล

ให้เราพิจารณาตัวอย่างของชุดข้อมูลการตรวจจับการฉ้อโกงเพื่อทำความเข้าใจแนวคิดของคลาสที่ไม่สมดุล -

Total observations = 5000

Fraudulent Observations = 50

Non-Fraudulent Observations = 4950

Event Rate = 1%วิธีการแก้

Balancing the classes’ทำหน้าที่เป็นวิธีแก้ปัญหาสำหรับชั้นเรียนที่ไม่สมดุล วัตถุประสงค์หลักของการปรับสมดุลของคลาสคือการเพิ่มความถี่ของคลาสของชนกลุ่มน้อยหรือลดความถี่ของคลาสส่วนใหญ่ ต่อไปนี้เป็นแนวทางในการแก้ปัญหาความไม่สมดุลของคลาส -

การสุ่มตัวอย่างซ้ำ

การสุ่มตัวอย่างซ้ำเป็นชุดวิธีการที่ใช้ในการสร้างชุดข้อมูลตัวอย่างขึ้นใหม่ทั้งชุดฝึกและชุดทดสอบ ทำการสุ่มตัวอย่างซ้ำเพื่อปรับปรุงความแม่นยำของแบบจำลอง ต่อไปนี้เป็นเทคนิคการสุ่มตัวอย่างซ้ำบางส่วน -

Random Under-Sampling- เทคนิคนี้มีจุดมุ่งหมายเพื่อสร้างสมดุลของการกระจายชั้นเรียนโดยการสุ่มกำจัดตัวอย่างชั้นเรียนส่วนใหญ่ สิ่งนี้จะทำจนกว่าอินสแตนซ์คลาสส่วนใหญ่และคลาสส่วนน้อยจะสมดุลกัน

Total observations = 5000

Fraudulent Observations = 50

Non-Fraudulent Observations = 4950

Event Rate = 1%ในกรณีนี้เราจะนำตัวอย่าง 10% โดยไม่มีการเปลี่ยนจากอินสแตนซ์ที่ไม่ใช่การฉ้อโกงจากนั้นรวมเข้ากับอินสแตนซ์การฉ้อโกง -

การสังเกตที่ไม่เป็นการฉ้อโกงหลังจากการสุ่มภายใต้การสุ่มตัวอย่าง = 10% ของ 4950 = 495

การสังเกตการณ์ทั้งหมดหลังจากรวมเข้ากับการสังเกตการณ์หลอกลวง = 50 + 495 = 545

ดังนั้นตอนนี้อัตราเหตุการณ์สำหรับชุดข้อมูลใหม่หลังจากอยู่ภายใต้การสุ่มตัวอย่าง = 9%

ข้อได้เปรียบหลักของเทคนิคนี้คือสามารถลดเวลาในการทำงานและปรับปรุงการจัดเก็บ แต่ในอีกด้านหนึ่งก็สามารถทิ้งข้อมูลที่เป็นประโยชน์ในขณะที่ลดจำนวนตัวอย่างข้อมูลการฝึกอบรม

Random Over-Sampling - เทคนิคนี้มีจุดมุ่งหมายเพื่อสร้างสมดุลของการกระจายคลาสโดยการเพิ่มจำนวนอินสแตนซ์ในคลาสของชนกลุ่มน้อยโดยการจำลองแบบ

Total observations = 5000

Fraudulent Observations = 50

Non-Fraudulent Observations = 4950

Event Rate = 1%ในกรณีที่เราจำลองการสังเกตการณ์หลอกลวง 50 ครั้ง 30 ครั้งการสังเกตการณ์ที่ฉ้อโกงหลังจากจำลองแบบการสังเกตการณ์ของชนกลุ่มน้อยจะเท่ากับ 1,500 จากนั้นการสังเกตการณ์ทั้งหมดในข้อมูลใหม่หลังจากการสุ่มตัวอย่างเกินจะเท่ากับ 4950 + 1500 = 6450 ดังนั้นอัตราเหตุการณ์สำหรับชุดข้อมูลใหม่ จะเป็น 1500/6450 = 23%

ข้อได้เปรียบหลักของวิธีนี้คือจะไม่มีการสูญเสียข้อมูลที่เป็นประโยชน์ แต่ในทางกลับกันก็มีโอกาสที่จะสวมใส่มากเกินไปเนื่องจากเป็นการจำลองเหตุการณ์ของชนกลุ่มน้อย

เทคนิคทั้งมวล

วิธีการนี้โดยทั่วไปใช้เพื่อแก้ไขอัลกอริทึมการจำแนกที่มีอยู่เพื่อให้เหมาะสมกับชุดข้อมูลที่ไม่สมดุล ในวิธีนี้เราสร้างตัวจำแนกสองขั้นตอนจากข้อมูลเดิมจากนั้นจึงรวมการคาดการณ์ ลักษณนามฟอเรสต์แบบสุ่มเป็นตัวอย่างของลักษณนามตามทั้งมวล

การถดถอยเป็นเครื่องมือทางสถิติและการเรียนรู้ของเครื่องที่สำคัญที่สุดอย่างหนึ่ง เราคงไม่ผิดหากจะบอกว่าเส้นทางของการเรียนรู้ของเครื่องเริ่มต้นจากการถดถอย อาจถูกกำหนดให้เป็นเทคนิคพาราเมตริกที่ช่วยให้เราสามารถตัดสินใจโดยอาศัยข้อมูลหรือกล่าวอีกนัยหนึ่งช่วยให้เราทำการคาดการณ์จากข้อมูลโดยเรียนรู้ความสัมพันธ์ระหว่างตัวแปรอินพุตและเอาต์พุต ที่นี่ตัวแปรเอาต์พุตขึ้นอยู่กับตัวแปรอินพุตเป็นจำนวนจริงที่มีมูลค่าต่อเนื่อง ในการถดถอยความสัมพันธ์ระหว่างตัวแปรอินพุตและเอาต์พุตมีความสำคัญและช่วยให้เราเข้าใจว่าค่าของตัวแปรเอาต์พุตเปลี่ยนแปลงไปอย่างไรเมื่อมีการเปลี่ยนแปลงตัวแปรอินพุต การถดถอยมักใช้ในการทำนายราคาเศรษฐศาสตร์การเปลี่ยนแปลงและอื่น ๆ

การสร้าง Regressors ใน Python

ในส่วนนี้เราจะได้เรียนรู้วิธีการสร้างตัวถอยหลังแบบเดี่ยวและแบบหลายตัวแปร

Linear Regressor / ตัวควบคุมตัวแปรเดียว

ให้เราสำคัญแพ็คเกจที่จำเป็นบางอย่าง -

import numpy as np

from sklearn import linear_model

import sklearn.metrics as sm

import matplotlib.pyplot as pltตอนนี้เราจำเป็นต้องให้ข้อมูลอินพุตและเราได้บันทึกข้อมูลของเราไว้ในไฟล์ชื่อ linear.txt

input = 'D:/ProgramData/linear.txt'เราจำเป็นต้องโหลดข้อมูลนี้โดยใช้ไฟล์ np.loadtxt ฟังก์ชัน

input_data = np.loadtxt(input, delimiter=',')

X, y = input_data[:, :-1], input_data[:, -1]ขั้นตอนต่อไปคือการฝึกโมเดล ให้เราฝึกอบรมและทดสอบตัวอย่าง

training_samples = int(0.6 * len(X))

testing_samples = len(X) - num_training

X_train, y_train = X[:training_samples], y[:training_samples]

X_test, y_test = X[training_samples:], y[training_samples:]ตอนนี้เราจำเป็นต้องสร้างวัตถุตัวถอยหลังเชิงเส้น

reg_linear = linear_model.LinearRegression()ฝึกวัตถุด้วยตัวอย่างการฝึกอบรม

reg_linear.fit(X_train, y_train)เราจำเป็นต้องทำการคาดคะเนด้วยข้อมูลการทดสอบ

y_test_pred = reg_linear.predict(X_test)ตอนนี้วางแผนและแสดงภาพข้อมูล

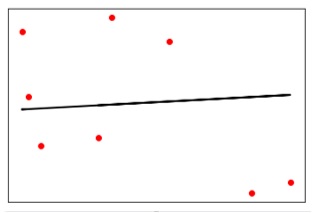

plt.scatter(X_test, y_test, color = 'red')

plt.plot(X_test, y_test_pred, color = 'black', linewidth = 2)

plt.xticks(())

plt.yticks(())

plt.show()เอาต์พุต

ตอนนี้เราสามารถคำนวณประสิทธิภาพของการถดถอยเชิงเส้นได้ดังนี้ -

print("Performance of Linear regressor:")

print("Mean absolute error =", round(sm.mean_absolute_error(y_test, y_test_pred), 2))

print("Mean squared error =", round(sm.mean_squared_error(y_test, y_test_pred), 2))

print("Median absolute error =", round(sm.median_absolute_error(y_test, y_test_pred), 2))

print("Explain variance score =", round(sm.explained_variance_score(y_test, y_test_pred),

2))

print("R2 score =", round(sm.r2_score(y_test, y_test_pred), 2))เอาต์พุต

ประสิทธิภาพของ Linear Regressor -

Mean absolute error = 1.78

Mean squared error = 3.89

Median absolute error = 2.01

Explain variance score = -0.09

R2 score = -0.09ในโค้ดด้านบนเราได้ใช้ข้อมูลขนาดเล็กนี้ หากคุณต้องการชุดข้อมูลขนาดใหญ่คุณสามารถใช้ sklearn.dataset เพื่อนำเข้าชุดข้อมูลที่ใหญ่ขึ้น

2,4.82.9,4.72.5,53.2,5.56,57.6,43.2,0.92.9,1.92.4,

3.50.5,3.41,40.9,5.91.2,2.583.2,5.65.1,1.54.5,

1.22.3,6.32.1,2.8Regressor หลายตัวแปร

ขั้นแรกให้เรานำเข้าแพ็คเกจที่จำเป็นบางอย่าง -

import numpy as np

from sklearn import linear_model

import sklearn.metrics as sm

import matplotlib.pyplot as plt

from sklearn.preprocessing import PolynomialFeaturesตอนนี้เราจำเป็นต้องให้ข้อมูลอินพุตและเราได้บันทึกข้อมูลของเราไว้ในไฟล์ชื่อ linear.txt

input = 'D:/ProgramData/Mul_linear.txt'เราจะโหลดข้อมูลนี้โดยใช้ไฟล์ np.loadtxt ฟังก์ชัน

input_data = np.loadtxt(input, delimiter=',')

X, y = input_data[:, :-1], input_data[:, -1]ขั้นตอนต่อไปคือการฝึกโมเดล เราจะให้การฝึกอบรมและการทดสอบตัวอย่าง

training_samples = int(0.6 * len(X))

testing_samples = len(X) - num_training

X_train, y_train = X[:training_samples], y[:training_samples]

X_test, y_test = X[training_samples:], y[training_samples:]ตอนนี้เราจำเป็นต้องสร้างวัตถุตัวถอยหลังเชิงเส้น

reg_linear_mul = linear_model.LinearRegression()ฝึกวัตถุด้วยตัวอย่างการฝึกอบรม

reg_linear_mul.fit(X_train, y_train)ในที่สุดเราต้องทำการคาดการณ์ด้วยข้อมูลการทดสอบ

y_test_pred = reg_linear_mul.predict(X_test)

print("Performance of Linear regressor:")

print("Mean absolute error =", round(sm.mean_absolute_error(y_test, y_test_pred), 2))

print("Mean squared error =", round(sm.mean_squared_error(y_test, y_test_pred), 2))

print("Median absolute error =", round(sm.median_absolute_error(y_test, y_test_pred), 2))

print("Explain variance score =", round(sm.explained_variance_score(y_test, y_test_pred), 2))

print("R2 score =", round(sm.r2_score(y_test, y_test_pred), 2))เอาต์พุต

ประสิทธิภาพของ Linear Regressor -

Mean absolute error = 0.6

Mean squared error = 0.65

Median absolute error = 0.41

Explain variance score = 0.34

R2 score = 0.33ตอนนี้เราจะสร้างพหุนามดีกรี 10 และฝึกตัวถอยหลัง เราจะจัดเตรียมจุดข้อมูลตัวอย่าง

polynomial = PolynomialFeatures(degree = 10)

X_train_transformed = polynomial.fit_transform(X_train)

datapoint = [[2.23, 1.35, 1.12]]

poly_datapoint = polynomial.fit_transform(datapoint)

poly_linear_model = linear_model.LinearRegression()

poly_linear_model.fit(X_train_transformed, y_train)

print("\nLinear regression:\n", reg_linear_mul.predict(datapoint))

print("\nPolynomial regression:\n", poly_linear_model.predict(poly_datapoint))เอาต์พุต

การถดถอยเชิงเส้น -

[2.40170462]การถดถอยพหุนาม -

[1.8697225]ในโค้ดด้านบนเราได้ใช้ข้อมูลขนาดเล็กนี้ หากคุณต้องการชุดข้อมูลขนาดใหญ่คุณสามารถใช้ sklearn.dataset เพื่อนำเข้าชุดข้อมูลที่ใหญ่ขึ้น

2,4.8,1.2,3.22.9,4.7,1.5,3.62.5,5,2.8,23.2,5.5,3.5,2.16,5,

2,3.27.6,4,1.2,3.23.2,0.9,2.3,1.42.9,1.9,2.3,1.22.4,3.5,

2.8,3.60.5,3.4,1.8,2.91,4,3,2.50.9,5.9,5.6,0.81.2,2.58,

3.45,1.233.2,5.6,2,3.25.1,1.5,1.2,1.34.5,1.2,4.1,2.32.3,

6.3,2.5,3.22.1,2.8,1.2,3.6ในบทนี้เราจะเน้นการเขียนโปรแกรมเชิงตรรกะและวิธีการช่วยในปัญญาประดิษฐ์

เรารู้อยู่แล้วว่าตรรกะคือการศึกษาหลักการของการใช้เหตุผลที่ถูกต้องหรือพูดง่ายๆก็คือการศึกษาสิ่งที่เกิดขึ้นหลังจากอะไร ตัวอย่างเช่นหากสองคำสั่งเป็นจริงเราสามารถอนุมานคำสั่งที่สามจากคำสั่งนั้นได้

แนวคิด

Logic Programming คือการรวมกันของสองคำตรรกะและการเขียนโปรแกรม Logic Programming เป็นกระบวนทัศน์ในการเขียนโปรแกรมซึ่งปัญหาจะแสดงเป็นข้อเท็จจริงและกฎเกณฑ์โดยคำสั่งของโปรแกรม แต่อยู่ในระบบของตรรกะที่เป็นทางการ เช่นเดียวกับกระบวนทัศน์การเขียนโปรแกรมอื่น ๆ เช่นเชิงวัตถุการใช้งานการประกาศและขั้นตอนเป็นต้นนอกจากนี้ยังเป็นวิธีเฉพาะในการเข้าถึงการเขียนโปรแกรม

วิธีแก้ปัญหาเกี่ยวกับการเขียนโปรแกรมลอจิก

Logic Programming ใช้ข้อเท็จจริงและกฎเกณฑ์ในการแก้ปัญหา นั่นคือเหตุผลที่พวกเขาเรียกว่า Building Block ของ Logic Programming ต้องระบุเป้าหมายสำหรับทุกโปรแกรมในการเขียนโปรแกรมลอจิก เพื่อให้เข้าใจว่าปัญหาสามารถแก้ไขได้อย่างไรในการเขียนโปรแกรมลอจิกเราจำเป็นต้องรู้เกี่ยวกับหน่วยการสร้าง - ข้อเท็จจริงและกฎ -

ข้อเท็จจริง

จริงๆแล้วโปรแกรมลอจิกทุกโปรแกรมต้องการข้อเท็จจริงเพื่อให้สามารถบรรลุเป้าหมายที่กำหนดได้ ข้อเท็จจริงโดยทั่วไปคือข้อความที่เป็นจริงเกี่ยวกับโปรแกรมและข้อมูล ตัวอย่างเช่นเดลีเป็นเมืองหลวงของอินเดีย

กฎ

จริงๆแล้วกฎเป็นข้อ จำกัด ที่ช่วยให้เราสามารถสรุปเกี่ยวกับโดเมนปัญหาได้ กฎที่เขียนโดยทั่วไปเป็นข้อตรรกะเพื่อแสดงข้อเท็จจริงต่างๆ ตัวอย่างเช่นหากเรากำลังสร้างเกมใด ๆ ก็ต้องกำหนดกฎทั้งหมด

กฎมีความสำคัญมากในการแก้ปัญหาใน Logic Programming กฎเป็นข้อสรุปเชิงตรรกะซึ่งสามารถแสดงข้อเท็จจริงได้ ต่อไปนี้เป็นไวยากรณ์ของกฎ -

A∶− B1, B2, ... , B n .

ที่นี่ A คือหัวและ B1, B2, ... Bn คือร่างกาย

ตัวอย่างเช่น - บรรพบุรุษ (X, Y): - พ่อ (X, Y)

บรรพบุรุษ (X, Z): - พ่อ (X, Y) บรรพบุรุษ (Y, Z)

สามารถอ่านได้ว่าสำหรับ X และ Y ทุกตัวถ้า X เป็นพ่อของ Y และ Y เป็นบรรพบุรุษของ Z X คือบรรพบุรุษของ Z สำหรับ X และ Y ทุกตัว X คือบรรพบุรุษของ Z ถ้า X คือ พ่อของ Y และ Y เป็นบรรพบุรุษของ Z

การติดตั้งแพ็คเกจที่มีประโยชน์

สำหรับการเริ่มต้นการเขียนโปรแกรมลอจิกใน Python เราจำเป็นต้องติดตั้งสองแพ็คเกจต่อไปนี้ -

Kanren

ช่วยให้เราสามารถลดความซับซ้อนของวิธีการสร้างโค้ดสำหรับตรรกะทางธุรกิจได้ ช่วยให้เราสามารถแสดงตรรกะในแง่ของกฎและข้อเท็จจริง คำสั่งต่อไปนี้จะช่วยคุณติดตั้ง kanren -

pip install kanrenSymPy

SymPy เป็นไลบรารี Python สำหรับคณิตศาสตร์สัญลักษณ์ มีจุดมุ่งหมายเพื่อให้เป็นระบบพีชคณิตคอมพิวเตอร์ที่มีคุณสมบัติครบถ้วน (CAS) ในขณะที่รักษารหัสให้เรียบง่ายที่สุดเท่าที่จะเป็นไปได้เพื่อให้เข้าใจง่ายและขยายได้ง่าย คำสั่งต่อไปนี้จะช่วยคุณติดตั้ง SymPy -

pip install sympyตัวอย่างการเขียนโปรแกรมลอจิก

ต่อไปนี้เป็นตัวอย่างบางส่วนที่สามารถแก้ไขได้โดยการเขียนโปรแกรมลอจิก -

การจับคู่นิพจน์ทางคณิตศาสตร์

จริงๆแล้วเราสามารถค้นหาค่าที่ไม่รู้จักได้โดยใช้การเขียนโปรแกรมตรรกะอย่างมีประสิทธิภาพ รหัส Python ต่อไปนี้จะช่วยให้คุณจับคู่นิพจน์ทางคณิตศาสตร์ -

พิจารณานำเข้าแพ็คเกจต่อไปนี้ก่อน -

from kanren import run, var, fact

from kanren.assoccomm import eq_assoccomm as eq

from kanren.assoccomm import commutative, associativeเราจำเป็นต้องกำหนดการดำเนินการทางคณิตศาสตร์ที่เราจะใช้ -

add = 'add'

mul = 'mul'ทั้งการบวกและการคูณเป็นกระบวนการสื่อสาร ดังนั้นเราจำเป็นต้องระบุและสามารถทำได้ดังนี้ -

fact(commutative, mul)

fact(commutative, add)

fact(associative, mul)

fact(associative, add)จำเป็นต้องกำหนดตัวแปร สามารถทำได้ดังนี้ -

a, b = var('a'), var('b')เราจำเป็นต้องจับคู่นิพจน์กับรูปแบบเดิม เรามีรูปแบบดั้งเดิมดังต่อไปนี้ซึ่งโดยพื้นฐานแล้ว (5 + a) * b -

Original_pattern = (mul, (add, 5, a), b)เรามีสองนิพจน์ต่อไปนี้เพื่อจับคู่กับรูปแบบดั้งเดิม -

exp1 = (mul, 2, (add, 3, 1))

exp2 = (add,5,(mul,8,1))สามารถพิมพ์เอาต์พุตได้ด้วยคำสั่งต่อไปนี้ -

print(run(0, (a,b), eq(original_pattern, exp1)))

print(run(0, (a,b), eq(original_pattern, exp2)))หลังจากรันโค้ดนี้เราจะได้ผลลัพธ์ต่อไปนี้ -

((3,2))

()ผลลัพธ์แรกแสดงถึงค่าสำหรับ a และ b. นิพจน์แรกตรงกับรูปแบบดั้งเดิมและส่งคืนค่าสำหรับa และ b แต่นิพจน์ที่สองไม่ตรงกับรูปแบบเดิมจึงไม่มีการส่งคืน

กำลังตรวจหา Prime Numbers

ด้วยความช่วยเหลือของการเขียนโปรแกรมตรรกะเราสามารถค้นหาจำนวนเฉพาะจากรายการตัวเลขและยังสามารถสร้างจำนวนเฉพาะได้ รหัส Python ที่ระบุด้านล่างจะค้นหาจำนวนเฉพาะจากรายการตัวเลขและจะสร้างจำนวนเฉพาะ 10 ตัวแรก

ให้เราพิจารณาการนำเข้าแพ็คเกจต่อไปนี้ก่อน -

from kanren import isvar, run, membero

from kanren.core import success, fail, goaleval, condeseq, eq, var

from sympy.ntheory.generate import prime, isprime

import itertools as itตอนนี้เราจะกำหนดฟังก์ชันที่เรียกว่า prime_check ซึ่งจะตรวจสอบจำนวนเฉพาะตามตัวเลขที่กำหนดเป็นข้อมูล

def prime_check(x):

if isvar(x):

return condeseq([(eq,x,p)] for p in map(prime, it.count(1)))

else:

return success if isprime(x) else failตอนนี้เราต้องประกาศตัวแปรที่จะใช้ -

x = var()

print((set(run(0,x,(membero,x,(12,14,15,19,20,21,22,23,29,30,41,44,52,62,65,85)),

(prime_check,x)))))

print((run(10,x,prime_check(x))))ผลลัพธ์ของโค้ดด้านบนจะเป็นดังนี้ -

{19, 23, 29, 41}

(2, 3, 5, 7, 11, 13, 17, 19, 23, 29)การแก้ปริศนา

การเขียนโปรแกรมลอจิกสามารถใช้เพื่อแก้ปัญหาต่างๆเช่น 8-puzzle, Zebra puzzle, Sudoku, N-queen เป็นต้นต่อไปนี้เราจะยกตัวอย่างของตัวต่อ Zebra ที่แตกต่างกันซึ่งมีดังต่อไปนี้ -

There are five houses.

The English man lives in the red house.

The Swede has a dog.

The Dane drinks tea.

The green house is immediately to the left of the white house.

They drink coffee in the green house.

The man who smokes Pall Mall has birds.

In the yellow house they smoke Dunhill.

In the middle house they drink milk.

The Norwegian lives in the first house.

The man who smokes Blend lives in the house next to the house with cats.

In a house next to the house where they have a horse, they smoke Dunhill.

The man who smokes Blue Master drinks beer.

The German smokes Prince.

The Norwegian lives next to the blue house.

They drink water in a house next to the house where they smoke Blend.เรากำลังแก้ปัญหาสำหรับคำถามนี้ who owns zebra ด้วยความช่วยเหลือของ Python

ให้เรานำเข้าแพ็คเกจที่จำเป็น -

from kanren import *

from kanren.core import lall

import timeตอนนี้เราต้องกำหนดสองฟังก์ชัน - left() และ next() เพื่อตรวจสอบว่าบ้านใครเหลืออยู่หรือข้างบ้านใคร -

def left(q, p, list):

return membero((q,p), zip(list, list[1:]))

def next(q, p, list):

return conde([left(q, p, list)], [left(p, q, list)])ตอนนี้เราจะประกาศตัวแปรบ้านดังนี้ -

houses = var()เราจำเป็นต้องกำหนดกฎด้วยความช่วยเหลือของแพ็คเกจ lall ดังนี้

มีบ้าน 5 หลัง -

rules_zebraproblem = lall(

(eq, (var(), var(), var(), var(), var()), houses),

(membero,('Englishman', var(), var(), var(), 'red'), houses),

(membero,('Swede', var(), var(), 'dog', var()), houses),

(membero,('Dane', var(), 'tea', var(), var()), houses),

(left,(var(), var(), var(), var(), 'green'),

(var(), var(), var(), var(), 'white'), houses),

(membero,(var(), var(), 'coffee', var(), 'green'), houses),

(membero,(var(), 'Pall Mall', var(), 'birds', var()), houses),

(membero,(var(), 'Dunhill', var(), var(), 'yellow'), houses),

(eq,(var(), var(), (var(), var(), 'milk', var(), var()), var(), var()), houses),

(eq,(('Norwegian', var(), var(), var(), var()), var(), var(), var(), var()), houses),

(next,(var(), 'Blend', var(), var(), var()),

(var(), var(), var(), 'cats', var()), houses),

(next,(var(), 'Dunhill', var(), var(), var()),

(var(), var(), var(), 'horse', var()), houses),

(membero,(var(), 'Blue Master', 'beer', var(), var()), houses),

(membero,('German', 'Prince', var(), var(), var()), houses),

(next,('Norwegian', var(), var(), var(), var()),

(var(), var(), var(), var(), 'blue'), houses),

(next,(var(), 'Blend', var(), var(), var()),

(var(), var(), 'water', var(), var()), houses),

(membero,(var(), var(), var(), 'zebra', var()), houses)

)ตอนนี้เรียกใช้ตัวแก้ปัญหาด้วยข้อ จำกัด ก่อนหน้านี้ -

solutions = run(0, houses, rules_zebraproblem)ด้วยความช่วยเหลือของรหัสต่อไปนี้เราสามารถดึงเอาท์พุทจากตัวแก้ -