การประมวลผลภาษาธรรมชาติ - คู่มือฉบับย่อ

ภาษาเป็นวิธีการสื่อสารด้วยความช่วยเหลือซึ่งเราสามารถพูดอ่านเขียนได้ ตัวอย่างเช่นเราคิดว่าเราตัดสินใจวางแผนและอื่น ๆ ด้วยภาษาที่เป็นธรรมชาติ แม่นยำในคำพูด อย่างไรก็ตามคำถามใหญ่ที่ทำให้เราต้องเผชิญในยุค AI นี้คือเราสามารถสื่อสารในลักษณะเดียวกันกับคอมพิวเตอร์ได้หรือไม่ กล่าวอีกนัยหนึ่งมนุษย์สามารถสื่อสารกับคอมพิวเตอร์ด้วยภาษาธรรมชาติได้หรือไม่? เป็นความท้าทายสำหรับเราในการพัฒนาแอปพลิเคชัน NLP เนื่องจากคอมพิวเตอร์ต้องการข้อมูลที่มีโครงสร้าง แต่คำพูดของมนุษย์ไม่มีโครงสร้างและมักมีความคลุมเครือ

ในแง่นี้เราสามารถพูดได้ว่า Natural Language Processing (NLP) เป็นสาขาย่อยของวิทยาการคอมพิวเตอร์โดยเฉพาะปัญญาประดิษฐ์ (AI) ที่เกี่ยวข้องกับการทำให้คอมพิวเตอร์เข้าใจและประมวลผลภาษาของมนุษย์ ในทางเทคนิคงานหลักของ NLP คือการเขียนโปรแกรมคอมพิวเตอร์เพื่อวิเคราะห์และประมวลผลข้อมูลภาษาธรรมชาติจำนวนมาก

ประวัติ NLP

เราได้แบ่งประวัติของ NLP ออกเป็นสี่ขั้นตอน ระยะมีความกังวลและสไตล์ที่แตกต่างกัน

ระยะแรก (ระยะการแปลด้วยเครื่อง) - ปลายทศวรรษที่ 1940 ถึงปลายทศวรรษที่ 1960

งานที่ทำในระยะนี้มุ่งเน้นไปที่การแปลด้วยเครื่อง (MT) เป็นหลัก ระยะนี้เป็นช่วงของความกระตือรือร้นและการมองโลกในแง่ดี

ตอนนี้ให้เราดูทั้งหมดที่เฟสแรกมีอยู่ -

การวิจัยเกี่ยวกับ NLP เริ่มต้นในต้นปี 1950 หลังจากการสอบสวนของ Booth & Richens และบันทึกข้อตกลงของ Weaver เกี่ยวกับการแปลด้วยเครื่องในปีพ. ศ. 2492

ปี 1954 เป็นปีที่มีการทดลองแบบ จำกัด เกี่ยวกับการแปลอัตโนมัติจากภาษารัสเซียเป็นภาษาอังกฤษในการทดลอง Georgetown-IBM

ในปีเดียวกันการตีพิมพ์วารสาร MT (Machine Translation) เริ่มต้นขึ้น

การประชุมระหว่างประเทศเรื่อง Machine Translation (MT) ครั้งแรกจัดขึ้นในปี 2495 และครั้งที่สองจัดขึ้นในปี 2499

ในปีพ. ศ. 2504 งานที่นำเสนอในการประชุมนานาชาติ Teddington เรื่องการแปลภาษาและการวิเคราะห์ภาษาประยุกต์เป็นประเด็นสำคัญของขั้นตอนนี้

ระยะที่สอง (ระยะที่มีอิทธิพลของ AI) - ปลายทศวรรษที่ 1960 ถึงปลายทศวรรษ 1970

ในระยะนี้งานที่ทำนั้นเกี่ยวข้องกับความรู้ทางโลกเป็นหลักและมีบทบาทในการสร้างและจัดการการแสดงความหมาย นั่นคือเหตุผลที่ระยะนี้เรียกอีกอย่างว่าเฟสปรุงแต่ง AI

เฟสมีดังต่อไปนี้ -

ในช่วงต้นปีพ. ศ. 2504 งานนี้ได้เริ่มต้นขึ้นเกี่ยวกับปัญหาในการจัดการและสร้างข้อมูลหรือฐานความรู้ งานนี้ได้รับอิทธิพลจาก AI

ในปีเดียวกันนี้ยังมีการพัฒนาระบบตอบคำถาม BASEBALL อินพุตของระบบนี้ถูก จำกัด และการประมวลผลภาษาที่เกี่ยวข้องนั้นเป็นเรื่องง่าย

มีการอธิบายระบบขั้นสูงมากใน Minsky (1968) ระบบนี้เมื่อเทียบกับระบบตอบคำถาม BASEBALL ได้รับการยอมรับและจัดเตรียมไว้สำหรับความจำเป็นในการอนุมานบนฐานความรู้ในการตีความและตอบสนองต่อการป้อนข้อมูลภาษา

เฟสที่สาม (Grammatico-logical Phase) - ปลายทศวรรษ 1970 ถึงปลายทศวรรษ 1980

เฟสนี้สามารถอธิบายได้ว่าเป็นเฟสไวยากรณ์ - ตรรกะ เนื่องจากความล้มเหลวของการสร้างระบบในทางปฏิบัติในช่วงสุดท้ายนักวิจัยจึงหันไปใช้ตรรกะในการแสดงความรู้และการให้เหตุผลใน AI

ระยะที่สามมีดังต่อไปนี้ -

แนวทางไวยากรณ์ - ตรรกะในช่วงปลายทศวรรษนี้ช่วยให้เรามีตัวประมวลผลประโยคที่ใช้งานทั่วไปที่มีประสิทธิภาพเช่น Core Language Engine ของ SRI และทฤษฎีการเป็นตัวแทนของวาทกรรมซึ่งนำเสนอวิธีการจัดการกับวาทกรรมที่ขยายออกไปมากขึ้น

ในขั้นตอนนี้เรามีทรัพยากรและเครื่องมือที่ใช้ได้จริงเช่นตัวแยกวิเคราะห์เช่น Alvey Natural Language Tools พร้อมกับระบบปฏิบัติการและเชิงพาณิชย์อื่น ๆ เช่นการสืบค้นฐานข้อมูล

งานเกี่ยวกับศัพท์ในปี 1980 ยังชี้ไปในทิศทางของวิธีแกรมมาติโก - ตรรกะ

ระยะที่สี่ (Lexical & Corpus Phase) - ทศวรรษที่ 1990

เราสามารถอธิบายสิ่งนี้เป็นเฟสศัพท์ & คลังข้อมูล ขั้นตอนนี้มีการใช้คำศัพท์เกี่ยวกับไวยากรณ์ที่ปรากฏในช่วงปลายทศวรรษ 1980 และกลายเป็นอิทธิพลที่เพิ่มขึ้น มีการปฏิวัติการประมวลผลภาษาธรรมชาติในทศวรรษนี้ด้วยการนำอัลกอริทึมการเรียนรู้ของเครื่องมาใช้สำหรับการประมวลผลภาษา

การศึกษาภาษามนุษย์

ภาษาเป็นองค์ประกอบที่สำคัญสำหรับชีวิตมนุษย์และยังเป็นลักษณะพื้นฐานที่สุดของพฤติกรรมของเรา เราสามารถสัมผัสได้ในสองรูปแบบส่วนใหญ่คือเขียนและพูด ในรูปแบบที่เป็นลายลักษณ์อักษรเป็นวิธีการส่งผ่านความรู้ของเราจากรุ่นหนึ่งไปยังรุ่นต่อไป ในรูปแบบการพูดมันเป็นสื่อหลักสำหรับมนุษย์ในการประสานงานซึ่งกันและกันในพฤติกรรมประจำวันของพวกเขา ภาษาได้รับการศึกษาในสาขาวิชาการต่างๆ ระเบียบวินัยแต่ละข้อมีชุดปัญหาของตัวเองและชุดวิธีแก้ไขเพื่อจัดการกับปัญหาเหล่านั้น

พิจารณาตารางต่อไปนี้เพื่อทำความเข้าใจสิ่งนี้ -

| ระเบียบวินัย | ปัญหา | เครื่องมือ |

|---|---|---|

นักภาษาศาสตร์ |

วลีและประโยคสามารถสร้างขึ้นด้วยคำได้อย่างไร? อะไรเป็นตัวยับยั้งความหมายที่เป็นไปได้ของประโยค? |

สัญชาตญาณเกี่ยวกับรูปร่างที่ดีและความหมาย แบบจำลองโครงสร้างทางคณิตศาสตร์ ตัวอย่างเช่นความหมายเชิงทฤษฎีแบบจำลองทฤษฎีภาษาที่เป็นทางการ |

นักจิตวิทยา |

มนุษย์สามารถระบุโครงสร้างของประโยคได้อย่างไร? ความหมายของคำสามารถระบุได้อย่างไร? ความเข้าใจเกิดขึ้นเมื่อใด |

เทคนิคการทดลองส่วนใหญ่สำหรับการวัดประสิทธิภาพของมนุษย์ การวิเคราะห์ทางสถิติของการสังเกต |

นักปรัชญา |

คำและประโยคได้รับความหมายอย่างไร? วัตถุถูกระบุด้วยคำพูดอย่างไร? มันหมายความว่าอะไร? |

การโต้แย้งภาษาธรรมชาติโดยใช้สัญชาตญาณ แบบจำลองทางคณิตศาสตร์เช่นตรรกะและทฤษฎีแบบจำลอง |

นักภาษาศาสตร์เชิงคำนวณ |

เราจะระบุโครงสร้างของประโยคได้อย่างไร ความรู้และเหตุผลสามารถจำลองได้อย่างไร? เราจะใช้ภาษาเพื่อทำงานบางอย่างให้สำเร็จได้อย่างไร? |

อัลกอริทึม โครงสร้างข้อมูล แบบจำลองทางการของการแสดงและการให้เหตุผล เทคนิค AI เช่นวิธีการค้นหาและการเป็นตัวแทน |

ความคลุมเครือและความไม่แน่นอนในภาษา

ความคลุมเครือโดยทั่วไปใช้ในการประมวลผลภาษาธรรมชาติสามารถเรียกได้ว่าเป็นความสามารถในการเข้าใจได้มากกว่าหนึ่งวิธี พูดง่ายๆก็คือเราสามารถพูดได้ว่าความคลุมเครือคือความสามารถในการเข้าใจได้มากกว่าหนึ่งวิธี ภาษาธรรมชาติมีความคลุมเครือมาก NLP มีความคลุมเครือประเภทต่อไปนี้ -

ความคลุมเครือของคำศัพท์

ความไม่ชัดเจนของคำเดียวเรียกว่าความไม่ชัดเจนของศัพท์ ตัวอย่างเช่นการรักษาคำsilver เป็นคำนามคำคุณศัพท์หรือคำกริยา

ความไม่ชัดเจนของไวยากรณ์

ความคลุมเครือประเภทนี้เกิดขึ้นเมื่อมีการแยกวิเคราะห์ประโยคในรูปแบบต่างๆ ตัวอย่างเช่นประโยค“ ชายเห็นหญิงสาวด้วยกล้องโทรทรรศน์” มีความคลุมเครือว่าชายคนนั้นเห็นหญิงสาวถือกล้องโทรทรรศน์หรือเขาเห็นเธอผ่านกล้องโทรทรรศน์ของเขา

ความไม่ชัดเจนของความหมาย

ความคลุมเครือแบบนี้เกิดขึ้นเมื่อความหมายของคำพูดนั้นสามารถตีความผิดได้ กล่าวอีกนัยหนึ่งความคลุมเครือทางความหมายจะเกิดขึ้นเมื่อประโยคมีคำหรือวลีที่คลุมเครือ ตัวอย่างเช่นประโยค“ รถชนเสาขณะที่กำลังเคลื่อนที่” มีความหมายไม่ชัดเจนเนื่องจากการตีความอาจเป็น“ รถขณะเคลื่อนที่ชนเสา” และ“ รถชนเสาขณะที่เสากำลังเคลื่อนที่”

Anaphoric Ambiguity

ความคลุมเครือแบบนี้เกิดขึ้นเนื่องจากการใช้เอนทิตี anaphora ในวาทกรรม ตัวอย่างเช่นม้าวิ่งขึ้นเขา มันชันมาก ไม่นานมันก็เหนื่อย ในที่นี้การอ้างอิงเชิงอนาล็อกของ "มัน" ในสองสถานการณ์ทำให้เกิดความคลุมเครือ

ความคลุมเครือในทางปฏิบัติ

ความคลุมเครือดังกล่าวหมายถึงสถานการณ์ที่บริบทของวลีทำให้เกิดการตีความหลายอย่าง พูดง่ายๆเราสามารถพูดได้ว่าความคลุมเครือในทางปฏิบัติเกิดขึ้นเมื่อข้อความนั้นไม่ได้เจาะจง ตัวอย่างเช่นประโยค“ ฉันชอบคุณเหมือนกัน” สามารถตีความได้หลายแบบเช่นฉันชอบคุณ (เช่นเดียวกับที่คุณชอบฉัน) ฉันชอบคุณ (เหมือนกับที่คนอื่นพูด)

ขั้นตอน NLP

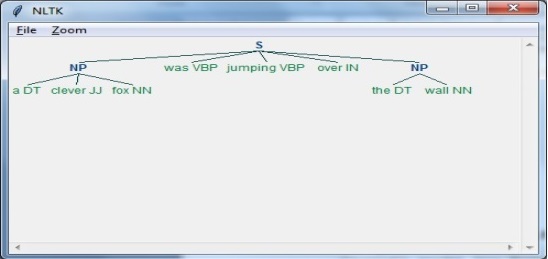

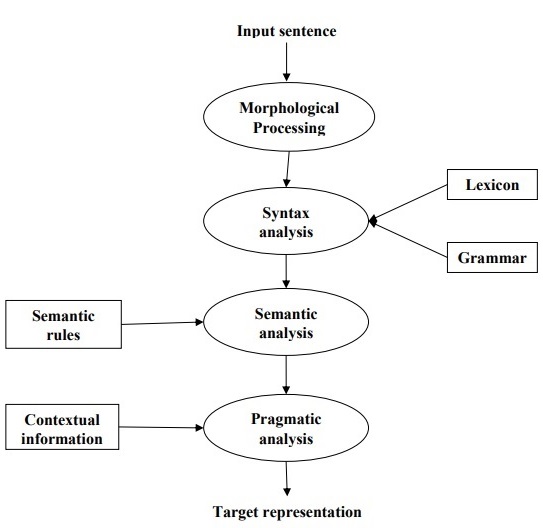

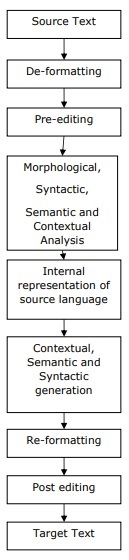

แผนภาพต่อไปนี้แสดงขั้นตอนหรือขั้นตอนเชิงตรรกะในการประมวลผลภาษาธรรมชาติ -

การประมวลผลทางสัณฐานวิทยา

เป็นช่วงแรกของ NLP จุดประสงค์ของขั้นตอนนี้คือการแบ่งส่วนของการป้อนภาษาออกเป็นชุดของโทเค็นที่สอดคล้องกับย่อหน้าประโยคและคำ ตัวอย่างเช่นคำเช่น“uneasy” สามารถแบ่งออกเป็นโทเค็นสองคำย่อยเป็น “un-easy”.

การวิเคราะห์ไวยากรณ์

เป็นระยะที่สองของ NLP จุดประสงค์ของระยะนี้มีสองเท่า: เพื่อตรวจสอบว่าประโยคนั้นมีรูปแบบที่ถูกต้องหรือไม่และแบ่งเป็นโครงสร้างที่แสดงความสัมพันธ์ทางวากยสัมพันธ์ระหว่างคำต่างๆ ตัวอย่างเช่นประโยคเช่น“The school goes to the boy” จะถูกปฏิเสธโดยตัววิเคราะห์ไวยากรณ์หรือตัวแยกวิเคราะห์

การวิเคราะห์ความหมาย

เป็นระยะที่สามของ NLP จุดประสงค์ของขั้นตอนนี้คือการดึงความหมายที่แน่นอนหรือคุณสามารถพูดความหมายตามพจนานุกรมจากข้อความ ข้อความถูกตรวจสอบความหมาย ตัวอย่างเช่นตัววิเคราะห์ความหมายจะปฏิเสธประโยคเช่น“ ไอศกรีมร้อน”

การวิเคราะห์เชิงปฏิบัติ

เป็นระยะที่สี่ของ NLP การวิเคราะห์เชิงปฏิบัตินั้นเหมาะกับวัตถุ / เหตุการณ์จริงซึ่งมีอยู่ในบริบทที่กำหนดพร้อมการอ้างอิงวัตถุที่ได้รับในช่วงสุดท้าย (การวิเคราะห์เชิงความหมาย) ตัวอย่างเช่นประโยค“ ใส่กล้วยในตะกร้าบนชั้นวาง” สามารถตีความเชิงความหมายได้สองแบบและตัววิเคราะห์เชิงปฏิบัติจะเลือกระหว่างความเป็นไปได้ทั้งสองนี้

ในบทนี้เราจะเรียนรู้เกี่ยวกับแหล่งข้อมูลทางภาษาในการประมวลผลภาษาธรรมชาติ

คอร์ปัส

คลังข้อมูลคือชุดข้อความขนาดใหญ่และมีโครงสร้างที่เครื่องอ่านได้ซึ่งผลิตขึ้นในสภาพแวดล้อมที่มีการสื่อสารตามธรรมชาติ พหูพจน์ของมันคือ corpora สามารถรับมาได้ในรูปแบบต่างๆเช่นข้อความที่เป็นแบบอิเล็กทรอนิกส์การถอดเสียงเป็นภาษาพูดและการรู้จำอักขระด้วยแสงเป็นต้น

องค์ประกอบของการออกแบบคอร์ปัส

ภาษาไม่มีที่สิ้นสุด แต่ต้องมีขนาดที่ จำกัด เพื่อให้คลังข้อมูลมีขนาด จำกัด เราจำเป็นต้องสุ่มตัวอย่างและรวมประเภทข้อความที่หลากหลายตามสัดส่วนเพื่อให้แน่ใจว่ามีการออกแบบคลังข้อมูลที่ดี

ตอนนี้ให้เราเรียนรู้เกี่ยวกับองค์ประกอบที่สำคัญบางอย่างสำหรับการออกแบบคลังข้อมูล -

การเป็นตัวแทนของคอร์ปัส

ความเป็นตัวแทนเป็นคุณสมบัติที่กำหนดของการออกแบบคอร์ปัส คำจำกัดความต่อไปนี้จากนักวิจัยผู้ยิ่งใหญ่สองคน - Leech and Biber จะช่วยให้เราเข้าใจการเป็นตัวแทนของคอร์ปัส -

According to Leech (1991), “ คลังข้อมูลถูกคิดว่าเป็นตัวแทนของความหลากหลายของภาษาซึ่งควรจะเป็นตัวแทนว่าการค้นพบตามเนื้อหาสามารถนำไปสู่ความหลากหลายของภาษาดังกล่าวได้หรือไม่”

According to Biber (1993), “ ความเป็นตัวแทนหมายถึงขอบเขตที่กลุ่มตัวอย่างมีความแปรปรวนทั้งหมดในประชากร”

ด้วยวิธีนี้เราสามารถสรุปได้ว่าการเป็นตัวแทนของคลังข้อมูลถูกกำหนดโดยปัจจัยสองประการต่อไปนี้ -

Balance - ช่วงของประเภทรวมอยู่ในคลังข้อมูล

Sampling - วิธีการเลือกชิ้นส่วนสำหรับแต่ละประเภท

คอร์ปัสบาลานซ์

องค์ประกอบที่สำคัญมากอีกอย่างของการออกแบบคลังข้อมูลคือความสมดุลของคลังข้อมูลซึ่งเป็นช่วงของประเภทที่รวมอยู่ในคลังข้อมูล เราได้ศึกษาแล้วว่าการเป็นตัวแทนของคลังข้อมูลทั่วไปนั้นขึ้นอยู่กับความสมดุลของคลังข้อมูล คลังข้อมูลที่สมดุลครอบคลุมหมวดหมู่ข้อความที่หลากหลายซึ่งควรจะเป็นตัวแทนของภาษา เราไม่มีมาตรการทางวิทยาศาสตร์ที่เชื่อถือได้สำหรับความสมดุล แต่การประมาณค่าและสัญชาตญาณที่ดีที่สุดใช้ได้ผลในข้อกังวลนี้ กล่าวอีกนัยหนึ่งเราสามารถพูดได้ว่ายอดคงเหลือที่ยอมรับนั้นพิจารณาจากการใช้งานตามวัตถุประสงค์เท่านั้น

การสุ่มตัวอย่าง

องค์ประกอบที่สำคัญอีกประการหนึ่งของการออกแบบคลังข้อมูลคือการสุ่มตัวอย่าง ความเป็นตัวแทนและความสมดุลของคอร์ปัสมีความสัมพันธ์อย่างใกล้ชิดกับการสุ่มตัวอย่าง นั่นคือเหตุผลที่เรากล่าวได้ว่าการสุ่มตัวอย่างเป็นสิ่งที่หลีกเลี่ยงไม่ได้ในการสร้างคลังข้อมูล

ตาม Biber(1993)“ ข้อควรพิจารณาประการแรกบางประการในการสร้างคลังข้อมูลเกี่ยวข้องกับการออกแบบโดยรวมเช่นประเภทของข้อความจำนวนข้อความการเลือกข้อความเฉพาะการเลือกตัวอย่างข้อความจากภายในข้อความและความยาวของข้อความ ตัวอย่าง สิ่งเหล่านี้เกี่ยวข้องกับการตัดสินใจสุ่มตัวอย่างไม่ว่าจะโดยรู้ตัวหรือไม่ก็ตาม”

ในขณะที่ได้รับตัวอย่างตัวแทนเราจำเป็นต้องพิจารณาสิ่งต่อไปนี้ -

Sampling unit- หมายถึงหน่วยที่ต้องใช้ตัวอย่าง ตัวอย่างเช่นสำหรับข้อความที่เป็นลายลักษณ์อักษรหน่วยการสุ่มตัวอย่างอาจเป็นหนังสือพิมพ์วารสารหรือหนังสือ

Sampling frame - รายการของหน่วยการสุ่มตัวอย่างอัลเรียกว่ากรอบการสุ่มตัวอย่าง

Population- อาจเรียกว่าการประกอบของหน่วยการสุ่มตัวอย่างทั้งหมด มีการกำหนดในแง่ของการผลิตภาษาการรับภาษาหรือภาษาเป็นผลิตภัณฑ์

ขนาดคอร์ปัส

องค์ประกอบที่สำคัญอีกประการหนึ่งของการออกแบบคอร์ปัสคือขนาด คอร์ปัสควรมีขนาดใหญ่แค่ไหน? ไม่มีคำตอบเฉพาะสำหรับคำถามนี้ ขนาดของคลังข้อมูลขึ้นอยู่กับวัตถุประสงค์ที่ต้องการรวมทั้งข้อควรพิจารณาในทางปฏิบัติดังนี้ -

ประเภทของคำถามที่คาดหวังจากผู้ใช้

วิธีการที่ผู้ใช้ใช้ในการศึกษาข้อมูล

ความพร้อมใช้งานของแหล่งข้อมูล

ด้วยความก้าวหน้าทางเทคโนโลยีขนาดของคอร์ปัสก็เพิ่มขึ้นด้วย ตารางเปรียบเทียบต่อไปนี้จะช่วยให้คุณเข้าใจว่าขนาดคลังข้อมูลทำงานอย่างไร -

| ปี | ชื่อคอร์ปัส | ขนาด (เป็นคำ) |

|---|---|---|

| ทศวรรษ 1960 - 70 | บราวน์และลอบ | 1 ล้านคำ |

| ทศวรรษที่ 1980 | บริษัท เบอร์มิงแฮม | 20 ล้านคำ |

| ทศวรรษที่ 1990 | คลังข้อมูลแห่งชาติอังกฤษ | 100 ล้านคำ |

| ในช่วงต้น 21 เซนต์ศตวรรษ | คลังข้อมูลของธนาคารแห่งอังกฤษ | 650 ล้านคำ |

ในส่วนต่อไปเราจะดูตัวอย่างของคลังข้อมูล

TreeBank Corpus

อาจถูกกำหนดให้เป็นคลังข้อความที่แยกวิเคราะห์ทางภาษาที่อธิบายโครงสร้างประโยควากยสัมพันธ์หรือความหมาย Geoffrey Leech เป็นผู้บัญญัติศัพท์คำว่า 'ธนาคารต้นไม้' ซึ่งแสดงให้เห็นว่าวิธีที่ใช้กันทั่วไปในการวิเคราะห์ไวยากรณ์โดยใช้โครงสร้างของต้นไม้ โดยทั่วไป Treebanks จะถูกสร้างขึ้นที่ด้านบนของคลังข้อมูลซึ่งได้รับการใส่คำอธิบายประกอบไว้แล้วด้วยแท็กส่วนของคำพูด

ประเภทของ TreeBank Corpus

Treebanks เชิงความหมายและไวยากรณ์เป็น Treebanks สองประเภทที่พบบ่อยที่สุดในด้านภาษาศาสตร์ ให้เราเรียนรู้เพิ่มเติมเกี่ยวกับประเภทเหล่านี้ -

ความหมายของ Treebanks

Treebanks เหล่านี้ใช้การแสดงโครงสร้างความหมายของประโยคอย่างเป็นทางการ พวกเขาแตกต่างกันไปในเชิงลึกของการแสดงความหมาย Robot Commands Treebank, Geoquery, Groningen Meaning Bank, RoboCup Corpus คือตัวอย่างของ Semantic Treebanks

ธนาคารต้นไม้ Syntactic

ตรงข้ามกับความหมายของ Treebanks อินพุตของระบบ Syntactic Treebank คือนิพจน์ของภาษาทางการที่ได้จากการแปลงข้อมูล Treebank ที่แยกวิเคราะห์ ผลลัพธ์ของระบบดังกล่าวเป็นการแสดงความหมายตามตรรกะเพรดิเคต Treebanks วากยสัมพันธ์ต่างๆในภาษาต่างๆได้ถูกสร้างขึ้นแล้ว ตัวอย่างเช่น,Penn Arabic Treebank, Columbia Arabic Treebank เป็นรูปแบบของ Treebanks ที่สร้างขึ้นในภาษาอาระเบีย Sininca ไวยากรณ์ Treebank สร้างขึ้นในภาษาจีน Lucy, Susane และ BLLIP WSJ คลังคำที่สร้างขึ้นในภาษาอังกฤษ

การใช้งาน TreeBank Corpus

ต่อไปนี้เป็นแอพพลิเคชั่นบางส่วนของ TreeBanks -

ในภาษาศาสตร์เชิงคำนวณ

หากเราพูดถึงภาษาเชิงคำนวณการใช้ TreeBanks ที่ดีที่สุดคือการออกแบบระบบประมวลผลภาษาธรรมชาติที่ล้ำสมัยเช่นแท็กเกอร์ส่วนหนึ่งของคำพูดตัววิเคราะห์ความหมายและระบบแปลด้วยเครื่อง

ในภาษาศาสตร์คอร์ปัส

ในกรณีของภาษาศาสตร์ Corpus การใช้ Treebanks ที่ดีที่สุดคือการศึกษาปรากฏการณ์ทางวากยสัมพันธ์

ในภาษาศาสตร์เชิงทฤษฎีและจิตวิเคราะห์

การใช้ Treebanks ที่ดีที่สุดในเชิงทฤษฎีและจิตวิเคราะห์คือหลักฐานการโต้ตอบ

PropBank Corpus

PropBank เรียกโดยเฉพาะว่า“ Proposition Bank” คือคลังข้อมูลซึ่งมีคำอธิบายประกอบด้วยข้อเสนอด้วยวาจาและข้อโต้แย้ง คลังข้อมูลเป็นทรัพยากรที่เน้นคำกริยา คำอธิบายประกอบที่นี่มีความสัมพันธ์อย่างใกล้ชิดกับระดับวากยสัมพันธ์มากขึ้น Martha Palmer et al. ภาควิชาภาษาศาสตร์มหาวิทยาลัยโคโลราโดโบลเดอร์ได้พัฒนาขึ้น เราสามารถใช้คำว่า PropBank เป็นคำนามทั่วไปที่อ้างถึงคลังข้อมูลใด ๆ ที่มีคำอธิบายประกอบด้วยประพจน์และอาร์กิวเมนต์

ในการประมวลผลภาษาธรรมชาติ (NLP) โครงการ PropBank มีบทบาทสำคัญมาก ช่วยในการติดฉลากบทบาทเชิงความหมาย

VerbNet (VN)

VerbNet (VN) เป็นแหล่งคำศัพท์ที่ไม่ขึ้นกับโดเมนตามลำดับชั้นและมีคำศัพท์ที่ใหญ่ที่สุดในภาษาอังกฤษซึ่งรวมเอาทั้งข้อมูลความหมายและข้อมูลวากยสัมพันธ์เกี่ยวกับเนื้อหา VN เป็นศัพท์คำกริยาที่ครอบคลุมกว้างซึ่งมีการแมปกับแหล่งคำศัพท์อื่น ๆ เช่น WordNet, Xtag และ FrameNet จัดเป็นคลาสกริยาที่ขยายคลาสเลวินโดยการปรับแต่งและเพิ่มคลาสย่อยเพื่อให้บรรลุการเชื่อมโยงกันของวากยสัมพันธ์และความหมายระหว่างสมาชิกชั้นเรียน

แต่ละคลาส VerbNet (VN) ประกอบด้วย -

ชุดคำอธิบายทางวากยสัมพันธ์หรือกรอบวากยสัมพันธ์

สำหรับการพรรณนาถึงการรับรู้พื้นผิวที่เป็นไปได้ของโครงสร้างอาร์กิวเมนต์สำหรับสิ่งก่อสร้างเช่นสกรรมกริยาอกรรมกริยาบุพบทวลีผลลัพธ์และการสลับไดอะเทซิสชุดใหญ่

ชุดคำอธิบายเชิงความหมายเช่นภาพเคลื่อนไหวมนุษย์องค์กร

สำหรับการ จำกัด ประเภทของบทบาทเฉพาะเรื่องที่อนุญาตโดยอาร์กิวเมนต์และอาจมีการกำหนดข้อ จำกัด เพิ่มเติม สิ่งนี้จะช่วยในการระบุลักษณะทางวากยสัมพันธ์ขององค์ประกอบที่น่าจะเกี่ยวข้องกับบทบาทเฉพาะเรื่อง

WordNet

WordNet สร้างโดย Princeton เป็นฐานข้อมูลคำศัพท์สำหรับภาษาอังกฤษ เป็นส่วนหนึ่งของคลังข้อมูล NLTK ใน WordNet คำนามคำกริยาคำคุณศัพท์และคำวิเศษณ์จะถูกจัดกลุ่มเป็นชุดของคำพ้องความหมายที่เรียกว่าSynsets. synsets ทั้งหมดเชื่อมโยงด้วยความช่วยเหลือของความสัมพันธ์เชิงแนวคิด - ความหมายและคำศัพท์ โครงสร้างของมันทำให้มีประโยชน์มากสำหรับการประมวลผลภาษาธรรมชาติ (NLP)

ในระบบสารสนเทศ WordNet ถูกใช้เพื่อวัตถุประสงค์ต่างๆเช่นการลดทอนความรู้สึกของคำการดึงข้อมูลการจัดประเภทข้อความอัตโนมัติและการแปลด้วยเครื่อง การใช้ WordNet ที่สำคัญที่สุดอย่างหนึ่งคือการค้นหาความคล้ายคลึงกันระหว่างคำต่างๆ สำหรับงานนี้อัลกอริทึมต่างๆได้ถูกนำมาใช้ในแพ็คเกจต่างๆเช่น Similarity in Perl, NLTK ใน Python และ ADW ใน Java

ในบทนี้เราจะเข้าใจการวิเคราะห์ระดับโลกในการประมวลผลภาษาธรรมชาติ

นิพจน์ทั่วไป

นิพจน์ทั่วไป (RE) เป็นภาษาสำหรับระบุสตริงการค้นหาข้อความ RE ช่วยให้เราจับคู่หรือค้นหาสตริงหรือชุดของสตริงอื่น ๆ โดยใช้ไวยากรณ์เฉพาะที่จัดขึ้นในรูปแบบ นิพจน์ทั่วไปใช้เพื่อค้นหาข้อความใน UNIX และ MS WORD ในลักษณะเดียวกัน เรามีเครื่องมือค้นหาที่หลากหลายโดยใช้คุณสมบัติ RE จำนวนมาก

คุณสมบัติของนิพจน์ทั่วไป

คุณสมบัติที่สำคัญบางประการของ RE -

Stephen Cole Kleene นักคณิตศาสตร์ชาวอเมริกันได้ปรับเปลี่ยนภาษานิพจน์ทั่วไปอย่างเป็นทางการ

RE เป็นสูตรในภาษาพิเศษซึ่งสามารถใช้ในการระบุคลาสของสตริงที่เรียบง่ายลำดับของสัญลักษณ์ กล่าวอีกนัยหนึ่งเราสามารถพูดได้ว่า RE เป็นสัญกรณ์เกี่ยวกับพีชคณิตสำหรับกำหนดลักษณะชุดของสตริง

นิพจน์ทั่วไปต้องการสองสิ่งหนึ่งคือรูปแบบที่เราต้องการค้นหาและอื่น ๆ คือคลังของข้อความที่เราต้องการค้นหา

ในทางคณิตศาสตร์นิพจน์ทั่วไปสามารถกำหนดได้ดังนี้ -

ε เป็นนิพจน์ทั่วไปซึ่งบ่งชี้ว่าภาษากำลังมีสตริงว่างเปล่า

φ เป็นนิพจน์ทั่วไปซึ่งแสดงว่าเป็นภาษาว่างเปล่า

ถ้า X และ Y เป็นนิพจน์ทั่วไปแล้ว

X, Y

X.Y(Concatenation of XY)

X+Y (Union of X and Y)

X*, Y* (Kleen Closure of X and Y)

ยังเป็นนิพจน์ทั่วไป

ถ้าสตริงมาจากกฎข้างต้นนั่นก็จะเป็นนิพจน์ทั่วไปเช่นกัน

ตัวอย่างนิพจน์ทั่วไป

ตารางต่อไปนี้แสดงตัวอย่างบางส่วนของนิพจน์ทั่วไป -

| นิพจน์ทั่วไป | ชุดปกติ |

|---|---|

| (0 + 10 *) | {0, 1, 10, 100, 1000, 10,000, …} |

| (0 * 10 *) | {1, 01, 10, 010, 0010, …} |

| (0 + ε) (1 + ε) | {ε, 0, 1, 01} |

| (a + b) * | มันจะเป็นชุดของสตริงของ a และ b ที่มีความยาวเท่าใดก็ได้ซึ่งรวมถึงสตริงว่างเช่น {ε, a, b, aa, ab, bb, ba, aaa …….} |

| (a + b) * abb | มันจะเป็นชุดของสตริงของ a และ b ที่ลงท้ายด้วยสตริง abb เช่น {abb, aabb, babb, aaabb, ababb, ………… .. } |

| (11) * | มันจะถูกกำหนดให้ประกอบด้วยเลขคู่ของ 1 ซึ่งรวมถึงสตริงว่างเช่น {ε, 11, 1111, 111111, ……….} |

| (aa) * (bb) * ข | มันจะเป็นชุดของสตริงที่ประกอบด้วยจำนวนคู่ของ a ตามด้วยจำนวนคี่ของ b เช่น {b, aab, aabbb, aabbbbb, aaaab, aaaabbb, ………… .. } |

| (aa + ab + ba + bb) * | มันจะเป็นสตริงของ a และ b ที่มีความยาวเท่ากันซึ่งหาได้จากการต่อสายอักขระ aa, ab, ba และ bb รวมทั้ง null เช่น {aa, ab, ba, bb, aaab, aaba, …………. .} |

ชุดปกติและคุณสมบัติของพวกเขา

อาจถูกกำหนดให้เป็นชุดที่แสดงถึงค่าของนิพจน์ทั่วไปและประกอบด้วยคุณสมบัติเฉพาะ

คุณสมบัติของชุดปกติ

ถ้าเรารวมชุดปกติสองชุดผลลัพธ์ก็จะเป็น regula ด้วย

ถ้าเราทำการตัดกันของชุดปกติสองชุดผลลัพธ์ก็จะเป็นปกติเช่นกัน

ถ้าเราเติมเต็มของเซ็ตปกติเซตผลลัพธ์ก็จะเป็นแบบปกติเช่นกัน

ถ้าเราสร้างความแตกต่างของชุดปกติสองชุดผลลัพธ์ก็จะเป็นปกติเช่นกัน

ถ้าเราทำการย้อนกลับของเซ็ตปกติเซตที่ได้ผลลัพธ์ก็จะเป็นปกติเช่นกัน

หากเราทำการปิดเซ็ตปกติเซตที่ได้ผลลัพธ์ก็จะเป็นแบบปกติเช่นกัน

ถ้าเราทำการต่อกันของชุดปกติสองชุดผลลัพธ์ก็จะเป็นแบบปกติเช่นกัน

Finite State Automata

คำว่าออโตมาตาซึ่งมาจากคำภาษากรีก "αὐτόματα" ซึ่งหมายถึง "การแสดงด้วยตนเอง" เป็นพหูพจน์ของออโตมาตอนซึ่งอาจนิยามได้ว่าเป็นอุปกรณ์คอมพิวเตอร์ที่ขับเคลื่อนด้วยตัวเองแบบนามธรรม

หุ่นยนต์ที่มีสถานะจำนวน จำกัด เรียกว่า Finite Automaton (FA) หรือ Finite State automata (FSA)

ในทางคณิตศาสตร์หุ่นยนต์สามารถแทนด้วย 5 ทูเพิล (Q, Σ, δ, q0, F) โดยที่ -

Q คือชุดสถานะที่ จำกัด

Σเป็นชุดสัญลักษณ์ที่ จำกัด เรียกว่าตัวอักษรของหุ่นยนต์

δคือฟังก์ชันการเปลี่ยนแปลง

q0 คือสถานะเริ่มต้นจากการประมวลผลอินพุตใด ๆ (q0 ∈ Q)

F คือชุดของสถานะสุดท้าย / สถานะของ Q (F ⊆ Q)

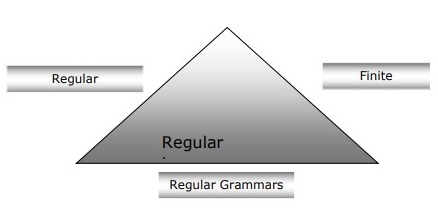

ความสัมพันธ์ระหว่าง Finite Automata, Regular Grammars และ Regular Expressions

ประเด็นต่อไปนี้จะทำให้เรามีมุมมองที่ชัดเจนเกี่ยวกับความสัมพันธ์ระหว่าง จำกัด ออโตมาตาไวยากรณ์ปกติและนิพจน์ทั่วไป -

อย่างที่เราทราบกันดีว่าออโตมาตาแบบ จำกัด เป็นรากฐานทางทฤษฎีของงานคำนวณและนิพจน์ทั่วไปเป็นวิธีหนึ่งในการอธิบาย

เราสามารถพูดได้ว่านิพจน์ทั่วไปสามารถนำไปใช้เป็น FSA และ FSA ใด ๆ สามารถอธิบายได้ด้วยนิพจน์ทั่วไป

ในทางกลับกันนิพจน์ทั่วไปเป็นวิธีการกำหนดลักษณะของภาษาที่เรียกว่าภาษาปกติ ดังนั้นเราสามารถพูดได้ว่าภาษาปกติสามารถอธิบายได้ด้วยความช่วยเหลือของ FSA และนิพจน์ทั่วไป

ไวยากรณ์ปกติซึ่งเป็นไวยากรณ์ที่เป็นทางการซึ่งอาจเป็นแบบขวาปกติหรือแบบซ้ายปกติเป็นอีกวิธีหนึ่งในการกำหนดลักษณะของภาษาปกติ

แผนภาพต่อไปนี้แสดงให้เห็นว่าออโตมาตา จำกัด นิพจน์ทั่วไปและไวยากรณ์ทั่วไปเป็นวิธีที่เทียบเท่ากันในการอธิบายภาษาทั่วไป

ประเภทของ Finite State Automation (FSA)

ระบบอัตโนมัติแบบ จำกัด มีสองประเภท ให้เราดูว่ามีอะไรบ้าง

ระบบอัตโนมัติ จำกัด ที่กำหนด (DFA)

อาจถูกกำหนดให้เป็นประเภทของระบบอัตโนมัติแบบ จำกัด ซึ่งสำหรับสัญลักษณ์อินพุตทุกตัวเราสามารถกำหนดสถานะที่เครื่องจักรจะเคลื่อนที่ได้ มีสถานะจำนวน จำกัด ซึ่งเป็นสาเหตุที่เครื่องเรียกว่า Deterministic Finite Automaton (DFA)

ในทางคณิตศาสตร์ DFA สามารถแทนได้ด้วย 5-tuple (Q, Σ, δ, q0, F) โดยที่ -

Q คือชุดสถานะที่ จำกัด

Σเป็นชุดสัญลักษณ์ที่ จำกัด เรียกว่าตัวอักษรของหุ่นยนต์

δคือฟังก์ชันการเปลี่ยนโดยที่δ: Q ×Σ→ Q

q0 คือสถานะเริ่มต้นจากการประมวลผลอินพุตใด ๆ (q0 ∈ Q)

F คือชุดของสถานะสุดท้าย / สถานะของ Q (F ⊆ Q)

ในขณะที่กราฟิก DFA สามารถแสดงด้วยไดอะกราฟที่เรียกว่าไดอะแกรมสถานะโดยที่ -

รัฐแสดงโดย vertices.

การเปลี่ยนจะแสดงตามป้ายกำกับ arcs.

สถานะเริ่มต้นแสดงโดย empty incoming arc.

สถานะสุดท้ายแสดงโดย double circle.

ตัวอย่าง DFA

สมมติว่า DFA เป็น

ถาม = {a, b, c},

Σ = {0, 1},

q 0 = {a}

F = {c}

ฟังก์ชันการเปลี่ยน Trans แสดงในตารางดังนี้ -

| สถานะปัจจุบัน | สถานะถัดไปสำหรับอินพุต 0 | สถานะถัดไปสำหรับอินพุต 1 |

|---|---|---|

| ก | ก | ข |

| ข | ข | ก |

| ค | ค | ค |

การแสดงกราฟิกของ DFA นี้จะเป็นดังนี้ -

ระบบอัตโนมัติ จำกัด ที่ไม่กำหนด (NDFA)

อาจถูกกำหนดให้เป็นประเภทของระบบอัตโนมัติแบบ จำกัด โดยที่สำหรับสัญลักษณ์อินพุตทุกตัวเราไม่สามารถกำหนดสถานะที่เครื่องจักรจะเคลื่อนที่ได้กล่าวคือเครื่องสามารถเคลื่อนที่ไปยังสถานะใดก็ได้ มีสถานะจำนวน จำกัด ซึ่งเป็นสาเหตุที่เครื่องเรียกว่า Non-กำหนด Finite Automation (NDFA)

ในทางคณิตศาสตร์ NDFA สามารถแทนค่าได้ด้วย 5-tuple (Q, Σ, δ, q0, F) โดยที่ -

Q คือชุดสถานะที่ จำกัด

Σเป็นชุดสัญลักษณ์ที่ จำกัด เรียกว่าตัวอักษรของหุ่นยนต์

δ: -is ฟังก์ชั่นการเปลี่ยนแปลงที่δ: Q ×Σ→ 2 Q

q0: - เป็นสถานะเริ่มต้นที่อินพุตใด ๆ ถูกประมวลผล (q0 ∈ Q)

F: - เป็นชุดของสถานะสุดท้าย / สถานะของ Q (F ⊆ Q)

ในขณะที่กราฟิก (เช่นเดียวกับ DFA) NDFA สามารถแสดงด้วยไดอะกราฟที่เรียกว่าไดอะแกรมสถานะโดยที่ -

รัฐแสดงโดย vertices.

การเปลี่ยนจะแสดงตามป้ายกำกับ arcs.

สถานะเริ่มต้นแสดงโดย empty incoming arc.

สถานะสุดท้ายจะแสดงด้วยคู่ circle.

ตัวอย่าง NDFA

สมมติว่า NDFA เป็น

ถาม = {a, b, c},

Σ = {0, 1},

q 0 = {a}

F = {c}

ฟังก์ชันการเปลี่ยน Trans แสดงในตารางดังนี้ -

| สถานะปัจจุบัน | สถานะถัดไปสำหรับอินพุต 0 | สถานะถัดไปสำหรับอินพุต 1 |

|---|---|---|

| ก | ก, ข | ข |

| ข | ค | ก, ค |

| ค | ข, ค | ค |

การแสดงกราฟิกของ NDFA นี้จะเป็นดังนี้ -

การแยกวิเคราะห์ทางสัณฐานวิทยา

คำว่าการแยกวิเคราะห์ทางสัณฐานวิทยาเกี่ยวข้องกับการแยกวิเคราะห์ของสัณฐานวิทยา เราสามารถกำหนดการแยกวิเคราะห์ทางสัณฐานวิทยาเป็นปัญหาในการรับรู้ว่าคำหนึ่ง ๆ แบ่งออกเป็นหน่วยที่มีความหมายขนาดเล็กเรียกว่าสัณฐานวิทยาซึ่งทำให้เกิดโครงสร้างทางภาษาบางประเภท ตัวอย่างเช่นเราสามารถทำลายคำว่าสุนัขจิ้งจอกเป็นสองสุนัขจิ้งจอกและ-es เราจะเห็นได้ว่าคำว่าสุนัขจิ้งจอกที่ทำขึ้นจากสอง morphemes หนึ่งคือสุนัขจิ้งจอกและอื่น ๆ ที่เป็น-es

ในอีกแง่หนึ่งเราสามารถพูดได้ว่าสัณฐานวิทยาคือการศึกษา -

การก่อตัวของคำ

ที่มาของคำ.

รูปแบบทางไวยากรณ์ของคำ

การใช้คำนำหน้าและคำต่อท้ายในการสร้างคำ

วิธีสร้างส่วนของคำพูด (PoS) ของภาษา

ประเภทของ Morphemes

Morphemes ซึ่งเป็นหน่วยที่มีความหมายที่เล็กที่สุดสามารถแบ่งออกเป็นสองประเภท -

Stems

ลำดับคำ

ลำต้น

เป็นหน่วยความหมายหลักของคำ นอกจากนี้เรายังสามารถพูดได้ว่าเป็นรากเหง้าของคำ ตัวอย่างเช่นในคำว่า foxes ก้านคือสุนัขจิ้งจอก

Affixes- ตามชื่อที่แนะนำพวกเขาเพิ่มความหมายเพิ่มเติมและฟังก์ชันทางไวยากรณ์ให้กับคำ ตัวอย่างเช่นในคำว่า foxes คำต่อท้ายคือ - es

นอกจากนี้การติดยังสามารถแบ่งออกเป็นสี่ประเภทดังต่อไปนี้ -

Prefixes- ตามชื่อที่แนะนำคำนำหน้าจะนำหน้าก้าน ตัวอย่างเช่นในคำว่า unbuckle un คือคำนำหน้า

Suffixes- ตามชื่อที่แนะนำคำต่อท้ายจะอยู่ตามลำต้น ตัวอย่างเช่นในคำว่าแมว -s คือคำต่อท้าย

Infixes- ตามชื่อที่แนะนำจะมีการสอดแทรกเข้าไปในก้าน ตัวอย่างเช่นคำว่า cupful สามารถทำให้เป็นพหูพจน์ได้โดยใช้ -s เป็น infix

Circumfixes- นำหน้าและตามลำต้น มีตัวอย่างของเส้นรอบวงในภาษาอังกฤษน้อยมาก ตัวอย่างที่พบบ่อยคือ 'A-ing' ซึ่งเราสามารถใช้ -A นำหน้าและ -ing ตามหลังก้าน

ลำดับคำ

ลำดับของคำจะถูกตัดสินโดยการแยกวิเคราะห์ทางสัณฐานวิทยา ตอนนี้ให้เราดูข้อกำหนดสำหรับการสร้างตัวแยกวิเคราะห์ทางสัณฐานวิทยา -

พจนานุกรมศัพท์

ข้อกำหนดแรกสุดสำหรับการสร้างตัวแยกวิเคราะห์สัณฐานวิทยาคือศัพท์ซึ่งรวมถึงรายการของลำต้นและสิ่งที่แนบมาพร้อมกับข้อมูลพื้นฐานเกี่ยวกับพวกมัน ตัวอย่างเช่นข้อมูลเช่นว่า stem เป็น Noun stem หรือ Verb stem เป็นต้น

Morphotactics

โดยพื้นฐานแล้วเป็นแบบจำลองของการสั่งซื้อแบบสัณฐาน ในอีกแง่หนึ่งโมเดลที่อธิบายว่าคลาสของ morphemes ใดที่สามารถทำตามคลาสอื่น ๆ ของ morphemes ภายในคำได้ ตัวอย่างเช่นความจริงทางสัณฐานวิทยาคือรูปพหูพจน์ภาษาอังกฤษมักจะตามหลังคำนามแทนที่จะนำหน้า

กฎออร์โธกราฟิก

กฎการสะกดเหล่านี้ใช้เพื่อจำลองการเปลี่ยนแปลงที่เกิดขึ้นในคำ ตัวอย่างเช่นกฎของการแปลง y เป็น ie ในคำเช่นเมือง + s = เมืองไม่ใช่เมือง

การวิเคราะห์เชิงไวยากรณ์หรือการแยกวิเคราะห์หรือการวิเคราะห์ไวยากรณ์เป็นขั้นตอนที่สามของ NLP จุดประสงค์ของขั้นตอนนี้คือการดึงความหมายที่แน่นอนหรือคุณสามารถพูดความหมายตามพจนานุกรมจากข้อความ การวิเคราะห์ไวยากรณ์จะตรวจสอบความหมายของข้อความโดยเปรียบเทียบกับกฎของไวยากรณ์ที่เป็นทางการ ตัวอย่างเช่นประโยคเช่น "hot ice-cream" จะถูกปฏิเสธโดยเครื่องวิเคราะห์ความหมาย

ในแง่นี้การวิเคราะห์วากยสัมพันธ์หรือการแยกวิเคราะห์อาจถูกกำหนดให้เป็นกระบวนการวิเคราะห์สตริงของสัญลักษณ์ในภาษาธรรมชาติที่สอดคล้องกับกฎของไวยากรณ์ที่เป็นทางการ ที่มาของคำ‘parsing’ มาจากคำภาษาละติน ‘pars’ ซึ่งหมายความว่า ‘part’.

แนวคิดของ Parser

ใช้เพื่อดำเนินงานในการแยกวิเคราะห์ อาจถูกกำหนดให้เป็นส่วนประกอบซอฟต์แวร์ที่ออกแบบมาสำหรับรับข้อมูลอินพุต (ข้อความ) และให้การแสดงโครงสร้างของอินพุตหลังจากตรวจสอบไวยากรณ์ที่ถูกต้องตามไวยากรณ์ที่เป็นทางการ นอกจากนี้ยังสร้างโครงสร้างข้อมูลโดยทั่วไปในรูปแบบของต้นไม้แยกวิเคราะห์หรือโครงสร้างไวยากรณ์นามธรรมหรือโครงสร้างลำดับชั้นอื่น ๆ

บทบาทหลักของการแยกวิเคราะห์ ได้แก่ -

เพื่อรายงานข้อผิดพลาดทางไวยากรณ์

เพื่อกู้คืนจากข้อผิดพลาดที่เกิดขึ้นโดยทั่วไปเพื่อให้การประมวลผลส่วนที่เหลือของโปรแกรมสามารถดำเนินต่อไปได้

เพื่อสร้างต้นไม้แยกวิเคราะห์

เพื่อสร้างตารางสัญลักษณ์

เพื่อสร้างตัวแทนระดับกลาง (IR)

ประเภทของการแยกวิเคราะห์

Derivation แบ่งการแยกวิเคราะห์ออกเป็นสองประเภทดังต่อไปนี้ -

การแยกวิเคราะห์จากบนลงล่าง

การแยกวิเคราะห์จากล่างขึ้นบน

การแยกวิเคราะห์จากบนลงล่าง

ในการแยกวิเคราะห์ประเภทนี้ตัวแยกวิเคราะห์จะเริ่มสร้างแผนผังการแยกวิเคราะห์จากสัญลักษณ์เริ่มต้นจากนั้นจึงพยายามเปลี่ยนสัญลักษณ์เริ่มต้นเป็นอินพุต รูปแบบที่พบบ่อยที่สุดของการแยกวิเคราะห์จากบนลงล่างใช้ขั้นตอนแบบวนซ้ำเพื่อประมวลผลอินพุต ข้อเสียเปรียบหลักของการแยกวิเคราะห์จากการสืบเชื้อสายซ้ำคือการย้อนรอย

การแยกวิเคราะห์จากล่างขึ้นบน

ในการแยกวิเคราะห์ประเภทนี้ตัวแยกวิเคราะห์จะเริ่มต้นด้วยสัญลักษณ์อินพุตและพยายามสร้างโครงสร้างตัวแยกวิเคราะห์จนถึงสัญลักษณ์เริ่มต้น

แนวคิดเกี่ยวกับการได้มา

ในการรับสตริงอินพุตเราจำเป็นต้องมีลำดับของกฎการผลิต Derivation คือชุดของกฎการผลิต ในระหว่างการแยกวิเคราะห์เราจำเป็นต้องตัดสินใจเกี่ยวกับ non-terminal ซึ่งจะถูกแทนที่พร้อมกับการตัดสินใจกฎการผลิตด้วยความช่วยเหลือที่จะเปลี่ยน non-terminal

ประเภทของการได้มา

ในส่วนนี้เราจะเรียนรู้เกี่ยวกับอนุพันธ์สองประเภทซึ่งสามารถใช้ในการตัดสินใจว่าจะแทนที่ขั้วใดด้วยกฎการผลิต -

การมาจากซ้ายสุด

ในรูปแบบซ้ายสุดรูปแบบความรู้สึกของอินพุตจะถูกสแกนและแทนที่จากทางซ้ายไปทางขวา รูปแบบความรู้สึกในกรณีนี้เรียกว่ารูปแบบความรู้สึกทางซ้าย

รากศัพท์ที่ถูกต้องที่สุด

ในรูปแบบซ้ายสุดรูปแบบความรู้สึกของอินพุตจะถูกสแกนและแทนที่จากขวาไปซ้าย รูปแบบความรู้สึกในกรณีนี้เรียกว่ารูปแบบความถูกต้อง

แนวคิดของ Parse Tree

อาจถูกกำหนดให้เป็นการแสดงภาพกราฟิกของการได้มา สัญลักษณ์เริ่มต้นของการได้มาทำหน้าที่เป็นรากของต้นไม้แยกวิเคราะห์ ในต้นไม้แยกวิเคราะห์ทุกต้นโหนดของใบไม้คือขั้วและโหนดภายในไม่ใช่ขั้ว คุณสมบัติของต้นไม้แยกวิเคราะห์คือการส่งผ่านตามลำดับจะสร้างสตริงอินพุตดั้งเดิม

แนวคิดของไวยากรณ์

ไวยากรณ์มีความจำเป็นและสำคัญมากในการอธิบายโครงสร้างทางวากยสัมพันธ์ของโปรแกรมที่มีรูปแบบดี ในแง่วรรณกรรมพวกเขาแสดงถึงกฎการสังเคราะห์สำหรับการสนทนาในภาษาธรรมชาติ ภาษาศาสตร์ได้พยายามกำหนดไวยากรณ์ตั้งแต่เริ่มใช้ภาษาธรรมชาติเช่นภาษาอังกฤษภาษาฮินดีเป็นต้น

ทฤษฎีของภาษาทางการยังสามารถใช้ได้ในสาขาวิทยาศาสตร์คอมพิวเตอร์ส่วนใหญ่เป็นภาษาโปรแกรมและโครงสร้างข้อมูล ตัวอย่างเช่นในภาษา 'C' กฎไวยากรณ์ที่ชัดเจนจะระบุวิธีการสร้างฟังก์ชันจากรายการและคำสั่ง

แบบจำลองทางคณิตศาสตร์ของไวยากรณ์ได้รับจาก Noam Chomsky ในปีพ. ศ. 2499 ซึ่งมีผลบังคับใช้สำหรับการเขียนภาษาคอมพิวเตอร์

ในทางคณิตศาสตร์ไวยากรณ์ G สามารถเขียนอย่างเป็นทางการเป็น 4-tuple (N, T, S, P) โดยที่ -

N หรือ VN = ชุดของสัญลักษณ์ที่ไม่ใช่เทอร์มินัลเช่นตัวแปร

T หรือ ∑ = ชุดสัญลักษณ์เทอร์มินัล

S = สัญลักษณ์เริ่มต้นโดยที่ S ∈ N

Pหมายถึงกฎการผลิตสำหรับเทอร์มินัลและไม่ใช่เทอร์มินัล มีรูปแบบα→βโดยที่αและβเป็นสตริงบน V N ∪ ∑ และสัญลักษณ์อย่างน้อยหนึ่งตัวของαเป็นของ V N

โครงสร้างวลีหรือไวยากรณ์ของเขตเลือกตั้ง

ไวยากรณ์โครงสร้างวลีนำโดย Noam Chomsky จะขึ้นอยู่กับความสัมพันธ์ของเขตเลือกตั้ง นั่นคือเหตุผลที่เรียกว่าไวยากรณ์ของเขตเลือกตั้ง มันตรงข้ามกับไวยากรณ์การพึ่งพา

ตัวอย่าง

ก่อนที่จะยกตัวอย่างไวยากรณ์เกี่ยวกับการแบ่งเขตเลือกตั้งเราจำเป็นต้องทราบประเด็นพื้นฐานเกี่ยวกับไวยากรณ์ของเขตเลือกตั้งและความสัมพันธ์ของเขตเลือกตั้ง

กรอบที่เกี่ยวข้องทั้งหมดดูโครงสร้างประโยคในแง่ของความสัมพันธ์ของเขตเลือกตั้ง

ความสัมพันธ์ของเขตเลือกตั้งนั้นมาจากการแบ่งหัวเรื่องของภาษาละตินและไวยากรณ์ภาษากรีก

โครงสร้างประโยคพื้นฐานเป็นที่เข้าใจในแง่ของ noun phrase NP และ verb phrase VP.

เราสามารถเขียนประโยค “This tree is illustrating the constituency relation” ดังต่อไปนี้ -

ไวยากรณ์การพึ่งพา

ตรงข้ามกับไวยากรณ์ของเขตเลือกตั้งและขึ้นอยู่กับความสัมพันธ์แบบพึ่งพา ได้รับการแนะนำโดย Lucien Tesniere ไวยากรณ์การพึ่งพา (DG) ตรงข้ามกับไวยากรณ์ของเขตเลือกตั้งเนื่องจากไม่มีโหนดวลี

ตัวอย่าง

ก่อนที่จะยกตัวอย่างไวยากรณ์ของการพึ่งพาเราจำเป็นต้องทราบประเด็นพื้นฐานเกี่ยวกับไวยากรณ์ของการพึ่งพาและความสัมพันธ์ของการพึ่งพา

ใน DG หน่วยทางภาษาคือคำเชื่อมต่อกันโดยการเชื่อมโยงโดยตรง

คำกริยากลายเป็นศูนย์กลางของโครงสร้างประโยค

หน่วยวากยสัมพันธ์อื่น ๆ ทุกหน่วยเชื่อมต่อกับคำกริยาในรูปของลิงก์กำกับ หน่วยวากยสัมพันธ์เหล่านี้เรียกว่าdependencies.

เราสามารถเขียนประโยค “This tree is illustrating the dependency relation” ดังนี้;

โครงสร้างการแยกวิเคราะห์ที่ใช้ไวยากรณ์ของเขตเลือกตั้งเรียกว่าโครงสร้างการแยกวิเคราะห์ตามเขตเลือกตั้ง และต้นไม้แยกวิเคราะห์ที่ใช้ไวยากรณ์การพึ่งพาเรียกว่าแผนผังการแยกวิเคราะห์ตามการพึ่งพา

ไวยากรณ์ฟรีตามบริบท

ไวยากรณ์ที่ไม่มีบริบทหรือที่เรียกว่า CFG เป็นสัญกรณ์สำหรับการอธิบายภาษาและส่วนเหนือของไวยากรณ์ปกติ สามารถดูได้ในแผนภาพต่อไปนี้ -

คำจำกัดความของ CFG

CFG ประกอบด้วยชุดกฎไวยากรณ์ที่ จำกัด โดยมีองค์ประกอบสี่ส่วนต่อไปนี้ -

ชุดที่ไม่ใช่ขั้ว

แสดงโดย V. ส่วนที่ไม่ใช่เทอร์มินัลเป็นตัวแปรทางวากยสัมพันธ์ที่แสดงถึงชุดของสตริงซึ่งช่วยในการกำหนดภาษาเพิ่มเติมซึ่งสร้างโดยไวยากรณ์

ชุดขั้ว

เรียกอีกอย่างว่าโทเค็นและกำหนดโดยΣ สตริงถูกสร้างขึ้นด้วยสัญลักษณ์พื้นฐานของเทอร์มินัล

ชุดโปรดักชั่น

แสดงโดย P. ชุดนี้กำหนดวิธีการรวมขั้วและไม่ใช่ขั้ว ทุกการผลิต (P) ประกอบด้วยขั้วที่ไม่ใช่ขั้วลูกศรและขั้ว (ลำดับของขั้ว) ที่ไม่ใช่ขั้วเรียกว่าด้านซ้ายของการผลิตและเทอร์มินัลเรียกว่าด้านขวาของการผลิต

เริ่มสัญลักษณ์

การผลิตเริ่มต้นจากสัญลักษณ์เริ่มต้น แสดงด้วยสัญลักษณ์ S สัญลักษณ์ที่ไม่ใช่ขั้วถูกกำหนดให้เป็นสัญลักษณ์เริ่มต้นเสมอ

จุดประสงค์ของการวิเคราะห์ความหมายคือการดึงความหมายที่แน่นอนหรือคุณสามารถพูดความหมายตามพจนานุกรมจากข้อความ งานของเครื่องวิเคราะห์ความหมายคือการตรวจสอบความหมายของข้อความ

เรารู้แล้วว่าการวิเคราะห์ศัพท์ยังเกี่ยวข้องกับความหมายของคำแล้วการวิเคราะห์เชิงความหมายแตกต่างจากการวิเคราะห์ศัพท์อย่างไร? การวิเคราะห์คำศัพท์จะขึ้นอยู่กับโทเค็นที่มีขนาดเล็กกว่า แต่ในอีกด้านหนึ่งการวิเคราะห์ความหมายจะเน้นไปที่กลุ่มใหญ่ นั่นคือเหตุผลที่การวิเคราะห์เชิงความหมายสามารถแบ่งออกเป็นสองส่วนต่อไปนี้ -

ศึกษาความหมายของคำแต่ละคำ

เป็นส่วนแรกของการวิเคราะห์ความหมายซึ่งทำการศึกษาความหมายของคำแต่ละคำ ส่วนนี้เรียกว่าความหมายเชิงศัพท์

การศึกษาการรวมกันของแต่ละคำ

ในส่วนที่สองจะรวมคำแต่ละคำเพื่อให้ความหมายในประโยค

งานที่สำคัญที่สุดของการวิเคราะห์ความหมายคือการได้รับความหมายที่เหมาะสมของประโยค ตัวอย่างเช่นวิเคราะห์ประโยค“Ram is great.”ในประโยคนี้ผู้พูดกำลังพูดถึงลอร์ดรามหรือคนที่ชื่อราม นั่นคือเหตุผลว่าทำไมงานเพื่อให้ได้ความหมายที่เหมาะสมของประโยคของตัววิเคราะห์ความหมายจึงมีความสำคัญ

องค์ประกอบของการวิเคราะห์ความหมาย

สิ่งต่อไปนี้เป็นองค์ประกอบที่สำคัญบางประการของการวิเคราะห์ความหมาย -

Hyponymy

อาจถูกกำหนดให้เป็นความสัมพันธ์ระหว่างคำทั่วไปและอินสแตนซ์ของคำทั่วไปนั้น ในที่นี้คำทั่วไปเรียกว่า hypernym และอินสแตนซ์เรียกว่า hyponyms ตัวอย่างเช่นสีของคำคือไฮเปอร์นีมและสีฟ้าสีเหลืองเป็นต้นเป็นคำที่มีความหมาย

Homonymy

อาจหมายถึงคำที่มีการสะกดเหมือนกันหรือรูปแบบเดียวกัน แต่มีความหมายต่างกันและไม่เกี่ยวข้องกัน ตัวอย่างเช่นคำว่า "Bat" เป็นคำที่คล้ายคลึงกันเนื่องจากค้างคาวสามารถใช้ในการตีลูกบอลได้หรือค้างคาวเป็นสัตว์เลี้ยงลูกด้วยนมที่บินออกหากินเวลากลางคืนเช่นกัน

Polysemy

Polysemy เป็นคำภาษากรีกซึ่งแปลว่า“ สัญญาณต่างๆ” เป็นคำหรือวลีที่มีความหมายแตกต่างกัน แต่เกี่ยวข้องกัน กล่าวอีกนัยหนึ่งเราสามารถพูดได้ว่า polysemy มีการสะกดเหมือนกัน แต่มีความหมายแตกต่างกันและเกี่ยวข้องกัน ตัวอย่างเช่นคำว่า“ ธนาคาร” เป็นคำที่มีความหมายดังต่อไปนี้ -

สถาบันการเงิน

อาคารที่สถาบันดังกล่าวตั้งอยู่

คำพ้องความหมายสำหรับ "พึ่งพา"

ความแตกต่างระหว่าง Polysemy และ Homonymy

ทั้งคำพหุนามและคำพ้องเสียงมีไวยากรณ์หรือการสะกดคำเหมือนกัน ความแตกต่างที่สำคัญระหว่างพวกเขาคือใน polysemy ความหมายของคำมีความสัมพันธ์กัน แต่ในความเหมือนกันความหมายของคำไม่เกี่ยวข้องกัน ตัวอย่างเช่นหากเราพูดถึงคำว่า "ธนาคาร" คำเดียวกันเราสามารถเขียนความหมายว่า "สถาบันการเงิน" หรือ "ริมฝั่งแม่น้ำ" ได้ ในกรณีนั้นจะเป็นตัวอย่างของคำพ้องเสียงเนื่องจากความหมายไม่เกี่ยวข้องกัน

พ้อง

เป็นความสัมพันธ์ระหว่างศัพท์สองรายการที่มีรูปแบบต่างกัน แต่แสดงความหมายเหมือนกันหรือใกล้เคียงกัน ตัวอย่างเช่น "ผู้แต่ง / นักเขียน" "โชคชะตา / พรหมลิขิต"

Antonymy

มันคือความสัมพันธ์ระหว่างรายการศัพท์สองรายการที่มีความสมมาตรระหว่างส่วนประกอบทางความหมายที่สัมพันธ์กับแกน ขอบเขตของ antonymy มีดังนี้ -

Application of property or not - ตัวอย่างคือ 'ชีวิต / ความตาย', 'ความรับรอง / ความไม่สงบ'

Application of scalable property - ตัวอย่างคือ 'รวย / จน', 'ร้อน / เย็น'

Application of a usage - ตัวอย่างคือ 'พ่อ / ลูก', 'ดวงจันทร์ / ดวงอาทิตย์'

การแสดงความหมาย

การวิเคราะห์เชิงความหมายสร้างการแสดงความหมายของประโยค แต่ก่อนที่จะเข้าสู่แนวคิดและแนวทางที่เกี่ยวข้องกับการแสดงความหมายเราจำเป็นต้องเข้าใจโครงสร้างพื้นฐานของระบบความหมาย

หน่วยการสร้างของระบบความหมาย

ในการแทนคำหรือการแทนความหมายของคำการสร้างต่อไปนี้มีบทบาทสำคัญ -

Entities- เป็นตัวแทนของแต่ละบุคคลเช่นบุคคลเฉพาะสถานที่ ฯลฯ ตัวอย่างเช่นหรยาณา อินเดียรามทั้งหมดเป็นหน่วยงาน

Concepts - แสดงถึงหมวดหมู่ทั่วไปของบุคคลเช่นบุคคลเมือง ฯลฯ

Relations- แสดงถึงความสัมพันธ์ระหว่างเอนทิตีและแนวคิด ยกตัวอย่างเช่นรามเป็นคน

Predicates- แสดงถึงโครงสร้างกริยา ตัวอย่างเช่นบทบาททางความหมายและไวยากรณ์ของกรณีเป็นตัวอย่างของเพรดิเคต

ตอนนี้เราสามารถเข้าใจได้แล้วว่าการแสดงความหมายแสดงให้เห็นถึงการรวมส่วนประกอบของระบบความหมายเข้าด้วยกัน กล่าวอีกนัยหนึ่งคือแสดงวิธีการรวบรวมเอนทิตีแนวคิดความสัมพันธ์และเพรดิเคตเพื่ออธิบายสถานการณ์ นอกจากนี้ยังช่วยให้สามารถใช้เหตุผลเกี่ยวกับโลกแห่งความหมายได้อีกด้วย

แนวทางการแสดงความหมาย

การวิเคราะห์ความหมายใช้แนวทางต่อไปนี้สำหรับการแสดงความหมาย -

ลอจิกเพรดิเคตลำดับแรก (FOPL)

อวนความหมาย

Frames

การพึ่งพาแนวคิด (CD)

สถาปัตยกรรมตามกฎ

ไวยากรณ์กรณี

กราฟแนวคิด

ต้องการการแสดงความหมาย

คำถามที่เกิดขึ้นที่นี่คือทำไมเราจึงต้องการการแสดงความหมาย? มีเหตุผลดังต่อไปนี้ -

การเชื่อมโยงองค์ประกอบทางภาษากับองค์ประกอบที่ไม่ใช่ภาษา

เหตุผลประการแรกคือด้วยความช่วยเหลือของการแสดงความหมายการเชื่อมโยงองค์ประกอบทางภาษากับองค์ประกอบที่ไม่ใช่ภาษาสามารถทำได้

แสดงถึงความหลากหลายในระดับศัพท์

ด้วยความช่วยเหลือของการแสดงความหมายรูปแบบบัญญัติที่ไม่คลุมเครือสามารถแสดงในระดับศัพท์ได้

สามารถใช้ในการให้เหตุผล

การแสดงความหมายสามารถใช้เพื่อหาเหตุผลในการตรวจสอบสิ่งที่เป็นจริงในโลกตลอดจนอนุมานความรู้จากการแทนค่าความหมาย

ความหมายของคำศัพท์

ส่วนแรกของการวิเคราะห์ความหมายการศึกษาความหมายของคำแต่ละคำเรียกว่าความหมายเชิงศัพท์ ซึ่งรวมถึงคำคำย่อยคำต่อท้าย (หน่วยย่อย) คำประสมและวลีด้วย คำคำย่อย ฯลฯ ทั้งหมดเรียกรวมกันว่ารายการศัพท์ กล่าวอีกนัยหนึ่งเราสามารถพูดได้ว่าความหมายเชิงศัพท์คือความสัมพันธ์ระหว่างรายการศัพท์ความหมายของประโยคและไวยากรณ์ของประโยค

ต่อไปนี้เป็นขั้นตอนที่เกี่ยวข้องกับความหมายเชิงศัพท์ -

การจำแนกประเภทของศัพท์เช่นคำคำย่อยคำต่อท้าย ฯลฯ จะดำเนินการในความหมายของศัพท์

การแยกองค์ประกอบของคำศัพท์เช่นคำคำย่อยคำต่อท้าย ฯลฯ จะดำเนินการในความหมายของศัพท์

นอกจากนี้ยังมีการวิเคราะห์ความแตกต่างและความคล้ายคลึงกันระหว่างโครงสร้างความหมายศัพท์ต่างๆ

เราเข้าใจดีว่าคำต่างๆมีความหมายที่แตกต่างกันไปตามบริบทของการใช้งานในประโยค ถ้าเราพูดถึงภาษาของมนุษย์พวกเขาก็มีความคลุมเครือเช่นกันเพราะหลายคำสามารถตีความได้หลายวิธีขึ้นอยู่กับบริบทของสิ่งที่เกิดขึ้น

การเปลี่ยนความรู้สึกของคำในการประมวลผลภาษาธรรมชาติ (NLP) อาจถูกกำหนดให้เป็นความสามารถในการกำหนดความหมายของคำที่เปิดใช้งานโดยการใช้คำในบริบทเฉพาะ ความคลุมเครือของคำศัพท์วากยสัมพันธ์หรือความหมายเป็นปัญหาแรก ๆ ที่ระบบ NLP ต้องเผชิญ เครื่องแท็กแบบ Part-of-speech (POS) ที่มีความแม่นยำระดับสูงสามารถแก้ปัญหาความคลุมเครือทางไวยากรณ์ของ Word ได้ ในทางกลับกันปัญหาในการแก้ไขความคลุมเครือทางความหมายเรียกว่า WSD (word sense disambiguation) การแก้ไขความคลุมเครือทางความหมายนั้นยากกว่าการแก้ไขความคลุมเครือทางไวยากรณ์

ตัวอย่างเช่นพิจารณาสองตัวอย่างของความหมายที่แตกต่างกันที่มีอยู่สำหรับคำนั้น “bass” -

ฉันได้ยินเสียงเบส

เขาชอบกินเนื้อย่างเบส

การเกิดขึ้นของคำ bassแสดงถึงความหมายที่แตกต่างอย่างชัดเจน ในประโยคแรกหมายถึงfrequency และประการที่สองหมายถึง fish. ดังนั้นหาก WSD ถูกทำให้สับสนจึงสามารถกำหนดความหมายที่ถูกต้องให้กับประโยคข้างต้นได้ดังนี้ -

ฉันได้ยินเสียงเบส / ความถี่

เขาชอบกินปลากะพง / ปลาย่าง

การประเมิน WSD

การประเมิน WSD ต้องการอินพุตสองอินพุตต่อไปนี้ -

พจนานุกรม

อินพุตแรกสำหรับการประเมิน WSD คือพจนานุกรมซึ่งใช้เพื่อระบุความรู้สึกที่จะถูกทำให้สับสน

ทดสอบ Corpus

อินพุตอื่นที่ WSD ต้องการคือคลังข้อมูลการทดสอบที่มีคำอธิบายประกอบสูงซึ่งมีเป้าหมายหรือความรู้สึกที่ถูกต้อง องค์กรทดสอบมีสองประเภท & minsu;

Lexical sample - corpora ประเภทนี้ถูกใช้ในระบบซึ่งจำเป็นต้องใช้ในการแยกแยะคำตัวอย่างเล็กน้อย

All-words - Corpora ประเภทนี้ถูกใช้ในระบบซึ่งคาดว่าจะทำให้คำทั้งหมดไม่ชัดเจนในข้อความที่กำลังทำงานอยู่

แนวทางและวิธีการในการ Disambiguation Word Sense (WSD)

แนวทางและวิธีการในการ WSD จำแนกตามแหล่งความรู้ที่ใช้ในการลดความบกพร่องของคำ

ตอนนี้ให้เราดูสี่วิธีการทั่วไปสำหรับ WSD -

วิธีการตามพจนานุกรมหรือความรู้

ตามชื่อที่แนะนำสำหรับการทำให้เข้าใจผิดวิธีการเหล่านี้ส่วนใหญ่อาศัยพจนานุกรมสมบัติและฐานความรู้คำศัพท์ พวกเขาไม่ใช้หลักฐานทางองค์กรในการทำให้เกิดความสับสน วิธี Lesk เป็นวิธีการตามพจนานุกรมเซมินัลที่นำโดย Michael Lesk ในปี 1986 คำจำกัดความของ Lesk ซึ่งอัลกอริทึม Lesk ใช้คือ“measure overlap between sense definitions for all words in context”. อย่างไรก็ตามในปี 2000 Kilgarriff และ Rosensweig ได้ให้คำจำกัดความของ Lesk ที่ง่ายขึ้นว่า“measure overlap between sense definitions of word and current context”ซึ่งหมายถึงการระบุความรู้สึกที่ถูกต้องทีละคำ บริบทปัจจุบันคือชุดของคำในประโยคหรือย่อหน้าโดยรอบ

วิธีการภายใต้การดูแล

สำหรับการลดความสับสนวิธีการเรียนรู้ของเครื่องใช้ประโยชน์จากองค์กรที่มีคำอธิบายประกอบในการฝึกอบรม วิธีการเหล่านี้ถือว่าบริบทสามารถให้หลักฐานเพียงพอในตัวมันเองที่จะทำให้ความรู้สึกไม่ชัดเจน ในวิธีการเหล่านี้ความรู้และการให้เหตุผลถือเป็นสิ่งที่ไม่จำเป็น บริบทจะแสดงเป็นชุดของ "คุณลักษณะ" ของคำ รวมถึงข้อมูลเกี่ยวกับคำศัพท์รอบข้างด้วย สนับสนุนเครื่องเวกเตอร์และการเรียนรู้โดยใช้หน่วยความจำเป็นแนวทางการเรียนรู้ภายใต้การดูแลที่ประสบความสำเร็จมากที่สุดสำหรับ WSD วิธีการเหล่านี้ขึ้นอยู่กับ corpora ที่ติดแท็กด้วยตนเองจำนวนมากซึ่งมีราคาแพงมากในการสร้าง

วิธีการกึ่งดูแล

เนื่องจากไม่มีคลังข้อมูลการฝึกอบรมอัลกอริธึมการลดทอนความรู้สึกส่วนใหญ่จึงใช้วิธีการเรียนรู้แบบกึ่งมีผู้ดูแล เป็นเพราะวิธีการกึ่งดูแลใช้ทั้งข้อมูลที่มีป้ายกำกับและไม่มีป้ายกำกับ วิธีการเหล่านี้ต้องการข้อความที่มีคำอธิบายประกอบจำนวนน้อยมากและข้อความธรรมดาที่ไม่มีคำอธิบายประกอบจำนวนมาก เทคนิคที่ใช้โดยวิธีกึ่งดูแลคือการบูตจากข้อมูลเมล็ดพันธุ์

วิธีการที่ไม่ได้รับการดูแล

วิธีการเหล่านี้ถือว่าความรู้สึกที่คล้ายคลึงกันเกิดขึ้นในบริบทที่คล้ายคลึงกัน นั่นคือเหตุผลที่ความรู้สึกสามารถถูกกระตุ้นจากข้อความโดยการจัดกลุ่มคำที่เกิดขึ้นโดยใช้การวัดความคล้ายคลึงกันของบริบท งานนี้เรียกว่าการชักนำความรู้สึกหรือการเลือกปฏิบัติ วิธีการที่ไม่ได้รับการดูแลมีศักยภาพที่ดีในการเอาชนะคอขวดของการได้มาซึ่งความรู้เนื่องจากการไม่พึ่งพาความพยายามด้วยตนเอง

การประยุกต์ใช้ Word Sense Disambiguation (WSD)

Word sense disambiguation (WSD) ถูกนำไปใช้ในเกือบทุกแอพพลิเคชั่นของเทคโนโลยีภาษา

ตอนนี้ให้เราดูขอบเขตของ WSD -

การแปลด้วยเครื่อง

การแปลด้วยเครื่องหรือ MT เป็นแอปพลิเคชันที่ชัดเจนที่สุดของ WSD ใน MT การเลือกคำศัพท์สำหรับคำที่มีการแปลที่แตกต่างกันสำหรับความรู้สึกที่แตกต่างกันนั้นทำโดย WSD ความรู้สึกใน MT แสดงเป็นคำในภาษาเป้าหมาย ระบบแปลภาษาด้วยเครื่องส่วนใหญ่ไม่ใช้โมดูล WSD ที่ชัดเจน

การดึงข้อมูล (IR)

การดึงข้อมูล (IR) อาจถูกกำหนดให้เป็นโปรแกรมซอฟต์แวร์ที่เกี่ยวข้องกับองค์กรการจัดเก็บการค้นคืนและการประเมินข้อมูลจากที่เก็บเอกสารโดยเฉพาะข้อมูลที่เป็นข้อความ โดยพื้นฐานแล้วระบบจะช่วยผู้ใช้ในการค้นหาข้อมูลที่ต้องการ แต่จะไม่ส่งคืนคำตอบของคำถามอย่างชัดเจน WSD ใช้เพื่อแก้ไขความไม่ชัดเจนของแบบสอบถามที่ให้ไว้กับระบบ IR เช่นเดียวกับ MT ระบบ IR ในปัจจุบันไม่ได้ใช้โมดูล WSD อย่างชัดเจนและอาศัยแนวคิดที่ว่าผู้ใช้จะพิมพ์บริบทที่เพียงพอในแบบสอบถามเพื่อดึงเฉพาะเอกสารที่เกี่ยวข้องเท่านั้น

การขุดข้อความและการสกัดข้อมูล (IE)

ในแอปพลิเคชันส่วนใหญ่ WSD จำเป็นต้องทำการวิเคราะห์ข้อความอย่างถูกต้อง ตัวอย่างเช่น WSD ช่วยให้ระบบรวบรวมอัจฉริยะทำการตั้งค่าสถานะคำที่ถูกต้อง ตัวอย่างเช่นระบบอัจฉริยะทางการแพทย์อาจต้องการการตั้งค่าสถานะ "ยาผิดกฎหมาย" มากกว่า "ยาทางการแพทย์"

พจนานุกรมศัพท์

WSD และพจนานุกรมสามารถทำงานร่วมกันได้เนื่องจากพจนานุกรมสมัยใหม่มีข้อมูล ด้วยคำศัพท์ WSD ให้การจัดกลุ่มความรู้สึกเชิงประจักษ์อย่างคร่าวๆรวมทั้งตัวบ่งชี้ความรู้สึกตามบริบทที่มีนัยสำคัญทางสถิติ

ปัญหาในการลดความสับสนของ Word Sense (WSD)

สิ่งต่อไปนี้เป็นปัญหาบางประการที่ต้องเผชิญกับการเปลี่ยนความรู้สึกของคำ (WSD) -

ความแตกต่างระหว่างพจนานุกรม

ปัญหาสำคัญของ WSD คือการตัดสินความหมายของคำเพราะประสาทสัมผัสที่แตกต่างกันอาจมีความสัมพันธ์กันอย่างใกล้ชิด แม้แต่พจนานุกรมและพจนานุกรมที่แตกต่างกันก็สามารถแบ่งคำต่างๆออกเป็นความรู้สึกได้

อัลกอริทึมที่แตกต่างกันสำหรับการใช้งานที่แตกต่างกัน

ปัญหาอีกประการหนึ่งของ WSD คืออัลกอริทึมที่แตกต่างกันโดยสิ้นเชิงอาจจำเป็นสำหรับแอปพลิเคชันที่แตกต่างกัน ตัวอย่างเช่นในการแปลด้วยเครื่องจะใช้รูปแบบของการเลือกคำเป้าหมาย และในการดึงข้อมูลไม่จำเป็นต้องมีการจัดเก็บข้อมูลทางความรู้สึก

ความแปรปรวนระหว่างผู้พิพากษา

ปัญหาอีกประการหนึ่งของ WSD คือโดยทั่วไประบบ WSD จะได้รับการทดสอบโดยให้ผลลัพธ์ของพวกเขาในงานเปรียบเทียบกับงานของมนุษย์ สิ่งนี้เรียกว่าปัญหาของความแปรปรวนระหว่างการตัดสิน

ความไม่เข้าใจในคำพูด

ความยากอีกประการหนึ่งใน WSD คือคำที่ไม่สามารถแบ่งออกเป็นคำย่อยที่ไม่ต่อเนื่องได้อย่างง่ายดาย

ปัญหาที่ยากที่สุดของ AI คือการประมวลผลภาษาธรรมชาติด้วยคอมพิวเตอร์หรืออีกนัยหนึ่งการประมวลผลภาษาธรรมชาติเป็นปัญหาที่ยากที่สุดของปัญญาประดิษฐ์ ถ้าเราพูดถึงปัญหาที่สำคัญใน NLP ปัญหาสำคัญอย่างหนึ่งใน NLP คือการประมวลผลวาทกรรม - การสร้างทฤษฎีและแบบจำลองของคำพูดที่รวมกันเป็นรูปเป็นร่างcoherent discourse. จริงๆแล้วภาษามักประกอบด้วยกลุ่มประโยคที่เรียงต่อกันมีโครงสร้างและสอดคล้องกันแทนที่จะเป็นประโยคแยกและไม่เกี่ยวข้องกันเช่นภาพยนตร์ กลุ่มประโยคที่เชื่อมโยงกันเหล่านี้เรียกว่าวาทกรรม

แนวคิดของการเชื่อมโยงกัน

การเชื่อมโยงกันและโครงสร้างของวาทกรรมมีความเชื่อมโยงกันในหลาย ๆ ด้าน การเชื่อมโยงกันพร้อมกับคุณสมบัติของข้อความที่ดีถูกใช้เพื่อประเมินคุณภาพผลลัพธ์ของระบบการสร้างภาษาธรรมชาติ คำถามที่เกิดขึ้นที่นี่คือข้อความที่สอดคล้องกันหมายความว่าอย่างไร? สมมติว่าเรารวบรวมประโยคหนึ่งจากหนังสือพิมพ์ทุกหน้าแล้วจะเป็นวาทกรรมหรือไม่? แน่นอนไม่ใช่ เป็นเพราะประโยคเหล่านี้ไม่แสดงความเชื่อมโยงกัน วาทกรรมที่สอดคล้องกันต้องมีคุณสมบัติดังต่อไปนี้ -

ความสัมพันธ์เชื่อมโยงระหว่างคำพูด

วาทกรรมจะสอดคล้องกันหากมีการเชื่อมต่อที่มีความหมายระหว่างคำพูดของมัน คุณสมบัตินี้เรียกว่าความสัมพันธ์เชื่อมโยงกัน ตัวอย่างเช่นต้องมีคำอธิบายบางอย่างเพื่อแสดงความเชื่อมโยงระหว่างคำพูด

ความสัมพันธ์ระหว่างเอนทิตี

คุณสมบัติอีกประการหนึ่งที่ทำให้วาทกรรมสอดคล้องกันคือต้องมีความสัมพันธ์บางอย่างกับเอนทิตี การเชื่อมโยงกันแบบนี้เรียกว่าการเชื่อมโยงตามเอนทิตี

โครงสร้างวาทกรรม

คำถามสำคัญเกี่ยวกับวาทกรรมคือวาทกรรมต้องมีโครงสร้างแบบไหน คำตอบสำหรับคำถามนี้ขึ้นอยู่กับการแบ่งกลุ่มที่เราใช้กับวาทกรรม การแบ่งส่วนของวาทกรรมอาจถูกกำหนดเป็นการกำหนดประเภทของโครงสร้างสำหรับวาทกรรมขนาดใหญ่ มันค่อนข้างยากที่จะใช้การแบ่งส่วนของวาทกรรม แต่มันสำคัญมากสำหรับinformation retrieval, text summarization and information extraction ประเภทของการใช้งาน

อัลกอริทึมสำหรับการแบ่งกลุ่มวาทกรรม

ในส่วนนี้เราจะเรียนรู้เกี่ยวกับอัลกอริทึมสำหรับการแบ่งส่วนวาทกรรม อัลกอริทึมอธิบายไว้ด้านล่าง -

การแบ่งกลุ่มวาทกรรมที่ไม่ได้รับการดูแล

ชั้นของการแบ่งกลุ่มวาทกรรมที่ไม่ได้รับการดูแลมักแสดงเป็นการแบ่งส่วนเชิงเส้น เราสามารถเข้าใจงานของการแบ่งส่วนเชิงเส้นด้วยความช่วยเหลือของตัวอย่าง ในตัวอย่างมีภารกิจในการแบ่งส่วนข้อความเป็นหน่วยหลายย่อหน้า หน่วยเป็นตัวแทนของข้อความต้นฉบับ อัลกอริทึมเหล่านี้ขึ้นอยู่กับการทำงานร่วมกันที่อาจกำหนดได้ว่าเป็นการใช้อุปกรณ์ทางภาษาบางอย่างเพื่อผูกหน่วยข้อความเข้าด้วยกัน ในทางกลับกันคำศัพท์ที่เชื่อมโยงกันคือความสัมพันธ์ที่บ่งบอกโดยความสัมพันธ์ระหว่างคำสองคำขึ้นไปในสองหน่วยเช่นการใช้คำพ้องความหมาย

การแบ่งกลุ่มวาทกรรมภายใต้การดูแล

วิธีการก่อนหน้านี้ไม่มีขอบเขตส่วนที่ติดป้ายกำกับด้วยมือ ในทางกลับกันการแบ่งกลุ่มวาทกรรมภายใต้การดูแลจำเป็นต้องมีข้อมูลการฝึกอบรมที่มีป้ายกำกับขอบเขต มันง่ายมากที่จะได้รับสิ่งเดียวกัน ในการแบ่งกลุ่มวาทกรรมภายใต้การดูแลเครื่องหมายวาทกรรมหรือคำพูดมีบทบาทสำคัญ Discourse marker หรือ cue word คือคำหรือวลีที่ทำหน้าที่ส่งสัญญาณโครงสร้างวาทกรรม เครื่องหมายวาทกรรมเหล่านี้เป็นเครื่องหมายเฉพาะโดเมน

การเชื่อมโยงข้อความ

การทำซ้ำคำศัพท์เป็นวิธีการค้นหาโครงสร้างในวาทกรรม แต่ไม่ตอบสนองความต้องการของการเป็นวาทกรรมที่สอดคล้องกัน เพื่อให้บรรลุวาทกรรมที่สอดคล้องกันเราต้องมุ่งเน้นไปที่ความสัมพันธ์เชื่อมโยงกันโดยเฉพาะ ดังที่เราทราบว่าความสัมพันธ์การเชื่อมโยงกันกำหนดความเชื่อมโยงที่เป็นไปได้ระหว่างคำพูดในวาทกรรม เฮ็บบ์ได้เสนอความสัมพันธ์เช่นนี้ดังนี้ -

เราใช้เวลาสองเทอม S0 และ S1 เพื่อแสดงความหมายของสองประโยคที่เกี่ยวข้อง -

ผลลัพธ์

อนุมานได้ว่ารัฐยืนยันตามระยะ S0 อาจทำให้รัฐยืนยันโดย S1. ตัวอย่างเช่นข้อความสองข้อความแสดงผลลัพธ์ความสัมพันธ์: Ram ถูกไฟไหม้ ผิวหนังของเขาไหม้

คำอธิบาย

มันอนุมานได้ว่ารัฐยืนยันโดย S1 อาจทำให้รัฐยืนยันโดย S0. ตัวอย่างเช่นข้อความสองข้อความแสดงความสัมพันธ์ - รามต่อสู้กับเพื่อนของชยัม เขาเมา

ขนาน

มันอนุมาน p (a1, a2, …) จากการยืนยันของ S0 และ p (b1, b2, …) จากการยืนยัน S1. ที่นี่ ai และ bi คล้ายกันสำหรับ i ทั้งหมด ตัวอย่างเช่นสองคำสั่งขนานกัน - Ram ต้องการรถ ชยัมต้องการเงิน

การทำอย่างละเอียด

มันอนุมานประพจน์ P เดียวกันจากทั้งสองการยืนยัน - S0 และ S1ตัวอย่างเช่นสองข้อความแสดงความสัมพันธ์อย่างละเอียด: รามมาจากจั ณ ฑีครห์ ชยัมมาจากเกรละ

โอกาส

มันเกิดขึ้นเมื่อสามารถอนุมานการเปลี่ยนแปลงของสถานะได้จากการยืนยันของ S0สถานะสุดท้ายที่อนุมานได้ S1และในทางกลับกัน. ตัวอย่างเช่นข้อความสองข้อความแสดงโอกาสความสัมพันธ์: รามหยิบหนังสือขึ้นมา เขามอบให้ชยัม

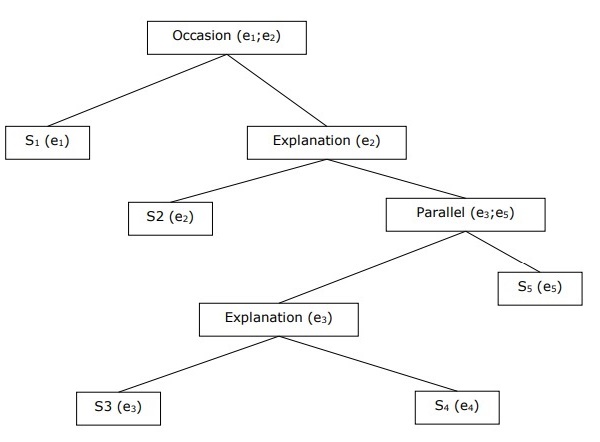

การสร้างโครงสร้างวาทกรรมตามลำดับชั้น

การเชื่อมโยงกันของวาทกรรมทั้งหมดสามารถพิจารณาได้จากโครงสร้างลำดับชั้นระหว่างความสัมพันธ์แบบเชื่อมโยงกัน ตัวอย่างเช่นข้อความต่อไปนี้สามารถแสดงเป็นโครงสร้างลำดับชั้น -

S1 - รามไปที่ธนาคารเพื่อฝากเงิน

S2 - จากนั้นเขาก็นั่งรถไฟไปที่ร้านขายผ้าของ Shyam

S3 - เขาต้องการซื้อเสื้อผ้า

S4 - เขาไม่มีเสื้อผ้าใหม่สำหรับปาร์ตี้

S5 - เขาอยากคุยกับชยัมเกี่ยวกับสุขภาพของเขาด้วย

ความละเอียดอ้างอิง

การตีความประโยคจากวาทกรรมใด ๆ เป็นงานที่สำคัญอีกอย่างหนึ่งและเพื่อให้บรรลุเป้าหมายนี้เราจำเป็นต้องรู้ว่าใครหรือหน่วยงานใดที่กำลังพูดถึง ที่นี่การอ้างอิงการตีความเป็นองค์ประกอบสำคัญReferenceอาจถูกกำหนดให้เป็นนิพจน์ทางภาษาเพื่อแสดงถึงเอนทิตีหรือบุคคล ยกตัวอย่างเช่นในทางเดิน, Ram , ผู้จัดการของธนาคารเอบีซีเห็นของเขาเพื่อนยัมที่ร้าน เขาไปพบเขาสำนวนภาษาศาสตร์เช่นรามเขาเขาอ้างอิง

ในบันทึกเดียวกัน reference resolution อาจถูกกำหนดให้เป็นภารกิจในการพิจารณาว่าเอนทิตีใดถูกอ้างถึงโดยนิพจน์ทางภาษาศาสตร์

คำศัพท์ที่ใช้ในการแก้ปัญหาการอ้างอิง

เราใช้คำศัพท์ต่อไปนี้ในการแก้ปัญหาอ้างอิง -

Referring expression- นิพจน์ภาษาธรรมชาติที่ใช้ในการอ้างอิงเรียกว่านิพจน์อ้างอิง ตัวอย่างเช่นข้อความที่ใช้ข้างต้นเป็นนิพจน์อ้างอิง

Referent- เป็นเอนทิตีที่อ้างถึง ตัวอย่างเช่นในตัวอย่างสุดท้ายที่กำหนด Ram เป็นตัวอ้างอิง

Corefer- เมื่อใช้สองนิพจน์เพื่ออ้างถึงเอนทิตีเดียวกันจะเรียกว่าคอร์เฟอร์ ตัวอย่างเช่น,Ram และ he เป็น corefers

Antecedent- คำนี้มีใบอนุญาตให้ใช้คำอื่นได้ ตัวอย่างเช่น,Ram เป็นค่าก่อนหน้าของการอ้างอิง he.

Anaphora & Anaphoric- อาจหมายถึงการอ้างอิงถึงเอนทิตีที่ได้รับการแนะนำก่อนหน้านี้ในประโยค และนิพจน์อ้างอิงเรียกว่า anaphoric

Discourse model - แบบจำลองที่มีการนำเสนอของเอนทิตีที่ถูกอ้างถึงในวาทกรรมและความสัมพันธ์ที่พวกเขามีส่วนร่วม

ประเภทของนิพจน์อ้างอิง

ตอนนี้ให้เราดูนิพจน์การอ้างอิงประเภทต่างๆ นิพจน์การอ้างอิงห้าประเภทได้อธิบายไว้ด้านล่าง -

วลีคำนามไม่แน่นอน

การอ้างอิงแบบนี้แสดงถึงเอนทิตีที่ใหม่สำหรับผู้ฟังในบริบทของวาทกรรม ตัวอย่างเช่น - ในประโยคที่ Ram ไปรอบ ๆ วันหนึ่งเพื่อนำอาหารมาให้เขา - บางส่วนเป็นข้อมูลอ้างอิงที่ไม่มีกำหนด

วลีคำนามที่แน่นอน

ตรงข้ามกับข้างต้นการอ้างอิงประเภทนี้แสดงถึงเอนทิตีที่ไม่ใหม่หรือระบุตัวตนได้ให้ผู้ฟังเข้าสู่บริบทของวาทกรรม ตัวอย่างเช่นในประโยค - ฉันเคยอ่าน The Times of India - The Times of India เป็นการอ้างอิงที่ชัดเจน

สรรพนาม

มันเป็นรูปแบบของการอ้างอิงที่แน่นอน ตัวอย่างเช่นรามหัวเราะดังที่สุดเท่าที่จะทำได้ คำhe แสดงถึงนิพจน์ที่อ้างถึงสรรพนาม

การสาธิต

สิ่งเหล่านี้แสดงให้เห็นและมีพฤติกรรมแตกต่างจากคำสรรพนามที่ชัดเจน ตัวอย่างเช่นนี่และนั่นคือคำสรรพนามที่แสดงให้เห็น

ชื่อ

เป็นนิพจน์อ้างอิงประเภทที่ง่ายที่สุด อาจเป็นชื่อบุคคลองค์กรและสถานที่ได้ด้วย ตัวอย่างเช่นในตัวอย่างข้างต้น Ram คือนิพจน์การตัดสินชื่อ

งานการแก้ปัญหาการอ้างอิง

งานการแก้ปัญหาอ้างอิงสองงานได้อธิบายไว้ด้านล่าง

ความละเอียดของ Coreference

เป็นหน้าที่ในการค้นหานิพจน์อ้างอิงในข้อความที่อ้างถึงเอนทิตีเดียวกัน พูดง่ายๆคือเป็นหน้าที่ในการค้นหานิพจน์คอร์เฟอร์ ชุดของนิพจน์ coreferring เรียกว่า coreference chain ตัวอย่างเช่น - เขาหัวหน้าผู้จัดการและเขา - สิ่งเหล่านี้อ้างถึงสำนวนในข้อความแรกที่ให้ไว้เป็นตัวอย่าง

ข้อ จำกัด เกี่ยวกับความละเอียดของ Coreference

ในภาษาอังกฤษปัญหาหลักสำหรับการแก้ปัญหาแกนกลางคือสรรพนาม เหตุผลที่อยู่เบื้องหลังนี้คือคำสรรพนามที่มีประโยชน์มากมาย ตัวอย่างเช่นสามารถอ้างถึงเขาและเธอได้มาก สรรพนามยังหมายถึงสิ่งที่ไม่ได้หมายถึงสิ่งที่เฉพาะเจาะจง ตัวอย่างเช่นฝนตก มันดีจริงๆ

ความละเอียด Anaphora Pronominal

ซึ่งแตกต่างจากความละเอียดของ coreference การแก้ปัญหา anaphora แบบสรรพนามอาจถูกกำหนดให้เป็นภารกิจในการค้นหาคำนำหน้าสำหรับคำสรรพนามเดียว ตัวอย่างเช่นสรรพนามเป็นของเขาและงานของการแก้ปัญหา anaphora สรรพนามคือการหาคำว่า Ram เพราะ Ram เป็นคำก่อนหน้า

การแท็กเป็นประเภทของการจัดประเภทที่อาจกำหนดเป็นการกำหนดคำอธิบายอัตโนมัติให้กับโทเค็น ในที่นี้ descriptor เรียกว่าแท็กซึ่งอาจแสดงถึงส่วนของคำพูดข้อมูลเชิงความหมายและอื่น ๆ

ตอนนี้ถ้าเราพูดถึงการติดแท็ก Part-of-Speech (PoS) มันอาจถูกกำหนดให้เป็นกระบวนการกำหนดส่วนใดส่วนหนึ่งของคำพูดให้กับคำที่กำหนด โดยทั่วไปเรียกว่าการติดแท็ก POS พูดง่ายๆเราสามารถพูดได้ว่าการติดแท็ก POS เป็นงานในการติดป้ายกำกับคำแต่ละคำในประโยคด้วยส่วนของคำพูดที่เหมาะสม เรารู้แล้วว่าส่วนต่างๆของคำพูด ได้แก่ คำนามคำกริยาคำวิเศษณ์คำคุณศัพท์คำสรรพนามการรวมและหมวดหมู่ย่อย

การติดแท็ก POS ส่วนใหญ่อยู่ภายใต้การติดแท็ก Rule Base POS, การติดแท็ก Stochastic POS และการติดแท็กตามการเปลี่ยนแปลง

การติดแท็ก POS ตามกฎ

หนึ่งในเทคนิคการแท็กที่เก่าแก่ที่สุดคือการติดแท็ก POS ตามกฎ ผู้ติดแท็กตามกฎใช้พจนานุกรมหรือศัพท์เพื่อรับแท็กที่เป็นไปได้สำหรับการแท็กแต่ละคำ หากคำนั้นมีแท็กที่เป็นไปได้มากกว่าหนึ่งแท็กผู้ติดแท็กตามกฎจะใช้กฎที่เขียนด้วยมือเพื่อระบุแท็กที่ถูกต้อง นอกจากนี้ยังสามารถดำเนินการลดความสับสนในการติดแท็กตามกฎโดยการวิเคราะห์คุณลักษณะทางภาษาของคำพร้อมกับคำที่นำหน้าและคำต่อไปนี้ ตัวอย่างเช่นสมมติว่าคำก่อนหน้าของคำเป็นบทความคำนั้นต้องเป็นคำนาม

ตามชื่อที่แนะนำข้อมูลประเภทนี้ทั้งหมดในการติดแท็ก POS ตามกฎจะถูกเข้ารหัสในรูปแบบของกฎ กฎเหล่านี้อาจเป็นอย่างใดอย่างหนึ่ง -

กฎรูปแบบบริบท

หรือเป็นนิพจน์ทั่วไปที่คอมไพล์เป็นออโตมาตาแบบ จำกัด โดยตัดกับการแทนประโยคที่คลุมเครือ

นอกจากนี้เรายังสามารถเข้าใจการติดแท็ก POS ตามกฎด้วยสถาปัตยกรรมสองขั้นตอน -

First stage - ในขั้นแรกจะใช้พจนานุกรมเพื่อกำหนดรายการคำพูดที่เป็นไปได้แต่ละคำ

Second stage - ในขั้นตอนที่สองจะใช้รายการกฎการลดความสับสนที่เขียนด้วยมือจำนวนมากเพื่อจัดเรียงรายการเป็นส่วนหนึ่งของคำพูดสำหรับแต่ละคำ

คุณสมบัติของการติดแท็ก POS ตามกฎ

ผู้ติดแท็ก POS ตามกฎมีคุณสมบัติดังต่อไปนี้ -

แท็กเกอร์เหล่านี้เป็นนักแท็กที่ขับเคลื่อนด้วยความรู้

กฎในการติดแท็ก POS ตามกฎถูกสร้างขึ้นด้วยตนเอง

ข้อมูลถูกเข้ารหัสในรูปแบบของกฎ

เรามีกฎจำนวน จำกัด ประมาณ 1,000 ข้อ

การสร้างแบบจำลองที่ราบรื่นและภาษาถูกกำหนดไว้อย่างชัดเจนในแท็กเกอร์ที่อิงตามกฎ

การติดแท็ก Stochastic POS

อีกเทคนิคหนึ่งในการติดแท็กคือ Stochastic POS Tagging ทีนี้คำถามที่เกิดขึ้นคือโมเดลใดที่สามารถสุ่มได้ แบบจำลองที่มีความถี่หรือความน่าจะเป็น (สถิติ) สามารถเรียกได้ว่าสุ่ม วิธีการต่างๆจำนวนมากสำหรับปัญหาของการติดแท็กบางส่วนของคำพูดสามารถเรียกว่า stochastic tagger

แท็กเกอร์สุ่มที่ง่ายที่สุดใช้วิธีการต่อไปนี้สำหรับการติดแท็ก POS -

แนวทางความถี่ของคำ

ด้วยวิธีนี้ผู้ติดแท็กสุ่มจะทำให้คำต่างๆไม่ชัดเจนโดยพิจารณาจากความน่าจะเป็นที่คำนั้นเกิดขึ้นกับแท็กหนึ่ง ๆ เรายังสามารถพูดได้ว่าแท็กที่พบบ่อยที่สุดกับคำในชุดการฝึกคือแท็กที่กำหนดให้กับอินสแตนซ์ของคำนั้นที่ไม่ชัดเจน ปัญหาหลักของวิธีนี้คืออาจให้ลำดับแท็กที่ยอมรับไม่ได้

ความน่าจะเป็นของลำดับแท็ก

เป็นอีกแนวทางหนึ่งของการติดแท็กสุ่มโดยที่แท็กเกอร์จะคำนวณความน่าจะเป็นของลำดับแท็กที่กำหนดที่เกิดขึ้น เรียกอีกอย่างว่าวิธี n-gram ถูกเรียกเช่นนี้เนื่องจากแท็กที่ดีที่สุดสำหรับคำหนึ่ง ๆ ถูกกำหนดโดยความน่าจะเป็นที่เกิดขึ้นกับ n แท็กก่อนหน้า

คุณสมบัติของ Stochastic POST Tagging

Stochastic POS taggers มีคุณสมบัติดังต่อไปนี้ -

การติดแท็ก POS นี้ขึ้นอยู่กับความน่าจะเป็นของการเกิดแท็ก

ต้องมีคลังข้อมูลการฝึกอบรม

คงไม่มีความเป็นไปได้สำหรับคำที่ไม่มีอยู่ในคลังข้อมูล

ใช้คลังข้อมูลการทดสอบที่แตกต่างกัน (นอกเหนือจากคลังข้อมูลการฝึกอบรม)

เป็นการติดแท็ก POS ที่ง่ายที่สุดเนื่องจากเลือกแท็กที่พบบ่อยที่สุดที่เกี่ยวข้องกับคำในคลังข้อมูลการฝึกอบรม

การแท็กตามการเปลี่ยนแปลง

การแท็กตามการแปลงข้อมูลเรียกอีกอย่างว่าการติดแท็ก Brill เป็นตัวอย่างของการเรียนรู้ตามการเปลี่ยนแปลง (TBL) ซึ่งเป็นอัลกอริทึมที่อิงตามกฎสำหรับการติดแท็ก POS อัตโนมัติไปยังข้อความที่กำหนด TBL ช่วยให้เรามีความรู้ทางภาษาในรูปแบบที่อ่านได้เปลี่ยนสถานะหนึ่งเป็นอีกสถานะหนึ่งโดยใช้กฎการเปลี่ยนแปลง

ได้รับแรงบันดาลใจจากทั้งแท็กเกอร์ที่อธิบายไว้ก่อนหน้านี้ - อิงตามกฎและสุ่ม หากเราเห็นความคล้ายคลึงกันระหว่างแท็กเกอร์ที่อิงกฎและแท็กเกอร์การเปลี่ยนแปลงเช่นเดียวกับที่อิงตามกฎก็จะขึ้นอยู่กับกฎที่ระบุว่าต้องกำหนดแท็กใดให้กับคำใด ในทางกลับกันถ้าเราเห็นความคล้ายคลึงกันระหว่าง stochastic และ transformation tagger แล้วก็เหมือนกับ stochastic มันเป็นเทคนิคการเรียนรู้ของเครื่องที่กฎจะถูกชักนำโดยอัตโนมัติจากข้อมูล

การทำงานของการเรียนรู้จากการเปลี่ยนแปลง (TBL)

เพื่อที่จะเข้าใจการทำงานและแนวคิดของแท็กเกอร์ตามการเปลี่ยนแปลงเราจำเป็นต้องเข้าใจการทำงานของการเรียนรู้ที่อิงกับการเปลี่ยนแปลง พิจารณาขั้นตอนต่อไปนี้เพื่อทำความเข้าใจการทำงานของ TBL -

Start with the solution - TBL มักเริ่มต้นด้วยวิธีแก้ปัญหาบางอย่างและทำงานเป็นรอบ

Most beneficial transformation chosen - ในแต่ละรอบ TBL จะเลือกการเปลี่ยนแปลงที่เป็นประโยชน์สูงสุด

Apply to the problem - การเปลี่ยนแปลงที่เลือกในขั้นตอนสุดท้ายจะถูกนำไปใช้กับปัญหา

อัลกอริทึมจะหยุดเมื่อการเปลี่ยนแปลงที่เลือกในขั้นตอนที่ 2 จะไม่เพิ่มมูลค่ามากขึ้นหรือไม่มีการเปลี่ยนแปลงให้เลือกอีก การเรียนรู้แบบนี้เหมาะที่สุดในงานจำแนกประเภท

ข้อดีของการเรียนรู้ตามการเปลี่ยนแปลง (TBL)

ข้อดีของ TBL มีดังนี้ -

เราเรียนรู้กฎง่ายๆชุดเล็ก ๆ และกฎเหล่านี้เพียงพอสำหรับการติดแท็ก

การพัฒนาและการดีบักเป็นเรื่องง่ายมากใน TBL เนื่องจากกฎที่เรียนรู้นั้นเข้าใจง่าย

ความซับซ้อนในการติดแท็กจะลดลงเนื่องจากใน TBL มีการผสมผสานระหว่างกฎที่เครื่องจักรเรียนรู้และมนุษย์สร้างขึ้น

แท็กเกอร์ที่ใช้การเปลี่ยนแปลงนั้นเร็วกว่าแท็กเกอร์รุ่น Markov มาก

ข้อเสียของการเรียนรู้ตามการเปลี่ยนแปลง (TBL)

ข้อเสียของ TBL มีดังนี้ -

Transformation-based Learning (TBL) ไม่ได้ให้ความน่าจะเป็นของแท็ก

ใน TBL เวลาในการฝึกอบรมจะนานมากโดยเฉพาะในองค์กรขนาดใหญ่

Hidden Markov Model (HMM) POS Tagging

ก่อนที่จะเจาะลึกลงไปในการติดแท็ก HMM POS เราต้องเข้าใจแนวคิดของ Hidden Markov Model (HMM)

แบบจำลอง Markov ที่ซ่อนอยู่

แบบจำลอง HMM อาจถูกกำหนดให้เป็นแบบจำลองสุ่มที่ฝังตัวแบบทวีคูณซึ่งกระบวนการสุ่มตัวอย่างซ่อนอยู่ กระบวนการสุ่มที่ซ่อนอยู่นี้สามารถสังเกตได้ผ่านกระบวนการสุ่มอีกชุดที่สร้างลำดับของการสังเกตเท่านั้น

ตัวอย่าง

ตัวอย่างเช่นลำดับของการทดลองการโยนเหรียญที่ซ่อนอยู่เสร็จสิ้นแล้วและเราจะเห็นเฉพาะลำดับการสังเกตที่ประกอบด้วยหัวและก้อย รายละเอียดที่แท้จริงของกระบวนการ - จำนวนเหรียญที่ใช้ลำดับที่เลือก - ถูกซ่อนจากเรา โดยการสังเกตลำดับของหัวและหางนี้เราสามารถสร้าง HMM หลายตัวเพื่ออธิบายลำดับ ต่อไปนี้เป็นรูปแบบหนึ่งของ Hidden Markov Model สำหรับปัญหานี้ -

เราสันนิษฐานว่ามีสองสถานะใน HMM และแต่ละรัฐสอดคล้องกับการเลือกเหรียญที่มีอคติต่างกัน เมทริกซ์ต่อไปนี้ให้ความน่าจะเป็นในการเปลี่ยนสถานะ -

$$A = \begin{bmatrix}a11 & a12 \\a21 & a22 \end{bmatrix}$$

ที่นี่

aij = ความน่าจะเป็นของการเปลี่ยนจากสถานะหนึ่งไปเป็นอีกสถานะหนึ่งจาก i เป็น j

a11 + a12= 1 และ21 + a 22 = 1

P1 = ความน่าจะเป็นของหัวของเหรียญแรกคืออคติของเหรียญแรก

P2 = ความน่าจะเป็นของหัวของเหรียญที่สองคืออคติของเหรียญที่สอง

เรายังสามารถสร้างแบบจำลอง HMM โดยสมมติว่ามี 3 เหรียญขึ้นไป

ด้วยวิธีนี้เราสามารถกำหนดลักษณะของ HMM ตามองค์ประกอบต่อไปนี้ -

N จำนวนสถานะในโมเดล (ในตัวอย่างด้านบน N = 2 มีเพียงสองสถานะ)

M จำนวนการสังเกตที่แตกต่างกันซึ่งสามารถปรากฏในแต่ละสถานะในตัวอย่างข้างต้น M = 2 เช่น H หรือ T)

A, การแจกแจงความน่าจะเป็นของการเปลี่ยนสถานะ - เมทริกซ์ A ในตัวอย่างข้างต้น

P, การแจกแจงความน่าจะเป็นของสัญลักษณ์ที่สังเกตได้ในแต่ละสถานะ (ในตัวอย่าง P1 และ P2)

I การแจกแจงสถานะเริ่มต้น

การใช้ HMM สำหรับการติดแท็ก POS

ขั้นตอนการติดแท็ก POS เป็นกระบวนการค้นหาลำดับของแท็กที่มักจะสร้างลำดับคำที่กำหนด เราสามารถจำลองกระบวนการ POS นี้ได้โดยใช้ Hidden Markov Model (HMM) โดยที่tags คือ hidden states ที่ผลิตไฟล์ observable output, กล่าวคือ words.

ในทางคณิตศาสตร์ในการติดแท็ก POS เรามักจะสนใจที่จะค้นหาลำดับแท็ก (C) ที่เพิ่ม -

P (C|W)

ที่ไหน

C = C 1 , C 2 , C 3 ... C T

W = W 1 , W 2 , W 3 , W T

ในอีกด้านหนึ่งของเหรียญความจริงก็คือเราต้องการข้อมูลทางสถิติจำนวนมากเพื่อประมาณลำดับประเภทดังกล่าวอย่างสมเหตุสมผล อย่างไรก็ตามเพื่อให้ปัญหาง่ายขึ้นเราสามารถใช้การแปลงทางคณิตศาสตร์ร่วมกับสมมติฐานบางอย่างได้

การใช้ HMM เพื่อทำการติดแท็ก POS เป็นกรณีพิเศษของการรบกวนแบบเบย์ ดังนั้นเราจะเริ่มต้นด้วยการแก้ไขปัญหาใหม่โดยใช้กฎของ Bayes ซึ่งกล่าวว่าความน่าจะเป็นเงื่อนไขดังกล่าวข้างต้นเท่ากับ -

(PROB (C1,..., CT) * PROB (W1,..., WT | C1,..., CT)) / PROB (W1,..., WT)

เราสามารถกำจัดตัวส่วนได้ในทุกกรณีเนื่องจากเราสนใจที่จะหาลำดับ C ซึ่งทำให้ค่าข้างต้นมีค่าสูงสุด สิ่งนี้จะไม่ส่งผลต่อคำตอบของเรา ตอนนี้ปัญหาของเราลดลงเป็นการค้นหาลำดับ C ที่ขยายใหญ่สุด -

PROB (C1,..., CT) * PROB (W1,..., WT | C1,..., CT) (1)

แม้ว่าจะลดปัญหาในนิพจน์ข้างต้นแล้ว แต่ก็ยังต้องใช้ข้อมูลจำนวนมาก เราสามารถตั้งสมมติฐานความเป็นอิสระที่สมเหตุสมผลเกี่ยวกับความน่าจะเป็นสองประการในนิพจน์ข้างต้นเพื่อเอาชนะปัญหา

ข้อสันนิษฐานแรก

ความน่าจะเป็นของแท็กขึ้นอยู่กับแท็กก่อนหน้า (โมเดลบิ๊กแรม) หรือสองแท็กก่อนหน้า (โมเดลตรีโกณมิติ) หรือแท็ก n ก่อนหน้า (โมเดล n กรัม) ซึ่งในทางคณิตศาสตร์สามารถอธิบายได้ดังนี้ -

PROB (C1,..., CT) = Πi=1..T PROB (Ci|Ci-n+1…Ci-1) (n-gram model)

PROB (C1,..., CT) = Πi=1..T PROB (Ci|Ci-1) (bigram model)

จุดเริ่มต้นของประโยคสามารถคำนวณได้โดยการสมมติความน่าจะเป็นเริ่มต้นสำหรับแต่ละแท็ก

PROB (C1|C0) = PROB initial (C1)

สมมติฐานที่สอง

ความน่าจะเป็นที่สองในสมการ (1) ข้างต้นสามารถประมาณได้โดยสมมติว่าคำนั้นปรากฏในหมวดหมู่โดยไม่ขึ้นอยู่กับคำในหมวดหมู่ก่อนหน้าหรือต่อจากนี้ซึ่งสามารถอธิบายทางคณิตศาสตร์ได้ดังนี้ -

PROB (W1,..., WT | C1,..., CT) = Πi=1..T PROB (Wi|Ci)

ตอนนี้บนพื้นฐานของสมมติฐานสองข้อข้างต้นเป้าหมายของเราลดลงเป็นการค้นหาลำดับ C ที่เพิ่มประสิทธิภาพสูงสุด

Πi=1...T PROB(Ci|Ci-1) * PROB(Wi|Ci)

ตอนนี้คำถามที่เกิดขึ้นที่นี่คือการแปลงปัญหาเป็นแบบฟอร์มด้านบนช่วยเราได้มาก คำตอบคือ - ใช่มันมี หากเรามีคลังข้อมูลที่ติดแท็กขนาดใหญ่ความน่าจะเป็นทั้งสองในสูตรข้างต้นสามารถคำนวณได้ดังนี้ -

PROB (Ci=VERB|Ci-1=NOUN) = (# of instances where Verb follows Noun) / (# of instances where Noun appears) (2)

PROB (Wi|Ci) = (# of instances where Wi appears in Ci) /(# of instances where Ci appears) (3)

ในบทนี้เราจะพูดถึงการเริ่มต้นภาษาธรรมชาติในการประมวลผลภาษาธรรมชาติ เริ่มต้นด้วยการให้เราเข้าใจก่อนว่าไวยากรณ์ภาษาธรรมชาติคืออะไร

ไวยากรณ์ภาษาธรรมชาติ

สำหรับภาษาศาสตร์ภาษาคือกลุ่มของสัญญาณเสียงตามอำเภอใจ เราอาจพูดได้ว่าภาษานั้นมีความคิดสร้างสรรค์อยู่ภายใต้กฎเกณฑ์โดยธรรมชาติและเป็นสากลในเวลาเดียวกัน ในทางกลับกันมันก็เป็นมนุษย์เช่นกัน ธรรมชาติของภาษาแตกต่างกันสำหรับคนที่แตกต่างกัน มีความเข้าใจผิดเกี่ยวกับธรรมชาติของภาษาเป็นอย่างมาก นั่นคือเหตุผลที่สำคัญมากที่จะต้องเข้าใจความหมายของคำที่ไม่ชัดเจน‘grammar’. ในภาษาศาสตร์คำว่าไวยากรณ์อาจถูกกำหนดเป็นกฎหรือหลักการด้วยความช่วยเหลือของภาษาที่ใช้งานได้ ในความหมายกว้าง ๆ เราสามารถแบ่งไวยากรณ์ออกเป็นสองประเภท -

ไวยากรณ์เชิงพรรณนา

ชุดของกฎที่นักภาษาศาสตร์และไวยากรณ์กำหนดไวยากรณ์ของผู้พูดเรียกว่าไวยากรณ์เชิงพรรณนา

ไวยากรณ์ของมุมมอง

เป็นความรู้สึกที่แตกต่างกันมากของไวยากรณ์ซึ่งพยายามรักษามาตรฐานความถูกต้องในภาษา หมวดหมู่นี้มีส่วนเกี่ยวข้องกับการทำงานของภาษาจริงเล็กน้อย

ส่วนประกอบของภาษา

ภาษาที่ใช้ในการศึกษาแบ่งออกเป็นส่วนที่เกี่ยวข้องกันซึ่งเป็นแบบธรรมดาและแบบแบ่งส่วนของการสืบสวนทางภาษาโดยพลการ คำอธิบายของส่วนประกอบเหล่านี้มีดังนี้ -

สัทศาสตร์

องค์ประกอบแรกของภาษาคือสัทวิทยา เป็นการศึกษาเสียงพูดของภาษาใดภาษาหนึ่ง ที่มาของคำสามารถโยงไปถึงภาษากรีกได้โดยที่ 'โทรศัพท์' หมายถึงเสียงหรือเสียง สัทศาสตร์การแบ่งย่อยของการออกเสียงคือการศึกษาเสียงพูดของภาษามนุษย์จากมุมมองของการผลิตการรับรู้หรือคุณสมบัติทางกายภาพ IPA (International Phonetic Alphabet) เป็นเครื่องมือที่แสดงถึงเสียงของมนุษย์ในรูปแบบปกติในขณะที่เรียนสัทวิทยา ใน IPA สัญลักษณ์ที่เป็นลายลักษณ์อักษรทุกตัวจะแสดงถึงเสียงพูดเพียงหนึ่งเดียวและในทางกลับกัน

Phonemes

อาจถูกกำหนดให้เป็นหนึ่งในหน่วยของเสียงที่ทำให้คำหนึ่งคำแตกต่างจากคำอื่นในภาษา ในภาษาศาสตร์หน่วยเสียงเขียนระหว่างเครื่องหมายทับ ตัวอย่างเช่นฟอนิม/k/ เกิดขึ้นในคำต่างๆเช่น kit, skit

สัณฐานวิทยา

เป็นองค์ประกอบที่สองของภาษา เป็นการศึกษาโครงสร้างและการจำแนกคำในภาษาใดภาษาหนึ่ง ที่มาของคำนี้มาจากภาษากรีกโดยที่คำว่า 'morphe' หมายถึง 'form' สัณฐานวิทยาพิจารณาหลักการของการสร้างคำในภาษา กล่าวอีกนัยหนึ่งวิธีที่เสียงรวมกันเป็นหน่วยที่มีความหมายเช่นคำนำหน้าคำต่อท้ายและรากศัพท์ นอกจากนี้ยังพิจารณาว่าสามารถจัดกลุ่มคำออกเป็นส่วน ๆ ของคำพูดได้อย่างไร

Lexeme

ในภาษาศาสตร์หน่วยนามธรรมของการวิเคราะห์ทางสัณฐานวิทยาที่สอดคล้องกับชุดของรูปแบบที่ใช้คำเดียวเรียกว่า lexeme วิธีการใช้ lexeme ในประโยคจะพิจารณาจากหมวดไวยากรณ์ Lexeme สามารถเป็นคำเดี่ยวหรือหลายคำ ตัวอย่างเช่น word talk เป็นตัวอย่างของคำศัพท์แต่ละคำซึ่งอาจมีรูปแบบทางไวยากรณ์มากมายเช่นการพูดการพูดคุยและการพูดคุย คำศัพท์คำศัพท์หลายคำสามารถประกอบด้วยคำออร์โทกราฟิคได้มากกว่าหนึ่งคำ ตัวอย่างเช่นพูดขึ้นดึงผ่าน ฯลฯ เป็นตัวอย่างของคำศัพท์หลายคำ

ไวยากรณ์

เป็นองค์ประกอบที่สามของภาษา เป็นการศึกษาลำดับและการจัดเรียงคำให้เป็นหน่วยใหญ่ขึ้น คำนี้สามารถโยงไปถึงภาษากรีกได้โดยที่คำว่า suntassein หมายถึง 'จัดลำดับ' ศึกษาประเภทของประโยคและโครงสร้างของประโยคประโยค

อรรถศาสตร์

เป็นองค์ประกอบที่สี่ของภาษา เป็นการศึกษาว่าสื่อความหมายอย่างไร ความหมายอาจเกี่ยวข้องกับโลกภายนอกหรือเกี่ยวข้องกับไวยากรณ์ของประโยคก็ได้ คำนี้สามารถโยงไปถึงภาษากรีกได้โดยที่คำว่า semainein หมายถึง 'to signify', 'show', 'signal'

Pragmatics

เป็นองค์ประกอบที่ห้าของภาษา เป็นการศึกษาหน้าที่ของภาษาและการใช้งานในบริบท ที่มาของคำสามารถโยงไปถึงภาษากรีกโดยที่คำว่า 'pragma' หมายถึง 'การกระทำ', 'ความสัมพันธ์'

หมวดไวยากรณ์

หมวดหมู่ทางไวยากรณ์อาจถูกกำหนดให้เป็นชั้นของหน่วยหรือคุณสมบัติภายในไวยากรณ์ของภาษา หน่วยเหล่านี้เป็นหน่วยพื้นฐานของภาษาและแบ่งชุดลักษณะทั่วไป หมวดไวยากรณ์เรียกอีกอย่างว่าคุณลักษณะทางไวยากรณ์

รายการหมวดไวยากรณ์มีคำอธิบายด้านล่าง -

จำนวน

เป็นหมวดไวยากรณ์ที่ง่ายที่สุด เรามีคำศัพท์สองคำที่เกี่ยวข้องกับหมวดหมู่นี้ −singular และ plural เอกพจน์เป็นแนวคิดของ 'หนึ่ง' ในขณะที่พหูพจน์เป็นแนวคิดของ 'มากกว่าหนึ่ง' ตัวอย่างเช่นสุนัข / สุนัขนี้ / เหล่านี้

เพศ

เพศทางไวยากรณ์แสดงออกโดยการเปลี่ยนแปลงในสรรพนามส่วนตัวและบุคคลที่ 3 ตัวอย่างของเพศทางไวยากรณ์เป็นเอกพจน์ - เขาเธอมัน; แบบฟอร์มบุคคลที่หนึ่งและสอง - ฉันเราและคุณ รูปพหูพจน์ของบุคคลที่ 3 เป็นเพศที่พบบ่อยหรือเพศเดียวกัน

บุคคล

หมวดไวยากรณ์ง่ายๆอีกประเภทหนึ่งคือบุคคล ภายใต้เงื่อนไขสามข้อต่อไปนี้ได้รับการยอมรับ -

1st person - ผู้ที่กำลังพูดได้รับการยอมรับว่าเป็นบุคคลที่ 1

2nd person - บุคคลที่เป็นผู้ฟังหรือผู้ที่พูดด้วยจะได้รับการยอมรับว่าเป็นบุคคลที่ 2

3rd person - บุคคลหรือสิ่งที่เรากำลังพูดถึงได้รับการยอมรับว่าเป็นบุคคลที่ 3

กรณี

เป็นหมวดไวยากรณ์ที่ยากที่สุดหมวดหนึ่ง อาจถูกกำหนดให้เป็นการบ่งชี้การทำงานของวลีคำนาม (NP) หรือความสัมพันธ์ของนามวลีกับคำกริยาหรือวลีคำนามอื่น ๆ ในประโยค เรามีสามกรณีต่อไปนี้ที่แสดงในสรรพนามส่วนบุคคลและคำถาม -

Nominative case- เป็นหน้าที่ของหัวเรื่อง ตัวอย่างเช่นฉันเราคุณเขาเธอมันพวกเขาและใครเป็นผู้เสนอชื่อ

Genitive case- เป็นหน้าที่ของผู้ครอบครอง ตัวอย่างเช่นฉัน / ของฉัน, ของเรา / ของเรา, ของเขา, เธอ / เธอ, ของพวกเขา, ของพวกเขา, ซึ่งมีสัมพันธการก

Objective case- เป็นหน้าที่ของวัตถุ ตัวอย่างเช่นฉันเราคุณเขาเธอพวกเขาซึ่งเป็นเป้าหมาย

ระดับ

หมวดไวยากรณ์นี้เกี่ยวข้องกับคำคุณศัพท์และคำวิเศษณ์ มีสามคำต่อไปนี้ -

Positive degree- เป็นการแสดงออกถึงคุณภาพ ตัวอย่างเช่นขนาดใหญ่รวดเร็วสวยงามคือองศาบวก

Comparative degree- เป็นการแสดงออกถึงระดับหรือความเข้มของคุณภาพที่มากขึ้นในหนึ่งในสองรายการ ตัวอย่างเช่นที่ใหญ่กว่าเร็วกว่าสวยงามกว่าคือองศาเปรียบเทียบ

Superlative degree- เป็นการแสดงออกถึงระดับหรือความเข้มของคุณภาพที่ยิ่งใหญ่ที่สุดในหนึ่งในสามรายการหรือมากกว่านั้น ตัวอย่างเช่นที่ใหญ่ที่สุดเร็วที่สุดสวยงามที่สุดคือองศาที่ยอดเยี่ยม

ความชัดเจนและความไม่แน่นอน

ทั้งสองแนวคิดนี้ง่ายมาก ความชัดเจนตามที่เราทราบหมายถึงผู้อ้างอิงซึ่งเป็นที่รู้จักคุ้นเคยหรือระบุตัวตนได้โดยผู้พูดหรือผู้ฟัง ในทางกลับกันความไม่แน่นอนหมายถึงการอ้างอิงที่ไม่เป็นที่รู้จักหรือไม่คุ้นเคย แนวคิดนี้สามารถเข้าใจได้ในการเกิดร่วมกันของบทความที่มีคำนาม -

definite article-

indefinite article- a / an

เครียด

หมวดไวยากรณ์นี้เกี่ยวข้องกับคำกริยาและสามารถกำหนดเป็นตัวบ่งชี้ทางภาษาของเวลาของการกระทำ กาลสร้างความสัมพันธ์เพราะมันบ่งบอกเวลาของเหตุการณ์ที่เกี่ยวกับช่วงเวลาของการพูด โดยทั่วไปมีสามประเภทดังต่อไปนี้ -

Present tense- แสดงถึงการเกิดขึ้นของการกระทำในช่วงเวลาปัจจุบัน ตัวอย่างเช่นรามทำงานหนัก

Past tense- แสดงถึงการเกิดขึ้นก่อนช่วงเวลาปัจจุบัน ตัวอย่างเช่นฝนตก

Future tense- หมายถึงการเกิดขึ้นของการกระทำหลังจากช่วงเวลาปัจจุบัน ตัวอย่างเช่นฝนจะตก

มุมมอง

อาจกำหนดหมวดหมู่ทางไวยากรณ์นี้เป็นมุมมองที่ถ่ายจากเหตุการณ์ สามารถเป็นประเภทต่อไปนี้ -

Perfective aspect- มุมมองถูกถ่ายโดยรวมและสมบูรณ์ในแง่มุม ตัวอย่างเช่นอดีตกาลที่เรียบง่ายเช่นyesterday I met my friend, เป็นภาษาอังกฤษที่สมบูรณ์แบบในแง่มุมเนื่องจากมองว่าเหตุการณ์นั้นสมบูรณ์และทั้งหมด

Imperfective aspect- มุมมองถูกถ่ายเป็นภาพต่อเนื่องและไม่สมบูรณ์ ตัวอย่างเช่นปัจจุบันกริยากาลเช่นI am working on this problem, ในภาษาอังกฤษไม่สมบูรณ์ในแง่มุมเนื่องจากมองว่าเหตุการณ์ไม่สมบูรณ์และดำเนินต่อไป

อารมณ์

หมวดไวยากรณ์นี้ยากที่จะกำหนด แต่สามารถระบุได้ง่ายๆว่าเป็นการบ่งบอกทัศนคติของผู้พูดต่อสิ่งที่เขา / เธอกำลังพูดถึง นอกจากนี้ยังเป็นคุณสมบัติทางไวยากรณ์ของคำกริยา มันแตกต่างจากกาลทางไวยากรณ์และด้านไวยากรณ์ ตัวอย่างของอารมณ์เป็นสิ่งที่บ่งบอก, คำถาม, ความจำเป็น, คำสั่งห้าม, เสริม, ศักยภาพ, ตัวเลือก, ผู้มาเยือนและผู้มีส่วนร่วม

ข้อตกลง

เรียกอีกอย่างว่าคองคอร์ด เกิดขึ้นเมื่อคำเปลี่ยนจากขึ้นอยู่กับคำอื่น ๆ ที่เกี่ยวข้อง กล่าวอีกนัยหนึ่งก็คือการทำให้คุณค่าของหมวดไวยากรณ์บางหมวดตกลงระหว่างคำที่แตกต่างกันหรือบางส่วนของคำพูด ต่อไปนี้เป็นข้อตกลงตามหมวดไวยากรณ์อื่น ๆ -

Agreement based on Person- เป็นข้อตกลงระหว่างเรื่องและคำกริยา ตัวอย่างเช่นเรามักจะใช้“ ฉัน” และ“ เขาเป็น” แต่ไม่เคย“ เขาเป็น” และ“ ฉันเป็น”

Agreement based on Number- ข้อตกลงนี้อยู่ระหว่างหัวเรื่องและคำกริยา ในกรณีนี้มีรูปแบบคำกริยาเฉพาะสำหรับบุคคลที่หนึ่งเอกพจน์บุคคลที่สองพหูพจน์และอื่น ๆ ตัวอย่างเช่นบุคคลที่ 1 เอกพจน์: ฉันเป็นจริงพหูพจน์บุคคลที่ 2: พวกเราจริงๆบุคคลที่ 3 เอกพจน์: เด็กชายร้องเพลงพหูพจน์บุคคลที่ 3: เด็กผู้ชายร้องเพลง

Agreement based on Gender- ในภาษาอังกฤษมีข้อตกลงในเรื่องเพศระหว่างคำสรรพนามและคำก่อนหน้า ตัวอย่างเช่นพระองค์ไปถึงจุดหมาย เรือไปถึงที่หมายของเธอ

Agreement based on Case- ข้อตกลงประเภทนี้ไม่ใช่ลักษณะสำคัญของภาษาอังกฤษ ตัวอย่างเช่นใครมาก่อน - เขาหรือน้องสาวของเขา?

ไวยากรณ์ภาษาพูด

ไวยากรณ์ภาษาอังกฤษที่เขียนและพูดภาษาอังกฤษมีคุณสมบัติทั่วไปหลายประการ แต่นอกจากนี้ยังมีความแตกต่างกันในหลายด้าน คุณสมบัติต่อไปนี้แยกความแตกต่างระหว่างไวยากรณ์ภาษาอังกฤษที่พูดและเขียน -

ความผิดปกติและการซ่อมแซม

คุณลักษณะที่โดดเด่นนี้ทำให้ไวยากรณ์ภาษาอังกฤษพูดและเขียนแตกต่างกัน เป็นที่รู้จักกันเป็นรายบุคคลว่าเป็นปรากฏการณ์ของความผิดปกติและเรียกรวมกันว่าเป็นปรากฏการณ์ของการซ่อมแซม ความผิดปกติรวมถึงการใช้สิ่งต่อไปนี้ -

Fillers words- บางครั้งในระหว่างประโยคเราใช้คำเติมเต็ม พวกเขาเรียกว่าฟิลเลอร์ของฟิลเลอร์หยุดชั่วคราว ตัวอย่างของคำดังกล่าวคือเอ่อและอืม

Reparandum and repair- ส่วนคำที่ซ้ำกันระหว่างประโยคเรียกว่า reparandum ในส่วนเดียวกันคำที่เปลี่ยนแปลงเรียกว่าการซ่อมแซม ลองพิจารณาตัวอย่างต่อไปนี้เพื่อทำความเข้าใจสิ่งนี้ -

Does ABC airlines offer any one-way flights uh one-way fares for 5000 rupees?

ในประโยคข้างต้นเที่ยวบินขาเดียวคือการซ่อมบำรุงและเที่ยวบินเที่ยวเดียวคือการซ่อมแซม

รีสตาร์ท

หลังจากฟิลเลอร์หยุดชั่วคราวการรีสตาร์ทจะเกิดขึ้น ตัวอย่างเช่นในประโยคด้านบนการรีสตาร์ทจะเกิดขึ้นเมื่อผู้พูดเริ่มถามเกี่ยวกับเที่ยวบินขาเดียวจากนั้นหยุดแก้ไขตัวเองด้วยการหยุดฟิลเลอร์ชั่วคราวแล้วเริ่มใหม่เพื่อถามเกี่ยวกับค่าโดยสารเที่ยวเดียว

เศษคำ

บางครั้งเราพูดประโยคที่มีเศษคำเล็ก ๆ ตัวอย่างเช่น,wwha-what is the time? นี่คือคำพูด w-wha เป็นเศษคำ

การดึงข้อมูล (IR) อาจถูกกำหนดให้เป็นโปรแกรมซอฟต์แวร์ที่เกี่ยวข้องกับองค์กรการจัดเก็บการค้นคืนและการประเมินข้อมูลจากที่เก็บเอกสารโดยเฉพาะข้อมูลที่เป็นข้อความ ระบบช่วยเหลือผู้ใช้ในการค้นหาข้อมูลที่ต้องการ แต่ไม่ได้ส่งคืนคำตอบของคำถามอย่างชัดเจน จะแจ้งการมีอยู่และตำแหน่งของเอกสารที่อาจประกอบด้วยข้อมูลที่จำเป็น เอกสารที่ตรงตามความต้องการของผู้ใช้เรียกว่าเอกสารที่เกี่ยวข้อง ระบบ IR ที่สมบูรณ์แบบจะดึงเฉพาะเอกสารที่เกี่ยวข้อง

ด้วยความช่วยเหลือของแผนภาพต่อไปนี้เราสามารถเข้าใจกระบวนการดึงข้อมูล (IR) -

จากแผนภาพข้างต้นเห็นได้ชัดว่าผู้ใช้ที่ต้องการข้อมูลจะต้องกำหนดคำขอในรูปแบบของแบบสอบถามในภาษาธรรมชาติ จากนั้นระบบ IR จะตอบสนองโดยการดึงเอาท์พุทที่เกี่ยวข้องในรูปแบบของเอกสารเกี่ยวกับข้อมูลที่ต้องการ

ปัญหาคลาสสิกในระบบการดึงข้อมูล (IR)

เป้าหมายหลักของการวิจัย IR คือการพัฒนาแบบจำลองสำหรับการดึงข้อมูลจากที่เก็บของเอกสาร ที่นี่เราจะพูดถึงปัญหาคลาสสิกชื่อad-hoc retrieval problemเกี่ยวข้องกับระบบ IR

ในการดึงข้อมูลแบบเฉพาะกิจผู้ใช้ต้องป้อนข้อความค้นหาในภาษาธรรมชาติที่อธิบายข้อมูลที่ต้องการ จากนั้นระบบ IR จะส่งคืนเอกสารที่จำเป็นที่เกี่ยวข้องกับข้อมูลที่ต้องการ ตัวอย่างเช่นสมมติว่าเรากำลังค้นหาบางอย่างบนอินเทอร์เน็ตและมีบางหน้าที่เกี่ยวข้องตามข้อกำหนดของเรา แต่อาจมีบางหน้าที่ไม่เกี่ยวข้องด้วย นี่เป็นเพราะปัญหาการดึงข้อมูลเฉพาะกิจ

ลักษณะของ Ad-hoc Retrieval

ต่อไปนี้เป็นลักษณะบางประการของการดึงข้อมูลเฉพาะกิจที่กล่าวถึงในการวิจัย IR -

ผู้ใช้ที่ได้รับความช่วยเหลือจากข้อเสนอแนะเกี่ยวกับความเกี่ยวข้องสามารถปรับปรุงการกำหนดแบบสอบถามดั้งเดิมได้อย่างไร

วิธีการใช้การรวมฐานข้อมูลกล่าวคือผลลัพธ์จากฐานข้อมูลข้อความที่แตกต่างกันสามารถรวมเป็นชุดผลลัพธ์เดียวได้อย่างไร

วิธีจัดการกับข้อมูลที่เสียหายบางส่วน? รุ่นใดที่เหมาะสมสำหรับรุ่นเดียวกัน?

แบบจำลองการดึงข้อมูล (IR)

ในทางคณิตศาสตร์มีการใช้แบบจำลองในพื้นที่ทางวิทยาศาสตร์หลายแห่งโดยมีวัตถุประสงค์เพื่อทำความเข้าใจปรากฏการณ์บางอย่างในโลกแห่งความเป็นจริง แบบจำลองการดึงข้อมูลคาดการณ์และอธิบายสิ่งที่ผู้ใช้จะพบโดยเกี่ยวข้องกับคำค้นหาที่ระบุ แบบจำลอง IR เป็นรูปแบบที่กำหนดลักษณะดังกล่าวข้างต้นของขั้นตอนการดึงข้อมูลและประกอบด้วยสิ่งต่อไปนี้ -

แบบจำลองสำหรับเอกสาร

แบบจำลองสำหรับการสืบค้น

ฟังก์ชันการจับคู่ที่เปรียบเทียบคิวรีกับเอกสาร

ในทางคณิตศาสตร์แบบจำลองการค้นคืนประกอบด้วย -

D - การเป็นตัวแทนสำหรับเอกสาร

R - การเป็นตัวแทนสำหรับการสอบถาม

F - กรอบการสร้างแบบจำลองสำหรับ D, Q พร้อมกับความสัมพันธ์ระหว่างกัน

R (q,di)- ฟังก์ชั่นความคล้ายคลึงกันซึ่งสั่งซื้อเอกสารที่เกี่ยวข้องกับแบบสอบถาม เรียกอีกอย่างว่าการจัดอันดับ

ประเภทของแบบจำลองการดึงข้อมูล (IR)

แบบจำลองข้อมูล (IR) สามารถแบ่งออกเป็นสามรุ่นดังต่อไปนี้ -

โมเดล IR แบบคลาสสิก

เป็นโมเดล IR ที่ง่ายและสะดวกที่สุด แบบจำลองนี้ขึ้นอยู่กับความรู้ทางคณิตศาสตร์ที่จดจำและเข้าใจได้ง่ายเช่นกัน Boolean, Vector และ Probabilistic เป็นโมเดล IR แบบคลาสสิกสามแบบ

แบบจำลอง IR ที่ไม่ใช่คลาสสิก

ตรงข้ามกับโมเดล IR แบบคลาสสิกอย่างสิ้นเชิง แบบจำลอง IR ประเภทดังกล่าวตั้งอยู่บนหลักการอื่นที่ไม่ใช่ความคล้ายคลึงความน่าจะเป็นการดำเนินการแบบบูลีน แบบจำลองตรรกะข้อมูลแบบจำลองทฤษฎีสถานการณ์และแบบจำลองการโต้ตอบเป็นตัวอย่างของแบบจำลอง IR ที่ไม่ใช่แบบคลาสสิก

แบบจำลอง IR ทางเลือก

เป็นการเพิ่มประสิทธิภาพของโมเดล IR แบบคลาสสิกโดยใช้เทคนิคเฉพาะบางอย่างจากสาขาอื่น ๆ โมเดลคลัสเตอร์แบบจำลองฟัซซีและโมเดลการสร้างดัชนีความหมายแฝง (LSI) เป็นตัวอย่างของโมเดล IR ทางเลือก

คุณสมบัติการออกแบบของระบบการดึงข้อมูล (IR)

ให้เราเรียนรู้เกี่ยวกับคุณสมบัติการออกแบบของระบบ IR -

ดัชนีกลับหัว

โครงสร้างข้อมูลหลักของระบบ IR ส่วนใหญ่อยู่ในรูปของดัชนีกลับหัว เราสามารถกำหนดดัชนีกลับหัวเป็นโครงสร้างข้อมูลที่แสดงรายการสำหรับทุกคำเอกสารทั้งหมดที่มีและความถี่ของการเกิดขึ้นในเอกสาร ทำให้ง่ายต่อการค้นหา 'hit' ของคำค้นหา

หยุดการกำจัดคำ

คำหยุดคือคำที่มีความถี่สูงซึ่งถือว่าไม่น่าจะมีประโยชน์สำหรับการค้นหา พวกมันมีน้ำหนักเชิงความหมายน้อยกว่า คำประเภทนี้ทั้งหมดอยู่ในรายการที่เรียกว่ารายการหยุด ตัวอย่างเช่นบทความ“ a”“ an”“ the” และคำบุพบทเช่น“ in”“ of”“ for”“ at” เป็นต้นเป็นตัวอย่างของคำหยุด ขนาดของดัชนีกลับด้านสามารถลดลงอย่างมีนัยสำคัญตามรายการหยุด ตามกฎหมายของ Zipf รายการหยุดที่ครอบคลุมคำสองสามคำจะช่วยลดขนาดของดัชนีกลับด้านได้เกือบครึ่งหนึ่ง ในทางกลับกันบางครั้งการกำจัดคำหยุดอาจทำให้เกิดการกำจัดคำที่เป็นประโยชน์สำหรับการค้นหา ตัวอย่างเช่นหากเรากำจัดอักษร“ A” ออกจาก“ วิตามินเอ” ก็จะไม่มีความสำคัญ

Stemming

Stemming เป็นรูปแบบที่เรียบง่ายของการวิเคราะห์สัณฐานวิทยาเป็นกระบวนการฮิวริสติกในการแยกรูปแบบฐานของคำโดยการตัดส่วนท้ายของคำออก ตัวอย่างเช่นคำว่าหัวเราะหัวเราะหัวเราะจะมีต้นตอมาจากคำว่าหัวเราะ

ในส่วนต่อไปเราจะพูดถึงโมเดล IR ที่สำคัญและมีประโยชน์

แบบจำลองบูลีน

เป็นแบบจำลองการดึงข้อมูล (IR) ที่เก่าแก่ที่สุด แบบจำลองนี้ขึ้นอยู่กับทฤษฎีเซตและพีชคณิตบูลีนโดยที่เอกสารคือชุดของคำศัพท์และแบบสอบถามคือนิพจน์บูลีนในเงื่อนไข โมเดลบูลีนสามารถกำหนดเป็น -

D- ชุดของคำกล่าวคือเงื่อนไขการจัดทำดัชนีที่มีอยู่ในเอกสาร ในที่นี้แต่ละคำจะมีอยู่ (1) หรือไม่มี (0)

Q - นิพจน์บูลีนโดยที่เงื่อนไขเป็นเงื่อนไขดัชนีและตัวดำเนินการเป็นผลิตภัณฑ์เชิงตรรกะ - และผลรวมตรรกะ - หรือและความแตกต่างเชิงตรรกะ - ไม่ใช่

F - พีชคณิตบูลีนเหนือชุดของคำศัพท์และชุดเอกสาร

หากเราพูดถึงความคิดเห็นเกี่ยวกับความเกี่ยวข้องดังนั้นในโมเดล Boolean IR การทำนายความเกี่ยวข้องสามารถกำหนดได้ดังนี้ -

R - เอกสารถูกคาดการณ์ว่าเกี่ยวข้องกับนิพจน์เคียวรีก็ต่อเมื่อมันตรงตามนิพจน์เคียวรีเป็น -

((˅) ˄ ˄ ˜ ℎ)

เราสามารถอธิบายแบบจำลองนี้โดยใช้คำค้นหาเป็นคำจำกัดความที่ชัดเจนของชุดเอกสาร

ตัวอย่างเช่นคำค้นหา “economic” กำหนดชุดเอกสารที่จัดทำดัชนีด้วยคำศัพท์ “economic”.

ตอนนี้ผลลัพธ์จะเป็นอย่างไรหลังจากรวมเงื่อนไขกับบูลีนและตัวดำเนินการ จะกำหนดชุดเอกสารที่มีขนาดเล็กกว่าหรือเท่ากับชุดเอกสารของคำศัพท์ใดคำหนึ่ง ตัวอย่างเช่นแบบสอบถามที่มีเงื่อนไข“social” และ “economic”จะจัดทำชุดเอกสารที่จัดทำดัชนีด้วยเงื่อนไขทั้งสอง กล่าวอีกนัยหนึ่งคือชุดเอกสารที่มีจุดตัดของทั้งสองชุด

ตอนนี้ผลลัพธ์จะเป็นอย่างไรหลังจากรวมเงื่อนไขกับตัวดำเนินการบูลีน OR? จะกำหนดชุดเอกสารที่ใหญ่กว่าหรือเท่ากับชุดเอกสารของคำศัพท์ใดคำหนึ่ง ตัวอย่างเช่นแบบสอบถามที่มีเงื่อนไข“social” หรือ “economic” จะจัดทำชุดเอกสารที่จัดทำดัชนีด้วยคำศัพท์อย่างใดอย่างหนึ่ง “social” หรือ “economic”. กล่าวอีกนัยหนึ่งคือชุดเอกสารที่มีการรวมกันของทั้งสองชุด

ข้อดีของโหมดบูลีน

ข้อดีของแบบจำลองบูลีนมีดังนี้ -

โมเดลที่ง่ายที่สุดซึ่งเป็นไปตามชุด

ง่ายต่อการเข้าใจและนำไปใช้

จะดึงข้อมูลที่ตรงกันเท่านั้น

ช่วยให้ผู้ใช้มีความรู้สึกในการควบคุมระบบ

ข้อเสียของแบบจำลองบูลีน

ข้อเสียของแบบจำลองบูลีนมีดังนี้ -

ฟังก์ชันความคล้ายคลึงกันของโมเดลคือบูลีน ดังนั้นจะไม่มีการจับคู่บางส่วน สิ่งนี้อาจสร้างความรำคาญให้กับผู้ใช้

ในโมเดลนี้การใช้ตัวดำเนินการบูลีนมีอิทธิพลมากกว่าคำที่สำคัญ

ภาษาของแบบสอบถามเป็นภาษาที่แสดงออก แต่ก็ซับซ้อนเช่นกัน

ไม่มีการจัดอันดับสำหรับเอกสารที่เรียกค้น

แบบจำลองอวกาศเวกเตอร์

เนื่องจากข้อเสียข้างต้นของแบบจำลองบูลีน Gerard Salton และเพื่อนร่วมงานของเขาจึงแนะนำแบบจำลองซึ่งเป็นไปตามเกณฑ์ความคล้ายคลึงกันของ Luhn เกณฑ์ความคล้ายคลึงกันที่กำหนดโดยรัฐ Luhn“ ยิ่งมีการแสดงสองรายการที่ตกลงกันในองค์ประกอบที่กำหนดและการแจกแจงของมันมากเท่าไหร่ความน่าจะเป็นที่จะแสดงข้อมูลที่คล้ายกันก็จะยิ่งสูงขึ้นเท่านั้น”

พิจารณาประเด็นสำคัญต่อไปนี้เพื่อทำความเข้าใจเพิ่มเติมเกี่ยวกับ Vector Space Model -

การแสดงดัชนี (เอกสาร) และแบบสอบถามถือเป็นเวกเตอร์ที่ฝังอยู่ในช่องว่างแบบยุคลิดที่มีมิติสูง

การวัดความคล้ายคลึงกันของเวกเตอร์เอกสารกับเวกเตอร์แบบสอบถามมักเป็นโคไซน์ของมุมระหว่างทั้งสอง

สูตรการวัดความคล้ายคลึงกันของโคไซน์

โคไซน์เป็นผลิตภัณฑ์ดอทปกติซึ่งสามารถคำนวณได้ด้วยความช่วยเหลือของสูตรต่อไปนี้ -

$$Score \lgroup \vec{d} \vec{q} \rgroup= \frac{\sum_{k=1}^m d_{k}\:.q_{k}}{\sqrt{\sum_{k=1}^m\lgroup d_{k}\rgroup^2}\:.\sqrt{\sum_{k=1}^m}m\lgroup q_{k}\rgroup^2 }$$

$$Score \lgroup \vec{d} \vec{q}\rgroup =1\:when\:d =q $$

$$Score \lgroup \vec{d} \vec{q}\rgroup =0\:when\:d\:and\:q\:share\:no\:items$$

การแสดงพื้นที่เวกเตอร์ด้วยแบบสอบถามและเอกสาร

แบบสอบถามและเอกสารแสดงด้วยช่องว่างเวกเตอร์สองมิติ เงื่อนไขคือcar และ insurance. มีแบบสอบถามหนึ่งรายการและเอกสารสามฉบับในพื้นที่เวกเตอร์

เอกสารที่ได้รับการจัดอันดับสูงสุดตามเงื่อนไขรถยนต์และประกันภัยจะเป็นเอกสาร d2 เพราะมุมระหว่าง q และ d2มีขนาดเล็กที่สุด เหตุผลเบื้องหลังก็คือทั้งแนวคิดรถยนต์และการประกันภัยมีความสำคัญใน d 2และด้วยเหตุนี้จึงมีน้ำหนักที่สูง ในอีกด้านหนึ่งd1 และ d3 นอกจากนี้ยังกล่าวถึงทั้งสองคำ แต่ในแต่ละกรณีหนึ่งในนั้นไม่ใช่คำที่สำคัญส่วนกลางในเอกสาร

การถ่วงน้ำหนักระยะ

การถ่วงน้ำหนักระยะหมายถึงน้ำหนักของเงื่อนไขในปริภูมิเวกเตอร์ ค่าน้ำหนักของเทอมที่สูงขึ้นผลกระทบของคำที่มีต่อโคไซน์จะมากขึ้น ควรกำหนดน้ำหนักเพิ่มเติมให้กับเงื่อนไขที่สำคัญกว่าในแบบจำลอง ตอนนี้คำถามที่เกิดขึ้นคือเราจะจำลองสิ่งนี้ได้อย่างไร

วิธีหนึ่งที่จะทำได้คือนับคำในเอกสารเป็นน้ำหนักคำศัพท์ อย่างไรก็ตามคุณคิดว่ามันจะเป็นวิธีที่มีประสิทธิภาพหรือไม่?

อีกวิธีหนึ่งซึ่งได้ผลดีกว่าคือการใช้ term frequency (tfij), document frequency (dfi) และ collection frequency (cfi).

ระยะความถี่ (tf ij )

อาจกำหนดเป็นจำนวนครั้งที่เกิดขึ้น wi ใน dj. ข้อมูลที่ถูกจับโดยความถี่ของคำคือความสำคัญของคำที่อยู่ในเอกสารที่กำหนดหรือกล่าวอีกนัยหนึ่งเราสามารถพูดได้ว่ายิ่งความถี่ของคำสูงขึ้นเท่าใดคำนั้นก็เป็นคำอธิบายที่ดีของเนื้อหาของเอกสารนั้น

ความถี่เอกสาร (df i )

มันอาจจะถูกกำหนดเป็นจำนวนรวมของเอกสารในคอลเลกชันที่ W ผมเกิดขึ้น มันเป็นตัวบ่งชี้ของการให้ข้อมูล คำที่เน้นความหมายจะเกิดขึ้นหลายครั้งในเอกสารซึ่งแตกต่างจากคำที่ไม่เน้นความหมาย

ความถี่ในการรวบรวม (cf i )

อาจกำหนดเป็นจำนวนครั้งทั้งหมดของ wi ในคอลเลกชัน