Maschinelles Lernen mit Python - Kurzanleitung

Wir leben im Zeitalter der Daten, das mit besserer Rechenleistung und mehr Speicherressourcen angereichert ist. Diese Daten oder Informationen nehmen von Tag zu Tag zu, aber die eigentliche Herausforderung besteht darin, alle Daten zu verstehen. Unternehmen und Organisationen versuchen, damit umzugehen, indem sie intelligente Systeme unter Verwendung der Konzepte und Methoden aus Data Science, Data Mining und maschinellem Lernen aufbauen. Unter ihnen ist maschinelles Lernen das aufregendste Gebiet der Informatik. Es wäre nicht falsch, wenn wir maschinelles Lernen als Anwendung und Wissenschaft von Algorithmen bezeichnen, die den Daten Sinn verleihen.

Was ist maschinelles Lernen?

Maschinelles Lernen (ML) ist das Gebiet der Informatik, mit dessen Hilfe Computersysteme Daten auf die gleiche Weise sinnvoll machen können wie Menschen.

Mit einfachen Worten, ML ist eine Art künstliche Intelligenz, die mithilfe eines Algorithmus oder einer Methode Muster aus Rohdaten extrahiert. Das Hauptaugenmerk von ML liegt darauf, Computersystemen zu ermöglichen, aus Erfahrungen zu lernen, ohne explizit programmiert zu werden oder menschliches Eingreifen.

Notwendigkeit für maschinelles Lernen

Der Mensch ist derzeit die intelligenteste und fortschrittlichste Spezies der Erde, weil er komplexe Probleme denken, bewerten und lösen kann. Auf der anderen Seite befindet sich die KI noch im Anfangsstadium und hat die menschliche Intelligenz in vielen Aspekten nicht übertroffen. Dann ist die Frage, was ist die Notwendigkeit, um Maschine lernen zu lassen? Der am besten geeignete Grund dafür ist, „Entscheidungen auf der Grundlage von Daten mit Effizienz und Skalierbarkeit zu treffen“.

In letzter Zeit investieren Unternehmen stark in neuere Technologien wie künstliche Intelligenz, maschinelles Lernen und Deep Learning, um die wichtigsten Informationen aus Daten zu erhalten, um mehrere reale Aufgaben auszuführen und Probleme zu lösen. Wir können es datengesteuerte Entscheidungen nennen, die von Maschinen getroffen werden, insbesondere um den Prozess zu automatisieren. Diese datengesteuerten Entscheidungen können anstelle der Programmierlogik bei Problemen verwendet werden, die nicht inhärent programmiert werden können. Tatsache ist, dass wir nicht ohne menschliche Intelligenz auskommen können, aber ein anderer Aspekt ist, dass wir alle reale Probleme mit Effizienz in großem Maßstab lösen müssen. Deshalb entsteht der Bedarf an maschinellem Lernen.

Warum und wann sollen Maschinen lernen?

Wir haben bereits die Notwendigkeit des maschinellen Lernens erörtert, aber es stellt sich die Frage, in welchen Szenarien wir die Maschine zum Lernen bringen müssen. Es kann verschiedene Umstände geben, unter denen wir Maschinen benötigen, um datengesteuerte Entscheidungen effizient und in großem Umfang zu treffen. Im Folgenden sind einige dieser Umstände aufgeführt, unter denen das Erlernen von Maschinen effektiver wäre -

Mangel an menschlichem Fachwissen

Das allererste Szenario, in dem eine Maschine lernen und datengesteuerte Entscheidungen treffen soll, kann der Bereich sein, in dem es an menschlichem Fachwissen mangelt. Die Beispiele können Navigationen in unbekannten Gebieten oder Raumplaneten sein.

Dynamische Szenarien

Es gibt einige Szenarien, die dynamischer Natur sind, dh sie ändern sich im Laufe der Zeit ständig. Bei diesen Szenarien und Verhaltensweisen soll eine Maschine lernen und datengesteuerte Entscheidungen treffen. Einige Beispiele können die Netzwerkkonnektivität und die Verfügbarkeit der Infrastruktur in einer Organisation sein.

Schwierigkeiten bei der Umsetzung von Fachwissen in Rechenaufgaben

Es kann verschiedene Bereiche geben, in denen Menschen ihr Fachwissen haben; Sie können dieses Fachwissen jedoch nicht in Rechenaufgaben umsetzen. Unter solchen Umständen wollen wir maschinelles Lernen. Die Beispiele können die Bereiche Spracherkennung, kognitive Aufgaben usw. sein.

Modell des maschinellen Lernens

Bevor wir das Modell des maschinellen Lernens diskutieren, müssen wir die folgende formale Definition von ML verstehen, die von Professor Mitchell gegeben wurde:

"Ein Computerprogramm soll aus der Erfahrung E in Bezug auf eine Klasse von Aufgaben T und das Leistungsmaß P lernen, wenn sich seine Leistung bei Aufgaben in T, gemessen durch P, mit der Erfahrung E verbessert."

Die obige Definition konzentriert sich im Wesentlichen auf drei Parameter, auch die Hauptkomponenten eines Lernalgorithmus, nämlich Aufgabe (T), Leistung (P) und Erfahrung (E). In diesem Zusammenhang können wir diese Definition vereinfachen als -

ML ist ein KI-Bereich, der aus Lernalgorithmen besteht, die -

Verbessere ihre Leistung (P)

Bei der Ausführung einer Aufgabe (T)

Im Laufe der Zeit mit Erfahrung (E)

Basierend auf dem oben Gesagten stellt das folgende Diagramm ein Modell für maschinelles Lernen dar -

Lassen Sie uns sie jetzt genauer besprechen -

Aufgabe (T)

Aus der Perspektive des Problems können wir die Aufgabe T als das zu lösende reale Problem definieren. Das Problem kann darin bestehen, den besten Immobilienpreis an einem bestimmten Ort zu finden oder die beste Marketingstrategie usw. zu finden. Wenn wir dagegen über maschinelles Lernen sprechen, ist die Definition der Aufgabe anders, da es schwierig ist, ML-basierte Aufgaben zu lösen konventioneller Programmieransatz.

Eine Aufgabe T wird als ML-basierte Aufgabe bezeichnet, wenn sie auf dem Prozess basiert und das System folgen muss, um Datenpunkte zu bearbeiten. Beispiele für ML-basierte Aufgaben sind Klassifizierung, Regression, strukturierte Annotation, Clustering, Transkription usw.

Erfahrung (E)

Wie der Name schon sagt, handelt es sich um das Wissen, das aus Datenpunkten gewonnen wurde, die dem Algorithmus oder Modell zur Verfügung gestellt wurden. Sobald das Dataset bereitgestellt wurde, wird das Modell iterativ ausgeführt und lernt ein inhärentes Muster. Das so erworbene Lernen heißt Erfahrung (E). Wenn wir eine Analogie zum menschlichen Lernen ziehen, können wir uns diese Situation so vorstellen, dass ein Mensch aus verschiedenen Attributen wie Situation, Beziehungen usw. lernt oder Erfahrungen sammelt. Überwachtes, unbeaufsichtigtes und verstärkendes Lernen sind einige Möglichkeiten, um zu lernen oder Erfahrungen zu sammeln. Die Erfahrungen aus unserem ML-Modell oder -Algorithmus werden zur Lösung der Aufgabe T verwendet.

Leistung (P)

Ein ML-Algorithmus soll Aufgaben ausführen und Erfahrungen im Laufe der Zeit sammeln. Das Maß, das angibt, ob der ML-Algorithmus erwartungsgemäß funktioniert oder nicht, ist seine Leistung (P). P ist im Grunde eine quantitative Metrik, die anhand ihrer Erfahrung E angibt, wie ein Modell die Aufgabe T ausführt. Es gibt viele Metriken, die zum Verständnis der ML-Leistung beitragen, z. B. Genauigkeitsbewertung, F1-Bewertung, Verwirrungsmatrix, Präzision und Rückruf , Empfindlichkeit usw.

Herausforderungen beim maschinellen Lernen

Während sich das maschinelle Lernen rasant weiterentwickelt und mit Cybersicherheit und autonomen Autos erhebliche Fortschritte macht, hat dieses Segment der KI insgesamt noch einen langen Weg vor sich. Der Grund dafür ist, dass ML die Anzahl der Herausforderungen nicht bewältigen konnte. Die Herausforderungen, vor denen ML derzeit steht, sind:

Quality of data- Gute Datenqualität für ML-Algorithmen ist eine der größten Herausforderungen. Die Verwendung von Daten geringer Qualität führt zu Problemen im Zusammenhang mit der Datenvorverarbeitung und der Merkmalsextraktion.

Time-Consuming task - Eine weitere Herausforderung für ML-Modelle ist der Zeitaufwand, insbesondere für die Datenerfassung, Merkmalsextraktion und das Abrufen.

Lack of specialist persons - Da die ML-Technologie noch in den Kinderschuhen steckt, ist die Verfügbarkeit von Expertenressourcen eine schwierige Aufgabe.

No clear objective for formulating business problems - Kein klares Ziel und klar definiertes Ziel für geschäftliche Probleme zu haben, ist eine weitere zentrale Herausforderung für ML, da diese Technologie noch nicht so ausgereift ist.

Issue of overfitting & underfitting - Wenn das Modell über- oder unterpasst ist, kann es für das Problem nicht gut dargestellt werden.

Curse of dimensionality- Eine weitere Herausforderung für das ML-Modell sind zu viele Merkmale von Datenpunkten. Dies kann ein echtes Hindernis sein.

Difficulty in deployment - Die Komplexität des ML-Modells macht es ziemlich schwierig, im wirklichen Leben eingesetzt zu werden.

Anwendungen des maschinellen Lernens

Maschinelles Lernen ist die am schnellsten wachsende Technologie und laut Forschern befinden wir uns im goldenen Jahr von KI und ML. Es wird verwendet, um viele reale komplexe Probleme zu lösen, die mit einem herkömmlichen Ansatz nicht gelöst werden können. Im Folgenden finden Sie einige reale Anwendungen von ML -

Emotionsanalyse

Stimmungsanalyse

Fehlererkennung und -verhütung

Wettervorhersage und Vorhersage

Börsenanalyse und -prognose

Sprachsynthese

Spracherkennung

Kundensegmentierung

Objekterkennung

Entdeckung eines Betruges

Betrugsprävention

Produktempfehlung an den Kunden beim Online-Shopping.

Eine Einführung in Python

Python ist eine beliebte objektorientierte Programmiersprache mit den Fähigkeiten einer höheren Programmiersprache. Seine leicht zu erlernende Syntax und Portabilitätsfähigkeit machen es heutzutage beliebt. Die folgenden Fakten geben uns die Einführung in Python -

Python wurde von Guido van Rossum am Stichting Mathematisch Centrum in den Niederlanden entwickelt.

Es wurde als Nachfolger der Programmiersprache 'ABC' geschrieben.

Die erste Version wurde 1991 veröffentlicht.

Der Name Python wurde von Guido van Rossum aus einer TV-Show namens Monty Pythons Flying Circus ausgewählt.

Es ist eine Open-Source-Programmiersprache, dh wir können sie kostenlos herunterladen und zur Entwicklung von Programmen verwenden. Es kann von www.python.org heruntergeladen werden .

Die Programmiersprache Python verfügt über die Funktionen von Java und C. Es hat den eleganten C-Code und andererseits Klassen und Objekte wie Java für die objektorientierte Programmierung.

Es ist eine interpretierte Sprache, dh der Quellcode des Python-Programms wird zuerst in Bytecode konvertiert und dann von der virtuellen Python-Maschine ausgeführt.

Stärken und Schwächen von Python

Jede Programmiersprache hat einige Stärken und Schwächen, ebenso wie Python.

Stärken

Studien und Umfragen zufolge ist Python die fünftwichtigste Sprache sowie die beliebteste Sprache für maschinelles Lernen und Datenwissenschaft. Aufgrund der folgenden Stärken hat Python:

Easy to learn and understand- Die Syntax von Python ist einfacher; Daher ist es selbst für Anfänger relativ einfach, die Sprache zu lernen und zu verstehen.

Multi-purpose language - Python ist eine Mehrzweckprogrammiersprache, da es strukturierte Programmierung, objektorientierte Programmierung sowie funktionale Programmierung unterstützt.

Huge number of modules- Python verfügt über eine große Anzahl von Modulen, die alle Aspekte der Programmierung abdecken. Diese Module sind leicht verfügbar und machen Python zu einer erweiterbaren Sprache.

Support of open source community- Als Open Source-Programmiersprache wird Python von einer sehr großen Entwicklergemeinschaft unterstützt. Aus diesem Grund können die Fehler von der Python-Community leicht behoben werden. Diese Eigenschaft macht Python sehr robust und anpassungsfähig.

Scalability - Python ist eine skalierbare Programmiersprache, da es eine verbesserte Struktur für die Unterstützung großer Programme bietet als Shell-Skripte.

Die Schwäche

Obwohl Python eine beliebte und leistungsstarke Programmiersprache ist, hat es seine eigene Schwäche der langsamen Ausführungsgeschwindigkeit.

Die Ausführungsgeschwindigkeit von Python ist im Vergleich zu kompilierten Sprachen langsam, da Python eine interpretierte Sprache ist. Dies kann der Hauptverbesserungsbereich für die Python-Community sein.

Python installieren

Um in Python arbeiten zu können, müssen wir es zuerst installieren. Sie können die Installation von Python auf eine der folgenden zwei Arten durchführen:

Python einzeln installieren

Verwenden der vorgefertigten Python-Distribution - Anaconda

Lassen Sie uns diese jeweils im Detail besprechen.

Python einzeln installieren

Wenn Sie Python auf Ihrem Computer installieren möchten, müssen Sie nur den für Ihre Plattform geltenden Binärcode herunterladen. Die Python-Distribution ist für Windows-, Linux- und Mac-Plattformen verfügbar.

Im Folgenden finden Sie eine kurze Übersicht über die Installation von Python auf den oben genannten Plattformen:

On Unix and Linux platform

Mit Hilfe der folgenden Schritte können wir Python unter Unix und Linux installieren -

Gehen Sie zuerst zu https://www.python.org/downloads/.

Klicken Sie anschließend auf den Link, um den für Unix / Linux verfügbaren komprimierten Quellcode herunterzuladen.

Laden Sie jetzt Dateien herunter und extrahieren Sie sie.

Als nächstes können wir die Modul- / Setup-Datei bearbeiten, wenn wir einige Optionen anpassen möchten.

Schreiben Sie als Nächstes den Befehl run ./configure script

make

make install

On Windows platform

Mit Hilfe der folgenden Schritte können wir Python auf der Windows-Plattform installieren -

Gehen Sie zuerst zu https://www.python.org/downloads/.

Klicken Sie anschließend auf den Link für die Windows-Installationsdatei python-XYZ.msi. Hier ist XYZ die Version, die wir installieren möchten.

Jetzt müssen wir die heruntergeladene Datei ausführen. Wir gelangen zum Python-Installationsassistenten, der einfach zu bedienen ist. Übernehmen Sie nun die Standardeinstellungen und warten Sie, bis die Installation abgeschlossen ist.

On Macintosh platform

Für Mac OS X, Homebrew, wird ein großartiges und benutzerfreundliches Paketinstallationsprogramm empfohlen, um Python 3 zu installieren. Falls Sie kein Homebrew haben, können Sie es mit Hilfe des folgenden Befehls installieren:

$ ruby -e "$(curl -fsSL

https://raw.githubusercontent.com/Homebrew/install/master/install)"Es kann mit dem folgenden Befehl aktualisiert werden -

$ brew updateUm Python3 auf Ihrem System zu installieren, müssen Sie den folgenden Befehl ausführen:

$ brew install python3Verwenden der vorgefertigten Python-Distribution: Anaconda

Anaconda ist eine gepackte Zusammenstellung von Python, die alle in der Datenwissenschaft weit verbreiteten Bibliotheken enthält. Wir können die folgenden Schritte ausführen, um die Python-Umgebung mit Anaconda einzurichten:

Step1- Zuerst müssen wir das erforderliche Installationspaket von der Anaconda-Distribution herunterladen. Der Link dafür isthttps://www.anaconda.com/distribution/. Sie können je nach Anforderung zwischen Windows-, Mac- und Linux-Betriebssystemen wählen.

Step2- Wählen Sie als Nächstes die Python-Version aus, die Sie auf Ihrem Computer installieren möchten. Die neueste Python-Version ist 3.7. Dort erhalten Sie die Optionen für das 64-Bit- und das 32-Bit-Grafikinstallationsprogramm.

Step3- Nach Auswahl des Betriebssystems und der Python-Version wird das Anaconda-Installationsprogramm auf Ihren Computer heruntergeladen. Doppelklicken Sie nun auf die Datei und das Installationsprogramm installiert das Anaconda-Paket.

Step4 - Um zu überprüfen, ob es installiert ist oder nicht, öffnen Sie eine Eingabeaufforderung und geben Sie Python wie folgt ein: -

Sie können dies auch in einer ausführlichen Videovorlesung unter überprüfenhttps://www.tutorialspoint.com/python_essentials_online_training/getting_started_with_anaconda.asp.

Warum Python für Data Science?

Python ist die fünftwichtigste Sprache sowie die beliebteste Sprache für maschinelles Lernen und Datenwissenschaft. Die folgenden Funktionen von Python machen es zur bevorzugten Sprachwahl für die Datenwissenschaft:

Umfangreiche Pakete

Python verfügt über eine umfangreiche und leistungsstarke Reihe von Paketen, die für die Verwendung in verschiedenen Domänen bereit sind. Es gibt auch Pakete wie Numpy, Scipy, Pandas, Scikit-Learn usw., die für maschinelles Lernen und Data Science erforderlich sind.

Einfaches Prototyping

Ein weiteres wichtiges Merkmal von Python, das es zur Wahl der Sprache für die Datenwissenschaft macht, ist das einfache und schnelle Prototyping. Diese Funktion ist nützlich für die Entwicklung eines neuen Algorithmus.

Kollaborationsfunktion

Das Gebiet der Datenwissenschaft erfordert grundsätzlich eine gute Zusammenarbeit, und Python bietet viele nützliche Tools, die dies extrem machen.

Eine Sprache für viele Domänen

Ein typisches Data Science-Projekt umfasst verschiedene Bereiche wie Datenextraktion, Datenmanipulation, Datenanalyse, Merkmalsextraktion, Modellierung, Bewertung, Bereitstellung und Aktualisierung der Lösung. Da Python eine Mehrzwecksprache ist, kann der Datenwissenschaftler alle diese Domänen von einer gemeinsamen Plattform aus ansprechen.

Komponenten des Python ML-Ökosystems

Lassen Sie uns in diesem Abschnitt einige Kernbibliotheken von Data Science diskutieren, die die Komponenten des Python-Ökosystems für maschinelles Lernen bilden. Diese nützlichen Komponenten machen Python zu einer wichtigen Sprache für Data Science. Obwohl es viele solcher Komponenten gibt, lassen Sie uns hier einige der wichtigsten Komponenten des Python-Ökosystems diskutieren -

Jupyter Notizbuch

Jupyter-Notebooks bieten grundsätzlich eine interaktive Computerumgebung für die Entwicklung von Python-basierten Data Science-Anwendungen. Sie sind früher als Ipython-Notizbücher bekannt. Im Folgenden sind einige der Funktionen von Jupyter-Notebooks aufgeführt, die es zu einer der besten Komponenten des Python ML-Ökosystems machen:

Jupyter-Notizbücher können den Analyseprozess Schritt für Schritt veranschaulichen, indem sie Dinge wie Code, Bilder, Text, Ausgabe usw. Schritt für Schritt anordnen.

Es hilft einem Datenwissenschaftler, den Denkprozess zu dokumentieren, während er den Analyseprozess entwickelt.

Man kann das Ergebnis auch als Teil des Notizbuchs erfassen.

Mit Hilfe von Jupyter-Notizbüchern können wir unsere Arbeit auch mit Kollegen teilen.

Installation und Ausführung

Wenn Sie die Anaconda-Distribution verwenden, müssen Sie das Jupyter-Notebook nicht separat installieren, da es bereits mit ihm installiert ist. Sie müssen nur zur Anaconda-Eingabeaufforderung gehen und den folgenden Befehl eingeben:

C:\>jupyter notebookNach dem Drücken der Eingabetaste wird ein Notebook-Server unter localhost: 8888 Ihres Computers gestartet. Es wird im folgenden Screenshot gezeigt -

Nachdem Sie auf die Registerkarte Neu geklickt haben, erhalten Sie eine Liste mit Optionen. Wählen Sie Python 3 und Sie gelangen zum neuen Notizbuch, in dem Sie arbeiten können. In den folgenden Screenshots erhalten Sie einen Einblick -

Wenn Sie dagegen die Standard-Python-Distribution verwenden, kann das Jupyter-Notebook mit dem beliebten Python-Paket-Installationsprogramm pip installiert werden.

pip install jupyterZelltypen in Jupyter Notebook

Im Folgenden sind die drei Zelltypen in einem Jupyter-Notizbuch aufgeführt:

Code cells- Wie der Name schon sagt, können wir diese Zellen zum Schreiben von Code verwenden. Nach dem Schreiben des Codes / Inhalts wird dieser an den Kernel gesendet, der dem Notizbuch zugeordnet ist.

Markdown cells- Wir können diese Zellen verwenden, um den Berechnungsprozess zu notieren. Sie können Dinge wie Text, Bilder, Latexgleichungen, HTML-Tags usw. enthalten.

Raw cells- Der darin geschriebene Text wird so angezeigt, wie er ist. Diese Zellen werden im Wesentlichen verwendet, um den Text hinzuzufügen, den wir nicht durch den automatischen Konvertierungsmechanismus des Jupyter-Notebooks konvertieren möchten.

Für eine detailliertere Untersuchung des Jupyter-Notebooks können Sie auf den Link gehenhttps://www.tutorialspoint.com/jupyter/index.htm.

NumPy

Es ist eine weitere nützliche Komponente, die Python zu einer der Lieblingssprachen für Data Science macht. Es steht im Wesentlichen für Numerical Python und besteht aus mehrdimensionalen Array-Objekten. Mit NumPy können wir die folgenden wichtigen Vorgänge ausführen:

Mathematische und logische Operationen an Arrays.

Fourier-Transformation

Operationen im Zusammenhang mit linearer Algebra.

Wir können NumPy auch als Ersatz für MatLab sehen, da NumPy hauptsächlich zusammen mit Scipy (Scientific Python) und Mat-plotlib (Plotbibliothek) verwendet wird.

Installation and Execution

Wenn Sie die Anaconda-Distribution verwenden, müssen Sie NumPy nicht separat installieren, da es bereits mit installiert ist. Sie müssen das Paket nur mit Hilfe der folgenden Schritte in Ihr Python-Skript importieren:

import numpy as npWenn Sie dagegen die Standard-Python-Distribution verwenden, kann NumPy mit dem beliebten Python-Paket-Installationsprogramm pip installiert werden.

pip install NumPyFür eine detailliertere Untersuchung von NumPy können Sie auf den Link gehenhttps://www.tutorialspoint.com/numpy/index.htm.

Pandas

Es ist eine weitere nützliche Python-Bibliothek, die Python zu einer der Lieblingssprachen für Data Science macht. Pandas wird hauptsächlich zur Datenmanipulation, zum Wrangling und zur Analyse verwendet. Es wurde 2008 von Wes McKinney entwickelt. Mit Hilfe von Pandas können wir bei der Datenverarbeitung die folgenden fünf Schritte ausführen:

Load

Prepare

Manipulate

Model

Analyze

Datendarstellung in Pandas

Die gesamte Darstellung von Daten in Pandas erfolgt mithilfe der folgenden drei Datenstrukturen:

Series- Es handelt sich im Grunde genommen um ein eindimensionales ndarray mit einer Achsenbeschriftung, was bedeutet, dass es sich um ein einfaches Array mit homogenen Daten handelt. Die folgende Reihe ist beispielsweise eine Sammlung von ganzen Zahlen 1,5,10,15,24,25…

| 1 | 5 | 10 | 15 | 24 | 25 | 28 | 36 | 40 | 89 |

Data frame- Es ist die nützlichste Datenstruktur und wird für fast alle Arten der Darstellung und Manipulation von Daten in Pandas verwendet. Grundsätzlich handelt es sich um eine zweidimensionale Datenstruktur, die heterogene Daten enthalten kann. Im Allgemeinen werden tabellarische Daten mithilfe von Datenrahmen dargestellt. Die folgende Tabelle zeigt beispielsweise die Daten von Schülern mit Namen und Rollennummern, Alter und Geschlecht -

Name |

Rollennummer |

Alter |

Geschlecht |

|---|---|---|---|

Aarav |

1 |

15 |

Männlich |

Harshit |

2 |

14 |

Männlich |

Kanika |

3 |

16 |

Weiblich |

Mayank |

4 |

15 |

Männlich |

Panel- Es handelt sich um eine dreidimensionale Datenstruktur, die heterogene Daten enthält. Es ist sehr schwierig, das Panel in grafischer Darstellung darzustellen, es kann jedoch als Container von DataFrame dargestellt werden.

Die folgende Tabelle gibt uns die Dimension und Beschreibung der oben genannten Datenstrukturen, die in Pandas verwendet werden -

Datenstruktur |

Abmessungen |

Beschreibung |

|---|---|---|

Serie |

1-D |

Größe unveränderlich, 1-D homogene Daten |

DataFrames |

2-D |

Größe Veränderbare, heterogene Daten in Tabellenform |

Panel |

3-D |

Größenveränderbares Array, Container mit DataFrame. |

Wir können diese Datenstrukturen verstehen, da die höherdimensionale Datenstruktur der Container der niedrigdimensionalen Datenstruktur ist.

Installation und Ausführung

Wenn Sie die Anaconda-Distribution verwenden, müssen Sie Pandas nicht separat installieren, da es bereits installiert ist. Sie müssen das Paket nur mit Hilfe der folgenden Schritte in Ihr Python-Skript importieren:

import pandas as pdWenn Sie dagegen die Standard-Python-Distribution verwenden, können Pandas mit dem beliebten Python-Paket-Installationsprogramm pip installiert werden.

pip install PandasNach der Installation von Pandas können Sie es wie oben beschrieben in Ihr Python-Skript importieren.

Beispiel

Das folgende Beispiel zeigt das Erstellen einer Serie aus ndarray mithilfe von Pandas:

In [1]: import pandas as pd

In [2]: import numpy as np

In [3]: data = np.array(['g','a','u','r','a','v'])

In [4]: s = pd.Series(data)

In [5]: print (s)

0 g

1 a

2 u

3 r

4 a

5 v

dtype: objectFür eine detailliertere Untersuchung von Pandas können Sie auf den Link gehen https://www.tutorialspoint.com/python_pandas/index.htm.

Scikit-lernen

Eine weitere nützliche und wichtigste Python-Bibliothek für Data Science und maschinelles Lernen in Python ist Scikit-learn. Das Folgende sind einige Funktionen von Scikit-learn, die es so nützlich machen -

Es basiert auf NumPy, SciPy und Matplotlib.

Es ist Open Source und kann unter BSD-Lizenz wiederverwendet werden.

Es ist für jedermann zugänglich und kann in verschiedenen Zusammenhängen wiederverwendet werden.

Mithilfe dieser Methode kann eine breite Palette von Algorithmen für maschinelles Lernen implementiert werden, die wichtige Bereiche der ML wie Klassifizierung, Clustering, Regression, Dimensionsreduzierung, Modellauswahl usw. abdecken.

Installation und Ausführung

Wenn Sie die Anaconda-Distribution verwenden, müssen Sie Scikit-learn nicht separat installieren, da es bereits mit installiert ist. Sie müssen das Paket nur in Ihrem Python-Skript verwenden. Mit der folgenden Skriptzeile importieren wir beispielsweise einen Datensatz von Brustkrebspatientinnen ausScikit-learn - -

from sklearn.datasets import load_breast_cancerWenn Sie dagegen die Standard-Python-Distribution verwenden und NumPy und SciPy verwenden, kann Scikit-learn mit dem beliebten Python-Paket-Installationsprogramm pip installiert werden.

pip install -U scikit-learnNach der Installation von Scikit-learn können Sie es wie oben beschrieben in Ihrem Python-Skript verwenden.

Es gibt verschiedene ML-Algorithmen, Techniken und Methoden, mit denen Modelle zur Lösung realer Probleme mithilfe von Daten erstellt werden können. In diesem Kapitel werden wir solche unterschiedlichen Arten von Methoden diskutieren.

Verschiedene Arten von Methoden

Das Folgende sind verschiedene ML-Methoden, die auf einigen breiten Kategorien basieren -

Basierend auf menschlicher Aufsicht

Im Lernprozess sind einige der Methoden, die auf menschlicher Aufsicht basieren, wie folgt:

Supervised Learning

Überwachte Lernalgorithmen oder -methoden sind die am häufigsten verwendeten ML-Algorithmen. Diese Methode oder dieser Lernalgorithmus entnimmt die Datenprobe, dh die Trainingsdaten und die zugehörige Ausgabe, dh Beschriftungen oder Antworten mit jeder Datenprobe während des Trainingsprozesses.

Das Hauptziel von überwachten Lernalgorithmen besteht darin, eine Assoziation zwischen Eingabedatenproben und entsprechenden Ausgaben zu lernen, nachdem mehrere Trainingsdateninstanzen durchgeführt wurden.

Zum Beispiel haben wir

x: Eingangsvariablen und

Y: Ausgabevariable

Wenden Sie nun einen Algorithmus an, um die Zuordnungsfunktion von der Eingabe zur Ausgabe wie folgt zu lernen:

Y = f (x)

Das Hauptziel wäre nun, die Abbildungsfunktion so gut zu approximieren, dass wir selbst bei neuen Eingabedaten (x) die Ausgabevariable (Y) für diese neuen Eingabedaten leicht vorhersagen können.

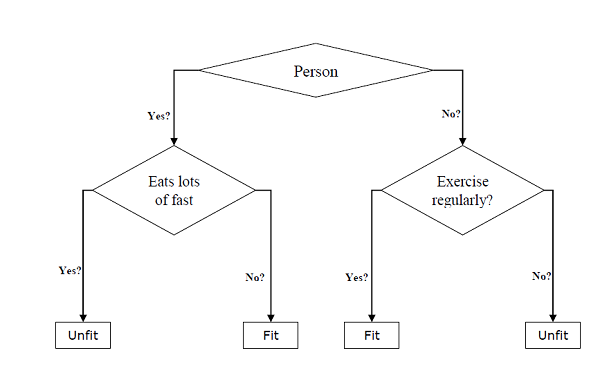

Es wird als überwacht bezeichnet, da der gesamte Lernprozess so gedacht werden kann, wie er von einem Lehrer oder Betreuer überwacht wird. Beispiele für überwachte Algorithmen für maschinelles Lernen umfassenDecision tree, Random Forest, KNN, Logistic Regression usw.

Basierend auf den ML-Aufgaben können überwachte Lernalgorithmen in die folgenden zwei großen Klassen unterteilt werden:

Classification

Regression

Classification

Das Hauptziel klassifizierungsbasierter Aufgaben besteht darin, kategoriale Ausgabebezeichnungen oder Antworten für die angegebenen Eingabedaten vorherzusagen. Die Ausgabe basiert auf dem, was das Modell in der Trainingsphase gelernt hat. Da wir wissen, dass die kategorialen Ausgabeantworten ungeordnete und diskrete Werte bedeuten, gehört jede Ausgabeantwort zu einer bestimmten Klasse oder Kategorie. Wir werden die Klassifizierung und die zugehörigen Algorithmen auch in den kommenden Kapiteln ausführlich erörtern.

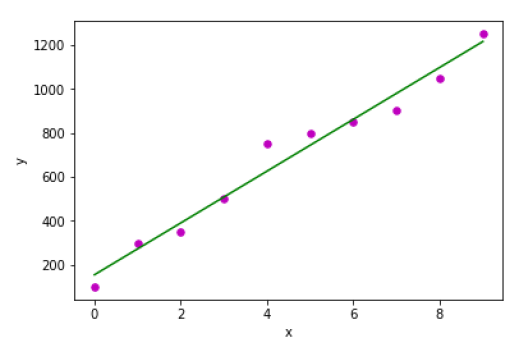

Regression

Das Hauptziel von auf Regression basierenden Aufgaben besteht darin, Ausgabekennzeichnungen oder Antworten, die weiterhin numerische Werte sind, für die angegebenen Eingabedaten vorherzusagen. Die Ausgabe basiert auf dem, was das Modell in seiner Trainingsphase gelernt hat. Grundsätzlich verwenden Regressionsmodelle die Eingabedatenmerkmale (unabhängige Variablen) und ihre entsprechenden kontinuierlichen numerischen Ausgabewerte (abhängige oder Ergebnisvariablen), um die spezifische Assoziation zwischen Eingaben und entsprechenden Ausgaben zu lernen. Wir werden die Regression und die damit verbundenen Algorithmen auch in weiteren Kapiteln ausführlich erörtern.

Unbeaufsichtigtes Lernen

Wie der Name schon sagt, ist es im Gegensatz zu überwachten ML-Methoden oder -Algorithmen, was bedeutet, dass wir bei unbeaufsichtigten Algorithmen für maschinelles Lernen keinen Supervisor haben, der irgendeine Art von Anleitung bietet. Unüberwachte Lernalgorithmen sind praktisch in dem Szenario, in dem wir nicht wie bei überwachten Lernalgorithmen die Freiheit haben, vorbeschriftete Trainingsdaten zu haben, und nützliche Muster aus Eingabedaten extrahieren möchten.

Zum Beispiel kann es wie folgt verstanden werden:

Angenommen, wir haben -

x: Input variablesDann würde es keine entsprechende Ausgabevariable geben und die Algorithmen müssen das interessante Muster in den Lerndaten ermitteln.

Beispiele für unbeaufsichtigte Algorithmen für maschinelles Lernen umfassen K-Mittel-Clustering, K-nearest neighbors usw.

Basierend auf den ML-Aufgaben können unbeaufsichtigte Lernalgorithmen in folgende breite Klassen unterteilt werden:

Clustering

Association

Reduzierung der Dimensionalität

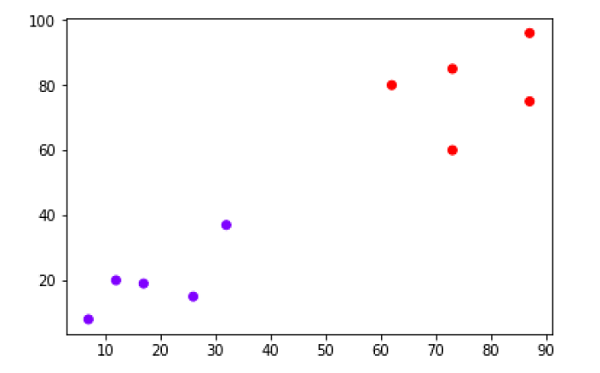

Clustering

Clustering-Methoden sind eine der nützlichsten unbeaufsichtigten ML-Methoden. Diese Algorithmen werden verwendet, um Ähnlichkeits- und Beziehungsmuster zwischen Datenproben zu finden und diese Proben dann in Gruppen mit Ähnlichkeit basierend auf Merkmalen zu gruppieren. Das reale Beispiel für Clustering besteht darin, die Kunden nach ihrem Kaufverhalten zu gruppieren.

Association

Eine andere nützliche unbeaufsichtigte ML-Methode ist AssociationHiermit wird ein großer Datensatz analysiert, um Muster zu finden, die die interessanten Beziehungen zwischen verschiedenen Elementen darstellen. Es wird auch als bezeichnetAssociation Rule Mining oder Market basket analysis Dies wird hauptsächlich zur Analyse von Kundeneinkaufsmustern verwendet.

Dimensionality Reduction

Diese unbeaufsichtigte ML-Methode wird verwendet, um die Anzahl der Merkmalsvariablen für jede Datenprobe durch Auswahl eines Satzes von Hauptmerkmalen oder repräsentativen Merkmalen zu reduzieren. Hier stellt sich die Frage, warum wir die Dimensionalität reduzieren müssen. Der Grund dafür ist das Problem der Komplexität des Merkmalsraums, das auftritt, wenn wir mit der Analyse und Extraktion von Millionen von Merkmalen aus Datenproben beginnen. Dieses Problem bezieht sich allgemein auf "Fluch der Dimensionalität". PCA (Principal Component Analysis), K-nächste Nachbarn und Diskriminanzanalyse sind einige der gängigen Algorithmen für diesen Zweck.

Anomaly Detection

Diese unbeaufsichtigte ML-Methode wird verwendet, um das Auftreten seltener Ereignisse oder Beobachtungen herauszufinden, die im Allgemeinen nicht auftreten. Durch die Verwendung des erlernten Wissens könnten Anomalieerkennungsmethoden zwischen anomalen oder normalen Datenpunkten unterscheiden. Einige der unbeaufsichtigten Algorithmen wie Clustering, KNN können Anomalien basierend auf den Daten und ihren Merkmalen erkennen.

Halbüberwachtes Lernen

Solche Algorithmen oder Methoden werden weder vollständig überwacht noch vollständig unbeaufsichtigt. Sie liegen grundsätzlich zwischen den beiden überwachten und unbeaufsichtigten Lernmethoden. Diese Arten von Algorithmen verwenden im Allgemeinen eine kleine überwachte Lernkomponente, dh eine kleine Menge vorbeschrifteter kommentierter Daten, und eine große unbeaufsichtigte Lernkomponente, dh viele unbeschriftete Daten für das Training. Wir können einen der folgenden Ansätze zur Implementierung von halbüberwachten Lernmethoden verfolgen:

Der erste und einfache Ansatz besteht darin, das überwachte Modell basierend auf einer kleinen Menge beschrifteter und kommentierter Daten zu erstellen und dann das unbeaufsichtigte Modell zu erstellen, indem dasselbe auf die großen Mengen unbeschrifteter Daten angewendet wird, um mehr beschriftete Proben zu erhalten. Trainieren Sie nun das Modell darauf und wiederholen Sie den Vorgang.

- , p> Der zweite Ansatz erfordert einige zusätzliche Anstrengungen. Bei diesem Ansatz können wir zuerst die unbeaufsichtigten Methoden verwenden, um ähnliche Datenproben zu gruppieren, diese Gruppen mit Anmerkungen zu versehen und dann eine Kombination dieser Informationen zum Trainieren des Modells zu verwenden.

Verstärkungslernen

Diese Methoden unterscheiden sich von zuvor untersuchten Methoden und werden auch sehr selten angewendet. Bei dieser Art von Lernalgorithmen gibt es einen Agenten, den wir über einen bestimmten Zeitraum trainieren möchten, damit er mit einer bestimmten Umgebung interagieren kann. Der Agent folgt einer Reihe von Strategien für die Interaktion mit der Umgebung und ergreift nach Beobachtung der Umgebung Maßnahmen in Bezug auf den aktuellen Zustand der Umgebung. Das Folgende sind die Hauptschritte der Lernmethoden zur Verstärkung:

Step1 - Zuerst müssen wir einen Agenten mit ersten Strategien vorbereiten.

Step2 - Beobachten Sie dann die Umgebung und ihren aktuellen Zustand.

Step3 - Wählen Sie als Nächstes die optimale Richtlinie für den aktuellen Status der Umgebung aus und führen Sie wichtige Maßnahmen aus.

Step4 - Jetzt kann der Agent eine entsprechende Belohnung oder Strafe erhalten, die der Aktion entspricht, die er im vorherigen Schritt ausgeführt hat.

Step5 - Jetzt können wir die Strategien aktualisieren, wenn dies erforderlich ist.

Step6 - Wiederholen Sie zuletzt die Schritte 2 bis 5, bis der Agent die optimalen Richtlinien gelernt und übernommen hat.

Aufgaben für maschinelles Lernen

Das folgende Diagramm zeigt, welche Art von Aufgabe für verschiedene ML-Probleme geeignet ist -

Basierend auf Lernfähigkeit

Im Lernprozess sind im Folgenden einige Methoden aufgeführt, die auf der Lernfähigkeit basieren:

Batch Learning

In vielen Fällen verfügen wir über End-to-End-Systeme für maschinelles Lernen, in denen wir das Modell auf einmal unter Verwendung der gesamten verfügbaren Trainingsdaten trainieren müssen. Eine solche Art von Lernmethode oder Algorithmus wird genanntBatch or Offline learning. Es wird als Batch- oder Offline-Lernen bezeichnet, da es sich um eine einmalige Prozedur handelt und das Modell mit Daten in einem einzigen Batch trainiert wird. Im Folgenden sind die Hauptschritte der Batch-Lernmethoden aufgeführt:

Step1 - Zuerst müssen wir alle Trainingsdaten sammeln, um mit dem Training des Modells zu beginnen.

Step2 - Beginnen Sie jetzt mit dem Training des Modells, indem Sie ganze Trainingsdaten auf einmal bereitstellen.

Step3 - Beenden Sie als Nächstes den Lern- / Trainingsprozess, sobald Sie zufriedenstellende Ergebnisse / Leistungen erzielt haben.

Step4- Stellen Sie dieses geschulte Modell schließlich in der Produktion bereit. Hier wird die Ausgabe für eine neue Datenprobe vorhergesagt.

Online lernen

Es ist völlig entgegengesetzt zu den Batch- oder Offline-Lernmethoden. Bei diesen Lernmethoden werden die Trainingsdaten in mehreren inkrementellen Stapeln, die als Mini-Stapel bezeichnet werden, an den Algorithmus geliefert. Das Folgende sind die Hauptschritte der Online-Lernmethoden -

Step1 - Zuerst müssen wir alle Trainingsdaten sammeln, um mit dem Training des Modells zu beginnen.

Step2 - Beginnen Sie nun mit dem Training des Modells, indem Sie dem Algorithmus einen kleinen Stapel von Trainingsdaten bereitstellen.

Step3 - Als nächstes müssen wir dem Algorithmus die Mini-Stapel von Trainingsdaten in mehreren Schritten zur Verfügung stellen.

Step4 - Da es nicht wie das Batch-Lernen aufhört, nachdem Sie die gesamten Trainingsdaten in Mini-Batches bereitgestellt haben, stellen Sie auch neue Datenmuster bereit.

Step5 - Schließlich wird es über einen bestimmten Zeitraum basierend auf den neuen Datenstichproben weiter lernen.

Basierend auf dem Generalisierungsansatz

Im Lernprozess folgen einige Methoden, die auf Generalisierungsansätzen basieren -

Instanzbasiertes Lernen

Die instanzbasierte Lernmethode ist eine der nützlichen Methoden, mit denen die ML-Modelle durch Verallgemeinerung auf der Grundlage der Eingabedaten erstellt werden. Es ist im Gegensatz zu den zuvor untersuchten Lernmethoden dahingehend, dass diese Art des Lernens ML-Systeme sowie Methoden umfasst, die die Rohdatenpunkte selbst verwenden, um die Ergebnisse für neuere Datenstichproben zu zeichnen, ohne ein explizites Modell auf Trainingsdaten aufzubauen.

Mit einfachen Worten, instanzbasiertes Lernen beginnt im Wesentlichen damit, die Eingabedatenpunkte zu betrachten und dann mithilfe einer Ähnlichkeitsmetrik die neuen Datenpunkte zu verallgemeinern und vorherzusagen.

Modellbasiertes Lernen

Bei modellbasierten Lernmethoden findet ein iterativer Prozess für die ML-Modelle statt, die auf verschiedenen Modellparametern basieren, die als Hyperparameter bezeichnet werden und in denen Eingabedaten zum Extrahieren der Merkmale verwendet werden. Bei diesem Lernen werden Hyperparameter basierend auf verschiedenen Modellvalidierungstechniken optimiert. Aus diesem Grund können wir sagen, dass modellbasierte Lernmethoden einen traditionelleren ML-Ansatz zur Verallgemeinerung verwenden.

Angenommen, wenn Sie ein ML-Projekt starten möchten, was ist dann das erste und wichtigste, was Sie benötigen würden? Es sind die Daten, die wir laden müssen, um eines der ML-Projekte zu starten. In Bezug auf Daten ist das häufigste Datenformat für ML-Projekte CSV (durch Kommas getrennte Werte).

Grundsätzlich ist CSV ein einfaches Dateiformat, mit dem tabellarische Daten (Nummer und Text) wie eine Tabelle im Klartext gespeichert werden. In Python können wir CSV-Daten auf verschiedene Arten laden, aber bevor wir CSV-Daten laden, müssen wir einige Überlegungen berücksichtigen.

Berücksichtigung beim Laden von CSV-Daten

Das CSV-Datenformat ist das am häufigsten verwendete Format für ML-Daten. Wir müssen jedoch darauf achten, wichtige Überlegungen zu beachten, während wir diese in unsere ML-Projekte laden.

Dateikopf

In CSV-Datendateien enthält der Header die Informationen für jedes Feld. Wir müssen dasselbe Trennzeichen für die Header-Datei und für die Datendatei verwenden, da die Header-Datei angibt, wie Datenfelder interpretiert werden sollen.

Im Folgenden sind die beiden Fälle im Zusammenhang mit dem CSV-Dateikopf aufgeführt, die berücksichtigt werden müssen:

Case-I: When Data file is having a file header - Es werden automatisch die Namen jeder Datenspalte zugewiesen, wenn die Datendatei einen Dateikopf hat.

Case-II: When Data file is not having a file header - Wir müssen die Namen jeder Datenspalte manuell zuweisen, wenn die Datendatei keinen Dateikopf hat.

In beiden Fällen müssen wir explizit angeben, ob unsere CSV-Datei einen Header enthält oder nicht.

Bemerkungen

Kommentare in Datendateien haben ihre Bedeutung. In der CSV-Datendatei werden Kommentare durch einen Hash (#) am Zeilenanfang angezeigt. Beim Laden von CSV-Daten in ML-Projekte müssen Kommentare berücksichtigt werden. Wenn wir Kommentare in der Datei haben, müssen wir möglicherweise angeben, ob diese Kommentare zu erwarten sind oder nicht.

Trennzeichen

In CSV-Datendateien ist das Komma (,) das Standardtrennzeichen. Die Rolle des Trennzeichens besteht darin, die Werte in den Feldern zu trennen. Es ist wichtig, die Rolle des Trennzeichens beim Hochladen der CSV-Datei in ML-Projekte zu berücksichtigen, da wir auch ein anderes Trennzeichen verwenden können, z. B. eine Registerkarte oder einen Leerraum. Wenn Sie jedoch ein anderes Trennzeichen als das Standardtrennzeichen verwenden, müssen Sie es explizit angeben.

Zitate

In CSV-Datendateien ist das doppelte Anführungszeichen ("") das Standard-Anführungszeichen. Es ist wichtig, die Rolle von Anführungszeichen beim Hochladen der CSV-Datei in ML-Projekte zu berücksichtigen, da wir auch andere Anführungszeichen als doppelte Anführungszeichen verwenden können. Wenn Sie jedoch ein anderes Anführungszeichen als das Standardzeichen verwenden, müssen Sie es explizit angeben.

Methoden zum Laden der CSV-Datendatei

Bei der Arbeit mit ML-Projekten besteht die wichtigste Aufgabe darin, die Daten ordnungsgemäß zu laden. Das gebräuchlichste Datenformat für ML-Projekte ist CSV. Es gibt verschiedene Varianten und unterschiedliche Schwierigkeiten beim Parsen. In diesem Abschnitt werden drei gängige Ansätze in Python zum Laden von CSV-Datendateien erläutert:

Laden Sie CSV mit der Python Standard Library

Der erste und am häufigsten verwendete Ansatz zum Laden von CSV-Datendateien ist die Verwendung der Python-Standardbibliothek, die uns eine Vielzahl integrierter Module bietet, nämlich das CSV-Modul und die reader () -Funktion. Das folgende Beispiel zeigt das Laden einer CSV-Datendatei mithilfe dieser Datei:

Beispiel

In diesem Beispiel verwenden wir den Irisblumendatensatz, der in unser lokales Verzeichnis heruntergeladen werden kann. Nach dem Laden der Datendatei können wir sie in ein NumPy-Array konvertieren und für ML-Projekte verwenden. Es folgt das Python-Skript zum Laden der CSV-Datendatei:

Zuerst müssen wir das von der Python-Standardbibliothek bereitgestellte CSV-Modul wie folgt importieren:

import csvAls nächstes müssen wir das Numpy-Modul importieren, um die geladenen Daten in ein NumPy-Array zu konvertieren.

import numpy as npGeben Sie nun den vollständigen Pfad der Datei an, die in unserem lokalen Verzeichnis gespeichert ist und die CSV-Datendatei enthält.

path = r"c:\iris.csv"Verwenden Sie als Nächstes die Funktion csv.reader (), um Daten aus der CSV-Datei zu lesen.

with open(path,'r') as f:

reader = csv.reader(f,delimiter = ',')

headers = next(reader)

data = list(reader)

data = np.array(data).astype(float)Wir können die Namen der Header mit der folgenden Skriptzeile drucken -

print(headers)In der folgenden Skriptzeile wird die Form der Daten gedruckt, dh die Anzahl der Zeilen und Spalten in der Datei.

print(data.shape)Die nächste Skriptzeile enthält die ersten drei Zeilen der Datendatei -

print(data[:3])Output

['sepal_length', 'sepal_width', 'petal_length', 'petal_width']

(150, 4)

[ [5.1 3.5 1.4 0.2]

[4.9 3. 1.4 0.2]

[4.7 3.2 1.3 0.2]]Laden Sie CSV mit NumPy

Ein weiterer Ansatz zum Laden der CSV-Datendatei ist die Funktion NumPy und numpy.loadtxt (). Das folgende Beispiel zeigt das Laden einer CSV-Datendatei mithilfe dieser Datei:

Beispiel

In diesem Beispiel verwenden wir den Pima-Indianer-Datensatz mit den Daten von Diabetikern. Dieser Datensatz ist ein numerischer Datensatz ohne Kopfzeile. Es kann auch in unser lokales Verzeichnis heruntergeladen werden. Nach dem Laden der Datendatei können wir sie in ein NumPy-Array konvertieren und für ML-Projekte verwenden. Das folgende ist das Python-Skript zum Laden der CSV-Datendatei -

from numpy import loadtxt

path = r"C:\pima-indians-diabetes.csv"

datapath= open(path, 'r')

data = loadtxt(datapath, delimiter=",")

print(data.shape)

print(data[:3])Ausgabe

(768, 9)

[ [ 6. 148. 72. 35. 0. 33.6 0.627 50. 1.]

[ 1. 85. 66. 29. 0. 26.6 0.351 31. 0.]

[ 8. 183. 64. 0. 0. 23.3 0.672 32. 1.]]Laden Sie CSV mit Pandas

Ein anderer Ansatz zum Laden der CSV-Datendatei ist die Funktion Pandas und pandas.read_csv (). Dies ist die sehr flexible Funktion, die einen pandas.DataFrame zurückgibt, der sofort zum Plotten verwendet werden kann. Das folgende Beispiel zeigt das Laden einer CSV-Datendatei mithilfe dieser Datei:

Beispiel

Hier werden wir zwei Python-Skripte implementieren, zum einen mit einem Iris-Datensatz mit Headern und zum anderen mit dem Pima Indians-Datensatz, einem numerischen Datensatz ohne Header. Beide Datensätze können in das lokale Verzeichnis heruntergeladen werden.

Script-1

Das folgende Python-Skript zum Laden der CSV-Datendatei mit Pandas on Iris-Datensatz:

from pandas import read_csv

path = r"C:\iris.csv"

data = read_csv(path)

print(data.shape)

print(data[:3])

Output:

(150, 4)

sepal_length sepal_width petal_length petal_width

0 5.1 3.5 1.4 0.2

1 4.9 3.0 1.4 0.2

2 4.7 3.2 1.3 0.2Script-2

Das folgende Python-Skript zum Laden der CSV-Datendatei sowie zum Bereitstellen der Headernamen mithilfe von Pandas im Pima Indians Diabetes-Datensatz:

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

headernames = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=headernames)

print(data.shape)

print(data[:3])Output

(768, 9)

preg plas pres skin test mass pedi age class

0 6 148 72 35 0 33.6 0.627 50 1

1 1 85 66 29 0 26.6 0.351 31 0

2 8 183 64 0 0 23.3 0.672 32 1Der Unterschied zwischen den oben verwendeten drei Ansätzen zum Laden der CSV-Datendatei kann anhand der angegebenen Beispiele leicht verstanden werden.

Einführung

Bei der Arbeit mit maschinellen Lernprojekten ignorieren wir normalerweise zwei wichtige Teile, die aufgerufen werden mathematics und data. Wir wissen, dass ML ein datengetriebener Ansatz ist und unser ML-Modell nur so gute oder so schlechte Ergebnisse liefert wie die Daten, die wir ihm zur Verfügung gestellt haben.

Im vorherigen Kapitel haben wir erläutert, wie wir CSV-Daten in unser ML-Projekt hochladen können. Es ist jedoch hilfreich, die Daten vor dem Hochladen zu verstehen. Wir können die Daten auf zwei Arten verstehen, mit Statistiken und mit Visualisierung.

In diesem Kapitel werden wir anhand der folgenden Python-Rezepte ML-Daten mit Statistiken verstehen.

Rohdaten betrachten

Das allererste Rezept ist das Betrachten Ihrer Rohdaten. Es ist wichtig, Rohdaten zu betrachten, da die Erkenntnisse, die wir nach der Betrachtung von Rohdaten erhalten, unsere Chancen auf eine bessere Vorverarbeitung sowie den Umgang mit Daten für ML-Projekte erhöhen.

Im Folgenden finden Sie ein Python-Skript, das mithilfe der head () - Funktion von Pandas DataFrame im Diabetes-Datensatz von Pima Indians implementiert wurde, um die ersten 50 Zeilen zu betrachten und ein besseres Verständnis zu erhalten.

Beispiel

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

headernames = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=headernames)

print(data.head(50))Ausgabe

preg plas pres skin test mass pedi age class

0 6 148 72 35 0 33.6 0.627 50 1

1 1 85 66 29 0 26.6 0.351 31 0

2 8 183 64 0 0 23.3 0.672 32 1

3 1 89 66 23 94 28.1 0.167 21 0

4 0 137 40 35 168 43.1 2.288 33 1

5 5 116 74 0 0 25.6 0.201 30 0

6 3 78 50 32 88 31.0 0.248 26 1

7 10 115 0 0 0 35.3 0.134 29 0

8 2 197 70 45 543 30.5 0.158 53 1

9 8 125 96 0 0 0.0 0.232 54 1

10 4 110 92 0 0 37.6 0.191 30 0

11 10 168 74 0 0 38.0 0.537 34 1

12 10 139 80 0 0 27.1 1.441 57 0

13 1 189 60 23 846 30.1 0.398 59 1

14 5 166 72 19 175 25.8 0.587 51 1

15 7 100 0 0 0 30.0 0.484 32 1

16 0 118 84 47 230 45.8 0.551 31 1

17 7 107 74 0 0 29.6 0.254 31 1

18 1 103 30 38 83 43.3 0.183 33 0

19 1 115 70 30 96 34.6 0.529 32 1

20 3 126 88 41 235 39.3 0.704 27 0

21 8 99 84 0 0 35.4 0.388 50 0

22 7 196 90 0 0 39.8 0.451 41 1

23 9 119 80 35 0 29.0 0.263 29 1

24 11 143 94 33 146 36.6 0.254 51 1

25 10 125 70 26 115 31.1 0.205 41 1

26 7 147 76 0 0 39.4 0.257 43 1

27 1 97 66 15 140 23.2 0.487 22 0

28 13 145 82 19 110 22.2 0.245 57 0

29 5 117 92 0 0 34.1 0.337 38 0

30 5 109 75 26 0 36.0 0.546 60 0

31 3 158 76 36 245 31.6 0.851 28 1

32 3 88 58 11 54 24.8 0.267 22 0

33 6 92 92 0 0 19.9 0.188 28 0

34 10 122 78 31 0 27.6 0.512 45 0

35 4 103 60 33 192 24.0 0.966 33 0

36 11 138 76 0 0 33.2 0.420 35 0

37 9 102 76 37 0 32.9 0.665 46 1

38 2 90 68 42 0 38.2 0.503 27 1

39 4 111 72 47 207 37.1 1.390 56 1

40 3 180 64 25 70 34.0 0.271 26 0

41 7 133 84 0 0 40.2 0.696 37 0

42 7 106 92 18 0 22.7 0.235 48 0

43 9 171 110 24 240 45.4 0.721 54 1

44 7 159 64 0 0 27.4 0.294 40 0

45 0 180 66 39 0 42.0 1.893 25 1

46 1 146 56 0 0 29.7 0.564 29 0

47 2 71 70 27 0 28.0 0.586 22 0

48 7 103 66 32 0 39.1 0.344 31 1

49 7 105 0 0 0 0.0 0.305 24 0Wir können anhand der obigen Ausgabe beobachten, dass die erste Spalte die Zeilennummer angibt, die für die Referenzierung einer bestimmten Beobachtung sehr nützlich sein kann.

Überprüfen der Datenabmessungen

Es ist immer eine gute Praxis zu wissen, wie viele Daten in Bezug auf Zeilen und Spalten wir für unser ML-Projekt haben. Die Gründe dafür sind -

Angenommen, wenn wir zu viele Zeilen und Spalten haben, würde es lange dauern, den Algorithmus auszuführen und das Modell zu trainieren.

Angenommen, wir haben zu wenig Zeilen und Spalten, dann hätten wir nicht genügend Daten, um das Modell gut zu trainieren.

Im Folgenden finden Sie ein Python-Skript, das durch Drucken der Shape-Eigenschaft in Pandas Data Frame implementiert wird. Wir werden es in einem Iris-Datensatz implementieren, um die Gesamtzahl der darin enthaltenen Zeilen und Spalten zu erhalten.

Beispiel

from pandas import read_csv

path = r"C:\iris.csv"

data = read_csv(path)

print(data.shape)Ausgabe

(150, 4)An der Ausgabe können wir leicht erkennen, dass der Iris-Datensatz, den wir verwenden werden, 150 Zeilen und 4 Spalten enthält.

Abrufen des Datentyps jedes Attributs

Es ist eine weitere gute Praxis, den Datentyp jedes Attributs zu kennen. Der Grund dafür ist, dass wir je nach Anforderung manchmal einen Datentyp in einen anderen konvertieren müssen. Beispielsweise müssen wir möglicherweise Zeichenfolgen in Gleitkomma- oder Int-Werte konvertieren, um kategoriale oder ordinale Werte darzustellen. Wir können uns anhand der Rohdaten eine Vorstellung vom Datentyp des Attributs machen. Eine andere Möglichkeit besteht darin, die Eigenschaft dtypes von Pandas DataFrame zu verwenden. Mit Hilfe der Eigenschaft dtypes können wir jeden Attributdatentyp kategorisieren. Es kann mit Hilfe des folgenden Python-Skripts verstanden werden -

Beispiel

from pandas import read_csv

path = r"C:\iris.csv"

data = read_csv(path)

print(data.dtypes)Ausgabe

sepal_length float64

sepal_width float64

petal_length float64

petal_width float64

dtype: objectAus der obigen Ausgabe können wir leicht die Datentypen jedes Attributs erhalten.

Statistische Zusammenfassung der Daten

Wir haben das Python-Rezept besprochen, um die Form, dh die Anzahl der Zeilen und Spalten, der Daten zu erhalten, aber oft müssen wir die Zusammenfassungen dieser Datenform überprüfen. Dies kann mit Hilfe der Funktion description () von Pandas DataFrame erfolgen, die außerdem die folgenden 8 statistischen Eigenschaften jedes Datenattributs bereitstellt:

Count

Mean

Standardabweichung

Mindestwert

Höchster Wert

25%

Median dh 50%

75%

Beispiel

from pandas import read_csv

from pandas import set_option

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

set_option('display.width', 100)

set_option('precision', 2)

print(data.shape)

print(data.describe())Ausgabe

(768, 9)

preg plas pres skin test mass pedi age class

count 768.00 768.00 768.00 768.00 768.00 768.00 768.00 768.00 768.00

mean 3.85 120.89 69.11 20.54 79.80 31.99 0.47 33.24 0.35

std 3.37 31.97 19.36 15.95 115.24 7.88 0.33 11.76 0.48

min 0.00 0.00 0.00 0.00 0.00 0.00 0.08 21.00 0.00

25% 1.00 99.00 62.00 0.00 0.00 27.30 0.24 24.00 0.00

50% 3.00 117.00 72.00 23.00 30.50 32.00 0.37 29.00 0.00

75% 6.00 140.25 80.00 32.00 127.25 36.60 0.63 41.00 1.00

max 17.00 199.00 122.00 99.00 846.00 67.10 2.42 81.00 1.00Aus der obigen Ausgabe können wir die statistische Zusammenfassung der Daten des Pima Indian Diabetes-Datensatzes zusammen mit der Form der Daten beobachten.

Überprüfen der Klassenverteilung

Klassenverteilungsstatistiken sind nützlich bei Klassifizierungsproblemen, bei denen wir das Gleichgewicht der Klassenwerte kennen müssen. Es ist wichtig, die Klassenwertverteilung zu kennen, denn wenn wir eine stark unausgewogene Klassenverteilung haben, dh eine Klasse hat viel mehr Beobachtungen als die andere Klasse, muss sie möglicherweise in der Datenaufbereitungsphase unseres ML-Projekts speziell behandelt werden. Mit Hilfe von Pandas DataFrame können wir problemlos eine Klassenverteilung in Python erhalten.

Beispiel

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

count_class = data.groupby('class').size()

print(count_class)Ausgabe

Class

0 500

1 268

dtype: int64Aus der obigen Ausgabe ist klar ersichtlich, dass die Anzahl der Beobachtungen mit Klasse 0 fast doppelt so hoch ist wie die Anzahl der Beobachtungen mit Klasse 1.

Überprüfen der Korrelation zwischen Attributen

Die Beziehung zwischen zwei Variablen wird als Korrelation bezeichnet. In der Statistik ist der Pearson-Korrelationskoeffizient die häufigste Methode zur Berechnung der Korrelation. Es kann drei Werte haben:

Coefficient value = 1 - Es repräsentiert voll positive Korrelation zwischen Variablen.

Coefficient value = -1 - Es repräsentiert voll negative Korrelation zwischen Variablen.

Coefficient value = 0 - Es repräsentiert no Korrelation überhaupt zwischen Variablen.

Es ist immer gut für uns, die paarweisen Korrelationen der Attribute in unserem Datensatz zu überprüfen, bevor wir sie in das ML-Projekt verwenden, da einige Algorithmen für maschinelles Lernen wie lineare Regression und logistische Regression schlecht funktionieren, wenn wir stark korrelierte Attribute haben. In Python können wir mithilfe der Funktion corr () in Pandas DataFrame auf einfache Weise eine Korrelationsmatrix von Datensatzattributen berechnen.

Beispiel

from pandas import read_csv

from pandas import set_option

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

set_option('display.width', 100)

set_option('precision', 2)

correlations = data.corr(method='pearson')

print(correlations)Ausgabe

preg plas pres skin test mass pedi age class

preg 1.00 0.13 0.14 -0.08 -0.07 0.02 -0.03 0.54 0.22

plas 0.13 1.00 0.15 0.06 0.33 0.22 0.14 0.26 0.47

pres 0.14 0.15 1.00 0.21 0.09 0.28 0.04 0.24 0.07

skin -0.08 0.06 0.21 1.00 0.44 0.39 0.18 -0.11 0.07

test -0.07 0.33 0.09 0.44 1.00 0.20 0.19 -0.04 0.13

mass 0.02 0.22 0.28 0.39 0.20 1.00 0.14 0.04 0.29

pedi -0.03 0.14 0.04 0.18 0.19 0.14 1.00 0.03 0.17

age 0.54 0.26 0.24 -0.11 -0.04 0.04 0.03 1.00 0.24

class 0.22 0.47 0.07 0.07 0.13 0.29 0.17 0.24 1.00Die Matrix in der obigen Ausgabe gibt die Korrelation zwischen allen Paaren des Attributs im Datensatz an.

Überprüfen des Versatzes der Attributverteilung

Die Schiefe kann als die Verteilung definiert werden, von der angenommen wird, dass sie Gaußsch ist, die jedoch verzerrt oder in die eine oder andere Richtung oder entweder nach links oder rechts verschoben erscheint. Das Überprüfen der Schiefe von Attributen ist aus folgenden Gründen eine der wichtigsten Aufgaben:

Das Vorhandensein von Schiefe in Daten erfordert die Korrektur in der Datenaufbereitungsphase, damit wir mehr Genauigkeit aus unserem Modell ziehen können.

Die meisten ML-Algorithmen gehen davon aus, dass Daten eine Gaußsche Verteilung haben, dh entweder eine Normalen der Glockenkurvendaten.

In Python können wir den Versatz jedes Attributs mithilfe der Funktion skew () in Pandas DataFrame einfach berechnen.

Beispiel

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

print(data.skew())Ausgabe

preg 0.90

plas 0.17

pres -1.84

skin 0.11

test 2.27

mass -0.43

pedi 1.92

age 1.13

class 0.64

dtype: float64Aus der obigen Ausgabe kann ein positiver oder negativer Versatz beobachtet werden. Wenn der Wert näher an Null liegt, zeigt er weniger Versatz.

Einführung

Im vorherigen Kapitel haben wir die Bedeutung von Daten für Algorithmen des maschinellen Lernens zusammen mit einigen Python-Rezepten erörtert, um die Daten mit Statistiken zu verstehen. Es gibt eine andere Möglichkeit namens Visualisierung, um die Daten zu verstehen.

Mithilfe der Datenvisualisierung können wir sehen, wie die Daten aussehen und welche Art von Korrelation die Datenattribute aufweisen. Dies ist der schnellste Weg, um festzustellen, ob die Funktionen der Ausgabe entsprechen. Mithilfe der folgenden Python-Rezepte können wir ML-Daten mit Statistiken verstehen.

Univariate Diagramme: Attribute unabhängig verstehen

Die einfachste Art der Visualisierung ist die Einzelvariablen- oder „univariate“ Visualisierung. Mithilfe der univariaten Visualisierung können wir jedes Attribut unseres Datensatzes unabhängig verstehen. Im Folgenden sind einige Techniken in Python aufgeführt, um eine univariate Visualisierung zu implementieren:

Histogramme

Histogramme gruppieren die Daten in Bins und sind der schnellste Weg, um sich ein Bild über die Verteilung der einzelnen Attribute im Datensatz zu machen. Im Folgenden sind einige der Merkmale von Histogrammen aufgeführt:

Es gibt uns eine Zählung der Anzahl von Beobachtungen in jedem zur Visualisierung erstellten Bin.

Anhand der Form des Behälters können wir leicht die Verteilung beobachten, dh das Wetter ist Gauß, schief oder exponentiell.

Histogramme helfen uns auch, mögliche Ausreißer zu erkennen.

Beispiel

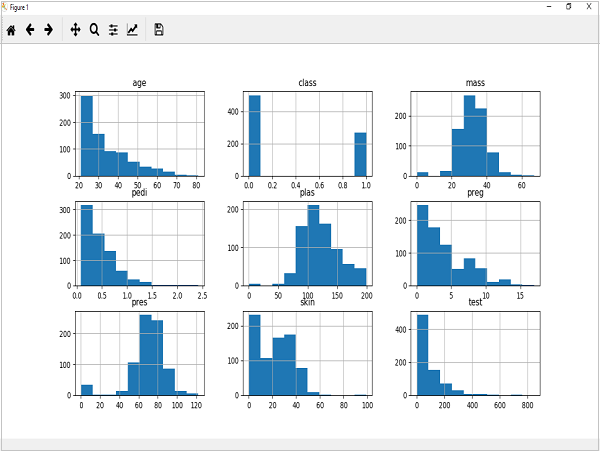

Der unten gezeigte Code ist ein Beispiel für ein Python-Skript, das das Histogramm der Attribute des Pima Indian Diabetes-Datensatzes erstellt. Hier verwenden wir die Funktion hist () für Pandas DataFrame, um Histogramme und zu generierenmatplotlib für sie zu plotten.

from matplotlib import pyplot

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

data.hist()

pyplot.show()Ausgabe

Die obige Ausgabe zeigt, dass das Histogramm für jedes Attribut im Dataset erstellt wurde. Daraus können wir beobachten, dass Alter, Pedi und Testattribut möglicherweise eine exponentielle Verteilung haben, während Masse und Plas eine Gaußsche Verteilung haben.

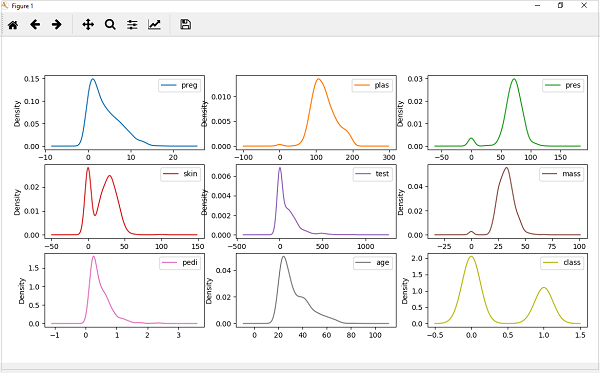

Dichtediagramme

Eine weitere schnelle und einfache Methode zum Abrufen der Verteilung der einzelnen Attribute sind Dichtediagramme. Es ist auch wie ein Histogramm, hat jedoch eine glatte Kurve, die durch die Oberseite jedes Fachs gezogen wird. Wir können sie als abstrahierte Histogramme bezeichnen.

Beispiel

Im folgenden Beispiel generiert das Python-Skript Dichtediagramme für die Verteilung der Attribute des Pima Indian Diabetes-Datensatzes.

from matplotlib import pyplot

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

data.plot(kind='density', subplots=True, layout=(3,3), sharex=False)

pyplot.show()Ausgabe

Aus der obigen Ausgabe kann der Unterschied zwischen Dichtediagrammen und Histogrammen leicht verstanden werden.

Box- und Whisker-Plots

Box- und Whisker-Diagramme, kurz Boxplots genannt, sind eine weitere nützliche Technik, um die Verteilung der Verteilung der einzelnen Attribute zu überprüfen. Das Folgende sind die Eigenschaften dieser Technik -

Es ist univariater Natur und fasst die Verteilung jedes Attributs zusammen.

Es wird eine Linie für den Mittelwert gezogen, dh für den Median.

Es zeichnet eine Box um die 25% und 75%.

Es werden auch Whisker gezeichnet, die uns eine Vorstellung von der Verbreitung der Daten geben.

Die Punkte außerhalb der Whisker kennzeichnen die Ausreißerwerte. Ausreißerwerte wären 1,5-mal größer als die Größe der Streuung der mittleren Daten.

Beispiel

Im folgenden Beispiel generiert das Python-Skript Dichtediagramme für die Verteilung der Attribute des Pima Indian Diabetes-Datensatzes.

from matplotlib import pyplot

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

data.plot(kind='box', subplots=True, layout=(3,3), sharex=False,sharey=False)

pyplot.show()Ausgabe

Aus dem obigen Diagramm der Attributverteilung ist ersichtlich, dass Alter, Test und Haut in Richtung kleinerer Werte verzerrt erscheinen.

Multivariate Diagramme: Interaktion zwischen mehreren Variablen

Eine andere Art der Visualisierung ist die multivariable oder „multivariate“ Visualisierung. Mithilfe der multivariaten Visualisierung können wir die Interaktion zwischen mehreren Attributen unseres Datensatzes verstehen. Im Folgenden finden Sie einige Techniken in Python zur Implementierung einer multivariaten Visualisierung:

Korrelationsmatrix-Diagramm

Die Korrelation ist ein Hinweis auf die Änderungen zwischen zwei Variablen. In unseren vorherigen Kapiteln haben wir die Pearson-Korrelationskoeffizienten und die Bedeutung der Korrelation ebenfalls erörtert. Wir können eine Korrelationsmatrix zeichnen, um zu zeigen, welche Variable eine hohe oder niedrige Korrelation in Bezug auf eine andere Variable aufweist.

Beispiel

Im folgenden Beispiel generiert und zeichnet das Python-Skript eine Korrelationsmatrix für den Pima Indian Diabetes-Datensatz. Es kann mit Hilfe der Funktion corr () in Pandas DataFrame generiert und mit Hilfe von pyplot geplottet werden.

from matplotlib import pyplot

from pandas import read_csv

import numpy

Path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(Path, names=names)

correlations = data.corr()

fig = pyplot.figure()

ax = fig.add_subplot(111)

cax = ax.matshow(correlations, vmin=-1, vmax=1)

fig.colorbar(cax)

ticks = numpy.arange(0,9,1)

ax.set_xticks(ticks)

ax.set_yticks(ticks)

ax.set_xticklabels(names)

ax.set_yticklabels(names)

pyplot.show()Ausgabe

Aus der obigen Ausgabe der Korrelationsmatrix können wir erkennen, dass sie symmetrisch ist, dh, dass unten links die gleiche wie oben rechts ist. Es wird auch beobachtet, dass jede Variable positiv miteinander korreliert ist.

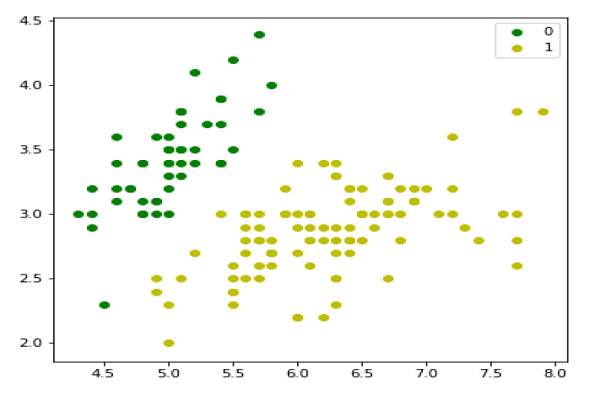

Streumatrix-Diagramm

Streudiagramme zeigen mit Hilfe von Punkten in zwei Dimensionen, wie stark eine Variable von einer anderen beeinflusst wird oder welche Beziehung zwischen ihnen besteht. Streudiagramme ähneln Liniendiagrammen in dem Konzept, dass sie horizontale und vertikale Achsen zum Zeichnen von Datenpunkten verwenden.

Beispiel

Im folgenden Beispiel generiert und zeichnet das Python-Skript eine Streumatrix für den Pima Indian Diabetes-Datensatz. Es kann mit Hilfe der Funktion dispers_matrix () in Pandas DataFrame generiert und mit Hilfe von pyplot geplottet werden.

from matplotlib import pyplot

from pandas import read_csv

from pandas.tools.plotting import scatter_matrix

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

scatter_matrix(data)

pyplot.show()Ausgabe

Einführung

Algorithmen für maschinelles Lernen sind vollständig von Daten abhängig, da dies der wichtigste Aspekt ist, der das Modelltraining ermöglicht. Auf der anderen Seite ist eine Maschine unbrauchbar, wenn wir aus diesen Daten keinen Sinn machen können, bevor wir sie ML-Algorithmen zuführen. Mit einfachen Worten, wir müssen immer die richtigen Daten eingeben, dh die Daten in der richtigen Größe, im richtigen Format und mit aussagekräftigen Merkmalen für das Problem, das die Maschine lösen soll.

Dies macht die Datenaufbereitung zum wichtigsten Schritt im ML-Prozess. Die Datenaufbereitung kann als das Verfahren definiert werden, mit dem unser Datensatz für den ML-Prozess besser geeignet ist.

Warum Datenvorverarbeitung?

Nach Auswahl der Rohdaten für das ML-Training ist die Datenvorverarbeitung die wichtigste Aufgabe. Im weitesten Sinne konvertiert die Datenvorverarbeitung die ausgewählten Daten in eine Form, mit der wir arbeiten oder die wir ML-Algorithmen zuführen können. Wir müssen unsere Daten immer vorverarbeiten, damit sie den Erwartungen des Algorithmus für maschinelles Lernen entsprechen.

Datenvorverarbeitungstechniken

Wir haben die folgenden Datenvorverarbeitungstechniken, die auf einen Datensatz angewendet werden können, um Daten für ML-Algorithmen zu erzeugen:

Skalierung

Höchstwahrscheinlich besteht unser Datensatz aus Attributen mit unterschiedlichem Maßstab, aber wir können solche Daten nicht für den ML-Algorithmus bereitstellen, daher ist eine Neuskalierung erforderlich. Durch die Neuskalierung von Daten wird sichergestellt, dass die Attribute dieselbe Skalierung aufweisen. Im Allgemeinen werden Attribute in den Bereich von 0 bis 1 neu skaliert. ML-Algorithmen wie Gradientenabstieg und k-Nearest Neighbors erfordern skalierte Daten. Wir können die Daten mit Hilfe der MinMaxScaler-Klasse der Scikit-Learn-Python-Bibliothek neu skalieren.

Beispiel

In diesem Beispiel werden die Daten des Pima Indians Diabetes-Datensatzes, den wir zuvor verwendet haben, neu skaliert. Zuerst werden die CSV-Daten geladen (wie in den vorherigen Kapiteln beschrieben) und dann mit Hilfe der MinMaxScaler-Klasse im Bereich von 0 bis 1 neu skaliert.

Die ersten Zeilen des folgenden Skripts sind dieselben wie in den vorherigen Kapiteln beim Laden von CSV-Daten.

from pandas import read_csv

from numpy import set_printoptions

from sklearn import preprocessing

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesJetzt können wir die MinMaxScaler-Klasse verwenden, um die Daten im Bereich von 0 bis 1 neu zu skalieren.

data_scaler = preprocessing.MinMaxScaler(feature_range=(0,1))

data_rescaled = data_scaler.fit_transform(array)Wir können auch die Daten für die Ausgabe nach unserer Wahl zusammenfassen. Hier setzen wir die Genauigkeit auf 1 und zeigen die ersten 10 Zeilen in der Ausgabe an.

set_printoptions(precision=1)

print ("\nScaled data:\n", data_rescaled[0:10])Ausgabe

Scaled data:

[[0.4 0.7 0.6 0.4 0. 0.5 0.2 0.5 1. ]

[0.1 0.4 0.5 0.3 0. 0.4 0.1 0.2 0. ]

[0.5 0.9 0.5 0. 0. 0.3 0.3 0.2 1. ]

[0.1 0.4 0.5 0.2 0.1 0.4 0. 0. 0. ]

[0. 0.7 0.3 0.4 0.2 0.6 0.9 0.2 1. ]

[0.3 0.6 0.6 0. 0. 0.4 0.1 0.2 0. ]

[0.2 0.4 0.4 0.3 0.1 0.5 0.1 0.1 1. ]

[0.6 0.6 0. 0. 0. 0.5 0. 0.1 0. ]

[0.1 1. 0.6 0.5 0.6 0.5 0. 0.5 1. ]

[0.5 0.6 0.8 0. 0. 0. 0.1 0.6 1. ]]Aus der obigen Ausgabe wurden alle Daten in den Bereich von 0 und 1 neu skaliert.

Normalisierung

Eine weitere nützliche Datenvorverarbeitungstechnik ist die Normalisierung. Dies wird verwendet, um jede Datenzeile auf eine Länge von 1 neu zu skalieren. Dies ist hauptsächlich in Sparse-Datensätzen nützlich, in denen viele Nullen vorhanden sind. Wir können die Daten mit Hilfe der Normalizer-Klasse der Scikit-Learn-Python-Bibliothek neu skalieren.

Arten der Normalisierung

Beim maschinellen Lernen gibt es zwei Arten von Normalisierungsvorverarbeitungstechniken:

L1 Normalisierung

Es kann als Normalisierungstechnik definiert werden, die die Datensatzwerte so ändert, dass in jeder Zeile die Summe der absoluten Werte immer bis zu 1 beträgt. Sie wird auch als kleinste absolute Abweichungen bezeichnet.

Example

In diesem Beispiel verwenden wir die L1-Normalisierungstechnik, um die Daten des zuvor verwendeten Pima-Indianer-Diabetes-Datensatzes zu normalisieren. Zuerst werden die CSV-Daten geladen und dann mit Hilfe der Normalizer-Klasse normalisiert.

Die ersten Zeilen des folgenden Skripts sind dieselben wie in den vorherigen Kapiteln beim Laden von CSV-Daten.

from pandas import read_csv

from numpy import set_printoptions

from sklearn.preprocessing import Normalizer

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv (path, names=names)

array = dataframe.valuesJetzt können wir die Normalizer-Klasse mit L1 verwenden, um die Daten zu normalisieren.

Data_normalizer = Normalizer(norm='l1').fit(array)

Data_normalized = Data_normalizer.transform(array)Wir können auch die Daten für die Ausgabe nach unserer Wahl zusammenfassen. Hier setzen wir die Genauigkeit auf 2 und zeigen die ersten 3 Zeilen in der Ausgabe an.

set_printoptions(precision=2)

print ("\nNormalized data:\n", Data_normalized [0:3])Output

Normalized data:

[[0.02 0.43 0.21 0.1 0. 0.1 0. 0.14 0. ]

[0. 0.36 0.28 0.12 0. 0.11 0. 0.13 0. ]

[0.03 0.59 0.21 0. 0. 0.07 0. 0.1 0. ]]L2 Normalisierung

Es kann als Normalisierungstechnik definiert werden, die die Datensatzwerte so ändert, dass in jeder Zeile die Summe der Quadrate immer bis zu 1 beträgt. Sie wird auch als kleinste Quadrate bezeichnet.

Example

In diesem Beispiel verwenden wir die L2-Normalisierungstechnik, um die Daten des zuvor verwendeten Pima-Indianer-Diabetes-Datensatzes zu normalisieren. Zuerst werden die CSV-Daten geladen (wie in den vorherigen Kapiteln beschrieben) und dann mit Hilfe der Normalizer-Klasse normalisiert.

Die ersten Zeilen des folgenden Skripts sind dieselben wie in den vorherigen Kapiteln beim Laden von CSV-Daten.

from pandas import read_csv

from numpy import set_printoptions

from sklearn.preprocessing import Normalizer

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv (path, names=names)

array = dataframe.valuesJetzt können wir die Normalizer-Klasse mit L1 verwenden, um die Daten zu normalisieren.

Data_normalizer = Normalizer(norm='l2').fit(array)

Data_normalized = Data_normalizer.transform(array)Wir können auch die Daten für die Ausgabe nach unserer Wahl zusammenfassen. Hier setzen wir die Genauigkeit auf 2 und zeigen die ersten 3 Zeilen in der Ausgabe an.

set_printoptions(precision=2)

print ("\nNormalized data:\n", Data_normalized [0:3])Output

Normalized data:

[[0.03 0.83 0.4 0.2 0. 0.19 0. 0.28 0.01]

[0.01 0.72 0.56 0.24 0. 0.22 0. 0.26 0. ]

[0.04 0.92 0.32 0. 0. 0.12 0. 0.16 0.01]]Binarisierung

Wie der Name schon sagt, ist dies die Technik, mit deren Hilfe wir unsere Daten binär machen können. Wir können einen binären Schwellenwert verwenden, um unsere Daten binär zu machen. Die Werte über diesem Schwellenwert werden in 1 und unter diesem Schwellenwert in 0 konvertiert. Wenn wir beispielsweise den Schwellenwert = 0,5 wählen, wird der darüber liegende Datensatzwert zu 1 und darunter zu 0. Das heißt warum wir es nennen könnenbinarizing die Daten oder thresholdingdie Daten. Diese Technik ist nützlich, wenn wir Wahrscheinlichkeiten in unserem Datensatz haben und diese in scharfe Werte konvertieren möchten.

Wir können die Daten mit Hilfe der Binarizer-Klasse der Scikit-Learn-Python-Bibliothek binarisieren.

Beispiel

In diesem Beispiel werden die Daten des Pima Indians Diabetes-Datensatzes, den wir zuvor verwendet haben, neu skaliert. Zuerst werden die CSV-Daten geladen und dann mit Hilfe der Binarizer-Klasse in Binärwerte umgewandelt, dh 0 und 1, abhängig vom Schwellenwert. Wir nehmen 0,5 als Schwellenwert.

Die ersten Zeilen des folgenden Skripts sind dieselben wie in den vorherigen Kapiteln beim Laden von CSV-Daten.

from pandas import read_csv

from sklearn.preprocessing import Binarizer

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesJetzt können wir die Binarize-Klasse verwenden, um die Daten in Binärwerte umzuwandeln.

binarizer = Binarizer(threshold=0.5).fit(array)

Data_binarized = binarizer.transform(array)Hier zeigen wir die ersten 5 Zeilen in der Ausgabe.

print ("\nBinary data:\n", Data_binarized [0:5])Ausgabe

Binary data:

[[1. 1. 1. 1. 0. 1. 1. 1. 1.]

[1. 1. 1. 1. 0. 1. 0. 1. 0.]

[1. 1. 1. 0. 0. 1. 1. 1. 1.]

[1. 1. 1. 1. 1. 1. 0. 1. 0.]

[0. 1. 1. 1. 1. 1. 1. 1. 1.]]Standardisierung

Eine weitere nützliche Datenvorverarbeitungstechnik, die im Wesentlichen verwendet wird, um die Datenattribute mit einer Gaußschen Verteilung zu transformieren. Es unterscheidet den Mittelwert und die SD (Standardabweichung) von einer Standard-Gauß-Verteilung mit einem Mittelwert von 0 und einer SD von 1. Diese Technik ist nützlich bei ML-Algorithmen wie linearer Regression, logistischer Regression, die eine Gauß-Verteilung im Eingabedatensatz voraussetzt und besser produziert Ergebnisse mit neu skalierten Daten. Wir können die Daten (Mittelwert = 0 und SD = 1) mit Hilfe der StandardScaler-Klasse der Scikit-Learn-Python-Bibliothek standardisieren.

Beispiel

In diesem Beispiel werden die Daten des Pima Indians Diabetes-Datensatzes, den wir zuvor verwendet haben, neu skaliert. Zuerst werden die CSV-Daten geladen und dann mit Hilfe der StandardScaler-Klasse in die Gaußsche Verteilung mit Mittelwert = 0 und SD = 1 konvertiert.

Die ersten Zeilen des folgenden Skripts sind dieselben wie in den vorherigen Kapiteln beim Laden von CSV-Daten.

from sklearn.preprocessing import StandardScaler

from pandas import read_csv

from numpy import set_printoptions

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesJetzt können wir die StandardScaler-Klasse verwenden, um die Daten neu zu skalieren.

data_scaler = StandardScaler().fit(array)

data_rescaled = data_scaler.transform(array)Wir können auch die Daten für die Ausgabe nach unserer Wahl zusammenfassen. Hier setzen wir die Genauigkeit auf 2 und zeigen die ersten 5 Zeilen in der Ausgabe an.

set_printoptions(precision=2)

print ("\nRescaled data:\n", data_rescaled [0:5])Ausgabe

Rescaled data:

[[ 0.64 0.85 0.15 0.91 -0.69 0.2 0.47 1.43 1.37]

[-0.84 -1.12 -0.16 0.53 -0.69 -0.68 -0.37 -0.19 -0.73]

[ 1.23 1.94 -0.26 -1.29 -0.69 -1.1 0.6 -0.11 1.37]

[-0.84 -1. -0.16 0.15 0.12 -0.49 -0.92 -1.04 -0.73]

[-1.14 0.5 -1.5 0.91 0.77 1.41 5.48 -0.02 1.37]]Datenbeschriftung

Wir haben die Bedeutung guter Fata für ML-Algorithmen sowie einige Techniken zur Vorverarbeitung der Daten vor dem Senden an ML-Algorithmen erörtert. Ein weiterer Aspekt in dieser Hinsicht ist die Datenkennzeichnung. Es ist auch sehr wichtig, die Daten an ML-Algorithmen mit korrekter Kennzeichnung zu senden. Beispielsweise sind bei Klassifizierungsproblemen viele Beschriftungen in Form von Wörtern, Zahlen usw. auf den Daten vorhanden.

Was ist Etikettencodierung?

Die meisten sklearn-Funktionen erwarten, dass die Daten eher mit Zahlenbezeichnungen als mit Wortbezeichnungen versehen sind. Daher müssen wir solche Bezeichnungen in Zahlenbezeichnungen umwandeln. Dieser Vorgang wird als Etikettencodierung bezeichnet. Wir können die Label-Codierung von Daten mit Hilfe der LabelEncoder () -Funktion der scikit-learn Python-Bibliothek durchführen.

Beispiel

Im folgenden Beispiel führt das Python-Skript die Etikettencodierung durch.

Importieren Sie zunächst die erforderlichen Python-Bibliotheken wie folgt:

import numpy as np

from sklearn import preprocessingJetzt müssen wir die Eingabebeschriftungen wie folgt bereitstellen:

input_labels = ['red','black','red','green','black','yellow','white']In der nächsten Codezeile wird der Beschriftungscodierer erstellt und trainiert.

encoder = preprocessing.LabelEncoder()

encoder.fit(input_labels)In den nächsten Skriptzeilen wird die Leistung überprüft, indem die zufällig geordnete Liste codiert wird.

test_labels = ['green','red','black']

encoded_values = encoder.transform(test_labels)

print("\nLabels =", test_labels)

print("Encoded values =", list(encoded_values))

encoded_values = [3,0,4,1]

decoded_list = encoder.inverse_transform(encoded_values)Wir können die Liste der codierten Werte mit Hilfe des folgenden Python-Skripts erhalten -