Scikit Learn - Kurzanleitung

In diesem Kapitel werden wir verstehen, was Scikit-Learn oder Sklearn ist, woher Scikit-Learn stammt und einige andere verwandte Themen wie Communitys und Mitwirkende, die für die Entwicklung und Wartung von Scikit-Learn verantwortlich sind, seine Voraussetzungen, Installation und seine Funktionen.

Was ist Scikit-Learn (Sklearn)

Scikit-learn (Sklearn) ist die nützlichste und robusteste Bibliothek für maschinelles Lernen in Python. Es bietet eine Auswahl effizienter Tools für maschinelles Lernen und statistische Modellierung, einschließlich Klassifizierung, Regression, Clustering und Dimensionsreduktion über eine Konsistenzschnittstelle in Python. Diese Bibliothek, die größtenteils in Python geschrieben ist, baut darauf aufNumPy, SciPy und Matplotlib.

Ursprung von Scikit-Learn

Es wurde ursprünglich genannt scikits.learn und wurde ursprünglich von David Cournapeau als Google Summer of Code-Projekt im Jahr 2007 entwickelt. Später, im Jahr 2010, nahmen Fabian Pedregosa, Gael Varoquaux, Alexandre Gramfort und Vincent Michel vom FIRCA (Französisches Institut für Forschung in Informatik und Automatisierung) teil Dieses Projekt wurde auf einer anderen Ebene veröffentlicht und am 1. Februar 2010 erstmals veröffentlicht (v0.1 Beta).

Werfen wir einen Blick auf die Versionsgeschichte -

Mai 2019: scikit-learn 0.21.0

März 2019: scikit-learn 0.20.3

Dezember 2018: scikit-learn 0.20.2

November 2018: scikit-learn 0.20.1

September 2018: scikit-learn 0.20.0

Juli 2018: scikit-learn 0.19.2

Juli 2017: scikit-learn 0.19.0

September 2016. scikit-learn 0.18.0

November 2015. scikit-learn 0.17.0

März 2015. scikit-learn 0.16.0

Juli 2014. scikit-learn 0.15.0

August 2013. scikit-learn 0.14

Community & Mitwirkende

Scikit-Learn ist eine Gemeinschaftsanstrengung und jeder kann dazu beitragen. Dieses Projekt wird am gehostethttps://github.com/scikit-learn/scikit-learn. Die folgenden Personen sind derzeit die Hauptverantwortlichen für die Entwicklung und Wartung von Sklearn -

Joris Van den Bossche (Datenwissenschaftler)

Thomas J Fan (Softwareentwickler)

Alexandre Gramfort (Forscher für maschinelles Lernen)

Olivier Grisel (Experte für maschinelles Lernen)

Nicolas Hug (Associate Research Scientist)

Andreas Mueller (Wissenschaftler für maschinelles Lernen)

Hanmin Qin (Software-Ingenieur)

Adrin Jalali (Open Source Entwickler)

Nelle Varoquaux (Data Science Researcher)

Roman Yurchak (Datenwissenschaftler)

Verschiedene Organisationen wie Booking.com, JP Morgan, Evernote, Inria, AWeber, Spotify und viele mehr verwenden Sklearn.

Voraussetzungen

Bevor wir die neueste Version von scikit-learn verwenden, benötigen wir Folgendes:

Python (> = 3,5)

NumPy (> = 1.11.0)

Scipy (> = 0,17,0) li

Joblib (> = 0,11)

Matplotlib (> = 1.5.1) ist für Sklearn-Plotfunktionen erforderlich.

Pandas (> = 0.18.0) wird für einige der Scikit-Lernbeispiele mit Datenstruktur und Analyse benötigt.

Installation

Wenn Sie NumPy und Scipy bereits installiert haben, sind die beiden einfachsten Möglichkeiten, scikit-learn zu installieren:

Mit pip

Der folgende Befehl kann verwendet werden, um scikit-learn über pip zu installieren -

pip install -U scikit-learnMit conda

Der folgende Befehl kann verwendet werden, um scikit-learn über conda zu installieren -

conda install scikit-learnWenn NumPy und Scipy jedoch noch nicht auf Ihrer Python-Workstation installiert sind, können Sie sie mit beiden installieren pip oder conda.

Eine andere Möglichkeit, scikit-learn zu verwenden, ist die Verwendung von Python-Distributionen wie Canopy und Anaconda weil beide die neueste Version von scikit-learn ausliefern.

Eigenschaften

Anstatt sich auf das Laden, Bearbeiten und Zusammenfassen von Daten zu konzentrieren, konzentriert sich die Scikit-learn-Bibliothek auf das Modellieren der Daten. Einige der beliebtesten Modellgruppen von Sklearn sind:

Supervised Learning algorithms - Fast alle gängigen überwachten Lernalgorithmen wie lineare Regression, Support Vector Machine (SVM), Entscheidungsbaum usw. sind Teil des Scikit-Lernens.

Unsupervised Learning algorithms - Andererseits verfügt es auch über alle gängigen unbeaufsichtigten Lernalgorithmen, von Clustering, Faktoranalyse, PCA (Principal Component Analysis) bis hin zu unbeaufsichtigten neuronalen Netzen.

Clustering - Dieses Modell wird zum Gruppieren unbeschrifteter Daten verwendet.

Cross Validation - Es wird verwendet, um die Genauigkeit von überwachten Modellen auf unsichtbare Daten zu überprüfen.

Dimensionality Reduction - Es wird verwendet, um die Anzahl der Attribute in Daten zu reduzieren, die für die Zusammenfassung, Visualisierung und Funktionsauswahl weiter verwendet werden können.

Ensemble methods - Wie der Name schon sagt, wird es zum Kombinieren der Vorhersagen mehrerer überwachter Modelle verwendet.

Feature extraction - Es wird verwendet, um die Features aus Daten zu extrahieren, um die Attribute in Bild- und Textdaten zu definieren.

Feature selection - Es wird verwendet, um nützliche Attribute zum Erstellen von überwachten Modellen zu identifizieren.

Open Source - Es ist eine Open-Source-Bibliothek und kann auch unter BSD-Lizenz kommerziell verwendet werden.

Dieses Kapitel befasst sich mit dem Modellierungsprozess von Sklearn. Lassen Sie uns dies im Detail verstehen und mit dem Laden des Datensatzes beginnen.

Laden des Datensatzes

Eine Datensammlung wird als Datensatz bezeichnet. Es hat die folgenden zwei Komponenten -

Features- Die Variablen der Daten werden als ihre Merkmale bezeichnet. Sie werden auch als Prädiktoren, Eingaben oder Attribute bezeichnet.

Feature matrix - Es ist die Sammlung von Funktionen, falls es mehr als eine gibt.

Feature Names - Es ist die Liste aller Namen der Funktionen.

Response- Es ist die Ausgabevariable, die im Wesentlichen von den Feature-Variablen abhängt. Sie werden auch als Ziel, Label oder Ausgabe bezeichnet.

Response Vector- Es wird verwendet, um die Antwortspalte darzustellen. Im Allgemeinen haben wir nur eine Antwortspalte.

Target Names - Es stellt die möglichen Werte dar, die von einem Antwortvektor angenommen werden.

Scikit-learn hat nur wenige Beispieldatensätze wie iris und digits für die Klassifizierung und die Boston house prices für die Regression.

Beispiel

Es folgt ein Beispiel zum Laden iris Datensatz -

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

feature_names = iris.feature_names

target_names = iris.target_names

print("Feature names:", feature_names)

print("Target names:", target_names)

print("\nFirst 10 rows of X:\n", X[:10])Ausgabe

Feature names: ['sepal length (cm)', 'sepal width (cm)', 'petal length (cm)', 'petal width (cm)']

Target names: ['setosa' 'versicolor' 'virginica']

First 10 rows of X:

[

[5.1 3.5 1.4 0.2]

[4.9 3. 1.4 0.2]

[4.7 3.2 1.3 0.2]

[4.6 3.1 1.5 0.2]

[5. 3.6 1.4 0.2]

[5.4 3.9 1.7 0.4]

[4.6 3.4 1.4 0.3]

[5. 3.4 1.5 0.2]

[4.4 2.9 1.4 0.2]

[4.9 3.1 1.5 0.1]

]Datensatz aufteilen

Um die Genauigkeit unseres Modells zu überprüfen, können wir den Datensatz in zwei Teile aufteilen.a training set und a testing set. Verwenden Sie das Trainingsset, um das Modell zu trainieren, und das Testset, um das Modell zu testen. Danach können wir bewerten, wie gut unser Modell war.

Beispiel

Im folgenden Beispiel werden die Daten in ein Verhältnis von 70:30 aufgeteilt, dh 70% werden als Trainingsdaten und 30% als Testdaten verwendet. Der Datensatz ist ein Iris-Datensatz wie im obigen Beispiel.

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size = 0.3, random_state = 1

)

print(X_train.shape)

print(X_test.shape)

print(y_train.shape)

print(y_test.shape)Ausgabe

(105, 4)

(45, 4)

(105,)

(45,)Wie im obigen Beispiel zu sehen, wird es verwendet train_test_split()Funktion von scikit-learn, um den Datensatz zu teilen. Diese Funktion hat die folgenden Argumente:

X, y - Hier, X ist der feature matrix und y ist das response vector, die aufgeteilt werden müssen.

test_size- Dies ist das Verhältnis der Testdaten zu den insgesamt angegebenen Daten. Wie im obigen Beispiel stellen wir eintest_data = 0.3 für 150 Zeilen X. Es werden Testdaten von 150 * 0,3 = 45 Zeilen erzeugt.

random_size- Es wird verwendet, um sicherzustellen, dass die Aufteilung immer gleich ist. Dies ist in Situationen nützlich, in denen Sie reproduzierbare Ergebnisse erzielen möchten.

Trainiere das Modell

Als nächstes können wir unseren Datensatz verwenden, um ein Vorhersagemodell zu trainieren. Wie bereits erwähnt, hat Scikit-Learn eine breite Palette vonMachine Learning (ML) algorithms die eine konsistente Schnittstelle zum Anpassen, Vorhersagen der Genauigkeit, Abrufen usw. haben.

Beispiel

Im folgenden Beispiel verwenden wir den Klassifikator KNN (K nächste Nachbarn). Gehen Sie nicht auf die Details der KNN-Algorithmen ein, da es dafür ein separates Kapitel geben wird. Dieses Beispiel dient nur dazu, den Implementierungsteil zu verstehen.

from sklearn.datasets import load_iris

iris = load_iris()

X = iris.data

y = iris.target

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size = 0.4, random_state=1

)

from sklearn.neighbors import KNeighborsClassifier

from sklearn import metrics

classifier_knn = KNeighborsClassifier(n_neighbors = 3)

classifier_knn.fit(X_train, y_train)

y_pred = classifier_knn.predict(X_test)

# Finding accuracy by comparing actual response values(y_test)with predicted response value(y_pred)

print("Accuracy:", metrics.accuracy_score(y_test, y_pred))

# Providing sample data and the model will make prediction out of that data

sample = [[5, 5, 3, 2], [2, 4, 3, 5]]

preds = classifier_knn.predict(sample)

pred_species = [iris.target_names[p] for p in preds] print("Predictions:", pred_species)Ausgabe

Accuracy: 0.9833333333333333

Predictions: ['versicolor', 'virginica']Modellpersistenz

Sobald Sie das Modell trainiert haben, ist es wünschenswert, dass das Modell für die zukünftige Verwendung erhalten bleibt, damit wir es nicht immer wieder neu trainieren müssen. Dies kann mit Hilfe von erfolgendump und load Merkmale joblib Paket.

Betrachten Sie das folgende Beispiel, in dem wir das oben trainierte Modell (classifier_knn) für die zukünftige Verwendung speichern werden -

from sklearn.externals import joblib

joblib.dump(classifier_knn, 'iris_classifier_knn.joblib')Der obige Code speichert das Modell in der Datei iris_classifier_knn.joblib. Jetzt kann das Objekt mit Hilfe des folgenden Codes aus der Datei neu geladen werden:

joblib.load('iris_classifier_knn.joblib')Vorverarbeitung der Daten

Da es sich um viele Daten handelt und diese Daten in Rohform vorliegen, müssen wir sie vor der Eingabe in Algorithmen für maschinelles Lernen in aussagekräftige Daten konvertieren. Dieser Vorgang wird als Vorverarbeitung der Daten bezeichnet. Scikit-learn hat das Paket benanntpreprocessingfür diesen Zweck. Daspreprocessing Paket hat die folgenden Techniken -

Binarisierung

Diese Vorverarbeitungstechnik wird verwendet, wenn wir unsere numerischen Werte in Boolesche Werte konvertieren müssen.

Beispiel

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]]

)

data_binarized = preprocessing.Binarizer(threshold=0.5).transform(input_data)

print("\nBinarized data:\n", data_binarized)Im obigen Beispiel haben wir verwendet threshold value = 0,5 und deshalb würden alle Werte über 0,5 in 1 und alle Werte unter 0,5 in 0 umgewandelt.

Ausgabe

Binarized data:

[

[ 1. 0. 1.]

[ 0. 1. 1.]

[ 0. 0. 1.]

[ 1. 1. 0.]

]Mittlere Entfernung

Diese Technik wird verwendet, um den Mittelwert aus dem Merkmalsvektor zu eliminieren, so dass jedes Merkmal auf Null zentriert ist.

Beispiel

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]]

)

#displaying the mean and the standard deviation of the input data

print("Mean =", input_data.mean(axis=0))

print("Stddeviation = ", input_data.std(axis=0))

#Removing the mean and the standard deviation of the input data

data_scaled = preprocessing.scale(input_data)

print("Mean_removed =", data_scaled.mean(axis=0))

print("Stddeviation_removed =", data_scaled.std(axis=0))Ausgabe

Mean = [ 1.75 -1.275 2.2 ]

Stddeviation = [ 2.71431391 4.20022321 4.69414529]

Mean_removed = [ 1.11022302e-16 0.00000000e+00 0.00000000e+00]

Stddeviation_removed = [ 1. 1. 1.]Skalierung

Wir verwenden diese Vorverarbeitungstechnik zum Skalieren der Merkmalsvektoren. Die Skalierung von Merkmalsvektoren ist wichtig, da die Merkmale nicht synthetisch groß oder klein sein sollten.

Beispiel

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_scaler_minmax = preprocessing.MinMaxScaler(feature_range=(0,1))

data_scaled_minmax = data_scaler_minmax.fit_transform(input_data)

print ("\nMin max scaled data:\n", data_scaled_minmax)Ausgabe

Min max scaled data:

[

[ 0.48648649 0.58252427 0.99122807]

[ 0. 1. 0.81578947]

[ 0.27027027 0. 1. ]

[ 1. 0.99029126 0. ]

]Normalisierung

Wir verwenden diese Vorverarbeitungstechnik zum Modifizieren der Merkmalsvektoren. Eine Normalisierung der Merkmalsvektoren ist erforderlich, damit die Merkmalsvektoren im gemeinsamen Maßstab gemessen werden können. Es gibt zwei Arten der Normalisierung:

L1 Normalisierung

Es wird auch als geringste absolute Abweichung bezeichnet. Der Wert wird so geändert, dass die Summe der Absolutwerte in jeder Zeile immer bis zu 1 bleibt. Das folgende Beispiel zeigt die Implementierung der L1-Normalisierung für Eingabedaten.

Beispiel

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_normalized_l1 = preprocessing.normalize(input_data, norm='l1')

print("\nL1 normalized data:\n", data_normalized_l1)Ausgabe

L1 normalized data:

[

[ 0.22105263 -0.2 0.57894737]

[-0.2027027 0.32432432 0.47297297]

[ 0.03571429 -0.56428571 0.4 ]

[ 0.42142857 0.16428571 -0.41428571]

]L2 Normalisierung

Auch als kleinste Quadrate bezeichnet. Der Wert wird so geändert, dass die Summe der Quadrate in jeder Zeile immer bis zu 1 bleibt. Das folgende Beispiel zeigt die Implementierung der L2-Normalisierung für Eingabedaten.

Beispiel

import numpy as np

from sklearn import preprocessing

Input_data = np.array(

[

[2.1, -1.9, 5.5],

[-1.5, 2.4, 3.5],

[0.5, -7.9, 5.6],

[5.9, 2.3, -5.8]

]

)

data_normalized_l2 = preprocessing.normalize(input_data, norm='l2')

print("\nL1 normalized data:\n", data_normalized_l2)Ausgabe

L2 normalized data:

[

[ 0.33946114 -0.30713151 0.88906489]

[-0.33325106 0.53320169 0.7775858 ]

[ 0.05156558 -0.81473612 0.57753446]

[ 0.68706914 0.26784051 -0.6754239 ]

]Wie wir wissen, wird beim maschinellen Lernen ein Modell aus Daten erstellt. Zu diesem Zweck muss der Computer zuerst die Daten verstehen. Als nächstes werden wir verschiedene Möglichkeiten diskutieren, die Daten darzustellen, um vom Computer verstanden zu werden -

Daten als Tabelle

Die beste Möglichkeit, Daten in Scikit-learn darzustellen, sind Tabellen. Eine Tabelle stellt ein 2D-Datenraster dar, wobei Zeilen die einzelnen Elemente des Datensatzes darstellen und die Spalten die Mengen darstellen, die sich auf diese einzelnen Elemente beziehen.

Beispiel

Mit dem folgenden Beispiel können wir herunterladen iris dataset in Form eines Pandas DataFrame mit Hilfe von Python seaborn Bibliothek.

import seaborn as sns

iris = sns.load_dataset('iris')

iris.head()Ausgabe

sepal_length sepal_width petal_length petal_width species

0 5.1 3.5 1.4 0.2 setosa

1 4.9 3.0 1.4 0.2 setosa

2 4.7 3.2 1.3 0.2 setosa

3 4.6 3.1 1.5 0.2 setosa

4 5.0 3.6 1.4 0.2 setosaAus der obigen Ausgabe können wir ersehen, dass jede Zeile der Daten eine einzelne beobachtete Blume darstellt und die Anzahl der Zeilen die Gesamtzahl der Blumen im Datensatz darstellt. Im Allgemeinen bezeichnen wir die Zeilen der Matrix als Beispiele.

Andererseits repräsentiert jede Spalte der Daten eine quantitative Information, die jede Probe beschreibt. Im Allgemeinen bezeichnen wir die Spalten der Matrix als Features.

Daten als Feature-Matrix

Die Merkmalsmatrix kann als Tabellenlayout definiert werden, bei dem Informationen als 2D-Matrix betrachtet werden können. Es wird in einer Variablen namens gespeichertXund als zweidimensional mit Form angenommen [n_samples, n_features]. Meistens ist es in einem NumPy-Array oder einem Pandas DataFrame enthalten. Wie bereits erwähnt, stellen die Stichproben immer die einzelnen vom Datensatz beschriebenen Objekte dar, und die Merkmale stellen die unterschiedlichen Beobachtungen dar, die jede Stichprobe quantitativ beschreiben.

Daten als Zielarray

Zusammen mit der mit X bezeichneten Feature-Matrix haben wir auch ein Ziel-Array. Es wird auch Label genannt. Es wird mit y bezeichnet. Die Beschriftung oder das Zielarray ist normalerweise eindimensional mit der Länge n_samples. Es ist im Allgemeinen in NumPy enthaltenarray oder Pandas Series. Das Zielarray kann sowohl Werte als auch kontinuierliche numerische Werte und diskrete Werte aufweisen.

Wie unterscheidet sich das Zielarray von Feature-Spalten?

Wir können beide durch einen Punkt unterscheiden, dass das Zielarray normalerweise die Größe ist, die wir aus den Daten vorhersagen möchten, dh statistisch gesehen ist es die abhängige Variable.

Beispiel

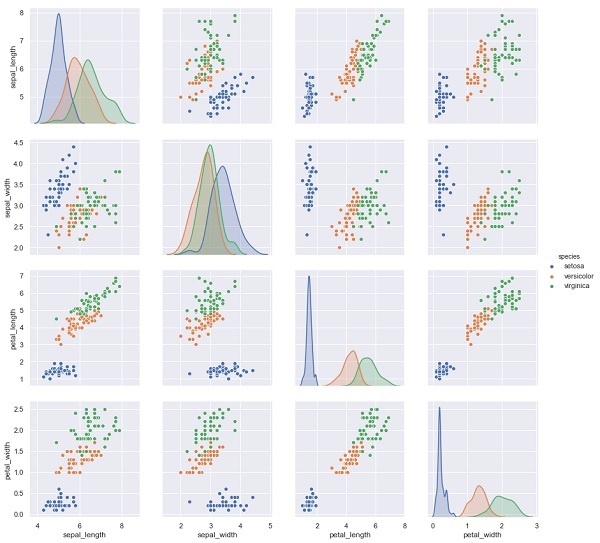

Im folgenden Beispiel prognostizieren wir aus dem Iris-Datensatz die Blütenarten basierend auf den anderen Messungen. In diesem Fall wird die Spalte "Arten" als Feature betrachtet.

import seaborn as sns

iris = sns.load_dataset('iris')

%matplotlib inline

import seaborn as sns; sns.set()

sns.pairplot(iris, hue='species', height=3);Ausgabe

X_iris = iris.drop('species', axis=1)

X_iris.shape

y_iris = iris['species']

y_iris.shapeAusgabe

(150,4)

(150,)In diesem Kapitel erfahren Sie mehr darüber Estimator API(Programmierschnittstelle). Beginnen wir mit dem Verständnis einer Estimator-API.

Was ist die Estimator-API?

Es ist eine der Haupt-APIs, die von Scikit-learn implementiert werden. Es bietet eine konsistente Schnittstelle für eine Vielzahl von ML-Anwendungen, weshalb alle Algorithmen für maschinelles Lernen in Scikit-Learn über die Estimator-API implementiert werden. Das Objekt, das aus den Daten lernt (Anpassung der Daten), ist ein Schätzer. Es kann mit jedem der Algorithmen wie Klassifizierung, Regression, Clustering oder sogar mit einem Transformator verwendet werden, der nützliche Funktionen aus Rohdaten extrahiert.

Zum Anpassen der Daten legen alle Schätzerobjekte eine Anpassungsmethode offen, die einen Datensatz wie folgt verwendet:

estimator.fit(data)Als nächstes können alle Parameter eines Schätzers wie folgt eingestellt werden, wenn er durch das entsprechende Attribut instanziiert wird.

estimator = Estimator (param1=1, param2=2)

estimator.param1Die Ausgabe der obigen wäre 1.

Sobald die Daten mit einem Schätzer ausgestattet sind, werden die Parameter aus den vorliegenden Daten geschätzt. Alle geschätzten Parameter sind nun die Attribute des Schätzobjekts, die wie folgt mit einem Unterstrich enden:

estimator.estimated_param_Verwendung der Estimator-API

Hauptverwendungen von Schätzern sind wie folgt:

Schätzung und Dekodierung eines Modells

Das Schätzobjekt wird zum Schätzen und Decodieren eines Modells verwendet. Darüber hinaus wird das Modell als deterministische Funktion der folgenden geschätzt:

Die Parameter, die bei der Objektkonstruktion bereitgestellt werden.

Der globale Zufallsstatus (numpy.random), wenn der Parameter random_state des Schätzers auf none gesetzt ist.

Alle Daten, die an den letzten Anruf an übergeben wurden fit, fit_transform, or fit_predict.

Alle Daten, die in einer Folge von Aufrufen an übergeben werden partial_fit.

Abbildung einer nicht rechteckigen Datendarstellung auf rechteckige Daten

Es ordnet eine nicht rechteckige Datendarstellung rechteckigen Daten zu. Mit einfachen Worten, es werden Eingaben vorgenommen, bei denen nicht jede Stichprobe als Array-ähnliches Objekt fester Länge dargestellt wird, und es wird für jede Stichprobe ein Array-ähnliches Objekt mit Merkmalen erstellt.

Unterscheidung zwischen Kern- und Außenproben

Es modelliert die Unterscheidung zwischen Kern- und Außenproben mithilfe der folgenden Methoden:

fit

fit_predict wenn transduktiv

vorhersagen, ob induktiv

Leitprinzipien

Beachten Sie beim Entwerfen der Scikit-Learn-API die folgenden Leitprinzipien:

Konsistenz

Dieses Prinzip besagt, dass alle Objekte eine gemeinsame Schnittstelle haben sollten, die aus einer begrenzten Anzahl von Methoden stammt. Die Dokumentation sollte auch konsistent sein.

Begrenzte Objekthierarchie

Dieses Leitprinzip lautet:

Algorithmen sollten durch Python-Klassen dargestellt werden

Datensätze sollten im Standardformat wie NumPy-Arrays, Pandas DataFrames und SciPy-Sparse-Matrix dargestellt werden.

Parameternamen sollten Standard-Python-Zeichenfolgen verwenden.

Komposition

Wie wir wissen, können ML-Algorithmen als die Folge vieler grundlegender Algorithmen ausgedrückt werden. Scikit-learn nutzt diese grundlegenden Algorithmen bei Bedarf.

Sinnvolle Standardeinstellungen

Nach diesem Prinzip definiert die Scikit-Lernbibliothek einen geeigneten Standardwert, wenn ML-Modelle benutzerdefinierte Parameter erfordern.

Inspektion

Gemäß diesem Leitprinzip wird jeder angegebene Parameterwert als Schamattribut angezeigt.

Schritte zur Verwendung der Estimator-API

Im Folgenden finden Sie die Schritte zur Verwendung der Scikit-Learn-Schätzer-API:

Schritt 1: Wählen Sie eine Modellklasse

In diesem ersten Schritt müssen wir eine Modellklasse auswählen. Dies kann durch Importieren der entsprechenden Estimator-Klasse aus Scikit-learn erfolgen.

Schritt 2: Wählen Sie Modellhyperparameter

In diesem Schritt müssen wir Klassenmodell-Hyperparameter auswählen. Dies kann durch Instanziieren der Klasse mit den gewünschten Werten erfolgen.

Schritt 3: Anordnen der Daten

Als nächstes müssen wir die Daten in Merkmalsmatrix (X) und Zielvektor (y) anordnen.

Schritt 4: Modellanpassung

Jetzt müssen wir das Modell an Ihre Daten anpassen. Dies kann durch Aufrufen der fit () -Methode der Modellinstanz erfolgen.

Schritt 5: Anwenden des Modells

Nach dem Anpassen des Modells können wir es auf neue Daten anwenden. Verwenden Sie für überwachtes Lernenpredict()Methode zur Vorhersage der Beschriftungen für unbekannte Daten. Verwenden Sie für unbeaufsichtigtes Lernenpredict() oder transform() Eigenschaften der Daten ableiten.

Beispiel für betreutes Lernen

Als Beispiel für diesen Prozess nehmen wir hier den allgemeinen Fall, dass eine Linie an (x, y) -Daten angepasst wird, d. H. simple linear regression.

Zuerst müssen wir den Datensatz laden, wir verwenden den Iris-Datensatz -

Beispiel

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shapeAusgabe

(150, 4)Beispiel

y_iris = iris['species']

y_iris.shapeAusgabe

(150,)Beispiel

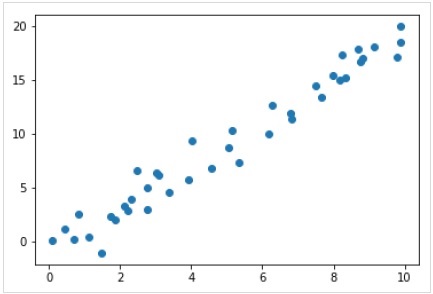

Für dieses Regressionsbeispiel verwenden wir nun die folgenden Beispieldaten:

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);Ausgabe

Wir haben also die obigen Daten für unser lineares Regressionsbeispiel.

Mit diesen Daten können wir nun die oben genannten Schritte anwenden.

Wählen Sie eine Modellklasse

Um ein einfaches lineares Regressionsmodell zu berechnen, müssen wir die lineare Regressionsklasse wie folgt importieren:

from sklearn.linear_model import LinearRegressionWählen Sie Modellhyperparameter

Sobald wir eine Modellklasse ausgewählt haben, müssen wir einige wichtige Entscheidungen treffen, die häufig als Hyperparameter dargestellt werden, oder die Parameter, die festgelegt werden müssen, bevor das Modell an Daten angepasst wird. Hier, für dieses Beispiel der linearen Regression, möchten wir den Achsenabschnitt mithilfe von anpassenfit_intercept Hyperparameter wie folgt -

Example

model = LinearRegression(fit_intercept = True)

modelOutput

LinearRegression(copy_X = True, fit_intercept = True, n_jobs = None, normalize = False)Daten anordnen

Nun, da wir wissen, dass unsere Zielvariable y ist in der richtigen Form, dh eine Länge n_samplesArray von 1-D. Wir müssen jedoch die Feature-Matrix neu gestaltenX um es zu einer Matrix der Größe zu machen [n_samples, n_features]. Dies kann wie folgt erfolgen:

Example

X = x[:, np.newaxis]

X.shapeOutput

(40, 1)Modellbefestigung

Sobald wir die Daten angeordnet haben, ist es Zeit, das Modell anzupassen, dh unser Modell auf Daten anzuwenden. Dies kann mit Hilfe von erfolgenfit() Methode wie folgt -

Example

model.fit(X, y)Output

LinearRegression(copy_X = True, fit_intercept = True, n_jobs = None,normalize = False)In Scikit-learn wird die fit() Prozess haben einige nachfolgende Unterstriche.

In diesem Beispiel zeigt der folgende Parameter die Steigung der einfachen linearen Anpassung der Daten -

Example

model.coef_Output

array([1.99839352])Der folgende Parameter repräsentiert den Achsenabschnitt der einfachen linearen Anpassung an die Daten -

Example

model.intercept_Output

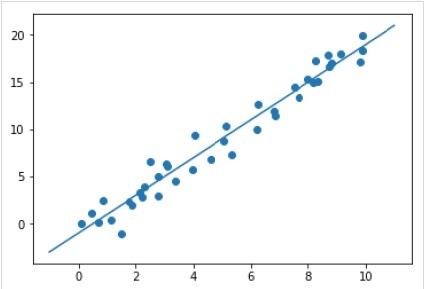

-0.9895459457775022Anwenden des Modells auf neue Daten

Nach dem Training des Modells können wir es auf neue Daten anwenden. Die Hauptaufgabe des überwachten maschinellen Lernens besteht darin, das Modell anhand neuer Daten zu bewerten, die nicht Teil des Trainingssatzes sind. Dies kann mit Hilfe von erfolgenpredict() Methode wie folgt -

Example

xfit = np.linspace(-1, 11)

Xfit = xfit[:, np.newaxis]

yfit = model.predict(Xfit)

plt.scatter(x, y)

plt.plot(xfit, yfit);Output

Vollständiges Arbeits- / ausführbares Beispiel

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shape

y_iris = iris['species']

y_iris.shape

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);

from sklearn.linear_model import LinearRegression

model = LinearRegression(fit_intercept=True)

model

X = x[:, np.newaxis]

X.shape

model.fit(X, y)

model.coef_

model.intercept_

xfit = np.linspace(-1, 11)

Xfit = xfit[:, np.newaxis]

yfit = model.predict(Xfit)

plt.scatter(x, y)

plt.plot(xfit, yfit);Beispiel für unbeaufsichtigtes Lernen

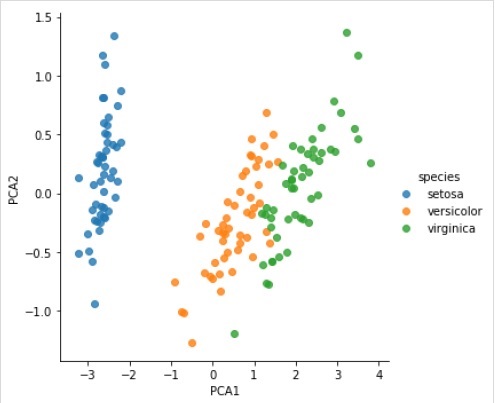

Als Beispiel für diesen Prozess wird hier häufig die Dimensionalität des Iris-Datensatzes reduziert, damit wir ihn leichter visualisieren können. In diesem Beispiel verwenden wir die Hauptkomponentenanalyse (PCA), eine schnelle lineare Dimensionsreduktionstechnik.

Wie im obigen Beispiel können wir die Zufallsdaten aus dem Iris-Datensatz laden und zeichnen. Danach können wir die folgenden Schritte ausführen -

Wählen Sie eine Modellklasse

from sklearn.decomposition import PCAWählen Sie Modellhyperparameter

Example

model = PCA(n_components=2)

modelOutput

PCA(copy = True, iterated_power = 'auto', n_components = 2, random_state = None,

svd_solver = 'auto', tol = 0.0, whiten = False)Modellbefestigung

Example

model.fit(X_iris)Output

PCA(copy = True, iterated_power = 'auto', n_components = 2, random_state = None,

svd_solver = 'auto', tol = 0.0, whiten = False)Transformieren Sie die Daten in zweidimensionale

Example

X_2D = model.transform(X_iris)Jetzt können wir das Ergebnis wie folgt darstellen:

Output

iris['PCA1'] = X_2D[:, 0]

iris['PCA2'] = X_2D[:, 1]

sns.lmplot("PCA1", "PCA2", hue = 'species', data = iris, fit_reg = False);Output

Vollständiges Arbeits- / ausführbares Beispiel

%matplotlib inline

import matplotlib.pyplot as plt

import numpy as np

import seaborn as sns

iris = sns.load_dataset('iris')

X_iris = iris.drop('species', axis = 1)

X_iris.shape

y_iris = iris['species']

y_iris.shape

rng = np.random.RandomState(35)

x = 10*rng.rand(40)

y = 2*x-1+rng.randn(40)

plt.scatter(x,y);

from sklearn.decomposition import PCA

model = PCA(n_components=2)

model

model.fit(X_iris)

X_2D = model.transform(X_iris)

iris['PCA1'] = X_2D[:, 0]

iris['PCA2'] = X_2D[:, 1]

sns.lmplot("PCA1", "PCA2", hue='species', data=iris, fit_reg=False);Die Objekte von Scikit-learn teilen sich eine einheitliche Basis-API, die aus den folgenden drei komplementären Schnittstellen besteht:

Estimator interface - Es ist für den Bau und die Montage der Modelle.

Predictor interface - Es ist für Vorhersagen.

Transformer interface - Es dient zum Konvertieren von Daten.

Die APIs verwenden einfache Konventionen, und die Entwurfsentscheidungen wurden so gesteuert, dass die Verbreitung von Framework-Code vermieden wird.

Zweck der Konventionen

Mit Konventionen soll sichergestellt werden, dass die API die folgenden allgemeinen Grundsätze einhält:

Consistency - Alle Objekte, unabhängig davon, ob sie einfach oder zusammengesetzt sind, müssen eine konsistente Schnittstelle gemeinsam haben, die sich aus einer begrenzten Anzahl von Methoden zusammensetzt.

Inspection - Konstruktorparameter und Parameterwerte, die vom Lernalgorithmus bestimmt werden, sollten gespeichert und als öffentliche Attribute verfügbar gemacht werden.

Non-proliferation of classes - Datensätze sollten als NumPy-Arrays oder Scipy-Sparse-Matrix dargestellt werden, während Namen und Werte von Hyperparametern als Standard-Python-Zeichenfolgen dargestellt werden sollten, um die Verbreitung von Framework-Code zu vermeiden.

Composition - Die Algorithmen, ob sie als Sequenzen oder Kombinationen von Transformationen zu den Daten ausgedrückt werden können oder natürlich als Metaalgorithmen angesehen werden, die mit anderen Algorithmen parametrisiert sind, sollten implementiert und aus vorhandenen Bausteinen zusammengesetzt werden.

Sensible defaults- In scikit-learn wird immer dann, wenn für eine Operation ein benutzerdefinierter Parameter erforderlich ist, ein geeigneter Standardwert definiert. Dieser Standardwert sollte dazu führen, dass die Operation auf sinnvolle Weise ausgeführt wird, z. B. um eine Basislösung für die jeweilige Aufgabe zu erhalten.

Verschiedene Konventionen

Die in Sklearn verfügbaren Konventionen werden nachfolgend erläutert -

Typ Casting

Es besagt, dass die Eingabe in umgewandelt werden soll float64. Im folgenden Beispiel, in demsklearn.random_projection Modul zur Reduzierung der Dimensionalität der Daten, wird es erklären -

Example

import numpy as np

from sklearn import random_projection

rannge = np.random.RandomState(0)

X = range.rand(10,2000)

X = np.array(X, dtype = 'float32')

X.dtype

Transformer_data = random_projection.GaussianRandomProjection()

X_new = transformer.fit_transform(X)

X_new.dtypeOutput

dtype('float32')

dtype('float64')Im obigen Beispiel können wir sehen, dass X ist float32 welches gegossen wird float64 durch fit_transform(X).

Parameter anpassen und aktualisieren

Hyperparameter eines Schätzers können aktualisiert und angepasst werden, nachdem er über das erstellt wurde set_params()Methode. Sehen wir uns das folgende Beispiel an, um es zu verstehen:

Example

import numpy as np

from sklearn.datasets import load_iris

from sklearn.svm import SVC

X, y = load_iris(return_X_y = True)

clf = SVC()

clf.set_params(kernel = 'linear').fit(X, y)

clf.predict(X[:5])Output

array([0, 0, 0, 0, 0])Sobald der Schätzer erstellt wurde, ändert der obige Code den Standardkernel rbf linear über SVC.set_params().

Der folgende Code ändert nun den Kernel zurück in rbf, um den Schätzer anzupassen und eine zweite Vorhersage zu treffen.

Example

clf.set_params(kernel = 'rbf', gamma = 'scale').fit(X, y)

clf.predict(X[:5])Output

array([0, 0, 0, 0, 0])Vollständiger Code

Das folgende ist das vollständige ausführbare Programm -

import numpy as np

from sklearn.datasets import load_iris

from sklearn.svm import SVC

X, y = load_iris(return_X_y = True)

clf = SVC()

clf.set_params(kernel = 'linear').fit(X, y)

clf.predict(X[:5])

clf.set_params(kernel = 'rbf', gamma = 'scale').fit(X, y)

clf.predict(X[:5])Multiclass & Multilabel Fitting

Bei der Anpassung mehrerer Klassen hängen sowohl die Lern- als auch die Vorhersageaufgaben vom Format der angepassten Zieldaten ab. Das verwendete Modul istsklearn.multiclass. Überprüfen Sie das folgende Beispiel, in dem der Klassifikator für mehrere Klassen auf ein 1d-Array passt.

Example

from sklearn.svm import SVC

from sklearn.multiclass import OneVsRestClassifier

from sklearn.preprocessing import LabelBinarizer

X = [[1, 2], [3, 4], [4, 5], [5, 2], [1, 1]]

y = [0, 0, 1, 1, 2]

classif = OneVsRestClassifier(estimator = SVC(gamma = 'scale',random_state = 0))

classif.fit(X, y).predict(X)Output

array([0, 0, 1, 1, 2])Im obigen Beispiel wird der Klassifizierer auf ein eindimensionales Array von Mehrklassenbeschriftungen und die angepasst predict()Das Verfahren liefert daher eine entsprechende Vorhersage für mehrere Klassen. Andererseits ist es aber auch möglich, auf ein zweidimensionales Array von binären Beschriftungsindikatoren wie folgt zu passen:

Example

from sklearn.svm import SVC

from sklearn.multiclass import OneVsRestClassifier

from sklearn.preprocessing import LabelBinarizer

X = [[1, 2], [3, 4], [4, 5], [5, 2], [1, 1]]

y = LabelBinarizer().fit_transform(y)

classif.fit(X, y).predict(X)Output

array(

[

[0, 0, 0],

[0, 0, 0],

[0, 1, 0],

[0, 1, 0],

[0, 0, 0]

]

)In ähnlicher Weise kann einer Instanz im Fall einer Mehrfachetikettenanpassung mehrere Etiketten wie folgt zugewiesen werden:

Example

from sklearn.preprocessing import MultiLabelBinarizer

y = [[0, 1], [0, 2], [1, 3], [0, 2, 3], [2, 4]]

y = MultiLabelBinarizer().fit_transform(y)

classif.fit(X, y).predict(X)Output

array(

[

[1, 0, 1, 0, 0],

[1, 0, 1, 0, 0],

[1, 0, 1, 1, 0],

[1, 0, 1, 1, 0],

[1, 0, 1, 0, 0]

]

)Im obigen Beispiel ist sklearn.MultiLabelBinarizerwird verwendet, um das zweidimensionale Array von Multilabels zu binarisieren, auf das es passt. Aus diesem Grund gibt die Funktion Predict () ein 2D-Array als Ausgabe mit mehreren Beschriftungen für jede Instanz aus.

Dieses Kapitel hilft Ihnen beim Erlernen der linearen Modellierung in Scikit-Learn. Beginnen wir mit dem Verständnis der linearen Regression in Sklearn.

In der folgenden Tabelle sind verschiedene lineare Modelle aufgeführt, die von Scikit-Learn bereitgestellt werden.

| Sr.Nr. | Modellbeschreibung |

|---|---|

| 1 | Lineare Regression Es ist eines der besten statistischen Modelle, das die Beziehung zwischen einer abhängigen Variablen (Y) und einem bestimmten Satz unabhängiger Variablen (X) untersucht. |

| 2 | Logistische Regression Die logistische Regression ist trotz ihres Namens eher ein Klassifizierungsalgorithmus als ein Regressionsalgorithmus. Basierend auf einem gegebenen Satz unabhängiger Variablen wird es verwendet, um einen diskreten Wert zu schätzen (0 oder 1, ja / nein, wahr / falsch). |

| 3 | Ridge Regression Die Ridge-Regression oder Tikhonov-Regularisierung ist die Regularisierungstechnik, die die L2-Regularisierung durchführt. Es modifiziert die Verlustfunktion durch Addieren der Strafe (Schrumpfungsmenge), die dem Quadrat der Größe der Koeffizienten entspricht. |

| 4 | Bayesian Ridge Regression Die Bayes'sche Regression ermöglicht es einem natürlichen Mechanismus, unzureichende oder schlecht verteilte Daten zu überleben, indem eine lineare Regression unter Verwendung von Wahrscheinlichkeitsverteilern anstelle von Punktschätzungen formuliert wird. |

| 5 | LASSO LASSO ist die Regularisierungstechnik, die die L1-Regularisierung durchführt. Es modifiziert die Verlustfunktion durch Addition der Strafe (Schrumpfungsmenge), die der Summe des Absolutwerts der Koeffizienten entspricht. |

| 6 | Multitasking LASSO Es ermöglicht die gemeinsame Anpassung mehrerer Regressionsprobleme, wodurch die ausgewählten Features für alle Regressionsprobleme, auch als Aufgaben bezeichnet, gleich sind. Sklearn bietet ein lineares Modell namens MultiTaskLasso, das mit einer gemischten L1-, L2-Norm für die Regularisierung trainiert wurde und die spärliche Koeffizienten für mehrere Regressionsprobleme gemeinsam schätzt. |

| 7 | Elastic-Net Das Elastic-Net ist eine regulierte Regressionsmethode, die beide Strafen, dh L1 und L2 der Lasso- und Ridge-Regressionsmethoden, linear kombiniert. Dies ist nützlich, wenn mehrere korrelierte Merkmale vorhanden sind. |

| 8 | Multitasking Elastic-Net Es handelt sich um ein Elastic-Net-Modell, mit dem mehrere Regressionsprobleme gemeinsam angepasst werden können, wobei die ausgewählten Funktionen für alle Regressionsprobleme, auch Aufgaben genannt, gleich bleiben |

Dieses Kapitel konzentriert sich auf die Polynommerkmale und Pipelining-Tools in Sklearn.

Einführung in Polynomfunktionen

Lineare Modelle, die auf nichtlinearen Funktionen von Daten trainiert werden, erhalten im Allgemeinen die schnelle Leistung linearer Methoden. Es ermöglicht ihnen auch, einen viel größeren Datenbereich anzupassen. Aus diesem Grund werden beim maschinellen Lernen solche linearen Modelle verwendet, die auf nichtlinearen Funktionen trainiert werden.

Ein solches Beispiel ist, dass eine einfache lineare Regression erweitert werden kann, indem Polynommerkmale aus den Koeffizienten konstruiert werden.

Angenommen, wir haben ein lineares Standardregressionsmodell, dann würde es für 2D-Daten folgendermaßen aussehen:

$$Y=W_{0}+W_{1}X_{1}+W_{2}X_{2}$$Jetzt können wir die Merkmale in Polynomen zweiter Ordnung kombinieren und unser Modell sieht wie folgt aus:

$$Y=W_{0}+W_{1}X_{1}+W_{2}X_{2}+W_{3}X_{1}X_{2}+W_{4}X_1^2+W_{5}X_2^2$$Das Obige ist immer noch ein lineares Modell. Hier haben wir gesehen, dass die resultierende Polynomregression in derselben Klasse linearer Modelle liegt und auf ähnliche Weise gelöst werden kann.

Zu diesem Zweck stellt scikit-learn ein Modul mit dem Namen bereit PolynomialFeatures. Dieses Modul wandelt eine Eingabedatenmatrix in eine neue Datenmatrix eines bestimmten Grades um.

Parameter

Die folgende Tabelle enthält die von verwendeten Parameter PolynomialFeatures Modul

| Sr.Nr. | Parameter & Beschreibung |

|---|---|

| 1 | degree - Ganzzahl, Standard = 2 Es repräsentiert den Grad der Polynommerkmale. |

| 2 | interaction_only - Boolean, Standard = false Standardmäßig ist es falsch, aber wenn es auf true gesetzt ist, werden die Features erzeugt, die Produkte mit den meisten Grad unterschiedlicher Eingabe-Features sind. Solche Merkmale werden Interaktionsmerkmale genannt. |

| 3 | include_bias - Boolean, Standard = true Es enthält eine Vorspannungsspalte, dh das Merkmal, in dem alle Polynomkräfte Null sind. |

| 4 | order - str in {'C', 'F'}, Standard = 'C' Dieser Parameter repräsentiert die Reihenfolge des Ausgabearrays im dichten Fall. 'F'-Reihenfolge bedeutet schneller zu berechnen, kann jedoch nachfolgende Schätzer verlangsamen. |

Attribute

Die folgende Tabelle enthält die von verwendeten Attribute PolynomialFeatures Modul

| Sr.Nr. | Attribute & Beschreibung |

|---|---|

| 1 | powers_ - Array, Form (n_output_features, n_input_features) Es zeigt, dass Potenzen_ [i, j] der Exponent des j-ten Eingangs im i-ten Ausgang ist. |

| 2 | n_input_features _ - int Wie der Name schon sagt, gibt es die Gesamtzahl der Eingabefunktionen an. |

| 3 | n_output_features _ - int Wie der Name schon sagt, gibt es die Gesamtzahl der Polynomausgabemerkmale an. |

Implementierungsbeispiel

Das folgende Python-Skript verwendet PolynomialFeatures Transformator zur Umwandlung eines Arrays von 8 in Form (4,2) -

from sklearn.preprocessing import PolynomialFeatures

import numpy as np

Y = np.arange(8).reshape(4, 2)

poly = PolynomialFeatures(degree=2)

poly.fit_transform(Y)Ausgabe

array(

[

[ 1., 0., 1., 0., 0., 1.],

[ 1., 2., 3., 4., 6., 9.],

[ 1., 4., 5., 16., 20., 25.],

[ 1., 6., 7., 36., 42., 49.]

]

)Rationalisierung mit Pipeline-Tools

Die obige Art der Vorverarbeitung, dh das Transformieren einer Eingabedatenmatrix in eine neue Datenmatrix eines bestimmten Grades, kann mit dem optimiert werden Pipeline Tools, mit denen grundsätzlich mehrere Schätzer zu einem verkettet werden.

Beispiel

Die folgenden Python-Skripte verwenden die Pipeline-Tools von Scikit-learn, um die Vorverarbeitung zu optimieren (passen zu Polynomdaten der Ordnung 3).

#First, import the necessary packages.

from sklearn.preprocessing import PolynomialFeatures

from sklearn.linear_model import LinearRegression

from sklearn.pipeline import Pipeline

import numpy as np

#Next, create an object of Pipeline tool

Stream_model = Pipeline([('poly', PolynomialFeatures(degree=3)), ('linear', LinearRegression(fit_intercept=False))])

#Provide the size of array and order of polynomial data to fit the model.

x = np.arange(5)

y = 3 - 2 * x + x ** 2 - x ** 3

Stream_model = model.fit(x[:, np.newaxis], y)

#Calculate the input polynomial coefficients.

Stream_model.named_steps['linear'].coef_Ausgabe

array([ 3., -2., 1., -1.])Die obige Ausgabe zeigt, dass das auf Polynommerkmalen trainierte lineare Modell die genauen Eingabepolynomkoeffizienten wiederherstellen kann.

Hier lernen wir einen Optimierungsalgorithmus in Sklearn kennen, der als Stochastic Gradient Descent (SGD) bezeichnet wird.

Stochastic Gradient Descent (SGD) ist ein einfacher, aber effizienter Optimierungsalgorithmus, mit dem die Werte von Parametern / Koeffizienten von Funktionen ermittelt werden, die eine Kostenfunktion minimieren. Mit anderen Worten, es wird zum diskriminativen Lernen von linearen Klassifikatoren unter konvexen Verlustfunktionen wie SVM und logistischer Regression verwendet. Es wurde erfolgreich auf große Datensätze angewendet, da die Aktualisierung der Koeffizienten für jede Trainingsinstanz und nicht am Ende der Instanzen durchgeführt wird.

SGD-Klassifikator

Der SGD-Klassifikator (Stochastic Gradient Descent) implementiert im Wesentlichen eine einfache SGD-Lernroutine, die verschiedene Verlustfunktionen und Strafen für die Klassifizierung unterstützt. Scikit-Learn bietetSGDClassifier Modul zur Implementierung der SGD-Klassifizierung.

Parameter

Die folgende Tabelle enthält die von verwendeten Parameter SGDClassifier Modul -

| Sr.Nr. | Parameter & Beschreibung |

|---|---|

| 1 | loss - str, default = 'Scharnier' Es stellt die Verlustfunktion dar, die während der Implementierung verwendet werden soll. Der Standardwert ist 'Scharnier', wodurch wir eine lineare SVM erhalten. Die anderen Optionen, die verwendet werden können, sind -

|

| 2 | penalty - str, 'keine', 'l2', 'l1', 'elastisches Netz' Dies ist der im Modell verwendete Regularisierungsterm. Standardmäßig ist es L2. Wir können L1 oder 'Elasticnet verwenden; aber auch beide könnten dem Modell Sparsamkeit verleihen, was mit L2 nicht erreichbar ist. |

| 3 | alpha - float, Standard = 0,0001 Alpha, die Konstante, die den Regularisierungsterm multipliziert, ist der Abstimmungsparameter, der entscheidet, wie sehr wir das Modell bestrafen möchten. Der Standardwert ist 0,0001. |

| 4 | l1_ratio - float, Standard = 0,15 Dies wird als ElasticNet-Mischparameter bezeichnet. Sein Bereich ist 0 <= l1_ratio <= 1. Wenn l1_ratio = 1 ist, wäre die Strafe L1 Strafe. Wenn l1_ratio = 0 ist, wäre die Strafe eine L2-Strafe. |

| 5 | fit_intercept - Boolean, Standard = True Dieser Parameter gibt an, dass der Entscheidungsfunktion eine Konstante (Bias oder Intercept) hinzugefügt werden soll. Bei der Berechnung wird kein Achsenabschnitt verwendet, und es wird angenommen, dass die Daten bereits zentriert sind, wenn sie auf false gesetzt werden. |

| 6 | tol - float oder none, optional, Standard = 1.e-3 Dieser Parameter repräsentiert das Stoppkriterium für Iterationen. Der Standardwert ist False. Wenn dieser Wert jedoch auf None gesetzt ist, werden die Iterationen beendet, wennloss > best_loss - tol for n_iter_no_changeaufeinanderfolgende Epochen. |

| 7 | shuffle - Boolean, optional, Standard = True Dieser Parameter gibt an, ob unsere Trainingsdaten nach jeder Epoche gemischt werden sollen oder nicht. |

| 8 | verbose - Ganzzahl, Standard = 0 Es repräsentiert die Ausführlichkeitsstufe. Der Standardwert ist 0. |

| 9 | epsilon - float, Standard = 0.1 Dieser Parameter gibt die Breite des unempfindlichen Bereichs an. Wenn Verlust = "epsilonunempfindlich" ist, wird jeder Unterschied zwischen der aktuellen Vorhersage und der korrekten Bezeichnung, der unter dem Schwellenwert liegt, ignoriert. |

| 10 | max_iter - int, optional, Standard = 1000 Wie der Name schon sagt, repräsentiert es die maximale Anzahl von Durchgängen über die Epochen, dh Trainingsdaten. |

| 11 | warm_start - bool, optional, default = false Wenn dieser Parameter auf True gesetzt ist, können wir die Lösung des vorherigen Aufrufs als Initialisierung wiederverwenden. Wenn wir Standard wählen, dh false, wird die vorherige Lösung gelöscht. |

| 12 | random_state - int, RandomState-Instanz oder None, optional, default = none Dieser Parameter stellt den Startwert der erzeugten Pseudozufallszahl dar, die beim Mischen der Daten verwendet wird. Folgende Optionen stehen zur Verfügung.

|

| 13 | n_jobs - int oder none, optional, Default = None Es gibt die Anzahl der CPUs an, die bei der OVA-Berechnung (One Versus All) für Probleme mit mehreren Klassen verwendet werden sollen. Der Standardwert ist none, was 1 bedeutet. |

| 14 | learning_rate - Zeichenfolge, optional, Standard = 'optimal'

|

| 15 | eta0 - double, default = 0.0 Es stellt die anfängliche Lernrate für die oben genannten Lernratenoptionen dar, dh "konstant", "aufrufend" oder "adaptiv". |

| 16 | power_t - idouble, Standard = 0,5 Es ist der Exponent für die Lernrate. |

| 17 | early_stopping - bool, default = False Dieser Parameter stellt die Verwendung eines frühen Stopps dar, um das Training zu beenden, wenn sich der Validierungswert nicht verbessert. Der Standardwert ist false, aber wenn er auf true gesetzt ist, wird automatisch ein geschichteter Teil der Trainingsdaten als Validierung beiseite gelegt und das Training abgebrochen, wenn sich der Validierungswert nicht verbessert. |

| 18 | validation_fraction - float, Standard = 0.1 Es wird nur verwendet, wenn Early_Stopping wahr ist. Es stellt den Anteil der Trainingsdaten dar, der als Validierungssatz für die vorzeitige Beendigung von Trainingsdaten beiseite gelegt werden soll. |

| 19 | n_iter_no_change - int, Standard = 5 Es stellt die Anzahl der Iterationen ohne Verbesserung dar, sollte der Algorithmus vor dem frühen Stoppen ausgeführt werden. |

| 20 | classs_weight - diktieren, {class_label: weight} oder "ausgeglichen" oder Keine, optional Dieser Parameter repräsentiert die mit Klassen verknüpften Gewichte. Wenn nicht angegeben, sollen die Klassen Gewicht 1 haben. |

| 20 | warm_start - bool, optional, default = false Wenn dieser Parameter auf True gesetzt ist, können wir die Lösung des vorherigen Aufrufs als Initialisierung wiederverwenden. Wenn wir Standard wählen, dh false, wird die vorherige Lösung gelöscht. |

| 21 | average - iBoolean oder int, optional, default = false Es gibt die Anzahl der CPUs an, die bei der OVA-Berechnung (One Versus All) für Probleme mit mehreren Klassen verwendet werden sollen. Der Standardwert ist none, was 1 bedeutet. |

Attribute

Die folgende Tabelle enthält die von verwendeten Attribute SGDClassifier Modul -

| Sr.Nr. | Attribute & Beschreibung |

|---|---|

| 1 | coef_ - Array, Form (1, n_features) wenn n_classes == 2, sonst (n_classes, n_features) Dieses Attribut gibt das den Features zugewiesene Gewicht an. |

| 2 | intercept_ - Array, Form (1,) wenn n_classes == 2, sonst (n_classes,) Es repräsentiert den unabhängigen Begriff in der Entscheidungsfunktion. |

| 3 | n_iter_ - int Es gibt die Anzahl der Iterationen an, um das Stoppkriterium zu erreichen. |

Implementation Example

Wie andere Klassifikatoren muss auch der stochastische Gradientenabstieg (SGD) mit den folgenden zwei Arrays ausgestattet werden:

Ein Array X, das die Trainingsmuster enthält. Es hat die Größe [n_samples, n_features].

Ein Array Y, das die Zielwerte enthält, dh Klassenbezeichnungen für die Trainingsmuster. Es hat die Größe [n_samples].

Example

Das folgende Python-Skript verwendet das lineare Modell SGDClassifier -

import numpy as np

from sklearn import linear_model

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

Y = np.array([1, 1, 2, 2])

SGDClf = linear_model.SGDClassifier(max_iter = 1000, tol=1e-3,penalty = "elasticnet")

SGDClf.fit(X, Y)Output

SGDClassifier(

alpha = 0.0001, average = False, class_weight = None,

early_stopping = False, epsilon = 0.1, eta0 = 0.0, fit_intercept = True,

l1_ratio = 0.15, learning_rate = 'optimal', loss = 'hinge', max_iter = 1000,

n_iter = None, n_iter_no_change = 5, n_jobs = None, penalty = 'elasticnet',

power_t = 0.5, random_state = None, shuffle = True, tol = 0.001,

validation_fraction = 0.1, verbose = 0, warm_start = False

)Example

Nach der Anpassung kann das Modell neue Werte wie folgt vorhersagen:

SGDClf.predict([[2.,2.]])Output

array([2])Example

Für das obige Beispiel können wir den Gewichtsvektor mit Hilfe des folgenden Python-Skripts erhalten -

SGDClf.coef_Output

array([[19.54811198, 9.77200712]])Example

In ähnlicher Weise können wir den Wert des Abfangens mithilfe des folgenden Python-Skripts ermitteln:

SGDClf.intercept_Output

array([10.])Example

Wir können den vorzeichenbehafteten Abstand zur Hyperebene mithilfe von ermitteln SGDClassifier.decision_function wie im folgenden Python-Skript verwendet -

SGDClf.decision_function([[2., 2.]])Output

array([68.6402382])SGD Regressor

Der Stochastic Gradient Descent (SGD) -Regressor implementiert im Wesentlichen eine einfache SGD-Lernroutine, die verschiedene Verlustfunktionen und Strafen unterstützt, um lineare Regressionsmodelle anzupassen. Scikit-Learn bietetSGDRegressor Modul zur Implementierung der SGD-Regression.

Parameter

Von SGDRegressorsind fast die gleichen wie im SGDClassifier-Modul. Der Unterschied liegt im Parameter 'Verlust'. ZumSGDRegressor Verlustparameter der Module Die positiven Werte sind wie folgt:

squared_loss - Es bezieht sich auf die gewöhnliche Anpassung der kleinsten Quadrate.

huber: SGDRegressor- Korrigieren Sie die Ausreißer, indem Sie über eine Entfernung von Epsilon vom quadratischen zum linearen Verlust wechseln. Die Arbeit von 'huber' besteht darin, 'squared_loss' so zu modifizieren, dass sich der Algorithmus weniger auf die Korrektur von Ausreißern konzentriert.

epsilon_insensitive - Tatsächlich werden die Fehler weniger als bei epsilon ignoriert.

squared_epsilon_insensitive- Es ist dasselbe wie epsilon_insensitive. Der einzige Unterschied besteht darin, dass es nach einer Toleranz von Epsilon zu einem quadratischen Verlust wird.

Ein weiterer Unterschied besteht darin, dass der Parameter 'power_t' den Standardwert 0,25 anstelle von 0,5 wie in hat SGDClassifier. Darüber hinaus gibt es keine Parameter 'class_weight' und 'n_jobs'.

Attribute

Die Attribute von SGDRegressor sind auch dieselben wie die des SGDClassifier-Moduls. Vielmehr hat es drei zusätzliche Attribute wie folgt:

average_coef_ - Array, Form (n_features,)

Wie der Name schon sagt, werden die den Features zugewiesenen Durchschnittsgewichte angegeben.

average_intercept_ - Array, Form (1,)

Wie der Name schon sagt, liefert es den gemittelten Intercept-Term.

t_ - int

Es gibt die Anzahl der Gewichtsaktualisierungen an, die während der Trainingsphase durchgeführt wurden.

Note - Die Attribute durchschnittlich_coef_ und durchschnittlich_intercept_ funktionieren, nachdem der Parameter 'Durchschnitt' auf True gesetzt wurde.

Implementation Example

Das folgende Python-Skript verwendet SGDRegressor lineares Modell -

import numpy as np

from sklearn import linear_model

n_samples, n_features = 10, 5

rng = np.random.RandomState(0)

y = rng.randn(n_samples)

X = rng.randn(n_samples, n_features)

SGDReg =linear_model.SGDRegressor(

max_iter = 1000,penalty = "elasticnet",loss = 'huber',tol = 1e-3, average = True

)

SGDReg.fit(X, y)Output

SGDRegressor(

alpha = 0.0001, average = True, early_stopping = False, epsilon = 0.1,

eta0 = 0.01, fit_intercept = True, l1_ratio = 0.15,

learning_rate = 'invscaling', loss = 'huber', max_iter = 1000,

n_iter = None, n_iter_no_change = 5, penalty = 'elasticnet', power_t = 0.25,

random_state = None, shuffle = True, tol = 0.001, validation_fraction = 0.1,

verbose = 0, warm_start = False

)Example

Sobald es angepasst ist, können wir den Gewichtsvektor mithilfe des folgenden Python-Skripts abrufen:

SGDReg.coef_Output

array([-0.00423314, 0.00362922, -0.00380136, 0.00585455, 0.00396787])Example

In ähnlicher Weise können wir den Wert des Abfangens mithilfe des folgenden Python-Skripts ermitteln:

SGReg.intercept_Output

SGReg.intercept_Example

Wir können die Anzahl der Gewichtsaktualisierungen während der Trainingsphase mithilfe des folgenden Python-Skripts ermitteln:

SGDReg.t_Output

61.0Vor- und Nachteile von SGD

Den Profis von SGD folgen -

Der stochastische Gradientenabstieg (SGD) ist sehr effizient.

Die Implementierung ist sehr einfach, da es viele Möglichkeiten zur Code-Optimierung gibt.

Nach den Nachteilen von SGD -

Der stochastische Gradientenabstieg (SGD) erfordert mehrere Hyperparameter wie Regularisierungsparameter.

Es reagiert empfindlich auf die Skalierung von Features.

Dieses Kapitel befasst sich mit einer maschinellen Lernmethode, die als Support Vector Machines (SVMs) bezeichnet wird.

Einführung

Support Vector Machines (SVMs) sind leistungsstarke und dennoch flexible Methoden für überwachtes maschinelles Lernen, die zur Klassifizierung, Regression und Erkennung von Ausreißern verwendet werden. SVMs sind in hochdimensionalen Räumen sehr effizient und werden im Allgemeinen bei Klassifizierungsproblemen verwendet. SVMs sind beliebt und speichereffizient, da sie eine Teilmenge von Trainingspunkten in der Entscheidungsfunktion verwenden.

Das Hauptziel von SVMs ist es, die Datensätze in die Anzahl der Klassen zu unterteilen, um a zu finden maximum marginal hyperplane (MMH) Dies kann in den folgenden zwei Schritten erfolgen:

Support Vector Machines generiert zunächst iterativ Hyperebenen, die die Klassen optimal trennen.

Danach wird die Hyperebene ausgewählt, die die Klassen korrekt trennt.

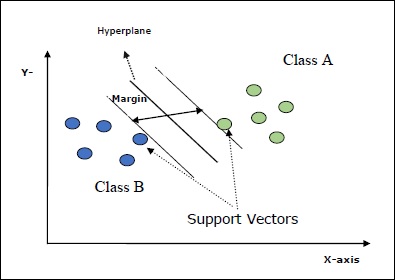

Einige wichtige Konzepte in SVM sind wie folgt:

Support Vectors- Sie können als die Datenpunkte definiert werden, die der Hyperebene am nächsten liegen. Unterstützungsvektoren helfen bei der Entscheidung der Trennlinie.

Hyperplane - Die Entscheidungsebene oder der Raum, der eine Gruppe von Objekten mit unterschiedlichen Klassen teilt.

Margin - Die Lücke zwischen zwei Zeilen auf den Schrankdatenpunkten verschiedener Klassen wird als Rand bezeichnet.

Die folgenden Diagramme geben Ihnen einen Einblick in diese SVM-Konzepte -

SVM in Scikit-learn unterstützt sowohl spärliche als auch dichte Abtastvektoren als Eingabe.

Klassifizierung von SVM

Scikit-learn bietet nämlich drei Klassen SVC, NuSVC und LinearSVC Dies kann eine Klassifizierung in mehreren Klassen durchführen.

SVC

Es ist eine C-Support-Vektorklassifikation, auf deren Implementierung basiert libsvm. Das von scikit-learn verwendete Modul istsklearn.svm.SVC. Diese Klasse behandelt die Unterstützung mehrerer Klassen nach einem Eins-gegen-Eins-Schema.

Parameter

Die folgende Tabelle enthält die von verwendeten Parameter sklearn.svm.SVC Klasse -

| Sr.Nr. | Parameter & Beschreibung |

|---|---|

| 1 | C - float, optional, default = 1.0 Dies ist der Strafparameter des Fehlerterms. |

| 2 | kernel - Zeichenfolge, optional, Standard = 'rbf' Dieser Parameter gibt den Kerneltyp an, der im Algorithmus verwendet werden soll. wir können jeden unter wählen,‘linear’, ‘poly’, ‘rbf’, ‘sigmoid’, ‘precomputed’. Der Standardwert des Kernels wäre‘rbf’. |

| 3 | degree - int, optional, default = 3 Es stellt den Grad der 'Poly'-Kernelfunktion dar und wird von allen anderen Kerneln ignoriert. |

| 4 | gamma - {'scale', 'auto'} oder float, Dies ist der Kernelkoeffizient für die Kernel 'rbf', 'poly' und 'sigmoid'. |

| 5 | optinal default - = 'Skala' Wenn Sie die Standardeinstellung wählen, dh gamma = 'scale', beträgt der von SVC zu verwendende Gamma-Wert 1 / (_ ∗. ()). Wenn andererseits gamma = 'auto' ist, wird 1 / _ verwendet. |

| 6 | coef0 - float, optional, Standard = 0.0 Ein unabhängiger Begriff in der Kernelfunktion, der nur in 'poly' und 'sigmoid' von Bedeutung ist. |

| 7 | tol - float, optional, default = 1.e-3 Dieser Parameter repräsentiert das Stoppkriterium für Iterationen. |

| 8 | shrinking - Boolean, optional, Standard = True Dieser Parameter gibt an, ob die Schrumpfheuristik verwendet werden soll oder nicht. |

| 9 | verbose - Boolescher Wert, Standard: false Es aktiviert oder deaktiviert die ausführliche Ausgabe. Der Standardwert ist false. |

| 10 | probability - boolean, optional, default = true Dieser Parameter aktiviert oder deaktiviert Wahrscheinlichkeitsschätzungen. Der Standardwert ist false, muss jedoch aktiviert werden, bevor wir fit aufrufen. |

| 11 | max_iter - int, optional, default = -1 Wie der Name schon sagt, repräsentiert es die maximale Anzahl von Iterationen innerhalb des Solvers. Der Wert -1 bedeutet, dass die Anzahl der Iterationen unbegrenzt ist. |

| 12 | cache_size - Float, optional Dieser Parameter gibt die Größe des Kernel-Cache an. Der Wert wird in MB (MegaBytes) angegeben. |

| 13 | random_state - int, RandomState-Instanz oder None, optional, default = none Dieser Parameter stellt den Startwert der erzeugten Pseudozufallszahl dar, die beim Mischen der Daten verwendet wird. Folgende sind die Optionen -

|

| 14 | class_weight - {diktieren, 'ausgeglichen'}, optional Dieser Parameter setzt den Parameter C der Klasse j für SVC auf _ℎ [] ∗. Wenn wir die Standardoption verwenden, bedeutet dies, dass alle Klassen das Gewicht eins haben sollen. Auf der anderen Seite, wenn Sie möchtenclass_weight:balancedverwendet die Werte von y, um die Gewichte automatisch anzupassen. |

| 15 | decision_function_shape - ovo ',' ovr ', default =' ovr ' Dieser Parameter entscheidet, ob der Algorithmus zurückkehrt ‘ovr’ (One-vs-Rest) Entscheidungsfunktion der Form wie alle anderen Klassifikatoren oder das Original ovo(Eins-gegen-Eins) Entscheidungsfunktion von libsvm. |

| 16 | break_ties - boolean, optional, default = false True - Die Vorhersage unterbricht die Verbindungen gemäß den Konfidenzwerten von entscheidungsfunktion False - Die Vorhersage gibt die erste Klasse unter den gebundenen Klassen zurück. |

Attribute

Die folgende Tabelle enthält die von verwendeten Attribute sklearn.svm.SVC Klasse -

| Sr.Nr. | Attribute & Beschreibung |

|---|---|

| 1 | support_ - Array-artig, Form = [n_SV] Es gibt die Indizes der Unterstützungsvektoren zurück. |

| 2 | support_vectors_ - Array-artig, Form = [n_SV, n_Features] Es gibt die Unterstützungsvektoren zurück. |

| 3 | n_support_ - Array-ähnlich, dtype = int32, shape = [n_class] Es repräsentiert die Anzahl der Unterstützungsvektoren für jede Klasse. |

| 4 | dual_coef_ - Array, Form = [n_Klasse-1, n_SV] Dies sind die Koeffizienten der Unterstützungsvektoren in der Entscheidungsfunktion. |

| 5 | coef_ - Array, Form = [n_Klasse * (n_Klasse-1) / 2, n_Funktionen] Dieses Attribut, das nur im Fall eines linearen Kernels verfügbar ist, gibt die den Features zugewiesene Gewichtung an. |

| 6 | intercept_ - Array, Form = [n_Klasse * (n_Klasse-1) / 2] Es repräsentiert den unabhängigen Term (Konstante) in der Entscheidungsfunktion. |

| 7 | fit_status_ - int Der Ausgang wäre 0, wenn er richtig sitzt. Der Ausgang wäre 1, wenn er falsch sitzt. |

| 8 | classes_ - Array of Shape = [n_Klassen] Es gibt die Bezeichnungen der Klassen. |

Implementation Example

Wie andere Klassifikatoren muss auch SVC mit den folgenden zwei Arrays ausgestattet werden:

Eine Anordnung XHalten der Trainingsmuster. Es hat die Größe [n_samples, n_features].

Eine Anordnung YHalten der Zielwerte, dh Klassenbezeichnungen für die Trainingsmuster. Es hat die Größe [n_samples].

Das folgende Python-Skript verwendet sklearn.svm.SVC Klasse -

import numpy as np

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

y = np.array([1, 1, 2, 2])

from sklearn.svm import SVC

SVCClf = SVC(kernel = 'linear',gamma = 'scale', shrinking = False,)

SVCClf.fit(X, y)Output

SVC(C = 1.0, cache_size = 200, class_weight = None, coef0 = 0.0,

decision_function_shape = 'ovr', degree = 3, gamma = 'scale', kernel = 'linear',

max_iter = -1, probability = False, random_state = None, shrinking = False,

tol = 0.001, verbose = False)Example

Sobald es angepasst ist, können wir den Gewichtsvektor mithilfe des folgenden Python-Skripts abrufen:

SVCClf.coef_Output

array([[0.5, 0.5]])Example

In ähnlicher Weise können wir den Wert anderer Attribute wie folgt ermitteln:

SVCClf.predict([[-0.5,-0.8]])Output

array([1])Example

SVCClf.n_support_Output

array([1, 1])Example

SVCClf.support_vectors_Output

array(

[

[-1., -1.],

[ 1., 1.]

]

)Example

SVCClf.support_Output

array([0, 2])Example

SVCClf.intercept_Output

array([-0.])Example

SVCClf.fit_status_Output

0NuSVC

NuSVC ist die Nu Support Vector Classification. Es ist eine weitere Klasse von scikit-learn, die eine Klassifizierung in mehreren Klassen durchführen kann. Es ist wie bei SVC, aber NuSVC akzeptiert leicht unterschiedliche Parametersätze. Der Parameter, der sich von SVC unterscheidet, ist wie folgt:

nu - float, optional, default = 0.5

Es repräsentiert eine Obergrenze für den Anteil der Trainingsfehler und eine Untergrenze für den Anteil der Unterstützungsvektoren. Sein Wert sollte im Intervall von (o, 1] liegen.

Die restlichen Parameter und Attribute sind dieselben wie bei SVC.

Implementierungsbeispiel

Wir können das gleiche Beispiel mit implementieren sklearn.svm.NuSVC Klasse auch.

import numpy as np

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]])

y = np.array([1, 1, 2, 2])

from sklearn.svm import NuSVC

NuSVCClf = NuSVC(kernel = 'linear',gamma = 'scale', shrinking = False,)

NuSVCClf.fit(X, y)Ausgabe

NuSVC(cache_size = 200, class_weight = None, coef0 = 0.0,

decision_function_shape = 'ovr', degree = 3, gamma = 'scale', kernel = 'linear',

max_iter = -1, nu = 0.5, probability = False, random_state = None,

shrinking = False, tol = 0.001, verbose = False)Wir können die Ausgaben der restlichen Attribute erhalten, wie dies im Fall von SVC der Fall war.

LinearSVC

Es handelt sich um eine lineare Unterstützungsvektorklassifizierung. Es ist ähnlich wie bei SVC mit Kernel = 'linear'. Der Unterschied zwischen ihnen ist dasLinearSVC implementiert in Bezug auf liblinear, während SVC in implementiert ist libsvm. Das ist der GrundLinearSVChat mehr Flexibilität bei der Auswahl von Strafen und Verlustfunktionen. Es skaliert auch besser auf eine große Anzahl von Proben.

Wenn wir über seine Parameter und Attribute sprechen, wird es nicht unterstützt ‘kernel’ weil angenommen wird, dass es linear ist und es auch einige der Attribute wie fehlt support_, support_vectors_, n_support_, fit_status_ und, dual_coef_.

Es unterstützt jedoch penalty und loss Parameter wie folgt -

penalty − string, L1 or L2(default = ‘L2’)

Dieser Parameter wird verwendet, um die Norm (L1 oder L2) anzugeben, die bei der Bestrafung (Regularisierung) verwendet wird.

loss − string, hinge, squared_hinge (default = squared_hinge)

Es stellt die Verlustfunktion dar, wobei 'Scharnier' der Standard-SVM-Verlust und 'squared_hinge' das Quadrat des Scharnierverlusts ist.

Implementierungsbeispiel

Das folgende Python-Skript verwendet sklearn.svm.LinearSVC Klasse -

from sklearn.svm import LinearSVC

from sklearn.datasets import make_classification

X, y = make_classification(n_features = 4, random_state = 0)

LSVCClf = LinearSVC(dual = False, random_state = 0, penalty = 'l1',tol = 1e-5)

LSVCClf.fit(X, y)Ausgabe

LinearSVC(C = 1.0, class_weight = None, dual = False, fit_intercept = True,

intercept_scaling = 1, loss = 'squared_hinge', max_iter = 1000,

multi_class = 'ovr', penalty = 'l1', random_state = 0, tol = 1e-05, verbose = 0)Beispiel

Nach der Anpassung kann das Modell neue Werte wie folgt vorhersagen:

LSVCClf.predict([[0,0,0,0]])Ausgabe

[1]Beispiel

Für das obige Beispiel können wir den Gewichtsvektor mit Hilfe des folgenden Python-Skripts erhalten -

LSVCClf.coef_Ausgabe

[[0. 0. 0.91214955 0.22630686]]Beispiel

In ähnlicher Weise können wir den Wert des Abfangens mithilfe des folgenden Python-Skripts ermitteln:

LSVCClf.intercept_Ausgabe

[0.26860518]Regression mit SVM

Wie bereits erwähnt, wird SVM sowohl für Klassifizierungs- als auch für Regressionsprobleme verwendet. Die Methode der Support Vector Classification (SVC) von Scikit-learn kann erweitert werden, um auch Regressionsprobleme zu lösen. Diese erweiterte Methode wird als Support Vector Regression (SVR) bezeichnet.

Grundlegende Ähnlichkeit zwischen SVM und SVR

Das von SVC erstellte Modell hängt nur von einer Teilmenge der Trainingsdaten ab. Warum? Da sich die Kostenfunktion für die Erstellung des Modells nicht um Trainingsdatenpunkte kümmert, die außerhalb des Spielraums liegen.

Das von SVR (Support Vector Regression) erstellte Modell hängt auch nur von einer Teilmenge der Trainingsdaten ab. Warum? Weil die Kostenfunktion zum Erstellen des Modells alle Trainingsdatenpunkte ignoriert, die nahe an der Modellvorhersage liegen.

Scikit-learn bietet nämlich drei Klassen SVR, NuSVR and LinearSVR als drei verschiedene Implementierungen von SVR.

SVR

Es ist die Epsilon-unterstützende Vektorregression, auf deren Implementierung basiert libsvm. Im Gegensatz zuSVC Es gibt nämlich zwei freie Parameter im Modell ‘C’ und ‘epsilon’.

epsilon - float, optional, default = 0.1

Es stellt das Epsilon im Epsilon-SVR-Modell dar und gibt die Epsilon-Röhre an, innerhalb derer in der Trainingsverlustfunktion keine Strafe mit Punkten verbunden ist, die innerhalb einer Entfernung von Epsilon vom tatsächlichen Wert vorhergesagt werden.

Die restlichen Parameter und Attribute sind ähnlich wie in SVC.

Implementierungsbeispiel

Das folgende Python-Skript verwendet sklearn.svm.SVR Klasse -

from sklearn import svm

X = [[1, 1], [2, 2]]

y = [1, 2]

SVRReg = svm.SVR(kernel = ’linear’, gamma = ’auto’)

SVRReg.fit(X, y)Ausgabe

SVR(C = 1.0, cache_size = 200, coef0 = 0.0, degree = 3, epsilon = 0.1, gamma = 'auto',

kernel = 'linear', max_iter = -1, shrinking = True, tol = 0.001, verbose = False)Beispiel

Sobald es angepasst ist, können wir den Gewichtsvektor mithilfe des folgenden Python-Skripts abrufen:

SVRReg.coef_Ausgabe

array([[0.4, 0.4]])Beispiel

In ähnlicher Weise können wir den Wert anderer Attribute wie folgt ermitteln:

SVRReg.predict([[1,1]])Ausgabe

array([1.1])In ähnlicher Weise können wir auch die Werte anderer Attribute abrufen.

NuSVR

NuSVR ist Nu Support Vector Regression. Es ist wie bei NuSVC, aber NuSVR verwendet einen Parameternuum die Anzahl der Unterstützungsvektoren zu steuern. Und im Gegensatz zu NuSVC wonu C-Parameter ersetzt, hier ersetzt epsilon.

Implementierungsbeispiel

Das folgende Python-Skript verwendet sklearn.svm.SVR Klasse -

from sklearn.svm import NuSVR

import numpy as np

n_samples, n_features = 20, 15

np.random.seed(0)

y = np.random.randn(n_samples)

X = np.random.randn(n_samples, n_features)

NuSVRReg = NuSVR(kernel = 'linear', gamma = 'auto',C = 1.0, nu = 0.1)^M

NuSVRReg.fit(X, y)Ausgabe

NuSVR(C = 1.0, cache_size = 200, coef0 = 0.0, degree = 3, gamma = 'auto',

kernel = 'linear', max_iter = -1, nu = 0.1, shrinking = True, tol = 0.001,

verbose = False)Beispiel

Sobald es angepasst ist, können wir den Gewichtsvektor mithilfe des folgenden Python-Skripts abrufen:

NuSVRReg.coef_Ausgabe

array(

[

[-0.14904483, 0.04596145, 0.22605216, -0.08125403, 0.06564533,

0.01104285, 0.04068767, 0.2918337 , -0.13473211, 0.36006765,

-0.2185713 , -0.31836476, -0.03048429, 0.16102126, -0.29317051]

]

)In ähnlicher Weise können wir auch den Wert anderer Attribute erhalten.

LinearSVR

Es ist eine lineare Unterstützungsvektorregression. Es ist ähnlich wie bei SVR mit Kernel = 'linear'. Der Unterschied zwischen ihnen ist dasLinearSVR implementiert in Bezug auf liblinear, während SVC implementiert in libsvm. Das ist der GrundLinearSVRhat mehr Flexibilität bei der Auswahl von Strafen und Verlustfunktionen. Es skaliert auch besser auf eine große Anzahl von Proben.

Wenn wir über seine Parameter und Attribute sprechen, wird es nicht unterstützt ‘kernel’ weil angenommen wird, dass es linear ist und es auch einige der Attribute wie fehlt support_, support_vectors_, n_support_, fit_status_ und, dual_coef_.

Es unterstützt jedoch 'Verlust'-Parameter wie folgt:

loss - string, optional, default = 'epsilon_insensitive'

Es stellt die Verlustfunktion dar, bei der epsilon_insensitiver Verlust der L1-Verlust und der quadratische epsilonunempfindliche Verlust der L2-Verlust ist.

Implementierungsbeispiel

Das folgende Python-Skript verwendet sklearn.svm.LinearSVR Klasse -

from sklearn.svm import LinearSVR

from sklearn.datasets import make_regression

X, y = make_regression(n_features = 4, random_state = 0)

LSVRReg = LinearSVR(dual = False, random_state = 0,

loss = 'squared_epsilon_insensitive',tol = 1e-5)

LSVRReg.fit(X, y)Ausgabe

LinearSVR(

C=1.0, dual=False, epsilon=0.0, fit_intercept=True,

intercept_scaling=1.0, loss='squared_epsilon_insensitive',

max_iter=1000, random_state=0, tol=1e-05, verbose=0

)Beispiel

Nach der Anpassung kann das Modell neue Werte wie folgt vorhersagen:

LSRReg.predict([[0,0,0,0]])Ausgabe

array([-0.01041416])Beispiel

Für das obige Beispiel können wir den Gewichtsvektor mit Hilfe des folgenden Python-Skripts erhalten -

LSRReg.coef_Ausgabe

array([20.47354746, 34.08619401, 67.23189022, 87.47017787])Beispiel

In ähnlicher Weise können wir den Wert des Abfangens mithilfe des folgenden Python-Skripts ermitteln:

LSRReg.intercept_Ausgabe

array([-0.01041416])Hier erfahren wir, was Anomalieerkennung in Sklearn ist und wie sie zur Identifizierung der Datenpunkte verwendet wird.

Die Erkennung von Anomalien ist eine Technik, mit der Datenpunkte im Datensatz identifiziert werden, die nicht gut mit den übrigen Daten übereinstimmen. Es hat viele geschäftliche Anwendungen wie Betrugserkennung, Intrusion Detection, Überwachung des Systemzustands, Überwachung und vorausschauende Wartung. Anomalien, die auch als Ausreißer bezeichnet werden, können in die folgenden drei Kategorien unterteilt werden:

Point anomalies - Es tritt auf, wenn eine einzelne Dateninstanz für den Rest der Daten als anomal angesehen wird.

Contextual anomalies- Eine solche Anomalie ist kontextspezifisch. Es tritt auf, wenn eine Dateninstanz in einem bestimmten Kontext anomal ist.

Collective anomalies - Dies tritt auf, wenn eine Sammlung verwandter Dateninstanzen für den gesamten Datensatz und nicht für einzelne Werte anomal ist.

Methoden

Zwei Methoden nämlich outlier detection und novelty detectionkann zur Erkennung von Anomalien verwendet werden. Es ist notwendig, den Unterschied zwischen ihnen zu sehen.

Ausreißererkennung

Die Trainingsdaten enthalten Ausreißer, die weit vom Rest der Daten entfernt sind. Solche Ausreißer werden als Beobachtungen definiert. Aus diesem Grund versuchen Ausreißererkennungsschätzer immer, die Region mit den konzentriertesten Trainingsdaten anzupassen, während sie die abweichenden Beobachtungen ignorieren. Es ist auch als unbeaufsichtigte Anomalieerkennung bekannt.

Neuheitserkennung

Es geht darum, bei neuen Beobachtungen ein unbeobachtetes Muster zu erkennen, das nicht in den Trainingsdaten enthalten ist. Hier werden die Trainingsdaten nicht durch die Ausreißer verschmutzt. Es ist auch als halbüberwachte Anomalieerkennung bekannt.

Es gibt eine Reihe von ML-Tools, die von scikit-learn bereitgestellt werden und sowohl zur Erkennung von Ausreißern als auch zur Erkennung von Neuheiten verwendet werden können. Diese Tools implementieren zunächst das Lernen von Objekten aus den Daten unbeaufsichtigt mithilfe der fit () -Methode wie folgt:

estimator.fit(X_train)Nun würden die neuen Beobachtungen wie folgt sortiert inliers (labeled 1) oder outliers (labeled -1) unter Verwendung der Predict () -Methode wie folgt:

estimator.fit(X_test)Der Schätzer berechnet zuerst die Rohbewertungsfunktion und dann sagt die Vorhersagemethode den Schwellenwert für diese Rohbewertungsfunktion her. Wir können mit Hilfe von auf diese Rohbewertungsfunktion zugreifenscore_sample Methode und kann den Schwellenwert durch steuern contamination Parameter.

Wir können auch definieren decision_function Methode, die Ausreißer als negativen Wert und Lieferanten als nicht negativen Wert definiert.

estimator.decision_function(X_test)Sklearn-Algorithmen zur Ausreißererkennung

Beginnen wir damit, zu verstehen, was eine elliptische Hülle ist.

Anbringen einer elliptischen Hülle

Dieser Algorithmus geht davon aus, dass reguläre Daten aus einer bekannten Verteilung wie der Gaußschen Verteilung stammen. Zur Erkennung von Ausreißern stellt Scikit-learn ein Objekt mit dem Namen bereitcovariance.EllipticEnvelop.

Dieses Objekt passt eine robuste Kovarianzschätzung an die Daten an und passt somit eine Ellipse an die zentralen Datenpunkte an. Die Punkte außerhalb des zentralen Modus werden ignoriert.

Parameter

Die folgende Tabelle enthält die von sklearn. covariance.EllipticEnvelop Methode -

| Sr.Nr. | Parameter & Beschreibung |

|---|---|

| 1 | store_precision - Boolean, optional, Standard = True Wir können es angeben, wenn die geschätzte Genauigkeit gespeichert ist. |

| 2 | assume_centered - Boolean, optional, Standard = False Wenn wir False setzen, werden der robuste Ort und die Kovarianz mithilfe des FastMCD-Algorithmus direkt berechnet. Wenn andererseits True festgelegt ist, wird die Unterstützung von robustem Standort und Kovarian berechnet. |

| 3 | support_fraction - float in (0., 1.), optional, default = None Dieser Parameter gibt der Methode an, wie viel Prozent der Punkte in die Unterstützung der rohen MCD-Schätzungen einbezogen werden sollen. |

| 4 | contamination - float in (0., 1.), optional, default = 0.1 Es gibt den Anteil der Ausreißer im Datensatz an. |

| 5 | random_state - int, RandomState-Instanz oder None, optional, default = none Dieser Parameter stellt den Startwert der erzeugten Pseudozufallszahl dar, die beim Mischen der Daten verwendet wird. Folgende sind die Optionen -

|

Attribute

Die folgende Tabelle enthält die von verwendeten Attribute sklearn. covariance.EllipticEnvelop Methode -

| Sr.Nr. | Attribute & Beschreibung |

|---|---|

| 1 | support_ - Array-ähnliche Form (n_samples,) Es stellt die Maske der Beobachtungen dar, die zur Berechnung robuster Schätzungen von Ort und Form verwendet werden. |

| 2 | location_ - Array-ähnliche Form (n_Features) Es gibt den geschätzten robusten Standort zurück. |