Uczenie maszynowe w Pythonie - szybki przewodnik

Żyjemy w „erze danych”, która jest wzbogacona o lepszą moc obliczeniową i większe zasoby pamięci masowej. Te dane lub informacje rosną z dnia na dzień, ale prawdziwym wyzwaniem jest nadanie sensu wszystkim danym. Firmy i organizacje próbują sobie z tym poradzić, budując inteligentne systemy, wykorzystując koncepcje i metodologie z nauki o danych, eksploracji danych i uczenia maszynowego. Wśród nich uczenie maszynowe to najbardziej ekscytująca dziedzina informatyki. Nie byłoby źle, gdybyśmy nazywali uczenie maszynowe zastosowaniem i nauką o algorytmach, które zapewniają sens danym.

Co to jest uczenie maszynowe?

Uczenie maszynowe (ML) to dziedzina informatyki, za pomocą której systemy komputerowe mogą nadawać sens danym w podobny sposób, jak robią to ludzie.

Mówiąc prościej, ML to rodzaj sztucznej inteligencji, która wyodrębnia wzorce z surowych danych za pomocą algorytmu lub metody. Głównym celem ML jest umożliwienie systemom komputerowym uczenia się na podstawie doświadczenia bez konieczności bezpośredniego programowania lub interwencji człowieka.

Potrzeba uczenia maszynowego

W tej chwili ludzie są najbardziej inteligentnymi i zaawansowanymi gatunkami na Ziemi, ponieważ potrafią myśleć, oceniać i rozwiązywać złożone problemy. Z drugiej strony sztuczna inteligencja jest wciąż na początkowym etapie i pod wieloma względami nie przewyższyła ludzkiej inteligencji. W takim razie pytanie brzmi, jaka jest potrzeba, aby maszyna się uczyła? Najbardziej odpowiednim powodem takiego działania jest „podejmowanie decyzji na podstawie danych, efektywnie i na skalę”.

Ostatnio organizacje intensywnie inwestują w nowsze technologie, takie jak sztuczna inteligencja, uczenie maszynowe i uczenie głębokie, aby uzyskać kluczowe informacje z danych, aby wykonać kilka rzeczywistych zadań i rozwiązać problemy. Możemy to nazwać decyzjami opartymi na danych, podejmowanymi przez maszyny, szczególnie w celu zautomatyzowania procesu. Te decyzje oparte na danych mogą być stosowane zamiast logiki programowania w przypadku problemów, których nie można zaprogramować z natury. Faktem jest, że nie możemy obejść się bez ludzkiej inteligencji, ale inny aspekt jest taki, że wszyscy musimy rozwiązywać rzeczywiste problemy z wydajnością na ogromną skalę. Dlatego pojawia się potrzeba uczenia maszynowego.

Dlaczego i kiedy uczynić maszyny?

Omówiliśmy już potrzebę uczenia maszynowego, ale pojawia się inne pytanie, w jakich scenariuszach musimy sprawić, by maszyna się uczyła? Może zaistnieć kilka okoliczności, w których potrzebujemy maszyn, aby efektywnie i na ogromną skalę podejmować decyzje oparte na danych. Poniżej przedstawiono niektóre z takich okoliczności, w których uczenie się maszyn byłoby bardziej efektywne -

Brak ludzkiej wiedzy

Pierwszy scenariusz, w którym chcemy, aby maszyna uczyła się i podejmowała decyzje oparte na danych, może być domeną, w której brakuje ludzkiej wiedzy. Przykładami mogą być nawigacje po nieznanych terytoriach lub planetach przestrzennych.

Dynamiczne scenariusze

Istnieje kilka scenariuszy, które mają charakter dynamiczny, tj. Zmieniają się w czasie. W przypadku takich scenariuszy i zachowań chcemy, aby maszyna uczyła się i podejmowała decyzje oparte na danych. Niektóre z przykładów mogą obejmować łączność sieciową i dostępność infrastruktury w organizacji.

Trudność w przełożeniu wiedzy specjalistycznej na zadania obliczeniowe

Mogą istnieć różne dziedziny, w których ludzie mają swoją wiedzę; jednak nie są w stanie przełożyć tej wiedzy na zadania obliczeniowe. W takich okolicznościach chcemy uczenia maszynowego. Przykładami mogą być domeny rozpoznawania mowy, zadań poznawczych itp.

Model uczenia maszynowego

Przed omówieniem modelu uczenia maszynowego musimy zrozumieć następującą formalną definicję ML podaną przez profesora Mitchella:

„Mówi się, że program komputerowy uczy się z doświadczenia E w odniesieniu do pewnej klasy zadań T i miary wydajności P, jeśli jego wydajność w zadaniach w T, mierzona przez P, poprawia się wraz z doświadczeniem E.”

Powyższa definicja koncentruje się w zasadzie na trzech parametrach, również głównych komponentach dowolnego algorytmu uczenia się, a mianowicie zadaniu (T), wydajności (P) i doświadczeniu (E). W tym kontekście możemy uprościć tę definicję, ponieważ -

ML to dziedzina sztucznej inteligencji polegająca na uczeniu się algorytmów, które -

Popraw ich wydajność (P)

Podczas wykonywania jakiegoś zadania (T)

Z biegiem czasu z doświadczeniem (E)

Na podstawie powyższego poniższy diagram przedstawia model uczenia maszynowego -

Omówmy je teraz bardziej szczegółowo -

Zadanie (T)

Z perspektywy problemu możemy zdefiniować zadanie T jako rzeczywisty problem do rozwiązania. Problemem może być znalezienie najlepszej ceny domu w określonej lokalizacji lub znalezienie najlepszej strategii marketingowej itp. Z drugiej strony, jeśli mówimy o uczeniu maszynowym, definicja zadania jest inna, ponieważ trudno jest rozwiązać zadania oparte na ML konwencjonalne podejście do programowania.

Mówi się, że zadanie T jest zadaniem opartym na ML, gdy jest oparte na procesie i system musi przestrzegać, aby operować na punktach danych. Przykłady zadań opartych na ML to klasyfikacja, regresja, ustrukturyzowane adnotacje, grupowanie, transkrypcja itp.

Doświadczenie (E)

Jak sama nazwa wskazuje, jest to wiedza uzyskana z punktów danych dostarczonych do algorytmu lub modelu. Po dostarczeniu z zestawem danych model będzie działał iteracyjnie i nauczy się pewnego nieodłącznego wzorca. Tak zdobyta wiedza nazywa się doświadczeniem (E). Dokonując analogii z ludzkim uczeniem się, możemy myśleć o tej sytuacji jako o tym, że człowiek uczy się lub uzyskuje pewne doświadczenie z różnych atrybutów, takich jak sytuacja, relacje itp. Uczenie się nadzorowane, nienadzorowane i wzmacniające to sposoby na zdobycie doświadczenia. Doświadczenie zdobyte dzięki naszemu modelowi lub algorytmowi ML posłuży do rozwiązania zadania T.

Wydajność (P)

Algorytm ML ma wykonywać zadania i zdobywać doświadczenie wraz z upływem czasu. Miarą, która mówi, czy algorytm ML działa zgodnie z oczekiwaniami, czy nie, jest jego wydajność (P). P jest w zasadzie miarą ilościową, która mówi, w jaki sposób model wykonuje zadanie, T, korzystając z jego doświadczenia, E.Istnieje wiele wskaźników, które pomagają zrozumieć wydajność ML, takie jak wynik dokładności, wynik F1, macierz pomyłki, precyzja, pamięć , wrażliwość itp.

Wyzwania w uczeniu się maszyn

Chociaż uczenie maszynowe szybko ewoluuje, robiąc znaczące postępy w zakresie cyberbezpieczeństwa i samochodów autonomicznych, ten segment sztucznej inteligencji jako całość wciąż ma przed sobą długą drogę. Powodem tego jest to, że ML nie był w stanie pokonać wielu wyzwań. Wyzwania, przed którymi stoi obecnie ML, to:

Quality of data- Posiadanie dobrej jakości danych dla algorytmów ML jest jednym z największych wyzwań. Korzystanie z danych niskiej jakości prowadzi do problemów związanych z przetwarzaniem wstępnym danych i ekstrakcją cech.

Time-Consuming task - Kolejnym wyzwaniem stojącym przed modelami ML jest czasochłonność, szczególnie na gromadzenie danych, wyodrębnianie cech i odzyskiwanie.

Lack of specialist persons - Ponieważ technologia ML jest wciąż w powijakach, dostępność zasobów eksperckich jest trudna.

No clear objective for formulating business problems - Brak jasnego celu i dobrze zdefiniowanego celu dla problemów biznesowych jest kolejnym kluczowym wyzwaniem dla ML, ponieważ ta technologia nie jest jeszcze tak dojrzała.

Issue of overfitting & underfitting - Jeśli model jest nadmiernie dopasowany lub niedopasowany, nie można go dobrze przedstawić dla problemu.

Curse of dimensionality- Kolejnym wyzwaniem, przed którym stoi model ML, jest zbyt wiele cech punktów danych. To może być prawdziwą przeszkodą.

Difficulty in deployment - Złożoność modelu ML sprawia, że jest on dość trudny do wdrożenia w prawdziwym życiu.

Zastosowania uczenia maszynowego

Uczenie maszynowe to najszybciej rozwijająca się technologia i według naukowców znajdujemy się w złotym roku AI i ML. Służy do rozwiązywania wielu złożonych problemów w świecie rzeczywistym, których nie można rozwiązać tradycyjnym podejściem. Oto kilka rzeczywistych zastosowań ML -

Analiza emocji

Analiza nastrojów

Wykrywanie i zapobieganie błędom

Prognozowanie i przewidywanie pogody

Analiza i prognozy giełdowe

Synteza mowy

Rozpoznawanie mowy

Segmentacja klientów

Rozpoznawanie obiektów

Wykrywanie oszustw

Zapobieganie oszustwom

Rekomendowanie produktów klientowi w zakupach online.

Wprowadzenie do Pythona

Python jest popularnym językiem programowania zorientowanym obiektowo, posiadającym możliwości języka programowania wysokiego poziomu. Łatwa do nauczenia się składnia i możliwość przenoszenia sprawiają, że jest obecnie popularny. Poniższe fakty stanowią wprowadzenie do Pythona -

Python został opracowany przez Guido van Rossuma w Stichting Mathematisch Centrum w Holandii.

Został napisany jako następca języka programowania o nazwie „ABC”.

Jego pierwsza wersja została wydana w 1991 roku.

Nazwa Python została wybrana przez Guido van Rossuma z programu telewizyjnego o nazwie Latający Cyrk Monty Pythona.

Jest to język programowania typu open source, co oznacza, że możemy go swobodnie pobierać i używać do tworzenia programów. Można go pobrać ze strony www.python.org .

Język programowania Python ma zarówno funkcje Java, jak i C. Ma elegancki kod „C”, az drugiej strony ma klasy i obiekty, takie jak Java do programowania obiektowego.

Jest to język interpretowany, co oznacza, że kod źródłowy programu w Pythonie byłby najpierw konwertowany na kod bajtowy, a następnie wykonywany przez maszynę wirtualną Pythona.

Mocne i słabe strony Pythona

Każdy język programowania ma swoje mocne i słabe strony, podobnie jak Python.

Silne strony

Według badań i ankiet Python jest piątym najważniejszym językiem, a także najpopularniejszym językiem do uczenia maszynowego i nauki o danych. Python ma następujące mocne strony -

Easy to learn and understand- Składnia Pythona jest prostsza; stąd też stosunkowo łatwo, nawet dla początkujących, nauczyć się i zrozumieć język.

Multi-purpose language - Python to uniwersalny język programowania, ponieważ obsługuje programowanie strukturalne, programowanie obiektowe, a także programowanie funkcjonalne.

Huge number of modules- Python ma ogromną liczbę modułów do pokrycia każdego aspektu programowania. Te moduły są łatwo dostępne do użycia, dzięki czemu Python jest językiem rozszerzalnym.

Support of open source community- Jako język programowania open source, Python jest obsługiwany przez bardzo dużą społeczność programistów. Z tego powodu błędy są łatwo naprawiane przez społeczność Pythona. Ta cecha sprawia, że Python jest bardzo solidny i adaptacyjny.

Scalability - Python jest skalowalnym językiem programowania, ponieważ zapewnia ulepszoną strukturę do obsługi dużych programów niż skrypty powłoki.

Słabość

Chociaż Python jest popularnym i potężnym językiem programowania, ma swoją słabość polegającą na powolnej szybkości wykonywania.

Szybkość wykonywania Pythona jest wolna w porównaniu z językami kompilowanymi, ponieważ Python jest językiem interpretowanym. Może to być główny obszar ulepszeń dla społeczności Pythona.

Instalowanie Pythona

Aby pracować w Pythonie, musimy go najpierw zainstalować. Możesz przeprowadzić instalację Pythona na jeden z następujących dwóch sposobów -

Instalowanie Pythona indywidualnie

Używanie wstępnie spakowanej dystrybucji Pythona - Anaconda

Omówmy je szczegółowo.

Instalowanie Pythona pojedynczo

Jeśli chcesz zainstalować Pythona na swoim komputerze, musisz pobrać tylko kod binarny odpowiedni dla Twojej platformy. Dystrybucja Pythona jest dostępna na platformy Windows, Linux i Mac.

Poniżej znajduje się krótkie omówienie instalacji Pythona na wyżej wymienionych platformach -

On Unix and Linux platform

Wykonując następujące kroki, możemy zainstalować Python na platformie Unix i Linux -

Najpierw przejdź do https://www.python.org/downloads/.

Następnie kliknij łącze, aby pobrać spakowany kod źródłowy dostępny dla systemów Unix / Linux.

Teraz pobierz i wyodrębnij pliki.

Następnie możemy edytować plik Modules / Setup, jeśli chcemy dostosować niektóre opcje.

Następnie napisz polecenie run ./configure script

make

dokonać instalacji

On Windows platform

Wykonując następujące kroki, możemy zainstalować Pythona na platformie Windows -

Najpierw przejdź do https://www.python.org/downloads/.

Następnie kliknij łącze do pliku instalatora Windows python-XYZ.msi. Tutaj XYZ to wersja, którą chcemy zainstalować.

Teraz musimy uruchomić pobrany plik. To przeniesie nas do kreatora instalacji Pythona, który jest łatwy w użyciu. Teraz zaakceptuj ustawienia domyślne i poczekaj, aż instalacja się zakończy.

On Macintosh platform

Dla Mac OS X, Homebrew, świetny i łatwy w użyciu instalator pakietów jest zalecany do zainstalowania Pythona 3. W przypadku, gdy nie masz Homebrew, możesz go zainstalować za pomocą następującego polecenia -

$ ruby -e "$(curl -fsSL

https://raw.githubusercontent.com/Homebrew/install/master/install)"Można go zaktualizować za pomocą poniższego polecenia -

$ brew updateTeraz, aby zainstalować Python3 w twoim systemie, musimy uruchomić następujące polecenie -

$ brew install python3Używanie wstępnie spakowanej dystrybucji języka Python: Anaconda

Anaconda to spakowana kompilacja Pythona, która zawiera wszystkie biblioteki szeroko używane w nauce o danych. Możemy wykonać następujące kroki, aby skonfigurować środowisko Python za pomocą Anacondy -

Step1- Najpierw musimy pobrać wymagany pakiet instalacyjny z dystrybucji Anaconda. Link do tego samego tohttps://www.anaconda.com/distribution/. Możesz wybrać system operacyjny Windows, Mac i Linux zgodnie z wymaganiami.

Step2- Następnie wybierz wersję Pythona, którą chcesz zainstalować na swoim komputerze. Najnowsza wersja Pythona to 3.7. Tam znajdziesz opcje zarówno dla 64-bitowego, jak i 32-bitowego instalatora graficznego.

Step3- Po wybraniu wersji systemu operacyjnego i Pythona, pobierze instalator Anaconda na twój komputer. Teraz kliknij dwukrotnie plik, a instalator zainstaluje pakiet Anaconda.

Step4 - Aby sprawdzić, czy jest zainstalowany, czy nie, otwórz wiersz polecenia i wpisz Python w następujący sposób -

Możesz to również sprawdzić w szczegółowym wykładzie wideo pod adresemhttps://www.tutorialspoint.com/python_essentials_online_training/getting_started_with_anaconda.asp.

Dlaczego Python do nauki o danych?

Python jest piątym najważniejszym językiem, a także najpopularniejszym językiem do uczenia maszynowego i nauki o danych. Oto cechy Pythona, które sprawiają, że jest to preferowany język do nauki o danych -

Bogaty zestaw pakietów

Python ma obszerny i potężny zestaw pakietów, które są gotowe do użycia w różnych domenach. Posiada również pakiety takie jak numpy, scipy, pandas, scikit-learn itp., Które są wymagane do uczenia maszynowego i nauki o danych.

Łatwe prototypowanie

Inną ważną cechą Pythona, która sprawia, że jest to język do nauki o danych, jest łatwe i szybkie prototypowanie. Ta funkcja jest przydatna przy opracowywaniu nowego algorytmu.

Funkcja współpracy

Dziedzina nauki o danych zasadniczo wymaga dobrej współpracy, a Python zapewnia wiele przydatnych narzędzi, które sprawiają, że jest to wyjątkowo.

Jeden język dla wielu dziedzin

Typowy projekt data science obejmuje różne dziedziny, takie jak ekstrakcja danych, manipulacja danymi, analiza danych, wyodrębnianie cech, modelowanie, ocena, wdrażanie i aktualizacja rozwiązania. Ponieważ Python jest językiem wielofunkcyjnym, umożliwia analitykom danych dotarcie do wszystkich tych domen z poziomu wspólnej platformy.

Komponenty ekosystemu Python ML

W tej sekcji omówimy kilka podstawowych bibliotek Data Science, które tworzą składniki ekosystemu uczenia maszynowego Python. Te przydatne komponenty sprawiają, że Python jest ważnym językiem dla nauki o danych. Chociaż istnieje wiele takich komponentów, omówmy tutaj niektóre z ważnych składników ekosystemu Pythona -

Notatnik Jupyter

Notebooki Jupyter zasadniczo zapewniają interaktywne środowisko obliczeniowe do tworzenia aplikacji do nauki danych opartych na języku Python. Wcześniej były znane jako notatniki ipython. Oto niektóre cechy notebooków Jupyter, które sprawiają, że jest to jeden z najlepszych elementów ekosystemu Python ML -

Notatniki Jupyter mogą zilustrować proces analizy krok po kroku, układając elementy, takie jak kod, obrazy, tekst, dane wyjściowe itp., Krok po kroku.

Pomaga analitykowi danych dokumentować proces myślowy podczas opracowywania procesu analizy.

Wynik można również uchwycić jako część zeszytu.

Za pomocą notatników jupyter możemy również dzielić się naszą pracą z rówieśnikami.

Instalacja i wykonanie

Jeśli używasz dystrybucji Anaconda, nie musisz oddzielnie instalować notebooka jupyter, ponieważ jest już z nim zainstalowany. Wystarczy przejść do polecenia Anaconda i wpisać następujące polecenie -

C:\>jupyter notebookPo naciśnięciu klawisza Enter uruchomi serwer notebooka pod adresem localhost: 8888 twojego komputera. Jest to pokazane na poniższym zrzucie ekranu -

Teraz po kliknięciu zakładki Nowa pojawi się lista opcji. Wybierz Python 3, a zostaniesz przeniesiony do nowego notatnika, aby rozpocząć z nim pracę. Zobaczysz to na poniższych zrzutach ekranu -

Z drugiej strony, jeśli używasz standardowej dystrybucji Pythona, notebook jupyter można zainstalować za pomocą popularnego instalatora pakietów Pythona, pip.

pip install jupyterRodzaje komórek w notatniku Jupyter

Poniżej przedstawiono trzy typy komórek w notebooku jupyter -

Code cells- Jak sama nazwa wskazuje, możemy użyć tych komórek do napisania kodu. Po zapisaniu kodu / treści prześle je do jądra, które jest powiązane z notatnikiem.

Markdown cells- Możemy użyć tych komórek do zapisu procesu obliczeniowego. Mogą zawierać takie rzeczy, jak tekst, obrazy, równania Latex, tagi HTML itp.

Raw cells- Tekst w nich wpisany jest wyświetlany tak, jak jest. Te komórki są w zasadzie używane do dodawania tekstu, którego nie chcemy konwertować przez mechanizm automatycznej konwersji notatnika jupyter.

Aby uzyskać bardziej szczegółowe badanie notatnika jupyter, możesz przejść do linkuhttps://www.tutorialspoint.com/jupyter/index.htm.

NumPy

Jest to kolejny przydatny komponent, dzięki któremu Python jest jednym z ulubionych języków Data Science. Zasadniczo oznacza Numerical Python i składa się z wielowymiarowych obiektów tablicowych. Korzystając z NumPy, możemy wykonać następujące ważne operacje -

Operacje matematyczne i logiczne na tablicach.

Transformacja Fouriera

Działania związane z algebrą liniową.

Widzimy również NumPy jako zamiennik MatLab, ponieważ NumPy jest używany głównie wraz z Scipy (Scientific Python) i Mat-plotlib (biblioteka kreśląca).

Installation and Execution

Jeśli używasz dystrybucji Anaconda, nie musisz oddzielnie instalować NumPy, ponieważ jest już z nią zainstalowany. Wystarczy zaimportować pakiet do skryptu Pythona za pomocą następujących czynności -

import numpy as npZ drugiej strony, jeśli używasz standardowej dystrybucji Pythona, NumPy można zainstalować za pomocą popularnego instalatora pakietów Pythona, pip.

pip install NumPyAby uzyskać bardziej szczegółowe badanie NumPy, możesz przejść do linkuhttps://www.tutorialspoint.com/numpy/index.htm.

Pandy

Jest to kolejna użyteczna biblioteka Pythona, dzięki której Python jest jednym z ulubionych języków nauki o danych. Pandy są zasadniczo używane do manipulacji danymi, sprzeciwiania się i analizy. Został opracowany przez Wesa McKinneya w 2008 roku. Z pomocą Pandy w przetwarzaniu danych możemy wykonać następujące pięć kroków -

Load

Prepare

Manipulate

Model

Analyze

Reprezentacja danych w Pandach

Cała reprezentacja danych w Pandas odbywa się za pomocą następujących trzech struktur danych -

Series- Jest to w zasadzie jednowymiarowa tablica ndarray z etykietą osi, co oznacza, że przypomina prostą tablicę z jednorodnymi danymi. Na przykład poniższa seria to zbiór liczb całkowitych 1,5,10,15,24,25…

| 1 | 5 | 10 | 15 | 24 | 25 | 28 | 36 | 40 | 89 |

Data frame- Jest to najbardziej użyteczna struktura danych i używana do prawie wszystkich rodzajów reprezentacji danych i manipulacji na pandach. Zasadniczo jest to dwuwymiarowa struktura danych, która może zawierać dane heterogeniczne. Ogólnie dane tabelaryczne są reprezentowane za pomocą ramek danych. Na przykład poniższa tabela pokazuje dane uczniów posiadających ich imiona i numery rolek, wiek i płeć -

Nazwa |

Numer rolki |

Wiek |

Płeć |

|---|---|---|---|

Aarav |

1 |

15 |

Męski |

Ostre |

2 |

14 |

Męski |

Kanika |

3 |

16 |

Płeć żeńska |

Mayank |

4 |

15 |

Męski |

Panel- Jest to trójwymiarowa struktura danych zawierająca dane heterogeniczne. Przedstawienie panelu w formie graficznej jest bardzo trudne, ale można go zilustrować jako kontener DataFrame.

Poniższa tabela przedstawia wymiary i opis wyżej wymienionych struktur danych używanych w Pandach -

Struktura danych |

Wymiar |

Opis |

|---|---|---|

Seria |

1-D |

Niezmienne wielkości, jednorodne dane 1-D |

DataFrames |

2-D |

Zmienne wielkości, heterogeniczne dane w formie tabelarycznej |

Płyta |

3-D |

Tablica z możliwością zmiany rozmiaru, kontener DataFrame. |

Możemy zrozumieć te struktury danych, ponieważ struktura danych o wyższych wymiarach jest pojemnikiem struktury danych o niższych wymiarach.

Instalacja i wykonanie

Jeśli używasz dystrybucji Anaconda, nie musisz instalować osobno Pandy, ponieważ jest już z nią zainstalowana. Wystarczy zaimportować pakiet do skryptu Pythona za pomocą następujących czynności -

import pandas as pdZ drugiej strony, jeśli używasz standardowej dystrybucji Pythona, Pandy można zainstalować za pomocą popularnego instalatora pakietów Pythona, pip.

pip install PandasPo zainstalowaniu Pandy możesz zaimportować go do swojego skryptu Python, tak jak powyżej.

Przykład

Poniżej znajduje się przykład tworzenia serii z ndarray przy użyciu Pandy -

In [1]: import pandas as pd

In [2]: import numpy as np

In [3]: data = np.array(['g','a','u','r','a','v'])

In [4]: s = pd.Series(data)

In [5]: print (s)

0 g

1 a

2 u

3 r

4 a

5 v

dtype: objectAby uzyskać bardziej szczegółowe badanie Pand, możesz przejść do linku https://www.tutorialspoint.com/python_pandas/index.htm.

Scikit-learn

Inną przydatną i najważniejszą biblioteką Pythona do nauki o danych i uczenia maszynowego w Pythonie jest Scikit-learn. Oto niektóre funkcje Scikit-Learn, które sprawiają, że jest tak przydatny -

Jest zbudowany na NumPy, SciPy i Matplotlib.

Jest to oprogramowanie typu open source i może być ponownie użyte na licencji BSD.

Jest dostępny dla każdego i można go ponownie wykorzystać w różnych kontekstach.

Za jego pomocą można zaimplementować szeroką gamę algorytmów uczenia maszynowego obejmujących główne obszary ML, takie jak klasyfikacja, grupowanie, regresja, redukcja wymiarowości, wybór modelu itp.

Instalacja i wykonanie

Jeśli używasz dystrybucji Anaconda, nie musisz oddzielnie instalować Scikit-learn, ponieważ jest już z nią zainstalowany. Wystarczy, że użyjesz pakietu w swoim skrypcie w Pythonie. Na przykład za pomocą następującego wiersza skryptu importujemy zbiór danych pacjentów z rakiem piersi zScikit-learn -

from sklearn.datasets import load_breast_cancerZ drugiej strony, jeśli używasz standardowej dystrybucji Pythona i masz NumPy i SciPy, Scikit-learn można zainstalować za pomocą popularnego instalatora pakietów Pythona, pip.

pip install -U scikit-learnPo zainstalowaniu Scikit-learn możesz użyć go w swoim skrypcie Pythona, tak jak to zrobiłeś powyżej.

Istnieją różne algorytmy, techniki i metody ML, które można wykorzystać do tworzenia modeli rozwiązywania rzeczywistych problemów przy użyciu danych. W tym rozdziale omówimy różne rodzaje metod.

Różne rodzaje metod

Poniżej przedstawiono różne metody ML oparte na niektórych szerokich kategoriach -

Na podstawie nadzoru człowieka

W procesie uczenia się niektóre metody oparte na nadzorze człowieka są następujące:

Supervised Learning

Algorytmy lub metody uczenia nadzorowanego są najczęściej używanymi algorytmami ML. Ta metoda lub algorytm uczenia się pobiera próbkę danych, tj. Dane uczące i powiązane z nimi dane wyjściowe, tj. Etykiety lub odpowiedzi z każdą próbką danych podczas procesu uczenia.

Głównym celem algorytmów uczenia nadzorowanego jest poznanie powiązań między próbkami danych wejściowych a odpowiadającymi im wynikami po wykonaniu wielu instancji danych szkoleniowych.

Na przykład mamy

x: zmienne wejściowe i

Y: zmienna wyjściowa

Teraz zastosuj algorytm, aby nauczyć się funkcji mapowania z wejścia do wyjścia w następujący sposób -

Y = f (x)

Teraz głównym celem byłoby tak dokładne przybliżenie funkcji mapowania, że nawet mając nowe dane wejściowe (x), możemy łatwo przewidzieć zmienną wyjściową (Y) dla tych nowych danych wejściowych.

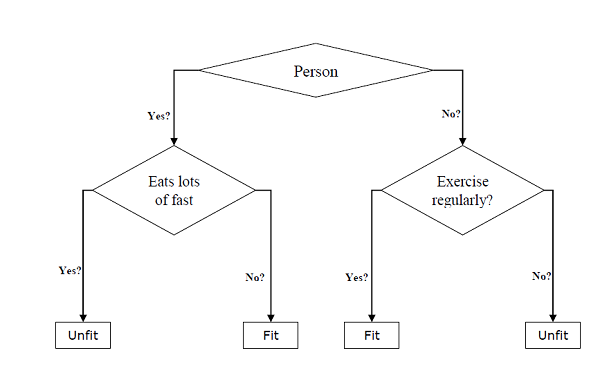

Nazywa się to nadzorowanym, ponieważ cały proces uczenia się można myśleć tak, jak jest nadzorowany przez nauczyciela lub superwizora. Przykłady nadzorowanych algorytmów uczenia maszynowego obejmująDecision tree, Random Forest, KNN, Logistic Regression itp.

Na podstawie zadań ML, nadzorowane algorytmy uczenia się można podzielić na dwie szerokie klasy -

Classification

Regression

Classification

Głównym celem zadań opartych na klasyfikacji jest przewidywanie kategorialnych etykiet wyjściowych lub odpowiedzi dla danych wejściowych. Wynik będzie oparty na tym, czego model nauczył się w fazie szkolenia. Ponieważ wiemy, że kategorialne odpowiedzi wyjściowe oznaczają nieuporządkowane i dyskretne wartości, stąd każda odpowiedź wyjściowa będzie należeć do określonej klasy lub kategorii. W kolejnych rozdziałach szczegółowo omówimy klasyfikację i powiązane z nią algorytmy.

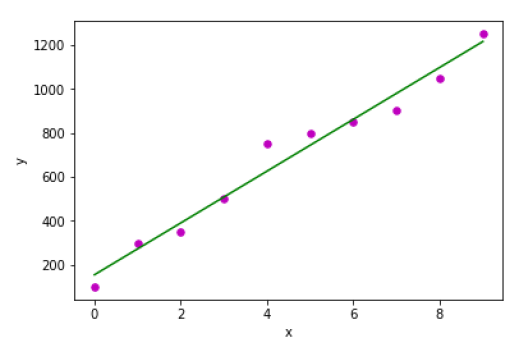

Regression

Głównym celem zadań opartych na regresji jest przewidywanie etykiet wyjściowych lub odpowiedzi, które są ciągłymi wartościami liczbowymi dla danych wejściowych. Wynik będzie oparty na tym, czego model nauczył się w fazie szkolenia. Zasadniczo modele regresji wykorzystują cechy danych wejściowych (zmienne niezależne) i odpowiadające im ciągłe liczbowe wartości wyjściowe (zmienne zależne lub wynikowe), aby nauczyć się określonego związku między danymi wejściowymi a odpowiadającymi im wynikami. W dalszych rozdziałach omówimy szczegółowo regresję i powiązane z nią algorytmy.

Uczenie się bez nadzoru

Jak sama nazwa wskazuje, jest odwrotnie do nadzorowanych metod lub algorytmów ML, co oznacza, że w algorytmach uczenia maszynowego bez nadzoru nie mamy żadnego nadzorcy, który mógłby udzielać jakichkolwiek wskazówek. Algorytmy uczenia bez nadzoru są przydatne w scenariuszu, w którym nie mamy wolności, jak w przypadku algorytmów uczenia nadzorowanego, posiadania wstępnie oznaczonych danych szkoleniowych i chcemy wydobyć przydatny wzorzec z danych wejściowych.

Na przykład można to rozumieć w następujący sposób -

Załóżmy, że mamy -

x: Input variables, wtedy nie byłoby odpowiedniej zmiennej wyjściowej, a algorytmy musiałyby odkryć interesujący wzorzec w danych do uczenia się.

Przykłady nienadzorowanych algorytmów uczenia maszynowego obejmują grupowanie K-średnich, K-nearest neighbors itp.

Na podstawie zadań ML, nienadzorowane algorytmy uczenia się można podzielić na następujące szerokie klasy -

Clustering

Association

Redukcja wymiarowości

Clustering

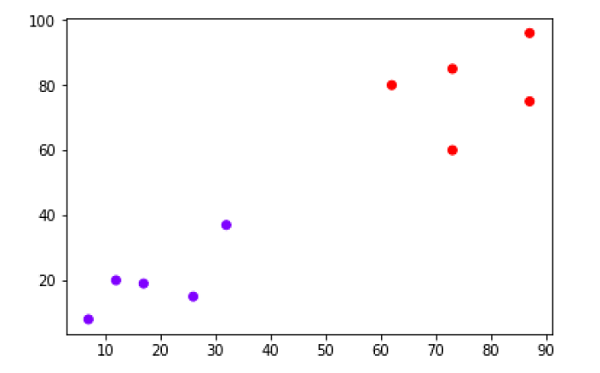

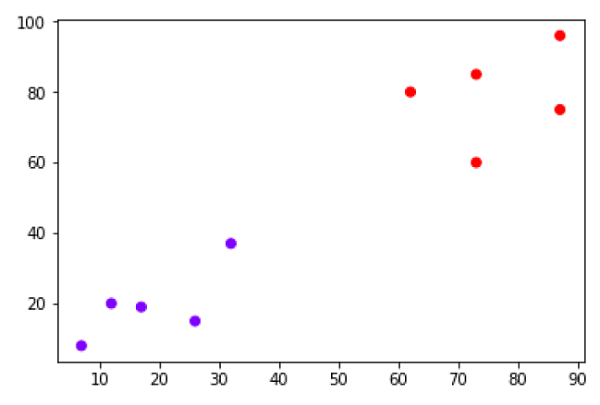

Metody klastrowania są jednymi z najbardziej użytecznych nienadzorowanych metod ML. Algorytmy te służyły do znajdowania podobieństw i wzorców relacji między próbkami danych, a następnie grupowania tych próbek w grupy o podobieństwie na podstawie cech. Rzeczywistym przykładem tworzenia klastrów jest grupowanie klientów według ich zachowań zakupowych.

Association

Inną użyteczną metodą ML bez nadzoru jest Associationktóry jest używany do analizy dużego zbioru danych w celu znalezienia wzorców, które dodatkowo reprezentują interesujące relacje między różnymi elementami. Jest również określany jakoAssociation Rule Mining lub Market basket analysis który służy głównie do analizy zachowań zakupowych klientów.

Dimensionality Reduction

Ta nienadzorowana metoda ML służy do zmniejszania liczby zmiennych cech dla każdej próbki danych poprzez wybór zestawu cech głównych lub reprezentatywnych. Powstaje tutaj pytanie, dlaczego musimy zmniejszyć wymiarowość? Przyczyną tego jest problem złożoności przestrzeni cech, który pojawia się, gdy zaczynamy analizować i wyodrębniać miliony cech z próbek danych. Ten problem ogólnie odnosi się do „przekleństwa wymiarowości”. PCA (Principal Component Analysis), K-najbliższych sąsiadów i analiza dyskryminacyjna to tylko niektóre z popularnych algorytmów służących do tego celu.

Anomaly Detection

Ta nienadzorowana metoda ML jest używana do wykrywania rzadkich zdarzeń lub obserwacji, które na ogół nie występują. Wykorzystując zdobytą wiedzę, metody wykrywania anomalii umożliwiłyby rozróżnienie między anomalnym a normalnym punktem danych. Niektóre nienadzorowane algorytmy, takie jak grupowanie, KNN mogą wykrywać anomalie na podstawie danych i ich cech.

Nauka częściowo nadzorowana

Tego rodzaju algorytmy lub metody nie są ani w pełni nadzorowane, ani całkowicie nienadzorowane. Zasadniczo mieszczą się między tymi dwoma, tj. Metodami uczenia się pod nadzorem i bez nadzoru. Tego rodzaju algorytmy generalnie wykorzystują mały nadzorowany komponent uczenia się, tj. Niewielką ilość wstępnie oznaczonych danych z adnotacjami i duży nienadzorowany komponent uczenia się, tj. Wiele nieoznaczonych danych do szkolenia. Możemy zastosować dowolne z następujących podejść do wdrażania częściowo nadzorowanych metod uczenia się -

Pierwszym i prostym podejściem jest zbudowanie nadzorowanego modelu w oparciu o niewielką ilość oznaczonych i opatrzonych adnotacjami danych, a następnie zbudowanie modelu bez nadzoru poprzez zastosowanie tego samego do dużych ilości nieoznakowanych danych, aby uzyskać więcej oznaczonych próbek. Teraz wytrenuj na nich model i powtórz proces.

- , p> Drugie podejście wymaga dodatkowych wysiłków. W tym podejściu możemy najpierw użyć metod nienadzorowanych, aby skupić podobne próbki danych, opisać te grupy, a następnie użyć kombinacji tych informacji do wytrenowania modelu.

Uczenie się ze wzmocnieniem

Metody te różnią się od dotychczas badanych i są również bardzo rzadko stosowane. W tego rodzaju algorytmach uczenia się byłby agent, którego chcielibyśmy wyszkolić przez pewien okres czasu, aby mógł wchodzić w interakcje z określonym środowiskiem. Agent będzie postępował zgodnie z zestawem strategii interakcji z otoczeniem, a następnie po obserwacji otoczenia podejmie działania dotyczące aktualnego stanu środowiska. Poniżej przedstawiono główne etapy metod uczenia się ze wzmocnieniem -

Step1 - Najpierw musimy przygotować agenta z pewnym wstępnym zestawem strategii.

Step2 - Następnie obserwuj otoczenie i jego aktualny stan.

Step3 - Następnie wybierz optymalną politykę względem aktualnego stanu środowiska i wykonaj ważne działania.

Step4 - Teraz agent może otrzymać odpowiednią nagrodę lub karę, zgodnie z działaniem podjętym przez niego w poprzednim kroku.

Step5 - Teraz możemy zaktualizować strategie, jeśli jest to wymagane.

Step6 - Na koniec powtarzaj kroki 2-5, aż agent nauczy się i zastosuje optymalne zasady.

Zadania odpowiednie do uczenia maszynowego

Poniższy diagram pokazuje, jaki typ zadania jest odpowiedni dla różnych problemów ML -

Oparte na zdolności uczenia się

W procesie uczenia się są następujące metody oparte na zdolności uczenia się -

Batch Learning

W wielu przypadkach mamy kompleksowe systemy Machine Learning, w których musimy trenować model za jednym razem, wykorzystując całe dostępne dane szkoleniowe. Taka metoda uczenia się lub algorytm to tzwBatch or Offline learning. Nazywa się to uczeniem wsadowym lub offline, ponieważ jest to procedura jednorazowa, a model będzie szkolony z danymi w jednej partii. Poniżej przedstawiono główne kroki metod uczenia wsadowego -

Step1 - Najpierw musimy zebrać wszystkie dane treningowe, aby rozpocząć trenowanie modelu.

Step2 - Teraz rozpocznij uczenie modelu, dostarczając pełne dane szkoleniowe za jednym razem.

Step3 - Następnie zakończ proces uczenia się / treningu po uzyskaniu zadowalających wyników / osiągnięć.

Step4- Na koniec wdróż wyszkolony model do produkcji. Tutaj będzie przewidywać wynik dla nowej próbki danych.

Nauka online

Jest to zupełnie odwrotne do metod uczenia się w trybie wsadowym lub offline. W tych metodach uczenia dane szkoleniowe są dostarczane do algorytmu w wielu przyrostowych partiach, zwanych minipartiami. Oto główne kroki metod uczenia się online -

Step1 - Najpierw musimy zebrać wszystkie dane treningowe, aby rozpocząć uczenie modelu.

Step2 - Teraz rozpocznij uczenie modelu, dostarczając mini partię danych uczących do algorytmu.

Step3 - Następnie musimy dostarczyć do algorytmu mini-partie danych szkoleniowych w wielu przyrostach.

Step4 - Ponieważ nie zatrzyma się jak uczenie wsadowe, a więc po dostarczeniu całych danych szkoleniowych w minisadach, należy również dostarczyć nowe próbki danych.

Step5 - Wreszcie będzie się uczyć przez pewien czas w oparciu o nowe próbki danych.

Oparte na podejściu uogólniającym

W procesie uczenia się poniżej przedstawiono niektóre metody oparte na podejściu uogólniającym -

Uczenie się oparte na instancjach

Metoda uczenia się oparta na instancjach jest jedną z przydatnych metod służących do budowania modeli ML poprzez generalizację na podstawie danych wejściowych. Jest to przeciwieństwo wcześniej badanych metod uczenia się, ponieważ ten rodzaj uczenia się obejmuje systemy ML, a także metody, które wykorzystują same surowe punkty danych do rysowania wyników dla nowszych próbek danych bez budowania wyraźnego modelu na danych szkoleniowych.

Mówiąc prościej, uczenie się oparte na instancjach zasadniczo zaczyna działać od spojrzenia na punkty danych wejściowych, a następnie przy użyciu miernika podobieństwa uogólni i przewiduje nowe punkty danych.

Uczenie się oparte na modelach

W metodach uczenia się opartych na modelu proces iteracyjny odbywa się na modelach ML, które są zbudowane na podstawie różnych parametrów modelu, zwanych hiperparametrami, w których dane wejściowe są używane do wyodrębniania cech. Podczas tego uczenia hiperparametry są optymalizowane w oparciu o różne techniki walidacji modeli. Dlatego możemy powiedzieć, że metody uczenia się oparte na modelu wykorzystują bardziej tradycyjne podejście ML do generalizacji.

Załóżmy, że jeśli chcesz rozpocząć projekt ML, to jaka jest pierwsza i najważniejsza rzecz, której byś potrzebował? Są to dane, które musimy załadować, aby rozpocząć dowolny projekt ML. Jeśli chodzi o dane, najpopularniejszym formatem danych w projektach ML jest CSV (wartości oddzielone przecinkami).

Zasadniczo CSV to prosty format pliku, który służy do przechowywania danych tabelarycznych (liczb i tekstu), takich jak arkusz kalkulacyjny w postaci zwykłego tekstu. W Pythonie możemy ładować dane CSV na różne sposoby, ale przed załadowaniem danych CSV musimy zadbać o kilka kwestii.

Rozważanie podczas ładowania danych CSV

Format danych CSV jest najpopularniejszym formatem danych ML, ale musimy zadbać o przestrzeganie głównych kwestii podczas ładowania tego samego do naszych projektów ML -

Nagłówek pliku

W plikach danych CSV nagłówek zawiera informacje dla każdego pola. Musimy użyć tego samego separatora dla pliku nagłówkowego i dla pliku danych, ponieważ to plik nagłówkowy określa, w jaki sposób należy interpretować pola danych.

Poniżej znajdują się dwa przypadki związane z nagłówkiem pliku CSV, które należy wziąć pod uwagę -

Case-I: When Data file is having a file header - Automatycznie przypisze nazwy do każdej kolumny danych, jeśli plik danych ma nagłówek pliku.

Case-II: When Data file is not having a file header - Musimy ręcznie przypisać nazwy do każdej kolumny danych, jeśli plik danych nie ma nagłówka pliku.

W obu przypadkach musimy wyraźnie określić, czy nasz plik CSV zawiera nagłówek, czy nie.

Komentarze

Komentarze w dowolnym pliku danych mają swoje znaczenie. W pliku danych CSV komentarze są oznaczone krzyżykiem (#) na początku wiersza. Musimy wziąć pod uwagę komentarze podczas ładowania danych CSV do projektów ML, ponieważ jeśli mamy komentarze w pliku, być może będziemy musieli wskazać, zależy od metody, którą wybierzemy do załadowania, czy oczekiwać tych komentarzy, czy nie.

Separator

W plikach danych CSV przecinek (,) jest standardowym separatorem. Rolą separatora jest oddzielenie wartości w polach. Ważne jest, aby wziąć pod uwagę rolę separatora podczas przesyłania pliku CSV do projektów ML, ponieważ możemy również użyć innego separatora, takiego jak tabulator lub spacja. Ale w przypadku użycia innego separatora niż standardowy, musimy go wyraźnie określić.

cytaty

W plikach danych CSV domyślnym cudzysłowem jest znak podwójnego cudzysłowu („”). Ważne jest, aby wziąć pod uwagę rolę cudzysłowów podczas przesyłania pliku CSV do projektów ML, ponieważ możemy również użyć innego znaku cudzysłowu niż podwójny cudzysłów. Ale w przypadku użycia innego znaku cudzysłowu niż standardowy, musimy to wyraźnie określić.

Metody ładowania pliku danych CSV

Podczas pracy z projektami ML najważniejszym zadaniem jest prawidłowe załadowanie do niego danych. Najpopularniejszym formatem danych w projektach ML jest CSV, który ma różne smaki i różne trudności w analizie. W tej sekcji omówimy trzy typowe podejścia w Pythonie do ładowania pliku danych CSV -

Załaduj plik CSV za pomocą biblioteki standardowej Python

Pierwszym i najczęściej używanym podejściem do załadowania pliku danych CSV jest użycie standardowej biblioteki Python, która zapewnia nam różnorodne wbudowane moduły, a mianowicie moduł csv i funkcję reader (). Poniżej znajduje się przykład ładowania pliku danych CSV za jego pomocą -

Przykład

W tym przykładzie używamy zestawu danych kwiatu tęczówki, który można pobrać do naszego katalogu lokalnego. Po załadowaniu pliku danych możemy go przekonwertować na tablicę NumPy i wykorzystać do projektów ML. Poniżej znajduje się skrypt Pythona do ładowania pliku danych CSV -

Najpierw musimy zaimportować moduł csv dostarczony przez standardową bibliotekę Pythona w następujący sposób -

import csvNastępnie musimy zaimportować moduł Numpy do konwersji załadowanych danych na tablicę NumPy.

import numpy as npTeraz podaj pełną ścieżkę do pliku przechowywanego w naszym katalogu lokalnym, zawierającego plik danych CSV -

path = r"c:\iris.csv"Następnie użyj funkcji csv.reader (), aby odczytać dane z pliku CSV -

with open(path,'r') as f:

reader = csv.reader(f,delimiter = ',')

headers = next(reader)

data = list(reader)

data = np.array(data).astype(float)Możemy wydrukować nazwy nagłówków za pomocą następującego wiersza skryptu -

print(headers)Poniższy wiersz skryptu wypisze kształt danych, tj. Liczbę wierszy i kolumn w pliku -

print(data.shape)Następna linia skryptu da pierwsze trzy linie pliku danych -

print(data[:3])Output

['sepal_length', 'sepal_width', 'petal_length', 'petal_width']

(150, 4)

[ [5.1 3.5 1.4 0.2]

[4.9 3. 1.4 0.2]

[4.7 3.2 1.3 0.2]]Załaduj plik CSV za pomocą NumPy

Innym podejściem do załadowania pliku danych CSV jest funkcja NumPy i numpy.loadtxt (). Poniżej znajduje się przykład ładowania pliku danych CSV za jego pomocą -

Przykład

W tym przykładzie korzystamy z zestawu danych Pima Indians Dataset zawierającego dane pacjentów z cukrzycą. Ten zbiór danych jest liczbowym zbiorem danych bez nagłówka. Można go również pobrać do naszego katalogu lokalnego. Po załadowaniu pliku danych możemy go przekonwertować na tablicę NumPy i wykorzystać do projektów ML. Poniżej znajduje się skrypt Pythona do ładowania pliku danych CSV -

from numpy import loadtxt

path = r"C:\pima-indians-diabetes.csv"

datapath= open(path, 'r')

data = loadtxt(datapath, delimiter=",")

print(data.shape)

print(data[:3])Wynik

(768, 9)

[ [ 6. 148. 72. 35. 0. 33.6 0.627 50. 1.]

[ 1. 85. 66. 29. 0. 26.6 0.351 31. 0.]

[ 8. 183. 64. 0. 0. 23.3 0.672 32. 1.]]Załaduj plik CSV z Pandami

Innym podejściem do załadowania pliku danych CSV jest użycie funkcji Pandas i pandas.read_csv (). Jest to bardzo elastyczna funkcja, która zwraca pandas.DataFrame, której można natychmiast użyć do kreślenia. Poniżej znajduje się przykład ładowania pliku danych CSV za jego pomocą -

Przykład

Tutaj zaimplementujemy dwa skrypty Pythona, pierwszy to zestaw danych Iris zawierający nagłówki, a drugi to zestaw danych Pima Indians Dataset, który jest liczbowym zestawem danych bez nagłówka. Oba zestawy danych można pobrać do katalogu lokalnego.

Script-1

Poniżej znajduje się skrypt Pythona do ładowania pliku danych CSV za pomocą Pandas on Iris Data set -

from pandas import read_csv

path = r"C:\iris.csv"

data = read_csv(path)

print(data.shape)

print(data[:3])

Output:

(150, 4)

sepal_length sepal_width petal_length petal_width

0 5.1 3.5 1.4 0.2

1 4.9 3.0 1.4 0.2

2 4.7 3.2 1.3 0.2Script-2

Poniżej znajduje się skrypt w Pythonie do ładowania pliku danych CSV, wraz z podaniem nazw nagłówków, przy użyciu zestawu danych Pandas on Pima Indians Diabetes -

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

headernames = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=headernames)

print(data.shape)

print(data[:3])Output

(768, 9)

preg plas pres skin test mass pedi age class

0 6 148 72 35 0 33.6 0.627 50 1

1 1 85 66 29 0 26.6 0.351 31 0

2 8 183 64 0 0 23.3 0.672 32 1Różnicę między powyższymi trzema podejściami do ładowania pliku danych CSV można łatwo zrozumieć na podstawie podanych przykładów.

Wprowadzenie

Podczas pracy z projektami uczenia maszynowego zazwyczaj pomijamy dwie najważniejsze części, tzw mathematics i data. Dzieje się tak, ponieważ wiemy, że ML jest podejściem opartym na danych, a nasz model ML da tylko tak dobre lub tak złe wyniki, jak dane, które mu przekazaliśmy.

W poprzednim rozdziale omówiliśmy, w jaki sposób możemy przesłać dane CSV do naszego projektu ML, ale dobrze byłoby zapoznać się z danymi przed ich przesłaniem. Możemy zrozumieć dane na dwa sposoby, za pomocą statystyk i wizualizacji.

W tym rozdziale, korzystając z przepisów Pythona, zrozumiemy dane ML ze statystykami.

Patrząc na surowe dane

Pierwszy przepis dotyczy przeglądania surowych danych. Ważne jest, aby spojrzeć na surowe dane, ponieważ wgląd, jaki uzyskamy po spojrzeniu na surowe dane, zwiększy nasze szanse na lepsze przetwarzanie wstępne, a także obsługę danych dla projektów ML.

Poniżej znajduje się skrypt Pythona zaimplementowany przy użyciu funkcji head () z Pandas DataFrame w zbiorze danych dotyczących cukrzycy Pima Indians, aby przyjrzeć się pierwszym 50 wierszom i lepiej je zrozumieć -

Przykład

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

headernames = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=headernames)

print(data.head(50))Wynik

preg plas pres skin test mass pedi age class

0 6 148 72 35 0 33.6 0.627 50 1

1 1 85 66 29 0 26.6 0.351 31 0

2 8 183 64 0 0 23.3 0.672 32 1

3 1 89 66 23 94 28.1 0.167 21 0

4 0 137 40 35 168 43.1 2.288 33 1

5 5 116 74 0 0 25.6 0.201 30 0

6 3 78 50 32 88 31.0 0.248 26 1

7 10 115 0 0 0 35.3 0.134 29 0

8 2 197 70 45 543 30.5 0.158 53 1

9 8 125 96 0 0 0.0 0.232 54 1

10 4 110 92 0 0 37.6 0.191 30 0

11 10 168 74 0 0 38.0 0.537 34 1

12 10 139 80 0 0 27.1 1.441 57 0

13 1 189 60 23 846 30.1 0.398 59 1

14 5 166 72 19 175 25.8 0.587 51 1

15 7 100 0 0 0 30.0 0.484 32 1

16 0 118 84 47 230 45.8 0.551 31 1

17 7 107 74 0 0 29.6 0.254 31 1

18 1 103 30 38 83 43.3 0.183 33 0

19 1 115 70 30 96 34.6 0.529 32 1

20 3 126 88 41 235 39.3 0.704 27 0

21 8 99 84 0 0 35.4 0.388 50 0

22 7 196 90 0 0 39.8 0.451 41 1

23 9 119 80 35 0 29.0 0.263 29 1

24 11 143 94 33 146 36.6 0.254 51 1

25 10 125 70 26 115 31.1 0.205 41 1

26 7 147 76 0 0 39.4 0.257 43 1

27 1 97 66 15 140 23.2 0.487 22 0

28 13 145 82 19 110 22.2 0.245 57 0

29 5 117 92 0 0 34.1 0.337 38 0

30 5 109 75 26 0 36.0 0.546 60 0

31 3 158 76 36 245 31.6 0.851 28 1

32 3 88 58 11 54 24.8 0.267 22 0

33 6 92 92 0 0 19.9 0.188 28 0

34 10 122 78 31 0 27.6 0.512 45 0

35 4 103 60 33 192 24.0 0.966 33 0

36 11 138 76 0 0 33.2 0.420 35 0

37 9 102 76 37 0 32.9 0.665 46 1

38 2 90 68 42 0 38.2 0.503 27 1

39 4 111 72 47 207 37.1 1.390 56 1

40 3 180 64 25 70 34.0 0.271 26 0

41 7 133 84 0 0 40.2 0.696 37 0

42 7 106 92 18 0 22.7 0.235 48 0

43 9 171 110 24 240 45.4 0.721 54 1

44 7 159 64 0 0 27.4 0.294 40 0

45 0 180 66 39 0 42.0 1.893 25 1

46 1 146 56 0 0 29.7 0.564 29 0

47 2 71 70 27 0 28.0 0.586 22 0

48 7 103 66 32 0 39.1 0.344 31 1

49 7 105 0 0 0 0.0 0.305 24 0Z powyższego wyniku możemy zauważyć, że pierwsza kolumna podaje numer wiersza, który może być bardzo przydatny do odniesienia się do określonej obserwacji.

Sprawdzanie wymiarów danych

Zawsze dobrze jest wiedzieć, ile danych w zakresie wierszy i kolumn mamy dla naszego projektu ML. Powody tego są -

Załóżmy, że jeśli mamy zbyt wiele wierszy i kolumn, uruchomienie algorytmu i nauczenie modelu zajęłoby dużo czasu.

Załóżmy, że jeśli mamy za mało wierszy i kolumn, to nie mielibyśmy wystarczającej ilości danych, aby dobrze wytrenować model.

Poniżej znajduje się skrypt Pythona zaimplementowany przez wydrukowanie właściwości shape w ramce danych Pandas. Zamierzamy go zaimplementować na zestawie danych tęczówki, aby uzyskać całkowitą liczbę wierszy i kolumn w nim.

Przykład

from pandas import read_csv

path = r"C:\iris.csv"

data = read_csv(path)

print(data.shape)Wynik

(150, 4)Na podstawie danych wyjściowych możemy łatwo zauważyć, że zbiór danych tęczówki, którego zamierzamy użyć, ma 150 wierszy i 4 kolumny.

Pobieranie typu danych każdego atrybutu

Inną dobrą praktyką jest znajomość typu danych każdego atrybutu. Powodem jest to, że zgodnie z wymaganiami czasami może być konieczne przekonwertowanie jednego typu danych na inny. Na przykład może być konieczne przekonwertowanie ciągu znaków na zmiennoprzecinkowe lub int w celu przedstawienia wartości jakościowych lub porządkowych. Możemy mieć pojęcie o typie danych atrybutu, patrząc na surowe dane, ale innym sposobem jest użycie właściwości dtypes Pandas DataFrame. Za pomocą właściwości dtypes możemy kategoryzować każdy typ danych atrybutów. Można to zrozumieć za pomocą następującego skryptu Pythona -

Przykład

from pandas import read_csv

path = r"C:\iris.csv"

data = read_csv(path)

print(data.dtypes)Wynik

sepal_length float64

sepal_width float64

petal_length float64

petal_width float64

dtype: objectZ powyższego wyniku możemy łatwo uzyskać typy danych każdego atrybutu.

Statystyczne podsumowanie danych

Omówiliśmy przepis Pythona, aby uzyskać kształt, tj. Liczbę wierszy i kolumn danych, ale wiele razy musimy przeglądać podsumowania z tego kształtu danych. Można to zrobić za pomocą funkcji opisywania () w Pandas DataFrame, która dodatkowo dostarcza następujących 8 właściwości statystycznych każdego atrybutu danych -

Count

Mean

Odchylenie standardowe

Minimalna wartość

Maksymalna wartość

25%

Mediana tj. 50%

75%

Przykład

from pandas import read_csv

from pandas import set_option

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

set_option('display.width', 100)

set_option('precision', 2)

print(data.shape)

print(data.describe())Wynik

(768, 9)

preg plas pres skin test mass pedi age class

count 768.00 768.00 768.00 768.00 768.00 768.00 768.00 768.00 768.00

mean 3.85 120.89 69.11 20.54 79.80 31.99 0.47 33.24 0.35

std 3.37 31.97 19.36 15.95 115.24 7.88 0.33 11.76 0.48

min 0.00 0.00 0.00 0.00 0.00 0.00 0.08 21.00 0.00

25% 1.00 99.00 62.00 0.00 0.00 27.30 0.24 24.00 0.00

50% 3.00 117.00 72.00 23.00 30.50 32.00 0.37 29.00 0.00

75% 6.00 140.25 80.00 32.00 127.25 36.60 0.63 41.00 1.00

max 17.00 199.00 122.00 99.00 846.00 67.10 2.42 81.00 1.00Z powyższego wyniku możemy obserwować statystyczne podsumowanie danych zbioru danych Pima Indian Diabetes wraz z kształtem danych.

Przeglądanie rozkładu klas

Statystyka dystrybucji klas jest przydatna w problemach klasyfikacyjnych, w których musimy znać równowagę wartości klas. Ważne jest, aby znać rozkład wartości klas, ponieważ jeśli mamy wysoce niezrównoważony rozkład klas, tj. Jedna klasa ma o wiele więcej obserwacji niż inna klasa, może to wymagać specjalnego traktowania na etapie przygotowania danych w naszym projekcie ML. Możemy łatwo uzyskać dystrybucję klas w Pythonie za pomocą Pandas DataFrame.

Przykład

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

count_class = data.groupby('class').size()

print(count_class)Wynik

Class

0 500

1 268

dtype: int64Z powyższego wyniku można wyraźnie zauważyć, że liczba obserwacji z klasą 0 jest prawie dwukrotnie większa niż liczba obserwacji z klasą 1.

Przeglądanie korelacji między atrybutami

Związek między dwiema zmiennymi nazywa się korelacją. W statystyce najpowszechniejszą metodą obliczania korelacji jest współczynnik korelacji Pearsona. Może mieć trzy wartości w następujący sposób -

Coefficient value = 1 - To reprezentuje pełne positive korelacja między zmiennymi.

Coefficient value = -1 - To reprezentuje pełne negative korelacja między zmiennymi.

Coefficient value = 0 - To reprezentuje no korelacja między zmiennymi.

Zawsze dobrze jest przejrzeć parami korelacje atrybutów w naszym zbiorze danych przed użyciem go w projekcie ML, ponieważ niektóre algorytmy uczenia maszynowego, takie jak regresja liniowa i regresja logistyczna, będą działać słabo, jeśli mamy wysoce skorelowane atrybuty. W Pythonie możemy łatwo obliczyć macierz korelacji atrybutów zestawu danych za pomocą funkcji corr () w Pandas DataFrame.

Przykład

from pandas import read_csv

from pandas import set_option

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

set_option('display.width', 100)

set_option('precision', 2)

correlations = data.corr(method='pearson')

print(correlations)Wynik

preg plas pres skin test mass pedi age class

preg 1.00 0.13 0.14 -0.08 -0.07 0.02 -0.03 0.54 0.22

plas 0.13 1.00 0.15 0.06 0.33 0.22 0.14 0.26 0.47

pres 0.14 0.15 1.00 0.21 0.09 0.28 0.04 0.24 0.07

skin -0.08 0.06 0.21 1.00 0.44 0.39 0.18 -0.11 0.07

test -0.07 0.33 0.09 0.44 1.00 0.20 0.19 -0.04 0.13

mass 0.02 0.22 0.28 0.39 0.20 1.00 0.14 0.04 0.29

pedi -0.03 0.14 0.04 0.18 0.19 0.14 1.00 0.03 0.17

age 0.54 0.26 0.24 -0.11 -0.04 0.04 0.03 1.00 0.24

class 0.22 0.47 0.07 0.07 0.13 0.29 0.17 0.24 1.00Macierz w powyższym wyniku podaje korelację między wszystkimi parami atrybutu w zbiorze danych.

Przeglądanie pochylenia rozkładu atrybutów

Skośność można zdefiniować jako rozkład, który przyjmuje się jako rozkład Gaussa, ale wydaje się zniekształcony lub przesunięty w jednym lub drugim kierunku albo w lewo lub w prawo. Przeglądanie skośności atrybutów jest jednym z ważnych zadań z następujących powodów -

Obecność skośności danych wymaga korekty na etapie przygotowania danych, abyśmy mogli uzyskać większą dokładność z naszego modelu.

Większość algorytmów ML zakłada, że dane mają rozkład Gaussa, tj. Albo dane normalne, albo dane o krzywej dzwonowej.

W Pythonie możemy łatwo obliczyć pochylenie każdego atrybutu, używając funkcji skew () w Pandas DataFrame.

Przykład

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

print(data.skew())Wynik

preg 0.90

plas 0.17

pres -1.84

skin 0.11

test 2.27

mass -0.43

pedi 1.92

age 1.13

class 0.64

dtype: float64Z powyższego wyniku można zaobserwować dodatnie lub ujemne odchylenie. Jeśli wartość jest bliższa zeru, pokazuje mniejsze pochylenie.

Wprowadzenie

W poprzednim rozdziale omówiliśmy znaczenie danych dla algorytmów uczenia maszynowego wraz z niektórymi regułami języka Python w celu zrozumienia danych ze statystykami. Istnieje inny sposób, zwany wizualizacją, służący do zrozumienia danych.

Za pomocą wizualizacji danych możemy zobaczyć, jak wyglądają dane i jaki rodzaj korelacji posiadają atrybuty danych. Jest to najszybszy sposób sprawdzenia, czy funkcje odpowiadają wynikowi. Korzystając z przepisów Pythona, możemy zrozumieć dane ML ze statystykami.

Wykresy jednowymiarowe: niezależne zrozumienie atrybutów

Najprostszym typem wizualizacji jest wizualizacja z jedną zmienną lub „jednowymiarowa”. Przy pomocy wizualizacji jednowymiarowej możemy niezależnie zrozumieć każdy atrybut naszego zbioru danych. Poniżej przedstawiono niektóre techniki w Pythonie do implementacji wizualizacji jednowymiarowej -

Histogramy

Histogramy grupują dane w koszach i są najszybszym sposobem na uzyskanie informacji o rozmieszczeniu każdego atrybutu w zbiorze danych. Oto niektóre cechy charakterystyczne histogramów -

Zapewnia nam liczbę obserwacji w każdym koszu utworzonym do wizualizacji.

Z kształtu kosza można łatwo zaobserwować rozkład, czyli pogodę jest to gaussowskie, skośne lub wykładnicze.

Histogramy pomagają nam również dostrzec możliwe wartości odstające.

Przykład

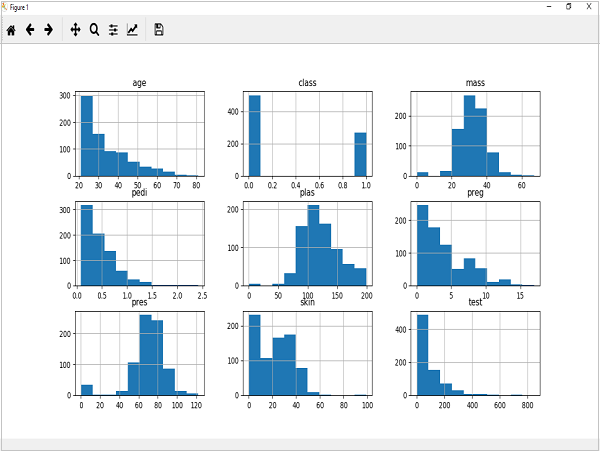

Poniższy kod jest przykładem skryptu w języku Python tworzącego histogram atrybutów zbioru danych Pima Indian Diabetes. Tutaj będziemy używać funkcji hist () na Pandas DataFrame do generowania histogramów imatplotlib za spiskowanie ich.

from matplotlib import pyplot

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

data.hist()

pyplot.show()Wynik

Powyższe dane wyjściowe pokazują, że utworzył histogram dla każdego atrybutu w zestawie danych. Z tego możemy zauważyć, że być może wiek, pedi i atrybut testowy mogą mieć rozkład wykładniczy, podczas gdy masa i plazma mają rozkład Gaussa.

Wykresy gęstości

Inną szybką i łatwą techniką uzyskania rozkładu poszczególnych atrybutów są wykresy gęstości. Jest również podobny do histogramu, ale ma gładką krzywą narysowaną przez górę każdego pojemnika. Możemy je nazwać abstrakcyjnymi histogramami.

Przykład

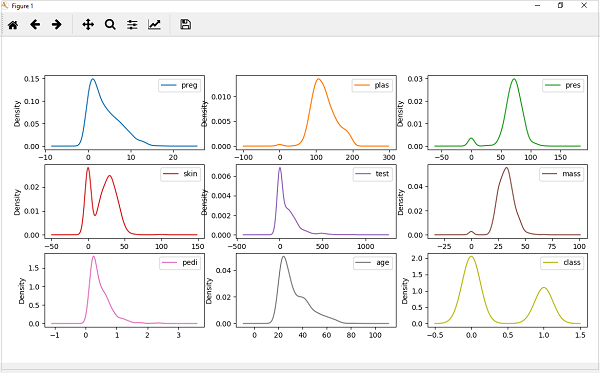

W poniższym przykładzie skrypt w języku Python wygeneruje wykresy gęstości dla dystrybucji atrybutów zestawu danych Pima Indian Diabetes.

from matplotlib import pyplot

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

data.plot(kind='density', subplots=True, layout=(3,3), sharex=False)

pyplot.show()Wynik

Z powyższego wyniku można łatwo zrozumieć różnicę między wykresami gęstości a histogramami.

Wykresy pudełkowe i wąsy

Wykresy pudełkowe i wąsy, w skrócie zwane również wykresami pudełkowymi, to kolejna przydatna technika do przeglądu rozkładu każdego atrybutu. Poniżej przedstawiono cechy tej techniki -

Ma charakter jednoczynnikowy i podsumowuje rozkład każdego atrybutu.

Rysuje linię dla wartości środkowej, tj. Dla mediany.

Rysuje prostokąt wokół 25% i 75%.

Rysuje również wąsy, które dają nam wyobrażenie o rozprzestrzenianiu się danych.

Kropki poza wąsami oznaczają wartości odstające. Wartości odstające byłyby 1,5 raza większe niż rozmiar rozprzestrzeniania się średnich danych.

Przykład

W poniższym przykładzie skrypt w języku Python wygeneruje wykresy gęstości dla dystrybucji atrybutów zestawu danych Pima Indian Diabetes.

from matplotlib import pyplot

from pandas import read_csv

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

data.plot(kind='box', subplots=True, layout=(3,3), sharex=False,sharey=False)

pyplot.show()Wynik

Z powyższego wykresu rozkładu atrybutu można zauważyć, że wiek, test i skóra wydają się być pochylone w kierunku mniejszych wartości.

Wykresy wielowymiarowe: interakcja między wieloma zmiennymi

Innym rodzajem wizualizacji jest wizualizacja z wieloma zmiennymi lub „wielowymiarowymi”. Przy pomocy wizualizacji wielowymiarowej możemy zrozumieć interakcje między wieloma atrybutami naszego zbioru danych. Poniżej przedstawiono niektóre techniki w Pythonie do implementacji wizualizacji wielowymiarowej -

Wykres macierzy korelacji

Korelacja jest wskazówką dotyczącą zmian między dwiema zmiennymi. W naszych poprzednich rozdziałach omówiliśmy współczynniki korelacji Pearsona i znaczenie korelacji. Możemy wykreślić macierz korelacji, aby pokazać, która zmienna ma wysoką lub niską korelację w odniesieniu do innej zmiennej.

Przykład

W poniższym przykładzie skrypt w języku Python wygeneruje i wykreśli macierz korelacji dla zestawu danych Pima Indian Diabetes. Można go wygenerować za pomocą funkcji corr () w Pandas DataFrame i wykreślić za pomocą pyplot.

from matplotlib import pyplot

from pandas import read_csv

import numpy

Path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(Path, names=names)

correlations = data.corr()

fig = pyplot.figure()

ax = fig.add_subplot(111)

cax = ax.matshow(correlations, vmin=-1, vmax=1)

fig.colorbar(cax)

ticks = numpy.arange(0,9,1)

ax.set_xticks(ticks)

ax.set_yticks(ticks)

ax.set_xticklabels(names)

ax.set_yticklabels(names)

pyplot.show()Wynik

Z powyższego wyniku macierzy korelacji widzimy, że jest symetryczna, tj. Lewy dolny róg jest taki sam jak prawy górny. Obserwuje się również, że każda zmienna jest ze sobą dodatnio skorelowana.

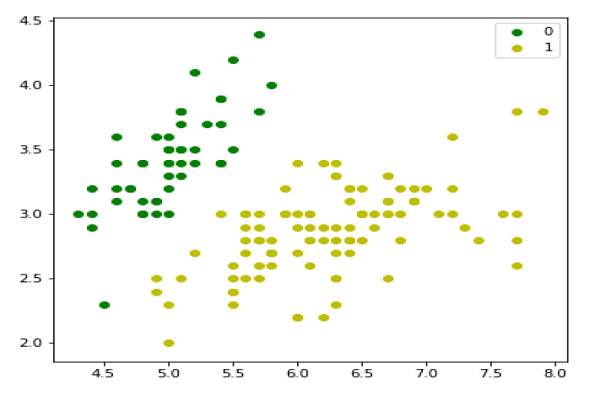

Wykres macierzy rozproszenia

Wykresy punktowe pokazują, jak bardzo na jedną zmienną wpływa inna lub związek między nimi za pomocą kropek w dwóch wymiarach. Wykresy punktowe są bardzo podobne do wykresów liniowych w koncepcji, że używają osi poziomej i pionowej do wykreślania punktów danych.

Przykład

W poniższym przykładzie skrypt w języku Python wygeneruje i wykreśli macierz rozrzutu dla zestawu danych Pima Indian Diabetes. Można go wygenerować za pomocą funkcji scatter_matrix () w Pandas DataFrame i wykreślić za pomocą pyplot.

from matplotlib import pyplot

from pandas import read_csv

from pandas.tools.plotting import scatter_matrix

path = r"C:\pima-indians-diabetes.csv"

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

data = read_csv(path, names=names)

scatter_matrix(data)

pyplot.show()Wynik

Wprowadzenie

Algorytmy uczenia maszynowego są całkowicie zależne od danych, ponieważ jest to najważniejszy aspekt, który umożliwia uczenie modeli. Z drugiej strony, jeśli nie będziemy w stanie wyciągnąć sensu z tych danych, przed przekazaniem ich do algorytmów ML maszyna będzie bezużyteczna. Mówiąc prościej, zawsze musimy podawać właściwe dane, tj. Dane w odpowiedniej skali, formacie i zawierające znaczące cechy, dla problemu, który chcemy rozwiązać przez maszynę.

To sprawia, że przygotowanie danych jest najważniejszym krokiem w procesie ML. Przygotowanie danych można zdefiniować jako procedurę, która sprawia, że nasz zbiór danych jest bardziej odpowiedni dla procesu ML.

Dlaczego wstępne przetwarzanie danych?

Po wybraniu surowych danych do treningu ML najważniejszym zadaniem jest wstępne przetwarzanie danych. W szerokim sensie wstępne przetwarzanie danych przekształci wybrane dane w formę, z którą możemy pracować lub możemy je przesłać do algorytmów ML. Zawsze musimy wstępnie przetwarzać nasze dane, aby były zgodne z oczekiwaniami algorytmu uczenia maszynowego.

Techniki wstępnego przetwarzania danych

Mamy następujące techniki wstępnego przetwarzania danych, które można zastosować na zestawie danych w celu uzyskania danych dla algorytmów ML -

skalowanie

Najprawdopodobniej nasz zbiór danych zawiera atrybuty o różnej skali, ale nie możemy dostarczyć takich danych do algorytmu ML, dlatego wymaga przeskalowania. Przeskalowanie danych zapewnia, że atrybuty są w tej samej skali. Ogólnie atrybuty są przeskalowywane do zakresu od 0 do 1. Algorytmy ML, takie jak gradientowe zejście i k-Nearest Neighbors, wymagają skalowanych danych. Możemy przeskalować dane za pomocą klasy MinMaxScaler biblioteki scikit-learn Python.

Przykład

W tym przykładzie przeskalujemy dane z zestawu danych Pima Indians Diabetes, którego używaliśmy wcześniej. Najpierw zostaną załadowane dane CSV (tak jak zostało to zrobione w poprzednich rozdziałach), a następnie przy pomocy klasy MinMaxScaler zostaną przeskalowane w zakresie 0 i 1.

Pierwsze kilka wierszy poniższego skryptu jest takich samych, jak napisaliśmy w poprzednich rozdziałach podczas ładowania danych CSV.

from pandas import read_csv

from numpy import set_printoptions

from sklearn import preprocessing

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesTeraz możemy użyć klasy MinMaxScaler do przeskalowania danych w zakresie od 0 do 1.

data_scaler = preprocessing.MinMaxScaler(feature_range=(0,1))

data_rescaled = data_scaler.fit_transform(array)Możemy również podsumować dane wyjściowe według naszego wyboru. Tutaj ustawiamy dokładność na 1 i pokazujemy pierwsze 10 wierszy na wyjściu.

set_printoptions(precision=1)

print ("\nScaled data:\n", data_rescaled[0:10])Wynik

Scaled data:

[[0.4 0.7 0.6 0.4 0. 0.5 0.2 0.5 1. ]

[0.1 0.4 0.5 0.3 0. 0.4 0.1 0.2 0. ]

[0.5 0.9 0.5 0. 0. 0.3 0.3 0.2 1. ]

[0.1 0.4 0.5 0.2 0.1 0.4 0. 0. 0. ]

[0. 0.7 0.3 0.4 0.2 0.6 0.9 0.2 1. ]

[0.3 0.6 0.6 0. 0. 0.4 0.1 0.2 0. ]

[0.2 0.4 0.4 0.3 0.1 0.5 0.1 0.1 1. ]

[0.6 0.6 0. 0. 0. 0.5 0. 0.1 0. ]

[0.1 1. 0.6 0.5 0.6 0.5 0. 0.5 1. ]

[0.5 0.6 0.8 0. 0. 0. 0.1 0.6 1. ]]Z powyższego wyniku wszystkie dane zostały przeskalowane do zakresu 0 i 1.

Normalizacja

Inną przydatną techniką wstępnego przetwarzania danych jest normalizacja. Służy do przeskalowania każdego wiersza danych tak, aby miał długość 1. Jest to przydatne głównie w rzadkich zestawach danych, w których mamy dużo zer. Możemy przeskalować dane za pomocą klasy Normalizer biblioteki scikit-learn Python.

Rodzaje normalizacji

W uczeniu maszynowym istnieją dwa typy technik wstępnego przetwarzania normalizacji, jak następuje:

Normalizacja L1

Można ją zdefiniować jako technikę normalizacji, która modyfikuje wartości zbioru danych w taki sposób, że w każdym wierszu suma wartości bezwzględnych będzie zawsze wynosić do 1. Nazywa się ją również najmniejszymi odchyleniami bezwzględnymi.

Example

W tym przykładzie używamy techniki L1 Normalize do znormalizowania danych z zestawu danych Pima Indians Diabetes, którego używaliśmy wcześniej. Najpierw zostaną załadowane dane CSV, a następnie przy pomocy klasy Normalizer zostaną znormalizowane.

Pierwsze kilka wierszy poniższego skryptu jest takich samych, jak napisaliśmy w poprzednich rozdziałach podczas ładowania danych CSV.

from pandas import read_csv

from numpy import set_printoptions

from sklearn.preprocessing import Normalizer

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv (path, names=names)

array = dataframe.valuesTeraz możemy użyć klasy Normalizer z L1 do normalizacji danych.

Data_normalizer = Normalizer(norm='l1').fit(array)

Data_normalized = Data_normalizer.transform(array)Możemy również podsumować dane wyjściowe według naszego wyboru. Tutaj ustawiamy dokładność na 2 i pokazujemy pierwsze 3 wiersze na wyjściu.

set_printoptions(precision=2)

print ("\nNormalized data:\n", Data_normalized [0:3])Output

Normalized data:

[[0.02 0.43 0.21 0.1 0. 0.1 0. 0.14 0. ]

[0. 0.36 0.28 0.12 0. 0.11 0. 0.13 0. ]

[0.03 0.59 0.21 0. 0. 0.07 0. 0.1 0. ]]Normalizacja L2

Można ją zdefiniować jako technikę normalizacji, która modyfikuje wartości zbioru danych w taki sposób, że w każdym wierszu suma kwadratów będzie zawsze wynosić do 1. Nazywa się ją również metodą najmniejszych kwadratów.

Example

W tym przykładzie używamy techniki L2 Normalization, aby znormalizować dane ze zbioru danych Pima Indians Diabetes, którego używaliśmy wcześniej. Najpierw dane CSV zostaną załadowane (tak jak zostało to zrobione w poprzednich rozdziałach), a następnie przy pomocy klasy Normalizer zostaną znormalizowane.

Pierwsze kilka wierszy poniższego skryptu jest takich samych, jak napisaliśmy w poprzednich rozdziałach podczas ładowania danych CSV.

from pandas import read_csv

from numpy import set_printoptions

from sklearn.preprocessing import Normalizer

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv (path, names=names)

array = dataframe.valuesTeraz możemy użyć klasy Normalizer z L1 do normalizacji danych.

Data_normalizer = Normalizer(norm='l2').fit(array)

Data_normalized = Data_normalizer.transform(array)Możemy również podsumować dane wyjściowe według naszego wyboru. Tutaj ustawiamy dokładność na 2 i pokazujemy pierwsze 3 wiersze na wyjściu.

set_printoptions(precision=2)

print ("\nNormalized data:\n", Data_normalized [0:3])Output

Normalized data:

[[0.03 0.83 0.4 0.2 0. 0.19 0. 0.28 0.01]

[0.01 0.72 0.56 0.24 0. 0.22 0. 0.26 0. ]

[0.04 0.92 0.32 0. 0. 0.12 0. 0.16 0.01]]Binaryzacja

Jak sama nazwa wskazuje, jest to technika, za pomocą której możemy uczynić nasze dane binarnymi. Możemy użyć progu binarnego, aby uczynić nasze dane binarnymi. Wartości powyżej tej wartości progowej zostaną przekonwertowane na 1, a poniżej tego progu zostaną przekonwertowane na 0. Na przykład, jeśli wybierzemy wartość progową = 0,5, wówczas wartość zbioru danych powyżej tej wartości progowej będzie równa 1, a poniżej tej wartości - 0. To znaczy dlaczego możemy to nazwaćbinarizing dane lub thresholdingdane. Ta technika jest przydatna, gdy mamy prawdopodobieństwa w naszym zbiorze danych i chcemy przekształcić je w konkretne wartości.

Możemy binaryzować dane za pomocą klasy Binarizer z biblioteki Python scikit-learn.

Przykład

W tym przykładzie przeskalujemy dane z zestawu danych Pima Indians Diabetes, którego używaliśmy wcześniej. Najpierw zostaną załadowane dane CSV, a następnie przy pomocy klasy Binarizer zostaną przekonwertowane na wartości binarne tj. 0 i 1 w zależności od wartości progowej. Przyjmujemy 0,5 jako wartość progową.

Pierwsze kilka wierszy poniższego skryptu jest takich samych, jak napisaliśmy w poprzednich rozdziałach podczas ładowania danych CSV.

from pandas import read_csv

from sklearn.preprocessing import Binarizer

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesTeraz możemy użyć klasy Binarize do konwersji danych na wartości binarne.

binarizer = Binarizer(threshold=0.5).fit(array)

Data_binarized = binarizer.transform(array)Tutaj pokazujemy pierwsze 5 wierszy danych wyjściowych.

print ("\nBinary data:\n", Data_binarized [0:5])Wynik

Binary data:

[[1. 1. 1. 1. 0. 1. 1. 1. 1.]

[1. 1. 1. 1. 0. 1. 0. 1. 0.]

[1. 1. 1. 0. 0. 1. 1. 1. 1.]

[1. 1. 1. 1. 1. 1. 0. 1. 0.]

[0. 1. 1. 1. 1. 1. 1. 1. 1.]]Normalizacja

Kolejna przydatna technika wstępnego przetwarzania danych, która jest zasadniczo używana do transformacji atrybutów danych z rozkładem Gaussa. Różni się średnią i odchyleniem standardowym (odchylenie standardowe) od standardowego rozkładu Gaussa ze średnią 0 i odchyleniem standardowym równym 1. Ta technika jest przydatna w algorytmach ML, takich jak regresja liniowa, regresja logistyczna, która zakłada rozkład Gaussa w wejściowym zbiorze danych i generuje lepsze wyniki z przeskalowanymi danymi. Możemy ustandaryzować dane (średnia = 0 i SD = 1) za pomocą klasy StandardScaler biblioteki scikit-learn Python.

Przykład

W tym przykładzie przeskalujemy dane z zestawu danych Pima Indians Diabetes, którego używaliśmy wcześniej. Najpierw dane CSV zostaną załadowane, a następnie przy pomocy klasy StandardScaler zostaną przekonwertowane na rozkład Gaussa ze średnią = 0 i SD = 1.

Pierwsze kilka wierszy poniższego skryptu jest takich samych, jak napisaliśmy w poprzednich rozdziałach podczas ładowania danych CSV.

from sklearn.preprocessing import StandardScaler

from pandas import read_csv

from numpy import set_printoptions

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesTeraz możemy użyć klasy StandardScaler do przeskalowania danych.

data_scaler = StandardScaler().fit(array)

data_rescaled = data_scaler.transform(array)Możemy również podsumować dane wyjściowe według naszego wyboru. Tutaj ustawiamy dokładność na 2 i pokazujemy pierwsze 5 wierszy na wyjściu.

set_printoptions(precision=2)

print ("\nRescaled data:\n", data_rescaled [0:5])Wynik

Rescaled data:

[[ 0.64 0.85 0.15 0.91 -0.69 0.2 0.47 1.43 1.37]

[-0.84 -1.12 -0.16 0.53 -0.69 -0.68 -0.37 -0.19 -0.73]

[ 1.23 1.94 -0.26 -1.29 -0.69 -1.1 0.6 -0.11 1.37]

[-0.84 -1. -0.16 0.15 0.12 -0.49 -0.92 -1.04 -0.73]

[-1.14 0.5 -1.5 0.91 0.77 1.41 5.48 -0.02 1.37]]Etykietowanie danych

Omówiliśmy znaczenie dobrego fata dla algorytmów ML, a także niektórych technik wstępnego przetwarzania danych przed wysłaniem ich do algorytmów ML. Jeszcze jednym aspektem w tym względzie jest etykietowanie danych. Bardzo ważne jest również przesłanie danych do algorytmów ML posiadających odpowiednie oznakowanie. Na przykład w przypadku problemów z klasyfikacją na danych znajduje się wiele etykiet w postaci słów, liczb itp.

Co to jest kodowanie etykiet?

Większość funkcji sklearn oczekuje, że dane będą miały etykiety liczbowe, a nie etykiety słów. Dlatego musimy zamienić takie etykiety na etykiety z numerami. Ten proces nazywa się kodowaniem etykiet. Możemy wykonać etykietowe kodowanie danych za pomocą funkcji LabelEncoder () biblioteki scikit-learn Python.

Przykład

W poniższym przykładzie skrypt Pythona wykona kodowanie etykiety.

Najpierw zaimportuj wymagane biblioteki Pythona w następujący sposób -

import numpy as np

from sklearn import preprocessingTeraz musimy podać etykiety wejściowe w następujący sposób -

input_labels = ['red','black','red','green','black','yellow','white']Następny wiersz kodu utworzy koder etykiet i wytrenuje go.

encoder = preprocessing.LabelEncoder()

encoder.fit(input_labels)Kolejne wiersze skryptu sprawdzą wydajność, kodując losowo uporządkowaną listę -

test_labels = ['green','red','black']

encoded_values = encoder.transform(test_labels)

print("\nLabels =", test_labels)

print("Encoded values =", list(encoded_values))

encoded_values = [3,0,4,1]

decoded_list = encoder.inverse_transform(encoded_values)Możemy uzyskać listę zakodowanych wartości za pomocą następującego skryptu w Pythonie -

print("\nEncoded values =", encoded_values)

print("\nDecoded labels =", list(decoded_list))Wynik

Labels = ['green', 'red', 'black']

Encoded values = [1, 2, 0]

Encoded values = [3, 0, 4, 1]

Decoded labels = ['white', 'black', 'yellow', 'green']W poprzednim rozdziale szczegółowo omówiliśmy, jak wstępnie przetwarzać i przygotowywać dane do uczenia maszynowego. W tym rozdziale wyjaśnimy szczegółowo wybór cech danych i różne aspekty z tym związane.

Znaczenie wyboru funkcji danych

Wydajność modelu uczenia maszynowego jest wprost proporcjonalna do funkcji danych używanych do jego trenowania. Na wydajność modelu ML wpłynie to negatywnie, jeśli dostarczone mu funkcje danych są nieistotne. Z drugiej strony użycie odpowiednich funkcji danych może zwiększyć dokładność modelu ML, zwłaszcza regresji liniowej i logistycznej.

Teraz pojawia się pytanie, czym jest automatyczny dobór funkcji? Można go zdefiniować jako proces, za pomocą którego wybieramy te cechy w naszych danych, które są najbardziej odpowiednie dla zmiennej wyjściowej lub predykcyjnej, którymi jesteśmy zainteresowani. Nazywa się to również wyborem atrybutów.

Poniżej przedstawiono niektóre korzyści wynikające z automatycznego wyboru funkcji przed modelowaniem danych -

Dokonanie wyboru funkcji przed modelowaniem danych zmniejszy nadmierne dopasowanie.

Wykonywanie wyboru funkcji przed modelowaniem danych zwiększy dokładność modelu ML.

Dokonanie wyboru funkcji przed modelowaniem danych skróci czas szkolenia

Techniki wyboru funkcji

Poniżej przedstawiono techniki automatycznego wyboru funkcji, których możemy użyć do modelowania danych ML w Pythonie -

Wybór jednowymiarowy

Ta technika wyboru cech jest bardzo przydatna przy wybieraniu tych cech, przy pomocy testów statystycznych, mających najsilniejszy związek ze zmiennymi predykcji. Możemy zaimplementować technikę jednoczynnikowego wyboru cech za pomocą SelectKBest0class biblioteki scikit-learn Python.

Example

W tym przykładzie użyjemy zbioru danych Pima Indians Diabetes, aby wybrać 4 atrybuty o najlepszych cechach za pomocą testu statystycznego chi-kwadrat.

from pandas import read_csv

from numpy import set_printoptions

from sklearn.feature_selection import SelectKBest

from sklearn.feature_selection import chi2

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesNastępnie podzielimy tablicę na komponenty wejściowe i wyjściowe -

X = array[:,0:8]

Y = array[:,8]Poniższe wiersze kodu wybiorą najlepsze funkcje z zestawu danych -

test = SelectKBest(score_func=chi2, k=4)

fit = test.fit(X,Y)Możemy również podsumować dane wyjściowe według naszego wyboru. Tutaj ustawiamy dokładność na 2 i pokazujemy 4 atrybuty danych z najlepszymi funkcjami wraz z najlepszym wynikiem każdego atrybutu -

set_printoptions(precision=2)

print(fit.scores_)

featured_data = fit.transform(X)

print ("\nFeatured data:\n", featured_data[0:4])Output

[ 111.52 1411.89 17.61 53.11 2175.57 127.67 5.39 181.3 ]

Featured data:

[[148. 0. 33.6 50. ]

[ 85. 0. 26.6 31. ]

[183. 0. 23.3 32. ]

[ 89. 94. 28.1 21. ]]Rekurencyjna eliminacja funkcji

Jak sama nazwa wskazuje, technika wyboru cech RFE (rekurencyjna eliminacja cech) usuwa atrybuty rekurencyjnie i buduje model z pozostałymi atrybutami. Możemy zaimplementować technikę wyboru cech RFE za pomocą klasy RFE biblioteki Python scikit-learn.

Przykład

W tym przykładzie użyjemy RFE z algorytmem regresji logistycznej, aby wybrać 3 najlepsze atrybuty mające najlepsze cechy z zestawu danych Pima Indians Diabetes do.

from pandas import read_csv

from sklearn.feature_selection import RFE

from sklearn.linear_model import LogisticRegression

path = r'C:\pima-indians-diabetes.csv'

names = ['preg', 'plas', 'pres', 'skin', 'test', 'mass', 'pedi', 'age', 'class']

dataframe = read_csv(path, names=names)

array = dataframe.valuesNastępnie podzielimy tablicę na komponenty wejściowe i wyjściowe -

X = array[:,0:8]

Y = array[:,8]Poniższe wiersze kodu wybiorą najlepsze funkcje ze zbioru danych -

model = LogisticRegression()

rfe = RFE(model, 3)

fit = rfe.fit(X, Y)

print("Number of Features: %d")

print("Selected Features: %s")

print("Feature Ranking: %s")Wynik

Number of Features: 3

Selected Features: [ True False False False False True True False]

Feature Ranking: [1 2 3 5 6 1 1 4]Jak widać na powyższym wyjściu, RFE wybiera preg, mass i pedi jako pierwsze 3 najlepsze cechy. Na wyjściu są oznaczone jako 1.

Analiza głównych składników (PCA)