Обучение и адаптация

Как говорилось ранее, ИНС полностью вдохновлена тем, как работает биологическая нервная система, то есть человеческий мозг. Самая впечатляющая характеристика человеческого мозга - это способность к обучению, поэтому ИНС приобретает ту же функцию.

Что такое обучение в ИНС?

По сути, обучение означает вносить изменения в себя и адаптировать их к изменениям в окружающей среде. ИНС - это сложная система, или, точнее, мы можем сказать, что это сложная адаптивная система, которая может изменять свою внутреннюю структуру на основе информации, проходящей через нее.

Почему это важно?

Будучи сложной адаптивной системой, обучение в ИНС подразумевает, что блок обработки способен изменять свое поведение ввода / вывода из-за изменения окружающей среды. Важность обучения в ИНС возрастает из-за фиксированной функции активации, а также вектора ввода / вывода при построении конкретной сети. Теперь, чтобы изменить поведение ввода / вывода, нам нужно настроить веса.

Классификация

Его можно определить как процесс обучения различению данных выборок по разным классам путем нахождения общих черт между выборками одних и тех же классов. Например, для обучения ИНС у нас есть несколько обучающих выборок с уникальными функциями, а для ее тестирования у нас есть несколько тестовых образцов с другими уникальными функциями. Классификация - это пример обучения с учителем.

Правила обучения нейронной сети

Мы знаем, что во время обучения ИНС, чтобы изменить поведение ввода / вывода, нам нужно настроить веса. Следовательно, требуется метод, с помощью которого можно изменять веса. Эти методы называются правилами обучения, которые представляют собой просто алгоритмы или уравнения. Ниже приведены некоторые правила обучения нейронной сети.

Правило обучения по-еврейски

Это правило, одно из старейших и простейших, было введено Дональдом Хеббом в его книге «Организация поведения» в 1949 году. Это своего рода обучение без учителя с прямой связью.

Basic Concept - Это правило основано на предложении Хебба, который написал:

«Когда аксон клетки A находится достаточно близко, чтобы возбуждать клетку B, и неоднократно или постоянно участвует в ее возбуждении, в одной или обеих клетках происходит некоторый процесс роста или метаболические изменения, так что эффективность A как одной из клеток, запускающих B , увеличена."

Из приведенного выше постулата мы можем сделать вывод, что связи между двумя нейронами могут быть усилены, если нейроны срабатывают одновременно, и могут ослабнуть, если они срабатывают в разное время.

Mathematical Formulation - В соответствии с правилом обучения Hebbian, следующая формула увеличивает вес соединения на каждом временном шаге.

$$ \ Delta w_ {ji} (t) \: = \: \ alpha x_ {i} (t) .y_ {j} (t) $$

Здесь $ \ Delta w_ {ji} (t) $ = приращение, на которое вес соединения увеличивается на временном шаге t

$ \ alpha $ = положительная и постоянная скорость обучения

$ x_ {i} (t) $ = входное значение от пресинаптического нейрона на временном шаге t

$ y_ {i} (t) $ = выход пресинаптического нейрона на том же временном шаге t

Правило обучения персептрона

Это правило является исправлением ошибок алгоритма контролируемого обучения однослойных сетей прямого распространения с линейной функцией активации, введенного Розенблаттом.

Basic Concept- Поскольку по своей природе контролируется, для вычисления ошибки будет проводиться сравнение между желаемым / целевым выходом и фактическим выходом. Если обнаружено какое-либо различие, необходимо изменить веса соединения.

Mathematical Formulation - Чтобы объяснить его математическую формулировку, предположим, что у нас есть n конечных входных векторов x (n), а также его желаемый / целевой выходной вектор t (n), где n = от 1 до N.

Теперь выход `` y '' можно рассчитать, как объяснялось ранее, на основе чистого входа, а функция активации, применяемая к этому чистому входу, может быть выражена следующим образом:

$$ y \: = \: f (y_ {in}) \: = \: \ begin {cases} 1, & y_ {in} \:> \: \ theta \\ 0, & y_ {in} \: \ leqslant \: \ theta \ end {case} $$

куда θ порог.

Обновление веса может быть выполнено в следующих двух случаях:

Case I - когда t ≠ y, тогда

$$ w (новый) \: = \: w (старый) \: + \; tx $$

Case II - когда t = y, тогда

Без изменения веса

Правило дельта-обучения (правило Уидроу-Хоффа)

Он был введен Бернардом Видроу и Марсианом Хоффом, также называемый методом наименьших средних квадратов (LMS), чтобы минимизировать ошибку по всем шаблонам обучения. Это своего рода контролируемый алгоритм обучения с функцией непрерывной активации.

Basic Concept- В основе этого правила лежит метод градиентного спуска, который продолжается вечно. Правило дельты обновляет синаптические веса, чтобы минимизировать чистый ввод в выходной блок и целевое значение.

Mathematical Formulation - Чтобы обновить синаптические веса, дельта-правило задается

$$ \ Delta w_ {i} \: = \: \ alpha \ :. x_ {i} .e_ {j} $$

Здесь $ \ Delta w_ {i} $ = изменение веса для i- го шаблона;

$ \ alpha $ = положительная и постоянная скорость обучения;

$ x_ {i} $ = входное значение от пресинаптического нейрона;

$ e_ {j} $ = $ (t \: - \: y_ {in}) $, разница между желаемым / целевым выходом и фактическим выходом $ y_ {in} $

Вышеупомянутое правило дельты применяется только для одного выходного устройства.

Обновление веса может быть выполнено в следующих двух случаях:

Case-I - когда t ≠ y, тогда

$$ w (новый) \: = \: w (старый) \: + \: \ Delta w $$

Case-II - когда t = y, тогда

Без изменения веса

Правило соревновательного обучения (победитель получает все)

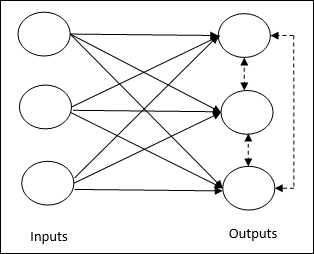

Он связан с обучением без учителя, в котором выходные узлы пытаются конкурировать друг с другом, чтобы представить входной шаблон. Чтобы понять это правило обучения, мы должны понять конкурентную сеть, которая представлена следующим образом:

Basic Concept of Competitive Network- Эта сеть похожа на однослойную сеть с прямой связью с обратной связью между выходами. Связи между выходами являются тормозными, показаны пунктирными линиями, что означает, что конкуренты никогда не поддерживают себя.

Basic Concept of Competitive Learning Rule- Как было сказано ранее, между выходными узлами будет конкуренция. Следовательно, основная концепция заключается в том, что во время обучения блок вывода с наибольшей активацией данного шаблона ввода будет объявлен победителем. Это правило также называется принципом «победитель получает все», потому что обновляется только нейрон-победитель, а остальные нейроны остаются без изменений.

Mathematical formulation - Ниже приведены три важных фактора для математической формулировки этого правила обучения.

Condition to be a winner - Предположим, что если нейрон $ y_ {k} $ хочет стать победителем, тогда будет следующее условие -

$$ y_ {k} \: = \: \ begin {cases} 1 & if \: v_ {k} \:> \: v_ {j} \: for \: all \: j, \: j \: \ neq \: k \\ 0 и иначе \ end {case} $$

Это означает, что если какой-либо нейрон, скажем, $ y_ {k} $ , хочет выиграть, то его индуцированное локальное поле (выход блока суммирования), скажем $ v_ {k} $, должно быть самым большим среди всех других нейронов. в сети.

Condition of sum total of weight - Другим ограничением правила конкурентного обучения является то, что сумма весов конкретного выходного нейрона будет равна 1. Например, если мы рассмотрим нейрон k тогда -

$$ \ displaystyle \ sum \ limits_ {j} w_ {kj} \: = \: 1 \: \: \: \: \: \: \: \: \: для \: all \: k $$

Change of weight for winner- Если нейрон не реагирует на входной паттерн, то в этом нейроне не происходит обучения. Однако, если побеждает конкретный нейрон, соответствующие веса корректируются следующим образом

$$ \ Delta w_ {kj} \: = \: \ begin {cases} - \ alpha (x_ {j} \: - \: w_ {kj}), & if \: нейрон \: k \: победит \\ 0, & if \: нейрон \: k \: loss \ end {cases} $$

Здесь $ \ alpha $ - скорость обучения.

Это ясно показывает, что мы отдаем предпочтение победившему нейрону, регулируя его вес, и если есть потеря нейрона, то нам не нужно беспокоиться о корректировке его веса.

Правило обучения Outstar

Это правило, введенное Гроссбергом, касается обучения с учителем, поскольку желаемые результаты известны. Это также называется обучением Гроссберга.

Basic Concept- Это правило применяется к нейронам, расположенным в слой. Он специально разработан для получения желаемого результатаd слоя p нейроны.

Mathematical Formulation - Корректировки веса в этом правиле рассчитываются следующим образом

$$ \ Delta w_ {j} \: = \: \ alpha \ :( d \: - \: w_ {j}) $$

Вот d - желаемый выход нейрона, а $ \ alpha $ - скорость обучения.