Kibana-クイックガイド

Kibana は、主に折れ線グラフ、棒グラフ、円グラフ、ヒートマップ、地域マップ、座標マップ、ゲージ、目標、タイムライオンなどの形式で大量のログを分析するために使用されるオープンソースのブラウザベースの視覚化ツールです。視覚化により簡単になります。入力ソースのエラーまたはその他の重要なイベントの傾向の変化を予測または確認するため。KibanaはElasticsearchおよびLogstashと同期して動作し、これらが一緒になっていわゆる ELK スタック。

ELKスタックとは何ですか?

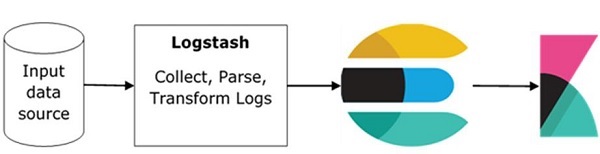

ELK Elasticsearch、Logstash、およびKibanaの略です。 ELKは、ログ分析に世界中で使用されている人気のあるログ管理プラットフォームの1つです。ELKスタックでは、Logstashはさまざまな入力ソースからログデータまたはその他のイベントを抽出します。イベントを処理し、後でElasticsearchに保存します。

Kibana Elasticsearchからログにアクセスし、折れ線グラフ、棒グラフ、円グラフなどの形式でユーザーに表示できる視覚化ツールです。

ELKスタックの基本的な流れをここの画像に示します-

Logstashは、ログがファイルされているすべてのリモートソースからデータを収集し、Elasticsearchにプッシュする責任があります。

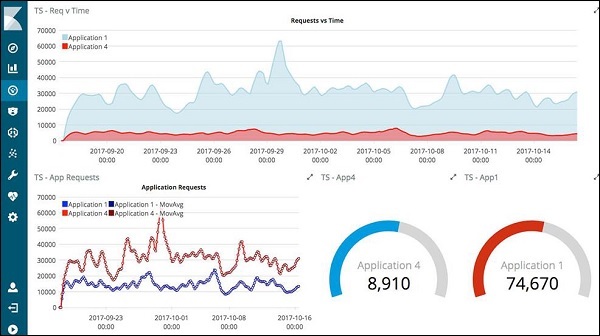

Elasticsearchはデータが収集されるデータベースとして機能し、KibanaはElasticsearchからのデータを使用して、以下に示すように、バーグラフ、円グラフ、ヒートマップの形式でユーザーにデータを表します。

データはリアルタイムで表示されます。たとえば、日単位または時間単位でユーザーに表示されます。Kibana UIはユーザーフレンドリーで、初心者でも非常に理解しやすいものです。

Kibanaの特徴

Kibanaは、ユーザーに次の機能を提供します-

視覚化

Kibanaには、データを簡単に視覚化する方法がたくさんあります。一般的に使用されているものには、縦棒グラフ、横棒グラフ、円グラフ、折れ線グラフ、ヒートマップなどがあります。

ダッシュボード

ビジュアライゼーションの準備ができたら、それらすべてを1つのボード(ダッシュボード)に配置できます。さまざまなセクションを一緒に観察すると、正確に何が起こっているかについての明確な全体的なアイデアが得られます。

開発ツール

開発ツールを使用してインデックスを操作できます。初心者は、開発ツールからダミーインデックスを追加したり、データを追加、更新、削除したり、インデックスを使用して視覚化を作成したりできます。

レポート

視覚化およびダッシュボードの形式のすべてのデータは、レポート(CSV形式)に変換したり、コードに埋め込んだり、URLの形式で他のユーザーと共有したりできます。

フィルタと検索クエリ

フィルタと検索クエリを利用して、ダッシュボードまたは視覚化ツールから特定の入力に必要な詳細を取得できます。

プラグイン

サードパーティのプラグインを追加して、Kibanaに新しい視覚化やその他のUIを追加できます。

座標マップと地域マップ

Kibanaの座標および地域マップは、地理マップ上に視覚化を表示して、データの現実的なビューを提供するのに役立ちます。

タイムライオン

Timelion、別名 timelineは、主に時間ベースのデータ分析に使用されるさらに別の視覚化ツールです。タイムラインを操作するには、インデックスに接続し、データに対して計算を実行して必要な結果を取得するのに役立つ単純な式言語を使用する必要があります。週、月などの点で、前のサイクルとデータを比較するのに役立ちます。

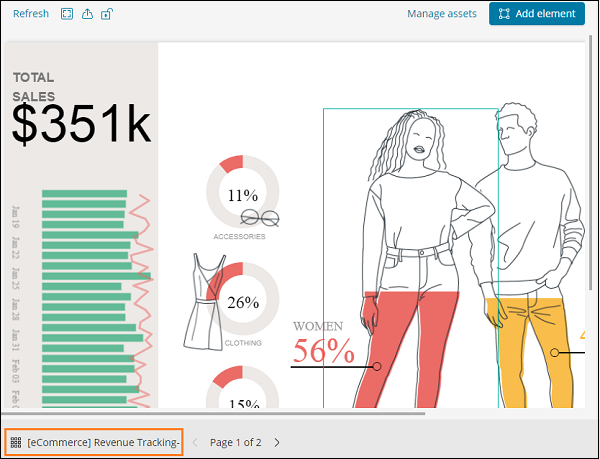

キャンバス

Canvasは、Kibanaのもう1つの強力な機能です。キャンバスの視覚化を使用すると、さまざまな色の組み合わせ、形状、テキスト、基本的にワークパッドと呼ばれる複数のページでデータを表すことができます。

Kibanaの利点

Kibanaは、ユーザーに次の利点を提供します-

主に折れ線グラフ、棒グラフ、円グラフ、ヒートマップなどの形式で大量のログを分析するために使用されるオープンソースのブラウザベースの視覚化ツールが含まれています。

初心者でも簡単に理解できます。

視覚化とダッシュボードのレポートへの変換の容易さ。

キャンバスの視覚化は、複雑なデータを簡単な方法で分析するのに役立ちます。

KibanaでのTimelionの視覚化は、データを逆方向に比較してパフォーマンスをよりよく理解するのに役立ちます。

Kibanaのデメリット

バージョンの不一致がある場合、Kibanaにプラグインを追加するのは非常に面倒です。

古いバージョンから新しいバージョンにアップグレードする場合、問題が発生する傾向があります。

Kibanaの使用を開始するには、Logstash、Elasticsearch、およびKibanaをインストールする必要があります。この章では、ここでELKスタックのインストールについて理解しようとします。

ここでは、次のインストールについて説明します-

- Elasticsearchのインストール

- Logstashのインストール

- Kibanaのインストール

Elasticsearchのインストール

Elasticsearchの詳細なドキュメントは、ライブラリにあります。ここでelasticsearchのインストールを確認できます。Elasticsearchをインストールするには、チュートリアルに記載されている手順に従う必要があります。

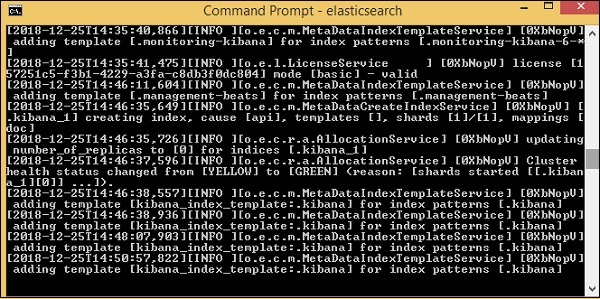

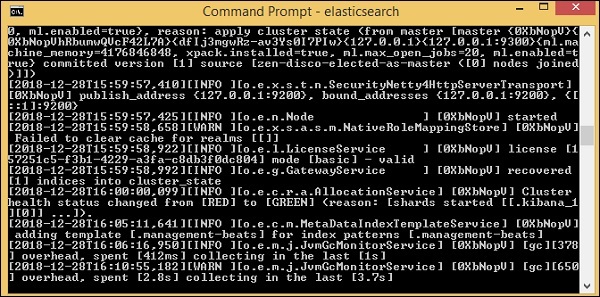

インストールが完了したら、次のようにElasticsearchサーバーを起動します-

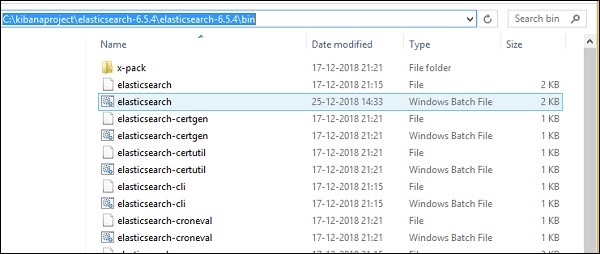

ステップ1

For Windows

> cd kibanaproject/elasticsearch-6.5.4/elasticsearch-6.5.4/bin

> elasticsearchWindowsユーザーの場合、JAVA_HOME変数をjavajdkパスに設定する必要があることに注意してください。

For Linux

$ cd kibanaproject/elasticsearch-6.5.4/elasticsearch-6.5.4/bin $ elasticsearch

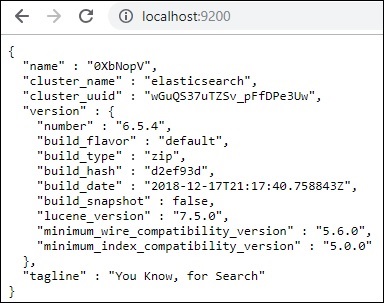

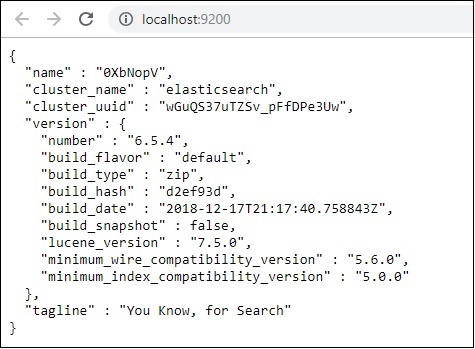

Elasticsearchのデフォルトのポートは9200です。完了したら、ローカルホストのポート9200でelasticsearchを確認できます。 http://localhost:9200/as 以下に示す-

Logstashのインストール

Logstashインストールの場合、この従っelasticsearchインストールすでに我々のライブラリに存在しています。

Kibanaのインストール

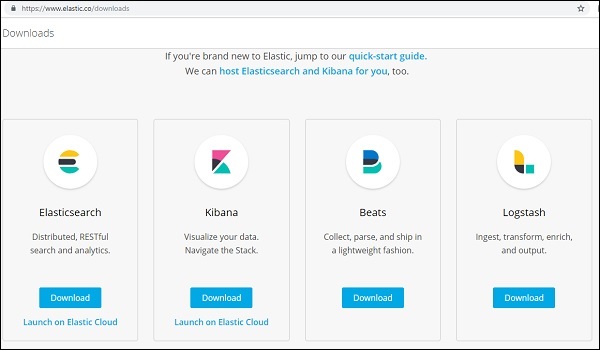

Kibanaの公式サイトにアクセスします-https://www.elastic.co/products/kibana

右上隅のダウンロードリンクをクリックすると、次のような画面が表示されます-

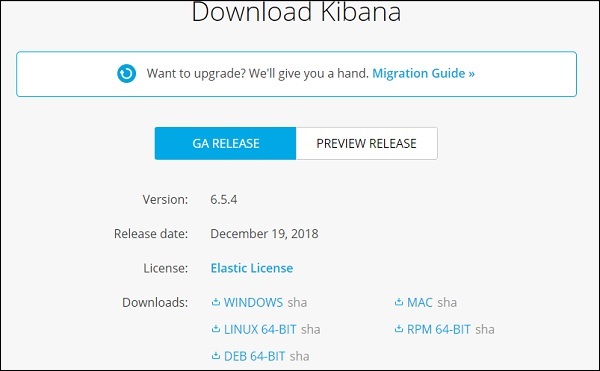

Kibanaの[ダウンロード]ボタンをクリックします。Kibanaで動作するには、64ビットマシンが必要であり、32ビットでは動作しないことに注意してください。

このチュートリアルでは、Kibanaバージョン6を使用します。ダウンロードオプションは、Windows、Mac、およびLinuxで使用できます。お好みでダウンロードできます。

フォルダを作成し、kibanaのtar / zipダウンロードを解凍します。Elasticsearchにアップロードされたサンプルデータを使用します。したがって、ここでは、elasticsearchとkibanaを開始する方法を見てみましょう。これを行うには、Kibanaが解凍されているフォルダーに移動します。

For Windows

> cd kibanaproject/kibana-6.5.4/kibana-6.5.4/bin

> kibanaFor Linux

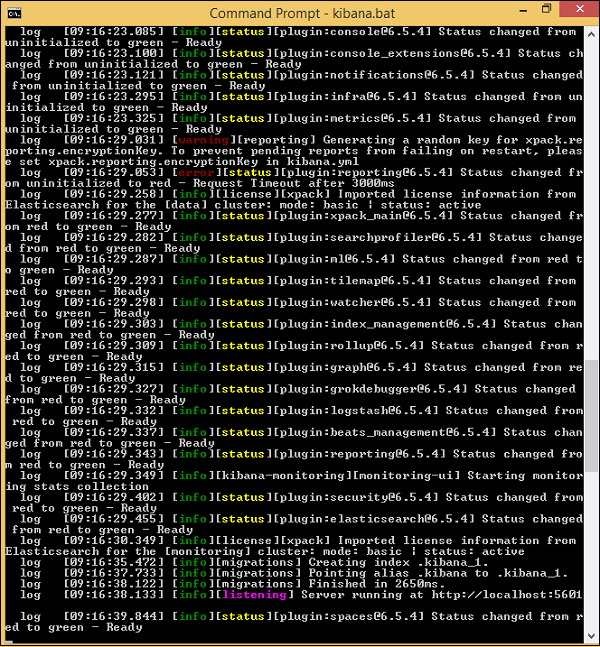

$ cd kibanaproject/kibana-6.5.4/kibana-6.5.4/bin $ kibanaKibanaが起動すると、ユーザーは次の画面を見ることができます-

コンソールに準備完了信号が表示されたら、ブラウザでKibanaを開くことができます。 http://localhost:5601/.kibanaを使用できるデフォルトのポートは5601です。

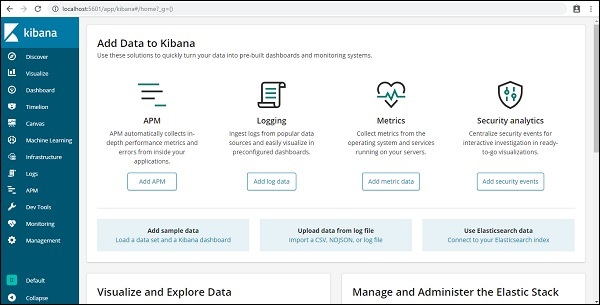

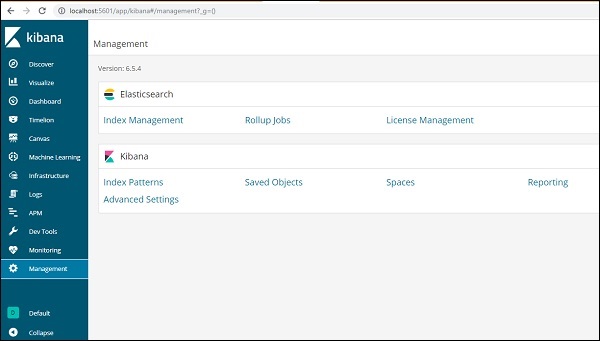

Kibanaのユーザーインターフェイスは次のとおりです-

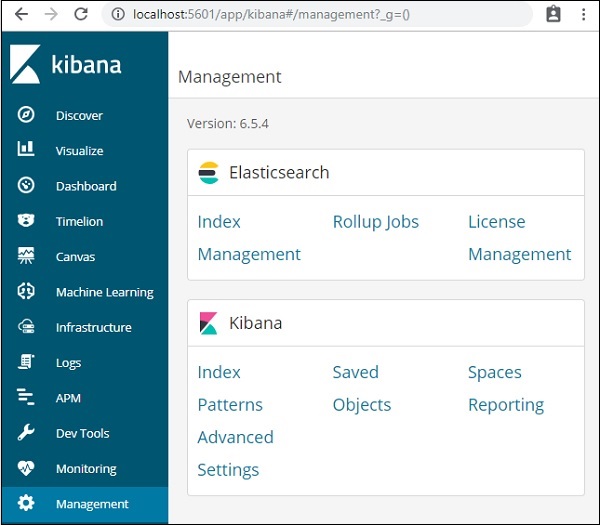

次の章では、KibanaのUIの使用方法を学習します。Kibana UIでKibanaのバージョンを確認するには、左側の[管理]タブに移動すると、現在使用しているKibanaのバージョンが表示されます。

Kibanaは、主に線グラフ、棒グラフ、円グラフ、ヒートマップなどの形式で大量のログを分析するために使用されるオープンソースの視覚化ツールです。KibanaはElasticsearchおよびLogstashと同期して動作し、これらが一緒になっていわゆる ELK スタック。

ELK Elasticsearch、Logstash、およびKibanaの略です。 ELK は、ログ分析に世界中で使用されている人気のあるログ管理プラットフォームの1つです。

ELKスタック内-

Logstashさまざまな入力ソースからログデータまたはその他のイベントを抽出します。イベントを処理し、後でElasticsearchに保存します。

Kibana Elasticsearchからログにアクセスし、折れ線グラフ、棒グラフ、円グラフなどの形式でユーザーに表示できる視覚化ツールです。

このチュートリアルでは、KibanaおよびElasticsearchと緊密に連携し、さまざまな形式でデータを視覚化します。

この章では、ELKスタックを一緒に使用する方法を理解しましょう。その上、あなたはまたどのようにするかを見るでしょう-

- LogstashからElasticsearchにCSVデータをロードします。

- KibanaのElasticsearchのインデックスを使用します。

LogstashからElasticsearchにCSVデータをロードする

CSVデータを使用して、Logstashを使用してElasticsearchにデータをアップロードします。データ分析に取り組むために、kaggle.comのWebサイトからデータを取得できます。Kaggle.comサイトにはすべての種類のデータがアップロードされており、ユーザーはそれを使用してデータ分析に取り組むことができます。

ここからcountries.csvデータを取得しました: https://www.kaggle.com/fernandol/countries-of-the-world。csvファイルをダウンロードして使用できます。

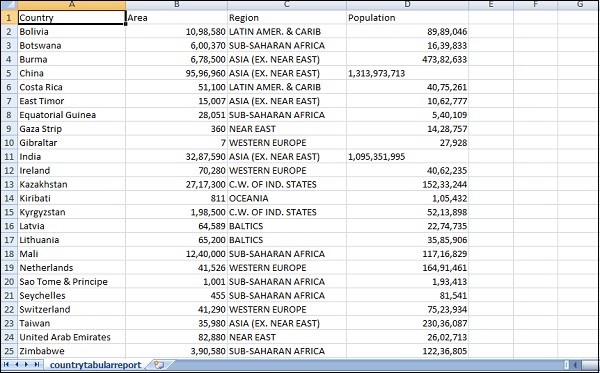

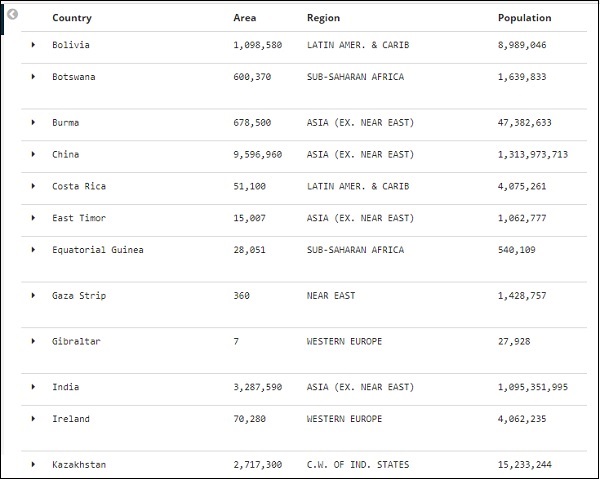

使用するcsvファイルには以下の詳細があります。

ファイル名-countriesdata.csv

列- 「国」、「地域」、「人口」、「地域」

ダミーのcsvファイルを作成して使用することもできます。logstashを使用して、このデータをcountriesdata.csvからelasticsearchにダンプします。

ターミナルでelasticsearchとKibanaを起動し、実行を続けます。以下に示すlogstash-configファイルに示すように、CSVファイルの列に関する詳細とその他の詳細を含むlogstashの構成ファイルを作成する必要があります。

input {

file {

path => "C:/kibanaproject/countriesdata.csv"

start_position => "beginning"

sincedb_path => "NUL"

}

}

filter {

csv {

separator => ","

columns => ["Country","Region","Population","Area"]

}

mutate {convert => ["Population", "integer"]}

mutate {convert => ["Area", "integer"]}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

=> "countriesdata-%{+dd.MM.YYYY}"

}

stdout {codec => json_lines }

}設定ファイルでは、3つのコンポーネントを作成しました-

入力

入力ファイルのパスを指定する必要があります。この場合はcsvファイルです。csvファイルが保存されているパスがパスフィールドに指定されます。

フィルタ

区切り文字が使用されたcsvコンポーネント(この場合はコンマ)と、csvファイルで使用可能な列があります。logstashは、入ってくるすべてのデータを文字列と見なすため、任意の列を整数として使用する場合は、上記のようにmutateを使用して同じものを指定する必要があります。

出力

出力については、データを配置する必要がある場所を指定する必要があります。ここでは、elasticsearchを使用しています。Elasticsearchに提供する必要のあるデータは、elasticsearchが実行されているホストであり、localhostと呼びます。の次のフィールドは、countries- currentdateという名前を付けたインデックスです。Elasticsearchでデータが更新されたら、Kibanaで同じインデックスを使用する必要があります。

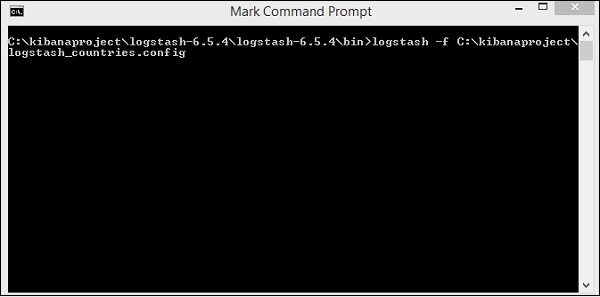

上記の設定ファイルをlogstash_countries.configとして保存します。次のステップで、この構成のパスをlogstashコマンドに指定する必要があることに注意してください。

csvファイルからelasticsearchにデータをロードするには、elasticsearchサーバーを起動する必要があります-

今、実行します http://localhost:9200 ブラウザでelasticsearchが正常に実行されているかどうかを確認します。

Elasticsearchを実行しています。次に、logstashがインストールされているパスに移動し、次のコマンドを実行してデータをelasticsearchにアップロードします。

> logstash -f logstash_countries.conf

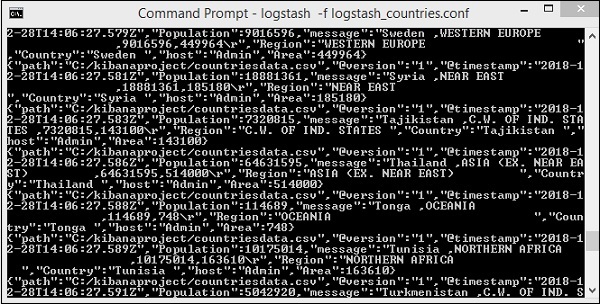

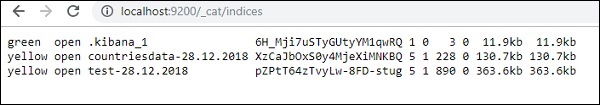

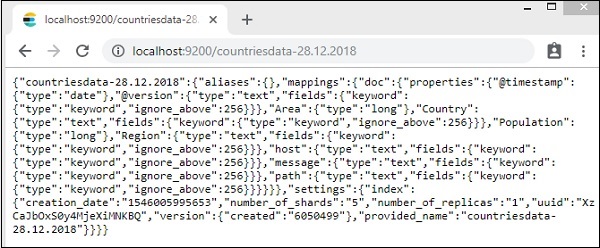

上の画面は、CSVファイルからElasticsearchへのデータの読み込みを示しています。Elasticsearchでインデックスが作成されているかどうかを知るには、次のように確認できます。

上記のように作成されたcountriesdata-28.12.2018インデックスを確認できます。

インデックスの詳細-国-2018年12月28日は次のとおりです-

プロパティ付きのマッピングの詳細は、データがlogstashからelasticsearchにアップロードされるときに作成されることに注意してください。

KibanaでElasticsearchのデータを使用する

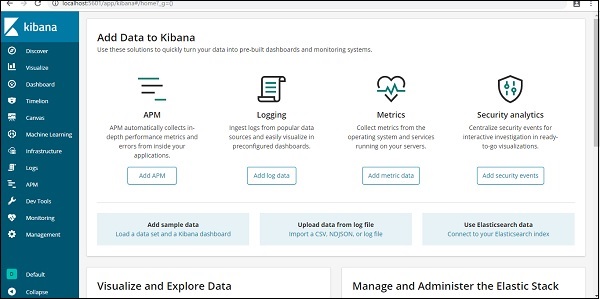

現在、ローカルホストのポート5601でKibanaを実行しています。 http://localhost:5601。KibanaのUIをここに示します-

KibanaはすでにElasticsearchに接続されており、表示できるはずです。 index :countries-28.12.2018 キバナの中。

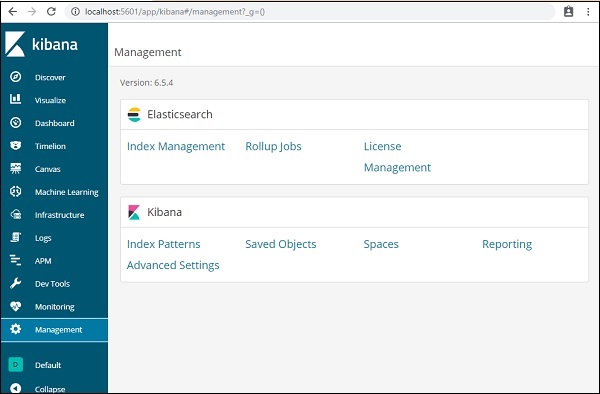

Kibana UIで、左側の[管理メニュー]オプションをクリックします-

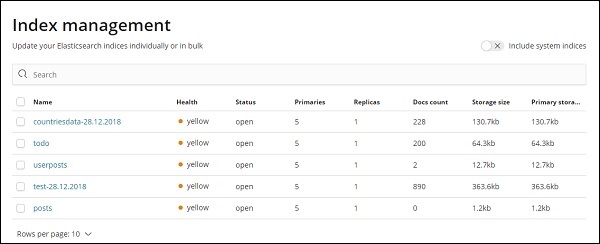

次に、[インデックス管理]-をクリックします。

Elasticsearchに存在するインデックスは、インデックス管理に表示されます。Kibanaで使用するインデックスはcountriesdata-28.12.2018です。

したがって、Kibanaにはすでにelasticsearchインデックスがあるので、次に、Kibanaのインデックスを使用して、円グラフ、棒グラフ、折れ線グラフなどの形式でデータを視覚化する方法を理解します。

logstashからelasticsearchにデータをアップロードする方法を見てきました。ここでは、logstashとelasticsearchを使用してデータをアップロードします。ただし、使用する必要のある日付、経度、緯度フィールドを持つデータについては、次の章で学習します。CSVファイルがない場合は、Kibanaに直接データをアップロードする方法も説明します。

この章では、次のトピックについて説明します-

- Elasticsearchで日付、経度、緯度のフィールドを持つLogstashアップロードデータを使用する

- 開発ツールを使用してバルクデータをアップロードする

Elasticsearchのフィールドを持つデータにLogstashアップロードを使用する

CSV形式のデータを使用します。同じものは、分析に使用できるデータを扱うKaggle.comから取得されます。

ここで使用される在宅医療訪問のデータは、サイトKaggle.comから取得されます。

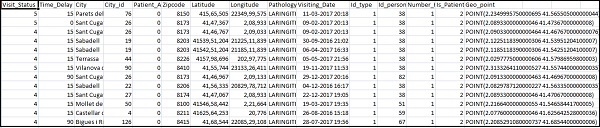

CSVファイルで使用できるフィールドは次のとおりです-

["Visit_Status","Time_Delay","City","City_id","Patient_Age","Zipcode","Latitude","Longitude",

"Pathology","Visiting_Date","Id_type","Id_personal","Number_Home_Visits","Is_Patient_Minor","Geo_point"]Home_visits.csvは次のとおりです-

以下は、logstashで使用されるconfファイルです-

input {

file {

path => "C:/kibanaproject/home_visits.csv"

start_position => "beginning"

sincedb_path => "NUL"

}

}

filter {

csv {

separator => ","

columns =>

["Visit_Status","Time_Delay","City","City_id","Patient_Age",

"Zipcode","Latitude","Longitude","Pathology","Visiting_Date",

"Id_type","Id_personal","Number_Home_Visits","Is_Patient_Minor","Geo_point"]

}

date {

match => ["Visiting_Date","dd-MM-YYYY HH:mm"]

target => "Visiting_Date"

}

mutate {convert => ["Number_Home_Visits", "integer"]}

mutate {convert => ["City_id", "integer"]}

mutate {convert => ["Id_personal", "integer"]}

mutate {convert => ["Id_type", "integer"]}

mutate {convert => ["Zipcode", "integer"]}

mutate {convert => ["Patient_Age", "integer"]}

mutate {

convert => { "Longitude" => "float" }

convert => { "Latitude" => "float" }

}

mutate {

rename => {

"Longitude" => "[location][lon]"

"Latitude" => "[location][lat]"

}

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "medicalvisits-%{+dd.MM.YYYY}"

}

stdout {codec => json_lines }

}デフォルトでは、logstashはelasticsearchにアップロードされたすべてのものを文字列と見なします。CSVファイルに日付フィールドがある場合は、日付形式を取得するために次の手順を実行する必要があります。

For date field −

date {

match => ["Visiting_Date","dd-MM-YYYY HH:mm"]

target => "Visiting_Date"

}地理的位置の場合、elasticsearchは-と同じように理解します

"location": {

"lat":41.565505000000044,

"lon": 2.2349995750000695

}したがって、elasticsearchが必要とする形式で経度と緯度があることを確認する必要があります。したがって、最初に経度と緯度を浮動小数点に変換し、後で名前を変更して、の一部として使用できるようにする必要があります。location jsonオブジェクトと lat そして lon。同じためのコードはここに示されています-

mutate {

convert => { "Longitude" => "float" }

convert => { "Latitude" => "float" }

}

mutate {

rename => {

"Longitude" => "[location][lon]"

"Latitude" => "[location][lat]"

}

}フィールドを整数に変換するには、次のコードを使用します-

mutate {convert => ["Number_Home_Visits", "integer"]}

mutate {convert => ["City_id", "integer"]}

mutate {convert => ["Id_personal", "integer"]}

mutate {convert => ["Id_type", "integer"]}

mutate {convert => ["Zipcode", "integer"]}

mutate {convert => ["Patient_Age", "integer"]}フィールドが処理されたら、次のコマンドを実行してelasticsearchにデータをアップロードします-

- Logstash binディレクトリ内に移動し、次のコマンドを実行します。

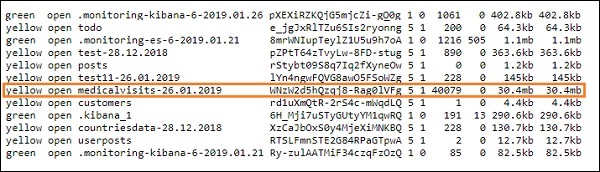

logstash -f logstash_homevisists.conf- 完了すると、以下に示すように、elasticsearchのlogstashconfファイルに記載されているインデックスが表示されます。

これで、アップロードされた上記のインデックスにインデックスパターンを作成し、それをさらに視覚化の作成に使用できます。

開発ツールを使用してバルクデータをアップロードする

KibanaUIの開発ツールを使用します。開発ツールは、Logstashを使用せずにElasticsearchにデータをアップロードするのに役立ちます。開発ツールを使用して、Kibanaに必要なデータを投稿、配置、削除、検索できます。

このセクションでは、サンプルデータをKibana自体にロードしてみます。これを使用してサンプルデータを練習し、Kibanaの機能を試して、Kibanaをよく理解することができます。

次のURLからjsonデータを取得し、Kibanaにアップロードしましょう。同様に、サンプルのjsonデータをKibana内にロードしてみることができます。

サンプルデータのアップロードを開始する前に、elasticsearchで使用するインデックス付きのjsonデータを用意する必要があります。logstashを使用してアップロードする場合、logstashはインデックスを追加するように注意し、ユーザーはelasticsearchに必要なインデックスについて気にする必要はありません。

通常のJsonデータ

[

{"type":"act","line_id":1,"play_name":"Henry IV",

"speech_number":"","line_number":"","speaker":"","text_entry":"ACT I"},

{"type":"scene","line_id":2,"play_name":"Henry IV",

"speech_number":"","line_number":"","speaker":"","text_entry":"SCENE I.London. The palace."},

{"type":"line","line_id":3,"play_name":"Henry IV",

"speech_number":"","line_number":"","speaker":"","text_entry":

"Enter KING HENRY, LORD JOHN OF LANCASTER, the

EARL of WESTMORELAND, SIR WALTER BLUNT, and others"}

]Kibanaで使用するjsonコードは、次のようにインデックスを付ける必要があります-

{"index":{"_index":"shakespeare","_id":0}}

{"type":"act","line_id":1,"play_name":"Henry IV",

"speech_number":"","line_number":"","speaker":"","text_entry":"ACT I"}

{"index":{"_index":"shakespeare","_id":1}}

{"type":"scene","line_id":2,"play_name":"Henry IV",

"speech_number":"","line_number":"","speaker":"",

"text_entry":"SCENE I. London. The palace."}

{"index":{"_index":"shakespeare","_id":2}}

{"type":"line","line_id":3,"play_name":"Henry IV",

"speech_number":"","line_number":"","speaker":"","text_entry":

"Enter KING HENRY, LORD JOHN OF LANCASTER, the EARL

of WESTMORELAND, SIR WALTER BLUNT, and others"}jsonfileに入る追加のデータがあることに注意してください-{"index":{"_index":"nameofindex","_id":key}}。

Elasticsearchと互換性のあるサンプルjsonファイルを変換するために、ここにphpに小さなコードがあり、elasticsearchが必要とする形式で指定されたjsonファイルを出力します。

PHPコード

<?php

$myfile = fopen("todo.json", "r") or die("Unable to open file!"); // your json file here $alldata = fread($myfile,filesize("todo.json")); fclose($myfile);

$farray = json_decode($alldata);

$afinalarray = []; $index_name = "todo";

$i=0; $myfile1 = fopen("todonewfile.json", "w") or die("Unable to open file!"); //

writes a new file to be used in kibana dev tool

foreach ($farray as $a => $value) { $_index = json_decode('{"index": {"_index": "'.$index_name.'", "_id": "'.$i.'"}}');

fwrite($myfile1, json_encode($_index));

fwrite($myfile1, "\n"); fwrite($myfile1, json_encode($value)); fwrite($myfile1, "\n");

$i++;

}

?>todojsonファイルをから取得しました https://jsonplaceholder.typicode.com/todos phpコードを使用して、Kibanaにアップロードする必要のある形式に変換します。

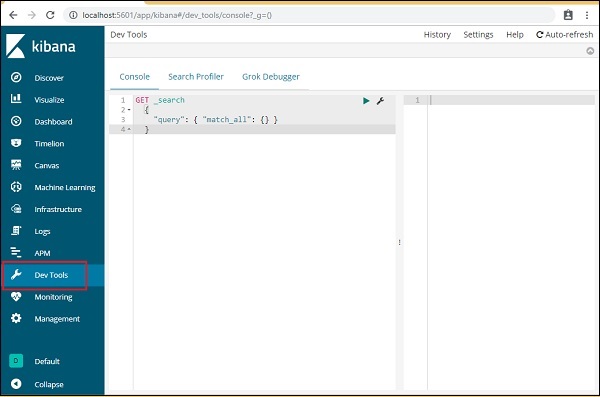

サンプルデータをロードするには、以下に示すように[開発ツール]タブを開きます-

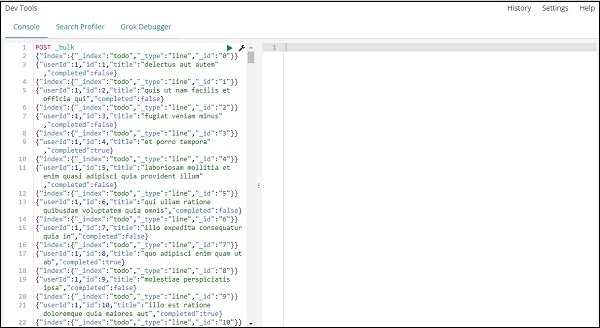

上記のようにコンソールを使用します。phpコードで実行した後に取得したjsonデータを取得します。

jsonデータをアップロードするために開発ツールで使用されるコマンドは次のとおりです。

POST _bulk作成しているインデックスの名前はtodoであることに注意してください。

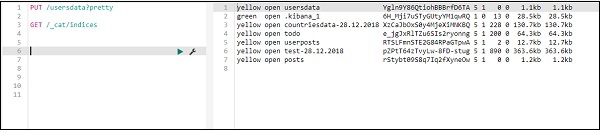

データがアップロードされている緑色のボタンをクリックすると、次のようにElasticsearchでインデックスが作成されているかどうかを確認できます-

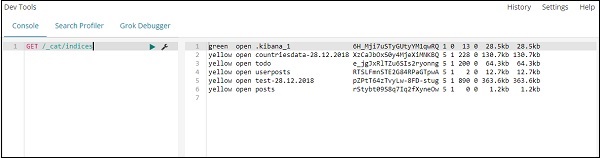

次のように開発ツール自体で同じことを確認できます-

Command −

GET /_cat/indices

index:todoで何かを検索したい場合は、以下に示すようにそれを行うことができます-

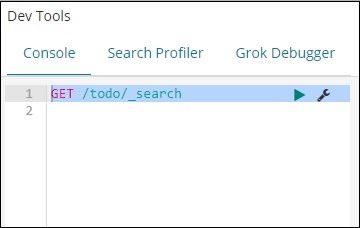

Command in dev tool

GET /todo/_search

上記の検索の出力は次のとおりです-

todoindexに存在するすべてのレコードを提供します。私たちが取得している合計レコードは200です。

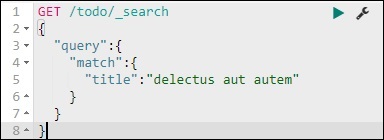

todoインデックスでレコードを検索する

次のコマンドを使用してそれを行うことができます-

GET /todo/_search

{

"query":{

"match":{

"title":"delectusautautem"

}

}

}

与えたタイトルと一致するレコードをフェッチすることができます。

Kibanaの管理セクションは、インデックスパターンを管理するために使用されます。この章では、次のことについて説明します。

- 時間フィルターフィールドなしでインデックスパターンを作成する

- 時間フィルターフィールドを使用してインデックスパターンを作成する

時間フィルターフィールドなしでインデックスパターンを作成する

これを行うには、Kibana UIに移動し、[管理]-をクリックします。

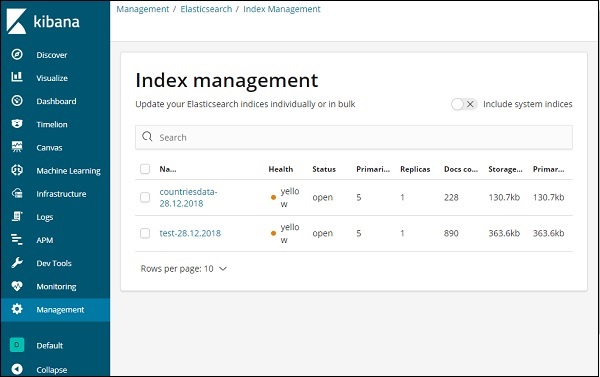

Kibanaを使用するには、まず、elasticsearchから入力されるインデックスを作成する必要があります。図のように、Elasticsearch→インデックス管理から利用可能なすべてのインデックスを取得できます-

現在、elasticsearchには上記のインデックスがあります。ドキュメント数は、各インデックスで使用可能なレコードの数を示します。更新されたインデックスがある場合、ドキュメント数は変化し続けます。プライマリストレージは、アップロードされた各インデックスのサイズを示します。

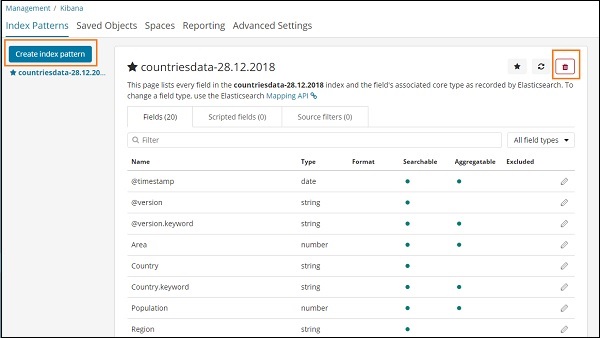

Kibanaで新しいインデックスを作成するには、以下に示すようにインデックスパターンをクリックする必要があります-

[インデックスパターン]をクリックすると、次の画面が表示されます-

[インデックスパターンの作成]ボタンは、新しいインデックスを作成するために使用されることに注意してください。チュートリアルの最初に作成されたcountriesdata-28.12.2018がすでにあることを思い出してください。

時間フィルターフィールドを使用してインデックスパターンを作成する

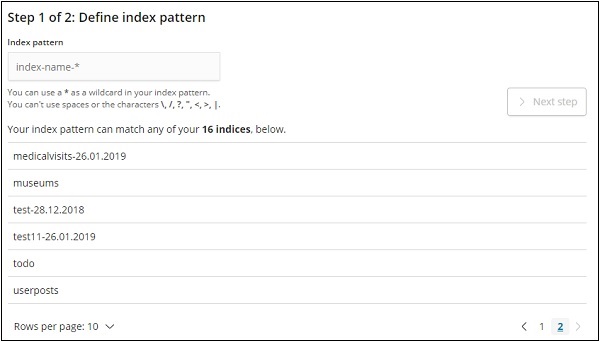

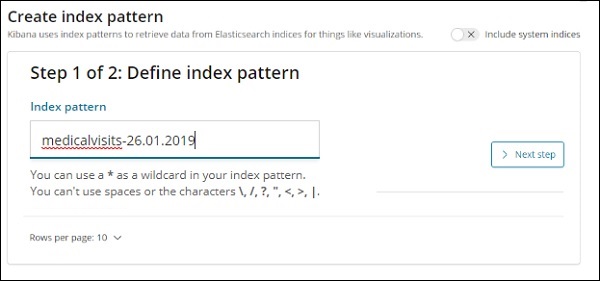

[インデックスパターンの作成]をクリックして、新しいインデックスを作成します。

elasticsearchのインデックスが表示されます。1つを選択して新しいインデックスを作成します。

次に、[次のステップ]をクリックします。

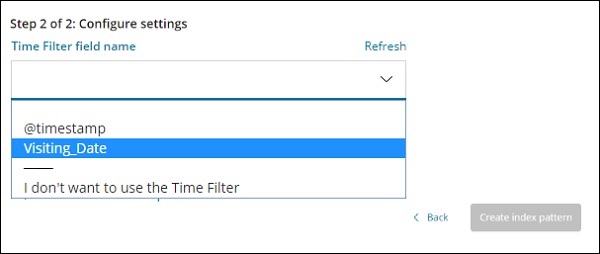

次のステップは、設定を構成することです。ここで、次のように入力する必要があります-

時間フィルターフィールド名は、時間に基づいてデータをフィルター処理するために使用されます。ドロップダウンには、インデックスのすべての時刻と日付に関連するフィールドが表示されます。

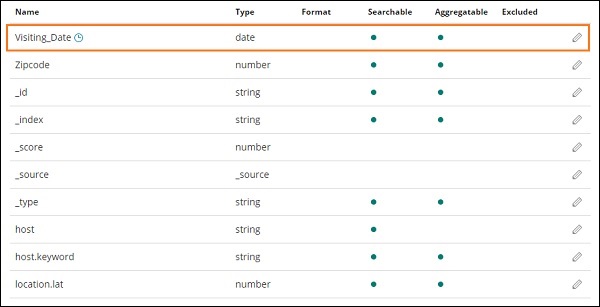

以下に示す画像では、日付フィールドとしてVisiting_Dateがあります。時間フィルターフィールド名としてVisiting_Dateを選択します。

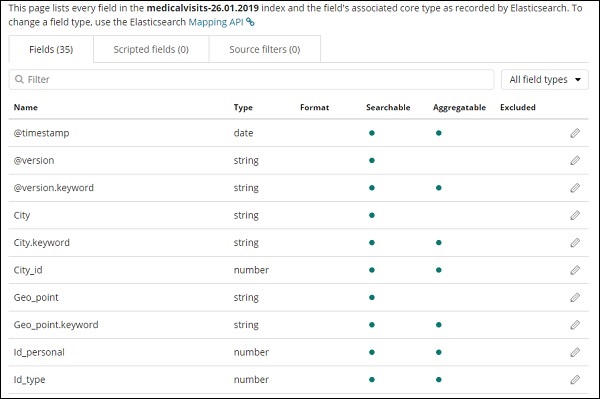

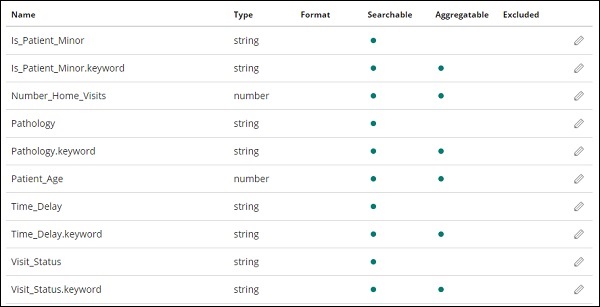

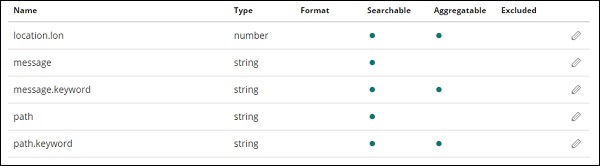

クリック Create index patternボタンをクリックしてインデックスを作成します。完了すると、以下に示すように、インデックスmedicalvisits-26.01.2019に存在するすべてのフィールドが表示されます-

インデックスmedicalvisitsには次のフィールドがあります-26.01.2019−

["Visit_Status","Time_Delay","City","City_id","Patient_Age","Zipcode","Latitude

","Longitude","Pathology","Visiting_Date","Id_type","Id_personal","Number_Home_

Visits","Is_Patient_Minor","Geo_point"].インデックスには、在宅医療訪問のすべてのデータが含まれています。logstashから挿入されたときにelasticsearchによって追加されるいくつかの追加フィールドがあります。

この章では、KibanaUIの[検出]タブについて説明します。以下の概念について詳しく学びます-

- 日付フィールドのないインデックス

- 日付フィールドのあるインデックス

日付フィールドのないインデックス

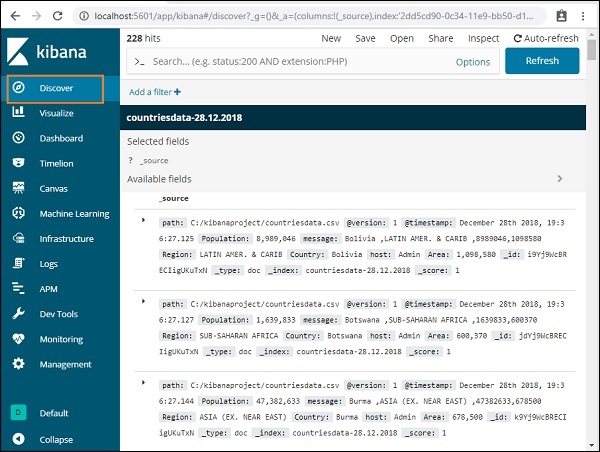

以下に示すように、左側のメニューで[検出]を選択します-

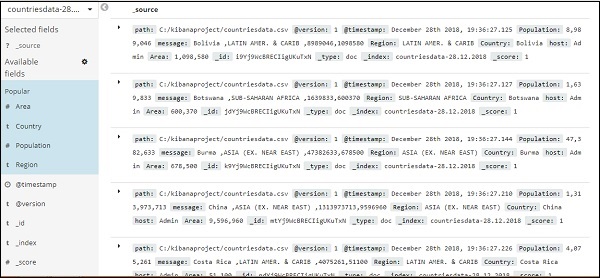

右側には、で利用可能なデータの詳細が表示されます。 countriesdata- 28.12.2018 前の章で作成したインデックス。

左上隅に、使用可能なレコードの総数が表示されます-

インデックス内のデータの詳細を取得できます (countriesdata-28.12.2018)このタブで。上記の画面の左上隅に、[新規]、[保存]、[開く]、[共有]、[検査]、[自動更新]などのボタンが表示されます。

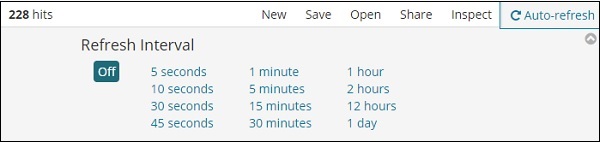

[自動更新]をクリックすると、次のような画面が表示されます-

上から秒、分、または時間をクリックして、自動更新間隔を設定できます。Kibanaは、設定したインターバルタイマーごとに画面を自動更新し、新しいデータを取得します。

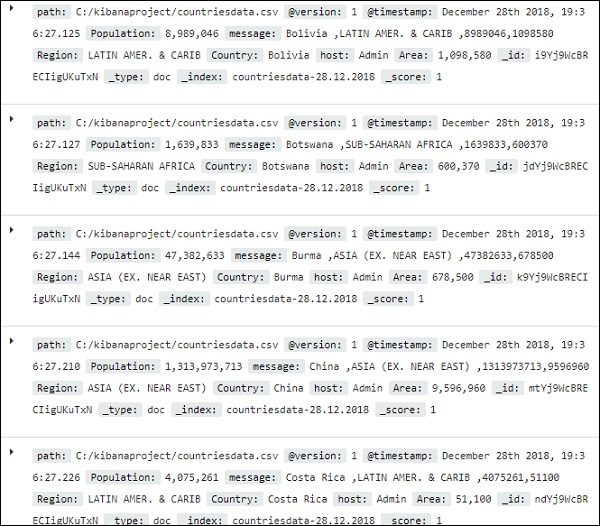

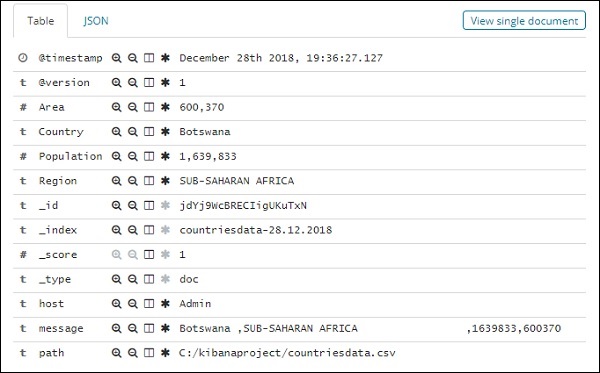

からのデータ index:countriesdata-28.12.2018 以下のように表示されます−

データとともにすべてのフィールドが行ごとに表示されます。矢印をクリックして行を展開すると、テーブル形式またはJSON形式で詳細が表示されます

JSON形式

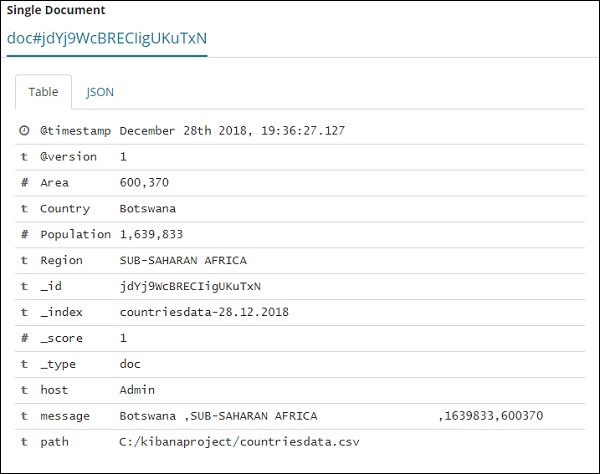

左側に[単一のドキュメントを表示]というボタンがあります。

クリックすると、以下のようにページ内の行または行に存在するデータが表示されます-

ここではすべてのデータの詳細を取得していますが、それぞれを確認することは困難です。

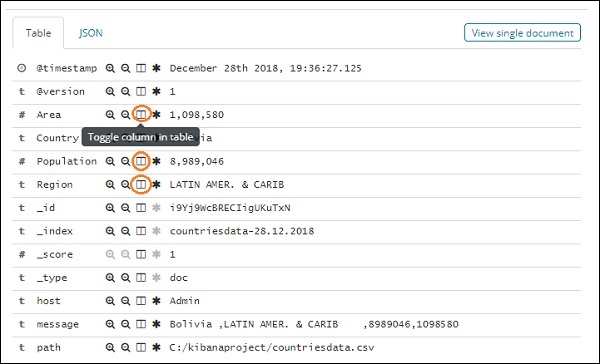

次に、表形式でデータを取得してみましょう。行の1つを展開し、各フィールドで使用可能な列の切り替えオプションをクリックする1つの方法を以下に示します-

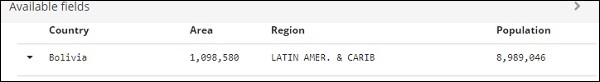

それぞれに使用可能なテーブルオプションの列を切り替えるをクリックすると、データがテーブル形式で表示されていることがわかります-

ここでは、国、地域、地域、人口のフィールドを選択しました。展開された行を折りたたむと、すべてのデータが表形式で表示されます。

選択したフィールドは、以下のように画面の左側に表示されます-

選択されたフィールドと使用可能なフィールドの2つのオプションがあることに注意してください。表形式で表示するために選択したフィールドは、選択したフィールドの一部です。フィールドを削除したい場合は、選択したフィールドオプションのフィールド名全体に表示される削除ボタンをクリックして削除できます。

削除すると、フィールドは[利用可能]フィールド内で使用できるようになり、目的のフィールド全体に表示される[追加]ボタンをクリックして追加し直すことができます。このメソッドを使用して、[使用可能なフィールド]から必須フィールドを選択することにより、データを表形式で取得することもできます。

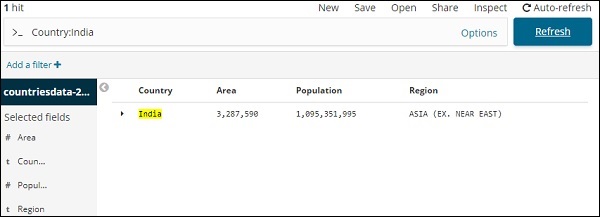

Discoverには、インデックス内のデータを検索するために使用できる検索オプションがあります。ここで検索オプションに関連する例を試してみましょう-

インドの国を検索するとします。次のように実行できます-

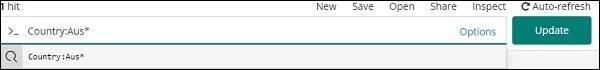

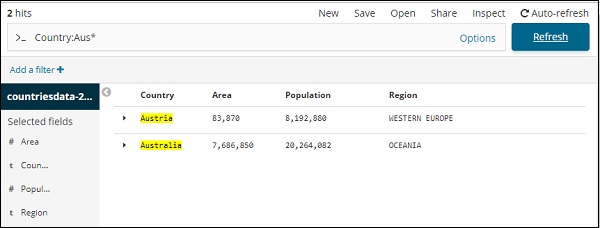

検索の詳細を入力して、[更新]ボタンをクリックできます。Ausで始まる国を検索する場合は、次のように検索できます。

結果を表示するには、[更新]をクリックします

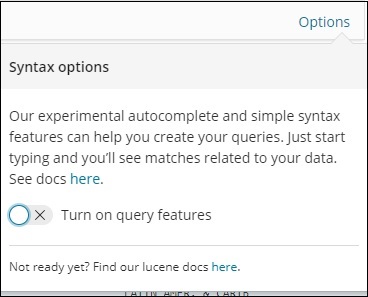

ここでは、Aus *で始まる2つの国があります。上記のように、検索フィールドには[オプション]ボタンがあります。ユーザーがそれをクリックすると、トグルボタンが表示されます。これは、オンのときに検索クエリの記述に役立ちます。

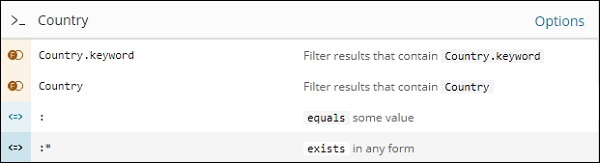

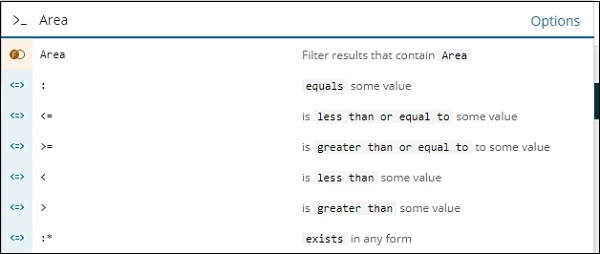

クエリ機能をオンにして、検索でフィールド名を入力すると、そのフィールドで使用可能なオプションが表示されます。

たとえば、Countryフィールドは文字列であり、文字列フィールドに次のオプションが表示されます-

同様に、AreaはNumberフィールドであり、Numberフィールド-の次のオプションが表示されます。

さまざまな組み合わせを試して、[検出]フィールドでの選択に従ってデータをフィルタリングできます。[検出]タブ内のデータは、[保存]ボタンを使用して保存できるため、将来の目的で使用できます。

Discover内のデータを保存するには、以下に示すように右上隅にある保存ボタンをクリックします-

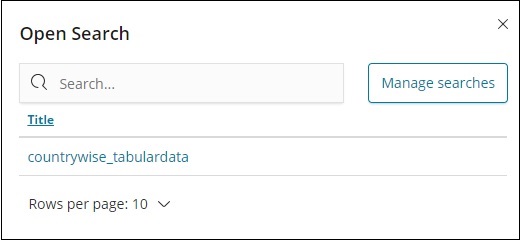

検索にタイトルを付け、[保存の確認]をクリックして保存します。保存したら、次に[検出]タブにアクセスしたときに、右上隅にある[開く]ボタンをクリックして、以下に示すように保存されたタイトルを取得できます。

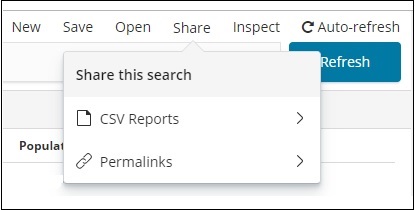

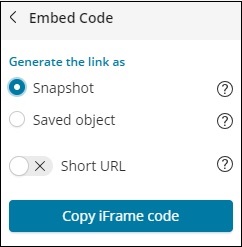

右上隅にある[共有]ボタンを使用して、他のユーザーとデータを共有することもできます。クリックすると、以下のような共有オプションが表示されます-

CSVレポートを使用するか、パーマリンクの形式で共有できます。

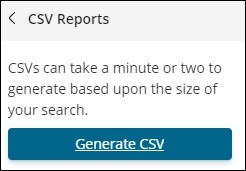

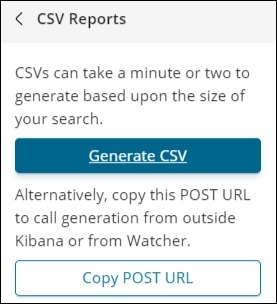

CSVレポートでonclickで使用できるオプションは次のとおりです。

[CSVの生成]をクリックして、レポートを他のユーザーと共有します。

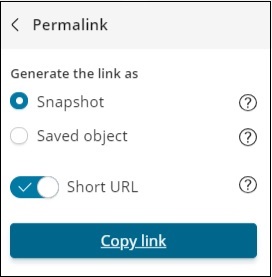

パーマリンクのonclickで利用可能なオプションは次のとおりです-

スナップショットオプションは、現在検索で利用可能なデータを表示するKibanaリンクを提供します。

[保存されたオブジェクト]オプションは、検索で利用可能な最近のデータを表示するKibanaリンクを提供します。

スナップショット- http://localhost:5601/goto/309a983483fccd423950cfb708fabfa5 保存されたオブジェクト:http:// localhost:5601 / app / kibana#/ Discover / 40bd89d0-10b1-11e9-9876-4f3d759b471e?_g =()

[検出]タブと利用可能な検索オプションを使用して、取得した結果を保存して他のユーザーと共有できます。

日付フィールドのあるインデックス

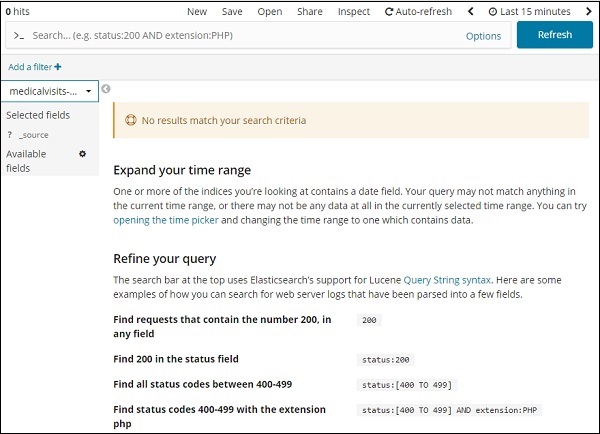

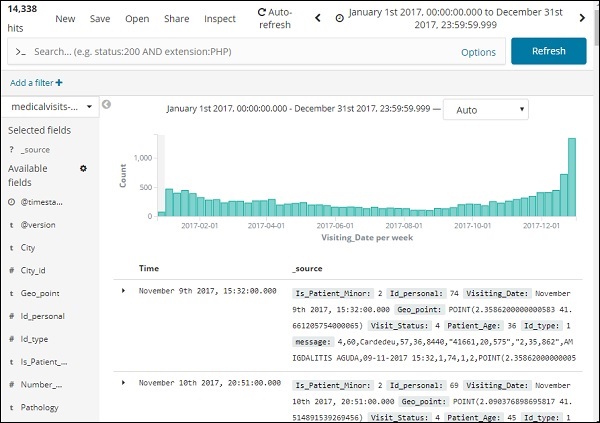

[検出]タブに移動し、インデックスを選択します。medicalvisits-26.01.2019

選択したインデックスの過去15分間に、「検索条件に一致する結果はありません」というメッセージが表示されました。インデックスには、2015年、2016年、2017年、2018年のデータがあります。

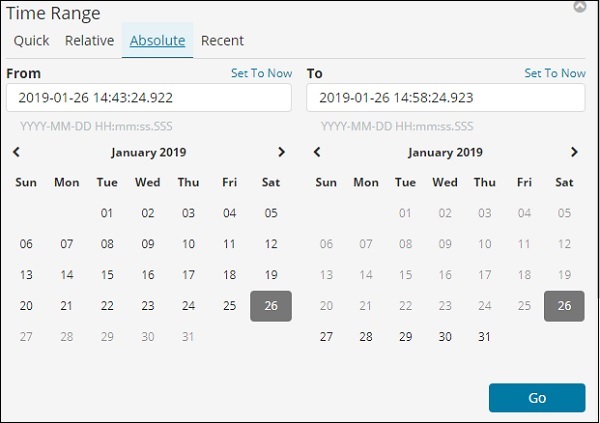

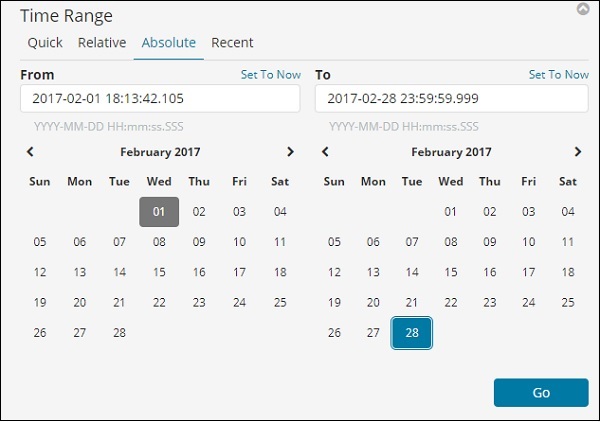

以下に示すように時間範囲を変更します-

[絶対]タブをクリックします。

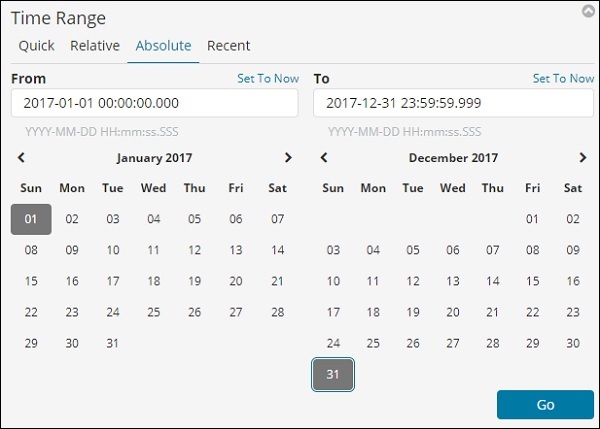

2017年のデータを分析するため、2017年1月1日から2017年12月31日までの日付を選択します。

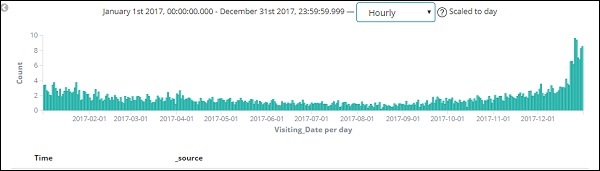

[移動]ボタンをクリックして、時間範囲を追加します。次のようにデータと棒グラフが表示されます-

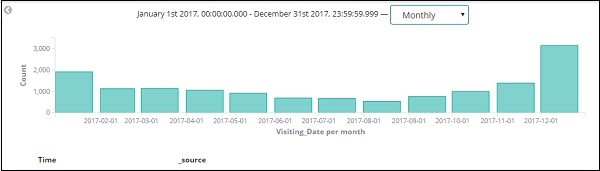

これは2017年の月次データです-

日付とともに時刻も保存されるため、時間と分でデータをフィルタリングすることもできます。

上の図は、2017年の時間別データを示しています。

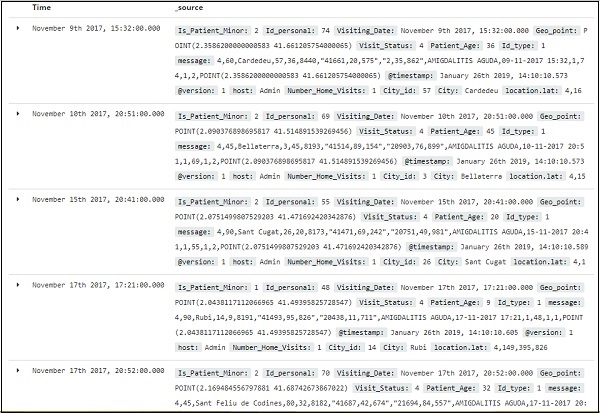

ここでは、インデックスから表示されるフィールド-medicalvisits-26.01.2019

以下に示すように、左側に使用可能なフィールドがあります-

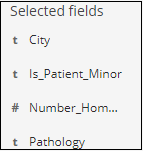

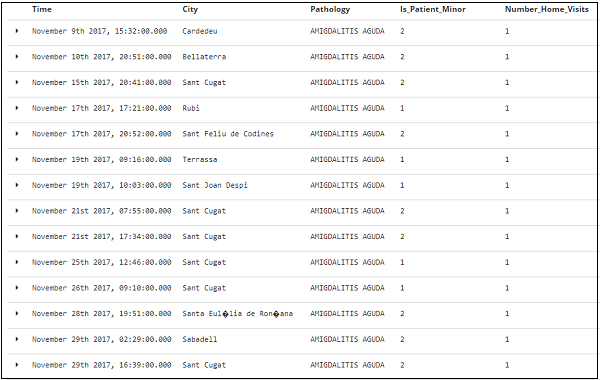

使用可能なフィールドからフィールドを選択し、以下に示すようにデータを表形式に変換できます。ここでは、次のフィールドを選択しました-

上記のフィールドの表形式のデータを次に示します-

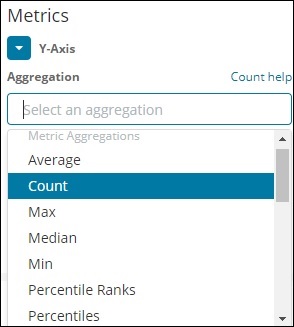

Kibanaの学習中に頻繁に出くわす2つの用語は、バケットとメトリックの集約です。この章では、Kibanaでそれらが果たす役割とその詳細について説明します。

Kibana Aggregationとは何ですか?

集約とは、特定の検索クエリまたはフィルターから取得されたドキュメントのコレクションまたはドキュメントのセットを指します。集約は、Kibanaで目的の視覚化を構築するための主要な概念を形成します。

視覚化を実行するときはいつでも、基準を決定する必要があります。つまり、データをグループ化してメトリックを実行する方法を決定する必要があります。

このセクションでは、2つのタイプの集約について説明します-

- バケットの集約

- メトリック集約

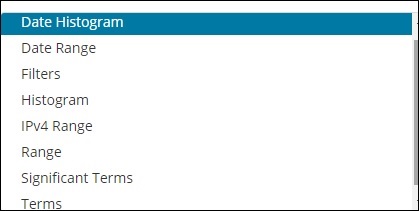

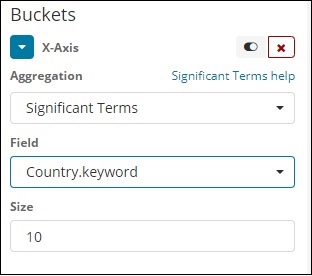

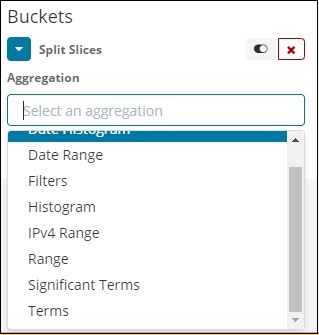

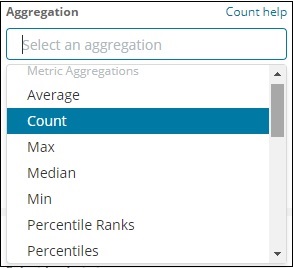

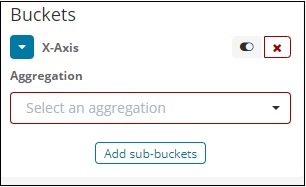

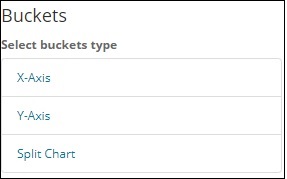

バケットの集約

バケットは主にキーとドキュメントで構成されます。集計が実行されると、ドキュメントはそれぞれのバケットに配置されます。したがって、最後にバケットのリストがあり、それぞれにドキュメントのリストがあります。Kibanaでビジュアライゼーションを作成するときに表示されるバケットアグリゲーションのリストを以下に示します-

BucketAggregationには次のリストがあります-

- 日付ヒストグラム

- 日付範囲

- Filters

- Histogram

- IPv4範囲

- Range

- 重要な用語

- Terms

作成中に、バケット集約用にそれらの1つを決定する必要があります。つまり、バケット内のドキュメントをグループ化します。

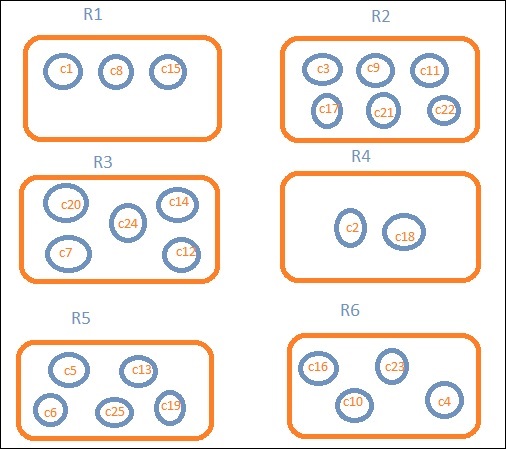

例として、分析のために、このチュートリアルの開始時にアップロードした国のデータについて考えてみます。国インデックスで使用できるフィールドは、国名、地域、人口、地域です。国のデータには、国の名前とその人口、地域、および地域が含まれています。

地域ごとのデータが必要だとしましょう。次に、各地域で利用可能な国が検索クエリになるため、この場合、地域がバケットを形成します。以下のブロック図は、R1、R2、R3、R4、R5、およびR6が取得したバケットであり、c1、c2 ..c25がバケットR1〜R6の一部であるドキュメントのリストであることを示しています。

各バケットにいくつかの円があることがわかります。これらは、検索条件に基づいたドキュメントのセットであり、各バケットに分類されると見なされます。バケットR1には、ドキュメントc1、c8、およびc15があります。これらの文書は、他の人と同じように、その地域に該当する国です。したがって、バケットR1の国を数えると、R2は3、6、R3は6、R4は2、R5は5、R6は4になります。

したがって、バケットの集約により、ドキュメントをバケットに集約し、上記のようにそれらのバケットにドキュメントのリストを含めることができます。

これまでのバケット集約のリストは次のとおりです。

- 日付ヒストグラム

- 日付範囲

- Filters

- Histogram

- IPv4範囲

- Range

- 重要な用語

- Terms

ここで、これらのバケットを1つずつ形成する方法について詳しく説明します。

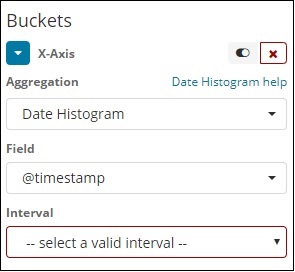

日付ヒストグラム

日付ヒストグラムの集計は、日付フィールドで使用されます。したがって、視覚化に使用するインデックス。そのインデックスに日付フィールドがある場合は、この集計タイプのみを使用できます。これはマルチバケット集約であり、複数のバケットの一部として一部のドキュメントを含めることができることを意味します。この集計には間隔があり、詳細は以下のとおりです。

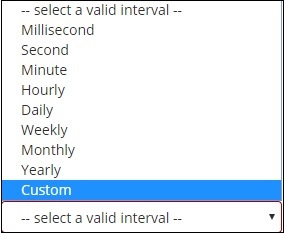

日付ヒストグラムとしてバケット集計を選択すると、日付関連のフィールドのみを表示する[フィールド]オプションが表示されます。フィールドを選択したら、次の詳細を持つ間隔を選択する必要があります-

したがって、選択されたインデックスから選択されたフィールドと間隔に基づいたドキュメントは、バケット内のドキュメントを分類します。たとえば、間隔を月単位として選択した場合、日付に基づくドキュメントはバケットに変換され、月に基づいて、つまり1月から12月に基づいてドキュメントがバケットに配置されます。ここでは、1月、2月、.. 12月がバケツになります。

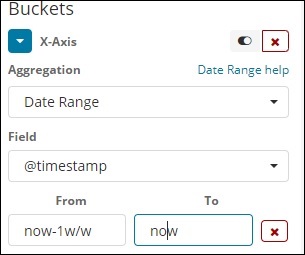

日付範囲

この集計タイプを使用するには、日付フィールドが必要です。ここでは、日付範囲があります。つまり、日付から日付までが指定されます。バケットには、フォームと指定された日付に基づいたドキュメントがあります。

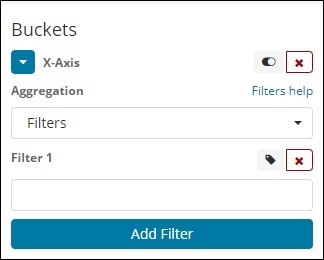

フィルター

フィルタタイプの集計では、バケットはフィルタに基づいて形成されます。ここでは、1つのドキュメントが1つ以上のバケットに存在できるフィルター基準に基づいて形成されたマルチバケットを取得します。

フィルタを使用すると、ユーザーは次のようにフィルタオプションでクエリを記述できます-

[フィルターの追加]ボタンを使用して、選択した複数のフィルターを追加できます。

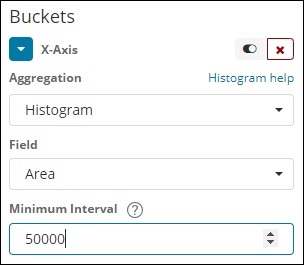

ヒストグラム

このタイプの集計は数値フィールドに適用され、適用された間隔に基づいてバケット内のドキュメントをグループ化します。たとえば、0-50、50-100、100-150などです。

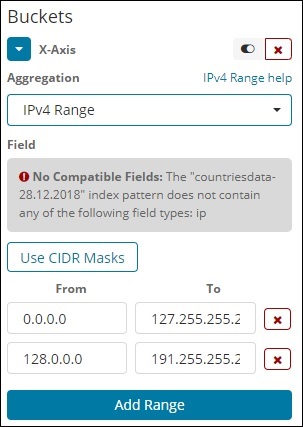

IPv4範囲

このタイプの集約は、主にIPアドレスに使用されます。

contriesdata-28.12.2018であるインデックスには、タイプIPのフィールドがないため、上記のようなメッセージが表示されます。IPフィールドがある場合は、上記のようにFrom値とTo値を指定できます。

範囲

このタイプの集約では、フィールドがタイプ番号である必要があります。範囲を指定する必要があり、ドキュメントは範囲内のバケットに一覧表示されます。

必要に応じて、[範囲の追加]ボタンをクリックして範囲を追加できます。

重要な用語

このタイプの集計は、主に文字列フィールドで使用されます。

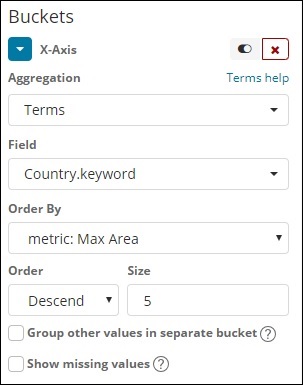

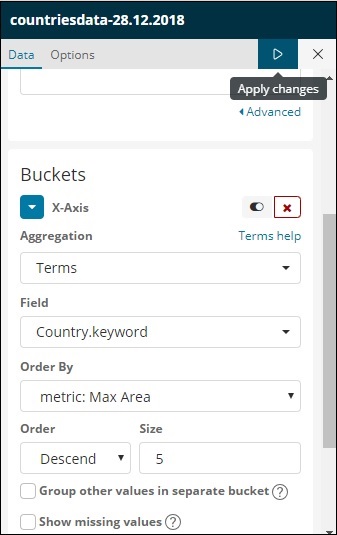

条項

このタイプの集計は、使用可能なすべてのフィールド、つまり数値、文字列、日付、ブール値、IPアドレス、タイムスタンプなどで使用されます。これは、これで作業するすべての視覚化で使用する集計であることに注意してください。チュートリアル。

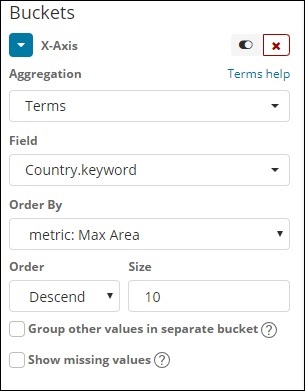

選択したメトリックに基づいてデータをグループ化するオプションの順序があります。サイズは、ビジュアライゼーションに表示するバケットの数を指します。

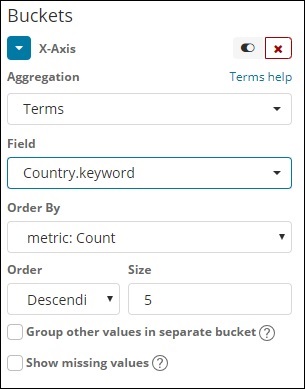

次に、メトリック集約について説明します。

メトリック集約

メトリック集約とは、主にバケット内に存在するドキュメントに対して実行される数学計算を指します。たとえば、数値フィールドを選択した場合、そのフィールドで実行できるメトリック計算は、COUNT、SUM、MIN、MAX、AVERAGEなどです。

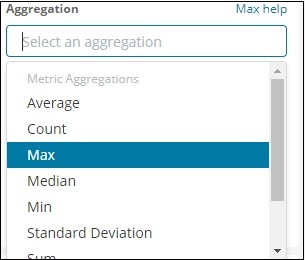

ここで説明するメトリック集計のリストを示します-

このセクションでは、私たちが頻繁に使用する重要なものについて説明しましょう-

- Average

- Count

- Max

- Min

- Sum

このメトリックは、前述の個々のバケット集計に適用されます。

次に、ここでメトリック集約のリストについて説明します-

平均

これにより、バケットに存在するドキュメントの値の平均が得られます。例-

R1からR6はバケットです。R1には、c1、c8、およびc15があります。c1の値が300、c8が500、c15が700であるとします。次に、R1バケットの平均値を取得します。

R1 = c1の値+ c8の値+ c15 / 3の値= 300 + 500 + 700/3 = 500。

バケットR1の平均は500です。ここで、ドキュメントの値は、国のデータを考慮すると、その地域の国の領域である可能性があります。

カウント

これにより、バケットに存在するドキュメントの数がわかります。地域に存在する国の数が必要だとすると、バケットに存在するドキュメントの総数になります。たとえば、R1は3、R2 = 6、R3 = 5、R4 = 2、R5 = 5、R6 = 4になります。

マックス

これにより、バケットに存在するドキュメントの最大値が得られます。地域バケットに地域ごとの国のデータがある場合は、上記の例を検討してください。各地域の最大値は、最大面積を持つ国になります。したがって、各地域、つまりR1からR6に1つの国があります。

に

これにより、バケットに存在するドキュメントの最小値が得られます。地域バケットに地域ごとの国のデータがある場合は、上記の例を検討してください。各地域の最小値は、最小面積の国になります。したがって、各地域、つまりR1からR6に1つの国があります。

和

これにより、バケットに存在するドキュメントの値の合計が得られます。たとえば、上記の例を検討する場合、地域内の1つまたは複数の国の合計が必要な場合、それは地域に存在するドキュメントの合計になります。

たとえば、地域R1の合計国を知るには、3、R2 = 6、R3 = 5、R4 = 2、R5 = 5、R6 = 4になります。

地域内にR1からR6よりも面積のあるドキュメントがある場合は、国ごとの面積が地域ごとに合計されます。

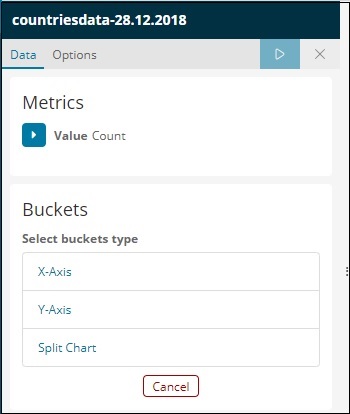

棒グラフ、折れ線グラフ、円グラフなどの形式でデータを視覚化できます。この章では、視覚化の作成方法を理解します。

ビジュアライゼーションを作成する

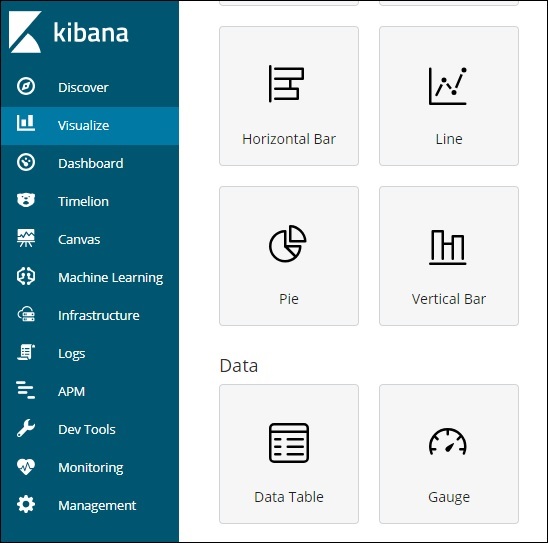

以下に示すように、KibanaVisualizationに移動します-

ビジュアライゼーションは作成されていないため、空白で表示され、ビジュアライゼーションを作成するためのボタンがあります。

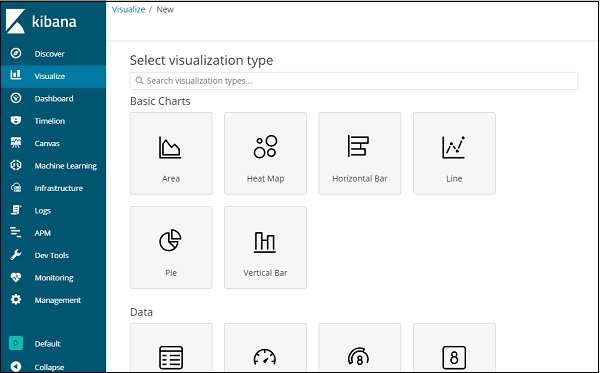

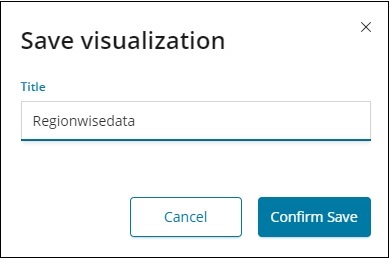

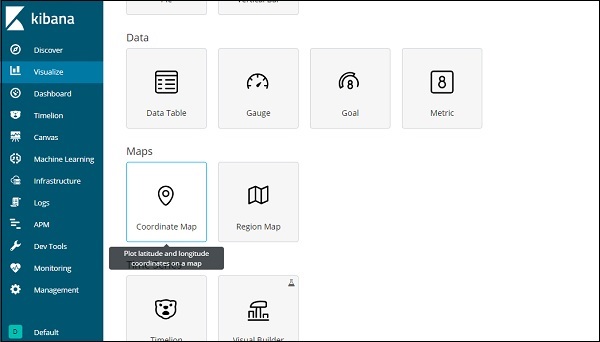

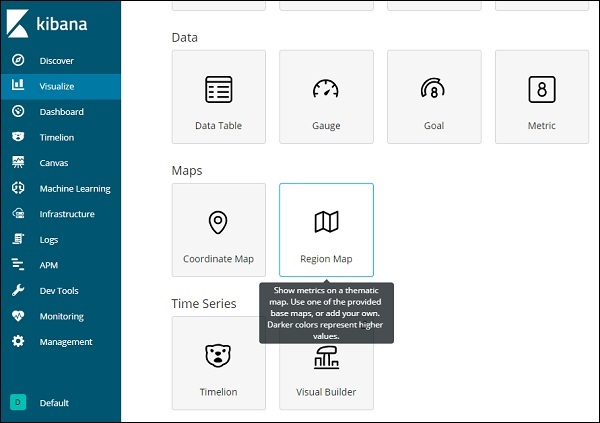

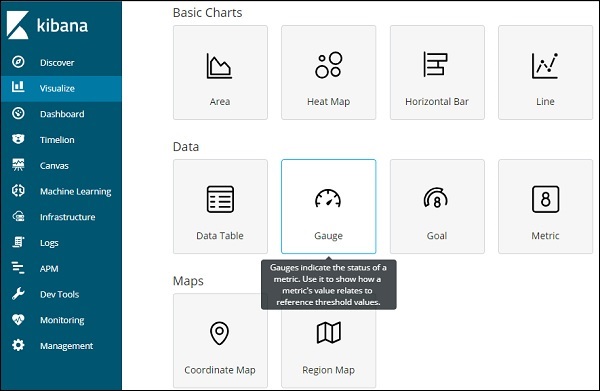

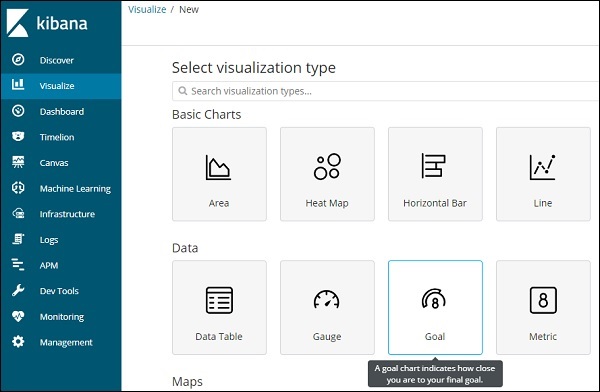

ボタンをクリックします Create a visualization 上の画面に示されているように、下に示されている画面に移動します-

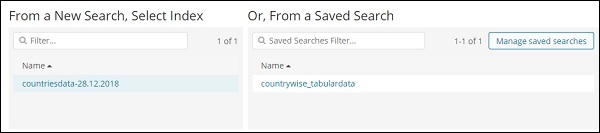

ここでは、データを視覚化するために必要なオプションを選択できます。次の章で、それぞれについて詳しく説明します。今、最初に円グラフを選択します。

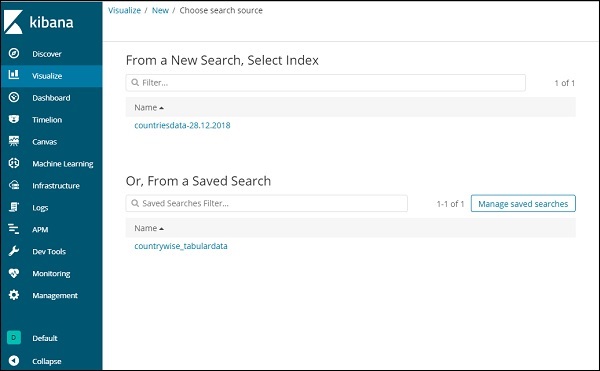

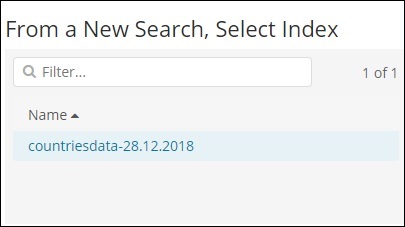

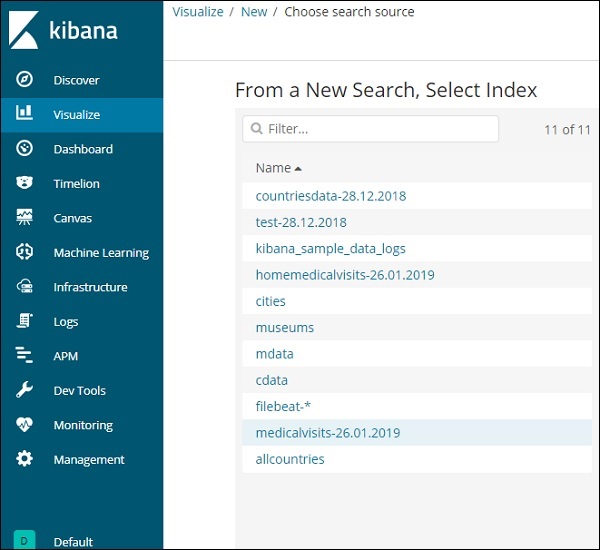

視覚化タイプを選択したら、次に作業するインデックスを選択する必要があります。次のような画面が表示されます-

これで、デフォルトの円グラフができました。countrysdata-28.12.2018を使用して、国のデータで利用可能な地域の数を円グラフ形式で取得します。

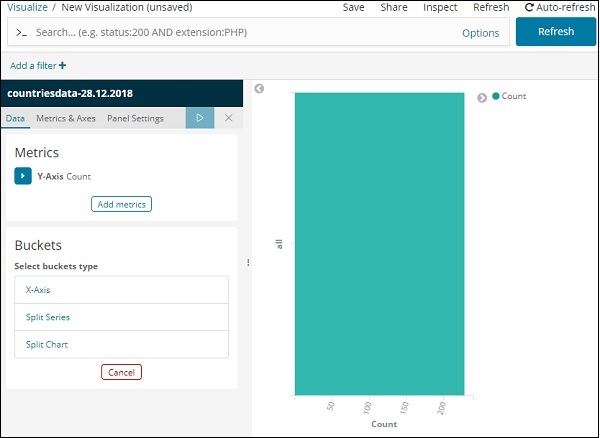

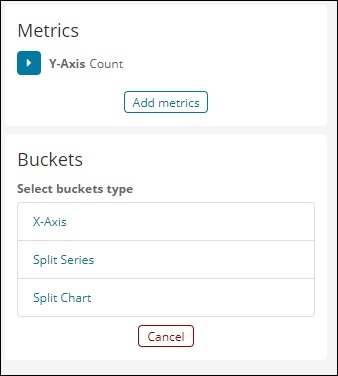

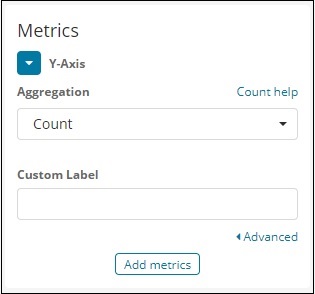

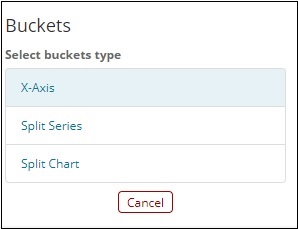

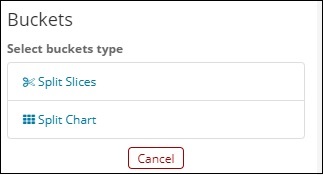

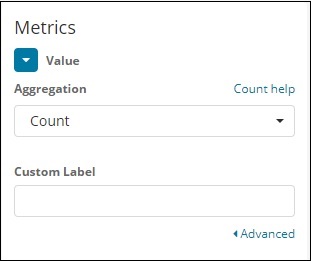

バケットとメトリックの集計

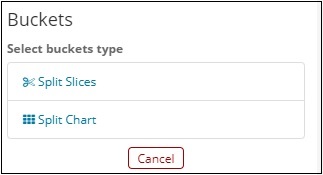

左側にはメトリックがあり、カウントとして選択します。バケットには、スライスの分割とグラフの分割の2つのオプションがあります。[スライスを分割]オプションを使用します。

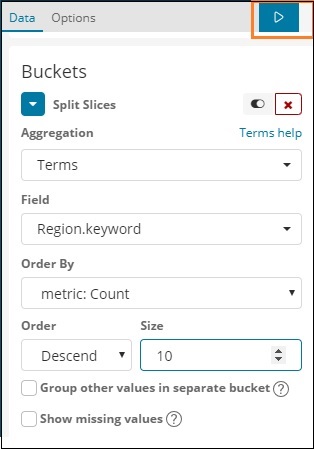

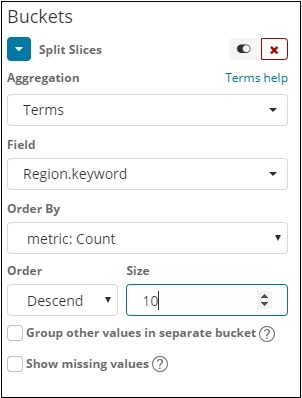

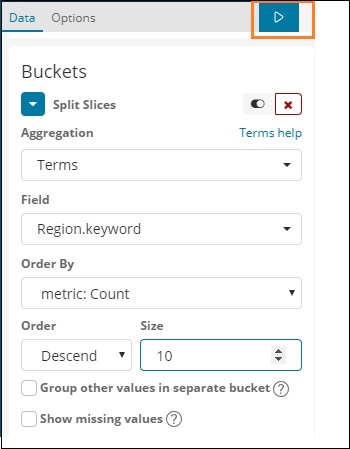

ここで、[スライスの分割]を選択すると、次のオプションが表示されます-

ここで、用語として集約を選択すると、次のように入力するオプションがさらに表示されます-

[フィールド]ドロップダウンには、選択したindex:countriesdataのすべてのフィールドが表示されます。RegionフィールドとOrderByを選択しました。OrderByのメトリックCountを選択したことに注意してください。降順で注文し、サイズを10とします。つまり、ここでは、国のインデックスから上位10の地域を取得します。

次に、下で強調表示されている分析ボタンをクリックすると、右側に更新された円グラフが表示されます。

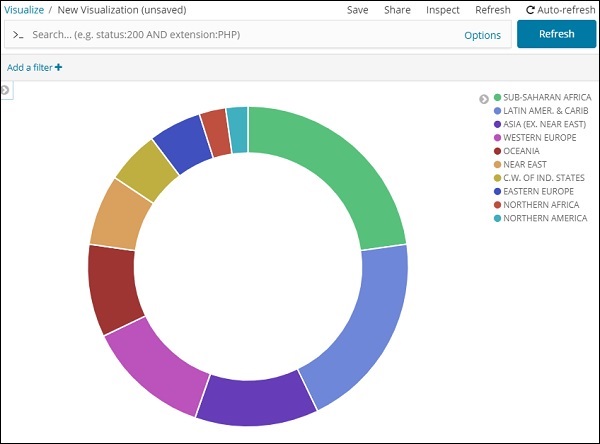

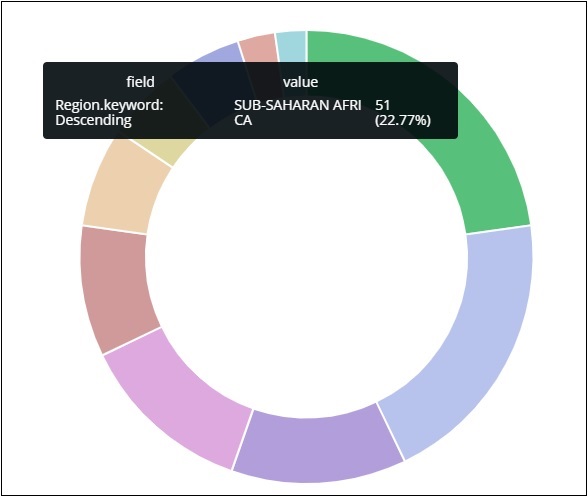

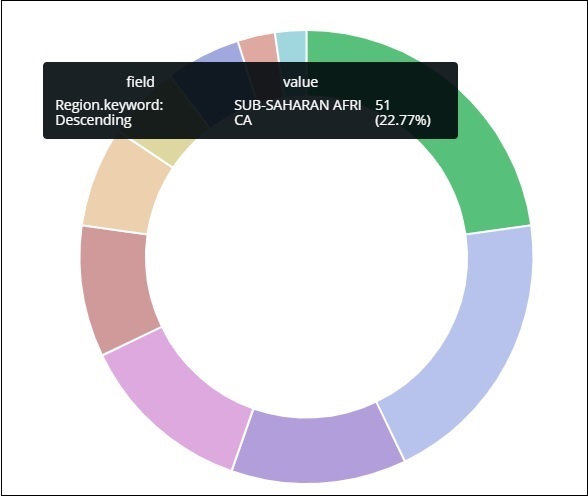

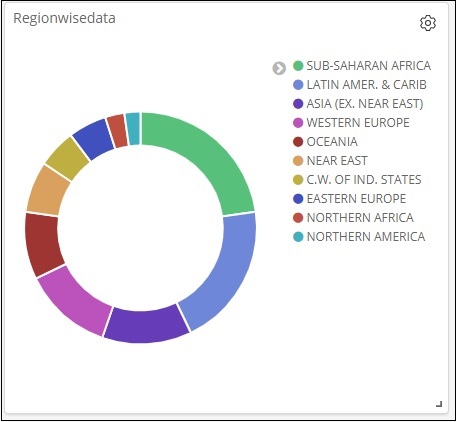

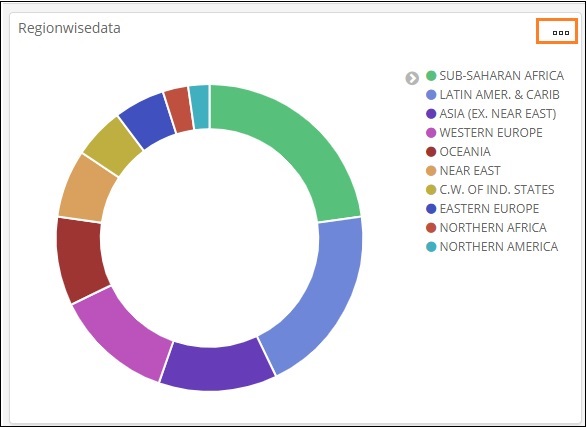

円グラフ表示

すべての地域が右上隅に色で表示され、同じ色が円グラフに表示されます。円グラフの上にマウスを置くと、以下に示すように、地域の数と地域の名前が表示されます。

つまり、アップロードした国のデータから、地域の22.77%がサハラ以南のアフリカによって占められていることがわかります。

アジア地域は12.5%をカバーし、その数は28です。

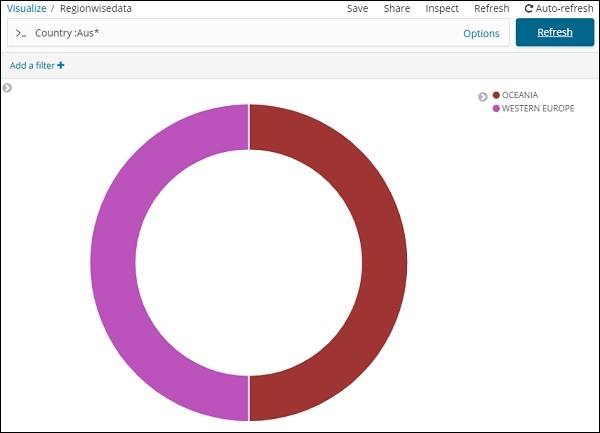

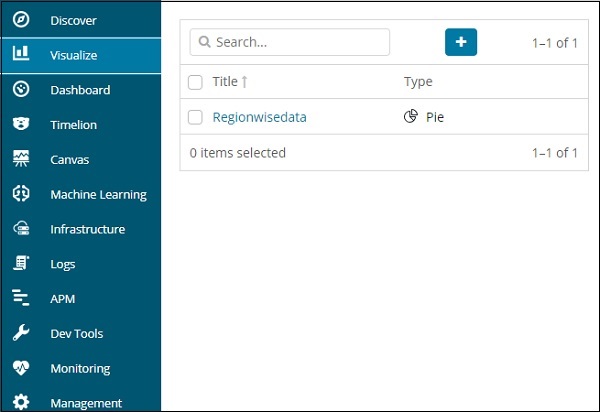

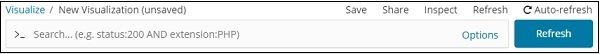

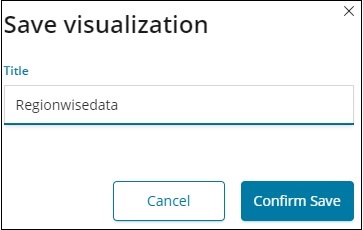

これで、以下に示すように、右上隅にある保存ボタンをクリックしてビジュアライゼーションを保存できます-

ここで、後で使用できるようにビジュアライゼーションを保存します。

以下に示す検索オプションを使用して、必要に応じてデータを取得することもできます。

Aus *で始まる国のデータをフィルタリングしました。円グラフやその他の視覚化については、次の章で詳しく説明します。

視覚化で最も一般的に使用されるチャートを調べて理解しましょう。

- 横棒グラフ

- 縦棒グラフ

- 円グラフ

上記の視覚化を作成するために従うべき手順は次のとおりです。鉄棒から始めましょう。

横棒グラフ

Kibanaを開き、以下に示すように左側の[視覚化]タブをクリックします-

+ボタンをクリックして、新しいビジュアライゼーションを作成します-

上にリストされている水平バーをクリックします。視覚化するインデックスを選択する必要があります。

を選択 countriesdata-28.12.2018上記のインデックス。インデックスを選択すると、以下のような画面が表示されます。

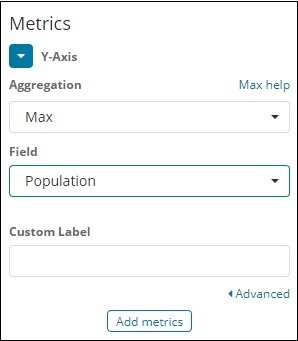

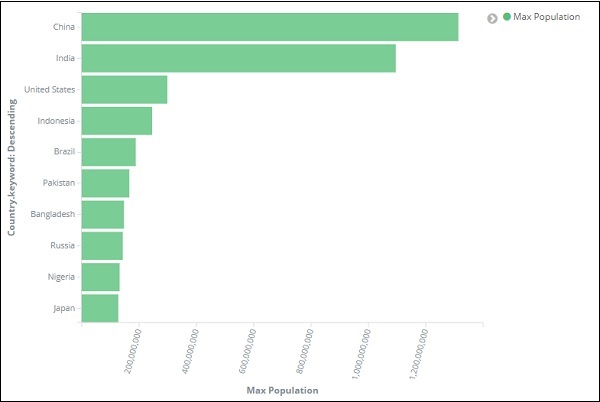

デフォルトのカウントが表示されます。ここで、国別の上位10人の人口のデータを確認できる水平グラフをプロットしてみましょう。

この目的のために、Y軸とX軸で必要なものを選択する必要があります。したがって、バケットとメトリックの集計を選択します-

ここで、Y軸をクリックすると、次のような画面が表示されます-

ここで、ここに表示されているオプションから必要な集計を選択します-

ここでは、利用可能な最大母集団に従ってデータを表示するため、最大集計を選択することに注意してください。

次に、最大値が必要なフィールドを選択する必要があります。インデックスcountriesdata-28.12.2018には、面積と人口の2つの数値フィールドしかありません。

最大の人口が必要なので、以下に示すように[人口]フィールドを選択します-

これで、Y軸が完成しました。Y軸で得られる出力は次のとおりです。

次に示すようにX軸を選択しましょう-

X軸を選択すると、次の出力が得られます-

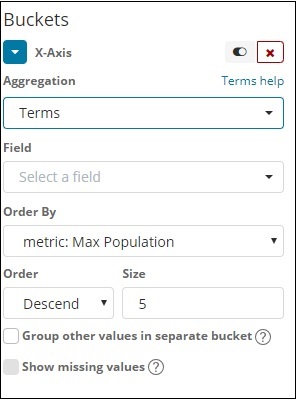

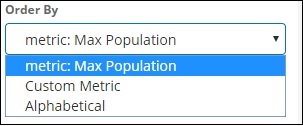

用語として集約を選択します。

ドロップダウンからフィールドを選択します。国ごとの人口が必要なので、国のフィールドを選択します。以下のオプションがあります-

人口が最も多い国を最初に表示するように、最大人口として順序を選択します。必要なデータが追加されたら、以下に示すように、メトリックデータの上にある[変更の適用]ボタンをクリックします-

[変更を適用]をクリックすると、水平方向のグラフが表示されます。このグラフでは、中国が最も人口の多い国であり、次にインド、米国などが続きます。

同様に、必要なフィールドを選択することで、さまざまなグラフをプロットできます。次に、この視覚化をmax_populationとして保存し、後でダッシュボードの作成に使用します。

次のセクションでは、垂直棒グラフを作成します。

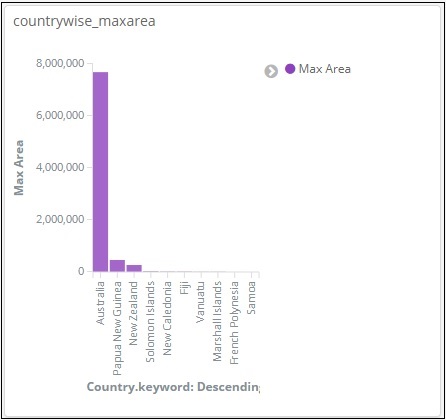

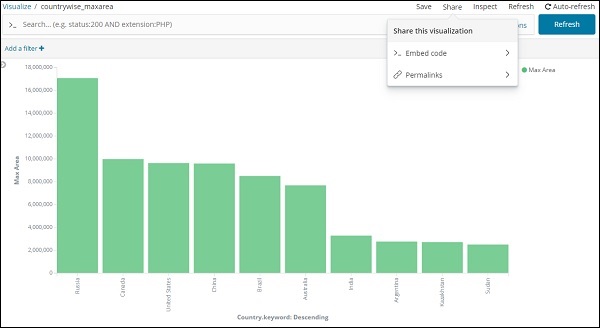

縦棒グラフ

[視覚化]タブをクリックし、垂直バーとインデックスを使用して新しい視覚化を作成します。 countriesdata-28.12.2018。

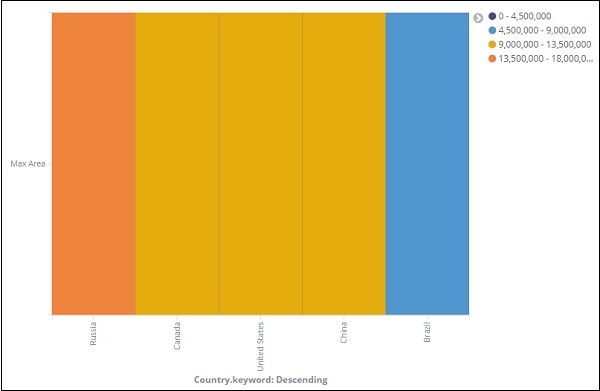

この垂直バーの視覚化では、国ごとの面積で棒グラフを作成します。つまり、国は最も高い面積で表示されます。

それでは、以下に示すようにY軸とX軸を選択しましょう-

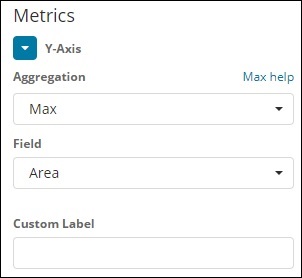

Y軸

X軸

ここで変更を適用すると、次のような出力が表示されます。

グラフから、ロシアが最も高く、カナダと米国がそれに続くことがわかります。このデータはインデックスcountriesdataとそのダミーデータから選択されているため、ライブデータでは数値が正しくない可能性があることに注意してください。

この視覚化をcountrywise_maxareaとして保存して、後でダッシュボードで使用できるようにします。

次に、円グラフに取り組みましょう。

円グラフ

したがって、最初にビジュアライゼーションを作成し、countriesdataとしてインデックスを使用して円グラフを選択します。円グラフ形式でcountriesdataで利用可能な地域の数を表示します。

左側には、カウントを与えるメトリックがあります。バケットには、スライスの分割とチャートの分割の2つのオプションがあります。次に、[スライスの分割]オプションを使用します。

ここで、[スライスの分割]を選択すると、次のオプションが表示されます-

用語として集約を選択すると、次のように入力するオプションがさらに表示されます-

[フィールド]ドロップダウンには、選択したインデックスのすべてのフィールドが表示されます。Countとして選択したRegionフィールドとOrderByを選択しました。降順で注文し、サイズは10になります。したがって、ここでは、国のインデックスから10の地域をカウントします。

次に、下で強調表示されている再生ボタンをクリックすると、右側に更新された円グラフが表示されます。

円グラフ表示

すべての地域が右上隅に色で表示され、同じ色が円グラフに表示されます。円グラフの上にマウスを置くと、以下に示すように、地域の数と地域の名前が表示されます。

したがって、アップロードした国のデータでは、地域の22.77%がサハラ以南のアフリカによって占められていることがわかります。

円グラフから、アジア地域が12.5%をカバーし、カウントが28であることがわかります。

これで、以下に示すように、右上隅にある保存ボタンをクリックしてビジュアライゼーションを保存できます-

次に、ビジュアライゼーションを保存して、後でダッシュボードで使用できるようにします。

この章では、視覚化で使用される2種類のグラフについて説明します。

- 折れ線グラフ

- Area

折れ線グラフ

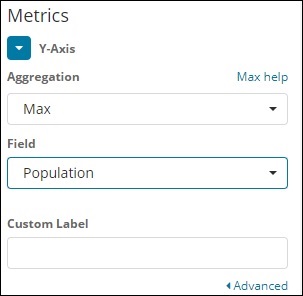

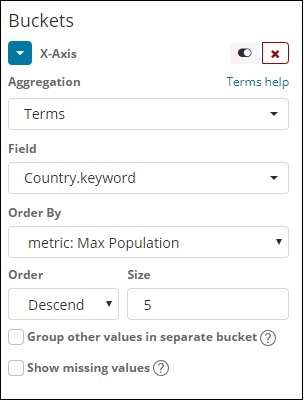

まず、視覚化を作成し、折れ線グラフを選択してデータを表示し、contriesdataをインデックスとして使用します。Y軸とX軸を作成する必要があります。その詳細を以下に示します。

Y軸の場合

Maxを集合体として採用していることに注意してください。そこで、ここではデータの表示を折れ線グラフで示します。ここで、国ごとの最大人口を示すグラフをプロットします。国ごとに最大の人口が必要なため、私たちが取った分野は人口です。

X軸の場合

x軸では、用語を集計、Country.keywordをフィールド、metric:Max Population for Order Byとし、注文サイズは5です。したがって、最大人口を持つ上位5か国をプロットします。変更を適用すると、次のような折れ線グラフが表示されます。

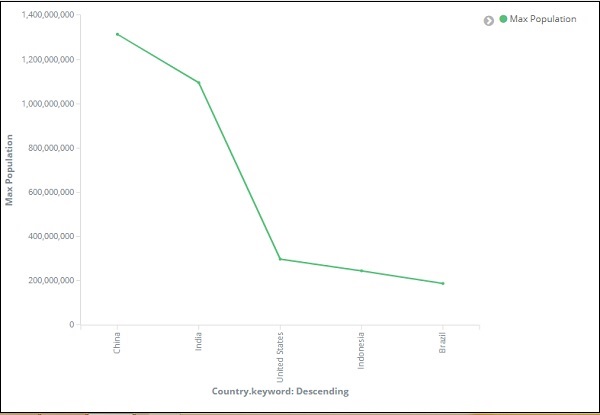

したがって、中国の人口は最大であり、人口の上位5か国としてインド、米国、インドネシア、ブラジルがそれに続きます。

ここで、後でダッシュボードで使用できるように、この折れ線グラフを保存しましょう。

[保存の確認]をクリックすると、ビジュアライゼーションを保存できます。

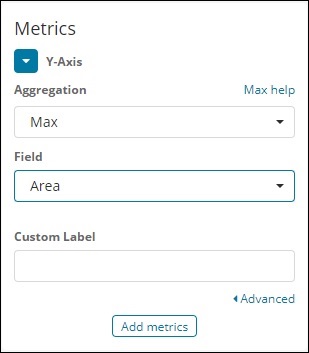

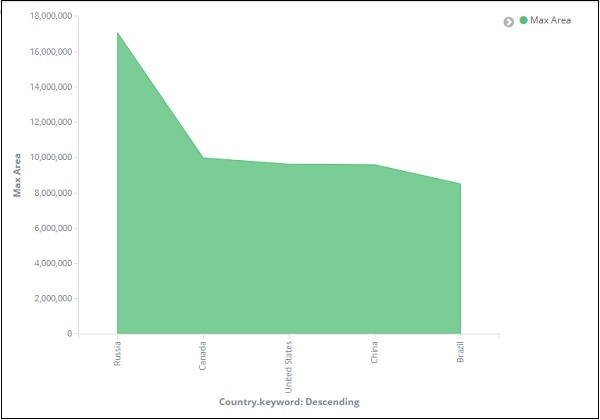

面グラフ

視覚化に移動し、countriesdataとしてインデックスのあるエリアを選択します。Y軸とX軸を選択する必要があります。国ごとの最大面積の面グラフをプロットします。

したがって、ここでX軸とY軸は次のようになります-

[変更を適用]ボタンをクリックすると、次のような出力が表示されます-

グラフから、ロシアが最も高く、カナダ、米国、中国、ブラジルがそれに続くことがわかります。ビジュアライゼーションを保存して、後で使用します。

この章では、ヒートマップの操作方法を理解します。ヒートマップは、データメトリックで選択された範囲のデータ表示をさまざまな色で表示します。

ヒートマップ入門

まず、以下に示すように、左側の視覚化タブをクリックして視覚化を作成する必要があります-

上記のように、ヒートマップとして視覚化タイプを選択します。以下に示すように、インデックスを選択するように求められます-

上記のように、インデックスcountriesdata-28.12.2018を選択します。インデックスが選択されると、以下に示すように選択されるデータがあります-

以下に示すようにメトリックを選択します-

以下に示すように、ドロップダウンから[最大集計]を選択します-

Max Areaを国ごとにプロットしたいので、Maxを選択しました。

次に、以下に示すようにバケットの値を選択します-

次に、以下に示すようにX軸を選択しましょう-

用語として集計、国としてフィールド、最大面積による注文を使用しました。以下に示すように、[変更の適用]をクリックします-

[変更を適用]をクリックすると、ヒートマップは次のようになります-

ヒートマップはさまざまな色で表示され、領域の範囲は右側に表示されます。以下に示すように、領域範囲の横にある小さな円をクリックすると、色を変更できます。

Kibanaの座標マップは、地理的領域を表示し、指定した集計に基づいてその領域を円でマークします。

座標マップのインデックスを作成する

座標マップに使用されるバケット集計は、ジオハッシュ集計です。このタイプの集計の場合、使用するインデックスには、geopointタイプのフィールドが必要です。ジオポイントは、緯度と経度の組み合わせです。

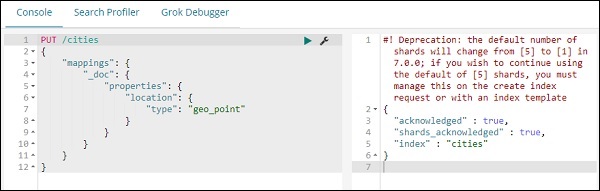

Kibana開発ツールを使用してインデックスを作成し、それにバルクデータを追加します。マッピングを追加し、必要なgeo_pointタイプを追加します。

使用するデータを以下に示します-

{"index":{"_id":1}}

{"location": "2.089330000000046,41.47367000000008", "city": "SantCugat"}

{"index":{"_id":2}}

{"location": "2.2947825000000677,41.601800991000076", "city": "Granollers"}

{"index":{"_id":3}}

{"location": "2.1105957495300474,41.5496295760424", "city": "Sabadell"}

{"index":{"_id":4}}

{"location": "2.132605678083895,41.5370461908878", "city": "Barbera"}

{"index":{"_id":5}}

{"location": "2.151270020052683,41.497779918345415", "city": "Cerdanyola"}

{"index":{"_id":6}}

{"location": "2.1364609496220606,41.371303520399344", "city": "Barcelona"}

{"index":{"_id":7}}

{"location": "2.0819450306711165,41.385491966414705", "city": "Sant Just Desvern"}

{"index":{"_id":8}}

{"location": "2.00532082278266,41.542294286427385", "city": "Rubi"}

{"index":{"_id":9}}

{"location": "1.9560805366930398,41.56142635214226", "city": "Viladecavalls"}

{"index":{"_id":10}}

{"location": "2.09205348251486,41.39327140161001", "city": "Esplugas de Llobregat"}次に、以下に示すように、Kibana DevToolsで次のコマンドを実行します-

PUT /cities

{

"mappings": {

"_doc": {

"properties": {

"location": {

"type": "geo_point"

}

}

}

}

}

POST /cities/_city/_bulk?refresh

{"index":{"_id":1}}

{"location": "2.089330000000046,41.47367000000008", "city": "SantCugat"}

{"index":{"_id":2}}

{"location": "2.2947825000000677,41.601800991000076", "city": "Granollers"}

{"index":{"_id":3}}

{"location": "2.1105957495300474,41.5496295760424", "city": "Sabadell"}

{"index":{"_id":4}}

{"location": "2.132605678083895,41.5370461908878", "city": "Barbera"}

{"index":{"_id":5}}

{"location": "2.151270020052683,41.497779918345415", "city": "Cerdanyola"}

{"index":{"_id":6}}

{"location": "2.1364609496220606,41.371303520399344", "city": "Barcelona"}

{"index":{"_id":7}}

{"location": "2.0819450306711165,41.385491966414705", "city": "Sant Just Desvern"}

{"index":{"_id":8}}

{"location": "2.00532082278266,41.542294286427385", "city": "Rubi"}

{"index":{"_id":9}}

{"location": "1.9560805366930398,41.56142635214226", "city": "Viladecavalls"}

{"index":{"_id":10}}

{"location": "2.09205348251486,41.3s9327140161001", "city": "Esplugas de Llobregat"}ここで、Kibana開発ツールで上記のコマンドを実行します-

上記は、タイプ_docのインデックス名citysを作成し、フィールドの場所はタイプgeo_pointです。

次に、インデックスにデータを追加しましょう:都市-

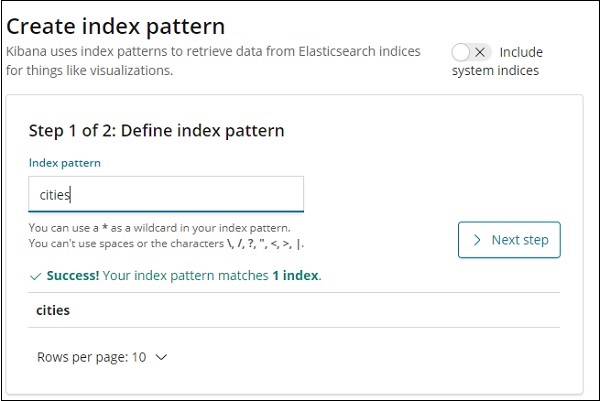

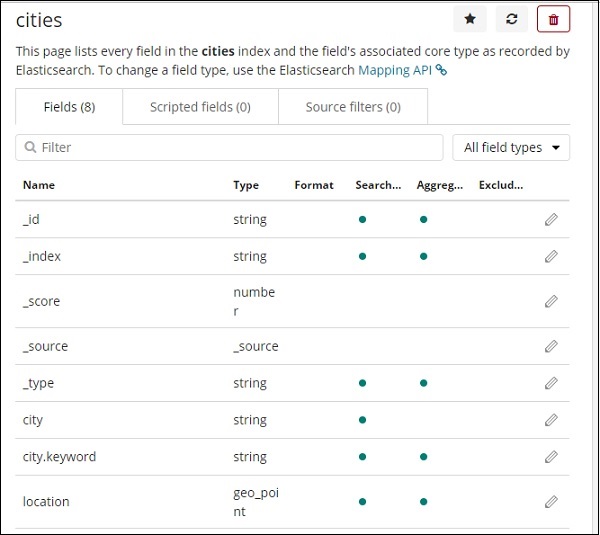

データを使用してインデックス名の引用を作成しました。次に、[管理]タブを使用して都市のインデックスパターンを作成しましょう。

都市インデックス内のフィールドの詳細をここに示します-

場所のタイプがgeo_pointであることがわかります。これを使用して視覚化を作成できます。

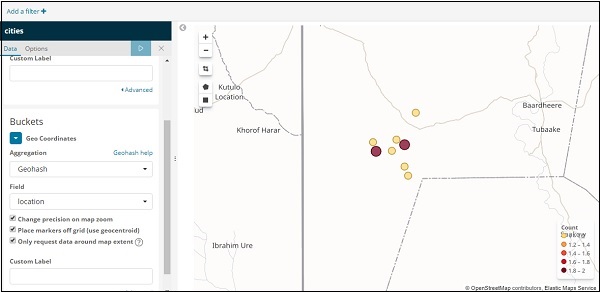

座標マップ入門

視覚化に移動し、座標マップを選択します。

インデックスパターンの都市を選択し、以下に示すように集約メトリックとバケットを構成します-

[分析]ボタンをクリックすると、次の画面が表示されます-

経度と緯度に基づいて、円は上記のようにマップ上にプロットされます。

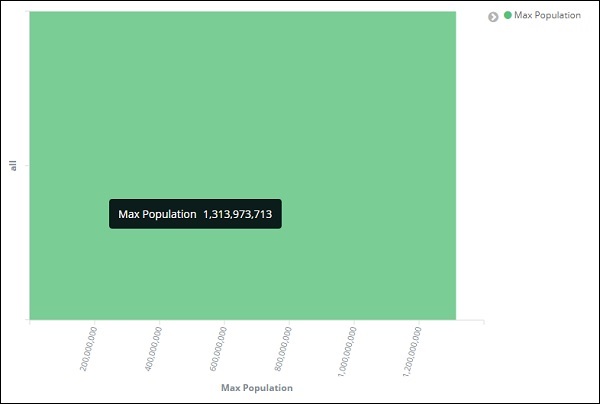

この視覚化により、地理的な世界地図に表示されたデータが表示されます。この章では、これについて詳しく見ていきましょう。

リージョンマップのインデックスを作成する

地域マップの視覚化で機能する新しいインデックスを作成します。アップロードするデータをここに示します-

{"index":{"_id":1}}

{"country": "China", "population": "1313973713"}

{"index":{"_id":2}}

{"country": "India", "population": "1095351995"}

{"index":{"_id":3}}

{"country": "United States", "population": "298444215"}

{"index":{"_id":4}}

{"country": "Indonesia", "population": "245452739"}

{"index":{"_id":5}}

{"country": "Brazil", "population": "188078227"}

{"index":{"_id":6}}

{"country": "Pakistan", "population": "165803560"}

{"index":{"_id":7}}

{"country": "Bangladesh", "population": "147365352"}

{"index":{"_id":8}}

{"country": "Russia", "population": "142893540"}

{"index":{"_id":9}}

{"country": "Nigeria", "population": "131859731"}

{"index":{"_id":10}}

{"country": "Japan", "population": "127463611"}開発ツールで_bulkuploadを使用してデータをアップロードすることに注意してください。

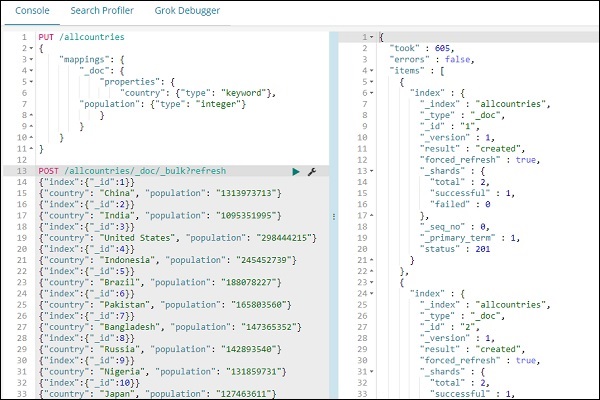

ここで、Kibana Dev Toolsに移動し、次のクエリを実行します-

PUT /allcountries

{

"mappings": {

"_doc": {

"properties": {

"country": {"type": "keyword"},

"population": {"type": "integer"}

}

}

}

}

POST /allcountries/_doc/_bulk?refresh

{"index":{"_id":1}}

{"country": "China", "population": "1313973713"}

{"index":{"_id":2}}

{"country": "India", "population": "1095351995"}

{"index":{"_id":3}}

{"country": "United States", "population": "298444215"}

{"index":{"_id":4}}

{"country": "Indonesia", "population": "245452739"}

{"index":{"_id":5}}

{"country": "Brazil", "population": "188078227"}

{"index":{"_id":6}}

{"country": "Pakistan", "population": "165803560"}

{"index":{"_id":7}}

{"country": "Bangladesh", "population": "147365352"}

{"index":{"_id":8}}

{"country": "Russia", "population": "142893540"}

{"index":{"_id":9}}

{"country": "Nigeria", "population": "131859731"}

{"index":{"_id":10}}

{"country": "Japan", "population": "127463611"}次に、インデックスallcountriesを作成しましょう。国フィールドタイプを次のように指定しましたkeyword −

PUT /allcountries

{

"mappings": {

"_doc": {

"properties": {

"country": {"type": "keyword"},

"population": {"type": "integer"}

}

}

}

}Note −地域マップを操作するには、集約で使用するフィールドタイプをtype askeywordとして指定する必要があります。

完了したら、_bulkコマンドを使用してデータをアップロードします。

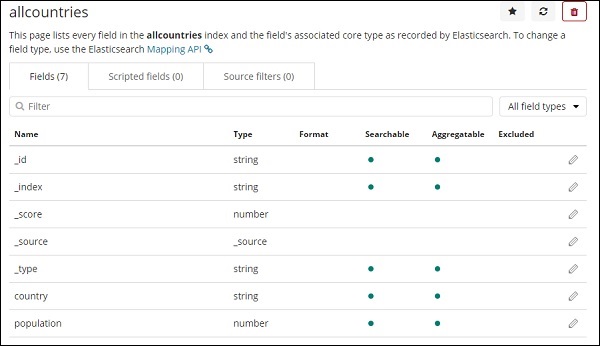

次に、インデックスパターンを作成します。Kibana Managementタブに移動し、create indexpatternを選択します。

これがすべての国のインデックスから表示されるフィールドです。

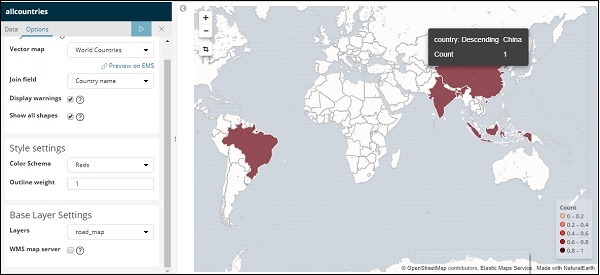

リージョンマップ入門

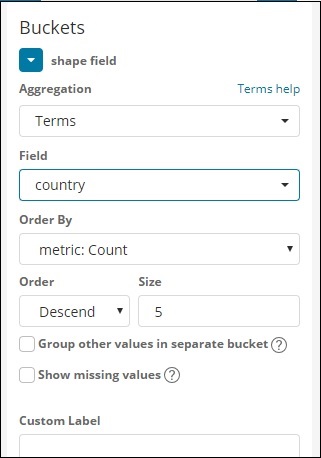

次に、リージョンマップを使用してビジュアライゼーションを作成します。Visualizationに移動し、RegionMapsを選択します。

完了したら、すべての国としてインデックスを選択し、続行します。

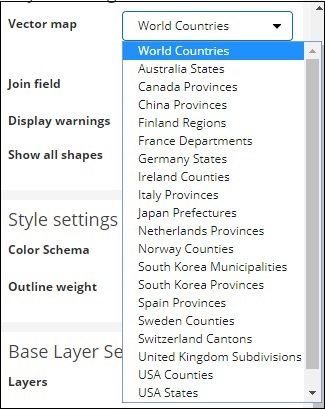

以下に示すように、集約メトリックとバケットメトリックを選択します-

ここでは、世界地図に同じものを表示したいので、国としてフィールドを選択しました。

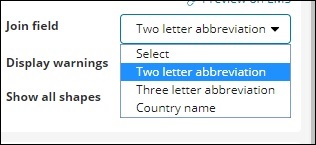

地域マップのベクトルマップと結合フィールド

地域マップの場合、以下に示すように[オプション]タブも選択する必要があります-

[オプション]タブには、世界地図にデータをプロットするために必要なレイヤー設定構成があります。

ベクターマップには次のオプションがあります-

ここでは、国のデータがあるため、世界の国を選択します。

結合フィールドには次の詳細があります-

インデックスには国名があるので、国名を選択します。

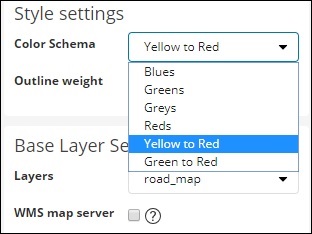

スタイル設定では、国に表示する色を選択できます-

レッズを選択します。残りの詳細については触れません。

次に、[分析]ボタンをクリックして、以下に示すように世界地図にプロットされた国の詳細を確認します。

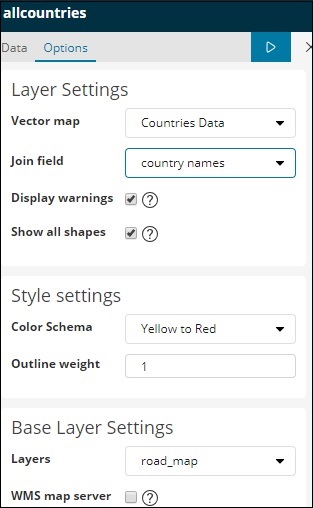

Kibanaの自己ホスト型ベクターマップと結合フィールド

ベクターマップと結合フィールドに独自のKibana設定を追加することもできます。これを行うには、kibana configフォルダーからkibana.ymlに移動し、次の詳細を追加します-

regionmap:

includeElasticMapsService: false

layers:

- name: "Countries Data"

url: "http://localhost/kibana/worldcountries.geojson"

attribution: "INRAP"

fields:

- name: "Country"

description: "country names"[オプション]タブのベクターマップには、デフォルトのデータではなく、上記のデータが入力されます。Kibanaが同じURLをダウンロードできるように、指定されたURLはCORS対応である必要があることに注意してください。使用するjsonファイルは、座標が継続するようにする必要があります。例-

https://vector.maps.elastic.co/blob/5659313586569216?elastic_tile_service_tos=agreeリージョンマップのベクターマップの詳細がセルフホストされている場合のオプションタブを以下に示します-

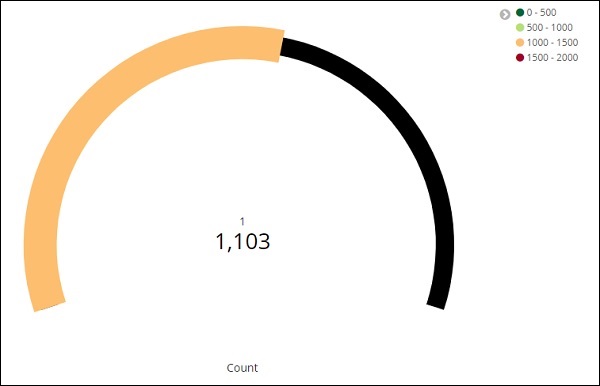

ゲージの視覚化により、データで考慮されるメトリックが事前定義された範囲内にどのように収まるかがわかります。

目標の視覚化により、目標と、データのメトリックが目標に向かってどのように進行するかがわかります。

ゲージの操作

Gaugeの使用を開始するには、視覚化に移動し、KibanaUIから[視覚化]タブを選択します。

ゲージをクリックして、使用するインデックスを選択します。

私たちはmedicalvisits-26.01.2019インデックスに取り組むつもりです。

2017年2月の時間範囲を選択してください

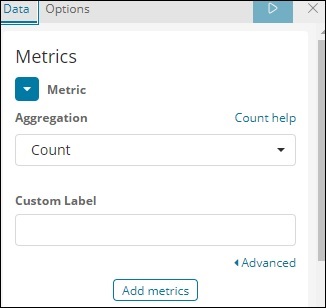

これで、メトリックとバケットの集計を選択できます。

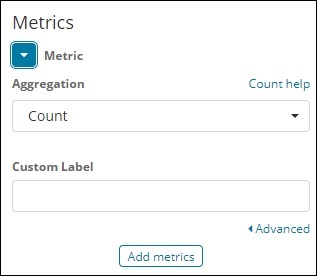

メトリック集計をカウントとして選択しました。

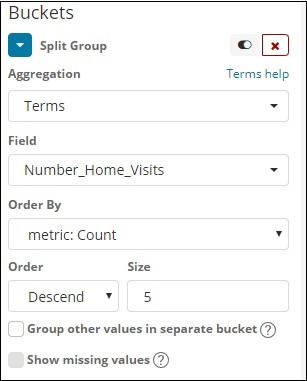

用語を選択したバケット集計。選択したフィールドはNumber_Home_Visitsです。

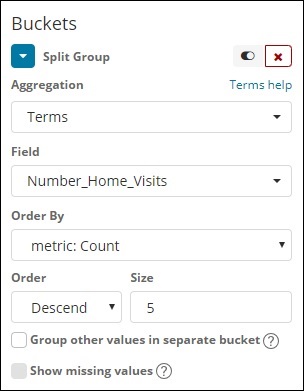

[データオプション]タブから、選択したオプションを以下に示します-

ゲージタイプは、円または円弧の形式にすることができます。円弧として選択し、その他はすべてデフォルト値として使用します。

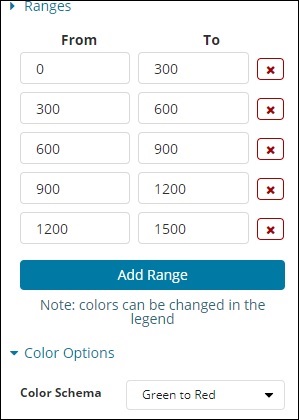

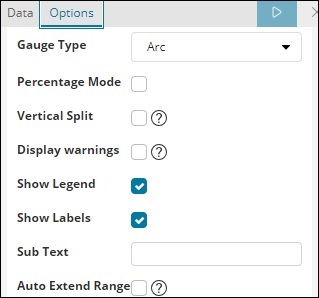

追加した定義済みの範囲を次に示します-

選択した色は緑から赤です。

次に、[分析]ボタンをクリックして、以下に示すようなゲージの形式で視覚化を確認します。

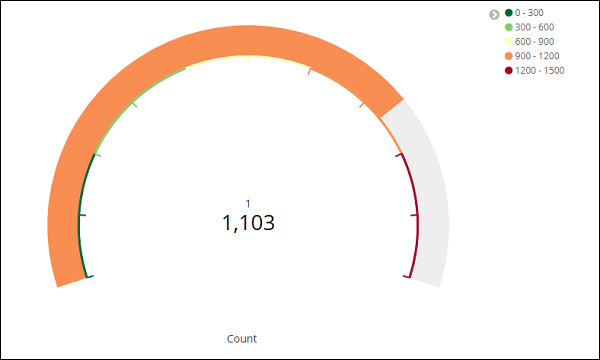

目標の処理

以下に示すように、[視覚化]タブに移動し、[目標]を選択します-

目標を選択し、インデックスを選択します。

インデックスとしてmedicalvisits-26.01.2019を使用します。

メトリック集計とバケット集計を選択します。

メトリック集約

メトリック集計として[カウント]を選択しました。

バケットの集約

バケットの集計として用語を選択しました。フィールドはNumber_Home_Visitsです。

選択したオプションは次のとおりです-

選択した範囲は次のとおりです-

[分析]をクリックすると、目標が次のように表示されます。

Canvasは、Kibanaのもう1つの強力な機能です。キャンバスの視覚化を使用すると、さまざまな色の組み合わせ、形状、テキスト、複数ページの設定などでデータを表すことができます。

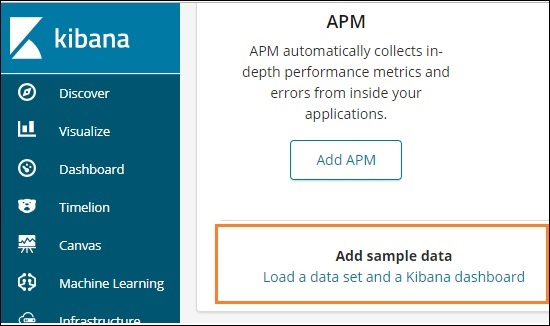

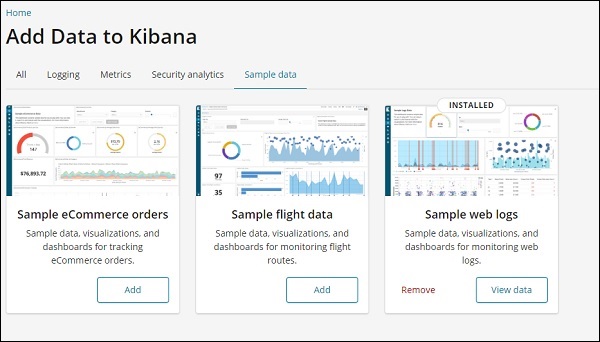

キャンバスに表示するデータが必要です。それでは、Kibanaですでに利用可能なサンプルデータをいくつかロードしてみましょう。

キャンバス作成用のサンプルデータの読み込み

サンプルデータを取得するには、Kibanaホームページに移動し、以下に示すように[サンプルデータの追加]をクリックします-

[データセットとKibanaダッシュボードの読み込み]をクリックします。以下のような画面が表示されます−

サンプルeコマース注文の[追加]ボタンをクリックします。サンプルデータの読み込みには時間がかかります。完了すると、「サンプルのeコマースデータが読み込まれました」というアラートメッセージが表示されます。

CanvasVisualization入門

次に、以下に示すようにCanvasVisualizationに移動します-

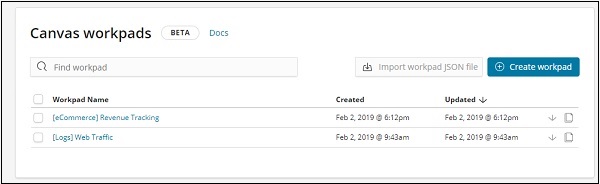

キャンバスをクリックすると、以下のような画面が表示されます-

eコマースとWebトラフィックのサンプルデータが追加されました。新しいワークパッドを作成することも、既存のワークパッドを使用することもできます。

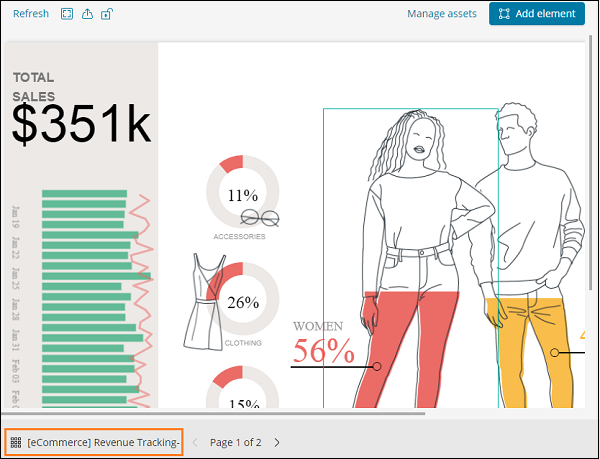

ここでは、既存のものを選択します。eコマース収益追跡ワークパッド名を選択すると、以下のような画面が表示されます-

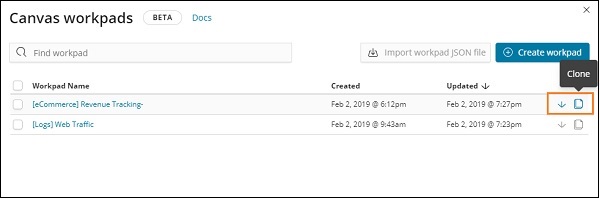

Canvasで既存のワークパッドを複製する

ワークパッドに変更を加えることができるように、ワークパッドのクローンを作成します。既存のワークパッドのクローンを作成するには、左下に表示されているワークパッドの名前をクリックします-

以下に示すように、名前をクリックしてクローンオプションを選択します-

クローンボタンをクリックすると、eコマースの収益追跡ワークパッドのコピーが作成されます。あなたはそれを以下に示すように見つけることができます-

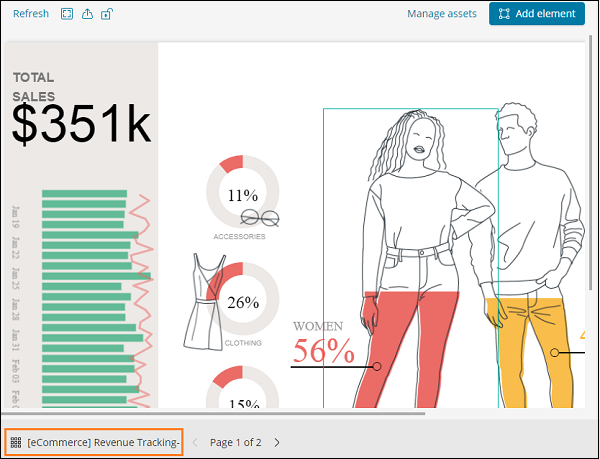

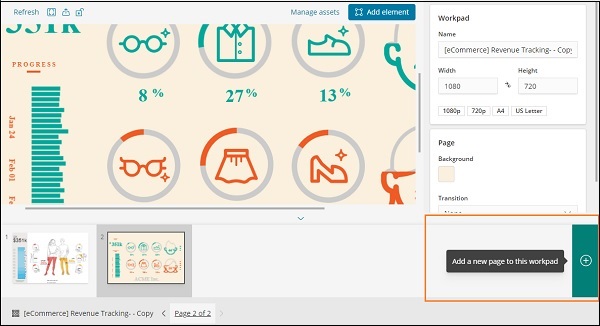

このセクションでは、ワークパッドの使用方法を理解しましょう。上記のワークパッドを見ると、2ページあります。したがって、キャンバスでは、データを複数のページで表すことができます。

2ページ目の表示は以下のようになります-

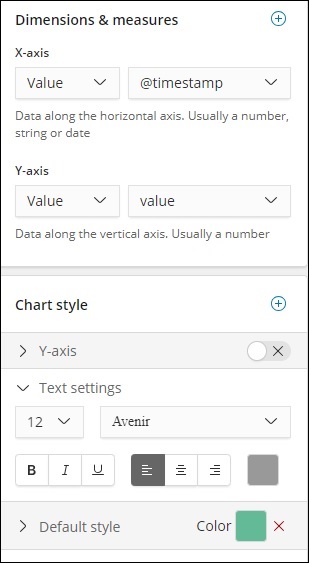

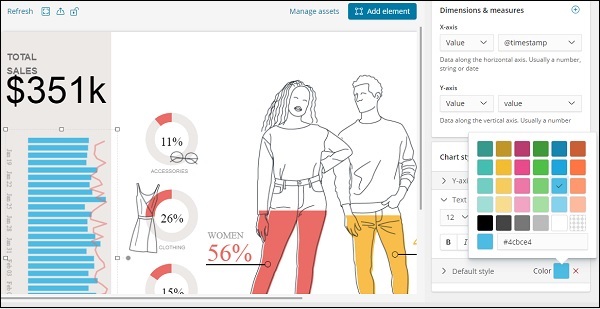

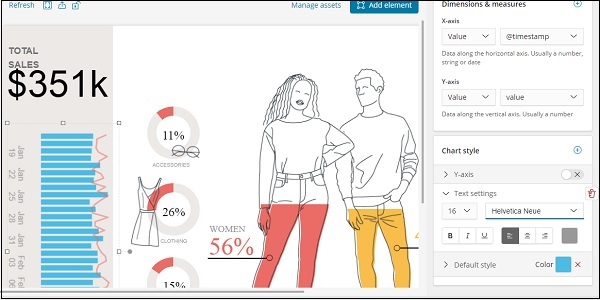

ページ1を選択し、以下に示すように左側に表示される総売上高をクリックします-

右側には、それに関連するデータが表示されます-

現在、使用されているデフォルトのスタイルは緑色です。ここで色を変えて、表示を確認することができます。

また、以下に示すように、テキスト設定のフォントとサイズを変更しました-

キャンバス内のワークパッドに新しいページを追加する

ワークパッドに新しいページを追加するには、以下のようにします-

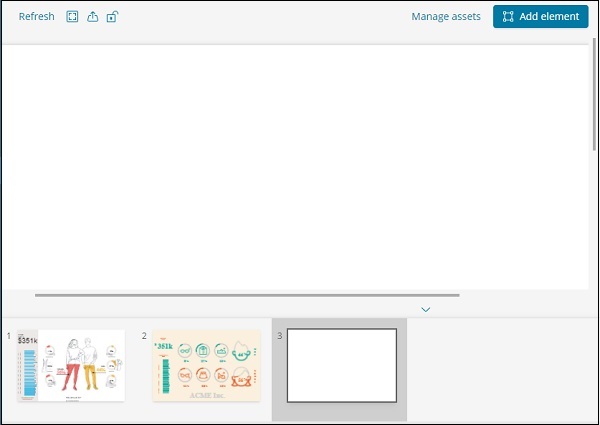

以下に示すようにページが作成されたら-

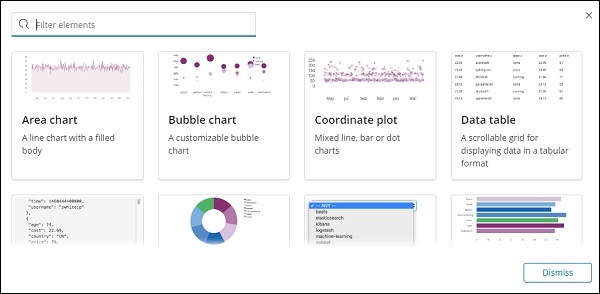

[要素の追加]をクリックすると、以下に示すように、可能なすべての視覚化が表示されます-

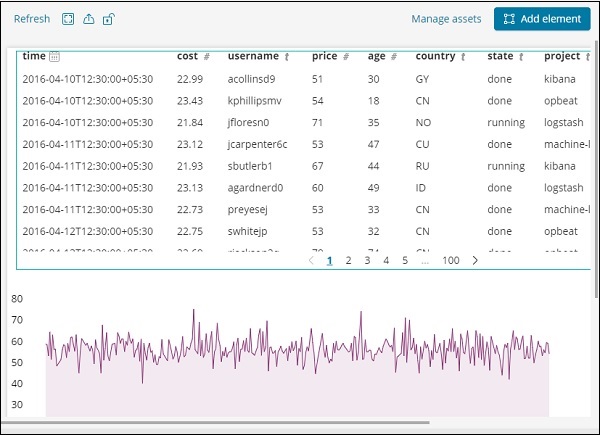

以下に示すように、データテーブルと面グラフの2つの要素を追加しました。

同じページにデータ要素を追加したり、ページを追加したりすることもできます。

前の章では、垂直バー、水平バー、円グラフなどの形式で視覚化を作成する方法を見てきました。この章では、ダッシュボードの形式でそれらを組み合わせる方法を学びましょう。ダッシュボードは、作成されたビジュアライゼーションのコレクションであるため、一度にすべてをまとめて確認できます。

ダッシュボード入門

Kibanaでダッシュボードを作成するには、以下に示すように利用可能なダッシュボードオプションをクリックします-

次に、上記のように[新しいダッシュボードの作成]ボタンをクリックします。以下のような画面が表示されます−

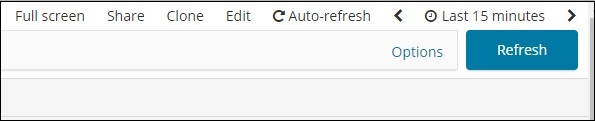

これまでにダッシュボードが作成されていないことに注意してください。上部には、保存、キャンセル、追加、オプション、共有、自動更新、およびダッシュボードでデータを取得する時間を変更できるオプションがあります。上記の[追加]ボタンをクリックして、新しいダッシュボードを作成します。

ダッシュボードに視覚化を追加する

[追加]ボタン(左上隅)をクリックすると、以下に示すように作成した視覚化が表示されます-

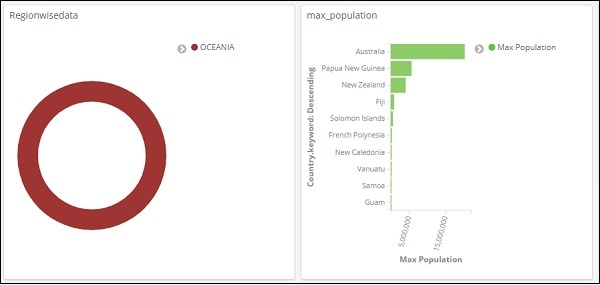

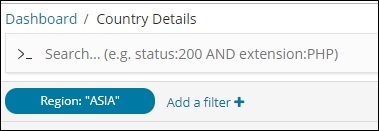

ダッシュボードに追加するビジュアライゼーションを選択します。以下に示すように、最初の3つの視覚化を選択します-

これが一緒に画面に表示される方法です-

したがって、ユーザーとして、アップロードしたデータに関する全体的な詳細を取得できます。国ごとに、国名、地域名、地域、人口のフィールドがあります。

これで、利用可能なすべての地域、国ごとの最大人口、最大面積などがわかりました。

これはアップロードしたサンプルデータの視覚化にすぎませんが、実際には、ビジネスの詳細を追跡するのは非常に簡単になります。たとえば、毎月または毎日数百万のヒットを記録するWebサイトがあり、売上を追跡したい場合などです。毎日、時間、分、秒で実行されます。ELKスタックが配置されている場合、Kibanaは、時間、分、秒ごとに、見たいように販売の視覚化を目の前に表示できます。実世界で起こっているように、リアルタイムデータを表示します。

Kibanaは、全体として、ビジネストランザクションに関する正確な詳細を日ごと、時間ごと、または毎分抽出する上で非常に重要な役割を果たします。そのため、会社は進捗状況を把握できます。

ダッシュボードを保存

上部の保存ボタンを使用してダッシュボードを保存できます。

ダッシュボードの名前を入力できるタイトルと説明、およびダッシュボードの機能を説明する簡単な説明があります。次に、[保存の確認]をクリックしてダッシュボードを保存します。

ダッシュボードの時間範囲の変更

現在、表示されているデータは過去15分間のものであることがわかります。これは時間フィールドのない静的データであるため、表示されるデータは変更されないことに注意してください。データをリアルタイムシステムに接続して時間を変更すると、反映されたデータも表示されます。

デフォルトでは、以下に示すように最後の15分が表示されます-

最後の15分をクリックすると、選択した時間範囲が表示されます。

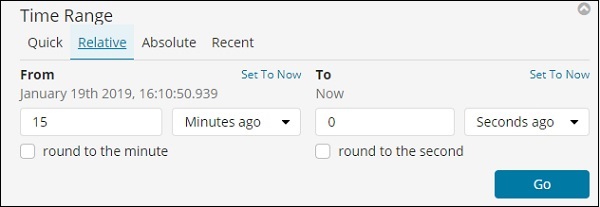

[クイック]、[相対]、[絶対]、[最近]のオプションがあることに注意してください。次のスクリーンショットは、クイックオプションの詳細を示しています-

次に、[相対]をクリックして、使用可能なオプションを確認します-

ここでは、開始日と終了日を分、時間、秒、月、年前で指定できます。

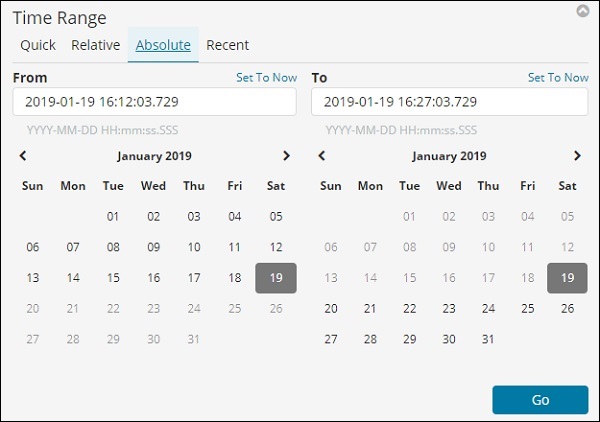

絶対オプションには次の詳細があります-

カレンダーオプションが表示され、日付範囲を選択できます。

最近のオプションは、過去15分間のオプションと、最近選択した他のオプションを返します。時間範囲を選択すると、その時間範囲内のデータが更新されます。

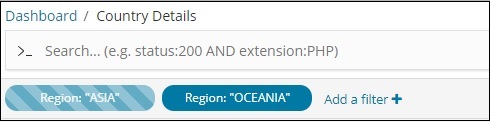

ダッシュボードでの検索とフィルターの使用

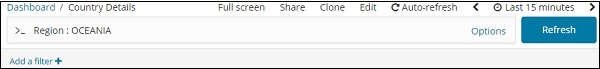

ダッシュボードで検索とフィルターを使用することもできます。検索では、特定の地域の詳細を取得したい場合、以下に示すように検索を追加できます。

上記の検索では、フィールドRegionを使用しており、region:OCEANIAの詳細を表示したいと考えています。

以下の結果が得られます-

上記のデータを見ると、オセアニア地域ではオーストラリアが最大の人口と面積を持っていると言えます。

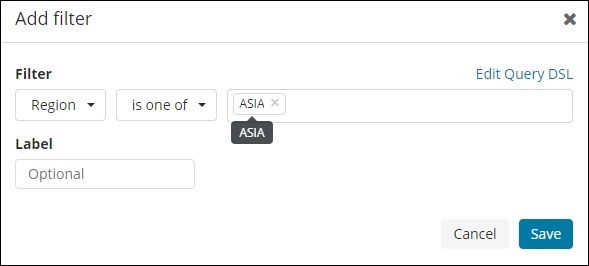

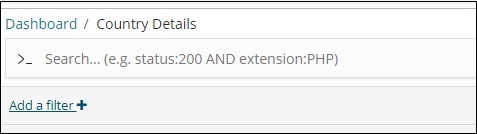

同様に、以下に示すようにフィルターを追加できます-

次に、[フィルターの追加]ボタンをクリックすると、以下に示すように、インデックスで使用可能なフィールドの詳細が表示されます。

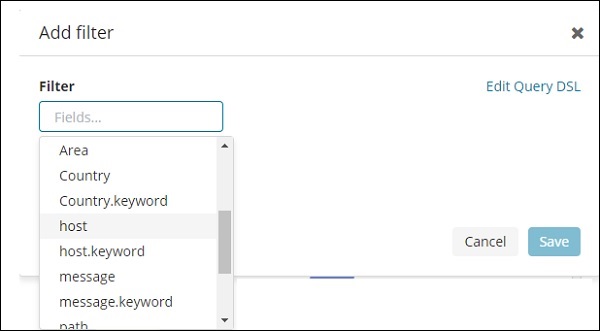

フィルタリングするフィールドを選択します。以下に示すように、Regionフィールドを使用してASIA地域の詳細を取得します-

フィルタを保存すると、次のようにフィルタが表示されます。

追加されたフィルターに従ってデータが表示されます-

以下に示すように、さらにフィルターを追加することもできます-

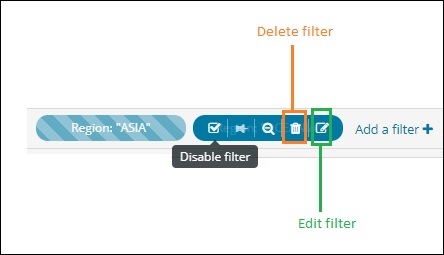

以下に示すように、[無効にする]チェックボックスをクリックすると、フィルターを無効にできます。

同じチェックボックスをクリックしてフィルターをアクティブにすると、フィルターをアクティブにできます。フィルタを削除するための削除ボタンがあることに注意してください。フィルタを編集したり、フィルタオプションを変更したりするには、[編集]ボタンをクリックします。

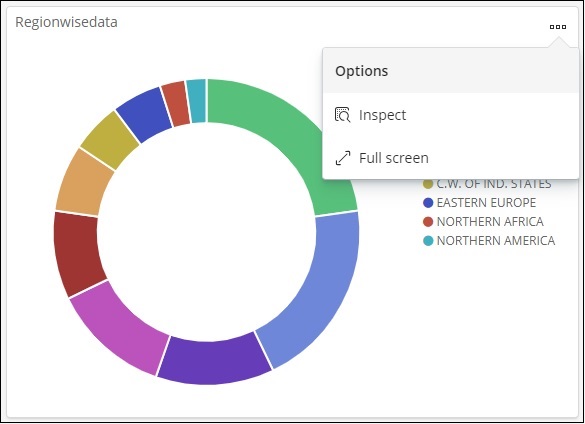

表示されたビジュアライゼーションでは、次のように3つのドットが表示されます-

それをクリックすると、以下のようなオプションが表示されます-

検査とフルスクリーン

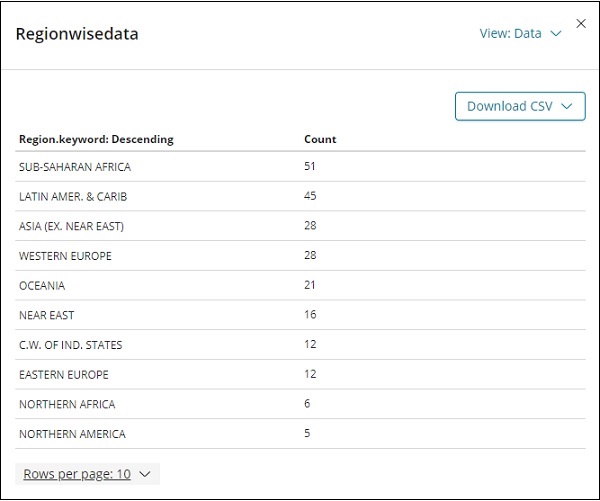

[検査]をクリックすると、以下に示すように、領域の詳細が表形式で表示されます。

Excelシートで表示したい場合に備えて、CSV形式でビジュアライゼーションをダウンロードするオプションがあります。

次のオプションのフルスクリーンは、以下に示すようにフルスクリーンモードで視覚化されます-

同じボタンを使用して、フルスクリーンモードを終了できます。

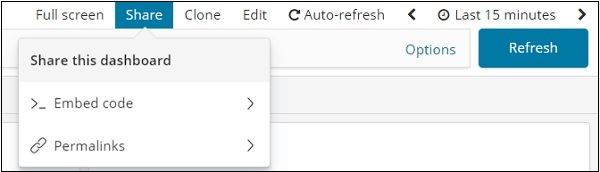

ダッシュボードの共有

共有ボタンを使用してダッシュボードを共有できます。共有ボタンをクリックすると、次のように表示されます-

埋め込みコードを使用してサイトにダッシュボードを表示したり、他のユーザーと共有するためのリンクとなるパーマリンクを使用したりすることもできます。

URLは次のようになります-

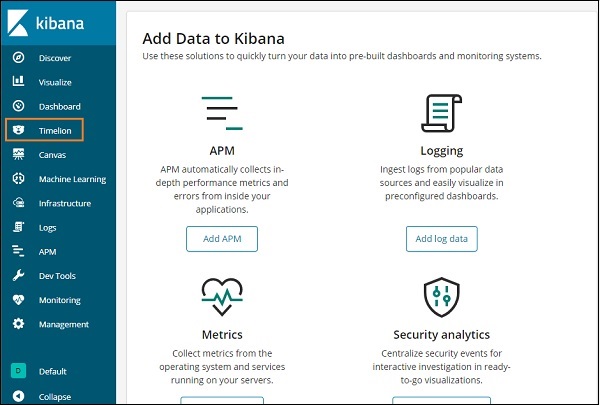

http://localhost:5601/goto/519c1a088d5d0f8703937d754923b84bタイムラインとも呼ばれるTimelionは、主に時間ベースのデータ分析に使用されるさらに別の視覚化ツールです。タイムラインを操作するには、インデックスに接続し、データに対して計算を実行して必要な結果を得るのに役立つ単純な式言語を使用する必要があります。

Timelionはどこで使用できますか?

Timelionは、時間関連のデータを比較する場合に使用されます。たとえば、サイトがあり、毎日ビューを取得しているとします。現在の週のデータを前の週と比較するデータ、つまり月曜日から月曜日、火曜日から火曜日など、ビューの違いやトラフィックを分析する必要があります。

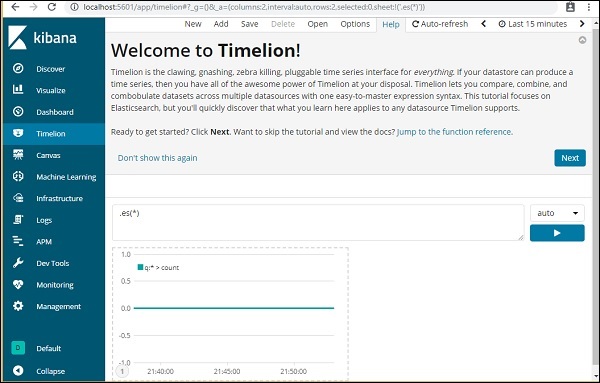

Timelion入門

Timelionの使用を開始するには、以下に示すようにTimelionをクリックします-

Timelionはデフォルトで、以下に示すようにすべてのインデックスのタイムラインを表示します-

Timelionは式の構文で動作します。

Note − es(*)=>はすべてのインデックスを意味します。

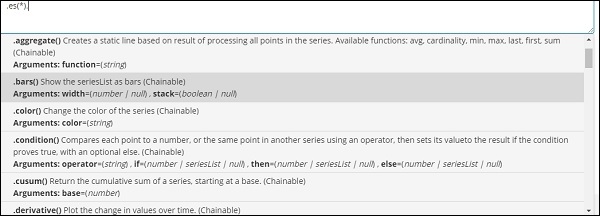

Timelionで使用できる関数の詳細を取得するには、以下に示すようにテキスト領域をクリックするだけです。

これは、式の構文で使用される関数のリストを提供します。

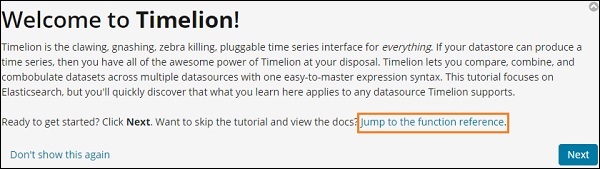

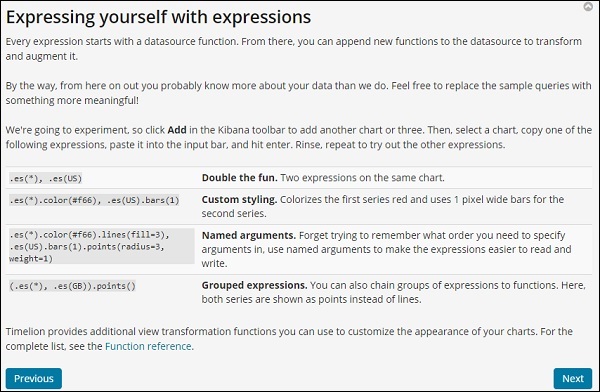

Timelionを起動すると、次のようなウェルカムメッセージが表示されます。強調表示されたセクション、つまり関数リファレンスにジャンプすると、timelionで使用できるすべての関数の詳細が示されます。

Timelionウェルカムメッセージ

Timelionのウェルカムメッセージは以下のとおりです-

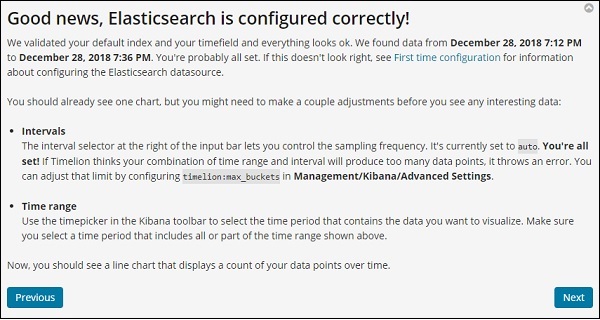

次のボタンをクリックすると、基本的な機能と使用法が説明されます。[次へ]をクリックすると、次の詳細が表示されます-

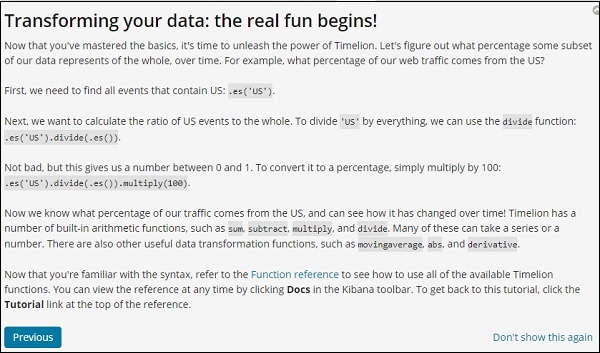

Timelion関数リファレンス

[ヘルプ]ボタンをクリックして、Timelionで利用可能な関数リファレンスの詳細を取得します-

Timelionの構成

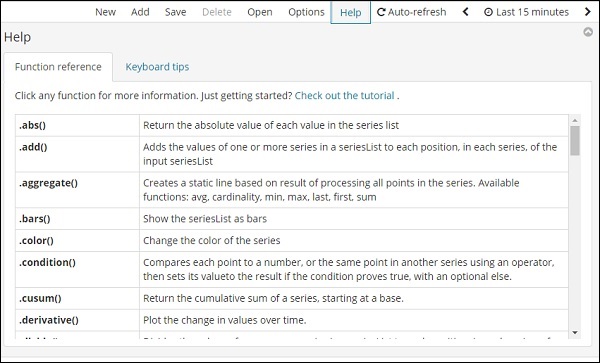

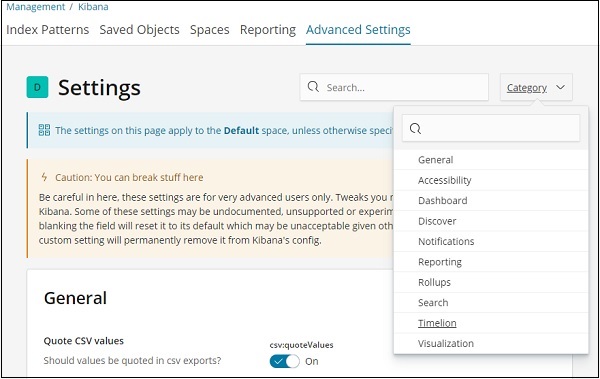

timelionの設定は、KibanaManagement→AdvancedSettingsで行います。

詳細設定をクリックし、カテゴリからTimelionを選択します

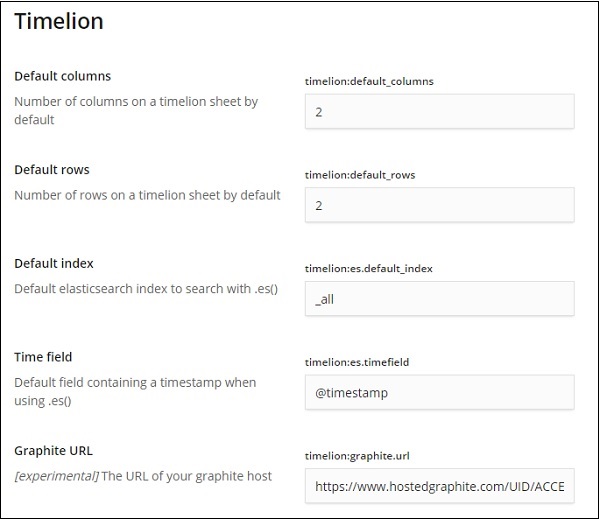

Timelionを選択すると、timelionの構成に必要なすべてのフィールドが表示されます。

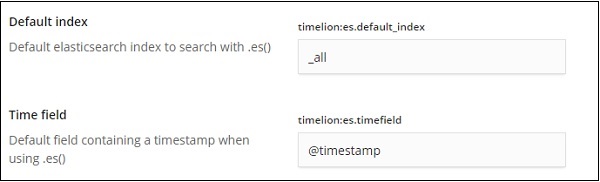

次のフィールドで、デフォルトのインデックスとインデックスで使用されるタイムフィールドを変更できます-

デフォルトは_allで、timefieldは@timestampです。そのままにして、タイムライオン自体のインデックスとタイムフィールドを変更します。

Timelionを使用したデータの視覚化

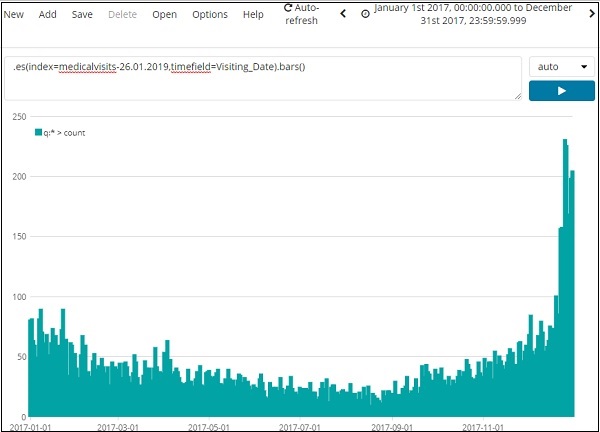

インデックスを使用します:medicalvisits-26.01.2019。以下は、2017年1月1日から2017年12月31日までのタイムライオンから表示されたデータです-

上記の視覚化に使用される式は次のとおりです。

.es(index=medicalvisits-26.01.2019,timefield=Visiting_Date).bars()インデックスmedicalvisits-26.01.2019を使用し、そのインデックスのタイムフィールドはVisiting_Dateであり、バー関数を使用しました。

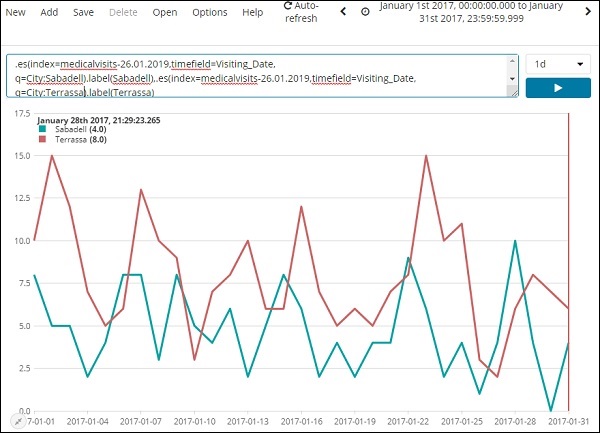

以下では、2017年1月の2つの都市を日ごとに分析しました。

使用される式は次のとおりです。

.es(index=medicalvisits-26.01.2019,timefield=Visiting_Date,

q=City:Sabadell).label(Sabadell),.es(index=medicalvisits-26.01.2019,

timefield=Visiting_Date, q=City:Terrassa).label(Terrassa)2日間のタイムライン比較をここに示します-

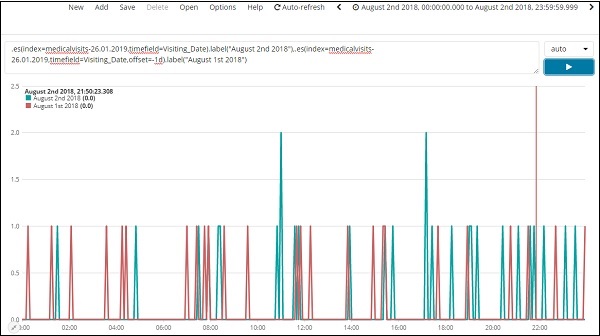

式

.es(index=medicalvisits-26.01.2019,timefield=Visiting_Date).label("August 2nd 2018"),

.es(index=medicalvisits-26.01.2019,timefield=Visiting_Date,offset=-1d).label("August 1st 2018")ここではオフセットを使用し、1日の差を与えています。現在の日付を2018年8月2日として選択しました。したがって、2018年8月2日と2018年8月1日のデータの違いがわかります。

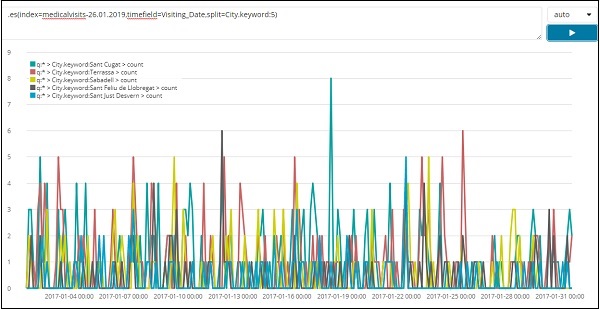

2017年1月の上位5都市のデータのリストを以下に示します。ここで使用した式は次のとおりです。

.es(index=medicalvisits-26.01.2019,timefield=Visiting_Date,split=City.keyword:5)

splitを使用し、フィールド名をcityとして指定しました。インデックスから上位5つの都市が必要なため、split = City.keyword:5として指定しました。

それは各都市の数を与え、プロットされたグラフに示されているようにそれらの名前をリストします。

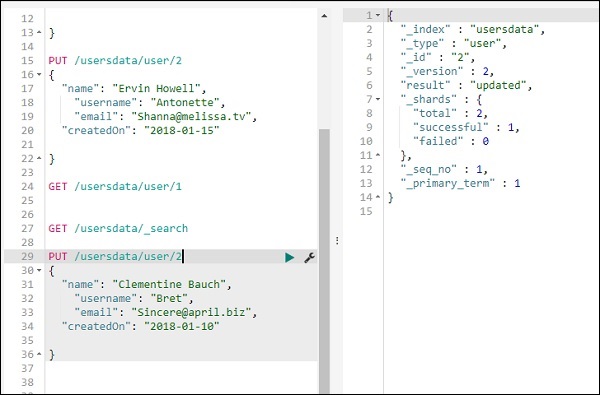

Logstashを使用せずに、開発ツールを使用してElasticsearchにデータをアップロードできます。開発ツールを使用して、Kibanaに必要なデータを投稿、配置、削除、検索できます。

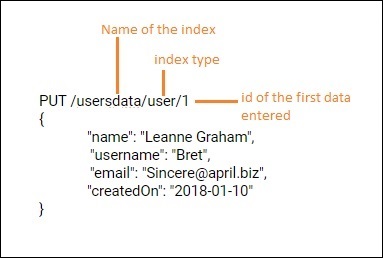

Kibanaで新しいインデックスを作成するには、開発ツールで次のコマンドを使用できます-

PUTを使用してインデックスを作成する

インデックスを作成するコマンドは次のとおりです-

PUT /usersdata?prettyこれを実行すると、空のインデックスuserdataが作成されます。

インデックスの作成は完了です。次に、インデックスにデータを追加します-

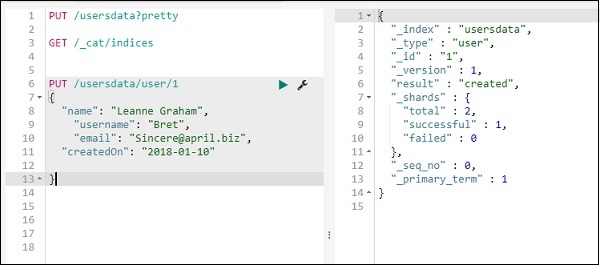

PUTを使用してインデックスにデータを追加する

次のようにデータをインデックスに追加できます-

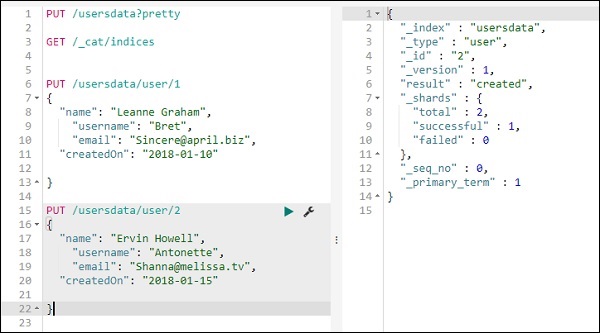

usersdataインデックスにもう1つのレコードを追加します-

したがって、usersdataインデックスには2つのレコードがあります。

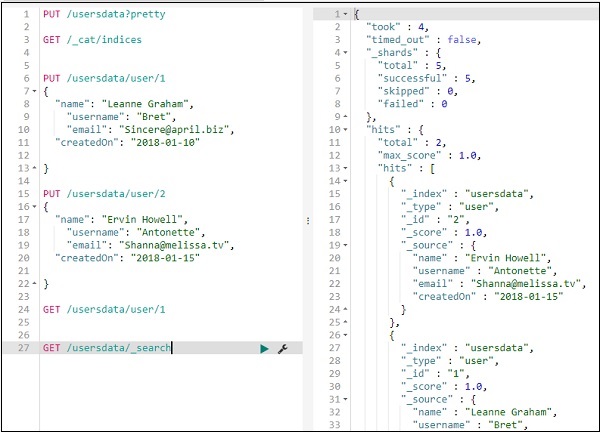

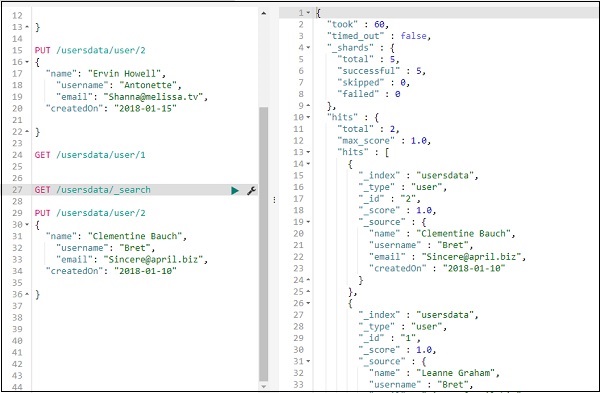

GETを使用してインデックスからデータをフェッチする

レコード1の詳細は次のように取得できます-

次のようにすべてのレコードを取得できます-

したがって、上記のように、usersdataからすべてのレコードを取得できます。

PUTを使用してインデックスのデータを更新する

レコードを更新するには、次のようにします-

名前を「ErvinHowell」から「ClementineBauch」に変更しました。これで、インデックスからすべてのレコードを取得し、次のように更新されたレコードを確認できます。

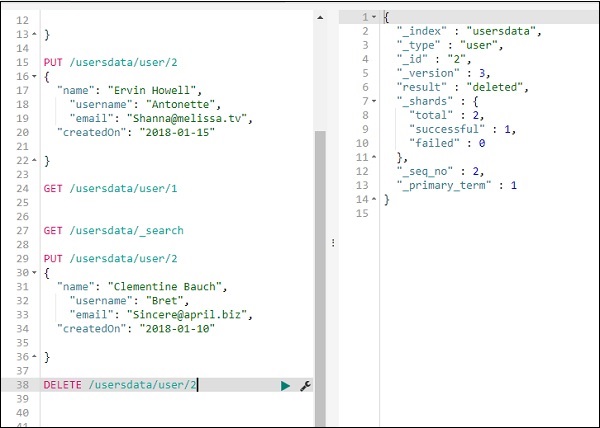

DELETEを使用してインデックスからデータを削除します

ここに示すようにレコードを削除できます-

これで、合計レコードが表示された場合、レコードは1つだけになります-

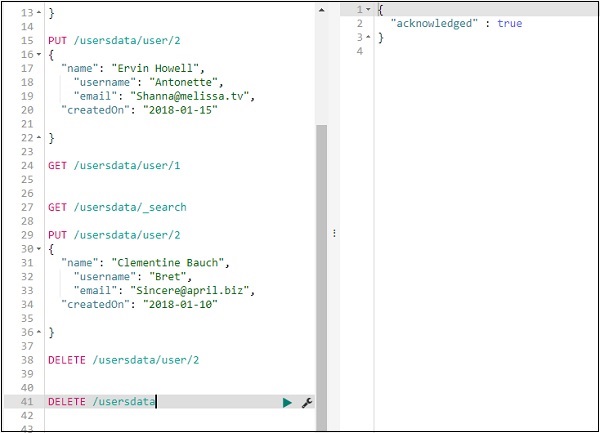

次のように作成されたインデックスを削除できます-

使用可能なインデックスを確認すると、インデックスが削除されたため、usersdataインデックスが含まれていません。

Kibana Monitoringは、ELKスタックのパフォーマンスに関する詳細を提供します。使用したメモリ、応答時間などの詳細を取得できます。

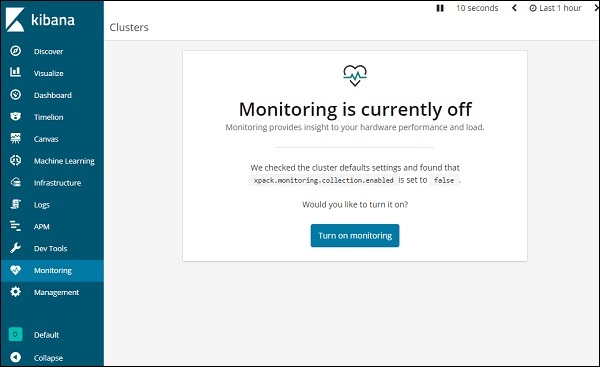

モニタリングの詳細

Kibanaでモニタリングの詳細を取得するには、以下に示すようにモニタリングタブをクリックします-

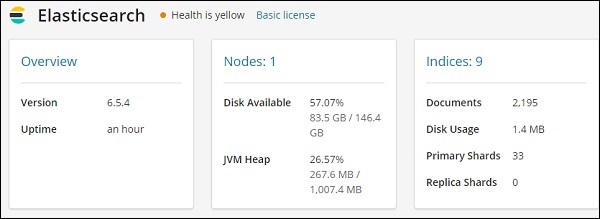

初めてモニタリングを使用するので、オンにしておく必要があります。これには、ボタンをクリックしますTurn on monitoring上に示すように。Elasticsearchに表示される詳細は次のとおりです-

これは、elasticsearchのバージョン、使用可能なディスク、elasticsearchに追加されたインデックス、ディスク使用量などを提供します。

Kibanaの監視の詳細をここに示します-

これは、リクエストとリクエストの最大応答時間、および実行中のインスタンスとメモリ使用量を示します。

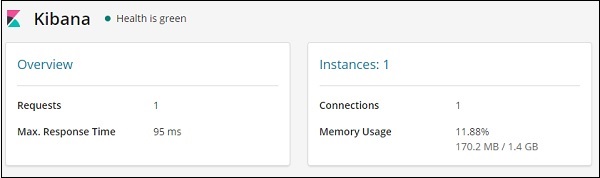

Kibana UIで使用できる[共有]ボタンを使用すると、レポートを簡単に作成できます。

Kibanaのレポートは、次の2つの形式で入手できます。

- Permalinks

- CSVレポート

パーマリンクとして報告する

視覚化を実行するときは、次のように同じことを共有できます-

共有ボタンを使用して、視覚化を埋め込みコードまたはパーマリンクとして他のユーザーと共有します。

埋め込みコードの場合、次のオプションがあります-

スナップショットまたは保存されたオブジェクトの短いURLまたは長いURLとしてiframeコードを生成できます。スナップショットは最近のデータを提供せず、ユーザーはリンクが共有されたときに保存されたデータを見ることができます。後で行われた変更は反映されません。

保存されたオブジェクトの場合、そのビジュアライゼーションに加えられた最近の変更を取得します。

長いURLのスナップショットIFrameコード-

<iframe src="http://localhost:5601/app/kibana#/visualize/edit/87af

cb60-165f-11e9-aaf1-3524d1f04792?embed=true&_g=()&_a=(filters:!(),linked:!f,query:(language:lucene,query:''),

uiState:(),vis:(aggs:!((enabled:!t,id:'1',params:(field:Area),schema:metric,type:max),(enabled:!t,id:'2',p

arams:(field:Country.keyword,missingBucket:!f,missingBucketLabel:Missing,order:desc,orderBy:'1',otherBucket:!

f,otherBucketLabel:Other,size:10),schema:segment,type:terms)),params:(addLegend:!t,addTimeMarker:!f,addToo

ltip:!t,categoryAxes:!((id:CategoryAxis-1,labels:(show:!t,truncate:100),position:bottom,scale:(type:linear),

show:!t,style:(),title:(),type:category)),grid:(categoryLines:!f,style:(color:%23eee)),legendPosition:right,

seriesParams:!((data:(id:'1',label:'Max+Area'),drawLi

nesBetweenPoints:!t,mode:stacked,show:true,showCircles:!t,type:histogram,valueAxis:ValueAxis-1)),times:!(),

type:histogram,valueAxes:!((id:ValueAxis-1,labels:(filter:!f,rotate:0,show:!t,truncate:100),name:LeftAxis-1,

position:left,scale:(mode:normal,type:linear),show:!t,style:(),title:(text:'Max+Area'),type:value))),title:

'countrywise_maxarea+',type:histogram))" height="600" width="800"></iframe>短縮URLのスナップショットIframeコード-

<iframe src="http://localhost:5601/goto/f0a6c852daedcb6b4fa74cce8c2ff6c4?embed=true" height="600" width="800"><iframe>スナップショットおよびショットURLとして。

短縮URL付き-

http://localhost:5601/goto/f0a6c852daedcb6b4fa74cce8c2ff6c4短縮URLをオフにすると、リンクは次のようになります-

http://localhost:5601/app/kibana#/visualize/edit/87afcb60-165f-11e9-aaf1-3524d1f04792?_g=()&_a=(filters:!(

),linked:!f,query:(language:lucene,query:''),uiState:(),vis:(aggs:!((enabled:!t,id:'1',params:(field:Area),

schema:metric,type:max),(enabled:!t,id:'2',params:(field:Country.keyword,missingBucket:!f,missingBucketLabel:

Missing,order:desc,orderBy:'1',otherBucket:!f,otherBucketLabel:Other,size:10),schema:segment,type:terms)),

params:(addLegend:!t,addTimeMarker:!f,addTooltip:!t,categoryAxes:!((id:CategoryAxis-1,labels:(show:!t,trun

cate:100),position:bottom,scale:(type:linear),show:!t,style:(),title:(),type:category)),grid:(categoryLine

s:!f,style:(color:%23eee)),legendPosition:right,seriesParams:!((data:(id:'1',label:'Max%20Area'),drawLines

BetweenPoints:!t,mode:stacked,show:true,showCircles:!t,type:histogram,valueAxis:ValueAxis-1)),times:!(),

type:histogram,valueAxes:!((id:ValueAxis-1,labels:(filter:!f,rotate:0,show:!t,truncate:100),name:LeftAxis-1,

position:left,scale:(mode:normal,type:linear),show:!t,style:(),title:(text:'Max%20Area'),type:value))),title:'countrywise_maxarea%20',type:histogram))ブラウザで上記のリンクをクリックすると、上記と同じ視覚化が得られます。上記のリンクはローカルでホストされているため、ローカル環境の外部で使用すると機能しません。

CSVレポート

データがあるKibanaでCSVレポートを取得できます。これは、主に[検出]タブにあります。

[検出]タブに移動し、データが必要なインデックスを取得します。ここでは、インデックスを取得しました:countriesdata-26.12.2018。これがインデックスから表示されたデータです-

以下に示すように、上記のデータから表形式のデータを作成できます-

[利用可能なフィールド]からフィールドを選択し、前に表示したデータを表形式に変換します。

以下に示すように、CSVレポートで上記のデータを取得できます-

共有ボタンには、CSVレポートとパーマリンクのオプションがあります。CSVレポートをクリックしてダウンロードできます。

データを保存するために必要なCSVレポートを取得することに注意してください。

[保存]を確認し、[共有]ボタンとCSVレポートをクリックします。次の表示が表示されます-

[CSVの生成]をクリックしてレポートを取得します。完了すると、[管理]タブに移動するように指示されます。

[管理]タブ→[レポート]に移動します

作成されたレポート名、ステータス、およびアクションが表示されます。上で強調表示されているダウンロードボタンをクリックして、csvレポートを取得できます。

ダウンロードしたCSVファイルは以下のとおりです-