डीएए - त्वरित गाइड

एल्गोरिथ्म एक गणना, डेटा प्रोसेसिंग, और स्वचालित तर्क कार्यों को पूरा करने के लिए संचालन के चरणों का एक समूह है। एक एल्गोरिथ्म एक कुशल विधि है जिसे समय और स्थान की परिमित मात्रा के भीतर व्यक्त किया जा सकता है।

एक एल्गोरिथ्म एक बहुत ही सरल और कुशल तरीके से किसी विशेष समस्या के समाधान का प्रतिनिधित्व करने का सबसे अच्छा तरीका है। यदि हमारे पास एक विशिष्ट समस्या के लिए एक एल्गोरिथम है, तो हम इसे किसी भी प्रोग्रामिंग भाषा में लागू कर सकते हैं, जिसका अर्थ है कि एalgorithm is independent from any programming languages।

एल्गोरिदम डिजाइन

एल्गोरिथ्म डिजाइन के महत्वपूर्ण पहलुओं में न्यूनतम समय और स्थान का उपयोग करके एक समस्या को हल करने के लिए एक कुशल एल्गोरिदम बनाना शामिल है।

किसी समस्या को हल करने के लिए, विभिन्न तरीकों का पालन किया जा सकता है। उनमें से कुछ समय की खपत के संबंध में कुशल हो सकते हैं, जबकि अन्य दृष्टिकोण स्मृति कुशल हो सकते हैं। हालांकि, किसी को यह ध्यान रखना होगा कि समय की खपत और स्मृति उपयोग दोनों को एक साथ अनुकूलित नहीं किया जा सकता है। यदि हमें कम समय में चलने के लिए एक एल्गोरिथ्म की आवश्यकता होती है, तो हमें अधिक मेमोरी में निवेश करना होगा और यदि हमें कम मेमोरी के साथ चलने के लिए एल्गोरिथम की आवश्यकता है, तो हमें अधिक समय की आवश्यकता है।

समस्या विकास कदम

निम्नलिखित चरण कम्प्यूटेशनल समस्याओं को हल करने में शामिल हैं।

- समस्या की परिभाषा

- एक मॉडल का विकास

- एक एल्गोरिथ्म की विशिष्टता

- एक एल्गोरिथ्म डिजाइनिंग

- एक एल्गोरिथ्म की शुद्धता की जाँच

- एक एल्गोरिथम का विश्लेषण

- एक एल्गोरिथ्म का कार्यान्वयन

- कार्यक्रम का परीक्षण

- Documentation

एल्गोरिदम के लक्षण

एल्गोरिदम की मुख्य विशेषताएं इस प्रकार हैं -

एल्गोरिदम में एक विशिष्ट नाम होना चाहिए

एल्गोरिदम में इनपुट और आउटपुट के स्पष्ट रूप से निर्धारित सेट होने चाहिए

एल्गोरिदम असंदिग्ध संचालन के साथ सुव्यवस्थित हैं

एल्गोरिदम समय की एक सीमित मात्रा में रुकते हैं। एल्गोरिथ्म को अनंत के लिए नहीं चलना चाहिए, अर्थात, एल्गोरिथ्म को किसी बिंदु पर समाप्त होना चाहिए

स्यूडोकोड

Pseudocode सादे पाठ के साथ जुड़े अस्पष्टता के बिना एक एल्गोरिथ्म का एक उच्च-स्तरीय विवरण देता है, लेकिन एक विशेष प्रोग्रामिंग भाषा के वाक्यविन्यास को जानने की आवश्यकता के बिना भी।

एल्गोरिथ्म को मौलिक कार्यों के एक सेट के रूप में दर्शाने के लिए स्यूडोकोड का उपयोग करके रनिंग टाइम को अधिक सामान्य तरीके से अनुमानित किया जा सकता है जिसे तब गिना जा सकता है।

एल्गोरिथ्म और स्यूडोकोड के बीच अंतर

एक एल्गोरिथ्म कुछ विशिष्ट विशेषताओं के साथ एक औपचारिक परिभाषा है जो एक प्रक्रिया का वर्णन करता है, जिसे एक विशिष्ट कार्य करने के लिए ट्यूरिंग-पूर्ण कंप्यूटर मशीन द्वारा निष्पादित किया जा सकता है। आम तौर पर, कंप्यूटर विज्ञान में किसी भी उच्च स्तरीय कार्य का वर्णन करने के लिए "एल्गोरिथ्म" शब्द का उपयोग किया जा सकता है।

दूसरी ओर, स्यूडोकोड एक अनौपचारिक और (अक्सर अल्पविकसित) मानव एल्गोरिथ्म का पठनीय विवरण होता है, जिसमें इसके कई बारीक विवरण होते हैं। स्यूडोकोड लिखने में शैलियों का कोई प्रतिबंध नहीं है और इसका एकमात्र उद्देश्य एल्गोरिथम के उच्च स्तर के चरणों का प्राकृतिक भाषा में बहुत यथार्थवादी तरीके से वर्णन करना है।

उदाहरण के लिए, प्रविष्टि सॉर्ट के लिए एक एल्गोरिथ्म निम्नलिखित है।

Algorithm: Insertion-Sort

Input: A list L of integers of length n

Output: A sorted list L1 containing those integers present in L

Step 1: Keep a sorted list L1 which starts off empty

Step 2: Perform Step 3 for each element in the original list L

Step 3: Insert it into the correct position in the sorted list L1.

Step 4: Return the sorted list

Step 5: Stopयहाँ एक छद्मकोश है जो वर्णन करता है कि एल्गोरिथ्म सम्मिलन-क्रम में ऊपर वर्णित उच्च स्तरीय अमूर्त प्रक्रिया को और अधिक यथार्थवादी तरीके से कैसे वर्णित किया जा सकता है।

for i <- 1 to length(A)

x <- A[i]

j <- i

while j > 0 and A[j-1] > x

A[j] <- A[j-1]

j <- j - 1

A[j] <- xइस ट्यूटोरियल में, एल्गोरिदम को pseudocode के रूप में प्रस्तुत किया जाएगा, जो कि C, C ++, Java, Python, और अन्य प्रोग्रामिंग भाषाओं के कई मामलों में समान है।

एल्गोरिदम के सैद्धांतिक विश्लेषण में, मनमाने ढंग से बड़े इनपुट के लिए जटिलता समारोह का अनुमान लगाने के लिए, स्पर्शोन्मुख अर्थों में उनकी जटिलता का अनुमान लगाना आम है। अवधि"analysis of algorithms" डोनाल्ड नथ द्वारा गढ़ा गया था।

एल्गोरिथम विश्लेषण कम्प्यूटेशनल जटिलता सिद्धांत का एक महत्वपूर्ण हिस्सा है, जो एक विशिष्ट कम्प्यूटेशनल समस्या को हल करने के लिए एल्गोरिदम के आवश्यक संसाधनों के लिए सैद्धांतिक अनुमान प्रदान करता है। अधिकांश एल्गोरिदम को मनमानी लंबाई के इनपुट के साथ काम करने के लिए डिज़ाइन किया गया है। एल्गोरिदम का विश्लेषण उसे निष्पादित करने के लिए आवश्यक समय और अंतरिक्ष संसाधनों की मात्रा का निर्धारण है।

आमतौर पर, एल्गोरिथ्म की दक्षता या चलने का समय एक फ़ंक्शन के रूप में कहा जाता है, जो इनपुट लंबाई से संबंधित चरणों की संख्या से संबंधित है time complexity, या स्मृति की मात्रा, के रूप में जाना जाता है space complexity।

विश्लेषण की आवश्यकता है

इस अध्याय में, हम एल्गोरिदम के विश्लेषण की आवश्यकता पर चर्चा करेंगे और किसी विशेष समस्या के लिए एक बेहतर एल्गोरिदम का चयन कैसे करें क्योंकि एक कम्प्यूटेशनल समस्या को विभिन्न एल्गोरिदम द्वारा हल किया जा सकता है।

एक विशिष्ट समस्या के लिए एक एल्गोरिथ्म पर विचार करके, हम पैटर्न मान्यता को विकसित करना शुरू कर सकते हैं ताकि इस एल्गोरिथ्म की मदद से इसी प्रकार की समस्याओं को हल किया जा सके।

एल्गोरिदम अक्सर एक दूसरे से काफी अलग होते हैं, हालांकि इन एल्गोरिदम का उद्देश्य समान है। उदाहरण के लिए, हम जानते हैं कि विभिन्न एल्गोरिदमों का उपयोग करके संख्याओं का एक सेट छांटा जा सकता है। एक एल्गोरिथ्म द्वारा की गई तुलनाओं की संख्या समान इनपुट के लिए दूसरों के साथ भिन्न हो सकती है। इसलिए, उन एल्गोरिदम की समय जटिलता भिन्न हो सकती है। उसी समय, हमें प्रत्येक एल्गोरिथ्म द्वारा आवश्यक मेमोरी स्पेस की गणना करने की आवश्यकता है।

एल्गोरिथ्म का विश्लेषण एल्गोरिथ्म की समस्या को सुलझाने की क्षमता का विश्लेषण करने की प्रक्रिया है समय और आकार के संदर्भ में आवश्यक है (कार्यान्वयन के दौरान भंडारण के लिए स्मृति का आकार)। हालांकि, एल्गोरिदम के विश्लेषण की मुख्य चिंता आवश्यक समय या प्रदर्शन है। आम तौर पर, हम निम्नलिखित प्रकार के विश्लेषण करते हैं -

Worst-case - आकार के किसी भी उदाहरण पर उठाए गए कदमों की अधिकतम संख्या a।

Best-case - आकार के किसी भी उदाहरण पर उठाए गए कदमों की न्यूनतम संख्या a।

Average case - आकार के किसी भी उदाहरण पर उठाए गए कदमों की औसत संख्या a।

Amortized - आकार के इनपुट पर लागू संचालन का एक क्रम a समय के साथ औसतन।

एक समस्या को हल करने के लिए, हमें समय के साथ-साथ अंतरिक्ष की जटिलता पर भी विचार करने की आवश्यकता है क्योंकि कार्यक्रम एक प्रणाली पर चल सकता है जहां मेमोरी सीमित है लेकिन पर्याप्त स्थान उपलब्ध है या इसके विपरीत हो सकता है। इस संदर्भ में, यदि हम तुलना करते हैंbubble sort तथा merge sort। बबल सॉर्ट को अतिरिक्त मेमोरी की आवश्यकता नहीं होती है, लेकिन मर्ज सॉर्ट के लिए अतिरिक्त स्थान की आवश्यकता होती है। हालांकि मर्ज सॉर्ट की तुलना में बबल सॉर्ट की समय जटिलता अधिक होती है, लेकिन अगर प्रोग्राम को किसी वातावरण में चलाने की आवश्यकता है, तो बबल सॉर्ट को लागू करने की आवश्यकता हो सकती है, जहां मेमोरी बहुत सीमित है।

एक एल्गोरिथ्म के संसाधन खपत को मापने के लिए, इस अध्याय में चर्चा की गई विभिन्न रणनीतियों का उपयोग किया जाता है।

असममित विश्लेषण

किसी फ़ंक्शन का स्पर्शोन्मुख व्यवहार f(n) की वृद्धि को दर्शाता है f(n) जैसा n बड़ा हो जाता है।

हम आम तौर पर के छोटे मूल्यों की अनदेखी करते हैं n, क्योंकि हम आम तौर पर यह अनुमान लगाने में रुचि रखते हैं कि बड़े इनपुट पर कार्यक्रम कितना धीमा होगा।

अंगूठे का एक अच्छा नियम यह है कि स्पर्शोन्मुख विकास दर जितनी धीमी होगी, एल्गोरिथम उतना ही बेहतर होगा। हालांकि यह हमेशा सच नहीं होता है।

उदाहरण के लिए, एक रैखिक एल्गोरिथ्म $f(n) = d * n + k$ हमेशा asymptotically एक द्विघात से बेहतर है, $f(n) = c.n^2 + q$।

पुनरावृत्ति समीकरणों को हल करना

पुनरावृत्ति एक समीकरण या असमानता है जो छोटे आदानों पर इसके मूल्य के संदर्भ में एक फ़ंक्शन का वर्णन करता है। आवर्ती का उपयोग आम तौर पर विभाजन और विजय प्रतिमान में किया जाता है।

हम मानते हैं T(n) आकार की समस्या पर चलने का समय होना n।

यदि समस्या का आकार काफी छोटा है, तो कहें n < c कहाँ पे c एक स्थिर है, सीधा समाधान निरंतर समय लेता है, जिसे इस प्रकार लिखा जाता है θ(1)। यदि समस्या का विभाजन आकार के साथ कई उप-समस्याओं का उत्पादन करता है$\frac{n}{b}$।

समस्या को हल करने के लिए, आवश्यक समय है a.T(n/b)। यदि हम विभाजन के लिए आवश्यक समय पर विचार करते हैंD(n) और उप-समस्याओं के परिणामों के संयोजन के लिए आवश्यक समय है C(n)पुनरावृत्ति संबंध का प्रतिनिधित्व इस प्रकार किया जा सकता है -

$$T(n)=\begin{cases}\:\:\:\:\:\:\:\:\:\:\:\:\:\:\:\:\:\:\:\:\:\:\:\theta(1) & if\:n\leqslant c\\a T(\frac{n}{b})+D(n)+C(n) & otherwise\end{cases}$$

निम्नलिखित तरीकों का उपयोग करके एक पुनरावृत्ति संबंध को हल किया जा सकता है -

Substitution Method - इस पद्धति में, हम एक बाध्य अनुमान लगाते हैं और गणितीय प्रेरण का उपयोग करके हम यह साबित करते हैं कि हमारी धारणा सही थी।

Recursion Tree Method - इस विधि में, एक पुनरावृत्ति वृक्ष का निर्माण होता है जहाँ प्रत्येक नोड लागत का प्रतिनिधित्व करता है।

Master’s Theorem - पुनरावृत्ति संबंध की जटिलता को खोजने के लिए यह एक और महत्वपूर्ण तकनीक है।

परिशोधित विश्लेषण

अमूर्त विश्लेषण आमतौर पर कुछ एल्गोरिदम के लिए उपयोग किया जाता है जहां समान संचालन का एक क्रम किया जाता है।

परिशोधित विश्लेषण अलग-अलग संचालन के अनुक्रम की लागत को बाध्य करने के बजाय, पूरे अनुक्रम की वास्तविक लागत पर एक बाध्य प्रदान करता है।

परिशोधित विश्लेषण औसत-केस विश्लेषण से भिन्न होता है; संभावना परिशोधन विश्लेषण में शामिल नहीं है। परिशोधित विश्लेषण सबसे खराब स्थिति में प्रत्येक ऑपरेशन के औसत प्रदर्शन की गारंटी देता है।

यह केवल विश्लेषण के लिए एक उपकरण नहीं है, यह डिजाइन के बारे में सोचने का एक तरीका है, क्योंकि डिजाइनिंग और विश्लेषण बारीकी से संबंधित हैं।

एकत्र करने की विधि

कुल विधि एक समस्या के बारे में वैश्विक दृष्टिकोण देती है। इस विधि में, यदिn संचालन में सबसे खराब समय लगता है T(n)कुल मिलाकर। फिर प्रत्येक ऑपरेशन की परिशोधन लागत हैT(n)/n। हालांकि अलग-अलग संचालन में अलग-अलग समय लग सकता है, इस पद्धति में अलग-अलग लागत की उपेक्षा की जाती है।

लेखा विधि

इस पद्धति में, अलग-अलग शुल्क उनकी वास्तविक लागत के अनुसार अलग-अलग परिचालनों को सौंपे जाते हैं। यदि किसी ऑपरेशन की बढ़ी हुई लागत इसकी वास्तविक लागत से अधिक है, तो अंतर को क्रेडिट के रूप में ऑब्जेक्ट को सौंपा गया है। यह क्रेडिट बाद के कार्यों के लिए भुगतान करने में मदद करता है जिसके लिए वास्तविक लागत से कम परिशोधन लागत होती है।

यदि वास्तविक लागत और परिशोधित लागत ith संचालन कर रहे हैं $c_{i}$ तथा $\hat{c_{l}}$, फिर

$$\displaystyle\sum\limits_{i=1}^n \hat{c_{l}}\geqslant\displaystyle\sum\limits_{i=1}^n c_{i}$$

संभावित विधि

यह विधि क्रेडिट के रूप में प्रीपेड काम पर विचार करने के बजाय संभावित ऊर्जा के रूप में प्रीपेड कार्य का प्रतिनिधित्व करती है। यह ऊर्जा भविष्य के संचालन के लिए भुगतान करने के लिए जारी की जा सकती है।

अगर हम प्रदर्शन करते हैं n एक प्रारंभिक डेटा संरचना के साथ संचालन शुरू होता है D0। हम मानते हैं,ci वास्तविक लागत के रूप में और Di के डेटा संरचना के रूप में ithऑपरेशन। एक वास्तविक संख्या के लिए संभावित फ़ंक्शन potential मैप्स Ф (Di), की सम्भावना है Di। परिशोधन लागत$\hat{c_{l}}$ द्वारा परिभाषित किया जा सकता है

$$\hat{c_{l}}=c_{i}+\Phi (D_{i})-\Phi (D_{i-1})$$

इसलिए, कुल परिशोधित लागत है

$$\displaystyle\sum\limits_{i=1}^n \hat{c_{l}}=\displaystyle\sum\limits_{i=1}^n (c_{i}+\Phi (D_{i})-\Phi (D_{i-1}))=\displaystyle\sum\limits_{i=1}^n c_{i}+\Phi (D_{n})-\Phi (D_{0})$$

गतिशील तालिका

यदि तालिका के लिए आवंटित स्थान पर्याप्त नहीं है, तो हमें तालिका को बड़े आकार की तालिका में कॉपी करना होगा। इसी तरह, यदि बड़ी संख्या में सदस्यों को तालिका से मिटा दिया जाता है, तो तालिका को छोटे आकार के साथ फिर से जोड़ना एक अच्छा विचार है।

परिशोधित विश्लेषण का उपयोग करके, हम दिखा सकते हैं कि सम्मिलन और विलोपन की परिशोधित लागत एक गतिशील तालिका में निरंतर और अप्रयुक्त स्थान है जो कुल अंतरिक्ष के निरंतर अंश से अधिक नहीं है।

इस ट्यूटोरियल के अगले अध्याय में, हम संक्षेप में एसिम्प्टोटिक नोटिफिकेशन पर चर्चा करेंगे।

एल्गोरिथ्म की डिजाइनिंग में, एल्गोरिथ्म की जटिलता विश्लेषण एक अनिवार्य पहलू है। मुख्य रूप से, एल्गोरिथम जटिलता अपने प्रदर्शन के बारे में चिंतित है कि यह कितनी तेजी से या धीमा काम करता है।

एक एल्गोरिथ्म की जटिलता डेटा और प्रसंस्करण समय को संसाधित करने के लिए आवश्यक मेमोरी की मात्रा के संदर्भ में एल्गोरिथ्म की दक्षता का वर्णन करती है।

एक एल्गोरिथ्म की जटिलता का दो दृष्टिकोणों में विश्लेषण किया गया है: Time तथा Space।

समय जटिलता

यह एक फ़ंक्शन है जो इनपुट के आकार के संदर्भ में एक एल्गोरिथ्म को चलाने के लिए आवश्यक समय की मात्रा का वर्णन करता है। "टाइम" का अर्थ है प्रदर्शन किए गए मेमोरी एक्सेस की संख्या, पूर्णांकों के बीच तुलना की संख्या, कुछ आंतरिक लूप को निष्पादित करने की संख्या या वास्तविक समय की एल्गोरिथम की मात्रा से संबंधित कुछ अन्य प्राकृतिक इकाई।

अंतरिक्ष जटिलता

यह एक फ़ंक्शन है जो एल्गोरिथ्म में इनपुट के आकार के संदर्भ में एक एल्गोरिथ्म मेमोरी की मात्रा का वर्णन करता है। हम अक्सर "अतिरिक्त" मेमोरी की आवश्यकता की बात करते हैं, इनपुट को स्टोर करने के लिए आवश्यक मेमोरी की गिनती नहीं करते हैं। फिर, हम इसे मापने के लिए प्राकृतिक (लेकिन निश्चित-लंबाई) इकाइयों का उपयोग करते हैं।

अंतरिक्ष जटिलता को कभी-कभी अनदेखा कर दिया जाता है क्योंकि उपयोग की जाने वाली जगह न्यूनतम और / या स्पष्ट होती है, हालांकि कभी-कभी यह समय के रूप में महत्वपूर्ण मुद्दा बन जाता है।

असममित संकेतन

एल्गोरिथ्म का निष्पादन समय अनुदेश सेट, प्रोसेसर गति, डिस्क I / O गति, आदि पर निर्भर करता है। इसलिए, हम एक एल्गोरिथ्म की दक्षता का आंकलन करते हैं।

एक एल्गोरिथ्म के समय समारोह द्वारा दर्शाया गया है T(n), कहाँ पे n इनपुट आकार है।

एक एल्गोरिथ्म की जटिलता का प्रतिनिधित्व करने के लिए विभिन्न प्रकार के स्पर्शोन्मुख संकेतन का उपयोग किया जाता है। एक एल्गोरिथ्म की रनिंग टाइम जटिलता की गणना करने के लिए एसिम्प्टोटिक नोटेशन का उपयोग किया जाता है।

O - बिग ओह

Ω - बड़ा ओमेगा

θ - बिग थीटा

o - छोटे ओह

ω - थोड़ा ओमेगा

ओ: असममित ऊपरी बाउंड

'ओ' (बिग ओह) सबसे अधिक इस्तेमाल किया जाने वाला अंकन है। एक समारोहf(n) का प्रतिनिधित्व किया जा सकता है g(n) अर्थात् O(g(n)), यदि सकारात्मक पूर्णांक का मान मौजूद है n जैसा n0 और एक सकारात्मक स्थिरांक c ऐसा है कि -

$f(n)\leqslant c.g(n)$ के लिये $n > n_{0}$ सभी मामले में

इसलिए, कार्य करें g(n) फ़ंक्शन के लिए एक ऊपरी बाध्य है f(n), जैसा g(n) से अधिक तेजी से बढ़ता है f(n)।

उदाहरण

आइए एक दिए गए कार्य पर विचार करें, $f(n) = 4.n^3 + 10.n^2 + 5.n + 1$

मानते हुए $g(n) = n^3$,

$f(n)\leqslant 5.g(n)$ के सभी मूल्यों के लिए $n > 2$

इसलिए, की जटिलता f(n) के रूप में प्रतिनिधित्व किया जा सकता है $O(g(n))$, अर्थात $O(n^3)$

Pt: असममित निचला बाउंड

हम कहते हैं कि $f(n) = \Omega (g(n))$ जब वहाँ मौजूद है c उस $f(n)\geqslant c.g(n)$ सभी पर्याप्त रूप से बड़े मूल्य के लिए n। यहाँnएक सकारात्मक पूर्णांक है। इसका मतलब है फंक्शनg फ़ंक्शन के लिए एक कम बाध्य है f; के एक निश्चित मूल्य के बादn, f नीचे कभी नहीं जाएगा g।

उदाहरण

आइए एक दिए गए कार्य पर विचार करें, $f(n) = 4.n^3 + 10.n^2 + 5.n + 1$।

मानते हुए $g(n) = n^3$, $f(n)\geqslant 4.g(n)$ के सभी मूल्यों के लिए $n > 0$।

इसलिए, की जटिलता f(n) के रूप में प्रतिनिधित्व किया जा सकता है $\Omega (g(n))$, अर्थात $\Omega (n^3)$

pt: एसिम्प्टोटिक टाइट बाउंड

हम कहते हैं कि $f(n) = \theta(g(n))$ जब वहाँ मौजूद हैं c1 तथा c2 उस $c_{1}.g(n) \leqslant f(n) \leqslant c_{2}.g(n)$ सभी पर्याप्त रूप से बड़े मूल्य के लिए n। यहाँn एक सकारात्मक पूर्णांक है।

इसका मतलब है फंक्शन g कार्य के लिए एक तंग बाध्य है f।

उदाहरण

आइए एक दिए गए कार्य पर विचार करें, $f(n) = 4.n^3 + 10.n^2 + 5.n + 1$

मानते हुए $g(n) = n^3$, $4.g(n) \leqslant f(n) \leqslant 5.g(n)$ के सभी बड़े मूल्यों के लिए n।

इसलिए, की जटिलता f(n) के रूप में प्रतिनिधित्व किया जा सकता है $\theta (g(n))$, अर्थात $\theta (n^3)$।

ओ - संकेतन

द्वारा प्रदान की गई स्पर्शोन्मुख ऊपरी सीमा O-notationहो सकता है या स्पर्शोन्मुख रूप से तंग न हो। बद्ध$2.n^2 = O(n^2)$ asymptotically तंग है, लेकिन बाध्य है $2.n = O(n^2)$ नहीं है।

हम प्रयोग करते हैं o-notation एक ऊपरी सीमा को निरूपित करने के लिए जो कि विषम रूप से तंग नहीं है।

हम औपचारिक रूप से परिभाषित करते हैं o(g(n)) (सेट के रूप में जी के छोटे-ओह) f(n) = o(g(n)) किसी भी सकारात्मक निरंतर के लिए $c > 0$ और वहाँ एक मूल्य मौजूद है $n_{0} > 0$, ऐसा है कि $0 \leqslant f(n) \leqslant c.g(n)$।

सहज रूप से, में o-notation, कार्यक्रम f(n) के सापेक्ष नगण्य हो जाता है g(n) जैसा nअनंतता; अर्थात्,

$$\lim_{n \rightarrow \infty}\left(\frac{f(n)}{g(n)}\right) = 0$$

उदाहरण

आइए हम एक ही कार्य पर विचार करें, $f(n) = 4.n^3 + 10.n^2 + 5.n + 1$

मानते हुए $g(n) = n^{4}$,

$$\lim_{n \rightarrow \infty}\left(\frac{4.n^3 + 10.n^2 + 5.n + 1}{n^4}\right) = 0$$

इसलिए, की जटिलता f(n) के रूप में प्रतिनिधित्व किया जा सकता है $o(g(n))$, अर्थात $o(n^4)$।

ation - संकेतन

हम प्रयोग करते हैं ω-notationएक निचली सीमा को निरूपित करने के लिए जो कि विषम रूप से तंग नहीं है। औपचारिक रूप से, हालांकि, हम परिभाषित करते हैंω(g(n)) (थोड़ा-ओ-जी के जी के) सेट के रूप में f(n) = ω(g(n)) किसी भी सकारात्मक निरंतर के लिए C > 0 और वहाँ एक मूल्य मौजूद है $n_{0} > 0$, कि $ 0 \ leqslant cg (n) <f (n) $।

उदाहरण के लिए, $\frac{n^2}{2} = \omega (n)$, परंतु $\frac{n^2}{2} \neq \omega (n^2)$। रिश्ता$f(n) = \omega (g(n))$ तात्पर्य है कि निम्नलिखित सीमा मौजूद है

$$\lim_{n \rightarrow \infty}\left(\frac{f(n)}{g(n)}\right) = \infty$$

अर्थात्, f(n) के सापेक्ष बड़े पैमाने पर हो जाता है g(n) जैसा n अनंत तक पहुंचता है।

उदाहरण

हमें एक ही कार्य पर विचार करें, $f(n) = 4.n^3 + 10.n^2 + 5.n + 1$

मानते हुए $g(n) = n^2$,

$$\lim_{n \rightarrow \infty}\left(\frac{4.n^3 + 10.n^2 + 5.n + 1}{n^2}\right) = \infty$$

इसलिए, की जटिलता f(n) के रूप में प्रतिनिधित्व किया जा सकता है $o(g(n))$, अर्थात $\omega (n^2)$।

अप्रीरी और अपोस्टारी विश्लेषण

Apriori विश्लेषण का अर्थ है, एक विशिष्ट प्रणाली पर इसे चलाने से पहले विश्लेषण किया जाता है। यह विश्लेषण एक ऐसा चरण है जहां कुछ सैद्धांतिक मॉडल का उपयोग करके फ़ंक्शन को परिभाषित किया जाता है। इसलिए, हम एल्गोरिथ्म को देखने के बजाय एक अलग मेमोरी, प्रोसेसर और कंपाइलर के साथ किसी विशेष सिस्टम पर चलाने के बजाय एल्गोरिथ्म के समय और स्थान की जटिलता को निर्धारित करते हैं।

एक एल्गोरिथ्म के अपोस्टियारी विश्लेषण का मतलब है कि हम एक सिस्टम पर चलने के बाद ही एक एल्गोरिथ्म का विश्लेषण करते हैं। यह सीधे सिस्टम पर निर्भर करता है और सिस्टम से सिस्टम में बदलाव करता है।

एक उद्योग में, हम Apostiari विश्लेषण नहीं कर सकते क्योंकि सॉफ्टवेयर आम तौर पर एक अनाम उपयोगकर्ता के लिए बनाया जाता है, जो इसे उद्योग में मौजूद लोगों से अलग एक प्रणाली पर चलाता है।

Apriori में, यही कारण है कि हम समय और स्थान की जटिलता को निर्धारित करने के लिए असममित नोटेशन का उपयोग करते हैं क्योंकि वे कंप्यूटर से कंप्यूटर में बदलते हैं; हालाँकि, asymptotically वे समान हैं।

इस अध्याय में, हम एक एल्गोरिथ्म की आवश्यकता वाले स्थान की मात्रा के संबंध में कम्प्यूटेशनल समस्याओं की जटिलता पर चर्चा करेंगे।

अंतरिक्ष जटिलता समय जटिलता की कई विशेषताओं को साझा करती है और उनकी कम्प्यूटेशनल कठिनाइयों के अनुसार समस्याओं को वर्गीकृत करने का एक और तरीका है।

अंतरिक्ष जटिलता क्या है?

अंतरिक्ष की जटिलता स्मृति (स्पेस) की मात्रा का वर्णन करने वाला एक फ़ंक्शन है जो एल्गोरिथ्म में इनपुट की मात्रा के संदर्भ में एक एल्गोरिथ्म लेता है।

हम अक्सर बोलते हैं extra memoryजरूरत है, इनपुट को स्टोर करने के लिए आवश्यक मेमोरी को गिनना नहीं। फिर, हम इसे मापने के लिए प्राकृतिक (लेकिन निश्चित-लंबाई) इकाइयों का उपयोग करते हैं।

हम बाइट्स का उपयोग कर सकते हैं, लेकिन इसका उपयोग करना आसान है, कहते हैं, उपयोग किए गए पूर्णांकों की संख्या, निश्चित-आकार की संरचनाओं की संख्या, आदि।

अंत में, हम जिस फ़ंक्शन के साथ आते हैं वह यूनिट का प्रतिनिधित्व करने के लिए आवश्यक बाइट्स की वास्तविक संख्या से स्वतंत्र होगा।

अंतरिक्ष जटिलता को कभी-कभी अनदेखा कर दिया जाता है क्योंकि उपयोग की जाने वाली जगह न्यूनतम और / या स्पष्ट होती है, हालांकि कभी-कभी यह समय की जटिलता के रूप में महत्वपूर्ण मुद्दा बन जाता है

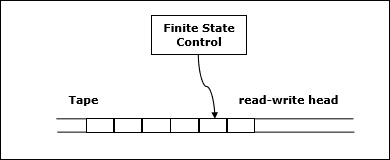

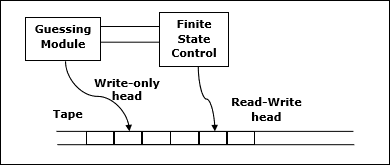

परिभाषा

लश्कर M निर्धारक हो Turing machine (TM)कि सभी आदानों पर टिका है। की अंतरिक्ष जटिलताM कार्य है $f \colon N \rightarrow N$, कहाँ पे f(n) टेप की कोशिकाओं की अधिकतम संख्या है और M लंबाई के किसी भी इनपुट को स्कैन करता है M। यदि अंतरिक्ष की जटिलताM है f(n), हम कह सकते हैं कि M अंतरिक्ष में चलता है f(n)।

हम स्पर्शोन्मुख संकेतन का उपयोग करके ट्यूरिंग मशीन की अंतरिक्ष जटिलता का अनुमान लगाते हैं।

लश्कर $f \colon N \rightarrow R^+$एक समारोह हो। अंतरिक्ष जटिलता वर्गों को निम्नानुसार परिभाषित किया जा सकता है -

SPACE = {L | L is a language decided by an O(f(n)) space deterministic TM}

SPACE = {L | L is a language decided by an O(f(n)) space non-deterministic TM}

PSPACE एक नियतात्मक ट्यूरिंग मशीन पर बहुपद स्थान में निर्णायक भाषाओं का वर्ग है।

दूसरे शब्दों में, PSPACE = Uk SPACE (nk)

सैविच की प्रमेय

अंतरिक्ष जटिलता से संबंधित सबसे शुरुआती प्रमेय में सेविच की प्रमेय है। इस प्रमेय के अनुसार, एक नियतात्मक मशीन अंतरिक्ष की एक छोटी मात्रा का उपयोग करके गैर-नियतात्मक मशीनों का अनुकरण कर सकती है।

समय की जटिलता के लिए, इस तरह के अनुकरण के लिए समय में एक घातीय वृद्धि की आवश्यकता होती है। अंतरिक्ष जटिलता के लिए, यह प्रमेय दिखाता है कि कोई भी गैर-नियतात्मक ट्यूरिंग मशीन जो उपयोग करती हैf(n) अंतरिक्ष को नियतात्मक TM में परिवर्तित किया जा सकता है जो उपयोग करता है f2(n) अंतरिक्ष।

इसलिए, सैविच की प्रमेय में कहा गया है कि, किसी भी कार्य के लिए, $f \colon N \rightarrow R^+$, कहाँ पे $f(n) \geqslant n$

NSPACE(f(n)) ⊆ SPACE(f(n))

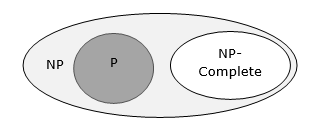

जटिलता वर्गों के बीच संबंध

निम्नलिखित चित्र विभिन्न जटिलता वर्गों के बीच संबंधों को दर्शाते हैं।

अब तक, हमने इस ट्यूटोरियल में पी और एनपी कक्षाओं की चर्चा नहीं की है। इन पर बाद में चर्चा की जाएगी।

कई एल्गोरिदम प्रकृति में पुनरावर्ती हैं जो किसी दिए गए समस्या को हल करने के लिए पुनरावर्ती उप-समस्याओं से निपटते हैं।

में divide and conquer approach, एक समस्या को छोटी समस्याओं में विभाजित किया जाता है, फिर छोटी समस्याओं को स्वतंत्र रूप से हल किया जाता है, और अंत में छोटी समस्याओं के समाधान को बड़ी समस्या के समाधान में जोड़ा जाता है।

आम तौर पर, डिवाइड-एंड-कॉनकोर एल्गोरिदम के तीन भाग होते हैं -

Divide the problem उप-समस्याओं की संख्या में जो एक ही समस्या के छोटे उदाहरण हैं।

Conquer the sub-problemsउन्हें पुन: हल करके। यदि वे पर्याप्त छोटे हैं, तो आधार मामलों के रूप में उप-समस्याओं को हल करें।

Combine the solutions मूल समस्या के समाधान में उप-समस्याओं के लिए।

फूट डालो और जीतो दृष्टिकोण के पेशेवरों और विपक्ष

विभाजित और जीतना दृष्टिकोण समानता का समर्थन करता है क्योंकि उप-समस्याएं स्वतंत्र हैं। इसलिए, एक एल्गोरिथ्म, जो इस तकनीक का उपयोग करके बनाया गया है, मल्टीप्रोसेसर सिस्टम या अलग-अलग मशीनों में एक साथ चल सकता है।

इस दृष्टिकोण में, अधिकांश एल्गोरिदम को पुनरावृत्ति का उपयोग करके डिज़ाइन किया गया है, इसलिए स्मृति प्रबंधन बहुत अधिक है। पुनरावर्ती फ़ंक्शन स्टैक के लिए उपयोग किया जाता है, जहां फ़ंक्शन स्थिति को संग्रहीत करने की आवश्यकता होती है।

फूट डालो और जीतो का आवेदन

निम्नलिखित कुछ समस्याएं हैं, जो विभाजन और विजय दृष्टिकोण का उपयोग करके हल की जाती हैं।

- संख्याओं के अनुक्रम का अधिकतम और न्यूनतम ज्ञात करना

- स्ट्रैसेन का मैट्रिक्स गुणन

- मर्ज़ सॉर्ट

- द्विआधारी खोज

आइए हम एक सरल समस्या पर विचार करें जिसे विभाजित करके और तकनीक को जीतकर हल किया जा सकता है।

समस्या का विवरण

एल्गोरिथ्म विश्लेषण में मैक्स-मिन समस्या एक सरणी में अधिकतम और न्यूनतम मूल्य पा रही है।

उपाय

किसी दिए गए सरणी में अधिकतम और न्यूनतम संख्या खोजने के लिए numbers[] आकार का nनिम्नलिखित एल्गोरिथ्म का उपयोग किया जा सकता है। पहले हम इसका प्रतिनिधित्व कर रहे हैंnaive method और फिर हम प्रस्तुत करेंगे divide and conquer approach।

Nave विधि

Nave विधि किसी भी समस्या को हल करने के लिए एक मूल विधि है। इस विधि में, अधिकतम और न्यूनतम संख्या अलग-अलग पाई जा सकती है। अधिकतम और न्यूनतम संख्या खोजने के लिए, निम्नलिखित सरल एल्गोरिथ्म का उपयोग किया जा सकता है।

Algorithm: Max-Min-Element (numbers[])

max := numbers[1]

min := numbers[1]

for i = 2 to n do

if numbers[i] > max then

max := numbers[i]

if numbers[i] < min then

min := numbers[i]

return (max, min)विश्लेषण

Naive विधि में तुलना की संख्या है 2n - 2।

विभाजन की संख्या को विभाजित और जीत के दृष्टिकोण का उपयोग करके कम किया जा सकता है। निम्नलिखित तकनीक है।

विभाजित और दृष्टिकोण को जीतें

इस दृष्टिकोण में, सरणी को दो हिस्सों में विभाजित किया गया है। फिर पुनरावर्ती दृष्टिकोण का उपयोग करते हुए प्रत्येक पड़ाव में अधिकतम और न्यूनतम संख्याएं पाई जाती हैं। बाद में, प्रत्येक आधे की अधिकतम दो मैक्सिमा और प्रत्येक आधे की न्यूनतम दो मिनीमा लौटाएं।

इस दी गई समस्या में, सरणी में तत्वों की संख्या है $y - x + 1$, कहाँ पे y से अधिक या बराबर है x।

$\mathbf{\mathit{Max - Min(x, y)}}$ किसी सरणी के अधिकतम और न्यूनतम मान लौटाएगा $\mathbf{\mathit{numbers[x...y]}}$।

Algorithm: Max - Min(x, y)

if y – x ≤ 1 then

return (max(numbers[x], numbers[y]), min((numbers[x], numbers[y]))

else

(max1, min1):= maxmin(x, ⌊((x + y)/2)⌋)

(max2, min2):= maxmin(⌊((x + y)/2) + 1)⌋,y)

return (max(max1, max2), min(min1, min2))विश्लेषण

लश्कर T(n) द्वारा की गई तुलनाओं की संख्या हो $\mathbf{\mathit{Max - Min(x, y)}}$, जहां तत्वों की संख्या $n = y - x + 1$।

अगर T(n) संख्याओं का प्रतिनिधित्व करता है, फिर पुनरावृत्ति संबंध के रूप में प्रतिनिधित्व किया जा सकता है

$$T(n) = \begin{cases}T\left(\lfloor\frac{n}{2}\rfloor\right)+T\left(\lceil\frac{n}{2}\rceil\right)+2 & for\: n>2\\1 & for\:n = 2 \\0 & for\:n = 1\end{cases}$$

चलिए हम मान लेते हैं n की शक्ति के रूप में है 2। इसलिये,n = 2k कहाँ पे k पुनरावृत्ति पेड़ की ऊंचाई है।

इसलिए,

$$T(n) = 2.T (\frac{n}{2}) + 2 = 2.\left(\begin{array}{c}2.T(\frac{n}{4}) + 2\end{array}\right) + 2 ..... = \frac{3n}{2} - 2$$

Naquerve विधि की तुलना में, विभाजित और जीत के दृष्टिकोण में, तुलना की संख्या कम है। हालाँकि, दोनों दृष्टिकोणों को स्पर्शोन्मुख संकेतन का उपयोग करके दर्शाया गया हैO(n)।

इस अध्याय में, हम मर्ज सॉर्ट पर चर्चा करेंगे और इसकी जटिलता का विश्लेषण करेंगे।

समस्या का विवरण

संख्याओं की सूची को छांटने की समस्या खुद को तुरंत विभाजित और जीतने वाली रणनीति के लिए उधार देती है: सूची को दो हिस्सों में विभाजित करें, प्रत्येक आधे को पुन: क्रमबद्ध करें, और फिर दो क्रमबद्ध उप-सूचियों को मर्ज करें।

उपाय

इस एल्गोरिथ्म में, संख्याएँ एक सरणी में संग्रहीत होती हैं numbers[]। यहाँ,p तथा q एक उप-सरणी की शुरुआत और अंत सूचकांक का प्रतिनिधित्व करता है।

Algorithm: Merge-Sort (numbers[], p, r)

if p < r then

q = ⌊(p + r) / 2⌋

Merge-Sort (numbers[], p, q)

Merge-Sort (numbers[], q + 1, r)

Merge (numbers[], p, q, r)Function: Merge (numbers[], p, q, r)

n1 = q – p + 1

n2 = r – q

declare leftnums[1…n1 + 1] and rightnums[1…n2 + 1] temporary arrays

for i = 1 to n1

leftnums[i] = numbers[p + i - 1]

for j = 1 to n2

rightnums[j] = numbers[q+ j]

leftnums[n1 + 1] = ∞

rightnums[n2 + 1] = ∞

i = 1

j = 1

for k = p to r

if leftnums[i] ≤ rightnums[j]

numbers[k] = leftnums[i]

i = i + 1

else

numbers[k] = rightnums[j]

j = j + 1विश्लेषण

आइए विचार करें, मर्ज-सॉर्ट का समय चल रहा है T(n)। इसलिये,

$T(n)=\begin{cases}c & if\:n\leqslant 1\\2\:x\:T(\frac{n}{2})+d\:x\:n & otherwise\end{cases}$जहाँ c और d स्थिर हैं

इसलिए, इस पुनरावृत्ति संबंध का उपयोग करते हुए,

$$T(n) = 2^i T(\frac{n}{2^i}) + i.d.n$$

जैसा, $i = log\:n,\: T(n) = 2^{log\:n} T(\frac{n}{2^{log\:n}}) + log\:n.d.n$

$=\:c.n + d.n.log\:n$

इसलिए, $T(n) = O(n\:log\:n)$

उदाहरण

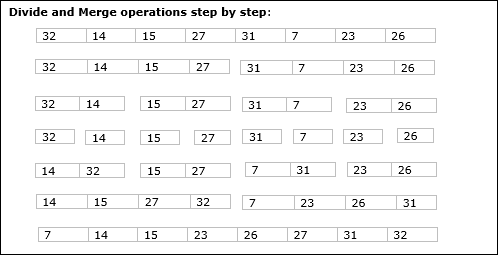

निम्नलिखित उदाहरण में, हमने मर्ज-सॉर्ट एल्गोरिथ्म को चरण दर चरण दिखाया है। सबसे पहले, प्रत्येक पुनरावृति सरणी को दो उप-सरणियों में विभाजित किया जाता है, जब तक कि उप-सरणी में केवल एक तत्व नहीं होता है। जब इन उप-सरणियों को आगे विभाजित नहीं किया जा सकता है, तो मर्ज संचालन किया जाता है।

इस अध्याय में, हम फूट डालो और जीतो विधि पर आधारित एक और एल्गोरिथ्म पर चर्चा करेंगे।

समस्या का विवरण

बाइनरी खोज को एक क्रमबद्ध सरणी पर किया जा सकता है। इस दृष्टिकोण में, एक तत्व का सूचकांकxयह निर्धारित किया जाता है कि तत्व तत्वों की सूची से संबंधित है या नहीं। यदि सरणी अनसोल्ड है, तो स्थिति को निर्धारित करने के लिए रैखिक खोज का उपयोग किया जाता है।

उपाय

इस एल्गोरिथ्म में, हम यह जानना चाहते हैं कि क्या तत्व है x किसी सरणी में संग्रहीत संख्याओं के समूह के अंतर्गत आता है numbers[]। कहाँ पेl तथा r एक उप-सरणी के बाएं और दाएं सूचकांक का प्रतिनिधित्व करते हैं जिसमें खोज ऑपरेशन किया जाना चाहिए।

Algorithm: Binary-Search(numbers[], x, l, r)

if l = r then

return l

else

m := ⌊(l + r) / 2⌋

if x ≤ numbers[m] then

return Binary-Search(numbers[], x, l, m)

else

return Binary-Search(numbers[], x, m+1, r)विश्लेषण

रेखीय खोज में चलता है O(n)समय। जबकि द्विआधारी खोज में परिणाम उत्पन्न करता हैO(log n) समय

लश्कर T(n) एक सरणी में सबसे खराब स्थिति में तुलना की संख्या हो n तत्वों।

इसलिये,

$$T(n)=\begin{cases}0 & if\:n= 1\\T(\frac{n}{2})+1 & otherwise\end{cases}$$

इस पुनरावृत्ति संबंध का उपयोग करना $T(n) = log\:n$।

इसलिए, द्विआधारी खोज का उपयोग करता है $O(log\:n)$ समय।

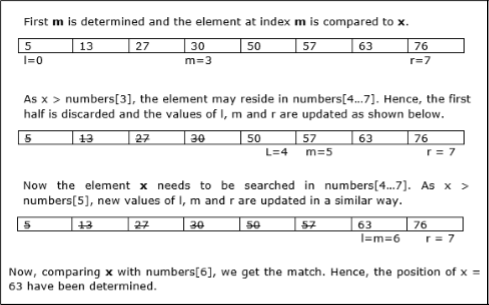

उदाहरण

इस उदाहरण में, हम तत्व 63 को खोजने जा रहे हैं।

इस अध्याय में, पहले हम मैट्रिक्स गुणन की सामान्य विधि के बारे में चर्चा करेंगे और बाद में हम स्ट्रैसेन के मैट्रिक्स गुणन एल्गोरिथम पर चर्चा करेंगे।

समस्या का विवरण

आइए हम दो मैट्रिक्स पर विचार करें X तथा Y। हम परिणामी मैट्रिक्स की गणना करना चाहते हैंZ by multiplying X and Y.

Naïve Method

First, we will discuss naïve method and its complexity. Here, we are calculating Z = X × Y. Using Naïve method, two matrices (X and Y) can be multiplied if the order of these matrices are p × q and q × r. Following is the algorithm.

Algorithm: Matrix-Multiplication (X, Y, Z)

for i = 1 to p do

for j = 1 to r do

Z[i,j] := 0

for k = 1 to q do

Z[i,j] := Z[i,j] + X[i,k] × Y[k,j]Complexity

Here, we assume that integer operations take O(1) time. There are three for loops in this algorithm and one is nested in other. Hence, the algorithm takes O(n3) time to execute.

Strassen’s Matrix Multiplication Algorithm

In this context, using Strassen’s Matrix multiplication algorithm, the time consumption can be improved a little bit.

Strassen’s Matrix multiplication can be performed only on square matrices where n is a power of 2. Order of both of the matrices are n × n.

Divide X, Y and Z into four (n/2)×(n/2) matrices as represented below −

$Z = \begin{bmatrix}I & J \\K & L \end{bmatrix}$ $X = \begin{bmatrix}A & B \\C & D \end{bmatrix}$ and $Y = \begin{bmatrix}E & F \\G & H \end{bmatrix}$

Using Strassen’s Algorithm compute the following −

$$M_{1} \: \colon= (A+C) \times (E+F)$$

$$M_{2} \: \colon= (B+D) \times (G+H)$$

$$M_{3} \: \colon= (A-D) \times (E+H)$$

$$M_{4} \: \colon= A \times (F-H)$$

$$M_{5} \: \colon= (C+D) \times (E)$$

$$M_{6} \: \colon= (A+B) \times (H)$$

$$M_{7} \: \colon= D \times (G-E)$$

Then,

$$I \: \colon= M_{2} + M_{3} - M_{6} - M_{7}$$

$$J \: \colon= M_{4} + M_{6}$$

$$K \: \colon= M_{5} + M_{7}$$

$$L \: \colon= M_{1} - M_{3} - M_{4} - M_{5}$$

Analysis

$T(n)=\begin{cases}c & if\:n= 1\\7\:x\:T(\frac{n}{2})+d\:x\:n^2 & otherwise\end{cases}$ where c and d are constants

Using this recurrence relation, we get $T(n) = O(n^{log7})$

Hence, the complexity of Strassen’s matrix multiplication algorithm is $O(n^{log7})$.

Among all the algorithmic approaches, the simplest and straightforward approach is the Greedy method. In this approach, the decision is taken on the basis of current available information without worrying about the effect of the current decision in future.

Greedy algorithms build a solution part by part, choosing the next part in such a way, that it gives an immediate benefit. This approach never reconsiders the choices taken previously. This approach is mainly used to solve optimization problems. Greedy method is easy to implement and quite efficient in most of the cases. Hence, we can say that Greedy algorithm is an algorithmic paradigm based on heuristic that follows local optimal choice at each step with the hope of finding global optimal solution.

In many problems, it does not produce an optimal solution though it gives an approximate (near optimal) solution in a reasonable time.

Components of Greedy Algorithm

Greedy algorithms have the following five components −

A candidate set − A solution is created from this set.

A selection function − Used to choose the best candidate to be added to the solution.

A feasibility function − Used to determine whether a candidate can be used to contribute to the solution.

An objective function − Used to assign a value to a solution or a partial solution.

A solution function − Used to indicate whether a complete solution has been reached.

Areas of Application

Greedy approach is used to solve many problems, such as

Finding the shortest path between two vertices using Dijkstra’s algorithm.

Finding the minimal spanning tree in a graph using Prim’s /Kruskal’s algorithm, etc.

Where Greedy Approach Fails

In many problems, Greedy algorithm fails to find an optimal solution, moreover it may produce a worst solution. Problems like Travelling Salesman and Knapsack cannot be solved using this approach.

The Greedy algorithm could be understood very well with a well-known problem referred to as Knapsack problem. Although the same problem could be solved by employing other algorithmic approaches, Greedy approach solves Fractional Knapsack problem reasonably in a good time. Let us discuss the Knapsack problem in detail.

Knapsack Problem

Given a set of items, each with a weight and a value, determine a subset of items to include in a collection so that the total weight is less than or equal to a given limit and the total value is as large as possible.

The knapsack problem is in combinatorial optimization problem. It appears as a subproblem in many, more complex mathematical models of real-world problems. One general approach to difficult problems is to identify the most restrictive constraint, ignore the others, solve a knapsack problem, and somehow adjust the solution to satisfy the ignored constraints.

Applications

In many cases of resource allocation along with some constraint, the problem can be derived in a similar way of Knapsack problem. Following is a set of example.

- Finding the least wasteful way to cut raw materials

- portfolio optimization

- Cutting stock problems

Problem Scenario

A thief is robbing a store and can carry a maximal weight of W into his knapsack. There are n items available in the store and weight of ith item is wi and its profit is pi. What items should the thief take?

In this context, the items should be selected in such a way that the thief will carry those items for which he will gain maximum profit. Hence, the objective of the thief is to maximize the profit.

Based on the nature of the items, Knapsack problems are categorized as

- Fractional Knapsack

- Knapsack

Fractional Knapsack

In this case, items can be broken into smaller pieces, hence the thief can select fractions of items.

According to the problem statement,

There are n items in the store

Weight of ith item $w_{i} > 0$

Profit for ith item $p_{i} > 0$ and

Capacity of the Knapsack is W

In this version of Knapsack problem, items can be broken into smaller pieces. So, the thief may take only a fraction xi of ith item.

$$0 \leqslant x_{i} \leqslant 1$$

The ith item contributes the weight $x_{i}.w_{i}$ to the total weight in the knapsack and profit $x_{i}.p_{i}$ to the total profit.

Hence, the objective of this algorithm is to

$$maximize\:\displaystyle\sum\limits_{n=1}^n (x_{i}.p_{}i)$$

subject to constraint,

$$\displaystyle\sum\limits_{n=1}^n (x_{i}.w_{}i) \leqslant W$$

It is clear that an optimal solution must fill the knapsack exactly, otherwise we could add a fraction of one of the remaining items and increase the overall profit.

Thus, an optimal solution can be obtained by

$$\displaystyle\sum\limits_{n=1}^n (x_{i}.w_{}i) = W$$

In this context, first we need to sort those items according to the value of $\frac{p_{i}}{w_{i}}$, so that $\frac{p_{i}+1}{w_{i}+1}$ ≤ $\frac{p_{i}}{w_{i}}$ . Here, x is an array to store the fraction of items.

Algorithm: Greedy-Fractional-Knapsack (w[1..n], p[1..n], W)

for i = 1 to n

do x[i] = 0

weight = 0

for i = 1 to n

if weight + w[i] ≤ W then

x[i] = 1

weight = weight + w[i]

else

x[i] = (W - weight) / w[i]

weight = W

break

return xAnalysis

If the provided items are already sorted into a decreasing order of $\mathbf{\frac{p_{i}}{w_{i}}}$, then the whileloop takes a time in O(n); Therefore, the total time including the sort is in O(n logn).

Example

Let us consider that the capacity of the knapsack W = 60 and the list of provided items are shown in the following table −

| Item | A | B | C | D |

|---|---|---|---|---|

| Profit | 280 | 100 | 120 | 120 |

| Weight | 40 | 10 | 20 | 24 |

| Ratio $(\frac{p_{i}}{w_{i}})$ | 7 | 10 | 6 | 5 |

As the provided items are not sorted based on $\mathbf{\frac{p_{i}}{w_{i}}}$. After sorting, the items are as shown in the following table.

| Item | B | A | C | D |

|---|---|---|---|---|

| Profit | 100 | 280 | 120 | 120 |

| Weight | 10 | 40 | 20 | 24 |

| Ratio $(\frac{p_{i}}{w_{i}})$ | 10 | 7 | 6 | 5 |

Solution

After sorting all the items according to $\frac{p_{i}}{w_{i}}$. First all of B is chosen as weight of B is less than the capacity of the knapsack. Next, item A is chosen, as the available capacity of the knapsack is greater than the weight of A. Now, C is chosen as the next item. However, the whole item cannot be chosen as the remaining capacity of the knapsack is less than the weight of C.

Hence, fraction of C (i.e. (60 − 50)/20) is chosen.

Now, the capacity of the Knapsack is equal to the selected items. Hence, no more item can be selected.

The total weight of the selected items is 10 + 40 + 20 * (10/20) = 60

And the total profit is 100 + 280 + 120 * (10/20) = 380 + 60 = 440

This is the optimal solution. We cannot gain more profit selecting any different combination of items.

Problem Statement

In job sequencing problem, the objective is to find a sequence of jobs, which is completed within their deadlines and gives maximum profit.

Solution

Let us consider, a set of n given jobs which are associated with deadlines and profit is earned, if a job is completed by its deadline. These jobs need to be ordered in such a way that there is maximum profit.

It may happen that all of the given jobs may not be completed within their deadlines.

Assume, deadline of ith job Ji is di and the profit received from this job is pi. Hence, the optimal solution of this algorithm is a feasible solution with maximum profit.

Thus, $D(i) > 0$ for $1 \leqslant i \leqslant n$.

Initially, these jobs are ordered according to profit, i.e. $p_{1} \geqslant p_{2} \geqslant p_{3} \geqslant \:... \: \geqslant p_{n}$.

Algorithm: Job-Sequencing-With-Deadline (D, J, n, k)

D(0) := J(0) := 0

k := 1

J(1) := 1 // means first job is selected

for i = 2 … n do

r := k

while D(J(r)) > D(i) and D(J(r)) ≠ r do

r := r – 1

if D(J(r)) ≤ D(i) and D(i) > r then

for l = k … r + 1 by -1 do

J(l + 1) := J(l)

J(r + 1) := i

k := k + 1Analysis

In this algorithm, we are using two loops, one is within another. Hence, the complexity of this algorithm is $O(n^2)$.

Example

Let us consider a set of given jobs as shown in the following table. We have to find a sequence of jobs, which will be completed within their deadlines and will give maximum profit. Each job is associated with a deadline and profit.

| Job | J1 | J2 | J3 | J4 | J5 |

|---|---|---|---|---|---|

| Deadline | 2 | 1 | 3 | 2 | 1 |

| Profit | 60 | 100 | 20 | 40 | 20 |

Solution

To solve this problem, the given jobs are sorted according to their profit in a descending order. Hence, after sorting, the jobs are ordered as shown in the following table.

| Job | J2 | J1 | J4 | J3 | J5 |

|---|---|---|---|---|---|

| Deadline | 1 | 2 | 2 | 3 | 1 |

| Profit | 100 | 60 | 40 | 20 | 20 |

From this set of jobs, first we select J2, as it can be completed within its deadline and contributes maximum profit.

Next, J1 is selected as it gives more profit compared to J4.

In the next clock, J4 cannot be selected as its deadline is over, hence J3 is selected as it executes within its deadline.

The job J5 is discarded as it cannot be executed within its deadline.

Thus, the solution is the sequence of jobs (J2, J1, J3), which are being executed within their deadline and gives maximum profit.

Total profit of this sequence is 100 + 60 + 20 = 180.

Merge a set of sorted files of different length into a single sorted file. We need to find an optimal solution, where the resultant file will be generated in minimum time.

If the number of sorted files are given, there are many ways to merge them into a single sorted file. This merge can be performed pair wise. Hence, this type of merging is called as 2-way merge patterns.

As, different pairings require different amounts of time, in this strategy we want to determine an optimal way of merging many files together. At each step, two shortest sequences are merged.

To merge a p-record file and a q-record file requires possibly p + q record moves, the obvious choice being, merge the two smallest files together at each step.

Two-way merge patterns can be represented by binary merge trees. Let us consider a set of n sorted files {f1, f2, f3, …, fn}. Initially, each element of this is considered as a single node binary tree. To find this optimal solution, the following algorithm is used.

Algorithm: TREE (n)

for i := 1 to n – 1 do

declare new node

node.leftchild := least (list)

node.rightchild := least (list)

node.weight) := ((node.leftchild).weight) + ((node.rightchild).weight)

insert (list, node);

return least (list);At the end of this algorithm, the weight of the root node represents the optimal cost.

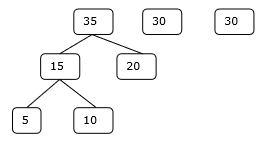

Example

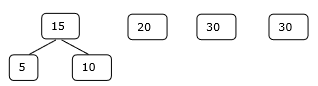

Let us consider the given files, f1, f2, f3, f4 and f5 with 20, 30, 10, 5 and 30 number of elements respectively.

If merge operations are performed according to the provided sequence, then

M1 = merge f1 and f2 => 20 + 30 = 50

M2 = merge M1 and f3 => 50 + 10 = 60

M3 = merge M2 and f4 => 60 + 5 = 65

M4 = merge M3 and f5 => 65 + 30 = 95

Hence, the total number of operations is

50 + 60 + 65 + 95 = 270

Now, the question arises is there any better solution?

बढ़ते क्रम में उनके आकार के अनुसार संख्याओं को क्रमबद्ध करने पर, हमें निम्नलिखित अनुक्रम मिलते हैं -

f4, f3, f1, f2, f5

इसलिए, इस अनुक्रम पर मर्ज संचालन किया जा सकता है

M1 = merge f4 and f3 => 5 + 10 = 15

M2 = merge M1 and f1 => 15 + 20 = 35

M3 = merge M2 and f2 => 35 + 30 = 65

M4 = merge M3 and f5 => 65 + 30 = 95

इसलिए, संचालन की कुल संख्या है

15 + 35 + 65 + 95 = 210

जाहिर है, यह पिछले वाले से बेहतर है।

इस संदर्भ में, हम अब इस एल्गोरिथ्म का उपयोग करके समस्या को हल करने जा रहे हैं।

प्रारंभिक सेट

चरण 1

चरण 2

चरण 3

चरण 4

इसलिए, समाधान 15 + 35 + 60 + 95 = 205 संख्याओं की तुलना करता है।

अनुकूलन समस्याओं में डायनामिक प्रोग्रामिंग का भी उपयोग किया जाता है। डिवाइड-एंड-कॉंकर विधि की तरह, डायनामिक प्रोग्रामिंग उपप्रोम्बलों के समाधानों को जोड़कर समस्याओं को हल करता है। इसके अलावा, डायनामिक प्रोग्रामिंग एल्गोरिथ्म प्रत्येक उप-समस्या को एक बार हल करता है और फिर एक तालिका में इसके उत्तर को बचाता है, जिससे हर बार उत्तर को पुन: कंप्यूटिंग के काम से बचा जाता है।

एक समस्या के दो मुख्य गुण बताते हैं कि डायनामिक प्रोग्रामिंग का उपयोग करके दी गई समस्या को हल किया जा सकता है। ये गुण हैंoverlapping sub-problems and optimal substructure।

ओवरलैपिंग उप-समस्याएं

डिवाइड-एंड-कॉनकेयर दृष्टिकोण के समान, डायनेमिक प्रोग्रामिंग भी उप-समस्याओं के समाधान को जोड़ती है। यह मुख्य रूप से उपयोग किया जाता है जहां एक उप-समस्या का समाधान बार-बार आवश्यक होता है। गणना किए गए समाधान एक तालिका में संग्रहीत किए जाते हैं, ताकि इन्हें फिर से गणना करने की आवश्यकता न हो। इसलिए, इस तकनीक की जरूरत है, जहां अतिव्यापी उप-समस्या मौजूद है।

उदाहरण के लिए, बाइनरी सर्च में ओवरलैपिंग उप-समस्या नहीं है। जबकि फाइबोनैचि संख्याओं के पुनरावर्ती कार्यक्रम में कई अतिव्यापी उप-समस्याएं हैं।

इष्टतम उप-संरचना

किसी दी गई समस्या में ऑप्टिमल सबस्ट्रक्चर प्रॉपर्टी है, यदि दी गई समस्या का इष्टतम समाधान उसकी उप-समस्याओं के इष्टतम समाधान का उपयोग करके प्राप्त किया जा सकता है।

उदाहरण के लिए, सबसे छोटी पथ समस्या में निम्नलिखित इष्टतम सबस्ट्रक्चर गुण हैं -

यदि एक नोड x स्रोत नोड से सबसे कम पथ पर स्थित है u गंतव्य के लिए नोड v, फिर सबसे छोटा रास्ता u सेवा v से सबसे छोटे मार्ग का संयोजन है u सेवा x, और सबसे छोटा रास्ता x सेवा v।

फ्लोयड-वारशॉल और बेलमैन-फोर्ड जैसे मानक ऑल पेयर शॉर्टेस्ट पाथ एल्गोरिदम डायनेमिक प्रोग्रामिंग के विशिष्ट उदाहरण हैं।

डायनामिक प्रोग्रामिंग दृष्टिकोण के चरण

डायनामिक प्रोग्रामिंग एल्गोरिथ्म को निम्नलिखित चार चरणों का उपयोग करके बनाया गया है -

- एक इष्टतम समाधान की संरचना की विशेषता।

- एक इष्टतम समाधान के मूल्य को पुन: परिभाषित करें।

- एक इष्टतम समाधान के मूल्य की गणना करें, आमतौर पर नीचे-ऊपर फैशन में।

- गणना की गई जानकारी से एक इष्टतम समाधान का निर्माण।

गतिशील प्रोग्रामिंग दृष्टिकोण के अनुप्रयोग

- मैट्रिक्स चेन गुणा

- सबसे लंबा सामान्य परिणाम

- ट्रैवलिंग सेल्समैन की समस्या

इस ट्यूटोरियल में, पहले हमने लालची दृष्टिकोण का उपयोग करके फ्रैक्शनल नॅप्सैक समस्या पर चर्चा की है। हमने दिखाया है कि लालची दृष्टिकोण फ्रैक्शनल नॅपैक के लिए एक इष्टतम समाधान देता है। हालांकि, यह अध्याय 0-1 नैकपैक समस्या और इसके विश्लेषण को कवर करेगा।

0-1 नैकपैक में, आइटम को तोड़ा नहीं जा सकता है, जिसका अर्थ है कि चोर को आइटम को एक पूरे के रूप में लेना चाहिए या इसे छोड़ देना चाहिए। इसे 0-1 नैकपैक के रूप में कहने के पीछे कारण है।

इसलिए, 0-1 नैकपैक के मामले में, का मूल्य xi दोनोंमेसे एक हो सकता है 0 या 1, जहाँ अन्य बाधाएँ समान रहती हैं।

0-1 नैकपैक को लालची दृष्टिकोण से हल नहीं किया जा सकता है। लालची दृष्टिकोण एक इष्टतम समाधान सुनिश्चित नहीं करता है। कई उदाहरणों में, लालची दृष्टिकोण एक इष्टतम समाधान दे सकता है।

निम्नलिखित उदाहरण हमारे बयान को स्थापित करेंगे।

उदाहरण 1

आइए हम इस बात पर विचार करें कि नैकस्पैक की क्षमता W = 25 है और आइटम निम्न तालिका में दिखाए गए हैं।

| मद | ए | ख | सी | घ |

|---|---|---|---|---|

| फायदा | 24 | 18 | 18 | 10 |

| वजन | 24 | 10 | 10 | 7 |

प्रति यूनिट वजन पर लाभ पर विचार किए बिना (pi/wi), अगर हम इस समस्या को हल करने के लिए लालची दृष्टिकोण लागू करते हैं, तो पहले आइटम Aचुना जाएगा क्योंकि यह सभी तत्वों के बीच अधिकतम i मम लाभ में योगदान देगा ।

आइटम का चयन करने के बाद A, और आइटम का चयन नहीं किया जाएगा। इसलिए, इस मद के लिए निर्धारित कुल लाभ है24। जबकि, आइटम का चयन करके इष्टतम समाधान प्राप्त किया जा सकता है,B और सी, जहां कुल लाभ 18 + 18 = 36 है।

उदाहरण -2

समग्र लाभ के आधार पर वस्तुओं का चयन करने के बजाय, इस उदाहरण में आइटमों का चयन अनुपात p i / w i के आधार पर किया जाता है । आइए हम मानते हैं कि नैकस्पैक की क्षमता डब्ल्यू = 60 है और आइटम निम्न तालिका में दिखाए गए हैं।

| मद | ए | ख | सी |

|---|---|---|---|

| कीमत | 100 | 280 | 120 |

| वजन | 10 | 40 | 20 |

| अनुपात | 10 | 7 | 6 |

लालची दृष्टिकोण का उपयोग करना, पहले आइटम Aचूना गया। फिर, अगले आइटमBचुना जाता है। इसलिए, कुल लाभ है100 + 280 = 380। हालाँकि, आइटम का चयन करके इस उदाहरण का इष्टतम समाधान प्राप्त किया जा सकता है,B तथा C, जहां कुल लाभ होता है 280 + 120 = 400।

इसलिए, यह निष्कर्ष निकाला जा सकता है कि लालची दृष्टिकोण एक इष्टतम समाधान नहीं दे सकता है।

0-1 नैकपैक को हल करने के लिए, डायनामिक प्रोग्रामिंग दृष्टिकोण की आवश्यकता होती है।

समस्या का विवरण

एक चोर एक दुकान चोरी कर रहा है और एक अधिकतम ले जा सकता है मैं के मल वजनWउसकी गुत्थी में। वहांn के आइटम और वजन ith आइटम है wi और इस मद का चयन करने का लाभ है pi। चोर को क्या सामान लेना चाहिए?

डायनेमिक-प्रोग्रामिंग दृष्टिकोण

लश्कर i एक इष्टतम समाधान में सबसे अधिक संख्या वाली वस्तु हो S के लिये Wडॉलर। फिरS' = S - {i} के लिए एक इष्टतम समाधान है W - wi डॉलर और समाधान के लिए मूल्य S है Vi उप-समस्या का मूल्य।

हम इस तथ्य को निम्नलिखित सूत्र में व्यक्त कर सकते हैं: परिभाषित करें c[i, w] वस्तुओं के लिए समाधान होना 1,2, … , iऔर अधिकतम आई मम वजनw।

एल्गोरिथ्म निम्नलिखित जानकारी लेता है

अधिकतम मैं मम वजनW

मदों की संख्या n

दो क्रम v = <v1, v2, …, vn> तथा w = <w1, w2, …, wn>

Dynamic-0-1-knapsack (v, w, n, W)

for w = 0 to W do

c[0, w] = 0

for i = 1 to n do

c[i, 0] = 0

for w = 1 to W do

if wi ≤ w then

if vi + c[i-1, w-wi] then

c[i, w] = vi + c[i-1, w-wi]

else c[i, w] = c[i-1, w]

else

c[i, w] = c[i-1, w]शुरू करने के लिए आइटम के सेट को टेबल से घटाया जा सकता है c[n, w] और पीछे की ओर ट्रेसिंग जहां से इष्टतम मान आए।

यदि c [i, w] = c [i-1, w] , तो आइटमi समाधान का हिस्सा नहीं है, और हम साथ अनुरेखण जारी रखते हैं c[i-1, w]। अन्यथा, आइटमi समाधान का हिस्सा है, और हम साथ अनुरेखण जारी रखते हैं c[i-1, w-W]।

विश्लेषण

यह एल्गोरिथ्म (( n , w ) बार लेता है क्योंकि तालिका c में ( n + 1) है। ( w + 1) प्रविष्टियां, जहां प्रत्येक प्रविष्टि को गणना करने के लिए each (1) समय की आवश्यकता होती है।

सबसे लंबे समय तक चलने वाली सामान्य समस्या सबसे लंबे अनुक्रम का पता लगा रही है जो कि दिए गए तार में मौजूद है।

परिणाम को

आइए एक अनुक्रम पर विचार करें S = <s 1 , s 2 , s 3 , s 4 ,…, s n >।

एक सीक्वेंस Z = <z 1 , z 2 , z 3 , z 4 ,…, z m > S पर S को S का आफ्टरनून कहा जाता है, अगर और केवल अगर इसे कुछ तत्वों के S डिलीट से प्राप्त किया जा सकता है।

सामान्य परिणाम

मान लीजिए, X तथा Yतत्वों के एक सीमित सेट पर दो अनुक्रम हैं। हम कह सकते हैं किZ का एक सामान्य परिणाम है X तथा Y, अगर Z दोनों का एक परिणाम है X तथा Y।

सबसे लंबा सामान्य परिणाम

यदि अनुक्रम का एक सेट दिया जाता है, तो सबसे लंबे समय तक चलने वाली समस्या बाद में उन सभी अनुक्रमों की एक सामान्य अनुवर्तीता है जो अधिकतम लंबाई का है।

सबसे लंबी सामान्य अनुवर्ती समस्या एक क्लासिक कंप्यूटर विज्ञान की समस्या है, जो डेटा उपयोगिता कार्यक्रमों जैसे कि डिफरेंट-यूटिलिटी का आधार है, और इसमें जैव सूचना विज्ञान के अनुप्रयोग हैं। यह संशोधन नियंत्रण प्रणालियों द्वारा भी व्यापक रूप से उपयोग किया जाता है, जैसे कि SVN और Git, फ़ाइलों के संशोधन-नियंत्रित संग्रह में किए गए कई परिवर्तनों को समेटने के लिए।

Nave विधि

लश्कर X लंबाई का एक क्रम हो m तथा Y लंबाई का एक क्रम n। के हर बाद के लिए जाँच करेंX चाहे वह इसके बाद का हो Y, और सबसे लंबे समय तक पाए जाने वाले सामान्य परिणाम लौटाएं।

वहां 2m के बाद के X। परीक्षण अनुक्रम है या नहीं यह एक के बाद हैY लेता है O(n)समय। इस प्रकार, भोले एल्गोरिदम ले जाएगाO(n2m) समय।

गतिशील प्रोग्रामिंग

चलो एक्स = <एक्स 1 , एक्स 2 , एक्स 3 , ..., एक्स मीटर > और वाई = <y 1 , वाई 2 , वाई 3 , ..., वाई एन > क्रम हो। एक तत्व की लंबाई की गणना करने के लिए निम्नलिखित एल्गोरिथ्म का उपयोग किया जाता है।

इस प्रक्रिया में, तालिका C[m, n] पंक्ति प्रमुख क्रम और एक अन्य तालिका में गणना की जाती है B[m,n] इष्टतम समाधान के निर्माण के लिए गणना की जाती है।

Algorithm: LCS-Length-Table-Formulation (X, Y)

m := length(X)

n := length(Y)

for i = 1 to m do

C[i, 0] := 0

for j = 1 to n do

C[0, j] := 0

for i = 1 to m do

for j = 1 to n do

if xi = yj

C[i, j] := C[i - 1, j - 1] + 1

B[i, j] := ‘D’

else

if C[i -1, j] ≥ C[i, j -1]

C[i, j] := C[i - 1, j] + 1

B[i, j] := ‘U’

else

C[i, j] := C[i, j - 1]

B[i, j] := ‘L’

return C and BAlgorithm: Print-LCS (B, X, i, j)

if i = 0 and j = 0

return

if B[i, j] = ‘D’

Print-LCS(B, X, i-1, j-1)

Print(xi)

else if B[i, j] = ‘U’

Print-LCS(B, X, i-1, j)

else

Print-LCS(B, X, i, j-1)यह एल्गोरिथ्म सबसे लंबे समय तक चलने वाले सामान्य प्रिंट को प्रिंट करेगा X तथा Y।

विश्लेषण

तालिका, बाहरी को आबाद करने के लिए for पाश iterates m समय और भीतर for पाश iterates nबार। इसलिए, एल्गोरिथ्म की जटिलता ओ (एम, एन) है , जहांm तथा n दो तारों की लंबाई है।

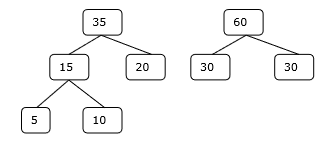

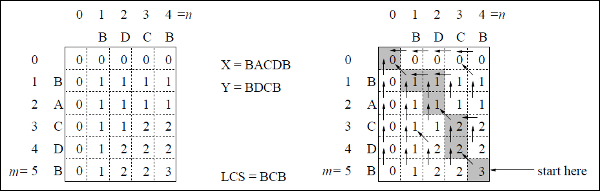

उदाहरण

इस उदाहरण में, हमारे पास दो तार हैं X = BACDB तथा Y = BDCB सबसे लंबे समय तक सामान्य परिणाम खोजने के लिए।

एल्गोरिथ्म एलसीएस-लंबाई-तालिका-निर्माण (जैसा कि ऊपर कहा गया है) के बाद, हमने टेबल सी (बाएं हाथ की तरफ दिखाया गया है) और टेबल बी (दाहिने हाथ की तरफ दिखाया गया है) की गणना की है।

टेबल बी में, 'डी', 'एल' और 'यू' के बजाय, हम क्रमशः विकर्ण तीर, बाएं तीर और ऊपर तीर का उपयोग कर रहे हैं। तालिका बी बनाने के बाद, LCS फ़ंक्शन LCS-Print द्वारा निर्धारित किया जाता है। परिणाम बीसीबी है।

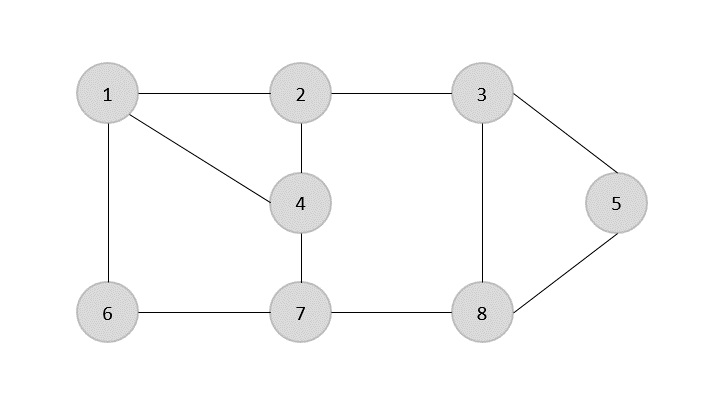

ए spanning tree एक अप्रत्यक्ष ग्राफ़ का एक सबसेट है जिसमें सभी किनारों को न्यूनतम संख्या में किनारों से जोड़ा गया है।

यदि सभी कोने एक ग्राफ में जुड़े हुए हैं, तो कम से कम एक फैले हुए पेड़ मौजूद हैं। एक ग्राफ में, एक से अधिक फैले हुए वृक्ष मौजूद हो सकते हैं।

गुण

- एक फैले हुए वृक्ष का कोई चक्र नहीं होता है।

- किसी भी शीर्ष पर किसी भी अन्य शीर्ष से पहुंचा जा सकता है।

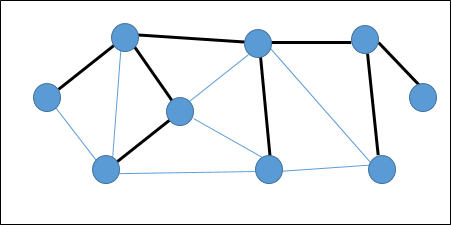

उदाहरण

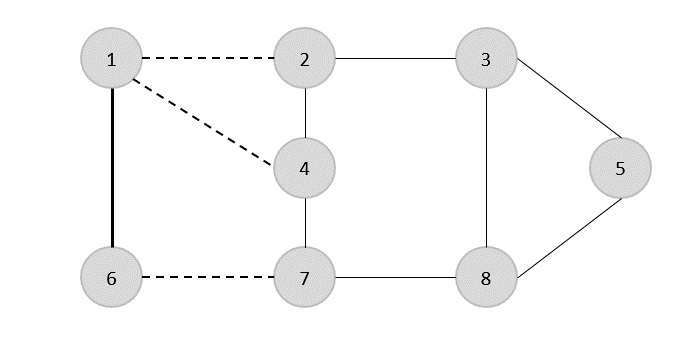

निम्नलिखित ग्राफ में, हाइलाइट किए गए किनारे एक फैले हुए पेड़ का निर्माण करते हैं।

न्यूनतम फैलाव वाला पेड़

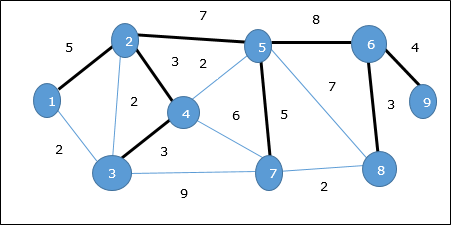

ए Minimum Spanning Tree (MST)एक जुड़े भारित अप्रत्यक्ष ग्राफ के किनारों का एक सबसेट है जो न्यूनतम संभव कुल बढ़त वजन के साथ सभी कोने जोड़ता है। एक एमएसटी प्राप्त करने के लिए, प्राइम के एल्गोरिथ्म या क्रुस्कल के एल्गोरिथ्म का उपयोग किया जा सकता है। इसलिए, हम इस अध्याय में प्राइम के एल्गोरिथ्म पर चर्चा करेंगे।

जैसा कि हमने चर्चा की है, एक ग्राफ में एक से अधिक फैले हुए पेड़ हो सकते हैं। अगर वहाँn वर्टिकल की संख्या, फैले हुए वृक्ष होना चाहिए n - 1किनारों की संख्या। इस संदर्भ में, यदि ग्राफ़ का प्रत्येक किनारा एक भार के साथ जुड़ा हुआ है और एक से अधिक फैले हुए पेड़ मौजूद हैं, तो हमें ग्राफ़ के न्यूनतम फैले हुए पेड़ को खोजने की आवश्यकता है।

इसके अलावा, अगर कोई डुप्लिकेट वेटेड किनारों मौजूद हैं, तो ग्राफ में कई न्यूनतम फैले हुए पेड़ हो सकते हैं।

उपरोक्त ग्राफ में, हमने एक फैले हुए पेड़ को दिखाया है, हालांकि यह न्यूनतम फैले हुए पेड़ नहीं है। इस फैले हुए पेड़ की लागत (5 + 7 + 3 + 3 + 5 + 8 + 3 + 4) = 38 है।

न्यूनतम फैले हुए पेड़ को खोजने के लिए हम प्राइम के एल्गोरिथ्म का उपयोग करेंगे।

प्राइम का एल्गोरिथम

प्राइम का एल्गोरिथ्म न्यूनतम फैले हुए पेड़ को खोजने के लिए एक लालची दृष्टिकोण है। इस एल्गोरिथ्म में, एक एमएसटी बनाने के लिए हम एक अनियंत्रित शीर्ष से शुरू कर सकते हैं।

Algorithm: MST-Prim’s (G, w, r)

for each u є G.V

u.key = ∞

u.∏ = NIL

r.key = 0

Q = G.V

while Q ≠ Ф

u = Extract-Min (Q)

for each v є G.adj[u]

if each v є Q and w(u, v) < v.key

v.∏ = u

v.key = w(u, v)फ़ंक्शन एक्सट्रैक्ट-मिन न्यूनतम बढ़त लागत के साथ वर्टेक्स लौटाता है। यह फ़ंक्शन मिन-हीप पर काम करता है।

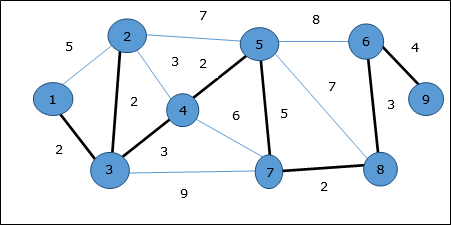

उदाहरण

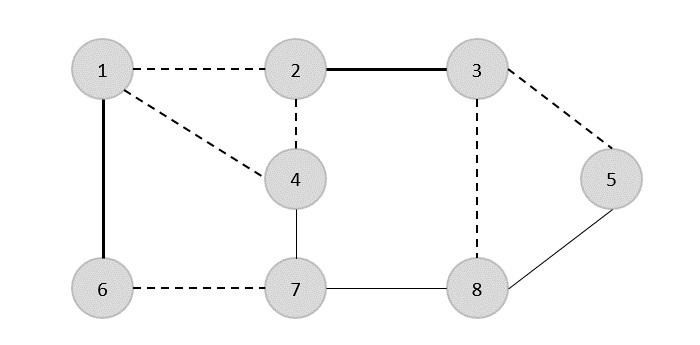

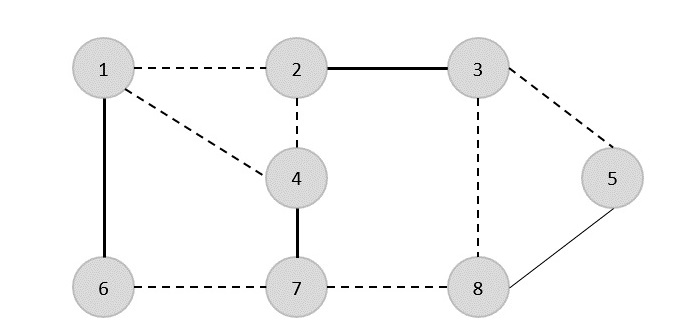

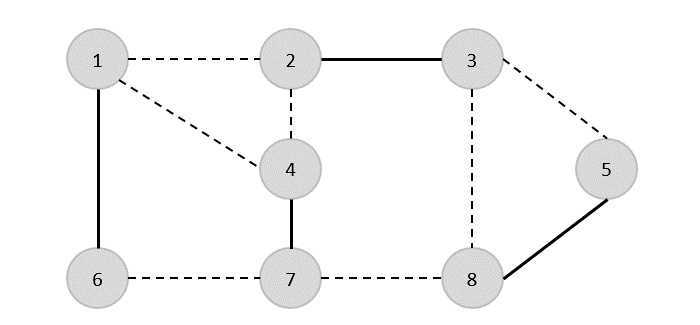

प्राइम के एल्गोरिथ्म का उपयोग करते हुए, हम किसी भी शीर्ष से शुरू कर सकते हैं, हमें शीर्ष से शुरू करते हैं 1।

शिखर 3 शीर्ष से जुड़ा है 1 न्यूनतम बढ़त लागत के साथ, इसलिए बढ़त (1, 2) फैले पेड़ में जोड़ा जाता है।

अगला, किनारा (2, 3) माना जाता है कि यह किनारों के बीच न्यूनतम है {(1, 2), (2, 3), (3, 4), (3, 7)}।

अगले चरण में, हमें बढ़त मिलती है (3, 4) तथा (2, 4)न्यूनतम लागत के साथ। एज(3, 4) यादृच्छिक पर चुना गया है।

इसी तरह से, किनारों (4, 5), (5, 7), (7, 8), (6, 8) तथा (6, 9)चुने गए हैं। के रूप में सभी कोने का दौरा कर रहे हैं, अब एल्गोरिथ्म बंद हो जाता है।

फैले हुए वृक्ष की लागत (2 + 2 + 3 + 2 + 5 + 2 + 3 + 4) = 23 है। इस ग्राफ में कोई अधिक फैलाव वाला वृक्ष नहीं है, जिसकी लागत कम है 23।

डीजकस्ट्रा का एल्गोरिथम

दिज्क्स्ट्रा का एल्गोरिथ्म एक निर्देशित भारित ग्राफ G = (V, E) पर एकल-स्रोत लघु-पथ समस्या का हल करता है , जहां सभी किनारे गैर-नकारात्मक हैं (यानी, w (u, v) for 0 प्रत्येक किनारे के लिए (u, v) )) ई )।

निम्नलिखित एल्गोरिथ्म में, हम एक फ़ंक्शन का उपयोग करेंगे Extract-Min(), जो सबसे छोटी कुंजी के साथ नोड को निकालता है।

Algorithm: Dijkstra’s-Algorithm (G, w, s)

for each vertex v Є G.V

v.d := ∞

v.∏ := NIL

s.d := 0

S := Ф

Q := G.V

while Q ≠ Ф

u := Extract-Min (Q)

S := S U {u}

for each vertex v Є G.adj[u]

if v.d > u.d + w(u, v)

v.d := u.d + w(u, v)

v.∏ := uविश्लेषण

इस एल्गोरिथ्म की जटिलता पूरी तरह से एक्सट्रैक्ट-मिन फ़ंक्शन के कार्यान्वयन पर निर्भर है। यदि अर्क मिन फ़ंक्शन को रैखिक खोज का उपयोग करके कार्यान्वित किया जाता है, तो इस एल्गोरिथ्म की जटिलता हैO(V2 + E)।

इस एल्गोरिथ्म में, यदि हम मिन-हीप का उपयोग करते हैं Extract-Min() फ़ंक्शन नोड को वापस करने के लिए कार्य करता है Q सबसे छोटी कुंजी के साथ, इस एल्गोरिथ्म की जटिलता को और कम किया जा सकता है।

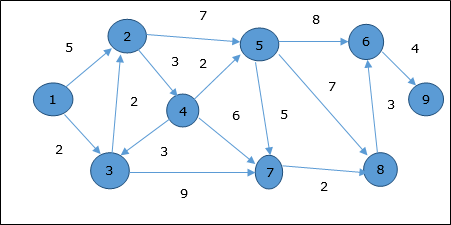

उदाहरण

आइए हम शीर्ष पर विचार करें 1 तथा 9क्रमशः शुरुआत और गंतव्य शीर्ष के रूप में। प्रारंभ में, प्रारंभ शीर्ष को छोड़कर सभी शीर्षों को the द्वारा चिह्नित किया जाता है और प्रारंभ शीर्ष को चिह्नित किया जाता है0।

| शिखर | प्रारंभिक | चरण १ वी १ | चरण 2 वी 3 | चरण 3 वी 2 | चरण 4 वी 4 | चरण 5 वी 5 | स्टेप 6 वी 7 | चरण 7 वी 8 | चरण 8 वी 6 |

|---|---|---|---|---|---|---|---|---|---|

| 1 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 2 | ∞ | 5 | 4 | 4 | 4 | 4 | 4 | 4 | 4 |

| 3 | ∞ | 2 | 2 | 2 | 2 | 2 | 2 | 2 | 2 |

| 4 | ∞ | ∞ | ∞ | 7 | 7 | 7 | 7 | 7 | 7 |

| 5 | ∞ | ∞ | ∞ | 1 1 | 9 | 9 | 9 | 9 | 9 |

| 6 | ∞ | ∞ | ∞ | ∞ | ∞ | 17 | 17 | 16 | 16 |

| 7 | ∞ | ∞ | 1 1 | 1 1 | 1 1 | 1 1 | 1 1 | 1 1 | 1 1 |

| 8 | ∞ | ∞ | ∞ | ∞ | ∞ | 16 | 13 | 13 | 13 |

| 9 | ∞ | ∞ | ∞ | ∞ | ∞ | ∞ | ∞ | ∞ | 20 |

इसलिए, वर्टेक्स की न्यूनतम दूरी 9 शीर्ष से 1 है 20। और रास्ता है

1 → 3 → 7 → 8 → 6 → 9

यह पथ पूर्ववर्ती सूचना के आधार पर निर्धारित किया जाता है।

बेलमैन फोर्ड एल्गोरिथम

यह एल्गोरिथ्म एक निर्देशित ग्राफ के एकल स्रोत सबसे छोटी पथ समस्या को हल करता है G = (V, E)जिसमें किनारे का वजन ऋणात्मक हो सकता है। इसके अलावा, यह एल्गोरिथ्म सबसे छोटा रास्ता खोजने के लिए लागू किया जा सकता है, अगर कोई नकारात्मक भारित चक्र मौजूद नहीं है।

Algorithm: Bellman-Ford-Algorithm (G, w, s)

for each vertex v Є G.V

v.d := ∞

v.∏ := NIL

s.d := 0

for i = 1 to |G.V| - 1

for each edge (u, v) Є G.E

if v.d > u.d + w(u, v)

v.d := u.d +w(u, v)

v.∏ := u

for each edge (u, v) Є G.E

if v.d > u.d + w(u, v)

return FALSE

return TRUEविश्लेषण

सबसे पहला for लूप का उपयोग आरंभीकरण के लिए किया जाता है, जो अंदर चलता है O(V)बार। अगलाfor लूप रन |V - 1| किनारों पर गुजरता है, जो लेता हैO(E) बार।

इसलिए, बेलमैन-फोर्ड एल्गोरिथ्म में चलता है O(V, E) समय।

उदाहरण

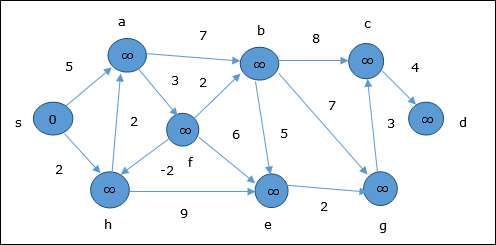

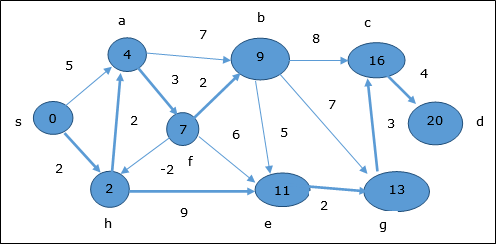

निम्न उदाहरण से पता चलता है कि बेलमैन-फोर्ड एल्गोरिदम कैसे कदम से कदम काम करता है। इस ग्राफ में एक नकारात्मक बढ़त है लेकिन इसका कोई नकारात्मक चक्र नहीं है, इसलिए इस तकनीक का उपयोग करके समस्या को हल किया जा सकता है।

आरंभीकरण के समय, स्रोत को छोड़कर सभी कोने the द्वारा चिह्नित किए जाते हैं और स्रोत द्वारा चिह्नित किया जाता है 0।

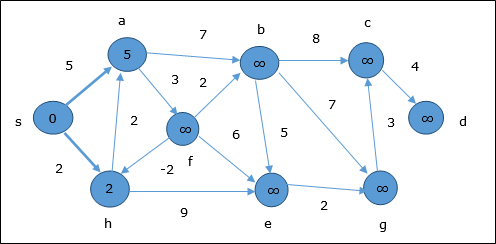

पहले चरण में, स्रोत से आने वाले सभी कोने न्यूनतम लागत द्वारा अद्यतन किए जाते हैं। इसलिए, कोनेa तथा h अपडेट किए जाते हैं।

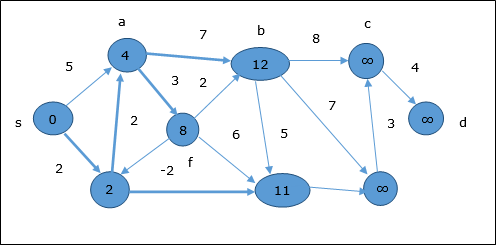

अगले चरण में, कोने a, b, f तथा e अपडेट किए जाते हैं।

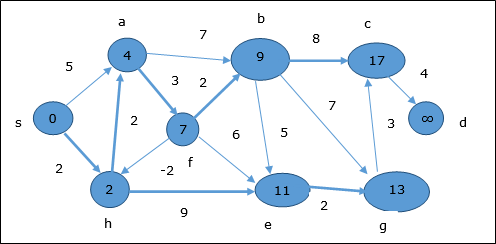

इसी स्टेप के बाद, इस स्टेप वर्जन में b, f, c तथा g अपडेट किए जाते हैं।

यहाँ, कोने c तथा d अपडेट किए जाते हैं।

इसलिए, वर्टेक्स के बीच न्यूनतम दूरी s और शीर्ष d है 20।

पूर्ववर्ती सूचनाओं के आधार पर, पथ s → h → e → g → c → d है

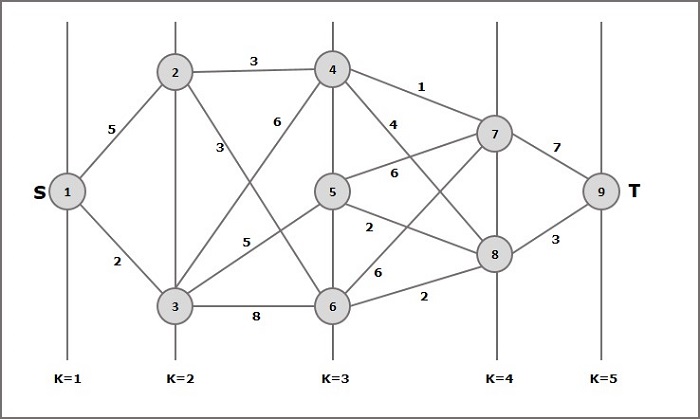

एक मल्टीस्टेज ग्राफ G = (V, E) एक निर्देशित ग्राफ़ है जहाँ वर्टिकल को विभाजित किया गया है k (कहाँ पे k > 1) असंबद्ध सबसेट की संख्या S = {s1,s2,…,sk}ऐसा किनारा (u, v) E में है, तो u v s i और v 1 s 1 + 1 विभाजन में कुछ सबसेट के लिए और |s1| = |sk| = 1।

शीर्षासन s Є s1 कहा जाता है source और शीर्ष t Є sk कहा जाता है sink।

Gआमतौर पर इसे भारित ग्राफ माना जाता है। इस ग्राफ में, एक किनारे की लागत (i, j) को c (i, j) द्वारा दर्शाया गया है । इसलिए, स्रोत से पथ की लागतs डूबना t इस मार्ग में प्रत्येक किनारों की लागत का योग है।

मल्टीस्टेज ग्राफ समस्या स्रोत से न्यूनतम लागत के साथ रास्ता ढूंढ रही है s डूबना t।

उदाहरण

मल्टीस्टेज ग्राफ की अवधारणा को समझने के लिए निम्नलिखित उदाहरण पर विचार करें।

सूत्र के अनुसार, हमें लागत की गणना करनी होगी (i, j) निम्नलिखित चरणों का उपयोग कर

चरण -1: लागत (K-2, j)

इस चरण में, तीन नोड्स (नोड 4, 5. 6) के रूप में चुने गए हैं j। इसलिए, इस कदम पर न्यूनतम लागत चुनने के लिए हमारे पास तीन विकल्प हैं।

लागत (3, 4) = मिनट {c (4, 7) + लागत (7, 9), सी (4, 8) + लागत (8, 9)} = 7

लागत (3, 5) = मिनट {c (5, 7) + लागत (7, 9), सी (5, 8) + लागत (8, 9)} = 5

लागत (3, 6) = मिनट {c (6, 7) + लागत (7, 9), सी (6, 8) + लागत (8, 9)} = 5

चरण -2: लागत (K-3, j)

दो नोड्स को j के रूप में चुना जाता है क्योंकि स्टेज k - 3 = 2 पर दो नोड्स होते हैं, 2 और 3. इसलिए, मान i = 2 और j = 2 और 3 होता है।

लागत (2, 2) = मिनट {c (2, 4) + लागत (4, 8) + लागत (8, 9), सी (2, 6) +

लागत (6, 8) + लागत (8, 9)} = 8

लागत (2, 3) = {c (3, 4) + लागत (4, 8) + लागत (8, 9), सी (3, 5) + लागत (5, 8) + लागत (8, 9) c (3, 6) + लागत (6, 8) + लागत (8, 9)} = 10

चरण -3: लागत (K-4, j)

लागत (1, 1) = {c (1, 2) + लागत (2, 6) + लागत (6, 8) + लागत (8, 9), सी (1, 3) + लागत (3, 5) + लागत (5, 8) + लागत (8, 9))} = 12

c (1, 3) + लागत (3, 6) + लागत (6, 8 + लागत (8, 9))}} 13

इसलिए, न्यूनतम लागत वाला मार्ग है 1→ 3→ 5→ 8→ 9।

समस्या का विवरण

एक यात्री को एक सूची से सभी शहरों का दौरा करने की आवश्यकता है, जहां सभी शहरों के बीच की दूरी ज्ञात है और प्रत्येक शहर को बस एक बार जाना चाहिए। वह सबसे छोटा संभव मार्ग क्या है जो वह प्रत्येक शहर में एक बार आता है और मूल शहर में लौटता है?

उपाय

ट्रैवलिंग सेल्समैन समस्या सबसे कुख्यात कम्प्यूटेशनल समस्या है। हम प्रत्येक संभावित दौरे का मूल्यांकन करने और सर्वश्रेष्ठ का चयन करने के लिए जानवर-बल दृष्टिकोण का उपयोग कर सकते हैं। के लियेn एक ग्राफ में कोने की संख्या, वहाँ हैं (n - 1)! संभावनाओं की संख्या।

गतिशील प्रोग्रामिंग दृष्टिकोण का उपयोग करते हुए जानवर-बल के बजाय, समाधान कम समय में प्राप्त किया जा सकता है, हालांकि बहुपद समय एल्गोरिथ्म नहीं है।

आइए हम एक ग्राफ पर विचार करें G = (V, E), कहाँ पे V शहरों का एक सेट है और Eभारित किनारों का एक सेट है। एक किनारेe(u, v) उस कोने का प्रतिनिधित्व करता है u तथा vजुड़े हुए हैं। वर्टेक्स के बीच की दूरीu तथा v है d(u, v), जो गैर-नकारात्मक होना चाहिए।

मान लीजिए हमने शहर में शुरुआत की है 1 और कुछ शहरों का दौरा करने के बाद अब हम शहर में हैं j। इसलिए, यह एक आंशिक दौरा है। हमें निश्चित रूप से जानने की जरूरत हैj, क्योंकि यह निर्धारित करेगा कि कौन से शहर अगले यात्रा के लिए सबसे सुविधाजनक हैं। हमें सभी शहरों का अब तक पता करने की आवश्यकता है, ताकि हम उनमें से किसी को भी न दोहराएं। इसलिए, यह एक उपयुक्त उप-समस्या है।

शहरों के सबसेट के लिए S Є {1, 2, 3, ... , n} जिसमें शामिल है 1, तथा j Є S, चलो C(S, j) प्रत्येक नोड में आने वाले सबसे छोटे पथ की लंबाई हो S बिल्कुल एक बार, शुरू करने पर 1 और अंत में j।

कब |S| > 1, हम परिभाषित करते हैंC(S, 1) = = चूंकि पथ शुरू नहीं हो सकता है और समाप्त नहीं हो सकता है 1।

अब, व्यक्त करते हैं C(S, j)छोटी उप-समस्याओं के संदर्भ में। हम पर शुरू करने की जरूरत है1 और अंत में j। हमें इस तरह से अगले शहर का चयन करना चाहिए

$$C(S, j) = min \:C(S - \lbrace j \rbrace, i) + d(i, j)\:where\: i\in S \: and\: i \neq jc(S, j) = minC(s- \lbrace j \rbrace, i)+ d(i,j) \:where\: i\in S \: and\: i \neq j $$

Algorithm: Traveling-Salesman-Problem

C ({1}, 1) = 0

for s = 2 to n do

for all subsets S Є {1, 2, 3, … , n} of size s and containing 1

C (S, 1) = ∞

for all j Є S and j ≠ 1

C (S, j) = min {C (S – {j}, i) + d(i, j) for i Є S and i ≠ j}

Return minj C ({1, 2, 3, …, n}, j) + d(j, i)विश्लेषण

सबसे ज्यादा हैं $2^n.n$उप-समस्याओं और प्रत्येक को हल करने के लिए रैखिक समय लगता है। इसलिए, कुल चलने का समय है$O(2^n.n^2)$।

उदाहरण

निम्नलिखित उदाहरण में, हम यात्रा विक्रेता समस्या को हल करने के लिए चरणों का वर्णन करेंगे।

उपरोक्त ग्राफ से, निम्न तालिका तैयार की जाती है।

| 1 | 2 | 3 | 4 | |

| 1 | 0 | 10 | 15 | 20 |

| 2 | 5 | 0 | 9 | 10 |

| 3 | 6 | 13 | 0 | 12 |

| 4 | 8 | 8 | 9 | 0 |

स = Φ

$$\small Cost (2,\Phi,1) = d (2,1) = 5\small Cost(2,\Phi,1)=d(2,1)=5$$

$$\small Cost (3,\Phi,1) = d (3,1) = 6\small Cost(3,\Phi,1)=d(3,1)=6$$

$$\small Cost (4,\Phi,1) = d (4,1) = 8\small Cost(4,\Phi,1)=d(4,1)=8$$

एस = 1

$$\small Cost (i,s) = min \lbrace Cost (j,s – (j)) + d [i,j]\rbrace\small Cost (i,s)=min \lbrace Cost (j,s)-(j))+ d [i,j]\rbrace$$

$$\small Cost (2,\lbrace 3 \rbrace,1) = d [2,3] + Cost (3,\Phi,1) = 9 + 6 = 15cost(2,\lbrace3 \rbrace,1)=d[2,3]+cost(3,\Phi ,1)=9+6=15$$

$$\small Cost (2,\lbrace 4 \rbrace,1) = d [2,4] + Cost (4,\Phi,1) = 10 + 8 = 18cost(2,\lbrace4 \rbrace,1)=d[2,4]+cost(4,\Phi,1)=10+8=18$$

$$\small Cost (3,\lbrace 2 \rbrace,1) = d [3,2] + Cost (2,\Phi,1) = 13 + 5 = 18cost(3,\lbrace2 \rbrace,1)=d[3,2]+cost(2,\Phi,1)=13+5=18$$

$$\small Cost (3,\lbrace 4 \rbrace,1) = d [3,4] + Cost (4,\Phi,1) = 12 + 8 = 20cost(3,\lbrace4 \rbrace,1)=d[3,4]+cost(4,\Phi,1)=12+8=20$$

$$\small Cost (4,\lbrace 3 \rbrace,1) = d [4,3] + Cost (3,\Phi,1) = 9 + 6 = 15cost(4,\lbrace3 \rbrace,1)=d[4,3]+cost(3,\Phi,1)=9+6=15$$

$$\small Cost (4,\lbrace 2 \rbrace,1) = d [4,2] + Cost (2,\Phi,1) = 8 + 5 = 13cost(4,\lbrace2 \rbrace,1)=d[4,2]+cost(2,\Phi,1)=8+5=13$$

एस = 2

$$\small Cost(2, \lbrace 3, 4 \rbrace, 1)=\begin{cases}d[2, 3] + Cost(3, \lbrace 4 \rbrace, 1) = 9 + 20 = 29\\d[2, 4] + Cost(4, \lbrace 3 \rbrace, 1) = 10 + 15 = 25=25\small Cost (2,\lbrace 3,4 \rbrace,1)\\\lbrace d[2,3]+ \small cost(3,\lbrace4\rbrace,1)=9+20=29d[2,4]+ \small Cost (4,\lbrace 3 \rbrace ,1)=10+15=25\end{cases}= 25$$

$$\small Cost(3, \lbrace 2, 4 \rbrace, 1)=\begin{cases}d[3, 2] + Cost(2, \lbrace 4 \rbrace, 1) = 13 + 18 = 31\\d[3, 4] + Cost(4, \lbrace 2 \rbrace, 1) = 12 + 13 = 25=25\small Cost (3,\lbrace 2,4 \rbrace,1)\\\lbrace d[3,2]+ \small cost(2,\lbrace4\rbrace,1)=13+18=31d[3,4]+ \small Cost (4,\lbrace 2 \rbrace ,1)=12+13=25\end{cases}= 25$$

$$\small Cost(4, \lbrace 2, 3 \rbrace, 1)=\begin{cases}d[4, 2] + Cost(2, \lbrace 3 \rbrace, 1) = 8 + 15 = 23\\d[4, 3] + Cost(3, \lbrace 2 \rbrace, 1) = 9 + 18 = 27=23\small Cost (4,\lbrace 2,3 \rbrace,1)\\\lbrace d[4,2]+ \small cost(2,\lbrace3\rbrace,1)=8+15=23d[4,3]+ \small Cost (3,\lbrace 2 \rbrace ,1)=9+18=27\end{cases}= 23$$

एस = ३

$$\small Cost(1, \lbrace 2, 3, 4 \rbrace, 1)=\begin{cases}d[1, 2] + Cost(2, \lbrace 3, 4 \rbrace, 1) = 10 + 25 = 35\\d[1, 3] + Cost(3, \lbrace 2, 4 \rbrace, 1) = 15 + 25 = 40\\d[1, 4] + Cost(4, \lbrace 2, 3 \rbrace, 1) = 20 + 23 = 43=35 cost(1,\lbrace 2,3,4 \rbrace),1)\\d[1,2]+cost(2,\lbrace 3,4 \rbrace,1)=10+25=35\\d[1,3]+cost(3,\lbrace 2,4 \rbrace,1)=15+25=40\\d[1,4]+cost(4,\lbrace 2,3 \rbrace ,1)=20+23=43=35\end{cases}$$

न्यूनतम लागत पथ 35 है।

लागत से शुरू करें {1, {2, 3, 4}, 1}, हम के लिए न्यूनतम मूल्य मिलता है d [1, 2]। कबs = 3, 1 से 2 तक पथ चुनें (लागत 10 है) फिर पीछे की ओर जाएं। कबs = 2, हम के लिए न्यूनतम मूल्य मिलता है d [4, 2]। 2 से 4 तक पथ का चयन करें (लागत 10 है) फिर पीछे की ओर जाएं।

कब s = 1, हम के लिए न्यूनतम मूल्य मिलता है d [4, 3]। पथ 4 से 3 का चयन करना (लागत 9 है), फिर हम तब तक जाएंगेs = Φकदम। हमें न्यूनतम मूल्य मिलता हैd [3, 1] (लागत 6 है)।

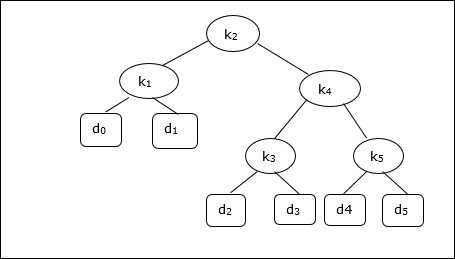

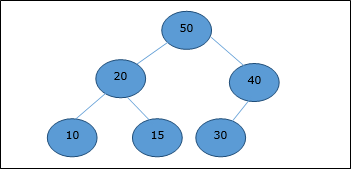

एक बाइनरी सर्च ट्री (BST) एक ऐसा पेड़ है जहां आंतरिक नोड्स में मुख्य मान संग्रहीत किए जाते हैं। बाहरी नोड्स नल नोड्स हैं। कुंजी को लेक्सिकोग्राफ़िक रूप से क्रमबद्ध किया गया है, अर्थात प्रत्येक आंतरिक नोड के लिए बाएं उप-ट्री की सभी कुंजी नोड की कुंजियों से कम है, और दाएँ उप-ट्री की सभी कुंजियाँ अधिक हैं।

जब हम चाबियों में से प्रत्येक को खोजने की आवृत्ति जानते हैं, तो पेड़ में प्रत्येक नोड तक पहुंचने की अपेक्षित लागत की गणना करना काफी आसान है। एक इष्टतम बाइनरी सर्च ट्री एक BST है, जिसमें प्रत्येक नोड का पता लगाने की न्यूनतम अपेक्षित लागत होती है

BST में एक तत्व का खोज समय है O(n), जबकि एक संतुलित-बीएसटी खोज समय है O(log n)। ऑप्टिमल कॉस्ट बाइनरी सर्च ट्री में फिर से खोज समय में सुधार किया जा सकता है, सबसे अधिक बार उपयोग किए जाने वाले डेटा को रूट में और रूट तत्व के करीब रखते हुए, पत्तियों के पास और पत्तियों में कम से कम अक्सर उपयोग किए गए डेटा को रखते हुए।

यहाँ, इष्टतम बाइनरी सर्च ट्री एल्गोरिथम प्रस्तुत किया गया है। पहले, हम प्रदान किए गए सेट से एक BST बनाते हैंn अलग-अलग चाबियों की संख्या < k1, k2, k3, ... kn >। यहाँ हम मानते हैं, एक कुंजी तक पहुँचने की संभावनाKi है pi। कुछ डमी कुंजी (d0, d1, d2, ... dn) जोड़े जाते हैं क्योंकि कुछ खोज उन मानों के लिए किए जा सकते हैं जो कुंजी सेट में मौजूद नहीं हैं K। हम मानते हैं, प्रत्येक डमी कुंजी के लिएdi पहुंच की संभावना है qi।

Optimal-Binary-Search-Tree(p, q, n)

e[1…n + 1, 0…n],

w[1…n + 1, 0…n],

root[1…n + 1, 0…n]

for i = 1 to n + 1 do

e[i, i - 1] := qi - 1

w[i, i - 1] := qi - 1

for l = 1 to n do

for i = 1 to n – l + 1 do

j = i + l – 1 e[i, j] := ∞

w[i, i] := w[i, i -1] + pj + qj

for r = i to j do

t := e[i, r - 1] + e[r + 1, j] + w[i, j]

if t < e[i, j]

e[i, j] := t

root[i, j] := r

return e and rootविश्लेषण

एल्गोरिथ्म की आवश्यकता है O (n3) समय, तीन नेस्टेड के बाद से forछोरों का उपयोग किया जाता है। इनमें से प्रत्येक लूप सबसे अधिक लेता हैn मान।

उदाहरण

निम्नलिखित पेड़ को ध्यान में रखते हुए, लागत 2.80 है, हालांकि यह एक इष्टतम परिणाम नहीं है।

| नोड | गहराई | संभावना | योगदान |

|---|---|---|---|

| k १ | 1 | 0.15 | 0.30 |

| के २ | 0 | 0.10 | 0.10 |

| के ३ | 2 | 0.05 | 0.15 |

| के ४ | 1 | 0.10 | 0.20 |

| के ५ | 2 | 0.20 | 0.60 |

| घ ० | 2 | 0.05 | 0.15 |

| घ १ | 2 | 0.10 | 0.30 |

| घ २ | 3 | 0.05 | 0.20 |

| घ ३ | 3 | 0.05 | 0.20 |

| घ ४ | 3 | 0.05 | 0.20 |

| घ ५ | 3 | 0.10 | 0.40 |

| Total | 2.80 |

एक इष्टतम समाधान प्राप्त करने के लिए, इस अध्याय में चर्चा किए गए एल्गोरिथ्म का उपयोग करके, निम्न तालिकाओं को उत्पन्न किया जाता है।

निम्नलिखित तालिकाओं में, स्तंभ सूचकांक है i और पंक्ति सूचकांक है j।

| इ | 1 | 2 | 3 | 4 | 5 | 6 |

|---|---|---|---|---|---|---|

| 5 | 2.75 | 2.00 | 1.30 | 0.90 | 0.50 | 0.10 |

| 4 | 1.75 | 1.20 | 0.60 | 0.30 | 0.05 | |

| 3 | 1.25 | 0.70 | 0.25 | 0.05 | ||

| 2 | 0.90 | 0.40 | 0.05 | |||

| 1 | 0.45 | 0.10 | ||||

| 0 | 0.05 |

| w | 1 | 2 | 3 | 4 | 5 | 6 |

|---|---|---|---|---|---|---|

| 5 | 1.00 | 0.80 | 0.60 | 0.50 | 0.35 | 0.10 |

| 4 | 0.70 | 0.50 | 0.30 | 0.20 | 0.05 | |

| 3 | 0.55 | 0.35 | 0.15 | 0.05 | ||

| 2 | 0.45 | 0.25 | 0.05 | |||

| 1 | 0.30 | 0.10 | ||||

| 0 | 0.05 |

| जड़ | 1 | 2 | 3 | 4 | 5 |

|---|---|---|---|---|---|

| 5 | 2 | 4 | 5 | 5 | 5 |

| 4 | 2 | 2 | 4 | 4 | |

| 3 | 2 | 2 | 3 | ||

| 2 | 1 | 2 | |||

| 1 | 1 |

From these tables, the optimal tree can be formed.

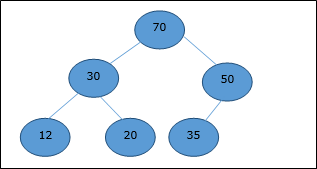

There are several types of heaps, however in this chapter, we are going to discuss binary heap. A binary heap is a data structure, which looks similar to a complete binary tree. Heap data structure obeys ordering properties discussed below. Generally, a Heap is represented by an array. In this chapter, we are representing a heap by H.

As the elements of a heap is stored in an array, considering the starting index as 1, the position of the parent node of ith element can be found at ⌊ i/2 ⌋ . Left child and right child of ith node is at position 2i and 2i + 1.

A binary heap can be classified further as either a max-heap or a min-heap based on the ordering property.

Max-Heap

In this heap, the key value of a node is greater than or equal to the key value of the highest child.

Hence, H[Parent(i)] ≥ H[i]

Min-Heap

In mean-heap, the key value of a node is lesser than or equal to the key value of the lowest child.

Hence, H[Parent(i)] ≤ H[i]

In this context, basic operations are shown below with respect to Max-Heap. Insertion and deletion of elements in and from heaps need rearrangement of elements. Hence, Heapify function needs to be called.

Array Representation

A complete binary tree can be represented by an array, storing its elements using level order traversal.

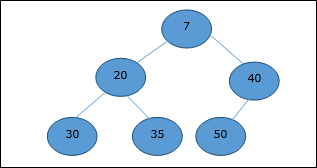

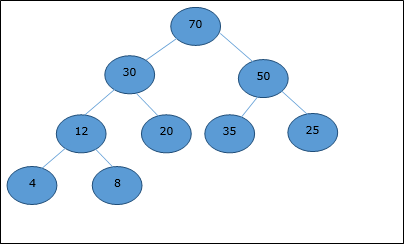

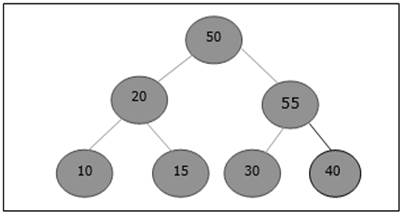

Let us consider a heap (as shown below) which will be represented by an array H.

Considering the starting index as 0, using level order traversal, the elements are being kept in an array as follows.

| Index | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | ... |

| elements | 70 | 30 | 50 | 12 | 20 | 35 | 25 | 4 | 8 | ... |

In this context, operations on heap are being represented with respect to Max-Heap.

To find the index of the parent of an element at index i, the following algorithm Parent (numbers[], i) is used.

Algorithm: Parent (numbers[], i)

if i == 1

return NULL

else

[i / 2]The index of the left child of an element at index i can be found using the following algorithm, Left-Child (numbers[], i).

Algorithm: Left-Child (numbers[], i)

If 2 * i ≤ heapsize

return [2 * i]

else

return NULLThe index of the right child of an element at index i can be found using the following algorithm, Right-Child(numbers[], i).

Algorithm: Right-Child (numbers[], i)

if 2 * i < heapsize

return [2 * i + 1]

else

return NULLTo insert an element in a heap, the new element is initially appended to the end of the heap as the last element of the array.

After inserting this element, heap property may be violated, hence the heap property is repaired by comparing the added element with its parent and moving the added element up a level, swapping positions with the parent. This process is called percolation up.

The comparison is repeated until the parent is larger than or equal to the percolating element.

Algorithm: Max-Heap-Insert (numbers[], key)

heapsize = heapsize + 1

numbers[heapsize] = -∞

i = heapsize

numbers[i] = key

while i > 1 and numbers[Parent(numbers[], i)] < numbers[i]

exchange(numbers[i], numbers[Parent(numbers[], i)])

i = Parent (numbers[], i)Analysis

Initially, an element is being added at the end of the array. If it violates the heap property, the element is exchanged with its parent. The height of the tree is log n. Maximum log n number of operations needs to be performed.

Hence, the complexity of this function is O(log n).

Example

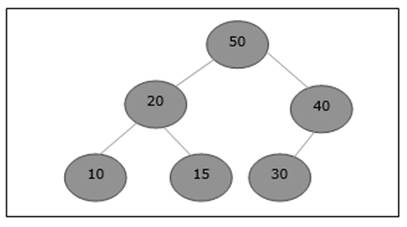

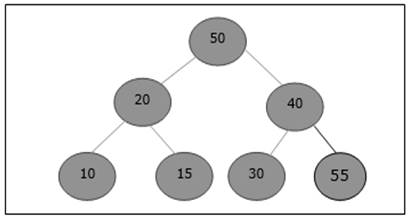

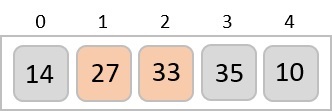

Let us consider a max-heap, as shown below, where a new element 5 needs to be added.

Initially, 55 will be added at the end of this array.

After insertion, it violates the heap property. Hence, the element needs to swap with its parent. After swap, the heap looks like the following.

Again, the element violates the property of heap. Hence, it is swapped with its parent.

Now, we have to stop.

Heapify method rearranges the elements of an array where the left and right sub-tree of ith element obeys the heap property.

Algorithm: Max-Heapify(numbers[], i)

leftchild := numbers[2i]

rightchild := numbers [2i + 1]

if leftchild ≤ numbers[].size and numbers[leftchild] > numbers[i]

largest := leftchild

else

largest := i

if rightchild ≤ numbers[].size and numbers[rightchild] > numbers[largest]

largest := rightchild

if largest ≠ i

swap numbers[i] with numbers[largest]

Max-Heapify(numbers, largest)When the provided array does not obey the heap property, Heap is built based on the following algorithm Build-Max-Heap (numbers[]).

Algorithm: Build-Max-Heap(numbers[])

numbers[].size := numbers[].length

fori = ⌊ numbers[].length/2 ⌋ to 1 by -1

Max-Heapify (numbers[], i)Extract method is used to extract the root element of a Heap. Following is the algorithm.

Algorithm: Heap-Extract-Max (numbers[])

max = numbers[1]

numbers[1] = numbers[heapsize]

heapsize = heapsize – 1

Max-Heapify (numbers[], 1)

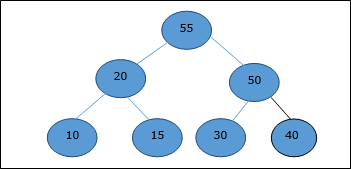

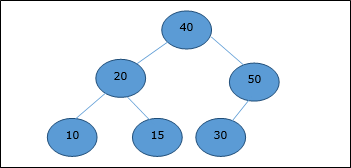

return maxExample

Let us consider the same example discussed previously. Now we want to extract an element. This method will return the root element of the heap.

After deletion of the root element, the last element will be moved to the root position.

Now, Heapify function will be called. After Heapify, the following heap is generated.

Bubble Sort is an elementary sorting algorithm, which works by repeatedly exchanging adjacent elements, if necessary. When no exchanges are required, the file is sorted.

This is the simplest technique among all sorting algorithms.

Algorithm: Sequential-Bubble-Sort (A)

fori← 1 to length [A] do

for j ← length [A] down-to i +1 do

if A[A] < A[j - 1] then

Exchange A[j] ↔ A[j-1]Implementation

voidbubbleSort(int numbers[], intarray_size) {

inti, j, temp;

for (i = (array_size - 1); i >= 0; i--)

for (j = 1; j <= i; j++)

if (numbers[j - 1] > numbers[j]) {

temp = numbers[j-1];

numbers[j - 1] = numbers[j];

numbers[j] = temp;

}

}Analysis

Here, the number of comparisons are

1 + 2 + 3 +...+ (n - 1) = n(n - 1)/2 = O(n2)

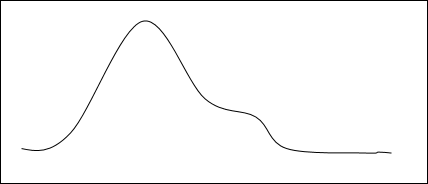

Clearly, the graph shows the n2 nature of the bubble sort.

In this algorithm, the number of comparison is irrespective of the data set, i.e. whether the provided input elements are in sorted order or in reverse order or at random.

Memory Requirement

From the algorithm stated above, it is clear that bubble sort does not require extra memory.

Example

Unsorted list: |

|

1st iteration:

5 > 2 swap |

|

|||||||

5 > 1 swap |

|

|||||||

5 > 4 swap |

|

|||||||

5 > 3 swap |

|

|||||||

5 < 7 no swap |

|

|||||||

7 > 6 swap |

|

2nd iteration:

2 > 1 swap |

|

|||||||

2 < 4 no swap |

|

|||||||

4 > 3 swap |

|

|||||||

4 < 5 no swap |

|

|||||||

5 < 6 no swap |

|

There is no change in 3rd, 4th, 5th and 6th iteration.

Finally,

the sorted list is |

|

Insertion sort is a very simple method to sort numbers in an ascending or descending order. This method follows the incremental method. It can be compared with the technique how cards are sorted at the time of playing a game.

The numbers, which are needed to be sorted, are known as keys. Here is the algorithm of the insertion sort method.

Algorithm: Insertion-Sort(A)

for j = 2 to A.length

key = A[j]

i = j – 1

while i > 0 and A[i] > key

A[i + 1] = A[i]

i = i -1

A[i + 1] = keyAnalysis

Run time of this algorithm is very much dependent on the given input.

If the given numbers are sorted, this algorithm runs in O(n) time. If the given numbers are in reverse order, the algorithm runs in O(n2) time.

Example

Unsorted list: |

|

1st iteration:

Key = a[2] = 13

a[1] = 2 < 13

Swap, no swap |

|

2nd iteration:

Key = a[3] = 5

a[2] = 13 > 5

Swap 5 and 13 |

|

Next, a[1] = 2 < 13

Swap, no swap |

|

3rd iteration:

Key = a[4] = 18

a[3] = 13 < 18,

a[2] = 5 < 18,

a[1] = 2 < 18

Swap, no swap |

|

4th iteration:

Key = a[5] = 14

a[4] = 18 > 14

Swap 18 and 14 |

|

Next, a[3] = 13 < 14,

a[2] = 5 < 14,

a[1] = 2 < 14

So, no swap |

|

Finally,

the sorted list is |

|