Técnicas de Regressão

A regressão é uma técnica estatística que ajuda a qualificar a relação entre as variáveis econômicas inter-relacionadas. A primeira etapa envolve estimar o coeficiente da variável independente e então medir a confiabilidade do coeficiente estimado. Isso requer a formulação de uma hipótese e, com base na hipótese, podemos criar uma função.

Se um gerente deseja determinar a relação entre os gastos com publicidade da empresa e sua receita de vendas, ele se submeterá ao teste de hipótese. Supondo que maiores gastos com publicidade levem a maiores vendas para uma empresa. O gerente coleta dados sobre despesas com publicidade e receita de vendas em um período específico de tempo. Esta hipótese pode ser traduzida na função matemática, onde leva a -

Y = A + Bx

Onde Y são vendas, x é a despesa com publicidade, A e B são constantes.

Depois de traduzir a hipótese na função, a base para isso é encontrar a relação entre as variáveis dependentes e independentes. O valor da variável dependente é da maior importância para os pesquisadores e depende do valor de outras variáveis. A variável independente é usada para explicar a variação na variável dependente. Pode ser classificado em dois tipos -

Simple regression - Uma variável independente

Multiple regression - Várias variáveis independentes

Regressão Simples

A seguir estão as etapas para construir a análise de regressão -

- Especifique o modelo de regressão

- Obtenha dados sobre as variáveis

- Estimar as relações quantitativas

- Teste a significância estatística dos resultados

- Uso de resultados na tomada de decisão

A fórmula para regressão simples é -

Y = a + bX + u

Y= variável dependente

X= variável independente

a= interceptar

b= declive

u= fator aleatório

Os dados de seção transversal fornecem informações sobre um grupo de entidades em um determinado momento, enquanto os dados de série temporal fornecem informações sobre uma entidade ao longo do tempo. Quando estimamos a equação de regressão, ela envolve o processo de descobrir a melhor relação linear entre as variáveis dependentes e independentes.

Método dos mínimos quadrados ordinários (OLS)

O método dos mínimos quadrados ordinários é projetado para ajustar uma linha através de uma dispersão de pontos de forma que a soma dos desvios quadrados dos pontos da linha seja minimizada. É um método estatístico. Normalmente, os pacotes de software realizam a estimativa OLS.

Y = a + bX

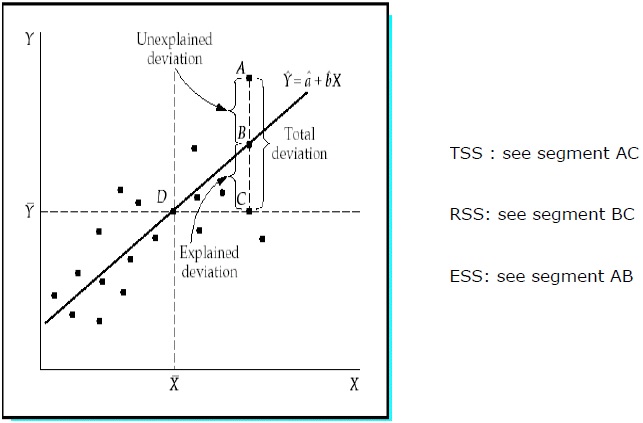

Coeficiente de determinação (R 2 )

O coeficiente de determinação é uma medida que indica que o percentual da variação na variável dependente se deve às variações nas variáveis independentes. R 2 é uma medida da qualidade do modelo de ajuste. A seguir estão os métodos -

Soma total dos quadrados (TSS)

Soma dos desvios quadrados dos valores da amostra de Y da média de Y.

TSS = SUM ( Yi − Y)2

Yi = variáveis dependentes

Y = média das variáveis dependentes

i = número de observações

Soma de regressão dos quadrados (RSS)

Soma dos desvios quadrados dos valores estimados de Y da média de Y.

RSS = SUM ( Ỷi − uY)2

Ỷi = valor estimado de Y

Y = média das variáveis dependentes

i = número de variações

Soma do erro dos quadrados (ESS)

Soma dos desvios quadrados dos valores da amostra de Y dos valores estimados de Y.

ESS = SUM ( Yi − Ỷi)2

Ỷi = valor estimado de Y

Yi = variáveis dependentes

i = número de observações

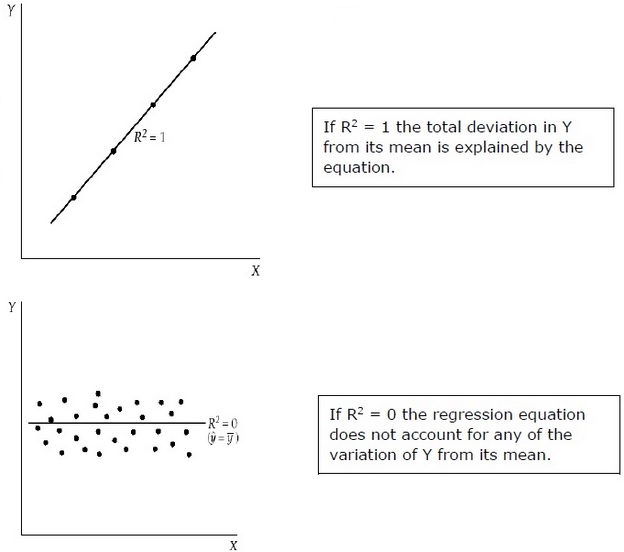

R 2 mede a proporção do desvio total de Y de sua média, que é explicado pelo modelo de regressão. Quanto mais próximo o R 2 estiver da unidade, maior será o poder explicativo da equação de regressão. Um R 2 próximo a 0 indica que a equação de regressão terá muito pouco poder explicativo.

Para avaliar os coeficientes de regressão, uma amostra da população é usada em vez de toda a população. É importante fazer suposições sobre a população com base na amostra e fazer um julgamento sobre o quão boas são essas suposições.

Avaliando os Coeficientes de Regressão

Cada amostra da população gera sua própria interceptação. Para calcular a diferença estatística, os seguintes métodos podem ser usados -

Two tailed test −

Hipótese nula: H 0 : b = 0

Hipótese alternativa: H a : b ≠ 0

One tailed test −

Hipótese nula: H 0 : b> 0 (ou b <0)

Hipótese alternativa: H a : b <0 (ou b> 0)

Statistic Test −

b = coeficiente estimado

E (b) = b = 0 (hipótese nula)

SE b = erro padrão do coeficiente

.Valor de tdepende do grau de liberdade, um ou dois testes reprovados e nível de significância. Para determinar o valor crítico det, a tabela t pode ser usada. Em seguida, vem a comparação do valor t com o valor crítico. É necessário rejeitar a hipótese nula se o valor absoluto do teste estatístico for maior ou igual ao valor t crítico. Não rejeite a hipótese nula, I o valor absoluto do teste estatístico é menor que o valor t crítico.

Múltiplas análises de regressão

Ao contrário da regressão simples na análise de regressão múltipla, os coeficientes indicam a mudança nas variáveis dependentes assumindo que os valores das outras variáveis são constantes.

O teste de significância estatística é chamado F-test. O teste F é útil porque mede a significância estatística de toda a equação de regressão, e não apenas para um indivíduo. Aqui, na hipótese nula, não há relação entre a variável dependente e as variáveis independentes da população.

A fórmula é - H 0 : b1 = b2 = b3 =…. = bk = 0

Não existe relação entre a variável dependente e o k variáveis independentes para a população.

F-test static −

$$ F \: = \: \ frac {\ left (\ frac {R ^ 2} {K} \ right)} {\ frac {(1-R ^ 2)} {(nk-1)}} $$

Valor crítico de Fdepende do numerador e do denominador do grau de liberdade e do nível de significância. A tabela F pode ser usada para determinar o valor F crítico. Em comparação com o valor F com o valor crítico (F *) -

Se F> F *, precisamos rejeitar a hipótese nula.

Se F <F *, não rejeite a hipótese nula, pois não há relação significativa entre a variável dependente e todas as variáveis independentes.