人工ニューラルネットワーク-基本概念

ニューラルネットワークは並列コンピューティングデバイスであり、基本的には脳のコンピューターモデルを作成する試みです。主な目的は、従来のシステムよりも高速にさまざまな計算タスクを実行するシステムを開発することです。これらのタスクには、パターン認識と分類、近似、最適化、およびデータクラスタリングが含まれます。

人工ニューラルネットワークとは何ですか?

人工ニューラルネットワーク(ANN)は、生物学的ニューラルネットワークのアナロジーから中心的なテーマを借りた効率的なコンピューティングシステムです。ANNは、「人工ニューラルシステム」、「並列分散処理システム」、または「コネクショニストシステム」とも呼ばれます。ANNは、ユニット間の通信を可能にするために、何らかのパターンで相互接続されたユニットの大規模なコレクションを取得します。これらのユニットは、ノードまたはニューロンとも呼ばれ、並列に動作する単純なプロセッサです。

すべてのニューロンは、接続リンクを介して他のニューロンと接続されています。各接続リンクは、入力信号に関する情報を持つウェイトに関連付けられています。重みは通常、伝達されている信号を励起または阻害するため、これはニューロンが特定の問題を解決するための最も有用な情報です。各ニューロンには、活性化信号と呼ばれる内部状態があります。入力信号とアクティベーションルールを組み合わせた後に生成される出力信号は、他のユニットに送信される場合があります。

ANNの簡単な歴史

ANNの歴史は次の3つの時代に分けることができます-

1940年代から1960年代のANN

この時代のいくつかの重要な進展は次のとおりです-

1943 −ニューラルネットワークの概念は、生理学者のウォーレンマカロックと数学者のウォルターピッツの研究から始まったと考えられています。1943年に、脳内のニューロンがどのように機能するかを説明するために、電気回路を使用して単純なニューラルネットワークをモデル化しました。 。

1949−ドナルド・ヘッブの著書「行動の組織」は、あるニューロンを別のニューロンが繰り返し活性化すると、使用するたびにその強度が増すという事実を示しています。

1956 −連想記憶ネットワークはテイラーによって導入されました。

1958 −パーセプトロンという名前のマッカロックとピッツのニューロンモデルの学習方法は、ローゼンブラットによって発明されました。

1960 − BernardWidrowとMarcianHoffは、「ADALINE」と「MADALINE」と呼ばれるモデルを開発しました。

1960年代から1980年代のANN

この時代のいくつかの重要な進展は次のとおりです-

1961 − Rosenblattは試みに失敗しましたが、多層ネットワークの「バックプロパゲーション」スキームを提案しました。

1964 −テイラーは、出力ユニット間の抑制を備えた勝者取り回路を構築しました。

1969 −多層パーセプトロン(MLP)は、ミンスキーとパパートによって発明されました。

1971 −コホネンは連想記憶を発達させた。

1976 − StephenGrossbergとGailCarpenterは、適応共鳴理論を開発しました。

1980年代から現在までのANN

この時代のいくつかの重要な進展は次のとおりです-

1982 −主な開発はホップフィールドのエネルギーアプローチでした。

1985 −ボルツマンマシンは、Ackley、Hinton、およびSejnowskiによって開発されました。

1986 − Rumelhart、Hinton、およびWilliamsは、一般化されたデルタルールを導入しました。

1988 − KoskoはBinaryAssociative Memory(BAM)を開発し、ANNでファジー論理の概念も提供しました。

歴史的なレビューは、この分野で大きな進歩があったことを示しています。ニューラルネットワークベースのチップが出現し、複雑な問題へのアプリケーションが開発されています。確かに、今日はニューラルネットワーク技術の移行期です。

生物学的ニューロン

神経細胞(ニューロン)は、情報を処理する特殊な生体細胞です。推定によれば、約10ニューロンの膨大な数がある11、約10、多数の相互接続とを15。

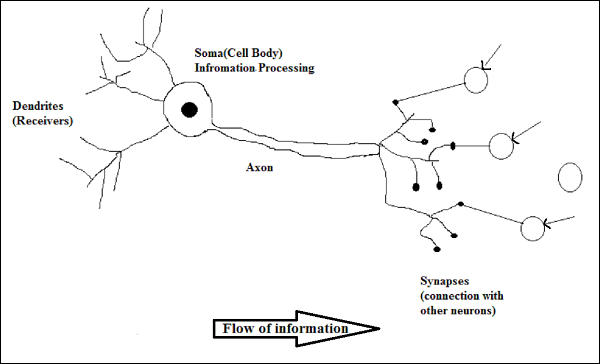

回路図

生物学的ニューロンの働き

上の図に示されているように、典型的なニューロンは次の4つの部分で構成されており、その働きを説明することができます。

Dendrites−それらは木のような枝であり、接続されている他のニューロンから情報を受け取る役割を果たします。別の意味では、それらはニューロンの耳のようなものであると言えます。

Soma −それはニューロンの細胞体であり、樹状突起から受け取った情報の処理を担当します。

Axon −ニューロンが情報を送信するケーブルのようなものです。

Synapses −それは軸索と他のニューロン樹状突起の間の接続です。

ANN対BNN

人工ニューラルネットワーク(ANN)と生物学的ニューラルネットワーク(BNN)の違いを見る前に、これら2つの用語に基づいた類似点を見てみましょう。

| 生物学的ニューラルネットワーク(BNN) | 人工ニューラルネットワーク(ANN) |

|---|---|

| 相馬 | ノード |

| 樹状突起 | 入力 |

| シナプス | 重みまたは相互接続 |

| アクソン | 出力 |

次の表は、言及されたいくつかの基準に基づくANNとBNNの比較を示しています。

| 基準 | BNN | ANN |

|---|---|---|

| Processing | 超並列、低速ですがANNより優れています | 超並列、高速ですが、BNNより劣っています |

| Size | 10個の11のニューロンと10本の15配線 | 10 2 10へ4ノード(主にアプリケーションとネットワーク設計者のタイプに依存) |

| Learning | 彼らは曖昧さを許容することができます | あいまいさを許容するには、非常に正確で構造化され、フォーマットされたデータが必要です |

| Fault tolerance | 部分的な損傷でもパフォーマンスが低下します | 堅牢なパフォーマンスが可能なため、フォールトトレラントになる可能性があります |

| Storage capacity | シナプスに情報を保存します | 情報を連続したメモリ位置に保存します |

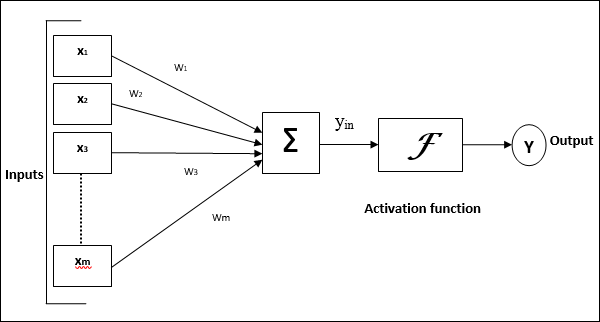

人工ニューラルネットワークのモデル

次の図は、ANNの一般的なモデルとそれに続く処理を表しています。

上記の人工ニューラルネットワークの一般的なモデルの場合、正味入力は次のように計算できます。

$$ y_ {in} \:= \:x_ {1} .w_ {1} \:+ \:x_ {2} .w_ {2} \:+ \:x_ {3}。w_{3} \: \ dotso \:x_ {m} .w_ {m} $$

つまり、ネット入力$ y_ {in} \:= \:\ sum_i ^ m \:x_ {i} .w_ {i} $

出力は、ネット入力に活性化関数を適用することで計算できます。

$$ Y \:= \:F(y_ {in})$$

出力=関数(計算された正味入力)