Sztuczna sieć neuronowa - podstawowe pojęcia

Sieci neuronowe to równoległe urządzenia obliczeniowe, które w zasadzie są próbą stworzenia komputerowego modelu mózgu. Głównym celem jest opracowanie systemu do wykonywania różnych zadań obliczeniowych szybciej niż systemy tradycyjne. Zadania te obejmują rozpoznawanie i klasyfikację wzorców, aproksymację, optymalizację i grupowanie danych.

Co to jest sztuczna sieć neuronowa?

Sztuczna sieć neuronowa (ANN) to wydajny system obliczeniowy, którego motyw przewodni został zapożyczony z analogii biologicznych sieci neuronowych. SSN są również nazywane „sztucznymi systemami neuronowymi”, „równoległymi systemami przetwarzania rozproszonego” lub „systemami koneksjonistycznymi”. ANN pozyskuje duży zbiór jednostek, które są ze sobą połączone w pewien sposób, aby umożliwić komunikację między jednostkami. Jednostki te, nazywane również węzłami lub neuronami, to proste procesory działające równolegle.

Każdy neuron jest połączony z innym neuronem za pomocą łącza. Każdemu łączu przypisana jest waga zawierająca informacje o sygnale wejściowym. Jest to najbardziej przydatna informacja dla neuronów do rozwiązania konkretnego problemu, ponieważ ciężar zwykle pobudza lub hamuje przekazywany sygnał. Każdy neuron ma stan wewnętrzny, który nazywany jest sygnałem aktywacji. Sygnały wyjściowe, które powstają po połączeniu sygnałów wejściowych i reguły zadziałania, mogą być wysyłane do innych jednostek.

Krótka historia ANN

Historię SSN można podzielić na następujące trzy epoki -

ANN w latach czterdziestych do sześćdziesiątych XX wieku

Oto niektóre kluczowe wydarzenia z tej epoki -

1943 - Założono, że koncepcja sieci neuronowej zapoczątkowała pracę fizjologa Warrena McCullocha i matematyka Waltera Pittsa, kiedy w 1943 r. Modelowali prostą sieć neuronową za pomocą obwodów elektrycznych, aby opisać, jak mogą działać neurony w mózgu .

1949- W książce Donalda Hebba The Organization of Behavior wysunięto fakt, że wielokrotna aktywacja jednego neuronu przez inny zwiększa jego siłę za każdym razem, gdy są używane.

1956 - Sieć pamięci asocjacyjnej została wprowadzona przez Taylora.

1958 - Metoda uczenia się modelu neuronów McCullocha i Pittsa o nazwie Perceptron została wynaleziona przez Rosenblatta.

1960 - Bernard Widrow i Marcian Hoff opracowali modele nazwane „ADALINE” i „MADALINE”.

ANN w latach 1960-1980

Oto niektóre kluczowe wydarzenia z tej epoki -

1961 - Rosenblatt podjął nieudaną próbę, ale zaproponował schemat „wstecznej propagacji” sieci wielowarstwowych.

1964 - Taylor skonstruował obwód zwycięzca bierze wszystko z zahamowaniami między jednostkami wyjściowymi.

1969 - Perceptron wielowarstwowy (MLP) został wynaleziony przez Minsky'ego i Paperta.

1971 - Kohonen rozwinął wspomnienia asocjacyjne.

1976 - Stephen Grossberg i Gail Carpenter opracowali adaptacyjną teorię rezonansu.

ANN od 1980 do chwili obecnej

Oto niektóre kluczowe wydarzenia z tej epoki -

1982 - Głównym osiągnięciem było podejście Hopfielda do energii.

1985 - Maszyna Boltzmanna została opracowana przez Ackleya, Hintona i Sejnowskiego.

1986 - Rumelhart, Hinton i Williams wprowadzili uogólnioną regułę delta.

1988 - Kosko opracował Binary Associative Memory (BAM), a także przedstawił koncepcję Fuzzy Logic w SSN.

Z przeglądu historycznego wynika, że w tej dziedzinie poczyniono znaczne postępy. Pojawiają się chipy oparte na sieciach neuronowych i opracowywane są aplikacje do rozwiązywania złożonych problemów. Z pewnością dzisiaj jest okres przejściowy dla technologii sieci neuronowych.

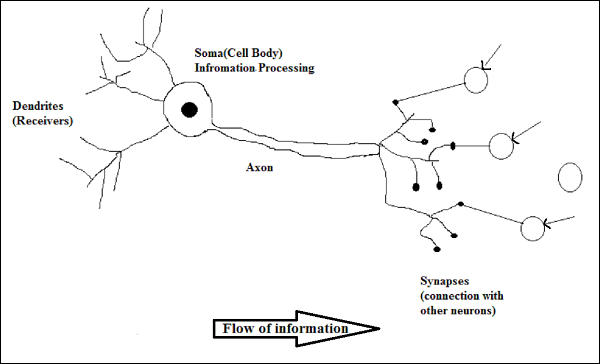

Biological Neuron

Komórka nerwowa (neuron) to specjalna komórka biologiczna, która przetwarza informacje. Według szacunków istnieje ogromna liczba neuronów, około 10 11 z licznymi połączeniami, około 10 15 .

Schemat

Działanie neuronu biologicznego

Jak pokazano na powyższym schemacie, typowy neuron składa się z następujących czterech części, za pomocą których możemy wyjaśnić jego działanie -

Dendrites- Są to gałęzie przypominające drzewo, odpowiedzialne za odbieranie informacji od innych neuronów, z którymi jest połączony. W innym sensie możemy powiedzieć, że są jak uszy neuronu.

Soma - Jest to ciało komórkowe neuronu i odpowiada za przetwarzanie informacji, które otrzymały z dendrytów.

Axon - To jest jak kabel, przez który neurony przesyłają informacje.

Synapses - Jest to połączenie między aksonem a innymi dendrytami neuronów.

ANN kontra BNN

Zanim przyjrzymy się różnicom między sztuczną siecią neuronową (ANN) a biologiczną siecią neuronową (BNN), przyjrzyjmy się podobieństwom opartym na terminologii między nimi.

| Biologiczna sieć neuronowa (BNN) | Sztuczna sieć neuronowa (ANN) |

|---|---|

| Soma | Węzeł |

| Dendryty | Wejście |

| Synapsa | Wagi lub połączenia międzysystemowe |

| Axon | Wynik |

Poniższa tabela przedstawia porównanie ANN i BNN na podstawie niektórych wymienionych kryteriów.

| Kryteria | BNN | ANN |

|---|---|---|

| Processing | Masywnie równoległe, powolne, ale lepsze niż ANN | Masywnie równoległe, szybkie, ale gorsze niż BNN |

| Size | 10 11 neuronów i 10 15 połączeń | 10 2 do 10 4 węzłów (zależy głównie od typu aplikacji i projektanta sieci) |

| Learning | Potrafią tolerować dwuznaczność | Aby tolerować niejednoznaczność, wymagane są bardzo precyzyjne, ustrukturyzowane i sformatowane dane |

| Fault tolerance | Wydajność spada nawet z częściowym uszkodzeniem | Jest zdolny do solidnej wydajności, dlatego może być odporny na uszkodzenia |

| Storage capacity | Przechowuje informacje w synapsie | Przechowuje informacje w ciągłych lokalizacjach pamięci |

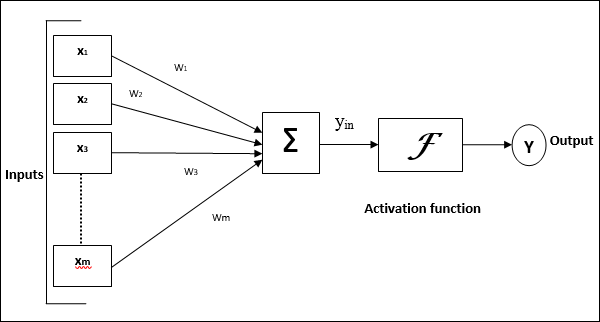

Model sztucznej sieci neuronowej

Poniższy diagram przedstawia ogólny model SSN, po którym następuje jego przetwarzanie.

Dla powyższego ogólnego modelu sztucznej sieci neuronowej wejście netto można obliczyć w następujący sposób -

$$ y_ {in} \: = \: x_ {1} .w_ {1} \: + \: x_ {2} .w_ {2} \: + \: x_ {3} .w_ {3} \: \ dotso \: x_ {m.} .w_ {m.} $$

tj. wejście netto $ y_ {in} \: = \: \ sum_i ^ m \: x_ {i} .w_ {i} $

Wyjście można obliczyć, stosując funkcję aktywacji na wejściu netto.

$$ Y \: = \: F (y_ {in}) $$

Wyjście = funkcja (obliczony wkład netto)