Sztuczna sieć neuronowa - bloki konstrukcyjne

Przetwarzanie SSN zależy od następujących trzech elementów składowych -

- Topologia sieci

- Korekty wag lub nauka

- Funkcje aktywacji

W tym rozdziale omówimy szczegółowo te trzy elementy składowe SSN

Topologia sieci

Topologia sieci to układ sieci wraz z jej węzłami i liniami łączącymi. Zgodnie z topologią SSN można podzielić na następujące rodzaje -

Sieć przekazująca

Jest to sieć jednorazowa, w której jednostki przetwarzania / węzły są ułożone w warstwach, a wszystkie węzły w warstwie są połączone z węzłami warstw poprzednich. Połączenie ma różną wagę. Brak pętli sprzężenia zwrotnego oznacza, że sygnał może przepływać tylko w jednym kierunku, od wejścia do wyjścia. Można go podzielić na dwa następujące typy -

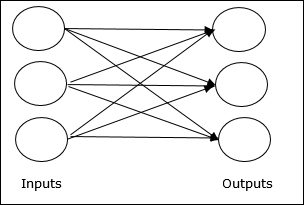

Single layer feedforward network- Koncepcja jest oparta na sprzężeniu zwrotnym ANN, który ma tylko jedną ważoną warstwę. Innymi słowy, możemy powiedzieć, że warstwa wejściowa jest w pełni połączona z warstwą wyjściową.

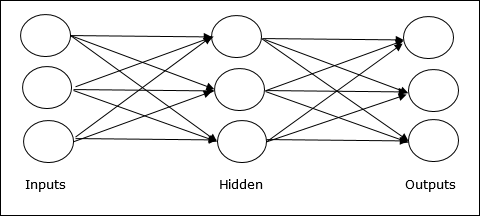

Multilayer feedforward network- Koncepcja jest oparta na sprzężeniu zwrotnym ANN mającym więcej niż jedną ważoną warstwę. Ponieważ ta sieć ma jedną lub więcej warstw między warstwą wejściową a wyjściową, nazywa się ją warstwami ukrytymi.

Sieć opinii

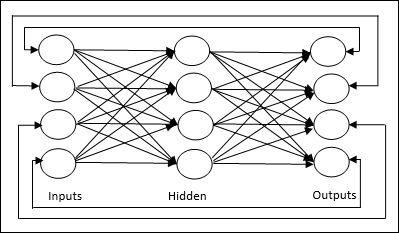

Jak sama nazwa wskazuje, sieć sprzężenia zwrotnego ma ścieżki sprzężenia zwrotnego, co oznacza, że sygnał może płynąć w obu kierunkach za pomocą pętli. To sprawia, że jest to nieliniowy układ dynamiczny, który zmienia się w sposób ciągły, aż do osiągnięcia stanu równowagi. Można go podzielić na następujące typy -

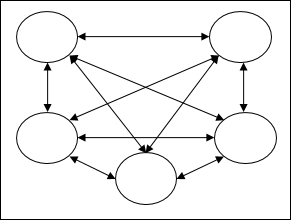

Recurrent networks- Są to sieci informacji zwrotnej z zamkniętymi pętlami. Poniżej przedstawiono dwa typy powtarzających się sieci.

Fully recurrent network - Jest to najprostsza architektura sieci neuronowej, ponieważ wszystkie węzły są połączone ze wszystkimi innymi, a każdy węzeł działa zarówno jako wejście, jak i wyjście.

Jordan network - Jest to sieć z zamkniętą pętlą, w której wyjście będzie ponownie przesyłane do wejścia jako sprzężenie zwrotne, jak pokazano na poniższym schemacie.

Korekty wag lub nauka

Uczenie się w sztucznej sieci neuronowej jest metodą modyfikowania wag połączeń między neuronami określonej sieci. Uczenie się w SSN można podzielić na trzy kategorie: uczenie się nadzorowane, uczenie się bez nadzoru i uczenie się ze wzmocnieniem.

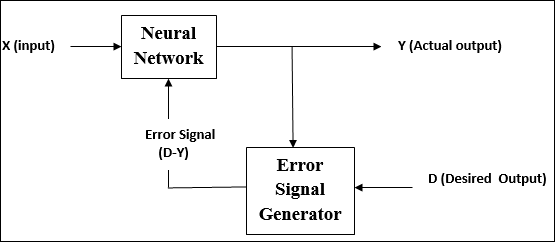

Nadzorowana nauka

Jak sama nazwa wskazuje, ten rodzaj nauki odbywa się pod okiem nauczyciela. Ten proces uczenia się jest zależny.

Podczas uczenia SSN w ramach uczenia nadzorowanego wektor wejściowy jest prezentowany w sieci, co daje wektor wyjściowy. Ten wektor wyjściowy jest porównywany z pożądanym wektorem wyjściowym. Sygnał błędu jest generowany, jeśli istnieje różnica między rzeczywistym wyjściem a żądanym wektorem wyjściowym. Na podstawie tego sygnału błędu wagi są korygowane, aż rzeczywista moc wyjściowa zostanie dopasowana do żądanej mocy.

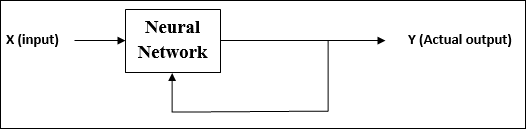

Uczenie się bez nadzoru

Jak sama nazwa wskazuje, ten rodzaj nauki odbywa się bez nadzoru nauczyciela. Ten proces uczenia się jest niezależny.

Podczas uczenia SSN w ramach uczenia się bez nadzoru wektory wejściowe podobnego typu są łączone w klastry. Po zastosowaniu nowego wzorca wejściowego sieć neuronowa daje odpowiedź wyjściową wskazującą klasę, do której należy wzorzec wejściowy.

Nie ma informacji zwrotnej ze środowiska, co powinno być pożądanym wyjściem i czy jest poprawne lub niepoprawne. Dlatego w tego typu uczeniu się sama sieć musi odkryć wzorce i cechy z danych wejściowych oraz relację danych wejściowych do danych wyjściowych.

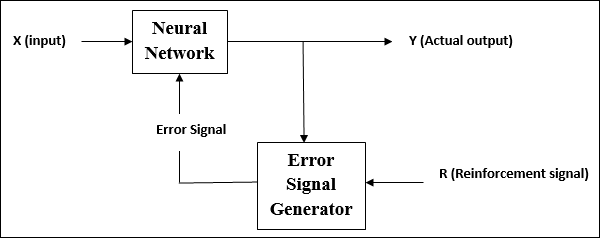

Uczenie się ze wzmocnieniem

Jak sama nazwa wskazuje, ten rodzaj uczenia się służy do wzmacniania lub wzmacniania sieci w zakresie niektórych krytycznych informacji. Ten proces uczenia się jest podobny do nadzorowanego uczenia się, jednak możemy mieć bardzo mniej informacji.

Podczas szkolenia sieci w ramach uczenia się przez wzmacnianie, sieć otrzymuje informacje zwrotne od środowiska. To sprawia, że jest trochę podobny do nadzorowanego uczenia się. Jednak uzyskana tutaj informacja zwrotna ma charakter ewaluacyjny, a nie pouczający, co oznacza, że nie ma nauczyciela takiego jak w uczeniu się nadzorowanym. Po otrzymaniu informacji zwrotnej sieć dokonuje korekty wag, aby w przyszłości uzyskać lepsze informacje o krytykach.

Funkcje aktywacji

Można to zdefiniować jako dodatkową siłę lub wysiłek zastosowany na wejściu w celu uzyskania dokładnego wyniku. W ANN możemy również zastosować funkcje aktywacji na wejściu, aby uzyskać dokładny wynik. Poniżej przedstawiono niektóre interesujące funkcje aktywacji -

Liniowa funkcja aktywacji

Jest również nazywany funkcją identyfikacji, ponieważ nie wykonuje edycji danych wejściowych. Można go zdefiniować jako -

$$ F (x) \: = \: x $$

Funkcja aktywacji esicy

Jest dwojakiego rodzaju:

Binary sigmoidal function- Ta funkcja aktywacji przeprowadza edycję danych wejściowych od 0 do 1. Ma charakter pozytywny. Jest zawsze ograniczony, co oznacza, że jego moc wyjściowa nie może być mniejsza niż 0 i większa niż 1. Ma również charakter ściśle rosnący, co oznacza, że większy wkład byłby wyjściem. Można go zdefiniować jako

$$ F (x) \: = \: sigm (x) \: = \: \ frac {1} {1 \: + \: exp (-x)} $$

Bipolar sigmoidal function- Ta funkcja aktywacji wykonuje edycję danych wejściowych w zakresie od -1 do 1. Może mieć charakter pozytywny lub negatywny. Jest zawsze ograniczony, co oznacza, że jego wartość wyjściowa nie może być mniejsza niż -1 i większa niż 1. Ma również charakter ściśle rosnący, podobnie jak funkcja sigmoidalna. Można go zdefiniować jako

$$ F (x) \: = \: sigm (x) \: = \: \ frac {2} {1 \: + \: exp (-x)} \: - \: 1 \: = \: \ frac {1 \: - \: exp (x)} {1 \: + \: exp (x)} $$