Zalecenia dotyczące treningu sieci neuronowych

W tym rozdziale zrozumiemy różne aspekty uczenia sieci neuronowej, które można wdrożyć za pomocą frameworka TensorFlow.

Oto dziesięć zaleceń, które można ocenić:

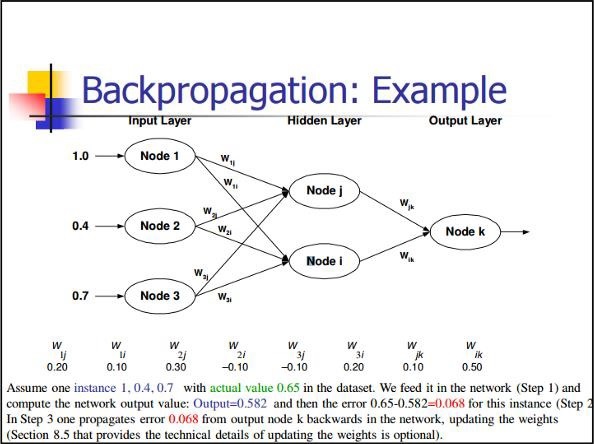

Back Propagation

Propagacja wsteczna jest prostą metodą obliczania pochodnych cząstkowych, która obejmuje podstawową postać składu najlepiej nadającą się do sieci neuronowych.

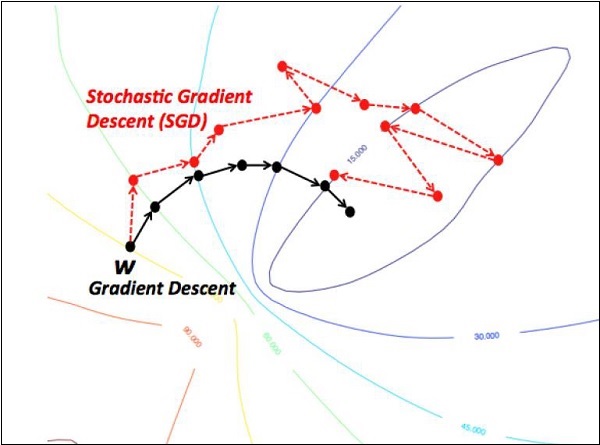

Stochastyczne zejście gradientowe

W stochastycznym spadku po gradiencie a batchto całkowita liczba przykładów, których użytkownik używa do obliczenia gradientu w jednej iteracji. Do tej pory przyjmuje się, że partia to cały zbiór danych. Najlepsza ilustracja działa w skali Google; zbiory danych często zawierają miliardy, a nawet setki miliardów przykładów.

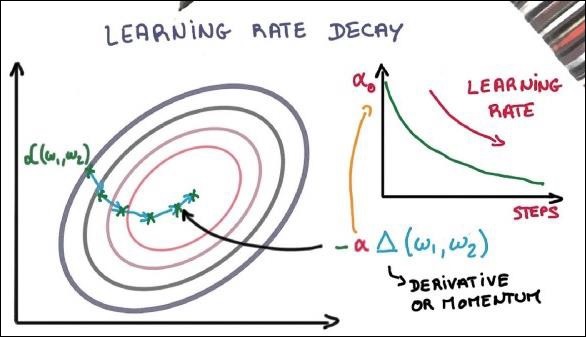

Spadek szybkości uczenia się

Dostosowanie tempa uczenia się jest jedną z najważniejszych cech optymalizacji zejścia gradientowego. Ma to kluczowe znaczenie dla implementacji TensorFlow.

Spadkowicz

Głębokie sieci neuronowe z dużą liczbą parametrów tworzą potężne systemy uczenia maszynowego. Jednak nadmierne dopasowanie jest poważnym problemem w takich sieciach.

Max Pooling

Max pooling to proces dyskretyzacji oparty na próbkach. Celem jest pobranie próbki reprezentacji wejściowej w dół, co zmniejsza wymiarowość przy wymaganych założeniach.

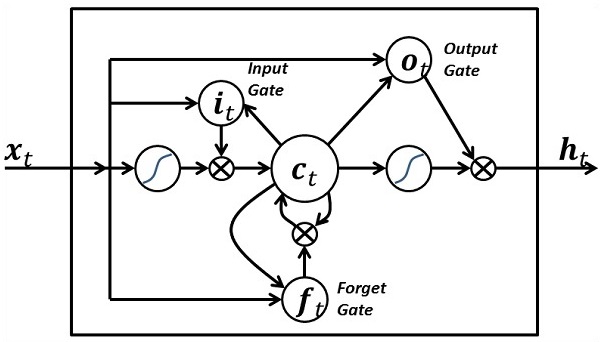

Pamięć długoterminowa (LSTM)

LSTM kontroluje decyzję, jakie dane wejściowe należy podjąć w ramach określonego neuronu. Obejmuje kontrolę nad decydowaniem o tym, co należy obliczyć i jakie dane wyjściowe mają zostać wygenerowane.