Künstliches Neuronales Netz - Grundkonzepte

Neuronale Netze sind parallele Computergeräte, was im Grunde ein Versuch ist, ein Computermodell des Gehirns zu erstellen. Das Hauptziel besteht darin, ein System zu entwickeln, mit dem verschiedene Rechenaufgaben schneller als mit herkömmlichen Systemen ausgeführt werden können. Diese Aufgaben umfassen Mustererkennung und -klassifizierung, Approximation, Optimierung und Datenclustering.

Was ist ein künstliches neuronales Netzwerk?

Das künstliche neuronale Netz (ANN) ist ein effizientes Computersystem, dessen zentrales Thema der Analogie biologischer neuronaler Netze entlehnt ist. ANNs werden auch als "künstliche neuronale Systeme" oder "parallel verteilte Verarbeitungssysteme" oder "verbindungsorientierte Systeme" bezeichnet. ANN erwirbt eine große Sammlung von Einheiten, die in einem bestimmten Muster miteinander verbunden sind, um die Kommunikation zwischen den Einheiten zu ermöglichen. Diese Einheiten, auch als Knoten oder Neuronen bezeichnet, sind einfache Prozessoren, die parallel arbeiten.

Jedes Neuron ist über eine Verbindungsverbindung mit einem anderen Neuron verbunden. Jeder Verbindungsverbindung ist ein Gewicht zugeordnet, das Informationen über das Eingangssignal enthält. Dies ist die nützlichste Information für Neuronen, um ein bestimmtes Problem zu lösen, da das Gewicht normalerweise das übertragene Signal anregt oder hemmt. Jedes Neuron hat einen internen Zustand, der als Aktivierungssignal bezeichnet wird. Ausgangssignale, die nach dem Kombinieren der Eingangssignale und der Aktivierungsregel erzeugt werden, können an andere Einheiten gesendet werden.

Eine kurze Geschichte von ANN

Die Geschichte von ANN kann in die folgenden drei Epochen unterteilt werden:

ANN in den 1940er bis 1960er Jahren

Einige Schlüsselentwicklungen dieser Ära sind wie folgt:

1943 - Es wurde angenommen, dass das Konzept des neuronalen Netzwerks mit der Arbeit des Physiologen Warren McCulloch und des Mathematikers Walter Pitts begann, als sie 1943 ein einfaches neuronales Netzwerk unter Verwendung elektrischer Schaltkreise modellierten, um zu beschreiben, wie Neuronen im Gehirn funktionieren könnten .

1949- Donald Hebbs Buch The Organization of Behavior ( Die Organisation des Verhaltens) hat die Tatsache hervorgehoben, dass die wiederholte Aktivierung eines Neurons durch ein anderes seine Stärke bei jeder Verwendung erhöht.

1956 - Taylor hat ein assoziatives Speichernetzwerk eingeführt.

1958 - Eine Lernmethode für das McCulloch- und Pitts-Neuronenmodell namens Perceptron wurde von Rosenblatt erfunden.

1960 - Bernard Widrow und Marcian Hoff entwickelten Modelle mit den Namen "ADALINE" und "MADALINE".

ANN in den 1960er bis 1980er Jahren

Einige Schlüsselentwicklungen dieser Ära sind wie folgt:

1961 - Rosenblatt unternahm einen erfolglosen Versuch, schlug jedoch das "Backpropagation" -Schema für mehrschichtige Netzwerke vor.

1964 - Taylor konstruierte eine Winner-Take-All-Schaltung mit Hemmungen zwischen den Ausgabeeinheiten.

1969 - Multilayer Perceptron (MLP) wurde von Minsky und Papert erfunden.

1971 - Kohonen entwickelte assoziative Erinnerungen.

1976 - Stephen Grossberg und Gail Carpenter entwickelten die adaptive Resonanztheorie.

ANN von 1980 bis heute

Einige Schlüsselentwicklungen dieser Ära sind wie folgt:

1982 - Die Hauptentwicklung war der Energieansatz von Hopfield.

1985 - Die Boltzmann-Maschine wurde von Ackley, Hinton und Sejnowski entwickelt.

1986 - Rumelhart, Hinton und Williams führten die Generalized Delta Rule ein.

1988 - Kosko entwickelte das Binary Associative Memory (BAM) und gab das Konzept der Fuzzy Logic in ANN bekannt.

Der historische Rückblick zeigt, dass in diesem Bereich erhebliche Fortschritte erzielt wurden. Auf neuronalen Netzen basierende Chips entstehen und Anwendungen für komplexe Probleme werden entwickelt. Sicherlich ist heute eine Übergangsphase für die neuronale Netzwerktechnologie.

Biologisches Neuron

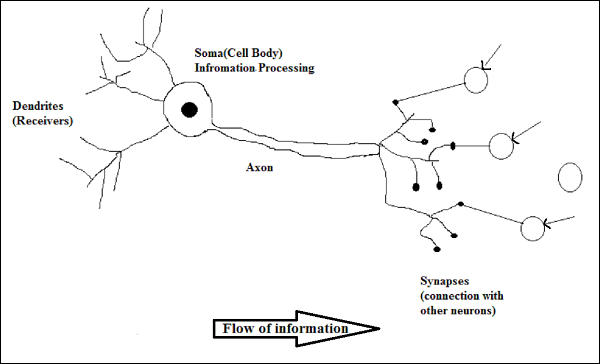

Eine Nervenzelle (Neuron) ist eine spezielle biologische Zelle, die Informationen verarbeitet. Nach einer Schätzung gibt es eine große Anzahl von Neuronen, ungefähr 10 11 mit zahlreichen Verbindungen, ungefähr 10 15 .

Schematische Darstellung

Arbeiten eines biologischen Neurons

Wie im obigen Diagramm gezeigt, besteht ein typisches Neuron aus den folgenden vier Teilen, mit deren Hilfe wir seine Funktionsweise erklären können:

Dendrites- Sie sind baumartige Zweige, die für den Empfang der Informationen von anderen Neuronen verantwortlich sind, mit denen sie verbunden sind. In einem anderen Sinne können wir sagen, dass sie wie die Ohren von Neuronen sind.

Soma - Es ist der Zellkörper des Neurons und verantwortlich für die Verarbeitung von Informationen, die sie von Dendriten erhalten haben.

Axon - Es ist wie ein Kabel, über das Neuronen die Informationen senden.

Synapses - Es ist die Verbindung zwischen dem Axon und anderen Neuronendendriten.

ANN gegen BNN

Bevor wir uns die Unterschiede zwischen dem künstlichen neuronalen Netzwerk (ANN) und dem biologischen neuronalen Netzwerk (BNN) ansehen, wollen wir uns die Ähnlichkeiten ansehen, die auf der Terminologie zwischen diesen beiden basieren.

| Biologisches Neuronales Netz (BNN) | Künstliches Neuronales Netz (ANN) |

|---|---|

| Soma | Knoten |

| Dendriten | Eingang |

| Synapse | Gewichte oder Verbindungen |

| Axon | Ausgabe |

Die folgende Tabelle zeigt den Vergleich zwischen ANN und BNN anhand einiger genannter Kriterien.

| Kriterien | BNN | ANN |

|---|---|---|

| Processing | Massiv parallel, langsam, aber überlegen als ANN | Massiv parallel, schnell, aber schlechter als BNN |

| Size | 10 11 Neuronen und 10 15 Verbindungen | 10 2 bis 10 4 Knoten (hängt hauptsächlich von der Art der Anwendung und dem Netzwerkdesigner ab) |

| Learning | Sie können Mehrdeutigkeiten tolerieren | Um Mehrdeutigkeiten zu tolerieren, sind sehr genaue, strukturierte und formatierte Daten erforderlich |

| Fault tolerance | Die Leistung verschlechtert sich bereits bei teilweisem Schaden | Es ist zu einer robusten Leistung fähig und kann daher fehlertolerant sein |

| Storage capacity | Speichert die Informationen in der Synapse | Speichert die Informationen an fortlaufenden Speicherorten |

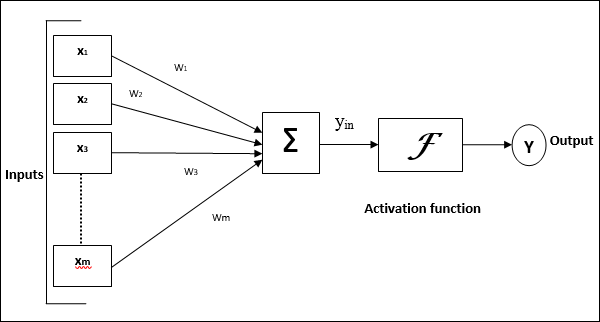

Modell eines künstlichen neuronalen Netzwerks

Das folgende Diagramm zeigt das allgemeine Modell von ANN, gefolgt von seiner Verarbeitung.

Für das obige allgemeine Modell eines künstlichen neuronalen Netzwerks kann die Nettoeingabe wie folgt berechnet werden:

$$ y_ {in} \: = \: x_ {1} .w_ {1} \: + \: x_ {2} .w_ {2} \: + \: x_ {3} .w_ {3} \: \ dotso \: x_ {m} .w_ {m} $$

dh Nettoeingabe $ y_ {in} \: = \: \ sum_i ^ m \: x_ {i} .w_ {i} $

Die Ausgabe kann berechnet werden, indem die Aktivierungsfunktion auf die Nettoeingabe angewendet wird.

$$ Y \: = \: F (y_ {in}) $$

Output = Funktion (Nettoeingang berechnet)