Recomendaciones para el entrenamiento de redes neuronales

En este capítulo, comprenderemos los diversos aspectos del entrenamiento de redes neuronales que se pueden implementar con el marco de trabajo de TensorFlow.

A continuación se presentan las diez recomendaciones, que pueden evaluarse:

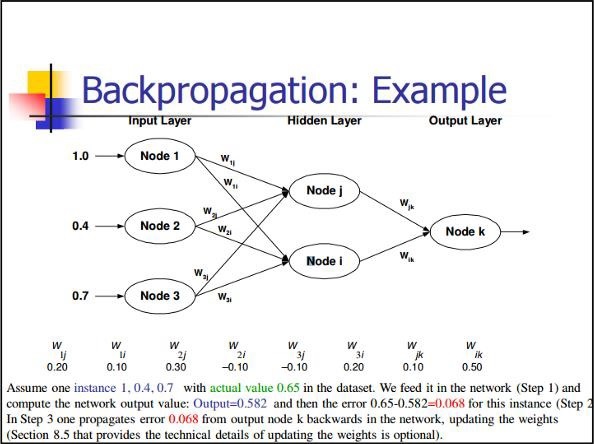

Propagación hacia atrás

La retropropagación es un método simple para calcular derivadas parciales, que incluye la forma básica de composición más adecuada para redes neuronales.

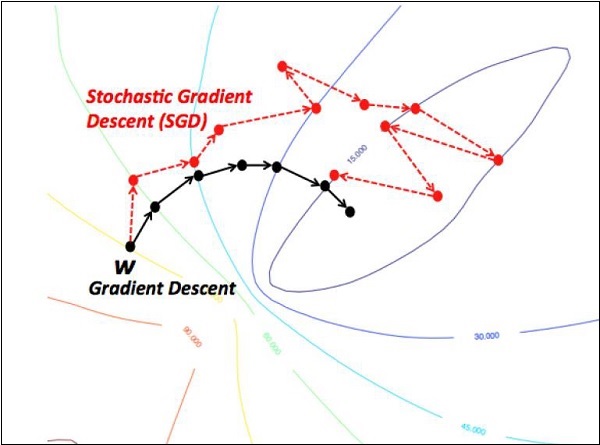

Descenso de gradiente estocástico

En descenso de gradiente estocástico, un batches el número total de ejemplos que usa un usuario para calcular el gradiente en una sola iteración. Hasta ahora, se supone que el lote ha sido el conjunto de datos completo. La mejor ilustración es trabajar a escala de Google; Los conjuntos de datos a menudo contienen miles de millones o incluso cientos de miles de millones de ejemplos.

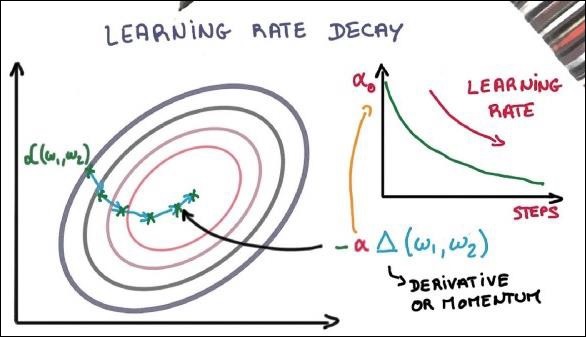

Decadencia de la tasa de aprendizaje

La adaptación de la tasa de aprendizaje es una de las características más importantes de la optimización del descenso de gradientes. Esto es crucial para la implementación de TensorFlow.

Abandonar

Las redes neuronales profundas con una gran cantidad de parámetros forman potentes sistemas de aprendizaje automático. Sin embargo, el ajuste excesivo es un problema grave en estas redes.

Agrupación máxima

La agrupación máxima es un proceso de discretización basado en muestras. El objetivo es reducir la muestra de una representación de entrada, lo que reduce la dimensionalidad con los supuestos requeridos.

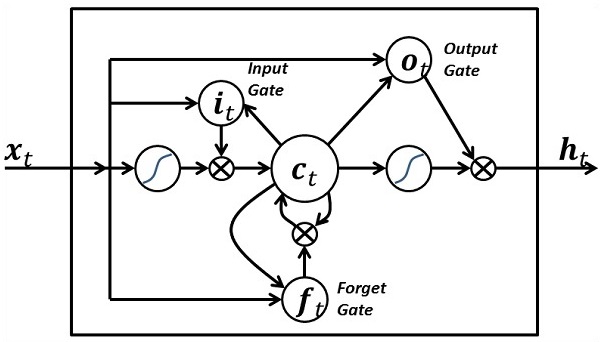

Memoria a corto plazo (LSTM)

LSTM controla la decisión sobre qué entradas deben tomarse dentro de la neurona especificada. Incluye el control para decidir qué se debe calcular y qué resultado se debe generar.