DIP - Guide rapide

introduction

Le traitement du signal est une discipline en génie électrique et en mathématiques qui traite de l'analyse et du traitement des signaux analogiques et numériques, et traite du stockage, du filtrage et d'autres opérations sur les signaux. Ces signaux comprennent les signaux de transmission, les signaux sonores ou vocaux, les signaux d'image et d'autres signaux, etc.

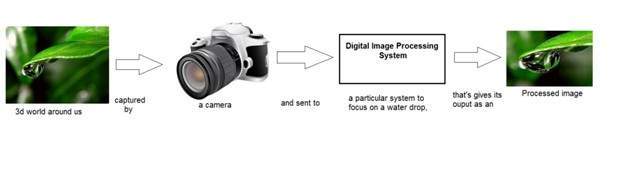

Parmi tous ces signaux, le champ qui traite du type de signaux pour lesquels l'entrée est une image et la sortie est également une image se fait en traitement d'image. Comme son nom l'indique, il traite du traitement des images.

Il peut être divisé en traitement d'image analogique et en traitement d'image numérique.

Traitement d'image analogique

Le traitement d'image analogique est effectué sur des signaux analogiques. Il comprend le traitement sur des signaux analogiques bidimensionnels. Dans ce type de traitement, les images sont manipulées par des moyens électriques en faisant varier le signal électrique. L'exemple courant est l'image de la télévision.

Le traitement d'image numérique a dominé le traitement d'image analogique au fil du temps en raison de sa plus large gamme d'applications.

Traitement d'image numérique

Le traitement d'image numérique traite du développement d'un système numérique qui effectue des opérations sur une image numérique.

Qu'est-ce qu'une image

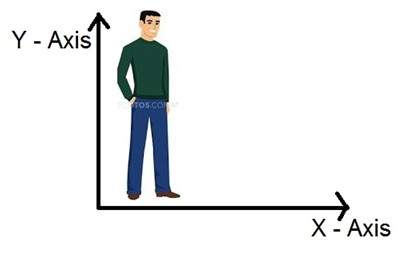

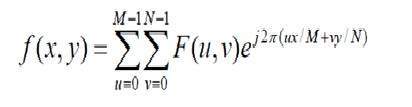

Une image n'est rien de plus qu'un signal bidimensionnel. Il est défini par la fonction mathématique f (x, y) où x et y sont les deux coordonnées horizontalement et verticalement.

La valeur de f (x, y) en tout point donne la valeur de pixel en ce point d'une image.

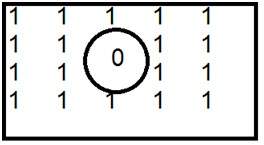

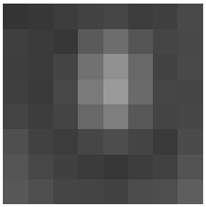

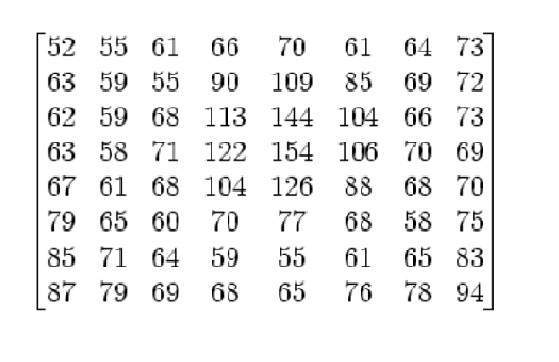

La figure ci-dessus est un exemple d'image numérique que vous visualisez maintenant sur votre écran d'ordinateur. Mais en réalité, cette image n'est rien d'autre qu'un tableau bidimensionnel de nombres compris entre 0 et 255.

| 128 | 30 | 123 |

| 232 | 123 | 321 |

| 123 | 77 | 89 |

| 80 | 255 | 255 |

Chaque nombre représente la valeur de la fonction f (x, y) à tout moment. Dans ce cas, les valeurs 128, 230, 123 représentent chacune une valeur de pixel individuelle. Les dimensions de l'image sont en fait les dimensions de ce tableau à deux dimensions.

Relation entre une image numérique et un signal

Si l'image est un tableau à deux dimensions, qu'est-ce que cela a à voir avec un signal? Pour comprendre cela, nous devons d'abord comprendre ce qu'est un signal?

Signal

Dans le monde physique, toute quantité mesurable dans le temps dans l'espace ou toute dimension supérieure peut être considérée comme un signal. Un signal est une fonction mathématique et il véhicule des informations. Un signal peut être un signal unidimensionnel ou bidimensionnel ou un signal dimensionnel supérieur. Un signal unidimensionnel est un signal mesuré dans le temps. L'exemple courant est un signal vocal. Les signaux bidimensionnels sont ceux qui sont mesurés sur d'autres grandeurs physiques. L'exemple du signal bidimensionnel est une image numérique. Nous examinerons plus en détail dans le prochain tutoriel comment des signaux unidimensionnels ou bidimensionnels et des signaux supérieurs sont formés et interprétés.

Relation

Puisque tout ce qui transmet des informations ou diffuse un message dans le monde physique entre deux observateurs est un signal. Cela inclut la parole ou (voix humaine) ou une image comme signal. Depuis que nous parlons, notre voix est convertie en onde / signal sonore et transformée en fonction du temps passé à la personne à qui nous parlons. Non seulement cela, mais la façon dont fonctionne un appareil photo numérique, comme l'acquisition d'une image à partir d'un appareil photo numérique implique le transfert d'un signal d'une partie du système à l'autre.

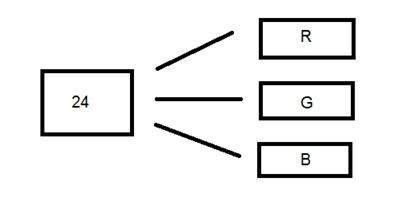

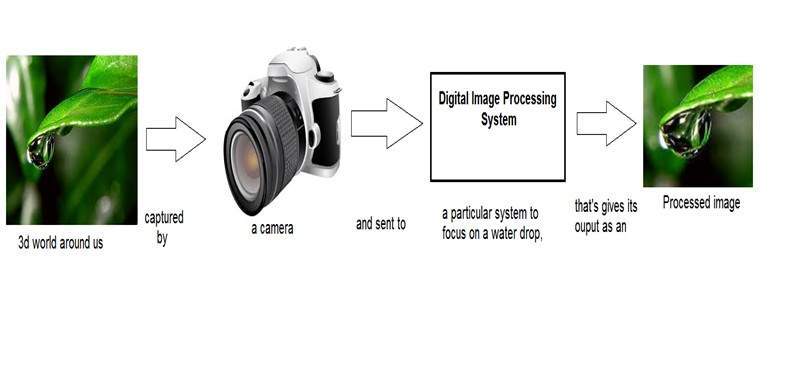

Comment une image numérique est formée

Depuis capturer une image à partir d'une caméra est un processus physique. La lumière du soleil est utilisée comme source d'énergie. Un réseau de capteurs est utilisé pour l'acquisition de l'image. Ainsi, lorsque la lumière du soleil tombe sur l'objet, alors la quantité de lumière réfléchie par cet objet est détectée par les capteurs, et un signal de tension continu est généré par la quantité de données détectées. Afin de créer une image numérique, nous devons convertir ces données sous une forme numérique. Cela implique l'échantillonnage et la quantification. (Ils sont discutés plus tard). Le résultat de l'échantillonnage et de la quantification donne un tableau ou une matrice bidimensionnelle de nombres qui ne sont rien d'autre qu'une image numérique.

Champs qui se chevauchent

Vision industrielle / par ordinateur

La vision industrielle ou vision par ordinateur traite du développement d'un système dans lequel l'entrée est une image et la sortie est une information. Par exemple: Développer un système qui scanne le visage humain et ouvre tout type de verrou. Ce système ressemblerait à quelque chose comme ça.

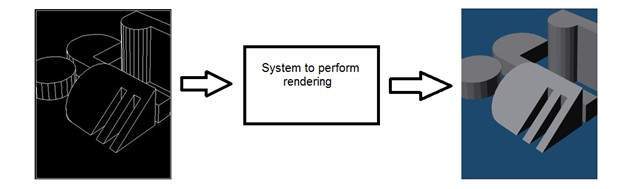

Infographie

L'infographie traite de la formation d'images à partir de modèles d'objets, plutôt que l'image est capturée par un appareil. Par exemple: rendu d'objets. Générer une image à partir d'un modèle objet. Un tel système ressemblerait à quelque chose comme ça.

Intelligence artificielle

L'intelligence artificielle est plus ou moins l'étude de la mise en machine de l'intelligence humaine. L'intelligence artificielle a de nombreuses applications dans le traitement d'images. Par exemple: développer des systèmes de diagnostic assisté par ordinateur qui aident les médecins à interpréter des images de rayons X, IRM, etc., puis mettre en évidence une section visible à examiner par le médecin.

Traitement de signal

Le traitement du signal est un parapluie et le traitement d'image se trouve sous lui. La quantité de lumière réfléchie par un objet dans le monde physique (monde 3D) passe à travers l'objectif de la caméra et devient un signal 2D et donc entraîne la formation d'image. Cette image est ensuite numérisée à l'aide de procédés de traitement du signal, puis cette image numérique est manipulée en traitement d'image numérique.

Ce tutoriel couvre les bases des signaux et du système nécessaires à la compréhension des concepts de traitement d'image numérique. Avant d'entrer dans les concepts de détail, définissons d'abord les termes simples.

Signaux

En génie électrique, la quantité fondamentale de représentation de certaines informations est appelée un signal. Peu importe ce que sont les informations, c'est-à-dire: des informations analogiques ou numériques. En mathématiques, un signal est une fonction qui transmet des informations. En fait, toute quantité mesurable dans le temps dans l'espace ou toute dimension supérieure peut être considérée comme un signal. Un signal peut être de n'importe quelle dimension et de n'importe quelle forme.

Signaux analogiques

Un signal peut être une grandeur analogique qui signifie qu'il est défini par rapport au temps. C'est un signal continu. Ces signaux sont définis sur des variables indépendantes continues. Ils sont difficiles à analyser car ils portent un grand nombre de valeurs. Ils sont très précis en raison d'un large échantillon de valeurs. Afin de stocker ces signaux, vous avez besoin d'une mémoire infinie car elle peut atteindre des valeurs infinies sur une ligne réelle. Les signaux analogiques sont désignés par des ondes sinusoïdales.

Par exemple:

Voix humaine

La voix humaine est un exemple de signaux analogiques. Lorsque vous parlez, la voix produite voyage dans l'air sous forme d'ondes de pression et appartient ainsi à une fonction mathématique, ayant des variables indépendantes d'espace et de temps et une valeur correspondant à la pression atmosphérique.

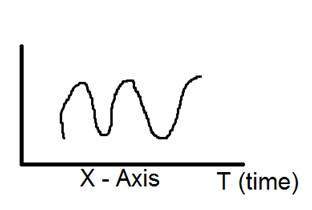

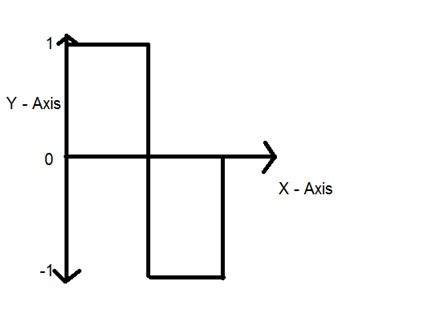

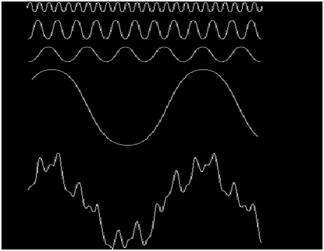

Un autre exemple est celui de l'onde de péché qui est montré dans la figure ci-dessous.

Y = sin (x) où x est indépendant

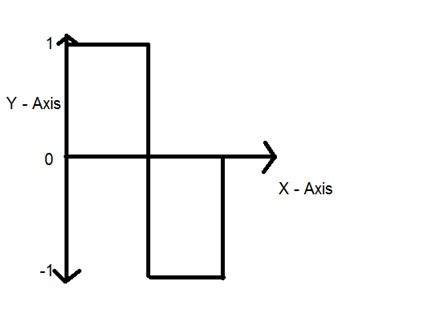

Signaux numériques

Par rapport aux signaux analogiques, les signaux numériques sont très faciles à analyser. Ce sont des signaux discontinus. Ce sont l'appropriation de signaux analogiques.

Le mot numérique signifie des valeurs discrètes et, par conséquent, cela signifie qu'ils utilisent des valeurs spécifiques pour représenter toute information. Dans le signal numérique, seules deux valeurs sont utilisées pour représenter quelque chose, à savoir: 1 et 0 (valeurs binaires). Les signaux numériques sont moins précis que les signaux analogiques car ils sont les échantillons discrets d'un signal analogique pris sur une certaine période de temps. Cependant, les signaux numériques ne sont pas sujets au bruit. Ils durent donc longtemps et sont faciles à interpréter. Les signaux numériques sont désignés par des ondes carrées.

Par exemple:

Clavier d'ordinateur

Chaque fois qu'une touche est enfoncée à partir du clavier, le signal électrique approprié est envoyé au contrôleur de clavier contenant la valeur ASCII de cette touche particulière. Par exemple, le signal électrique qui est généré lorsque la touche du clavier a est enfoncée, transporte les informations du chiffre 97 sous la forme de 0 et 1, qui est la valeur ASCII du caractère a.

Différence entre les signaux analogiques et numériques

| Élément de comparaison | Signal analogique | Signal numérique |

|---|---|---|

| Une analyse | Difficile | Possible d'analyser |

| Représentation | Continu | Discontinu |

| Précision | Plus précise | Moins précis |

| Espace de rangement | Mémoire infinie | Facilement stocké |

| Soumis au bruit | Oui | Non |

| Technique d'enregistrement | Le signal d'origine est conservé | Des échantillons du signal sont prélevés et conservés |

| Exemples | Voix humaine, thermomètre, téléphones analogiques, etc. | Ordinateurs, téléphones numériques, stylos numériques, etc. |

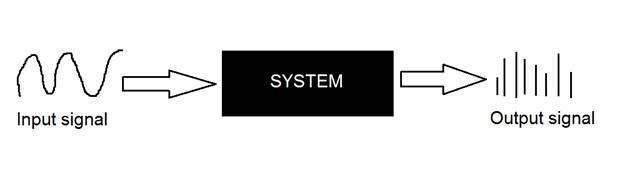

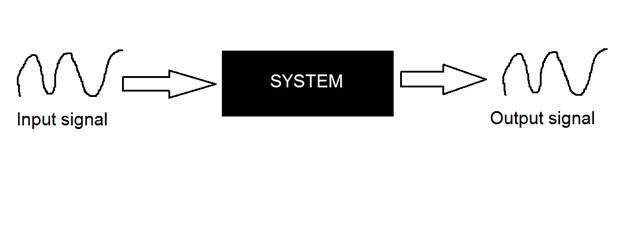

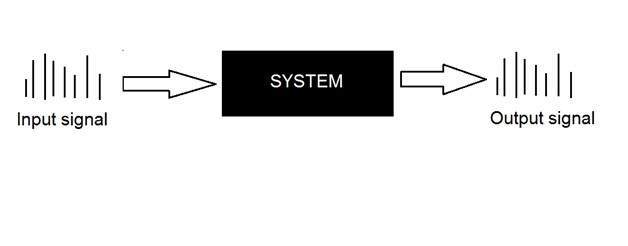

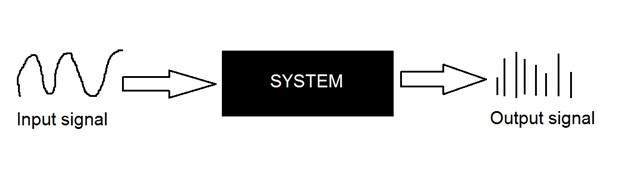

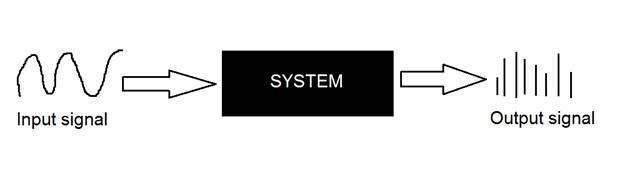

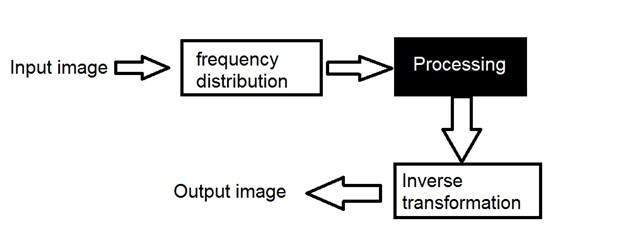

Systèmes

Un système est défini par le type d'entrée et de sortie qu'il traite. Puisque nous avons affaire à des signaux, donc dans notre cas, notre système serait un modèle mathématique, un morceau de code / logiciel, ou un appareil physique, ou une boîte noire dont l'entrée est un signal et il effectue un traitement sur ce signal, et la sortie est un signal. L'entrée est appelée excitation et la sortie est appelée réponse.

Dans la figure ci-dessus, un système a été montré dont l'entrée et la sortie sont toutes deux des signaux mais l'entrée est un signal analogique. Et la sortie est un signal numérique. Cela signifie que notre système est en fait un système de conversion qui convertit les signaux analogiques en signaux numériques.

Jetons un coup d'œil à l'intérieur de ce système de boîte noire

Conversion de signaux analogiques en signaux numériques

Comme il existe de nombreux concepts liés à cette conversion analogique-numérique et vice-versa. Nous aborderons uniquement ceux qui sont liés au traitement numérique des images. Deux concepts principaux interviennent dans la conversion.

Sampling

Quantization

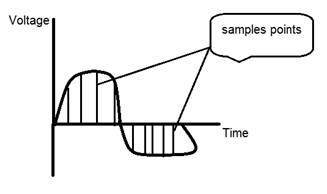

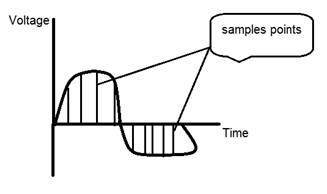

Échantillonnage

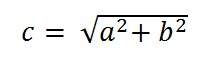

L'échantillonnage comme son nom l'indique peut être défini comme un prélèvement d'échantillons. Prenez des échantillons d'un signal numérique sur l'axe des x. L'échantillonnage est effectué sur une variable indépendante. Dans le cas de cette équation mathématique:

L'échantillonnage se fait sur la variable x. On peut aussi dire que la conversion de l'axe x (valeurs infinies) en numérique se fait sous échantillonnage.

L'échantillonnage est ensuite divisé en échantillonnage ascendant et échantillonnage descendant. Si la plage de valeurs sur l'axe des x est inférieure, nous augmenterons l'échantillon de valeurs. Ceci est connu sous le nom d'échantillonnage vers le haut et vice versa est connu sous le nom d'échantillonnage vers le bas

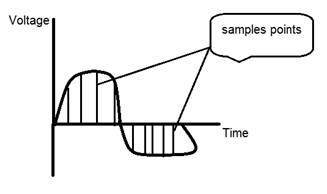

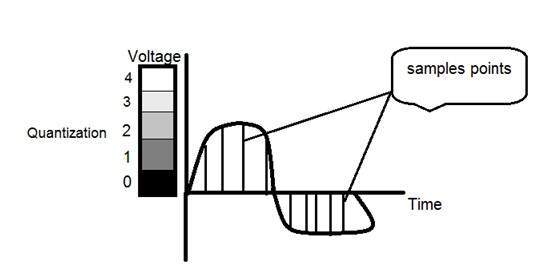

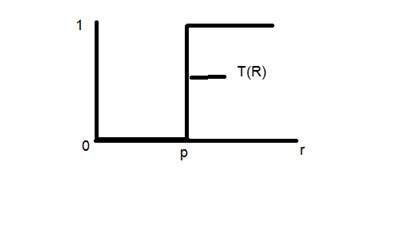

Quantification

La quantification, comme son nom l'indique, peut être définie comme une division en quanta (partitions). La quantification est effectuée sur une variable dépendante. C'est le contraire de l'échantillonnage.

Dans le cas de cette équation mathématique y = sin (x)

La quantification se fait sur la variable Y. Cela se fait sur l'axe y. La conversion des valeurs infinies de l'axe y en 1, 0, -1 (ou tout autre niveau) est connue sous le nom de quantification.

Ce sont les deux étapes de base impliquées lors de la conversion d'un signal analogique en un signal numérique.

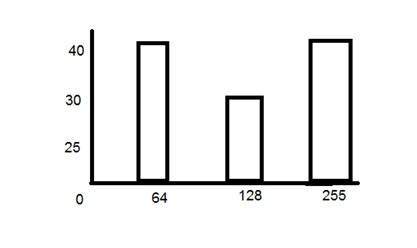

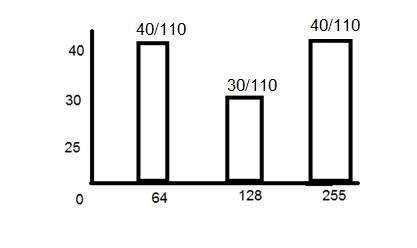

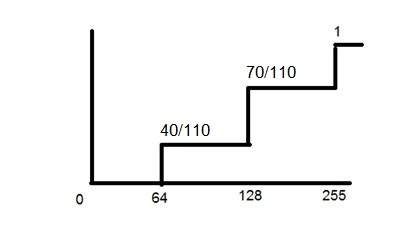

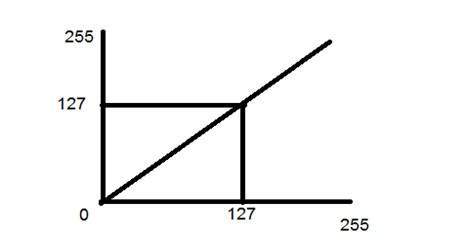

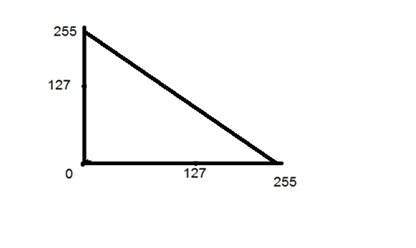

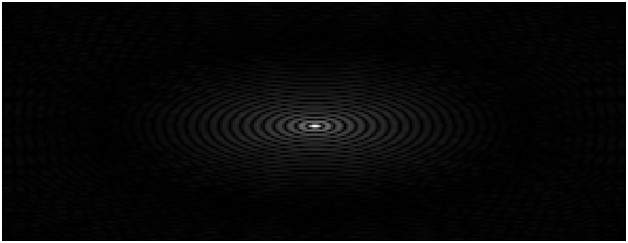

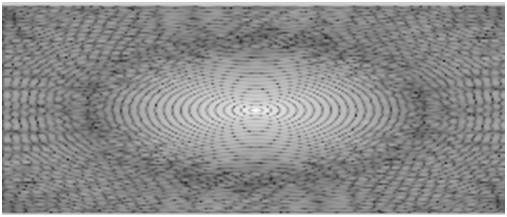

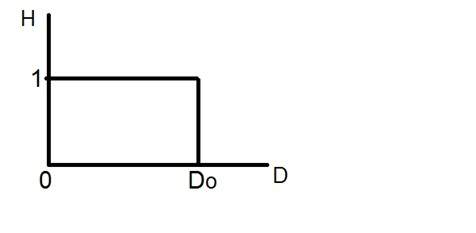

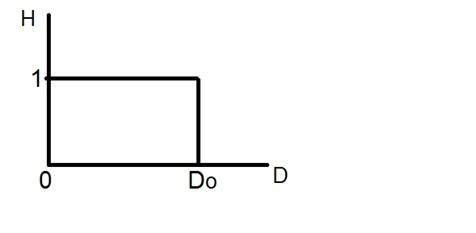

La quantification d'un signal a été montrée dans la figure ci-dessous.

Pourquoi avons-nous besoin de convertir un signal analogique en signal numérique.

La première et évidente raison est que le traitement numérique des images traite des images numériques, qui sont des signaux numériques. Ainsi, chaque fois que l'image est capturée, elle est convertie au format numérique, puis elle est traitée.

La deuxième et importante raison est que pour effectuer des opérations sur un signal analogique avec un ordinateur numérique, vous devez stocker ce signal analogique dans l'ordinateur. Et pour stocker un signal analogique, une mémoire infinie est nécessaire pour le stocker. Et puisque ce n'est pas possible, c'est pourquoi nous convertissons ce signal au format numérique, puis le stockons dans un ordinateur numérique, puis effectuons des opérations dessus.

Systèmes continus vs systèmes discrets

Systèmes continus

Les types de systèmes dont l'entrée et la sortie sont à la fois des signaux continus ou des signaux analogiques sont appelés systèmes continus.

Systèmes discrets

Le type de systèmes dont l'entrée et la sortie sont à la fois des signaux discrets ou des signaux numériques sont appelés systèmes numériques

Origine de la caméra

L'histoire de l'appareil photo et de la photographie n'est pas exactement la même. Les concepts de caméra ont été introduits bien avant le concept de photographie

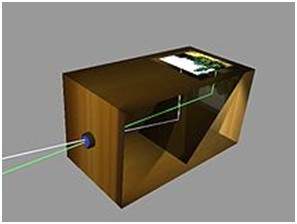

Chambre noire

L'histoire de la caméra se situe en ASIE. Les principes de la caméra ont été introduits pour la première fois par un philosophe chinois MOZI. Il est connu sous le nom de camera obscura. Les caméras ont évolué à partir de ce principe.

Le mot camera obscura est issu de deux mots différents. Caméra et Obscura. Le sens du mot caméra est une pièce ou une sorte de voûte et Obscura signifie sombre.

Le concept introduit par le philosophe chinois consiste en un appareil qui projette une image de son environnement sur le mur. Cependant, il n'a pas été construit par les Chinois.

La création de la camera obscura

Le concept de chinois a été mis en pratique par un scientifique musulman Abu Ali Al-Hassan Ibn al-Haitham communément appelé Ibn al-Haitham. Il a construit la première camera obscura. Son appareil photo suit les principes de la caméra sténopé. Il a construit cet appareil quelque part autour de 1000.

Appareil photo portable

En 1685, un premier appareil photo portable a été construit par Johann Zahn. Avant l'avènement de cet appareil, la caméra se composait d'une taille de pièce et n'était pas portable. Bien qu'un appareil ait été fabriqué par un scientifique irlandais Robert Boyle et Robert Hooke, il s'agissait d'un appareil photo transportable, mais cet appareil était tout de même très énorme pour le transporter d'un endroit à l'autre.

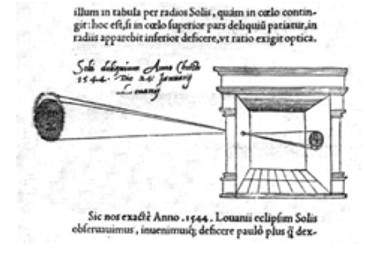

Origine de la photographie

Bien que la camera obscura ait été construite en 1000 par un scientifique musulman. Mais sa première utilisation réelle a été décrite au XIIIe siècle par un philosophe anglais Roger Bacon. Roger a suggéré l'utilisation de la caméra pour l'observation des éclipses solaires.

Da Vinci

Bien que de nombreuses améliorations aient été apportées avant le 15ème siècle, les améliorations et les découvertes faites par Leonardo di ser Piero da Vinci étaient remarquables. Da Vinci était un grand artiste, musicien, anatomiste et ingénieur de guerre. Il est crédité de nombreuses inventions. Son une des peintures les plus célèbres comprend, la peinture de Mona Lisa.

Da Vinci a non seulement construit une caméra obscura selon le principe d'une caméra à trou d'épingle, mais l'utilise également comme aide au dessin pour son travail artistique. Dans son travail, qui a été décrit dans le Codex Atlanticus, de nombreux principes de la camera obscura ont été définis.

Son appareil photo suit le principe d'une caméra à trou d'épingle qui peut être décrite comme

Lorsque des images d'objets illuminés pénètrent à travers un petit trou dans une pièce très sombre, vous verrez [sur le mur opposé] ces objets dans leur forme et leur couleur appropriées, de taille réduite dans une position inversée, en raison de l'intersection des rayons.

Première photographie

La première photographie a été prise en 1814 par un inventeur français Joseph Nicéphore Niepce. Il capture la première photographie d'une vue de la fenêtre du Gras, en enduisant la plaque d'étain de bitume et en l'exposant ensuite à la lumière.

Première photographie sous-marine

La première photographie sous-marine a été prise par un mathématicien anglais William Thomson à l'aide d'une boîte étanche. Cela a été fait en 1856.

L'origine du film

L'origine du film a été introduite par un inventeur américain et un philanthrope connu sous le nom de George Eastman, considéré comme le pionnier de la photographie.

Il a fondé la société appelée Eastman Kodak, célèbre pour le développement de films. L'entreprise commence à fabriquer des films en papier en 1885. Il crée d'abord la caméra Kodak, puis Brownie. Brownie était une caméra box et gagnait en popularité en raison de sa fonction Snapshot.

Après l'avènement du film, l'industrie de la caméra a de nouveau connu un boom et une invention en a conduit une autre.

Leica et Argus

Leica et argus sont les deux caméras analogiques développées respectivement en 1925 et en 1939. La caméra Leica a été construite à l'aide d'un film cinématographique 35 mm.

Argus était un autre appareil photo analogique qui utilise le format 35 mm et était plutôt bon marché par rapport à Leica et est devenu très populaire.

Caméras CCTV analogiques

En 1942, un ingénieur allemand Walter Bruch a développé et installé le tout premier système de caméras CCTV analogiques. Il est également crédité pour l'invention de la télévision couleur dans les années 1960.

Photo Pac

Le premier appareil photo jetable a été introduit en 1949 par Photo Pac. L'appareil photo n'était qu'un appareil photo à usage unique avec un rouleau de film déjà inclus. Les dernières versions de Photo pac étaient imperméables et ont même le flash.

Caméras digitales

Mavica par Sony

Mavica (la caméra vidéo magnétique) a été lancé par Sony en 1981 a été le premier changeur de jeu dans le monde de l'appareil photo numérique. Les images ont été enregistrées sur des disquettes et les images peuvent être visualisées plus tard sur n'importe quel écran.

Ce n'était pas un appareil photo numérique pur, mais un appareil photo analogique. Mais a obtenu sa popularité en raison de sa capacité de stockage d'images sur des disquettes. Cela signifie que vous pouvez désormais stocker des images pendant une longue période et que vous pouvez enregistrer un grand nombre d'images sur la disquette qui sont remplacées par le nouveau disque vierge, lorsqu'elles sont pleines. Mavica a la capacité de stocker 25 images sur un disque.

Une autre chose importante introduite par mavica était sa capacité de capture de photos de 0,3 mégapixel.

Caméras digitales

Fuji DS-1P camera par Fuji films 1988 a été le premier véritable appareil photo numérique

Nikon D1 était un appareil photo 2,74 mégapixels et le premier appareil photo reflex numérique commercial développé par Nikon, et était très abordable par les professionnels.

Aujourd'hui, les appareils photo numériques sont inclus dans les téléphones mobiles avec une résolution et une qualité très élevées.

Étant donné que le traitement numérique des images a des applications très larges et que presque tous les domaines techniques sont touchés par le DIP, nous allons simplement discuter de certaines des principales applications du DIP.

Le traitement d'image numérique ne se limite pas seulement à ajuster la résolution spatiale des images quotidiennes capturées par l'appareil photo. Il ne s'agit pas seulement d'augmenter la luminosité de la photo, etc. C'est bien plus que cela.

Les ondes électromagnétiques peuvent être considérées comme un flux de particules, où chaque particule se déplace à la vitesse de la lumière. Chaque particule contient un faisceau d'énergie. Ce faisceau d'énergie s'appelle un photon.

Le spectre électromagnétique en fonction de l'énergie du photon est indiqué ci-dessous.

Dans ce spectre électromagnétique, nous ne pouvons voir que le spectre visible. Le spectre visible comprend principalement sept couleurs différentes qui sont communément appelées (VIBGOYR). VIBGOYR signifie violet, indigo, bleu, vert, orange, jaune et rouge.

Mais cela n'annule pas l'existence d'autres éléments du spectre. Notre œil humain ne peut voir que la partie visible, dans laquelle nous avons vu tous les objets. Mais une caméra peut voir les autres choses qu'un œil nu est incapable de voir. Par exemple: rayons X, rayons gamma, etc. Par conséquent, l'analyse de tout cela se fait également dans le traitement d'images numériques.

Cette discussion conduit à une autre question qui est

pourquoi devons-nous analyser tous ces autres éléments du spectre EM aussi?

La réponse à cette question réside dans le fait, car ces autres produits tels que XRay ont été largement utilisés dans le domaine médical. L'analyse des rayons gamma est nécessaire car elle est largement utilisée en médecine nucléaire et en observation astronomique. Il en va de même pour le reste des éléments du spectre EM.

Applications du traitement d'image numérique

Certains des principaux domaines dans lesquels le traitement d'image numérique est largement utilisé sont mentionnés ci-dessous

Renforcement et restauration d'image

Domaine médical

Télédétection

Transmission et encodage

Vision machine / robot

Traitement des couleurs

La reconnaissance de formes

Traitement vidéo

Imagerie microscopique

Others

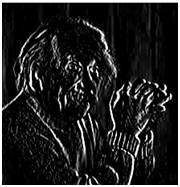

Renforcement et restauration d'image

La netteté et la restauration d'image se réfèrent ici au traitement des images qui ont été capturées à partir de l'appareil photo moderne pour en faire une meilleure image ou pour manipuler ces images de manière à obtenir le résultat souhaité. Il fait référence à ce que fait habituellement Photoshop.

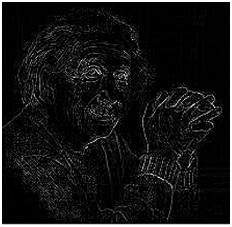

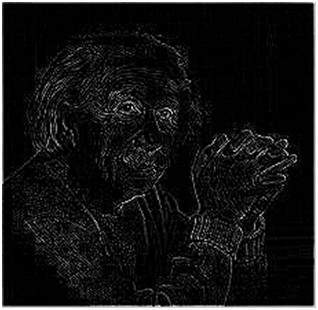

Cela inclut le zoom, le flou, la netteté, la conversion de l'échelle de gris en couleur, la détection des contours et vice versa, la récupération d'image et la reconnaissance d'image. Les exemples courants sont:

L'image originale

L'image agrandie

Image floue

Image nette

Bords

Domaine médical

Les applications courantes du DIP dans le domaine médical sont

Imagerie par rayons gamma

PET scan

Imagerie aux rayons X

CT médical

Imagerie UV

Imagerie UV

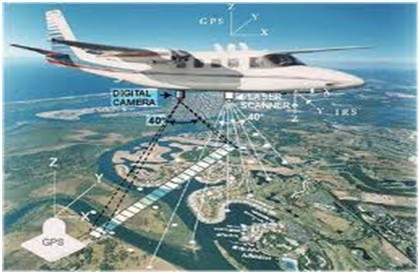

Dans le domaine de la télédétection, la zone de la Terre est balayée par un satellite ou depuis un terrain très élevé puis elle est analysée pour en obtenir des informations. Une application particulière du traitement d'image numérique dans le domaine de la télédétection est la détection des dommages aux infrastructures causés par un tremblement de terre.

Comme il faut plus de temps pour saisir les dommages, même si des dommages graves sont ciblés. La zone affectée par le tremblement de terre étant parfois si large, qu'il n'est pas possible de l'examiner à l'œil nu pour estimer les dommages. Même si c'est le cas, c'est une procédure très mouvementée et longue. Une solution à cela se trouve donc dans le traitement numérique des images. Une image de la zone affectée est capturée depuis le dessus du sol, puis elle est analysée pour détecter les différents types de dommages causés par le séisme.

Les étapes clés incluses dans l'analyse sont

L'extraction des bords

Analyse et mise en valeur de différents types d'arêtes

Transmission et encodage

La toute première image qui a été transmise sur le fil était de Londres à New York via un câble sous-marin. L'image qui a été envoyée est illustrée ci-dessous.

La photo qui a été envoyée a mis trois heures à atteindre d'un endroit à un autre.

Maintenant, imaginez simplement qu'aujourd'hui nous sommes en mesure de voir des flux vidéo en direct ou des images de vidéosurveillance en direct d'un continent à un autre avec un délai de quelques secondes. Cela signifie que beaucoup de travail a également été fait dans ce domaine. Ce champ ne se concentre pas uniquement sur la transmission, mais aussi sur le codage. De nombreux formats différents ont été développés pour une bande passante élevée ou faible pour encoder des photos, puis les diffuser sur Internet ou etc.

Vision machine / robot

Outre les nombreux défis auxquels un robot est confronté aujourd'hui, l'un des plus grands défis est toujours d'augmenter la vision du robot. Rendre le robot capable de voir les choses, de les identifier, d'identifier les obstacles, etc. Beaucoup de travail a été apporté par ce domaine et un autre champ complet de vision par ordinateur a été introduit pour travailler dessus.

Détection des haies

La détection d'obstacles est l'une des tâches courantes qui a été effectuée par le traitement de l'image, en identifiant différents types d'objets dans l'image, puis en calculant la distance entre le robot et les obstacles.

Robot suiveur de ligne

La plupart des robots fonctionnent aujourd'hui en suivant la ligne et sont donc appelés robots suiveurs de ligne. Cela aide un robot à se déplacer sur son chemin et à effectuer certaines tâches. Ceci a également été réalisé grâce au traitement d'image.

Traitement des couleurs

Le traitement des couleurs comprend le traitement des images colorées et des différents espaces colorimétriques utilisés. Par exemple, le modèle de couleur RVB, YCbCr, HSV. Il s'agit également d'étudier la transmission, le stockage et le codage de ces images couleur.

La reconnaissance de formes

La reconnaissance de formes implique l'étude du traitement d'image et de divers autres domaines qui incluent l'apprentissage automatique (une branche de l'intelligence artificielle). Dans la reconnaissance de formes, le traitement d'image est utilisé pour identifier les objets dans une image, puis l'apprentissage automatique est utilisé pour entraîner le système au changement de modèle. La reconnaissance de formes est utilisée dans le diagnostic assisté par ordinateur, la reconnaissance de l'écriture manuscrite, la reconnaissance d'images, etc.

Traitement vidéo

Une vidéo n'est rien d'autre que le mouvement très rapide des images. La qualité de la vidéo dépend du nombre d'images / d'images par minute et de la qualité de chaque image utilisée. Le traitement vidéo implique la réduction du bruit, l'amélioration des détails, la détection de mouvement, la conversion de la fréquence d'images, la conversion du format d'image, la conversion de l'espace colorimétrique, etc.

Nous allons regarder cet exemple afin de comprendre le concept de dimension.

Considérez que vous avez un ami qui vit sur la lune, et il veut vous envoyer un cadeau pour votre cadeau d'anniversaire. Il vous interroge sur votre résidence sur terre. Le seul problème est que le service de messagerie sur la lune ne comprend pas l'adresse alphabétique, mais ne comprend que les coordonnées numériques. Alors, comment lui envoyez-vous votre position sur terre?

C'est de là que vient le concept de dimensions. Les dimensions définissent le nombre minimum de points requis pour pointer une position d'un objet particulier dans un espace.

Revenons donc à notre exemple dans lequel vous devez envoyer votre position sur terre à votre ami sur la lune. Vous lui envoyez trois paires de coordonnées. Le premier s'appelle la longitude, le second s'appelle la latitude et le troisième s'appelle l'altitude.

Ces trois coordonnées définissent votre position sur la terre. Les deux premiers définissent votre emplacement et le troisième définit votre hauteur au-dessus du niveau de la mer.

Cela signifie donc que seules trois coordonnées sont nécessaires pour définir votre position sur terre. Cela signifie que vous vivez dans un monde en 3 dimensions. Et donc cela répond non seulement à la question sur la dimension, mais répond également à la raison, c'est pourquoi nous vivons dans un monde en 3D.

Puisque nous étudions ce concept en référence au traitement numérique de l'image, nous allons maintenant relier ce concept de dimension à une image.

Dimensions de l'image

Donc, si nous vivons dans le monde 3D, signifie un monde en 3 dimensions, alors quelles sont les dimensions d'une image que nous capturons. Une image est bidimensionnelle, c'est pourquoi nous définissons également une image comme un signal bidimensionnel. Une image n'a que la hauteur et la largeur. Une image n'a pas de profondeur. Jetez un œil à cette image ci-dessous.

Si vous regardez la figure ci-dessus, cela montre qu'il n'a que deux axes qui sont l'axe de la hauteur et de la largeur. Vous ne pouvez pas percevoir la profondeur de cette image. C'est pourquoi nous disons qu'une image est un signal bidimensionnel. Mais notre œil est capable de percevoir des objets tridimensionnels, mais cela sera expliqué plus en détail dans le prochain tutoriel sur le fonctionnement de la caméra et l'image est perçue.

Cette discussion conduit à d'autres questions sur la façon dont les systèmes à 3 dimensions sont formés à partir de 2 dimensions.

Comment fonctionne la télévision?

Si nous regardons l'image ci-dessus, nous verrons qu'il s'agit d'une image bidimensionnelle. Pour le convertir en trois dimensions, nous avons besoin d'une autre dimension. Prenons le temps comme troisième dimension, dans ce cas, nous déplacerons cette image bidimensionnelle sur le temps de troisième dimension. Le même concept qui se produit à la télévision, qui nous aide à percevoir la profondeur de différents objets sur un écran. Cela signifie-t-il que ce qui apparaît à la télévision ou ce que nous voyons sur l'écran de télévision est en 3D. Eh bien, nous pouvons oui. La raison en est que, dans le cas de la télévision, nous si nous lisons une vidéo. Ensuite, une vidéo n'est rien d'autre que des images bidimensionnelles se déplaçant dans le temps. Comme les objets bidimensionnels se déplacent sur la troisième dimension qui est un temps, nous pouvons dire qu'il est tridimensionnel.

Différentes dimensions des signaux

1 signal de dimension

L'exemple courant d'un signal à 1 dimension est une forme d'onde. Il peut être représenté mathématiquement par

F (x) = forme d'onde

Où x est une variable indépendante. Puisqu'il s'agit d'un signal à une dimension, c'est pourquoi il n'y a qu'une seule variable x est utilisée.

La représentation graphique d'un signal unidimensionnel est donnée ci-dessous:

La figure ci-dessus montre un signal unidimensionnel.

Maintenant, cela conduit à une autre question, qui est, même s'il s'agit d'un signal unidimensionnel, alors pourquoi a-t-il deux axes ?. La réponse à cette question est que même s'il s'agit d'un signal unidimensionnel, nous le dessinons dans un espace bidimensionnel. Ou nous pouvons dire que l'espace dans lequel nous représentons ce signal est bidimensionnel. C'est pourquoi il ressemble à un signal bidimensionnel.

Peut-être pouvez-vous mieux comprendre le concept d'une dimension en regardant la figure ci-dessous.

Revenez maintenant à notre discussion initiale sur la dimension, considérez la figure ci-dessus comme une ligne réelle avec des nombres positifs d'un point à l'autre. Maintenant, si nous devons expliquer l'emplacement de n'importe quel point sur cette ligne, nous n'avons besoin que d'un seul nombre, ce qui signifie qu'une seule dimension.

Signal 2 dimensions

L'exemple courant d'un signal bidimensionnel est une image, qui a déjà été discutée ci-dessus.

Comme nous l'avons déjà vu, une image est un signal bidimensionnel, c'est-à-dire qu'elle a deux dimensions. Il peut être représenté mathématiquement par:

F (x, y) = Image

Où x et y sont deux variables. Le concept de deux dimensions peut également être expliqué en termes de mathématiques comme:

Maintenant, dans la figure ci-dessus, étiquetez les quatre coins du carré comme A, B, C et D respectivement. Si nous appelons, un segment de ligne dans la figure AB et l'autre CD, alors nous pouvons voir que ces deux segments parallèles se rejoignent et forment un carré. Chaque segment de ligne correspond à une dimension, donc ces deux segments de ligne correspondent à 2 dimensions.

Signal 3 dimensions

Le signal tridimensionnel comme il nomme fait référence à ces signaux qui ont trois dimensions. L'exemple le plus courant a été discuté au début, celui de notre monde. Nous vivons dans un monde en trois dimensions. Cet exemple a été discuté de manière très détaillée. Un autre exemple de signal tridimensionnel est un cube ou des données volumétriques ou l'exemple le plus courant serait un personnage de dessin animé animé ou 3D.

La représentation mathématique du signal tridimensionnel est:

F (x, y, z) = caractère animé.

Un autre axe ou dimension Z est impliqué dans une trois dimension, qui donne l'illusion de la profondeur. Dans un système de coordonnées cartésiennes, il peut être considéré comme:

Signal 4 dimensions

Dans un signal à quatre dimensions, quatre dimensions sont impliquées. Les trois premiers sont les mêmes que ceux d'un signal tridimensionnel qui sont: (X, Y, Z), et le quatrième qui leur est ajouté est T (temps). Le temps est souvent appelé dimension temporelle qui est un moyen de mesurer le changement. Mathématiquement, un signal à quatre d peut être énoncé comme suit:

F (x, y, z, t) = film d'animation.

L'exemple courant d'un signal en 4 dimensions peut être un film d'animation en 3D. Comme chaque personnage est un personnage 3D, ils sont ensuite déplacés par rapport au temps, ce qui nous a permis de voir une illusion d'un film en trois dimensions ressemblant davantage à un monde réel.

Cela signifie donc qu'en réalité les films d'animation sont en 4 dimensions c'est-à-dire: mouvement de personnages 3D sur la quatrième dimension du temps.

Comment fonctionne l'œil humain?

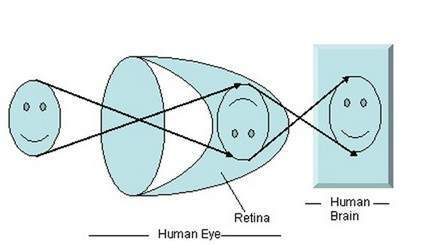

Avant de discuter de la formation d'image sur des appareils photo analogiques et numériques, nous devons d'abord discuter de la formation d'image sur l'œil humain. Parce que le principe de base suivi par les caméras a été retiré du chemin, l'œil humain fonctionne.

Lorsque la lumière tombe sur l'objet particulier, elle est réfléchie après avoir frappé à travers l'objet. Les rayons de lumière, lorsqu'ils sont passés à travers la lentille de l'œil, forment un angle particulier et l'image est formée sur la rétine qui est la face arrière de la paroi. L'image formée est inversée. Cette image est ensuite interprétée par le cerveau et cela nous permet de comprendre les choses. En raison de la formation de l'angle, nous sommes capables de percevoir la hauteur et la profondeur de l'objet que nous voyons. Cela a été expliqué plus en détail dans le didacticiel de transformation de perspective.

Comme vous pouvez le voir sur la figure ci-dessus, lorsque la lumière du soleil tombe sur l'objet (dans ce cas, l'objet est un visage), elle est réfléchie et différents rayons forment un angle différent lorsqu'ils sont passés à travers l'objectif et une image inversée de l'objet a été formé sur le mur du fond. La dernière partie de la figure indique que l'objet a été interprété par le cerveau et ré-inversé.

Revenons maintenant à notre discussion sur la formation d'image sur les appareils photo analogiques et numériques.

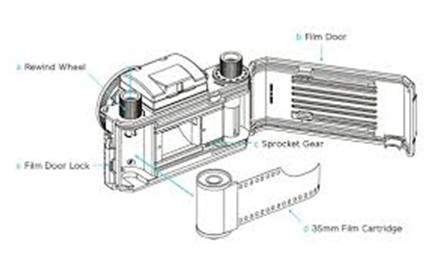

Formation d'image sur des caméras analogiques

Dans les caméras analogiques, la formation d'image est due à la réaction chimique qui a lieu sur la bande utilisée pour la formation d'image.

Une bande de 35 mm est utilisée dans la caméra analogique. Il est indiqué sur la figure par une cartouche de film 35 mm. Cette bande est enduite d'halogénure d'argent (une substance chimique).

Une bande de 35 mm est utilisée dans la caméra analogique. Il est indiqué sur la figure par une cartouche de film 35 mm. Cette bande est enduite d'halogénure d'argent (une substance chimique).

La lumière n'est rien d'autre que les petites particules connues sous le nom de particules de photons.Ainsi, lorsque ces particules de photons passent à travers la caméra, elle réagit avec les particules d'halogénure d'argent sur la bande et il en résulte de l'argent qui est le négatif de l'image.

Afin de mieux le comprendre, jetez un œil à cette équation.

Photons (particules légères) + halogénure d'argent? argent ? image négative.

Ce ne sont que les bases, bien que la formation d'image implique de nombreux autres concepts concernant le passage de la lumière à l'intérieur, ainsi que les concepts de vitesse d'obturation et d'obturation et d'ouverture et son ouverture, mais pour l'instant, nous allons passer à la partie suivante. Bien que la plupart de ces concepts aient été abordés dans notre tutoriel sur l'obturateur et l'ouverture.

Ce ne sont que les bases, bien que la formation d'image implique de nombreux autres concepts concernant le passage de la lumière à l'intérieur, ainsi que les concepts de vitesse d'obturation et d'obturation et d'ouverture et son ouverture, mais pour l'instant, nous allons passer à la partie suivante. Bien que la plupart de ces concepts aient été abordés dans notre tutoriel sur l'obturateur et l'ouverture.

Formation d'image sur les appareils photo numériques

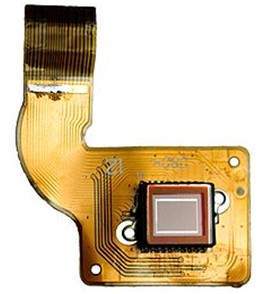

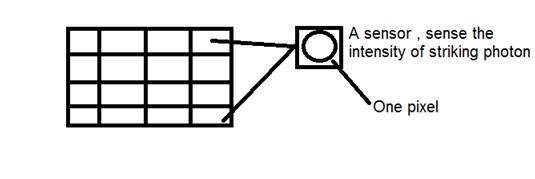

Dans les appareils photo numériques, la formation de l'image n'est pas due à la réaction chimique qui a lieu, elle est plutôt un peu plus complexe que celle-ci. Dans l'appareil photo numérique, un réseau de capteurs CCD est utilisé pour la formation de l'image.

Formation d'image grâce à la matrice CCD

CCD signifie dispositif à couplage de charge. C'est un capteur d'image, et comme les autres capteurs, il détecte les valeurs et les convertit en un signal électrique. En cas de CCD, il détecte l'image et la convertit en signal électrique, etc.

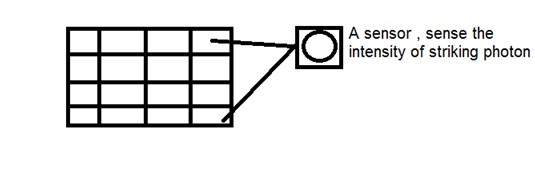

Ce CCD a en fait la forme d'un tableau ou d'une grille rectangulaire. C'est comme une matrice avec chaque cellule de la matrice contenant un censeur qui détecte l'intensité du photon.

Comme les caméras analogiques, dans le cas du numérique aussi, lorsque la lumière tombe sur l'objet, la lumière se réfléchit après avoir heurté l'objet et autorisée à entrer à l'intérieur de la caméra.

Chaque capteur du réseau CCD lui-même est un capteur analogique. Lorsque des photons de lumière frappent la puce, elle est maintenue sous forme de petite charge électrique dans chaque capteur photo. La réponse de chaque capteur est directement égale à la quantité de lumière ou d'énergie (photonique) frappée sur la surface du capteur.

Puisque nous avons déjà défini une image comme un signal bidimensionnel et en raison de la formation bidimensionnelle de la matrice CCD, une image complète peut être obtenue à partir de cette matrice CCD.

Il a un nombre limité de capteurs et cela signifie qu'un détail limité peut être capturé. De plus, chaque capteur ne peut avoir qu'une seule valeur par rapport à chaque particule de photon qui le frappe.

Ainsi, le nombre de photons frappant (courant) est compté et stocké. Afin de les mesurer avec précision, des capteurs CMOS externes sont également connectés à un réseau CCD.

Introduction au pixel

La valeur de chaque capteur du réseau CCD se réfère à chacun la valeur du pixel individuel. Le nombre de capteurs = nombre de pixels. Cela signifie également que chaque capteur ne peut avoir qu'une et une seule valeur.

Stockage de l'image

Les charges stockées par le réseau CCD sont converties en tension un pixel à la fois. À l'aide de circuits supplémentaires, cette tension est convertie en une information numérique, puis elle est stockée.

Chaque entreprise qui fabrique un appareil photo numérique fabrique ses propres capteurs CCD. Cela comprend, Sony, Mistubishi, Nikon, Samsung, Toshiba, FujiFilm, Canon, etc.

Outre les autres facteurs, la qualité de l'image capturée dépend également du type et de la qualité de la matrice CCD qui a été utilisée.

Dans ce didacticiel, nous discuterons de certains des concepts de base de l'appareil photo, comme l'ouverture, l'obturateur, la vitesse d'obturation, l'ISO et nous discuterons de l'utilisation collective de ces concepts pour capturer une bonne image.

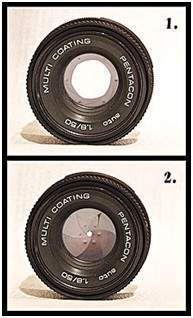

Ouverture

L'ouverture est une petite ouverture qui permet à la lumière de voyager à l'intérieur de l'appareil photo. Voici l'image de l'ouverture.

Vous verrez quelques petites lames comme des trucs à l'intérieur de l'ouverture. Ces lames créent une forme octogonale qui peut être ouverte fermée. Et il est donc logique que plus les lames s'ouvriront, plus le trou par lequel la lumière devrait passer sera plus grand. Plus le trou est grand, plus la lumière est autorisée à entrer.

Effet

L'effet de l'ouverture correspond directement à la luminosité et à l'obscurité d'une image. Si l'ouverture d'ouverture est large, cela permettrait à plus de lumière de passer dans l'appareil photo. Plus de lumière donnerait plus de photons, ce qui aboutirait finalement à une image plus lumineuse.

L'exemple de ceci est montré ci-dessous

Considérez ces deux photos

Celui du côté droit semble plus lumineux, cela signifie que lorsqu'il a été capturé par l'appareil photo, l'ouverture était grande ouverte. Par rapport à l'autre image sur le côté gauche, qui est très sombre par rapport à la première, cela montre que lorsque cette image a été capturée, son ouverture n'était pas grande ouverte.

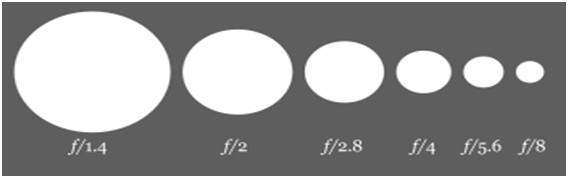

Taille

Voyons maintenant les maths derrière l'ouverture. La taille de l'ouverture est indiquée par une valeur af. Et il est inversement proportionnel à l'ouverture de l'ouverture.

Voici les deux équations qui expliquent le mieux ce concept.

Grande ouverture = petite valeur f

Petite taille d'ouverture = plus grande valeur f

En images, il peut être représenté comme:

Obturateur

Après l'ouverture, vient l'obturateur. La lumière, lorsqu'elle est autorisée à passer de l'ouverture, tombe directement sur l'obturateur. L'obturateur est en fait une couverture, une fenêtre fermée ou peut être considéré comme un rideau. Rappelez-vous lorsque nous parlons du capteur de réseau CCD sur lequel l'image est formée. Bien derrière l'obturateur se trouve le capteur. L'obturateur est donc la seule chose qui se trouve entre la formation de l'image et la lumière, quand elle est passée de l'ouverture.

Dès que l'obturateur est ouvert, la lumière tombe sur le capteur d'image et l'image se forme sur le réseau.

Effet

Si l'obturateur laisse passer la lumière un peu plus longtemps, l'image serait plus lumineuse. De même, une image plus sombre est produite, lorsqu'un obturateur est autorisé à se déplacer très rapidement et que, par conséquent, la lumière qui est autorisée à passer a très moins de photons, et l'image qui se forme sur le capteur à matrice CCD est très sombre.

Shutter a deux autres concepts principaux:

Vitesse d'obturation

Temps d'obturation

Vitesse d'obturation

La vitesse d'obturation peut être désignée comme le nombre de fois où l'obturateur s'ouvre ou se ferme. N'oubliez pas que nous ne parlons pas de la durée d'ouverture ou de fermeture de l'obturateur.

Temps d'obturation

Le temps d'obturation peut être défini comme

Lorsque l'obturateur est ouvert, le temps d'attente nécessaire pour qu'il soit fermé est appelé temps d'obturation.

Dans ce cas, nous ne parlons pas du nombre de fois où l'obturateur s'est ouvert ou fermé, mais nous parlons de combien de temps il reste grand ouvert.

Par exemple:

Nous pouvons mieux comprendre ces deux concepts de cette manière. Cela permet de dire qu'un volet s'ouvre 15 fois puis se ferme, et pour chaque fois il s'ouvre pendant 1 seconde puis se ferme. Dans cet exemple, 15 est la vitesse d'obturation et 1 seconde est le temps d'obturation.

Relation

La relation entre la vitesse d'obturation et le temps d'obturation est qu'ils sont tous deux inversement proportionnels l'un à l'autre.

Cette relation peut être définie dans l'équation ci-dessous.

Plus de vitesse d'obturation = moins de temps d'obturation

Moins de vitesse d'obturation = plus de temps d'obturation.

Explication:

Plus le temps requis est court, plus la vitesse est élevée. Et plus le temps requis est long, moins la vitesse est élevée.

Applications

Ces deux concepts réunis font une variété d'applications. Certains d'entre eux sont donnés ci-dessous.

Objets en mouvement rapide:

Si vous deviez capturer l'image d'un objet en mouvement rapide, cela pourrait être une voiture ou quoi que ce soit. L'ajustement de la vitesse d'obturation et de son temps aurait beaucoup d'effet.

Donc, afin de capturer une image comme celle-ci, nous allons apporter deux modifications:

Augmenter la vitesse d'obturation

Diminuer le temps d'obturation

Ce qui se passe, c'est que lorsque nous augmentons la vitesse d'obturation, plus il y a de fois, l'obturateur s'ouvre ou se ferme. Cela signifie que différents échantillons de lumière permettraient de passer. Et lorsque nous réduisons le temps d'obturation, cela signifie que nous capturerons immédiatement la scène et fermerons la porte de l'obturateur.

Si vous faites cela, vous obtenez une image nette d'un objet en mouvement rapide.

Afin de le comprendre, nous allons regarder cet exemple. Supposons que vous souhaitiez capturer l'image d'une chute d'eau en mouvement rapide.

Vous réglez votre vitesse d'obturation sur 1 seconde et vous prenez une photo. C'est ce que vous obtenez

Ensuite, vous réglez votre vitesse d'obturation sur une vitesse plus rapide et vous obtenez.

Ensuite, vous réglez votre vitesse d'obturation encore plus rapidement et vous obtenez.

Vous pouvez voir sur la dernière photo, que nous avons augmenté notre vitesse d'obturation très rapidement, ce qui signifie qu'un obturateur s'ouvre ou se ferme en 200e de 1 seconde et nous avons donc une image nette.

ISO

Le facteur ISO est mesuré en nombres. Il indique la sensibilité de la lumière à la caméra. Si le nombre ISO est abaissé, cela signifie que notre appareil photo est moins sensible à la lumière et si le nombre ISO est élevé, cela signifie qu'il est plus sensible.

Effet

Plus l'ISO est élevé, plus l'image sera lumineuse. Si l'ISO est réglé sur 1600, l'image serait très lumineuse et vice versa.

Effet secondaire

Si l'ISO augmente, le bruit dans l'image augmente également. Aujourd'hui, la plupart des fabricants de caméras s'efforcent de supprimer le bruit de l'image lorsque l'ISO est réglé sur une vitesse plus élevée.

Pixel

Le pixel est le plus petit élément d'une image. Chaque pixel correspond à une valeur quelconque. Dans une image en échelle de gris de 8 bits, la valeur du pixel est comprise entre 0 et 255. La valeur d'un pixel en tout point correspond à l'intensité des photons lumineux frappant en ce point. Chaque pixel stocke une valeur proportionnelle à l'intensité lumineuse à cet emplacement particulier.

PEL

Un pixel est également appelé PEL. Vous pouvez avoir plus de compréhension du pixel à partir des images ci-dessous.

Dans l'image ci-dessus, il peut y avoir des milliers de pixels, qui forment ensemble cette image. Nous allons zoomer cette image dans la mesure où nous pouvons voir une division de pixels. Il est montré dans l'image ci-dessous.

Dans l'image ci-dessus, il peut y avoir des milliers de pixels, qui forment ensemble cette image. Nous allons zoomer cette image dans la mesure où nous pouvons voir une division de pixels. Il est montré dans l'image ci-dessous.

Relation expédiée avec la matrice CCD

Nous avons vu comment une image est formée dans le réseau CCD. Ainsi, un pixel peut également être défini comme

La plus petite division du tableau CCD est également appelée pixel.

Chaque division de la matrice CCD contient la valeur par rapport à l'intensité du photon frappant. Cette valeur peut également être appelée comme un pixel

Calcul du nombre total de pixels

Nous avons défini une image comme un signal ou une matrice bidimensionnelle. Ensuite, dans ce cas, le nombre de PEL serait égal au nombre de lignes multiplié par le nombre de colonnes.

Cela peut être représenté mathématiquement comme ci-dessous:

Nombre total de pixels = nombre de lignes (X) nombre de colonnes

Ou nous pouvons dire que le nombre de paires de coordonnées (x, y) constitue le nombre total de pixels.

Nous regarderons plus en détail dans le tutoriel des types d'images, que comment calculer les pixels dans une image couleur.

Niveau de gris

La valeur du pixel à tout moment indique l'intensité de l'image à cet emplacement, également appelée niveau de gris.

Nous verrons plus en détail la valeur des pixels dans le stockage d'image et le tutoriel sur les bits par pixel, mais pour l'instant, nous allons simplement regarder le concept d'une seule valeur de pixel.

Valeur de pixel. (0)

Comme il a déjà été défini au début de ce didacticiel, chaque pixel ne peut avoir qu'une seule valeur et chaque valeur indique l'intensité de la lumière en ce point de l'image.

Nous allons maintenant regarder une valeur très unique 0. La valeur 0 signifie l'absence de lumière. Cela signifie que 0 indique sombre, et cela signifie en outre que chaque fois qu'un pixel a une valeur de 0, cela signifie qu'à ce stade, une couleur noire se formerait.

Jetez un œil à cette matrice d'images

| 0 | 0 | 0 |

| 0 | 0 | 0 |

| 0 | 0 | 0 |

Maintenant, cette matrice d'image s'est remplie de 0. Tous les pixels ont une valeur de 0. Si nous devions calculer le nombre total de pixels de cette matrice, voici comment nous allons le faire.

Nombre total de pixels = nombre total de lignes X total no. de colonnes

= 3 X 3

= 9.

Cela signifie qu'une image serait formée avec 9 pixels, et que cette image aurait une dimension de 3 lignes et 3 colonnes et surtout cette image serait noire.

L'image résultante qui serait faite serait quelque chose comme ça

Maintenant, pourquoi cette image est-elle toute noire. Parce que tous les pixels de l'image avaient une valeur de 0.

Lorsque les yeux humains voient des choses de près, ils semblent plus grands que ceux qui sont loin. C'est ce qu'on appelle la perspective d'une manière générale. Alors que la transformation est le transfert d'un objet, etc. d'un état à un autre.

Donc, globalement, la transformation de perspective traite de la conversion du monde 3D en image 2D. Le même principe sur lequel fonctionne la vision humaine et le même principe sur lequel fonctionne la caméra.

Nous verrons en détail pourquoi cela se produit, que les objets qui sont près de vous paraissent plus grands, tandis que ceux qui sont loin, paraissent plus petits même s'ils paraissent plus gros lorsque vous les atteignez.

Nous commencerons cette discussion par le concept de cadre de référence:

Cadre de réference:

Le cadre de référence est essentiellement un ensemble de valeurs par rapport auxquelles nous mesurons quelque chose.

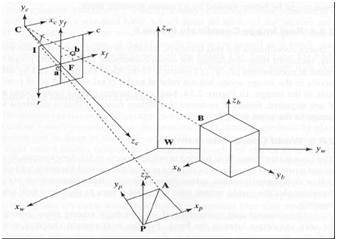

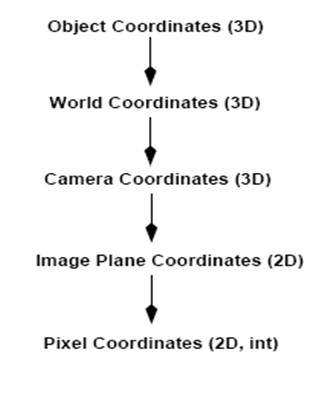

5 cadres de référence

Afin d'analyser un monde / image / scène 3D, 5 cadres de références différents sont nécessaires.

Object

World

Camera

Image

Pixel

Cadre de coordonnées d'objet

Le cadre de coordonnées d'objet est utilisé pour la modélisation d'objets. Par exemple, vérifier si un objet particulier est au bon endroit par rapport à l'autre objet. C'est un système de coordonnées 3D.

Cadre de coordonnées du monde

Le cadre de coordonnées du monde est utilisé pour les objets associés dans un monde en 3 dimensions. C'est un système de coordonnées 3D.

Cadre de coordonnées de la caméra

Le cadre de coordonnées de la caméra est utilisé pour relier les objets par rapport à la caméra. C'est un système de coordonnées 3D.

Cadre de coordonnées d'image

Ce n'est pas un système de coordonnées 3D, mais plutôt un système 2D. Il est utilisé pour décrire comment les points 3D sont mappés dans un plan d'image 2D.

Cadre de coordonnées de pixel

C'est aussi un système de coordonnées 2D. Chaque pixel a une valeur de coordonnées de pixels.

Transformation entre ces 5 cadres

C'est ainsi qu'une scène 3D est transformée en 2D, avec une image de pixels.

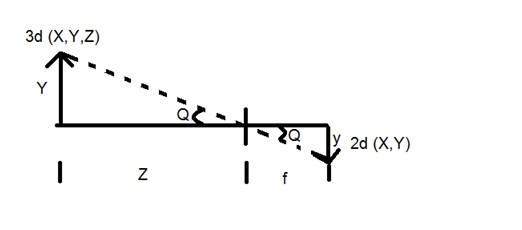

Nous allons maintenant expliquer ce concept mathématiquement.

Y = objet 3D

y = Image 2D

f = distance focale de la caméra

Z = distance entre l'image et la caméra

Maintenant, il y a deux angles différents formés dans cette transformée qui sont représentés par Q.

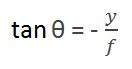

Le premier angle est

Où moins indique que l'image est inversée. Le deuxième angle formé est:

En comparant ces deux équations, nous obtenons

À partir de cette équation, nous pouvons voir que lorsque les rayons de lumière se reflètent après avoir frappé de l'objet, passé de la caméra, une image inversée se forme.

Nous pouvons mieux comprendre cela, avec cet exemple.

Par exemple

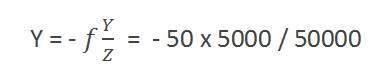

Calcul de la taille de l'image formée

Supposons qu'une image ait été prise d'une personne de 5 m de haut et se tenant à une distance de 50 m de la caméra, et nous devons dire que la taille de l'image de la personne, avec une caméra de distance focale est de 50 mm.

Solution:

Comme la distance focale est en millimètre, nous devons donc tout convertir en millimètre pour pouvoir le calculer.

Alors,

Y = 5000 mm.

f = 50 mm.

Z = 50000 mm.

En mettant les valeurs dans la formule, nous obtenons

= -5 mm.

Là encore, le signe moins indique que l'image est inversée.

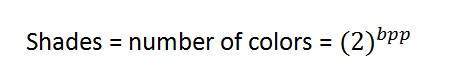

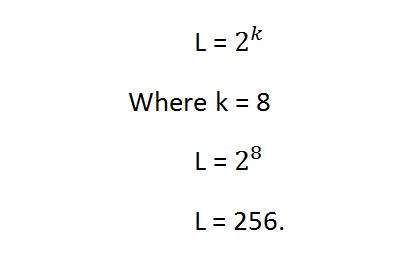

Bpp ou bits par pixel désigne le nombre de bits par pixel. Le nombre de couleurs différentes dans une image dépend de la profondeur de couleur ou des bits par pixel.

Bits en mathématiques:

C'est comme jouer avec des bits binaires.

Combien de nombres peuvent être représentés par un bit.

0

1

Combien de combinaisons de deux bits peuvent être faites.

00

01

dix

11

Si nous concevons une formule pour le calcul du nombre total de combinaisons qui peuvent être faites à partir de bit, ce serait comme ça.

Où bpp désigne les bits par pixel. Mettez 1 dans la formule, vous obtenez 2, mettez 2 dans la formule, vous obtenez 4. Il croît de façon exponentielle.

Nombre de couleurs différentes:

Or, comme nous l'avons dit au début, que le nombre de couleurs différentes dépend du nombre de bits par pixel.

Le tableau pour certains des bits et leur couleur est donné ci-dessous.

| Bits par pixel | Nombre de couleurs |

|---|---|

| 1 bpp | 2 couleurs |

| 2 pb | 4 coloris |

| 3 pb | 8 couleurs |

| 4 pb | 16 couleurs |

| 5 bpp | 32 couleurs |

| 6 pb | 64 couleurs |

| 7 pb | 128 couleurs |

| 8 pb | 256 couleurs |

| 10 pb | 1024 couleurs |

| 16 pb | 65536 couleurs |

| 24 pb | 16777216 couleurs (16,7 millions de couleurs) |

| 32 bpp | 4294967296 couleurs (4294 millions de couleurs) |

Ce tableau montre différents bits par pixel et la quantité de couleur qu'ils contiennent.

Nuances

Vous pouvez facilement remarquer le modèle de croissance exponentielle. La célèbre image en échelle de gris est de 8 bpp, ce qui signifie qu'elle contient 256 couleurs différentes ou 256 nuances.

Les nuances peuvent être représentées comme suit:

Les images couleur sont généralement au format 24 bpp, ou 16 bpp.

Nous en verrons plus sur les autres formats de couleurs et types d'images dans le tutoriel des types d'images.

Valeurs de couleur:

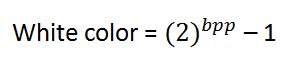

Couleur noire:

Couleur blanche:

La valeur qui indique la couleur blanche peut être calculée comme suit:

Dans le cas de 1 bpp, 0 indique le noir et 1 le blanc.

Dans le cas de 8 bpp, 0 indique le noir et 255 le blanc.

Couleur grise:

Lorsque vous calculez la valeur de couleur noir et blanc, vous pouvez calculer la valeur de pixel de la couleur grise.

La couleur grise est en fait le point médian du noir et blanc. Cela dit,

Dans le cas de 8 bpp, la valeur de pixel qui indique la couleur grise est 127 ou 128 bpp (si vous comptez à partir de 1, pas à partir de 0).

Exigences de stockage d'images

Après la discussion sur les bits par pixel, nous avons maintenant tout ce dont nous avons besoin pour calculer la taille d'une image.

Taille de l'image

La taille d'une image dépend de trois choses.

Nombre de rangées

Le nombre de colonnes

Nombre de bits par pixel

La formule de calcul de la taille est donnée ci-dessous.

Taille d'une image = lignes * cols * bpp

Cela signifie que si vous avez une image, disons celle-ci:

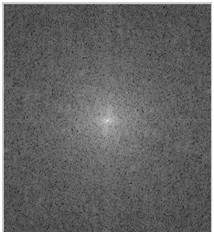

En supposant qu'il comporte 1024 lignes et 1024 colonnes. Et comme il s'agit d'une image en échelle de gris, elle a 256 nuances de gris différentes ou il a des bits par pixel. Ensuite, en mettant ces valeurs dans la formule, nous obtenons

Taille d'une image = lignes * cols * bpp

= 1024 * 1024 * 8

= 8388608 bits.

Mais puisque ce n'est pas une réponse standard que nous reconnaissons, nous allons donc la convertir dans notre format.

Le convertir en octets = 8388608/8 = 1048576 octets.

Conversion en kilo-octets = 1048576/1024 = 1024kb.

Conversion en méga octets = 1024/1024 = 1 Mo.

C'est ainsi qu'une taille d'image est calculée et stockée. Maintenant dans la formule, si on vous donne la taille de l'image et les bits par pixel, vous pouvez également calculer les lignes et les colonnes de l'image, à condition que l'image soit carrée (mêmes lignes et même colonne).

Il existe de nombreux types d'images, et nous examinerons en détail les différents types d'images et la distribution des couleurs.

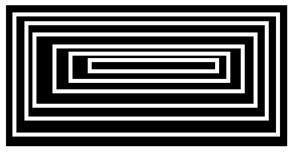

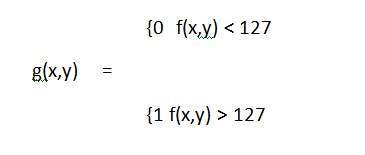

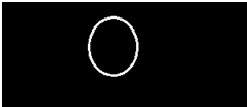

L'image binaire

L'image binaire, comme son nom l'indique, ne contient que deux valeurs de pixels.

0 et 1.

Dans notre précédent tutoriel sur les bits par pixel, nous avons expliqué cela en détail à propos de la représentation des valeurs de pixel dans leurs couleurs respectives.

Ici, 0 fait référence à la couleur noire et 1 à la couleur blanche. Il est également connu sous le nom de Monochrome.

Image en noir et blanc:

L'image résultante qui est formée est donc constituée uniquement de couleur noir et blanc et peut donc également être appelée image noir et blanc.

Pas de niveau de gris

L'un des aspects intéressants de cette image binaire est qu'il n'y a pas de niveau de gris. On n'y trouve que deux couleurs noir et blanc.

Format

Les images binaires ont un format de PBM (Portable bit map)

Format couleur 2, 3, 4, 5, 6 bits

Les images au format couleur 2, 3, 4, 5 et 6 bits ne sont pas largement utilisées aujourd'hui. Ils étaient utilisés autrefois pour les anciens écrans de télévision ou les écrans de surveillance.

Mais chacune de ces couleurs a plus de deux niveaux de gris, et a donc une couleur grise contrairement à l'image binaire.

Dans un 2 bit 4, dans un 3 bit 8, dans un 4 bit 16, dans un 5 bit 32, dans un 6 bit 64 couleurs différentes sont présentes.

Format de couleur 8 bits

Le format couleur 8 bits est l'un des formats d'image les plus connus. Il contient 256 nuances de couleurs différentes. Elle est communément appelée image en niveaux de gris.

La gamme des couleurs en 8 bits varie de 0 à 255. Où 0 représente le noir, 255 le blanc et 127 le gris.

Ce format a été utilisé initialement par les premiers modèles des systèmes d'exploitation UNIX et les premiers Macintosh couleur.

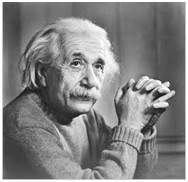

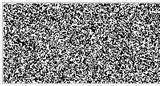

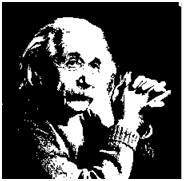

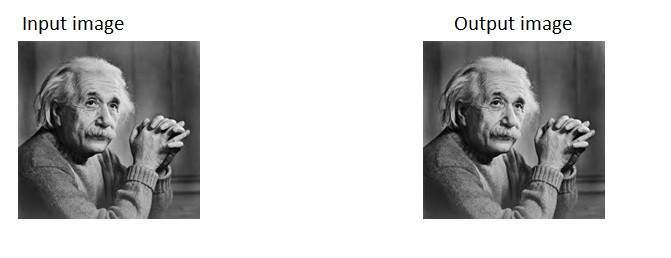

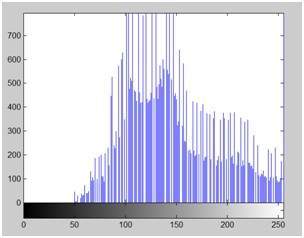

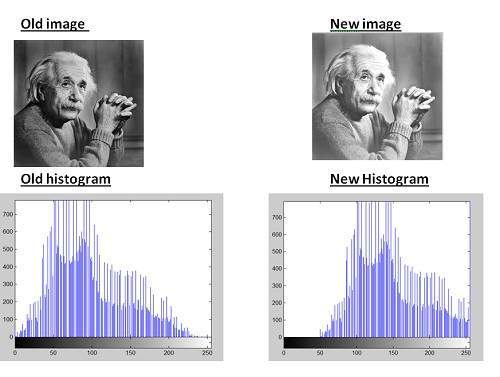

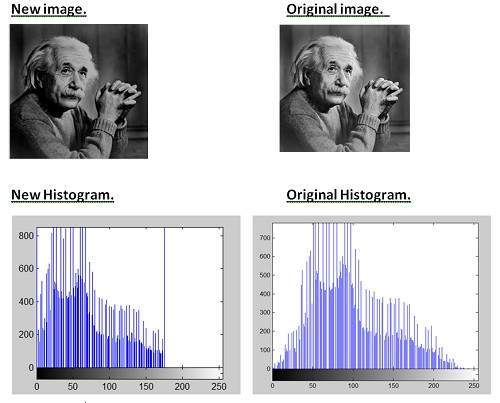

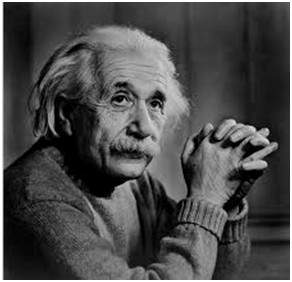

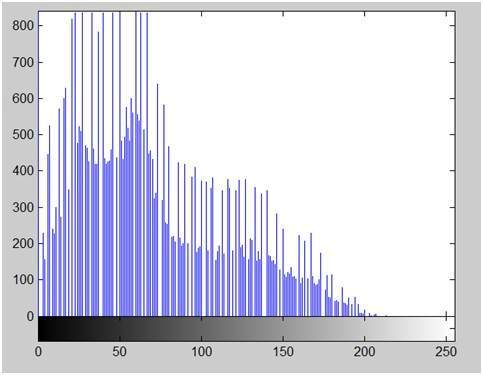

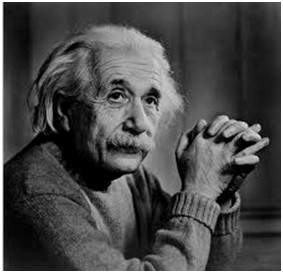

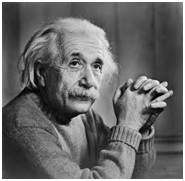

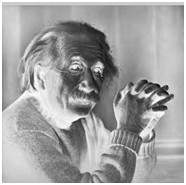

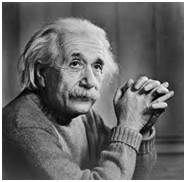

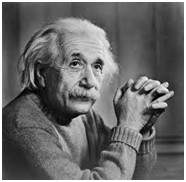

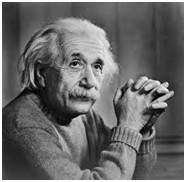

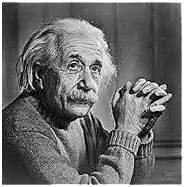

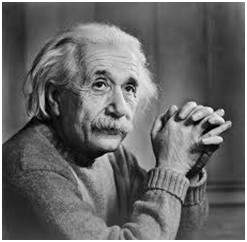

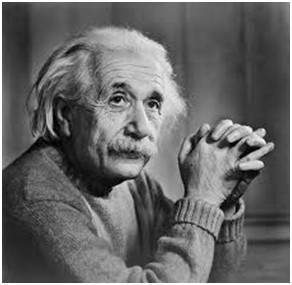

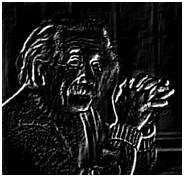

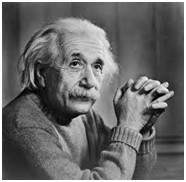

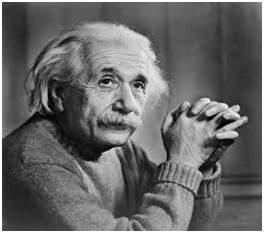

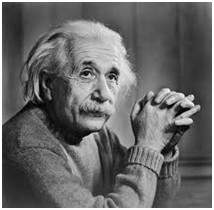

Une image en niveaux de gris d'Einstein est présentée ci-dessous:

Format

Le format de ces images est PGM (Portable Gray Map).

Ce format n'est pas pris en charge par défaut par Windows. Pour voir l'image en niveaux de gris, vous devez disposer d'une visionneuse d'image ou d'une boîte à outils de traitement d'image telle que Matlab.

Derrière l'image en échelle de gris:

Comme nous l'avons expliqué à plusieurs reprises dans les tutoriels précédents, une image n'est rien d'autre qu'une fonction bidimensionnelle, et peut être représentée par un tableau ou une matrice bidimensionnelle. Donc, dans le cas de l'image d'Einstein montrée ci-dessus, il y aurait une matrice bidimensionnelle en arrière avec des valeurs comprises entre 0 et 255.

Mais ce n'est pas le cas avec les images couleur.

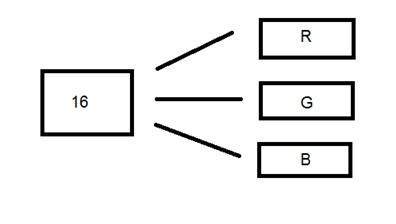

Format de couleur 16 bits

C'est un format d'image couleur. Il contient 65 536 couleurs différentes. Il est également connu sous le nom de format haute couleur.

Il a été utilisé par Microsoft dans leurs systèmes qui prennent en charge un format de couleur supérieur à 8 bits. Maintenant, dans ce format 16 bits et le format suivant, nous allons discuter qui est un format 24 bits sont tous les deux un format couleur.

La distribution des couleurs dans une image couleur n'est pas aussi simple qu'elle l'était dans une image en niveaux de gris.

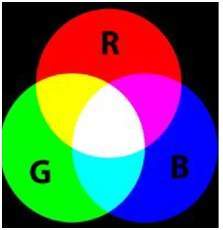

Un format 16 bits est en fait divisé en trois autres formats qui sont le rouge, le vert et le bleu. Le fameux format (RVB).

Il est représenté graphiquement dans l'image ci-dessous.

Maintenant, la question se pose, comment répartiriez-vous 16 en trois. Si tu le fais comme ça,

5 bits pour R, 5 bits pour G, 5 bits pour B

Ensuite, il reste un peu à la fin.

Donc la distribution de 16 bits a été faite comme ça.

5 bits pour R, 6 bits pour G, 5 bits pour B.

Le bit supplémentaire qui a été laissé est ajouté au bit vert. Parce que le vert est la couleur la plus apaisante pour les yeux dans ces trois couleurs.

Notez que cette distribution n'est pas suivie par tous les systèmes. Certains ont introduit un canal alpha dans le 16 bits.

Une autre distribution du format 16 bits est comme ceci:

4 bits pour R, 4 bits pour G, 4 bits pour B, 4 bits pour canal alpha.

Ou certains le distribuent comme ça

5 bits pour R, 5 bits pour G, 5 bits pour B, 1 bits pour canal alpha.

Format de couleur 24 bits

Format de couleur 24 bits également appelé format de couleur vraie. Comme le format couleur 16 bits, dans un format couleur 24 bits, les 24 bits sont à nouveau distribués dans trois formats différents: Rouge, Vert et Bleu.

Puisque 24 est également divisé sur 8, il a donc été réparti également entre trois canaux de couleur différents.

Leur distribution est comme ça.

8 bits pour R, 8 bits pour G, 8 bits pour B.

Derrière une image 24 bits.

Contrairement à une image en échelle de gris 8 bits, qui a une matrice derrière elle, une image 24 bits a trois matrices différentes de R, V, B.

Format

C'est le format le plus couramment utilisé. Son format est PPM (Portable pixMap) qui est pris en charge par le système d'exploitation Linux. La fameuse fenêtre a son propre format qui est BMP (Bitmap).

Dans ce tutoriel, nous verrons comment différents codes de couleur peuvent être combinés pour créer d'autres couleurs, et comment nous pouvons convertir les codes de couleur RVB en hexadécimal et vice versa.

Différents codes couleurs

Toutes les couleurs ici sont au format 24 bits, ce qui signifie que chaque couleur contient 8 bits de rouge, 8 bits de vert, 8 bits de bleu. Ou nous pouvons dire que chaque couleur a trois parties différentes. Il vous suffit de changer la quantité de ces trois portions pour créer n'importe quelle couleur.

Format de couleur binaire

La couleur noire

Image:

Code décimal:

(0,0,0)

Explication:

Comme cela a été expliqué dans les tutoriels précédents, que dans un format 8 bits, 0 fait référence au noir. Donc, si nous devons créer une couleur noire pure, nous devons rendre les trois parties de R, V, B à 0.

Couleur blanche

Image:

Code décimal:

(255 255 255)

Explication:

Puisque chaque partie de R, V, B est une partie de 8 bits. Donc en 8 bits, la couleur blanche est formée par 255. C'est expliqué dans le tutoriel de pixel. Donc, afin de créer une couleur blanche, nous avons défini chaque portion sur 255 et c'est ainsi que nous avons obtenu une couleur blanche. En définissant chacune des valeurs sur 255, nous obtenons une valeur globale de 255, ce qui rend la couleur blanche.

Modèle de couleur RVB:

La couleur rouge

Image:

Code décimal:

(255,0,0)

Explication:

Comme nous n'avons besoin que de la couleur rouge, nous mettons à zéro le reste des deux parties qui sont vertes et bleues, et nous définissons la partie rouge à son maximum qui est de 255.

La couleur verte

Image:

Code décimal:

(0,255,0)

Explication:

Comme nous n'avons besoin que de la couleur verte, nous mettons à zéro le reste des deux parties qui sont rouge et bleu, et nous définissons la partie verte à son maximum qui est de 255.

Couleur bleue

Image:

Code décimal:

(0,0,255)

Explication:

Comme nous n'avons besoin que de la couleur bleue, nous mettons à zéro le reste des deux parties qui sont rouge et verte, et nous définissons la partie bleue à son maximum qui est de 255

Couleur grise:

Couleur: gris

Image:

Code décimal:

(128 128 128 128)

Explication:

Comme nous l'avons déjà défini dans notre tutoriel de pixel, cette couleur grise est en fait le point médian. Dans un format 8 bits, le point médian est 128 ou 127. Dans ce cas, nous choisissons 128. Nous définissons donc chaque partie à son point médian qui est 128, ce qui donne une valeur moyenne globale et nous obtenons une couleur grise.

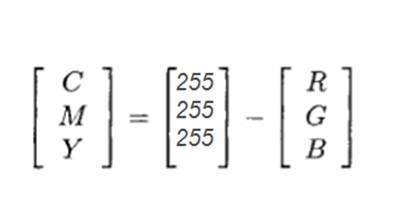

Modèle de couleur CMJN:

CMYK est un autre modèle de couleur où c représente le cyan, m le magenta, y le jaune et k le noir. Le modèle CMJN est couramment utilisé dans les imprimantes couleur dans lesquelles deux carters de couleur sont utilisés. L'un se compose de CMJ et d'autres de couleur noire.

Les couleurs de CMY peuvent également être faites en changeant la quantité ou la portion de rouge, de vert et de bleu.

Couleur: cyan

Image:

Code décimal:

(0,255,255)

Explication:

La couleur cyan est formée de la combinaison de deux couleurs différentes qui sont le vert et le bleu. Nous fixons donc ces deux au maximum et nous mettons à zéro la partie du rouge. Et nous obtenons la couleur cyan.

Couleur: magenta

Image:

Code décimal:

(255,0255)

Explication:

La couleur magenta est formée de la combinaison de deux couleurs différentes qui sont le rouge et le bleu. Nous fixons donc ces deux au maximum et nous supprimons la portion de vert. Et nous obtenons une couleur magenta.

Couleur jaune

Image:

Code décimal:

(255,255,0)

Explication:

La couleur jaune est formée de la combinaison de deux couleurs différentes qui sont le rouge et le vert. Nous fixons donc ces deux au maximum et nous supprimons la partie de bleu. Et nous obtenons la couleur jaune.

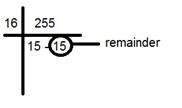

Conversion

Nous allons maintenant voir que la façon dont les couleurs sont converties est d'un format à un autre.

Conversion du code RVB en code hexadécimal:

La conversion de Hex en RVB se fait par cette méthode:

Prenez une couleur. Par exemple: Blanc = (255, 255, 255).

Prenez la première portion, par exemple 255.

Divisez-le par 16. Comme ceci:

Prenez les deux nombres sous la ligne, le facteur et le reste. Dans ce cas, c'est 15 15 qui est FF.

Répétez l'étape 2 pour les deux prochaines portions.

Combinez tout le code hexadécimal en un seul.

Réponse: #FFFFFF

Conversion de Hex en RVB:

La conversion du code hexadécimal au format décimal rgb se fait de cette manière.

Prenez un nombre hexadécimal. Par exemple: #FFFFFF

Décomposer ce nombre en 3 parties: FF FF FF

Prenez la première partie et séparez ses composants: FF

Convertissez chaque pièce séparément en binaire: (1111) (1111)

Maintenant, combinez les binaires individuels en un seul: 11111111

Convertissez ce binaire en décimal: 255

Maintenant, répétez l'étape 2, deux fois de plus.

La valeur de la première étape est R, la deuxième est G et la troisième appartient à B.

Réponse: (255, 255, 255)

Les couleurs communes et leur code hexadécimal sont indiqués dans ce tableau.

| Couleur | Code hexadécimal |

|---|---|

| Noir | # 000000 |

| blanc | #FFFFFF |

| gris | # 808080 |

| rouge | # FF0000 |

| vert | # 00FF00 |

| Bleu | # 0000FF |

| Cyan | # 00FFFF |

| Magenta | # FF00FF |

| Jaune | # FFFF00 |

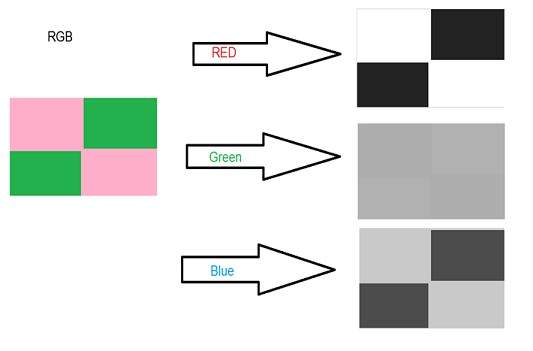

Méthode moyenne

Méthode pondérée ou méthode de luminosité

Méthode moyenne

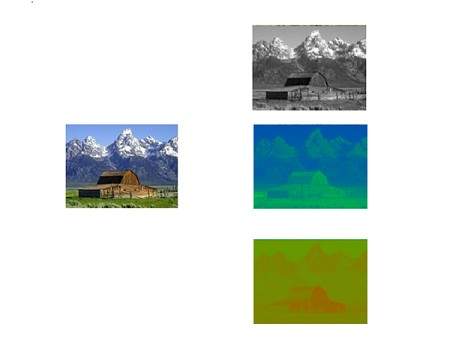

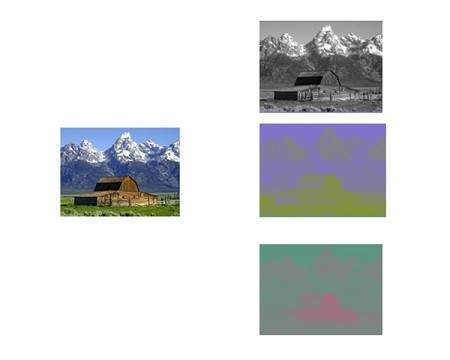

La méthode moyenne est la plus simple. Il suffit de prendre la moyenne de trois couleurs. Comme il s'agit d'une image RVB, cela signifie que vous avez ajouté r avec g avec b, puis divisez-le par 3 pour obtenir l'image en niveaux de gris souhaitée.

C'est fait de cette façon.

Niveaux de gris = (R + G + B) / 3

Par exemple:

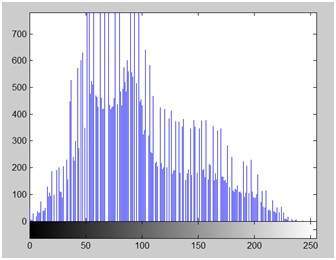

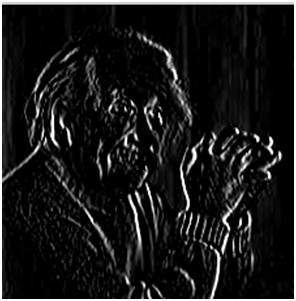

Si vous avez une image couleur comme l'image ci-dessus et que vous souhaitez la convertir en niveaux de gris en utilisant la méthode moyenne. Le résultat suivant apparaîtrait.

Explication

Il y a une chose pour être sûr, qu'il arrive quelque chose aux œuvres originales. Cela signifie que notre méthode moyenne fonctionne. Mais les résultats n'ont pas été comme prévu. Nous voulions convertir l'image en niveaux de gris, mais cela s'est avéré être une image plutôt noire.

Problème

Ce problème est dû au fait que nous prenons la moyenne des trois couleurs. Étant donné que les trois couleurs différentes ont trois longueurs d'onde différentes et ont leur propre contribution à la formation de l'image, nous devons donc prendre la moyenne en fonction de leur contribution, et non en utilisant la méthode moyenne. En ce moment, ce que nous faisons est ceci,

33% de rouge, 33% de vert, 33% de bleu

Nous prenons 33% de chacun, cela signifie que chacune des portions a la même contribution à l'image. Mais en réalité ce n'est pas le cas. La solution à cela a été donnée par la méthode de la luminosité.

Méthode pondérée ou méthode de luminosité

Vous avez vu le problème qui se produit dans la méthode moyenne. La méthode pondérée a une solution à ce problème. Étant donné que la couleur rouge a plus de longueur d'onde que les trois couleurs, et que le vert est la couleur qui a non seulement moins de longueur d'onde que la couleur rouge, mais aussi le vert est la couleur qui donne un effet plus apaisant aux yeux.

Cela signifie que nous devons diminuer la contribution de la couleur rouge, et augmenter la contribution de la couleur verte, et mettre la contribution de la couleur bleue entre ces deux.

Donc, la nouvelle équation qui forme est:

Nouvelle image en niveaux de gris = ((0,3 * R) + (0,59 * G) + (0,11 * B)).

Selon cette équation, le rouge a contribué à 30%, le vert a contribué à 59%, ce qui est plus élevé dans les trois couleurs et le bleu à 11%.

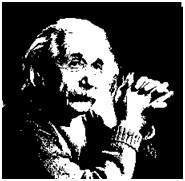

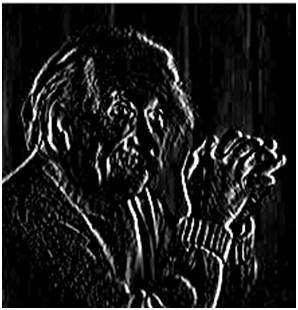

En appliquant cette équation à l'image, nous obtenons ceci

Image originale:

Image en niveaux de gris:

Explication

Comme vous pouvez le voir ici, l'image a maintenant été correctement convertie en niveaux de gris en utilisant la méthode pondérée. Par rapport au résultat de la méthode moyenne, cette image est plus lumineuse.

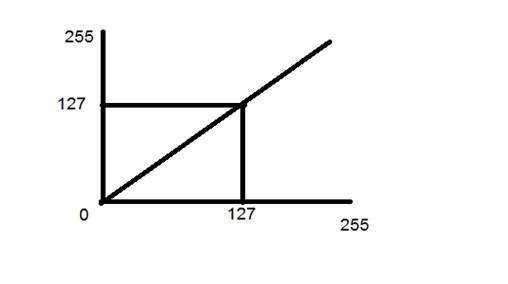

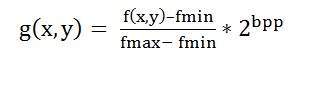

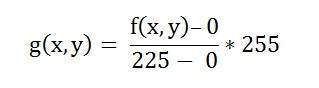

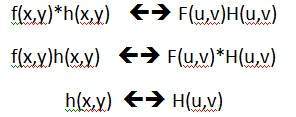

Conversion du signal analogique en signal numérique:

La sortie de la plupart des capteurs d'image est un signal analogique, et nous ne pouvons pas y appliquer de traitement numérique car nous ne pouvons pas le stocker. On ne peut pas le stocker car il nécessite une mémoire infinie pour stocker un signal qui peut avoir des valeurs infinies.

Nous devons donc convertir un signal analogique en un signal numérique.

Pour créer une image qui est numérique, nous devons convertir des données continues sous forme numérique. Cela se fait en deux étapes.

Sampling

Quantization

Nous allons discuter de l'échantillonnage maintenant, et la quantification sera discutée plus tard, mais pour l'instant, nous discuterons juste un peu de la différence entre ces deux et de la nécessité de ces deux étapes.

Idée basique:

L'idée de base de la conversion d'un signal analogique en son signal numérique est

pour convertir ses deux axes (x, y) en un format numérique.

Puisqu'une image est continue non seulement dans ses coordonnées (axe x), mais aussi dans son amplitude (axe y), la partie qui traite de la numérisation des coordonnées est appelée échantillonnage. Et la partie qui traite de la numérisation de l'amplitude est connue sous le nom de quantification.

Échantillonnage.

L'échantillonnage a déjà été introduit dans notre tutoriel d'introduction aux signaux et au système. Mais nous allons discuter ici plus.

Voici ce que nous avons discuté de l'échantillonnage.

Le terme échantillonnage fait référence à prélever des échantillons

Nous numérisons l'axe des x dans l'échantillonnage

Cela se fait sur une variable indépendante

Dans le cas de l'équation y = sin (x), cela se fait sur la variable x

Il est divisé en deux parties, échantillonnage ascendant et échantillonnage descendant

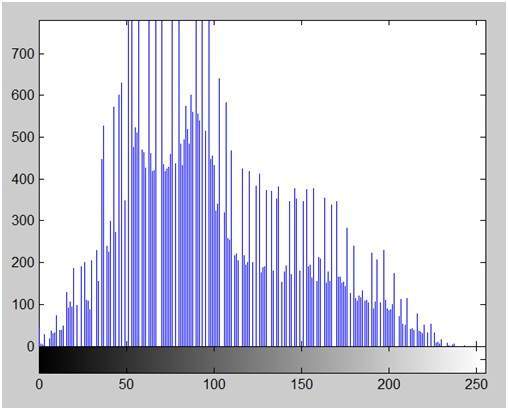

Si vous regardez la figure ci-dessus, vous verrez qu'il existe des variations aléatoires dans le signal. Ces variations sont dues au bruit. Lors de l'échantillonnage, nous réduisons ce bruit en prélevant des échantillons. Il est évident que plus d'échantillons que nous prenons, la qualité de l'image serait meilleure, le bruit serait plus supprimé et il en va de même vice versa.

Cependant, si vous effectuez un échantillonnage sur l'axe x, le signal n'est pas converti au format numérique, à moins que vous ne preniez également l'échantillonnage de l'axe y, ce que l'on appelle la quantification. Plus il y a d'échantillons signifie finalement que vous collectez plus de données, et en cas d'image, cela signifie plus de pixels.

Navire de relation avec des pixels

Puisqu'un pixel est le plus petit élément d'une image. Le nombre total de pixels dans une image peut être calculé comme suit

Pixels = nombre total de lignes * nombre total de colonnes.

Disons que nous avons un total de 25 pixels, cela signifie que nous avons une image carrée de 5 X 5. Ensuite, comme nous l'avons discuté ci-dessus dans l'échantillonnage, plus d'échantillons aboutissent finalement à plus de pixels. Cela signifie donc que de notre signal continu, nous avons prélevé 25 échantillons sur l'axe des x. Cela fait référence à 25 pixels de cette image.

Cela conduit à une autre conclusion que puisque le pixel est également la plus petite division d'un tableau CCD. Cela signifie donc qu'il a également une relation avec le tableau CCD, ce qui peut être expliqué comme suit.

Relation avec la matrice CCD

Le nombre de capteurs sur un réseau CCD est directement égal au nombre de pixels. Et puisque nous avons conclu que le nombre de pixels est directement égal au nombre d'échantillons, cela signifie que le nombre d'échantillons est directement égal au nombre de capteurs sur la matrice CCD.

Suréchantillonnage.

Au début, nous avons défini que l'échantillonnage est en outre catégorisé en deux types. Ce qui est un échantillonnage en hausse et en sous-échantillonnage. L'échantillonnage ascendant est également appelé suréchantillonnage.

Le suréchantillonnage a une application très profonde dans le traitement d'image qui est connue sous le nom de zoom.

Zoomer

Nous présenterons officiellement le zoom dans le prochain didacticiel, mais pour l'instant, nous expliquerons brièvement le zoom.

Le zoom fait référence à l'augmentation de la quantité de pixels, de sorte que lorsque vous zoomez sur une image, vous verrez plus de détails.

L'augmentation de la quantité de pixels se fait par suréchantillonnage. La seule façon de zoomer, ou d'augmenter les échantillons, est de zoomer optiquement, à travers le mouvement moteur de l'objectif, puis de capturer l'image. Mais nous devons le faire, une fois l'image capturée.

Il y a une différence entre le zoom et l'échantillonnage.

Le concept est le même, à savoir augmenter les échantillons. Mais la principale différence est que pendant que l'échantillonnage est effectué sur les signaux, le zoom est effectué sur l'image numérique.

Avant de définir la résolution des pixels, il est nécessaire de définir un pixel.

Pixel

Nous avons déjà défini un pixel dans notre tutoriel de concept de pixel, dans lequel nous définissons un pixel comme le plus petit élément d'une image. Nous avons également défini qu'un pixel peut stocker une valeur proportionnelle à l'intensité lumineuse à cet endroit particulier.

Maintenant que nous avons défini un pixel, nous allons définir ce qu'est la résolution.

Résolution

La résolution peut être définie de plusieurs manières. Tels que la résolution des pixels, la résolution spatiale, la résolution temporelle, la résolution spectrale. À partir de laquelle nous allons discuter de la résolution des pixels.

Vous avez probablement vu que dans les paramètres de votre ordinateur, vous avez une résolution d'écran de 800 x 600, 640 x 480, etc.

En résolution de pixels, le terme résolution fait référence au nombre total de pixels dans une image numérique. Par exemple. Si une image a M lignes et N colonnes, sa résolution peut être définie comme MX N.

Si nous définissons la résolution comme le nombre total de pixels, alors la résolution des pixels peut être définie avec un ensemble de deux nombres. Le premier nombre correspond à la largeur de l'image ou aux pixels sur les colonnes, et le deuxième nombre correspond à la hauteur de l'image ou aux pixels sur sa largeur.

On peut dire que plus la résolution des pixels est élevée, plus la qualité de l'image est élevée.

Nous pouvons définir la résolution en pixels d'une image comme 4500 X 5500.

Mégapixels

Nous pouvons calculer les mégapixels d'une caméra en utilisant la résolution des pixels.

Pixels de colonne (largeur) X pixels de ligne (hauteur) / 1 million.

La taille d'une image peut être définie par sa résolution en pixels.

Taille = résolution de pixel X bpp (bits par pixel)

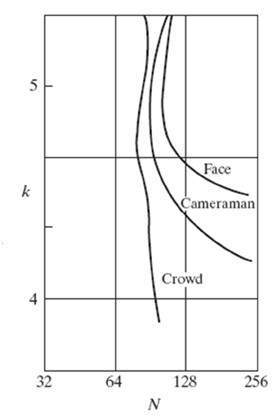

Calcul des mégapixels de la caméra