DIP - Guia Rápido

Introdução

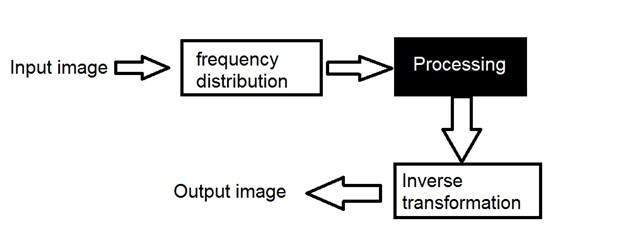

O processamento de sinais é uma disciplina da engenharia elétrica e da matemática que lida com a análise e o processamento de sinais analógicos e digitais e com o armazenamento, filtragem e outras operações em sinais. Esses sinais incluem sinais de transmissão, sinais de som ou voz, sinais de imagem e outros sinais, etc.

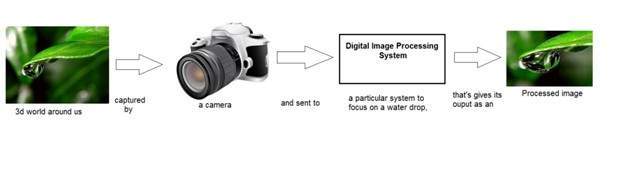

De todos esses sinais, o campo que trata do tipo de sinal para o qual a entrada é uma imagem e a saída também é uma imagem é feito no processamento de imagens. Como o próprio nome sugere, trata do processamento de imagens.

Ele pode ser dividido em processamento de imagem analógico e processamento de imagem digital.

Processamento analógico de imagem

O processamento analógico da imagem é feito em sinais analógicos. Inclui processamento em sinais analógicos bidimensionais. Nesse tipo de processamento, as imagens são manipuladas por meios elétricos, variando o sinal elétrico. O exemplo comum é a imagem da televisão.

O processamento de imagem digital tem dominado o processamento de imagem analógica com o passar do tempo devido à sua ampla gama de aplicações.

Processamento digital de imagens

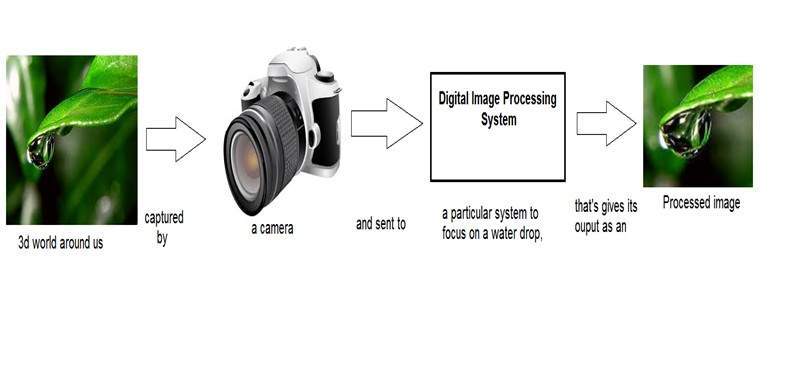

O processamento digital de imagens trata do desenvolvimento de um sistema digital que realiza operações em uma imagem digital.

O que é uma imagem

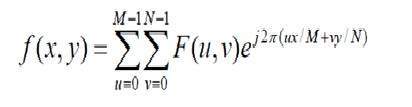

Uma imagem nada mais é do que um sinal bidimensional. É definido pela função matemática f (x, y) onde xey são as duas coordenadas horizontal e verticalmente.

O valor de f (x, y) em qualquer ponto é o valor do pixel naquele ponto de uma imagem.

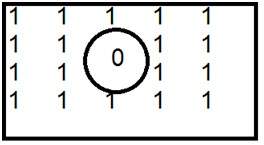

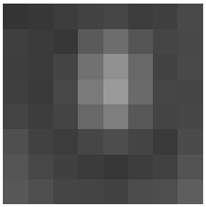

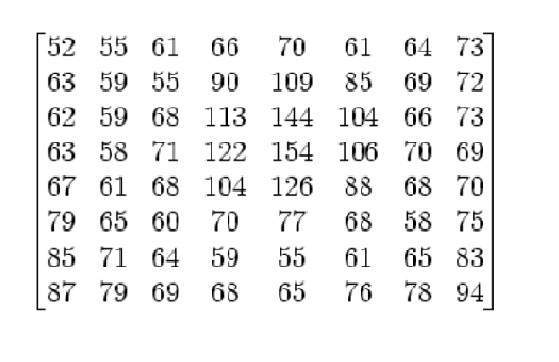

A figura acima é um exemplo de imagem digital que você está vendo agora na tela do computador. Mas, na verdade, esta imagem nada mais é do que uma matriz bidimensional de números variando entre 0 e 255.

| 128 | 30 | 123 |

| 232 | 123 | 321 |

| 123 | 77 | 89 |

| 80 | 255 | 255 |

Cada número representa o valor da função f (x, y) em qualquer ponto. Neste caso, o valor 128, 230, 123 cada um representa um valor de pixel individual. As dimensões da imagem são, na verdade, as dimensões dessa matriz bidimensional.

Relação entre uma imagem digital e um sinal

Se a imagem é uma matriz bidimensional, o que isso tem a ver com um sinal? Para entender isso, precisamos primeiro entender o que é um sinal?

Sinal

No mundo físico, qualquer quantidade mensurável através do tempo no espaço ou qualquer dimensão superior pode ser tomada como um sinal. Um sinal é uma função matemática e transmite algumas informações. Um sinal pode ser unidimensional ou bidimensional ou um sinal de dimensão superior. O sinal unidimensional é um sinal medido ao longo do tempo. O exemplo comum é um sinal de voz. Os sinais bidimensionais são aqueles medidos em outras quantidades físicas. O exemplo de sinal bidimensional é uma imagem digital. Veremos com mais detalhes no próximo tutorial como sinais unidimensionais ou bidimensionais e sinais superiores são formados e interpretados.

Relação

Pois qualquer coisa que transmita informações ou transmita uma mensagem no mundo físico entre dois observadores é um sinal. Isso inclui a fala ou (voz humana) ou uma imagem como um sinal. Desde quando falamos, nossa voz é convertida em onda / sinal sonora e transformada em relação ao tempo para a pessoa com quem estamos falando. Não só isso, mas a forma como uma câmera digital funciona, já que a aquisição de uma imagem de uma câmera digital envolve a transferência de um sinal de uma parte do sistema para outra.

Como uma imagem digital é formada

Já que capturar uma imagem de uma câmera é um processo físico. A luz solar é usada como fonte de energia. Uma matriz de sensores é usada para a aquisição da imagem. Portanto, quando a luz do sol incide sobre o objeto, a quantidade de luz refletida por esse objeto é detectada pelos sensores e um sinal de voltagem contínuo é gerado pela quantidade de dados detectados. Para criar uma imagem digital, precisamos converter esses dados em formato digital. Isso envolve amostragem e quantização. (Eles são discutidos mais tarde). O resultado da amostragem e quantização resulta em uma matriz bidimensional ou matriz de números que nada mais é do que uma imagem digital.

Campos sobrepostos

Visão de máquina / computador

A visão mecânica ou por computador trata do desenvolvimento de um sistema em que a entrada é uma imagem e a saída algumas informações. Por exemplo: Desenvolver um sistema que escaneia o rosto humano e abre qualquer tipo de fechadura. Este sistema seria mais ou menos assim.

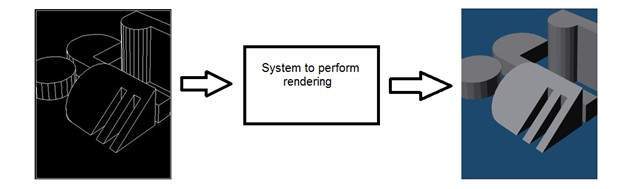

Gráficos de computador

A computação gráfica lida com a formação de imagens a partir de modelos de objetos, em vez da imagem ser capturada por algum dispositivo. Por exemplo: Renderização de objetos. Gerando uma imagem a partir de um modelo de objeto. Esse sistema seria mais ou menos assim.

Inteligência artificial

A inteligência artificial é mais ou menos o estudo de colocar a inteligência humana em máquinas. A inteligência artificial tem muitas aplicações no processamento de imagens. Por exemplo: desenvolver sistemas de diagnóstico auxiliados por computador que auxiliem os médicos na interpretação de imagens de raios-X, ressonância magnética, etc. e, em seguida, destacando a seção visível a ser examinada pelo médico.

Processamento de sinal

O processamento de sinais é um guarda-chuva e o processamento de imagens está sob ele. A quantidade de luz refletida por um objeto no mundo físico (mundo 3D) passa pelas lentes da câmera e se torna um sinal 2d e, portanto, resulta na formação da imagem. Essa imagem é então digitalizada usando métodos de processamento de sinal e, em seguida, essa imagem digital é manipulada no processamento de imagem digital.

Este tutorial cobre os conceitos básicos de sinais e sistema necessários para a compreensão dos conceitos de processamento digital de imagens. Antes de entrar nos conceitos de detalhes, vamos primeiro definir os termos simples.

Sinais

Na engenharia elétrica, a quantidade fundamental de representação de algumas informações é chamada de sinal. Não importa quais são as informações, ou seja: Informações analógicas ou digitais. Em matemática, um sinal é uma função que transmite algumas informações. Na verdade, qualquer quantidade mensurável através do tempo no espaço ou qualquer dimensão superior pode ser tomada como um sinal. Um sinal pode ser de qualquer dimensão e pode ser de qualquer forma.

Sinais analógicos

Um sinal pode ser uma grandeza analógica, o que significa que é definido em relação ao tempo. É um sinal contínuo. Esses sinais são definidos em variáveis independentes contínuas. Eles são difíceis de analisar, pois carregam um grande número de valores. Eles são muito precisos devido a uma grande amostra de valores. Para armazenar esses sinais, você precisa de uma memória infinita porque ela pode atingir valores infinitos em uma linha real. Os sinais analógicos são denotados por ondas sin.

Por exemplo:

Voz humana

A voz humana é um exemplo de sinais analógicos. Quando você fala, a voz produzida viaja pelo ar na forma de ondas de pressão e, portanto, pertence a uma função matemática, tendo variáveis independentes de espaço e tempo e um valor correspondente à pressão do ar.

Outro exemplo é a onda sin que é mostrada na figura abaixo.

Y = sin (x) onde x é independente

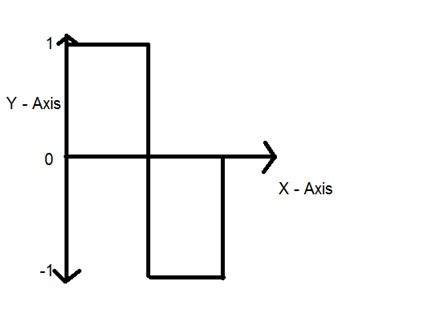

Sinais digitais

Em comparação com os sinais analógicos, os sinais digitais são muito fáceis de analisar. Eles são sinais descontínuos. Eles são a apropriação de sinais analógicos.

A palavra digital significa valores discretos e, portanto, significa que eles usam valores específicos para representar qualquer informação. No sinal digital, apenas dois valores são usados para representar algo, ou seja: 1 e 0 (valores binários). Os sinais digitais são menos precisos do que os sinais analógicos porque são amostras discretas de um sinal analógico obtido ao longo de algum período de tempo. No entanto, os sinais digitais não estão sujeitos a ruído. Portanto, eles duram muito e são fáceis de interpretar. Os sinais digitais são denotados por ondas quadradas.

Por exemplo:

Teclado de computador

Sempre que uma tecla é pressionada no teclado, o sinal elétrico apropriado é enviado ao controlador do teclado contendo o valor ASCII dessa tecla específica. Por exemplo, o sinal elétrico que é gerado quando a tecla a do teclado é pressionada, carrega informações do dígito 97 na forma de 0 e 1, que é o valor ASCII do caractere a.

Diferença entre sinais analógicos e digitais

| Elemento de comparação | Sinal analógico | Sinal digital |

|---|---|---|

| Análise | Difícil | Possível analisar |

| Representação | Contínuo | Descontínuo |

| Precisão | Mais preciso | Menos preciso |

| Armazenamento | Memória infinita | Facilmente armazenado |

| Sujeito a ruído | sim | Não |

| Técnica de Gravação | O sinal original é preservado | Amostras do sinal são coletadas e preservadas |

| Exemplos | Voz humana, termômetro, telefones analógicos etc. | Computadores, telefones digitais, canetas digitais, etc. |

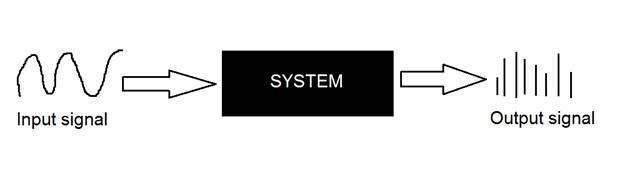

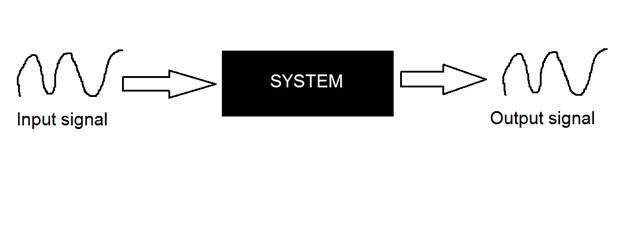

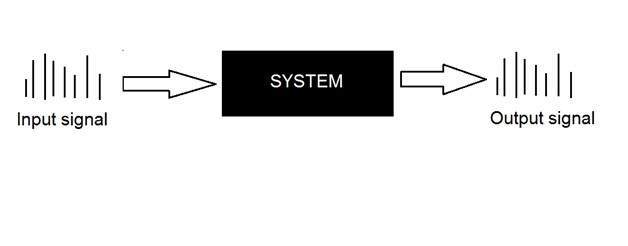

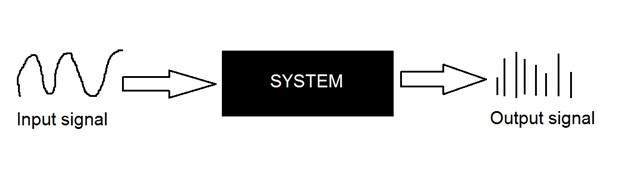

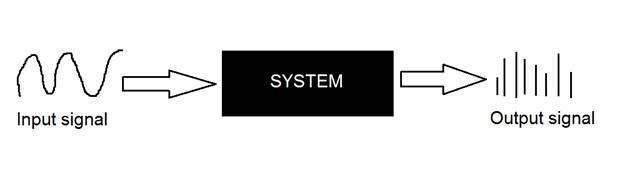

Sistemas

Um sistema é definido pelo tipo de entrada e saída com que lida. Já que estamos lidando com sinais, então, em nosso caso, nosso sistema seria um modelo matemático, um pedaço de código / software ou um dispositivo físico, ou uma caixa preta cuja entrada é um sinal e executa algum processamento nesse sinal, e a saída é um sinal. A entrada é conhecida como excitação e a saída como resposta.

Na figura acima, foi mostrado um sistema cuja entrada e saída são sinais, mas a entrada é um sinal analógico. E a saída é um sinal digital. Isso significa que nosso sistema é na verdade um sistema de conversão que converte sinais analógicos em sinais digitais.

Vamos dar uma olhada no interior deste sistema de caixa preta

Conversão de sinais analógicos em digitais

Uma vez que existem muitos conceitos relacionados a esta conversão de analógico para digital e vice-versa. Discutiremos apenas aqueles relacionados ao processamento digital de imagens. Existem dois conceitos principais que estão envolvidos na cobertura.

Sampling

Quantization

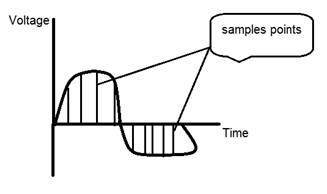

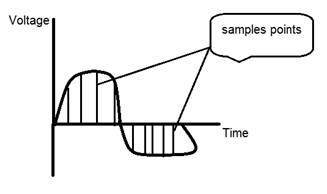

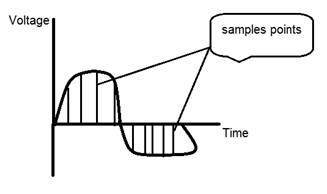

Amostragem

Amostragem, como o nome sugere, pode ser definido como obter amostras. Obtenha amostras de um sinal digital no eixo x. A amostragem é feita em uma variável independente. No caso desta equação matemática:

A amostragem é feita na variável x. Também podemos dizer que a conversão do eixo x (valores infinitos) para digital é feita sob amostragem.

A amostragem é ainda dividida em amostragem ascendente e amostragem inferior. Se a faixa de valores no eixo x for menor, então aumentaremos a amostra de valores. Isso é conhecido como up sampling e vice-versa é conhecido como down sampling

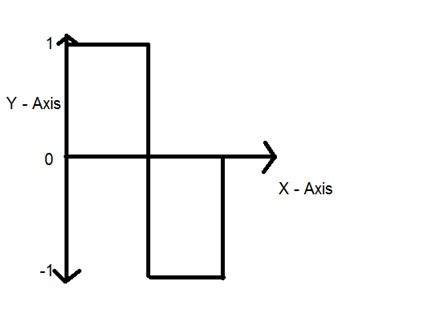

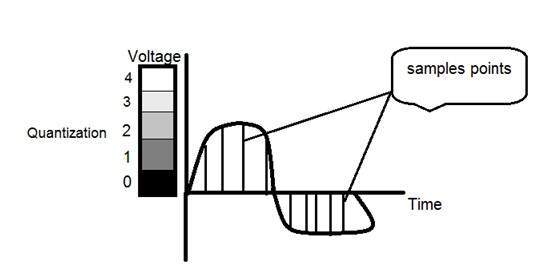

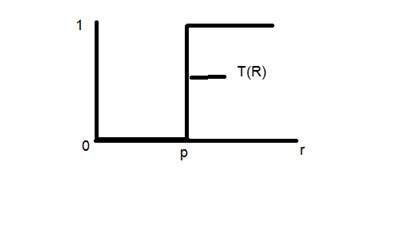

Quantização

Quantização, como o nome sugere, pode ser definida como divisão em quanta (partições). A quantização é feita na variável dependente. É o oposto da amostragem.

No caso desta equação matemática y = sin (x)

A quantização é feita na variável Y. Isso é feito no eixo y. A conversão dos valores infinitos do eixo y em 1, 0, -1 (ou qualquer outro nível) é conhecida como Quantização.

Estas são as duas etapas básicas envolvidas na conversão de um sinal analógico em um sinal digital.

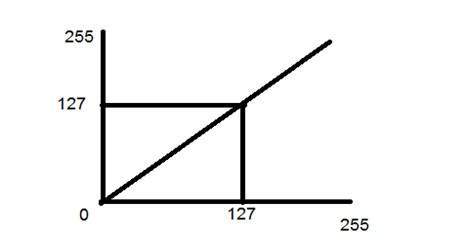

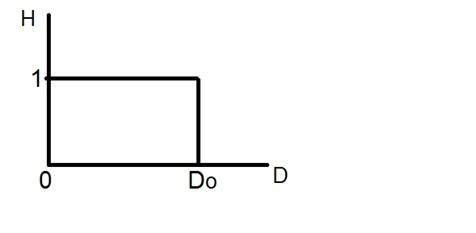

A quantização de um sinal é mostrada na figura abaixo.

Por que precisamos converter um sinal analógico em sinal digital.

A primeira e óbvia razão é que o processamento digital de imagens lida com imagens digitais, que são sinais digitais. Assim, sempre que a imagem é capturada, ela é convertida em formato digital e, em seguida, é processada.

A segunda e importante razão é que, para realizar operações em um sinal analógico com um computador digital, você deve armazenar esse sinal analógico no computador. E para armazenar um sinal analógico, é necessária uma memória infinita para armazená-lo. E como isso não é possível, é por isso que convertemos esse sinal em formato digital e depois o armazenamos em um computador digital e então realizamos as operações nele.

Sistemas contínuos vs sistemas discretos

Sistemas contínuos

Os tipos de sistemas cujas entradas e saídas são sinais contínuos ou analógicos são chamados de sistemas contínuos.

Sistemas discretos

O tipo de sistema cuja entrada e saída são sinais discretos ou digitais são chamados de sistemas digitais

Origem da câmera

A história da câmera e da fotografia não é exatamente a mesma. Os conceitos de câmera foram introduzidos muito antes do conceito de fotografia

Camera Obscura

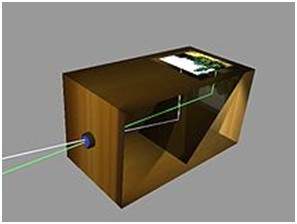

A história da câmera está na ÁSIA. Os princípios da câmera foram introduzidos pela primeira vez por um filósofo chinês MOZI. É conhecido como câmera obscura. As câmeras evoluíram a partir desse princípio.

A palavra camera obscura evoluiu de duas palavras diferentes. Câmera e Obscura. O significado da palavra câmera é uma sala ou algum tipo de abóbada e Obscura significa escuro.

O conceito introduzido pelo filósofo chinês consiste em um dispositivo, que projeta uma imagem do seu entorno na parede. No entanto, não foi construído pelos chineses.

A criação da camera obscura

O conceito de chinês foi concretizado por um cientista muçulmano Abu Ali Al-Hassan Ibn al-Haitham comumente conhecido como Ibn al-Haitham. Ele construiu a primeira câmera obscura. Sua câmera segue os princípios da câmera pinhole. Ele construiu este dispositivo em algo em torno de 1000.

Camera portatil

Em 1685, uma primeira câmera portátil foi construída por Johann Zahn. Antes do advento deste dispositivo, as câmeras tinham o tamanho de uma sala e não eram portáteis. Embora um dispositivo tenha sido feito por um cientista irlandês Robert Boyle e Robert Hooke, era uma câmera transportável, mas ainda assim esse dispositivo era muito grande para carregá-la de um lugar para outro.

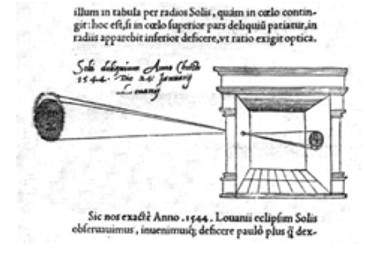

Origem da fotografia

Embora a câmera obscura tenha sido construída em 1000 por um cientista muçulmano. Mas seu primeiro uso real foi descrito no século 13 por um filósofo inglês Roger Bacon. Roger sugeriu o uso de câmera para a observação de eclipses solares.

Da Vinci

Embora muitas melhorias tenham sido feitas antes do século 15, as melhorias e as descobertas feitas por Leonardo di ser Piero da Vinci foram notáveis. Da Vinci foi um grande artista, músico, anatomista e engenheiro de guerra. Ele é creditado por muitas invenções. Sua uma das pinturas mais famosas inclui, a pintura de Mona Lisa.

Da vinci não só construiu uma câmera obscura seguindo o princípio de uma câmera pin hole, mas também a usa como auxílio de desenho para seu trabalho artístico. Em seu trabalho, que foi descrito no Codex Atlanticus, muitos princípios da camera obscura foram definidos.

Sua câmera segue o princípio de uma câmera de orifício de alfinete, que pode ser descrita como

Quando imagens de objetos iluminados penetram por um pequeno orifício em uma sala muito escura, você verá [na parede oposta] esses objetos em sua forma e cor adequadas, reduzidos em tamanho na posição invertida, devido à interseção dos raios.

Primeira fotografia

A primeira fotografia foi tirada em 1814 pelo inventor francês Joseph Nicephore Niepce. Ele captura a primeira fotografia de uma vista da janela do Le Gras, revestindo a placa de estanho com betume e depois expondo essa placa à luz.

Primeira fotografia subaquática

A primeira fotografia subaquática foi tirada por um matemático inglês William Thomson usando uma caixa à prova d'água. Isso foi feito em 1856.

A origem do filme

A origem do cinema foi introduzida por um inventor e filantropo americano conhecido como George Eastman, considerado o pioneiro da fotografia.

Ele fundou a empresa Eastman Kodak, famosa por desenvolver filmes. A empresa começou a fabricar filme de papel em 1885. Ele primeiro criou a câmera Kodak e depois Brownie. Brownie era uma câmera box e ganhou sua popularidade devido ao seu recurso de Snapshot.

Após o advento do filme, a indústria de câmeras mais uma vez teve um boom e uma invenção levou a outra.

Leica e Argus

Leica e argus são as duas câmeras analógicas desenvolvidas em 1925 e 1939, respectivamente. A câmera Leica foi construída usando um filme cine 35mm.

Argus era outra câmera analógica que usa o formato 35mm e era bastante barata em comparação com a Leica e se tornou muito popular.

Câmeras analógicas de CFTV

Em 1942, um engenheiro alemão Walter Bruch desenvolveu e instalou o primeiro sistema de câmeras analógicas de CFTV. Ele também é creditado pela invenção da televisão em cores em 1960.

Photo Pac

A primeira câmera descartável foi lançada em 1949 pela Photo Pac. A câmera era apenas uma câmera de uso único com um rolo de filme já incluído. As versões posteriores do Photo pac eram à prova d'água e ainda tinham flash.

Câmeras digitais

Mavica da Sony

Mavica (a câmera de vídeo magnética) foi lançada pela Sony em 1981 foi a primeira virada de jogo no mundo das câmeras digitais. As imagens foram gravadas em disquetes e as imagens podem ser visualizadas posteriormente em qualquer tela do monitor.

Não era uma câmera digital pura, mas sim uma câmera analógica. Mas ganhou popularidade devido à sua capacidade de armazenamento de imagens em disquetes. Isso significa que agora você pode armazenar imagens por um longo período, e você pode salvar um grande número de imagens no disquete que são substituídas pelo novo disco em branco, quando ficam cheias. O Mavica tem capacidade para armazenar 25 imagens em disco.

Mais uma coisa importante que o mavica introduziu foi sua capacidade de 0,3 mega pixel de capturar fotos.

Câmeras digitais

Fuji DS-1P camera da Fuji films 1988 foi a primeira verdadeira câmera digital

Nikon D1 foi uma câmera de 2,74 megapixels e a primeira câmera SLR digital comercial desenvolvida pela Nikon, e era muito acessível para os profissionais.

Hoje, as câmeras digitais estão incluídas nos telefones celulares com resolução e qualidade muito altas.

Visto que o processamento de imagem digital tem aplicações muito amplas e quase todos os campos técnicos são afetados pelo DIP, discutiremos apenas algumas das principais aplicações do DIP.

O processamento digital de imagens não se limita apenas a ajustar a resolução espacial das imagens cotidianas capturadas pela câmera. Não se limita apenas a aumentar o brilho da foto, etc. Pelo contrário, é muito mais do que isso.

As ondas eletromagnéticas podem ser consideradas como um fluxo de partículas, em que cada partícula se move com a velocidade da luz. Cada partícula contém um feixe de energia. Esse feixe de energia é chamado de fóton.

O espectro eletromagnético de acordo com a energia do fóton é mostrado abaixo.

Neste espectro eletromagnético, somos capazes de ver apenas o espectro visível. O espectro visível inclui principalmente sete cores diferentes comumente denominadas como (VIBGOYR). VIBGOYR significa violeta, índigo, azul, verde, laranja, amarelo e vermelho.

Mas isso não anula a existência de outras coisas no espectro. Nosso olho humano só pode ver a parte visível, na qual vimos todos os objetos. Mas uma câmera pode ver outras coisas que a olho nu não consegue ver. Por exemplo: raios x, raios gama, etc. Portanto, a análise de tudo isso também é feita no processamento digital de imagens.

Esta discussão leva a outra questão que é

por que precisamos analisar todas as outras coisas no espectro EM também?

A resposta a esta pergunta está no fato, porque outras coisas como o XRay têm sido amplamente utilizadas no campo da medicina. A análise de raios gama é necessária porque é amplamente utilizado na medicina nuclear e observação astronômica. O mesmo acontece com o resto das coisas no espectro EM.

Aplicações de processamento digital de imagens

Alguns dos principais campos nos quais o processamento de imagem digital é amplamente utilizado são mencionados abaixo

Nitidez e restauração de imagem

Campo médico

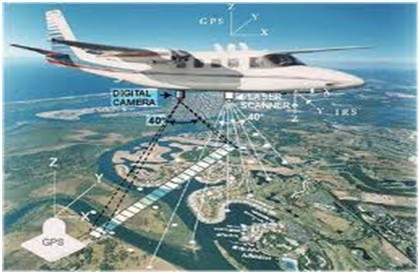

Sensoriamento remoto

Transmissão e codificação

Visão da máquina / robô

Processamento de cor

Reconhecimento de padrões

Processamento de vídeo

Imagem Microscópica

Others

Nitidez e restauração de imagem

A nitidez e a restauração de imagem referem-se aqui a processar imagens que foram capturadas com a câmera moderna para torná-las uma imagem melhor ou para manipular essas imagens de forma a atingir o resultado desejado. Refere-se a fazer o que o Photoshop normalmente faz.

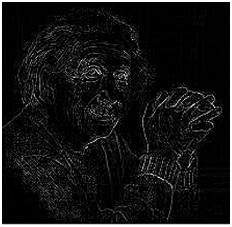

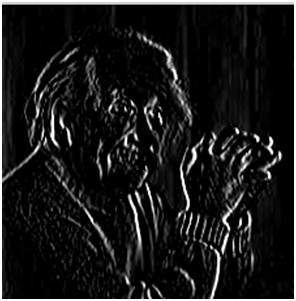

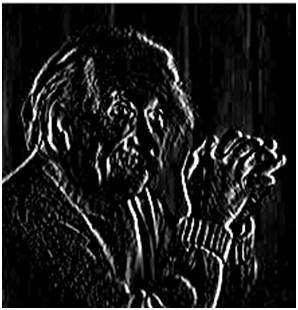

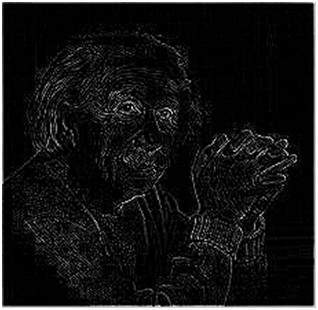

Isso inclui zoom, desfoque, nitidez, escala de cinza para conversão de cor, detecção de bordas e vice-versa, recuperação de imagem e reconhecimento de imagem. Os exemplos comuns são:

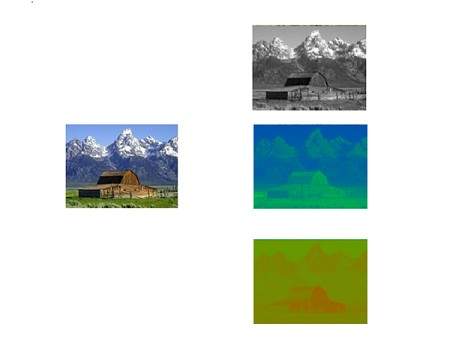

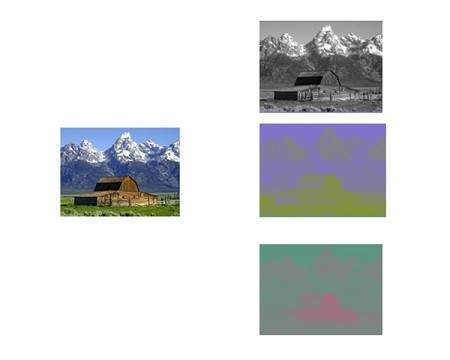

A imagem original

A imagem ampliada

Imagem borrada

Imagem nítida

Arestas

Campo médico

As aplicações comuns do DIP no campo da medicina são

Imagem de raios gama

PET scan

Imagem de raio x

CT Médica

Imagem UV

Imagem UV

No campo do sensoriamento remoto, a área da Terra é varrida por um satélite ou de um terreno muito elevado e, em seguida, é analisada para obter informações sobre ela. Uma aplicação particular do processamento digital de imagens no campo do sensoriamento remoto é a detecção de danos à infraestrutura causados por um terremoto.

Como leva mais tempo para agarrar os danos, mesmo se houver danos graves. Visto que a área afetada pelo terremoto às vezes é tão grande, que não é possível examiná-la a olho nu para estimar os danos. Mesmo se for, é um procedimento muito agitado e demorado. Portanto, uma solução para isso é encontrada no processamento digital de imagens. Uma imagem da área afetada é capturada de cima do solo e, em seguida, é analisada para detectar os vários tipos de danos causados pelo terremoto.

As principais etapas incluídas na análise são

A extração de bordas

Análise e aprimoramento de vários tipos de arestas

Transmissão e codificação

A primeira imagem transmitida por fio foi de Londres a Nova York por meio de um cabo submarino. A imagem enviada é mostrada abaixo.

A foto enviada demorou três horas para ir de um lugar a outro.

Agora, imagine que hoje podemos ver o feed de vídeo ao vivo ou imagens de cctv ao vivo de um continente para outro com apenas um atraso de segundos. Isso significa que muito trabalho foi feito também neste campo. Este campo não se concentra apenas na transmissão, mas também na codificação. Muitos formatos diferentes foram desenvolvidos para largura de banda alta ou baixa para codificar fotos e transmiti-las pela internet ou etc.

Visão da máquina / robô

Além dos muitos desafios que um robô enfrenta hoje, um dos maiores desafios ainda é aumentar a visão do robô. Torne o robô capaz de ver as coisas, identificá-las, identificar os obstáculos, etc. Muito trabalho foi contribuído por este campo e um outro campo completo de visão computacional foi introduzido para trabalhar nele.

Deteção de obstáculos

A detecção de obstáculos é uma das tarefas comuns que têm sido feitas por meio do processamento de imagens, identificando diferentes tipos de objetos na imagem e calculando a distância entre o robô e os obstáculos.

Robô seguidor de linha

A maioria dos robôs de hoje trabalha seguindo a linha e, portanto, são chamados de robôs seguidores de linha. Isso ajuda um robô a se mover em seu caminho e realizar algumas tarefas. Isso também foi alcançado por meio do processamento de imagem.

Processamento de cor

O processamento de cores inclui o processamento de imagens coloridas e diferentes espaços de cores usados. Por exemplo, modelo de cores RGB, YCbCr, HSV. Também envolve estudar a transmissão, armazenamento e codificação dessas imagens coloridas.

Reconhecimento de padrões

O reconhecimento de padrões envolve o estudo do processamento de imagens e de vários outros campos que incluem o aprendizado de máquina (um ramo da inteligência artificial). No reconhecimento de padrões, o processamento de imagem é usado para identificar os objetos em uma imagem e, em seguida, o aprendizado de máquina é usado para treinar o sistema para a mudança no padrão. O reconhecimento de padrões é usado no diagnóstico auxiliado por computador, reconhecimento de escrita, reconhecimento de imagens, etc.

Processamento de vídeo

Um vídeo nada mais é do que o movimento muito rápido das imagens. A qualidade do vídeo depende do número de quadros / imagens por minuto e da qualidade de cada quadro sendo usado. O processamento de vídeo envolve redução de ruído, aprimoramento de detalhes, detecção de movimento, conversão de taxa de quadros, conversão de proporção de aspecto, conversão de espaço de cores, etc.

Veremos este exemplo para entender o conceito de dimensão.

Considere que você tem um amigo que mora na lua e quer lhe enviar um presente no seu presente de aniversário. Ele perguntou sobre sua residência na terra. O único problema é que o serviço de correio na lua não entende o endereço alfabético, mas apenas as coordenadas numéricas. Então, como você envia a ele sua posição na terra?

É daí que vem o conceito de dimensões. As dimensões definem o número mínimo de pontos necessários para apontar uma posição de qualquer objeto específico dentro de um espaço.

Portanto, vamos voltar ao nosso exemplo novamente, no qual você deve enviar sua posição na Terra para seu amigo na lua. Você envia a ele três pares de coordenadas. O primeiro é denominado longitude, o segundo denominado latitude e o terceiro denominado altitude.

Essas três coordenadas definem sua posição na terra. Os dois primeiros definem sua localização e o terceiro define sua altura acima do nível do mar.

Isso significa que apenas três coordenadas são necessárias para definir sua posição na terra. Isso significa que você vive em um mundo que é tridimensional. E, portanto, isso não apenas responde à questão sobre a dimensão, mas também responde a razão pela qual vivemos em um mundo 3D.

Já que estamos estudando este conceito em referência ao processamento digital de imagens, vamos agora relacionar este conceito de dimensão com uma imagem.

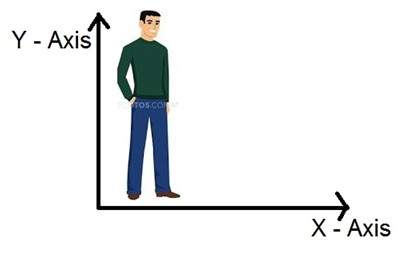

Dimensões da imagem

Portanto, se vivemos no mundo 3D, significa um mundo tridimensional, quais são as dimensões de uma imagem que capturamos. Uma imagem é bidimensional, por isso também definimos uma imagem como um sinal bidimensional. Uma imagem tem apenas altura e largura. Uma imagem não tem profundidade. Basta dar uma olhada na imagem abaixo.

Se você olhar para a figura acima, verá que ela tem apenas dois eixos, que são os eixos de altura e largura. Você não pode perceber a profundidade desta imagem. É por isso que dizemos que uma imagem é um sinal bidimensional. Mas nosso olho é capaz de perceber objetos tridimensionais, mas isso seria mais explicado no próximo tutorial de como a câmera funciona e a imagem é percebida.

Esta discussão leva a algumas outras questões sobre como os sistemas de 3 dimensões são formados a partir de 2 dimensões.

Como funciona a televisão?

Se olharmos a imagem acima, veremos que é uma imagem bidimensional. Para convertê-lo em três dimensões, precisamos de uma outra dimensão. Vamos levar um tempo como a terceira dimensão, nesse caso vamos mover esta imagem bidimensional sobre o tempo da terceira dimensão. O mesmo conceito que acontece na televisão, que nos ajuda a perceber a profundidade de diferentes objetos em uma tela. Isso significa que o que aparece na TV ou o que vemos na tela da televisão é 3D? Bem, podemos sim. A razão é que, no caso da TV, se estamos reproduzindo um vídeo. Então, um vídeo nada mais é do que imagens bidimensionais que se movem ao longo da dimensão do tempo. Como objetos bidimensionais estão se movendo sobre a terceira dimensão, que é um tempo, podemos dizer que é tridimensional.

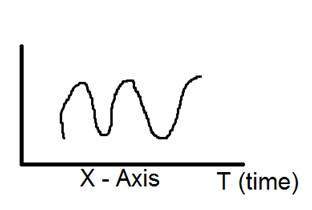

Diferentes dimensões de sinais

Sinal de 1 dimensão

O exemplo comum de um sinal de 1 dimensão é uma forma de onda. Pode ser representado matematicamente como

F (x) = forma de onda

Onde x é uma variável independente. Como é um sinal de uma dimensão, é por isso que há apenas uma variável x usada.

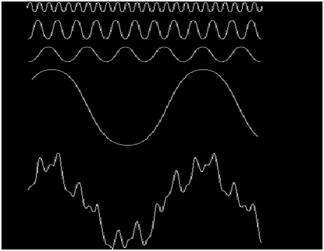

A representação pictórica de um sinal unidimensional é fornecida abaixo:

A figura acima mostra um sinal unidimensional.

Agora, isso leva a outra questão, que é, embora seja um sinal unidimensional, então por que ele tem dois eixos? A resposta a essa pergunta é que, embora seja um sinal unidimensional, estamos desenhando em um espaço bidimensional. Ou podemos dizer que o espaço no qual estamos representando esse sinal é bidimensional. É por isso que parece um sinal bidimensional.

Talvez você possa entender melhor o conceito de uma dimensão olhando para a figura abaixo.

Agora volte à nossa discussão inicial sobre dimensão. Considere a figura acima como uma linha real com números positivos de um ponto a outro. Agora, se tivermos que explicar a localização de qualquer ponto nesta linha, precisamos apenas de um número, o que significa apenas uma dimensão.

Sinal de 2 dimensões

O exemplo comum de um sinal bidimensional é uma imagem, que já foi discutida acima.

Como já vimos, uma imagem é um sinal bidimensional, ou seja: possui duas dimensões. Pode ser representado matematicamente como:

F (x, y) = imagem

Onde x e y são duas variáveis. O conceito de duas dimensões também pode ser explicado em termos matemáticos como:

Agora na figura acima, rotule os quatro cantos do quadrado como A, B, C e D respectivamente. Se chamarmos, um segmento de linha na figura AB e o outro CD, então podemos ver que esses dois segmentos paralelos se unem e formam um quadrado. Cada segmento de linha corresponde a uma dimensão, portanto, esses dois segmentos de linha correspondem a 2 dimensões.

Sinal de 3 dimensões

Sinal tridimensional, como ele denomina, refere-se aos sinais que têm três dimensões. O exemplo mais comum foi discutido no início, que é o nosso mundo. Vivemos em um mundo tridimensional. Este exemplo foi discutido de forma muito elaborada. Outro exemplo de sinal tridimensional é um cubo ou dados volumétricos ou o exemplo mais comum seria um personagem animado ou de desenho animado 3D.

A representação matemática do sinal tridimensional é:

F (x, y, z) = personagem animado.

Outro eixo ou dimensão Z está envolvido em uma dimensão tridimensional, o que dá a ilusão de profundidade. Em um sistema de coordenadas cartesianas, pode ser visto como:

Sinal de 4 dimensões

Em um sinal de quatro dimensões, quatro dimensões estão envolvidas. Os três primeiros são iguais aos de um sinal tridimensional que são: (X, Y, Z), e o quarto que é adicionado a eles é T (tempo). O tempo é frequentemente referido como dimensão temporal, que é uma forma de medir a mudança. Matematicamente, um sinal de quatro d pode ser declarado como:

F (x, y, z, t) = filme animado.

O exemplo comum de um sinal quadridimensional pode ser um filme 3D animado. Como cada personagem é um personagem 3D e depois eles são movidos com relação ao tempo, devido ao que vimos uma ilusão de um filme tridimensional mais parecido com um mundo real.

Isso significa que, na realidade, os filmes animados são 4 dimensionais, ou seja: movimento de personagens 3D ao longo do tempo da quarta dimensão.

Como funciona o olho humano?

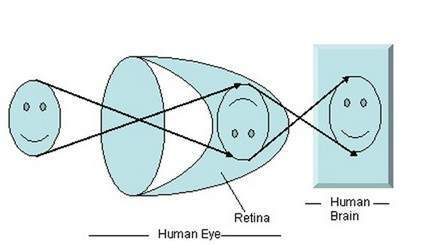

Antes de discutirmos a formação da imagem em câmeras analógicas e digitais, devemos primeiro discutir a formação da imagem no olho humano. Como o princípio básico seguido pelas câmeras foi retirado do caminho, o olho humano funciona.

Quando a luz incide sobre um objeto específico, ela é refletida de volta após atingir o objeto. Os raios de luz, quando passam pelas lentes do olho, formam um ângulo específico, e a imagem é formada na retina, que fica na parte de trás da parede. A imagem formada é invertida. Essa imagem é então interpretada pelo cérebro e isso nos torna capazes de entender as coisas. Devido à formação do ângulo, somos capazes de perceber a altura e profundidade do objeto que estamos vendo. Isso foi mais explicado no tutorial de transformação de perspectiva.

Como você pode ver na figura acima, quando a luz do sol incide sobre o objeto (neste caso, o objeto é um rosto), ela é refletida de volta e diferentes raios formam diferentes ângulos quando são passados através da lente e uma imagem invertida de o objeto foi formado na parede posterior. A última parte da figura denota que o objeto foi interpretado pelo cérebro e reinvertido.

Agora vamos levar nossa discussão de volta à formação da imagem em câmeras analógicas e digitais.

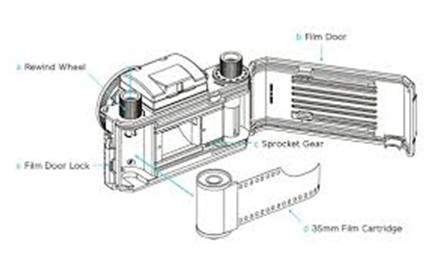

Formação de imagem em câmeras analógicas

Em câmeras analógicas, a formação da imagem se deve à reação química que ocorre na tira que é usada para a formação da imagem.

Uma tira de 35 mm é usada na câmera analógica. É denotado na figura por um cartucho de filme de 35 mm. Esta tira é revestida com haleto de prata (uma substância química).

Uma tira de 35 mm é usada na câmera analógica. É denotado na figura por um cartucho de filme de 35 mm. Esta tira é revestida com haleto de prata (uma substância química).

A luz nada mais é do que pequenas partículas conhecidas como partículas de fótons. Então, quando essas partículas de fótons são passadas pela câmera, ela reage com as partículas de haleto de prata na tira e resulta na prata, que é o negativo da imagem.

Para entender melhor, dê uma olhada nesta equação.

Fótons (partículas de luz) + haleto de prata? prata ? negativo da imagem.

Este é apenas o básico, embora a formação da imagem envolva muitos outros conceitos relacionados à passagem da luz por dentro, e os conceitos de obturador e velocidade do obturador e abertura e sua abertura, mas por agora iremos passar para a próxima parte. Embora a maioria desses conceitos tenha sido discutida em nosso tutorial de obturador e abertura.

Este é apenas o básico, embora a formação da imagem envolva muitos outros conceitos relacionados à passagem da luz por dentro, e os conceitos de obturador e velocidade do obturador e abertura e sua abertura, mas por agora iremos passar para a próxima parte. Embora a maioria desses conceitos tenha sido discutida em nosso tutorial de obturador e abertura.

Formação de imagem em câmeras digitais

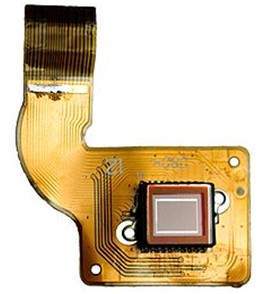

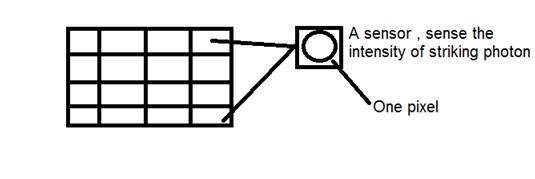

Nas câmeras digitais, a formação da imagem não se deve à reação química que ocorre, mas é um pouco mais complexa que isso. Na câmera digital, um conjunto CCD de sensores é usado para a formação da imagem.

Formação de imagem por meio de matriz CCD

CCD significa dispositivo acoplado por carga. É um sensor de imagem e, como outros sensores, detecta os valores e os converte em um sinal elétrico. No caso do CCD, ele detecta a imagem e a converte em sinal elétrico, etc.

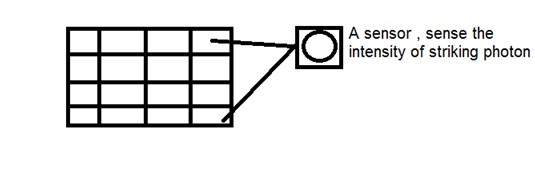

Na verdade, esse CCD tem o formato de uma matriz ou uma grade retangular. É como uma matriz, com cada célula da matriz contendo um censor que detecta a intensidade do fóton.

Assim como as câmeras analógicas, também no caso das digitais, quando a luz incide sobre o objeto, a luz reflete de volta após atingir o objeto e entrar no interior da câmera.

Cada sensor do próprio conjunto CCD é um sensor analógico. Quando os fótons de luz atingem o chip, ele é mantido como uma pequena carga elétrica em cada fotossensor. A resposta de cada sensor é diretamente igual à quantidade de luz ou energia (fóton) atingida na superfície do sensor.

Como já definimos uma imagem como um sinal bidimensional e devido à formação bidimensional da matriz CCD, uma imagem completa pode ser obtida a partir dessa matriz CCD.

Ele tem um número limitado de sensores e significa que um detalhe limitado pode ser capturado por ele. Além disso, cada sensor pode ter apenas um valor em relação a cada partícula de fóton que o atinge.

Assim, o número de fótons que atingem (atuais) são contados e armazenados. Para medi-los com precisão, os sensores CMOS externos também são acoplados ao conjunto CCD.

Introdução ao pixel

O valor de cada sensor da matriz CCD refere-se a cada um dos valores do pixel individual. O número de sensores = número de pixels. Isso também significa que cada sensor pode ter apenas um e apenas um valor.

Armazenando imagem

As cargas armazenadas pela matriz CCD são convertidas em voltagem, um pixel de cada vez. Com a ajuda de circuitos adicionais, essa tensão é convertida em uma informação digital e armazenada.

Cada empresa que fabrica câmeras digitais, faz seus próprios sensores CCD. Isso inclui Sony, Mistubishi, Nikon, Samsung, Toshiba, FujiFilm, Canon etc.

Além de outros fatores, a qualidade da imagem capturada também depende do tipo e da qualidade da matriz CCD utilizada.

Neste tutorial, discutiremos alguns dos conceitos básicos de câmera, como abertura, obturador, velocidade do obturador, ISO e discutiremos o uso coletivo desses conceitos para capturar uma boa imagem.

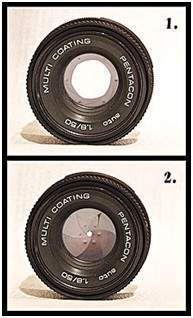

Abertura

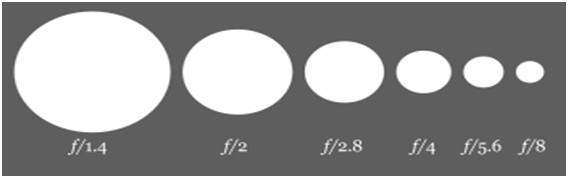

A abertura é uma pequena abertura que permite que a luz entre na câmera. Aqui está a imagem da abertura.

Você verá algumas pequenas lâminas como coisas dentro da abertura. Essas lâminas criam uma forma octogonal que pode ser aberta e fechada. E, portanto, faz sentido que, quanto mais lâminas se abrirem, maior será o buraco pelo qual a luz teria que passar. Quanto maior for o buraco, mais luz pode entrar.

Efeito

O efeito da abertura corresponde diretamente ao brilho e escuridão de uma imagem. Se a abertura for ampla, permitirá que mais luz entre na câmera. Mais luz resultaria em mais fótons, o que acabaria resultando em uma imagem mais brilhante.

O exemplo disso é mostrado abaixo

Considere essas duas fotos

O do lado direito parece mais claro, isso significa que quando foi capturado pela câmera, a abertura estava totalmente aberta. Em comparação com a outra foto do lado esquerdo, que é muito escura em comparação com a primeira, isso mostra que quando aquela imagem foi capturada, sua abertura não estava totalmente aberta.

Tamanho

Agora vamos discutir a matemática por trás da abertura. O tamanho da abertura é denotado por um valor af. E é inversamente proporcional à abertura da abertura.

Aqui estão as duas equações que melhor explicam este conceito.

Tamanho de abertura grande = valor f pequeno

Tamanho da abertura pequena = maior valor f

De forma pictórica, pode ser representado como:

Obturador

Após a abertura, vem o obturador. A luz, quando pode passar pela abertura, incide diretamente sobre o obturador. O obturador é na verdade uma cobertura, uma janela fechada ou pode ser considerado uma cortina. Lembre-se de quando falamos sobre o sensor de matriz CCD no qual a imagem é formada. Bem atrás do obturador está o sensor. Portanto, o obturador é a única coisa que fica entre a formação da imagem e a luz, quando ela sai da abertura.

Assim que o obturador é aberto, a luz incide sobre o sensor de imagem e a imagem é formada na matriz.

Efeito

Se o obturador permitir que a luz passe um pouco mais, a imagem seria mais brilhante. Da mesma forma, uma imagem mais escura é produzida quando um obturador pode se mover muito rapidamente e, portanto, a luz que pode passar tem muito menos fótons, e a imagem que é formada no sensor de matriz CCD é muito escura.

O obturador tem mais dois conceitos principais:

Velocidade do obturador

Tempo do obturador

Velocidade do obturador

A velocidade do obturador pode ser referida como o número de vezes que o obturador abre ou fecha. Lembre-se de que não estamos falando sobre por quanto tempo a veneziana abre ou fecha.

Tempo do obturador

O tempo do obturador pode ser definido como

Quando o obturador está aberto, o tempo de espera que leva até que seja fechado é chamado de tempo do obturador.

Neste caso, não estamos falando sobre quantas vezes a veneziana abriu ou fechou, mas sim por quanto tempo ela permanece aberta.

Por exemplo:

Podemos entender melhor esses dois conceitos dessa forma. Isso quer dizer que uma veneziana abre 15 vezes e depois fecha, e para cada vez que abre por 1 segundo e depois fecha. Neste exemplo, 15 é a velocidade do obturador e 1 segundo é o tempo do obturador.

Relação

A relação entre a velocidade do obturador e o tempo do obturador é que ambos são inversamente proporcionais um ao outro.

Essa relação pode ser definida na equação abaixo.

Mais velocidade do obturador = menos tempo do obturador

Menos velocidade do obturador = mais tempo do obturador.

Explicação:

Quanto menor for o tempo necessário, maior será a velocidade. E quanto maior o tempo necessário, menor é a velocidade.

Formulários

Esses dois conceitos juntos formam uma variedade de aplicações. Alguns deles são fornecidos abaixo.

Objetos em movimento rápido:

Se você fosse capturar a imagem de um objeto em movimento rápido, poderia ser um carro ou qualquer coisa. O ajuste da velocidade do obturador e seu tempo afetaria muito.

Portanto, para capturar uma imagem como esta, faremos duas alterações:

Aumentar a velocidade do obturador

Diminuir o tempo do obturador

O que acontece é que, quando aumentamos a velocidade do obturador, quanto mais vezes, o obturador abre ou fecha. Significa que diferentes amostras de luz permitiriam a passagem. E quando diminuímos o tempo do obturador, significa que capturaremos imediatamente a cena e fecharemos o portão do obturador.

Se você fizer isso, terá uma imagem nítida de um objeto em movimento rápido.

Para entendê-lo, veremos este exemplo. Suponha que você queira capturar a imagem de uma queda d'água em movimento rápido.

Você define a velocidade do obturador para 1 segundo e tira uma foto. Isto é o que você recebe

Então você define a velocidade do obturador para uma velocidade mais rápida e você consegue.

Então, novamente, você define a velocidade do obturador para ainda mais rápida e você consegue.

Você pode ver na última foto que aumentamos a velocidade do obturador para muito rápido, o que significa que o obturador é aberto ou fechado em 200 de 1 segundo e, portanto, temos uma imagem nítida.

ISO

O fator ISO é medido em números. Isso denota a sensibilidade da luz à câmera. Se o número ISO for reduzido, significa que nossa câmera é menos sensível à luz e se o número ISO for alto, significa que é mais sensível.

Efeito

Quanto mais alto for o ISO, mais brilhante será a imagem. SE ISO estiver definido para 1600, a imagem ficará muito mais clara e vice-versa.

Efeito colateral

Se o ISO aumentar, o ruído na imagem também aumenta. Hoje, a maioria das empresas fabricantes de câmeras está trabalhando para remover o ruído da imagem quando o ISO é definido para uma velocidade mais alta.

Pixel

Pixel é o menor elemento de uma imagem. Cada pixel corresponde a qualquer valor. Em uma imagem em escala de cinza de 8 bits, o valor do pixel está entre 0 e 255. O valor de um pixel em qualquer ponto corresponde à intensidade dos fótons de luz que atingem aquele ponto. Cada pixel armazena um valor proporcional à intensidade da luz naquele local específico.

PEL

Um pixel também é conhecido como PEL. Você pode entender melhor o pixel nas imagens abaixo.

Na foto acima, pode haver milhares de pixels, que juntos formam esta imagem. Vamos ampliar essa imagem na medida em que formos capazes de ver algumas divisões de pixels. Isso é mostrado na imagem abaixo.

Na foto acima, pode haver milhares de pixels, que juntos formam esta imagem. Vamos ampliar essa imagem na medida em que formos capazes de ver algumas divisões de pixels. Isso é mostrado na imagem abaixo.

Relacionamento com matriz CCD

Vimos como uma imagem é formada na matriz CCD. Portanto, um pixel também pode ser definido como

A menor divisão da matriz CCD também é conhecida como pixel.

Cada divisão da matriz CCD contém o valor em relação à intensidade do fóton que a atinge. Este valor também pode ser chamado de pixel

Cálculo do número total de pixels

Definimos uma imagem como um sinal ou matriz bidimensional. Nesse caso, o número de PEL seria igual ao número de linhas multiplicado pelo número de colunas.

Isso pode ser representado matematicamente como abaixo:

Número total de pixels = número de linhas (X) número de colunas

Ou podemos dizer que o número de pares de coordenadas (x, y) compõe o número total de pixels.

Veremos com mais detalhes no tutorial de tipos de imagem, como calculamos os pixels em uma imagem colorida.

Nível de cinza

O valor do pixel em qualquer ponto denota a intensidade da imagem naquele local, e isso também é conhecido como nível de cinza.

Veremos com mais detalhes sobre o valor dos pixels no tutorial de armazenamento de imagens e bits por pixel, mas por enquanto vamos olhar apenas para o conceito de apenas um valor de pixel.

Valor do pixel. (0)

Como já foi definido no início deste tutorial, que cada pixel pode ter apenas um valor e cada valor denota a intensidade da luz naquele ponto da imagem.

Agora veremos um valor muito único 0. O valor 0 significa ausência de luz. Isso significa que 0 denota escuro e, além disso, significa que sempre que um pixel tem um valor de 0, significa que nesse ponto, a cor preta seria formada.

Dê uma olhada nesta matriz de imagem

| 0 | 0 | 0 |

| 0 | 0 | 0 |

| 0 | 0 | 0 |

Agora, esta matriz de imagem foi totalmente preenchida com 0. Todos os pixels têm um valor de 0. Se tivéssemos que calcular o número total de pixels desta matriz, é assim que o faremos.

Nº total de pixels = nº total. de linhas X total no. de colunas

= 3 X 3

= 9.

Isso significa que uma imagem seria formada com 9 pixels, e essa imagem teria uma dimensão de 3 linhas e 3 colunas e, o mais importante, essa imagem seria preta.

A imagem resultante que seria feita seria algo assim

Agora, por que essa imagem está toda preta. Porque todos os pixels da imagem têm valor 0.

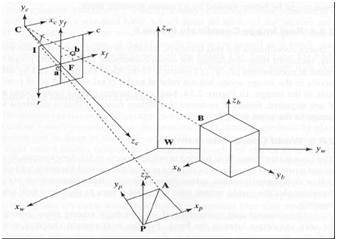

Quando os olhos humanos veem as coisas de perto, eles parecem maiores em comparação com aqueles que estão longe. Isso é chamado de perspectiva de uma maneira geral. Considerando que a transformação é a transferência de um objeto etc. de um estado para outro.

Portanto, no geral, a transformação da perspectiva trata da conversão do mundo 3D em imagem 2d. O mesmo princípio sobre o qual a visão humana funciona e o mesmo princípio sobre o qual a câmera funciona.

Veremos em detalhes por que isso acontece, que os objetos que estão perto de você parecem maiores, enquanto os que estão longe parecem menores, embora pareçam maiores quando você os alcança.

Começaremos esta discussão pelo conceito de quadro de referência:

Quadro de Referência:

O quadro de referência é basicamente um conjunto de valores em relação aos quais medimos algo.

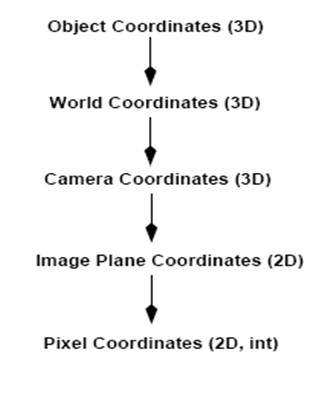

5 quadros de referência

Para analisar um mundo / imagem / cena 3D, são necessários 5 quadros de referência diferentes.

Object

World

Camera

Image

Pixel

Quadro de coordenadas do objeto

O quadro de coordenadas do objeto é usado para modelar objetos. Por exemplo, verificar se um determinado objeto está em um local adequado em relação ao outro objeto. É um sistema de coordenadas 3D.

Quadro de coordenadas mundiais

O quadro de coordenadas do mundo é usado para co-relacionar objetos em um mundo tridimensional. É um sistema de coordenadas 3D.

Quadro de coordenadas da câmera

O quadro de coordenadas da câmera é usado para relacionar objetos em relação à câmera. É um sistema de coordenadas 3D.

Quadro de coordenadas da imagem

Não é um sistema de coordenadas 3D, mas sim um sistema 2D. É usado para descrever como os pontos 3D são mapeados em um plano de imagem 2d.

Quadro de coordenadas de pixel

É também um sistema de coordenadas 2d. Cada pixel tem um valor de coordenadas de pixel.

Transformação entre estes 5 frames

É assim que uma cena 3D se transforma em 2d, com imagem de pixels.

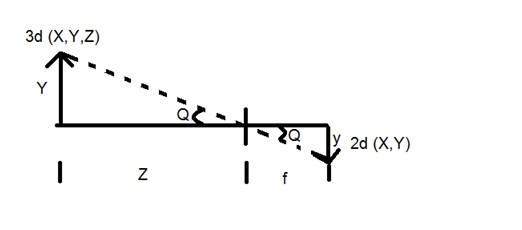

Agora vamos explicar esse conceito matematicamente.

Y = objeto 3D

y = imagem 2d

f = comprimento focal da câmera

Z = distância entre a imagem e a câmera

Agora, existem dois ângulos diferentes formados nesta transformação que são representados por Q.

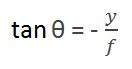

O primeiro ângulo é

Onde menos denota que a imagem está invertida. O segundo ângulo que se forma é:

Comparando essas duas equações, obtemos

A partir dessa equação, podemos ver que quando os raios de luz refletem de volta após atingirem o objeto, passado da câmera, uma imagem invertida é formada.

Podemos entender melhor isso, com este exemplo.

Por exemplo

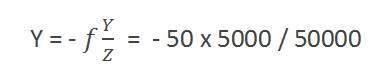

Calculando o tamanho da imagem formada

Suponha que foi tirada uma imagem de uma pessoa com 5m de altura, e em pé a uma distância de 50m da câmera, e temos que dizer que o tamanho da imagem da pessoa, com uma câmera de comprimento focal é de 50mm.

Solução:

Como a distância focal é em milímetros, temos que converter tudo em milímetros para podermos calculá-la.

Então,

Y = 5000 mm.

f = 50 mm.

Z = 50000 mm.

Colocando os valores na fórmula, obtemos

= -5 mm.

Novamente, o sinal de menos indica que a imagem está invertida.

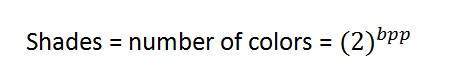

Bpp ou bits por pixel denota o número de bits por pixel. O número de cores diferentes em uma imagem depende da profundidade da cor ou bits por pixel.

Bits em matemática:

É como brincar com bits binários.

Quantos números podem ser representados por um bit.

0

1

Quantas combinações de dois bits podem ser feitas.

00

01

10

11

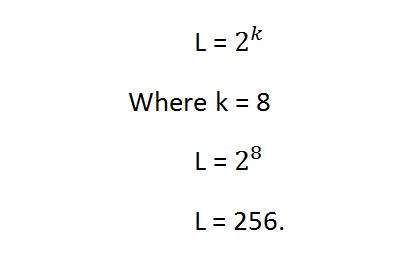

Se criarmos uma fórmula para o cálculo do número total de combinações que podem ser feitas a partir do bit, seria assim.

Onde bpp denota bits por pixel. Coloque 1 na fórmula, você obtém 2, coloque 2 na fórmula, e você obtém 4. Ele cresce exponencialmente.

Número de cores diferentes:

Agora, como dissemos no início, que o número de cores diferentes depende do número de bits por pixel.

A tabela para alguns dos bits e suas cores é fornecida abaixo.

| Bits por pixel | Número de cores |

|---|---|

| 1 bpp | 2 cores |

| 2 bpp | 4 cores |

| 3 bpp | 8 cores |

| 4 bpp | 16 cores |

| 5 bpp | 32 cores |

| 6 bpp | 64 cores |

| 7 bpp | 128 cores |

| 8 bpp | 256 cores |

| 10 bpp | 1024 cores |

| 16 bpp | 65536 cores |

| 24 bpp | 16777216 cores (16,7 milhões de cores) |

| 32 bpp | 4294967296 cores (4294 milhões de cores) |

Esta tabela mostra diferentes bits por pixel e a quantidade de cor que eles contêm.

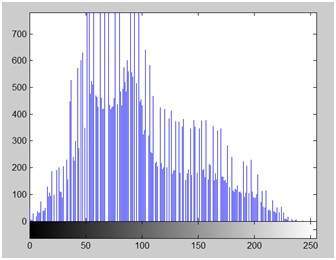

Tons

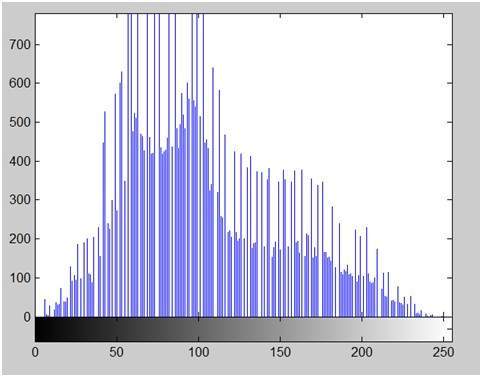

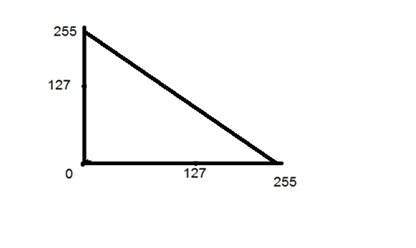

Você pode notar facilmente o padrão de crescimento exponencional. A famosa imagem em escala de cinza é de 8 bpp, o que significa que tem 256 cores diferentes ou 256 tons.

As sombras podem ser representadas como:

As imagens coloridas geralmente têm o formato de 24 bpp ou 16 bpp.

Veremos mais sobre outros formatos de cores e tipos de imagem no tutorial de tipos de imagem.

Valores de cor:

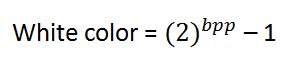

Cor preta:

Cor branca:

O valor que denota a cor branca pode ser calculado como:

No caso de 1 bpp, 0 denota preto e 1 denota branco.

No caso de 8 bpp, 0 denota preto e 255 denota branco.

Cor cinza:

Ao calcular o valor da cor preta e branca, você pode calcular o valor do pixel da cor cinza.

A cor cinza é, na verdade, o ponto médio do preto e branco. Dito isto,

No caso de 8bpp, o valor do pixel que denota a cor cinza é 127 ou 128bpp (se você contar de 1, não de 0).

Requisitos de armazenamento de imagens

Após a discussão sobre bits por pixel, agora temos tudo o que precisamos para calcular o tamanho de uma imagem.

Tamanho da imagem

O tamanho de uma imagem depende de três coisas.

Numero de linhas

Numero de colunas

Número de bits por pixel

A fórmula para calcular o tamanho é fornecida abaixo.

Tamanho de uma imagem = linhas * cols * bpp

Isso significa que se você tem uma imagem, digamos esta:

Supondo que ele tenha 1024 linhas e 1024 colunas. E como é uma imagem em escala de cinza, tem 256 tons diferentes de cinza ou bits por pixel. Então, colocando esses valores na fórmula, obtemos

Tamanho de uma imagem = linhas * cols * bpp

= 1024 * 1024 * 8

= 8388608 bits.

Mas, como não é uma resposta padrão que reconhecemos, vamos convertê-la em nosso formato.

Convertendo em bytes = 8388608/8 = 1048576 bytes.

Convertendo em bytes de kilo = 1048576/1024 = 1024 kb.

Convertendo em Mega bytes = 1024/1024 = 1 Mb.

É assim que o tamanho de uma imagem é calculado e armazenado. Agora, na fórmula, se você tiver o tamanho da imagem e os bits por pixel, também poderá calcular as linhas e colunas da imagem, desde que a imagem seja quadrada (mesmas linhas e mesma coluna).

Existem muitos tipos de imagens e veremos em detalhes sobre os diferentes tipos de imagens e a distribuição de cores nelas.

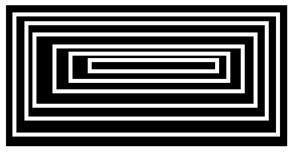

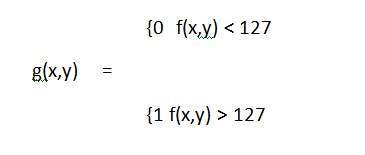

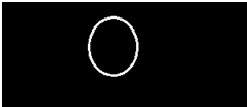

A imagem binária

A imagem binária, conforme seu nome indica, contém apenas dois valores de pixel.

0 e 1.

Em nosso tutorial anterior de bits por pixel, explicamos isso em detalhes sobre a representação dos valores de pixel em suas respectivas cores.

Aqui, 0 se refere à cor preta e 1 se refere à cor branca. Também é conhecido como Monocromático.

Imagem em preto e branco:

A imagem resultante formada, portanto, consiste apenas na cor preto e branco e, portanto, também pode ser chamada de imagem em preto e branco.

Sem nível de cinza

Uma das coisas interessantes sobre essa imagem binária é que não há nenhum nível de cinza nela. Apenas duas cores que são preto e branco são encontradas nele.

Formato

As imagens binárias têm um formato de PBM (mapa de bits portátil)

Formato de cores 2, 3, 4, 5, 6 bits

As imagens com formato de cor de 2, 3, 4, 5 e 6 bits não são muito utilizadas hoje. Eles foram usados nos velhos tempos para telas de TV antigas ou monitores.

Mas cada uma dessas cores tem mais de dois níveis de cinza e, portanto, tem uma cor cinza ao contrário da imagem binária.

Em um 2 bit 4, em um 3 bit 8, em um 4 bit 16, em um 5 bit 32, em um 6 bit 64 cores diferentes estão presentes.

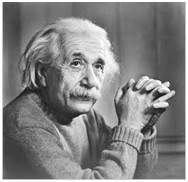

Formato de cor de 8 bits

O formato de cor de 8 bits é um dos formatos de imagem mais famosos. Possui 256 tons diferentes de cores. É comumente conhecido como imagem em tons de cinza.

A gama de cores em 8 bits varia de 0-255. Onde 0 significa preto, 255 significa branco e 127 significa cor cinza.

Esse formato foi usado inicialmente pelos primeiros modelos dos sistemas operacionais UNIX e pelos primeiros Macintoshes coloridos.

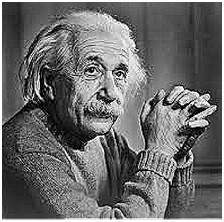

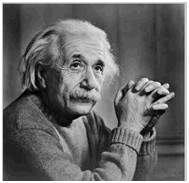

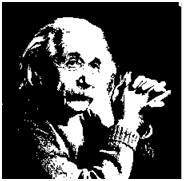

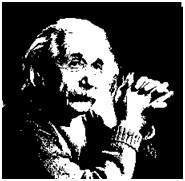

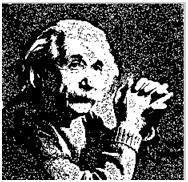

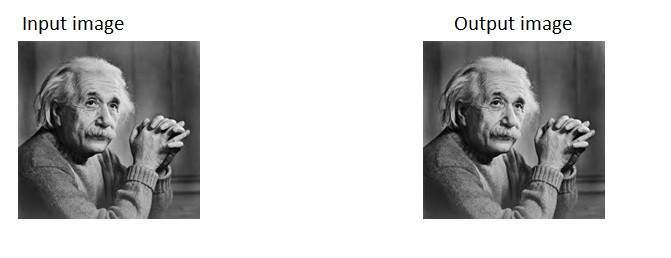

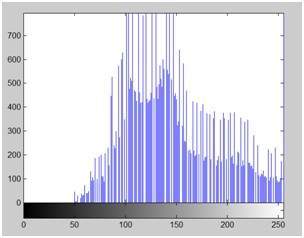

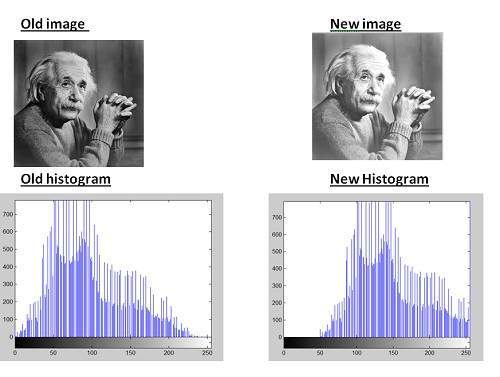

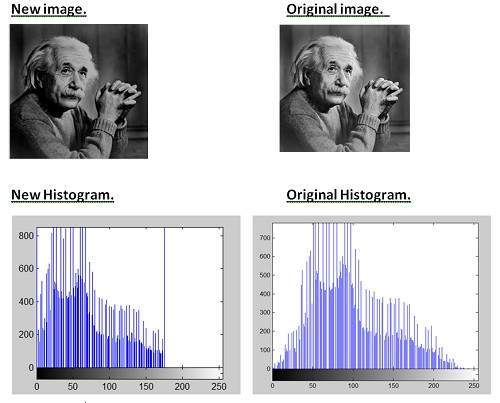

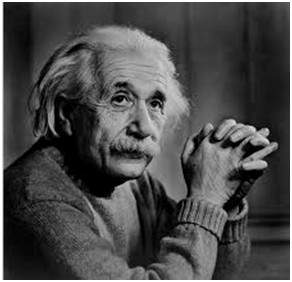

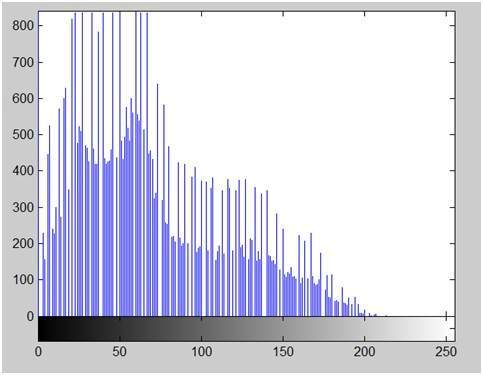

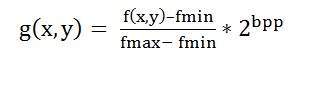

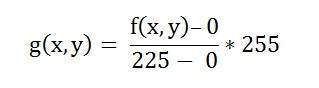

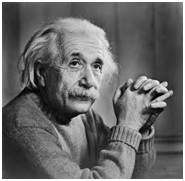

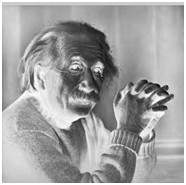

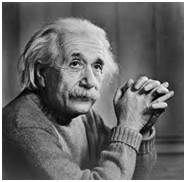

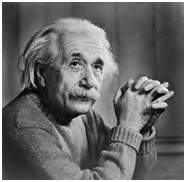

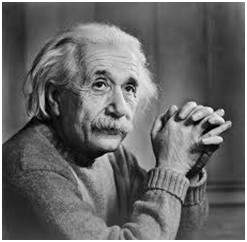

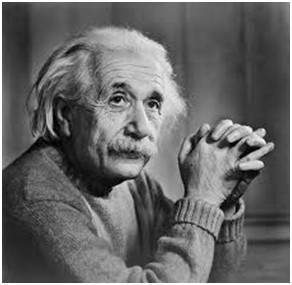

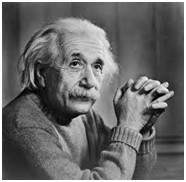

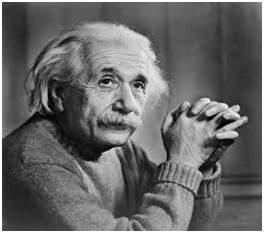

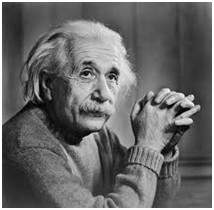

Uma imagem em tons de cinza de Einstein é mostrada abaixo:

Formato

O formato dessas imagens é PGM (Portable Gray Map).

Este formato não é suportado por padrão no Windows. Para ver imagens em escala de cinza, você precisa ter um visualizador de imagens ou uma caixa de ferramentas de processamento de imagem como o Matlab.

Por trás da imagem em escala de cinza:

Como explicamos várias vezes nos tutoriais anteriores, que uma imagem nada mais é que uma função bidimensional e pode ser representada por um array ou matriz bidimensional. Portanto, no caso da imagem de Einstein mostrada acima, haveria uma matriz bidimensional atrás com valores variando entre 0 e 255.

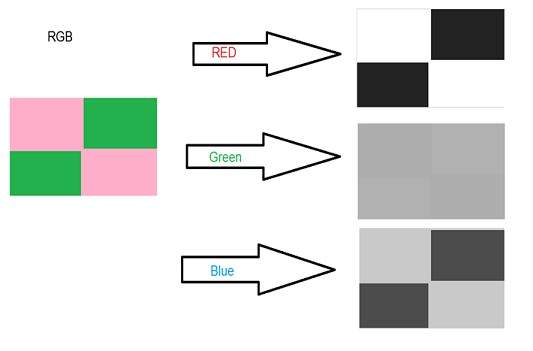

Mas esse não é o caso das imagens coloridas.

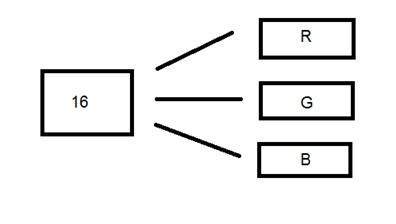

Formato de cor de 16 bits

É um formato de imagem colorida. Possui 65.536 cores diferentes. Também é conhecido como formato de alta cor.

Ele tem sido usado pela Microsoft em seus sistemas que oferecem suporte a formatos de cores de mais de 8 bits. Agora, neste formato de 16 bits e no próximo formato, vamos discutir que é um formato de 24 bits e ambos são formatos de cores.

A distribuição de cores em uma imagem colorida não é tão simples como era em uma imagem em tons de cinza.

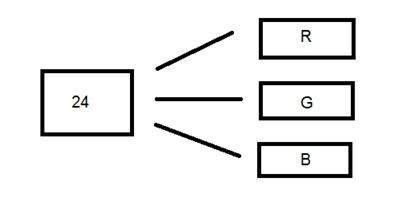

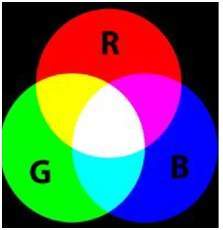

Um formato de 16 bits é dividido em três formatos adicionais: Vermelho, Verde e Azul. O famoso formato (RGB).

Está representado pictoricamente na imagem abaixo.

Agora surge a pergunta: como você distribuiria 16 em três. Se você fizer assim,

5 bits para R, 5 bits para G, 5 bits para B

Então, resta um bit no final.

Portanto, a distribuição de 16 bits foi feita assim.

5 bits para R, 6 bits para G, 5 bits para B.

O bit adicional que foi deixado para trás é adicionado ao bit verde. Porque o verde é a cor mais calmante para os olhos em todas essas três cores.

Observe que esta distribuição não é seguida por todos os sistemas. Alguns introduziram um canal alfa em 16 bits.

Outra distribuição de formato de 16 bits é a seguinte:

4 bits para R, 4 bits para G, 4 bits para B, 4 bits para canal alfa.

Ou alguns distribuem assim

5 bits para R, 5 bits para G, 5 bits para B, 1 bits para canal alfa.

Formato de cor de 24 bits

Formato de cor de 24 bits também conhecido como formato de cor verdadeira. Como o formato de cores de 16 bits, em um formato de cores de 24 bits, os 24 bits são novamente distribuídos em três formatos diferentes de vermelho, verde e azul.

Como 24 é dividido igualmente em 8, ele foi distribuído igualmente entre três canais de cores diferentes.

A distribuição deles é assim.

8 bits para R, 8 bits para G, 8 bits para B.

Atrás de uma imagem de 24 bits.

Ao contrário de uma imagem em escala de cinza de 8 bits, que tem uma matriz atrás dela, uma imagem de 24 bits tem três matrizes diferentes de R, G, B.

Formato

É o formato usado mais comum. Seu formato é PPM (Portable pixMap) que é compatível com o sistema operacional Linux. As famosas janelas têm seu próprio formato, que é o BMP (Bitmap).

Neste tutorial, veremos como diferentes códigos de cores podem ser combinados para fazer outras cores e como podemos converter códigos de cores RGB em hexadecimal e vice-versa.

Códigos de cores diferentes

Todas as cores aqui são do formato de 24 bits, o que significa que cada cor tem 8 bits de vermelho, 8 bits de verde e 8 bits de azul. Ou podemos dizer que cada cor tem três partes diferentes. Basta alterar a quantidade dessas três porções para fazer qualquer cor.

Formato de cor binária

Cor preta

Imagem:

Código decimal:

(0,0,0)

Explicação:

Como foi explicado nos tutoriais anteriores, em um formato de 8 bits, 0 se refere a preto. Portanto, se tivermos que fazer uma cor preta pura, temos que transformar todas as três partes de R, G, B em 0.

Cor branca

Imagem:

Código decimal:

(255.255.255)

Explicação:

Uma vez que cada porção de R, G, B é uma porção de 8 bits. Portanto, em 8 bits, a cor branca é formada por 255. Isso é explicado no tutorial do pixel. Então, para fazer uma cor branca, definimos cada porção em 255 e foi assim que obtivemos uma cor branca. Definindo cada um dos valores para 255, obtemos o valor geral de 255, o que torna a cor branca.

Modelo de cores RGB:

Cor vermelha

Imagem:

Código decimal:

(255,0,0)

Explicação:

Como precisamos apenas da cor vermelha, zeramos o restante das duas partes que são verdes e azuis e definimos a parte vermelha para seu máximo, que é 255.

Cor verde

Imagem:

Código decimal:

(0,255,0)

Explicação:

Como precisamos apenas da cor verde, zeramos o resto das duas partes que são vermelhas e azuis e definimos a parte verde para seu máximo, que é 255.

Cor azul

Imagem:

Código decimal:

(0,0,255)

Explicação:

Como precisamos apenas da cor azul, zeramos o restante das duas partes que são vermelhas e verdes e definimos a parte azul para o seu máximo, que é 255

Cor cinza:

Cor: Cinza

Imagem:

Código decimal:

(128.128.128)

Explicação:

Como já definimos em nosso tutorial de pixel, essa cor cinza é na verdade o ponto médio. Em um formato de 8 bits, o ponto médio é 128 ou 127. Neste caso, escolhemos 128. Portanto, configuramos cada parte em seu ponto médio, que é 128, e isso resulta em um valor médio geral e obtemos a cor cinza.

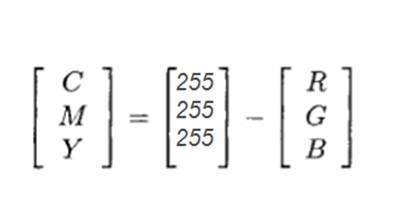

Modelo de cores CMYK:

CMYK é outro modelo de cor em que c significa ciano, m significa magenta, y significa amarelo ek significa preto. O modelo CMYK é comumente usado em impressoras coloridas em que dois cárteres de cor são usados. Um consiste em CMY e o outro na cor preta.

As cores do CMY também podem ser feitas alterando a quantidade ou porção de vermelho, verde e azul.

Cor: Ciano

Imagem:

Código decimal:

(0,255,255)

Explicação:

A cor ciano é formada pela combinação de duas cores diferentes, o verde e o azul. Portanto, definimos esses dois no máximo e zeramos a parte do vermelho. E obtemos a cor ciano.

Cor: Magenta

Imagem:

Código decimal:

(255.0.255)

Explicação:

A cor magenta é formada pela combinação de duas cores diferentes que são o vermelho e o azul. Portanto, definimos esses dois no máximo e zeramos a parte verde. E temos a cor magenta.

Cor amarela

Imagem:

Código decimal:

(255.255,0)

Explicação:

A cor amarela é formada a partir da combinação de duas cores diferentes, o vermelho e o verde. Portanto, definimos esses dois no máximo e zeramos a parte de azul. E temos a cor amarela.

Conversão

Agora veremos como as cores são convertidas de um formato para outro.

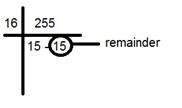

Conversão de RGB para código Hex:

A conversão de Hex em rgb é feita por meio deste método:

Pegue uma cor. Ex: Branco = (255, 255, 255).

Pegue a primeira porção, por exemplo, 255.

Divida por 16. Assim:

Pegue os dois números abaixo da linha, o fator e o restante. Nesse caso, é 15 15 que é FF.

Repita a etapa 2 para as próximas duas partes.

Combine todo o código hexadecimal em um.

Resposta: #FFFFFF

Conversão de Hex para RGB:

A conversão do código hexadecimal para o formato decimal rgb é feita desta forma.

Pegue um número hexadecimal. Por exemplo: #FFFFFF

Divida este número em 3 partes: FF FF FF

Pegue a primeira parte e separe seus componentes: FF

Converta cada uma das partes separadamente em binário: (1111) (1111)

Agora combine os binários individuais em um: 11111111

Converta este binário em decimal: 255

Agora repita a etapa 2, mais duas vezes.

O valor que vem na primeira etapa é R, o segundo é G e o terceiro pertence a B.

Resposta: (255, 255, 255)

As cores comuns e seus códigos hexadecimais foram fornecidos nesta tabela.

| Cor | Código Hex |

|---|---|

| Preto | # 000000 |

| Branco | #FFFFFF |

| cinzento | # 808080 |

| Vermelho | #FF0000 |

| Green | #00FF00 |

| Blue | #0000FF |

| Cyan | #00FFFF |

| Magenta | #FF00FF |

| Yellow | #FFFF00 |

Average method

Weighted method or luminosity method

Average method

Average method is the most simple one. You just have to take the average of three colors. Since its an RGB image , so it means that you have add r with g with b and then divide it by 3 to get your desired grayscale image.

Its done in this way.

Grayscale = (R + G + B) / 3

For example:

If you have an color image like the image shown above and you want to convert it into grayscale using average method. The following result would appear.

Explanation

There is one thing to be sure , that something happens to the original works. It means that our average method works. But the results were not as expected. We wanted to convert the image into a grayscale , but this turned out to be a rather black image.

Problem

This problem arise due to the fact , that we take average of the three colors. Since the three different colors have three different wavelength and have their own contribution in the formation of image , so we have to take average according to their contribution , not done it averagely using average method. Right now what we are doing is this,

33% of Red, 33% of Green, 33% of Blue

We are taking 33% of each, that means , each of the portion has same contribution in the image. But in reality thats not the case. The solution to this has been given by luminosity method.

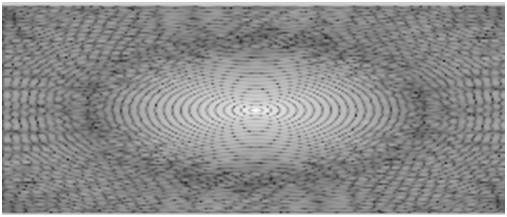

Weighted method or luminosity method

You have seen the problem that occur in the average method. Weighted method has a solution to that problem. Since red color has more wavelength of all the three colors , and green is the color that has not only less wavelength then red color but also green is the color that gives more soothing effect to the eyes.

It means that we have to decrease the contribution of red color , and increase the contribution of the green color , and put blue color contribution in between these two.

So the new equation that form is:

New grayscale image = ( (0.3 * R) + (0.59 * G) + (0.11 * B) ).

According to this equation , Red has contribute 30% , Green has contributed 59% which is greater in all three colors and Blue has contributed 11%.

Applying this equation to the image, we get this

Original Image:

Grayscale Image:

Explanation

As you can see here , that the image has now been properly converted to grayscale using weighted method. As compare to the result of average method , this image is more brighter.

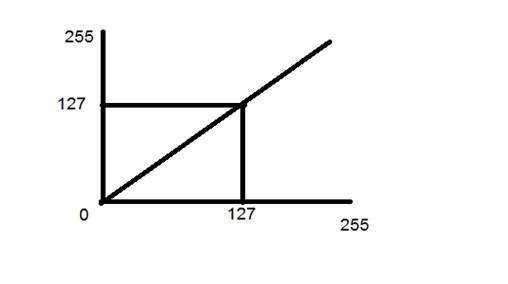

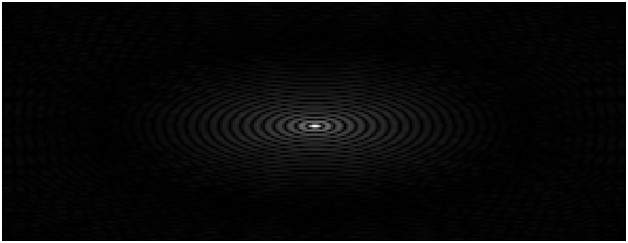

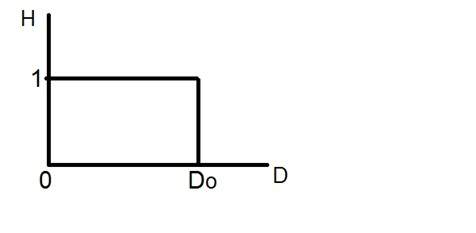

Conversion of analog signal to digital signal:

The output of most of the image sensors is an analog signal, and we can not apply digital processing on it because we can not store it. We can not store it because it requires infinite memory to store a signal that can have infinite values.

So we have to convert an analog signal into a digital signal.

To create an image which is digital , we need to covert continuous data into digital form. There are two steps in which it is done.

Sampling

Quantization

We will discuss sampling now , and quantization will be discussed later on but for now on we will discuss just a little about the difference between these two and the need of these two steps.

Basic idea:

The basic idea behind converting an analog signal to its digital signal is

to convert both of its axis (x,y) into a digital format.

Since an image is continuous not just in its co-ordinates (x axis) , but also in its amplitude (y axis), so the part that deals with the digitizing of co-ordinates is known as sampling. And the part that deals with digitizing the amplitude is known as quantization.

Sampling.

Sampling has already been introduced in our tutorial of introduction to signals and system. But we are going to discuss here more.

Here what we have discussed of the sampling.

The term sampling refers to take samples

We digitize x axis in sampling

It is done on independent variable

In case of equation y = sin(x), it is done on x variable

It is further divided into two parts , up sampling and down sampling

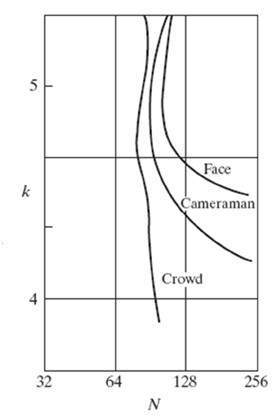

If you will look at the above figure , you will see that there are some random variations in the signal. These variations are due to noise. In sampling we reduce this noise by taking samples. It is obvious that more samples we take , the quality of the image would be more better, the noise would be more removed and same happens vice versa.

However , if you take sampling on the x axis , the signal is not converted to digital format , unless you take sampling of the y-axis too which is known as quantization. The more samples eventually means you are collecting more data, and in case of image , it means more pixels.

Relation ship with pixels

Since a pixel is a smallest element in an image. The total number of pixels in an image can be calculated as

Pixels = total no of rows * total no of columns.

Lets say we have total of 25 pixels , that means we have a square image of 5 X 5. Then as we have dicussed above in sampling , that more samples eventually result in more pixels. So it means that of our continuous signal , we have taken 25 samples on x axis. That refers to 25 pixels of this image.

This leads to another conclusion that since pixel is also the smallest division of a CCD array. So it means it has a relationship with CCD array too , which can be explained as this.

Relationship with CCD array

The number of sensors on a CCD array is directly equal to the number of pixels. And since we have concluded that the number of pixels is directly equal to the number of samples, that means that number sample is directly equal to the number of sensors on CCD array.

Oversampling.

In the beginning we have define that sampling is further categorize into two types. Which is up sampling and down sampling. Up sampling is also called as over sampling.

The oversampling has a very deep application in image processing which is known as Zooming.

Zooming

We will formally introduce zooming in the upcoming tutorial , but for now on , we will just briefly explain zooming.

Zooming refers to increase the quantity of pixels , so that when you zoom an image , you will see more detail.

The increase in the quantity of pixels is done through oversampling. The one way to zoom is , or to increase samples, is to zoom optically , through the motor movement of the lens and then capture the image. But we have to do it , once the image has been captured.

There is a difference between zooming and sampling.

The concept is same , which is, to increase samples. But the key difference is that while sampling is done on the signals , zooming is done on the digital image.

Before we define pixel resolution, it is necessary to define a pixel.

Pixel

We have already defined a pixel in our tutorial of concept of pixel, in which we define a pixel as the smallest element of an image. We also defined that a pixel can store a value proportional to the light intensity at that particular location.

Now since we have defined a pixel, we are going to define what is resolution.

Resolution

The resolution can be defined in many ways. Such as pixel resolution , spatial resolution , temporal resolution , spectral resolution. Out of which we are going to discuss pixel resolution.

You have probably seen that in your own computer settings , you have monitor resolution of 800 x 600 , 640 x 480 e.t.c

In pixel resolution , the term resolution refers to the total number of count of pixels in an digital image. For example. If an image has M rows and N columns , then its resolution can be defined as M X N.

If we define resolution as the total number of pixels , then pixel resolution can be defined with set of two numbers. The first number the width of the picture , or the pixels across columns , and the second number is height of the picture , or the pixels across its width.

We can say that the higher is the pixel resolution , the higher is the quality of the image.

We can define pixel resolution of an image as 4500 X 5500.

Megapixels

We can calculate mega pixels of a camera using pixel resolution.

Column pixels (width ) X row pixels ( height ) / 1 Million.

The size of an image can be defined by its pixel resolution.

Size = pixel resolution X bpp ( bits per pixel )

Calculating the mega pixels of the camera

Lets say we have an image of dimension: 2500 X 3192.

Its pixel resolution = 2500 * 3192 = 7982350 bytes.

Dividing it by 1 million = 7.9 = 8 mega pixel (approximately).

Aspect ratio

Another important concept with the pixel resolution is aspect ratio.

Aspect ratio is the ratio between width of an image and the height of an image. It is commonly explained as two numbers separated by a colon (8:9). This ratio differs in different images , and in different screens. The common aspect ratios are:

1.33:1, 1.37:1, 1.43:1, 1.50:1, 1.56:1, 1.66:1, 1.75:1, 1.78:1, 1.85:1, 2.00:1, e.t.c

Advantage:

Aspect ratio maintains a balance between the appearance of an image on the screen , means it maintains a ratio between horizontal and vertical pixels. It does not let the image to get distorted when aspect ratio is increased.

For example:

This is a sample image , which has 100 rows and 100 columns. If we wish to make is smaller, and the condition is that the quality remains the same or in other way the image does not get distorted , here how it happens.

Original image:

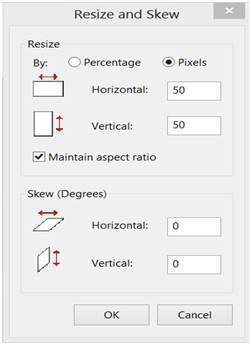

Changing the rows and columns by maintain the aspect ratio in MS Paint.

Result

Smaller image , but with same balance.

You have probably seen aspect ratios in the video players, where you can adjust the video according to your screen resolution.

Finding the dimensions of the image from aspect ratio:

Aspect ratio tells us many things. With the aspect ratio, you can calculate the dimensions of the image along with the size of the image.

For example

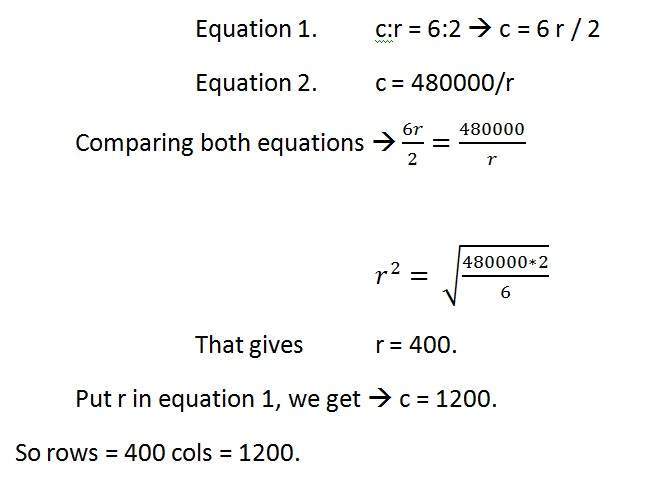

If you are given an image with aspect ratio of 6:2 of an image of pixel resolution of 480000 pixels given the image is an gray scale image.

And you are asked to calculate two things.

Resolve pixel resolution to calculate the dimensions of image

Calculate the size of the image

Solution:

Given:

Aspect ratio: c:r = 6:2

Pixel resolution: c * r = 480000

Bits per pixel: grayscale image = 8bpp

Find:

Number of rows = ?

Number of cols = ?

Solving first part:

Solving 2nd part:

Size = rows * cols * bpp

Size of image in bits = 400 * 1200 * 8 = 3840000 bits

Size of image in bytes = 480000 bytes

Size of image in kilo bytes = 48 kb (approx).

In this tutorial we are going to introduce the concept of zooming , and the common techniques that are used to zoom an image.

Zooming

Zooming simply means enlarging a picture in a sense that the details in the image became more visible and clear. Zooming an image has many wide applications ranging from zooming through a camera lens , to zoom an image on internet e.t.c.

For example

is zoomed into

You can zoom something at two different steps.

The first step includes zooming before taking an particular image. This is known as pre processing zoom. This zoom involves hardware and mechanical movement.

The second step is to zoom once an image has been captured. It is done through many different algorithms in which we manipulate pixels to zoom in the required portion.

We will discuss them in detail in the next tutorial.

Optical Zoom vs digital Zoom

These two types of zoom are supported by the cameras.

Optical Zoom:

The optical zoom is achieved using the movement of the lens of your camera. An optical zoom is actually a true zoom. The result of the optical zoom is far better then that of digital zoom. In optical zoom , an image is magnified by the lens in such a way that the objects in the image appear to be closer to the camera. In optical zoom the lens is physically extend to zoom or magnify an object.

Digital Zoom:

Digital zoom is basically image processing within a camera. During a digital zoom , the center of the image is magnified and the edges of the picture got crop out. Due to magnified center , it looks like that the object is closer to you.

During a digital zoom , the pixels got expand , due to which the quality of the image is compromised.

The same effect of digital zoom can be seen after the image is taken through your computer by using an image processing toolbox / software, such as Photoshop.

The following picture is the result of digital zoom done through one of the following methods given below in the zooming methods.

Now since we are leaning digital image processing , we will not focus , on how an image can be zoomed optically using lens or other stuff. Rather we will focus on the methods, that enable to zoom a digital image.

Zooming methods:

Although there are many methods that does this job , but we are going to discuss the most common of them here.

They are listed below.

Pixel replication or (Nearest neighbor interpolation)

Zero order hold method

Zooming K times

All these three methods are formally introduced in the next tutorial.

In this tutorial we are going to formally introduce three methods of zooming that were introduced in the tutorial of Introduction to zooming.

Methods

Pixel replication or (Nearest neighbor interpolation)

Zero order hold method

Zooming K times

Each of the methods have their own advantages and disadvantages. We will start by discussing pixel replication.

Method 1: Pixel replication:

Introduction:

It is also known as Nearest neighbor interpolation. As its name suggest , in this method , we just replicate the neighboring pixels. As we have already discussed in the tutorial of Sampling , that zooming is nothing but increase amount of sample or pixels. This algorithm works on the same principle.

Working:

In this method we create new pixels form the already given pixels. Each pixel is replicated in this method n times row wise and column wise and you got a zoomed image. Its as simple as that.

For example:

if you have an image of 2 rows and 2 columns and you want to zoom it twice or 2 times using pixel replication, here how it can be done.

For a better understanding , the image has been taken in the form of matrix with the pixel values of the image.

| 1 | 2 |

| 3 | 4 |

The above image has two rows and two columns, we will first zoom it row wise.

Row wise zooming:

When we zoom it row wise , we will just simple copy the rows pixels to its adjacent new cell.

Here how it would be done.

| 1 | 1 | 2 | 2 |

| 3 | 3 | 4 | 4 |

As you can that in the above matrix , each pixel is replicated twice in the rows.

Column size zooming:

The next step is to replicate each of the pixel column wise, that we will simply copy the column pixel to its adjacent new column or simply below it.

Here how it would be done.

| 1 | 1 | 2 | 2 |

| 1 | 1 | 2 | 2 |

| 3 | 3 | 4 | 4 |

| 3 | 3 | 4 | 4 |

New image size:

As it can be seen from the above example , that an original image of 2 rows and 2 columns has been converted into 4 rows and 4 columns after zooming. That means the new image has a dimensions of

(Original image rows * zooming factor, Original Image cols * zooming factor)

Advantage and disadvantage:

One of the advantage of this zooming technique is , it is very simple. You just have to copy the pixels and nothing else.