ทฤษฎีเรโซแนนซ์แบบปรับได้

เครือข่ายนี้ได้รับการพัฒนาโดย Stephen Grossberg และ Gail Carpenter ในปี 1987 โดยอาศัยการแข่งขันและใช้รูปแบบการเรียนรู้ที่ไม่มีผู้ดูแล เครือข่าย Adaptive Resonance Theory (ART) ตามชื่อที่แนะนำนั้นเปิดกว้างสำหรับการเรียนรู้ใหม่ ๆ (ปรับตัว) ได้เสมอโดยไม่สูญเสียรูปแบบเก่า ๆ (การสั่นพ้อง) โดยทั่วไปเครือข่าย ART เป็นลักษณนามเวกเตอร์ซึ่งรับเวกเตอร์อินพุตและจำแนกเป็นประเภทใดประเภทหนึ่งขึ้นอยู่กับรูปแบบที่จัดเก็บไว้ซึ่งคล้ายคลึงกันมากที่สุด

หัวหน้าฝ่ายปฏิบัติการ

การดำเนินการหลักของการจำแนกประเภท ART สามารถแบ่งออกเป็นขั้นตอนต่อไปนี้ -

Recognition phase- เวกเตอร์อินพุตถูกเปรียบเทียบกับการจำแนกประเภทที่นำเสนอในทุกโหนดในเลเยอร์เอาต์พุต ผลลัพธ์ของเซลล์ประสาทจะกลายเป็น“ 1” ถ้าตรงกับการจำแนกที่ใช้มากที่สุดมิฉะนั้นจะกลายเป็น“ 0”

Comparison phase- ในขั้นตอนนี้จะทำการเปรียบเทียบเวกเตอร์อินพุตกับเวกเตอร์เลเยอร์เปรียบเทียบ เงื่อนไขสำหรับการรีเซ็ตคือระดับของความคล้ายคลึงกันจะน้อยกว่าพารามิเตอร์การเฝ้าระวัง

Search phase- ในขั้นตอนนี้เครือข่ายจะค้นหาการรีเซ็ตและการจับคู่ที่ทำในขั้นตอนข้างต้น ดังนั้นหากไม่มีการรีเซ็ตและการแข่งขันค่อนข้างดีการจัดประเภทจะสิ้นสุดลง มิฉะนั้นกระบวนการจะซ้ำและต้องส่งรูปแบบอื่น ๆ ที่จัดเก็บไว้เพื่อค้นหาการจับคู่ที่ถูกต้อง

ART1

เป็น ART ประเภทหนึ่งซึ่งออกแบบมาเพื่อจัดกลุ่มเวกเตอร์ไบนารี เราสามารถเข้าใจเกี่ยวกับเรื่องนี้ด้วยสถาปัตยกรรมของมัน

สถาปัตยกรรมของ ART1

ประกอบด้วยสองหน่วยต่อไปนี้ -

Computational Unit - ประกอบด้วยสิ่งต่อไปนี้ -

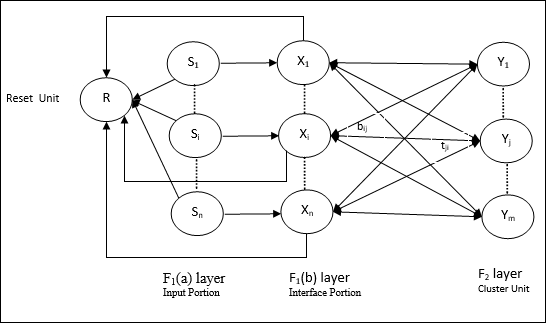

Input unit (F1 layer) - นอกจากนี้ยังมีสองส่วนต่อไปนี้ -

F1(a) layer (Input portion)- ใน ART1 จะไม่มีการประมวลผลในส่วนนี้แทนที่จะมีเวกเตอร์อินพุตเท่านั้น เชื่อมต่อกับเลเยอร์F 1 (b) (ส่วนอินเตอร์เฟส)

F1(b) layer (Interface portion)- ส่วนนี้รวมสัญญาณจากส่วนอินพุตกับเลเยอร์F 2 เลเยอร์F 1 (b) เชื่อมต่อกับเลเยอร์F 2โดยใช้น้ำหนักจากล่างขึ้นบนbijและชั้นF 2เชื่อมต่อกับชั้น F 1 (b) ผ่านน้ำหนักจากบนลงล่างtji.

Cluster Unit (F2 layer)- นี่คือเลเยอร์การแข่งขัน หน่วยที่มีอินพุตสุทธิที่ใหญ่ที่สุดถูกเลือกเพื่อเรียนรู้รูปแบบการป้อนข้อมูล การเปิดใช้งานหน่วยคลัสเตอร์อื่น ๆ ทั้งหมดถูกตั้งค่าเป็น 0

Reset Mechanism- การทำงานของกลไกนี้ขึ้นอยู่กับความคล้ายคลึงกันระหว่างน้ำหนักจากบนลงล่างและเวกเตอร์อินพุต ตอนนี้ถ้าระดับของความคล้ายคลึงกันนี้น้อยกว่าพารามิเตอร์การเฝ้าระวังคลัสเตอร์จะไม่ได้รับอนุญาตให้เรียนรู้รูปแบบและส่วนที่เหลือจะเกิดขึ้น

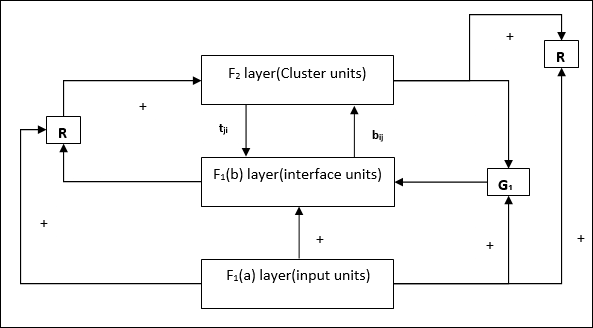

Supplement Unit - จริงๆแล้วปัญหาเกี่ยวกับกลไกการรีเซ็ตก็คือเลเยอร์ F2จะต้องถูกยับยั้งภายใต้เงื่อนไขบางประการและจะต้องพร้อมใช้งานเมื่อเกิดการเรียนรู้บางอย่าง นั่นคือเหตุผลที่หน่วยเสริมสองหน่วย ได้แก่G1 และ G2 ถูกเพิ่มพร้อมกับหน่วยรีเซ็ต R. พวกเขาเรียกว่าgain control units. หน่วยเหล่านี้รับและส่งสัญญาณไปยังหน่วยอื่น ๆ ที่มีอยู่ในเครือข่าย‘+’ บ่งบอกถึงสัญญาณกระตุ้นในขณะที่ ‘−’ บ่งบอกถึงสัญญาณยับยั้ง

พารามิเตอร์ที่ใช้

ใช้พารามิเตอร์ต่อไปนี้ -

n - จำนวนส่วนประกอบในเวกเตอร์อินพุต

m - จำนวนคลัสเตอร์สูงสุดที่สามารถสร้างได้

bij- น้ำหนักตั้งแต่ F 1 (b) ถึง F 2ชั้นคือน้ำหนักจากล่างขึ้นบน

tji- น้ำหนักตั้งแต่ชั้น F 2ถึง F 1 (b) คือน้ำหนักจากบนลงล่าง

ρ - พารามิเตอร์การเฝ้าระวัง

||x|| - บรรทัดฐานของเวกเตอร์ x

อัลกอริทึม

Step 1 - เริ่มต้นอัตราการเรียนรู้พารามิเตอร์การเฝ้าระวังและน้ำหนักดังนี้ -

$$ \ alpha \:> \: 1 \: \: และ \: \: 0 \: <\ rho \: \ leq \: 1 $$

$$ 0 \: <\: b_ {ij} (0) \: <\: \ frac {\ alpha} {\ alpha \: - \: 1 \: + \: n} \: \: และ \: \: t_ {ij} (0) \: = \: 1 $$

Step 2 - ทำต่อขั้นตอนที่ 3-9 เมื่อเงื่อนไขการหยุดไม่เป็นจริง

Step 3 - ดำเนินการต่อในขั้นตอนที่ 4-6 สำหรับทุกการฝึกอบรม

Step 4- ตั้งค่าการเปิดใช้งานของหน่วย F 1 (a) และ F 1ทั้งหมดดังนี้

F2 = 0 and F1(a) = input vectors

Step 5- ต้องส่งสัญญาณอินพุตจากเลเยอร์F 1 (a) ถึง F 1 (b) เช่น

$$ s_ {i} \: = \: x_ {i} $$

Step 6- สำหรับทุกโหนดF 2 ที่ถูกยับยั้ง

$ y_ {j} \: = \: \ sum_i b_ {ij} x_ {i} $ เงื่อนไขคือ yj ≠ -1

Step 7 - ทำตามขั้นตอนที่ 8-10 เมื่อการรีเซ็ตเป็นจริง

Step 8 - ค้นหา J สำหรับ yJ ≥ yj สำหรับโหนดทั้งหมด j

Step 9- คำนวณการเปิดใช้งานอีกครั้งใน F 1 (b) ดังนี้

$$ x_ {i} \: = \: sitJi $$

Step 10 - ตอนนี้หลังจากคำนวณบรรทัดฐานของเวกเตอร์แล้ว x และเวกเตอร์ sเราต้องตรวจสอบเงื่อนไขการรีเซ็ตดังนี้ -

ถ้า ||x||/ ||s|| <พารามิเตอร์การเฝ้าระวัง ρ, theninhibitnode J และไปที่ขั้นตอนที่ 7

อื่น ๆ ถ้า ||x||/ ||s|| ≥พารามิเตอร์การเฝ้าระวัง ρจากนั้นดำเนินการต่อไป

Step 11 - อัปเดตน้ำหนักสำหรับโหนด J สามารถทำได้ดังนี้ -

$$ b_ {ij} (ใหม่) \: = \: \ frac {\ alpha x_ {i}} {\ alpha \: - \: 1 \: + \: || x ||} $$

$$ t_ {ij} (ใหม่) \: = \: x_ {i} $$

Step 12 - ต้องตรวจสอบเงื่อนไขการหยุดสำหรับอัลกอริทึมและอาจเป็นดังนี้ -

- ห้ามมีการเปลี่ยนแปลงของน้ำหนัก

- ไม่ได้ทำการรีเซ็ตสำหรับหน่วย

- ถึงจำนวนสูงสุดของยุคแล้ว