Цифровая обработка сигналов - Краткое руководство

Определение

Сигналом можно назвать все, что несет информацию. Его также можно определить как физическую величину, которая изменяется в зависимости от времени, температуры, давления или от любых независимых переменных, таких как речевой сигнал или видеосигнал.

Процесс работы, в котором характеристики сигнала (амплитуда, форма, фаза, частота и т. Д.) Претерпевают изменение, известен как обработка сигнала.

Note- Любой нежелательный сигнал, мешающий основному сигналу, называется шумом. Итак, шум - это тоже сигнал, но нежелательный.

В соответствии с их представлением и обработкой сигналы можно разделить на различные категории, детали которых обсуждаются ниже.

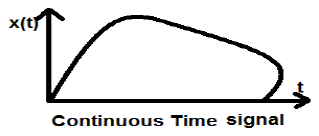

Сигналы непрерывного времени

Сигналы с непрерывным временем определяются по континууму времени и, таким образом, представлены непрерывной независимой переменной. Сигналы с непрерывным временем часто называют аналоговыми сигналами.

Этот тип сигнала демонстрирует непрерывность как по амплитуде, так и по времени. У них будут значения в каждый момент времени. Функции синуса и косинуса являются лучшим примером сигнала непрерывного времени.

Показанный выше сигнал является примером непрерывного сигнала времени, потому что мы можем получить значение сигнала в каждый момент времени.

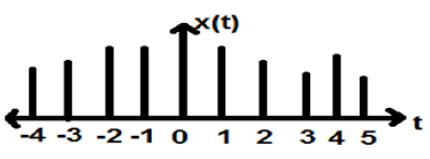

Дискретные временные сигналы

Сигналы, которые определяются в дискретные моменты времени, называются дискретными сигналами. Следовательно, каждая независимая переменная имеет различное значение. Таким образом, они представлены в виде последовательности чисел.

Хотя речевые и видеосигналы могут быть представлены как в непрерывном, так и в дискретном формате времени; при определенных обстоятельствах они идентичны. Амплитуды также показывают дискретные характеристики. Прекрасным примером этого является цифровой сигнал; чья амплитуда и время дискретны.

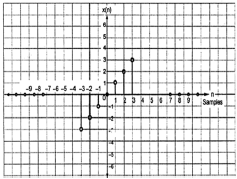

На рисунке выше изображена дискретная амплитудная характеристика дискретного сигнала за период времени. Математически эти типы сигналов можно сформулировать как:

$$x = \left \{ x\left [ n \right ] \right \},\quad -\infty < n< \infty$$Где n - целое число.

Это последовательность чисел x, где n- е число в последовательности представлено как x [n].

Для тестирования системы обычно используются стандартные или базовые сигналы. Эти сигналы являются основными строительными блоками для многих сложных сигналов. Следовательно, они играют очень важную роль в изучении сигналов и систем.

Единица измерения импульса или дельта-функции

Сигнал, удовлетворяющий условию, $\delta(t) = \lim_{\epsilon \to \infty} x(t)$называется единичным импульсным сигналом. Этот сигнал стремится к бесконечности, когда t = 0, и стремится к нулю, когда t ≠ 0, так что площадь под его кривой всегда равна единице. Дельта-функция имеет нулевую амплитуду везде excunit_impulse.jpgept при t = 0.

Свойства импульсного сигнала агрегата

- δ (t) - четный сигнал.

- δ (t) является примером сигнала ни энергии, ни мощности (NENP).

- Площадь единичного импульсного сигнала можно записать как; $$A = \int_{-\infty}^{\infty} \delta (t)dt = \int_{-\infty}^{\infty} \lim_{\epsilon \to 0} x(t) dt = \lim_{\epsilon \to 0} \int_{-\infty}^{\infty} [x(t)dt] = 1$$

- Вес или мощность сигнала можно записать как; $$y(t) = A\delta (t)$$

- Площадь взвешенного импульсного сигнала можно записать как - $$y (t) = \int_{-\infty}^{\infty} y (t)dt = \int_{-\infty}^{\infty} A\delta (t) = A[\int_{-\infty}^{\infty} \delta (t)dt ] = A = 1 = Wigthedimpulse$$

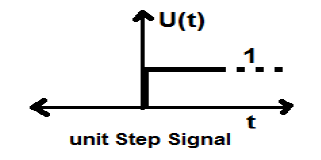

Сигнал шага устройства

Сигнал, удовлетворяющий следующим двум условиям -

- $U(t) = 1(when\quad t \geq 0 )and$

- $U(t) = 0 (when\quad t < 0 )$

известен как сигнал единичного шага.

Он обладает свойством показывать разрыв при t = 0. В точке разрыва значение сигнала определяется как среднее значение сигнала. Этот сигнал был получен непосредственно до и после точки разрыва (согласно феноменам Гибба).

Если мы добавим сигнал шага к другому сигналу шага, масштабированному по времени, то результат будет равен единице. Это сигнал типа мощности, значение мощности - 0,5. Среднеквадратичное значение (среднеквадратичное значение) составляет 0,707, а его среднее значение также равно 0,5.

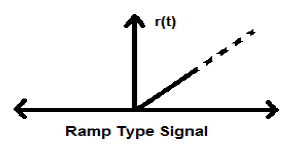

Сигнал рампы

Интеграция ступенчатого сигнала приводит к сигналу линейного изменения. Он представлен r (t). Сигнал линейного изменения также удовлетворяет условию$r(t) = \int_{-\infty}^{t} U(t)dt = tU(t)$. Это сигнал ни энергии, ни мощности (NENP).

Параболический сигнал

Интеграция сигнала Ramp приводит к параболическому сигналу. Он представлен как p (t). Параболический сигнал также удовлетворяет условию$p(t) = \int_{-\infty}^{t} r(t)dt = (t^{2}/2)U(t)$. Это сигнал ни энергии, ни мощности (NENP).

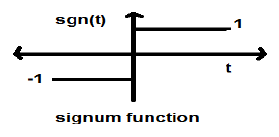

Сигнум Функция

Эта функция представлена как

$$sgn(t) = \begin{cases}1 & for\quad t >0\\-1 & for\quad t<0\end{cases}$$Это сигнал силового типа. Его значение мощности и среднеквадратичное значение (среднеквадратичное значение) равны 1. Среднее значение знаковой функции равно нулю.

Функция Sinc

Это также функция синуса и записывается как -

$$SinC(t) = \frac{Sin\Pi t}{\Pi T} = Sa(\Pi t)$$Свойства функции Sinc

Это сигнал энергетического типа.

$Sinc(0) = \lim_{t \to 0}\frac{\sin \Pi t}{\Pi t} = 1$

$Sinc(\infty) = \lim_{t \to \infty}\frac{\sin \Pi \infty}{\Pi \infty} = 0$ (Диапазон sinπ∞ варьируется от -1 до +1, но все, что делится на бесконечность, равно нулю)

-

Если $ \sin c(t) = 0 => \sin \Pi t = 0$

$\Rightarrow \Pi t = n\Pi$

$\Rightarrow t = n (n \neq 0)$

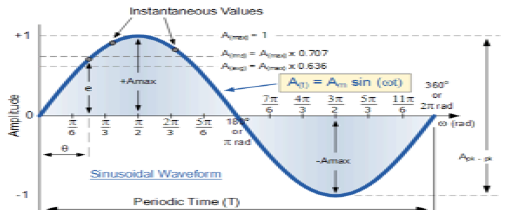

Синусоидальный сигнал

Сигнал, который является непрерывным по своей природе, известен как непрерывный сигнал. Общий формат синусоидального сигнала

$$x(t) = A\sin (\omega t + \phi )$$Вот,

A = амплитуда сигнала

ω = угловая частота сигнала (измеряется в радианах)

φ = фазовый угол сигнала (измеряется в радианах)

Этот сигнал имеет тенденцию повторяться через определенный период времени, поэтому он называется периодическим сигналом. Период времени сигнала задается как;

$$T = \frac{2\pi }{\omega }$$Схематическое изображение синусоидального сигнала показано ниже.

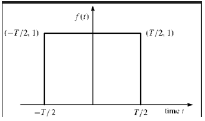

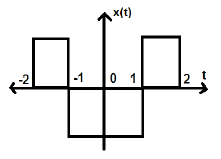

Прямоугольная функция

Сигнал называется прямоугольным функциональным типом, если он удовлетворяет следующему условию:

$$\pi(\frac{t}{\tau}) = \begin{cases}1, & for\quad t\leq \frac{\tau}{2}\\0, & Otherwise\end{cases}$$

Будучи симметричным относительно оси Y, этот сигнал называется четным.

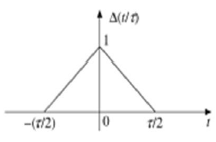

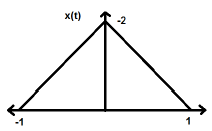

Треугольный импульсный сигнал

Любой сигнал, который удовлетворяет следующему условию, называется треугольным сигналом.

$$\Delta(\frac{t}{\tau}) = \begin{cases}1-(\frac{2|t|}{\tau}) & for|t|<\frac{\tau}{2}\\0 & for|t|>\frac{\tau}{2}\end{cases}$$

Этот сигнал симметричен относительно оси Y. Следовательно, его также называют четным сигналом.

Мы видели, как основные сигналы могут быть представлены в непрерывной временной области. Давайте посмотрим, как основные сигналы могут быть представлены в дискретной временной области.

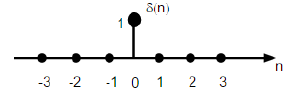

Последовательность импульсов агрегата

Он обозначается как δ (n) в дискретной временной области и может быть определен как;

$$\delta(n)=\begin{cases}1, & for \quad n=0\\0, & Otherwise\end{cases}$$

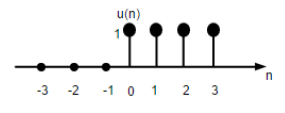

Сигнал шага устройства

Дискретный сигнал шага единицы времени определяется как;

$$U(n)=\begin{cases}1, & for \quad n\geq0\\0, & for \quad n<0\end{cases}$$

На рисунке выше показано графическое представление дискретной ступенчатой функции.

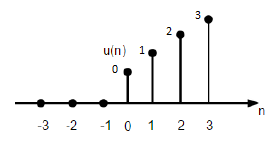

Функция разгона агрегата

Функция дискретного линейного изменения модуля может быть определена как -

$$r(n)=\begin{cases}n, & for \quad n\geq0\\0, & for \quad n<0\end{cases}$$

На приведенном выше рисунке показано графическое представление дискретного линейного сигнала.

Параболическая функция

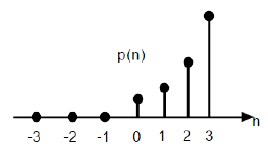

Дискретная единичная параболическая функция обозначается как p (n) и может быть определена как;

$$p(n) = \begin{cases}\frac{n^{2}}{2} ,& for \quad n\geq0\\0, & for \quad n<0\end{cases}$$В терминах функции единичного шага это можно записать как;

$$P(n) = \frac{n^{2}}{2}U(n)$$

На приведенном выше рисунке показано графическое представление параболической последовательности.

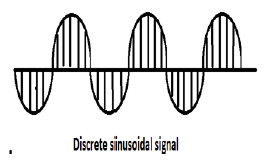

Синусоидальный сигнал

Все сигналы с непрерывным временем являются периодическими. Синусоидальные последовательности с дискретным временем могут быть или не быть периодическими. Они зависят от значения ω. Чтобы сигнал с дискретным временем был периодическим, угловая частота ω должна быть рационально кратной 2π.

Дискретный синусоидальный сигнал показан на рисунке выше.

Дискретная форма синусоидального сигнала может быть представлена в формате -

$$x(n) = A\sin(\omega n + \phi)$$Здесь A, ω и φ имеют обычный смысл, а n - целое число. Период времени дискретного синусоидального сигнала определяется как -

$$N =\frac{2\pi m}{\omega}$$Где N и m - целые числа.

Сигналы непрерывного времени можно классифицировать в соответствии с различными условиями или операциями, выполняемыми с сигналами.

Четные и нечетные сигналы

Даже сигнал

Сигнал называется даже если он удовлетворяет следующему условию;

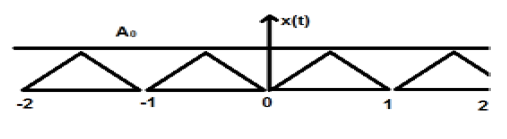

$$x(-t) = x(t)$$Реверс сигнала во времени не означает здесь никакого изменения амплитуды. Например, рассмотрим треугольную волну, показанную ниже.

Треугольный сигнал - это четный сигнал. Поскольку он симметричен относительно оси Y. Можно сказать, что это зеркальное отображение по оси Y.

Рассмотрим другой сигнал, показанный на рисунке ниже.

Мы можем видеть, что вышеупомянутый сигнал ровный, поскольку он симметричен относительно оси Y.

Странный сигнал

Сигнал называется нечетным, если он удовлетворяет следующему условию

$$x(-t) = -x(t)$$Здесь и обращение времени, и изменение амплитуды происходят одновременно.

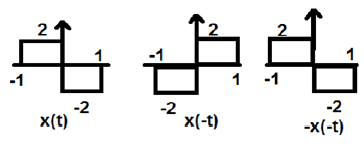

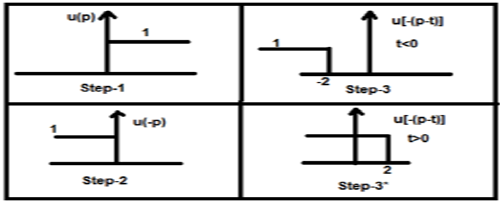

На рисунке выше мы видим ступенчатый сигнал x (t). Чтобы проверить, является ли это нечетным сигналом, сначала мы обращаем время, т.е. x (-t), и результат такой, как показано на рисунке. Затем мы меняем амплитуду результирующего сигнала, т.е. –x (-t), и получаем результат, как показано на рисунке.

Если мы сравним первый и третий сигналы, то увидим, что они одинаковы, т.е. x (t) = -x (-t), что удовлетворяет нашим критериям. Следовательно, вышеуказанный сигнал является нечетным.

Ниже приведены некоторые важные результаты, относящиеся к четным и нечетным сигналам.

- Четный × Четный = Четный

- Нечетный × Нечетный = Четный

- Четное × Нечетное = Нечетное

- Четный ± Четный = Четный

- Нечетный ± Нечетный = Нечетный

- Четное ± Нечетное = Ни четное, ни нечетное

Представление любого сигнала в четной или нечетной форме

Некоторые сигналы нельзя напрямую разделить на четные или нечетные. Они представлены как комбинация четного и нечетного сигнала.

$$x(t)\rightarrow x_{e}(t)+x_{0}(t)$$Где x e (t) представляет четный сигнал, а x o (t) представляет нечетный сигнал

$$x_{e}(t)=\frac{[x(t)+x(-t)]}{2}$$И

$$x_{0}(t)=\frac{[x(t)-x(-t)]}{2}$$пример

Найдите четную и нечетную части сигнала $x(n) = t+t^{2}+t^{3}$

Solution - Обращая x (n), мы получаем

$$x(-n) = -t+t^{2}-t^{3}$$

Теперь по формуле четная часть

$$x_{e}(t) = \frac{x(t)+x(-t)}{2}$$

$$= \frac{[(t+t^{2}+t^{3})+(-t+t^{2}-t^{3})]}{2}$$

$$= t^{2}$$

Аналогично по формуле нечетная часть равна

$$x_{0}(t)=\frac{[x(t)-x(-t)]}{2}$$

$$= \frac{[(t+t^{2}+t^{3})-(-t+t^{2}-t^{3})]}{2}$$

$$= t+t^{3}$$

Периодические и непериодические сигналы

Периодические сигналы

Периодический сигнал повторяется через определенный промежуток времени. Мы можем показать это в форме уравнения как -

$$x(t) = x(t)\pm nT$$Где, n = целое число (1,2,3 ……)

T = Основной период времени (FTP) ≠ 0 и ≠ ∞

Фундаментальный период времени (FTP) - это наименьшее положительное и фиксированное значение времени, в течение которого сигнал является периодическим.

Треугольный сигнал показан на рисунке выше с амплитудой A. Здесь сигнал повторяется каждые 1 секунду. Таким образом, можно сказать, что сигнал периодический и его FTP составляет 1 сек.

Непериодический сигнал

Проще говоря, непериодические сигналы непериодичны по своей природе. Очевидно, что эти сигналы не будут повторяться через какое-то время.

Непериодические сигналы не соответствуют определенному формату; поэтому никакое конкретное математическое уравнение не может их описать.

Энергия и сигналы мощности

Сигнал называется сигналом энергии, если и только если полная содержащаяся энергия конечна и отлична от нуля (0 <E <∞). Следовательно, для сигнала любого типа энергии общий нормализованный сигнал конечен и не равен нулю.

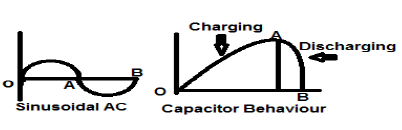

Синусоидальный сигнал переменного тока является прекрасным примером сигнала типа Energy, потому что он находится в положительном полупериоде в одном случае, а затем отрицательный в следующем полупериоде. Следовательно, его средняя мощность становится равной нулю.

Конденсатор без потерь также является прекрасным примером сигнала типа Energy, потому что, когда он подключен к источнику, он заряжается до оптимального уровня, а когда источник удален, он рассеивает такое же количество энергии через нагрузку и делает свою среднюю мощность равной нуль.

Для любого конечного сигнала x (t) энергия может быть обозначена как E и записана как;

$$E = \int_{-\infty}^{+\infty} x^{2}(t)dt$$Спектральная плотность сигналов энергетического типа дает количество энергии, распределенной на различных частотных уровнях.

Тип питания Сигналы

Сигнал называется сигналом типа мощности, если и только если нормализованная средняя мощность конечна и не равна нулю, т.е. (0 <p <∞). Для сигнала типа мощности нормализованная средняя мощность конечна и не равна нулю. Почти все периодические сигналы являются сигналами мощности, и их средняя мощность конечна и не равна нулю.

В математической форме мощность сигнала x (t) может быть записана как;

$$P = \lim_{T \rightarrow \infty}1/T\int_{-T/2}^{+T/2} x^{2}(t)dt$$Разница между сигналами энергии и мощности

В следующей таблице приведены различия сигналов энергии и мощности.

| Сигнал мощности | Энергетический сигнал |

|---|---|

| Практические периодические сигналы - это силовые сигналы. | Непериодические сигналы - это энергетические сигналы. |

| Здесь нормализованная средняя мощность конечна и не равна нулю. | Здесь полная нормализованная энергия конечна и отлична от нуля. |

| Математически, $$P = \lim_{T \rightarrow \infty}1/T\int_{-T/2}^{+T/2} x^{2}(t)dt$$ |

Математически, $$E = \int_{-\infty}^{+\infty} x^{2}(t)dt$$ |

| Эти сигналы могут существовать бесконечно долго. | Эти сигналы существуют в течение ограниченного периода времени. |

| Энергия сигнала мощности бесконечна в течение бесконечного времени. | Мощность энергетического сигнала равна нулю в течение бесконечного времени. |

Решенные примеры

Example 1 - Найдите мощность сигнала $z(t) = 2\cos(3\Pi t+30^{o})+4\sin(3\Pi +30^{o})$

Solution- Два вышеуказанных сигнала ортогональны друг другу, потому что их частотные составляющие идентичны друг другу, а также имеют одинаковую разность фаз. Таким образом, общая мощность будет суммой индивидуальных полномочий.

Позволять $z(t) = x(t)+y(t)$

где $x(t) = 2\cos (3\Pi t+30^{o})$ и $y(t) = 4\sin(3\Pi +30^{o})$

Сила $x(t) = \frac{2^{2}}{2} = 2$

Сила $y(t) = \frac{4^{2}}{2} = 8$

Следовательно, $P(z) = p(x)+p(y) = 2+8 = 10$… Ответ.

Example 2 - Проверить, подан ли сигнал $x(t) = t^{2}+j\sin t$ сопряжена или нет?

Solution- Здесь действительная часть, являющаяся t 2, является четной, а нечетная (мнимая)$\sin t$странно. Таким образом, вышеуказанный сигнал является сопряженным сигналом.

Example 3 - Проверить, есть ли $X(t)= \sin \omega t$ нечетный сигнал или четный сигнал.

Solution - Учитывая $X(t) = \sin \omega t$

Переворачивая время, мы получим $\sin (-\omega t)$

Но мы знаем что $\sin(-\phi) = -\sin \phi$.

Следовательно,

$$\sin (-\omega t) = -\sin \omega t$$Это удовлетворяет условию нечетности сигнала. Следовательно,$\sin \omega t$ это странный сигнал.

Как и сигналы непрерывного времени, сигналы дискретного времени можно классифицировать в соответствии с условиями или операциями с сигналами.

Четные и нечетные сигналы

Даже сигнал

Сигнал называется четным или симметричным, если он удовлетворяет следующему условию;

$$x(-n) = x(n)$$

Здесь мы видим, что x (-1) = x (1), x (-2) = x (2) и x (-n) = x (n). Таким образом, это четный сигнал.

Странный сигнал

Сигнал называется нечетным, если он удовлетворяет следующему условию;

$$x(-n) = -x(n)$$

Из рисунка видно, что x (1) = -x (-1), x (2) = -x (2) и x (n) = -x (-n). Следовательно, это не только антисимметричный, но и нечетный сигнал.

Периодические и непериодические сигналы

Дискретный сигнал времени является периодическим тогда и только тогда, когда он удовлетворяет следующему условию:

$$x(n+N) = x(n)$$Здесь сигнал x (n) повторяется через N периодов. Лучше всего это можно понять, рассмотрев косинусоидальный сигнал -

$$x(n) = A \cos(2\pi f_{0}n+\theta)$$ $$x(n+N) = A\cos(2\pi f_{0}(n+N)+\theta) = A\cos(2\pi f_{0}n+2\pi f_{0}N+\theta)$$ $$= A\cos(2\pi f_{0}n+2\pi f_{0}N+\theta)$$Чтобы сигнал стал периодическим, должно выполняться следующее условие;

$$x(n+N) = x(n)$$ $$\Rightarrow A\cos(2\pi f_{0}n+2\pi f_{0}N+\theta) = A \cos(2\pi f_{0}n+\theta)$$т.е. $2\pi f_{0}N$ является целым кратным $2\pi$

$$2\pi f_{0}N = 2\pi K$$ $$\Rightarrow N = \frac{K}{f_{0}}$$Частоты дискретных синусоидальных сигналов разделены целым кратным $2\pi$.

Энергия и сигналы мощности

Энергетический сигнал

Энергия дискретного сигнала времени обозначается как E. Математически это можно записать как;

$$E = \displaystyle \sum\limits_{n=-\infty}^{+\infty}|x(n)|^2$$Если каждое индивидуальное значение $x(n)$возводим в квадрат и складываем, получаем сигнал энергии. Вот$x(n)$ это энергетический сигнал, и его энергия конечна во времени, т.е. $ 0 <E <\ infty $

Сигнал питания

Средняя мощность дискретного сигнала представлена как P. Математически это можно записать как;

$$P = \lim_{N \to \infty} \frac{1}{2N+1}\displaystyle\sum\limits_{n=-N}^{+N} |x(n)|^2$$Здесь мощность конечна, т.е. 0 <P <∞. Однако есть некоторые сигналы, которые не относятся ни к сигналам типа энергии, ни к типу мощности.

Есть и другие сигналы, которые являются результатом выполненной над ними операции. Некоторые распространенные типы сигналов обсуждаются ниже.

Сопряженные сигналы

Сигналы, удовлетворяющие условию $x(t) = x*(-t)$ называются сопряженными сигналами.

Позволять $x(t) = a(t)+jb(t)$... экв. 1

Так, $x(-t) = a(-t)+jb(-t)$

И $x*(-t) = a(-t)-jb(-t)$... экв. 2

По условию, $x(t) = x*(-t)$

Если мы сравним оба производных уравнения 1 и 2, то увидим, что действительная часть четная, а мнимая - нечетная. Это условие того, чтобы сигнал был сопряженным типом.

Сопряженные антисимметричные сигналы

Сигналы, удовлетворяющие условию $x(t) = -x*(-t)$ называются сопряженным антисимметричным сигналом

Позволять $x(t) = a(t)+jb(t)$... экв. 1

Так $x(-t) = a(-t)+jb(-t)$

И $x*(-t) = a(-t)-jb(-t)$

$-x*(-t) = -a(-t)+jb(-t)$... экв. 2

По условию $x(t) = -x*(-t)$

Теперь снова сравним оба уравнения, как мы это делали для сопряженных сигналов. Здесь мы обнаружим, что действительная часть нечетна, а мнимая часть четна. Это условие для того, чтобы сигнал стал сопряженным антисимметричным типом.

пример

Пусть дан сигнал $x(t) = \sin t+jt^{2}$.

Здесь настоящая часть $\sin t$ странно, а мнимая часть $t^2$даже. Итак, этот сигнал можно классифицировать как сопряженный антисимметричный сигнал.

Любую функцию можно разделить на две части. Одна часть является сопряженной симметрией, а другая часть является сопряженной антисимметричной. Таким образом, любой сигнал x (t) можно записать как

$$x(t) = xcs(t)+xcas(t)$$где $xcs(t)$ сопряженный симметричный сигнал и $xcas(t)$ сопряженный антисимметричный сигнал

$$xcs(t) = \frac{[x(t)+x*(-t)]}{2}$$И

$$xcas(t) = \frac{[x(t)-x*(-t)]}{2}$$Полуволновые симметричные сигналы

Когда сигнал удовлетворяет условию $cx(t) = -x(t\pm (\frac{T_{0}}{2}))$, это называется полуволновым симметричным сигналом. Здесь изменение амплитуды и сдвиг сигнала по времени происходит за половину времени. Для полуволнового симметричного сигнала среднее значение будет равно нулю, но это не тот случай, когда ситуация меняется на противоположную.

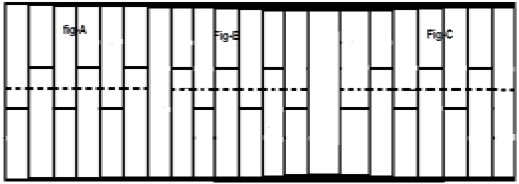

Рассмотрим сигнал x (t), как показано на рисунке A выше. Первый шаг - сдвинуть сигнал по времени и заставить его$x[t-(\frac{T}{2})]$. Итак, новый сигнал изменяется, как показано на рисунке B. Затем мы меняем амплитуду сигнала, т.е.$-x[t-(\frac{T}{2})]$ как показано на рисунке С. Поскольку этот сигнал повторяется после сдвига полупериода и изменения амплитуды, это полуволновой симметричный сигнал.

Ортогональный сигнал

Два сигнала x (t) и y (t) называются ортогональными, если они удовлетворяют следующим двум условиям.

Condition 1 - $\int_{-\infty}^{\infty}x(t)y(t) = 0$ [для непериодического сигнала]

Condition 2 - $\int x(t)y(t) = 0$ [Для периодического сигнала]

Сигналы, содержащие нечетные гармоники (3- я , 5- я , 7- я и т. Д.) И имеющие разные частоты, взаимно ортогональны друг другу.

В сигналах тригонометрического типа синусоидальные и косинусоидальные функции также ортогональны друг другу; при условии, что они имеют одинаковую частоту и находятся в одной фазе. Таким же образом DC (сигналы постоянного тока) и синусоидальные сигналы также ортогональны друг другу. Если x (t) и y (t) - два ортогональных сигнала и$z(t) = x(t)+y(t)$ тогда мощность и энергия z (t) могут быть записаны как;

$$P(z) = p(x)+p(y)$$ $$E(z) = E(x)+E(y)$$пример

Проанализируйте сигнал: $z(t) = 3+4\sin(2\pi t+30^0)$

Здесь сигнал состоит из сигнала постоянного тока (3) и одной синусоидальной функции. Таким образом, по свойству этот сигнал является ортогональным сигналом, и два субсигнала в нем взаимно ортогональны друг другу.

Сдвиг означает движение сигнала либо во временной области (вокруг оси Y), либо в области амплитуды (вокруг оси X). Соответственно, мы можем разделить сдвиг на две категории, названные как сдвиг во времени и сдвиг по амплитуде, которые впоследствии обсуждаются ниже.

Временной сдвиг

Временной сдвиг означает сдвиг сигналов во временной области. Математически это можно записать как

$$x(t) \rightarrow y(t+k)$$Это значение K может быть положительным или отрицательным. В соответствии со знаком значения k у нас есть два типа смещения, названные смещением вправо и смещением влево.

Случай 1 (K> 0)

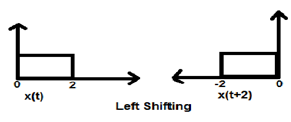

Когда K больше нуля, смещение сигнала происходит «влево» во временной области. Поэтому этот тип смещения известен как смещение сигнала влево.

Example

Случай 2 (K <0)

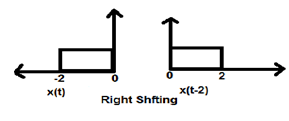

Когда K меньше нуля, смещение сигнала происходит вправо во временной области. Поэтому этот тип смещения известен как смещение вправо.

Example

На приведенном ниже рисунке показан сдвиг сигнала вправо на 2.

Сдвиг амплитуды

Смещение амплитуды означает смещение сигнала в амплитудной области (вокруг оси X). Математически это можно представить как -

$$x(t) \rightarrow x(t)+K$$Это значение K может быть положительным или отрицательным. Соответственно, у нас есть два типа сдвига амплитуды, которые далее обсуждаются ниже.

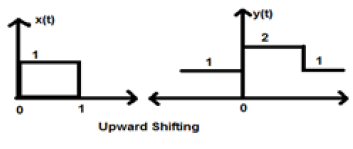

Случай 1 (K> 0)

Когда K больше нуля, смещение сигнала происходит вверх по оси x. Поэтому этот тип переключения известен как смещение вверх.

Example

Рассмотрим сигнал x (t), который задается как;

$$x = \begin{cases}0, & t < 0\\1, & 0\leq t\leq 2\\ 0, & t>0\end{cases}$$Пусть мы взяли K = + 1, поэтому новый сигнал можно записать как -

$y(t) \rightarrow x(t)+1$ Итак, y (t), наконец, можно записать как;

$$x(t) = \begin{cases}1, & t < 0\\2, & 0\leq t\leq 2\\ 1, & t>0\end{cases}$$

Случай 2 (K <0)

Когда K меньше нуля, происходит смещение сигнала вниз по оси X. Поэтому это называется сдвигом сигнала вниз.

Example

Рассмотрим сигнал x (t), который задается как;

$$x(t) = \begin{cases}0, & t < 0\\1, & 0\leq t\leq 2\\ 0, & t>0\end{cases}$$Пусть мы взяли K = -1, чтобы новый сигнал можно было записать как;

$y(t)\rightarrow x(t)-1$ Итак, y (t), наконец, можно записать как;

$$y(t) = \begin{cases}-1, & t < 0\\0, & 0\leq t\leq 2\\ -1, & t>0\end{cases}$$

Масштабирование сигнала означает, что константа умножается на время или амплитуду сигнала.

Масштабирование времени

Если постоянная умножается на ось времени, это называется масштабированием по времени. Математически это можно представить как;

$x(t) \rightarrow y(t) = x(\alpha t)$ или же $x(\frac{t}{\alpha})$; где α ≠ 0

Таким образом, ось y одинакова, величина оси x уменьшается или увеличивается в зависимости от знака константы (положительного или отрицательного). Следовательно, масштабирование также можно разделить на две категории, как описано ниже.

Сжатие времени

Когда альфа больше нуля, амплитуда сигнала делится на альфа, тогда как значение оси Y остается неизменным. Это называется сжатием времени.

Example

Рассмотрим сигнал x (t), который показан на рисунке ниже. Возьмем значение альфа равным 2. Итак, y (t) будет x (2t), что показано на данном рисунке.

Ясно, что из приведенных выше рисунков видно, что величина времени по оси Y остается прежней, но амплитуда по оси x уменьшается с 4 до 2. Следовательно, это случай сжатия по времени.

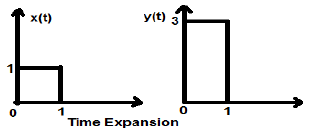

Расширение времени

Когда время делится на постоянную альфа, величина сигнала по оси Y умножается на альфа раз, сохраняя величину по оси X как есть. Поэтому это называется сигналом типа «Расширение времени».

Example

Давайте рассмотрим квадратный сигнал x (t) с величиной 1. Когда мы масштабировали его по времени на константу 3, так что $x(t) \rightarrow y(t) \rightarrow x(\frac{t}{3})$, то амплитуда сигнала изменяется в 3 раза, что показано на рисунке ниже.

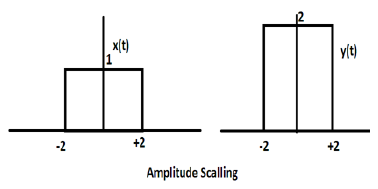

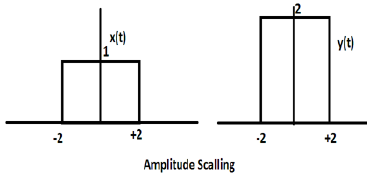

Масштабирование амплитуды

Умножение константы на амплитуду сигнала вызывает масштабирование амплитуды. В зависимости от знака константы это может быть масштабирование амплитуды или затухание. Рассмотрим прямоугольный сигнал x (t) = Π (t / 4).

Предположим, мы определяем другую функцию y (t) = 2 Π (t / 4). В этом случае значение оси Y будет удвоено, сохраняя значение оси времени таким, какое оно есть. Это показано на рисунке ниже.

Рассмотрим другую прямоугольную волновую функцию, определяемую как z (t), где z (t) = 0,5 (t / 4). Здесь амплитуда функции z (t) будет вдвое меньше амплитуды функции x (t), т.е. ось времени останется прежней, ось амплитуды будет уменьшена вдвое. Это показано на рисунке ниже.

Каждый раз, когда время в сигнале умножается на -1, сигнал меняет направление. Он производит зеркальное отображение вокруг оси Y или X. Это известно как разворот сигнала.

Реверс можно разделить на два типа в зависимости от того, умножается ли время или амплитуда сигнала на -1.

Обратное время

Каждый раз, когда время сигнала умножается на -1, это называется обращением времени сигнала. В этом случае сигнал производит зеркальное отображение вокруг оси Y. Математически это можно записать как;

$$x(t) \rightarrow y(t) \rightarrow x(-t)$$Лучше всего это можно понять на следующем примере.

В приведенном выше примере мы ясно видим, что сигнал перевернулся относительно оси Y. Итак, это тоже один из видов масштабирования по времени, но здесь величина масштабирования всегда (-1).

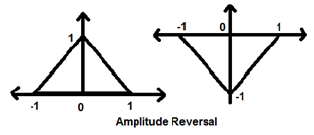

Изменение амплитуды

Каждый раз, когда амплитуда сигнала умножается на -1, это называется инверсией амплитуды. В этом случае сигнал производит зеркальное отображение вокруг оси X. Математически это можно записать как;

$$x(t)\rightarrow y(t)\rightarrow -x(t)$$Рассмотрим следующий пример. Отчетливо виден разворот амплитуды.

Две очень важные операции, выполняемые с сигналами, - это дифференциация и интеграция.

Дифференциация

Дифференциация любого сигнала x (t) означает наклон этого сигнала во времени. Математически это представлено как;

$$x(t)\rightarrow \frac{dx(t)}{dt}$$В случае дифференциации OPAMP эта методология очень полезна. Мы можем легко дифференцировать сигнал графически, а не использовать формулу. Однако условием является то, что сигнал должен быть прямоугольного или треугольного типа, что бывает в большинстве случаев.

| Исходный сигнал | Дифференцированный сигнал |

|---|---|

| Рампа | Шаг |

| Шаг | Импульс |

| Импульс | 1 |

В приведенной выше таблице показано состояние сигнала после дифференцирования. Например, линейный сигнал после дифференцирования преобразуется в ступенчатый сигнал. Точно так же сигнал единичного шага становится импульсным сигналом.

пример

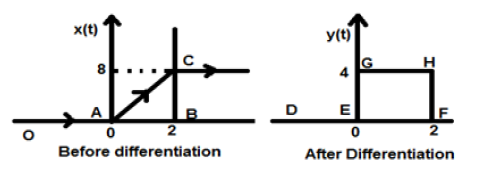

Пусть дан нам сигнал $x(t) = 4[r(t)-r(t-2)]$. Когда этот сигнал нанесен на график, он будет выглядеть так, как показано на левой стороне рисунка, приведенного ниже. Теперь наша цель - различить данный сигнал.

Для начала начнем дифференцировать данное уравнение. Мы знаем, что линейный сигнал после дифференцирования дает сигнал единичного шага.

Таким образом, наш результирующий сигнал y (t) может быть записан как;

$y(t) = \frac{dx(t)}{dt}$

$= \frac{d4[r(t)-r(t-2)]}{dt}$

$= 4[u(t)-u(t-2)]$

Теперь этот сигнал построен окончательно, что показано в правой части рисунка выше.

Интеграция любого сигнала означает суммирование этого сигнала в определенной временной области для получения модифицированного сигнала. Математически это можно представить как -

$$x(t)\rightarrow y(t) = \int_{-\infty}^{t}x(t)dt$$Здесь также в большинстве случаев мы можем выполнить математическое интегрирование и найти результирующий сигнал, но прямое интегрирование в быстрой последовательности возможно для сигналов, которые графически изображены в прямоугольном формате. Как и в случае дифференциации, здесь мы также обратимся к таблице, чтобы быстро получить результат.

| Исходный сигнал | Интегрированный сигнал |

|---|---|

| 1 | импульс |

| Импульс | шаг |

| Шаг | Рампа |

пример

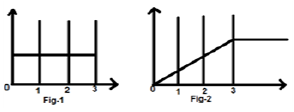

Рассмотрим сигнал $x(t) = u(t)-u(t-3)$. Это показано на рисунке 1 ниже. Ясно, что это ступенчатый сигнал. Теперь интегрируем. Обращаясь к таблице, мы знаем, что интегрирование ступенчатого сигнала дает линейный сигнал.

Однако мы рассчитаем это математически,

$y(t) = \int_{-\infty}^{t}x(t)dt$

$= \int_{-\infty}^{t}[u(t)-u(t-3)]dt$

$= \int_{-\infty}^{t}u(t)dt-\int_{-\infty}^{t}u(t-3)dt$

$= r(t)-r(t-3)$

То же, что и на рис. 2,

Свертка двух сигналов во временной области эквивалентна умножению их представления в частотной области. Математически мы можем записать свертку двух сигналов как

$$y(t) = x_{1}(t)*x_{2}(t)$$ $$= \int_{-\infty}^{\infty}x_{1}(p).x_{2}(t-p)dp$$Шаги для свертки

- Возьмите сигнал x 1 (t) и положите туда t = p, чтобы он был x 1 (p).

- Возьмите сигнал x 2 (t), выполните шаг 1 и сделайте его x 2 (p).

- Сделайте свертку сигнала т.е. x 2 (-p).

- Сделайте сдвиг во времени вышеуказанного сигнала x 2 [- (pt)]

- Затем произведите умножение обоих сигналов. т.е.$x_{1}(p).x_{2}[−(p−t)]$

пример

Сделаем свертку ступенчатого сигнала u (t) с себе подобным.

$y(t) = u(t)*u(t)$

$= \int_{-\infty}^{\infty}[u(p).u[-(p-t)]dp$

Теперь это t может быть больше или меньше нуля, что показано на рисунках ниже.

Итак, в приведенном выше случае результат возникает со следующими возможностями

$y(t) = \begin{cases}0, & if\quad t<0\\\int_{0}^{t}1dt, & for\quad t>0\end{cases}$

$= \begin{cases}0, & if\quad t<0\\t, & t>0\end{cases} = r(t)$

Свойства свертки

Коммутативный

В нем говорится, что порядок свертки не имеет значения, что математически можно показать как

$$x_{1}(t)*x_{2}(t) = x_{2}(t)*x_{1}(t)$$Ассоциативный

В нем говорится, что порядок свертки, включающий три сигнала, может быть любым. Математически это можно представить как;

$$x_{1}(t)*[x_{2}(t)*x_{3}(t)] = [x_{1}(t)*x_{2}(t)]*x_{3}(t)$$Распределительный

Сначала могут быть добавлены два сигнала, а затем их свертка может быть произведена в третий сигнал. Это эквивалентно свертке двух сигналов по отдельности с третьим сигналом и окончательно сложенным. Математически это можно записать как;

$$x_{1}(t)*[x_{2}(t)+x_{3}(t)] = [x_{1}(t)*x_{2}(t)+x_{1}(t)*x_{3}(t)]$$Площадь

Если сигнал является результатом свертки двух сигналов, то площадь сигнала - это умножение этих отдельных сигналов. Математически это можно записать

Если $y(t) = x_{1}*x_{2}(t)$

Тогда Площадь y (t) = Площадь x 1 (t) X Площадь x 2 (t)

Масштабирование

Если два сигнала масштабируются до некоторой неизвестной константы «а» и выполняется свертка, то результирующий сигнал также будет свернут до той же константы «а» и будет разделен на эту величину, как показано ниже.

Если, $x_{1}(t)*x_{2}(t) = y(t)$

Потом, $x_{1}(at)*x_{2}(at) = \frac{y(at)}{a}, a \ne 0$

Задержка

Предположим, что сигнал y (t) является результатом свертки двух сигналов x1 (t) и x2 (t). Если два сигнала задерживаются на время t1 и t2 соответственно, то результирующий сигнал y (t) будет задержан на (t1 + t2). Математически это можно записать как -

Если, $x_{1}(t)*x_{2}(t) = y(t)$

Потом, $x_{1}(t-t_{1})*x_{2}(t-t_{2}) = y[t-(t_{1}+t_{2})]$

Решенные примеры

Example 1 - Найдите свертку сигналов u (t-1) и u (t-2).

Solution- Данными сигналами являются u (t-1) и u (t-2). Их свертку можно выполнить, как показано ниже -

$y(t) = u(t-1)*u(t-2)$

$y(t) = \int_{-\infty}^{+\infty}[u(t-1).u(t-2)]dt$

$= r(t-1)+r(t-2)$

$= r(t-3)$

Example 2 - Найдите свертку двух сигналов, заданных

$x_{1}(n) = \lbrace 3,-2, 2\rbrace $

$x_{2}(n) = \begin{cases}2, & 0\leq n\leq 4\\0, & x > elsewhere\end{cases}$

Solution -

x 2 (n) можно декодировать как$x_{2}(n) = \lbrace 2,2,2,2,2\rbrace Originalfirst$

x 1 (n) задано ранее$= \lbrace 3,-2,3\rbrace = 3-2Z^{-1}+2Z^{-2}$

Так же, $x_{2}(z) = 2+2Z^{-1}+2Z^{-2}+2Z^{-3}+2Z^{-4}$

Результирующий сигнал,

$X(Z) = X_{1}(Z)X_{2}(z)$

$= \lbrace 3-2Z^{-1}+2Z^{-2}\rbrace \times \lbrace 2+2Z^{-1}+2Z^{-2}+2Z^{-3}+2Z^{-4}\rbrace$

$= 6+2Z^{-1}+6Z^{-2}+6Z^{-3}+6Z^{-4}+6Z^{-5}$

Принимая обратное Z-преобразование вышеупомянутого, мы получим результирующий сигнал как

$x(n) = \lbrace 6,2,6,6,6,0,4\rbrace$ Происхождение в первую очередь

Example 3 - Определите свертку следующих 2 сигналов -

$x(n) = \lbrace 2,1,0,1\rbrace$

$h(n) = \lbrace 1,2,3,1\rbrace$

Solution -

Принимая Z-преобразование сигналов, получаем,

$x(z) = 2+2Z^{-1}+2Z^{-3}$

И $h(n) = 1+2Z^{-1}+3Z^{-2}+Z^{-3}$

Теперь свертка двух сигналов означает умножение их Z-преобразований.

То есть $Y(Z) = X(Z) \times h(Z)$

$= \lbrace 2+2Z^{-1}+2Z^{-3}\rbrace \times \lbrace 1+2Z^{-1}+3Z^{-2}+Z^{-3}\rbrace$

$= \lbrace 2+5Z^{-1}+8Z^{-2}+6Z^{-3}+3Z^{-4}+3Z^{-5}+Z^{-6}\rbrace$

Используя обратное Z-преобразование, результирующий сигнал можно записать как;

$y(n) = \lbrace 2,5,8,6,6,1 \rbrace Originalfirst$

Некоторые системы имеют обратную связь, а некоторые нет. Те, которые не имеют системы обратной связи, их выход зависит только от текущих значений входных данных. Прошлое значение данных в то время отсутствует. Эти типы систем известны как статические системы. Это тоже не зависит от будущих ценностей.

Поскольку в этих системах нет прошлых записей, значит, у них нет и памяти. Поэтому мы говорим, что все статические системы - это системы без памяти. Давайте возьмем пример, чтобы лучше понять эту концепцию.

пример

Давайте проверим, являются ли следующие системы статическими или нет.

- $y(t) = x(t)+x(t-1)$

- $y(t) = x(2t)$

- $y(t) = x = \sin [x(t)]$

а) $y(t) = x(t)+x(t-1)$

Здесь x (t) - текущая стоимость. Это не имеет никакого отношения к прошлым ценностям того времени. Итак, это статическая система. Однако в случае x (t-1), если мы положим t = 0, он уменьшится до x (-1), который зависит от прошлого значения. Итак, это не статично. Следовательно, здесь y (t) не является статической системой.

б) $y(t) = x(2t)$

Если мы подставим t = 2, результат будет y (t) = x (4). Опять же, это зависит от будущей стоимости. Так что это тоже не статическая система.

в) $y(t) = x = \sin [x(t)]$

В этом выражении мы имеем дело с синусоидальной функцией. Диапазон синусоидальной функции находится в пределах от -1 до +1. Итак, какие бы значения мы ни подставляли для x (t), мы получим от -1 до +1. Таким образом, можно сказать, что он не зависит ни от прошлых, ни от будущих ценностей. Следовательно, это статическая система.

Из приведенных выше примеров мы можем сделать следующие выводы -

- Любая система со сдвигом во времени не статична.

- Любая система со сдвигом амплитуды также не статична.

- Случаи интеграции и дифференциации также не статичны.

Если система зависит от прошлого и будущего значения сигнала в любой момент времени, то она называется динамической системой. В отличие от статических систем, это не системы без памяти. В них хранятся прошлые и будущие ценности. Следовательно, они требуют некоторой памяти. Давайте лучше поймем эту теорию на нескольких примерах.

Примеры

Узнайте, являются ли следующие системы динамическими.

a) $y(t) = x(t+1)$

В этом случае, если мы поместим t = 1 в уравнение, оно будет преобразовано в x (2), которое является будущим зависимым значением. Потому что здесь мы вводим значение 1, но показывает значение для x (2). Поскольку это сигнал, зависящий от будущего, очевидно, что это динамическая система.

b) $y(t) = Real[x(t)]$

$$= \frac{[x(t)+x(t)^*]}{2}$$В этом случае, какое бы значение мы ни поставили, оно будет показывать сигнал реального значения времени. Он не зависит от будущих или прошлых ценностей. Следовательно, это не динамическая система, а статическая система.

c) $y(t) = Even[x(t)]$

$$= \frac{[x(t)+x(-t)]}{2}$$Здесь, если мы заменим t = 1, один сигнал покажет x (1), а другой покажет x (-1), которое является прошлым значением. Аналогично, если мы положим t = -1, тогда один сигнал покажет x (-1), а другой покажет x (1), которое является будущим значением. Следовательно, очевидно, что это случай динамической системы.

d) $y(t) = \cos [x(t)]$

В этом случае, поскольку система является функцией косинуса, она имеет определенную область значений, которая находится в диапазоне от -1 до +1. Следовательно, какие бы значения мы ни поставили, мы получим результат в пределах указанного лимита. Следовательно, это статическая система

Из приведенных выше примеров мы можем сделать следующие выводы -

- Все сигналы случаев сдвига во времени являются динамическими сигналами.

- В случае масштабирования по времени все сигналы также являются динамическими.

- Сигналы случаев интеграции являются динамическими сигналами.

Ранее мы видели, что система должна быть независимой от будущих и прошлых ценностей, чтобы стать статичной. В этом случае состояние почти такое же с небольшими изменениями. Здесь, чтобы система была причинной, она должна быть независимой только от будущих ценностей. Это означает, что прошлая зависимость не вызовет проблем, когда система станет причинной.

Причинные системы представляют собой практически или физически реализуемые системы. Давайте рассмотрим несколько примеров, чтобы лучше понять это.

Примеры

Рассмотрим следующие сигналы.

a) $y(t) = x(t)$

Здесь сигнал зависит только от текущих значений x. Например, если мы подставим t = 3, результат будет отображаться только для этого момента времени. Следовательно, поскольку она не зависит от будущей стоимости, мы можем назвать ее причинной системой.

b) $y(t) = x(t-1)$

Здесь система зависит от прошлых ценностей. Например, если мы подставим t = 3, выражение сократится до x (2), которое является прошлым значением для нашего ввода. Ни в коем случае это не зависит от будущих ценностей. Следовательно, эта система также является причинной системой.

c) $y(t) = x(t)+x(t+1)$

В данном случае система состоит из двух частей. Часть x (t), как мы обсуждали ранее, зависит только от текущих значений. Так что никаких проблем с этим нет. Однако, если мы возьмем случай x (t + 1), он явно зависит от будущих значений, потому что если мы положим t = 1, выражение сократится до x (2), что является будущим значением. Следовательно, это не причинно.

Непричинная система прямо противоположна причинной системе. Если система зависит от будущих значений входных данных в любой момент времени, то говорят, что система не является причинно-следственной системой.

Примеры

Давайте возьмем несколько примеров и попробуем понять это лучше.

a) $y(t) = x(t+1)$

Мы уже обсуждали эту систему в причинной системе. Для любого ввода это уменьшит стоимость системы до ее будущего значения. Например, если мы положим t = 2, оно уменьшится до x (3), что является будущим значением. Следовательно, система не является причинной.

b) $y(t) = x(t)+x(t+2)$

В этом случае x (t) является чисто зависимой функцией от текущей стоимости. Мы уже обсуждали, что функция x (t + 2) зависит от будущего, потому что для t = 3 она даст значения для x (5). Следовательно, это не причинно.

c) $y(t) = x(t-1)+x(t)$

В этой системе это зависит от настоящих и прошлых значений заданного входа. Какие бы значения мы ни подставляли, они никогда не покажут никакой будущей зависимости. Ясно, что это не беспричинная система; скорее это причинная система.

Антипричинная система - это всего лишь немного модифицированная версия непричинной системы. Система зависит только от будущих значений входных данных. Он не зависит ни от настоящих, ни от прошлых ценностей.

Примеры

Узнайте, являются ли следующие системы антипричинными.

a) $y(t) = x(t)+x(t-1)$

Система имеет две подфункции. Одна подфункция x (t + 1) зависит от будущего значения ввода, а другая подфункция x (t) зависит только от настоящего. Поскольку система зависит от текущей стоимости в дополнение к будущей стоимости, эта система не является антипричинной.

b) $y(t) = x(t+3)$

Если мы проанализируем вышеуказанную систему, мы увидим, что система зависит только от будущих значений системы, т.е. если мы положим t = 0, оно уменьшится до x (3), что является будущим значением. Эта система - прекрасный пример антипричинной системы.

Линейная система подчиняется законам суперпозиции. Этот закон является необходимым и достаточным условием для доказательства линейности системы. Помимо этого, система представляет собой комбинацию двух типов законов:

- Закон аддитивности

- Закон однородности

И закон однородности, и закон аддитивности показаны на рисунках выше. Однако есть и другие условия, позволяющие проверить, является ли система линейной или нет.

The conditions are -

- Выход должен быть нулевым для нулевого входа.

- В системе не должно быть никаких нелинейных операторов.

Примеры нелинейных операторов -

(а) Тригонометрические операторы - Sin, Cos, Tan, Cot, Sec, Cosec и т. д.

(b) Экспоненциальная, логарифмическая, модульная, квадратная, кубическая и т. д.

(c) sa (i / p), Sinc (i / p), Sqn (i / p) и т. д.

Ни входной x, ни выходной y не должны иметь этих нелинейных операторов.

Примеры

Выясним, являются ли следующие системы линейными.

a) $y(t) = x(t)+3$

Эта система не является линейной, потому что она нарушает первое условие. Если мы положим вход равным нулю, сделав x (t) = 0, то выход не будет нулевым.

b) $y(t) = \sin tx(t)$

В этой системе, если мы дадим вход как ноль, выход станет нулевым. Следовательно, первое условие явно выполняется. Опять же, к x (t) не применялся нелинейный оператор. Следовательно, второе условие также выполняется. Следовательно, система является линейной системой.

c) $y(t) = \sin (x(t))$

В указанной выше системе выполняется первое условие, потому что если мы положим x (t) = 0, на выходе также будет sin (0) = 0. Однако второе условие не выполняется, так как существует нелинейный оператор, который управляет x (t). Следовательно, система не линейна.

Если мы хотим дать определение этой системе, мы можем сказать, что системы, которые не являются линейными, являются нелинейными системами. Ясно, что в этом случае должны выполняться все условия, которые нарушаются в линейных системах.

Условия

Выход не должен быть нулевым, когда применяемый вход равен нулю.

Любой нелинейный оператор может быть применен к входу или выходу, чтобы сделать систему нелинейной.

Примеры

Узнать, являются ли данные системы линейными или нелинейными.

a) $y(t) = e^{x(t)}$

В указанной выше системе выполняется первое условие, потому что если мы сделаем вход равным нулю, на выходе будет 1. Кроме того, ко входу применяется экспоненциальный нелинейный оператор. Ясно, что это случай нелинейной системы.

b) $y(t) = x(t+1)+x(t-1)$

Вышеупомянутый тип системы имеет дело как с прошлыми, так и с будущими ценностями. Однако, если мы сделаем его вход нулевым, то ни одно из его значений не существует. Следовательно, мы можем сказать, что если ввод равен нулю, то версия ввода с масштабированием по времени и со сдвигом по времени также будет равна нулю, что нарушает наше первое условие. Опять же, здесь нет нелинейного оператора. Следовательно, нарушается и второе условие. Ясно, что эта система не является нелинейной системой; скорее это линейная система.

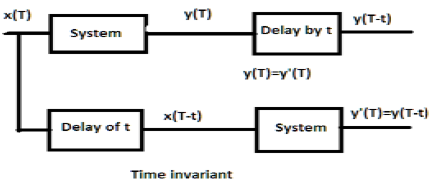

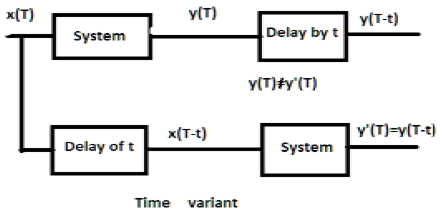

Для системы, не зависящей от времени, выход и вход должны задерживаться на некоторую единицу времени. Любая задержка, предусмотренная на входе, должна отражаться на выходе для неизменной во времени системы.

Примеры

a) $y(T) = x(2T)$

Если это выражение выше, оно сначала проходит через систему, а затем через временную задержку (как показано в верхней части рисунка); тогда вывод станет$x(2T-2t)$. Теперь то же выражение сначала проходит через временную задержку, а затем через систему (как показано в нижней части рисунка). Результат станет$x(2T-t)$.

Следовательно, система не является неизменной во времени системой.

b) $y(T) = \sin [x(T)]$

Если сигнал сначала проходит через систему, а затем через процесс задержки времени, выход будет $\sin x(T-t)$. Точно так же, если система сначала проходит через временную задержку, а затем через систему, то выходной сигнал будет$\sin x(T-t)$. Мы ясно видим, что оба выхода одинаковы. Следовательно, система инвариантна во времени.

Для изменяющейся во времени системы также, выход и вход должны задерживаться на некоторую постоянную времени, но задержка на входе не должна отражаться на выходе. Все случаи масштабирования по времени являются примерами системы изменения во времени. Точно так же, когда коэффициент в системной взаимосвязи является функцией времени, тогда система также является временной.

Примеры

a) $y(t) = x[\cos T]$

Если вышеупомянутый сигнал сначала проходит через систему, а затем через временную задержку, выход будет $x\cos (T-t)$. Если сначала он будет пропущен через временную задержку, а затем через систему, он будет$x(\cos T-t)$. Поскольку выходы не одинаковы, система зависит от времени.

b) $y(T) = \cos T.x(T)$

Если вышеуказанное выражение сначала пропущено через систему, а затем через временную задержку, то на выходе будет $\cos(T-t)x(T-t)$. Однако, если выражение передается сначала через временную задержку, а затем через систему, на выходе будет$\cos T.x(T-t)$. Поскольку выходы не совпадают, очевидно, что система зависит от времени.

Стабильная система удовлетворяет условию BIBO (ограниченный вход для ограниченного выхода). Здесь ограниченный означает конечный по амплитуде. Для стабильной системы выход должен быть ограниченным или конечным, для конечного или ограниченного входа в каждый момент времени.

Некоторыми примерами ограниченных входов являются функции синуса, косинуса, постоянного тока, знака и единичного шага.

Примеры

a) $y(t) = x(t)+10$

Здесь для определенного ограниченного входа мы можем получить определенный ограниченный выход, т.е. если мы положим $x(t) = 2, y(t) = 12$которая ограничена по своей природе. Следовательно, система стабильна.

b) $y(t) = \sin [x(t)]$

В данном выражении мы знаем, что синусоидальные функции имеют определенную границу значений, которая находится между -1 и +1. Итак, какие бы значения мы ни подставили в x (t), мы получим значения в пределах нашей границы. Следовательно, система стабильна.

Нестабильные системы не удовлетворяют условиям BIBO. Следовательно, для ограниченного входа мы не можем ожидать ограниченного выхода в случае нестабильных систем.

Примеры

a) $y(t) = tx(t)$

Здесь для конечного входа мы не можем ожидать конечного выхода. Например, если мы положим$x(t) = 2 \Rightarrow y(t) = 2t$. Это не конечное значение, потому что мы не знаем значение t. Таким образом, его можно варьировать откуда угодно. Следовательно, эта система нестабильна. Это нестабильная система.

b) $y(t) = \frac{x(t)}{\sin t}$

Ранее мы обсуждали, что функция синуса имеет определенный диапазон от -1 до +1; но здесь он присутствует в знаменателе. Итак, в худшем случае, если мы положим t = 0 и функция синуса станет нулевой, тогда вся система будет стремиться к бесконечности. Следовательно, этот тип системы совсем не стабилен. Очевидно, это нестабильная система.

Example 1 - Проверить, есть ли $y(t) = x*(t)$ является линейным или нелинейным.

Solution- Функция представляет собой сопряженное значение ввода. Это может быть проверено либо первым законом однородности и законом аддитивности, либо двумя правилами. Однако проверка с помощью правил намного проще, поэтому мы будем придерживаться этого.

Если вход в систему равен нулю, выход также стремится к нулю. Следовательно, наше первое условие выполнено. Ни на входе, ни на выходе не используется нелинейный оператор. Следовательно, система линейная.

Example 2 - Проверить, есть ли $y(t)=\begin{cases}x(t+1), & t > 0\\x(t-1), & t\leq 0\end{cases}$ линейно или нелинейно

Solution- Очевидно, мы можем видеть, что когда время становится меньше или равно нулю, вход становится нулевым. Итак, мы можем сказать, что при нулевом входе и выходе также ноль, и наше первое условие выполнено.

Опять же, на входе и на выходе нет нелинейных операторов. Следовательно, система линейная.

Example 3 - Проверить, есть ли $y(t) = \sin t.x(t)$ стабильно или нет.

Solution - Предположим, мы взяли значение x (t) равным 3. Здесь синусоидальная функция была умножена на нее, а максимальное и минимальное значение синусоидальной функции варьируется от -1 до +1.

Следовательно, максимальное и минимальное значение всей функции также будет варьироваться от -3 до +3. Таким образом, система стабильна, потому что здесь мы получаем ограниченный вход для ограниченного выхода.

Дискретное временное преобразование Фурье (DTFT) существует для сигналов энергии и мощности. Z-преобразование также существует для сигналов типа «ни энергия, ни мощность» (NENP), только до определенной степени. Замена$z=e^{jw}$ используется для преобразования Z-преобразования в DTFT только для абсолютно суммируемого сигнала.

Таким образом, Z-преобразование дискретного временного сигнала x (n) в ряд по степеням может быть записано как -

$$X(z) = \sum_{n-\infty}^\infty x(n)Z^{-n}$$Вышеприведенное уравнение представляет собой уравнение двустороннего Z-преобразования.

Как правило, когда сигнал Z-преобразован, его можно представить как -

$$X(Z) = Z[x(n)]$$Или же $x(n) \longleftrightarrow X(Z)$

Если это непрерывный сигнал времени, то Z-преобразования не нужны, потому что используются преобразования Лапласа. Однако сигналы дискретного времени можно анализировать только с помощью Z-преобразования.

Регион конвергенции

Область конвергенции - это диапазон комплексной переменной Z в Z-плоскости. Z-преобразование сигнала конечное или сходящееся. Итак, ROC представляет собой тот набор значений Z, для которого X (Z) имеет конечное значение.

Свойства ROC

- ROC не включает полюса.

- Для правостороннего сигнала ROC будет вне круга в Z-плоскости.

- Для левостороннего сигнала ROC будет внутри круга в Z-плоскости.

- Для стабильности ROC включает единичный круг в Z-плоскости.

- Для двустороннего сигнала ROC представляет собой кольцо в Z-плоскости.

- Для сигнала конечной длительности ROC представляет собой всю Z-плоскость.

Z-преобразование однозначно характеризуется -

- Выражение X (Z)

- ROC X (Z)

Сигналы и их ROC

| х (п) | X (Z) | ROC |

|---|---|---|

| $\delta(n)$ | $1$ | Вся плоскость Z |

| $U(n)$ | $1/(1-Z^{-1})$ | Мод (Z)> 1 |

| $a^nu(n)$ | $1/(1-aZ^{-1})$ | Мод (Z)> Мод (а) |

| $-a^nu(-n-1)$ | $1/(1-aZ^{-1})$ | Mod (Z) <Mod (a) |

| $na^nu(n)$ | $aZ^{-1}/(1-aZ^{-1})^2$ | Мод (Z)> Мод (а) |

| $-a^nu(-n-1)$ | $aZ^{-1}/(1-aZ^{-1})^2$ | Mod (Z) <Mod (a) |

| $U(n)\cos \omega n$ | $(Z^2-Z\cos \omega)/(Z^2-2Z \cos \omega +1)$ | Мод (Z)> 1 |

| $U(n)\sin \omega n$ | $(Z\sin \omega)/(Z^2-2Z \cos \omega +1)$ | Мод (Z)> 1 |

пример

Найдем Z-преобразование и ROC сигнала, заданного как $x(n) = \lbrace 7,3,4,9,5\rbrace$, где начало ряда находится в 3.

Solution - Применяя формулу, которую мы имеем -

$X(z) = \sum_{n=-\infty}^\infty x(n)Z^{-n}$

$= \sum_{n=-1}^3 x(n)Z^{-n}$

$= x(-1)Z+x(0)+x(1)Z^{-1}+x(2)Z^{-2}+x(3)Z^{-3}$

$= 7Z+3+4Z^{-1}+9Z^{-2}+5Z^{-3}$

ROC - это вся Z-плоскость за исключением Z = 0, ∞, -∞

В этой главе мы поймем основные свойства Z-преобразований.

Линейность

В нем указано, что когда два или более отдельных дискретных сигнала умножаются на константы, их соответствующие Z-преобразования также будут умножены на те же константы.

Математически,

$$a_1x_1(n)+a_2x_2(n) = a_1X_1(z)+a_2X_2(z)$$Proof - Мы это знаем,

$$X(Z) = \sum_{n=-\infty}^\infty x(n)Z^{-n}$$$= \sum_{n=-\infty}^\infty (a_1x_1(n)+a_2x_2(n))Z^{-n}$

$= a_1\sum_{n = -\infty}^\infty x_1(n)Z^{-n}+a_2\sum_{n = -\infty}^\infty x_2(n)Z^{-n}$

$= a_1X_1(z)+a_2X_2(z)$ (Следовательно, доказано)

Здесь ОКР - это $ROC_1\bigcap ROC_2$.

Временной сдвиг

Свойство сдвига во времени показывает, как изменение во временной области дискретного сигнала повлияет на Z-область, которую можно записать как;

$$x(n-n_0)\longleftrightarrow X(Z)Z^{-n}$$Или же $x(n-1)\longleftrightarrow Z^{-1}X(Z)$

Proof -

Позволять $y(P) = X(P-K)$

$Y(z) = \sum_{p = -\infty}^\infty y(p)Z^{-p}$

$= \sum_{p = -\infty}^\infty (x(p-k))Z^{-p}$

Пусть s = pk

$= \sum_{s = -\infty}^\infty x(s)Z^{-(s+k)}$

$= \sum_{s = -\infty}^\infty x(s)Z^{-s}Z^{-k}$

$= Z^{-k}[\sum_{s=-\infty}^\infty x(m)Z^{-s}]$

$= Z^{-k}X(Z)$ (Следовательно, доказано)

Здесь ROC можно записать как Z = 0 (p> 0) или Z = ∞ (p <0)

пример

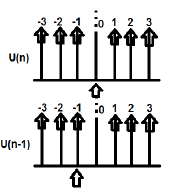

U (n) и U (n-1) могут быть построены следующим образом

Z-преобразование U (n) cab можно записать как;

$\sum_{n = -\infty}^\infty [U(n)]Z^{-n} = 1$

Z-преобразование U (n-1) можно записать как;

$\sum_{n = -\infty}^\infty [U(n-1)]Z^{-n} = Z^{-1}$

Так вот $x(n-n_0) = Z^{-n_0}X(Z)$ (Следовательно, доказано)

Масштабирование времени

Свойство Time Scaling сообщает нам, какой будет Z-домен сигнала, когда время масштабируется в его дискретной форме, которая может быть записана как;

$$a^nx(n) \longleftrightarrow X(a^{-1}Z)$$Proof -

Позволять $y(p) = a^{p}x(p)$

$Y(P) = \sum_{p=-\infty}^\infty y(p)Z^{-p}$

$= \sum_{p=-\infty}^\infty a^px(p)Z^{-p}$

$= \sum_{p=-\infty}^\infty x(p)[a^{-1}Z]^{-p}$

$= X(a^{-1}Z)$(Следовательно, доказано)

ROC: = Mod (ar1) <Mod (Z) <Mod (ar2), где Mod = модуль

пример

Определим Z-преобразование $x(n) = a^n \cos \omega n$ используя свойство масштабирования времени.

Solution -

Мы уже знаем, что Z-преобразование сигнала $\cos (\omega n)$ дается -

$$\sum_{n=-\infty}^\infty(\cos \omega n)Z^{-n} = (Z^2-Z \cos \omega)/(Z^2-2Z\cos \omega +1)$$

Теперь, применяя свойство масштабирования времени, Z-преобразование $a^n \cos \omega n$ можно записать как;

$\sum_{n=-\infty}^\infty(a^n\cos \omega n)Z^{-n} = X(a^{-1}Z)$

$= [(a^{-1}Z)^2-(a^{-1}Z \cos \omega n)]/((a^{-1}Z)^2-2(a^{-1}Z \cos \omega n)+1)$

$= Z(Z-a \cos \omega)/(Z^2-2az \cos \omega+a^2)$

Последовательная дифференциация

Свойство последовательной дифференциации показывает, что Z-преобразование будет иметь место, когда мы дифференцируем дискретный сигнал во временной области относительно времени. Это показано ниже.

$$\frac{dx(n)}{dn} = (1-Z^{-1})X(Z)$$Proof -

Рассмотрим левую часть уравнения - $\frac{dx(n)}{dn}$

$$= \frac{[x(n)-x(n-1)]}{[n-(n-1)]}$$$= x(n)-X(n-1)$

$= x(Z)-Z^{-1}x(Z)$

$= (1-Z^{-1})x(Z)$ (Следовательно, доказано)

ROC: R1 <Mod (Z) <R2

пример

Найдем Z-преобразование сигнала по формуле $x(n) = n^2u(n)$

По свойству мы можем написать

$Zz[nU(n)] = -Z\frac{dZ[U(n)]}{dz}$

$= -Z\frac{d[\frac{Z}{Z-1}]}{dZ}$

$= Z/((Z-1)^2$

$= y(let)$

Теперь Z [ny] можно найти, снова применив свойство

$Z(n,y) = -Z\frac{dy}{dz}$

$= -Z\frac{d[Z/(Z-1)^3]}{dz}$

$= Z(Z+1)/(Z-1)^2$

Свертка

Это отображает изменение в Z-области системы, когда свертка имеет место в форме дискретного сигнала, которую можно записать как -

$x_1(n)*x_2(n) \longleftrightarrow X_1(Z).X_2(Z)$

Proof -

$X(Z) = \sum_{n = -\infty}^\infty x(n)Z^{-n}$

$= \sum_{n=-\infty}^\infty[\sum_{k = -\infty}^\infty x_1(k)x_2(n-k)]Z^{-n}$

$= \sum_{k = -\infty}^\infty x_1(k)[\sum_n^\infty x_2(n-k)Z^{-n}]$

$= \sum_{k = -\infty}^\infty x_1(k)[\sum_{n = -\infty}^\infty x_2(n-k)Z^{-(n-k)}Z^{-k}]$

Пусть nk = l, тогда приведенное выше уравнение cab записывается как -

$X(Z) = \sum_{k = -\infty}^\infty x_1(k)[Z^{-k}\sum_{l=-\infty}^\infty x_2(l)Z^{-l}]$

$= \sum_{k = -\infty}^\infty x_1(k)X_2(Z)Z^{-k}$

$= X_2(Z)\sum_{k = -\infty}^\infty x_1(Z)Z^{-k}$

$= X_1(Z).X_2(Z)$ (Следовательно, доказано)

РПЦ:$ROC\bigcap ROC2$

пример

Найдем свертку двух сигналов

$x_1(n) = \lbrace 3,-2,2\rbrace$ ... (ур.1)

$x_2(n) = \lbrace 2,0\leq 4\quad and\quad 0\quad elsewhere\rbrace$ ... (уравнение 2)

Z-преобразование первого уравнения можно записать как;

$\sum_{n = -\infty}^\infty x_1(n)Z^{-n}$

$= 3-2Z^{-1}+2Z^{-2}$

Z-преобразование второго сигнала можно записать как;

$\sum_{n = -\infty}^\infty x_2(n)Z^{-n}$

$= 2+2Z^{-1}+2Z^{-2}+2Z^{-3}+2Z^{-4}$

Итак, свертка двух вышеупомянутых сигналов определяется следующим образом:

$X(Z) = [x_1(Z)^*x_2(Z)]$

$= [3-2Z^{-1}+2Z^{-2}]\times [2+2Z^{-1}+2Z^{-2}+2Z^{-3}+2Z^{-4}]$

$= 6+2Z^{-1}+6Z^{-2}+6Z^{-3}+...\quad...\quad...$

Применяя обратное Z-преобразование, получаем,

$x(n) = \lbrace 6,2,6,6,6,0,4\rbrace$

Теорема о начальном значении

Если x (n) является причинной последовательностью, Z-преобразование которой имеет вид X (z), то теорема о начальном значении может быть записана как;

$X(n)(at\quad n = 0) = \lim_{z \to \infty} X(z)$

Proof - Мы это знаем,

$X(Z) = \sum_{n = 0} ^\infty x(n)Z^{-n}$

Расширяя вышеуказанный ряд, получаем:

$= X(0)Z^0+X(1)Z^{-1}+X(2)Z^{-2}+...\quad...$

$= X(0)\times 1+X(1)Z^{-1}+X(2)Z^{-2}+...\quad...$

В указанном выше случае, если Z → ∞, то $Z^{-n}\rightarrow 0$ (Поскольку n> 0)

Следовательно, мы можем сказать;

$\lim_{z \to \infty}X(z) = X(0)$ (Следовательно, доказано)

Теорема о конечном значении

Теорема о конечном значении утверждает, что если Z-преобразование сигнала представлено как X (Z) и все полюса находятся внутри круга, то его конечное значение обозначается как x (n) или X (∞) и может быть записано как -

$X(\infty) = \lim_{n \to \infty}X(n) = \lim_{z \to 1}[X(Z)(1-Z^{-1})]$

Conditions -

- Это применимо только для причинных систем.

- $X(Z)(1-Z^{-1})$ должен иметь полюса внутри единичной окружности в Z-плоскости.

Proof - Мы знаем, что

$Z^+[x(n+1)-x(n)] = \lim_{k \to \infty}\sum_{n=0}^kZ^{-n}[x(n+1)-x(n)]$

$\Rightarrow Z^+[x(n+1)]-Z^+[x(n)] = \lim_{k \to \infty}\sum_{n=0}^kZ^{-n}[x(n+1)-x(n)]$

$\Rightarrow Z[X(Z)^+-x(0)]-X(Z)^+ = \lim_{k \to \infty}\sum_{n = 0}^kZ^{-n}[x(n+1)-x(n)]$

Здесь мы можем применить расширенное свойство одностороннего Z-преобразования. Итак, приведенное выше уравнение можно переписать как:

$Z^+[x(n+1)] = Z[X(2)^+-x(0)Z^0] = Z[X(Z)^+-x(0)]$

Теперь положив z = 1 в приведенное выше уравнение, мы можем расширить приведенное выше уравнение -

$\lim_{k \to \infty}{[x(1)-x(0)+x(6)-x(1)+x(3)-x(2)+...\quad...\quad...+x(x+1)-x(k)]}$

Это можно сформулировать так:

$X(\infty) = \lim_{n \to \infty}X(n) = \lim_{z \to 1}[X(Z)(1-Z^{-1})]$(Следовательно, доказано)

пример

Найдем начальное и конечное значение x (n), сигнал которого задается выражением

$X(Z) = 2+3Z^{-1}+4Z^{-2}$

Solution - Давайте сначала найдем начальное значение сигнала, применив теорему

$x(0) = \lim_{z \to \infty}X(Z)$

$= \lim_{z \to \infty}[2+3Z^{-1}+4Z^{-2}]$

$= 2+(\frac{3}{\infty})+(\frac{4}{\infty}) = 2$

Теперь найдем Конечное значение сигнала, применив теорему

$x(\infty) = \lim_{z \to \infty}[(1-Z^{-1})X(Z)]$

$= \lim_{z \to \infty}[(1-Z^{-1})(2+3Z^{-1}+4Z^{-2})]$

$= \lim_{z \to \infty}[2+Z^{-1}+Z^{-2}-4Z^{-3}]$

$= 2+1+1-4 = 0$

Some other properties of Z-transform are listed below -

Дифференциация по частоте

Он дает изменение в Z-области сигнала, когда его дискретный сигнал дифференцируется по времени.

$nx(n)\longleftrightarrow -Z\frac{dX(z)}{dz}$

Его ROC можно записать как;

$r_2< Mod(Z)< r_1$

пример

Давайте найдем значение x (n) с помощью дифференцирования по частоте, дискретный сигнал которого в Z-области определяется выражением $x(n)\longleftrightarrow X(Z) = log(1+aZ^{-1})$

По свойству мы можем написать, что

$nx(n)\longleftrightarrow -Z\frac{dx(Z)}{dz}$

$= -Z[\frac{-aZ^{-2}}{1+aZ^{-1}}]$

$= (aZ^{-1})/(1+aZ^{-1})$

$= 1-1/(1+aZ^{-1})$

$nx(n) = \delta(n)-(-a)^nu(n)$

$\Rightarrow x(n) = 1/n[\delta(n)-(-a)^nu(n)]$

Умножение во времени

Он дает изменение в Z-области сигнала, когда умножение происходит на дискретном уровне сигнала.

$x_1(n).x_2(n)\longleftrightarrow(\frac{1}{2\Pi j})[X1(Z)*X2(Z)]$

Спряжение во времени

Это изображает представление сопряженного дискретного сигнала в Z-области.

$X^*(n)\longleftrightarrow X^*(Z^*)$

Система, выполняющая системные функции, может быть стабильной только в том случае, если все полюса лежат внутри единичной окружности. Сначала мы проверяем, является ли система причинной или нет. Если система является Причинной, то мы переходим к определению ее устойчивости BIBO; где устойчивость BIBO относится к ограниченному входу при условии ограниченного выхода.

Это можно записать как;

$Mod(X(Z))< \infty$

$= Mod(\sum x(n)Z^{-n})< \infty$

$= \sum Mod(x(n)Z^{-n})< \infty$

$= \sum Mod[x(n)(re^{jw})^{-n}]< 0$

$= \sum Mod[x(n)r^{-n}]Mod[e^{-jwn}]< \infty$

$= \sum_{n = -\infty}^\infty Mod[x(n)r^{-n}]< \infty$

Приведенное выше уравнение показывает условие существования Z-преобразования.

Однако условием существования сигнала DTFT является

$$\sum_{n = -\infty}^\infty Mod(x(n)< \infty$$Пример 1

Попробуем найти Z-преобразование сигнала, которое задается как

$x(n) = -(-0.5)^{-n}u(-n)+3^nu(n)$

$= -(-2)^nu(n)+3^nu(n)$

Solution - Здесь для $-(-2)^nu(n)$ ROC левосторонний и Z <2

За $3^nu(n)$ ROC правосторонний и Z> 3

Следовательно, здесь Z-преобразование сигнала не будет, потому что нет общей области.

Пример 2

Попробуем найти Z-преобразование сигнала по формуле

$x(n) = -2^nu(-n-1)+(0.5)^nu(n)$

Solution - Здесь для $-2^nu(-n-1)$ ROC сигнала левосторонний и Z <2

Для сигнала $(0.5)^nu(n)$ ROC правосторонний и Z> 0,5

Итак, общий ROC формируется как 0,5 <Z <2

Следовательно, Z-преобразование можно записать как;

$X(Z) = \lbrace\frac{1}{1-2Z^{-1}}\rbrace+\lbrace\frac{1}{(1-0.5Z)^{-1}}\rbrace$

Пример 3

Попробуем найти Z-преобразование сигнала, которое задается как $x(n) = 2^{r(n)}$

Solution- r (n) - сигнал рампы. Таким образом, сигнал можно записать как:

$x(n) = 2^{nu(n)}\lbrace 1, n<0 (u(n)=0)\quad and\quad2^n, n\geq 0(u(n) = 1)\rbrace$

$= u(-n-1)+2^nu(n)$

Здесь для сигнала $u(-n-1)$ и ROC Z <1 и для $2^nu(n)$ с ROC Z> 2.

Значит, Z-преобразования сигнала не будет.

Z-преобразование причинной системы

Причинную систему можно определить как $h(n) = 0,n<0$. Для причинной системы ROC будет вне круга в Z-плоскости.

$H(Z) = \displaystyle\sum\limits_{n = 0}^{\infty}h(n)Z^{-n}$

Расширяя приведенное выше уравнение,

$H(Z) = h(0)+h(1)Z^{-1}+h(2)Z^{-2}+...\quad...\quad...$

$= N(Z)/D(Z)$

Для причинных систем расширение передаточной функции не включает положительные степени Z. Для причинной системы порядок числителя не может превышать порядок знаменателя. Это можно записать как

$\lim_{z \rightarrow \infty}H(Z) = h(0) = 0\quad or\quad Finite$

Для устойчивости причинной системы полюса передаточной функции должны находиться внутри единичного круга в Z-плоскости.

Z-преобразование для антипричинной системы

Антипричинную систему можно определить как $h(n) = 0, n\geq 0$. Для антипричинной системы полюса передаточной функции должны лежать вне единичной окружности в Z-плоскости. Для антипричинной системы ROC будет внутри круга в Z-плоскости.

Если мы хотим проанализировать систему, которая уже представлена в частотной области, как сигнал дискретного времени, мы переходим к обратному Z-преобразованию.

Математически это можно представить как;

$$x(n) = Z^{-1}X(Z)$$где x (n) - сигнал во временной области, а X (Z) - сигнал в частотной области.

Если мы хотим представить приведенное выше уравнение в интегральном формате, мы можем записать его как

$$x(n) = (\frac{1}{2\Pi j})\oint X(Z)Z^{-1}dz$$Здесь интеграл ведется по замкнутому пути C. Этот путь находится внутри ROC x (z) и содержит начало координат.

Методы поиска обратного Z-преобразования

Когда анализ необходим в дискретном формате, мы конвертируем сигнал частотной области обратно в дискретный формат с помощью обратного Z-преобразования. Мы следуем следующим четырем способам определения обратного Z-преобразования.

- Метод длинного деления

- Метод частичного разложения фракций

- Метод остатка или контурного интеграла

Метод длинного деления

В этом методе Z-преобразование сигнала x (z) может быть представлено как отношение полиномов, как показано ниже;

$$x(z)=N(Z)/D(Z)$$Теперь, если мы продолжим делить числитель на знаменатель, то мы получим ряд, как показано ниже.

$$X(z) = x(0)+x(1)Z^{-1}+x(2)Z^{-2}+...\quad...\quad...$$Вышеупомянутая последовательность представляет собой серию обратного Z-преобразования данного сигнала (для n≥0), и указанная выше система является причинной.

Однако для n <0 серию можно записать как;

$$x(z) = x(-1)Z^1+x(-2)Z^2+x(-3)Z^3+...\quad...\quad...$$Метод частичного разложения фракций

Здесь также сигнал сначала выражается в форме N (z) / D (z).

Если это рациональная дробь, она будет представлена следующим образом;

$x(z) = b_0+b_1Z^{-1}+b_2Z^{-2}+...\quad...\quad...+b_mZ^{-m})/(a_0+a_1Z^{-1}+a_2Z^{-2}+...\quad...\quad...+a_nZ^{-N})$

Вышеупомянутый неверен, когда m <n и an 0

Если соотношение неправильное (например, неправильное), то мы должны преобразовать его в надлежащую форму, чтобы решить эту проблему.

Остаточный или контурный интегральный метод

В этом методе мы получаем обратное Z-преобразование x (n) путем суммирования вычетов $[x(z)Z^{n-1}]$на всех полюсах. Математически это можно выразить как

$$x(n) = \displaystyle\sum\limits_{all\quad poles\quad X(z)}residues\quad of[x(z)Z^{n-1}]$$Здесь вычет для любого полюса порядка m при $z = \beta$ является

$$Residues = \frac{1}{(m-1)!}\lim_{Z \rightarrow \beta}\lbrace \frac{d^{m-1}}{dZ^{m-1}}\lbrace (z-\beta)^mX(z)Z^{n-1}\rbrace$$Пример 1

Найдите реакцию системы $s(n+2)-3s(n+1)+2s(n) = \delta (n)$, когда все начальные условия равны нулю.

Solution - Взяв Z-преобразование с обеих сторон приведенного выше уравнения, мы получим

$$S(z)Z^2-3S(z)Z^1+2S(z) = 1$$$\Rightarrow S(z)\lbrace Z^2-3Z+2\rbrace = 1$

$\Rightarrow S(z) = \frac{1}{\lbrace z^2-3z+2\rbrace}=\frac{1}{(z-2)(z-1)} = \frac{\alpha _1}{z-2}+\frac{\alpha _2}{z-1}$

$\Rightarrow S(z) = \frac{1}{z-2}-\frac{1}{z-1}$

Взяв обратное Z-преобразование приведенного выше уравнения, мы получим

$S(n) = Z^{-1}[\frac{1}{Z-2}]-Z^{-1}[\frac{1}{Z-1}]$

$= 2^{n-1}-1^{n-1} = -1+2^{n-1}$

Пример 2

Найдите системную функцию H (z) и отклик единичной выборки h (n) системы, разностное уравнение которой описывается следующим образом:

$y(n) = \frac{1}{2}y(n-1)+2x(n)$

где y (n) и x (n) - выход и вход системы соответственно.

Solution - Взяв Z-преобразование приведенного выше разностного уравнения, мы получаем

$y(z) = \frac{1}{2}Z^{-1}Y(Z)+2X(z)$

$= Y(Z)[1-\frac{1}{2}Z^{-1}] = 2X(Z)$

$= H(Z) = \frac{Y(Z)}{X(Z)} = \frac{2}{[1-\frac{1}{2}Z^{-1}]}$

Эта система имеет полюс на $Z = \frac{1}{2}$ и $Z = 0$ и $H(Z) = \frac{2}{[1-\frac{1}{2}Z^{-1}]}$

Следовательно, взяв обратное Z-преобразование вышеупомянутого, мы получим

$h(n) = 2(\frac{1}{2})^nU(n)$

Пример 3

Определить Y (z), n≥0 в следующем случае -

$y(n)+\frac{1}{2}y(n-1)-\frac{1}{4}y(n-2) = 0\quad given\quad y(-1) = y(-2) = 1$

Solution - Применяя Z-преобразование к приведенному выше уравнению, мы получаем

$Y(Z)+\frac{1}{2}[Z^{-1}Y(Z)+Y(-1)]-\frac{1}{4}[Z^{-2}Y(Z)+Z^{-1}Y(-1)+4(-2)] = 0$

$\Rightarrow Y(Z)+\frac{1}{2Z}Y(Z)+\frac{1}{2}-\frac{1}{4Z^2}Y(Z)-\frac{1}{4Z}-\frac{1}{4} = 0$

$\Rightarrow Y(Z)[1+\frac{1}{2Z}-\frac{1}{4Z^2}] =\frac{1}{4Z}-\frac{1}{2}$

$\Rightarrow Y(Z)[\frac{4Z^2+2Z-1}{4Z^2}] = \frac{1-2Z}{4Z}$

$\Rightarrow Y(Z) = \frac{Z(1-2Z)}{4Z^2+2Z-1}$

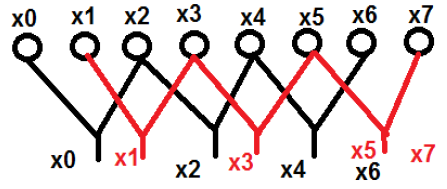

Подобно преобразованию Фурье сигнала непрерывного времени, преобразование Фурье с дискретным временем может использоваться для представления дискретной последовательности в ее эквивалентном представлении в частотной области и системе дискретного времени LTI и для разработки различных вычислительных алгоритмов.

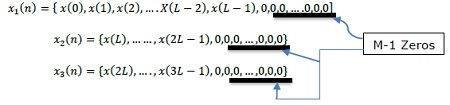

X (jω) в непрерывном FT является непрерывной функцией x (n). Однако DFT имеет дело с представлением x (n) с выборками его спектра X (ω). Следовательно, этот математический инструмент имеет большое значение в вычислительном отношении в удобном представлении. С помощью этого инструмента можно обрабатывать как периодические, так и непериодические последовательности. Для выборки периодических последовательностей необходимо увеличить период до бесконечности.

Выборка в частотной области

Из введения ясно, что нам нужно знать, как выполнять выборку в частотной области, то есть выборку X (ω). Следовательно, связь между дискретизированным преобразованием Фурье и ДПФ устанавливается следующим образом.

Точно так же периодические последовательности могут соответствовать этому инструменту, если увеличить период N до бесконечности.

Пусть непериодическая последовательность равна, $X(n) = \lim_{N \to \infty}x_N(n)$

Определяя его преобразование Фурье,

$X(\omega ) = \sum_{n=-\infty}^\infty x(n)e^{-jwn}X(K\delta \omega)$

Здесь X (ω) дискретизируется периодически на каждом интервале радиан δω.

Поскольку X (ω) периодичен в 2π радиан, нам нужны выборки только в основном диапазоне. Выборки берутся через эквидистантные интервалы в диапазоне частот 0≤ω≤2π. Расстояние между эквивалентными интервалами составляет$\delta \omega = \frac{2\pi }{N}k$ радиан.

Теперь оценивая, $\omega = \frac{2\pi}{N}k$

$X(\frac{2\pi}{N}k) = \sum_{n = -\infty}^\infty x(n)e^{-j2\pi nk/N},$ ... уравнение (2)

где k = 0,1, …… N-1

После разделения приведенного выше и изменения порядка суммирования

$X(\frac{2\pi}{N}k) = \displaystyle\sum\limits_{n = 0}^{N-1}[\displaystyle\sum\limits_{l = -\infty}^\infty x(n-Nl)]e^{-j2\pi nk/N}$ ... уравнение (3)

$\sum_{l=-\infty}^\infty x(n-Nl) = x_p(n) = a\quad periodic\quad function\quad of\quad period\quad N\quad and\quad its\quad fourier\quad series\quad = \sum_{k = 0}^{N-1}C_ke^{j2\pi nk/N}$

где, n = 0,1,… .., N-1; 'p' - обозначает периодическую сущность или функцию

Коэффициенты Фурье:

$C_k = \frac{1}{N}\sum_{n = 0}^{N-1}x_p(n)e^{-j2\pi nk/N}$k = 0,1,…, N-1 ... уравнение (4)

Сравнивая уравнения 3 и 4, получаем:

$NC_k = X(\frac{2\pi}{N}k)$k = 0,1,…, N-1 ... уравнение (5)

$NC_k = X(\frac{2\pi}{N}k) = X(e^{jw}) = \displaystyle\sum\limits_{n = -\infty}^\infty x_p(n)e^{-j2\pi nk/N}$... уравнение (6)

Из разложения в ряд Фурье,

$x_p(n) = \frac{1}{N}\displaystyle\sum\limits_{k = 0}^{N-1}NC_ke^{j2\pi nk/N} = \frac{1}{N}\sum_{k = 0}^{N-1}X(\frac{2\pi}{N}k)e^{j2\pi nk/N}$... уравнение (7)

Где n = 0,1,…, N-1

Здесь мы получили периодический сигнал от X (ω). $x(n)$ можно извлечь из $x_p(n)$ только, если во временной области нет алиасинга. $N\geq L$

N = период $x_p(n)$ L = период $x(n)$

$x(n) = \begin{cases}x_p(n), & 0\leq n\leq N-1\\0, & Otherwise\end{cases}$

Таким образом достигается отображение.

Свойства ДПФ

Линейность

В нем говорится, что ДПФ комбинации сигналов равно сумме ДПФ отдельных сигналов. Возьмем два сигнала x 1 (n) и x 2 (n), ДПФ которых равны X 1 (ω) и X 2 (ω) соответственно. Так что если

$x_1(n)\rightarrow X_1(\omega)$и$x_2(n)\rightarrow X_2(\omega)$

потом $ax_1(n)+bx_2(n)\rightarrow aX_1(\omega)+bX_2(\omega)$

где a и b являются константами.

Симметрия

Свойства симметрии ДПФ могут быть получены аналогично тому, как мы вывели свойства симметрии ДПФ. Мы знаем, что ДПФ последовательности x (n) обозначается X (K). Теперь, если x (n) и X (K) являются комплекснозначной последовательностью, то ее можно представить как под

$x(n) = x_R(n)+jx_1(n),0\leq n\leq N-1$

И $X(K) = X_R(K)+jX_1(K),0\leq K\leq N-1$

Свойство двойственности

Рассмотрим сигнал x (n), ДПФ которого задается как X (K). Пусть последовательность конечной длительности будет X (N). Тогда согласно теореме двойственности

Если, $x(n)\longleftrightarrow X(K)$

Потом, $X(N)\longleftrightarrow Nx[((-k))_N]$

Итак, используя эту теорему, если мы знаем ДПФ, мы можем легко найти последовательность конечной длительности.

Сложные сопряженные свойства

Предположим, имеется сигнал x (n), ДПФ которого также известно нам как X (K). Теперь, если комплексно-сопряженный сигнал задан как x * (n), то мы можем легко найти ДПФ без особых вычислений, используя теорему, показанную ниже.

Если, $x(n)\longleftrightarrow X(K)$

Потом, $x*(n)\longleftrightarrow X*((K))_N = X*(N-K)$

Круговой сдвиг частоты

Умножение последовательности x (n) на комплексную экспоненциальную последовательность $e^{j2\Pi kn/N}$эквивалентен круговому сдвигу ДПФ на L единиц по частоте. Это двойное свойство циклического сдвига во времени.

Если, $x(n)\longleftrightarrow X(K)$

Потом, $x(n)e^{j2\Pi Kn/N}\longleftrightarrow X((K-L))_N$

Умножение двух последовательностей

Если есть два сигнала x 1 (n) и x 2 (n) и их соответствующие ДПФ равны X 1 (k) и X 2 (K), то умножение сигналов во временной последовательности соответствует циклической свертке их ДПФ.

Если, $x_1(n)\longleftrightarrow X_1(K)\quad\&\quad x_2(n)\longleftrightarrow X_2(K)$

Потом, $x_1(n)\times x_2(n)\longleftrightarrow X_1(K)© X_2(K)$

Теорема Парсеваля

Для комплексных последовательностей x (n) и y (n) в общем случае

Если, $x(n)\longleftrightarrow X(K)\quad \&\quad y(n)\longleftrightarrow Y(K)$

Потом, $\sum_{n = 0}^{N-1}x(n)y^*(n) = \frac{1}{N}\sum_{k = 0}^{N-1}X(K)Y^*(K)$

Мы знаем, что когда $\omega = 2\pi K/N$ и $N\rightarrow \infty,\omega$ становится непрерывной переменной, а суммирование пределов становится $-\infty$ к $+\infty$.

Следовательно,

$$NC_k = X(\frac{2\pi}{N}k) = X(e^{j\omega}) = \displaystyle\sum\limits_{n = -\infty}^\infty x(n)e^{\frac{-j2\pi nk}{N}} = \displaystyle\sum\limits_{n = -\infty}^\infty x(n)e^{-j\omega n}$$Преобразование Фурье с дискретным временем (DTFT)

Мы знаем это, $X(e^{j\omega}) = \sum_{n = -\infty}^\infty x(n)e^{-j\omega n}$

Где, $X(e^{j\omega})$непрерывна и периодична по ω с периодом 2π. … Уравнение (1)

В настоящее время,

$x_p(n) = \sum_{k = 0}^{N-1}NC_ke^{j2 \pi nk/N}$ … Из ряда Фурье

$x_p(n) = \frac{1}{2\pi}\sum_{k=0}^{N-1}NC_ke^{j2\pi nk/N}\times \frac{2\pi}{N}$

ω становится непрерывным и $\frac{2\pi}{N}\rightarrow d\omega$, по причинам, указанным выше.

$x(n) = \frac{1}{2\pi}\int_{n = 0}^{2\pi}X(e^{j\omega})e^{j\omega n}d\omega$… Уравнение (2)

Обратное дискретное временное преобразование Фурье

Символично,

$x(n)\Longleftrightarrow x(e^{j\omega})$(Пара преобразований Фурье)

Необходимое и достаточное условие существования дискретного преобразования Фурье для непериодической последовательности x (n) является абсолютно суммируемым.

т.е.$\sum_{n = -\infty}^\infty|x(n)|<\infty$

Свойства DTFT

Linearity : $a_1x_1(n)+a_2x_2(n)\Leftrightarrow a_1X_1(e^{j\omega})+a_2X_2(e^{j\omega})$

Time shifting - $x(n-k)\Leftrightarrow e^{-j\omega k}.X(e^{j\omega})$

Time Reversal - $x(-n)\Leftrightarrow X(e^{-j\omega})$

Frequency shifting - $e^{j\omega _0n}x(n)\Leftrightarrow X(e^{j(\omega -\omega _0)})$

Differentiation frequency domain - $nx(n) = j\frac{d}{d\omega}X(e^{j\omega})$

Convolution - $x_1(n)*x_2(n)\Leftrightarrow X_1(e^{j\omega})\times X_2(e^{j\omega})$

Multiplication - $x_1(n)\times x_2(n)\Leftrightarrow X_1(e^{j\omega})*X_2(e^{j\omega})$

Co-relation - $y_{x_1\times x_2}(l)\Leftrightarrow X_1(e^{j\omega})\times X_2(e^{j\omega})$

Modulation theorem - $x(n)\cos \omega _0n = \frac{1}{2}[X_1(e^{j(\omega +\omega _0})*X_2(e^{jw})$

Symmetry -$x^*(n)\Leftrightarrow X^*(e^{-j\omega})$ ;

$x^*(-n)\Leftrightarrow X^*(e^{j\omega})$ ;

$Real[x(n)]\Leftrightarrow X_{even}(e^{j\omega})$ ;

$Imag[x(n)]\Leftrightarrow X_{odd}(e^{j\omega})$ ;

$x_{even}(n)\Leftrightarrow Real[x(e^{j\omega})]$ ;

$x_{odd}(n)\Leftrightarrow Imag[x(e^{j\omega})]$ ;

Parseval’s theorem - $\sum_{-\infty}^\infty|x_1(n)|^2 = \frac{1}{2\pi}\int_{-\pi}^{\pi}|X_1(e^{j\omega})|^2d\omega$