Assoziatives Gedächtnis implementieren

Geschrieben von Shashata Sawmya und Harveer Singh

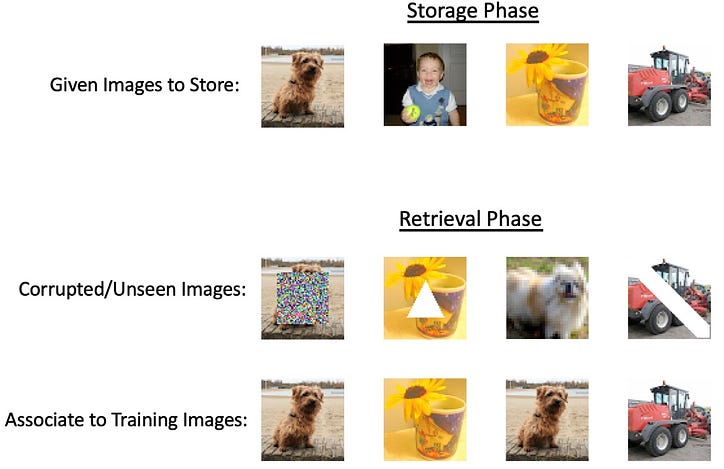

Mit dem Aufkommen großer neuronaler Netze und den ständig zunehmenden technologischen Fortschritten, die aktuelle Methoden an ihre absoluten Grenzen bringen, liegt der Schwerpunkt auf der Entwicklung eines Allround-Tools, das alles kann. Allerdings würden die meisten Aufgaben nicht die unglaublich intensiven tiefen Netzwerke erfordern, sondern dennoch etwas Vielseitigeres als grundlegende mathematische Modelle. Eine mögliche Aufgabe, die nicht die Intensität tiefer neuronaler Netze erfordern würde, wäre das Speichern und Abrufen von Informationen, die als assoziative Erinnerungen bezeichnet werden. Die Idee hier ist, dass wir bei gegebener Eingabe eine verwandte Ausgabe von einem System abrufen möchten, das diese beiden miteinander verknüpft und im „Speicher“ behält. Der Name assoziatives Gedächtnis geht auf das psychologische Konzept zurück, dass unser Gehirn ein Gedächtnisspeichersystem ist, das in der Lage ist, Konzepte miteinander zu verknüpfen. Eine Art des assoziativen Gedächtnisses ist das autoassoziative Gedächtnis, bei dem wir eine teilweise Darstellung unserer gewünschten Ausgabe als Eingabe geben. Dabei kann es sich entweder um die Ausgabe mit zusätzlichem Rauschen oder um ausgeblendete Teile der Ausgabe handeln. Ein Beispiel für diese Art von Gedächtnis in Aktion wäre, wenn Sie ein Teilbild eines Verwandten sehen und Ihr Gehirn den Rest des Bildes automatisch mental ausfüllen könnte. Ein anderer Typ ist das heteroassoziative Gedächtnis, bei dem die Ausgaben verschiedenen Kategorien der gegebenen Eingabe angehören können, das Modell jedoch daran denkt, sie miteinander zu verknüpfen. Stellen Sie sich vor, Sie hören das Wort „Hund“, Ihr Gehirn ist in der Lage, es automatisch mit anderen Begriffen wie „Katze“ oder „Leine“ zu assoziieren [1]. Ein Beispiel für diese Art von Gedächtnis in Aktion wäre, wenn Sie ein Teilbild eines Verwandten sehen und Ihr Gehirn den Rest des Bildes automatisch mental ausfüllen könnte. Ein anderer Typ ist das heteroassoziative Gedächtnis, bei dem die Ausgaben verschiedenen Kategorien der gegebenen Eingabe angehören können, das Modell jedoch daran denkt, sie miteinander zu verknüpfen. Stellen Sie sich vor, Sie hören das Wort „Hund“, Ihr Gehirn ist in der Lage, es automatisch mit anderen Begriffen wie „Katze“ oder „Leine“ zu assoziieren [1]. Ein Beispiel für diese Art von Gedächtnis in Aktion wäre, wenn Sie ein Teilbild eines Verwandten sehen und Ihr Gehirn den Rest des Bildes automatisch mental ausfüllen könnte. Ein anderer Typ ist das heteroassoziative Gedächtnis, bei dem die Ausgaben verschiedenen Kategorien der gegebenen Eingabe angehören können, das Modell jedoch daran denkt, sie miteinander zu verknüpfen. Stellen Sie sich vor, Sie hören das Wort „Hund“, Ihr Gehirn ist in der Lage, es automatisch mit anderen Begriffen wie „Katze“ oder „Leine“ zu assoziieren [1].

AM-Systeme (Assoziatives Gedächtnis) haben eine lange Geschichte, aber es gibt wichtige Forschungsmeilensteine, die einen Überblick über die technischen Fortschritte geben können:

- Willshaw-Netz (Willshaw et al., 1969)

- Hopfield-Netzwerk (Hopfield, 1982)

Inspiriert von den „gedächtnisähnlichen“ Eigenschaften von Hologrammen schlug DJ Willshaw 1969 den Korrelelographen oder Korrelogramm und einen quantitativen Ansatz für das assoziative Gedächtnis vor.

Die obige Abbildung zeigt die Faltung der Muster A und B, um ein neues Muster auf C zu erzeugen. Genauer gesagt enthalten A und B Nadellöcher, durch die eine Lichtquelle (hinter A) hindurchtritt, um ein Muster auf C zu erzeugen, das Informationen über beide Muster von enthält Nadellöcher. Auf dieser Grundlage, siehe Abbildung 2 unten, erzeugt das Erzeugen von Nadellöchern aus dem projizierten Muster auf C und das Leiten von Licht, das hinter C und durch B emittiert wird, genau das gleiche Muster, wo sich die Nadellöcher von A befinden.

Während der Konstruktion des Korrelographen bemerkte Willshaw, dass das Muster auf C die Größe N² hätte, wenn sowohl A als auch B N Nadellöcher enthielten. Dies führte zum Vorschlag des assoziativen Netzes, einem Schnittpunkt von N parallelen Linien (die A darstellen) und N parallelen Linien (die B darstellen).

Der Aufbau des Netzes folgt, dass jeder Halbkreis im N²-Raum eingeschaltet ist, wenn sowohl der linke Eingang als auch der rechte Eingang ebenfalls eingeschaltet sind, was ihre Verbindung zueinander darstellt. Sie können dann Muster A aus B abrufen, indem Sie den On-Kreisen von der linken Seite folgen und sehen, mit welchen On-Kreisen von oben sie verknüpft sind, indem Sie sehen, welche der N²-Punkte On sind. Es ist klar, dass dies mit nur einer Paarzuordnung problemlos funktionieren würde, aber es ist auch möglich, mehrere Muster im selben Netz zu lernen. Willshaw zeigt, dass das theoretische Maximum der Effizienz des Netzwerks dann erreicht ist, wenn 50 % der N²-Punkte eingeschaltet sind. Dies verringert die Wahrscheinlichkeit eines „falschen Treffers“ – was auf einen Punkt in A schließen lässt, der ursprünglich nicht mit dem B-Muster verknüpft war [2 ].

Hopfield-Netzwerk

Natürlich im Anschluss an das assoziative Netzwerk kam es 1982 zu einer großen Innovation, die das moderne AM-Design voranbrachte, als John Hopfield, der oft als der Pate der neuronalen Netzwerke bezeichnet wird, sein Hopfield-Netzwerk vorschlug. Das Netzwerk ist rekurrent und vollständig verbunden, wobei sich jedes Neuron in einem binären Zustand (0 oder 1) befindet und die gegebene Gewichtung zwischen dem Eingabewert und dem gewünschten Ausgabewert in einer Gewichtsmatrix dargestellt wird.

Wenn Tij die entsprechende Gewichtsmatrix ist, wird die Assoziation erreicht durch:

Dabei handelt es sich um einen Cutoff-Betrag, der geschickt gewählt wurde, um die Genauigkeit zu verbessern.

Für die Speicherung mehrerer Assoziationszustände gilt folgender Algorithmus:

Wir erlegen die Einschränkung auf, dass für i=j das Gewicht in T 0 ist. Dies führt zur Pseudoorthogonalität von:

Dies legt nahe, dass der vorhergesagte Wert für J positiv ist, wenn Vi 1 ist, und negativ, wenn er 0 ist. Dies folgt der vorherigen Assoziationsregel, bei der U 0 ist.

Dieser Lernalgorithmus ermittelt im Wesentlichen die stabilen Zustände für jedes Muster, aber dadurch wird die Anzahl der Muster, die sich ein bestimmtes Netzwerk merken kann, belastet. Inspiriert von Ising-Modellen und der Energieminimierung schlägt Hopfield vor, diesen Aktualisierungsmechanismus als Energieminimierung zu interpretieren. Bei einem wiederkehrenden Netzwerk mit N Knoten sind alle Knoten miteinander verbunden. Wir nehmen jeweils einen zufälligen Knoten und verwenden die Gewichtsmatrix, um diesen Knoten zu aktualisieren.

Dabei ist s die Knotennummer und der Wert in den Klammern der Zeitschritt.

Bei der Untersuchung der stabilen Punkte wird der Aktualisierungsalgorithmus durch diese Energieregel definiert:

Dies deutet darauf hin, dass jede Änderung von Vi die Energie des Netzwerks verringert, solange die Änderung von Vi (+ oder -) mit dem Vorzeichen der Ausgabe der Matrixmultiplikation übereinstimmt.

Die Knoten werden asynchron und zufällig gemäß der angegebenen Energieregel und dem angegebenen Schwellenwert aktualisiert. Das Erreichen eines stabilen Energiezustands ist garantiert, da die Aktualisierungsregel ein Neuron nur dann ändert, wenn sie die Energie in jedem Zeitschritt verringert. Bei der Bestimmung, wie viele stabile Zustände existieren können, wurde gezeigt, dass etwa 0,15 N Zustände für N Neuronen im Modell existieren, eine strikte o(N)-Skalierung [3]. Es ist auch wichtig anzumerken, dass die Struktur dieser Art von Netzwerk dazu beiträgt, bei autoassoziativen Aufgaben erfolgreich zu sein, es gibt jedoch Variationen wie „Vektor-Matrix-Vektor“-Kodierungen, die auch heteroassoziatives Gedächtnis implementieren können [4].

Biologische Theorien

Eine Schlüsselidee, die allen oben genannten Modellen zugrunde liegt, besteht darin, eine Verbindung zu fördern, wenn ein Neuron mit dem Neuron im übereinstimmenden Muster übereinstimmt. Diese Art des Lernens ist als „hebbianisches Lernen“ bekannt, das eine Verbindung in Synapsen fördert, wenn die beiden Neuronen gemeinsam feuern. Obwohl die Gedächtnisbildung im Gehirn immer noch ein unbekanntes Phänomen ist, wurde im Labor gezeigt, dass die Idee „zusammen feuern, zusammen verdrahten“ biologisch korrekt ist [5].

Assoziatives Gedächtnis in-silico implementieren

Assoziatives Gedächtnis ist eine Art Gedächtnis, das das Speichern und Abrufen von Informationen basierend auf den Beziehungen oder Assoziationen zwischen verschiedenen Datenteilen ermöglicht. Die Entwicklung von Rechenmodellen für ein solches System ist ein altbewährtes Problem an der Schnittstelle von Neurowissenschaften und künstlicher Intelligenz. Gut untersuchte Methoden wie Hopfield-Netzwerke können nur binäre Muster speichern; Allerdings erfordern komplexe Daten (wie Bilder und Texte) komplexe Systeme, um das Problem zu lösen.

Sind energiebasierte Methoden gute Rechenmodelle für das assoziative Gedächtnis?

Fast alle energiebasierten assoziativen Gedächtnismodelle speichern Muster in den lokalen Minima einer Energiefunktion. Die Hauptidee dieser Modelle besteht darin, eine Energielandschaft zu definieren, in der die gespeicherten Muster stabilen Zuständen mit niedriger Energie entsprechen. Die Energiefunktion ist so konzipiert, dass sie mehrere lokale Minima aufweist, die jeweils ein gespeichertes Muster darstellen. Wenn das System eine Eingabe empfängt, aktualisiert es iterativ seinen Zustand, um die Energiefunktion zu minimieren, und konvergiert schließlich mit dem nächstgelegenen gespeicherten Muster, also dem lokalen Minimum, das der Eingabe am nächsten liegt. Einige energiebasierte Modelle sind –

Hopfield-Netzwerke [2]: Die Energiefunktion in Hopfield-Netzwerken ist als quadratische Funktion des Netzwerkzustands definiert. Jedes gespeicherte Muster entspricht einem lokalen Minimum dieser Energiefunktion. Die Netzwerkdynamik stellt sicher, dass das System zu einem dieser lokalen Minima konvergiert und so das zugehörige Muster effektiv abruft.

Boltzmann-Maschinen [6]: Bei Boltzmann-Maschinen wird die Energiefunktion anhand der Zustände der Knoten und der Gewichte der Verbindungen zwischen ihnen definiert. Der Lernprozess passt die Gewichte an, um eine Energielandschaft mit lokalen Minima zu erstellen, die den gespeicherten Mustern entsprechen. Das System nutzt dann stochastische Dynamik, um die Energielandschaft zu erkunden, sich auf ein lokales Minimum einzustellen und das entsprechende Muster abzurufen.

Auf der Mittelfeldtheorie basierende Ansätze [7]: Diese Ansätze speichern auch Muster in den lokalen Minima einer Energiefunktion. Durch die Annäherung der Dynamik eines komplexen Systems mit der Mean-Field-Theorie können die Lern- und Abrufprozesse effizienter analysiert und optimiert werden.

Diese herkömmlichen Modelle können kleine Bilddaten verarbeiten, können jedoch aufgrund ihrer begrenzten Kapazität, Skalierbarkeit und Rechenkomplexität Probleme mit größeren und komplexeren Bildern haben.

Kann Interpolation allein ein assoziatives Gedächtnis implementieren?

Beim Auswendiglernen muss das Modell Trainingsdaten abrufen, während bei der Interpolation die Fähigkeit besteht, die Trainingsdaten perfekt anzupassen. Daher kann die Interpolation allein kein assoziatives Gedächtnis implementieren. Interpolation kann eine nützliche Technik zur Approximation von Werten zwischen bekannten Datenpunkten sein, sie reicht jedoch nicht aus, um ein vollwertiges assoziatives Speichersystem zu implementieren. Assoziative Speichermodelle dienen dazu, Muster basierend auf ihren Assoziationen zu speichern und abzurufen, häufig durch die Identifizierung des gespeicherten Musters, das einer bestimmten Eingabe am nächsten kommt, selbst wenn die Eingabe verrauscht oder unvollständig ist.

Während die Interpolation zum Schätzen von Werten zwischen bekannten Datenpunkten verwendet werden kann, ist sie nicht grundsätzlich für den Umgang mit Rauschen, unvollständigen Informationen oder Mustererkennung ausgelegt. Interpolationsmethoden wie die lineare oder polynomielle Interpolation basieren auf der Annahme, dass die zugrunde liegende Funktion glatt ist oder eine bestimmte Form hat, was für viele reale assoziative Gedächtnisprobleme möglicherweise nicht zutrifft.

Eine alternative Methode für assoziatives Gedächtnis – Überparametrisierung?

Überparametrisierung bezieht sich auf eine Situation, in der ein Modell für maschinelles Lernen im Vergleich zur Größe des Trainingsdatensatzes eine große Anzahl von Parametern (Gewichtungen und Verzerrungen) aufweist. Mit anderen Worten: Das Modell ist komplexer als nötig, um die zugrunde liegenden Muster in den Daten zu erklären oder zu erfassen. Es wurde bereits früher beobachtet, dass überparametrisierte Modelle die Daten interpolieren können; eine aktuelle Studie von Radhakrishnan et al. 2020 [8] zeigte, dass überparametrisierte Autoencoder auch zum Speichern und Abrufen von Trainingsbeispielen verwendet werden können. Der Mechanismus ist bemerkenswert einfach; – die Beispiele können sein

einfach durch Iteration der erlernten Karte wiederhergestellt.

Autoencoder! Auch überparametrisiert! Was ist das?

Ein Autoencoder ist eine Art künstliches neuronales Netzwerk, das zum unbeaufsichtigten Lernen effizienter Datendarstellungen verwendet wird, häufig mit dem Ziel der Dimensionsreduzierung, des Merkmalslernens oder der Datenkomprimierung. Es besteht aus zwei Hauptteilen: dem Encoder und dem Decoder.

Das Trainingsziel eines Autoencoders besteht darin, den Rekonstruktionsfehler zwischen den Eingabedaten und den rekonstruierten Daten zu minimieren, der dadurch entsteht, dass die Eingabe durch den Encoder und dann durch den Decoder geleitet wird.

Einfach ausgedrückt ist ein überparametrisierter Autoencoder ein Autoencoder mit einer großen Anzahl von Parametern. Adit et. al. zeigte, dass überparametrisierte Autoencoder Trainingsbeispiele als Fixpunkte oder Aktoren speichern. Es lernt jedoch auch die Identitätskarte f(x) = x

Dies ist ein Nachteil für die Assoziativität, da eine Voraussetzung dafür ist, dass die Ableitung an Beispielen kleiner als 1 sein muss. Adit et. al. 2020ging davon aus, dass überparametrisierte Autoencoder leistungsstark genug sind, um assoziatives Gedächtnis zu implementieren. Sie zeigten in ihrer Arbeit, dass überparametrisierte Autoencoder als „Attractor-based Associative Memory“ verwendet werden können. Die Kernidee hinter Attraktor-basierten Systemen besteht darin, dass das Netzwerk in der Lage sein sollte, ein gespeichertes Muster abzurufen, wenn eine unvollständige oder verrauschte Version dieses Musters vorliegt. Das Eingabemuster dient als Hinweis, und die Netzwerkdynamik führt das System zum nächstgelegenen Attraktor, wodurch das Rauschen effektiv „bereinigt“ oder die fehlenden Informationen ergänzt werden – vereinfacht gesagt kann OPA ein assoziatives Gedächtnis implementieren. Die mathematischen Bedingungen für ein attraktorbasiertes assoziatives Gedächtnis sind:

- Beispiele müssen Fixpunkte sein.

- Ableitungen in Beispielen müssen kleiner als 1 sein.

Passiert das wirklich?

Das Papier liefert umfangreiche empirische Belege dafür, dass Attraktoren in Autoencodern verschiedener Architekturen und Optimierungstechniken zu finden sind. Die Autoren demonstrierten erfolgreich einen überparametrisierten Autoencoder, der 500 Bilder aus dem ImageNet-64-Datensatz als Attraktoren speichern kann. Sie bestätigten, dass alle 500 Trainingsbilder tatsächlich als Attraktoren gespeichert waren, indem sie die Eigenwerte der Jacobi-Matrix für jedes Beispiel untersuchten. Die Studie analysierte auch die Rate, mit der Trainingsbeispiele bei verschiedenen Formen der Korruption wiederhergestellt werden konnten, und zeigte eine beeindruckend hohe Wiederherstellungsrate.

Weitere Experimente zeigten, dass Autoencoder auch Trainingsbeispiele als Attraktoren speichern konnten, wenn sie mit 2.000 Bildern aus dem MNIST-Datensatz und 1.000 Schwarzweißbildern aus dem CIFAR10-Datensatz trainiert wurden. Obwohl in überparametrisierten Autoencodern möglicherweise falsche Attraktoren (andere Attraktoren als Trainingsbeispiele) vorhanden sein können, konnten die Forscher in ihrem ImageNet-64-Beispiel keine solchen falschen Attraktoren identifizieren.

Die Autoren führten eine umfassende Analyse des Attraktorphänomens durch und untersuchten verschiedene gängige Architekturen, Optimierungsmethoden und Initialisierungsschemata. Dazu gehörten eine Reihe von Nichtlinearitäten, Optimierungsmethoden und Initialisierungsschemata. Ihre Ergebnisse zeigten, dass Attraktoren in jedem Szenario auftauchten, in dem sich das Training innerhalb von 1.000.000 Epochen einem ausreichend geringen Verlust annäherte. Bezeichnenderweise war dieses Phänomen nicht auf vollständig verbundene Netzwerke beschränkt, sondern wurde auch in weit verbreiteten Netzwerkarchitekturen wie Faltungs- und wiederkehrenden Netzwerken beobachtet.

Bezeichnenderweise beschränkte sich dieses Phänomen nicht nur auf vollständig verbundene Netzwerke, sondern wurde auch in weit verbreiteten Netzwerkarchitekturen wie Faltungs- und rekurrenten Netzwerken beobachtet. Um die 2D-Attraktoren zu visualisieren, trainierten sie einen Autoencoder, um sechs Trainingsbeispiele als Attraktoren zu speichern, und visualisierten ihre Anziehungsgebiete durch Iteration der trainierten Autoencoder-Karte, beginnend bei 10.000 Gitterpunkten bis zur Konvergenz. Das Vektorfeld im Experiment gibt die durch die Iteration gegebene Bewegungsrichtung an. Jedes Trainingsbeispiel und sein entsprechendes Anziehungsgebiet werden durch unterschiedliche Farben dargestellt. Interessanterweise ergab die Studie, dass die vom Autoencoder gelernte Metrik zur Trennung der Anziehungsgebiete nicht die euklidische Distanz ist, die durch ein Voronoi-Diagramm angezeigt würde.

Die Sequenzkodierung liefert bessere Ergebnisse als die automatische Kodierung.

Eine geringfügige Änderung der Zielfunktion gegenüber den Autoencodern führt zur Implementierung assoziativer Speicher. Die Forscher zeigten, dass die Minimierung der Verlustfunktion für einen ausreichend kleinen und stabilen Schwellenwert die Trainingssequenzen als Grenzzyklen des Netzwerks kodiert (eine Art Attraktor, der ein stabiles, periodisches Verhalten zeigt).

Schlussbemerkung

Zusammenfassend lässt sich sagen, dass das assoziative Gedächtnis ein faszinierender Aspekt der menschlichen Kognition ist, der in verschiedenen Kontexten untersucht wurde, darunter biologische Systeme, Hopfield-Netzwerke und überparametrisierte neuronale Netzwerke. Unser Verständnis des assoziativen Gedächtnisses in lebenden Organismen hat die Entwicklung von Rechenmodellen wie Hopfield-Netzwerken inspiriert, die wiederum die Bereiche künstliche Intelligenz und maschinelles Lernen vorangebracht haben.

Jüngste Forschungen zu überparametrisierten neuronalen Netzen haben die Entstehung von Attraktoren, einem Phänomen im Zusammenhang mit dem assoziativen Gedächtnis, in einer Reihe von Architekturen und Optimierungstechniken entdeckt. Diese aufregende Entwicklung festigt nicht nur die Verbindung zwischen biologischen und künstlichen neuronalen Systemen, sondern eröffnet auch neue Möglichkeiten für die Erforschung effizienterer und robusterer Modelle für die Speicherung und den Abruf von Erinnerungen.

Während wir weiterhin die komplizierten Mechanismen aufdecken, die dem assoziativen Gedächtnis zugrunde liegen, werden unsere Erkenntnisse weitere Innovationen in der künstlichen Intelligenz vorantreiben und den Weg für fortschrittliche, biologisch inspirierte Modelle ebnen, die die kognitiven Fähigkeiten des Menschen simulieren können. Diese fortlaufende Forschung verspricht, unser Verständnis der komplexen Beziehung zwischen Biologie und Informatik zu verbessern und letztendlich zu Durchbrüchen zu führen, die beiden Bereichen zugute kommen können.

Besonderer Dank geht an Nir N. Shavit für seine Anleitung und hilfreiche Diskussion. Erstellt im Rahmen der MIT-Klasse 6.S978 – Gewebe vs. Silizium im maschinellen Lernen, Frühjahr 2023.

Verweise

- Smith, J. (2022). Was ist assoziatives Gedächtnis? Sehr gut.https://www.verywellmind.com/what-is-associative-memory-5198601

- Willshaw, DJ, Buneman, OP, & Longuet-Higgins, HC (1969). Nicht-holographisches assoziatives Gedächtnis. Nature , 222 (5197), 960–962. Y. (2018). Theoretische Grundlagen für die Alpha-Beta-Assoziativspeicher: 10 Jahre abgeleitete Erweiterungen, Modelle und Anwendungen. Briefe zur neuronalen Verarbeitung , 48 (2), 811–847.

- Hopfield, JJ (1982). Neuronale Netze und physikalische Systeme mit entstehenden kollektiven Rechenfähigkeiten. Proceedings of the National Academy of Sciences , 79 (8), 2554–2558.

- Kosko, B. (1988). Bidirektionale assoziative Erinnerungen. IEEE Transactions on Systems, Man, and Cybernetics, 18(1), 49–60.

- McClelland, JL (2006). Wie weit kann man mit hebräischem Lernen gehen und wann führt es in die Irre? Veränderungsprozesse im Gehirn und in der kognitiven Entwicklung: Aufmerksamkeit und Leistung xxi, 21, 33–69.

- Ackley, David H., Geoffrey E. Hinton und Terrence J. Sejnowski. „Ein Lernalgorithmus für Boltzmann-Maschinen.“ Kognitionswissenschaft 9.1 (1985): 147–169.

- Barabási, Albert-László, Réka Albert und Hawoong Jeong. „Mean-Field-Theorie für skalenfreie Zufallsnetzwerke.“ Physica A: Statistische Mechanik und ihre Anwendungen 272.1–2 (1999): 173–187.

- Radhakrishnan, Adityanarayanan, Mikhail Belkin und Caroline Uhler. „Überparametrisierte neuronale Netze implementieren assoziatives Gedächtnis.“ Verfahren der National Academy of Sciences 117.44 (2020): 27162–27170

![Was ist überhaupt eine verknüpfte Liste? [Teil 1]](https://post.nghiatu.com/assets/images/m/max/724/1*Xokk6XOjWyIGCBujkJsCzQ.jpeg)